HMM

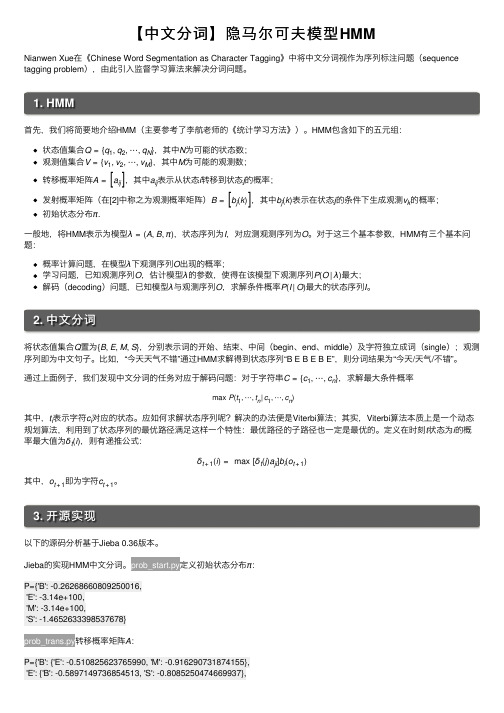

【中文分词】隐马尔可夫模型HMM

【中⽂分词】隐马尔可夫模型HMMNianwen Xue 在《Chinese Word Segmentation as Character Tagging 》中将中⽂分词视作为序列标注问题(sequence tagging problem ),由此引⼊监督学习算法来解决分词问题。

1. HMM⾸先,我们将简要地介绍HMM (主要参考了李航⽼师的《统计学习⽅法》)。

HMM 包含如下的五元组:状态值集合Q ={q 1,q 2,⋯,q N },其中N 为可能的状态数;观测值集合V ={v 1,v 2,⋯,v M },其中M 为可能的观测数;转移概率矩阵A =a ij ,其中a ij 表⽰从状态i 转移到状态j 的概率;发射概率矩阵(在[2]中称之为观测概率矩阵)B =b j (k ),其中b j (k )表⽰在状态j 的条件下⽣成观测v k 的概率;初始状态分布π.⼀般地,将HMM 表⽰为模型λ=(A ,B ,π),状态序列为I ,对应测观测序列为O 。

对于这三个基本参数,HMM 有三个基本问题:概率计算问题,在模型λ下观测序列O 出现的概率;学习问题,已知观测序列O ,估计模型λ的参数,使得在该模型下观测序列P (O |λ)最⼤;解码(decoding )问题,已知模型λ与观测序列O ,求解条件概率P (I |O )最⼤的状态序列I 。

2. 中⽂分词将状态值集合Q 置为{B ,E ,M ,S },分别表⽰词的开始、结束、中间(begin 、end 、middle )及字符独⽴成词(single );观测序列即为中⽂句⼦。

⽐如,“今天天⽓不错”通过HMM 求解得到状态序列“B E B E B E”,则分词结果为“今天/天⽓/不错”。

通过上⾯例⼦,我们发现中⽂分词的任务对应于解码问题:对于字符串C ={c 1,⋯,c n },求解最⼤条件概率max P (t 1,⋯,t n |c 1,⋯,c n )其中,t i 表⽰字符c i 对应的状态。

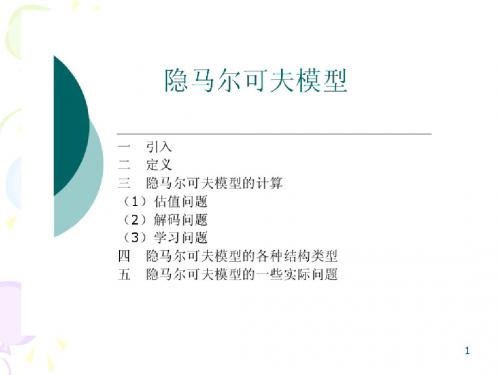

HMM-简介

P(O | λ) = ∑ β1 (i) i =1

解码问题—Viterbi算法

Viterbi算法采用动态规划算法。复杂度为O(K 2L) 。其中 K和 L分别为状态个数和序列长

度。

定义δ t (i )

=

max

q1,q2 ,...qt−1

P[q1 q2 ...qt−1 , qt

=

i, O1,O2,…Ot ,

3) 终止:

N

P(O | λ ) = ∑α T (i) i=1

其中递推是整个算法的核心。 后向算法和前向算法性质上是一样的,只是递推方向不同。定义后向变量:

β t (i) = P(Ot +1Ot +1...OT | qt = Si ,λ )

也就是给定模型参数,当时刻 t的状态是Si 的时候,从时刻 t+1到序列结束的输出观察序

对于 HMM 模型,其的状态转换过程是不可观察的,因而称之为“隐”马尔可夫模型。

HMM定义

1) X代表一组状态的集合,其中 X = {S1, S2,..., SN } ,状态数为 N,并用qt 来表示 t时刻的 状态。虽然状态是隐藏的,但对于很多应用来说,有一些物理的意义都和状态或者状态 集相关。状态内部的联系就是从一个状态可以到其它状态。

集合的元素作为混合高斯模型的分量,实现的是带隐变量的

最大似然估计。

的 HMM,可能有aij =0(对于一对或多对 i,j)。

4) 状态 j的观察概率分布 B = {b j (k)} ,表示状态 j输出相应观察值的概率,其中

bj (k )

=

P{O t

= Vk

|q t

=

S },1 ≤ j

j

≤

N

1≤k ≤ M 。

一文搞懂HMM(隐马尔可夫模型)

⼀⽂搞懂HMM(隐马尔可夫模型)什么是熵(Entropy)简单来说,熵是表⽰物质系统状态的⼀种度量,⽤它⽼表征系统的⽆序程度。

熵越⼤,系统越⽆序,意味着系统结构和运动的不确定和⽆规则;反之,,熵越⼩,系统越有序,意味着具有确定和有规则的运动状态。

熵的中⽂意思是热量被温度除的商。

负熵是物质系统有序化,组织化,复杂化状态的⼀种度量。

熵最早来原于物理学. 德国物理学家鲁道夫·克劳修斯⾸次提出熵的概念,⽤来表⽰任何⼀种能量在空间中分布的均匀程度,能量分布得越均匀,熵就越⼤。

1. ⼀滴墨⽔滴在清⽔中,部成了⼀杯淡蓝⾊溶液2. 热⽔晾在空⽓中,热量会传到空⽓中,最后使得温度⼀致更多的⼀些⽣活中的例⼦:1. 熵⼒的⼀个例⼦是⽿机线,我们将⽿机线整理好放进⼝袋,下次再拿出来已经乱了。

让⽿机线乱掉的看不见的“⼒”就是熵⼒,⽿机线喜欢变成更混乱。

2. 熵⼒另⼀个具体的例⼦是弹性⼒。

⼀根弹簧的⼒,就是熵⼒。

胡克定律其实也是⼀种熵⼒的表现。

3. 万有引⼒也是熵⼒的⼀种(热烈讨论的话题)。

4. 浑⽔澄清[1]于是从微观看,熵就表现了这个系统所处状态的不确定性程度。

⾹农,描述⼀个信息系统的时候就借⽤了熵的概念,这⾥熵表⽰的是这个信息系统的平均信息量(平均不确定程度)。

最⼤熵模型我们在投资时常常讲不要把所有的鸡蛋放在⼀个篮⼦⾥,这样可以降低风险。

在信息处理中,这个原理同样适⽤。

在数学上,这个原理称为最⼤熵原理(the maximum entropy principle)。

让我们看⼀个拼⾳转汉字的简单的例⼦。

假如输⼊的拼⾳是"wang-xiao-bo",利⽤语⾔模型,根据有限的上下⽂(⽐如前两个词),我们能给出两个最常见的名字“王⼩波”和“王晓波 ”。

⾄于要唯⼀确定是哪个名字就难了,即使利⽤较长的上下⽂也做不到。

当然,我们知道如果通篇⽂章是介绍⽂学的,作家王⼩波的可能性就较⼤;⽽在讨论两岸关系时,台湾学者王晓波的可能性会较⼤。

第08章 HMM

• N和T分别为状态个数和序列长度 定义:

δ t (i ) = max P[q1q2 ...qt −1 , qt = i, O1,O2,…Ot , | λ ]

q1 , q2 ,...qt −1

我们所要找的,就是T时刻最大的 δ T (i) 表的那个状态序列

所代

51

Viterbi算法 Viterbi算法(续) 算法(

3

马尔科夫链

• 时间 状态都离散的马尔科夫过程称为马尔科 时间和状态 状态 夫链 • 记作{Xn = X(n), n = 0,1,2,…}

– 在时间集T1 = {0,1,2,…}上对离散状态的过程相 继观察的结果

• 链的状态空间记做I = {a1, a2,…}, ai∈R. • 条件概率Pij ( m ,m+n)=P{Xm+n = aj|Xm = ai} 为马氏链在时刻m处于状态ai条件下,在 时刻m+n转移到状态aj的转移概率 转移概率。 转移概率

– 递归: – 终结:

βt (i) = ∑aijbj (Ot+1)βt +1( j) t = T −1,T − 2,...,1,1≤ i ≤ N

i=1 N

P(O / λ) = ∑β1 (i)

i =1

N

50

Viterbi算法 Viterbi算法

• 目的:给定观察序列O以及模型λ,如何选择一

个对应的状态序列S ,使得S能够最为合理的 解释观察序列O?

图8-1 马尔可夫过程状态图。箭头表示状态之间允许转移,箭头的数字表示转移概率

22

实际上并非所有的HMM都像图8-1那样复杂,模型越简单越便于估计和应 用。对于某些应用特别是语音识别来说,采用其他类型的HMM效果会更好。一 种最常见的模型是从左至右的模型,其一般形式示于图8-2。 模型只有惟一的一个初始状态和一个终止状态,并且这个过程只要进入一 个新的状态就不能返回到以前的状态。这种模型很适合于其性质随着时间变化 的信号,如语音信号。 在图8-2所示的模型中,前向转移受到进一步的约束:模型只能重复原有 状态、前进一个状态或两个状态。

HMM隐马尔可夫模型解析课件

的颜色为O1,并把球放回缸中 n 根据描述缸的转移的概率分布,随机选择下一口缸,

重复以上步骤。

n 为最观后察得值到序一列个O描。述球的颜色的序列O1,O2, … ,称

HMM实例——约束

在上述实验中,有几个要点需要注意:

n (a)转移矩阵没有零值 的Markov链

n (b)转移矩阵有零值的 Markov链

n (c)和(d)是左-右形式表 示的Markov链

HMM实例

Urn 3 Urn 2 Urn 1

Veil

Observed Ball Sequence

HMM实例——描述

n 设有N个缸,每个缸中装有很多彩球,球的颜色 由一组概率分布描述。实验进行方式如下

的统计特性,即状态转移概率确定;这个 状态产生的输出亦为随机的,取决于该状 态生成语音观察量的概率。

n 无跨越模型符合人类的语音特点,广泛应 用于语音识别中。

n 有跨越用于反映音素在发音中可能被吸收 或删除的情况。

Two types of HMM

n State-emission HMM (Moore machine):

n X(t+1) = f(X(t) ) n 现实中存在很多马尔可夫过程

马尔可夫链

n 时间和状态都离散的马尔可夫过程称为马尔可夫链

n 记作{Xn = X(n), n = 0,1,2, …}

n 在时间集T1 = {0,1,2, …}上对离散状态的过程相继观察的结果

n 链的状态空间记做I = {a1, a2, …}, ai∈R.

隐马尔可夫模型 Hidden Markov model

hmm 时间序列 预测方法

HMM时间序列预测方法1. 引言在时间序列分析中,预测未来的数值是一个重要的任务。

HMM(隐马尔可夫模型)是一种常用的时间序列预测方法,它可以用于解决各种具有时序关系的问题,如语音识别、自然语言处理、股票市场预测等。

本文将详细介绍HMM时间序列预测方法的原理、应用以及实现过程。

2. HMM基本原理HMM是一种统计模型,用于描述由一个隐藏状态序列和一个可观察状态序列组成的过程。

隐藏状态是不可直接观察到的,而可观察状态则可以被观察到。

HMM假设隐藏状态之间存在马尔可夫性质,即当前隐藏状态只与前一个隐藏状态相关。

HMM由以下几个要素组成: - 隐藏状态集合:表示可能出现的所有隐藏状态。

-可观察状态集合:表示可能出现的所有可观察状态。

- 初始概率分布:表示初始时刻每个隐藏状态出现的概率。

- 状态转移概率矩阵:表示从一个隐藏状态转移到另一个隐藏状态的概率。

- 观测概率矩阵:表示在给定隐藏状态下,观测到某个可观察状态的概率。

HMM的基本思想是通过给定的观测序列,利用已知的模型参数来推断隐藏状态序列,并进一步预测未来的观测序列。

3. HMM时间序列预测方法步骤HMM时间序列预测方法包括以下几个步骤:步骤1:模型训练•收集历史数据:从过去的时间序列中收集足够数量的观测数据。

•确定隐藏状态和可观察状态:根据具体问题确定隐藏状态和可观察状态的集合。

•估计初始概率分布:根据历史数据统计每个隐藏状态出现的频率,并将其归一化得到初始概率分布。

•估计状态转移概率矩阵:根据历史数据统计每个隐藏状态之间转移的频率,并将其归一化得到状态转移概率矩阵。

•估计观测概率矩阵:根据历史数据统计在给定隐藏状态下,每个可观察状态出现的频率,并将其归一化得到观测概率矩阵。

步骤2:模型推断•给定观测序列:根据已有的观测序列,利用前面训练得到的模型参数,通过前向算法计算每个隐藏状态的前向概率。

•预测隐藏状态序列:利用维特比算法,根据前向概率计算最可能的隐藏状态序列。

HMM隐马尔可夫模型在自然语言处理中的应用

HMM隐马尔可夫模型在自然语言处理中的应用隐马尔可夫模型(Hidden Markov Model,HMM)是自然语言处理中常用的一种概率统计模型,它广泛应用于语音识别、文本分类、机器翻译等领域。

本文将从HMM的基本原理、应用场景和实现方法三个方面,探讨HMM在自然语言处理中的应用。

一、HMM的基本原理HMM是一种二元组( $λ=(A,B)$),其中$A$是状态转移矩阵,$B$是观测概率矩阵。

在HMM中,状态具有时序关系,每个时刻处于某一状态,所取得的观测值与状态相关。

具体来说,可以用以下参数描述HMM模型:- 隐藏状态集合$S={s_1,s_2,...,s_N}$:表示模型所有可能的状态。

- 观测符号集合$V={v_1,v_2,...,v_M}$:表示模型所有可能的观测符号。

- 初始状态分布$\pi={\pi (i)}$:表示最初处于各个状态的概率集合。

- 状态转移矩阵$A={a_{ij}}$:表示从$i$状态转移到$j$状态的概率矩阵。

- 观测概率矩阵$B={b_j(k)}$:表示处于$j$状态时,观测到$k$符号的概率。

HMM的主要任务是在给定观测符号序列下,求出最有可能的对应状态序列。

这个任务可以通过HMM的三种基本问题求解。

- 状态序列概率问题:已知模型参数和观测符号序列,求得该观测符号序列下各个状态序列的概率。

- 观测符号序列概率问题:已知模型参数和状态序列,求得该状态序列下观测符号序列的概率。

- 状态序列预测问题:已知模型参数和观测符号序列,求得使得观测符号序列概率最大的对应状态序列。

二、HMM的应用场景1. 语音识别语音识别是指将语音信号转化成文字的过程,它是自然语言处理的关键技术之一。

HMM在语音识别领域具有广泛应用,主要用于建立声学模型和语言模型。

其中,声学模型描述语音信号的产生模型,是从语音输入信号中提取特征的模型,而语言模型描述语言的组织方式,是指给定一个句子的前提下,下一个字或单词出现的可能性。

隐马尔科夫(HMM)模型详解及代码实现

机器学习之隐马尔科夫模型(HMM)机器学习之隐马尔科夫模型(HMM)1、隐马尔科夫模型介绍2、隐马尔科夫数学原理3、Python代码实现隐马尔科夫模型4、总结隐马尔可夫模型介绍马尔科夫模型(hidden Markov model,HMM)是关于时序的概率模型,描述由一个隐藏的马尔科夫随机生成不可观测的状态随机序列,再由各个状态生成一个观测从而产生观测随机序列的过程,属于一个生成模型。

下面我们来从概率学角度定义马尔科夫模型,从一个典型例子开始:假设有4个盒子,每个盒子里面有不同数量的红、白两种颜色的球,具体如下表:盒子编号1234红球数5368白球数5742现在从这些盒子中取出T个球,取样规则为每次选择一个盒子取出一个球,记录其颜色,放回。

在这个过程中,我们只能观测到球的颜色的序列,观测不到球是从哪个盒子中取出来的,即观测不到盒子的序列,这里有两个随机序列,一个是盒子的序列(状态序列),一个是球的颜色的观测序列(观测序列),前者是隐藏的,只有后者是可观测的。

这里就构成了一个马尔科夫的例子。

定义是所有的可能的状态集合,V是所有的可能的观测的集合:其中,N是可能的状态数,M是可能的观测数,例如上例中N=4,M=2。

是长度为T的状态序列,是对应的观测序列:A是状态转移概率矩阵:其中, 是指在时刻处于状态的条件下在时刻转移到状态的概率。

B是观测概率矩阵:其中, 是指在时刻处于状态的条件下生成观测的概率。

是初始状态概率向量:其中, 是指在时刻=1处于状态的概率。

由此可得到,隐马尔可夫模型的三元符号表示,即称为隐马尔可夫模型的三要素。

由定义可知隐马尔可夫模型做了两个基本假设:(1)齐次马尔科夫性假设,即假设隐藏的马尔科夫链在任意时刻的状态只和-1状态有关;(2)观测独立性假设,观测只和当前时刻状态有关;仍以上面的盒子取球为例,假设我们定义盒子和球模型:状态集合: = {盒子1,盒子2,盒子3,盒子4}, N=4观测集合: = {红球,白球} M=2初始化概率分布:状态转移矩阵:观测矩阵:(1)转移概率的估计:假设样本中时刻t处于状态i,时刻t+1转移到状态j 的频数为那么转台转移概率的估计是:(2)观测概率的估计:设样本中状态为j并观测为k的频数是那么状态j观测为k的概率, (3)初始状态概率的估计为S个样本中初始状态为的频率。

hmm 前向后向算法 理解

HMM(隐马尔可夫模型)前向后向算法1. 介绍在自然语言处理和机器学习领域,隐马尔可夫模型(Hidden Markov Model, HMM)是一种常用的统计模型,用于建模具有隐含状态的序列数据。

HMM在语音识别、自然语言处理、生物信息学等领域有广泛的应用。

HMM由状态集合、观测集合、状态转移概率矩阵、观测概率矩阵和初始状态概率向量组成。

在HMM中,状态是不可见的,只能通过观测序列来推断。

HMM的前向后向算法是一种基于动态规划的算法,用于计算给定观测序列下的模型参数。

本文将详细介绍HMM的前向后向算法的原理和实现过程。

2. 前向算法前向算法用于计算给定观测序列下的模型参数,包括观测概率、状态转移概率和初始状态概率。

下面是前向算法的具体步骤:步骤1:初始化初始化前向概率矩阵α,α[i][t]表示在时刻t处于状态i的概率。

初始化方式为α[i][0] = π[i] * B[i][O[0]],其中π是初始状态概率向量,B是观测概率矩阵,O是观测序列。

步骤2:递推计算根据前向概率矩阵α的递推公式,计算α[i][t]的值。

递推公式为α[i][t] = ∑(α[j][t-1] * A[j][i]) * B[i][O[t]],其中A是状态转移概率矩阵。

步骤3:终止条件计算观测序列的概率P(O)。

终止条件为P(O) = ∑α[i][T],其中T为观测序列的长度。

3. 后向算法后向算法用于计算给定观测序列下的模型参数,包括观测概率、状态转移概率和初始状态概率。

下面是后向算法的具体步骤:步骤1:初始化初始化后向概率矩阵β,β[i][t]表示在时刻t处于状态i的概率。

初始化方式为β[i][T] = 1,其中T为观测序列的长度。

步骤2:递推计算根据后向概率矩阵β的递推公式,计算β[i][t]的值。

递推公式为β[i][t] =∑(A[i][j] * B[j][O[t+1]] * β[j][t+1]),其中A是状态转移概率矩阵,B是观测概率矩阵。

HMM(隐马尔可夫模型)及其应用

HMM(隐马尔可夫模型)及其应用摘要:隐马尔可夫模型(Hidden Markov Model,HMM)作为一种统计分析模型,创立于20世纪70年代。

80年代得到了传播和发展,成为信号处理的一个重要方向,现已成功地用于语音识别,行为识别,文字识别以及故障诊断等领域。

本文先是简要介绍了HMM的由来和概念,之后重点介绍了3个隐马尔科夫模型的核心问题。

关键词:HMM,三个核心问题HMM的由来1870年,俄国有机化学家Vladimir V. Markovnikov第一次提出马尔可夫模型。

马尔可夫在分析俄国文学家普希金的名著《叶夫盖尼•奥涅金》的文字的过程中,提出了后来被称为马尔可夫框架的思想。

而Baum及其同事则提出了隐马尔可夫模型,这一思想后来在语音识别领域得到了异常成功的应用。

同时,隐马尔可夫模型在“统计语言学习”以及“序列符号识别”(比如DNA序列)等领域也得到了应用。

人们还把隐马尔可夫模型扩展到二维领域,用于光学字符识别。

而其中的解码算法则是由Viterbi和他的同事们发展起来的。

马尔可夫性和马尔可夫链1. 马尔可夫性如果一个过程的“将来”仅依赖“现在”而不依赖“过去”,则此过程具有马尔可夫性,或称此过程为马尔可夫过程。

马尔可夫性可用如下式子形象地表示:X(t+1)=f(X(t))2. 马尔可夫链时间和状态都离散的马尔可夫过程称为马尔可夫链。

记作{Xn=X(n), n=0,1,2,…}这是在时间集T1={0,1,2,…}上对离散状态的过程相继观察的结果。

链的状态空间记作I={a1, a2,…}, ai ∈R.条件概率Pij(m, m+n)=P{ Xm+n = aj | Xm = aj }为马氏链在时刻m处于状态ai条件下,在时刻m+n转移到状态aj的转移概率。

3. 转移概率矩阵如下图所示,这是一个转移概率矩阵的例子。

由于链在时刻m从任何一个状态ai出发,到另一时刻m+n,必然转移到a1,a2…,诸状态中的某一个,所以有当与m无关时,称马尔可夫链为齐次马尔可夫链,通常说的马尔可夫链都是指齐次马尔可夫链。

隐马尔科夫模型(HMM)详解

马尔科夫过程马尔科夫过程可以看做是一个自动机,以一定的概率在各个状态之间跳转。

考虑一个系统,在每个时刻都可能处于N个状态中的一个,N个状态集合是{S1,S2,S3,...S N}。

我们如今用q1,q2,q3,…q n来表示系统在t=1,2,3,…n时刻下的状态。

在t=1时,系统所在的状态q取决于一个初始概率分布PI,PI(S N)表示t=1时系统状态为S N的概率。

马尔科夫模型有两个假设:1. 系统在时刻t的状态只与时刻t-1处的状态相关;〔也称为无后效性〕2. 状态转移概率与时间无关;〔也称为齐次性或时齐性〕第一条详细可以用如下公式表示:P(q t=S j|q t-1=S i,q t-2=S k,…)= P(q t=S j|q t-1=S i)其中,t为大于1的任意数值,S k为任意状态第二个假设那么可以用如下公式表示:P(q t=S j|q t-1=S i)= P(q k=S j|q k-1=S i)其中,k为任意时刻。

下列图是一个马尔科夫过程的样例图:可以把状态转移概率用矩阵A表示,矩阵的行列长度均为状态数目,a ij表示P(S i|S i-1)。

隐马尔科夫过程与马尔科夫相比,隐马尔科夫模型那么是双重随机过程,不仅状态转移之间是个随机事件,状态和输出之间也是一个随机过程,如下列图所示:此图是从别处找来的,可能符号与我之前描绘马尔科夫时不同,相信大家也能理解。

该图分为上下两行,上面那行就是一个马尔科夫转移过程,下面这一行那么是输出,即我们可以观察到的值,如今,我们将上面那行的马尔科夫转移过程中的状态称为隐藏状态,下面的观察到的值称为观察状态,观察状态的集合表示为O={O1,O2,O3,…O M}。

相应的,隐马尔科夫也比马尔科夫多了一个假设,即输出仅与当前状态有关,可以用如下公式表示:P(O1,O2,…,O t|S1,S2,…,S t)=P(O1|S1)*P(O2|S2)*...*P(O t|S t) 其中,O1,O2,…,O t为从时刻1到时刻t的观测状态序列,S1,S2,…,S t那么为隐藏状态序列。

基于hmm的中文分词

基于hmm的中文分词

基于HMM的中文分词是一种常见的自然语言处理技术,它使用隐

马尔可夫模型(HMM)来进行中文分词,即将一段连续的中文文本切分

成一个个有意义的词语。

HMM模型是一种统计模型,其基本思想是将观测数据看作是由一系列不可见的隐含状态序列生成的,通过观测数据和隐含状态序列之间

的概率关系来推断出最可能的隐含状态序列,从而达到对观测数据的

分析和建模的目的。

在中文分词中,HMM模型通常将中文文本看作一个序列,每个词语对应一个隐含状态,而观测数据则是每个汉字或标点符号,通过概率

转移矩阵和发射概率矩阵来计算每个汉字或标点符号分别属于哪个词语,从而完成中文分词任务。

基于HMM的中文分词具有较高的准确性和鲁棒性,常常被应用于

各种自然语言处理应用中,例如机器翻译、信息检索、情感分析等等。

同时,也有一些后续的改进算法和技术,例如基于CRF(条件随机场)的中文分词、神经网络模型等,不过HMM模型依然是中文分词中比较

有代表性和典型的一种方法。

HMM

3、HMM的三个基本问题

• 1.求值问题(Evaluation Problem)

• 2.译码问题(Decoding Problem) 3. 学习问题(Learning Problem)

• 求值问题(Evaluation Problem)

– 已知:

• 观测序列 O (o1 , o2 ,oT ) • 模型 ( A, B, )

• 整体概率

P (O ) P (Q ) P ( q1q2 qt qT ) P ( qT | qT 1 q1 ) P ( qT 1 q1 ) P ( qT 1 q1 ) P ( qT | qT 1 ) q1 P ( q2 | q1 ) P ( q3 | q2 ) P ( qT | qT 1 )

• Baum_Welch,Viterbi

随机时序网络图示

输出

MAXNET

评分1 评分2 评分N

……

HMM1

HMM2

HMMN

输入

二、HMM概述

• • • • Markov Model HMM定义 HMM三个基本问题 HMM类型

1、Markov Model

• 模型描述

P(qt | qt 1 , qt 2 ,q1 ) P(qt | qt 1 )

DHMM

• 观测矢量具有离散概率分布,它只能取有限多个离散 分布的矢量中的某一个。用标号k表示这些离散矢量, k=1~M,M为矢量总数,即码本的容量。

bj (O(t )) bjk P(Vk (t ) | qt j), j 1 ~ N, k 1 ~ M

M k 1

b jk 1,

– 1072

后向算法

Baum_Welch

隐形马尔科夫模型

yesterday Cloudy 0.250 0.125 0.625 Rainy 0.250 0.375 0.375

5、混淆矩阵:

observed states

Dry Dryish Damp Soggy

Sunny 0.60 0.20 0.15 0.05

Hidden Cloudy 0.25 0.25 0.25 0.25

2、观察状态(海藻湿度):Dry,Dryish,Damp, Soggy; 3、初始状态概率: Sunny(0.63),Cloudy (0.17),Rainy(0.20);

4、状态转移矩阵:

weather today

Sunny Cloudy Rainy

weather Sunny 0.500 0.375 0.125

如:天气情况(晴、多云、和雨)

非确定性的生成模式(天气预测)

假设该过程是一个一阶过程,即今天的天气情况仅 和昨天的天气有关用状态 Nhomakorabea移矩阵描述

非确定性的生成模式(天气预测)

定义初始概率,称为向量 ;

一个一阶马尔科夫模型,包括如下概念:

状态:晴、多云、雨 状态转移概率 初始概率

当一个隐士不能通过直接观察天气状态来预测 天气时,但他有一些水藻。民间的传说告诉我 们水藻的状态与天气有一定的概率关系。也就 是说,水藻的状态与天气时紧密相关的。此时, 我们就有两组状态:观察状态(水藻的状态) 和隐含状态(天气状态)。因此,我们希望得 到一个算法可以为隐士通过水藻和马尔科夫过 程,在没有直接观察天气的情况下得到天气的 变化情况。

利用前向算法来得到观察状态序列对应于一个HMM 的概率

解码:根据观察序列找到最有可能出现的隐状 态序列

viterbi算法(隐士只能通过感受水藻的状态来 判断天气状况)

保守区域hmm格式

保守区域hmm格式1.引言1.1 概述概述保守区域隐藏马尔可夫模型(HMM)是一种常用的序列建模方法,广泛应用于语音识别、自然语言处理、生物信息学等领域。

它是基于概率统计的一种方法,用于对具有一定规律的序列数据进行建模和预测。

在保守区域HMM中,我们特别关注的是那些具有保守性质的区域,这些区域在不同的序列中保持相对稳定,从而能够帮助我们更好地理解和分析序列数据。

通过使用保守区域HMM,我们可以对序列数据中的保守区域进行建模,并利用模型进行预测和分析。

在建模过程中,首先需要确定保守区域的定义和边界,在某些领域中,保守性质可能与序列中的一些重要特征相关,比如保守蛋白质结构中的保守氨基酸残基。

然后,我们需要选择一种合适的数学模型来描述保守区域的特性,常用的选择是马尔可夫模型。

在保守区域HMM中,保守区域被认为是隐藏状态,而序列数据则是由这些隐藏状态生成的观测序列。

隐藏状态之间的转移概率和隐藏状态生成观测的发射概率可以通过训练数据来估计。

一旦模型训练完毕,我们就可以使用这个模型来进行序列的预测和分析任务。

保守区域HMM在实际应用中广泛发挥作用。

例如,在生物信息学领域,我们可以利用保守区域HMM来预测蛋白质的结构和功能信息。

在语音识别领域,保守区域HMM被用于建模语音信号中的音素,从而实现语音识别任务。

此外,在自然语言处理领域,保守区域HMM也被应用于词性标注、命名实体识别等任务中。

总之,保守区域HMM是一种强大的序列建模方法,能够帮助我们对具有保守性质的区域进行建模和分析。

通过深入理解保守区域HMM的原理和应用,我们可以更好地应用这一模型解决实际问题,并在相关领域取得更好的研究成果。

在接下来的章节中,我们将介绍保守区域HMM的文章结构以及目的,以帮助读者更好地理解和应用这一模型。

1.2 文章结构文章结构部分主要是为了给读者提供一个整体的框架,使其能够更好地理解和组织文章的内容。

本文分为三个主要部分:引言、正文和结论。

如何使用隐马尔科夫模型进行序列标注(四)

隐马尔科夫模型(Hidden Markov Model,HMM)是一种在序列标注问题中应用广泛的概率图模型。

它主要用于对观测序列进行建模,并根据观测序列预测隐藏的状态序列。

在自然语言处理领域,HMM被广泛应用于词性标注、命名实体识别、语音识别等任务中。

本文将介绍HMM的基本原理和如何使用HMM进行序列标注。

### HMM的基本原理HMM由状态空间、观测空间、初始概率分布、状态转移概率矩阵和观测概率矩阵组成。

其中状态空间表示可能的隐藏状态,观测空间表示可能的观测结果,初始概率分布表示系统在初始时刻各个隐藏状态的概率分布,状态转移概率矩阵表示系统从一个隐藏状态转移到另一个隐藏状态的概率分布,观测概率矩阵表示系统在某个隐藏状态下观测到某个观测结果的概率分布。

### HMM的学习HMM的学习包括参数估计和状态序列的求解。

参数估计是指根据已知的观测序列估计HMM的参数,常用的方法有最大似然估计和Baum-Welch算法。

最大似然估计是通过最大化观测序列的联合概率来估计HMM的参数,而Baum-Welch算法是一种迭代算法,通过前向-后向算法来估计HMM的参数。

状态序列的求解是指给定观测序列,求解对应的隐藏状态序列,常用的方法有维特比算法。

### HMM的应用HMM在序列标注中的应用主要包括三个步骤:模型训练、解码和评估。

在模型训练阶段,我们需要利用已知的观测序列来估计HMM的参数。

在解码阶段,我们利用已训练好的HMM模型来求解给定观测序列对应的隐藏状态序列,常用的方法是维特比算法。

在评估阶段,我们需要评估模型对观测序列的拟合程度,常用的方法是对数似然比。

### HMM在词性标注中的应用词性标注是指给定一个句子,为句子中的每个词语标注其词性的任务。

HMM 在词性标注中的应用是将词性作为隐藏状态,词语作为观测结果,然后利用已训练好的HMM模型对句子中的词语进行标注。

在HMM中,观测结果是离散的,通常是词语对应的词性,而隐藏状态是连续的,通常是不同的词性。

隐马尔科夫模型HMM(一)HMM模型

隐马尔科夫模型HMM (⼀)HMM 模型 隐马尔科夫模型HMM (⼀)HMM 模型基础 隐马尔科夫模型(Hidden Markov Model ,以下简称HMM )是⽐较经典的机器学习模型了,它在语⾔识别,⾃然语⾔处理,模式识别等领域得到⼴泛的应⽤。

当然,随着⽬前深度学习的崛起,尤其是,等神经⽹络序列模型的⽕热,HMM 的地位有所下降。

但是作为⼀个经典的模型,学习HMM 的模型和对应算法,对我们解决问题建模的能⼒提⾼以及算法思路的拓展还是很好的。

本⽂是HMM 系列的第⼀篇,关注于HMM 模型的基础。

1. 什么样的问题需要HMM 模型 ⾸先我们来看看什么样的问题解决可以⽤HMM 模型。

使⽤HMM 模型时我们的问题⼀般有这两个特征:1)我们的问题是基于序列的,⽐如时间序列,或者状态序列。

2)我们的问题中有两类数据,⼀类序列数据是可以观测到的,即观测序列;⽽另⼀类数据是不能观察到的,即隐藏状态序列,简称状态序列。

有了这两个特征,那么这个问题⼀般可以⽤HMM 模型来尝试解决。

这样的问题在实际⽣活中是很多的。

⽐如:我现在在打字写博客,我在键盘上敲出来的⼀系列字符就是观测序列,⽽我实际想写的⼀段话就是隐藏序列,输⼊法的任务就是从敲⼊的⼀系列字符尽可能的猜测我要写的⼀段话,并把最可能的词语放在最前⾯让我选择,这就可以看做⼀个HMM 模型了。

再举⼀个,我在和你说话,我发出的⼀串连续的声⾳就是观测序列,⽽我实际要表达的⼀段话就是状态序列,你⼤脑的任务,就是从这⼀串连续的声⾳中判断出我最可能要表达的话的内容。

从这些例⼦中,我们可以发现,HMM 模型可以⽆处不在。

但是上⾯的描述还不精确,下⾯我们⽤精确的数学符号来表述我们的HMM 模型。

2. HMM 模型的定义 对于HMM 模型,⾸先我们假设Q 是所有可能的隐藏状态的集合,V 是所有可能的观测状态的集合,即:Q ={q 1,q 2,...,q N },V ={v 1,v 2,...v M } 其中,N 是可能的隐藏状态数,M 是所有的可能的观察状态数。

hmm维特比算法

hmm维特比算法维特比算法是一种用于求解隐马尔可夫模型(Hidden Markov Model, HMM)的动态规划算法。

它可以用于解决多个领域的问题,如自然语言处理、语音识别、基因识别等。

由于其高效的计算性能和精确性,维特比算法在这些领域得到了广泛的应用。

维特比算法的核心思想是通过动态规划的方式,找到给定观测序列条件下最有可能的隐藏状态序列。

在HMM中,隐藏状态序列是不可见的,只能通过观测序列来进行推测。

维特比算法通过利用HMM的马尔可夫性质,即当前状态只与前一个状态有关,来进行求解。

具体而言,维特比算法采用了一种“迭代求解”的方式,从观测序列的第一个时间步开始,逐个时间步地计算每个隐藏状态的最优路径。

首先,对于初始时间步,计算每个隐藏状态的初始概率和发射概率。

然后,在后续的每个时间步中,计算每个隐藏状态的转移概率和发射概率,并选择概率最大的路径作为最优路径。

为了实现这一迭代求解过程,维特比算法使用了两个重要的数据结构:状态表和路径表。

状态表用于存储每个时间步的隐藏状态概率,路径表用于存储每个隐藏状态的最优路径。

通过不断地更新这两个表格,维特比算法能够找到最有可能的隐藏状态序列。

需要注意的是,由于维特比算法是一种动态规划算法,它要求HMM满足无后效性。

也就是说,每个时间步的最优路径只与前一个时间步的最优路径相关,与之前的路径无关。

这是由于马尔可夫性质的限制所导致的。

维特比算法的时间复杂度为O(TN²),其中T为时间步数,N为隐藏状态的数量。

因此,在应用维特比算法时,需要根据问题规模和计算资源来选择适当的隐藏状态数量,以保证算法的效率。

总结来说,维特比算法是一种用于求解隐马尔可夫模型的动态规划算法,通过迭代求解的方式,能够找到给定观测序列条件下隐藏状态序列的最优路径。

它在多个领域中得到了广泛的应用,并以其高效的计算性能和精确性而闻名。

当然,维特比算法也有一定的局限性,例如对于HMM模型的先验知识依赖较强,对于非马尔可夫性质的问题难以处理等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

前言:隐含马尔可夫模型是一个数学模型,到目前为之,它一直被认为是实现快速精确的语音识别系统的最成功的方法。

复杂的语音识别问题通过隐含马尔可夫模型能非常简单地被表述、解决,让我不由由衷地感叹数学模型之妙。

自然语言是人类交流信息的工具。

很多自然语言处理问题都可以等同于通信系统中的解码问题-- 一个人根据接收到的信息,去猜测发话人要表达的意思。

这其实就象通信中,我们根据接收端收到的信号去分析、理解、还原发送端传送过来的信息。

以下该图就表示了一个典型的通信系统:

其中s1,s2,s3...表示信息源发出的信号。

o1, o2, o3 ... 是接受器接收到的信号。

通信中的解码就是根据接收到的信号o1, o2, o3 ...还原出发送的信号s1,s2,s3...。

其实我们平时在说话时,脑子就是一个信息源。

我们的喉咙(声带),空气,就是如电线和光缆般的信道。

听众耳朵的就是接收端,而听到的声音就是传送过来的信号。

根据声学信号来推测说话者的意思,就是语音识别。

这样说来,如果接收端是一台计算机而不是人的话,那么计算机要做的就是语音的自动识别。

同样,在计算机中,如果我们要根据接收到的英语信息,推测说话者的汉语意思,就是机器翻译;如果我们要根据带有拼写错误的语句推测说话者想表达的正确意思,那就是自动纠错。

那么怎么根据接收到的信息来推测说话者想表达的意思呢?我们可以利用叫做“隐含马尔可夫模型”(Hidden Markov Model)来解决这些问题。

以语音识别为例,当我们观测到语音信号o1,o2,o3 时,我们要根据这组信号推测出发送的句子s1,s2,s3。

显然,我们应该在所有可能的句子中找最有可能性的一个。

用数学语言来描述,就是在已知o1,o2,o3,...的情况下,求使得条件概率

P (s1,s2,s3,...|o1,o2,o3....) 达到最大值的那个句子s1,s2,s3,...

当然,上面的概率不容易直接求出,于是我们可以间接地计算它。

利用贝叶斯公式并且省掉一个

常数项,可以把上述公式等价变换成

P(o1,o2,o3,...|s1,s2,s3....) * P(s1,s2,s3,...)

其中

P(o1,o2,o3,...|s1,s2,s3....) 表示某句话s1,s2,s3...被读成o1,o2,o3,...的可能性, 而

P(s1,s2,s3,...) 表示字串s1,s2,s3,...本身能够成为一个合乎情理的句子的可能性,所以这个公式的意义是用发送信号为s1,s2,s3...这个数列的可能性乘以s1,s2,s3...本身可以一个句子的可能性,得出概率。

(读者读到这里也许会问,你现在是不是把问题变得更复杂了,因为公式越写越长了。

别着急,我们现在就来简化这个问题。

)我们在这里做两个假设:

第一,s1,s2,s3,... 是一个马尔可夫链,也就是说,si 只由si-1 决定(详见系列一);

第二,第i 时刻的接收信号oi 只由发送信号si 决定(又称为独立输出假设, 即P(o1,o2,o3,...|s1,s2,s3....) = P(o1|s1) * P(o2|s2)*P(o3|s3)...。

那么我们就可以很容易利用算法Viterbi 找出上面式子的最大值,进而找出要识别的句子s1,s2,s3,...。

满足上述两个假设的模型就叫隐含马尔可夫模型。

我们之所以用“隐含”这个词,是因为状态s1,s2,s3,...是无法直接观测到的。

隐含马尔可夫模型的应用远不只在语音识别中。

在上面的公式中,如果我们把s1,s2,s3,...当成中文,把o1,o2,o3,...当成对应的英文,那么我们就能利用这个模型解决机器翻译问题;如果我们把o1,o2,o3,...当成扫描文字得到的图像特征,就能利用这个模型解决印刷体和手写体的识别。

P (o1,o2,o3,...|s1,s2,s3....) 根据应用的不同而又不同的名称,在语音识别中它被称为“声学模型” (Acoustic Model),在机器翻译中是“翻译模型” (Translation Model) 而在拼写校正中是“纠错模型” (Correction Model)。

而P (s1,s2,s3,...) 就是我们在系列一中提到的语言模型。

在利用隐含马尔可夫模型解决语言处理问题前,先要进行模型的训练。

常用的训练方法由伯姆(Baum)在60年代提出的,并以他的名字命名。

隐含马尔可夫模型在处理语言问题早期的成功应用是语音识别。

七十年代,当时IBM 的Fred Jelinek (贾里尼克) 和卡内基·梅隆大学的Jim and Janet Baker (贝克夫妇,李开复的师兄师姐) 分别独立地提出用隐含马尔可夫模型来识别语音,语音识别的错误率相比人工智能和模式匹配等方法降低了三倍(从30% 到10%)。

八十年代李开复博士坚持采用隐含马尔可夫模型的框架,成功地开发了世界上第一个大词汇量连续语音识别系统Sphinx。

我最早接触到隐含马尔可夫模型是几乎二十年前的事。

那时在《随机过程》(清华“著名”的一门课)里学到这个模型,但当时实在想不出它有什么实际用途。

几年后,我在清华跟随王作英教授学习、研究语音识别时,他给了我几十篇文献。

我印象最深的就是贾里尼克和李开复的文章,它们的核心思想就是隐含马尔可夫模型。

复杂的语音识别问题居然能如此简单地被表述、解决,我由衷地感叹数学模型之妙。