apache Tez调研笔记

hadoop分布式实验总结

hadoop分布式实验总结Hadoop分布式实验总结一、实验目标本次实验的目标是深入理解Hadoop分布式文件系统(HDFS)和MapReduce计算模型,通过实际操作和案例分析,掌握Hadoop的基本原理和应用。

二、实验内容在本次实验中,我们主要完成了以下几个部分的内容:1. HDFS的基本操作:包括在HDFS中创建文件夹、上传和下载文件等。

2. MapReduce编程:编写Map和Reduce函数,实现对数据的处理和分析。

3. Hadoop集群搭建:配置Hadoop集群,了解节点间的通信和数据传输机制。

4. 性能优化:通过调整参数和优化配置,提高Hadoop集群的性能。

三、实验过程1. HDFS操作:首先,我们在本地机器上安装了Hadoop,并启动了HDFS。

然后,我们通过Hadoop命令行工具对HDFS进行了基本的操作,包括创建文件夹、上传和下载文件等。

在操作过程中,我们遇到了权限问题,通过修改配置文件解决了问题。

2. MapReduce编程:我们选择了一个经典的问题——单词计数作为案例,编写了Map和Reduce函数。

在编写过程中,我们了解了MapReduce的基本原理和编程模型,以及如何处理数据的分片和shuffle过程。

3. Hadoop集群搭建:我们在实验室的局域网内搭建了一个Hadoop集群,配置了各个节点之间的通信和数据传输。

在配置过程中,我们注意到了防火墙和网络通信的问题,通过调整防火墙规则和配置网络参数,解决了问题。

4. 性能优化:我们对Hadoop集群进行了性能优化,通过调整参数和优化配置,提高了集群的性能。

我们了解到了一些常用的优化方法,如调整数据块大小、优化网络参数等。

四、实验总结通过本次实验,我们深入了解了Hadoop分布式文件系统和MapReduce计算模型的基本原理和应用。

在实验过程中,我们遇到了一些问题,但通过查阅资料和互相讨论,最终解决了问题。

通过本次实验,我们不仅掌握了Hadoop的基本操作和编程技能,还提高了解决实际问题的能力。

hadoop伪分布式心得 -回复

hadoop伪分布式心得-回复Hadoop伪分布式心得在进行大数据处理和分析时,Hadoop已经成为了一个非常有用的工具。

作为一个分布式计算框架,Hadoop的设计目标是能够处理大规模数据集,并提供高度可靠性和灵活性。

通过将数据分散存储和计算任务分布到多个计算节点上,Hadoop能够优化计算资源的使用,并加速数据处理的速度。

而在学习和使用Hadoop的过程中,我选择了使用Hadoop的伪分布式模式进行实验。

以下是我在使用Hadoop伪分布式模式期间的心得体会。

首先,我发现Hadoop伪分布式模式是入门学习Hadoop非常理想的选择。

相较于完全分布式模式,伪分布式模式搭建和配置的过程要简单得多。

在伪分布式模式下,我们只需要在一台机器上安装和配置Hadoop组件,就可以模拟出一个具有多节点的分布式环境。

这大大减少了我们的部署时间和成本。

同时,由于伪分布式模式只使用了一台计算机,我们不需要处理节点之间的网络通信和资源调度问题,能够更专注地学习和理解Hadoop的核心原理和机制。

其次,通过在Hadoop伪分布式模式下进行实验,我能够更好地理解Hadoop的组件和架构。

在学习Hadoop的过程中,我逐渐掌握了Hadoop的核心组件,如HDFS(分布式文件系统)和MapReduce(分布式计算框架)。

在伪分布式模式下,我能够直接操作和管理Hadoop的核心组件,这加深了我对Hadoop的理解。

例如,我学会了如何通过hdfs 命令进行文件的上传和下载,以及如何通过yarn命令提交和监控MapReduce作业的运行状况。

这些实践使我对Hadoop的管理和操作变得更加熟练,为以后的工作和学习打下了坚实的基础。

另外,Hadoop伪分布式模式也为我提供了一个良好的平台,用于开发和测试自己的Hadoop应用程序。

通过在伪分布式模式下搭建Hadoop集群,我能够将自己编写的MapReduce作业提交到Hadoop集群中进行运行。

hadoop安装实验总结

hadoop安装实验总结Hadoop安装实验总结Hadoop是一个开源的分布式计算框架,用于处理大规模数据集。

在本次实验中,我成功安装了Hadoop,并进行了相关的配置和测试。

以下是我对整个过程的总结和经验分享。

1. 环境准备在开始安装Hadoop之前,我们需要确保已经具备了以下几个环境条件:- 一台Linux操作系统的机器,推荐使用Ubuntu或CentOS。

- Java开发环境,Hadoop是基于Java开发的,因此需要安装JDK。

- SSH服务,Hadoop通过SSH协议进行节点之间的通信,因此需要确保SSH服务已启动。

2. 下载和安装Hadoop可以从Hadoop官方网站上下载最新的稳定版本。

下载完成后,解压缩到指定目录,并设置环境变量。

同时,还需要进行一些配置,包括修改配置文件和创建必要的目录。

3. 配置Hadoop集群Hadoop是一个分布式系统,通常会配置一个包含多个节点的集群。

在配置文件中,我们需要指定集群的各个节点的IP地址和端口号,并设置一些重要的参数,如数据存储路径、副本数量等。

此外,还可以根据实际需求调整其他配置参数,以优化集群性能。

4. 启动Hadoop集群在完成集群配置后,我们需要启动Hadoop集群。

这一过程需要先启动Hadoop的各个组件,包括NameNode、DataNode、ResourceManager和NodeManager等。

启动成功后,可以通过Web 界面查看集群的状态和运行情况。

5. 测试Hadoop集群为了验证Hadoop集群的正常运行,我们可以进行一些简单的测试。

例如,可以使用Hadoop提供的命令行工具上传和下载文件,查看文件的副本情况,或者运行一些MapReduce任务进行数据处理。

这些测试可以帮助我们了解集群的性能和可靠性。

6. 故障排除与优化在实际使用Hadoop时,可能会遇到一些故障和性能问题。

为了解决这些问题,我们可以通过查看日志文件或者使用Hadoop提供的工具进行故障排查。

hadoop实验报告总结

hadoop实验报告总结Hadoop是一个大数据处理框架,它可以处理 petabyte 级别的数据存储和处理。

在大数据时代,Hadoop 的使用越来越普及,因此学习和掌握 Hadoop 成为了当今大数据从业人员的必修课。

本实验报告旨在介绍 Hadoop 的使用,以及在使用过程中所遇到的问题和解决方法。

我们需要了解 Hadoop 的基本架构。

Hadoop 的基本组成部分包括 HDFS(Hadoop Distributed File System),MapReduce,YARN(Yet Another Resource Negotiator)等。

HDFS 是一个用于存储和管理大数据的分布式文件系统,MapReduce 是一种用于分布式数据处理的编程模型,YARN 则是一个资源管理系统。

这三个组成部分相互配合,使得Hadoop 可以完成大数据存储和处理的任务。

在本次实验中,我们主要使用 HDFS 和 MapReduce 进行操作。

在使用 HDFS 进行操作之前,我们需要了解 HDFS 的基本概念和几个关键点。

HDFS 的文件以块的形式存储在不同的数据节点中,每个块的大小默认为 128MB。

每个文件至少会存储在三个数据节点中,以确保数据的容错性和高可用性。

HDFS 还具有很好的扩展性,可以根据需要增加更多的数据节点。

在使用 HDFS 进行操作时,我们可以使用 Hadoop 自带的命令行界面或者使用 GUI工具,如 Apache Ambari。

在本次实验中,我们使用了 Hadoop 自带的命令行界面进行操作。

在操作中,我们通过以下几个步骤实现了文件的上传、下载和删除操作:1. 使用命令 `hdfs dfs -put` 上传文件到 HDFS 上。

2. 使用命令 `hdfs dfs -get` 从 HDFS 上下载文件到本地。

3. 使用命令 `hdfs dfs -rm` 删除 HDFS 上的文件。

在使用 HDFS 时还需要注意以下几个关键点:1. 在上传文件时需要指定文件的大小和副本数,默认情况下副本数为 3。

apache Tez调研笔记

1.什么就是Apache TezTez就是Apache最新得支持DAG作业得开源计算框架,它可以将多个有依赖得作业转换为一个作业从而大幅提升DAG作业得性能。

Tez并不直接面向最终用户——它允许开发者为最终用户构建性能更快、扩展性更好得应用程序。

Hadoop传统上就是一个大量数据批处理平台。

但就是,有很多用例需要近乎实时得查询处理性能。

还有一些工作则不太适合MapReduce,例如机器学习。

Tez 得目得就就是帮助Hadoop处理这些用例场景。

Tez项目得目标就是支持高度定制化,这样它就能够满足各种用例得需要,让人们不必借助其她得外部方式就能完成自己得工作。

它直接源于MapReduce框架,核心思想就是将Map与Reduce两个操作进一步拆分,即Map被拆分成Input、Processor、Sort、Merge与Output, Reduce被拆分成Input、Shuffle、Sort、Merge、Processor与Output等,这样,这些分解后得元操作可以任意灵活组合,产生新得操作,这些操作经过一些控制程序组装后,可形成一个大得DAG作业。

总结起来,Tez有以下特点:1)运行在yarn上;2)适用于DAG(有向图)应用(可与hive与pig结合);具有表现力得数据流API——Tez团队希望通过一套富有表现力得数据流定义API让用户能够描述她们所要运行计算得有向无环图(DAG)。

为了达到这个目得,Tez实现了一个结构化类型得API,您可以在其中添加所有得处理节点与边,并可视化实际构建得图形;下图就是一个实现terasort(分布式排序)过程得流程图:灵活得输入—处理器—输出(Input-Processor-Output)运行时模型——可以通过连接不同得输入、处理器与输出动态地构建运行时执行器;Tez将用户数据流图得每个顶点瞧作就是一个input-processor-output模型。

Input&output决定了数据得格式与怎样得被读取与写入,processor就是对数据得处理逻辑。

apaphe笔记

apache单ip多域名多目录配置自己的vps上放了别人的网站,那怎么样让自己的网站和别人的网站能同时被访问呢?需要使用apache的虚拟主机配置。

配置httpd.conf文件比如原来是这种只是指向一个目录的配置DocumentRoot "/opt/lampp/htdocs/ppe112"<Directory "/opt/lampp/htdocs/ppe112">## Possible values for the Options directive are "None", "All",# or any combination of:# Indexes Includes FollowSymLinks SymLinksifOwnerMatch ExecCGI MultiViews## Note that "MultiViews" must be named *explicitly* --- "Options All" # doesn't give it to you.## The Options directive is both complicated and important. Please see# /docs/trunk/mod/core.html#options# for more information.##Options Indexes FollowSymLinks# XAMPPOptions Indexes FollowSymLinks ExecCGI Includes## AllowOverride controls what directives may be placed in .htaccess files.# It can be "All", "None", or any combination of the keywords:# Options FileInfo AuthConfig Limit##AllowOverride None# since XAMPP 1.4:AllowOverride All## Controls who can get stuff from this server.#Require all granted</Directory>把这段话变成<VirtualHost 198.199.107.XXX> #这里填主机的ip地址ServerName DocumentRoot "/opt/lampp/htdocs/AAA"<Directory "/opt/lampp/htdocs/AAA">## Possible values for the Options directive are "None", "All", # or any combination of:# Indexes Includes FollowSymLinks SymLinksifOwnerMatch ExecCGI MultiViews## Note that "MultiViews"must be named *explicitly* --- "Options All"# doesn't give it to you.## The Options directive is both complicated and important. Please see# /docs/trunk/mod/core.html#options# for more information.##Options Indexes FollowSymLinks# XAMPPOptions Indexes FollowSymLinks ExecCGI Includes## AllowOverride controls what directives may be placedin .htaccess files.# It can be "All", "None", or any combination of the keywords: # Options FileInfo AuthConfig Limit##AllowOverride None# since XAMPP 1.4:AllowOverride All## Controls who can get stuff from this server.#Require all granted</Directory></VirtualHost><VirtualHost 198.199.107.XXX> #这里填主机的ip地址ServerName DocumentRoot "/opt/lampp/htdocs/BBB"<Directory "/opt/lampp/htdocs/BBB">## Possible values for the Options directive are "None", "All", # or any combination of:# Indexes Includes FollowSymLinks SymLinksifOwnerMatch ExecCGI MultiViews## Note that "MultiViews"must be named *explicitly* --- "Options All"# doesn't give it to you.## The Options directive is both complicated and important. Please see# /docs/trunk/mod/core.html#options# for more information.##Options Indexes FollowSymLinks# XAMPPOptions Indexes FollowSymLinks ExecCGI Includes## AllowOverride controls what directives may be placedin .htaccess files.# It can be "All", "None", or any combination of the keywords: # Options FileInfo AuthConfig Limit##AllowOverride None# since XAMPP 1.4:AllowOverride All## Controls who can get stuff from this server. #Require all granted</Directory></VirtualHost>。

JSTORM使用笔记

JSTORM使用笔记简单快速的传输层框架,安装如下:wget /zeromq-2.1.7.tar.gz tar zxf zeromq-2.1.7.tar.gzcd zeromq-2.1.7./configuremakesudo make installsudo ldconfig应该是zmq的java包吧,安装步骤如下:git clone git:///nathanmarz/jzmq.gitcd jzmq./autogen.sh./configuremakemake install针对大型分布式系统提供配置维护、名字服务、分布式同步、组服务等,可以保证:1.顺序性:客户端的更新请求都会被顺序处理2.原子性:更新操作要不成功,要不失败3.一致性:客户端不论连接到那个服务端,展现给它的都是同一个视图4.可靠性:更新会被持久化5.实时性:对于每个客户端他的系统视图都是最新的在zookeeper中有几种角色:1.Leader:发起投票和决议,更新系统状态2.Follower:响应客户端请求,参与投票3.Observer:不参与投票,只同步Leader状态4.Client:发起请求在启动之前需要在conf下编写zoo.cfg配置文件,里面的内容包括:1.tickTime:心跳间隔2.initLimit:Follower和Leader之间建立连接的最大心跳数3.syncLimit:Follower和Leader之间通信时限4.dataDir:数据目录5.dataLogDir:日志目录6.minSessionTimeout:最小会话时间(默认tickTime * 2)7.maxSessionTimeout:最大会话时间(默认tickTime * 20)8.maxClientCnxns:客户端数量9.clientPort:监听客户端连接的端口10.server.N=YYYY:A:B:其中N为服务器编号,YYYY是服务器的IP地址,A是Leader和Follower通信端口,B为选举端口在单机的时候可以直接将zoo_sample.cfg修改为zoo.cfg,然后使用启动服务即可(如果报错没有目录,手动创建即可):sudo ./zkServer.sh start现在用netstat -na(或者是./zkCli.sh 127.0.0.1:2181)就能看到在监听指定的端口,那么zookeeper现在起来了。

第2章-Hadoop初体验

6、Pig Pig是一种数据流语言和运行环境,用于检索非常大的数据集。 Pig为大型数据集的处理提供了一个更高层次的抽象。与 MapReduce相比,Pig提供了更丰富的数据结构,还提供了一 套更强大的数据变换操作。Pig Latin语言的编译器会把类SQL 的数据分析请求转换为一系列经过优化处理的MapReduce运算。 Pig为复杂的海量数据并行计算提供了一个简单的操作和编程的 接口。

9、Sqoop Sqoop是Apache 旗下一款适用于Hadoop和关系型数据库服务 器之间传送数据的开源工具。通过Sqoop,可以方便地将数据 从MySQL,Oracle等关系数据库中导入到Hadoop的 HDFS、 Hive、HBase 等数据存储系统,也可以将数据从Hadoop的文 件系统中导出到mysql等关系数据库中,使得Hadoop和传统关 系数据库之间的数据迁移变得非常方便。

来增加其存储能力。

5、Hive(数据仓库) Hive是基于Hadoop的一个数据仓库工具,并提供简单的类 SQL的HiveQL 语言实现查询功能,可以将类SQL语句转换为 MapReduce任务进行运行。 其优点是学习成本低,可以通过 类SQL语句快速实现简单的MapReduce统计,不必开发专门的 MapReduce应用,减少开发人员的学习成本,主要适ut Mahout 是 Apache软件基金会旗下的一个开源项目,是 Hadoop系统基于MapReduce开发的数据挖掘/机器学习库,提 供一些可扩展的数据挖掘/机器学习领域经典算法的实现,旨在 帮助开发人员更加方便快捷地创建智能应用程序。Mahout实现 了大部分常用的数据挖掘算法,包括聚类、分类、推荐、频繁

3、 Hadoop优势 (3)高效性。 Hadoop以并行的方式工作,通过大规模的并行处理来加快 数据的处理速度,并保证各个节点的动态平衡,因此保证 了集群的整体处理速度。

Apache与网络监控与调整总结

Apache与网络监控与调整总结Apache与网络监控与调整总结Apache监控与调整总结1.监控关注点1.1.配置监控/opt/IBMIHS/conf/httpd.confStartServers:控制进程在最初建立MinSpareServers:最少空闲的进程MaxSpareServers:最大空闲的进程ServerLimit20xx:最大进程数MaxClients1000:设定的是Apache可以同时处理的请求MaxRequestsPerChild:置的是每个子进程可处理的请求数/opt/IBMIHS/logsaccess_log2.常用监控工具1.找到conf/httpd.conf文件。

===============================================2.修改httpd.conf。

(1)ForWindowsa)去掉LoadModulestatus_modulemodules/ApacheModuleStatus.dll前面的注释。

b)去掉SetHandlerserver-statusorderdeny,allowdenyfromallallowfrom127.0.0.1#Onlylocalhostisallowedtolaunchthestatuspage注释改成SetHandlerserver-status=======================================(2)ForUnixPlatforma)打开LoadModulestatus_modulemodules/mod_status.so注释ExtendedStatusOnb)==================================================3.重启IHS===================================================4.访问-status3.监控脚本使用方法:./apacheMon.sh10180取样间隔为10s,180次另外,在脚本中需要设置服务器的IP地址,或者设置从哪个网卡取4.各参数解释Networks监控1.监控连接数1)某IP地址的连接数:netstat-an|grep218.61.149|grepESTABLISHED|wcl 2)网络流量监控脚本:扩展阅读:SiteScope监控:apache本来监控apache通过早期版本的Lr的可以很好的完成。

hadoop面试题目(3篇)

第1篇一、Hadoop基础知识1. 请简述Hadoop的核心组件及其作用。

2. 什么是Hadoop生态系统?列举出Hadoop生态系统中的主要组件。

3. 什么是MapReduce?请简述MapReduce的原理和特点。

4. 请简述Hadoop的分布式文件系统HDFS的架构和特点。

5. 什么是Hadoop的YARN?它有什么作用?6. 请简述Hadoop的HBase、Hive、Pig等组件的特点和应用场景。

7. 什么是Hadoop的集群部署?请简述Hadoop集群的部署流程。

8. 什么是Hadoop的分布式缓存?请简述其作用和实现方式。

9. 什么是Hadoop的MapReduce作业?请简述MapReduce作业的执行流程。

10. 请简述Hadoop的HDFS数据复制策略。

11. 什么是Hadoop的NameNode和DataNode?它们各自有什么作用?12. 请简述Hadoop的HDFS数据写入和读取过程。

13. 什么是Hadoop的Zookeeper?它在Hadoop集群中有什么作用?14. 请简述Hadoop的HDFS数据块的校验和机制。

15. 什么是Hadoop的HDFS数据恢复机制?二、Hadoop核心组件面试题1. 请简述Hadoop的MapReduce组件的架构和执行流程。

2. 请简述Hadoop的HDFS数据块的读写过程。

3. 请简述Hadoop的YARN资源调度器的工作原理。

4. 请简述Hadoop的HBase组件的架构和特点。

5. 请简述Hadoop的Hive组件的架构和特点。

6. 请简述Hadoop的Pig组件的架构和特点。

7. 请简述Hadoop的Zookeeper组件的架构和特点。

8. 请简述Hadoop的HDFS数据块的复制策略。

9. 请简述Hadoop的HDFS数据块的校验和机制。

10. 请简述Hadoop的HDFS数据恢复机制。

三、Hadoop高级面试题1. 请简述Hadoop集群的故障转移机制。

伪分布的实验报告

一、实验名称伪分布式实验二、实验目的1. 了解伪分布式Hadoop的基本原理和架构;2. 掌握Hadoop伪分布式环境的搭建步骤;3. 熟悉Hadoop伪分布式环境下HDFS和YARN的基本操作。

三、实验原理伪分布式Hadoop是一种简化版的分布式计算环境,它将所有的Hadoop服务(如HDFS、YARN、MapReduce等)运行在一个单台机器上。

在这种环境下,可以方便地研究Hadoop的分布式存储和计算机制,而不需要购买和维护多台服务器。

伪分布式Hadoop主要由以下几个组件组成:1. Hadoop分布式文件系统(HDFS):负责存储海量数据;2. Yet Another Resource Negotiator(YARN):负责资源管理和任务调度;3. MapReduce:Hadoop的并行计算框架。

四、实验环境1. 操作系统:Linux;2. Java开发环境:JDK 1.8;3. Hadoop版本:Hadoop 3.3.4。

五、实验步骤1. 安装Java开发环境(1)下载JDK 1.8安装包;(2)解压安装包至指定目录;(3)配置环境变量,使Java命令可以在任意位置执行。

2. 安装Hadoop(1)下载Hadoop 3.3.4安装包;(2)解压安装包至指定目录;(3)配置Hadoop环境变量,使Hadoop命令可以在任意位置执行;(4)配置Hadoop配置文件。

3. 配置Hadoop配置文件(1)编辑`hadoop-env.sh`文件,设置JDK路径;(2)编辑`core-site.xml`文件,配置HDFS的存储路径;(3)编辑`hdfs-site.xml`文件,配置HDFS副本数量等参数;(4)编辑`mapred-site.xml`文件,配置MapReduce相关参数;(5)编辑`yarn-site.xml`文件,配置YARN相关参数。

4. 格式化HDFS在Hadoop命令行中执行以下命令:```hdfs dfs -format```5. 启动Hadoop服务在Hadoop命令行中执行以下命令:```start-dfs.shstart-yarn.sh```6. 验证Hadoop服务在浏览器中访问`http://localhost:50070`,查看HDFS的Web界面;在浏览器中访问`http://localhost:8088`,查看YARN的Web界面。

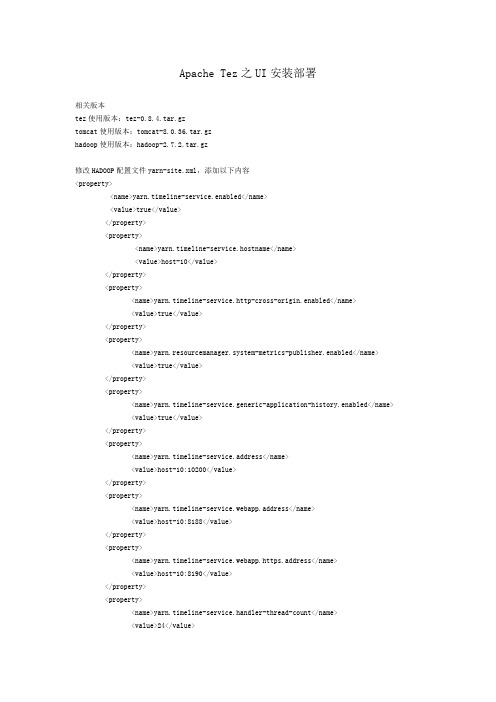

ApacheTez之UI安装部署

Apache Tez之UI安装部署相关版本tez使用版本:tez-0.8.4.tar.gztomcat使用版本:tomcat-8.0.36.tar.gzhadoop使用版本:hadoop-2.7.2.tar.gz修改HADOOP配置文件yarn-site.xml,添加以下内容<property><name>yarn.timeline-service.enabled</name><value>true</value></property><property><name>yarn.timeline-service.hostname</name><value>host-10</value></property><property><name>yarn.timeline-service.http-cross-origin.enabled</name><value>true</value></property><property><name>yarn.resourcemanager.system-metrics-publisher.enabled</name><value>true</value></property><property><name>yarn.timeline-service.generic-application-history.enabled</name> <value>true</value></property><property><name>yarn.timeline-service.address</name><value>host-10:10200</value></property><property><name>yarn.timeline-service.webapp.address</name><value>host-10:8188</value></property><property><name>yarn.timeline-service.webapp.https.address</name><value>host-10:8190</value></property><property><name>yarn.timeline-service.handler-thread-count</name><value>24</value></property><property><name>yarn.timeline-service.leveldb-timeline-store.path</name><value>/home/dataplat/hadoop-2.7.2/filesystem/yarn/timeline/</value></property>修改配置文件tez-site.xml,添加一下内容<property><name>tez.history.logging.service.class</name><value>org.apache.tez.dag.history.logging.ats.ATSHistoryLoggingService</value> </property><property><name>tez.allow.disabled.timeline-domains</name><value>true</value></property><property><name>tez.tez-ui.history-url.base</name><value>http://host-10:8080/tez-ui-0.8.4</value></property>启动timelineserverhadoop-2.7.2$ sbin/yarn-daemon.sh start timelineserver拷贝tez目录下tez-ui-0.8.4.war包到Tomcat的webapps目录$ cp tez-0.8.4/tez-ui-0.8.4.war tomcat-8.0.36/webapps/修改scripts目录下的configs.js文件,取消timelineBaseUrl、RMWebUrl注释,改为指定地址timelineBaseUrl: 'http://192.168.0.115:8188'RMWebUrl: 'http://192.168.0.115:8088'重启Tomcat,页面访问http://host-10:8080/tez-ui-0.8.4即可看到tez-ui界面。

使用apache ignite加工指标-概述说明以及解释

使用apache ignite加工指标-概述说明以及解释1.引言1.1 概述概述部分的内容可以描述本文的主题和目标,以及介绍使用Apache Ignite加工指标的背景和意义。

以下是一个可能的概述部分的内容:在当今的数据驱动时代,企业面临着海量数据的挑战。

数据的产生速度和规模不断增加,对数据处理和分析能力提出了更高的要求。

为了从这些海量数据中提取有价值的信息和洞察,数据加工在企业中变得越来越重要。

Apache Ignite作为一个开源的分布式数据库和计算平台解决方案,提供了强大的功能和灵活性,为企业实现高速的数据处理和分析提供了良好的支持。

它具有高度可扩展性、低延迟的特点,能够处理大规模数据集,并通过并行计算和内存加速技术实现快速的数据加工。

本文旨在介绍如何使用Apache Ignite加工指标,即通过对数据进行处理和计算,从中获取有意义的指标和结果。

首先,我们将简要介绍Apache Ignite的特点和优势,包括其分布式架构和内存计算能力。

然后,我们将详细探讨使用Apache Ignite进行数据加工的优势和方法,包括数据存储和处理的设计原则以及常用的加工指标计算方法。

通过阅读本文,读者将了解如何利用Apache Ignite高效地加工大规模数据,并且能够为企业决策和业务发展提供有力的支持。

本文将结合实际案例和应用场景,帮助读者理解和应用Apache Ignite在数据加工方面的优势和价值。

通过使用Apache Ignite加工指标,企业能够更好地把握数据的力量,提高决策的准确性和效率,进而实现业务的增长和竞争优势。

因此,深入了解和掌握Apache Ignite的加工指标功能对于现代企业来说是至关重要的。

1.2文章结构1.2 文章结构本文将按以下结构展开讨论使用Apache Ignite加工指标的优势。

了解整体的文章结构将有助于读者更好地理解本文的内容。

第2节将介绍Apache Ignite的简介,包括它的基本概念和功能。

2018年apache日志解析-word范文 (5页)

本文部分内容来自网络整理,本司不为其真实性负责,如有异议或侵权请及时联系,本司将立即删除!== 本文为word格式,下载后可方便编辑和修改! ==apache日志解析篇一:apache的日志解析总结版web 服务器日志配置和分析详解从某种程度上将”日志就是金钱”,因为通过日志能够分析出一个网站具有高流量,则广告商愿意为其支付费用。

对于所有的公司或 ICP 来说,除了要保证网站稳定正常的运行以外,一个重要的问题就是网站访问量的统计和分析报表,这对于了解和监控网站的运行状态,提高各个网站的服务能力和服务水平是必不可少的。

而这些要求都可以通过对Web 服务器日志文件的统计和分析来实现。

一、web 日志分析原理web 服务器日志记录了 Web 服务器接收处理请求及运行时错误等各种原始信息。

通过对日志进行统计、分析和综合,就能有效地掌握服务器的运行状况、发现和排除错误原因、了解客户访问分布等,更好地加强系统的维护和管理。

Web 服务模式主要有三个步骤:服务请求,包含用户端的众多基本信息,如 IP 地址、浏览器类型、目标 URL 等。

服务响应,Web 服务器接收到请求后,按照用户要求运行相应的功能,并将信息返回给用户。

如果出现错误,将返回错误代码。

追加日志,服务器将对用户访问过程中的相关信息以追加的方式保存到日志文件中。

如图 1 。

图 1 Web 服务模式主要有三个步骤二、Apache 日志的配置1、日志类型 1.3 版本 Apache 的标准中规定了 4 类日志:? ? ? ?错误日志访问日志传输日志 Cookie 日志其中:传输日志和 Cookie 日志被 Apache 2.0 认为已经过时。

所以本文仅讨论错误日志和访问日志。

同时错误日志和访问日志被 Apache 2.0 默认设置。

错误日志包含:获知失效链接获知 CGI 错误获知用户认证错误访问日志包含:访问服务器的远程机器的地址:可以得知浏览者来自何方浏览者访问的资源:可以得知网站中的哪些部分最受欢迎浏览者的浏览时间:可以从浏览时间(如工作时间或休闲时间)对网站内容进行调整浏览者使用的浏览器:可以根据大多数浏览者使用的浏览器对站点进行优化访问日志分类:为了便于分析 Apache 的访问日志,Apache 的默认配置文件中,按记录的信息不同(用不同格式昵称说明不同的信息)将访问日志分为 4 类:普通日志格式(common log format,CLF)common 参考日志格式(referer log format)referrer 代理日志格式(agent logformat)agent 2、配置访问日志命令 CustomLog 命令用来对服务器的请求进行日志记录。

apache-atlas深度剖析

apache-atlas深度剖析atlas 是apache下的⼤数据的元数据管理和数据治理平台,是Hadoop社区为解决Hadoop⽣态系统的元数据治理问题⽽产⽣的开源项⽬,它为Hadoop集群提供了包括数据分类、集中策略引擎、数据⾎缘、安全和⽣命周期管理在内的元数据治理核⼼能⼒。

⽀持对hive、storm、kafka、hbase、sqoop等进⾏元数据管理以及以图库的形式展⽰数据的⾎缘关系。

• 各种Hadoop和⾮Hadoop元数据的预定义类型• 为要管理的元数据定义新类型的能⼒• 类型可以具有原始属性、复杂属性、对象引⽤;可以从其他类型继承。

• 类型的实例,称为实体,捕获元数据对象细节及其关系• REST API与类型和实例⼀起⼯作更容易集成• 动态创建分类的能⼒,如PII、ExIPRESION、DATAAL质量、敏感• 分类可以包括属性,如EXPIRES_ON分类中的expiry_date 属性• 实体可以与多个分类相关联,从⽽能够更容易地发现和安全执⾏。

• 通过谱系传播分类-⾃动确保分类跟随数据经过各种处理• 直观的UI,以查看数据的传承,因为它通过各种处理• REST API访问和更新⾎统• 通过类型、分类、属性值或⾃由⽂本搜索实体的直观UI• 丰富的 REST API 实现复杂的标准搜索• 搜索实体的SQL类查询语⾔——领域特定语⾔(DSL)• ⽤于元数据访问的细粒度安全性,允许对实体实例和操作(如添加/更新/删除分类)的访问进⾏控制• 与Apache Ranger的集成使得基于与Apache Atlas中的实体相关联的分类的数据访问的授权/数据屏蔽成为可能。

例如:• 谁可以访问被分类为PII、敏感的数据• 客户服务⽤户只能看到被列为国家标识的列的最后4位数字⼀、架构整体架构实现如下图所⽰:Type System: Atlas allows users to define a model for the metadata objects they want to manage. The model is composed of definitions called ‘types’. Instances of ‘types’ called ‘entities’ represent the actual metadata objects that are managed. The Type System is a component that allows users to define and manage the types and entities. All metadata objects managed by Atlas out of the box (like Hive tables, for e.g.) are modelled using types and represented as entities. To store new types of metadata in Atlas, one needs to understand the concepts of the type system component.One key point to note is that the generic nature of the modelling in Atlas allows data stewards and integrators to define both technical metadata and business metadata. It is also possible to define rich relationships between the two using features of Atlas.Graph Engine: Internally, Atlas persists metadata objects it manages using a Graph model. This approach provides great flexibility and enables efficient handling of rich relationships between the metadata objects. Graph engine component is responsible for translating between types and entities of the Atlas type system, and the underlying graph persistence model. In addition to managing the graph objects, the graph engine also creates the appropriate indices for the metadata objects so that they can be searched efficiently. Atlas uses the JanusGraph to store the metadata objects.JanusGraph 的数据的底层存储⽀持Hbase、cassandra、embeddedcassandra、berkeleyje、inmemory(直接存储在内存中)等。

apache Tez调研笔记

1.什么是Apache TezTez是Apache最新的支持DAG作业的开源计算框架,它可以将多个有依赖的作业转换为一个作业从而大幅提升DAG作业的性能。

Tez并不直接面向最终用户——它允许开发者为最终用户构建性能更快、扩展性更好的应用程序。

Hadoop传统上是一个大量数据批处理平台。

但是,有很多用例需要近乎实时的查询处理性能。

还有一些工作则不太适合MapReduce,例如机器学习。

Tez的目的就是帮助Hadoop处理这些用例场景。

Tez项目的目标是支持高度定制化,这样它就能够满足各种用例的需要,让人们不必借助其他的外部方式就能完成自己的工作。

它直接源于MapReduce 框架,核心思想是将Map和Reduce两个操作进一步拆分,即Map被拆分成Input、Processor、Sort、Merge和Output, Reduce被拆分成Input、Shuffle、Sort、Merge、Processor和Output等,这样,这些分解后的元操作可以任意灵活组合,产生新的操作,这些操作经过一些控制程序组装后,可形成一个大的DAG作业。

总结起来,Tez有以下特点:1)运行在yarn上;2)适用于DAG(有向图)应用(可与hive和pig结合);3)具有表现力的数据流API——Tez团队希望通过一套富有表现力的数据流定义API让用户能够描述他们所要运行计算的有向无环图(DAG)。

为了达到这个目的,Tez实现了一个结构化类型的API,你可以在其中添加所有的处理节点和边,并可视化实际构建的图形;下图是一个实现terasort(分布式排序)过程的流程图:4)灵活的输入—处理器—输出(Input-Processor-Output)运行时模型——可以通过连接不同的输入、处理器和输出动态地构建运行时执行器;Tez将用户数据流图的每个顶点看作是一个input-processor-output模型。

Input&output决定了数据的格式和怎样的被读取和写入,processor是对数据的处理逻辑。

hadoopmapreducehive及数据仓库总结和体会 -回复

hadoopmapreducehive及数据仓库总结和体会-回复Hadoop, MapReduce, Hive和数据仓库总结和体会在大数据时代,数据分析和处理变得愈发重要。

Hadoop是一个基于分布式存储和计算的开源框架,MapReduce是它的一种计算模型,Hive是一个数据仓库基础设施。

在对这些工具进行学习和实践的过程中,我体会到了它们的优势和应用场景,也意识到了它们的一些缺点和限制。

首先,Hadoop作为一个分布式存储和计算框架,可以处理成千上万台机器上的大规模数据。

它的优势在于强大的可扩展性和容错能力。

Hadoop 将数据切分成小块,并存储在不同的节点上,这使得并行处理成为可能。

此外,Hadoop提供了分布式文件系统HDFS,使得存储和访问大规模数据变得更加高效和可靠。

在使用Hadoop的过程中,我学会了如何搭建Hadoop集群、管理分布式文件系统和编写MapReduce程序。

通过编写MapReduce程序,我能够在大规模数据集上进行复杂的计算和分析。

尽管Hadoop能够处理大规模数据,但编写和调试MapReduce程序并不容易。

MapReduce程序的编写需要熟悉特定的编程模型和API,例如Java中的Map和Reduce函数。

调试MapReduce程序也需要运行整个作业,这在大规模数据集上可能需要很长的时间。

此外,Hadoop对于低延迟的交互式查询支持不够好,这使得它不适合一些需要实时处理的应用场景。

为了解决Hadoop的一些限制,Hive应运而生。

Hive是一个构建在Hadoop之上的数据仓库基础设施,它提供了一个类似于SQL的查询语言HiveQL。

通过HiveQL,我们可以使用类似于传统数据库的方式来查询和分析存储在Hadoop中的数据。

同时,Hive还提供了一些优化机制,例如元数据缓存和查询统计信息,以提高查询性能。

在使用Hive的过程中,我发现Hive能够轻松地将复杂的MapReduce任务转化为简单的SQL 查询,使得数据分析变得更加方便和高效。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Apache Tez1.什么是Tez是Apache最新的支持DAG作业的开源计算框架,它可以将多个有依赖的作业转换为一个作业从而大幅提升DAG作业的性能。

Tez并不直接面向最终用户——它允许开发者为最终用户构建性能更快、扩展性更好的应用程序。

Hadoop 传统上是一个大量数据批处理平台。

但是,有很多用例需要近乎实时的查询处理性能。

还有一些工作则不太适合MapReduce,例如机器学习。

Tez的目的就是帮助Hadoop处理这些用例场景。

Tez项目的目标是支持高度定制化,这样它就能够满足各种用例的需要,让人们不必借助其他的外部方式就能完成自己的工作。

它直接源于MapReduce框架,核心思想是将Map和Reduce两个操作进一步拆分,即Map被拆分成Input、Processor、Sort、Merge和Output,Reduce被拆分成Input、Shuffle、Sort、Merge、Processor和Output等,这样,这些分解后的元操作可以任意灵活组合,产生新的操作,这些操作经过一些控制程序组装后,可形成一个大的DAG作业。

总结起来,Tez有以下特点:1)运行在yarn上;2)适用于DAG(有向图)应用(可与hive和pig结合);3)具有表现力的数据流API——Tez团队希望通过一套富有表现力的数据流定义API让用户能够描述他们所要运行计算的有向无环图(DAG)。

为了达到这个目的,Tez实现了一个结构化类型的API,你可以在其中添加所有的处理节点和边,并可视化实际构建的图形;下图是一个实现terasort(分布式排序)过程的流程图:4)灵活的输入—处理器—输出(Input-Processor-Output)运行时模型——可以通过连接不同的输入、处理器和输出动态地构建运行时执行器;Tez将用户数据流图的每个顶点看作是一个input-processor-output模型。

Input&output决定了数据的格式和怎样的被读取和写入,processor是对数据的处理逻辑。

将这些任务模型进行组装就可以形成不同功能的DAG图,连接不同processor的input&output需要互相兼容;5)数据类型无关性——仅关心数据的移动,不关心数据格式(键值对、面向元组的格式等,mr需要指定map和reduce的输入输出格式);6)}7)简单地部署——Tez完全是一个客户端应用程序,它利用了YARN的本地资源和分布式缓存;8)DAG图在运行时的优化和重新配置——分布式数据处理是具有动态的特性,不能执行前提前预知并选出最有的优化策略。

Tez可以在执行过程中通过收集tasks的信息更改数据流图。

例如下图,运行时,当获知数据量有10GB的时候,自动将reducer的数量进行更改。

Tez于2014-07-16成为apache顶级项目,目前最新的稳定版本是,最新版本是版,目前我们平台采用的是。

Apache当前有顶级项目Oozie用于DAG作业设计,但Oozie是比较高层(作业层面)的,它只是提供了一种多类型作业(比如MR程序、Hive、Pig等)依赖关系表达方式,并按照这种依赖关系提交这些作业,而Tez则不同,它在更底层提供了DAG编程接口,用户编写程序时直接采用这些接口进行程序设计,这种更底层的编程方式会带来更高的效率,举例如下:传统的MR(包括Hive,Pig和MR程序)。

假设有四个有依赖关系的MR作业(1个较为复杂的Hive SQL语句或者Pig脚本可能被翻译成4个有依赖关系的MR作业)或者用Oozie描述的4个有依赖关系的作业,运行过程如下图左边所示(其中,绿色是Reduce Task,需要写HDFS),采用tez的示意图如右边所示。

通过上面的例子可以看出,Tez可以将多个有依赖的作业转换为一个作业(这样只需写一次HDFS,且中间节点较少),从而大大提升DAG作业的性能。

原来的mapreduce作业需要执行多次的hdfs的读写。

2./的优化3.Tez. 当前YARN框架存在的问题(1)作业启用一个独立的ApplicationMasterMRv1中所有作业公用一个作业追踪器JobTracker,当JobTracker出现故障是,整个系统将不可用,且所有作业将运行失败。

与MRv1不同,YARN中每个作业启用一个独立的作业追踪器ApplicationMaster,解决了MRv1中单点故障和扩展瓶颈问题。

但这种方式引入一个新的问题:作业延迟较大,即每个作业首先要申请资源启动一个ApplicationMaster后,才可以正式启动作业,也就是说,较MRv1中的作业运行过程,YARN作业将耗费更多的计算资源和产生更长的运行延迟,这不利于运行小作业和DAG作业,尤其是DAG作业(如Hive SQL和Pig 产生的DAG作业),将需要更多的计算资源。

(2)资源无法重用在MRv1中,用户可为自己的作业设置是否启用JVM重用功能,如果启用该功能,则同一个JVM可运行多个任务,从而降低作业延迟提高作业效率。

在YARN MRAppMaster(MRAppMaster是MapReduce计算框架的ApplicationMaster)中,MRAppMaster总是为未运行的任务申请新的资源(Container),也就是时候,任务运行完成后便会释放对应的资源,并为接下来运行的任务重新申请资源(Container),而不会向MRv1那样重用资源(Container)。

Apache Tez中的优化技术为了克服当前YARN存在的问题,Apache Tez提出了一系列优化技术,其中值得一说的是ApplicationMaster缓冲池、预先启动Container和Container重用这三项技术。

(1)ApplicationMaster缓冲池在Apache Tez中,用户并不是直接将作业提交到ResouceManager上,而是提交到一个叫AMPoolServer的服务上。

该服务启动后,会预启动若干个ApplicationMaster,形成一个ApplicationMaster缓冲池,这样,当用户提交作业时,可通过AMPoolServer直接将作业提交到这些ApplicationMaster上。

这样做的好处是,避免了每个作业启动一个独立的ApplicationMaster。

>在Apache Tez中,管理员可采用参数和配置ApplicationMaster缓冲区中最小ApplicationMaster个数和最大ApplicationMaster个数。

(2)预先启动ContainerApplicationMaster缓冲池中的每个ApplicationMaster启动时可以预先启动若干个Container,以提高作业运行效率。

管理员可通过参数设置每个ApplicationMaster预启动container的数目。

(3)Container重用每个任务运行完成后,ApplicationMaster不会立即释放其占用的container,而是将其分配给其他未运行的任务,从而达到资源(Container)重用的目的。

管理员可通过参数指定是否启用Container重用功能,通过参数设置每个container重用次数。

4.Tez on HDP:在版本中已经集成了Tez,在首页右边能看到Tez的任务视图页面。

点击每个Tez的任务,能查看到DAG信息和所有对任务的描述。

如下是执行hive两表join的任务,执行语句如下:分别是表clc_test join clc_test2和clc_test2 join clc_test,DAG图如下:)图中,map1、map2不是说这里只有两个map,他们是DAG处理节点(vertex)的名称(节点Vertex的名称可以在程序中随便定义),根据输入数据量或者配置的不同,每个处理节点可以并行运行多个任务。

除节点外,在DAG图中还可以看到连接两个vertex的边的信息,看下图,Map2 到map1的边(edge)用来连接两个vertex,可以在DAG图中查看输入和输出的类型为Unordered*,map2的作用实质就是把被join的表输入到map1中去做join运算,所以数据并不需要排序。

另外由于数据量少,从map2到map1的数据移动类型(Data movement type)为broadcast,这个等同于mr里面的map join。

下面再看一个更复杂的select语句:DAG图如下图所示,map1和map2负责join,reducer3负责distinct和group by。

在HDP上通过yarn jar 运行mr和tez自带的wordcount案例,比较两个的运行时间,发现tez的整体运行时间为34秒,mr为50秒;任务的application master 和container都启动之后执行数据处理的时间,tez为6秒,mr要31秒。

启动的时候,tez多了一步DAG的启动,而且启动就花了15秒,5.Tez的实现)Tez对外提供了6种可编程组件,分别是:(1)Input:对输入数据源的抽象,它解析输入数据格式,并吐出一个个Key/value;(2)Output:对输出数据源的抽象,它将用户程序产生的Key/value写入文件系统;(3)Paritioner:对数据进行分片,类似于MR中的Partitioner;(4)Processor:对计算的抽象,它从一个Input中获取数据,经处理后,通过Output输出;(5)Task:对任务的抽象,每个Task由一个Input、Ouput和Processor组成;(6)Maser:管理各个Task的依赖关系,并按顺依赖关系执行他们。

除了以上6种组件,Tez还提供了两种算子,分别是Sort(排序)和Shuffle (洗牌),为了用户使用方便,它还提供了多种Input、Output、Task和Sort的实现。

为了展示Tez的使用方法和验证Tez框架的可用性,Apache在YARN MRAppMaster基础上使用Tez编程接口重新设计了MapReduce框架,使之可运行在YARN中。

为了减少Tez开发工作量,并让Tez能够运行在YARN之上,Tez 重用了大部分YARN 中MRAppMater的代码,包括客户端、资源申请、任务推测执行、任务启动等。

-Tez API包括以下几个组件:有向无环图(DAG)——定义整体任务。

一个DAG对象对应一个任务。

节点(Vertex)——定义用户逻辑以及执行用户逻辑所需的资源和环境。

一个节点对应任务中的一个步骤。

边(Edge)——定义生产者和消费者节点之间的连接。

边需要分配属性,对Tez而言这些属性是必须的。