RBF网络的微分进化正交最小二乘算法

径向基神经网络RBF介绍

径向基神经网络RBF介绍径向基神经网络(Radial Basis Function Neural Network,以下简称RBF神经网络)是一种人工神经网络模型。

它以径向基函数为激活函数,具有快速学习速度和较高的逼近能力,被广泛应用于函数逼近、模式识别、时间序列预测等领域。

下面将详细介绍RBF神经网络的基本原理、结构和学习算法。

1.基本原理:RBF神经网络由输入层、隐藏层和输出层组成。

输入层接收外部输入数据,隐藏层由一组径向基函数组成,输出层计算输出值。

其基本原理是通过适当的权值与径向基函数的线性组合,将输入空间映射到高维特征空间,并在该空间中进行线性回归或分类。

RBF神经网络的关键在于选择合适的径向基函数和隐藏层节点的中心点。

2.网络结构:隐藏层是RBF神经网络的核心,它由一组径向基函数组成。

每个径向基函数具有一个中心点和一个半径。

典型的径向基函数有高斯函数和多项式函数。

高斯函数的形式为:φ(x) = exp(-β*,x-c,^2)其中,β为控制函数衰减速度的参数,c为径向基函数的中心点,x为输入向量。

隐藏层的输出由输入向量与每个径向基函数的权值进行加权求和后经过激活函数得到。

输出层通常采用线性激活函数,用于输出预测值。

3.学习算法:RBF神经网络的学习算法包括两个步骤:网络初始化和权值训练。

网络初始化时需要确定隐藏层节点的中心点和半径。

常用的方法有K-means 聚类和最大极大算法。

权值训练阶段的目标是通过输入样本和对应的目标值来调整权值,使得网络的输出尽可能接近目标值。

常用的方法有最小均方误差算法(Least Mean Square,LMS)和最小二乘法。

最小均方误差算法通过梯度下降法修改权值,使网络输出的均方误差最小化。

最小二乘法则通过求解线性方程组得到最优权值。

在训练过程中,需要进行误差反向传播,根据输出误差调整权值。

4.特点与应用:RBF神经网络具有以下特点:-输入输出非线性映射能力强,可以逼近复杂的非线性函数关系;-学习速度较快,只需通过非线性映射学习输出函数,避免了反向传播算法的迭代计算;-具有较好的泛化能力,对噪声和异常数据有一定的鲁棒性。

BP神经网络以及径向基网络的研究RBF毕业论文

Chen等人提出的正交最小二乘(Orthogonal Least Squares,OLS)算法,每次选择对网络输出影响最大的输入数据作为隐节点的中心,逐个加入RBF网络中,直到适当的网络构造出来为止[23]。这种方法不存在数值病态问题,简单高效,但是选择出来的网络结构不一定是最简单的。Chen又提出了正则化正交最小二乘(Regularized orthogonal least squares, ROLS),把OLS方法和正则化方法相结合,可以训练出网络结构简单泛化、性能优越的RBF网络[24]。Mao使用OLS消除隐层各单元响应的相关性[25],从而每个RBF隐层神经元的分类能力可以分别估计,此方法选择的网络结构简洁,而且隐节点的中心具有很强的分类能力。

2006年,Barreto等人提出了RBF网络基因正交最小二乘算法[39],这个算法在同一层次上混合了正交最小二乘算法和基因算法,吸收了两原始算法的长处,训练出来的RBF网络比仅试用正交最小二乘算法训练出来的网络的泛化性能要优越,而且计算复杂度小于标准遗传算法。

(7)离群点

1995年Sánchez提出了一种针对离群点的RBF网络的鲁棒学习算法[40],用定标鲁棒代价函数(Scaled Robust Loss Function,SRLF)代替通常学习算法使用的平方代价函数,然后使用共轭梯度法完成非线性优化过程,但这种算法不能自动选择隐节点的中心。1999年Chien-Cheng等提出了一种新的鲁棒RBF神经网络[41],具有高效的学习速率,合理的网络结构,可以用于拟合常数值函数,并且对离群点具有鲁棒性。1999年,刘妹琴等提出了一种结合改进遗传算法的RBF网络鲁棒学习算法[42],可以提高RBF网络的泛化性能,消除噪声影响,揭示训练数据的潜在规律,但是该算法的复杂度比较高。

三种RBF神经网络比较分析

三种RBF神经网络比较分析摘要:径向基函数(RBF)神经网络广泛应用于模式识别、非线性函数逼近等领域。

通过对聚类、梯度、正交最小二乘三种RBF神经网络进行正弦函数逼近的仿真实验,从中比较分析这三种RBF神经网络。

得到的对比分析结果表明:正交最小二乘的方式所需的训练时间最短,网络收敛速度最快,并且不需要预先定义隐层节点数。

关键词:神经网络;径向基函数;Matlab0引言人工神经网络是一种模仿生物神经网络的结构和功能的数学模型或计算模型。

现代神经网络是一种非线性统计性数据建模工具,常用来对输入和输出间复杂的关系进行建模,或用来探索数据的模式。

RBF神经网络即径向基函数神经网络(Radical Basis Function),是由J. Moody和C. Darken于上世纪80年代末提出的一种神经网络模型。

径向基函数神经网络是一种高效的前馈式神经网络,它具有其他前向网络所不具有的最佳逼近性能和全局最优特性,并且结构简单,训练速度快。

同时,它也是一种可以广泛应用于模式识别、非线性函数逼近等领域的神经网络模型。

1RBF神经网络原理由输入层、一个隐含层(径向基层)和一个线性输出层组成的前向RBF神经网络结构如图1。

隐含层神经元是将该层权值向量w与输入向量c之间的矢量距离与偏差b相乘后作为该神经元激活函数的输入,即:Ini=(‖w-c‖·bi)2=∑n[]j=1(wji-cj)2·bi(1)若取径向基函数为高斯函数,则神经元的输出为:Outi=e-In2i=e-(‖w-c‖·bi)2=e-(∑n[]j=1(wji-cj)2·bi)2(2)由式(1)可以看出,随着和之间距离的减少,径向基函数输出值增加,且在其输入为0时,即w和c之间的距离为0时,输出为最大值1。

1.1基于聚类的RBF神经网络原理基于聚类的RBF神经网络方法最早由Broomhead and Lowe提出。

最简单形式是有固定的中心,映射属性的参数有两组:输出层权值w,和径向基函数中心c。

最小二乘算法在RBF神经网络中的应用

此 ,B R F网络 以其简单的结构 、 快速 的训练过 程和 良好 的推 广能力 等诸 多优点 已在许多应用领域取得 了巨大 的成功 , 特 别是在模式分类 和函数逼近方面 。

R F网络 中心选 取正交最 小二乘 0 s算法 , B L 解决 了径

R F网络 中所用的非线性 函数的形式对 网络性能的影 B 响并不是至关重要 的, 关键 因素是 基 函数 中心的选取 , 中心

2 R F中心选取 的正 交最d -乘算 法 B x

正交最 d - 乘 ( r ooa L atS ur-O S 法来 源 x O t gnl es q ae- L ) h

于线性 回归模型。令网络的训练样本对为 { , ” } ”= d( ) , 12 …, , , N。其 中 , 为训练样本 数 ; ∈R N 为网络 的输入 数据矢量 ; ( ) d ” ∈R’ 网络的期望输 出响应 。根据线性 回 为

选取不 当构造 出来 的 R F网络 的性 能一般 不能令人 满意。 B

例如 , 如果某 些中心靠 的太近 , 产生近似线形相关 , 会 从而带 来数值上 的病变条件。由于 R F网络中心选取是该 网络能 B

否成功用于实际的关键 , 因此下面我们主要研究径 向高斯 函 数中心 的选取算法 。

关键词 : 径向基 函数 ; 神经 网络 ; 最小二乘算法 ; 函数逼近

中 图分 类 号 : P 8 T 1 文 献标 识 码 : A

0 引言

近年来 , 随着智能技 术 的发 展 , 神经 网络理论 已得 到 了

广泛的应用 , 中前馈 网络和反馈 网络是两 种典 型的 网络模 其

y: i

图 1 R F网络 结构 B

u j= e xp

rbf神经网络原理

rbf神经网络原理RBF(RadialBasisFunction)神经网络是一种广泛应用的人工神经网络,它以其准确性和高精度被广泛应用于多种领域,其中有建模预测、模式识别和控制系统等。

本文首先介绍了RBF神经网络的基本原理,然后介绍了其优势及模式识别应用,最后重点介绍了其在控制系统研究中的应用。

RBF神经网络的原理是在一个给定的期望输出集合中,通过学习总结出一组带有可调整参数的基函数分布,以此来进行近似。

它的本质是一个二次形式的最小二乘函数:E(w)=∑i{p[i]-yd[i]^2}+∑jε{wj*hj(x)}其中p[i]是第i个观测点的期望输出,hj(x)是第j个基函数,wj是它的参数,yd[i]是第i个点的实际输出值。

基函数通常用高斯函数形式,其参数会在学习过程中不断调整,使得建模能够准确拟合实际数据。

RBF神经网络的优势在于其具有可解释性、快速学习速度、无局部极小点和可扩展性等特点,即其可以有效解决复杂的系统建模和控制问题。

在模式识别方面,由于RBF神经网络具有很高的识别精度,它被广泛用于语音识别、图像分类等复杂任务。

例如,一些研究者使用RBF神经网络来识别人脸图像,以及基于光学字符识别的文本翻译系统,其准确率高达99%。

另外,RBF神经网络也被广泛用于控制系统领域,其中包括机器人控制、动力系统控制及非线性系统的鲁棒控制和稳定控制等。

例如,研究者使用RBF神经网络设计了一种可用于机器人末端重力补偿的非线性控制器,提高了机器人对负载变化的响应效果。

总而言之,RBF神经网络具有可解释性、快速学习速度、无局部极小点和可扩展性等优势,广泛应用于各种领域,如模式识别、控制系统设计等。

通过RBF神经网络可以更好地解决复杂的实际问题,具有极大的应用价值。

RBF网络原理及应用

X1 X2

输入

R1(X)

x1

x2 0 1 0 1 R1(X) 0.3679 0.3679 0.1353 1

y 0 0 0 1 R2(X) 0.3679 0.3679 1 0.1353

∑

R2(X)

径向基神经元

− x − µ1

2

y

输出 x1 1 0 0 1 x2 0 1 0 1

1 0 0 1

a1 1

1 y = b0 + b1 (a0 * x ) + b2 (c0 + c1 * ) x2

0.811 y1 = 0.932 + 0.784* x + x2 ∧ 0.603 0.538 y2 = 1.161 + 0.920* x1 + x2

0.538 1 ∧

求出模型参数可得到如下三个非线性回归模型:

下面以1-9作为训练样本,10-12作为检验样本,采用 RBFNN方法进行预测。结果如下表.

10-12的预测值与实际值比较 10-12的预测值与实际值比较

RBFNN模型在多元非线性回归中的应用 2.2 RBFNN模型在多元非线性回归中的应用

从以上分析可知,用RBFNN方法做非线性回归的 拟合效果和预测效果都比传统回归方法好. 从上面的实例和分析可以得出如下结论: RBFNN法与传统回归方法相比,具有如下的特点: 1)避免数据的分析工作和建模工作,RBFNN能够从观测 样本中发现隐含的复杂结构。 2)能够完成复杂的输入输出非线性映射,理论上对任一 连续函数或映射可由一个三层神经网络实现。

y3 = 1.452 + 0.689* x

∧

0.538 1

0.754 + x2

基于蚂蚁算法的RBF网络参数的两阶段优化[1]

![基于蚂蚁算法的RBF网络参数的两阶段优化[1]](https://img.taocdn.com/s3/m/d84955da26fff705cc170a73.png)

K y od: i Bs Fntn F , a nto , t n a ot , m t ot itn ew rs Rd l i uco(B ) r e r a cl y rh pr e r i z i a a as i R nu l w k n o e o l im a e pm ao g a

基于蚂蚁算法的 R, a 网络参数的两阶段优化

邢桂华 朱庆保

( 京师范大学 与 机科学学院, 京 209) 南 数学 计算 南 1 7 0

E m ixh xz f o - a : yst m l g@ o. c

摘 要 提出了 一种径向基函数(B ) R F 网络中心参数仿生优化算法, 该算法基于改进的蚂蚁算法分两阶段完成。 第一阶 段为: 首先进行网络参数范围佑算, 然后根据一定的步长对网络参数区间取离散点, 最后蚂蚁根据在各个离 散点的信息 素的多少来选择路径, 从而进行网络参数优化。 第二阶段为: 利用第一阶段的结果进行局部区间扩张, 从而进行进一步优 化。用蚂蚁算法优化后的网络对典型的混沌时间序列进行预测, 结果表明其预测的各项误差低于常规的优化方法。

f t a i l ay pne, nw t t d d n ot id r p ce . e il a i p s s l e adds e e e i fm a c b pmz m e e sy h t c c o r h e o l x s c o x n s o e n a e i e o r ilT y a h s r p

了收敛速度和最优解的获得。与之相比, 本文设计的算法同样 为了克服停滞从而搜索到最优解这一 目的, 但本文的方法更直 接有效, 采用保留优秀群体的复制若干优秀解的方法以便快速 收敛 , 并且在选择时采用随机选择和概率选择交叉进行 , 这样 有利于出现更好的解以克服局部最优问题。 在实现最后达到全 局最优解方面, 本文采用的是两阶段算法, 第二阶段是在第一 阶段的基础上进行一定范围的邻域扩展, 然后再在新的搜索区 间上进行蚁群算法的重新搜索。 比较而言这种局部搜索不同于 已有解交叉策略和变异算子, 是在目 前解的基础上进行邻域的 重新搜索, 从变异的 念上来说 , 概 其获得更优解的几率更高。 文

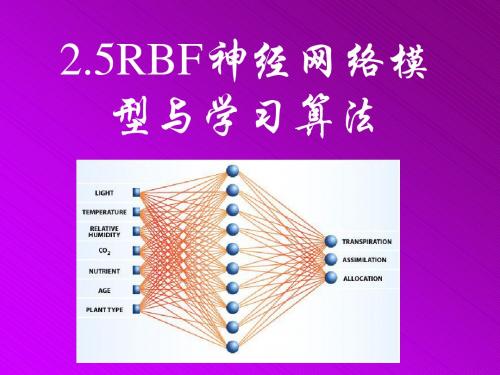

2.5RBF神经网络模型与学习算法

means聚类算法 基于质心的 k-means聚类算法

坐标表示 5 个点 { X1,X2,X3,X4,X5 } 作为一个聚类分析的 坐标表示5个点{ 二维样本: 二维样本:X1=(0,2),X2=(0,0),X3=(1.5,0), X4 = ( 5,0 ) , X5 = ( 5,2 ) . 假设要求的簇的数量k=2 . 假设要求的簇的数量 k=2 k= 第1步:由样本的随机分布形成两个簇: 由样本的随机分布形成两个簇: 随机分布形成两个簇 C1={X1,X2,X4}和C2={X3,X5}. 这两个簇的质心M1和M2是: 这两个簇的质心M 质心 M1={(0+0+5)/3,(2+0+0)/3}={1.66,0.66}; )/3,(2 )/3 66, 66} M2={(1.5+5)/2,(0+2)/2}={3.25,1.00}; {(1 25, 00}

means聚类算法 基于质心的 k-means聚类算法

1. 选择一个含有随机选择样本的 k 个簇的初始划 选择一个含有随机选择样本的k 计算这些簇的质心. 分,计算这些簇的质心. 2.根据欧氏距离把剩余的每个样本分配到距离它 最近的簇质心的一个划分. 最近的簇质心的一个划分. 3.计算被分配到每个簇的样本的均值向量,作为 计算被分配到每个簇的样本的均值向量, 新的簇的质心. 新的簇的质心. 4.重复2,3直到k个簇的质心点不再发生变化或准 重复2 直到k 则函数收敛. 则函数收敛.

means聚类算法 基于质心的 k-means聚类算法

第3步:计算新的质心(返回) 新的质心( 计算新的质心 返回) M1={0.5,0.67}; 67} e12=4.17; 17; M2={5.0,1.0}. E=6.17; 17; 相应的方差及总体平方误差分别是: 相应的方差及总体平方误差分别是: 00; e22=2.00; 可以看出第一次迭代后,总体误差显著减小(从 可以看出第一次迭代后,总体误差显著减小( 27.48到 17) 在这个简单的例子中, 值 27.48 到 6.17 ) . 在这个简单的例子中 , 第一 次迭代同时也是最后一次迭代, 次迭代同时也是最后一次迭代,因为如果继续分 析新中心和样本间的距离, 析新中心和样本间的距离,样本将会全部分给同 样的簇,不将重新分配,算法停止. 样的簇,不将重新分配,算法停止.

RBF神经网络算法及其应用

和 n。

2 RBF 神经网络学习算法

遗传算法( GA ) 是一种具有全局寻优能力且对 系统无需先验知识的拟生态算法。变长度染色体遗 传算法是在简单遗传算法基础上改进而来, 其染色 体长度随着进化过程会发生变化, 该算法具有简单、 通用和鲁棒性强的特点。利用变长度染色体遗传算 法, 以输出均方误差最小为目标, 优选出不依赖于样 本的基函数中心以及中心数目 , 能够有效地反映系 统输入输出之间的关系, 达到较好的逼近效果。 2. 1 编 码 为了提高计算的精度并减小染色体的长度 , 本

其中 , X ∀ R n 是输入矢量, ( # ) 是一个 R 非线性函数, 一般取高斯型函数 ( !X - ci !) = ex p(w i 是权值 , ci 和 为中心数目。

i

!X - ci !

2 i

2

)

是基函数的数据中心和宽度, n

RBF 神经网络中待定的参数有两类 : 一类是基 函数的中心 ci 和宽度

, 因此被广泛应用于模式识别、 函数逼

[ 2]

近、 自适应滤波、 非线性时间序列预测等领域。目前 RBF 神经网络的训练算法有多种 , 其中正交优选 算法和递推 Giv ens 变换算法是较为有效的学习算 法。正交优选法可以自动确定最佳隐层数目和网络 输出权值 , 但隐含层中心点取值为输入数据, 因此很 难反映出系统真正的输入输出关系 , 并且初始中心 点数太多。在优选过程中会出现数据病态现象

明显优于文献[ 4] 。当输入节点数目为 8 时, 其训练 和预测结果见图 2 和图 3, 预测均方误差为 3. 957 ∋ 10- 4 , 而文献[ 9] 中采用的 BP 网络的预测均方误差 为 2. 6 ∋ 10 , 显然本文方法比 BP 网络的预测误差 提高了 1 个数量级。

RBF神经网络的函数逼近能力及其算法

RBF神经网络的函数逼近能力及其算法RBF(径向基函数)神经网络是一种用于函数逼近的非线性神经网络模型。

它具有强大的函数逼近能力,并且在许多领域中被广泛应用。

RBF神经网络由输入层、隐含层和输出层组成,其中隐含层是其核心组成部分。

隐含层包含一组径向基函数,这些函数将输入映射到一组隐含单元上。

每个隐含单元使用一个径向基函数计算输出,这个函数是以该隐含单元为中心的高斯函数。

RBF神经网络的函数逼近能力还受到其隐藏单元数量和径向基函数的选择的影响。

隐含单元的数量越多,网络的逼近能力越强,但也容易导致过拟合。

同时,选择适当的径向基函数也是至关重要的。

常见的径向基函数包括高斯函数、多项式函数和sigmoid函数,它们具有不同的特点和适用范围。

RBF神经网络的训练算法通常使用两个步骤:聚类和最小二乘法。

聚类步骤用于确定隐含单元的位置,最小化输入数据点与隐含单元之间的距离。

常用的聚类算法有K-means算法和自组织映射算法。

最小二乘法步骤用于确定径向基函数的参数,以最小化训练数据点与神经网络输出之间的误差。

这可以通过线性回归或最小二乘法来实现。

总之,RBF神经网络具有强大的函数逼近能力,可以逼近任意复杂的非线性函数。

其核心算法包括聚类和最小二乘法,通过确定隐含单元和径向基函数的参数来实现函数逼近。

这使得RBF神经网络在多个领域中得到广泛应用,包括模式识别、时间序列预测、图像处理等。

RBF神经网络学习算法

RBF神经网络学习算法RBF(径向基函数)神经网络是一种常用的神经网络模型,其学习算法主要分为两个步骤:网络初始化和参数优化。

本篇文章将详细介绍RBF 神经网络学习算法的原理和步骤。

1.网络初始化(1)选择隐藏层神经元的个数隐藏层神经元的个数决定了网络的复杂度。

一般情况下,隐藏层神经元的个数越多,网络的拟合能力越强。

但是隐藏层神经元个数的选择也受限于样本的数量和特征维度。

(2)选择径向基函数径向基函数用于将输入样本映射到隐藏层,常用的径向基函数有高斯函数、多项式函数等。

高斯函数是最常用的径向基函数,其具有良好的非线性映射性质。

选择合适的径向基函数如高斯函数可以提高网络的拟合能力。

(3)确定径向基函数的参数高斯函数有一个重要参数σ,控制了函数的宽度。

确定适当的σ值可以使得网络在训练过程中收敛更快,提高网络的学习效率。

2.参数优化(1)梯度下降法梯度下降法是一种常用的优化方法,通过不断迭代网络参数来最小化误差函数。

具体步骤如下:a.随机初始化网络的权值和偏置。

b.使用前向传播计算网络的输出。

d.根据误差计算参数的梯度。

e.根据梯度和学习率更新参数。

f.重复b-e直到满足停止准则。

(2)最小二乘法最小二乘法是一种基于最小化误差平方和的优化方法。

具体步骤如下:a.设置误差函数为平方和。

b.对误差函数求偏导,并令导数为0,得到参数的闭式解。

c.使用闭式解更新参数。

3.网络训练与预测(1)网络训练(2)网络预测网络预测是指使用训练好的网络来进行新样本的预测。

给定新样本的特征向量,通过前向传播计算网络的输出,即为网络对该样本的预测结果。

总结:本文首先介绍了RBF神经网络的基本原理和结构,然后详细描述了RBF神经网络的学习算法。

网络初始化包括选择隐藏层神经元个数、径向基函数和参数的确定。

参数优化主要通过梯度下降法和最小二乘法来优化网络的参数。

最后,本文介绍了网络训练和预测的过程。

通过合理选择网络结构和参数,RBF神经网络可以有效地处理非线性问题,具有很好的拟合能力和预测能力。

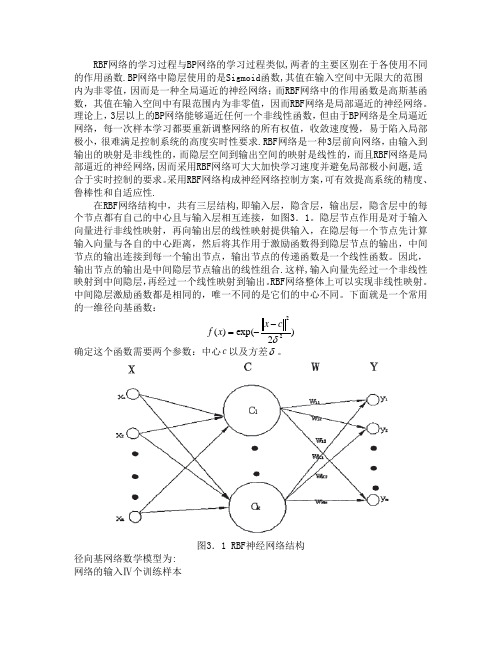

RBF网络

RBF 网络的学习过程与BP 网络的学习过程类似,两者的主要区别在于各使用不同的作用函数.BP 网络中隐层使用的是Sigmoid 函数,其值在输入空间中无限大的范围内为非零值,因而是一种全局逼近的神经网络;而RBF 网络中的作用函数是高斯基函数,其值在输入空间中有限范围内为非零值,因而RBF 网络是局部逼近的神经网络。

理论上,3层以上的BP 网络能够逼近任何一个非线性函数,但由于BP 网络是全局逼近网络,每一次样本学习都要重新调整网络的所有权值,收敛速度慢,易于陷入局部极小,很难满足控制系统的高度实时性要求.RBF 网络是一种3层前向网络,由输入到输出的映射是非线性的,而隐层空间到输出空间的映射是线性的,而且RBF 网络是局部逼近的神经网络,因而采用RBF 网络可大大加快学习速度并避免局部极小问题,适合于实时控制的要求。

采用RBF 网络构成神经网络控制方案,可有效提高系统的精度、鲁棒性和自适应性.在RBF 网络结构中,共有三层结构,即输入层,隐含层,输出层,隐含层中的每个节点都有自己的中心且与输入层相互连接,如图3.1。

隐层节点作用是对于输入向量进行非线性映射,再向输出层的线性映射提供输入,在隐层每一个节点先计算输入向量与各自的中心距离,然后将其作用于激励函数得到隐层节点的输出,中间节点的输出连接到每一个输出节点,输出节点的传递函数是一个线性函数。

因此,输出节点的输出是中间隐层节点输出的线性组合.这样,输入向量先经过一个非线性映射到中间隐层,再经过一个线性映射到输出。

RBF 网络整体上可以实现非线性映射。

中间隐层激励函数都是相同的,唯一不同的是它们的中心不同。

下面就是一个常用的一维径向基函数:)2exp()(22δc x x f --=确定这个函数需要两个参数:中心c 以及方差δ。

图3.1 RBF 神经网络结构径向基网络数学模型为:网络的输入Ⅳ个训练样本{}km k k k x x x X ,....,21=(N k ,...2,1=)网络对应的输出:{}km k k k y y y Y ,...,21= (N k ,...2,1=)网络输出连接权系数构成连接矩阵:}{,,..2,1,,...2,1,,J j I i j i W ===隐层节点个数I,中心点:{i C } I i ,...2,1= 方差i δ网络输入输出之间的关系:221)21exp()(i k i I i ij k kj C X w X y --=∑=δRBF 网络逼近的性能指标函数为:)(k E =2)]([21k kj k X y Y - 3.2 RBF 神经网络的性能改进3.2.1 RBF 神经网络训练数据的预处理1.进行数据预处理的原因对于使用有教师训练算法的前向神经网络,训练样本的质量对网络的性能非常重要.RBF 神经网络是一种局部网络,只有在隐含层节点中心的一定范围内的点才会使网络产生一定的输出。

RBF网络的微分进化正交最小二乘算法

2007,43(35)ComputerEngineeringandApplications计算机工程与应用RBF(RadialBasisFunction)网络近年来一直是重点研究的一种人工神经网络,它在很多领域,如函数近似、系统建模、模式识别、信号处理等,得到了成功应用。

与其他类型的神经网络相比,RBF网络具有简单的网络结构以及快速的学习能力等优点[1]。

目前,RBF网络常用的学习算法包括:k均值聚类算法、正交最小二乘(OrthogonalLeastSquares,OLS)算法、梯度下降算法、剪枝增长算法等[1,2]。

Barreto把OLS方法与遗传算法(GeneticAlgorithm,GA)相结合,提出了RBF网络的遗传正交最小二乘(GeneticOr-thogonalLeastSquares,GOLS)训练算法[3]。

该算法结合了OLS算法和GA的优点,训练得到的网络性能比使用OLS算法得到的网络性能优越,而且避免了GA的计算代价。

Barreto在提出这一算法时指出,从理论上讲,算法中的GA可以以任何进化算法来替代,而不影响算法的性能[3]。

微分进化[4](DifferentialEvolution,DE)是浮点编码的全局优化进化策略,尤其适合解决非线性不可微连续函数的最小化问题,使用简便,收敛速度快,鲁棒性强。

本文在Barreto工作的基础上,将OLS与DE相结合,提出了RBF网络的微分进化正交最小二乘(DifferentialEvolutionOrthogonalLeastSquares,DEOLS)训练算法。

与GOLS相比,DEOLS比GOLS易于实现,鲁棒性强,且实验结果表明DEOLS具有很好的函数近似和时间序列预测性能。

1OLS在RBF网络的OLS[2]训练算法中,初始状态隐结点为空,统一设定隐结点的宽度为!,所有的训练样本作为备选隐结点,按照最大降低误差平方和(SumofSquareErrors,SSE)的标准从训练样本中逐个选择隐结点的中心cj。

正交最小二乘算法在训练RBF网络中的应用

正交最小二乘算法在训练RBF 网络中的应用李超(控制科学与工程学院、模式识别与智能系统专业、2010010224)摘要:为了使RBF 网络能够适用于各种问题,必须做到能根据不同问题而自动确定其隐层节点数和隐层中心。

人们在这方面做了大量的研究工作,目前主要的方法有正交最小二乘算法(OLS ,Orthogonal Least Squares )及动态均值聚类算法等。

主要由S.Chen 等人提出的正交最小二乘算法是目前训练RBF 网络应用较多的一种方法。

它是一种构造型算法,该算法简单易行,运算速度快。

通过正交优选法可以确定网络隐层最佳神经元个数及隐层中心,网络的输出层权值最后可以通过线性优化算法很容易地求出。

1.问题的提出RBF 网络学习算法RBF 网络要学习的参数有四个,分别是隐层节点数、基函数的中心、基函数的宽度及网络隐含层到输出层的连接权值。

而RBF 网络中所用的非线性函数的形式及基函数的宽度对网络性能的影响并不是至关重要的,关键因素是基函数中心的选取,中心选取不当构造出来的RBF 网络的性能一般不能令人满意。

利用正交最小二乘算法建立了板形模式识别模型。

正交最小二乘算法是目前训练RBF 网络应用较多的一种方法。

这种方法简单易行,运算速度快。

2.问题的求解通过正交优选法可以确定网络隐含层的最佳神经元个数及隐含层基函数的中心,最后通过线性优化算法求出网络隐含层到输出层的连接权值。

我们选用正交最小二乘算法来训练RBF 网络,下面开始分析该算法。

设网络学习样本数为N ,学习样本输入和输出为1{(),()}N k D k Y k -,12()[(),(),...,()]ni D k d k d k d k =。

选择网络隐含层初始神经元个数为N ,隐含层基函数的中心从学习样本中选取。

RBF 网络的期望输出可以用(1)式来表示:Y P E θ=+ (1)其中:12[,,...,]no Y y y y =, [(1),(2),...,()]T i i i i y y y y N =12[,,...,]N P p p p =,[(1),(2),...,()]T i i i i p p p p N =,1i N ≤≤120[,,...,]n θθθθ=, 12[,,...,],10T i i i Ni i n θθθθ=≤≤120[,,...,]n E e e e =,[(1),(2),...,()],10T i i i i e e e e N i n =≤≤P 为隐含层输出矩阵,θ为隐含层到输出层的连接权矩阵,E 为网络期望输出与实际输出之间的误差矩阵。

RBF网络的微分进化正交最小二乘算法

RBF网络的微分进化正交最小二乘算法

苏美娟;邓伟

【期刊名称】《计算机工程与应用》

【年(卷),期】2007(043)035

【摘要】研究用于径向基函数(RBF)网络训练的一种微分进化正交最小二乘(DEOLS)算法.把微分进化(DE)算法的种群作为正交最小二乘(OLS)算法的候选径向基函数集合,利用OLS对DE的种群个体进行评断,以确定RBF网络的隐结点的数目、中心和宽度.该算法融合了DE的强大搜索能力和OLS的高效评断能力,隐结点的选择比OLS要合理,同时避免DE的复杂性.最后使用实验验证了该算法的优越性.【总页数】3页(P46-48)

【作者】苏美娟;邓伟

【作者单位】苏州大学,计算机科学与技术学院,江苏,苏州,215006;苏州大学,计算机科学与技术学院,江苏,苏州,215006

【正文语种】中文

【中图分类】TP183

【相关文献】

1.快速模糊正交最小二乘算法 [J], 王江;王先来;杨屹

2.基于正交最小二乘算法的小波神经网络 [J], 徐晓霞;陈涛;王晓升

3.快速模糊正交最小二乘算法 [J], 杨屹;王江;王先来

4.基于微分进化免疫的RBF网络学习算法研究 [J], 徐晓晖;苏美娟;邓伟

5.正交函数-偏最小二乘算法及其在复方制剂分析中的应用 [J], 丁德荣;颜杰;阎爱国;刘世庆

因版权原因,仅展示原文概要,查看原文内容请购买。

基于OLS算法的RBF神经网络在大坝安全监测中的应用

基于OLS算法的RBF神经网络在大坝安全监测中的应用

基于OLS算法的RBF神经网络在大坝安全监测中的应用

摘要:文章介绍了RBF网络的基本原理以及网络中心选取OLS算法(正交最小二乘法),并将该方法应用于大坝渗流安全监测资料的分析预报上,应用结果表明:该神经网路可以很好地克服BP神经网络学习过程的收敛过分依赖r初值和可能出现局部收敛的缺陷,具有较快的`运算速度、较强的非线性映射能力和较好的预报功能.作者:刘红涛作者单位:陕西省西安市临潼区油槐街道办,陕西,西安,710604 期刊:中国科技博览 Journal:ZHONGGUO BAOZHUANG KEJI BOLAN 年,卷(期):2010, (8) 分类号:X924.2 关键词:RBF 神经网络OLS算法大坝安全监测。

RBF网学习的进化优选算法

RBF网学习的进化优选算法

魏海坤;徐嗣鑫;宋文忠

【期刊名称】《控制理论与应用》

【年(卷),期】2000(017)004

【摘要】讨论了用正交最小二乘算法训练RBF网的不足之处,然后引入了选择路径的概念,在此基础上,提出了RBF网隐层节点选取的进化优选算法.仿真结果表明,在

不同的精度要求下,用进化优选算法均能设计出比正交最小二乘算法更小的RBF网.【总页数】5页(P604-608)

【作者】魏海坤;徐嗣鑫;宋文忠

【作者单位】东南大学自动化研究所,南京,210096;东南大学自动化研究所,南

京,210096;东南大学自动化研究所,南京,210096

【正文语种】中文

【中图分类】TP3

【相关文献】

1.最小RBF网进化优选算法在燃煤着火特性预测中的应用 [J], 沈晟

2.基于模糊协同进化免疫的RBF网络学习算法研究 [J], 徐晓晖;黄剑玲

3.基于遗忘进化规划的Hopfield网学习算法 [J], 孟祥武;程虎

4.基于微分进化免疫的RBF网络学习算法研究 [J], 徐晓晖;苏美娟;邓伟

5.最小RBF网设计的进化优选算法及其在动力配煤过程状态预测建模中的应用 [J], 魏海坤;徐嗣鑫;宋文忠;吴福保

因版权原因,仅展示原文概要,查看原文内容请购买。

正交偏最小二乘法

正交偏最小二乘法正交偏最小二乘法(Orthogonal Partial Least Squares, OPLS)是一种常用的多元统计分析方法,广泛应用于数据建模、特征选择、变量筛选等领域。

本文将介绍正交偏最小二乘法的原理、应用和优势,以及其在实际问题中的应用案例。

正交偏最小二乘法是基于偏最小二乘法(Partial Least Squares, PLS)的改进方法。

偏最小二乘法是一种回归分析的方法,通过将自变量和因变量进行线性组合,建立回归模型。

但是在应用过程中,偏最小二乘法可能存在多个潜在的自变量对应一个因变量的情况,这就导致了模型的不稳定性和可解释性差。

正交偏最小二乘法通过引入正交化的步骤,解决了偏最小二乘法的不足。

其基本思想是,在建立回归模型的过程中,除了考虑与因变量相关的部分(预测分量),还引入与因变量不相关的部分(正交分量),从而提高模型的解释能力和稳定性。

通过正交化的操作,正交偏最小二乘法能够将数据进行更好的降维,去除噪声和冗余信息,提取出对预测结果有用的信息。

正交偏最小二乘法在实际问题中具有广泛的应用。

例如,在药物研发领域,研究人员可以利用正交偏最小二乘法对大量的分子结构和活性数据进行建模和预测,快速筛选出具有潜在药效的化合物。

在工业过程控制中,正交偏最小二乘法可以用于建立传感器数据与产品质量之间的关系,实现对产品质量的在线监测和控制。

此外,正交偏最小二乘法还可以应用于生物信息学、化学分析、图像处理等领域。

与其他方法相比,正交偏最小二乘法具有以下优势。

首先,正交偏最小二乘法能够解决多重共线性问题,降低模型的复杂度,提高模型的解释能力。

其次,正交偏最小二乘法能够处理高维数据,提取出对预测结果有用的特征,减少冗余信息的干扰。

此外,正交偏最小二乘法还可以进行特征选择,帮助研究人员挖掘出对预测结果具有重要影响的变量。

下面以一个实际应用案例来说明正交偏最小二乘法的应用。

假设我们需要建立一个模型来预测商品的销售量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

度。 该算法融合 了 D E的强大搜 索能力和 O S的高效评 断能 力, L 隐结点的选择 比 O S要合理 , L 同时避免 D E的复杂性。 最后使用实

验 验 证 了该 算 法 的优 越 性

关键 词 : B R F神 经 网络 ; 交 最 小二 乘方 法 ; 分 进 化 算 法 正 微 文章 编 号 :0 2 8 3 (0 7 3 — 0 6 0 文 献 标 识 码 : 中图 分类 号 :P 8 10 — 3 12 0 )5 04 — 3 A T 13

维普资讯

4 6

2 0 , pi t n 计算机工程与应用 o p trE n ei n p l ai s n c o

R F网络 的微 分进化正交最小 二乘算法 B

苏美 娟 , 邓 伟

S ija , E G We U Me-H i D N i - l

苏州大学 计算机科学与技 术学院 , 江苏 苏州 2 0 06 1 5

S h o f C mp t r S in e & T c n l g S o h w U ie st S z o , in s 0 6, i a c o l o o u e c e c e h oo y, o c o n v r i y, u h u Ja g u 2 0 Ch n 1 5

Ke r s Ra ilBai u cin RB y wo d : da s F n t ( F) n t r ; to o a e s S u r( S) meh d Diee t lE ouin DE) ag r h s o ewok Or g n lL at q ae OL h to ; f rni v lt ( f a o loi m t

E m i meu nu o u o — a : i as@sh. n l j c S ij a , NG W e.i eet lE ouin O to o a es S u r ( E S lo i m o B ew r .o ue U Me-n n DE i f rni v lt rh g n lL at q ae D 0L )ag r h fr R F n t o kC mp tr D a o t

En i e rn n piain ,0 7,3 3 :6 4 . gn ei g a d Ap l t s 2 0 4 ( 5)4 - 8 c o

Ab ta t Diee t l v lt n sr c : f rni E oui Orh g n l e s q ae ( OL f a o to o a L at u r DE S) ag r h S loi m fr BF ew r i rs ne a y rd loi m t o R n t ok s e e td, h b i ag r h p t be dn too a e s S u rs ( S)meh d wi f rnilE ouin ( ln ig Or g n lL at q ae OL h to t Diee t v lt h f a o DE) ag r h T e p p lt n o h loi m 。 loi m.h o uai fte DE ag rt t o h

e c dn h e t r a d w d h o BF h d e o e c re p n s t h s t o a d d t n o i g te c n e n i t f R i d n n d , o r s o d o t e e f c n i ae RBF f OI whl e p o t OL o s o S, i DE x li S t e s e a u t a h i d vd a f t e p p lt nT i a g r h c mp o s s t e sr n e r h o r o n h ef in v l a in v l ae e c n i i u l o h o u ai .h s lo i m o r mie h t g s a c p we f DE a d t e f ce t e a u t o t o i o a i t f OL s lc i g i d n o e mo e ai n l t a OL w to t n u r g h c mp tt n l o t f DE. l s, x e i b l y o S,e e t h d e n d s i n r r t al h n o y S, i u i c ri t e o u a i a c s h n o o At a t e p r - me t a e u e o d mo sr t t e efc ie e s o h s ag rtm. n s r s d t e n tae h f t n s f t i lo h e v i

摘

要 : 究 用于 径 向基 函数 ( B ) 研 R F 网络 训 练 的 一 种微 分进 4 f交最 小二 乘 ( E L ) 法 。 微 分进 化 ( E 算 法 的种 群 作 为 正 交 g. - D O S算 把 D )

最 小二 乘( L ) 法 的候 选 径 向基 函数 集 合 , 用 O S对 D 的种 群 个体 进 行 评 断 , O S算 利 L E 以确 定 R F网络 的 隐 结 点 的数 目 、 心和 宽 B 中