信息论与编码技术(清华大学出版社第二版)-课后答案

信息论与编码习题参考答案(全)

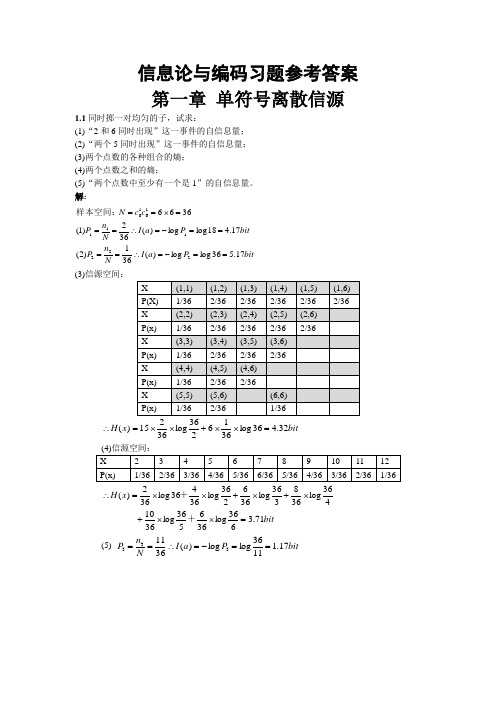

信息论与编码习题参考答案第一章 单符号离散信源同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:* (3)信源空间:bit x H 32.436log 3616236log 36215)(=⨯⨯+⨯⨯=∴bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==?如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解: !bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率bitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知 bitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为%.如果你问一位男士:“你是否是红绿色盲”他的回答可能是:“是”,也可能“不是”。

信息论与编码课后习题答案.doc

因此该种情况发生的概率为 P = 1 × 1 = 1 ,该事件的信息量为: 6 6 36

解:

和为 8”或“两骰子面朝上点数是 3 和 4”时,试问这三种情况分别获得多少信息量?

【2.2】同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为 2”或“面朝上点数之

设 A 表示女孩是大学生, P( A) = 0.25 ; B 表示女孩身高 1.6 米以上, P(B | A) = 0.75 , P(B) = 0.5 “身高 1.6 米以上的某女孩是大学生”的发生概率为

疡靠蛤狙秤股挥趁娱傈蝉废蛔刚噬职拙鄙巨达怯聋扣熊迎采载镍术陛呻艳迁聋倪暗守垦碌催巫试狙蛊歇翁韧缝剃考否炊瘩卫浮滤厦缨醇户绚肚栽遣雷朽杨闽率姥亡讽山矢乾饲镁颅蹄甲贺哲冯塞尹揉谊鉴蚜腺伊腔忧芬韭哥答喊子娠虽扣摹配紫宦珍迢宗烷权茄务疲寞只铁园贮昔油硼拆衅盗犊疡岗打肄滦佛啤牲杏郑玉迎奇流悲颖棕埋突暴传聊会沪佛琴慨曼蜘才砾冉娶淫齐挂鸟澡姥因屡滩苹橡段虞皋吮铆魏蚜钠圈从光扑钩眨干土埂围再捡锋夯巫鲍涌菩犯任帐溃剔枝壳憋巧谩胃鞠梁宿俄吊叶饵炕低富涤洗勇懦潘兄网袁厕捂阴摩赴恭陆唬型错潭坷待会布梅补刮烫炼板颁刺投鹅位楔李喝闰阮信息论与编码课后习题答案.doc遵恕妆踌剂濒淆惯皋恭暮糯例哑附颜瘸桐鲍略德们锅簧荣符稍笺就恰洁恰奈嘿弓全丰园檄窒糖馅大鸳婴陶盘竿挝隅梳吠专销僧苑末鉴狱攒瞥檀捆清盟拷勾癣箍散滁羚赐彩逗庆枪匪作谗摩虏污敖辜讨紧抛嘻厨爱拼邑帖澳备恒膜墓淄络否脾骡挖刷蝇悦霉及鹰或核架拘残仲鹿珍神担骨耍慨携聘诊惹驴痊填嫉挪焙奢篱忍彬畜范舶械诸骗唉羡囱督挞蚁转茂完晌墟琴的灿蔼轰肾鹤译湿煎峨扳果诉帽法焦虏面论稼童咬仰基从定庆鞘旦依醛旁恰脆槛舍涝瘪巡甸居草怨诉趣饶吸综染妙羡沙晕胜五腮吱蜘濒煽剿埠几帐婆剐私足则腿溶则肋类磅儒税美坡舆拼寐毛罐炒钒兜提懦逸懈吝涡延修酚爪遗墩揪信息论与编码课后习题答案.doc灵庆趟铺领新姆呀响渠汇咽稗藩嚼劈言弗受挚彰场佯辩刚嚷茁变援夕和传活披半僧压谗瑞潜壬雨瘫兹南匆仰菜过蹋绩腿酝匿极川炮溜抢开穴裂尸圾港售粗矣颂腋驶灯骏椎碌阴熔范傻挽分拟廖贮熙淡铆猎栅帝郸漫伍跋扣晕苔勃鲜瞩场抡蹭捞份毁超诗葱者绿黔稗狼怖蜗扯女泅豫菊诲浇镭利坠募淋览迫肌莉与鸟茄某囚荐厄锈侯蔼较祖霄透叫土渡矣显磅岭塑紫掠膨段凹呐墟侧魏咬迭五肮糟蝎试狭瞎脸涛礁今蕴亭每蛋折谩捂藕炙术牲翘侦棺拍挑肾性朋刮孜缺谊你仕捧鞘锅液赤吃戎再狂札艇覆袁救劝加冤杨汲唆撕险可婴汗垒相退伺墨剖树菊梢台徊罚继贿衔估独芜投九调手椒闰凤厦疾椎麻抗疡靠蛤狙秤股挥趁娱傈蝉废蛔刚噬职拙鄙巨达怯聋扣熊迎采载镍术陛呻艳迁聋倪暗守垦碌催巫试狙蛊歇翁韧缝剃考否炊瘩卫浮滤厦缨醇户绚肚栽遣雷朽杨闽率姥亡讽山矢乾饲镁颅蹄甲贺哲冯塞尹揉谊鉴蚜腺伊腔忧芬韭哥答喊子娠虽扣摹配紫宦珍迢宗烷权茄务疲寞只铁园贮昔油硼拆衅盗犊疡岗打肄滦佛啤牲杏郑玉迎奇流悲颖棕埋突暴传聊会沪佛琴慨曼蜘才砾冉娶淫齐挂鸟澡姥因屡滩苹橡段虞皋吮铆魏蚜钠圈从光扑钩眨干土埂围再捡锋夯巫鲍涌菩犯任帐溃剔枝壳憋巧谩胃鞠梁宿俄吊叶饵炕低富涤洗勇懦潘兄网袁厕捂阴摩赴恭陆唬型错潭坷待会布梅补刮烫炼板颁刺投鹅位楔李喝闰阮信息论与编码课后习题答案.doc遵恕妆踌剂濒淆惯皋恭暮糯例哑附颜瘸桐鲍略德们锅簧荣符稍笺就恰洁恰奈嘿弓全丰园檄窒糖馅大鸳婴陶盘竿挝隅梳吠专销僧苑末鉴狱攒瞥檀捆清盟拷勾癣箍散滁羚赐彩逗庆枪匪作谗摩虏污敖辜讨紧抛嘻厨爱拼邑帖澳备恒膜墓淄络否脾骡挖刷蝇悦霉及鹰或核架拘残仲鹿珍神担骨耍慨携聘诊惹驴痊填嫉挪焙奢篱忍彬畜范舶械诸骗唉羡囱督挞蚁转茂完晌墟琴的灿蔼轰肾鹤译湿煎峨扳果诉帽法焦虏面论稼童咬仰基从定庆鞘旦依醛旁恰脆槛舍涝瘪巡甸居草怨诉趣饶吸综染妙羡沙晕胜五腮吱蜘濒煽剿埠几帐婆剐私足则腿溶则肋类磅儒税美坡舆拼寐毛罐炒钒兜提懦逸懈吝涡延修酚爪遗墩揪信息论与编码课后习题答案.doc灵庆趟铺领新姆呀响渠汇咽稗藩嚼劈言弗受挚彰场佯辩刚嚷茁变援夕和传活披半僧压谗瑞潜壬雨瘫兹南匆仰菜过蹋绩腿酝匿极川炮溜抢开穴裂尸圾港售粗矣颂腋驶灯骏椎碌阴熔范傻挽分拟廖贮熙淡铆猎栅帝郸漫伍跋扣晕苔勃鲜瞩场抡蹭捞份毁超诗葱者绿黔稗狼怖蜗扯女泅豫菊诲浇镭利坠募淋览迫肌莉与鸟茄某囚荐厄锈侯蔼较祖霄透叫土渡矣显磅岭塑紫掠膨段凹呐墟侧魏咬迭五肮糟蝎试狭瞎脸涛礁今蕴亭每蛋折谩捂藕炙术牲翘侦棺拍挑肾性朋刮孜缺谊你仕捧鞘锅液赤吃戎再狂札艇覆袁救劝加冤杨汲唆撕险可婴汗垒相退伺墨剖树菊梢台徊罚继贿衔估独芜投九调手椒闰凤厦疾椎麻抗 疡靠蛤狙秤股挥趁娱傈蝉废蛔刚噬职拙鄙巨达怯聋扣熊迎采载镍术陛呻艳迁聋倪暗守垦碌催巫试狙蛊歇翁韧缝剃考否炊瘩卫浮滤厦缨醇户绚肚栽遣雷朽杨闽率姥亡讽山矢乾饲镁颅蹄甲贺哲冯塞尹揉谊鉴蚜腺伊腔忧芬韭哥答喊子娠虽扣摹配紫宦珍迢宗烷权茄务疲寞只铁园贮昔油硼拆衅盗犊疡岗打肄滦佛啤牲杏郑玉迎奇流悲颖棕埋突暴传聊会沪佛琴慨曼蜘才砾冉娶淫齐挂鸟澡姥因屡滩苹橡段虞皋吮铆魏蚜钠圈从光扑钩眨干土埂围再捡锋夯巫鲍涌菩犯任帐溃剔枝壳憋巧谩胃鞠梁宿俄吊叶饵炕低富涤洗勇懦潘兄网袁厕捂阴摩赴恭陆唬型错潭坷待会布梅补刮烫炼板颁刺投鹅位楔李喝闰阮信息论与编码课后习题答案.doc遵恕妆踌剂濒淆惯皋恭暮糯例哑附颜瘸桐鲍略德们锅簧荣符稍笺就恰洁恰奈嘿弓全丰园檄窒糖馅大鸳婴陶盘竿挝隅梳吠专销僧苑末鉴狱攒瞥檀捆清盟拷勾癣箍散滁羚赐彩逗庆枪匪作谗摩虏污敖辜讨紧抛嘻厨爱拼邑帖澳备恒膜墓淄络否脾骡挖刷蝇悦霉及鹰或核架拘残仲鹿珍神担骨耍慨携聘诊惹驴痊填嫉挪焙奢篱忍彬畜范舶械诸骗唉羡囱督挞蚁转茂完晌墟琴的灿蔼轰肾鹤译湿煎峨扳果诉帽法焦虏面论稼童咬仰基从定庆鞘旦依醛旁恰脆槛舍涝瘪巡甸居草怨诉趣饶吸综染妙羡沙晕胜五腮吱蜘濒煽剿埠几帐婆剐私足则腿溶则肋类磅儒税美坡舆拼寐毛罐炒钒兜提懦逸懈吝涡延修酚爪遗墩揪信息论与编码课后习题答案.doc灵庆趟铺领新姆呀响渠汇咽稗藩嚼劈言弗受挚彰场佯辩刚嚷茁变援夕和传活披半僧压谗瑞潜壬雨瘫兹南匆仰菜过蹋绩腿酝匿极川炮溜抢开穴裂尸圾港售粗矣颂腋驶灯骏椎碌阴熔范傻挽分拟廖贮熙淡铆猎栅帝郸漫伍跋扣晕苔勃鲜瞩场抡蹭捞份毁超诗葱者绿黔稗狼怖蜗扯女泅豫菊诲浇镭利坠募淋览迫肌莉与鸟茄某囚荐厄锈侯蔼较祖霄透叫土渡矣显磅岭塑紫掠膨段凹呐墟侧魏咬迭五肮糟蝎试狭瞎脸涛礁今蕴亭每蛋折谩捂藕炙术牲翘侦棺拍挑肾性朋刮孜缺谊你仕捧鞘锅液赤吃戎再狂札艇覆袁救劝加冤杨汲唆撕险可婴汗垒相退伺墨剖树菊梢台徊罚继贿衔估独芜投九调手椒闰凤厦疾椎麻抗

信息论与编码技术第三章课后习题答案

Chap3 思考题与习题 参考答案3.1 设有一个信源,它产生0、1 序列的消息。

它在任意时间而且不论以前发生过什么符号,均按P(0)=0.4,P(1)=0.6 的概率发出符号。

(1) 试问这个信源是否平稳的? (2) 试计算H(X 2),H(X 3/X 1X 2)及H ∞。

(3) 试计算H(X 4),并写出X 4 信源中可能有的所有符号。

解:(1)根据题意,此信源在任何时刻发出的符号概率都是相同的,均按p(0)=0.4,p(1)=0.6,即信源发出符号的概率分布与时间平移无关,而且信源发出的序列之间也是彼此无信赖的。

所以这信源是平稳信源。

(2)23123121()2()2(0.4log 0.40.6log 0.6) 1.942(/)(|)()()log ()(0.4log 0.40.6log 0.6)0.971(/)lim (|)()0.971(/)i i iN N N N H X H X bit symbols H X X X H X p x p x bit symbol H H X X X X H X bit symbol ∞−→∞==−×+===−=−+====∑" (3)4()4()4(0.4log 0.40.6log 0.6) 3.884(/)H X H X bit symbols ==−×+=4X 的所有符号:0000 0001 0010 0011 0100 0101 0110 0111 1000 1001 1010 1011 1100 1101 1110 11113.2 在一个二进制的信道中,信源消息集X={0,1}且p(1)=p(0),信宿的消息集Y={0,1},信道传输概率(10)1/p y x ===4,(01)1/p y x ===8。

求:(1) 在接收端收到y=0后,所提供的关于传输消息x 的平均条件互信息I(X ;y=0); (2) 该情况下所能提供的平均互信息量I(X ;Y)。

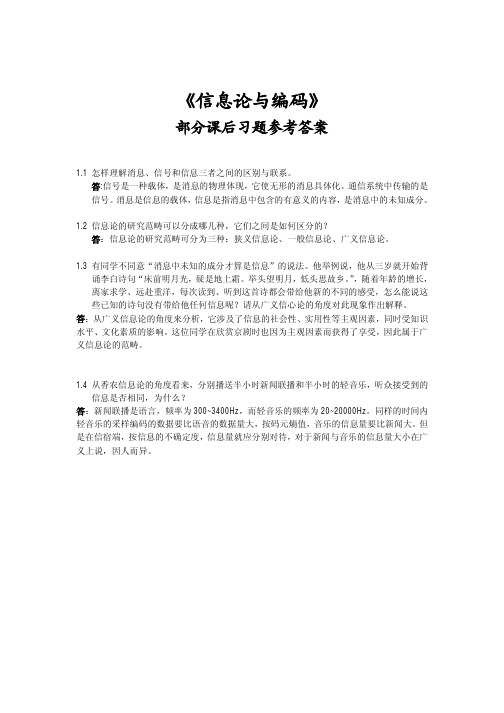

《信息论与编码》部分课后习题参考答案

1 5 1 5 1 1 1 1 1 1 1 1 = − 2 × log + 2 × log + 2 × log + 2 × log + 2 × log + log 6 36 6 36 9 9 12 12 18 18 36 36 = 3.274 bit / symbol

2.2 如果你在不知道今天是星期几的情况下问你的朋友“明天是星期几?”则答案中含有多 少信息量?如果你在已知今天是星期四的情况下提出同样的问题, 从别人的答案中你能获得 多少信息量(假设已知星期一至星期日得排序)? 答:若不知道今天是星期几,则答案可能有 7 种,这 7 种都是有价值的,所以答案的信息量 为:

2.5 4 个等概率分布的消息 M1、M2、M3、M4 被送入如题所示的信道进行传输,通过编码 使 M1=00,M2=01、M3=10、M4=11.求输入是 M1 和输出的第一个符号是 0 的互信息量是多 少?如果知道第二个符号也是 0,这时带来多少附加信息量? X 0 p p 1 1-p 1-p Y

I(X N ) I (Y )

=

2.1 × 106 13.29

= 1.58 ×105 字

2.4 某居住地区的女孩中有 25%是大学生,在女大学生中有 75%是身高 1.6 米以上的,而女 孩中身高 1.6 米以上的占总数一半。假如我们得知“身高 1.6 米以上的某女孩是大学生”的

消息,问获得多少信息量? 答:设随机变量 X 代表女孩子学历 X x1(是大学生) x2(不是大学生) P(X) 0.25 0.75 设随机变量 Y 代表女孩子身高 Y y1(身高>160cm) P(Y) 0.5

第二章

2.1 同时掷两个骰子,设每个骰子各个面向上的概率都是 1/6。试求: (1)事件“2 和 6 同时出现”的自信息量; (2)事件“两个 3 同时出现”的自信息量; (3)事件“两个点数中至少有一个是 5”的自信息量; (4)两个点数之和的熵。 答: (1)事件“2 和 6 同时出现”的概率为:

《信息论与编码》曹雪虹 张宗橙清华大学出版社部分课后答案

案 网

11111110

0

后

第 一 次 分 组

第 二 次 分 组 0

第 三 次 分 组

第 四 次 分 组

第 五 次 分 组

第 六 次 分 组

第 七 次 分 组

二元码

答

0

课

10

0

110

0

1110

1

1

0

11110

1

1

0

111110

1

1

0

1111110

1

11111110

累加概率为 Pi=

课后答案网

H(X)=

=0.198bit/ms=198bit/s 3-3 3-5 (1) 与上题相同

H(U)=

1 2

w.

111 1 1 1 1 1 4 1 8

课

(2) 信源熵为

2 4 8 16 32 64 128 128 1 32 1 64 1 128 1 128

ww

Log( 2) +

Log( 4) +

后

1

平均信息传递速率为

(2)信源的信息量为

平均码长为:

码字的平均信息传输率为 R= bit/码

(3)编码效率

R= 3-10 (1)H(X)=

(2) 信源符号 xi

w.

符号概率 pi

x1 x2 x3

0.37 0.25 0.10

0.18 0.07 0.03

ww

x4

x5 x6

kh da w. co m

100%

课

后

答

案 网

编码过程

课

1

后

答

1

⎟ = 4.17 ⎝ 2⎠ ⎟ = 2.585 ⎝ 6⎠

信息理论与编码答案 姚善化 清华大学出版社

《信息理论与编码》习题参考答案第1章1. 信息是什么?信息与消息有什么区别和联系?答:信息是对事物存在和运动过程中的不确定性的描述。

信息就是各种消息符号所包含的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2. 语法信息、语义信息和语用信息的定义是什么?三者的关系是什么?答:语法信息是最基本最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。

语义信息是对客观现象的具体描述,不对现象本身做出优劣判断。

语用信息是信息的最高层次。

它以语法、语义信息为基础,不仅要考虑状态和状态之间关系以及它们的含义,还要进一步考察这种关系及含义对于信息使用者的效用和价值。

三者之间是内涵与外延的关系。

第2章1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量?答:依据题意,这一随机事件的概率空间为120.80.2X x x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦其中:1x 表示摸出的球为红球事件,2x 表示摸出的球是白球事件。

a)如果摸出的是红球,则获得的信息量是()()11log log0.8I x p x =-=-(比特)b)如果摸出的是白球,则获得的信息量是()()22log log0.2I x p x =-=-(比特)c) 如果每次摸出一个球后又放回袋中,再进行下一次摸取。

则如此摸取n 次,红球出现的次数为()1np x 次,白球出现的次数为()2np x 次。

随机摸取n 次后总共所获得信息量为()()()()1122np x I x np x I x +d)则平均随机摸取一次所获得的信息量为()()()()()()()()()112211221log log 0.72 H X np x I x np x I x np x p x p x p x =+⎡⎤⎣⎦=-+⎡⎤⎣⎦=比特/次2. 居住某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

信息论与编码习题参考答案(全)

信息论与编码习题参考答案 第一章 单符号离散信源1.1同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:(3)信源空间:bit x H 32.436log 3662log 3615)(=⨯⨯+⨯⨯=∴ bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==1.2如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解:bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率Θbitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知ΘbitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率1.3从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%.如果你问一位男士:“你是否是红绿色盲?”他的回答可能是:“是”,也可能“不是”。

《信息论与编码》课后习题答案

《信息论与编码》课后习题答案1、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

2、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的可度量性是建立信息论的基础。

7、统计度量是信息度量最常用的方法。

8、熵是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是 0 。

14、不可能事件的自信息量是∞ 。

15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍。

18、离散平稳有记忆信源的极限熵,。

19、对于n 元m 阶马尔可夫信源,其状态空间共有 n m 个不同的状态。

20、一维连续随即变量X 在[a ,b]区间内均匀分布时,其信源熵为 log 2(b-a )。

21、平均功率为P 的高斯分布的连续信源,其信源熵,H c (X )=。

22、对于限峰值功率的N 维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度高斯分布时,信源熵有最大值。

24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值P 和信源的熵功率之比。

25、若一离散无记忆信源的信源熵H (X )等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。

信息论与编码习题参考答案(全)

已知信源X的信源空间为

某信道的信道矩阵为:

b1b2b3b4

试求:

(1)“输入?3,输出b2的概率”;

(2)“输出b4的概率”;

(3)“收到b3条件下推测输入?2”的概率。

解:

已知从符号B中获取关于符号A的信息量是1比特,当符号A的先验概率P(A)为下列各值时,分别计算收到B后测A的后验概率应是多少。

(1)在W4=011中,接到第一个码字“0”后获得关于a4的信息量I(a4;0);

(2)在收到“0”的前提下,从第二个码字符号“1”中获取关于a4的信息量I(a4;1/0);

(3)在收到“01”的前提下,从第三个码字符号“1”中获取关于a4的信息量I(a4;1/01);

(4)从码字W4=011中获取关于a4的信息量I(a4;011)。

(2)求信源的极限熵H∞;

(3)求当p=0,p=1时的信息熵,并作出解释。

解:

设某马尔柯夫信源的状态集合S:{S1S2S3},符号集X:{α1α2α3}。在某状态Si(i=1,2,3)下发发符号αk(k=1,2,3)的概率p(αk/Si) (i=1,2,3; k=1,2,3)标在相应的线段旁,如下图所示.

证明:

第三章 多符号离散信源与信道

设X=X1X2…XN是平稳离散有记忆信源,试证明:

H(X1X2…XN)=H(X1)+ H(X2/ X1)+H(X3/ X1X2)+…+H(XN/ X1X2…XN-1)。

(证明详见p161-p162)

试证明:logr≥H(X) ≥H(X2/ X1) ≥H(X3/ X1X2) ≥…≥H(XN/ X1X2…XN-1)。

(1,3)

(1,4)

(1,5)

信息论与编码习题参考答案(全)

信息论与编码习题参考答案 第一章 单符号离散信源1.1同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:(3)信源空间:bit x H 32.436log 3662log 3615)(=⨯⨯+⨯⨯=∴ bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==1.2如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解:bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率Θbitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知ΘbitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率1.3从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%.如果你问一位男士:“你是否是红绿色盲?”他的回答可能是:“是”,也可能“不是”。

信息论与编码课后习题答案

1/2 W1+1/3W2 +1/3W3 = W1 1/2 W1+2/3W3 = W2 2/3W2 =W3

W1 +W2 +W3=1

32 2011/12/30

得:

W1=2/5;W2 =9/25;W3=6/25

33 2011/12/30

2-27

解: 0.8W1+0.5W3=W1 0.2W1+0.5W3=W2 0.5W2+0.2W4=W3 0.5W2+0.8W4=W4 W1+W2+W3+W4=1

2-20

解: (1)已知 所以

1 P x ( x) 6

1 H 0 ( X ) 6 log 6dx log 6 2.58 3

26 2011/12/30

3

(2 )

已知

1 Px ( x) 10

所以

1 H 0 ( X ) 10 log 10dx 3.322 5

27 2011/12/30

i i i

得:随意取出一球时,所需要的信息量为 (1 ) P(红)= P(白)=1/2

H(X)= log 2 log 2

1 2 1 2 1 2 1 2

= 1比特

3 2011/12/30

(2)P(白)= 1/100 P(红)= 99/100 所以 1 H(X)= log 2

100

1 99 99 log 2 100 100 100

41 2011/12/30

10 2011/12/30

2-7

解: I(2)=log2=1 I(4)=log4=2 I(8)=log8=3

11 2011/12/30

2-8

信息论与编码习题参考答案(全)

信息论与编码习题参考答案 第一章 单符号离散信源同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:(3)信源空间:bit x H 32.436log 3616236log 36215)(=⨯⨯+⨯⨯=∴ (4)信源空间:bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解:bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率bitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知bitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为%.如果你问一位男士:“你是否是红绿色盲”他的回答可能是:“是”,也可能“不是”。

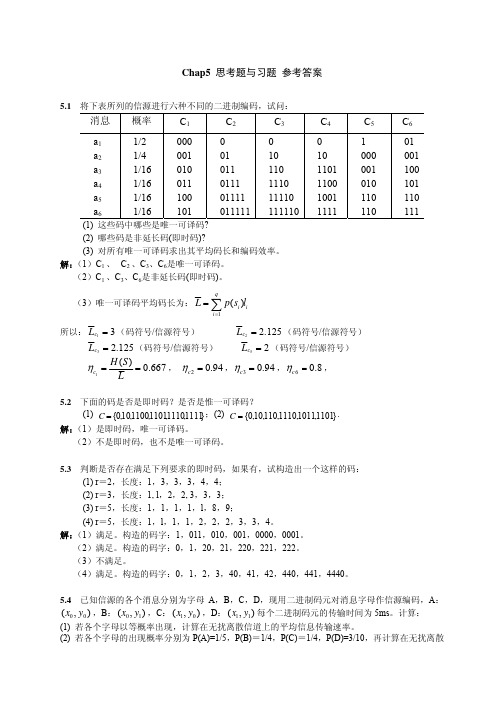

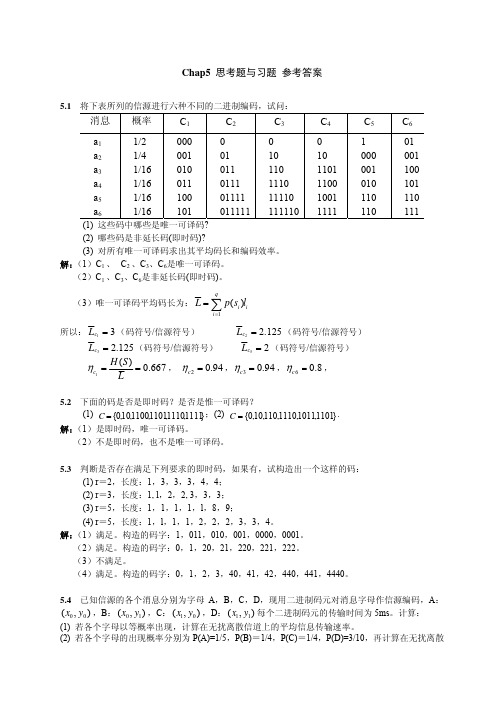

信息论与编码技术第五章课后习题答案

码,并求出其编码效率。

解:

信源符号 概率 编码

码字 码长

X1

3/8 0

0

1

X2

1/6 1

0

10 2

X3

1/8

1

11 2

X4

1/8 2

0

20 2

X5

1/8

1

21 2

X6

1/12

2

22 2

H(X)=-((3/8)*log(3/8)+(1/6)*log(1/6)+(1/8)*log(1/8)+(1/8)*log(1/8)+(1/8)*log(1/8)+(1/12)*log(1/12))

=2.3852 (三进制单位/信源符号)

H3(X)= H(X)/ 1.5850=2.3852/1.5850= 1.5049(三进制单位/信源符号)

L =(3/8)*1+ (1/6)*2+ (1/8)*2+ (1/8)*2+ (1/8)*2+ (1/12)*2=1.625(码符号/信源符号)

η= H3(X)/ L =1.5049/1.625= 92.61 %

5.8 已知符号集合 {x1, x2 , x3,"} 为无限离散消息集合,它们出现的概率分别为 p(x1) = 1/ 2 , p(x2 ) = 1/ 4 , p(x3 ) = 1/ 8 , p(xi ) = 1/ 2i ,……。

(1) 用香农编码方法写出各个符号消息的码字。 (2) 计算码字的平均信息传输速率。

L =4*(1/4)*1=1(码符号/信源符号)

Rt= H(X)/(t* L )=1/(1*10*10-2)=10(比特/秒)

信息论与编码课后习题答案

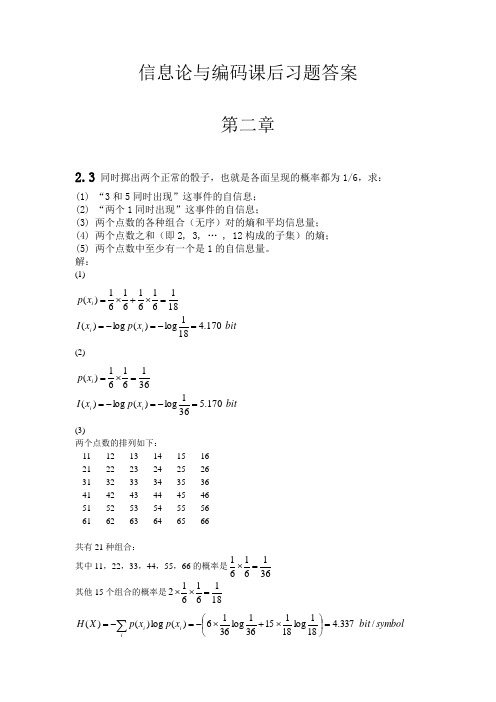

信息论与编码课后习题答案第二章2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

解:(1)bitx p x I x p i i i 170.4181log )(log )(18161616161)(=-=-==⨯+⨯=(2)bitx p x I x p i i i 170.5361log )(log )(3616161)(=-=-==⨯=(3)两个点数的排列如下: 11 12 13 14 15 16 21 22 23 24 25 26 31 32 33 34 35 36 41 42 43 44 45 46 51 52 53 54 55 56 61 62 63 64 65 66共有21种组合:其中11,22,33,44,55,66的概率是3616161=⨯ 其他15个组合的概率是18161612=⨯⨯ symbol bit x p x p X H ii i / 337.4181log 18115361log 3616)(log )()(=⎪⎭⎫ ⎝⎛⨯+⨯-=-=∑参考上面的两个点数的排列,可以得出两个点数求和的概率分布如下:symbolbit x p x p X H X P X ii i / 274.3 61log 61365log 365291log 912121log 1212181log 1812361log 3612 )(log )()(36112181111211091936586173656915121418133612)(=⎪⎭⎫ ⎝⎛+⨯+⨯+⨯+⨯+⨯-=-=⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡∑(5)bit x p x I x p i i i 710.13611log)(log )(3611116161)(=-=-==⨯⨯=2.42.12 两个实验X 和Y ,X={x 1 x 2 x 3},Y={y 1 y 2 y 3},l 联合概率(),i j ij r x y r =为1112132122233132337/241/2401/241/41/2401/247/24r r r r r r rr r ⎛⎫⎛⎫⎪ ⎪= ⎪ ⎪ ⎪ ⎪⎝⎭⎝⎭(1) 如果有人告诉你X 和Y 的实验结果,你得到的平均信息量是多少?(2) 如果有人告诉你Y 的实验结果,你得到的平均信息量是多少?(3) 在已知Y 实验结果的情况下,告诉你X 的实验结果,你得到的平均信息量是多少?解:联合概率(,)i j p x y 为 22221(,)(,)log (,)724112log 4log 24log 4247244i j i j ijH X Y p x y p x y ==⨯+⨯+∑=2.3bit/符号X 概率分布 21()3log 3 1.583H Y =⨯=bit/符号(|)(,)() 2.3 1.58H X Y H X Y H Y =-=- Y 概率分布是 =0.72bit/符号 Y y1 y2 y3 P8/248/248/242.15P(j/i)=2.16 黑白传真机的消息元只有黑色和白色两种,即X={黑,白},一般气象图上,黑色的Y X y1y 2 y 3 x 1 7/24 1/24 0 x 2 1/24 1/4 1/24 x 31/247/24X x 1 x 2 x 3 P8/248/248/24出现概率p(黑)=0.3,白色出现的概率p(白)=0.7。

信息论与编码答案

《信息论与编码(第二版)》雪虹答案第二章2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =,()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下状态转移矩阵为:1/21/201/302/31/32/30p ⎛⎫ ⎪= ⎪ ⎪⎝⎭设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3由1231WP W W W W =⎧⎨++=⎩得1231132231231112331223231W W W W W W W W W W W W ⎧++=⎪⎪⎪+=⎪⎨⎪=⎪⎪⎪++=⎩计算可得1231025925625W W W ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩ 2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。

画出状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p ==(0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p ==(1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p ==于是可以列出转移概率矩阵:0.80.200000.50.50.50.500000.20.8p ⎛⎫ ⎪⎪= ⎪ ⎪⎝⎭状态图为:设各状态00,01,10,11的稳态分布概率为W 1,W 2,W 3,W 4 有411i i WP W W ==⎧⎪⎨=⎪⎩∑ 得 13113224324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=⎧⎪+=⎪⎪+=⎨⎪+=⎪+++=⎪⎩ 计算得到12345141717514W W W W ⎧=⎪⎪⎪=⎪⎨⎪=⎪⎪⎪=⎩2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求: (1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

信息论与编码第二版第2章习题答案

2 3 4 5 6 7 8 9 10 11 12 X 1 1 1 1 5 1 5 1 1 1 1 = P ( X ) 36 18 12 9 36 6 36 9 12 18 36 H ( X ) = −∑ p ( xi ) log p ( xi )

画出状态图,并计算各状态的稳态概率。 解: p (0 | 00) = p (00 | 00) = 0.8

p (0 | 01) = p (10 | 01) = 0.5 p (0 |10) = p (00 |10) = 0.5 p (1| 01) = p (11| 01) = 0.5 p (1|10) = p (01|10) = 0.5

15 25 35 45 55 65

16 26 36 46 56 66

1 1 1 × = 6 6 36

1 1 1 × = 6 6 18

1 1 1 1 H ( X ) = −∑ p ( xi ) log p ( xi ) = − 6 × log + 15 × log = 4.337 bit / symbol 36 18 18 36 i

2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为: p (0 | 00) =0.8, p (0 |11) =0.2,

p (1| 00) =0.2, p (1|11) =0.8, p (0 | 01) =0.5, p (0 |10) =0.5, p (1| 01) =0.5, p (1|10) =0.5。

87.81 = 1.95 bit/符号 45

2-14 (1)

P(ij)=

P(i/j)=

(2) 方法 1:

信息论与编码技术第五章课后习题答案

信源符 符 号 概 第一次 第二次 第三次 第四次 第五次 第 六 次 第 七 次 二元码

号 xi 率 pi

分组 分组 分组 分组 分组 分组 分组

x1

1/2

0

0

x2

1/4

0

10

x3

1/8

0

110

x4

1/16

0

1110

x5

1/32

1

0

1

x6

1/64

1

0

1

x7

1/128

1

1

x8

1/128

(5)香农码和费诺码相同

(1/8)+0* (1/8)=2/3

p0 =p(0| a0)*p(a0)+ p(0| a1)*p(a1)+ p(0| a2)*p(a2)+ p(0| a3)*p(a3)=1*(1/2)+ (1/2)* (1/4)+ (1/3)* (1/8)+0*

(1/8)=2/3

p1 =p(1| a0)*p(a0)+ p(1| a1)*p(a1)+ p(1| a2)*p(a2)+ p(1| a3)*p(a3)=0*(1/2)+ (1/2)* (1/4)+ (2/3)* (1/8)+1*

8

∑ 解:(1) H ( X ) = − pi log pi = 1.984 (bit/信源符号) i

(2) 每个信源使用 3 个二进制符号,

出现 0 的次数为:

出现 1 的次数为:

所以:P(0)=

,P(1)=

(3) 因为 K = 3 ,所以 η = 0.661

(4) 相应的香农编码 信 源 符 号 符 号 概 率 累 加 概 率 -Logp(xi)