hadoop集群版本升级方案v1.0

Hadoop集群的升级与扩容策略探讨

Hadoop集群的升级与扩容策略探讨在大数据时代,Hadoop作为一种开源的分布式计算框架,被广泛应用于各行各业。

然而,随着数据量的不断增长和业务需求的变化,原有的Hadoop集群可能无法满足当前的需求。

因此,升级和扩容成为了许多企业面临的问题。

本文将探讨Hadoop集群的升级与扩容策略。

首先,我们需要明确升级和扩容的概念。

升级是指将Hadoop集群从旧版本升级到新版本,以获得更好的性能和功能。

扩容则是指向现有Hadoop集群中增加新的节点,以增加集群的计算和存储能力。

在进行升级和扩容之前,我们首先需要评估当前Hadoop集群的状况和性能。

这可以通过监控集群的资源利用率、任务执行时间和数据处理能力等指标来实现。

通过评估,我们可以确定是否需要进行升级和扩容,并且为后续的决策提供依据。

对于升级来说,我们需要考虑以下几个方面。

首先是版本的选择。

在选择升级版本时,我们需要考虑新版本的稳定性、兼容性和功能改进等因素。

同时,我们还需要评估升级对现有业务的影响,以及升级所需的时间和资源投入。

在确定升级版本后,我们需要进行充分的测试和验证,以确保升级过程的可行性和稳定性。

对于扩容来说,我们需要考虑以下几个方面。

首先是硬件的选择。

在选择新节点时,我们需要考虑节点的配置、性能和可扩展性等因素。

同时,我们还需要评估新节点的成本和投入产出比,以确保扩容的经济性和可行性。

其次是数据迁移和负载均衡。

在扩容后,我们需要将现有数据迁移到新节点上,并且重新分配任务和负载,以实现集群资源的均衡利用。

最后是集群的监控和管理。

扩容后,我们需要及时监控和管理新节点,以保证集群的稳定运行和高效利用。

除了升级和扩容外,我们还可以考虑其他一些策略来优化Hadoop集群的性能和扩展能力。

例如,可以采用数据分区和压缩技术来减少数据的存储和传输开销。

可以采用容器化和虚拟化技术来提高集群的资源利用率和灵活性。

可以采用自动化和智能化管理工具来简化集群的运维和管理。

大数据平台简介

大数据平台简介

大数据平台简介

目录

Hadoop生态系统 Hadoop主流厂商 HDFS MapReduce Hive Spark

Hadoop生态系统

Hadoop 1.0 V 2.0

Hadoop生态系统

Ambari (安装部署工具)

Zookeeper (分布式协调服务)

HDFS的基本结构之 NameNode

Namenode是一个中心服务器负责管理文件系统的命名空间 协调客户端对文件的访问 Namenode执行文件系统的命名空间操作例如打开、关闭、重命名文件和目录 记录每个文件数据块在各个Datanode上的位置和副本信息

HDFS元数据持久化

NameNode存有HDFS的元数据:主要由FSImage和EditLog组成 FSImage是元数据镜像文件 保存整个文件系统的目录树 数据块映射关系:文件与数据块映射关系DataNode与数据块映射关系 EditLog是元数据操作日志记录每次保存fsimage之后到下次保存之间的所有hdfs操作

HBase (分布式协数据库)

Oozie (作业流调度系统)

HDFS (分布式存储系统)

YARN (分布式计算框架)

MapReduce (离线计算)

Tez (DAG计算)

Spark (内存计算)

Hive

Pig

Mahout

Sqoop (数据库TEL工具)

Flume (日志收集)

……

……

HDFS-Hadoop Distributed

无法高效存储大量小文件

HDFS现在遇到的主要问题

分布后的文件系统有个无法回避的问题因为文件不在一个磁盘导致读取访问操作的延时这个是HDFS现在遇到的主要问题

HADOOP 1.0与2.0区别

HADOOP2.0较1.0版本的进步1.1从Hadoop整体框架来说,Hadoop1.0即第一代Hadoop,由分布式存储系统HDFS和分布式计算框架MapReduce组成,其中HDFS由一个NameNode和多个DateNode组成,MapReduce由一个JobTracker 和多个TaskTracker组成。

Hadoop2.0即第二代Hadoop为克服Hadoop1.0中的不足:针对Hadoop1.0单NameNode制约HDFS的扩展性问题,提出HDFS Federation,它让多个NameNode分管不同的目录进而实现访问隔离和横向扩展,同时彻底解决了NameNode单点故障问题,单点故障是通过主备NameNode切换实现的,这是一种古老的解决服务单点故障的方案,主备NameNode之间通过一个共享存储同步元数据信息,因此共享存储系统的选择称为关键而Hadoop则提供了NFS、QJM和Bookeeper三种可选的共享存储系统,HDFS Federation实现的,它允许一个HDFS集群中存在多个NameNode,每个NameNode分管一部分目录,而不同NameNode之间彼此独立,共享所有DataNode的存储资源,注意,NameNode Federation中的每个NameNode仍存在单点问题,需为每个NameNode提供一个backup以解决单点故障问题;针对Hadoop1.0中的MapReduce在扩展性和多框架支持等方面的不足,它将JobTracker中的资源管理和作业控制分开,分别由ResourceManager(负责所有应用程序的资源分配)和ApplicationMaster(负责管理一个应用程序)实现,即引入了资源管理框架Yarn。

1.2从MapReduce计算框架来讲MapReduce1.0计算框架主要由三部分组成:编程模型、数据处理引擎和运行时环境。

它的基本编程模型是将问题抽象成Map和Reduce两个阶段,其中Map阶段将输入的数据解析成key/value,迭代调用map()函数处理后,再以key/value 的形式输出到本地目录,Reduce阶段将key相同的value进行规约处理,并将最终结果写到HDFS上;它的数据处理引擎由MapTask和ReduceTask组成,分别负责Map阶段逻辑和Reduce阶段的逻辑处理;它的运行时环境由一个JobTracker和若干个TaskTracker两类服务组成,其中JobTracker负责资源管理和所有作业的控制,TaskTracker负责接收来自JobTracker的命令并执行它。

Hadoop-1.0.0集群安装

9.部署slave节点 将master.hadoop上安装配置完成的hadoop文件夹复制到slave1.hadoop和slave2.hadoop: hduser@master: hadoop$ scp -r /usr/local/hadoop hduser@slave1.hadoop:/usr/local/ hduser@master: hadoop$ scp -r /usr/local/hadoop hduser@slave2.hadoop:/usr/local/

pagecomatlassianjirapluginsystemissuetabpanels新发布版本比较容易出现低级错误要么等下一个版本修复这个问题要么自己搭建一套hadoop开发环境用svnsvnapacheorg上获取源代码用eclipse在源代码上应用这个补丁并重新buildhadoop才能解决

这样就能无密码登录,如下图:

7.在 master.hadoop 上安装 Hadoop

# cd /usr/local # tar xzf hadoop-1.0.0.tar.gz # mv hadoop-1.0.0 hadoop # chown -R hduser:hadoop hadoop

#vi /home/hduser/.bashrc # Some convenient aliases and functions for running Hadoop-related commands unalias fs &> /dev/null alias fs="hadoop fs" unalias hls &> /dev/null alias hls="fs -ls"

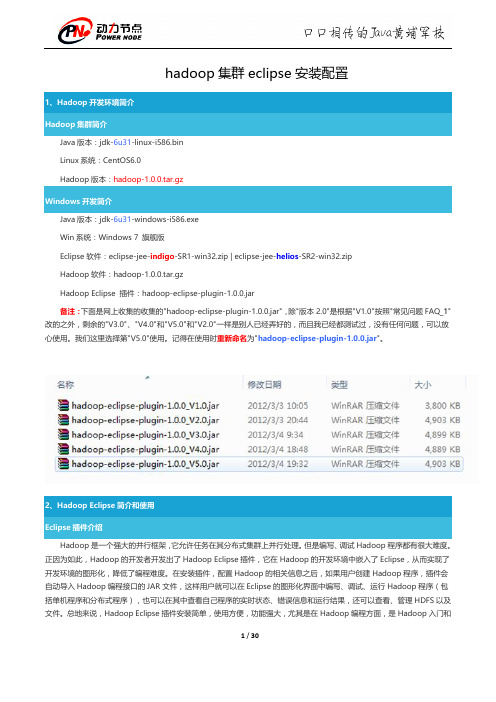

hadoop集群eclipse安装配置

第二步: 选择"Window"菜单下的"Preference", 然后弹出一个窗体, 在窗体的左侧, 有一列选项, 里面会多出"Hadoop Map/Reduce"选项, 点击此选项, 选择 Hadoop 的安装目录 (如我的 Hadoop 目录: E:\HadoopWorkPlat\hadoop-1.0.0) 。 结果如下图:

"中的"

",点击"Other"选项,也可以弹出上图,从中选

7 / 30

第四步:建立与 Hadoop 集群的连接,在 Eclipse 软件下面的"Map/Reduce Locations"进行右击,弹出一个选项,选 择"New Hadoop Location",然后弹出一个窗体。

8 / 30

注意上图中的红色标注的地方,是需要我们关注的地方。

hadoop fs -ls

Байду номын сангаас

12 / 30

到此为止,我们的 Hadoop Eclipse 开发环境已经配置完毕,不尽兴的同学可以上传点本地文件到 HDFS 分布式文件上, 可以互相对比意见文件是否已经上传成功。 3、Eclipse 运行 WordCount 程序 配置 Eclipse 的 JDK 如果电脑上不仅仅安装的 JDK6.0,那么要确定一下 Eclipse 的平台的默认 JDK 是否 6.0。从"Window"菜单下选择 "Preference",弹出一个窗体,从窗体的左侧找见"Java",选择"Installed JREs",然后添加 JDK6.0。下面是我的默认选择 JRE。

hadoop升级

hadoop升级1.运行dfsadmin -upgradeProgress status 检查是否存在备份如果是第一次升级就不存在备份(在升级Hadoop前,如果已经存在备份,需要先结束 finalize 它。

)2.备份node.dir下文件,同时要备份下hdfs的文件目录的元数据信息:bin/hadoop fsck / -files -blocks -locations > dfs-v-old-fsck-1.logbin/hadoop dfs -lsr / > dfs-v-old-lsr-1.logbin/hadoop dfsadmin -report > dfs-v-old-report-1.log3.停止所有节点 bin/stop-all.sh4.在所有节点上重新部署hadoop 并替换conf文件夹下所有文件(就是将原有的hadoop-0.19.1更名为hadoop-0.19.1-oldverstion,然后解压hadoop-0.19.2.tar.gz 将0.19.2中的conf文件替换为0.19.1中的conf文件夹)并且要对照修改hadoop-site.xml中的路径指定是否正确5.使用 bin/start-dfs.sh -upgrade 进行升级(DFS从一个版本升级到另外一个版本的时候,NameNode和DataNode使用的文件格式有可能会改变。

当你第一次使用新版本的时候,你要告诉Hadoop 去改变HDFS版本,否则,新版本不会生效)6.监控升级情况和升级问题处理开始升级,你可以通过bin/hadoop dfsadmin -upgradeProgress命令来查看版本升级的情况。

当然你可以使用bin/hadoop dfsadmin -upgradeProgress details来查看更多的详细信息。

当升级过程被阻塞的时候,你可以使用bin/hadoop dfsadmin -upgradeProgress force来强制升级继续执行(当你使用这个命令的时候,一定要慎重考虑)。

Hadoop集群配置心得(低配置集群+自动同步配置)

Hadoop集群配置⼼得(低配置集群+⾃动同步配置)本⽂为本⼈原创,⾸发到炼数成⾦。

情况是这样的,我没有⼀个⾮常强劲的电脑来搞出⼀个性能⾮常NB的服务器集群,相信很多⼈也跟我差不多,所以现在把我的低配置集群经验拿出来写⼀下好了。

我的配备:1)五六年前的赛扬单核处理器2G内存笔记本 2)公司给配的ThinkpadT420,i5双核处理器4G内存(可⽤内存只有3.4G,是因为装的是32位系统的缘故吧。

)就算是⽤公司配置的电脑,做出来三台1G内存的虚拟机也显然是不现实的。

企业笔记本运⾏的软件多啊,什么都不做空余内存也才不到3G。

所以呢,我的想法就是:⽤我⾃⼰的笔记本(简称PC1)做Master节点,⽤来跑Jobtracker,Namenode 和SecondaryNamenode;⽤公司的笔记本跑两个虚拟机(简称VM1和VM2),⽤来做Slave节点,跑Tasktracker和Datanode。

这么做的话,就需要让PC1,VM1和VM2处于同⼀个⽹段⾥,保证他们之间可以互相连通。

⽹络环境:我的两台电脑都是通过⼀个⽆线路由上⽹。

构建跟外部的电脑同⼀⽹段的虚拟机配置过程:准备⼯作:构建⼀个集群,⾸先前提条件是每台服务器都要有⼀个固定的IP地址,然后才可能进⾏后续的操作。

所以呢,先把我的两台笔记本电脑全部设置成固定IP(注意,如果像我⼀样使⽤⽆线路由上⽹,那就要把⽆线⽹卡的IP设置成固定IP)。

⽤来做Master节点的PC1:192.168.33.150,⽤来跑虚拟机的宿主笔记本:192.168.33.157。

⽬标:VM1和VM2的IP地址分别设置成192.168.33.151和152。

步骤:1)新建VM1虚拟机。

2)打开VM1的⽹卡设置界⾯,连接⽅式选Bridge。

(桥接)关于桥接的具体信息,可以百度⼀下。

我们需要知道的,就是⽤桥接的⽅式,可以让虚拟机通过本机的⽹关来上⽹,所以就可以跟本机处于同⼀个⽹段,互相之间可以进⾏通信。

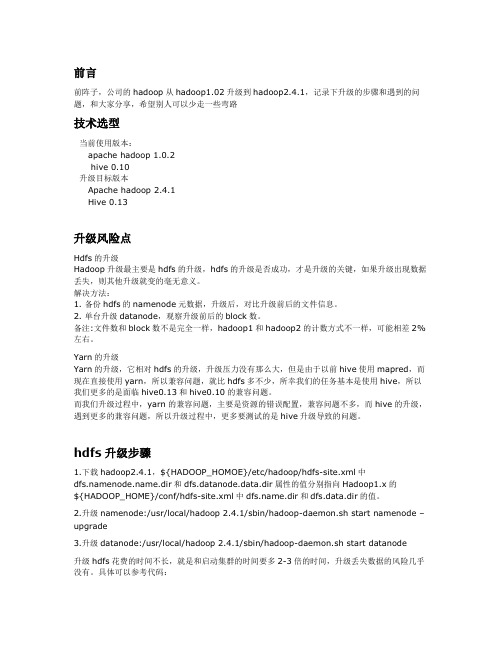

hadhoop2升级

前言前阵子,公司的hadoop从hadoop1.02升级到hadoop2.4.1,记录下升级的步骤和遇到的问题,和大家分享,希望别人可以少走一些弯路技术选型当前使用版本:apache hadoop 1.0.2hive 0.10升级目标版本Apache hadoop 2.4.1Hive 0.13升级风险点Hdfs的升级Hadoop升级最主要是hdfs的升级,hdfs的升级是否成功,才是升级的关键,如果升级出现数据丢失,则其他升级就变的毫无意义。

解决方法:1. 备份hdfs的namenode元数据,升级后,对比升级前后的文件信息。

2. 单台升级datanode,观察升级前后的block数。

备注:文件数和block数不是完全一样,hadoop1和hadoop2的计数方式不一样,可能相差2%左右。

Yarn的升级Yarn的升级,它相对hdfs的升级,升级压力没有那么大,但是由于以前hive使用mapred,而现在直接使用yarn,所以兼容问题,就比hdfs多不少,所幸我们的任务基本是使用hive,所以我们更多的是面临hive0.13和hive0.10的兼容问题。

而我们升级过程中,yarn的兼容问题,主要是资源的错误配置,兼容问题不多,而hive的升级,遇到更多的兼容问题,所以升级过程中,更多要测试的是hive升级导致的问题。

hdfs升级步骤1.下载hadoop2.4.1,${HADOOP_HOMOE}/etc/hadoop/hdfs-site.xml中.dir和dfs.datanode.data.dir属性的值分别指向Hadoop1.x的${HADOOP_HOME}/conf/hdfs-site.xml中.dir和dfs.data.dir的值。

2.升级namenode:/usr/local/hadoop 2.4.1/sbin/hadoop-daemon.sh start namenode –upgrade3.升级datanode:/usr/local/hadoop 2.4.1/sbin/hadoop-daemon.sh start datanode升级hdfs花费的时间不长,就是和启动集群的时间要多2-3倍的时间,升级丢失数据的风险几乎没有。

hadoop集群版本升级方案v1.0

hadoop集群版本升级方案v1.01.集群版本升级方案1.1.版本变化Hadoop版本:hadoop-2.3.0-cdh5.1.0 -> hadoop-2.6.0-cdh5.14.0Hbase版本:hbase-0.98.1-cdh5.1.0 -> hbase-1.2.0-cdh5.14.01.2.Hadoop集群版本升级1.2.1.Hadoop集群版本升级流程1.2.1.1.滚动升级1.准备新版本hadoop安装包,并上传到备节点并解压到指定目录。

2.将老版本的配置文件同步至新版本,并将新版本hadoop目录分发到全部节点。

3.备份hadoop元数据和编辑日志。

4.创建备份回滚镜像,用于集群升级失败回滚。

5.检查滚镜像状态,正常后方可继续执行。

6.升级journalnode服务。

7.升级zkfc服务。

8.升级备节点namenode服务。

9.同步备节点(原主节点)namenode服务。

10.升级datanode服务。

11.升级resourcemanager服务。

12.升级nodemanager服务。

13.更改所有节点的环境变量。

14.等待升级结束,使用hadoop fsck -blocks查看HDFS是否完整并健康运行。

15.待新版本集群稳定运行一段时间而没有任何问题,执行升级完成命令,整个hadoop集群版本升级结束。

1.2.1.2.停集群升级1.准备新版本hadoop安装包,并上传到备节点并解压到指定目录。

2.将老版本的配置文件同步至新版本,并将新版本hadoop目录分发到全部节点。

3.备份hadoop元数据和编辑日志。

4.停止所有业务,停止hbase服务,停止hadoop服务。

5.集群部署新版hadoop,更改环境变量。

6.升级journalnode服务。

7.升级zkfc服务。

8.升级主节点namenode服务。

9.同步备节点namenode服务。

10.重启集群(start-dfs.sh & start-yarn.sh)。

Hadoop的升级和回滚

caibinbupt

博客 微博 相册 收藏 留言 关于我

Hadoop的升级和回滚

Hadoop

当升级某个集群的Hadoop的时候,正如任何软件的升级一样,可能会引入新的 bug或者不兼容的修改导致现有的应用出现过去没有发现的问题。在所有重要的HDFS 安装应用中,是不允许出现因丢失任何数据需要从零开始重启HDFS的情况。HDFS允 许管理员恢复到 Hadoop的早期版本,并且将集群的状态回滚到升级前。HDFS的升级 细节请参考 upgrade wiki 。HDFS在任何时间只能有一个备份,因此在升级前,管 理员需要通过'bin/hadoop 命令移除现有的备份。下 面简要描述了典型的升级过程:

1)在升级Hadoop前,如果已经存在备份,需要先结束(finalize)它。 可以通过'dfsadmin -upgradeProgress status'命令查询集群是否需要执 行finalize 2)停止集群,分发部署新版本的Hadoop 3)执行新版本的hadoop,通过添加 -upgrade 选项,例如/bin/startdfs.sh -upgrade 4)大多数情况下,集群在升级后可以正常运行。一旦新的HDFS在运行 若干天的操作后没有出现问题,那么就可以结束(finalize)这次升级。请 注意,在升级前删除的文件并不释放在datanode上的实际磁盘空间,直到集 群被结束(finalize)升级前。 5)如果有需要回到老版本的Hadoop,那么可以:

a)停止集群,分发部署老版本的Hadoop

b)通过rollback选项启动集群,例如bin/start-dfs.sh -rollback

Hadoop培训 Hadoop 存储系统 Apache Kudu 1.0.0 发布_光环大数据培训

Hadoop培训 Hadoop 存储系统 Apache Kudu 1.0.0 发布_光环大数据培训Apache Kudu 1.0.0 发布,该版本添加了一些新特性。

部分更新内容如下:Removal of multiversion concurrency control (MVCC) history is now supported. This allows Kudu to reclaim disk space, where previously Kudu would keep a full history of all changes made to a given table since the beginning of time.Most of Kudu’s c ommand line tools have been consolidated under a new top-level "kudu" tool. This reduces the number of large binaries distributed with Kudu and also includes much-improved help output.Administrative tools including "kudu cluster ksck" now support running against multi-master Kudu clusters.The C++ client API now supports writing data in AUTO_FLUSH_BACKGROUND mode. This can provide higher throughput for ingest workloads.还有其他的Bug修复、优化和提升,点击这里查看详细更新内容下载地址:/releases/1.0.0/Apache Kudu 简介为了应对先前发现的这些趋势,有两种不同的方式:持续更新现有的hadoop工具或者重新设计开发一个新的组件。

hadoop—集群维护手册

h a d o o p—集群维护手册work Information Technology Company.2020YEARHadoop部分启动命令:start-all.sh停止命令:stop-all.shHadoop运行增加集群的存储量/节点如果只增加集群的存储量,建议增加Hadoop datanode节点。

步骤:1、停掉集群包括Hadoop和hbase,当然也可以不停掉,直接在hadoop namenode的配置文件Slave里添加新节点的host,别忘了在host文件里也要添加新添加的host名。

2、执行bin/start-all.sh启动集群3、以下选择一种1)如果不手动作平衡,插入的数据将会放在新添加的节点上。

以趋于平衡。

2)如果手动平衡,则 start-balancer.sh和调用bin/sHadoop balancer命令相似,也可加参数 -threshold 5(threshold 是平衡阈值,默认是10%,值越低各节点越平衡,但消耗时间也更长)。

在使用start-balancer.sh时,如果在hdfs-site.xml里面没有配置dfs.balance.bandwidthPerSec,那么集群hdfs内部默认使用1M/S的速度移动数据(so slowly...),我们可以通过在hdfs-site.xml里面配置dfs.balance.bandwidthPerSec来加快balance的速度。

最开始我们配置的是20m/S ,然后结果是导致job运行变得不稳定,出现一些意外的长map单元,某些reduce时间处理变长(整个集群负载满满的情况下,外加20m/s的balance),在前天的中国hadoop年会上听淘宝调整的为10m/s,需要调整后实验,看看情况如何。

另外再修改dfs.balance.bandwidthPerSec参数后,需要在namenode上运行stop-dfs.sh start-dfs.sh重启hdfs生效。

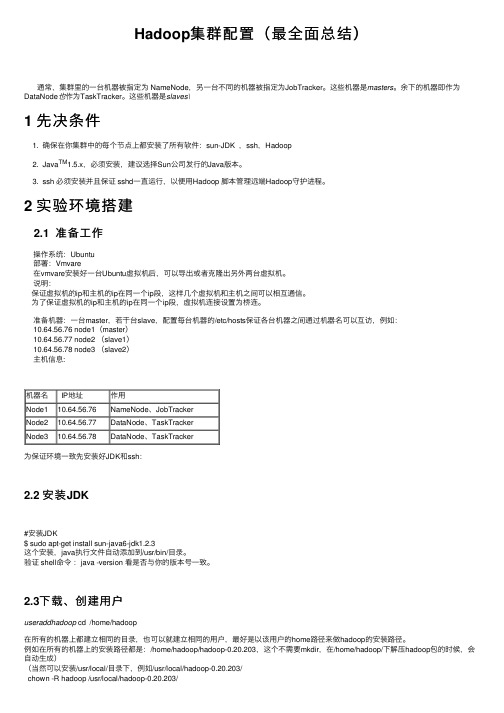

Hadoop集群配置(最全面总结)

Hadoop集群配置(最全⾯总结)通常,集群⾥的⼀台机器被指定为 NameNode,另⼀台不同的机器被指定为JobTracker。

这些机器是masters。

余下的机器即作为DataNode也作为TaskTracker。

这些机器是slaves\1 先决条件1. 确保在你集群中的每个节点上都安装了所有软件:sun-JDK ,ssh,Hadoop2. Java TM1.5.x,必须安装,建议选择Sun公司发⾏的Java版本。

3. ssh 必须安装并且保证 sshd⼀直运⾏,以便⽤Hadoop 脚本管理远端Hadoop守护进程。

2 实验环境搭建2.1 准备⼯作操作系统:Ubuntu部署:Vmvare在vmvare安装好⼀台Ubuntu虚拟机后,可以导出或者克隆出另外两台虚拟机。

说明:保证虚拟机的ip和主机的ip在同⼀个ip段,这样⼏个虚拟机和主机之间可以相互通信。

为了保证虚拟机的ip和主机的ip在同⼀个ip段,虚拟机连接设置为桥连。

准备机器:⼀台master,若⼲台slave,配置每台机器的/etc/hosts保证各台机器之间通过机器名可以互访,例如:10.64.56.76 node1(master)10.64.56.77 node2 (slave1)10.64.56.78 node3 (slave2)主机信息:机器名 IP地址作⽤Node110.64.56.76NameNode、JobTrackerNode210.64.56.77DataNode、TaskTrackerNode310.64.56.78DataNode、TaskTracker为保证环境⼀致先安装好JDK和ssh:2.2 安装JDK#安装JDK$ sudo apt-get install sun-java6-jdk1.2.3这个安装,java执⾏⽂件⾃动添加到/usr/bin/⽬录。

验证 shell命令:java -version 看是否与你的版本号⼀致。

Hadoop集群部署文档

Hadoop集群部署文档By Superxgl1.分布式运行模式下面的内容我们将重点介绍hadoop分布式模式如何部署。

3.1机器说明本文使用四台机器搭建集群环境,机器名分别为master,slave01,slave02,slave03,可通过切换到root用户执行# hostname -v new_host_name来更改域名。

四台机器均安装CentOS 5.3操作系统(其它Linux 发行版亦可)。

3.2用机器名Ping通机器确保各台机器之间网络畅通,机器名与IP 地址之间解析正确,从任一台机器都可以ping 通其它机器的机器名。

如有机器名的解析问题无法ping通,可通过设置/etc/hosts 文件解决,当然更好的解决方法是在你的网络中配置DNS 服务器。

在这里我们通过设置/etc/hosts 文件来解决机器名的解析问题。

master,slave01,slave02,slave03的/etc/hosts 文件的设置如下图:$ su –#vi /etc/hosts我们将使用master 作为分布式文件系统HDFS 的Name Node及MapReduce 运行过程中的Job Tracker 结点,我们将master称之为主结点。

其它三台机器(slave01,slave02,slave03) 作为HDFS 的Data Node以及MapReduce 运行过程中的Task Tracker 结点,这些结点可统称为从结点。

如你需要部署更多的机器,也是很容易的,将新加入的机器作为Data Node以及Task Tracker 结点即可,其配置过程与本文介绍的四台机器的环境类似,此不赘述。

3.3新建系统had oop用户Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户,所以需要每台机器建一个同名的用户。

如hadoop, 或直接使用root 帐号亦可。

在这里我们推荐使用普通账户hadoop。

《Hadoop权威指南:大数据的存储与分析》笔记

《Hadoop权威指南:大数据的存储与分析》阅读随笔目录一、Hadoop简介 (3)1.1 Hadoop的发展历程 (4)1.2 Hadoop的核心组件 (6)1.2.1 Hadoop分布式文件系统 (6)1.2.2 MapReduce编程模型 (8)1.2.3 YARN资源管理器 (9)二、Hadoop的安装与配置 (11)2.1 安装前的准备 (13)2.2 安装步骤 (14)2.3 验证安装 (16)三、Hadoop的数据存储 (17)3.1 HDFS的工作原理 (17)3.2 HDFS的高级特性 (19)3.2.1 数据副本机制 (21)3.2.2 数据块大小调整 (22)3.3 HDFS的使用和管理 (23)3.3.1 文件的上传和下载 (24)3.3.2 集群管理和维护 (25)四、Hadoop的数据分析 (27)4.1 MapReduce的工作流程 (29)4.2 MapReduce的应用案例 (30)4.3 Hive和Pig的使用 (31)4.3.1 Hive的使用 (32)4.3.2 Pig的使用 (33)五、Hadoop的性能优化 (34)5.1 网络优化 (36)5.2 内存优化 (37)5.3 磁盘优化 (39)六、Hadoop的安全管理 (39)6.1 用户和权限管理 (41)6.2 数据加密 (42)6.3 安全审计 (44)七、Hadoop的实践与应用 (45)7.1 电商网站数据存储与分析 (47)7.2 金融数据分析 (49)7.3 医疗健康数据存储与分析 (51)八、总结与展望 (52)8.1 Hadoop的优势与挑战 (54)8.2 未来发展趋势 (56)一、Hadoop简介Hadoop是一个开源的分布式存储和计算框架,它的核心思想是将大规模数据分散到多个计算节点上进行处理,从而实现对大数据的有效管理和分析。

Hadoop的出现极大地推动了大数据处理技术的发展,使得企业能够更有效地利用存储在海量数据中的有价值的信息。

Hadoop集群搭建指南V0.1

Hadoop集群搭建指南修订历史记录环境准备 (3)UBUNTU环境配置 (3)2.1安装SSH (3)2.2关闭防火墙 (3)2.3安装FTP S ERVER (3)2.4安装JDK (4)2.4.1解压安装 (4)2.4.2配置环境变量 (4)2.4.3配置默认JDK (4)2.4.4测试JDK (5)HADOOP集群的安装 (5)3.1H ADOOP节点的说明 (5)3.2环境说明 (6)3.2.1先决条件 (6)3.2.2服务器规划 (6)3.2.3使用主机名通信 (6)3.2.4在所有的机器上建立同样的用户 (7)3.3H ADOOP的安装 (8)3.3.1SSH无密码验证登录 (8)3.3.2Hadoop安装 (9)3.4H ADOOP的配置 (10)3.4.1配置文件说明 (10)3.4.2Master配置 (10)3.4.3Slave配置 (13)3.4.4Hadoop的启动及验证 (14)常见问题 (17)4.1问题1:CANNOT CREATE DIRECTORY: (17)4.2问题2:W ARNING:$HADOOP_HOME IS DEPRECATED (18)环境准备操作系统:Ubuntu Server 13.04JDK:1.7 从oracle网站上下载,而非openjdkHadoop: /hadoop/common/hadoop-1.2.0/Ubuntu环境配置2.1安装SSH在安装Ubuntu Server最后的时候选择openssh Server的安装。

如果没有选择,使用以下命令进行安装Sudo ap-get install openssh-server确认SSH Server是否启动:ps -e |grep ssh如果只有ssh-agent那ssh-server还没有启动,需要/etc/init.d/ssh start,如果看到sshd 那说明ssh-server已经启动了。

Hadoop生态系统概述以及版本演化

Hadoop构成 YARN(资源管理系统)

Hadoop构成 YARN(资源管理系统)

Hadoop构成 MapReduce(分布式计算框架)

源自于Google的MapReduce论文

发表于2004年12月 Hadoop MapReduce是Google MapReduce克隆版

MapReduce特点

Spark …

(内存计算)

YARN

(分布式计算框架)

HDFS

(分布式存储系统)

Flume (日志收集 )

Hadoop构成 Hive(基于MR的数据仓库)

由facebook开源,最初用于解决海量结构化的日志数据统 计问题;

ETL(Extraction-Transformation-Loading)工具

Hadoop构成 YARN(资源管理系统)

YARN是什么

Hadoop 2.0新增系统 负责集群的资源管理和调度 使得多种计算框架可以运行在一个集群中

YARN的特点

良好的扩展性、高可用性 对多种类型的应用程序进行统一管理和调度 自带了多种多用户调度器,适合共享集群环境

Hadoop构成 YARN(资源管理系统)

Hadoop介绍 概述

分布式存储系统HDFS(Hadoop Distributed File System)

分布式存储系统 提供了高可靠性、高扩展性和高吞吐率的数据存储服务

资源管理系统YARN(Yet Another Resource Negotiator)

负责集群资源的统一管理和调度

分布式计算框架MapReduce

构建在Hadoop之上的数据仓库;

数据计算使用MR,数据存储使用HDFS

Hive 定义了一种类 SQL 查询语言——HQL;

大数据挖掘工具资料收集之RhadoopV1.0

1基本介绍1.1简介RHadoop是运行R语言的Hadoop分布式计算平台的简称。

要认识Rhadoop首先我们分别来认识R语言和Hadoop。

Hadoop已经成名好多年了,它是Apache软件基金会旗下的一个JAVA开源分布式计算平台,现已被各大互联网企业(包括Yahoo和Facebook等)用于大规模数据分布式存储与分布式计算。

近年来随着云计算、大数据处理、数据挖掘等概念和应用越来越火,Hadoop更是名声大噪,各大企业对熟悉Hadoop体系架构和性能优化的人才需求也相当旺盛,人才缺口也相对加大。

R语言可能对大多数人来说比较陌生,但是做数理统计、数据分析的人不会不知道R。

R 是一门主要运用于统计分析与绘图的编程语言和操作工具。

和Matlab类似,R是一门高级脚本化编程语言,直接在命令行输入指令即可运行,无需编译链接。

它可以进行高效的向量化运算,效率远高于传统的循环运算。

另外,R是开源的,有大批杰出的工程师和程序员为R开发了许多好用的函数库和图形化工具,尤其在数理统计方面有大量成熟的开源的程序包。

所以R是做数据挖掘、数据分析的廉价高效的方案。

1.2功能Rhadoop是将R的强大统计分析能力和hadoop的大数据处理能力相结合,可由以下几项功能组成。

●R内置多种统计学及数字分析功能●R的另一强项是绘图功能,制图具有印刷的素质,也可加入数学符号●Hadoop分布式文件系统,高吞吐量的数据级别达到TB、PB甚至EB●Mapreduce高效并行计算1.3常用算法包Rhadoop中的数据挖掘算法均来自R语言(或者说R软件),常用算法包如下:1.3.1聚类∙常用的包: fpc,cluster,pvclust,mclust∙基于划分的方法: kmeans, pam, pamk, clara∙基于层次的方法: hclust, pvclust, agnes, diana∙基于模型的方法: mclust∙基于密度的方法: dbscan∙基于画图的方法: plotcluster, plot.hclust∙基于验证的方法: cluster.stats1.3.2分类∙常用的包:rpart,party,randomForest,rpartOrdinal,tree,marginTree,maptree,survival∙决策树: rpart, ctree∙随机森林: cforest, randomForest∙回归, Logistic回归, Poisson回归: glm, predict, residuals∙生存分析: survfit, survdiff, coxph1.3.3关联规则与频繁项集∙常用的包:arules:支持挖掘频繁项集,最大频繁项集,频繁闭项目集和关联规则DRM:回归和分类数据的重复关联模型∙APRIORI算法,广度RST算法:apriori, drm∙ECLAT算法:采用等价类,RST深度搜索和集合的交集: eclat 1.3.4序列模式∙常用的包: arulesSequences∙SPADE算法: cSPADE1.3.5时间序列∙常用的包: timsac∙时间序列构建函数: ts∙成分分解: decomp, decompose, stl, tsr1.3.6人工神经网络∙nnet1.3.7支持向量机∙e10711.3.8统计∙常用的包: Base R, nlme∙方差分析: aov, anova∙密度分析: density∙假设检验: t.test, prop.test, anova, aov∙线性混合模型:lme∙主成分分析和因子分析:princomp1.3.9接入数据挖掘软件Weka算法包∙RWeka: 通过这个接口,可以在R中使用Weka的所有算法。

Brocade-VDX系统升级及配置

1.升级NOS因为设备出厂时的版本基本都很陈旧,直接上线会造成不必要的麻烦,因此直接升级稳定版本,可以减少上线后很多不必要的工作量。

博科TAC针对每款设备都有版本推荐,Target Path Selection Guide,建议每次项目交付前,首先登陆到下载页面,下载TAC推荐的稳定版本。

具体升级步骤:把nos文件解压,然后拷贝到根目录c:/nos4.1.2下面。

在ftp软件上的根目录用C:\描述即可vdx6710‐54# firmware download interactiveServer name or IP address: 172.16.1.1File name: nos4.1.2Protocol (ftp, scp, sftp): ftpUser: brocadePassword: **********Reboot system after download? [y/n]:yDo Auto‐Commit after Reboot? [y/n]:yPerforming system sanity check...Do you want to continue? [y/n]:yChecking conditions for downloading to 4.1.22015/01/28‐03:07:16, [HASM‐1120], 1545,, INFO, VDX6710‐54, Current version 4.0.1.You are running firmwaredownload with auto‐reboot and auto‐commit enabled. After the firmware is downloaded the system will reboot and commit firmware automatically.2015/01/28‐03:07:16, [SULB‐1105], 1546,, WARNING, VDX6710‐54, Firmware upgrade session (0:single MM upgrade) starts.2015/01/28‐03:07:16, [SULB‐1100], 1547,, INFO, VDX6710‐54, Firmware install begins on SWITCH. Preparing for firmware download...Warning: possible packaging issue in srmd‐1.0‐1.ppc.rpmInstalling 49 packages. Please wait...rcinit‐1.1.5‐9############################### [ 100% ]misc‐2.1.0‐1############################### [ 100% ]pam‐0.75‐28############################### [ 100% ]util‐linux‐2.13o‐22############################### [ 100% ]sh‐utils‐2.1‐10############################### [ 100% ]man‐1.6g‐8############################### [ 100% ]bootenv‐1.0.3‐8############################### [ 100% ]kernel‐2.6.34.6‐1############################### [ 100% ]syslog‐ng‐3.3.7‐1############################### [ 100% ]vixie‐cron‐3.0.2‐62_4############################### [ 100% ]rsh‐0.18‐4############################### [ 100% ]setup‐4.1.2‐30############################### [ 100% ]agent‐nos‐common‐4.1.2‐1############################### [ 100% ]openssl‐0.9.9‐3############################### [ 100% ]openssh‐5.2p1‐13############################### [ 100% ]ntp‐5.94e‐4############################### [ 100% ]sendmail‐8.10‐11############################### [ 100% ]fss‐4.1.2‐12############################### [ 100% ]apache‐1.3.32‐10############################### [ 100% ]tz‐7.12‐6############################### [ 100% ]sysstat‐5.0.5‐10############################### [ 100% ]ipv6‐1.3‐10############################### [ 100% ]traceroute‐1.5a12‐13############################### [ 100% ] minicom‐2.1‐3.7############################### [ 100% ] fwdl‐4.1.2‐47############################### [ 100% ] kernel‐module‐usb‐2.6.34.6‐1############################### [ 100% ] kernel‐module‐net‐2.6.34.6‐1############################### [ 100% ] fabos‐setup‐4.1.2‐15############################### [ 100% ] fabos‐drivers‐4.1.2‐12############################### [ 100% ] fabos‐libs‐4.1.2‐14############################### [ 100% ] nonet‐lib‐4.1.2‐1############################### [ 100% ] group factory does not exist ‐ using root group factory does not exist ‐ using root group factory does not exist ‐ using root group factory does not exist ‐ using root fabos‐diag‐4.1.2‐17############################### [ 100% ] group factory does not exist ‐ using root group factory does not exist ‐ using root fabos‐4.1.2‐19############################### [ 100% ] fabos‐daemons‐4.1.2‐6############################### [ 100% ] fabos‐zoning‐4.1.2‐10############################### [ 100% ] fabos‐routing‐4.1.2‐10############################### [ 100% ] fabos‐vf‐4.1.2‐10############################### [ 100% ] fabos‐wwnhs‐4.1.2‐10############################### [ 100% ] fabos‐man‐4.1.2‐13############################### [ 100% ] group factory does not exist ‐ using root fabos‐swbd116‐4.1.2‐2############################### [ 100% ] php‐5.3.2‐2############################### [ 100% ] confd‐3.7.6.4.brcd‐3############################### [ 100% ] cli‐schemas‐4.1.2‐10############################### [ 100% ] prom‐8548‐2.2.0‐1############################### [ 100% ]eccrepd‐4.1.2‐11############################### [ 100% ]dcm‐4.1.2‐8############################### [ 100% ]openvswitch‐4.1.2‐1.7.0############################### [ 100% ]python‐e500v2‐3.3.2‐1############################### [ 100% ]zvm‐4.1.2‐1############################### [ 100% ]srmd‐1.0‐1############################### [ 100% ]Done install PackageRemoving unneeded files, please wait ...Finished removing unneeded files.Wed Jan 28 03:10:50 UTC 2015 ‐ Initializing the Dcmd and Ccmd database...2.基础配置网管口的配置曾经难倒过不少人参考配置switch(config)# interface Management 1/0switch(config‐Management‐1/0)# no ip address dhcpswitch(config‐Management‐1/0)# ip address 192.168.1.1/24switch(config‐Management‐1/0)# ip gateway‐address 192.168.1.254 switch# show running‐config interface Management 1/0interface Management 1/0no tcp burstrateip icmp echo‐replyno ip address dhcpip address 192.168.1.1/24ipv6 icmpv6 echo‐replyno ipv6 address autoconfigno ipv6 address dhcpvrf forwarding mgmt‐vrfno shutdown!如果是NOS5.0以上版本,请注意mgmt‐vrf,参考配置如下rbridge‐id 10switch‐attributes chassis‐name VDX6740switch‐attributes host‐name RB10vrf mamt‐vrf!vrf mgmt‐vrfaddress‐family ipv4 unicastip route 0.0.0.0/0 99.1.64.76!interface Management 10/0no tcp burstrateip icmp echo‐replyno ip address dhcpip address 99.1.64.78/24ipv6 icmpv6 echo‐replyno ipv6 address autoconfigno ipv6 address dhcpvrf forwarding mgmt‐vrfno shutdown记住ping的时候,后面也得带vrf3.License添加参考配置怎么帮客户生成license?1)拆开设备包装,一般情况下会有一个纸质信封(有时是邮件告知),拆开信封,有一个transaction key,拿到这个玩意。

1+X大数据平台运维初级练习题库(附答案)

1+X大数据平台运维初级练习题库(附答案)一、单选题(共60题,每题1分,共60分)1、下列哪项通常是集群的最主要瓶颈()。

A、CPUB、网络C、磁盘IOD、内存正确答案:C2、Namenode 在启动时自动进入安全模式,在安全模式阶段,说法错误的是()A、安全模式目的是在系统启动时检查各个 DataNode 上数据块的有效性B、根据策略对数据块进行必要的复制或删除C、当数据块最小百分比数满足的最小副本数条件时,会自动退出安全模式D、文件系统允许有修改正确答案:D3、下列哪个程序通常与 NameNode 在同一个节点启动()。

A、TaskTrackerB、DataNodeC、SecondaryNameNodeD、Jobtracker正确答案:D4、查看当前yarn 运行任务列表采用()命令A、yarn application -logB、HDFS application –listC、yarn application -killD、yarn application -list正确答案:D5、HBase依赖( )提供消息通信机制。

A、ZookeeperB、ChubbyC、RPCD、Socket正确答案:A6、在确认客户需求,进行确认需求调研的时候,以下说法正确的是A、按计划有步骤的确定客户需求调研。

B、将客户的想法记录下来,就能解决客户的实际问题C、确定客户需求调研的过程中,不可避免的会出现客户提出一些现有条件下根本无法实现或者即使实现也非常困难的要求,我们要无条件去满足客户的需求。

D、先了解细节需求,再了解宏观需求正确答案:A7、查看 HDFS 的报告命令A、bin/hdfs dfsadmin -reportB、bin/hdfs -reportC、bin/hdfs deadmin -reportD、bin/hdfs dfs -report正确答案:A8、用于检查节点自身的健康状态的进程是A、ResourceManagerB、NodeManagerC、NameNodeD、DataNode正确答案:B9、关于 Hadoop 的运行机制过程顺序说法正确的是()A、作业提交--作业初始化--任务分配--任务的执行--任务进度和状态的更新--任务结束B、任务执行-作业提交--作业初始化--任务的分配--任务进度和状态的更新--任务结束C、作业初始化--作业提交--任务分配--任务的执行--任务进度和状态的更新--任务结束D、任务分配--作业提交--作业初始化--任务的执行--任务进度和状态的更新--任务结束正确答案:A10、以下()文件中主要用来配置 ResourceManager, NodeManager 的通信端口,web 监控端口等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.集群版本升级方案

1.1.版本变化

Hadoop版本:hadoop-2.3.0-cdh5.1.0 -> hadoop-2.6.0-cdh5.14.0

Hbase版本:hbase-0.98.1-cdh5.1.0 -> hbase-1.2.0-cdh5.14.0

1.2.Hadoop集群版本升级

1.2.1.Hadoop集群版本升级流程

1.2.1.1.滚动升级

1.准备新版本hadoop安装包,并上传到备节点并解压到指定目录。

2.将老版本的配置文件同步至新版本,并将新版本hadoop目录分发到全部节

点。

3.备份hadoop元数据和编辑日志。

4.创建备份回滚镜像,用于集群升级失败回滚。

5.检查滚镜像状态,正常后方可继续执行。

6.升级journalnode服务。

7.升级zkfc服务。

8.升级备节点namenode服务。

9.同步备节点(原主节点)namenode服务。

10.升级datanode服务。

11.升级resourcemanager服务。

12.升级nodemanager服务。

13.更改所有节点的环境变量。

14.等待升级结束,使用hadoop fsck -blocks查看HDFS是否完整并健康运行。

15.待新版本集群稳定运行一段时间而没有任何问题,执行升级完成命令,整个

hadoop集群版本升级结束。

1.2.1.2.停集群升级

1.准备新版本hadoop安装包,并上传到备节点并解压到指定目录。

2.将老版本的配置文件同步至新版本,并将新版本hadoop目录分发到全部节

点。

3.备份hadoop元数据和编辑日志。

4.停止所有业务,停止hbase服务,停止hadoop服务。

5.集群部署新版hadoop,更改环境变量。

6.升级journalnode服务。

7.升级zkfc服务。

8.升级主节点namenode服务。

9.同步备节点namenode服务。

10.重启集群(start-dfs.sh & start-yarn.sh)。

11.待升级结束,查看hadoop集群运行情况和块是否完整。

12.待新版本集群稳定运行一段时间而没有任何问题,执行升级完成命令。

1.2.2.Hadoop集群版本升级失败回退

如果升级失败,可以随时回滚,执行回滚命令数据会回滚到升级前那一刻的数据,升级后的数据修改全部失效。

回滚操作不支持滚动方式,必须停止集群才能执行。

回滚流程如下:

1.关闭所有hbase和hadoop服务。

2.恢复所有节点升级前的hadoop版本。

3.回滚journalnode服务。

4.回滚zkfc服务。

5.回滚主节点namenode服务。

6.同步备节点namenode服务。

7.回滚所有datanode服务。

8.回滚yarn服务。

9.等待回滚完毕后,使用hadoop fsck -blocks查看HDFS是否完整并健康运

行。

1.2.3.Hadoop集群版本升级失败回退备用方案

在执行hadoop集群版本回退方案失败后,启动备用回退方案。

1.关闭所有hbase和hadoop服务。

2.恢复集群所有节点升级前的hadoop版本。

3.还原hadoop元数据备份。

4.启动journalnode服务。

5.启动zkfc服务。

6.启动主节点namenode服务。

7.同步备节点namenode服务。

8.启动datanode服务。

9.启动yarn服务。

10.等待回滚完毕后,使用hadoop fsck -blocks查看HDFS是否完整并健康运

行。

1.3.Hbase集群版本升级

1.3.1.Hbase集群版本升级流程

1.3.1.1.滚动升级

1.当hadoop升级成功后,将新版本hbase安装包上传至服务器并解压到指定

目录。

2.更改新版hbase配置文件并将新版hbase目录发送到所有节点。

3.待hadoop退出安全模式后,重启备节点master服务(重启即停止老版本服

务,启动新版本服务,以下重启都适用)。

4.待备节点master服务重启完毕,重启主节点的master服务。

5.待主节点master服务重启完毕,重启所有regionserver节点的regionserver

服务。

6.更改所有节点环境变量,让其指向新版hbase。

7.使用网页监控或者hbase shell检查hbase中的数据是否完整。

1.3.1.

2.停集群升级

1.当hadoop升级成功后,将新版本hbase安装包上传至服务器并解压到指定

目录。

2.更改新版hbase配置文件并将新版hbase目录发送到所有节点。

3.关闭老版本hbase集群服务。

4.将环境变量修改为新版本hbase。

5.当hadoop退出安全模式后,启动新版hbase服务。

6.使用网页监控或者hbase shell检查hbase中的数据是否完整。

1.3.

2.Hbase集群版本升级失败回退

当新版hbase集群升级失败后,需回退到之前的版本,流程如下:

1.关闭新版本hbase集群服务。

2.将环境变量修改为老版本hbase。

3.当hadoop退出安全模式后,启动老版本hbase。

4.使用网页监控或者hbase shell检查hbase中的数据是否完整。