MATLAB最速下降法(梯度法)程序

matlab 梯度法

matlab 梯度法在MATLAB中,可以使用梯度法来最小化或最大化一个函数。

梯度法是一种迭代优化算法,通过迭代调整参数值以逐步逼近目标函数的极小值或极大值。

首先,需要定义一个目标函数。

例如,假设我们要最小化一个函数f(x) = x^2,在MATLAB中可以定义如下:```matlabfunction y = f(x)y = x^2;end```接下来,我们可以使用fminunc函数来实现梯度法。

fminunc函数是MATLAB中用于非线性优化的函数,可以处理带有约束和无约束的问题。

在梯度法中,我们不需要提供目标函数的梯度信息,fminunc会自动计算梯度。

```matlabx0 = 1; % 初始参数值options = optimoptions('fminunc', 'Display', 'iter', 'Algorithm','quasi-newton'); % 配置选项[x, fval] = fminunc(@f, x0, options); % 使用fminunc函数进行优化```在上述代码中,我们使用了optimoptions函数来配置fminunc函数的选项。

其中,'Display', 'iter'选项用于显示每一步的迭代信息,'Algorithm', 'quasi-newton'选项用于指定使用拟牛顿法进行优化。

运行以上代码,MATLAB将输出每一步迭代的信息,并在最后给出最优参数值和最小化的函数值。

需要注意的是,梯度法的性能通常会受到初始参数值的影响。

因此,选择合适的初始参数值可能对优化结果产生重要影响。

matlab梯度算法

matlab梯度算法Matlab梯度算法在数学和计算机科学中,梯度是指一个多元函数在某一点上的变化率或斜率。

梯度算法是一种优化算法,用于找到函数的最小值或最大值。

在Matlab中,有多种方法可以使用梯度算法来优化函数,包括梯度下降和共轭梯度法。

本文将详细介绍Matlab中的梯度算法,并逐步讲解其原理和应用。

I. 梯度下降法梯度下降法是一种基于迭代的优化算法,通过计算函数的梯度来更新参数的值,以逐步接近函数的最小值。

在Matlab中,可以使用"gradientDescent"函数来实现梯度下降法。

1. 实现梯度下降法首先,我们需要定义一个优化目标函数,例如:f(x) = x^2 + 2x + 1。

然后,定义其梯度函数为g(x) = 2x + 2。

接下来,我们可以使用以下代码来计算梯度下降:matlab定义优化目标函数f = (x) x^2 + 2*x + 1;定义梯度函数g = (x) 2*x + 2;初始化参数x0 = 0;设置学习率和迭代次数alpha = 0.01;iterations = 100;梯度下降法for i = 1:iterationsx0 = x0 - alpha * g(x0);end打印最优解disp(['Optimal solution: ', num2str(x0)]);在这个例子中,我们使用了学习率(alpha)为0.01,迭代次数(iterations)为100。

通过不断更新参数x0的值,最终得到了最优解。

2. 梯度下降法的原理梯度下降法的核心思想是利用函数在当前点的梯度信息来更新参数的值,以便能够向着函数的最小值前进。

具体来说,算法的步骤如下:a. 初始化参数的值:选择一个初始参数的值作为起始点。

b. 计算梯度:计算函数在当前点的梯度,即求解函数关于参数的偏导数。

c. 更新参数:根据当前点的梯度和学习率,通过减去梯度的乘积来更新参数的值。

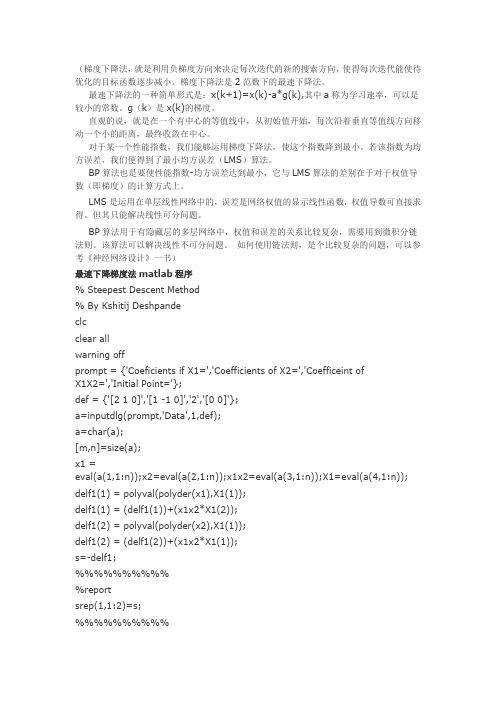

Mtable最速下降法及程序

(梯度下降法,就是利用负梯度方向来决定每次迭代的新的搜索方向,使得每次迭代能使待优化的目标函数逐步减小。

梯度下降法是2范数下的最速下降法。

最速下降法的一种简单形式是:x(k+1)=x(k)-a*g(k),其中a称为学习速率,可以是较小的常数。

g(k)是x(k)的梯度。

直观的说,就是在一个有中心的等值线中,从初始值开始,每次沿着垂直等值线方向移动一个小的距离,最终收敛在中心。

对于某一个性能指数,我们能够运用梯度下降法,使这个指数降到最小。

若该指数为均方误差,我们便得到了最小均方误差(LMS)算法。

BP算法也是要使性能指数-均方误差达到最小,它与LMS算法的差别在于对于权值导数(即梯度)的计算方式上。

LMS是运用在单层线性网络中的,误差是网络权值的显示线性函数,权值导数可直接求得。

但其只能解决线性可分问题。

BP算法用于有隐藏层的多层网络中,权值和误差的关系比较复杂,需要用到微积分链法则。

该算法可以解决线性不可分问题。

如何使用链法则,是个比较复杂的问题,可以参考《神经网络设计》一书)最速下降梯度法matlab程序% Steepest Descent Method% By Kshitij Deshpandeclcclear allwarning offprompt = {'Coeficients if X1=','Coefficients of X2=','Coefficeint ofX1X2=','Initial Point='};def = {'[2 1 0]','[1 -1 0]','2','[0 0]'};a=inputdlg(prompt,'Data',1,def);a=char(a);[m,n]=size(a);x1 =eval(a(1,1:n));x2=eval(a(2,1:n));x1x2=eval(a(3,1:n));X1=eval(a(4,1:n)); delf1(1) = polyval(polyder(x1),X1(1));delf1(1) = (delf1(1))+(x1x2*X1(2));delf1(2) = polyval(polyder(x2),X1(1));delf1(2) = (delf1(2))+(x1x2*X1(1));s=-delf1;%%%%%%%%%%%reportsrep(1,1:2)=s;%%%%%%%%%%x1new(1)=s(1)^2;x1new(2)=2*X1(1)*s(1);x1new(3) = X1(1)^2;x1new=x1new*x1(1);x1new_(2)=x1(2)*s(1);x1new_(3)=x1(2)*X1(1);x1new = x1new+x1new_;x2new(1)=s(2)^2;x2new(2)=2*X1(2)*s(2);x2new(3) = X1(2)^2;x2new=x2new*x2(1);x2new_(2)=x2(2)*s(2);x2new_(3)=x2(2)*X1(2);x2new = x2new+x2new_;x1x2new(1)=s(1)*s(2);x1x2new(2)=X1(1)*s(2)+X1(2)*s(1);x1x2new(3)=X1 (1)*X1(2);x1x2new=x1x2*x1x2new;df = polyder(x1new+x2new+x1x2new);lambda(1) = roots(df);X1=X1+lambda(1)*s;Xrep(1,1:2)=X1;delf1(1) = polyval(polyder(x1),X1(1));delf1(1) = (delf1(1))+(x1x2*X1(2));delf1(2) = polyval(polyder(x2),X1(2));delf1(2) = (delf1(2))+(x1x2*X1(1));if all(X1)== 0fprintf('%d %d is the optimum point',X1(1),X1(2));enditrep(1)=1;it=2;while all(delf1)==1s=-delf1;x1new(1)=s(1)^2;x1new(2)=2*X1(1)*s(1);x1new(3) = X1(1)^2;x1new=x1new*x1(1);x1new_(2)=x1(2)*s(1);x1new_(3)=x1(2)*X1(1);x1new = x1new+x1new_;x2new(1)=s(2)^2;x2new(2)=2*X1(2)*s(2);x2new(3) = X1(2)^2;x2new=x2new*x2(1);x2new_(2)=x2(2)*s(2);x2new_(3)=x2(2)*X1(2);x2new = x2new+x2new_;x1x2new(1)=s(1)*s(2);x1x2new(2)=X1(1)*s(2)+X1(2)*s(1);x1x2new(3)=X1 (1)*X1(2);x1x2new=x1x2*x1x2new;df = polyder(x1new+x2new+x1x2new);lambda(it) = roots(df);X1=X1+lambda(it)*s;delf1(1) = polyval(polyder(x1),X1(1));delf1(1) = (delf1(1))+(x1x2*X1(2));delf1(2) = polyval(polyder(x2),X1(2));delf1(2) = (delf1(2))+(x1x2*X1(1));itrep(it)=it;srep(it,1:2)=s;Xrep(it,1:2)=X1;it=it+1;end[m,n]=size(itrep);matrix=[itrep' srep(1:n,1) srep(1:n,2) Xrep(1:n,1) Xrep(1:n,2)]; answer = char(num2str(X1));answer = ['The optimal point is [' answer ']'];msgbox(answer,'Solution');disp(' Press Any key to View Detailed Report............');pauseecho offreport steep;clc用拟牛顿法求极小值点[ux,sfval,uexit,uoutput,grid,hess]=fminunc(ff,x0)Warning: Gradient must be provided for trust-region method; using line-search method instead.> In D:\MAT53\toolbox\optim\fminunc.m at line 202 Optimization terminated successfully:Current search direction is a descent direction, and magnitude of directional derivative in search direction less than 2*options.TolFun ux =1.0000 1.0000sfval =1.9118e-011uexit =1uoutput =iterations: 26funcCount: 162stepsize: 1.2992firstorderopt: 5.0023e-004algorithm: 'medium-scale: Quasi-Newton line search'grid =1.0e-003 *-0.5002-0.1888hess =820.4031 -409.5497-409.5497 204.7720在解寻优问题(Optimization)时,梯度下降法是最常使用的一个方法.某一纯量函数f(x),如果可微分的话,其梯度向量为▽xf,表示函数值在x方向增加最快的大小.▽xf=i*df/dx.如果g是两自变数x,y的函数,如g(x,y),则▽g= i*dg/dx+j*dg/dy可能在x-y平面上任意方向,这个方向上因Δx, Δy变动时Δg增加最大.是故▽g称之为方向性导数(Directional derivative).以梯度下降法为基础的演算法,一旦梯度为零,演算的进展自然停止.当误差表面凹点不只一个时,演算的进行将可能停滞於任何凹点底部(梯度为零),而未必能寻得误差表面的真正最低凹点。

梯度下降法 matlab

梯度下降法matlab

在Matlab中,实现梯度下降法的基本步骤如下:

1. 定义损失函数(或成本函数)和梯度函数;

2. 初始化参数;

3. 指定学习速率和最大迭代次数;

4. 进行迭代更新参数。

以下是一个贝尔纳丁梯度下降的简单实现:

```Matlab

定义损失函数

f = @(x) x^2;

定义梯度函数

df = @(x) 2*x;

初始化参数

x = -1;

指定学习速率和最大迭代次数

alpha = 0.1;

max_iter = 100;

迭代更新参数

for i = 1:max_iter

x = x - alpha * df(x);

fprintf('After %d iterations, x = %.5f\n', i, x);

end

```

这个例子中的损失函数是x的平方,梯度函数是2x。

初始参数x设置为-1,学习速率alpha设置为0.1,最大迭代次数设置为100。

在每次迭代中,参数x都会按照梯度方向更新。

这只是一个简单的例子,实际使用中可能需要对算法进行一些优化,例如添加收敛条件,调整学习速率等。

三元函数梯度下降matlab代码

三元函数梯度下降 Matlab 代码一、引言在数学和计算机科学领域,梯度下降是一种常用的优化算法,用于最小化一个函数的值。

对于多元函数,我们可以使用梯度下降算法来求解函数的最小值点。

在本篇文章中,我将着重讨论三元函数的梯度下降,并共享针对该算法的 Matlab 代码实现。

二、梯度下降算法简介梯度下降是一种迭代优化算法,其基本思想是通过不断沿着函数梯度的相反方向更新参数,直到达到函数的最小值点。

对于三元函数,我们需要求解的是函数在三维空间中的最小值点,而梯度下降算法就能很好地实现这一目标。

三、三元函数的梯度下降 Matlab 代码实现我们首先定义一个三元函数,例如 f(x, y, z) = x^2 + y^2 + z^2,然后编写Matlab 代码来实现梯度下降算法。

以下是一个简单的示例:```matlab% 定义三元函数function f = three_variable_function(x, y, z)f = x^2 + y^2 + z^2;end% 梯度下降算法实现function [min_point, min_value] = gradient_descent() learning_rate = 0.1; % 学习率max_iterations = 1000; % 最大迭代次数precision = 0.0001; % 收敛精度x = 3; % 初值y = 4;z = 5;for i = 1:max_iterationsgrad_x = 2*x; % 计算梯度grad_y = 2*y;grad_z = 2*z;x = x - learning_rate * grad_x; % 参数更新y = y - learning_rate * grad_y;z = z - learning_rate * grad_z;f_val = three_variable_function(x, y, z); % 计算函数值 if abs(f_val) < precision % 判断收敛break;endendmin_point = [x, y, z]; % 最小值点min_value = f_val; % 最小值end```以上代码中,我们首先定义了一个简单的三元函数three_variable_function,并在 gradient_descent 函数中实现了梯度下降算法,最终得到了函数的最小值点和最小值。

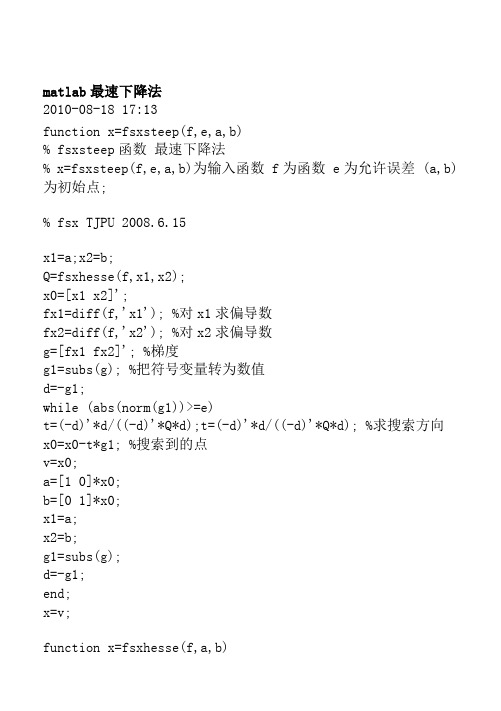

MATLAB实现最速下降法(梯度)程序

matlab最速下降法2010-08-18 17:13function x=fsxsteep(f,e,a,b)% fsxsteep函数最速下降法% x=fsxsteep(f,e,a,b)为输入函数 f为函数 e为允许误差 (a,b)为初始点;% fsx TJPU 2008.6.15x1=a;x2=b;Q=fsxhesse(f,x1,x2);x0=[x1 x2]';fx1=diff(f,'x1'); %对x1求偏导数fx2=diff(f,'x2'); %对x2求偏导数g=[fx1 fx2]'; %梯度g1=subs(g); %把符号变量转为数值d=-g1;while (abs(norm(g1))>=e)t=(-d)'*d/((-d)'*Q*d);t=(-d)'*d/((-d)'*Q*d); %求搜索方向x0=x0-t*g1; %搜索到的点v=x0;a=[1 0]*x0;b=[0 1]*x0;x1=a;x2=b;g1=subs(g);d=-g1;end;x=v;function x=fsxhesse(f,a,b)% fsxhesse函数求函数的hesse矩阵;% 本程序仅是简单的求二次函数的hesse矩阵!;% x=fsxhesse(f)为输入函数 f为二次函数 x1,x2为自变量;% fsx TJPU 2008.6.15x1=a;x2=b;fx=diff(f,'x1'); %求f对x1偏导数fy=diff(f,'x2'); %求f对x2偏导数fxx=diff(fx,'x1'); %求二阶偏导数对x1再对x1fxy=diff(fx,'x2'); %求二阶偏导数对x1再对x2fyx=diff(fy,'x1'); %求二阶偏导数对x2再对x1fyy=diff(fy,'x2'); %求二阶偏导数对x2再对x2fxx=subs(fxx); %将符号变量转化为数值fxy=subs(fxy);fyx=subs(fyx);fyy=subs(fyy);x=[fxx,fxy;fyx,fyy]; %求hesse矩阵syms x1 x2;X=[x1,x2];fx=X(1)^2+2*X(2)^2;z=fsxsteep(fx,0.001,1,1)。

matlab 梯度下降法编程

梯度下降法是一种常用的优化算法,可用于求解最优化问题。

在MATLAB 中,我们可以通过编写梯度下降法的程序来解决各种复杂的优化问题。

本文将深入介绍 MATLAB 中梯度下降法的编程方法,并根据其深度和广度要求,逐步探讨梯度下降法的原理、实现步骤、优化调节和应用场景,帮助读者全面理解和掌握这一优化算法。

1. 梯度下降法的原理梯度下降法是一种迭代优化算法,其基本原理是不断沿着目标函数的负梯度方向更新参数,直至达到局部最小值或全局最小值。

在MATLAB 中,我们可以利用数值计算和矩阵运算来实现梯度下降法,通过不断迭代来更新参数并逐步逼近最优解。

2. 梯度下降法的实现步骤在 MATLAB 中实现梯度下降法主要包括以下步骤:定义目标函数、计算目标函数的梯度、选择学习率和迭代次数、初始化参数、通过循环迭代更新参数直至收敛。

通过编写 MATLAB 程序来实现这些步骤,我们可以轻松地对各种复杂的优化问题进行求解。

3. 优化调节和应用场景在实际应用中,梯度下降法的效果受到学习率和迭代次数的影响,因此需要进行适当的优化调节。

在 MATLAB 中,我们可以通过调节学习率和设置合理的停止准则来提高梯度下降法的收敛速度和稳定性。

梯度下降法在机器学习、神经网络训练、参数优化等领域有着广泛的应用场景,通过 MATLAB 编程可以快速应用于实际问题中。

总结回顾通过本文的介绍,我们全面了解了 MATLAB 中梯度下降法的编程方法。

从梯度下降法的原理到实现步骤,再到优化调节和应用场景,我们逐步深入地探讨了这一优化算法。

在实际编程中,我们需要注意学习率和迭代次数的选择,并结合具体问题进行调节优化。

梯度下降法在各种优化问题中具有广泛的应用,通过 MATLAB 编程可以轻松应用于实际场景中。

个人观点和理解我个人认为,掌握 MATLAB 中梯度下降法的编程方法对于解决各种复杂的优化问题非常重要。

通过编写梯度下降法的程序,我们可以深入理解优化算法的原理,并在实际问题中灵活应用。

梯度优化算法在matlab中的实现

梯度优化算法在Matlab中的实现梯度优化算法是一种常用的数值优化算法,它通过不断迭代来寻找函数的最小值或最大值。

在机器学习和深度学习领域,梯度优化算法被广泛应用于优化模型的参数,以使模型能够更好地拟合数据。

在本文中,我们将探讨梯度优化算法在Matlab中的实现,并深入了解这一算法的原理和应用。

一、梯度下降算法梯度下降算法是梯度优化算法的一种,它通过不断迭代来更新参数,使目标函数的值不断减小。

在梯度下降算法中,关键的步骤是计算目标函数对参数的梯度,然后沿着梯度的反方向更新参数。

这一过程持续进行,直到达到收敛条件为止。

在Matlab中实现梯度下降算法可以通过以下步骤进行:1. 定义目标函数在Matlab中,首先需要定义目标函数,即待优化的函数。

我们可以定义一个简单的目标函数如下:```matlabfunction y = target_function(x)y = x^2;end```2. 计算梯度接下来,需要计算目标函数对参数的梯度。

在Matlab中,可以使用内置的gradient函数来计算梯度。

对于上述的目标函数,可以这样计算梯度:```matlabx = 1;dx = gradient(@target_function, x);```3. 更新参数有了梯度之后,就可以沿着梯度的反方向更新参数。

在梯度下降算法中,参数的更新公式为:```matlablearning_rate = 0.1;x = x - learning_rate * dx;```通过以上步骤,就可以在Matlab中实现简单的梯度下降算法了。

二、常见的梯度优化算法除了简单的梯度下降算法之外,还有一些其他常见的梯度优化算法,如随机梯度下降(SGD)、动量法(Momentum)、Adam算法等。

这些算法在不同的场景下有不同的表现,需要根据具体问题来选择合适的算法。

在Matlab中,这些算法都有成熟的实现,可以方便地调用和使用。

三、个人观点和理解梯度优化算法在机器学习和深度学习领域扮演着至关重要的角色。

matlab 梯度下降算法 -回复

matlab 梯度下降算法-回复Matlab梯度下降算法(Gradient Descent Algorithm in Matlab)在机器学习和优化问题中,梯度下降算法是一种常用的优化算法。

它通过迭代地调整参数值,以最小化某个目标函数。

本文将详细介绍如何在Matlab中实现梯度下降算法,并提供一个简单的示例说明。

1. 梯度下降算法简介(Introduction to Gradient Descent Algorithm)梯度下降算法是一种通过迭代调整参数以最小化目标函数的优化算法。

其基本思想是在每一步迭代中,计算目标函数的梯度,并按照梯度的方向调整参数值。

通过迭代调整参数直至收敛,得到目标函数的最小值。

数学上,梯度是目标函数在某一点上的导数。

在梯度下降算法中,我们将目标函数的梯度视为移动方向。

通过不断迭代调整参数,算法会朝着梯度的相反方向移动,从而能够找到最小值点。

梯度下降算法具有广泛的应用,包括线性回归、逻辑回归、神经网络等。

2. 在Matlab中实现梯度下降算法(Implementing Gradient Descent Algorithm in Matlab)在Matlab中实现梯度下降算法非常简单。

我们首先定义目标函数以及其梯度函数,并初始化参数值。

然后,通过迭代地更新参数值,直到达到停止条件。

下面是一个简单的示例,说明如何在Matlab中实现梯度下降算法:matlab定义目标函数及其梯度函数function [f, grad] = target_func(x)f = (x(1)^2 + x(2)^2)/2; 目标函数grad = [x(1); x(2)]; 梯度函数end梯度下降算法function [x_opt, f_opt] = gradient_descent(learning_rate, tolerance) 参数初始化x = [0; 0];[f, grad] = target_func(x);f_opt = f;iter = 0;while norm(grad) > tolerance 迭代停止条件x = x - learning_rate * grad; 更新参数[f, grad] = target_func(x); 计算新的目标函数值及梯度f_opt = min(f_opt, f); 更新最优值iter = iter + 1;endfprintf('迭代次数:d\n', iter);x_opt = x;end运行梯度下降算法learning_rate = 0.1;tolerance = 1e-5;[x_opt, f_opt] = gradient_descent(learning_rate, tolerance);fprintf('最优参数:s\n', mat2str(x_opt));fprintf('最优值:f\n', f_opt);在上述示例中,我们定义了一个二维目标函数`f = (x(1)^2 + x(2)^2)/2` ,其梯度为`[x(1); x(2)]`。

matlab梯度下降法

matlab梯度下降法

Matlab中的梯度下降法是一种常用的有监督式机器学习算法,它可以估计输入空间中的函数值最小值的参数。

它可以有效地处理非线性的多元函数最小化问题,在优化技术的

应用领域非常重要。

梯度下降法的主要过程如下:由一个初始猜测,从头开始计算函数值对参数的梯度

(梯度是参数改变量导致函数值变化量最大程度);将计算出来的梯度反对参数进行更新;以步长为更新系数,将梯度乘以步长,从而获得更新后的参数值;再次计算函数值,如果

目标函数值变小,则继续更新,否则结束更新。

Matlab 中的梯度下降法首先使用fminunc函数来估算函数最小值的那个参数。

这个

函数的输入是一个匿名函数,并且有至少两个参数。

除此之外,还需要定义一个数组来表

示初始猜测点(也就是第一次梯度下降的参数值)。

然后,函数会遍历函数自变量空间,

查找最优值,最后输出最小值及最优参数。

fminunc函数返回最佳参数值,可以使用“ fminsearch” 函数处理多变量的梯度下降,它返回最大值和最优参数值,做这个可以用 Matlab中的“ fminsearch”算法。

此外,也可以使用Matlab中的“ fmincon”优化算法,这是一种以最小限度原则为

基础,应用于多自变量最小化问题的算法,它可以应用约束条件,比如多变量梯度下降时,每个变量的取值可以被上下限值限制。

总之,Matlab中包含了一系列用于梯度下降优化的函数,他们具有不同的功能,但基本过程都是更新自变量,使得函数值变小的梯度下降。

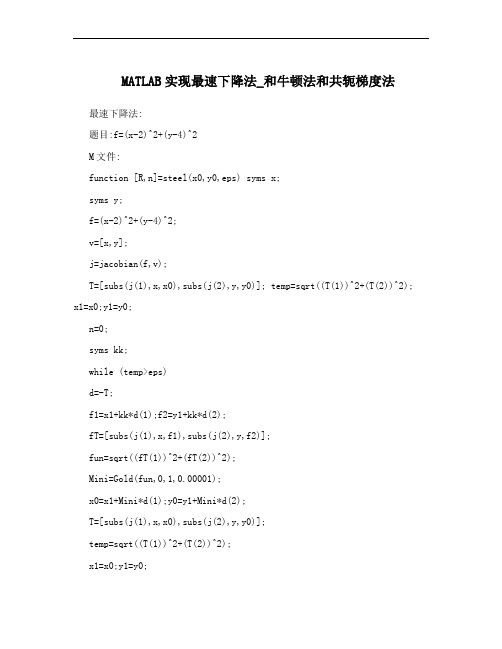

MATLAB实现最速下降法_和牛顿法和共轭梯度法

MATLAB实现最速下降法_和牛顿法和共轭梯度法最速下降法:题目:f=(x-2)^2+(y-4)^2M文件:function [R,n]=steel(x0,y0,eps) syms x;syms y;f=(x-2)^2+(y-4)^2;v=[x,y];j=jacobian(f,v);T=[subs(j(1),x,x0),subs(j(2),y,y0)]; temp=sqrt((T(1))^2+(T(2))^2); x1=x0;y1=y0;n=0;syms kk;while (temp>eps)d=-T;f1=x1+kk*d(1);f2=y1+kk*d(2);fT=[subs(j(1),x,f1),subs(j(2),y,f2)];fun=sqrt((fT(1))^2+(fT(2))^2);Mini=Gold(fun,0,1,0.00001);x0=x1+Mini*d(1);y0=y1+Mini*d(2);T=[subs(j(1),x,x0),subs(j(2),y,y0)];temp=sqrt((T(1))^2+(T(2))^2);x1=x0;y1=y0;n=n+1;endR=[x0,y0]调用黄金分割法:M文件:function Mini=Gold(f,a0,b0,eps) syms x;format long; syms kk;u=a0+0.382*(b0-a0);v=a0+0.618*(b0-a0);k=0;a=a0;b=b0;array(k+1,1)=a;array(k+1,2)=b; while((b-a)/(b0-a0)>=eps) Fu=subs(f,kk,u);Fv=subs(f,kk,v);if(Fu<=Fv)b=v;v=u;u=a+0.382*(b-a);k=k+1;elseif(Fu>Fv)a=u;u=v;v=a+0.618*(b-a);k=k+1;endarray(k+1,1)=a;array(k+1,2)=b; endMini=(a+b)/2;输入:[R,n]=steel(0,1,0.0001)R = 1.99999413667642 3.99999120501463 R = 1.999994136676423.99999120501463 n = 1牛顿法:题目:f=(x-2)^2+(y-4)^2M文件:syms x1 x2;f=(x1-2)^2+(x2-4)^2;v=[x1,x2];df=jacobian(f,v);df=df.';G=jacobian(df,v);epson=1e-12;x0=[0,0]';g1=subs(df,{x1,x2},{x0(1,1),x0(2,1)});G1=subs (G,{x1,x2},{x0(1,1),x0(2,1)});k=0;mul_count=0;sum_count=0;mul_count=mul_count+12;sum_count=sum_count+6; while(norm(g1)>epson) p=-G1\g1;x0=x0+p;g1=subs(df,{x1,x2},{x0(1,1),x0(2,1)});G1=subs(G,{x1,x2},{x0(1,1),x0(2,1)});k=k+1;mul_count=mul_count+16;sum_count=sum_count+11;end;kx0mul_countsum_count结果::k = 1x0 =24mul_count = 28sum_count = 17 共轭梯度法:题目:f=(x-2)^2+(y-4)^2M文件:function f=conjugate_grad_2d(x0,t)x=x0;syms xi yi af=(xi-2)^2+(yi-4)^2; fx=diff(f,xi);fy=diff(f,yi);fx=subs(fx,{xi,yi},x0); fy=subs(fy,{xi,yi},x0); fi=[fx,fy]; count=0;while double(sqrt(fx^2+fy^2))>ts=-fi;if count<=0s=-fi;elses=s1;endx=x+a*s;f=subs(f,{xi,yi},x);f1=diff(f);f1=solve(f1);if f1~=0ai=double(f1);elsebreakx,f=subs(f,{xi,yi},x),count endx=subs(x,a,ai);f=xi-xi^2+2*xi*yi+yi^2;fxi=diff(f,xi);fyi=diff(f,yi);fxi=subs(fxi,{xi,yi},x);fyi=subs(fyi,{xi,yi},x);fii=[fxi,fyi];d=(fxi^2+fyi^2)/(fx^2+fy^2); s1=-fii+d*s;count=count+1;fx=fxi;fy=fyi;endx,f=subs(f,{xi,yi},x),count 输入:conjugate_grad_2d([0,0],0.0001) 结果:x = 0.24998825499785 -0.24999998741273f = 0.12499999986176count = 10ans = 0.12499999986176。

(完整)实验2 最速下降法和共轭梯度法的程序设计

实验2 最速下降法和共轭梯度法的程序设计一、实验目的1、熟悉无约束优化问题的最速下降算法和共轭梯度法。

2、培养matlab 编程与上机调试能力。

二、实验课时:2个课时三、实验准备1、预习无约束优化问题的最速下降算法和共轭梯度法.2、熟悉matlab 软件的基本操作及程序编写。

四、实验内容课堂实验演示根据最速下降法编写程序,求函数21222121342)(m in x x x x x x x f -++-=的极小值,其中初始点为()01,1Tx =算法步骤如下:Step1::给出初始点0x ,和精度1;0k ε<<=;Step2:计算()k f x ∇,如果()k f x ε∇≤,则停止迭代,输出结果;否则转step3;Step3:令下降方向()k k d f x =-∇,计算步长因子k λ使得0()min ()k k k k k f x d f x d λλλ≥+=+,令1,1k k k k x x d k k λ+=+=+,转step2.其程序如下:function [x,iter,val,dval] = Steepest_Descent_Method(x ,eps)k = 1;dy = grad_obj(x);x_mat (:,1) = x ;%存储每一次迭代得到的点xwhile norm (dy)〉epsd = —dy ; % 搜索方向lambda = line_search(x ,d );%步长x = x + d *lambda ;k = k + 1;x_mat (:,k ) = x;dy = grad_obj (x);enditer = k — 1;val = obj(x);%目标函数在极值点处的函数值dval = grad_obj(x);%目标函数在极值点处的梯度%———----—-————-—-————-—-———-——---—----——-—---——---—-—-——--——--—x1 = linspace(—1。

matlab最速下降法求解二次凸函数的最小值

matlab最速下降法求解二次凸函数的最小值1.引言1.1 概述概述:在数学和优化领域中,最速下降法是一种常用的优化算法,用于求解二次凸函数的最小值。

该算法通过迭代更新变量的值,以逐步靠近函数的最小值。

在本文中,我们将介绍最速下降法的原理和步骤,并探讨它在求解二次凸函数最小值中的应用。

最速下降法的核心思想是沿着目标函数梯度的反方向移动,以找到函数的最小值。

具体而言,算法从一个初始点开始,计算该点的梯度,并将其与一个步长因子相乘,得到一个移动的方向。

然后,根据这个方向更新变量的值,并重复此过程直到满足停止准则。

对于二次凸函数的最小值求解,最速下降法是一种有效且收敛性良好的方法。

二次凸函数是一种具有凸性和二次项的函数,它在数学和工程问题的建模中经常出现。

通过最速下降法,我们可以通过迭代计算逐步逼近二次凸函数的最小值。

本文主要目的是介绍最速下降法在求解二次凸函数最小值中的应用。

我们将详细讨论最速下降法的原理和步骤,并通过数学推导和示例说明其有效性和收敛性。

我们还将比较最速下降法与其他优化算法的优缺点,并总结结论。

通过本文的阅读,读者将能够了解最速下降法在求解二次凸函数最小值中的原理和应用。

这将有助于读者更好地理解最速下降法的优势和局限性,并为进一步研究和应用提供基础。

1.2文章结构2. 正文2.1 最速下降法的原理和步骤最速下降法是一种常用的优化算法,用于求解函数的最小值。

它基于函数的负梯度方向进行迭代,通过迭代更新自变量的值来逐步逼近最优解。

最速下降法的步骤如下:步骤1:选择初始点。

从问题的可行域内选择一个初始点作为最速下降法的起点。

步骤2:计算负梯度。

在当前点处,计算目标函数的负梯度,即函数在该点处的梯度乘以-1。

步骤3:确定步长。

寻找沿着负梯度方向移动的合适步长,使得目标函数的值能够得到较大的下降。

步骤4:更新自变量。

根据确定的步长,更新自变量的值。

步骤5:重复步骤2-步骤4。

不断迭代执行步骤2到步骤4,直到满足停止准则。

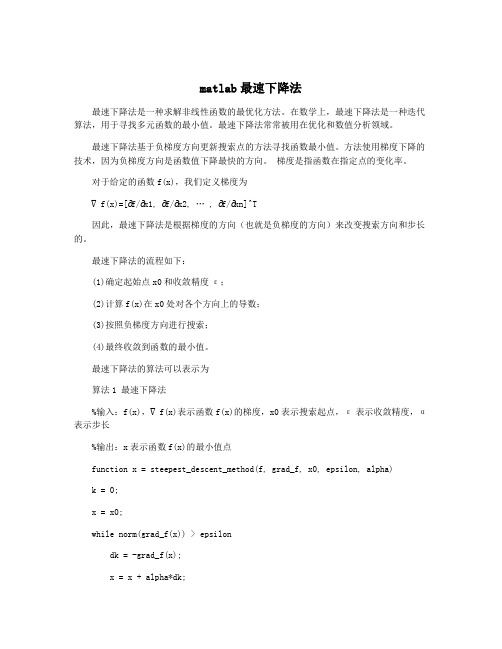

matlab最速下降法

matlab最速下降法最速下降法是一种求解非线性函数的最优化方法。

在数学上,最速下降法是一种迭代算法,用于寻找多元函数的最小值。

最速下降法常常被用在优化和数值分析领域。

最速下降法基于负梯度方向更新搜索点的方法寻找函数最小值。

方法使用梯度下降的技术,因为负梯度方向是函数值下降最快的方向。

梯度是指函数在指定点的变化率。

对于给定的函数f(x),我们定义梯度为∇f(x)=[∂f/∂x1, ∂f/∂x2, … , ∂f/∂xn]^T因此,最速下降法是根据梯度的方向(也就是负梯度的方向)来改变搜索方向和步长的。

最速下降法的流程如下:(1)确定起始点x0和收敛精度ε;(2)计算f(x)在x0处对各个方向上的导数;(3)按照负梯度方向进行搜索;(4)最终收敛到函数的最小值。

最速下降法的算法可以表示为算法1 最速下降法%输入:f(x),∇f(x)表示函数f(x)的梯度,x0表示搜索起点,ε表示收敛精度,α表示步长%输出:x表示函数f(x)的最小值点function x = steepest_descent_method(f, grad_f, x0, epsilon, alpha)k = 0;x = x0;while norm(grad_f(x)) > epsilondk = -grad_f(x);x = x + alpha*dk;k = k + 1;endend其中,norm是向量的范数,grad_f表示函数f的梯度,alpha是步长因子,可以通过试验或线搜索确定。

在上述算法中,基于梯度的每一步都保证了函数值下降。

算法的停止条件通常是达到预定的精度或规定的最大迭代次数。

最速下降法的优缺点优点:(1)相对简单,易于理解和实现;(2)算法的执行速度相对较快。

(1)可能会在迭代过程中陷入局部最小值;(2)需要对步长因子α进行调整;(3)在非线性函数的优化中,最速下降法可能需要许多迭代才能收敛,导致计算量大。

最速下降法是一种通用的非线性优化算法,广泛应用于各种数学和工程问题中。

梯度法matlab程序 -回复

梯度法matlab程序-回复梯度法(matlab程序)是一种常用的优化算法,它利用函数的梯度信息来寻找函数的最小值或最大值。

本文将介绍梯度法的原理以及如何用matlab实现梯度法。

首先,让我们了解一下梯度法的原理。

梯度法是一种迭代方法,它基于函数在某个点处的梯度信息来决定迭代的方向。

利用梯度法,我们可以逐步接近函数的最小值或最大值。

梯度法的核心思想是:在每个迭代步骤中,我们沿着负梯度方向移动一个小的步长。

这是因为梯度的方向指向函数在该点上升最快的方向,所以我们希望朝着负梯度的方向移动,以便逐步接近函数的最小值。

接下来,让我们讨论如何在matlab中实现梯度法。

在matlab中,我们可以使用"gradient"函数来计算函数在给定点处的梯度向量。

然后,我们可以根据梯度向量的方向来更新当前点的位置。

具体来说,我们可以使用以下步骤来实现梯度法:1. 初始化迭代参数:包括初始点位置、迭代次数、学习率等。

2. 在每个迭代步骤中,计算当前点的梯度向量。

使用"gradient"函数计算当前点处的梯度向量,并将其保存为一个向量。

3. 根据梯度向量的方向和学习率更新当前点的位置。

更新公式为:新点位置= 当前点位置- 学习率* 梯度向量。

在matlab中,我们可以使用矢量运算来实现这个更新过程。

4. 检查终止条件。

可以设置多个终止条件,如迭代次数、梯度大小等。

如果满足终止条件,则停止迭代,否则返回步骤2。

现在,我们将使用一个具体的例子来说明如何在matlab中实现梯度法。

假设我们要优化的函数是f(x) = x^2 + 2x + 1。

我们可以使用梯度法来寻找函数的最小值。

首先,我们需要定义梯度函数,它计算给定点x 的梯度向量。

在这个例子中,我们的梯度函数是df(x) = 2x + 2。

我们可以在matlab中定义梯度函数的代码如下:matlabfunction grad = gradient_func(x)grad = 2*x + 2;end接下来,我们将实现梯度法的代码。

MATLAB梯度优化算法程序

查看文章matlab最速下降法2010-08-18 17:13function x=fsxsteep(f,e,a,b)% fsxsteep函数最速下降法% x=fsxsteep(f,e,a,b)为输入函数 f为函数 e为允许误差 (a,b)为初始点; % fsx TJPU 2008.6.15x1=a;x2=b;Q=fsxhesse(f,x1,x2);x0=[x1 x2]';fx1=diff(f,'x1'); %对x1求偏导数fx2=diff(f,'x2'); %对x2求偏导数g=[fx1 fx2]'; %梯度g1=subs(g); %把符号变量转为数值d=-g1;while (abs(norm(g1))>=e)t=(-d)'*d/((-d)'*Q*d);t=(-d)'*d/((-d)'*Q*d); %求搜索方向x0=x0-t*g1; %搜索到的点v=x0;a=[1 0]*x0;b=[0 1]*x0;x1=a;x2=b;g1=subs(g);d=-g1;end;x=v;function x=fsxhesse(f,a,b)% fsxhesse函数求函数的hesse矩阵;% 本程序仅是简单的求二次函数的hesse矩阵!;% x=fsxhesse(f)为输入函数 f为二次函数 x1,x2为自变量;% fsx TJPU 2008.6.15x1=a;x2=b;fx=diff(f,'x1'); %求f对x1偏导数fy=diff(f,'x2'); %求f对x2偏导数fxx=diff(fx,'x1'); %求二阶偏导数对x1再对x1fxy=diff(fx,'x2'); %求二阶偏导数对x1再对x2fyx=diff(fy,'x1'); %求二阶偏导数对x2再对x1fyy=diff(fy,'x2'); %求二阶偏导数对x2再对x2fxx=subs(fxx); %将符号变量转化为数值fxy=subs(fxy);fyx=subs(fyx);fyy=subs(fyy);x=[fxx,fxy;fyx,fyy]; %求hesse矩阵syms x1 x2;X=[x1,x2];fx=X(1)^2+2*X(2)^2;z=fsxsteep(fx,0.001,1,1)。

最速下降法MATLAB程序实现

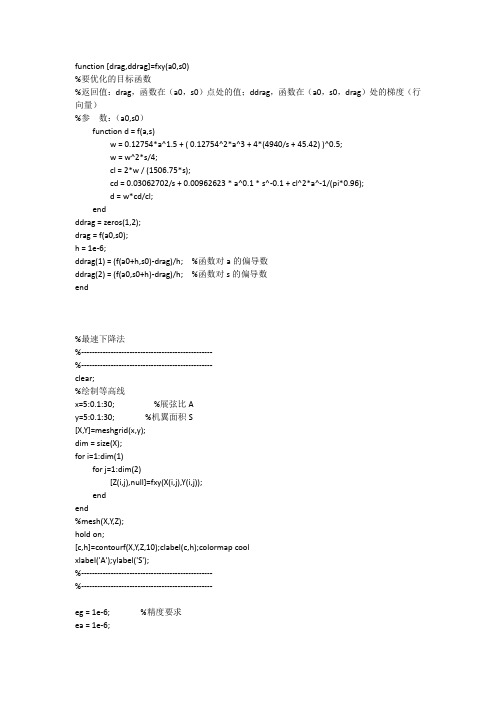

function [drag,ddrag]=fxy(a0,s0)%要优化的目标函数%返回值:drag,函数在(a0,s0)点处的值;ddrag,函数在(a0,s0,drag)处的梯度(行向量)%参数:(a0,s0)function d = f(a,s)w = 0.12754*a^1.5 + ( 0.12754^2*a^3 + 4*(4940/s + 45.42) )^0.5;w = w^2*s/4;cl = 2*w / (1506.75*s);cd = 0.03062702/s + 0.00962623 * a^0.1 * s^-0.1 + cl^2*a^-1/(pi*0.96);d = w*cd/cl;endddrag = zeros(1,2);drag = f(a0,s0);h = 1e-6;ddrag(1) = (f(a0+h,s0)-drag)/h; %函数对a的偏导数ddrag(2) = (f(a0,s0+h)-drag)/h; %函数对s的偏导数end%最速下降法%-------------------------------------------------%-------------------------------------------------clear;%绘制等高线x=5:0.1:30; %展弦比Ay=5:0.1:30; %机翼面积S[X,Y]=meshgrid(x,y);dim = size(X);for i=1:dim(1)for j=1:dim(2)[Z(i,j),null]=fxy(X(i,j),Y(i,j));endend%mesh(X,Y,Z);hold on;[c,h]=contourf(X,Y,Z,10);clabel(c,h);colormap coolxlabel('A');ylabel('S');%-------------------------------------------------%-------------------------------------------------eg = 1e-6; %精度要求ea = 1e-6;num = 0; %迭代次数num1 = 0; %确定最优步长迭代的次数x0=15;y0=30; %起始点[z0,dz0] = fxy(x0,y0);while norm(dz0)>egz00 = z0;x00 = x0;y00 = y0;h = norm(dz0)/1e4; %初始步长dz0 = dz0/norm(dz0); %沿梯度方向的单位向量x1 = x0 - dz0(1)*h;y1 = y0 - dz0(2)*h;[z1,dz1] = fxy(x1,y1);step0 = 0; %[step0,step1],步长极小值区间step1 = step0+h;step = step0;if z1<z0while z1<z0 %用进退法确定步长的极值区间step = step0;step0 = step1;z0 = z1;h = 2*h;step1 = step1 + h;x1 = x0 - dz0(1)*step1;y1 = y0 - dz0(2)*step1;[z1,dz1] = fxy(x1,y1);endstep1 = step0;step0 = step;endwhile (step1-step0)>eg %黄金分割法求最优步长x2 = x0 - dz0(1)*( step0 + 0.618*(step1-step0) );y2 = y0 - dz0(2)*( step0 + 0.618*(step1-step0) );[z2,dz2] = fxy(x2,y2);x1 = x0 - dz0(1)*( step0 + 0.382*(step1-step0) );y1 = y0 - dz0(2)*( step0 + 0.382*(step1-step0) );[z1,dz1] = fxy(x1,y1);if z1>z2step0 = step0 + 0.382*(step1-step0);else if z1<z2step1 = step0 + 0.618*(step1-step0);elsestep0 = step0 + 0.382*(step1-step0);step1 = step0 + 0.618*(step1-step0);endendnum1 = num1+1;endstep_opt = (step0+step1)/2; %最优步长x0 = x0 - dz0(1)*step_opt;y0 = y0 - dz0(2)*step_opt;[z0,dz0] = fxy(x0,y0);%line([x00,x0],[y00,y0],[z00,z0],'Color','r','LineWidth',2);line([x00,x0],[y00,y0],'Color','r','LineWidth',2);plot(x0,y0,'r+');num = num + 1;if abs(z0-z00) <= ea+er*abs(z00)break;endendhold off;disp(['Opt_Piont = ( ', num2str(x0), ',' ,num2str(y0),' )']); disp(['Opt_Value = ',num2str(z0)]);disp(['迭代次数:',num2str(num)]);disp(['线性搜索迭代次数:',num2str(num1)]);。