NLP取得成功的模型(下)

nlp 预训练模型的发展史

nlp 预训练模型的发展史NLP(自然语言处理)预训练模型是近年来取得巨大进展的领域之一。

在过去几年里,随着深度学习和神经网络技术的快速发展,NLP 预训练模型得到了广泛应用和研究。

在本文中,我将为您介绍NLP 预训练模型的发展史,涵盖从最早的模型到最新的技术进展。

1. Word2Vec(2013年):Word2Vec是NLP预训练模型的开端。

由Tomas Mikolov等人于2013年提出的Word2Vec模型,通过将单词嵌入到低维向量空间中,将自然语言转化为数值表示。

它通过训练一个神经网络模型,根据上下文来预测一个单词的出现概率,从而得到词向量。

Word2Vec模型的出现极大地促进了NLP领域的发展。

2. GloVe(2014年):GloVe(全称Global Vectors for Word Representation)是由斯坦福大学的研究者于2014年提出的一种基于全局词频统计的词向量表示模型。

与Word2Vec不同,GloVe通过在整个语料库上计算词语之间的共现统计信息来生成词向量。

这种方法克服了Word2Vec在处理大规模语料库时的一些问题,并且在NLP任务中取得了很好的效果。

3. ELMo(2018年):ELMo(全称Embeddings from Language Models)是斯坦福大学发布的一种NLP预训练模型。

ELMo模型通过训练一个双向语言模型来生成上下文相关的词向量。

与传统的静态词向量不同,ELMo的词向量可以根据上下文的不同而变化。

这使得ELMo可以更好地捕捉词语的多义性和上下文信息,提高了NLP任务的性能。

4. GPT(2018年):GPT(全称Generative Pre-trained Transformer)是由OpenAI发布的一种基于Transformer模型的预训练语言模型。

GPT模型通过使用无标签的大规模语料库进行预训练,学习到了丰富的语言知识。

然后,通过微调模型,可以在各种NLP任务上进行下游任务的处理。

npl自然语言处理常用算法模型

npl自然语言处理常用算法模型NPL自然语言处理常用算法模型自然语言处理(Natural Language Processing,NLP)是计算机科学与人工智能领域中的一个重要研究方向,旨在使计算机能够理解和处理人类的自然语言。

NLP常用算法模型是指在NLP领域中被广泛使用的一些算法模型,它们能够处理文本数据并从中提取有用的信息。

本文将介绍几个常用的NLP算法模型。

1. 词袋模型(Bag of Words)词袋模型是一种简单而常用的NLP算法模型,它将文本表示为一个词汇表,并统计每个词在文本中出现的频率。

词袋模型忽略了单词的顺序和上下文信息,只关注单词的频率。

通过词袋模型,我们可以将文本数据转化为数值型数据,以便于计算机处理。

2. TF-IDF模型TF-IDF(Term Frequency-Inverse Document Frequency)模型是一种用于评估一个词对于一个文档集或一个语料库中的一个特定文档的重要程度的统计方法。

TF-IDF模型综合考虑了一个词在文档中的频率(Term Frequency)和在整个语料库中的逆文档频率(Inverse Document Frequency),从而计算出一个词的权重。

TF-IDF模型常用于文本分类、信息检索和关键词提取等任务。

3. 词嵌入模型(Word Embedding)词嵌入模型是一种将词语映射到低维空间向量表示的方法。

它能够捕捉到词语之间的语义关系,使得相似含义的词在向量空间中更加接近。

Word2Vec和GloVe是两种常用的词嵌入模型。

词嵌入模型在NLP任务中广泛应用,如文本分类、命名实体识别和情感分析等。

4. 循环神经网络(Recurrent Neural Network,RNN)循环神经网络是一种具有记忆性的神经网络模型,可以处理序列数据,尤其适用于处理自然语言。

RNN通过引入循环结构,使得网络能够记住之前的信息,并在当前的输入上进行计算。

自然语言处理大模型应用案例

自然语言处理大模型应用案例自然语言处理(Natural Language Processing,简称NLP)是人工智能领域的一个重要分支,旨在使计算机能够理解、分析和生成人类语言。

随着深度学习技术的发展,现在已经出现了许多大模型应用于自然语言处理任务,下面将列举10个具体的案例。

1. 机器翻译:大模型可以用于机器翻译任务,将一种语言的文本转换成另一种语言的文本。

通过训练大模型,可以提高翻译的质量和准确性。

2. 文本分类:大模型可以用于文本分类任务,将给定的文本分为不同的类别。

这在新闻分类、情感分析等场景中有着广泛的应用。

3. 语言模型:大模型可以用于语言模型的训练,即根据给定的上下文预测下一个词或字符。

语言模型可以应用于文本生成、语音识别等任务。

4. 问答系统:大模型可以用于问答系统,通过训练大模型,可以使得计算机能够根据问题回答用户的提问,并提供相关的信息和答案。

5. 情感分析:大模型可以用于情感分析任务,即分析文本的情感倾向,判断文本是积极的、消极的还是中立的。

这在舆情分析、社交媒体分析等领域有着广泛的应用。

6. 命名实体识别:大模型可以用于命名实体识别任务,即识别文本中的人名、地名、组织名等实体。

这在信息抽取、知识图谱构建等领域中有着重要的应用。

7. 关键词提取:大模型可以用于关键词提取任务,即从给定的文本中抽取出最重要的关键词。

这在文本摘要、信息检索等场景中有着广泛的应用。

8. 语音识别:大模型可以用于语音识别任务,将语音转换成文本。

通过训练大模型,可以提高语音识别的准确性和鲁棒性。

9. 文本生成:大模型可以用于文本生成任务,生成符合语法和语义规则的文本。

这在对话系统、写作助手等场景中有着重要的应用。

10. 信息抽取:大模型可以用于信息抽取任务,即从结构化和非结构化的文本中抽取出关键信息。

这在知识图谱构建、信息检索等领域有着广泛的应用。

以上是十个基于大模型的自然语言处理应用案例,这些应用在实际生活中有着广泛的应用价值,能够为人们提供更智能、便捷的服务。

nlp 问答模型 指标

nlp 问答模型指标NLP 问答模型是一种利用自然语言处理技术进行问答的模型。

它可以根据用户的问题,从大量的文本数据中寻找并提供准确的答案。

本文将介绍 NLP 问答模型的工作原理、应用场景以及评估指标。

一、NLP 问答模型的工作原理NLP 问答模型主要分为两个步骤:问题理解和答案生成。

问题理解阶段包括问题分析、语义理解和信息检索。

首先,模型需要对用户提出的问题进行分析,包括词性标注、句法分析等。

然后,模型需要对问题进行语义理解,确定用户的意图和需求。

最后,模型通过信息检索技术,从大规模的知识库或文本数据中找到与问题相关的信息。

答案生成阶段包括候选答案生成和答案选择。

在候选答案生成阶段,模型根据问题和相关信息生成多个候选答案。

然后,在答案选择阶段,模型根据一定的评分指标,选择最佳的答案作为输出。

二、NLP 问答模型的应用场景NLP 问答模型在许多领域都有广泛的应用,如智能客服、智能助手、知识图谱等。

在智能客服领域,NLP 问答模型可以根据用户的问题,提供准确的答案,解决用户的问题,提高客户满意度。

在智能助手领域,NLP 问答模型可以回答用户的各种问题,如天气查询、交通信息查询、翻译等,提供便捷的服务。

在知识图谱领域,NLP 问答模型可以根据用户的问题,从知识图谱中提取相关的知识,并生成准确的答案,帮助用户获取所需信息。

三、NLP 问答模型的评估指标评估 NLP 问答模型的性能可以使用多个指标,包括准确率、召回率、F1 值等。

准确率是指模型给出的答案中正确的比例。

召回率是指模型找到的正确答案占所有正确答案的比例。

F1 值是准确率和召回率的调和平均数,综合考虑了模型的准确性和召回性能。

除了这些常用的指标,还可以使用其他指标来评估模型的性能,如BLEU 分数、ROUGE 分数等。

这些指标主要用于评估模型生成的文本的质量和流畅度。

总结:NLP 问答模型是一种利用自然语言处理技术进行问答的模型。

它可以根据用户的问题,从大量的文本数据中提供准确的答案。

nlp概念模型

nlp概念模型NLP(自然语言处理)概念模型是一种用于表示和处理自然语言的模型。

它主要包含以下几个方面的内容:1. 语言模型(Language Model):语言模型是用来预测句子(或文本序列)的概率的模型,它可以帮助理解文本的上下文和语法规则。

2. 词嵌入(Word Embedding):词嵌入是将词语表示为固定长度的向量,以便计算机可以更好地理解和处理词语。

常用的词嵌入模型包括Word2Vec、GloVe和BERT。

3. 句法分析(Syntactic Parsing):句法分析是确定句子的语法结构的过程,它可以将句子分解成词语和句法关系的组合。

常用的句法分析模型包括基于规则的方法、概率上下文无关文法(PCFG)和神经网络模型。

4. 语义分析(Semantic Analysis):语义分析是理解句子的意义和逻辑关系的过程,它可以基于词义、词组和上下文来推断句子的含义。

常用的语义分析模型有词义消歧(Word Sense Disambiguation)、命名实体识别(Named Entity Recognition)和情感分析(Sentiment Analysis)等。

5. 机器翻译(Machine Translation):机器翻译是将一种语言的句子或文本自动转化为另一种语言的过程。

常见的机器翻译模型有统计机器翻译(SMT)和神经网络机器翻译(NMT)。

6. 对话系统(Dialogue System):对话系统是用于与人进行对话的智能系统。

它可以帮助解决实际问题、提供信息或进行娱乐等。

常见的对话系统有基于规则的对话系统、基于检索的对话系统和基于生成的对话系统。

这些概念模型都是NLP领域的重要组成部分,它们相互关联,共同构成了自然语言处理的基础框架。

大模型在nlp中的应用研究

大模型在nlp中的应用研究如下:

•机器翻译。

机器翻译是NLP领域的一个重要应用,而大规模模型在提高翻译准确度和效率方面发挥了重要作用。

通过训练大规模的神经网络模型,可以学习到语言之间的内在联系和转换规则,从而实现更加准确和流畅的翻译。

•问答系统。

大规模模型在问答系统中也得到了广泛应用。

通过对大规模语料库进行训练,模型可以学习到各种语言模式和知识,从而能够更好地理解和回答用户提出的问题。

•文本生成。

大规模模型在文本生成方面也取得了显著的成果。

例如,利用大规模的GPT系列模型,可以实现各种文本的自动生成,如新闻报道、小说、广告文案等。

•情感分析。

大规模模型也被广泛应用于情感分析中。

通过对大规模的文本数据进行训练,模型可以学习到文本中所包含的情感信息,从而对文本进行情感分类或情感倾向性分析。

总之,大规模模型在NLP领域的应用研究已经取得了很大的进展,但仍需要不断改进和优化模型,以适应不同的应用场景和需求。

神经语言程序(NLP)教学法的模型构建

神经语言程序(NLP)教学法的模型构建【摘要】神经语言程序(NLP)教学法的模型构建在教育领域中具有重要意义。

本文从神经网络在NLP教学法中的应用、语言模型的构建、情感分析模型的构建、文本生成模型的构建以及数据预处理与特征工程等方面展开讨论。

研究指出,通过构建有效的模型可以提高教学效果,帮助学生更好地理解和应用语言知识。

结合实际案例分析,本文总结了NLP教学法的模型构建在提升学习者语言能力和情感认知方面的积极作用。

未来,可以进一步探索更多的模型构建方法,推动NLP教学法在教育领域的应用前景。

神经语言程序(NLP)教学法的模型构建将为教育改革和语言教学带来新的发展机遇。

【关键词】神经语言程序(NLP)教学法、模型构建、神经网络、语言模型、情感分析模型、文本生成模型、数据预处理、特征工程、总结、未来发展、应用前景。

1. 引言1.1 神经语言程序(NLP)教学法的模型构建概述神经语言程序(NLP)是人工智能领域中一门重要的研究方向,它致力于实现计算机与人类自然语言的高效交互与理解。

在教学领域,NLP技术的应用也日益受到重视,通过构建NLP模型来辅助教育教学过程,提高学生的学习效果和教学效率已经成为一个热门研究方向。

神经网络作为NLP模型构建的核心技术,在教学法中发挥着重要作用。

神经网络可以通过大量的文本数据进行训练,从而学习语言中的规律和特征,实现自然语言处理和分析。

在NLP教学法中,利用神经网络构建各种模型,可以帮助教师和学生更好地理解语言、分析情感、生成文本等。

NLP教学法中还涉及到语言模型的构建、情感分析模型的构建、文本生成模型的构建等内容。

这些模型的构建需要对数据进行预处理和特征工程,以确保模型的准确性和有效性。

通过构建神经语言程序(NLP)教学法的模型,可以有效提升教育教学的质量和效率,为学生和教师提供更好的学习和教学体验。

神经语言程序(NLP)教学法的研究意义和应用前景将在接下来的内容中逐一展开。

利用自然语言处理技术进行自然语言理解的模型可解释性分析(四)

自然语言处理(NLP)技术近年来得到了广泛的应用和发展,其在自然语言理解方面取得了不小的进展。

然而,随着NLP技术的不断发展,人们对于NLP模型的可解释性也越来越关注。

在本文中,我们将探讨利用自然语言处理技术进行自然语言理解的模型的可解释性分析,并探讨其应用前景。

一、NLP技术的发展自然语言处理技术是人工智能领域的一个重要分支,其主要目标是使计算机能够理解、分析和处理人类语言。

随着深度学习和大数据技术的发展,NLP技术取得了巨大的进步,包括但不限于语音识别、机器翻译、情感分析、文本分类等方面。

二、NLP模型的可解释性在NLP领域,模型的可解释性是一个重要的议题。

NLP模型通常是通过大量的语料库进行训练,以便能够准确地理解和处理自然语言。

然而,由于NLP模型通常是由深度神经网络构建而成,其复杂的结构和参数使得其可解释性较低,人们往往难以理解模型的决策过程和内部机制。

三、利用自然语言处理技术进行自然语言理解的模型可解释性分析针对NLP模型的可解释性问题,近年来研究者们开展了大量的工作,以提高NLP模型的可解释性。

其中,基于注意力机制的模型成为了研究热点之一。

通过引入注意力机制,模型可以学习到输入文本中不同部分的重要性,从而使得模型的决策过程更加透明和可解释。

另外,研究者们还提出了一些针对NLP模型可解释性的评估指标和方法。

例如,可以通过可视化模型的注意力权重来分析模型对于输入文本的关注点,或者通过解释性的文本生成来理解模型的决策过程。

四、NLP模型的可解释性对应用的意义NLP模型的可解释性不仅仅是一个学术问题,更关乎到NLP技术在实际应用中的可信度和可靠性。

例如,在医疗领域,NLP技术被广泛应用于医疗文本的自动化处理,包括疾病诊断、病历记录等方面。

如果NLP模型的决策过程不可解释,那么医生和病人可能难以信任模型的判断结果。

因此,提高NLP模型的可解释性对于医疗领域的应用至关重要。

此外,在金融领域,NLP技术也被广泛应用于金融新闻的情感分析、舆情监测等方面。

自然语言处理中常见的词性标注模型(Ⅱ)

自然语言处理中常见的词性标注模型一、概述自然语言处理(Natural Language Processing, NLP)是计算机科学与人工智能领域的交叉学科,旨在让计算机能够理解、处理和生成自然语言。

而词性标注(Part-of-Speech Tagging, POS tagging)则是NLP领域中的一项重要任务,其目标是为给定的词汇赋予相应的词性,例如名词、动词、形容词等。

在本文中,我们将介绍自然语言处理中常见的词性标注模型。

二、基于规则的词性标注模型基于规则的词性标注模型是最早的一种词性标注方法,其核心思想是根据语言学规则和语法知识来为文本中的词汇赋予词性。

这种方法的优点在于规则清晰、可解释性强,但缺点也很明显,即需要大量的人工编写规则,并且很难覆盖所有的语言现象。

因此,基于规则的词性标注模型在实际应用中并不常见。

三、基于统计的词性标注模型随着数据驱动方法的兴起,基于统计的词性标注模型逐渐成为主流。

其中,最为经典的模型之一是隐马尔可夫模型(Hidden Markov Model, HMM)。

HMM是一种概率图模型,其基本思想是将词性标注问题转化为一个序列标注问题,通过计算给定词序列下各个词性序列的条件概率,来确定最可能的词性序列。

HMM在词性标注领域取得了很大的成功,但也存在着对上下文信息利用不足的问题。

另一种基于统计的词性标注模型是条件随机场(Conditional Random Field, CRF)。

与HMM相比,CRF能够更好地利用上下文信息,因此在词性标注的准确性上有所提升。

CRF的特点是能够建模输入序列和输出序列之间的依赖关系,因此在词性标注任务中表现出色。

四、基于神经网络的词性标注模型近年来,随着深度学习的发展,基于神经网络的词性标注模型也逐渐崭露头角。

其中,双向长短时记忆网络(Bidirectional Long Short-Term Memory, BiLSTM)和转移型词性标注模型(Transition-Based POS Tagging Model)是两种比较典型的模型。

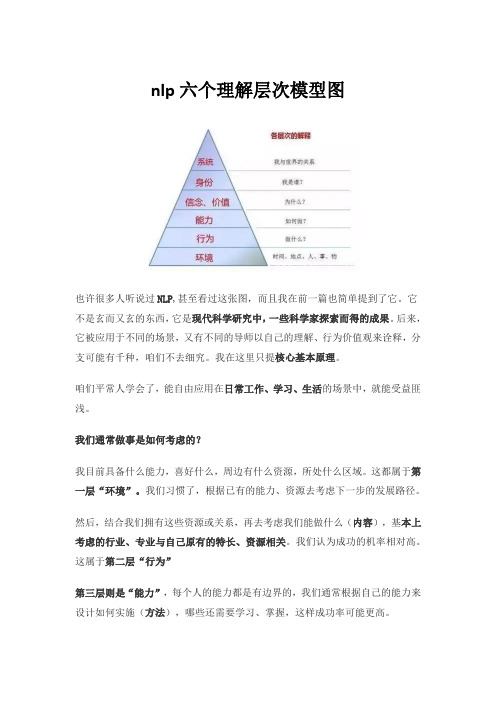

nlp六个理解层次模型图

nlp六个理解层次模型图也许很多人听说过NLP,甚至看过这张图,而且我在前一篇也简单提到了它。

它不是玄而又玄的东西,它是现代科学研究中,一些科学家探索而得的成果。

后来,它被应用于不同的场景,又有不同的导师以自己的理解、行为价值观来诠释,分支可能有千种,咱们不去细究。

我在这里只提核心基本原理。

咱们平常人学会了,能自由应用在日常工作、学习、生活的场景中,就能受益匪浅。

我们通常做事是如何考虑的?我目前具备什么能力,喜好什么,周边有什么资源,所处什么区域。

这都属于第一层“环境”。

我们习惯了,根据已有的能力、资源去考虑下一步的发展路径。

然后,结合我们拥有这些资源或关系,再去考虑我们能做什么(内容),基本上考虑的行业、专业与自己原有的特长、资源相关。

我们认为成功的机率相对高。

这属于第二层“行为”第三层则是“能力”,每个人的能力都是有边界的,我们通常根据自己的能力来设计如何实施(方法),哪些还需要学习、掌握,这样成功率可能更高。

第四层是“信念、价值”,我们应该怎样怎样,我认为什么特质最重要。

这就是核心价值观。

第五层是身份的确认,我们想让自己成为什么样的人,自己的理想是什么,我想过什么样的一生。

第六层是系统,有的也叫灵性,指我们与世界的关系。

我们人生的意义何在,通常是宗教、信仰解决这个问题。

现代科学任何一门学科,学到博士最终都上升到哲学的范畴。

我们从第一层,直到第六层,真是很难。

很可能走几层,就不愿意多想了。

层次越低的问题,越容易解决;而当问题集中在信念或身份、系统时,解决起来会变得困难。

我们不得不,承认人与人之间的确存在较大差异。

我们现在能看到马云在淘宝一穷二白的情况下,畅想远景,面向国际市场。

如今发现,当年吹过的牛,现今居然都成了真,还将越做越好。

这说明什么?一生要做的事业,不是一步一步做成的,而是一开始设定的。

如果从上到下,是个降维过程。

思路清晰,更有效率。

有个故事说,一位学生向爱因斯坦请教,这个世界上最重要的问题是什么?我不知道这个故事是真,还是杜撰,但可以借来解释NLP六层次这个理论。

经典的自然语言处理模型

经典的自然语言处理模型自然语言处理(NaturalLanguageProcessing,NLP)是计算机科学与人工智能领域重要的研究方向,它致力于让计算机理解、处理和生成自然语言。

在NLP领域中,有许多经典的模型被广泛应用于各种任务。

下面,我们就来介绍一下这些经典的自然语言处理模型。

1. 朴素贝叶斯模型(Naive Bayes Model)朴素贝叶斯模型是一种基于贝叶斯定理的分类算法,它在文本分类、垃圾邮件过滤、情感分析等任务中表现出色。

该模型的优点在于其简单性和高效性,但是它也存在着假设“特征之间相互独立”的缺陷。

2. 支持向量机模型(Support Vector Machine Model)支持向量机模型是一种二分类模型,它通过在高维空间中找到一个最优超平面来实现分类。

该模型在文本分类、情感分析等任务中表现优秀,但是其需要大量计算资源和数据,因此在处理大规模数据时效率较低。

3. 隐马尔可夫模型(Hidden Markov Model)隐马尔可夫模型是一种统计模型,它用来描述由隐藏的马尔可夫链随机生成观测序列的过程。

该模型在自然语言生成、语音识别等任务中得到广泛应用。

4. 递归神经网络模型(Recurrent Neural Network Model)递归神经网络模型是一种具有时间循环结构的神经网络模型,它可以处理序列数据。

该模型在语音识别、自然语言生成等任务中表现出色,但是其计算量大、训练时间长,容易出现梯度消失等问题。

5. 卷积神经网络模型(Convolutional Neural Network Model)卷积神经网络模型是一种可以提取局部特征的神经网络模型,它在文本分类、情感分析等任务中表现极佳。

该模型的训练速度快,但是需要大量数据和计算资源。

总之,以上这些经典的自然语言处理模型都有其独特的优点和不足之处,需要根据具体任务来选择合适的模型。

随着人工智能技术的不断发展,NLP领域的研究也将越来越深入,相信未来会有更加先进的模型和方法被提出和应用。

自然语言处理中的深度学习模型介绍

自然语言处理中的深度学习模型介绍自然语言处理(Natural Language Processing,NLP)是人工智能领域的重要分支之一,它研究如何使计算机能够理解和处理人类语言。

近年来,深度学习模型在NLP领域取得了巨大的突破,为机器翻译、情感分析、语义理解等任务带来了显著的改进。

深度学习是一种模仿人脑神经网络结构的机器学习方法,它通过多层次的神经元网络来模拟人脑的信息处理过程。

在NLP中,深度学习模型可以用于从海量的文本数据中学习语言的规律和特征,进而实现各种自然语言处理任务。

一种常用的深度学习模型是循环神经网络(Recurrent Neural Network,RNN)。

RNN通过引入时间维度,使得模型能够处理序列数据,如句子、段落等。

RNN的一个重要变种是长短时记忆网络(Long Short-Term Memory,LSTM),它通过引入门控机制解决了传统RNN中的梯度消失和梯度爆炸问题,使得模型能够更好地捕捉长距离依赖关系。

在机器翻译任务中,深度学习模型已经取得了巨大的成功。

以循环神经网络为基础的编码-解码模型(Encoder-Decoder Model)被广泛应用于机器翻译领域。

该模型将输入序列编码成一个固定长度的向量表示,然后通过解码器将该向量表示转换成目标语言的序列。

通过大规模的平行语料训练,深度学习模型能够学习到源语言和目标语言之间的映射关系,从而实现高质量的机器翻译。

除了机器翻译,情感分析也是NLP领域中一个重要的任务。

深度学习模型在情感分析中的应用主要是通过卷积神经网络(Convolutional Neural Network,CNN)来实现。

CNN通过引入卷积操作和池化操作,能够有效地提取文本中的局部特征,并通过多层次的卷积层和全连接层来进行特征融合和分类。

通过大规模的情感标注数据训练,深度学习模型能够学习到文本中的情感信息,从而实现准确的情感分类。

除了RNN和CNN,还有一些其他的深度学习模型在NLP领域中得到了广泛应用。

扩散模型nlp

扩散模型nlp扩散模型NLP:为AI赋予人类情感和自然度随着人工智能的不断发展,自然语言处理(Natural Language Processing,简称NLP)成为了人工智能领域中备受关注的热门技术。

而在NLP领域中,扩散模型(Transformer)则是一种引人瞩目的重要技术。

扩散模型是一种基于注意力机制的神经网络模型,它的出现极大地改进了自然语言处理的效果。

相比传统的循环神经网络(RNN)和卷积神经网络(CNN),扩散模型能够更好地捕捉文本之间的长距离依赖关系,从而在各种NLP任务中取得了显著的成果。

在NLP领域中,扩散模型被广泛应用于机器翻译、文本生成、文本分类、命名实体识别等任务中。

尤其是在机器翻译领域,扩散模型凭借其强大的建模能力,使得机器翻译的质量大幅提升。

通过学习大规模的语料库,扩散模型能够准确地捕捉到不同语言之间的语义和句法特征,从而实现更加准确、流畅的翻译效果。

除了机器翻译,扩散模型在文本生成任务中也有着重要的应用。

基于扩散模型的文本生成系统能够生成富有逻辑性和连贯性的文章,使得生成的文本更加接近人类的表达方式。

这使得扩散模型在自动写作、对话系统等领域有着广泛的应用前景。

扩散模型的成功之处在于它能够充分利用注意力机制来处理文本中的信息,从而更好地捕捉到文本之间的关联性。

通过将输入序列中的每个单词都与其他单词进行关联,扩散模型能够更好地理解上下文信息,从而提高模型的预测能力。

然而,尽管扩散模型在NLP领域中取得了巨大的成功,但它仍然存在一些挑战和局限性。

首先,扩散模型需要大量的计算资源来进行训练,这使得它在实际应用中的成本较高。

其次,扩散模型对于数据的依赖性较强,需要大量的标注数据来进行训练,这在某些领域中可能会受到限制。

为了进一步改进扩散模型的性能,研究人员提出了许多改进方法。

其中包括基于预训练的模型(Pretrained Models)、模型压缩(Model Compression)和模型蒸馏(Model Distillation)等技术。

自然语言处理中的语义分析模型

自然语言处理中的语义分析模型自然语言处理(Natural Language Processing,简称NLP)是人工智能领域中的一个重要研究方向,旨在使计算机能够理解和处理人类语言。

在NLP的各个任务中,语义分析是其中一个关键环节。

语义分析模型旨在理解和表达句子、段落或文本的语义信息,帮助计算机更好地理解人类语言的含义。

一、语义分析的背景和意义随着互联网的快速发展,大量的文本数据被生成和积累。

为了更好地利用这些数据,语义分析成为了必不可少的工具。

语义分析模型可以帮助计算机从文本中提取出关键信息,进行情感分析、推荐系统、机器翻译等任务。

此外,语义分析还可以应用于智能客服、智能问答系统等领域,提供更加智能化和人性化的服务。

二、传统的语义分析方法在NLP领域,传统的语义分析方法主要基于规则和规则库。

这些方法需要人工编写大量的规则和规则库,以指导计算机进行语义分析。

然而,这种方法存在着规则编写困难、规则库难以维护等问题,无法适应大规模和多样化的文本数据处理需求。

三、基于机器学习的语义分析模型为了解决传统方法的问题,近年来,基于机器学习的语义分析模型得到了广泛应用。

这些模型通过学习大量的文本数据,自动学习语义分析的规律和模式。

其中,深度学习模型如卷积神经网络(CNN)和循环神经网络(RNN)在语义分析中取得了显著的成果。

四、卷积神经网络在语义分析中的应用卷积神经网络是一种前馈神经网络,其在图像处理中取得了巨大的成功。

近年来,卷积神经网络也被引入到语义分析中。

通过卷积层的滤波器,卷积神经网络可以提取文本中的局部特征。

然后,通过池化层和全连接层的处理,卷积神经网络可以将这些特征组合起来,得到文本的语义表示。

五、循环神经网络在语义分析中的应用循环神经网络是一种具有记忆能力的神经网络,能够处理序列数据。

在语义分析中,循环神经网络可以通过记忆之前的信息,更好地理解文本的语义。

通过循环层的处理,循环神经网络可以捕捉到文本中的上下文信息,从而更好地进行语义分析。

经典的自然语言处理模型

经典的自然语言处理模型自然语言处理(Natural Language Processing,NLP)是人工智能领域中的一个重要研究方向,旨在使计算机能够理解、分析和生成人类自然语言。

随着深度学习的发展,现代NLP模型在文本分类、情感分析、机器翻译等任务上取得了显著的成果。

下面将介绍几个经典的自然语言处理模型。

1. 词袋模型(Bag of Words,BoW)词袋模型是最简单直观的NLP模型之一,它将文本表示为一个词汇表中所有词汇的统计信息。

在词袋模型中,忽略词语的顺序和语法结构,只关注每个词汇的频率。

对于文本分类任务,可以将每个词汇看作特征,通过向量化表示实现机器学习算法的输入。

缺点是无法捕捉词汇的语义信息。

2. 词嵌入模型(Word Embedding)为了解决词袋模型的缺点,词嵌入模型被提出。

词嵌入模型通过学习词汇在一个低维空间中的分布式表示,将每个词汇映射为一个密集向量。

这种表示能够捕捉到词汇之间的语义关系,如近义词的相似性等。

Word2Vec和GloVe是两个常用的词嵌入模型,它们通过预训练大规模语料库实现了高质量的词嵌入向量。

3. 长短期记忆网络(Long Short-Term Memory,LSTM)LSTM是一种循环神经网络(Recurrent Neural Network,RNN)的变种,适用于处理序列数据,如自然语言。

相比传统的RNN,LSTM具有更强的记忆能力,能够学习并捕捉长期依赖关系。

LSTM通过门控机制,可以选择性地忘记、更新和输出信息,使得模型能够更好地处理文本的长期依赖性。

4. 卷积神经网络(Convolutional Neural Network,CNN)CNN最初是用于图像处理领域,但在NLP中也得到了广泛应用。

CNN通过卷积操作和池化操作来提取文本特征,使得模型能够自动学习特征的局部关系。

在文本分类、情感分析等任务中,CNN可以作为一个分类器来捕捉文本中的语义特征,相较于传统的机器学习算法具有更好的性能。

nlp思考能力模型

NLP思考能力模型是一个相对标准化的模型,通过这个模型,我们可以给每件事情赋予相对意义,把大部分时间和精力放在有深远意义的事情上,累积出来的效果自然把人生推至更理想的高线上。

这个模型包括六个层次,从低到高分别是环境、行为、能力、信念/价值观、身份和精神(系统)。

1. 环境:包括除自己本身以外的人、事、物、时、地的元素。

这些都是资源,可以为我们所用,但不能控制它们。

2. 行为:是在环境中实际操作过程,也就是做的过程,所采用的方式。

3. 能力:是人在一个情况里所拥有的不同选择,情绪也属于能力的层次,它体现了人做事的灵活性。

4. 信念/价值观:代表了做事的意义,就是为什么做?

5. 身份:就像一颗钻石,角色是它不同的剖面。

也就是“我是谁?” “我要如何实现生命的最终意义”。

6. 精神(系统):也称系统,即“我与世界的关系和影响”,我对这个世界的贡献,这是心灵层次的问题。

一般来说,我们通常从低层次的问题出发去寻找解决方法,但如果遇到困难或瓶颈,就容易陷入低层次的困扰。

此时,如果能从高层次的角度思考问题,往往能找到更好的解决方案。

经典的自然语言处理模型

经典的自然语言处理模型自然语言处理(Natural Language Processing, NLP)是人工智能领域的一个重要分支,旨在让计算机能够理解、解释和生成人类语言。

在NLP领域中,有一些经典的模型被广泛应用于各种任务,如文本分类、情感分析、语言生成等。

本文将介绍一些经典的自然语言处理模型,包括传统的统计方法和现代的深度学习模型。

首先,我们来谈谈传统的统计方法。

在NLP早期阶段,研究人员主要采用基于规则和统计的方法来处理自然语言。

其中,最经典的模型之一就是n-gram语言模型。

n-gram模型是一种基于马尔可夫假设的语言模型,它假设一个词的出现只依赖于前面n个词。

通过统计训练语料库中的n-gram出现频率,可以计算文本的概率。

虽然n-gram模型简单直观,但在一些任务上表现出色,比如机器翻译和语音识别。

另一个经典的模型是隐马尔可夫模型(Hidden Markov Model, HMM)。

HMM是一种用于建模时序数据的概率图模型,被广泛应用于语音识别、词性标注等任务中。

HMM模型假设观测序列的生成过程是由一个隐藏的马尔可夫链决定的,通过观测序列的最大似然估计来学习模型参数。

虽然HMM模型在一些任务上表现良好,但在处理长距离依赖性和复杂语义理解方面存在局限性。

随着深度学习的兴起,现代的NLP模型开始采用神经网络来处理自然语言。

其中,最著名的模型之一就是循环神经网络(Recurrent Neural Network, RNN)。

RNN是一种递归神经网络,能够处理变长序列数据。

通过反复的神经元连接,RNN能够捕捉序列数据中的长距离依赖性,被广泛应用于语言建模、机器翻译等任务中。

然而,传统的RNN模型存在梯度消失和梯度爆炸的问题,限制了模型的学习能力。

为了解决RNN的问题,研究人员提出了长短时记忆网络(Long Short-Term Memory, LSTM)。

LSTM是一种特殊的RNN变体,通过门控单元的设计来解决梯度消失和梯度爆炸的问题。

nlp逻辑思维模型

NLP逻辑思维模型引言自然语言处理(Natural Language Processing,NLP)是人工智能领域的一个重要分支,旨在使计算机能够理解和处理人类语言。

NLP逻辑思维模型是一种基于逻辑思维方法的NLP模型,通过建立逻辑关系和推理规则,帮助计算机更好地理解和分析自然语言。

逻辑思维模型的基本原理逻辑思维模型基于形式逻辑和推理规则,通过将自然语言转化为逻辑形式,再基于逻辑规则进行推理和分析。

其基本原理如下:1.语义解析:将自然语言转化为逻辑形式,将语句中的实体、属性和关系等要素提取出来,并建立相应的逻辑关系。

2.知识表示:将领域知识以逻辑形式表示,构建知识库。

知识库中包含实体、属性和关系的定义以及它们之间的逻辑规则。

3.推理与推断:基于知识库中的逻辑规则,进行推理和推断,从而得出新的结论或回答用户的问题。

4.语言生成:将逻辑形式转化为自然语言,生成符合人类习惯和习语的语句,以提供给用户。

NLP逻辑思维模型的应用领域NLP逻辑思维模型可以应用于多个领域,包括但不限于以下几个方面:1. 问答系统通过将用户的问题转化为逻辑形式,并基于知识库进行推理,NLP逻辑思维模型可以帮助问答系统更准确地回答用户的问题。

例如,用户问:“谁是美国第一位总统?”,模型可以通过知识库中的逻辑规则得出结论:“乔治·华盛顿是美国第一位总统”。

2. 文本分类与情感分析NLP逻辑思维模型可以对文本进行分类和情感分析。

通过将文本转化为逻辑形式,并基于知识库中的规则进行推理,模型可以判断文本的类别和情感倾向。

例如,对于一篇电影评论,模型可以判断该评论是正面还是负面,以及该评论属于哪个电影类型。

3. 信息抽取与知识图谱构建NLP逻辑思维模型可以从大量的文本数据中抽取出实体、属性和关系等信息,并构建知识图谱。

通过将文本中的实体和关系转化为逻辑形式,并基于逻辑规则进行推理,模型可以建立起实体之间的关联和知识图谱。

4. 机器翻译与语言生成NLP逻辑思维模型可以将逻辑形式转化为自然语言,用于机器翻译和语言生成。

经典的自然语言处理模型

经典的自然语言处理模型自然语言处理(Natural Language Processing,NLP)是人工智能领域中的一个重要分支,涉及计算机与人类自然语言之间的交互以及语言处理的各种任务。

在NLP的研究中,经典的模型被广泛使用来处理语言文本,下面将介绍几个经典的NLP 模型,并提供一些相关的参考内容。

1. 词袋模型(Bag-of-Words Model)词袋模型是NLP中最简单且常见的模型之一。

它将文本中的每个词看作一个独立的特征,忽略了词与词之间的顺序和语法关系。

参考内容可以是关于词袋模型的原理、应用和改进方法的研究论文或教材。

2. 递归神经网络(Recursive Neural Network,RNN)RNN是一种循环神经网络结构,可以用于处理序列数据,如语言文本。

RNN具有记忆性,可以通过学习上下文的关系来理解文本的语义。

相关参考内容可以是RNN的基本原理、不同变体(如长短时记忆网络 LSTM)以及应用于NLP任务(如情感分析、机器翻译)的研究论文或教材。

3. 卷积神经网络(Convolutional Neural Network,CNN)CNN是一种用于图像处理的深度学习模型,但也经常被应用于NLP任务,如文本分类和命名实体识别。

CNN通过卷积操作捕捉局部特征,并通过池化操作进行特征降维和整合。

相关参考内容可以是关于CNN在NLP中的应用和改进方法的研究论文或教材。

4. 隐马尔可夫模型(Hidden Markov Model,HMM)HMM是一种基于概率图模型的统计模型,常用于序列标注任务,如词性标注和命名实体识别。

HMM假设观测序列是由一个隐藏的马尔可夫过程生成的,通过学习隐含的状态序列来进行标注和分析。

相关参考内容可以是有关HMM的原理、改进方法和应用于NLP任务的研究论文或教材。

5. 神经语言模型(Neural Language Model)神经语言模型是使用神经网络来建模语言概率分布的模型。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

期望的状态现在想像一种你期望达到的状态,就像运用你的五种感官去设想你的目标一样。

当我们设想一个令人满意的结果时,这一切都在自然地发生着。

当你为结果设想更大范围的效果、更长久的后果时,例如,别人的反应,又如你取得从未想过的目标你会做何感想,你将会更真实地体验到你所期望达到的那种状态。

这些与经历相关的感觉形成了动觉(Kinaesthetic)的一部分,在NLP中,动觉也包括触觉、本体感觉以及运动感觉。

当你熟悉每一种感觉或每一种“呈现性的系统(representa-tional system)”以及它们的特性,或者熟悉它们的属性,你将会很快地学会如何控制这些状态。

更重要的是,你能够在你目前的状态和你期望的状态的各个方面作类似比较。

同样,你也可以在如何用你的感官去感知事物的过程中做出改变。

在你的大脑思维中,你看见了什么?这使你更接近目标吗?运用这种方式,你可以验证自己是成功还是失败,不仅在物质利益(可以看得见的)方面,而且还在于状态的改变和长远生活的目标方面。

在设订目标时,你可以问自己:“什么样的精神状态是我想要的?”这不仅仅意味着每天转瞬即逝的感觉,而且也意味着能改变你精神世界的地图的长期的态度、信念、价值观和想法。

除了对你渴望去实施、去得到或者去了解的东西设订目标之外,在将状态改变过程运用到你追求目标时,你可以问自己这个很重要的问题:“我究竟想成为什么样的人?”资源为了从目前的状态改变到期望的状态,你需要资源,包括内部资源和外部资源。

目前状态+资源=期望的状态这些资源包括你过去的经历,也包括你已经学到的有助于做出改变的知识和技能。

你的资源可能还包括其他能帮助你的人,以及你可以模仿的别人的行为,或者是你所知道能在目前对你有所帮助的状态,或者你能发展并运用的最新的技能,以及你所积累的经验和智慧。

你可以在个人改变和个人追求方面运用这个状态改变模型。

通过了解目前的状态,你期望的状态以及你能利用的资源、特别是你的记忆,就可以在你的生命中开始运用这个简单的模式,以取得更大的成功。

生活满意模型( Life Content Model)我们每个人的个性和偏好不同,看待世界的方式也不同。

从而,每个人追求目标的方式也不同。

这种“经历”的模式包括了一个人生命中的大部分,因此NLP称之为生活满意模型。

它确认了我们体验生活的方式中的一些主要不同之处,而且在设立目标和做决策的过程中我们可以将这些不同之处结合在一起。

这个模型包括五种要素,或者说是个性特征;●实际行动(doing)。

●求知(knowing)。

●占有/索取(getting/having)。

●变往(relating)。

●以某种状态而存在(being)。

就如同感觉偏好—样,例如看或听,这些我们如何去理解我们的经历的特征,会在我们的生命中持续很长一段时间。

在一些情况下我们常常把它们看做是个人的特点。

然而,如果我们确认并有意识地去采用这些基本的特性,我们能取得更大的成功。

这些策略不同于我们为一个具体的技能或行为而采取的精神“策略”,他们往往在—个更高层次,作为一种与生俱来的思维习惯在起作用。

他们代表了我们为行动而采取的策略的宏观层次。

这意味着在五种生活满意模型中,每一种都包含了许多技能和行动,例如,我们每个人都有许多为取得一定结果而去行动的经历。

在这个层次(即我们采取的行动)上的任何改变,都将对我们所有的行为,从而对我们要取得的目标或者我们尚未取得的目标产生一种不成比例的影响。

让我们看看这五种倾向是如何体现在我们身上。

实际行动你是个实干的人吗?你愿意在你对事情作更多了解前就采取行动吗?你经常用到类似“做”、“行动”、“移动”、“建议”等等这样的词语吗?你常常问“现在我们需要做些什么”吗?大部分关于个性和学习风格的模型确认了这样一种“行动者”的个性。

大部分行为导向的人会意识到他们这方面的个性,他们的亲人、朋友也同样会意识到:●在别人采取行动之前他们巳经采取行功了。

●当他们被邀请参加一个有关培训的研讨会,或者被赋予一个机会去从事一项哪必是蛮横的行动,他们会毫不犹豫地参加。

●世界上绝大多数志愿者是由他们组成的。

●他们是举行对最成功的商人和最差的射手进行排名活动的倡议者,●他们热爱旅行,因为它可以产生新的体验。

●他们不愿仿效别人的生活方式,希望自主地生活。

这些个性会影响一个人实现目标的方式。

对自己的喜好作个简单的认识会帮助你更成功地达到你的目的。

把自己的喜好作为一个个性特征加以管理,甚至会带来更大的成功。

求知一些人会把理解事物、认识事物看得很重要。

在他们冒险采取行动之前,他们会尽可能多地去了解一项新的活动——一种新的技能和行为。

在某些情况下,知识和理解似乎和最终产品(指目标)一样重要。

这样的人哪怕有时没有真正体验过生命中的一些东西,但通过获取有关知识,他们一样感到很满足。

一位有求知欲望的人:●出于自身的原因而尊重知识。

●在采取行动前尽可能多地获取相关信息,而且他们往往是掌握多大程度的信息量,办事过程就执行到相应的程度。

●在他们买书之前,他们可能会把能找到的书包括有关汽车、计算机或假期等等全部看一遍。

●读过大量的非小说类书籍。

●常常使用“知道”、”理解”、“学习”、“了解”、“查明”以及类似的词语。

●常问问题,仔细聆听。

获取知识对于他们来说,可以带来快乐,一种力量的感觉、一种安全的感觉以及其他方面的好处,尽管这在一个行动导向的人看来很难理解。

除了他们无意识的愿望和目的之外,求知在他们实现目标的方式中可能起着很大的作用。

索取/占有另一类人对物质利益有特殊的喜好。

他们只有获得物质或拥有物质才会满意。

我们把这类人称为实利主义者。

他们希望得到更多的物质,常常使用一些像“得到”、“拥有”、“物质”、“获得”和“我的”这样的词语。

它们可能并不总是用于物质占有或者获取财富和取得成功的场合。

例如,有的时候,一个人希望实现个人目标(例如,“获得”目标),例如学习一门语言或掌握一项技能,这种具体的证明可以采用的形式包括证书、奖金或其他受到承认的形式。

在这种情况下,一个人所获得的东西本身并无任何价值,但是长远来看,却象征了某一种行为或成绩。

这样一个人需要拥有一些东西,以此来向别人展示自己曾做过的以及自己所知道的。

将自己的注意力放在占有物质的人,往往会把获知或者行动放在第二位。

如果他们无需任何努力就能享受到最终产品,对他们来说,这是最好的。

例如,在他们买了一辆轿车或一个高保真音响后,他们会立即亨受占有这些东西带给他们的乐趣,稍后他们才会去浏览使用手册。

你可以很容易辨别出占有欲望强的人们,因为他们往往选择最新的小玩意,并且充分享受一个现代家庭或现代商业所有的个人装备。

你可能还会注意到一些更细微的证明。

工作上的晋升是与对不同昀椅子、桌子、办公室的期望紧密联系在一起,也是与新职位方方面面的工作、新的关系联系在一起,在培训课上,一些人如果在课程结束时没有满载而归,他们就会感觉受骗了。

交往一些人把同别人的联系视做生活中最重要的部分,我们可以称之为“交往的人”。

这样的人把别人的感觉,别人的想法同自己联系在一起,没有外部的肯定,他们不会学任何东西。

他们常常问自己,“某某人是怎么看我的?”通过如下一些方法来确认他们:●倾听他们是否经常提及类似“关于”、“交流”、“联系”和“感觉”这样的词语。

●倾听他们是否经常提及剐人的姓名。

●别人的想法在他们的心目中占据很高的地位,有时这包括已故的父母、兄弟姐妹、老师以及下属。

●他们参加的俱乐部,他们买的车,以及他们愿意参加的体育活动的种类都反映出他们对于别人对他们的评价作何感想。

这些人常常把别人的利益放在自己的利益之上。

他们可能享受到参与活动、拥有物质的乐趣,但他们真正关心的只是参与这些活动,以及拥有物质对他们的名誉、声望和重要关系产生的影响。

这并不意味着利他毛义。

很明显,无论我们的生活满意模型是什么样的,我们总能够从我们日常行为中所采用的策略之外得到快乐和益处,即使我们是无意识地在追求这种快乐。

作为某一状态而存在一些人无论是在生理感觉上,还是在抽象的感觉上,都把职位放在首位。

他们常常使用像“家”、“成为”这样的词语,他们会说“我想成为……(I want to be …)”而不是“我想知道……(I want to know ……)”,或者“我想做……(I want to do …)”等等。

例如,一些人希望自己安顿下来,希望对周围的人和事满意,希望经济上能独立等,这些似乎决定了他们的生活。

这种个性和个人的身份、地位或扮演的角色紧密相关。

初看起来,这似乎是语言表达上的差别。

例如,一个人可能会说“我是一名作家”(成为),然而另一个人会说“我写书”(行动),但任何一种体验生活和追求目标的方式都决定了一个人在特定情况下的行为。

医生、护士,士兵或喜剧演员必须做出特定的举动——更多的是由于他们的身份决定了他们必须这么做,而不是由于做出这些行为给他们带来了快乐。

人们对满意的生活会有不同的理解,这种特性的延伸甚至超越了态度,影响到我们的价值观、信念以及身份,但不会超过“成为”这一层面。

确定你的生活满意模型上面提到的五种生活满意模型对你来说似乎都很熟悉。

从一开始,你就认识周围展示出这些个性的人们。

而且,我们每个人对某一种个性都会表现出—定的倾向,同时,我们的行为至少在一定程度上是和别人的个性存在联系。

然而,我们经常会有一种直觉的偏好,告诉我们应该怎么做,特别是在要做出重要决定和生活中的改变的关键时刻。

因此,了解你自己的偏好意味着在一个非常基础的层面上了解你自己,而成功往往始于这样一个基础的层面。

如果你还没有确定在你生活中占据支配地位的个性,那么请你回想一下在不同的情况下,例如你主要的购买物,或者在假期中,在你所参加的联系活动和社会活动中,你最先展示出的是哪一种倾向。

现在,你可能已经部分的或是全部确定了你的个性。