Linux之TCPIP内核参数优化

TCP协议的性能优化与调优方法总结(三)

TCP协议的性能优化与调优方法总结一、引言TCP(Transmission Control Protocol,传输控制协议)是一种面向连接的、可靠的传输协议,在互联网通信中起到了重要的作用。

然而,随着网络的快速发展和应用需求的增加,TCP协议的性能问题也逐渐凸显出来。

本文将总结一些TCP协议的性能优化与调优方法,希望能够提供一些有益的参考。

二、拥塞控制算法优化拥塞控制是TCP协议中的一个重要机制,它通过调节数据发送速率来避免网络拥塞。

在实际应用中,可以采取以下方法优化拥塞控制算法:1. 使用更好的拥塞控制算法:目前常用的拥塞控制算法有TCP Tahoe、TCP Reno等,可以根据应用场景的具体需求选择合适的拥塞控制算法。

例如,对于延迟敏感的应用,可以选择TCP Low Latency 算法。

2. 动态调整拥塞窗口大小:通过调整拥塞窗口大小,可以有效控制数据发送速率。

可以根据网络状况实时调整拥塞窗口大小,从而提高数据传输的效率和稳定性。

三、合理设置超时与重传机制超时与重传机制是TCP协议中确保可靠性的关键机制之一。

在实际应用中,可采取以下方法进行优化:1. 设置合理的重传超时时间:过小的重传超时时间会导致过多的重传,降低网络传输效率;过大的重传超时时间会延长数据传输时间。

因此,需要根据网络环境的延迟和丢包率等情况,合理设置重传超时时间。

2. 使用快速重传机制:当接收方连续收到相同的数据段时,可以立即向发送方发送冗余的ACK,以触发发送方进行快速重传。

这样可以提前恢复丢失的数据段,减小重传延迟,提高数据传输效率。

四、优化滑动窗口机制滑动窗口机制是TCP协议中用于流量控制和传输可靠性的重要机制。

在实际应用中,可采取以下方法进行优化:1. 使用合适的窗口大小:窗口大小决定了数据发送的速率,过小的窗口大小会导致低效的传输,过大的窗口大小会导致网络拥塞。

因此,需要根据网络状况调整窗口大小,以达到最佳的传输效果。

Linux操作系统内核性能测试与调优

Linux操作系统内核性能测试与调优操作系统是计算机系统中最核心的软件之一,它负责协调和管理计算机硬件资源以及提供统一的用户界面。

Linux操作系统因其开放源代码、稳定性和安全性而备受欢迎。

然而,在大规模和高负载的环境中,Linux操作系统的性能可能会出现瓶颈。

因此,进行内核性能测试与调优是非常重要的。

一、性能测试的重要性在处理大量数据和并发用户请求时,操作系统的性能会成为瓶颈。

通过性能测试,我们可以了解操作系统在不同负载情况下的表现,进而定位和解决性能瓶颈。

性能测试有助于提高系统的响应时间、吞吐量和并发性能,从而确保系统的稳定运行。

二、性能测试的分类1. 压力测试:通过模拟实际用户行为或产生大量虚拟用户,并观察系统在负载增加的情况下的响应时间和吞吐量。

常用的压力测试工具包括Apache JMeter和Gatling等。

2. 负载测试:通过模拟实际业务场景,并且能够测试系统在高负载情况下的响应能力和稳定性。

这种测试方法可以帮助我们发现系统在繁忙时是否仍然能够正常工作,并识别可能存在的性能瓶颈。

3. 并发测试:通过模拟多个并发用户并行执行相同或不同的操作,以验证系统在并发访问下的性能表现。

这种测试方法可以评估系统的并发处理能力和资源利用率。

三、内核性能调优的重要性Linux操作系统的性能与其内核配置息息相关。

对内核的性能调优可以提高系统的响应速度、降低延迟和提高吞吐量。

通过调整内核参数和优化内核模块,可以使操作系统更好地适应特定的工作负载。

四、内核性能调优的方法1. 内核参数调整:根据系统的工作负载特点,适当调整内核参数。

例如,可以通过修改TCP/IP堆栈参数来提高网络性能,或者通过修改文件系统参数来提高磁盘I/O性能。

2. 内核模块优化:优化内核使用的模块,选择性加载和卸载不必要的模块,以减少内核的资源占用和启动时间。

3. 中断处理优化:通过合理分配和调整中断处理的优先级,减少中断处理的开销,提高系统的性能。

linux kernel tcp 保活机制

Linux内核中的TCP保活机制是一种用于检测空闲连接是否仍然有效的方法。

当启用TCP保活机制后,如果一个TCP连接在一段时间内没有数据传输,系统会发送保活探测包(Keepalive Probe)给对端,以检测连接是否仍然存活。

下面是关于Linux内核中TCP保活机制的一些重要信息:

1.参数设置:

•TCP保活机制可以通过修改TCP套接字选项来启用和配置。

相关的套接字选项包括SO_KEEPALIVE、TCP_KEEPIDLE、TCP_KEEPINTVL和TCP_KEEPCNT。

•SO_KEEPALIVE用于启用或禁用TCP保活机制。

•TCP_KEEPIDLE指定了开始发送保活探测包之前的空闲时间。

•TCP_KEEPINTVL指定了连续发送保活探测包的间隔时间。

•TCP_KEEPCNT指定了在放弃连接之前尝试发送保活探测包的次数。

2.默认值:

•默认情况下,Linux内核中TCP保活机制是禁用的。

•如果需要使用TCP保活机制,需要在代码中显式地设置相应的套接字选项。

3.作用:

•TCP保活机制可以帮助检测连接断开的情况,例如对端意外崩溃或网络故障。

•通过发送保活探测包,可以在连接出现问题时及时发现并采取相应的处理措施。

4.注意事项:

•启用TCP保活机制可能会增加网络流量,因为需要定期发送保活探测包。

•需要谨慎配置TCP保活机制的参数,以避免对网络性能产生不必要的影响。

在实际应用中,根据具体的需求和场景,可以根据上述参数对TCP保活机制进行相应的调整和优化。

内核tcp参数

TCP参数是用来配置和调整TCP协议栈的内核参数,以优化网络性能和吞吐量。

下面是一些常见的内核TCP参数:

1. tcp_syncookies:启用SYN cookies防止SYN洪水攻击。

2. tcp_fin_timeout:设置TCP连接在关闭时等待FIN包的超时时间。

3. tcp_tw_reuse:允许复用TIME_W AIT状态的套接字。

4. tcp_tw_recycle:开启快速回收TIME_W AIT套接字的机制。

5. tcp_max_tw_buckets:限制TIME_W AIT套接字的最大数量。

6. tcp_keepalive_time:设置TCP连接的空闲时间,超过该时间将发送keepalive 探测包。

7. tcp_keepalive_probes:设置发送keepalive探测包的次数。

8. tcp_keepalive_intvl:设置两次发送keepalive探测包的间隔时间。

9. tcp_rmem:设置接收缓冲区大小。

10. tcp_wmem:设置发送缓冲区大小。

11. tcp_max_syn_backlog:设置SYN队列的最大长度,控制同时等待三次握手完成的连接数。

12. tcp_slow_start_after_idle:控制TCP长时间处于空闲状态后重新进入慢启动的阈值。

这只是一小部分常见的TCP参数,内核还有很多其他的TCP参数可以根据具体需求进行调整。

要注意,在修改这些参数之前,需要谨慎评估对系统性能和稳定性的影响,并确保了解每个参数的功能和作用。

1。

linux系统内核参数优化-linux快速入门教程

linux系统内核参数优化-linux快速⼊门教程内核的 shmall 和 shmmax 参数SHMMAX= 配置了最⼤的内存segment的⼤⼩ ------>这个设置的⽐SGA_MAX_SIZE⼤⽐较好。

SHMMIN= 最⼩的内存segment的⼤⼩SHMMNI= 整个系统的内存segment的总个数SHMSEG= 每个进程可以使⽤的内存segment的最⼤个数配置信号灯( semphore )的参数:SEMMSL= 每个semphore set⾥⾯的semphore数量 -----> 这个设置⼤于你的process的个数吧,否则你不得不分多个semphore set,好像有process+n之说,我忘了n是⼏了。

SEMMNI= 整个系统的semphore set总数SEMMNS=整个系统的semphore总数shmall 是全部允许使⽤的共享内存⼤⼩,shmmax 是单个段允许使⽤的⼤⼩。

这两个可以设置为内存的 90%。

例如 16G 内存,16*1024*1024*1024*90% = 15461882265,shmall 的⼤⼩为 15461882265/4k(getconf PAGESIZE可得到) = 3774873。

修改 /etc/sysctl.confkernel.shmmax=15461882265kernel.shmall=3774873kernel.msgmax=65535kernel.msgmnb=65535执⾏ sudo sysctl -p可以使⽤ ipcs -l 看结果。

ipcs -u 可以看到实际使⽤的情况========================================================================linux 内存管理⼀、前⾔本⽂档针对OOP8⽣产环境,具体优化策略需要根据实际情况进⾏调整;本⽂档将在以下⼏个⽅⾯来阐述如何针对RedHat Enterprise Linux 进⾏性能优化。

内核TCP优化的相关参数

内核TCP优化的相关参数

1、增大内核接收缓冲区段TCP/IP协议栈在内核实现中比较重要的一个重要参数是接受缓冲区段,它限制了TCP套接字接收数据的速率,以及TCP连接能够发送的最大字节数。

接收缓冲区段对于产生大量网络流量的高网络出口有着重要的影响。

增大TCP接收缓冲区段的目的是将已接收数据(还没有处理)缓存在内存,减少数据在硬件缓冲区之间的复制次数,从而增加吞吐量、提高网络性能。

2、增加内核重传时间间隔参数TCP/IP协议栈在内核实现中,重传时间间隔参数是控制TCP连接丢包重传时间间隔的参数,它可以控制TCP重传时间间隔,调整报文段重传时间间隔,从而改善理论性能,提高网络性能。

增大重传时间间隔的目的是利用TCP的慢启动协议,使TCP连接使用更多的期望带宽,以实现较高的吞吐量,同时,重传时间也影响着TCP重传窗口的大小,也影响了TCP连接的抗丢包能力。

3、增大保活时间参数TCP/IP协议栈在内核实现中,保活时间参数可以控制TCP连接的保活时间,默认值通常是2小时,如果TCP连接必须长时间保持下去,可以增大保活时间参数,以避免连接被服务器认为是未使用而被关闭。

linux调优参数

在Linux系统上,可以通过调整参数来优化系统的性能和功能。

以下是一些常见的Linux调优参数:内存管理:vm.swappiness:调整交换分区的使用频率,默认值为60,建议将其设置为10或更低的值,以减少交换分区的使用。

vm.min_free_kbytes:设置系统保留的空闲内存量,默认值为64,建议根据实际情况调整。

vm.max_map_count:设置进程可以拥有的最大内存映射数量,默认值为65536,如果需要运行大量进程或使用大量内存映射,可以适当增加该值。

网络性能:net.ipv4.tcp_tw_reuse:允许重用TIME_WAIT套接字,默认值为0,建议将其设置为1以减少TIME_WAIT套接字数量。

net.ipv4.tcp_fin_timeout:设置TIME_WAIT套接字的超时时间,默认值为60秒,可以适当增加该值以减少TIME_WAIT套接字数量。

net.ipv4.tcp_keepalive_time:设置TCP keepalive探测的间隔时间,默认值为75秒,可以适当增加该值以避免因长时间不活动而断开连接。

文件系统:fs.file-max:设置系统可以同时打开的最大文件数量,默认值为1024,可以根据实际情况调整。

fs.nr_open:设置系统进程可以同时打开的文件数量上限,默认值为8192,可以根据实际情况调整。

CPU 调度:kernel.sched_min_granularity_ns:设置最小调度时间粒度,默认值为1000000纳秒(1毫秒),可以根据实际情况调整。

kernel.sched_migration_cost_ns:设置CPU调度迁移的开销时间,默认值为500000纳秒(半毫秒),可以适当增加该值以提高系统在多核处理器上的性能。

系统进程:kernel.panic:设置系统崩溃时的重启次数,默认值为1,建议将其设置为0以避免系统无限重启。

fs.inotify.max_user_instances:设置系统可以监视的文件系统实例数量上限,默认值为8192,可以根据实际情况调整。

linux系统优化的方法

linux系统优化的方法

1.减少启动服务:通过启动项和初始化项,关闭一些不必要的服

务和软件,以实现启动更快,占用资源更少的目的。

2.修改内核参数:根据服务器的硬件情况,调整一些内核参数,

以达到更好的性能和资源管理。

3.安装监控工具:通过安装监控工具(如top、iostat、vmstat)分析服务器的负载情况,如CPU、内存、磁盘、网络等方面的使用情况,排除负载过高的问题。

4.调整文件系统:可以采用ext4文件系统代替ext3文件系统,

以提高磁盘读写速度。

5.优化磁盘读写:可以通过调整系统缓存、调整磁盘调度算法、

替换硬盘为SSD等方式提高磁盘读写速度,减少IO等待时间。

6.优化网络连接:通过优化网络带宽、调整TCP/IP参数、升级

驱动程序等方式提高网络连接,对于负载高的站点特别有效。

7.更新软件和补丁:定期更新系统和软件补丁,以修复漏洞,提

高系统的安全性和稳定性。

8.安全加固:通过关闭不必要的服务和端口,设置安全策略、使

用防火墙等手段加强系统的安全性。

9.资源分配策略:根据系统的使用情况,采用适当的资源分配策

略(如动态分配)提高系统的性能和使用效率。

10.使用高效的编译器:使用最新版本的编译器,对代码进行优化,减少程序的运行时间和占用资源。

Linux操作系统修改内核参数的三种方法详细说明

Linux操作系统修改内核参数的三种方法详细说明linux内核的参数设置怎么弄呢,Linux 操作系统修改内核参数有以下三种方式:修改 /etc/sysctl.conf 文件;在文件中加入配置项,格式为 key = value,保存修改后的文件,执行命令 sysctl -p 加载新配置。

使用 sysctl 命令临时修改;如:sysctl -w net.ipv4.tcp_mem = “379008 505344 758016”直接修改/proc/sys/ 目录中的文件。

如:echo “379008 505344 758016” 》 /proc/sys/net/ipv4/tcp_mem 注意:第一种方式在重启操作系统后自动永久生效;第二种和第三种方式在重启后失效。

内核参数kernel.core_uses_pi d = 1core_uses_pid 可以控制 core 文件的文件名中是否添加 pid 作为扩展名。

设置为1,表示添加 pid 作为扩展名,生成的 core 文件格式为core.xxx;设置为0(默认),表示生成的 core 文件统一命名为 core。

kernel.core_pat te rn = corecore_pattern 可以控制 core 文件的保存位置和文件格式。

如:kernel.core_pattern = “/corefile/core-%e-%p-%t”,表示将core 文件统一生成到 /corefile 目录下,产生的文件名为 core-命令名-pid-时间戳。

以下是参数列表:%p - insert pid into filename 添加 pid%u - insert current uid into filename 添加当前 uid%g - insert current gid into filename 添加当前 gid%s - insert signal that caused the coredump into the filename 添加导致产生 core 的信号%t - insert UNIX ti me that the coredump occurred into filename 添加 core 文件生成时的 unix 时间%h - insert hostname where the coredump happened into filename 添加主机名%e - insert coredumping executable name into filename 添加命令名kernel.msgmax = 8192进程间的消息传递是在内核的内存中进行的。

TCP协议的性能优化与调优方法总结

TCP协议的性能优化与调优方法总结概述:TCP协议是互联网中最重要的传输协议之一,它在保证可靠性的同时,也面临着性能方面的挑战。

本文将总结TCP协议的性能优化与调优方法,帮助提高网络传输的效率与体验。

一、流量控制与拥塞控制的关系流量控制和拥塞控制是TCP协议中的两个关键机制,它们的合理应用对于保证网络传输的效率至关重要。

流量控制的优化TCP协议中的流量控制通过窗口大小来限制发送方的发送速率,保证接收方能够及时处理接收到的数据。

优化流量控制可以改善网络传输的效率。

首先,合理设置窗口大小。

通过增大窗口大小(窗口扩大)可以提高传输速率。

但是窗口扩大过大可能会引发拥塞,需要与拥塞控制机制配合使用。

其次,采用快速重传和快速恢复机制。

快速重传允许发送方在连续收到三个重复的ACK时立即重传丢失的数据,从而避免等待超时。

快速恢复机制则可以更快地恢复拥塞窗口,提高网络传输的效率。

拥塞控制的优化拥塞控制主要通过检测网络的拥塞程度,并根据拥塞程度来调整发送方的发送速率,避免网络拥塞进一步加剧。

优化拥塞控制有助于提高网络的稳定性和可靠性。

首先,采用拥塞窗口调整算法。

拥塞窗口调整算法如慢启动、拥塞避免、快重传和快恢复等都是针对不同阶段和拥塞状态的优化算法,通过动态调整拥塞窗口的大小,使得发送方的发送速率能够适应网络的拥塞程度。

其次,使用拥塞控制机制。

常见的拥塞控制机制有随机早期检测(RED)和队列管理算法等,这些机制可以通过丢包率和延迟等指标来判断网络拥塞程度,并及时调整发送方的发送速率,从而避免拥塞的发生。

二、TCP窗口大小的优化TCP窗口大小是影响网络传输速率的一个重要参数,合理设置窗口大小有助于提高网络传输的效率。

扩大窗口大小通过扩大TCP窗口大小可以提高网络的传输速率。

窗口大小受到操作系统缓冲区的限制,可以通过更改操作系统的参数来调整窗口大小。

动态窗口大小调整动态调整窗口大小可以根据网络状况来自适应地调整发送方的发送速率,提高网络传输的效率。

内核调教方案

内核调教方案内核调教方案概述内核是操作系统的核心组件,对系统性能和稳定性起着重要的作用。

通过对内核进行调教优化,可以提升系统的响应速度、降低能耗、提高稳定性等。

本文将介绍一些常见的内核调教方案,帮助用户更好地利用内核资源。

调整内核参数调整内核参数是内核调教的基础工作。

可以通过修改`/etc/sysctl.conf`文件来设置内核参数。

下面是一些常见的内核参数设置:启用TCP/IP协议的SYN Cookie```shellnet.ipv4.tcp_syncookies = 1```启用SYN Cookie可以防止SYN Flood攻击,提高系统的安全性。

调整系统最大进程数量```shellkernel.pid_max = 65536```默认情况下,系统的最大进程数量是32768。

如果系统需要同时运行更多的进程,可以适当增加这个参数的值。

调整文件打开数限制```shellfs.file-max = 65536```默认情况下,系统的文件打开数限制是1024。

如果系统有较多的文件操作,可以适当增加这个参数的值。

调整TCP最大连接数```shellnet.ipv4.tcp_max_syn_backlog = 8192```默认情况下,系统的TCP最大连接数是128。

如果系统需要支持更多的TCP连接,可以适当增加这个参数的值。

调整内存页面回收参数```shellvm.swappiness = 10vm.vfs_cache_pressure = 100```这些参数用于调整内核对内存页面的回收策略,可以提高系统的内存利用率。

定制内核编译选项定制内核编译选项是一种更深入的内核调教方式,可以根据系统的具体需求提升系统的性能和稳定性。

去掉不需要的模块和驱动在编译内核时,可以去掉不需要的模块和驱动,减小内核的体积和加载时间。

可以通过编辑`make menuconfig`界面来选择需要的模块和驱动。

开启优化选项在编译内核时,可以开启一些优化选项,提高系统的性能。

TCP协议的性能优化与调优方法总结(一)

TCP协议的性能优化与调优方法总结介绍随着互联网的迅猛发展,TCP协议作为网络传输层的核心协议,扮演着重要的角色。

TCP协议的性能优化与调优对于提高网络传输效率、降低延迟和增强抗拥塞能力具有重要意义。

本文将探讨TCP协议的性能优化与调优方法,帮助读者更好地了解并应用于实际网络环境。

一、拥塞控制算法拥塞控制是TCP协议的一项重要功能,保证网络的稳定和公平性。

常见的拥塞控制算法包括慢启动、拥塞避免和快速重传等。

1. 慢启动:TCP连接建立时,发送端发送的数据量逐渐增加,以逐步探测网络的拥塞情况。

可以通过调整初始拥塞窗口大小和指数增长倍数来优化慢启动算法。

2. 拥塞避免:在慢启动阶段结束后,进入拥塞避免状态。

此时,TCP发送端发送的数据量按线性方式递增。

可以通过调整拥塞窗口大小和增长因子来优化拥塞避免算法。

3. 快速重传:当发送端接收到连续的重复ACK时,认为网络发生了丢包,立即进行重传。

通过优化重传次数和时间间隔,可以提高TCP 协议的性能。

二、流量控制技术流量控制是TCP协议的另一个重要功能,用于避免发送端的数据过载接收端。

常见的流量控制技术包括滑动窗口和延迟确认等。

1. 滑动窗口:滑动窗口是TCP协议用于控制发送端发送数据量的一种机制。

通过调整窗口大小和滑动窗口的起始位置,可以优化TCP 的流量控制效果。

2. 延迟确认:TCP协议中,接收端接收到数据后并不立即发送确认ACK,而是等待一定时间再发送。

通过调整延迟确认时间,可以减少网络中的ACK数量,提高网络传输效率。

三、拥塞避免方法拥塞避免是保证TCP协议性能的关键,以下是常见的拥塞避免方法:1. 拥塞窗口调整:当网络出现拥塞时,TCP发送端通过减小拥塞窗口来避免进一步的拥塞。

可以通过调整窗口减小的速率和阈值来优化拥塞窗口调整方法。

2. 动态重传超时参数调整:TCP协议中定义了重传超时时间,用于探测丢包并进行重传。

通过调整重传超时时间的算法和参数,可以提高TCP协议的传输效率和侦测丢包的准确性。

Linux修改TCP连接数

Linux修改TCP连接数Linux TCP 连接数修改Thanks /blog/826199一、文件数限制修改(1) vi /etc/security/limits.conf* soft nofile 10240* hard nofile 10240(2) vi /etc/pam.d/loginsession required /lib/security/pam_limits.so二、网络端口限制修改(1) vi /etc/rc.d/rc.local/sbin/modprobe ip_conntrack # 加载 ip_contrack 模块# /sbin/sysctl –p #使 /etc/sysctl.conf 的配置生效,根据实际情况来决定是否添加此命令[root@AS4U8 ~]# sysctl -a | grep "net.ipv4.ip"net.ipv4.ip_conntrack_max = 16384这表明将系统对最大跟踪的TCP连接数限制默认为16384。

请注意,此限制值要尽量小,以节省对内核内存的占用(2) vi /etc/sysctl.confnet.ipv4.ip_local_port_range = 1024 65000net.ipv4.ip_conntrack_max = 10240此限制值要尽量小,以节省对内核内存的占用。

详细解说:1、修改用户进程可打开文件数限制在Linux平台上,无论编写客户端程序还是服务端程序,在进行高并发TCP连接处理时,最高的并发数量都要受到系统对用户单一进程同时可打开文件数量的限制(这是因为系统为每个TCP连接都要创建一个socket句柄,每个socket句柄同时也是一个文件句柄)。

可使用ulimit命令查看系统允许当前用户进程打开的文件数限制:[speng@as4 ~]$ ulimit -n1024这表示当前用户的每个进程最多允许同时打开1024个文件,这1024个文件中还得除去每个进程必然打开的标准输入,标准输出,标准错误,服务器监听socket,进程间通讯的unix 域socket等文件,那么剩下的可用于客户端socket连接的文件数就只有大概1024-10=1014个左右。

linuxtcping参数

`linuxtcping` 是一个用于测试网络连接的工具,它的参数主要有以下几种:

* `-p`:指定要测试的目标端口。

你可以使用单个端口号,也可以使用端口范围,例如`linuxtcping -p 80` 将测试80端口的可达性,`linuxtcping -p 1-100` 将测试1到100端口范围内的可达性。

* `-t`:指定测试的超时时间。

默认情况下,linuxtcping将等待2秒钟来获取响应。

你可以使用-t参数来更改默认值,例如`linuxtcping -t 5` 将等待5秒钟来获取响应。

* `-c`:指定测试的次数。

默认情况下,linuxtcping将发送4个测试包。

你可以使用-c参数来更改默认值,例如`linuxtcping -c 10` 将发送10个测试包。

以上是linuxtcping 的主要参数,更多详细信息可以通过`linuxtcping --help` 获取。

Linux网络性能优化提高带宽和延迟的技巧

Linux网络性能优化提高带宽和延迟的技巧Linux是一种出色的操作系统,被广泛用于服务器环境中。

在网络通信中,性能优化对于提高带宽和降低延迟至关重要。

以下是一些在Linux系统上优化网络性能的技巧。

1. 使用适当的网络驱动程序网络驱动程序负责处理网络数据包的传输和接收。

选择适合硬件设备和操作系统的最新驱动程序,可以提高网络性能。

在Linux环境中,常见的网络驱动程序有e1000e、ixgbe和mlx4_en等。

2. 调整网络协议栈参数Linux的网络协议栈参数可以通过修改系统内核参数进行优化。

一些重要的参数包括TCP窗口大小、拥塞控制算法以及SYN队列大小等。

通过针对具体的网络需求进行调整,可以提高带宽和降低延迟。

3. 使用高效的网络服务软件选择高效的网络服务软件可以改善网络性能。

例如,Nginx作为一个轻量级的Web服务器,具有高性能和并发能力。

相比之下,Apache是一个功能较为丰富但相对较重的服务器软件。

4. 配置适当的网络缓冲区网络缓冲区的大小对于网络性能至关重要。

通过调整Linux系统中的网络缓冲区大小,可以提高网络吞吐量和降低延迟。

TCP栈和网络设备的缓冲区大小可以通过修改系统参数进行调整。

5. 启用网络流量控制和优先级Linux系统提供了一些机制来控制网络流量,以确保关键应用程序的优先级。

例如,使用Traffic Control来限制特定应用程序的带宽,或者通过Quality of Service(QoS)来为特定应用程序指定优先级。

6. 开启TCP快速打开握手TCP快速打开是一种优化技术,通过减少三次握手的次数来降低延迟。

在Linux系统上,可以通过修改内核参数来启用TCP快速打开握手功能。

这样可以加快连接的建立速度和降低延迟。

7. 使用断开连接的快速回收在网络通信中,及时回收断开的连接对于释放资源非常重要。

通过启用Linux系统的断开连接快速回收功能,可以在断开连接后立即释放相关资源,提高系统的处理能力和网络性能。

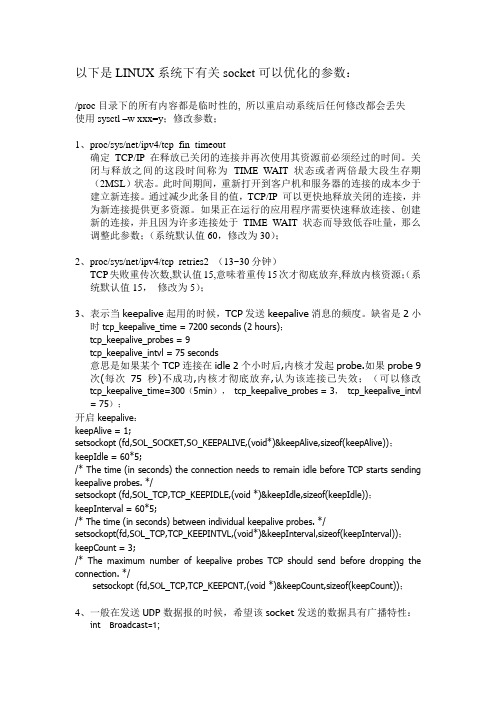

LINUX系统有关TCP的参数

以下是LINUX系统下有关socket可以优化的参数:/proc目录下的所有内容都是临时性的, 所以重启动系统后任何修改都会丢失使用sysctl –w xxx=y;修改参数;1、proc/sys/net/ipv4/tcp_fin_timeout确定TCP/IP 在释放已关闭的连接并再次使用其资源前必须经过的时间。

关闭与释放之间的这段时间称为TIME_WAIT 状态或者两倍最大段生存期(2MSL)状态。

此时间期间,重新打开到客户机和服务器的连接的成本少于建立新连接。

通过减少此条目的值,TCP/IP 可以更快地释放关闭的连接,并为新连接提供更多资源。

如果正在运行的应用程序需要快速释放连接、创建新的连接,并且因为许多连接处于TIME_WAIT 状态而导致低吞吐量,那么调整此参数;(系统默认值60,修改为30);2、proc/sys/net/ipv4/tcp_retries2 (13~30分钟)TCP失败重传次数,默认值15,意味着重传15次才彻底放弃,释放内核资源;(系统默认值15,修改为5);3、表示当keepalive起用的时候,TCP发送keepalive消息的频度。

缺省是2小时tcp_keepalive_time = 7200 seconds (2 hours);tcp_keepalive_probes = 9tcp_keepalive_intvl = 75 seconds意思是如果某个TCP连接在idle 2个小时后,内核才发起probe.如果probe 9次(每次75秒)不成功,内核才彻底放弃,认为该连接已失效;(可以修改tcp_keepalive_time=300(5min),tcp_keepalive_probes = 3,tcp_keepalive_intvl = 75);开启keepalive:keepAlive = 1;setsockopt (fd,SOL_SOCKET,SO_KEEPALIVE,(void*)&keepAlive,sizeof(keepAlive));keepIdle = 60*5;/* The time (in seconds) the connection needs to remain idle before TCP starts sending keepalive probes. */setsockopt (fd,SOL_TCP,TCP_KEEPIDLE,(void *)&keepIdle,sizeof(keepIdle));keepInterval = 60*5;/* The time (in seconds) between individual keepalive probes. */setsockopt(fd,SOL_TCP,TCP_KEEPINTVL,(void*)&keepInterval,sizeof(keepInterval));keepCount = 3;/* The maximum number of keepalive probes TCP should send before dropping the connection. */setsockopt (fd,SOL_TCP,TCP_KEEPCNT,(void *)&keepCount,sizeof(keepCount));4、一般在发送UDP数据报的时候,希望该socket发送的数据具有广播特性:int Broadcast=1;setsockopt(s,SOL_SOCKET,SO_BROADCAST,(const char*)&bBroadcast,sizeof(int)); 5、发送数据时候一般是系统缓冲区满以后才发送,现在设置为只要系统缓冲区有数据就立刻发送:int Nodelay=1;SetSockOpt(s,IPPROTO_TCP,TCP_NODELAY, &bNodelayt,sizeof(int));6、2个udp socket:单播的那个socket bind INADDR_ANY并且设置SO_BROADCAST选项为0,此时他只接受单播数据报广播的那个socket bind 255.255.255.255,并且设置SO_BROADCASE选项为1,此时他只接受UDP广播。

Linux高级网络性能调优使用TCPIP堆栈参数

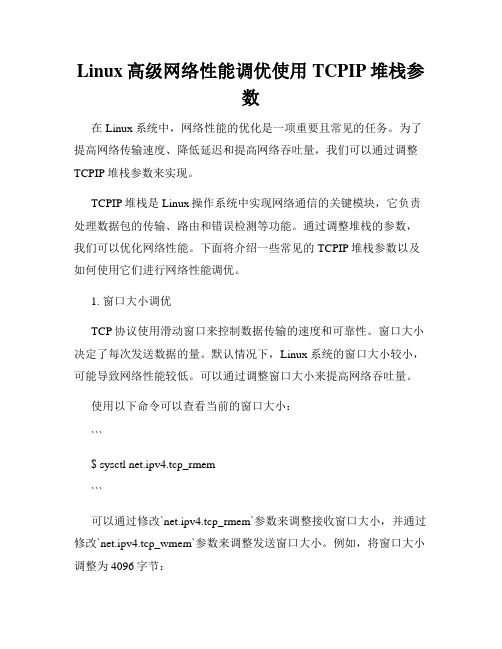

Linux高级网络性能调优使用TCPIP堆栈参数在Linux系统中,网络性能的优化是一项重要且常见的任务。

为了提高网络传输速度、降低延迟和提高网络吞吐量,我们可以通过调整TCPIP堆栈参数来实现。

TCPIP堆栈是Linux操作系统中实现网络通信的关键模块,它负责处理数据包的传输、路由和错误检测等功能。

通过调整堆栈的参数,我们可以优化网络性能。

下面将介绍一些常见的TCPIP堆栈参数以及如何使用它们进行网络性能调优。

1. 窗口大小调优TCP协议使用滑动窗口来控制数据传输的速度和可靠性。

窗口大小决定了每次发送数据的量。

默认情况下,Linux系统的窗口大小较小,可能导致网络性能较低。

可以通过调整窗口大小来提高网络吞吐量。

使用以下命令可以查看当前的窗口大小:```$ sysctl net.ipv4.tcp_rmem```可以通过修改`net.ipv4.tcp_rmem`参数来调整接收窗口大小,并通过修改`net.ipv4.tcp_wmem`参数来调整发送窗口大小。

例如,将窗口大小调整为4096字节:```$ sysctl -w net.ipv4.tcp_rmem="4096 87380 6291456"```2. 拥塞控制算法选择Linux系统支持多种拥塞控制算法,如TCP Reno、TCP Cubic等。

不同的算法在网络负载和延迟控制方面表现不同。

为了适应不同的网络环境,可以通过修改拥塞控制算法来优化网络性能。

可以使用以下命令将拥塞控制算法更改为TCP Cubic:```$ sysctl -w net.ipv4.tcp_congestion_control=cubic```3. SYN队列长度调优SYN队列用于存放等待建立TCP连接的请求。

默认情况下,Linux 系统的SYN队列长度较小,可能导致连接延迟和丢失。

可以通过调整SYN队列长度来提高网络性能。

使用以下命令可以查看当前的SYN队列长度:```$ sysctl net.ipv4.tcp_max_syn_backlog```可以通过修改`net.ipv4.tcp_max_syn_backlog`参数来调整SYN队列长度。

TCPIP及内核参数优化调优

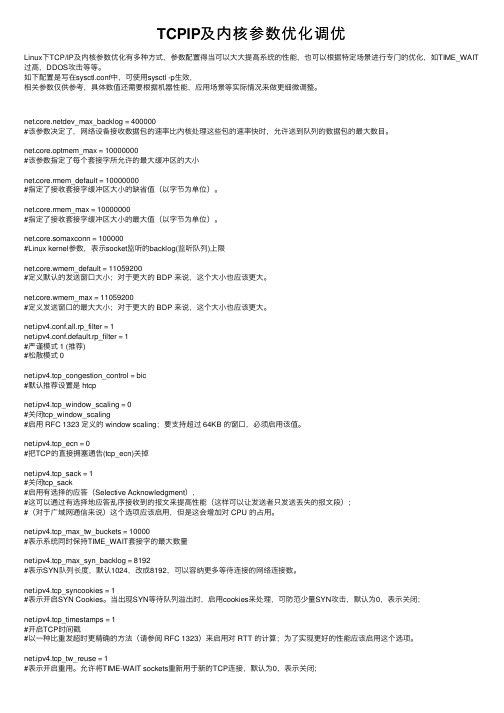

TCPIP及内核参数优化调优Linux下TCP/IP及内核参数优化有多种⽅式,参数配置得当可以⼤⼤提⾼系统的性能,也可以根据特定场景进⾏专门的优化,如TIME_WAIT 过⾼,DDOS攻击等等。

如下配置是写在sysctl.conf中,可使⽤sysctl -p⽣效,相关参数仅供参考,具体数值还需要根据机器性能,应⽤场景等实际情况来做更细微调整。

dev_max_backlog = 400000#该参数决定了,⽹络设备接收数据包的速率⽐内核处理这些包的速率快时,允许送到队列的数据包的最⼤数⽬。

net.core.optmem_max = 10000000#该参数指定了每个套接字所允许的最⼤缓冲区的⼤⼩net.core.rmem_default = 10000000#指定了接收套接字缓冲区⼤⼩的缺省值(以字节为单位)。

net.core.rmem_max = 10000000#指定了接收套接字缓冲区⼤⼩的最⼤值(以字节为单位)。

net.core.somaxconn = 100000#Linux kernel参数,表⽰socket监听的backlog(监听队列)上限net.core.wmem_default = 11059200#定义默认的发送窗⼝⼤⼩;对于更⼤的 BDP 来说,这个⼤⼩也应该更⼤。

net.core.wmem_max = 11059200#定义发送窗⼝的最⼤⼤⼩;对于更⼤的 BDP 来说,这个⼤⼩也应该更⼤。

net.ipv4.conf.all.rp_filter = 1net.ipv4.conf.default.rp_filter = 1#严谨模式 1 (推荐)#松散模式 0net.ipv4.tcp_congestion_control = bic#默认推荐设置是 htcpnet.ipv4.tcp_window_scaling = 0#关闭tcp_window_scaling#启⽤ RFC 1323 定义的 window scaling;要⽀持超过 64KB 的窗⼝,必须启⽤该值。

linux之TCP调优

linux之TCP调优# 原⽂原⽂地址# tcp握⼿客户端在等待服务器回复的 ACK 报⽂。

正常情况下,服务器会在⼏毫秒内返回 ACK,但如果客户端迟迟没有收到 ACK 客户端会重发SYN,重试的次数由 tcp_syn_retries 参数控制,默认是 6 次:net.ipv4.tcp_syn_retries = 6第 1 次重试发⽣在 1 秒钟后,接着会以翻倍的⽅式在第 2、4、8、16、32 秒共做 6 次重试,最后⼀次重试会等待 64 秒,如果仍然没有返回ACK,才会终⽌三次握⼿。

所以,总耗时是 1+2+4+8+16+32+64=127 秒,超过 2 分钟。

如果这是⼀台有明确任务的服务器,你可以根据⽹络的稳定性和⽬标服务器的繁忙程度修改重试次数,调整客户端的三次握⼿时间上限。

⽐如内⽹中通讯时,就可以适当调低重试次数,尽快把错误暴露给应⽤程序。

新连接建⽴失败的原因有很多,怎样获得由于队列已满⽽引发的失败次数呢?netstat -s 命令给出的统计结果中可以得到:netstat -s | grep "SYNs to LISTEN"这⾥给出的是队列溢出导致 SYN 被丢弃的个数。

注意这是⼀个累计值,如果数值在持续增加,则应该调⼤ SYN 半连接队列。

修改队列⼤⼩的⽅法,是设置 Linux 的 tcp_max_syn_backlog 参数:net.ipv4.tcp_max_syn_backlog = 1024这⾥给出的是队列溢出导致 SYN 被丢弃的个数。

注意这是⼀个累计值,如果数值在持续增加,则应该调⼤ SYN 半连接队列。

修改队列⼤⼩的⽅法,是设置 Linux 的 tcp_max_syn_backlog 参数:net.ipv4.tcp_max_syn_backlog = 1024如果 SYN 半连接队列已满,只能丢弃连接吗?并不是这样,开启 syncookies 功能就可以在不使⽤ SYN 队列的情况下成功建⽴连接。

如何进行TCP参数参数调优

如何进行TCP参数参数调优

为了提高TCP协议的性能和稳定性,我们可以进行一些调优:

TCP窗口大小:TCP窗口大小控制数据包在发送端和接收端之间的传

输速度,通过增加TCP窗口大小可以提高网络吞吐量。

可以使用

tcp_window_scaling参数来启用窗口缩放,并使用tcp_rmem和tcp_wmem

参数设置接收和发送缓冲区的大小。

延迟确认:TCP协议默认使用延迟确认,即等待一段时间再发送确认

数据包,以减少网络流量。

可以使用tcp_sack参数来启用选择性确认,

并使用tcp_ack_delay参数调整延迟确认时间,以提高TCP协议的响应速度。

慢启动:TCP协议使用慢启动算法来控制拥塞窗口大小,以避免网络

拥塞。

可以使用tcp_slow_start_after_idle参数来调整慢启动算法的启

动时间,并使用tcp_congestion_control参数选择合适的拥塞控制算法。

超时重传:TCP协议使用超时重传机制来处理丢失的数据包,以保证

数据可靠性。

可以使用tcp_retries1和tcp_retries2参数来调整重传次

数和超时时间,以提高TCP协议的可靠性。

MTU大小:MTU是网络中最大传输单元的缩写,控制TCP数据包的大小。

可以使用tcp_mtu_probing参数启用MTU探测,并使用tcp_mss参数

设置最大数据包大小,以提高网络传输效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux之TCPIP内核参数优化

/proc/sys/net目录

所有的TCP/IP参数都位于/proc/sys/net目录下(请注意,对/proc/sys/net目录下内容的修改都是临时的,任何修改在系统重启后都会丢失),例如下面这些重要的参数:

参数(路径+文件)

描述

默认值

优化值

/proc/sys/net/core/rmem_default

默认的TCP数据接收窗口大小(字节)。

229376

256960

/proc/sys/net/core/rmem_max

最大的TCP数据接收窗口(字节)。

131071

513920

/proc/sys/net/core/wmem_default

默认的TCP数据发送窗口大小(字节)。

229376

256960

/proc/sys/net/core/wmem_max

最大的TCP数据发送窗口(字节)。

131071

513920

/proc/sys/net/core/netdev_max_backlog

在每个网络接口接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的最大数目。

1000

2000

/proc/sys/net/core/somaxconn

定义了系统中每一个端口最大的监听队列的长度,这是个全局的参数。

128

2048

/proc/sys/net/core/optmem_max

表示每个套接字所允许的最大缓冲区的大小。

20480

81920

/proc/sys/net/ipv4/tcp_mem

确定TCP栈应该如何反映内存使用,每个值的单位都是内存页(通常是4KB)。

第一个值是内存使用的下限;第二个值是内存压力模式开始对缓冲区使用应用压力的上限;第三个值是内存使用的上限。

在这个层次上可以将报文丢弃,从而减少对内存的使用。

对于较大的BDP 可以增大这些值(注意,其单位是内存页而不是字节)。

94011 125351 188022

131072 262144 524288

/proc/sys/net/ipv4/tcp_rmem

为自动调优定义socket使用的内存。

第一个值是为socket接收缓冲区分配的最少字节数;第二个值是默认值(该值会被rmem_default覆盖),缓冲区在系统负载不重的情况下可以增长到这个值;第三个值是接收缓冲区空间的最大字节数(该值会被rmem_max覆盖)。

4096 87380 4011232

8760 256960 4088000

/proc/sys/net/ipv4/tcp_wmem

为自动调优定义socket使用的内存。

第一个值是为socket发送缓冲区分配的最少字节数;第二个值是默认值(该值会被wmem_default覆盖),缓冲区在系统负载不重的情况下可以增长到这个值;第三个值是发送缓冲区空间的最大字节数(该值会被wmem_max覆盖)。

4096 16384 4011232

8760 256960 4088000

/proc/sys/net/ipv4/tcp_keepalive_time

TCP发送keepalive探测消息的间隔时间(秒),用于确认TCP连接是否有效。

7200

1800

/proc/sys/net/ipv4/tcp_keepalive_intvl

探测消息未获得响应时,重发该消息的间隔时间(秒)。

75

30

/proc/sys/net/ipv4/tcp_keepalive_probes

在认定TCP连接失效之前,最多发送多少个keepalive探测消息。

9

3

/proc/sys/net/ipv4/tcp_sack

启用有选择的应答(1表示启用),通过有选择地应答乱序接收到的报文来提高性能,让发送者只发送丢失的报文段,(对于广域网通信来说)这个选项应该启用,但是会增加对CPU 的占用。

1

/proc/sys/net/ipv4/tcp_fack

启用转发应答,可以进行有选择应答(SACK)从而减少拥塞情况的发生,这个选项也应该启用。

1

1

/proc/sys/net/ipv4/tcp_timestamps

TCP时间戳(会在TCP包头增加12个字节),以一种比重发超时更精确的方法(参考RFC 1323)来启用对RTT 的计算,为实现更好的性能应该启用这个选项。

1

1

/proc/sys/net/ipv4/tcp_window_scaling

启用RFC 1323定义的window scaling,要支持超过64KB的TCP窗口,必须启用该值(1

表示启用),TCP窗口最大至1GB,TCP连接双方都启用时才生效。

1

1

/proc/sys/net/ipv4/tcp_syncookies

表示是否打开TCP同步标签(syncookie),内核必须打开了CONFIG_SYN_COOKIES项进行编译,同步标签可以防止一个套接字在有过多试图连接到达时引起过载。

1

1

/proc/sys/net/ipv4/tcp_tw_reuse

表示是否允许将处于TIME-WAIT状态的socket(TIME-WAIT的端口)用于新的TCP连接。

1

/proc/sys/net/ipv4/tcp_tw_recycle

能够更快地回收TIME-WAIT套接字。

1

/proc/sys/net/ipv4/tcp_fin_timeout

对于本端断开的socket连接,TCP保持在FIN-WAIT-2状态的时间(秒)。

对方可能会断开连接或一直不结束连接或不可预料的进程死亡。

60

30

/proc/sys/net/ipv4/ip_local_port_range

表示TCP/UDP协议允许使用的本地端口号

32768 61000

1024 65000

/proc/sys/net/ipv4/tcp_max_syn_backlog

对于还未获得对方确认的连接请求,可保存在队列中的最大数目。

如果服务器经常出现过载,可以尝试增加这个数字。

2048

2048

/proc/sys/net/ipv4/tcp_low_latency

允许TCP/IP栈适应在高吞吐量情况下低延时的情况,这个选项应该禁用。

/proc/sys/net/ipv4/tcp_westwood

启用发送者端的拥塞控制算法,它可以维护对吞吐量的评估,并试图对带宽的整体利用情况进行优化,对于WAN 通信来说应该启用这个选项。

/proc/sys/net/ipv4/tcp_bic

为快速长距离网络启用Binary Increase Congestion,这样可以更好地利用以GB速度进行操作的链接,对于WAN通信应该启用这个选项。

1

/etc/文件

/etc/是一个允许你改变正在运行中的Linux系统的接口。

它包含一些TCP/IP堆栈和虚拟内存系统的高级选项,可用来控制Linux网络配置,由于/proc/sys/net目录内容的临时性,建议把TCPIP参数的修改添加到/etc/文件, 然后保存文件,使用命令“/sbin/sysctl –p”使之立即生效。

具体修改方案参照上文:

= 256960

= 513920

= 256960

= 513920

= 2000

= 2048

= 81920

= 131072 262144 524288

= 8760 256960 4088000 = 8760 256960 4088000 = 1800

= 30

= 3

= 1

= 1

= 1

= 1

= 1

= 1

= 1

= 30

= 1024 65000

= 2048。