国科大信息检索作业

中国科学院大学计算机领域信息检索期末考试答案

域信息检索与利用实用技巧任课老师:李玲试题专用纸1、简答题:您在学习和研究过程中遇到下列问题时,常用哪些方法来解决?(10题,3分/小题,共30分)(1)查找期刊时,您常用的方法?答: 中文期刊一般用:中国知网、万方数据库、维普数据库等;外文期刊一般用:ACM、IEEE、Elsevier ScienceDirect、SpringerLink、ScienceOnline 、Taylor & Francis Online Journals 、Cambridge Journal等;可通过国科大图书馆进入上述网站首页,输入所需检索的期刊信息,如期刊名称、作者、发表年份等信息进行查询。

(2)查找中国科学院学位论文时,您常用的方法?答: 进入“中国科学院大学”首页→点击右下方“图书馆”→点击进入“中科院学位论文数据库”→进入检索界面,输入所需检索的论文信息,如:论文名称、作者、指导老师等。

(3)查找各国专利以及专利的被引用情况时, 您常用的方法?答:进入国家知识产权局官网“”,输入所需检索专利的发明名称、申请号、申请人(三者至少必填其一)进行检索,查看专利被引用情况。

(4)查找SCI期刊的影响因子,您常用的方法?答:通过国科大图书馆点击“ISI-SCIE”进入web of science平台查询界面,输入期刊的关键词、作者等信息,可通过“AND”进行多个关键词组合以缩小查询范围。

(5)查找标准文献时,有哪些注意事项?答:合理选择标准数据库(如中文期刊会议类检索工具选用CNKI、维普、万方等,查询专利选用国家知识产权局等数据库);注意文献的发表时间(如利用CNKI科技类期刊数据库查询只能查询1994年之后发表的文献,维普中文科技期刊库可查询1984年之后发表的文献)使用多个精确的关键字组合,以减小检索范围。

(6)文献管理时,您常用的方法?答:使用EndNote文献管理工具,进行分类管理方便后期查询。

域信息检索与利用实用技巧任课老师:李玲试题专用纸(7)获取无法直接下载的文献全文时,您常用的方法?答:可通过文献传递,向有权限的人求助;或通过查询Researchgate,付费网站获取;也可以邮件联系文献作者求助。

信息检索综合作业课件

信息检索综合作业一、实习内容利用所学的信息检索知识和检索方法,根据自己选择的课题,综合运用各种检索工具,从多方面搜集相关资料,完成该课题的综合检索报告。

二、实习要求1、检索课题:自拟。

根据自己专业情况或自己的兴趣选择检索题目。

2、检索报告(1)格式如下:①选取3个数据库,包括两个2个中文数据库、1个外文数据库检索与所选主题相关的文献。

尽量做到查全、查准两方面平衡。

②每一个库根据检索结果的不同,制定不同的检索策略,要选取适当的关键词,进行组配并构建检索式。

详细描述检索时的约束条件。

例如:检索过程及结果(1)中文信息资源①CNKI中国知网——中国期刊全文数据库a.检索式:篇名=(网络购物+网上购物+网购)*关键词=风险*时间=2004-2013b.检索结果:得到79条记录。

下面是其中的3条。

[1]波骆尔.中蒙消费者网上购物感知风险研究[J].经营管理者,2012(8):166.[2]陈璐.基于我国市场环境下网络购物风险防范对策研究[J].江苏商论,2011(3):47-49.[3]董大海,李广辉,杨毅.消费者网上购物感知风险构面研究[J].管理学报,2005(1):55-60.②CNKI中国知网——中国博硕士学位论文全文数据库a.检索式:题名=(网络购物+网上购物+网购)*摘要=风险*学位年度=2004-2013.b.检索结果:得到167条记录。

下面是其中的3条。

[1]刘佳艾. 信息不对称下B2C消费者信任影响因素研究[D]. 北京:北京化工大学,2012.[2]姚秀丽. 中国消费者网上购物风险及消费行为模型研究[D]. 北京:北京邮电大学,2010.[3]张科. 基于TAM理论的C2C网络消费信任研究[D]. 南京:南京大学,2007.③Springer LINKa.检索式:TI= (online shopping + online purchasing ) *any word=risk* Publication Date =2004-2013b.检索结果:得到22条记录。

中国科学技术大学--信息检索作业答案(电子版)

中国科学技术大学上海工程硕士第八期《信息检索》考试试题姓名:陶亮学号:SG15010018成绩:第一章息检索及其主要功用3、你通常利用什么样的文献传播渠道来获取有关文献信息?答:文献信息的传播渠道是多种多样的,归结起来有以下三种基本形式:(1)人际传播渠道:是通过人们之间的直接交流,如相互交谈、相互借还或传阅资料、交换意见、参加会议、听课、听讲座等。

(2)组织传播渠道:是通过一定的形式无偿或部分有偿地向社会公众提供文献资料的中介交流形式,如图书馆、档案馆、各类文献情报中心、学校、美术馆乃至教堂等。

(3)大众传播渠道:借助于各种传统及现代化手段来传播的一种方式。

如通过订阅杂志、购买图书、观看影视作品或网上浏览下载等形式。

以上三种形式各有所长,相互补充,长期共存,各自发挥着独特的功能。

在我的日常生活中,上述三种文献传播渠道都有,但人际传播和大众传播是最多的传播渠道。

4、对于信息检索的五大功用,你最有体会的是什么?最不了解的是什么?你认为这五大功用以外还可以总结出来有关信息检索的其他功用吗?(请简介)答:信息检索五大功用分别为:(1)开阔视野,正确决策:能够及时、系统地了解前人的工作经验与成果,掌握事物最新动态及发展趋势。

适时做出正确决策,使所开展的工作取得最快、最有效的进展。

(2)提高功效,事半功倍:能节省人们对有用信息进行搜集利用的时间及精力,提高工作效益,做到事半功倍。

同时还能培养人们的自学能力、科学研究及鉴赏能力。

(3)学习借鉴,推动创新:有利于及时把握各种信息,促进科技发明和发现不断涌现,同时对人们开展终身学习不断提升综合素质、创作出更多、更优秀的成果及文献也具有强大的支持和推动作用。

(4)规避风险,维护权益:可以避免重复劳动、少走弯路、免去低水平复制所带来的损失,使各种科研、经营、生产等活动实现投入少、收效高,还可使人们规避风险,利用知识产权保护法等法律规范,维护自身或单位(国家)的正当权益。

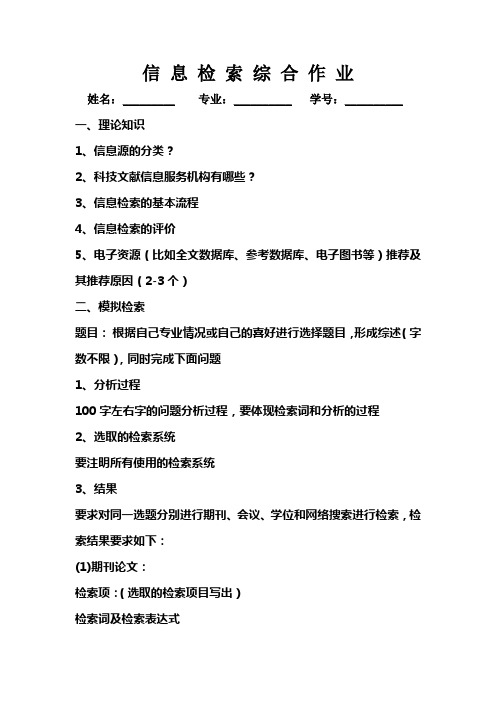

信息检索 综合作业

信息检索综合作业姓名:_________ 专业:__________ 学号:__________一、理论知识1、信息源的分类?2、科技文献信息服务机构有哪些?3、信息检索的基本流程4、信息检索的评价5、电子资源(比如全文数据库、参考数据库、电子图书等)推荐及其推荐原因(2-3个)二、模拟检索题目:根据自己专业情况或自己的喜好进行选择题目,形成综述(字数不限),同时完成下面问题1、分析过程100字左右字的问题分析过程,要体现检索词和分析的过程2、选取的检索系统要注明所有使用的检索系统3、结果要求对同一选题分别进行期刊、会议、学位和网络搜索进行检索,检索结果要求如下:(1)期刊论文:检索项:(选取的检索项目写出)检索词及检索表达式检索结果:(总数量要少于300,不能出现“零”结果,选取一个结果进行描述给出全部外部特征包括作者、作者单位、出处等)(2)会议论文(要求同上)(3)学位论文(要求同上)(4)搜索引擎利用搜索引擎的高级检索的项目及搜索的词,用两种或两种以上的组合方式进行搜索并将搜索的数量写出,同样不能出现“零”结果。

结果的记载要求是要将组合方式写出,搜索的结果数量写出。

三、思考题1.信息检索的核心问题是什么,简要说明理由?2.信息检索课的心得与建议注意:1、不可抄袭,如果两人或多人的作业内容相同视为抄袭,抄袭的作业视为无效,成绩取消。

2、作业上交邮箱xinxijiansuo1@(周三上课)xinxijiansuo6@(周六上课)3、回答说明问题即可,可不必局限字数4、时间期限:2011年5月7号之前5、联系方式:图书馆206 8887057最后,希望同学们会有所收获,欢迎多多提意见,希望我们可以一起成长!谢谢!。

信息检索作业范本

信息检索作业范本文献检索综合检索报告07 级 * * 专业 * * 班学号 ***********姓名 * * *题目:节能制冷技术及制冷设备的研究成果与发展趋势检索词:制冷(Refrigeration) 节能(Energy conservation) 技术(Technology) 设备(Equipment)发展趋势(Developing trend)检索过程:以中文检索期刊维普中文科技期刊为例,第一步现在搜索栏内输入关键词制冷,搜到了与制冷相关的文章10200篇文章,但与题目的相关性有的文章很差。

因此采用逻辑联合的方式进行搜索,再搜索栏内输入关键词制冷and技术,然后进行检索,得到了295篇文章,进一步利用检索词之间的关系进行逻辑结合,输入关键词制冷and设备,然后进行搜索,搜到652篇文章!接着变换搜索方式在搜索栏内输入文摘节能and制冷and设备,然后进行搜索得到了201篇文章。

接着还可以变换搜索方式一题目名的方式进行搜索制冷and技术and设备,然后进行搜索得到搜索结果19。

然后变换搜索数据库,进入CNKI网络数据库,进行不同的逻辑组合进行搜索,在搜索栏内输入关键词节能and制冷and技术,然后点搜索搜索到了316篇相关文章,为了扩大搜索范围和结果,输入关键词节能and制冷and技术and发展and趋势,搜索到了1文章,由于检索到的文章少,进一步进行检索,输入检索词节能and制冷and设备and发展,搜索到了8篇文章。

进入外文搜索网站EBSCOhost Web,然后进行逻辑搜索,这些行为同样是在时间2000到2008的范围内进行搜索的,输入检索词Refrigeration and Technology,搜多到了36篇文章。

感觉搜索的结果还是不很理想,于是在中国科技在线和百度网站上进行搜索,已得到更好的结果.现将具体检索结果介绍如下。

检索结果:(1)数据库:维普中文科技期刊检索年限:2000-2008检索词:制冷检索过程:进入数据库维普中文科技期刊,点搜索中的高级搜索,输入检索词,输入限制的年限,点击搜索进行搜索。

信息检索与利用作业模板

信息检索与利用作业模板课程报告课程名称:系别:班级:指导教师:学生姓名:时间:____________________ 二〇一二年月日实验1:各种类型中外文文献检索(6学时)目的:1.学会电子图书检索。

2.学会中文学位论文检索。

3.学会中文会议论文检索。

4.学会中文期刊论文检索。

5.学会国内重要专业人士、重要研究机构、重要文献、重要期刊等信息检索。

6.学会标准文献检索。

7. 学会科技成果检索。

8. 学会外文期刊论文检索。

内容:1.自选检索课题。

2.分析检索课题,确定检索标识,编写提问式。

3.利用超星电子图书(免费阅览室) 、中国知网数字出版平台、国家科技图书文献中心等相关数据库。

4. 在相关检索提问框中输入提问式实施检索,筛选命中文献,选择检索结果输出格式并输出结果。

如有必要可反复修改检索提问式优化检索结果。

5.记录检索过程,完成检索报告并提交。

要求:1.电子图书选择超星电子图书(免费阅览室)或其他电子书全文数据库中的1种数据库进行电子图书检索:数据库名称____________________________检索策略(表达式)______________________命中文献数____________选取其中1条文献题录书名:作者姓名:出版时间:总页数:章(或节)数:参考文献数:2.中文学位论文选择中国知网数字出版平台——中国优秀硕士学位论文全文数据库、中国博士学位论文全文数据库、国家科技图书文献中心——中文学位论文等数据库中的1种数据库进行学位论文检索:数据库名称______________________________________ 检索年限_______________________________________ 检索策略(表达式)________________________________ 命中文献数____________ 选取其中1条文献题录论文题目:作者姓名:导师姓名:授予学位级别:作者专业名称:学位授予单位:授予学位时间:论文总页数:3.会议论文选择中国知网数字出版平台——中国重要会议论文全文数据库、国家科技图书文献中心——中文会议论文等数据库中的1种数据库进行会议论文检索:数据库名称______________________________________ 检索年限_______________________________________ 检索策略(表达式)________________________________ 命中文献数____________ 选取其中1条文献题录论文题目:作者姓名:第一作者单位:会议名称:会议地点:主办单位:出处(会议录名称、出版时间、论文在会议录中的页码范围):4.中文期刊论文选择中国知网数字出版平台——中国学术期刊网络出版总库、国家科技图书文献中心——中文期刊等数据库中的1种数据库进行中文电子期刊检索:数据库名称______________________________________ 检索年限_______________________________________ 检索策略(表达式)________________________________ 命中文献数____________ 选取其中1条文献题录论文题目:作者姓名:第一作者单位:出处(出版物名称、年、卷、期、页码范围):5.国内重要专业人士、重要研究机构、重要文献、重要期刊等信息。

关于信息检索的作业

关于信息检索的作业一、请给出下列文献的《中图法》分类号:1、方言:H172、初等代数:O1223、《红楼梦》研究与评论:I207.4114、PowerPoint基础:TP391.415、网络安全:TP393.086、跆拳道:G886.9二、编写检索逻辑式1、《工业工程与管理》杂志2008年发表有关工程材料试验(TB302)的论文K=工程材料试验*J=工业工程与管理*Y=2008或者C=TB302*J=工业工程与管理*Y=20082、查询2008年以后除陈力外的作者发表的有关“政府人才服务机构”的论文K=政府人才服务机构*(A=!陈力)*Y=2008或者:K=政府人才服务机构-(A=陈力)*Y=20083、北京大学李明发表的关于《红楼梦》研究与评论(I207.411)的论文S=北京大学*T=《红楼梦》研究与评论*A=李明4、文思敏发表的图书馆学(G250)及图书馆管理(G251)类的论文。

A=文思敏*(C=G250+G251)5、若AF代表机构,AU代表作者,已知王强是以前是东北师大的老师,现在在我校工作,要检索他除幼儿教育外的全部文章AU=王强*(AF=东北师范大学+你们学校名称)-(K=幼儿教育)6、找除软件和硬件以外的、计算机方面的文章。

K=计算机-(K=软件+硬件)7、黄玉姣、屠美如发表的有关微生物燃料电池方面的论文A=(黄玉娇+屠美如)*(M=微生物燃料+燃料电池)说明:A=作者,C=分类号,J=期刊,K=关键词,M=题目名或者关键词,S=机构,Y=年代。

在不同的检索系统中检索式可能不相同。

并且在以上逻辑检索式中,某些字段可能要加上英文输入法状态下的引号才有效。

三、检索中国大百科全书全书在线1、用“组合检索查询”检索“丝绸之路”的详细注释(复制条目标题和释文第一段)打开http://202.112.118.40:918/web/index.htm,点击组合检索。

在中文名称栏输入:丝绸之路,在右边的下拉框选择“相等”,英文名称和正文缺省。

信息检索作业 (3)

信息检索作业1. 简介信息检索(Information Retrieval)指的是通过计算机系统从大量的信息中找到用户所需的有效信息的过程。

本篇文档将介绍信息检索的基本概念、技术和应用,并探讨信息检索系统的优化策略。

2. 信息检索的基本概念2.1 信息检索定义信息检索是指从大规模的、非结构化的信息资源中寻找用户所需信息的过程。

不同于数据库查询,信息检索更关注的是如何从大规模、动态的信息资源中快速准确地提取出用户需要的信息。

2.2 信息检索过程信息检索过程主要包括以下几个步骤:1.收集信息源:从互联网、数据库、文件等资源中收集大量的信息。

2.预处理:对收集到的信息进行清洗、分词、去除停用词等操作,将原始文本转化为可以处理的形式。

3.索引构建:根据预处理后的文本,构建倒排索引(Inverted Index),用于快速定位文档。

4.查询处理:根据用户的查询词,通过倒排索引定位相关的文档。

5.评价与排序:根据查询与文档的匹配程度,计算出相关性分数,并对结果进行排序。

6.结果展示:将获取的信息以用户易读的方式展示给用户。

2.3 常见的信息检索模型•布尔模型:把检索任务看作是布尔逻辑运算,通过组合关键词的逻辑运算进行检索。

•向量空间模型:将查询和文档表示为向量,在向量空间中计算相似度并排序结果。

•概率检索模型:基于概率论统计的模型,通过计算查询与文档的相关性得分进行排序。

•语言模型:将查询和文档都看作是语言模型,通过计算两者的相似度进行排序。

3. 信息检索的技术3.1 分词技术分词是信息检索的基础步骤,通过将文本切分成一个一个的词语,构建倒排索引。

常见的分词技术有:基于字典的分词、最大匹配法、最少切分法等。

3.2 倒排索引倒排索引是一种将词语映射到文档的数据结构,用于快速定位包含某个词语的文档。

倒排索引一般由词典和倒排列表组成,可以通过词典快速查找到包含某个词语的文档列表。

3.3 相似度计算相似度计算是信息检索中评价文档与查询之间相关性的指标,常见的相似度计算方法有:余弦相似度、BM25等。

国科大信息检索作业

国科大2013年秋季《现代信息检索》第一次作业(第一章到第五章)以下每题10分,共计100分。

1、习题1-4a.时间复杂度O(x+y)。

因为倒排记录表记录的文档号是按照从小到大排列的,在扫描Brutus对应的倒排表的时指针指向文档号为x,扫描Caesar对应的倒排记录表的指针对应的文档号为y,如果x<y那么x在结果集中,brutus指针后移,如果x=y,x不在结果集中,两个指针都后移,如果x>y,caesar指针后移。

b.时间复杂度是O(N),N是全部的文档数。

因为结果集的大小取决于文档数N,而不是倒排记录表的长度。

2、习题1-7对于原始的查询,按照倒排记录表的长度从小到大查询会节省查询复杂度(tangerine OR trees) = O(46653+316812)=O(363465)(marmalade OR skies) = O(107913+271658) = O(379571)(kaleidoscope OR eyes) = O(46653+87009) = O(300321)即顺序为:(kaleidoscope OR eyes) AND (tangerine OR trees)AND(marmalade OR skies)3、习题1-10UNION(p1,p2)answer ←{ }while p1!=NIL and p2!=NILdo if docID(p1)=docID(p2)then ADD(answer,docID(p1))p1<- next(p1)p2<-next(p2)else if docID(p1)<docID(p2)then ADD(answer,docID(p1))p1<- next(p1)else ADD(answer,docID(p2))p2<-next(p2)while p1!=NILdo ADD(answer,docID(p1))p1<- next(p1)while p2!=NILdo ADD(answer,docID(p2))p2<- next(p2)return(answer)4、习题2-7a.由24跳到75这一次跳转b.比较为(3,3) (5,5) (9,89) (15,89) (24,89) (75,89)(75,89) (92,89) (75,89)(92,89) (81,89) (84,89) (89,89) (92,95) (115,95)(96,95) (96,97) (97,97) (100,99) (100,100) (115,101)总共21次比较c.比较为(3,3) (5,5) (9,89) (15,89) (24,89) (39,89) (60,89) (68,89) (75,89) (81,89) (84,89) (89,89) (92,95) (96,95) (96,97)(97,97) (100,99) (100,101) (115,101) 总共19次比较56、习题3-116*6*6*6=12967、习题4-1倒排索引的构建需要两步:1.扫描文档,建立词项文档对。

计算机信息检索课作业

计算机信息检索课作业:

1.选择本人的导师(或本专业的教师),对其科研成果(包括论文和项目)进行汇总检索并作出分析评价

提示:从网络、数据库等多种途径选取有关资料,利用ELSCLESI以及中文科技论文引文系统等评价工具。

要求:写出从哪些途径检索了资料(来源及选择的过程),检索过程(检索策略的制定和调整)、遇到的问题等,并从成果分析其主要研究方向、分析代表性成果。

2.说出与自己专业相关度较高的数据库,并选择你准备做或正在做的科研项目,查找课题相关的参考资料,并写出一个文献综述。

提示:选择正确的数据库,选择好的检索策略。

写出选择和调整数据库及检索策略的过程。

要求:检索的资料要对相关的中外文文献有较全面的把握,文献综述不是文献摘录

作业完成后可发到邮箱,一般收到作业会有回复,如没收到回复请电话询问一下,避免网络问题没有收到。

有问题也可以邮件或电话咨询。

电话:-131张老师,或-122赵老师。

考试前必须完成作业。

信息检索综合作业

信息检索综合作业————————————————————————————————作者: ————————————————————————————————日期:信息检索综合作业一、实习内容ﻩ利用所学的信息检索知识和检索方法,根据自己选择的课题,综合运用各种检索工具,从多方面搜集相关资料,完成该课题的综合检索报告。

二、实习要求1、检索课题:自拟。

根据自己专业情况或自己的兴趣选择检索题目。

2、检索报告(1)格式如下:①选取3个数据库,包括两个2个中文数据库、1个外文数据库检索与所选主题相关的文献。

尽量做到查全、查准两方面平衡。

②每一个库根据检索结果的不同,制定不同的检索策略,要选取适当的关键词,进行组配并构建检索式。

详细描述检索时的约束条件。

例如:检索条件:主题:专利知识产权战略年限:2008-2013匹配方式:精确。

等等检索式:(专利 or知识产权)and 战略;每一个库都要写明检索策略和检索式。

③原则上每一个库的检索结果不能少于20多于300。

④从检索结果中选取3篇相关文献,用著录格式表达,并附上摘要信息。

可参考《信息资源检索与利用》(第2版)一书P311-332中信息资源检索综合示例。

(2)提交打印稿,排版整洁。

打印稿交给班长,手机:截止日期2014/12/15,过期不收。

3、信息检索综合作业占本课程最终考核成绩的40%,请大家独立、认真完成。

三、评分标准1、检索课题的难度系数值(10分)2、选择和使用检索工具的情况:(1)选择检索工具的种类(10分)(2)检索词、检索表达式的构建(10分)(2)所查文献条目的数量(10分)(3)所查文献的出版类型(10分)(4)所查文献的语种(10分)(5)外文文摘的翻译情况(翻译一篇)(10分)(6)所查文献与课题的相关度情况(10分)3、小结情况(10分)4、检索报告的格式(10分)关于计算机网络安全漏洞的检测和防范的检索报告软件工程ZB122 韩贝202120826一、分析研究课题随着计算机技术的迅猛发展,计算机网络向世界各个角落延伸,人们通过网络享受着巨大便利。

《科技信息检索》作业

《科技信息检索》考核题(2015年上学期)一、填空题(20分)1. 载体记录和(媒体传播)是信息的存在形式。

它们构成信息的基本属性2. 知识、载体和(记录)构成了文献的三要素3. 按信息的(加工层次),信息可分为一次信息,二次信息,三次信息和零次信息。

4. 以感光材料为载体,利用光学技术将文字、图形、影像等信息符号按比例缩小的文献形式是(缩微型)5. 图书按功用性质可以分为:阅读性图书和(工具书)两大类6.ISBN由(10)位数字分成4段组成,它是识别图书的唯一标识。

7. 期刊是指有固定名称、(版式)和连续的编号,定期或不定期长期出版的连续性出版物8. ISSN是(国际标准刊号),由8位数字分两段组成,如1000-01359. 目前全世界每年发表科技报告数量庞大,其中绝大多数产自发达国家,较著名的有美国政府的四大报告是( PB、AD、NASA、DOE)10. 美国国家技术信息服务处,简称(NTIS),是美国政府科技报告的出版机构。

11. 专利说明书是指专利申请者为了获得某项发明的(专利权),在申请专利时必须向专利局呈交的有关该发明的详细技术说明,专利说明书有固定的独特格式。

12. 按专利权的种类,专利可分为:发明专利、(实用新型专利)和外观设计。

13. 专利号由国别代码(2位字母)+顺序号(7位数字)+法律状态码(1位字母)组成。

SE是(瑞典)国家的国别代码。

14. 标准按使用范围划分:国际标准、区域标准、国家标准、行业标准及(企业标准)等15. 美国国家标准的国标代码是(ANSI )。

16. 检索文档:也就是我们通常说的(数据库),主要由"文档、记录和字段" 组成。

17. 目录(catalog)是对一批相关文献(外部特征)的揭示和报道,是有序的文献清单(list)。

目录通常以一个完整的出版物为著录的最小单位。

18. 索引是对一组信息集合的有系统的指引,一般只起指引特定信内容及其(存储地址)的作用。

信息检索作业.doc

1.利用“独秀学术搜索”查找下列问题答案(要求列出查询步棸及资料来源)(1)信息源的类型划分及含义划分:按信息源产生的时间顺序来划分先导信息源、即时信息源、滞后信息源。

先导信息源是指产生于社会活动之前的信息源。

如天气预报。

即时信息源是指在社会活动中产生的,如工作纪录,实验报告等。

滞后信息源如报刊。

按信息源传播形式来划分口传信息源、文献信息源和汉密哈顿实物信息源。

口传信息源存在于人脑的记忆中,人们通过交流、讨论、报告会的方式交流传播实物信息源存在于自然界和人工制品中,人们可通过实践、实验、采集、参观等方式交流传播文献信息源存在于文献中,人们可以通过阅读、视听学习等方式交流传播。

(包括印刷型信息源和电子信息源等)按信息的加工和集约程度分一次信息源:直接来自作者的原创的,没有经过任何加工处理的信息二次信息源:感知信息源从一次信息源中加工处理提取的信息三次信息源:再生信息源或工具书(百科全书,辞典,手册,年鉴)四次信息源:图书馆、档案馆、数据库、博物馆。

联合国教科文组织1976年出版的《文献术语》一书将信息源定义为:个人为满足其信息需要而获得信息的来源,称信息源。

一切产生、生产、存贮、加工、传播信息的源泉都可以看作是信息源。

含义:信息源(information sources)一般指信息的来源地(包括信息资源生产地和发生地)。

信息源内涵丰富,它不仅包括各种信息载体,也包括各种信息机构;不仅包括传统印刷型文献资料,也包括现代电子图书报刊;不仅包括各种信息储存和信息传递机构,也包括各种信息生产机构。

(2)布尔逻辑检索布尔逻辑检索是当今最成熟的检索理论之一,也是构造检索表达式最基本、最简单的匹配模式。

布尔逻辑检索是通过布尔逻辑算符来实现的,这些运算符能把一些具有简单概念的检索词(或检索项)组配成为一个具有复杂概念的检索式,用以表达用户的检索要求。

常用的布尔逻辑算符有三种,分别是逻辑或“oR”、逻辑与“AND”、逻辑非“NOT”。

中国科学院大学现代信息检索课后习题答案

《信息检索导论》课后练习答案王斌最后更新日期2013/9/28第一章布尔检索习题1-1 [*] 画出下列文档集所对应的倒排索引(参考图1-3中的例子)。

文档1 new home sales top forecasts文档2 home sales rise in july文档3 increase in home sales in july文档4 july new home sales rise1 2 322 3121 2 3习题1-2 [*] 考虑如下几篇文档:文档1 breakthrough drug for schizophrenia文档2 new schizophrenia drug文档3 new approach for treatment of schizophrenia文档4 new hopes for schizophrenia patientsa. 画出文档集对应的词项—文档矩阵;解答:文档1文档2文档3文档4drug1100for1011hopes0001new0111of0010patients0001schizophrenia1111treatment0010b. 画出该文档集的倒排索引(参考图1-3中的例子)。

解答:参考a。

习题1-3 [*] 对于习题1-2中的文档集,如果给定如下查询,那么返回的结果是什么?a.schizophrenia AND drug解答:{文档1,文档2}b.for AND NOT (drug OR approach)解答:{文档4}习题1-4 [*] 对于如下查询,能否仍然在O(x+y)次内完成?其中x和y分别是Brutus和Caesar所对应的倒排记录表长度。

如果不能的话,那么我们能达到的时间复杂度是多少?a.Brutus AND NOT Caesarb.Brutus OR NOT Caesar解答:a.可以在O(x+y)次内完成。

通过集合的减操作即可。

信息检索大作业-(最终版)

信息检索综合实验报告2013~2014学年第 2 学期学院自动化专业控制科学与工程和控制工程组名 Union Buss小组成员小组成员小组成员2014年 6月 9 日基于ASIC的Camera图像预处理系统的研究与实现一检索课题概况(一)检索课题名称中文题目:基于ASIC的Camera图像预处理系统的研究与实现英文题目:Development and Implement of Camera Image Preprocessing System based on ASIC(二)检索课题简介伴随着电子技术的不断进步和数字化信息时代的到来,图像处理技术已经发展到今天各个领域如工程、医学、通信、军事工业生产以及科学研究中,于此同时消费电子产品也急速发展,已经进入了普通消费者的家庭。

手机已经成为一般家庭成员的必需品。

目前消费者已不再认为手机仅仅用来打电话的,而是将更多的焦点放在了手机的其他功能业务上,手机的拍照功能以及摄像功能自然成为手机中不可缺少的功能。

但是图像从摄像头感光后,在采集以及传输过程中,由于获取图像的工具或者手段的影响,使得获取的图像存在噪声或者变形等缺陷,而不能正常实现我们所拍摄的物体,或者我们为了要进行图像后期处理,我们需要对原始数据进行一些改变以及压缩,为此对图像进行预处理是非常重要而有必要的。

(三)总体检索思路本课题的题目是基于ASIC的Camera图像预处理系统的研究与实现,从题目中我们不难看出该课题属于电子技术范畴,主要领域涉及图像预处理方面,在图书馆的中文数据库和外文数据库中都可以找到关于图像预处理的各种文献,其中主要包括近十年来在该领域的会议、期刊、论文、专利等文献类型。

在检索过程中可利用的中文数据库有:CNKI中国知网、维普期刊资源整合平台;外文数据库有:Elsevier的Science Direct数据库、EI 数据库和IEL数据库。

网络检索工具可采用百度或者google等。

科技信息检索结课作业

科技信息检索结课作业

结合本专业或感兴趣的研究课题进行检索并提交一份书面的检索报告,作业要求如下:

1)写明检索课题的名称、检索要求(包括年限限定、期刊范围限定等);

2)分析课题,并写出反映课题内容的关键词(中文,提供尽量多的同义词与相近词);

3)根据课题需求选择学校购买的相关数据库,经过充分的检索和调研后,确定具体某一种数据库进行检索;

4)写出详细的检索步骤:

包括选择的数据库名称,

检索方式(传统检索、高级检索或者专业检索)

检索字段的选择

确定检索式

调整检索结果,选择相关文献10篇左右。

5)评价检索结果:

6)最后将检到的相关文献附后,并按国标GB/T 7714-2005(网上搜索下载)著录;

7)分析检索结果,命中多少条记录,其中有多少是相关的,多少是不相关的(误检),并简单分析原因;

8) 说明所检索课题目前国内外的现状;

8)A4打印,班长将作业收齐上交。

国科大 中科院 现代信息检索开卷考试用复习

这里面有详尽描述。

11.BM25 模型 BM25 模型是基于二重泊松推导的,用来考察词语在查询中的权值。BM25 模型融合了 三个计算因子, BIM 模型计算得分+查询词在文档 D 中的权值+查询词自身的权值。 通过计算 即可总结出与查询词最相关的文档。 BM25 不用高频词项。

优点:一定程度上的理论化模型,是基于二重泊松假设,适用于绝大多数文本语料上的 信息检索应用。实验证明是有效的。 缺点:待调参数多且参数敏感性高,必须去停用词。 计算时,qtf=1 无影响,所以前一个因子=1,w1 就是文档频率>n/2 时,文档不可用,所 以要去掉停用词。

TF k1 tf ld tf k1 1 b b avg _ l

文档归一:

意义是,当查询内容出现在长文档中,重要性减

小,出现在短文当中,重要性大。 11.1 统计语言模型, 基本假设, 和 BM25 假设区别?为什么要用平滑处理?统计量是如何在 公式中体现的? 区别:这种做法提供了一种新的文档排序的实现方法,和对文档 D 与查询 Q 相关的概 率 P 进行显示建模,而基本的统计建模方法则首先对每篇文档 D 建模得到文档的概率模型 MD,然后按照模型生成查询的概率 P(q|Md)的高低来对文档进行排序。 假设:基于多项随机试验,文档的模型符合某类概率模型的总体分布,文档和查询都是 该总体分布下的一个抽样样本实例,根据文档,估计文档的模型,即求出该总体分布及其参 数,之后计算该总体分布下抽样出查询的概率。BM25 是基于二重泊松假设的。 平滑能够进行重新分配概率,使得即使没有出现的事件也会赋予一个概率。 统计量体现:

7.1 三种模型对于文档长度的处理方式?解释三种模型对文档长度进行归一是如何体现的? 8.未插值的 AP AP:平均正确率,对不同召回率点上的正确率进行平均。 未插值的 AP: 某个查询有 6 个相关结果, 但是系统只返回了 5 篇, 位置分别是 1,2,5,10,20, 则 AP=(1/1+2/2+3/5+4/10+5/20+0)/6 插 值 的 AP : 在 召 回 率 分 别 为 0, 0.1, 0.2,…,1.0 的 十 个 点 上 的 正 确 率 求 平 均 。 Ap=(1/1+2/2+3+5+4+10+5+20)/5。它只对返回的相关文档算入分母。 9.缓冲池方法 Pooling 缓冲池方法是为了解决召回率难以计算的问题。 对于大规模的语料集合, 列举每个查询 的所有相关文档不实际,所以召回率就没有分母了,无法计算。就要用到缓冲池作为分母。 对多个检索系统的 Topk 个结果组成的集合进行人工标注,标注出的相关文档集合作为 整个相关文档集合。 Topk:从文档集的所有文档出找出 k 个离查询最近的文档,对每个文档进行余弦相似度 的评分,按照高低排序,选择前 k 个。 缓冲池效果和局限性:最常见的,如果只有部分的结果进行了 Pooling 操作,则计算结 果时的分子变小,从而正确率会变小;计算召回率时的分母和分子都变小,所以不确定。如 果所有的结果都进行了 Pooling,则此时计算的正确率分子分母都不变,正确率等于真实的 正确率,计算召回率时,分子不变,分母小于真实的相关文档总数,所以计算出的召回率大 于真实的召回率。 缓冲池的局限性:召回率不可考,所以在强调召回率准确度的系统中无法使用,缓冲池 只对一小部分文档进行评价, 当语料集变大时, 缓冲池所占比例越来越小, 则此时未插值 AP 不可靠,需要考虑其他指标。 10.评分指标 /s/blog_72995dcc01013oo9.html

国科大现代信息检索第二次作业

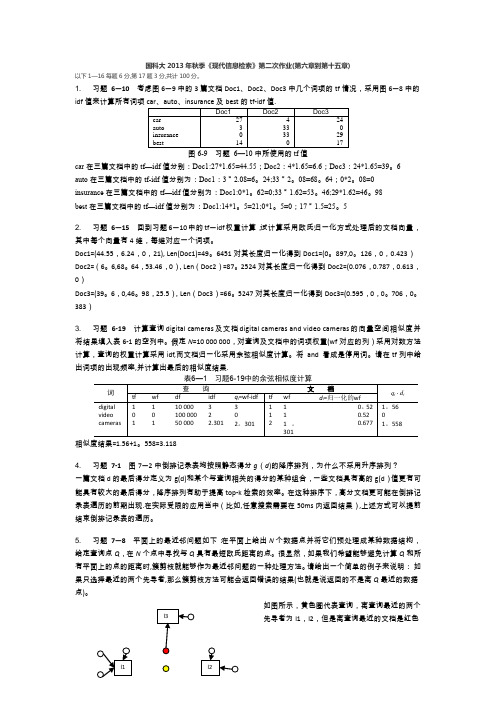

国科大2013年秋季《现代信息检索》第二次作业(第六章到第十五章)以下1—16每题6分,第17题3分,共计100分。

1. 习题 6—10 考虑图6—9中的3篇文档Doc1、Doc2、Doc3中几个词项的tf 情况,采用图6—8中的idf 值来计算所有词项图6-9 习题 6—10中所使用的tf 值car 在三篇文档中的tf —idf 值分别:Doc1:27*1.65=44.55;Doc2:4*1.65=6.6;Doc3:24*1.65=39。

6 auto 在三篇文档中的tf -idf 值分别为:Doc1:3*2.08=6。

24;33*2。

08=68。

64;0*2。

08=0 insurance 在三篇文档中的tf —idf 值分别为:Doc1:0*1。

62=0;33*1.62=53。

46;29*1.62=46。

98best 在三篇文档中的tf —idf 值分别为:Doc1:14*1。

5=21;0*1。

5=0;17*1.5=25。

52. 习题 6—15 回到习题6—10中的tf—idf 权重计算,试计算采用欧氏归一化方式处理后的文档向量,其中每个向量有4维,每维对应一个词项。

Doc1=(44.55,6.24,0,21), Len(Doc1)=49。

6451对其长度归一化得到Doc1=(0。

897,0。

126,0,0.423) Doc2=(6。

6,68。

64,53.46,0),Len (Doc2)=87。

2524对其长度归一化得到Doc2=(0.076,0.787,0.613,0)Doc3=(39。

6,0,46。

98,25.5),Len (Doc3)=66。

5247对其长度归一化得到Doc3=(0.595,0,0。

706,0。

383) 3.习题 6-19 计算查询digital cameras 及文档digital cameras and video cameras 的向量空间相似度并将结果填入表6-1的空列中。

信息检索平时作业

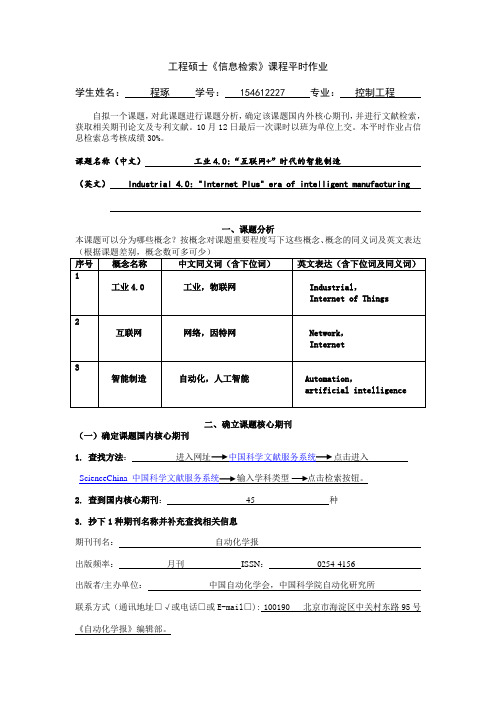

工程硕士《信息检索》课程平时作业学生姓名:程琢学号: 154612227 专业:控制工程自拟一个课题,对此课题进行课题分析,确定该课题国内外核心期刊,并进行文献检索,获取相关期刊论文及专利文献。

10月12日最后一次课时以班为单位上交。

本平时作业占信息检索总考核成绩30%。

课题名称(中文)工业4.0:“互联网+”时代的智能制造(英文) Industrial 4.0: "Internet Plus" era of intelligent manufacturing一、课题分析本课题可以分为哪些概念?按概念对课题重要程度写下这些概念、概念的同义词及英文表达(根据课题差别,概念数可多可少)序号概念名称中文同义词(含下位词)英文表达(含下位词及同义词)1工业4.0 工业,物联网 Industrial,Internet of Things2互联网网络,因特网 Network,Internet3智能制造自动化,人工智能 Automation,artificial intelligence二、确立课题核心期刊(一)确定课题国内核心期刊1. 查找方法:进入网址中国科学文献服务系统点击进入ScienceChina 中国科学文献服务系统输入学科类型点击检索按钮。

2. 查到国内核心期刊:45 种3. 抄下1种期刊名称并补充查找相关信息期刊刊名:自动化学报出版频率:月刊ISSN:0254-4156出版者/主办单位:中国自动化学会,中国科学院自动化研究所联系方式(通讯地址□√或电话□或E-mail□): 100190 北京市海淀区中关村东路95号《自动化学报》编辑部。

(二)确立课题国外核心期刊1. 查找方法:进入中南大学图书馆选择外文数据库中的JCR点击Select Categories 选择AUTOMA TION & CONTROL SYSTEMS点击Submit2. 找到国外英文核心期刊: 58 种3. 抄下1种期刊名称并补充查找相关信息(1)期刊刊名全称: IEEE Transactions on Industrial Electronics 影响因子: 6.498 出版频率:月刊出版国家或地区:美国ISSN:0278-0046出版者/主办单位:Institute of Electrical and Electronics Engineers联系方式(打√选择,并填写具体内容)(通讯地址□√或电话□或E-mail□)3 Park Ave, 17th Fl, New York, NY 10016 美国.三、文献检索(一)查找课题的中文期刊论文1. 检索平台:中国知网2. 检索策略(包括检索方式、检索字段、检索提问词及其逻辑组配关系)检索方式:高级检索主题=工业4.0 or 主题=智能制造 or 题名=互联网+3. 检出期刊论文篇数: 821 篇4. 抄下一条切题期刊论文论文题名:工业4.0和智能制造第一作者:张曙来源(包括期刊刊名、年、卷(期)及起始页码):机械设计与制造工程,2014,08:1-5(二)查找课题的外文期刊论文1. 检索平台:EI2. 检索策略(包括检索方式、检索字段、检索提问词及其逻辑组配关系)检索方式:快速检索 ((Industrial4.0) WN KY)OR((Intelligent Manufacturing) WN KY)3. 检出期刊论文篇数: 345 篇4. 抄下一条切题期刊论文论文题名: Guest editorial introduction to the focused section on mechatronics for intelligent manufacturing 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

国科大2013年秋季《现代信息检索》第一次作业(第一章到第五章)

以下每题10分,共计100分。

1、习题1-4

a.时间复杂度O(x+y)。

因为倒排记录表记录的文档号是按照从小到大排列的,在扫描Brutus对应的倒排表的时指针指向文档

号为x,扫描Caesar对应的倒排记录表的指针对应的文档号为y,如果x<y那么x在结果集中,brutus指针后移,如果x=y,x不在结果集中,两个指针都后移,如果x>y,caesar指针后移。

b.时间复杂度是O(N),N是全部的文档数。

因为结果集的大小取决于文档数N,而不是倒排记录表的长度。

2、习题1-7

对于原始的查询,按照倒排记录表的长度从小到大查询会节省查询复杂度

(tangerine OR trees) = O(46653+316812)=O(363465)

(marmalade OR skies) = O(107913+271658) = O(379571)

(kaleidoscope OR eyes) = O(46653+87009) = O(300321)

即顺序为:(kaleidoscope OR eyes) AND (tangerine OR trees)AND(marmalade OR skies)

3、习题1-10

UNION(p1,p2)

answer ←{ }

while p1!=NIL and p2!=NIL

do if docID(p1)=docID(p2)

then ADD(answer,docID(p1))

p1<- next(p1)

p2<-next(p2)

else if docID(p1)<docID(p2)

then ADD(answer,docID(p1))

p1<- next(p1)

else ADD(answer,docID(p2))

p2<-next(p2)

while p1!=NIL

do ADD(answer,docID(p1))

p1<- next(p1)

while p2!=NIL

do ADD(answer,docID(p2))

p2<- next(p2)

return(answer)

4、习题2-7

a.由24跳到75这一次跳转

b.比较为(3,3) (5,5) (9,89) (15,89) (24,89) (75,89)(75,89) (92,89) (75,89)(92,89) (81,89) (84,89) (89,89) (92,95) (115,95)

(96,95) (96,97) (97,97) (100,99) (100,100) (115,101)总共21次比较

c.比较为(3,3) (5,5) (9,89) (15,89) (24,89) (39,89) (60,89) (68,89) (75,89) (81,89) (84,89) (89,89) (92,95) (96,95) (96,97)

(97,97) (100,99) (100,101) (115,101) 总共19次比较

5

6、习题3-11

6*6*6*6=1296

7、习题4-1

倒排索引的构建需要两步:

1.扫描文档,建立词项文档对。

2.对词项文档对进行排序。

第一步时间复杂度为O(T),文档大小为800000*200*6=9.6*108B,所需时间为:读入时间+建立词项-文档对的时间

为9.6*108(2*10-8)=19.2s

第二步时间复杂度为O(T log2T),所有倒排记录数为108。

花费的时间为2*( T log2T)*(磁盘寻道时间+一个词项文档对的传输时间+比较时间)=2*(108*log2(108))*(5*10-3+2*10-8*8+10-8)=26575424.76s≈307.59天≈308天

总时间为308天

8、习题4-3 对于n = 15个数据片,r = 10个分区文件,j = 3个词项分区,假定使用的集群的机器的参数如表4-1所示,那么在

MapReduce构架下对Reuters-RCV1语料进行分布式索引需要多长时间?

解答【整个计算过程是近似的,数字不一定对,但是要了解过程】:

(一)、MAP阶段【读入语料(已经不带XML标记信息了,参考表5-6),词条化,写入分区文件】:

(1) 读入语料:

基于表4-2,Reuters RCV1共有8*105篇文档,每篇文档有200词条,每个词条(考虑标点和空格)占6B,因此整个语料库的大小为8*105*200*6=9.6*108B (近似1GB,注表4-2对应于表5-1第3行的数据,而那里的数据已经经过去数字处理,因此实际的原始文档集大小应该略高于0.96G,这里近似计算,但是不要认为没有处理就得到表5-1第3行的结果)

将整个语料库分成15份,则每份大小为9.6*108/15 B

每一份读入机器的时间为:9.6*108/15*2*10-8=1.28s

(2) 词条化:每一份语料在机器上进行词条化处理,得到8*105*200=1.6*108个词项ID-文档ID对(参考表4-2和图4-6,注意此

时重复的词项ID-文档ID对还没有处理),共占1.6*108*8=1.28*109个字节,词条化的时间暂时忽略不计【从题目无法得到词条化这一部分时间,从表5-1看词条化主要是做了去数字和大小写转换,当然也感觉这一部分的处理比较简单,可以忽略】。

(3) 写入分区文件:每一份语料得到的词项ID-文档ID (Key-Value)存储到分区所花的时间为:

(1.28*109/15)*2*10-8=1.71s

(4) MAP阶段时间:

由于分成15份,但只有10台机器进行MAP操作,所以上述MAP操作需要两步,因此,整个MAP过程所需时间为

(1.28+1.71)*2=6.0s

(二)、REDUCE阶段【读入分区文件,排序,写入倒排索引】:

(1) 读入分区文件【读入过程中已经实现所有Key-Value对中的Value按Key聚合,即变成Key, list(V1,V2..)。

聚合过程在内存中

实现,速度很快,该时间不计。

另外,网络传输时间这里也不计算】:

根据表4-2,所有倒排记录的数目为1.6*108,因此3台索引器上每台所分配的倒排记录数目为1.6*108/3,而每条记录由4字节词项ID和4字节文档ID组成,因此每台索引器上需要读入的倒排记录表数据为1.28*109/3字节。

于是,每台索引器读数据的时间为1.28*109/3*2*10-8=8.5s

(2) 排序:

每台索引器排序所花的时间为1.6*108/3*log2(1.6*108/3)*10-8=13.7s

(3) 写入倒排索引文件【此时倒排文件已经实现文档ID的去重,假定只存储词项ID和文档ID列表,并不存储其他信息(如词项的

DF及在每篇文档中的TF还有指针等等)】:

需要写入磁盘的索引大小为(据表4-2,词项总数为4*105个) 4*105/3*4+108/3*4=4/3*108字节

索引写入磁盘的时间为:4/3*108*2*10-8=2.7s

(4) REDUCE阶段时间为:8.5+13.7+2.7=24.9

(三) 因此,整个分布式索引的时间约为6.0+8.5+13.7+2.7=30.9s

9、习题5-2

k=8:每8个词项节省的空间3*8-(3+8)=13,节省空间(400000/8)*13=0.65MB,空间使用7.6-0.65=6.95MB

k=16: 每16个词项节省的空间3*16-(3+16)=29,节省空间(400000/16)*29=0.725MB,空间使用7.6-0.725=6.875MB 10、习题5-8

原始间距序列的二进制为1001,110,11,111011,111 。

值为9,6,3,59,7

倒排记录表为9 15 18 77 84。