SREA_training

Ford SQE Training PPAP

三、PPAP18个交付项

3、批准的特殊特性协议

福特特殊要求内容: 3.1 必须针对每个零件识别CC / SC /PTC特性; 3.2 必须由PD / IQ / SQE参与确定项目以及达成一致的管控方法; 3.3 在必要时,需要得到福特PD / STA的认可; 交付资料: 特殊特性清单

三、PPAP18个交付项

Phase0 R-at-Rate

1. 设计记录 2. 工程变更文件 3. 工程批准 4. 设计FMEA 5. 过程流程图 6. 过程FMEA 7. 控制计划 8. 测量系统分析 16. 检查辅具 17. 顾客特殊要求

Phase1 Quality Verification

9. 尺寸报告 10. 材料、性能测试报告 11. 初始过程能力研究 12. 有资格的实验室文件 13. 外观批准报告 14. 生产样件 15. 标准样件 18. 零件提交保证书

分供方PPAP的提交: • 对于供应商,福特指定的PPAP提交等级是3级或者5级,任何提交给福特的PPAP文件包

需包含所有分供方子零件批准的证据。证据可能是一个摘要(所有批准的PSW,一个 PSW签署批准或等同批准的汇总清单。 • 供应商同样需要保证这些已经批准的分供方PPAP资料能够被获取用于评审。

6、过程FMEA

AIAG交付项要求内容: 1. 供应商应该依据和兼顾顾客的需求开发PFMEA。 注:如果新零件的通用性通过了供应商的评审,一个单一的过程FMEA可以应用一系列家族的∕ 相似的零件或材料的制造过程。

福特交付项要求内容: 1. 所有供应商(含照图加工或者自主设计的供应商)需要识别在APQP∕PPAP证据工资表

二、福特对PPAP特殊要求

2.1 福特阶段性PPAP在福特GPDS开发系统的介绍

development set发展集

development set发展集Development set(发展集)是机器学习中常用的数据集之一。

在机器学习任务中,我们通常将数据集划分为训练集(training set)、发展集(development set)和测试集(test set)。

训练集用于模型的参数估计,测试集用于评估模型的性能。

而发展集则是在模型训练过程中,用于调整模型超参数和进行模型选择的数据集。

发展集在机器学习中起着至关重要的作用。

首先,它可以用来选择最佳的模型超参数。

模型超参数是指在模型在训练过程中需要手动设置的参数,例如学习率、正则化参数等。

选择合适的超参数可以提高模型的性能。

通过在发展集上尝试不同的超参数组合,我们可以比较它们的性能,并选择最佳的超参数组合。

发展集还可以用于进行模型选择。

在机器学习任务中,我们通常需要选择一个最佳的模型来解决问题。

通过在发展集上评估不同模型的性能,我们可以选择性能最好的模型作为最终的模型。

这样可以避免在测试集上过度拟合,保证模型的泛化能力。

需要注意的是,发展集的数据不能在模型训练中使用。

它仅仅用于调整超参数和选择模型。

这是为了避免模型在训练过程中过度拟合发展集的情况,从而保证模型对未知数据的泛化能力。

在选择发展集时,我们需要确保其与训练集和测试集是相互独立的。

这意味着发展集中的样本不能出现在训练集和测试集中,以避免数据泄漏导致模型性能评估的不准确。

为了有效利用发展集,我们可以使用交叉验证方法。

交叉验证是一种将数据集划分为多个子集的方法,其中一个子集作为发展集,其他子集用于训练和测试。

通过多次交叉验证,我们可以得到更稳定和可靠的模型性能评估结果。

发展集的规模和分布应该与实际应用场景尽可能接近,以确保模型在实际应用中的性能。

如果发展集与实际应用场景存在较大差异,可能导致模型在实际应用中的性能下降。

发展集在机器学习中扮演着重要的角色。

它用于调整模型超参数和选择最佳模型,以提高模型的性能和泛化能力。

prepare_model_for_training

prepare_model_for_training

prepare_model_for_training 是一个通用的方法名称,它可能出现在不同的上下文和库中。

这个名称通常表示该方法用于准备模型以进行训练。

具体来说,prepare_model_for_training 可能会执行以下操作:

1.数据预处理:对输入数据进行必要的转换或标准化,使其适合模

型的输入。

2.模型参数初始化:为模型中的权重和偏差设置初始值。

3.模型结构定义:确保模型的结构已正确定义并可以用于训练。

4.编译模型:为训练设置优化器、损失函数等。

5.设置训练循环:设置训练过程中所需的循环,如训练循环、验证

循环等。

6.设备分配:决定模型应该在哪里运行,例如CPU、GPU或其他类

型的计算设备。

7.其他设置:其他与训练相关的设置,如学习率、批处理大小等。

如果你在特定的库或框架中看到了这个方法,那么为了更具体地了解它做什么,你应该查看该库或框架的文档或源代码。

Ford SQE Training CP & PTC

控制计划

控制计划的重要输入及其分类:

DFMEA

YC、YS

DVP&R

• • • • •

客户和员工的安 全 政府法规 设计要求 售后要求 顾客满意度

Prototype Control Plan

Process Flow Chart PFMEA

Per-Launch Control Plan

Standard Work Instruction Visual Aids Modification Of PFMEA (As Required) Production Control Plan

•

• • • •

试生产控制计划包括了增加控制计划和频率,以确保产品满足初始生产运行、制定测量技术和数 据收集要求。 注:量产控制计划需要同STA达成一致后,运用到Phase3的生产中。 试生产控制计划数据的提交— 供应商提交到福特发动机工厂的所有<Unit TT>and<Unit PP>零件, 需要提交在试生产控制计划中制定的数据。

Supplier Quality Engineer – 控制计划和传递特性

PASS Automotive Components (Shanghai) Co., Ltd. Shanghai China www.pass.deBy Robin Han 2014.7.27控制计划

控制计划:

1、控制计划是过程的书面细节描述,用于控制并减小零件及生产过程的变差。 2、控制计划描述了过程的每个阶段(包括进货、生产过程、出厂)所需的控制措施。 3、控制计划还详细列出控制特殊性的过程检测及控制方法。 4、描述了制造商的质量控制系统,包括针对特殊产品和过程的反应计划。 5、控制计划不能代替作业指导书。控制计划主要是给工程师使用,不能直接指导生产,因 此要根据控制计划中药控制的项目和要求,编制一系列的作业指导书,共现场作业员使用。

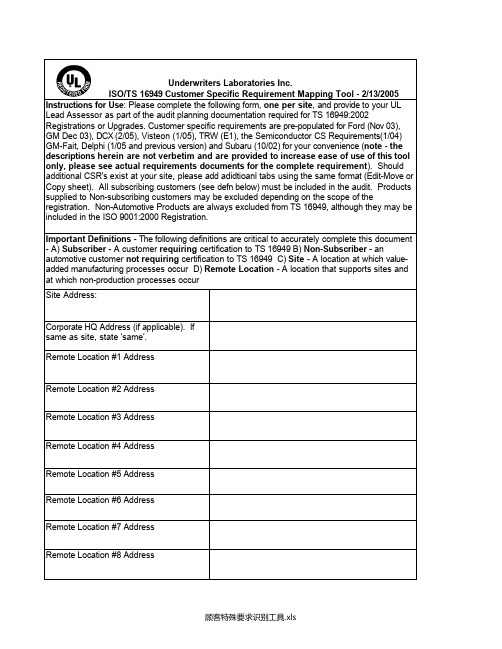

顾客特殊要求

Underwriters Laboratories Inc.ISO/TS 16949 Customer Specific Requirement Mapping Tool - 2/13/2005 Instructions for Use: Please complete the following form, one per site, and provide to your UL Lead Assessor as part of the audit planning documentation required for TS 16949:2002 Registrations or Upgrades. Customer specific requirements are pre-populated for Ford (Nov 03), GM Dec 03), DCX (2/05), Visteon (1/05), TRW (E1), the Semiconductor CS Requirements(1/04) GM-Fait, Delphi (1/05 and previous version) and Subaru (10/02) for your convenience (note - the descriptions herein are not verbetim and are provided to increase ease of use of this tool only, please see actual requirements documents for the complete requirement). Should additional CSR's exist at your site, please add adidtioanl tabs using the same format (Edit-Move or Copy sheet). All subscribing customers (see defn below) must be included in the audit. Products supplied to Non-subscribing customers may be excluded depending on the scope of the registration. Non-Automotive Products are always excluded from TS 16949, although they may be included in the ISO 9001:2000 Registration.Important Definitions - The following definitions are critical to accurately complete this document - A) Subscriber - A customer requiring certification to TS 16949 B) Non-Subscriber - an automotive customer not requiring certification to TS 16949 C) Site - A location at which value-added manufacturing processes occur D) Remote Location - A location that supports sites and at which non-production processes occurSite Address:Corporate HQ Address (if applicable). Ifsame as site, state 'same'.Remote Location #1 AddressRemote Location #2 AddressRemote Location #3 AddressRemote Location #4 AddressRemote Location #5 AddressRemote Location #6 AddressRemote Location #7 AddressRemote Location #8 Address使用说明:请完成以下表格,每现场一份且作为TS16949:2002注册或升级要求的文件审核计划的一部分提供给你的UL主任审核员。

英语口语缩写聊天缩写

老外聊天、发邮件常用英语缩写邮件里常用的四个英文缩写CC,FYI,ASAP,RESEND1. CC=Carbon copy 抄送2. FYI=for your reference 供你参考3. ASAP=as soon as possible 尽快4. RESEND! 重传数字:2 = to/too2B or not 2B = To be or not to be4 = for4ever = foreverA:ASL = Age/Sex/LocationAFAIC = As Far As I’m ConcernedAFAIK = As Far As I KnowAMBW = All My Best WishesAOTS = All Of The SuddenASAFP = As Soon As "Friggin" Possible ASAP = As Soon As PossibleATST = At The Same TimeB:B4 = BeforeB4N = Bye For NowBBIAB = Be Back In A BitBBIAF = Be Back In A FewBBL = Be Back LaterBBN = Bye Bye NowBF = Boy friendBFD = Big Fing DealBFN = Bye For NowBHOF = Bald Headed Old FartBIF = Basis In FactBITD = Back In The DayBiz = BusinessBM = Byte MeBMOTA = Byte Me On The AssBNF = Big Name FanBOHICA = Bend Over Here It Comes Again BOM=bill of material 材料清单BR = Best regardsBRB = Be Right BackBRT = Be Right ThereBS = Big SmileBT = Byte ThisBTDT = Been There Done ThatBTSOOM = Beats The Sh Out Of MeBTW = By The WayBTWBO = Be There With Bells OnBWDIK = But What Do I Know?BWO = Black, White or OtherC:Cam = Web CameraCIAO = Goodbye (in Italian)CID = Consider It DoneCIS = CompuServe Information ServiceCMF = Count My FingersCof$ = Church of ScientologyCRAFT = Can’t Remember A Fing Thing CRAWS = Can’t Remember Anything Worth A Sh CSL = Can’t Stop LaughingCTC = Choaking The ChickenCU = See YouCUL/CYL/CUL8R = See You LaterCWYL = Chat With You LaterCYA = Cover Your AssD:DBEYR = Don’t Believe Everything You Read DD = Due DiligenceDDD = Direct Distance DialDETI = Don’t Even Think ItDGT = Don’t Go ThereDHYB = Don’t Hold Your BreathDIIK = Damned If I KnownDILLIGAD = Do I Look Like I Give A d\\amn DILLIGAS = Do I Look Like I Give A ShDKDC = Don’t Know Don’t CareDL = DownloadDLTM = Don’t Lie To MeDQYDJ = Don’t Quit You’re Day JobDRIB = Don’t Read If BusyDS = Dunce SmileyDYSTSOTT = Did You See The Size Of That ThingE:EG = Evil GrinEOM = End Of MessageESO = Equipment Smarter than OperatorF:F2F/FTF = Face To FaceFAQ = Frequently Asked QuestionFBKS = Failure Between Keyboard and SeatFE = For Example/Fatal ErrorFF&PN = Fresh Fields And Pastures NewFOAF = Friend Of A FriendFTASB = Faster Than A Speeding BulletFT = FaintFTL = Faster Than LightFTTB = For The Time BeingFUBAR = Fed Up Beyond All RecognitionFUBB = Fed Up Beyond BeliefFUD = (Spreading) Fear, Uncertainty, and DisinformationFWIW = For What It’s WorthFYA = For Your AmusementFYI = For Your InformationFYM = For Your MisinformationG:G2G = Got To GoG8T/GR8 = GreatGAL = Get A LifeGDGD = Good,GoodGF = girlfriendGG = Good Game/Gotta GoGIGO = Garbage In, Garbage Out GIWIST = Gee, I Wish I’d Said ThatGL = Good LuckGLYASDI = God Loves You And So Do I GMTA = Great Minds Think Alike GNBLFY = Got Nothing But Love For You GR&D = Grinning Running And Ducking GRRRR = "Growling"GSOAS = Go Sit On A SnakeGTG = Got To GoGTGB = Got To Go, ByeGTGP = Got To Go PeeGTH = Go To HellGTSY = Glad To See YaGYPO = Get Your Pants OffBE A QUEEN.H:HAGO = Have A Good OneHAK = Hugs And KissesHB = Hurry BackHD = HoldHHO1/2K = Ha Ha, Only Half Kidding HHOK = Ha Ha, Only KiddingHIOOC = Help! I’m Out Of Coffee Howz = How isHTH = Hope This (That) HelpsHUA = Heads Up AceHUYA = Head Up Your AI:IAC = In Any CaseIAE = In Any EventIANAC = I Am Not A CrookIANAL = I Am Not A LawyerIBT = In Between TechnologyIBTD = I Beg To DifferIC = I See/In CharacterIDGAF = I Don’t Give A FIDGI = I Don’t Get ItIDK = I Don’t KnowIDKY = I Don’t Know YouIDST = I Didn’t Say ThatIDTS = I Don’t Think SoIFAB = I Found A BugIFU = I Fed UpIGGP = I Gotta Go PeeIIIO = Intel Inside, Idiot OutsideIIMAD = If It Makes An(y) DifferenceIIRC = If I Remember CorrectlyIIWM = If It Were MeILICISCOMK = I Laughed, I Cried, I Spat/Spilt Coffee/Crumbs/Coke On My KeyboardILY = I Love YouIMHO = In My Humble OpinionIMNSHO = In My Not So Humble OpinionIMO = In My OpinionINMP = It’s Not My Problem INPO = In No Particular OrderIOH = I’m Outta HereIOW = In Other WordsIRL = In Real LifeISS = I Said SoITM = In The MoneyIYKWIM = If You Know What I Mean IYSS = If You Say SoJ:J/C = Just CheckingJ/K = Just Kidding!J/W = Just WonderingJAFO = Just Another Fing OnlookerK:K/KK = OK/OK, OKKFY = Kiss For YouKISS = Keep It Simple StupidKIT = Keep In TouchKMA = Kiss My AssKWIM = Know What I MeanKX = kissKYPO = Keep Your Pants OnL:L8R = LaterLD = Long DistanceLDTTWA = Let’s Do The Time Warp Again LLTA = Lots And Lots Of Thunderous Applause LMAO = Laughing My Ass OffLMK = Let Me KnowLOL = Laughing Out Loud/Lots Of Luck(Love) LTIC = Laughing ’Til I CryLTNS = Long Time No SeeLYL = Love Ya LotsLYLAS = Love You Like A SisterM:M8T = MateMHOTY = My Hat’s Off To YouMM = Market MakerMorF = Male or Female?MOTD = Message Of The DayMOTSS = Members Of The Same Sex MTFBWY = May The Force Be With You MWBRL = More Will Be Revealed LaterMYOB = Mind Your Own BusinessN:N = And/Know/NowNAK = Nursing At KeyboardNAZ = Name, Address, Zip (also means Nasdaq) NBD = No Big DealNBIF = No Basis In FactNFI = No Fing IdeaNFW = No Fing WayNIFOC = Nude In Front Of The ComputerNM = Never MindNMP = Not My ProblemNMU = Nothing Much YouNOYB = None Of Your BusinessNP = No ProblemNQOCD = Not Quite Our Class DearNRG = EnergyNRN = No Reply NecessaryNYCFS = New York City Finger SaluetO:OAUS = On An Unrelated SubjectOBTW = Oh, By The WayOIC = Oh, I SeeOICU = Oh, I See YouOMDB = Over My Dead BodyOMG = Oh My God/Oh My GoshOMIK = Open Mouth, Insert KeyboardONNA = Oh No, Not AgainOOC = Out Of CharacterOOTB = Out Of The Box/Out Of The BlueOT = Off TopicOTOH = On The Other HandOWTTE = Or Words To That EffectOZ = stands for "Australia"P:PEBCAK = Problem Exists Between Chair And KeyboardPEM = Privacy Enhanced MailPic = PicturePIMP = Peeing In My PantsPITA = Pain In The AssPLS/PLZ = PleasePMFJI = Pardon Me For Jumping InPO = Piss Off /product order/purchase orderPOS = Parents Over ShoulderPOV = Point Of ViewPPL = PeoplePro = ProfessionalPS = By The Way/PhotoshopS:SS:spring/summerT:TAH = Take A HikeTANSTAAFL = There Ain’t No Such Thing As A Free LunchTARFU = Things Are Really Fed UpTDTM = Talk Dirty To MeTEOTWAWKI = The End Of The World As We Know It TFN = Thanks For Nothin’THX/TX/THKS = ThanksTIA = Thanks In AdvanceTIAIL = Think I Am In LoveTIC = Tongue In CheekTKS/TKX=ThanksTLA = Three Letter AcronymTLGO = The List Goes OnTM = Trust MeTMI = Too Much InformationTMTOWTDI = There’s More Than One Way To Do It TPTB = The Powers That BeTSR = Totally Stuck in RAMTTFN = Ta Ta For NowTTT = That’s The Ticket/To The TopTTUL/TTYL = Talk To You LaterTWHAB = This Won’t Hurt A BitTY = Thank YouTYVM = Thank You Very MuchU:U = YouUR = YourU R = You areunPC = unPolitically Correct URYY4M = You Are Too Wise For MeV:VFM = Values For MoneyVG = Very GoodW:WAG = Wild Ass GuessWAI = What An IdiotWB = Welcome BackWCA = Who Cares AnywayWDYS = What Did You Say? WDYT = What Do You Think?WE = WhateverWEG = Wicked Evil GrinWG = Wicked GrinWGAFF = Who Gives A Flying FWIIFM = What’s In It For Me?WIT = Wordsmith In TrainingWITFITS = What in the F is this ShWOG = Wise Old GuyWot/Wut = WhatWRT = With Respect To/With Regard To WTF = What The FWTG = Way To Go!WTSDS = Where The Sun Don’t Shine WYMM = Will You Marry MeWYP = What’s Your Problem?WYRN = What’s Your Real Name?WYS = Whatever You SayWYSIWYG = What You See Is What You Get WYT = Whatever You ThinkX:X U = Kiss YouY:Y = WhyYa = YouYA = Yet AnotherYAFIYGI = You Asked For It You Got It YDKM = You Don’t Know MeYep/Yup = YesYGBK = You Gotta Be Kiddin’YMMV = Your Mileage May VaryYNK = You Never KnowYOYO = You’re On Your OwnYR = Yeah, RightYSYD = Yeah, Sure You DoYTTT = You Telling The Truth? YYSSW = Yeah Yeah Sure Sure Whatever缩略语含义说明BTW 或btw 顺便说一句by the way 的首字母缩略词。

prepare_model_for_training

prepare_model_for_training 标题:为训练准备模型引言概述:在机器学习和深度学习领域,为训练准备模型是非常重要的一步。

只有经过充分准备的模型才能在训练过程中取得良好的性能。

本文将从五个大点出发,详细阐述为训练准备模型的关键步骤。

正文内容:1. 数据预处理1.1 数据清洗:去除异常值、处理缺失值和重复值。

1.2 特征工程:选择和提取与训练任务相关的特征,进行特征缩放、编码和选择。

2. 模型选择与构建2.1 模型选择:根据训练任务的特点和数据集的特征选择合适的模型,如线性回归、决策树、支持向量机等。

2.2 模型构建:根据选择的模型,确定模型的结构和参数,并进行初始化。

3. 损失函数与优化算法3.1 损失函数选择:根据训练任务的目标,选择适合的损失函数,如平方损失、交叉熵损失等。

3.2 优化算法选择:根据模型的结构和数据集的规模选择合适的优化算法,如梯度下降、Adam等。

4. 训练过程4.1 数据集划分:将数据集划分为训练集、验证集和测试集,用于模型的训练、调参和评估。

4.2 批量训练:采用批量训练的方式,每次迭代使用一小部分数据进行参数更新,提高训练效率和模型泛化能力。

4.3 参数调优:通过调整模型的超参数,如学习率、正则化参数等,优化模型的性能。

5. 模型评估与保存5.1 模型评估:使用验证集和测试集对训练好的模型进行评估,计算准确率、精确率、召回率等指标。

5.2 模型保存:将训练好的模型保存,以便后续使用和部署。

总结:在为训练准备模型的过程中,数据预处理、模型选择与构建、损失函数与优化算法、训练过程以及模型评估与保存是关键的步骤。

通过合理的准备,可以提高模型的训练效果和性能。

因此,在实际应用中,我们应该重视为训练准备模型这一步骤,以提升机器学习和深度学习模型的质量和可用性。

一种融合多感受野和密集残差注意的超分辨率重建方法

一种融合多感受野和密集残差注意的超分辨率重建方法随着研究人员关注计算机视觉领域中超分辨率重建(SR)问题的不断增加,改进SR方法以实现较高的重建质量和效率已经成为一个重要的研究课题。

本文提出了一种新的SR方法,它将多感受野(MSR)和密集残差注意(DRAN)两个模块结合起来,可以有效地改善SR结果。

多感受野模块根据不同尺度的多感受野提取特征,以及各个尺度的特征融合和图像重建,从而实现对大尺度结构的提取和精细细节的恢复,同时减少了中间特征提取的噪声效应。

密集残差注意模块通过由精细特征和残差特征组成的非线性融合,来避免深层次特征抽取过程中的梯度消失和突变问题,从而实现更精细,更精确的重建结果。

本文在三种公数据集,即Set5,Set14和BSD200上进行了详细的实验,结果表明,与其他SR方法相比,所提出的方法具有更低的块失真(BD),更高的结构相关性系数(PSNR)和视觉质量评分(VMAF)。

现有的SR方法大多采用单视角的特征提取技术来提取高分辨率(HR)图像的特征,但单视角特征易受噪声影响,导致SR结果出现细节模糊、结构偏离等问题。

为了解决上述问题,本文提出了一种新的融合多感受野和密集残差注意的SR方法。

该方法采用多尺度的MSR 模块提取特征,将提取的特征以不同的尺度组合,有效地提高了模型的使用效果。

另外,Dran模块使用了一系列非线性融合来提取精细特征,从而可以更好地恢复重建图像的结构与细节。

通过实验,本文的方法更好地提高了SR的精度,而且时间效率也非常高。

为了验证本文提出的方法是否真正有效,本文在三个常用数据集上进行了大量实验。

实验结果表明,所提出的方法在所有实验数据集上都取得了比其他最先进方法更好的结果,表明这种方法可以更准确地恢复重建图像,不仅提高了重建精度,而且改善了重建速度。

本文提出了一种新的SR方法,通过融合多感受野和密集残差注意来提高SR的性能。

与传统SR方法相比,本文提出的模型可以更准确地恢复图像的细节,改善图像的块失真,PSNR和VMAF,提高重建精度,提升时间效率。

trainingarguments参数

trainingarguments参数Trainingarguments参数是深度学习中非常重要的一个概念,它决定了模型的训练过程中的许多细节。

本文将从基础概念出发,系统地介绍trainingarguments参数的含义和作用。

一、trainingarguments参数的定义Trainingarguments参数是在深度学习中用于控制模型的训练过程的一组参数,其包括许多不同的参数值,例如batch size、learning rate、momentum等。

二、trainingarguments参数的作用1. Batch sizeBatch size指的是每次迭代训练中用到的样本数,它决定了每个参数更新的方式和速度。

如果batch size设置过小会导致在滑动平均的过程中产生的噪声较大,训练的效果会比较差。

而batch size设置过大则会占用较多的内存,有可能导致无法运行。

因此,需要根据实际情况选择合适的batch size。

2. Learning rateLearning rate是控制模型训练速度的一个超参数。

它定量地表达了每次迭代中调整模型参数的数量级。

在训练早期,如果learning rate过大,会导致模型梯度爆炸的问题,模型稳定性较差。

而在训练后期,如果learning rate过小,模型则会很难收敛。

所以需要合适的learning rate才能对模型训练起到很好的作用。

3. MomentumMomentum指的是模型中梯度下降的加速度,它会考虑之前梯度的信息来更新当前的参数。

Momentum参数的调整可以加速模型的收敛,起到优化的作用。

但如果Momentum参数过大,则可能会导致模型震荡。

因此,需要权衡各个参数的取值来获得最佳的训练效果。

三、trainingarguments参数的调整trainingarguments参数的调整是深度学习中优化模型的重要手段,而如何调整这些参数也是一个需认真处理的问题。

chatgpt训练话术

chatgpt训练话术

ChatGPT是一种基于大规模预训练模型的对话生成模型,它通

过在庞大的语料库上进行自监督学习来获得对话技能。

训练ChatGPT的过程可以分为两个阶段,预训练和微调。

在预训练阶段,模型使用大量的公开互联网文本数据进行自监

督学习。

它通过预测下一个词的任务来学习语言的统计规律和语义

关系。

这个过程使得模型能够捕捉到丰富的语言知识和语境信息。

在微调阶段,使用人工生成的对话数据对预训练的模型进行进

一步训练。

这些对话数据包括模型与人类操作员进行的对话交互。

操作员扮演用户和模型的角色,通过与模型进行对话来生成训练数据。

这个阶段的目标是使模型能够更好地理解和生成自然语言对话。

为了训练ChatGPT,还需要设计合适的训练目标和损失函数。

常见的目标是最大似然估计,即使模型生成的对话与人类对话尽可

能地相似。

损失函数可以是交叉熵损失函数或其他适当的损失函数,用于衡量模型生成对话的质量和准确性。

在训练过程中,还要考虑一些技术细节,如批处理大小、学习

率、模型的层数和隐藏单元数等。

这些参数的选择需要根据具体的任务和数据集进行调整和优化。

总的来说,训练ChatGPT是一个复杂而庞大的工程,需要大量的计算资源和高质量的训练数据。

通过预训练和微调的过程,模型可以学到丰富的对话知识,并能够生成连贯、有逻辑的回答。

中英文验证码深度训练

中英文验证码的深度训练通常涉及以下步骤:数据收集:首先需要收集大量的中英文验证码图片和对应的正确答案。

这些数据可以来自各种网站、应用程序或开源数据集。

数据预处理:对收集到的数据进行预处理,包括图像清洗、大小调整、灰度化等操作,以便于模型训练。

模型选择:选择适合的深度学习模型,例如卷积神经网络(CNN)、循环神经网络(RNN)或长短期记忆网络(LSTM)等。

模型训练:

使用训练数据集对模型进行训练,通过调整模型参数和优化器来最小化错误率。

模型评估:使用验证数据集对训练好的模型进行评估,以了解模型在未见过的数据上的表现。

模型优化:根据评估结果对模型进行优化,例如调整模型结构、增加或减少层数、改变激活函数等。

部署模型:将训练好的模型部署到生产环境中,用于实际的中英文验证码识别任务。

智能飞行器应用技术赛前集训计划

智能飞行器应用技术赛前集训计划【中英文实用版】英文文档内容:Intelligent Flying Vehicle Application Technology Pre-Competition Training PlanThe pre-competition training plan for the intelligent flying vehicle application technology is an essential step to ensure the success of the participants in the upcoming competition.The training plan aims to enhance the skills and knowledge of the participants in the field of intelligent flying vehicles, covering various aspects such as drone operation, programming, and application development.The training plan includes the following key components:1.Basic Training: This phase focuses on familiarizing participants with the basic concepts of drones, including drone types, components, and safety regulations.Participants will also learn fundamental flying skills to operate drones safely and accurately.2.Programming and Control: In this phase, participants will delve into the programming and control systems of drones.They will learn to program flight paths, control drone movements, and implement autonomous navigation techniques.The training will also cover advanced programming concepts such as drone swarm technology and machine learning algorithms.3.Application Development: Participants will explore various applications of intelligent flying vehicles, including aerial photography, mapping, and surveillance.They will learn to develop custom applications using specialized software and programming languages.The training will also cover data processing and analysis techniques to extract valuable insights from the collected data.4.Team Collaboration and Project Management: T o prepare participants for the competition, the training plan emphasizes team collaboration and project management skills.Participants will learn to work together efficiently, divide tasks, and manage time effectively.They will also develop presentation and pitching skills to communicate their ideas effectively.5.Mock Competitions and Feedback: Throughout the training period, participants will engage in mock competitions to simulate real-life scenarios.They will receive feedback from experts in the field, allowing them to identify areas for improvement and refine their strategies.6.Continuous Learning and Support: The training plan encourages participants to stay updated with the latest advancements in intelligent flying vehicle technology.They will have access to online resources, workshops, and mentorship programs to support their continuous learning and development.By following this comprehensive pre-competition training plan,participants will be well-equipped with the necessary skills and knowledge to excel in the intelligent flying vehicle application technology competition.The training plan aims to foster a strong foundation in drone technology and inspire participants to explore new frontiers in this exciting field.中文文档内容:智能飞行器应用技术赛前集训计划智能飞行器应用技术赛前集训计划是为了确保参赛者在即将到来的比赛中取得成功而制定的关键步骤。

gpt-sovits训练规律

gpt-sovits训练规律英文回答:GPT-Soviets training is an iterative process that involves several key steps:1. Data collection and preparation:The first step is to collect a large dataset of text data in the target language. This data should be relevant to the task that the model will be trained on. Once the data is collected, it is preprocessed to remove noise and inconsistencies.2. Model initialization:The next step is to initialize the GPT-Soviet model. This involves setting the initial weights and biases of the model. The model is typically initialized with random weights, but it can also be initialized with weights thatare pretrained on a related task.3. Training:Once the model is initialized, it is trained on the target dataset. The training process involves iteratively updating the model's weights and biases to minimize a loss function. The loss function measures the difference between the model's predictions and the true labels.4. Evaluation:After the model has been trained, it is evaluated on a held-out test set. The test set is used to assess the model's performance on unseen data. The model's performance is typically measured using metrics such as accuracy, precision, and recall.5. Deployment:Once the model has been evaluated and found to perform well, it can be deployed for use. The model can be deployedin a variety of ways, such as a web service, a mobile app, or a desktop application.中文回答:GPT-Soviets 训练流程。

pretrain 和sft两个步骤的训练

pretrain 和sft两个步骤的训练一、预训练(Pretrain)预训练是一种深度学习的方法,主要是在大规模无标签数据上进行训练,然后将其应用于有标签的数据集上。

预训练的目的是通过训练一个大的神经网络来学习有用的特征表示,这些特征表示可以在不同的任务和数据集上使用。

在自然语言处理领域,预训练通常是指利用大量的无标签文本数据来训练一个模型,该模型能够理解和生成自然语言文本。

预训练通常使用无监督学习算法,其中最常用的是自编码器(Autoencoder)和语言模型(Language Model)。

自编码器通过将输入数据编码为一个低维的向量,然后从该向量重构输入数据,从而学习数据的表示。

语言模型则是预测给定前文之后的下一个词的概率分布,从而学习语言的内在结构和语义信息。

二、自监督学习(Self-Supervised Learning,SFT)自监督学习是一种机器学习方法,它利用无标签数据进行训练,通过预测输入数据的某个变换后的版本或者某个相关任务来学习有用的特征表示。

在自然语言处理领域,自监督学习通常是指利用大量的无标签文本数据来训练模型,该模型能够完成诸如文本分类、命名实体识别等任务。

自监督学习的常见方法包括:1)文本分类:给定一个文本集合,将每个文本标记为其所属的类别;2)命名实体识别(NER):识别文本中的特定实体,如人名、地名、组织机构名等;3)关系抽取:从文本中抽取实体之间的关系;4)问答系统:针对给定的问题,从文本中找出答案;5)对话生成:根据给定的对话上下文生成下一个回复等。

三、Pretrain和SFT的关系预训练和自监督学习是深度学习中两种重要的方法,它们之间的关系密不可分。

预训练通常是指在大规模的无标签数据上进行训练,学习有用的特征表示。

而自监督学习则是利用无标签数据来完成某个相关任务,从而学习特征表示。

在自然语言处理领域,预训练通常是指利用大量的无标签文本数据来训练一个模型,该模型能够理解和生成自然语言文本。

senta模型原理解析

senta模型原理解析

Senta模型是一种情感分析模型,主要用于判断文本中的情感倾向,包括积极、消极和中性情感。

Senta模型的原理基于深度学习和自然语言处理技术,下面我将从几个方面对Senta模型的原理进行解析。

首先,Senta模型采用了深度学习技术,其中最核心的部分是使用了卷积神经网络(CNN)和长短时记忆网络(LSTM)。

CNN主要用于提取文本中的局部特征,而LSTM则用于捕捉文本中的长距离依赖关系。

这两种网络结合起来可以更好地理解文本中的情感信息,并进行情感分类。

其次,Senta模型在训练过程中使用了大规模的文本数据集,通过无监督学习和有监督学习相结合的方式,使得模型能够更好地理解文本中的情感信息。

通过对大量文本数据的学习,Senta模型可以更准确地判断不同文本的情感倾向。

此外,Senta模型还使用了词嵌入技术,将文本中的词语转换为向量表示,这样可以更好地表达词语之间的语义关系。

通过词嵌入技术,Senta模型可以更好地理解文本中的情感信息,从而提高

情感分类的准确性。

总的来说,Senta模型的原理主要基于深度学习和自然语言处理技术,通过对大规模文本数据的学习和词嵌入技术的运用,使得模型能够更好地理解文本中的情感信息,并进行准确的情感分类。

希望这些解析能够帮助你更好地理解Senta模型的原理。

ChatGPT技术的训练流程简述

ChatGPT技术的训练流程简述ChatGPT是一款基于开放AI公司所开发的语言模型GPT(Generative Pre-trained Transformer)的对话生成模型。

它通过训练大规模的语言数据集来学习语言的语法、语义和上下文,并能够生成流畅、连贯的对话回复。

在本文中,我们将简要介绍ChatGPT技术的训练流程。

ChatGPT的训练过程可以分为两个主要步骤:预训练和微调。

预训练阶段旨在让模型具备基本的语言理解和生成能力,而微调阶段则是针对具体的任务进行优化和调整。

在预训练阶段,ChatGPT使用了大量的无监督文本数据进行训练。

这些文本数据包括来自互联网的各种文章、新闻、博客等等。

通过使用Transformer架构,ChatGPT能够从这些海量数据中学习到语言的特征和规律。

预训练的目标是让模型能够理解和生成自然语言,以及具备一定的常识和推理能力。

在预训练过程中,ChatGPT通过自监督学习的方式进行训练。

它的训练目标是预测文本中缺失的部分,即通过上下文中的一部分来预测下一个词。

这样的预测任务可以促使模型学习到语言的上下文关系和语义含义。

通过不断重复这一训练过程,模型逐渐提高了对语言模式的理解和生成能力。

预训练完成后,ChatGPT进入微调阶段。

微调阶段的目标是将模型应用到特定的任务中,并根据任务需求进行一定的优化和调整。

这需要使用有人工标注的对话数据集进行训练。

在微调过程中,ChatGPT的输入是一个上下文和一个预期回复,而输出则是一个基于这个上下文生成的回复。

微调过程中的数据准备是关键的一步。

首先,对于每个对话,ChatGPT将上下文和预期回复拼接在一起作为模型的输入。

然后,使用一种特殊的标记来分隔不同的对话和回复,以帮助模型理解对话的结构和流程。

接下来,对数据进行适当的预处理,例如分词、编码等,以便于模型的处理。

微调阶段还需要定义一个合适的模型评估指标来衡量生成回复的质量。

通常情况下,人工评估人们对生成回复的满意度是一种常用的评估方式。

gpts概念

GPTs是Generative Pre-trained Transformers的缩写,中文可以称为“生成式预训练转换器”。

这是OpenAI推出的一种人工智能技术,主要用于自然语言处理任务,如对话生成、文本摘要、机器翻译等。

GPTs通过预训练(pre-training)的方式,在大量文本数据上进行学习,从而获得理解和生成自然语言的能力。

在首届OpenAI开发者大会上,OpenAI宣布允许用户构建自定义ChatGPT完成特定的个人和专业任务。

用户能快速创建自己专用版本的ChatGPT,可以用于帮助教孩子数学或解释棋盘游戏的规则。

另外,在最新论文中,OpenAI直接把GPTs称作general-purpose technologies (GPTs),即通用技术。

通用技术是指满足三个核心标准的技术——在时间上持续改进、在经济中普遍存在、并能产生相关创新的技术。

随着时间的推移,GPT在不断改进,因此满足了第一个标准。

llama2 训练要求

llama2 训练要求

Llama 2是一款由Meta开源的语言大模型,其训练要求主要包括以下几个方面:

训练数据:Llama 2的训练数据比Llama 1多了40%,上下文长度也翻倍。

预训练模型是在2万亿的token上训练的,训练语料库包含了来自公开可用资源的混合数据,并且不包括Meta产品或服务相关的数据。

模型架构:Llama 2采用了Llama 1中的大部分预训练设置和模型架构,包括标准Transformer架构、使用RMSNorm的预归一化、SwiGLU激活函数和旋转位置嵌入。

训练参数:在超参数方面,Meta使用AdamW优化器进行训练,其中β_1=0.9,β_2=0.95,eps=10^-5。

同时使用余弦学习率计划(预热2000步),并将最终学习率衰减到了峰值学习率的10%。

此外,Llama 2还开源了利用对话数据SFT后的Llama2-Chat 模型,进一步提升了模型在对话任务上的性能。

请注意,以上信息仅供参考,实际训练要求可能因具体任务和数据集的不同而有所差异。

同时,由于Llama 2是一款大型语言模型,其训练需要强大的计算资源和时间成本,因此在实际应用中需要充分考虑这些因素。

chatgpt 生成原理

chatgpt 生成原理

ChatGPT的生成原理是基于生成式预训练模型(Generative

Pre-trained Model),采用自回归的语言模型实现。

其训练过

程可以分为两个阶段:预训练和微调。

在预训练阶段,使用大规模文本数据进行自监督训练。

模型通过预测给定上下文的下一个词来学习语言的概率分布。

预训练中的输入数据是从互联网获取的各种无监督的文本数据,例如网页、书籍、维基百科等,并且通过掩码处理来生成自监督任务。

模型会通过尝试恢复被遮盖的部分(如被“[MASK]”代替

的词)来学习上下文的表示,从而使模型能够学习到丰富的语义和上下文信息。

在微调阶段,使用有监督的对话数据进行模型的属性微调,以确保模型在生成对话时可以更好地满足用户需求。

微调的目标是最大化对话数据集上的似然性,并采用束搜索算法(beam search)来生成回复建议。

生成过程中,用户输入的信息会作为输入传递给模型,模型会根据输入的上下文内容预测下一个最可能的词或短语,并将其作为模型的输出。

用户可以通过逐步交互来与ChatGPT进行

对话,实现问答、聊天等功能。

总的来说,ChatGPT通过预训练和微调阶段的训练来学习语言知识和上下文理解,使其具备一定的智能水平,可以生成连贯、合理的回复。

发展基于“语义检测”的低参数量、多模态预训练电池通用人工智能模型

发展基于“语义检测”的低参数量、多模态预训练电池通用人工智能模型吴思远;李泓【期刊名称】《储能科学与技术》【年(卷),期】2024(13)4【摘要】ChatGPT的出现意味着一种以“预训练+微调”为主的新科研范式诞生,以OpenAI为代表的企业正朝着训练通用人工智能(AGI)模型的路线前进,AGI意味着人工智能具备超越人类智力并解决通用性问题的能力,其是为了解决通用问题并具有强大的自学能力来促进人类社会发展。

然而OpenAI等模型仍然是以文本为主结合图像等作为输入,对于电池体系来说,文本信息是少数的,更多的是温度、电压-电流曲线等的多模态数据,其所关注的结果包括电池荷电态、电池健康度、剩余寿命和是否出现电池性能跳水的拐点,甚至包括无数据情况下电池二次(梯度)利用的健康度评估。

这意味着ChatGPT的路线虽然也可能解决电池体系的问题,但是以文本为主的样式或许有些“杀鸡用牛刀”,即使未来OpenAI的AGI可能解决当前电池存在的问题,但是在模型参数和输入方面与电池本质不符会使得模型参数量巨大而不适合电池离线端评估。

对于电池体系的AGI,应该有自己独特的“文本语言”即理解电池运行过程中所发生的一切物理、化学过程以及其之间的关联,从而实现通用性并为后续全固态电池量产上车做铺垫。

本文展望了在电池体系发展AGI过程中应该重新设计模型架构,特别在特征表示、数据结构设计、预训练方法、预训练过程设计和实际任务微调等需要重新设计。

此外,相较于运行在服务器端的大模型,发展低参数量特别是离线的模型对于实时预测和基于我国国情及国际形势发展是十分必要的。

本文主要讨论了发展基于“语义检测”的低参数量、多模态预训练电池通用人工智能模型所需要经历的几个阶段、可能面临的困难和评价指标,同时给出中国科学院物理研究所(以下简称物理所)在电池大模型在预训练、微调和测评三个方面“三步走”计划中的规划和可能线路。

【总页数】9页(P1216-1224)【作者】吴思远;李泓【作者单位】中国科学院物理研究所北京清洁能源前沿研究中心;中国科学院物理研究所凝聚态物质科学数据中心【正文语种】中文【中图分类】TP391.77;TP391.9【相关文献】1.基于预训练模型和联合调参的改进训练算法2.基于双预训练Transformer和交叉注意力的多模态谣言检测3.基于预训练和多模态融合的假新闻检测4.基于预训练模型和编码器的图文跨模态检索算法因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

4. Where and when is the SREA process applicable? (p. 10)

2. Why do we have the SREA process?

3. 4. 5. What is the risk of not following the SREA process? Where and when is the SREA process applicable? Understand the SREA process steps.

6. 7.

Understand the linkage of SREA to Resourcing. Be able to locate the SREA materials.

8.

9.

Know where the SREA records are kept.

Know who to contact if you have questions.

5. Understand the SREA process steps (p. 12)

a) Production Components - Manufacturing Process and Site Location Changes (p. 14) b) Production Components - Design changes or Requests to ship parts/product made to a temporary engineering specification (p. 32) c) Service-Unique Components - Supplier Part Design, Manufacturing Process and Site/Location Change (p. 42)

a) b) c) Production Components - Manufacturing Process and Site Location Changes Production Components - Design changes or Requests to ship parts/product made to a temporary engineering specification Service-Unique Components - Supplier Part Design, Manufacturing Process And Site/Location Change

6 of 59

© 2006 Ford Motor Company

January 2008

FORD CONFIDENTIAL*

Supplier Request for Engineering Approval (SREA)

Learning Objectives

1. 2. What is a Supplier Request for Engineering Approval? Why do we have the SREA process?

* NOTE: SREA approval does not indicate an approval to ship

parts/product. PSW (Part Submission Warrant) approval per PPAP and any Ford-specified functional trails for production parts, as appropriate, are required prior to shipping parts/product.

2. 3. Why do we have the SREA process? What is the risk of not following the SREA process?

4.

5.

Where and when is the SREA process applicable?

Understand the SREA process steps.

January 2008

FORD CONFIDENTIAL*

3 of 59

© 2006 Ford Motor Company

Supplier Request for Engineering Approval (SREA)

1. What is a Supplier Request for Engineering Approval?

January 2008

FORD CONFIDENTIAL*

5 of 59

© 2006 Ford Motor Company

Supplier Request for Engineering Approval (SREA)

2. Why do we have the SREA process?

• To prevent external supplier-initiated changes adversely affecting our product quality or manufacturing operations. • PPAP (Production Part Approval Process) requires notification to Ford of all supplier-initiated changes to the supplier manufacturing process, site or part. • The SREA is the communication tool used by Ford Motor Company to meet the external supplier-initiated change notification requirement of PPAP.

An SREA is an external Supplier Request to obtain Ford Engineering, Ford plant (e.g. Plant Vehicle Team - PVT, or Powertrain PD Resident), and Ford Purchasing (buyer and / or STA) Approval for a plan to implement* a proposed external supplier-initiated manufacturing process or site change.

6. Understand the linkage of SREA to Resourcing (p.53) 7. Be able to locate the SREA materials (p. 55) 8. Know where the SREA records are kept (p. 57) 9. Know who to contact if you have questions (p. 59)

2 of 59

© 2006 Ford Motor Company

January 2008

FORD CONFIDENTIAL*

Supplier Request for Engineering Approval (SREA)

Learning Objectives 1. What is a Supplier Request for Engineering Approval?

4 of 59

© 2006 Ford Motor Company

January 2008

FORD CONFIDENTIAL*

Supplier Request for Engineering Approval (SREA)

Learning Objectives

1. What is a Supplier Request for Engineering Approval?

Where the supplier does not have access to WERS or equivalent, an SREA can also be used to communicate a supplier-initiated design change to Ford parts/products or to request permission to ship parts/products made to a temporary engineering specification.

Supplier Request for Engineering Approval (SREA)

Global SREA

(Supplier Request for Engineering Approval)

Cascade Training for: STA, Design Engineering, Plant (PD) Engineering, Buyers, Suppliers, Production, FCSD

1 of 59

© 2006 Ford Motor Company

January 2008

FORD CONFIDENTIAL*

Supplier Request for Engineering Approval (SREA)

Learning Objectives

1. What is a Supplier Request for Engineering Approval? (p. 4)

3. What is the risk of not following the SREA process?