RHCS

国内linux下ha高可用软件简单介绍

国内linux下ha高可用软件简单介绍gobeta发布于2008-3-24 | 次阅读字号: 大中小(网友评论0条) 我要评论1、vcs,感觉bz对vcs有居多误解,我知道从03年起,zte/hw在基本上大部分电信项目上使用了vcs,而且基本上都是核心应用,vcs的稳定性毋庸置疑,唯一的缺点在于贵。

另外vcs 需要suse非标准内核,这是让我非常郁闷的地方2、红旗的ha,这里有人题到了,我说一下,最早红旗oem的叫rsf-1的ha软件,这个很粗糙,而且相当不稳定(在某邮政项目被用户投诉致死),后来改oem nec的cluster pro(lite),这个功能上还可以,几年前用过,当时只有for windows的客户端,让我很郁闷,不过现在有基于web界面的客户端。

3、turboha,turbo ha在国内05年前还行,在zte的某些非关键项目上因为成本的考虑,使用了一些turbo ha6.0的产品,后来主要开发人员都离开了,6.5也是很久才推出,不算一个很成熟的产品。

4、rhcs/heartbeat,之所以把这两个ha并列出来,是他们具有相同的特点,功能花哨无比,但是真用起来却不是那么回事,hb的resource.d n年没有更新过,大部分时间你需要自己去改resource.d里面的脚本;rhcs现在底层cluster membership用了openais的东东,上层脚本也变得和heartbeat 一样,使用ocf标准,但是我不能忍的是,现在执行每个脚本的stop操作后,都要sleep 10s,这是一个非常sb的设计。

gfs在国内某些商用局开使用起来,ut在杭州网通iptv就在用,功能和性能都还可以,但是也是问题一大堆。

另外,novell据说会力捧heartbeat,以对抗rhcs,个人不看好。

5、fujitsu&simense,这个ha软件刚进中国,我做了一些测试和评估,毕竟是德国人做得,非常严谨和规范,只不过中规中矩,而且价格上没有太大的优势,这个软件包含这loading balance 的功能模块,是我见到的linux下为数不多的不是基于lvs的负载均衡解决方案(ibm was edge server好像也有负载均衡功能,但是这个是通用的)6、roseha,因为价格的关系,roseha在低端还是有很多人用,说是在之前的版本很糟糕,但是2.0之后,功能还可以,配置也还算方便。

Cluster安装手册

2、给集群命名。注意一个局域网内不能有两个重名的 Cluster。 � 在 RHCS5 里默认使用多播心跳,用户选中 “Custom Configure Multicast”可自定 义多播地址。 � 选择 “Use a Quorum Disk”来配置磁盘心跳,本项目由于 RDAC 链路切换时间长的 问题需要手动配置,具体方法见下面“8、添加磁盘心跳”部分。

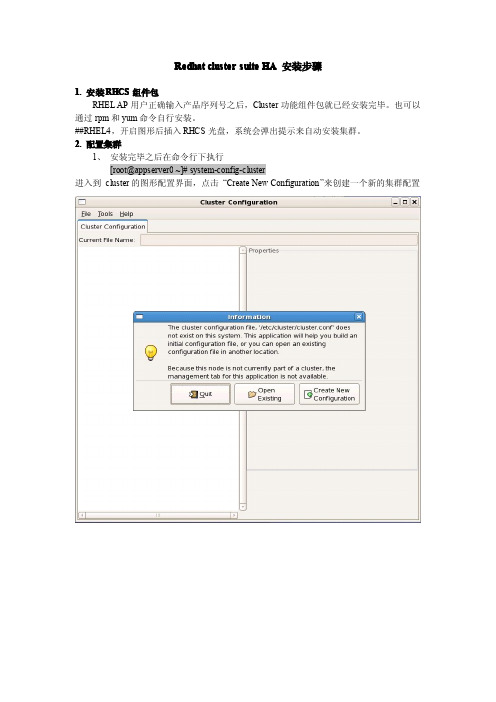

Redhat cluster suite HA 安装步骤

1. 安装 RHCS 组件包 RHEL AP 用户正确输入产品序列号之后,Cluster 功能组件包就已经安装完毕。也可以 通过 rpm 和 yum 命令自行安装。 ##RHEL4 ,开启图形后插入 RHCS 光盘,系统会弹出提示来自动安装集群。 2. 配置集群 1、 安装完毕之后在命令行下执行 [root@appserver0 ~]# system-config-cluster 进入到 cluster 的图形配置界面,点击 “Create New Configuration”来创建一个新的集群配置

<cluster alias="tomcat_cluster" config_version="21" name=" tomcat_cluster "> <quorumd device="/dev/sde1" interval="3" label="gfs_voting" min_score="2" tko="30" votes="10"> <heuristic interval="2" program="ping -c1 -t1 10.199.75.225" score="2" tko="20"/> </quorumd> 这样保证在 rdac在切换链路的时候不会因为时间过长,超过 qdisk的timeout时间后qdisk将本机 重启。现在的 timeout为3s * 30 = 90s 然后加入下面行,这是为了保证在 qdisk在反应时间里,集群cman不会因为心跳的 timeout而触发 fence动作将节点重启。 <cman deadnode_timeout="135"/> 修改完毕之后,将配置文件手动拷贝到集群所有节点上 # scp /etc/cluster/cluster.conf LRS02:/etc/改 hosts 文件,在终端输入 vi /etc/hosts,修改里面 ip 对应关系。 4)system-config-cluster 修改配置( fence 设备配置需要更改 ip 为新更改的 BMC 地址,另外 资源中的 服务虚 拟 IP ),将配 置文件 send 到另一台 机器 , scp /etc/cluster/cluster.conf sjzportal2:/etc/cluster 5)chkconfig cman on chkconfig rgmanager on 重启机器

rhca考试科目

rhca考试科目RHCA(RedHatCertifiedArchitect)是RedHat公司推出的一项专业认证考试,它是一项面向有丰富实践经验的IT专业人员,旨在考核他们在Red Hat产品,特别是Red Hat Enterprise Linux操作系统上的有效解决方案的能力,考试科目包括:1. Red Hat Enterprise Linux统管理:这个科目考查RHCA的考试者对Linux的操作,包括安装、设置和管理Red Hat Enterprise Linux服务器,包括系统配置、文件系统管理、软件包管理、用户管理、资源监视、网络管理等。

2. Red Hat证系统管理员(RHCSA):这个科目是RHCSA考试,考试者需要掌握和操作Linux系统的熟练程度,例如安装、设置和管理Linux系统,以及了解Linux的基本命令。

3. Red Hat Certified Engineer(RHCE):这个科目是RHCE考试,考试者需要掌握如何在Linux环境下设计、配置和管理网络,以及安全的公共访问和远程管理。

4. Red Hat Certified Security Expert(RHCSE):这个科目是RHCSE考试,考试者需要掌握如何通过安全控制措施来防止、监控和保护系统。

5. Red Hat Certified Virtualization Administrator(RHCVA):这个科目是RHCVA考试,考试者需要掌握如何设计、安装、配置和管理虚拟化解决方案,以及使用虚拟化的相关技术。

此外,Red Hat还提供了一些其他的考试,例如Red Hat SystemAdministration III(RHEL 7),Red Hat Networking and Security、Red Hat Storage and Virtualization,和Red Hat Server Hardening 等考试。

基于RHEL6的RHCS红帽集群套件应用

毛毛雨:AM 3885999RHCS 基于 RHEL6.0 x86_64(实验教程) 实验说明:所用的RHEL 版本均为 6.0 x86_64,宿主机支持虚拟化,内存不小于4G。

实验拓扑如下:在本实验中,为了节省资源将 ISCSI-Target 也放到 manager 一个机器上了。

vmware 创建一个虚拟机,内存3G,按下图设置使得虚拟机也支持虚拟化,vmware workstation 版本不低于7:蓝狐Linux系统培训中心毛毛雨:AM 3885999毛毛雨:AM 3885999蓝狐Linux 系统培训中心毛毛雨:AM 3885999在这个虚拟机中装好 rhel6,ip192.168.0.200,作为 RHCS 的管理端,继续在其上安装 kvm,kvm 的安装请查看我之前写的关于 kvm 文档,kvm 安装好后,创建两 个 vm(virtual machine) ,桥接到 192.168.0.200 的物理网卡上,vm 上安装好 rhel6,ip 分别为192.168.0.201和 192.168.0.202,作为 RHCS 的节点,这样的拓扑设计 的原因是我们可以在 RHCS 中使用 fence-virsh 来fence 掉 kvm 管理的 RHCS 故障节点。

使用hostname 指令设置主机名,想重启之后生效别忘了/etc/sysconfig/network,因为本环境中没有使用DNS,所以在manager 上设置/etc/hosts 添加如下三行, 再 scp 到 web1 和web2。

[root@manager ~]# vim /etc/hosts 127.0.0.1 localhost.localdomain localhost ::1localhost6.localdomain6 localhost6192.168.0.200 manager 192.168.0.201 web1 192.168.0.202web2manager、web1、web2 均关闭selinux、iptables。

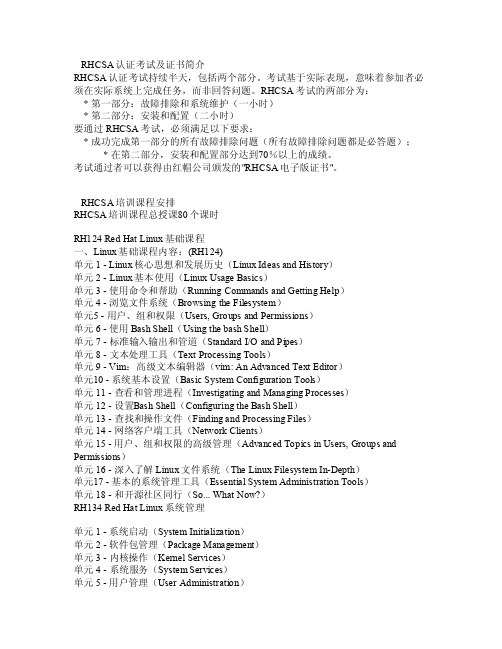

RHCSA认证考试及证书简介

RHC SA认证考试及证书简介RHC SA认证考试持续半天,包括两个部分。

考试基于实际表现,意味着参加者必须在实际系统上完成任务,而非回答问题。

RH CSA考试的两部分为: * 第一部分:故障排除和系统维护(一小时) * 第二部分:安装和配置(二小时)要通过RH CSA考试,必须满足以下要求:* 成功完成第一部分的所有故障排除问题(所有故障排除问题都是必答题); * 在第二部分,安装和配置部分达到70%以上的成绩。

考试通过者可以获得由红帽公司颁发的"RHC SA电子版证书"。

RHCSA培训课程安排RHC SA培训课程总授课80个课时RH124 Red HatLinux基础课程一、Li nux基础课程内容:(RH124)单元1 -Linux核心思想和发展历史(Linux Idea s and Hist ory)单元2- Lin ux基本使用(Lin ux Us age B asics)单元3 - 使用命令和帮助(Run ningComma nds a nd Ge tting Help)单元4 - 浏览文件系统(Brow singthe F ilesy stem)单元5 - 用户、组和权限(User s, Gr oupsand P ermis sions)单元6 - 使用Bash Shel l(Usi ng th e bas h She ll)单元7 -标准输入输出和管道(Stan dardI/O a nd Pi pes)单元8- 文本处理工具(T ext P roces singTools)单元9 - V im:高级文本编辑器(vim: An A dvanc ed Te xt Ed itor)单元10 - 系统基本设置(Basi c Sys tem C onfig urati on To ols)单元11 - 查看和管理进程(Inve stiga tingand M anagi ng Pr ocess es)单元12- 设置B ash S hell(Confi gurin g the Bash Shel l)单元13 -查找和操作文件(F indin g and Proc essin g Fil es)单元14- 网络客户端工具(Netwo rk Cl ients)单元15 -用户、组和权限的高级管理(Ad vance d Top ics i n Use rs, G roups andPermi ssion s)单元16 -深入了解Linux文件系统(The L inuxFiles ystem In-D epth)单元17 - 基本的系统管理工具(E ssent ial S ystem Admi nistr ation Tool s)单元18 -和开源社区同行(S o...WhatNow?)RH134 Re d Hat Linu x 系统管理单元1 - 系统启动(S ystem Init ializ ation)单元2 - 软件包管理(Packa ge Ma nagem ent)单元3- 内核操作(Ker nel S ervic es)单元4 -系统服务(Syst em Se rvice s)单元5 -用户管理(UserAdmin istra tion)单元6 - 文件系统管理(Files ystem Mana gemen t)单元7 -高级文件系统管理(A dvanc ed Fi lesys tem M anage ment)单元8 - 网络设置(Ne twork Conf igura tion)单元9 - 安装(Inst allat ion)单元10 - Xe n虚拟化技术(Vir tuali zatio n wit h Xen)单元11 -故障排除(Troub lesho oting)。

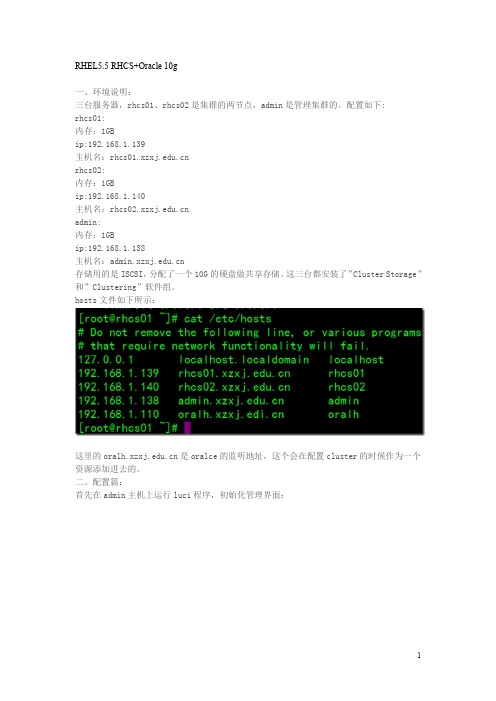

RHEL5.5 RHCS+Oracle 10g安装配置

RHEL5.5 RHCS+Oracle 10g一、环境说明:三台服务器,rhcs01、rhcs02是集群的两节点,admin是管理集群的。

配置如下:rhcs01:内存:1GBip:192.168.1.139主机名:rhcs02:内存:1GBip:192.168.1.140主机名:admin:内存:1GBip:192.168.1.138主机名:存储用的是ISCSI,分配了一个10G的硬盘做共享存储。

这三台都安装了”Cluster Storage”和”Clustering”软件组。

hosts文件如下所示:这里的是oralce的监听地址,这个会在配置cluster的时候作为一个资源添加进去的。

二、配置篇:首先在admin主机上运行luci程序,初始化管理界面:这里会创建登录集群管理界面的帐号以及设置密码信息,完了后提示重启luci程序:重启完了后,会提示如何进入管理界面,按照上面的提示登入luci管理界面:1、创建一个cluster框架:点击cluster->create a new cluster,输入下面信息: Cluster Name:ora-clusterNode Hostname:然后点击submit,本的框架就建立好了,如下图所示:接着/etc/cluster/fence_xvm.key文件:然后点击Cluster->Cluster list->查看ora-cluster 的状态,如下图所示:cman,rgmanager 在运行中并且是在系统启动的时候自动启动。

如图所示:如果cman和rgmanager没有运行,则可以在系统中使用service命令启动。

然后点击Update node daemon properties,系统会更新进程的状态。

2、设置共享存储:点击Storage->system list->或者,如图:这里之前认到的是sdb,创建完成后重启了下机器就变成sdd了,不去理会它。

ESXi5+VM+RHCS环境构筑时遇到的问题及解决方法

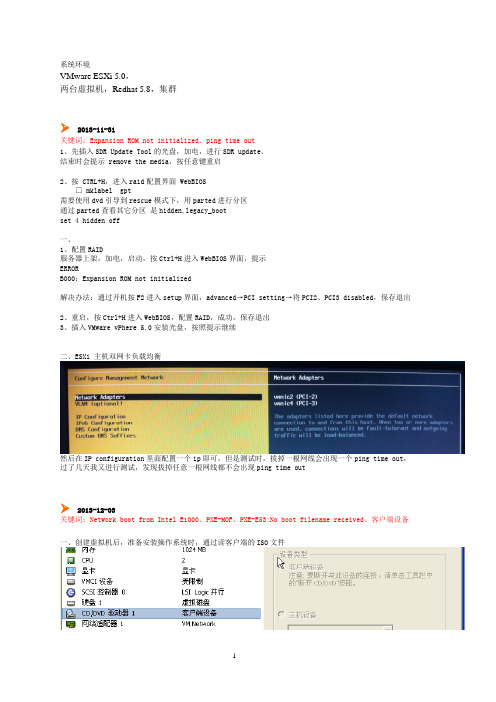

系统环境VMware ESXi 5.0,两台虚拟机,Redhat 5.8,集群2013-11-31关键词:Expansion ROM not initialized、ping time out1、先插入SDR Update Tool的光盘,加电,进行SDR update。

结束时会提示 remove the media,按任意键重启2、按 CTRL+H,进入raid配置界面 WebBIOS□ mklabel gpt需要使用dvd引导到rescue模式下,用parted进行分区通过parted查看其它分区是hidden,legacy_bootset 4 hidden off一、1、配置RAID服务器上架,加电,启动,按Ctrl+H进入WebBIOS界面,提示ERRORB000:Expansion ROM not initialized解决办法:通过开机按F2进入setup界面,advanced→PCI setting→将PCI2、PCI3 disabled,保存退出2、重启,按Ctrl+H进入WebBIOS,配置RAID,成功,保存退出3、插入VMware vPhere 5.0安装光盘,按照提示继续二、ESXi 主机双网卡负载均衡然后在IP configuration里面配置一个ip即可,但是测试时,拔掉一根网线会出现一个ping time out,过了几天我又进行测试,发现拔掉任意一根网线都不会出现ping time out2013-12-03关键词:Network boot from Intel E1000、PXE-MOF、PXE-E53:No boot filename received、客户端设备一、创建虚拟机后,准备安装操作系统时,通过读客户端的ISO文件启动时一直报下面的错误Network boot from Intel E1000PXE-MOFPXE-E53:No boot filename received解决方法如下:you need to click the "connected" and "connect at power on" in the right top corner in order to make the iso to mount properly.After you click "connect at power on", reboot the VM and it should boot from the iso.如果还出现上面提示时,点击回车,就会进入安装界面第二种解决方法,启动虚拟机后按F2进入BIOS设置,删除掉network boot选项,通过按+/-号将选项移到如下图位置如果还不行就把网卡全删了,等安装完之后再添加二、安装系统选择安装包后,会有一个Transferring的过程这种方式安装需要更久的时间,200分钟左右2013-12-04关键词:ESXi Shell、linux resuce模式分区、put: failed to upload ***.iso. Operation unsupported、Operating System not found一、开启ESXi Shell访问,将ISO文件先上传至ESXi 服务器,参考文档《[精]打开VMware ESXi 5.0 上的SSH 支持.org.htm》二、使用VMware Client端的ISO文件安装OS好慢啊啊啊啊三、先通过iso文件引导到linux resuce模式下进行硬盘分区,但是分完后exit,重新启动虚拟机,一直黑屏,没动静,如下图,试了两遍都是这样用这种读取ISO的方式也不行,最后把分区删了,重新安装,在安装过程中再进行分区四、通过sftp向ESXi服务器上传iso文件报错,其实已经上传成功sftp> cd /vmfs/volumes/datastore1sftp> lcd D:\03_software\01worksoft\linux_isosftp> put RRedhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.isorhel-server-5.7-i386-dvd.iso rhel-server-5.7-x86_64-dvd.isorhel-server-6.2-x86_64-dvd.isosftp> put Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.isoUploading Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso to /vmfs/volumes/529ca399-d0838ebe-bd5c-94de80e79249/Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso 100% 4028944KB 8777KB/s 00:07:39 put: failed to upload D:/03_software/01worksoft/linux_iso/Redhat.Enterprise.Linux.v5.UPDATE.8.X86_64.DVD-HOTiSO.iso. Operation unsupported.sftp>sftp>五、通过编辑虚拟机设置,指定ISO路径,好像没有,在启动时仍然提示Operating System not found,需要在控制台重新指定,然后回车2013-12-05关键词:文件被锁定,无法访问、Unable to establish an SSL connection to TESTDB1:11111:ClientSocket(homename,port,timeout):connect()failed、Proposed updated config file does not have greate version number.、Error locking on node TESTDB2: Volume group for uuid not found、/boot: UNEXPECTED INCONSISTENCY一、TESTDB2新增了一块硬盘,使用已有的,指向TESTDB1的100GB硬盘,保存设置,启动TESTDB2时,提示如下正确的设置方法如下1、新增共享硬盘,命令如下cd /vmfs/volumes/datastore1/TESTDB-SHAREvmkfstools -c 102400m -a lsilogic -d eagerzeroedthick TESTDB_SHARE.vmdk2、将共享硬盘添加到2台虚拟机,按照文件《Esxi下虚拟机共享磁盘.pdf》添加3、修改TESTDB1.vmx和TESTDB2.vmx文件,追加以下内容sched.scsi1:0.shares="normal"disk.EnanbleUUID="true"disk.locking="false"diskLib.datacacheMaxSize="0"diskLib.datacacheMaxReadAheadSize="0"diskLib.datacacheMinReadAheadSize="0"diskLib.datacachePageSize="4096"diskLib.MaxUnsynceWrites="0"4、启动2台虚拟机,均可以正常启动二、节点与luci通信异常通过https://192.168.144.201:8084访问节点1,添加cluster时报错Unable to establish an SSL connection to TESTDB1:11111:ClientSocket(homename,port,timeout):connect()failed 原因分析This error occurs when the luci server cannot communicate with the ricci agent. Verify that ricci is installed and started on each node. Ensure that the firewall has been configured correctly, and that Security-Enhanced Linux (SELinux) is not the issue. Check /var/log/audit/audit.log for details on SELinux issues.安装了ricci后问题解决,前提是需要安装其他依赖包[root@TESTDB2 Server]# rpm -ivh oddjob*Preparing... ########################################### [100%]1:oddjob ########################################### [ 20%]2:oddjob-libs ########################################### [ 40%]3:oddjob-libs ########################################### [ 60%]4:oddjob-devel ########################################### [ 80%]5:oddjob-devel ########################################### [100%][root@TESTDB2 Server]#[root@TESTDB2 Server]#[root@TESTDB2 Server]# cd -/var/ftp/pub/Cluster[root@TESTDB2 Cluster]# rpm -ivh modcluster-0.12.1-7.el5.x86_64.rpmPreparing... ########################################### [100%]1:modcluster ########################################### [100%][root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]# rpm -ivh ricci-0.12.2-51.el5.x86_64.rpmPreparing... ########################################### [100%]1:ricci ########################################### [100%][root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]#[root@TESTDB2 Cluster]# service ricci statusricci is stopped[root@TESTDB2 Cluster]# service ricci startStarting oddjobd: [ OK ]generating SSL certificates... doneStarting ricci: [ OK ][root@TESTDB2 Cluster]#三、创建failover域时报错Proposed updated config file does not have greate version number.报错原因:之前通过system-config-cluster工具配置了cluster,并做了变更,导致cluster.conf文件中的version变成2,后来是把conf文件手工删除,通过luci的web界面进行配置的,导致报错,解决方法:手工将conf文件中的version由1改为2,在submi,正常结束四、在节点1,pvcreate,vgcreate正常,在lvcreate时报错[root@TESTDB1 23:20:29 by-id]# lvcreate -l +100%FREE -n lvdbdata vgdbdataError locking on node TESTDB2: Volume group for uuid not found: nbSOLD3XdROA1d08hvwvFOpNCFTywRyOnqSZpwxAQQ1N41PtxsjOLJ35Lye5NEGgFailed to activate new LV.原因待查五、重启服务器,在启动时TESTDB1报错:/boot: UNEXPECTED INCONSISTENCY用fsck /dev/sdb修复时报错后来改用fsck直接修复,按照提示输入y,一路回车,修复完毕,重启正常,但是shutdown后在startup时仍然报同样的错误,fsck修复后又能重启,再shutdown后在startup时还报错,删了/dev/sdb的其他分区,shutdown后在startup时正常,估计和分区有关系六、TESTDB2启动时有如下报错Scsi_reserve failed原因待查,未解决2013-12-06关键词:0x80070570、createrepo cannot access parent directories: No such file or directory安装windows报错,错误代码0x80070570、原因未知,换了一个iso文件,问题解决0x80070570使用windows2008自带的工具进行硬盘分区,均没有解决该报错问题,重新新建了一个虚拟机,换了一个英文版的iso文件,正常安装又换了一个中文版的介质,也能正常安装,有问题的介质是重新构筑DB服务器,从testap拷贝2个虚拟机一、建立分组文件[root@TEST-DB1 15:52:28 repodata]# createrepo -g /var/ftp/pub/Cluster/repodata/comps-rhel5-cluster.xml /var/ftp/pub/Clustershell-init: error retrieving current directory: getcwd: cannot access parent directories: No such file or directory Traceback (most recent call last):File "/usr/share/createrepo/genpkgmetadata.py", line 722, in ?main(sys.argv[1:])File "/usr/share/createrepo/genpkgmetadata.py", line 592, in maincmds, directories = parseArgs(args)File "/usr/share/createrepo/genpkgmetadata.py", line 431, in parseArgscmds['basedir'] = os.getcwd()OSError: [Errno 2] No such file or directory[root@TEST-DB1 15:53:47 repodata]#重新再执行一遍就没问题了二、rhcs组件安装完毕后,启动报错可以先无视,等创建完cluster后,报错消失,据说是少了cluster.conf文件三、需要先停止luci服务,执行luci_admin init,创建用户后,才能登陆https://192.168.144.201:8084/,luci只用在主节点配就可以了在luci界面create a cluster后,/etc/cluster下面会产生一个cluster.conf文件2013-12-09关键词:starting killall、在节点1上可以看到qdisk信息,在节点2上就看不到、WARNING: Falling back to local file-based lockingclurgmgrd: [6279]: <err> startFilesystem: Could not match /dev/mapper/vg_db-lv_db with a real device一、是系统关机时 hang在starting killall这里不动,只能强制关机原因:系统有一些服务器需要停止,解决办法,在脚本/etc/init.d/killall中添加红色字体三行,重新关机定位需要停止的服务[root@TEST-DB1 ~]# cat /etc/init.d/killall#! /bin/bash# Bring down all unneeded services that are still running (there shouldn't# be any, so this is just a sanity check)echo "Starting /etc/init.d/killall" > /var/log/killall.logcase "$1" in*start);;*)echo $"Usage: $0 {start}"exit 1;;esacfor i in /var/lock/subsys/* ; doecho "Found $i" >> /var/log/killall.log# Check if the script is there.[ -f "$i" ] || continue# Get the subsystem name.subsys=${i#/var/lock/subsys/}# Networking could be needed for NFS root.[ $subsys = network ] && continue# Bring the subsystem down.if [ -f /etc/init.d/$subsys.init ]; then/etc/init.d/$subsys.init stopelif [ -f /etc/init.d/$subsys ]; then/etc/init.d/$subsys stopelserm -f "$i"fidoneecho "Finished /etc/init.d/killall script" >> /var/log/killall.log在killall.log中记录了如下信息[root@TEST-DB1 log]# more killall.logStarting /etc/init.d/killallFound /var/lock/subsys/clvmd继续检查发现clvmd服务是开机启动,并且已经启动,由于此时还没有配置lvm,所以猜测是该原因导致,于是手工停止clvmd 服务,重新关机,可以正常关闭,问题解决[root@TEST-DB1 subsys]# /etc/init.d/clvmd statusclvmd (pid 2836) is running...Clustered Volume Groups: (none)Active clustered Logical Volumes: (none)二、之前添加qdisk,是从一块共享硬盘上分区出来的一块,在节点1上执行mkqdisk -c /dev/sdb1 -l myqdisk后,在节点1上可以看到qdisk信息,在节点2上就看不到解决办法:单独创建一块共享磁盘给2个节点作为qdisk使用节点1执行:mkqdisk -c /dev/sdc -l myqdisk节点1和2执行: mkqdisk -L三、创建共享文件系统Pvcreate时告警[root@TEST-DB1 16:30:29 ~]# pvcreate /dev/sdbconnect() failed on local socket: No such file or directoryInternal cluster locking initialisation failed.WARNING: Falling back to local file-based locking.Volume Groups with the clustered attribute will be inaccessible.Writing physical volume data to disk "/dev/sdb"Physical volume "/dev/sdb" successfully created[root@TEST-DB1 16:30:37 ~]#执行service clvmd start后,在重新创建,告警消失四、第一次创建gfs的资源,把device写成/dev/mapper/vg_db-lv_db,然后启动service时报错,Dec 9 17:51:17 TEST-DB1 kernel: dlm: connecting to 2Dec 9 17:51:17 TEST-DB1 kernel: dlm: got connection from 2Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Starting stopped service service:DB-ServiceDec 9 17:51:23 TEST-DB1 clurgmgrd: [6279]: <err> startFilesystem: Could not match /dev/mapper/vg_db-lv_db with a real deviceDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> start on fs "FS-DATA" returned 2 (invalid argument(s)) Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <warning> #68: Failed to start service:DB-Service; return value: 1 Dec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Stopping service service:DB-ServiceDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <notice> Service service:DB-Service is recoveringDec 9 17:51:23 TEST-DB1 clurgmgrd[6279]: <warning> #71: Relocating failed service service:DB-ServiceDec 9 17:51:24 TEST-DB1 clurgmgrd[6279]: <notice> Service service:DB-Service is stopped解决办法:改成/dev/vg_db/lv_db,问题解决2013-12-10关键词:cluster资源组切换时共享文件系统不能自动umount、db2数据库状态Operable、一、clusvcadm -r DB-Service切换测试,资源组中的ip和nfs服务都能从一个节点切换到另一个节点,共享文件系统/dbdata从一个节点切到另一个节点后,原节点上不会自动umount,导致文档系统在2个节点上都mount原因分析:创建共享文件系统时只在节点1上执行了gfs_mkfs -p lock_dlm -t DB_Cluster:dbdata -j 2 /dev/vg_db/lv_db,在节点2上也执行了一些,但是问题没有解决补充一下,文件系统是GFS,在网上找的的资料《/uid-26931379-id-3558604.html》GFS是RHCS为集群系统提供的一个存储解决方案,它允许集群多个节点在块级别上共享存储,每个节点通过共享一个存储空间,保证了访问数据的一致性,更切实的说,GFS是RHCS提供的一个集群文件系统,多个节点同时挂载一个文件系统分区,而文件系统数据不受破坏,这是单一的文件系统,例如EXT3、EXT2所不能做到的。

石英多模光纤共分8种

1、双包层光纤2、硬树脂包层光纤3、硅橡胶包层光纤4、聚酰亚胺涂层光纤5、侧发光光纤6、锥度光纤7、氟涂层光纤8、耐辐照光纤一、双包层光纤(HCS)1.技术说明石英双包层光纤按光谱传输范围分为紫外石英双包层光纤(UVHCS)和红外石英双包层光纤(IRHCS);数值孔径(NA):0.22±0.02、0.27±0.02;芯皮比(CCDR):1:1.04、1:1.05、1:1.1、1:1.2、1:1.4。

2.光纤光谱图如下:传输范围:UVHCS:190nm~1200nm;IRHCS:350nm~2500nm 透过率(波长632.8nm):≧99.7%/m;长期使用温度(丙烯酸树脂涂层):-40℃~80℃长期弯曲使用半径:300D(D为光纤包层外径);短期弯曲使用半径:100D(D为光纤包层外径);3.光纤结构图:1——光纤芯层(通光层)纯石英材料2——光纤皮层(光学包层)石英材料3——光纤涂覆层(保护层)树脂材料4.产品规格型号UVHCS系列规格芯径(μm)±2%包层外径(μm)±2%涂覆外径(μm)±5%UVHCS100/110100110180 UVHCS105/125105125240 UVHCS192/200192200245 UVHCS200/220200220280 UVHCS288/300288300500 UVHCS385/400385400550 UVHCS400/420400420600 UVHCS400/440400440600 UVHCS480/50048050700 UVHCS577/600577600900UVHCS600/630600630900 UVHCS800/8408008401200 UVHCS960/100096010001400 UVHCS1000/1100100011001400IRHCS系列规格芯径(μm)±2%包层外径(μm)±2%涂覆外径(μm)±5%IRHCS50/12550±2%125±2%245±5% IRHCS62.5/12562.5±2%125±2%245±5% IRHCS192/200192±2%200±2%245±5% IRHCS200/220200±2%220±2%280±5% IRHCS200/240200±2%240±2%400±5% IRHCS300/330300±2%330±2%500±5% IRHCS400/440400±2%440±2%600±5% IRHCS600/660600±2%660±2%900±5% IRHCS800/840800±2%840±2%1200±5% IRHCS800/880800±2%880±2%1300±5%5.订货须知:通光径在100~1000μm的特殊规格光纤可以根据要求定制。

RHCS双机调测指导书指导书V1.1_091212

RHCS双机调测指导书华为技术有限公司版权所有侵权必究RHCS双机调测指导书指导书文档密级:内部公开修订记录RHCS双机调测指导书指导书文档密级:内部公开目录第1章安装规划 (1)1.1实例说明 (1)1.2安装环境 (1)1.2.1 硬件环境 (1)1.2.2 操作系统 (1)1.3 安装规划 (1)第2章系统安装配置 (5)2.1 系统安装 (5)2.1.1 操作系统安装 (5)2.1.2 RHCS安装 (15)2.2 配置系统环境 (16)2.2.1 打开telnet服务 (16)2.2.2 开启root用户Xmanager远程登录 (17)2.2.3 缩短内核引导超时限度 (18)2.3 HP ILO卡配置 (18)第3章双机调测 (23)3.1 配置双机 (23)3.2 集群管理 (32)3.2.1 集群启动和关闭 (32)3.2.2 显示群集和服务状态 (32)RHCS双机调测指导书指导书文档密级:内部公开关键词:RHCS、Redhat、Liunx、DHCP、DNS、Cluster摘要:RHCS双机调测指导书介绍了如何安装redhat操作系统和RHCS集群软件,并通过配置实例介绍了RHCS双机调测过程,旨在对工程师的开局和维护有指导作用。

缩略语清单:RHCS:Redhat Cluster Suite参考资料清单:RHCS双机调测指导书指导书文档密级:内部公开第1章安装规划1.1 实例说明本文以两台HP服务器搭建HTTP服务双机为例,并使用最少的资源,详细介绍RHCS双机配置过程。

1.2 安装环境1.2.1 硬件环境HPDL585机架服务器:(HP ProLiant DL585R05机架式机箱)*1/(CPUAMD O8380 Quad-Core Processor)*4/(内存 HP 2GB Reg PC2-64002x4GB)*16/(网卡 HP NC364T PCIe 四通道千兆网卡 (铜介质))*1/(硬盘146GB 10K SAS 2.5"双端口热插拔硬盘)*41.2.2 操作系统Redhat 5.4企业版x86_64,集群软件:Redhat Cluster Suite,操作系统自带。

RHCS(Linux 双机)的常用操作

Novmcgrady’s RHCS GuideRHCS(Linux双机)的常用操作(版本1.1)目录1 启动双机软件服务 (2)2 停止双机软件服务 (2)3 图形化界面启动应用服务 (2)4 图形化界面停止应用服务 (3)5 针对应用服务的常用操作 (3)5.1 查看双机有哪些服务在运行及运行状况 (3)6 命令行方式启动停止和切换应用服务 (4)6.1 启动某个应用服务 (4)6.2 重启某个服务 (4)6.3 停止某个服务 (4)6.4 切换某个服务 (4)7 常见问题和解决方法 (5)7.1 服务器无法正确识别到存储 (5)7.1.1 正常情况 (5)7.1.2 非正常情况 (6)7.1.3 无法找到磁盘的解决方法 (6)7.2 服务器上丢失了某应用服务的启动停止脚本 (6)7.2.1 正常情况 (6)7.2.2 解决方法 (8)8 常用操作命令 (9)1 启动双机软件服务在webdb1和webdb2上操作在webdb1上用root用户登录进入图形界面,点击桌面右键open terminal输入如下命令:1) service cman start (在webdb1上执行)2) service cman start (在webdb2上执行)以上两命令可以同时执行等执行完成后,继续3) service rgmanager start (在webdb1上执行)4) service rgmanager start (在webdb2上执行)2 停止双机软件服务停止双机服务进入图形界面,点击桌面右键open terminal输入如下命令:1) service rgmanager stop (在webdb1上执行)2) service rgmanager stop (在webdb2上执行)等执行完成后,继续3) service cman stop (在webdb1上执行)4) service cman stop (在webdb2上执行)3 图形化界面启动应用服务1.在webdb1或webdb2上,只需在一个节点上执行1) 点击system->administration->server settings->cluster management2) 点击上方的cluster management3) 选中service:orasvc,点击上方Enable启动oracle双机服务2.等待数分钟后,该服务的State栏变成started,代表oracle服务已经启动3.启动trs服务选择service:trssvc,点击上方Enable启动trs服务注意:必须在启动了双机软件服务之后才能启动应用服务4 图形化界面停止应用服务在webdb1或webdb2上1) 点击system->administration->server settings->cluster management2) 点击上方的cluster management3) 选中service:orasvc,点击上方Disable停止oracle双机服务注意:必须先应用服务才能停止双机软件服务5 针对应用服务的常用操作5.1 查看双机有哪些服务在运行及运行状况使用命令:clustat -l例如:[root@webdb2 TRS]# clustat -lMember Status: QuorateMember Name ID Status------ ---- ---- ------webdb1 1 Online, rgmanagerwebdb2 2 Online, Local, rgmanagerService Information------- -----------Service Name : service:orasvc 第一个服务orasvcCurrent State : started (112) 该服务是启动的Owner : webdb1 该服务启动在webdb1上Last Owner : webdb1Last Transition : Fri Dec 19 17:47:29 2008Service Name : service:trssvc 第二个服务trssvcCurrent State : started (112) 该服务是启动的Owner : webdb2 该服务启动在webdb2上Last Owner : noneLast Transition : Wed Dec 24 09:06:43 20086 命令行方式启动停止和切换应用服务注意:1.一下服务必须使用root用户执行2. 以下操作必须在cman和rgmanager两个服务都起来之后才能操作6.1 启动某个应用服务比如要启动trssvc这个服务使用命令:clusvcadm -e trssvc -m webdb2 该命令将在webdb2上启动trssvc这个服务查看日志:tail -f /var/log/messages错误都会显示在/var/log/messages文件中,具体问题原因都可以通过该文件进行分析6.2 重启某个服务比如要重启trssvc这个服务使用命令:clusvcadm -R trssvc 该命令重启trssvc这个服务查看日志:tail -f /var/log/messages错误都会显示在/var/log/messages文件中,具体问题原因都可以通过该文件进行分析6.3 停止某个服务比如要停止trssvc这个服务使用命令:clusvcadm -s trssvc -m webdb2 该命令将在webdb2上停止trssvc这个服务查看日志:tail -f /var/log/messages错误都会显示在/var/log/messages文件中,具体问题原因都可以通过该文件进行分析6.4 切换某个服务比如要将trssvc这个服务从webdb1上切换到webdb2上使用命令:clusvcadm -r trssvc -m webdb2 该命令将运行在webdb1上的trssvc服务切换到webdb2上查看日志:tail -f /var/log/messages错误都会显示在/var/log/messages文件中,具体问题原因都可以通过该文件进行分析7 常见问题和解决方法7.1 服务器无法正确识别到存储7.1.1 正常情况在两台机器都启动以后在两台机器上都使用如下命令查看磁盘是否正常,例如:[root@webdb2 TRS]# fdisk -l (该命令用来查看服务器识别到的硬盘)Disk /dev/sda: 145.9 GB, 145999527936 bytes(/dev/sda是服务器本地硬盘)255 heads, 63 sectors/track, 17750 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 64 514048+ 83 Linux/dev/sda2 65 586 4192965 82 Linux swap / Solaris/dev/sda3 587 17750 137869830 83 Linux(dev/sda1、sda2、sda3是本地服务器硬盘上划分的三个分区)Disk /dev/sdb: 2147.4 GB, 2147483648000 bytes(/dev/sdb也是存储上的一块磁盘,用来存放oracle数据)255 heads, 63 sectors/track, 261083 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 261083 2097149166 83 Linux(/dev/sdb1是存放oracle数据磁盘上的一个分区,该磁盘上只有这一个分区)Disk /dev/sdc: 1073.7 GB, 1073741824000 bytes255 heads, 63 sectors/track, 130541 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytes(/dev/sdc也是存储上的一块磁盘,用来存放trs数据)Device Boot Start End Blocks Id System/dev/sdc1 1 130541 1048570551 83 Linux(/dev/sdc1是存放oracle数据磁盘上的一个分区,该磁盘上只有这一个分区)注意:必须要两台机器都能看到上述几块磁盘(服务器和存储的)7.1.2 非正常情况使用fdisk -l无法查看到/dev/sdb和/dev/sdc两块存储区域,只能看到本地磁盘,例如:[root@webdb2 TRS]# fdisk -l (该命令用来查看服务器识别到的硬盘)Disk /dev/sda: 145.9 GB, 145999527936 bytes(/dev/sda是服务器本地硬盘)255 heads, 63 sectors/track, 17750 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 64 514048+ 83 Linux/dev/sda2 65 586 4192965 82 Linux swap / Solaris/dev/sda3 587 17750 137869830 83 Linux(dev/sda1、sda2、sda3是本地服务器硬盘上划分的三个分区)出现这种情况有两种方法解决:一、 重启机器二、 分别运行两台机器上/etc/rc.local里的一条命令,例如:/sbin/fence_brocade -a 172.16.1.10 -l admin -p password -n 5 -o enable注意:该条命令需要在各自机器上查看,两台机器运行的上述命令有区别。

焊条表示方法及对照表

焊条表示方法及对照表焊条是一种金属材料,在焊接过程中起到导电、熔化和填补焊缝等作用。

为了方便使用,焊条通常以符号的形式标记。

下面是常见的焊条表示方法及对照表。

1.焊条品种表示:焊条的品种表示通常采用字母和数字的组合。

字母表示焊条的种类,数字表示特殊要求和用途。

常见的焊条品种如下:-E:表示电焊条-R:表示熔化补焊条-MC:表示金属镀层焊条-T:表示抗冲击焊条-G:表示岛屿焊条2.焊条材质表示:焊条的材质表示通常采用字母和数字的组合。

字母表示焊条的材质,数字表示焊条的特殊要求和用途。

常见的焊条材质如下:-R:表示低碳钢-S:表示低合金钢-M:表示不锈钢-N:表示铸铁-W:表示镍合金-H:表示硬派防护钢3.焊条性能表示:焊条的性能表示通常采用具体的数字和符号来标记。

常见的焊条性能表示如下:-F:表示焊条适用于平直焊接-V:表示焊条适用于纵向焊接-H:表示焊条适用于横向焊接-OH:表示焊条适用于覆盖横向焊接-FH:表示焊条适用于插件横向焊接-P:表示焊条适用于全位置焊接-G:表示焊条具有较好的冶金性能对照表如下所示:品种材质性能E6010RHN当焊接位置要求有限E6011RHN适用性与6010相似,但更好E6012RHCS当焊接位置要求有限E6013RHLH适用性与6012相似,但更好E7014RHBH适用于工程结构E7016RHTHH适用于工程结构E7024RHBH适用于重型结构焊接E8018RHCLS适用于一般重型结构E9018RHCLS适用于高强度结构通过上述对照表,我们可以根据焊接要求和工作环境的要求选择适当的焊条。

焊条的选择不仅关系到焊接质量,而且也关系到工作效率和成本。

因此,在实际工作中,我们应该根据具体情况,仔细选择合适的焊条。

运维手册_HA_RHCS日常运维手册(923)

文档标识文件状态:[] 草稿[√] 正式发布[ ] 正在修改RedHat HA维护手册版本:1.0.0编制孟东2015年12月20日审核批准年月日生效日期:年月日修订历史记录日期版本修订说明作者目录第一章引言 (4)第二章集群状态工具总览 (4)**. 显示群集和服务状态 (4)**. 日志查看 (6)第三章集群状态维护 6**. 初始化RHCS (6)**. 开启RHCS (7)**. 关闭RHCS (7)**. 查看RHCS状态 (7)**. 手动切换资源组命令 (7)**. ILO界面登录与主机硬重启 (8)**. 异常应急情况处理步骤: (9)**. F AILOVER测试9第一章引言本章描述在群集被安装和配置后所涉及的管理和维护任务。

第二章集群状态工具总览群集状态工具显示了群集服务、群集成员、和应用程序服务的状态,以及和服务操作有关的统计数据。

群集配置文件(由群集配置工具所维护)被用来决定如何管理成员、服务和群集守护进程。

使用群集状态工具来启动和停止那个成员上的群集服务、重新启动应用程序服务、或把应用程序服务转移到另一个成员上。

2.1.显示群集和服务状态监视群集和应用程序服务状态能够帮助识别和解决群集环境中的问题。

以下工具可以在显示群集状态方面提供帮助:clustat 命令日志文件消息群集监视GUI群集和服务状态包括以下信息:群集成员系统状态心跳频道状态服务状态以及哪个群集系统在运行该服务或拥有该服务监视群集系统的服务状态使用群集状态工具来启动和停止那个成员上的群集服务、重新启动应用程序服务、或把应用程序服务转移到另一个成员上。

当配置了群集服务,并相关的群集进程启动后,在shell提示符中,运行system-config-cluster,点击Cluster Management标签,就会显示当前群集的服务状态:在shell提示下显示当前集群状态的快照,启用clustat工具,其示例的具体输出如下:2.2.日志查看hundsun70 log:tail –f /var/log/message:Aug 4 03:38:31 hundsun70 gconfd (root-9085): GConf server is not in use, shutting down.Aug 4 03:38:31 hundsun70 gconfd (root-9085): ExitingAug 4 03:52:14 hundsun70 clurgmgrd[2629]: <notice> Stopping service service:oracleAug 4 03:52:18 hundsun70 rhsmd: In order for Subscription Manager to provide your system with updates, your system must be registered with the Customer Portal. Please enter your Red Hat login to ensure your system is up-to-date.Aug 4 03:52:35 hundsun70 avahi-daemon[2512]: Withdrawing address record for 192.168.56.90 on eth0.Aug 4 03:52:45 hundsun70 clurgmgrd[2629]: <notice> Service service:oracle is stoppedHundsun71 log:tail –f /var/log/message:Aug 4 03:52:46 hundsun71 clurgmgrd[2396]: <notice> Starting stopped service service:oracleAug 4 03:52:46 hundsun71 kernel: kjournald starting. Commit interval 5 seconds Aug 4 03:52:46 hundsun71 kernel: EXT3 FS on sdc, internal journalAug 4 03:52:46 hundsun71 kernel: EXT3-fs: mounted filesystem with ordered data mode.Aug 4 03:52:50 hundsun71 avahi-daemon[2287]: Registering new address record for 192.168.56.90 on eth0.Aug 4 03:53:10 hundsun71 clurgmgrd[2396]: <notice> Service service:oracle started第三章集群状态维护3.1.初始化RHCS在节点1上运行service cman start (同时在节点2上开启service cman start)在节点1上运行service rgmanager start在节点2上运行service rgmanager start3.2.开启RHCS在节点1上运行service cman startservice rgmanager start在节点2上运行service cman startservice rgmanager start3.3.关闭RHCS在节点2上运行service rgmanager stopservice cman stop在节点1上运行service rgmanager stopservice cman stop3.4.查看RHCS状态#clustat3.5.手动切换资源组命令#clusvcadm –r stsrv –m stapp23.6.ilo界面登录与主机硬重启3.7.异常应急情况处理步骤:1)节点1假死或登录不了,HA未切换手动reboot重启节点1(ssh登录不了的情况下,登录ilo进行硬重启)2)节点1硬重启后,HA仍未正常切换手动切换资源组:clusvcadm –r stsrv –m stapp23)手动切换仍未成功用ilo登录节点2,更改节点2的IP,再重启应用。

集群、双机热备、三机热备

我觉得三机热备可以这样解释一. 集群、双机热备、三机热备1.集群的定义集群(Cluster)是由两台或多台节点机(服务器)构成的一种松散耦合的计算节点集合,为用户提供网络服务或应用程序(包括数据库、Web服务和文件服务等)的单一客户视图,同时提供接近容错机的故障恢复能力。

2.集群的分类高性能计算科学集群;负载均衡集群;高可用性集群。

3.什么是高可用集群高可用性集群(High Availability Cluster), 简称HA Cluster,是指以减少服务中断(宕机)时间为目的的服务器集群技术。

高可用性(HA)集群的出现是为了使集群的整体服务尽可能可用,以便考虑计算硬件和软件的容错性。

如果高可用性集群中的主节点发生了故障,那么将由次节点代替它。

次节点通常是主节点的镜像,所以当它代替主节点时,它可以完全接管其身份,并且因此使系统环境对于用户是一致的。

HA集群通常包括2至8个或更多的节点,不过目前80%的HA集群都是2个节点。

4.什么是双机热备双机热备是一种通俗的名称,实质上就是节点数为2的高可用集群。

双机热备,就是将中心服务器安装成互为备份的两台服务器,并且在同一时间内只有一台服务器运行。

当其中运行着的一台服务器出现故障无法启动时,另一台备份服务器会迅速的自动启动并运行(一般为数分钟左右),从而保证整个网络系统的正常运行。

5.什么是三机热备网上对“三机热备”的提法不多,经过查阅相关资料,我认为三机热备和双机热备一样,也属于高可用集群的范畴,即节点数为3的高可用集群。

所以可以从高可用集群的角度来看三机热备的应用现状和软件平台。

二. 基于LINUX平台的高可用集群的软件在集群产品应用方面,有两大类软件产品。

一类是双机软件,另一类则称作集群软件。

这两类软件都是为实现系统的高可用性服务的,都解决了一台服务器出现故障时,由其他服务器接管应用,从而持续可靠地提供服务的问题。

双机软件只能支持两台服务器以主从方式或互备方式工作。

RedHat Linux Ent 5.6安装手册 RHCS安装与配置手册

RedHat Linux Ent 5.6安装手册/RHCS安装与配置手册目录一、RHEL5.6系统安装 (2)二、RHEL5.6系统配置 (17)2.1 设置时间同步 (17)2.2 建立useradmin、sysoper、sysadmin用户管理用户与系统监控 (17)2.3 部署sysoper与useradmin维护脚本 (17)2.4配置sudo (17)三、RHEL5.6系统安全加固与系统优化 (18)四、RHEL5.6 YUM配置 (18)五、RHCS 5.6 安装与配置 (19)5.1 服务器设置 (19)5.2 安装Cluster软件(linux1、linux2) (20)5.3 在所有节点上配置CLUSTER(linux1、linux2) (20)5.4 在所有节点上执行如下命令,启动CLUSTER服务 (24)5.5 查看集群状态 (24)5.6 手动切换集群服务 (24)一、RHEL5.6系统安装1.1将RHEL 5.6光盘放入光驱,设置从光驱启动,如下图按回车。

1.2选择‘Skip’回车1.3点‘Next’1.4点‘Next’1.5点‘Next’1.6选择‘Skip entering Installation Number’,点‘OK’1.7选择‘Skip’1.8选择‘Y es’,再选择‘Create custom layout’,点‘Next’按同样的方法建立swap、/ 分驱,大小分别为:物理内存2位、10G1.10分驱完成之后选择‘Next’1.11选择‘Next’1.12设置IP地址,选择‘Edit’,选择‘Enable IPV4 support’,Manual Configuration,设置IP地址,点“OK”1.13Hostname,选择‘manually’输入主机名:,Gateway:xxx.xxx.xxx.xxx Primary DNS:xxx.xxx.xxx.xxx Secondary DNS:xxx.xxx.xxx.xxx,点‘Next’1.14时区:选择“Asia/Shanghai”,点Next1.15输入ROOT密码:****,点next1.16选择‘Customize now’,点Next1.17 选择Languages,选中‘Chinese Support’点Next.1.18点‘Next’1.19等待大约三十分钟安装完成。

Rainbow 型号 RHCS19 Power Nozzle 使用说明书

使用说明书W E R N O Z Z L E安全重要说明1. 请仅按照此手册所述方法使用设备。

请仅与型号为 RHCS19 Rainbow 的设备共同使用。

2. 为了降低触电风险 - 请仅在室内使用。

3. 为避免火灾风险,请勿使用此设备清空任何燃烧或冒烟物体,例如香烟、火柴或余烬。

4. 为了避免触电,请勿湿手操作插头或 Power Nozzle。

5. 为了避免受伤,请勿将任何物体放入开口。

请勿在任何开口被堵住时使用设备;请及时清理开口处的灰尘、布屑、毛发和任何其他可能阻塞气流的物体。

6. 为了避免受伤,请勿使毛发、宽松服饰、手指和身体的任何部分靠近开口和活动组件。

7. 为了降低触电风险 - 请仅将其用于干吸。

请勿在户外或潮湿表面使用 Power Nozzle。

8. 为了避免因移动组件造成伤害,请在清理或维修前拔掉电源插头。

9. 此 Power Nozzle 采用双层绝缘结构。

请仅使用相同的更换件。

请参阅说明,了解双重绝缘电器的维修方法。

10. 双重绝缘电器标有以下一个或多个标记:标语“双层绝缘”或“双重绝缘”,或双层绝缘图标(由外而内两个正方形)。

在双重绝缘电器中,由两个绝缘系统代替接地装置。

双重绝缘电器不提供接地机制,且不应提供接地方法。

维修双重绝缘电器须要了解系统结构,在维修过程中须极度小心,且应由具备资质的人员负责。

双重绝缘电器的更换件必须与其更换的元件相同。

11. 为了避免火灾风险,请勿使用此电器清理可燃液体(例如汽油),或在该类液体可能出现的地方使用此电器。

12. 岁及以上儿童和具有身体、感官或精神缺陷或缺乏经验和知识的人在获得 Rainbow 的安全使用监管或说明并理解涉及的危险后,可以使用 Rainbow。

儿童应在成人监督下使用 Rainbow ,以确保他们不会将其当作玩具。

儿童应在成人监督下进行电器的清洁和维护。

13. 请仅将 Power Nozzle 用于干吸。

请勿在户外或潮湿表面上使用。

集群文件系统之GFS2

集群⽂件系统之GFS2⼀、⽂件系统分类 1.集群⽂件系统 GFS2 OCFS2 2.分布式⽂件系统(有分布式⽂件锁。

) GFS(Goole) :适⽤海量⼤⽂件 HDFS(Hadoop) :适⽤海量⼤⽂件 MogileFS :适⽤海量⼩⽂件⼆、RHCS(Redhat Hat Cluster Suite)红帽集群套件 注:需要适⽤GFS2则需要先安装RHCS 1.RHCS概念: RHCS是⼀个功能完备的集群应⽤解决⽅案,它从应⽤的前端访问到数据后端的数据数据存储都提供了⼀个⾏之有效的集群架构实现,通过RHCS提供的这种解决⽅案,不但能保证前端应⽤持久,稳定的提供服务,同时也保证了后端数据存储的安全。

RHCS提供了集群系统中三种集群架构,分别是⾼可⽤性集群,负载均衡集群,存储集群 2.RHCS核⼼功能特点: ⾼可⽤集群 LVS GFS⽂件系统三、部署RHCS的⽅法 1.conga部署(luci+ricci) 控制节点:luci 集群节点:ricci 注意:在安装RHCS的时候要禁⽤epel源 2.⼿动部署四、conga部署RHCS 1.需要四台linux机器。

⼀台控制节点。

三台集群节点。

控制节点安装ansible、并且主机名、双机互信配置完毕。

2.集群节点通过ansible安装ricci (注意这⾥要⽤本机镜像内的源安装,不⽤epel源安装,因为epel版本可能更旧) #ansible webserver -m yum -a "name=ricci state=present disablerepo=epel" 3.主节点安装luci #yum -y install luci --disablerepo=epel 4.验证集群节点ricci服务 netstat -tulp (ricci⽤tcp:1111与upd:111端⼝) 5.启动控制节点服务 service luci start 6.使⽤浏览器登录RHCS管理界⾯(地址在启动服务的时候会显⽰) 7.配置集群节点及资源五、配置GFS2(集群⽂件系统)六、配置CLVM(集群逻辑卷)。

石英多模光纤共分8种

1、双包层光纤2、硬树脂包层光纤3、硅橡胶包层光纤4、聚酰亚胺涂层光纤5、侧发光光纤6、锥度光纤7、氟涂层光纤8、耐辐照光纤一、双包层光纤(HCS)1.技术说明石英双包层光纤按光谱传输范围分为紫外石英双包层光纤(UVHCS)和红外石英双包层光纤(IRHCS);数值孔径(NA):0.22±0.02、0.27±0.02;芯皮比(CCDR):1:1.04、1:1.05、1:1.1、1:1.2、1:1.4。

2.光纤光谱图如下:传输范围:UVHCS:190nm~1200nm;IRHCS:350nm~2500nm 透过率(波长632.8nm):≧99.7%/m;长期使用温度(丙烯酸树脂涂层):-40℃~80℃长期弯曲使用半径:300D(D为光纤包层外径);短期弯曲使用半径:100D(D为光纤包层外径);3.光纤结构图:1——光纤芯层(通光层)纯石英材料2——光纤皮层(光学包层)石英材料3——光纤涂覆层(保护层)树脂材料4.产品规格型号UVHCS系列规格芯径(μm)±2%包层外径(μm)±2%涂覆外径(μm)±5%UVHCS100/110100110180 UVHCS105/125105125240 UVHCS192/200192200245 UVHCS200/220200220280 UVHCS288/300288300500 UVHCS385/400385400550 UVHCS400/420400420600 UVHCS400/440400440600 UVHCS480/50048050700 UVHCS577/600577600900UVHCS600/630600630900 UVHCS800/8408008401200 UVHCS960/100096010001400 UVHCS1000/1100100011001400IRHCS系列规格芯径(μm)±2%包层外径(μm)±2%涂覆外径(μm)±5%IRHCS50/12550±2%125±2%245±5% IRHCS62.5/12562.5±2%125±2%245±5% IRHCS192/200192±2%200±2%245±5% IRHCS200/220200±2%220±2%280±5% IRHCS200/240200±2%240±2%400±5% IRHCS300/330300±2%330±2%500±5% IRHCS400/440400±2%440±2%600±5% IRHCS600/660600±2%660±2%900±5% IRHCS800/840800±2%840±2%1200±5% IRHCS800/880800±2%880±2%1300±5%5.订货须知:通光径在100~1000μm的特殊规格光纤可以根据要求定制。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

资料编码 产品名称 Redhat cluster suite 使用对象产品版本 编写部门软件公司国内技术服务部 资料版本Redhat Cluster Suite Redhat Cluster Suite安装指导安装指导安装指导拟 制: 日 期: 审 核: 日 期: 审 核: 日 期: 批 准:日 期:华 为 技 术 有 限 公 司版权所有 侵权必究侵权必究2009-12-1 华为机密,未经许可不得扩散第3页共46页目录第一章 概述 5 第二章 系统环境 5 第三章 安装配置 6 3.1 RHEL5.4 系统安装 6 3.2 完善系统环境 24 3.3 存储配置 27 3.4 安装多路径软件 29 3.5 安装RHCS 软件包 30 3.6 RHCS 配置 31 第四章 群集管理 442009-12-1 华为机密,未经许可不得扩散第4页共46页关键词:RHEL RHCS 摘 要:主要介绍RHEL5.4版本下RHCS 环境安装配置 缩略语清单:RHEL :Redhat Enterprise Linux RHCS: Redhat Cluster Suite参考资料:redhat 官方文档 Cluster_Administration Cluster_Suite_Overview2009-12-1 华为机密,未经许可不得扩散 第5页共46页第一章 概述红帽群集管理器是一组技术集合。

它们被综合在一起来提供数据完好性和在失效情况下保持程序可用性的能力。

通过使用冗余的硬件、共享的磁盘贮存区、电源管理、以及强健的群集管理和应用程序失效转移机制,群集能够满足企业市场的需要。

群集特别适合于数据库应用程序、网络文件服务器、以及带有动态内容的万维网服务器,它还可以用来部署高可用性的电子商务站点,这类站点除了负荷平衡能力之外还具备提供完全的数据完好性和应用程序可用性的能力。

第二章 系统环境2.1 硬件环境服务器:ATAE 单板2块存 储:华赛OceanStor S2300E,通过FC连接服务器。

Fence设备:Fence 设备的作用时在一个节点出现问题时,另一个节点通过 fence 设备把出现问题的节点重新启动,这样做到了非人工的干预和防止出现问题的节点访问共享存储,造成文件系统的冲突。

关于 Fence 设备,有外置的比如 APC 的电源管理器。

很多服务器都是内置的,只不过不同厂家的叫法不同而已。

比如 HP 的称为 iLo,IBM 的称为 BMC 。

ATAE 不支持Fence 设备。

2.2 操作系统Redhat EL5.4版本,集群软件:Redhat Cluster Suite,操作系统自带。

2.3 组网拓扑2009-12-1 华为机密,未经许可不得扩散第6页共46页2009-12-1 华为机密,未经许可不得扩散 第7页共46页第三章 安装配置3.1 RHEL5.4 系统安装3.1.1 设定引导顺序进入主机BIOS ,在BOOT 菜单下,选择引导顺序: 光驱引导 硬盘引导 按F10保存退出。

3.1.2 跳过介质检查系统重新启动,并由光驱引导,开始安装界面,直接回车选择图形界面安装,并跳过介质检查,节约时间。

3.1.3 选择安装过程语言为简体中文2009-12-1 华为机密,未经许可不得扩散 第8页共46页3.1.4 选择键盘模式为美国英语式2009-12-1 华为机密,未经许可不得扩散 第9页共46页3.1.5 输入安装号码2009-12-1 华为机密,未经许可不得扩散 第10页共46页说明:此处输入安装号码,如:49af89414d147589,将会提示选择安装集群和集群存储以及虚拟化等应用软件包。

如果跳过安装号码,将不会看到集群和集群存储以及虚拟化等软件包,待系统安装完毕后只能通过建立YUM 源来安装相应应用软件包。

3.1.6 选择自定义分区2009-12-1 华为机密,未经许可不得扩散 第11页共46页建立/boot 分区:/boot 分区大小150M 足够了,文件类型EXT3并强制为主分区。

2009-12-1华为机密,未经许可不得扩散 第12页共46页建立SWAP 分区:为实际物理大小的2倍2009-12-1华为机密,未经许可不得扩散 第13页共46页建立/根分区:余下空间分配给/根分区,文件类型EXT3,并强制为主分区。

2009-12-1华为机密,未经许可不得扩散 第14页共46页3.1.7 设定主机名,并选中需要激活的网卡,并编辑IP 地址。

2009-12-1华为机密,未经许可不得扩散 第15页共46页3.1.8 设定root 用户密码2009-12-1华为机密,未经许可不得扩散 第16页共46页3.1.9 定制安装组件软件包2009-12-1华为机密,未经许可不得扩散 第17页共46页说明:在3.1.5处输入安装号码后结果在此体现,选择集群和集群存储,并选则“现在定制”后将对每个组件所需的软件做进一步详细的选择。

2009-12-1华为机密,未经许可不得扩散 第18页共46页说明:.点击“可选的软件包”按钮,可以针对每个组件做详细的软件包选择。

3.1.10 重新引导:安装环境定制完毕后将会进行安装系统,并重新引导2009-12-1华为机密,未经许可不得扩散 第19页共46页3.1.11 系统参数配置系统安装完毕后将会重新启动,并设置初始环境参数。

2009-12-1华为机密,未经许可不得扩散 第20页共46页3.1.12 关闭防火墙:RHCS 集群需要关闭防火墙设置,以防所需端口被屏蔽。

2009-12-1华为机密,未经许可不得扩散 第21页共46页3.1.13 禁用SELinux2009-12-1 华为机密,未经许可不得扩散 第22页共46页3.1.14 创建root 用户之外普通用户,安装oracle 时不要在此设定oracle 用户。

2009-12-1 华为机密,未经许可不得扩散第23页共46页点击“前进”按钮,其他默认安装,并选择不进行注册,即可完成RHEL 5.4系统安装。

2009-12-1 华为机密,未经许可不得扩散第24页共46页3.2 完善系统环境3.2.1 打开telnet 服务安装telnet 服务器端程序。

到光盘Server 目录下,找到telnet-server-0.17-39.el5.x86_64.rpm 包,命令安装。

rpm –iUh telnet-server-0.17-39.el5.x86_64.rpm编辑/etc/securetty 文件:# vi /etc/securetty 填加pts/0、pts/1等,:wq!保存退出。

编辑/etc/xinetd.d/telnet 文件: # vi xinetd.d/telnet # default: on# description: The telnet server serves telnet sessions; it uses \ # unencrypted username/password pairs for authentication. service telnet {flags = REUSE socket_type = stream wait = no user = rootserver = /usr/sbin/in.telnetd log_on_failure += USERID disable = yes }将disable 改为no,保存退出。

重启网络服务# service xinetd restart root 用户即可远程登录系统。

2009-12-1 华为机密,未经许可不得扩散 第25页共46页3.2.2 开启root 用户Xmanager 远程登录编辑/etc/gdm/custom.conf 文件: #vi /etc/gdm/custom.conf 在[xdmcp]下填加 Enable=true 保存退出。

编辑/usr/share/gdm/defaults.conf 文件:#vi /usr/share/gdm/defaults.conf 改写如下:AllowRemoteRoot=true [xdmcp]下: Enable=true Port=177 保存退出。

重启gdm 服务: #gdm-restart查看177端口是否打开,Xmanager 使用177端口 #netstat –unpolXmanager 可以root 远程登录。

3.2.3 缩短内核引导超时限度有可能通过缩短内核引导超时限度来缩短成员的引导时间。

在红帽企业 Linux 的引导过程中,引导装载程序允许你指定要引导的另一个内核。

指定内核的默认超时时间是十秒钟。

修改成员的内核引导超时限度,按照以下方式来编辑恰当的文件:在使用 GRUB 引导装载程序时,你应该修改 /boot/grub/grub.conf 中的超时参数来指定恰当的 timeout 秒数。

要把间隔设为 3 秒钟,按照以下方式来编辑参数: timeout = 32009-12-1 华为机密,未经许可不得扩散第26页共46页在使用 LILO 或 ELILO 引导装载程序时,编辑 /etc/lilo.conf 文件(x86 系统)或elilo.conf 文件(Itanium 系统),并指定想要的 timeout 数值(以十分之一秒为单位)。

以下的例子把超时限度设为三秒钟: timeout = 30要应用 /etc/lilo.conf 文件中的改变,使用 /sbin/lilo 命令。

在 Itanium 系 统 上 , 要 应 用 /boot/efi/efi/redhat/elilo.conf 文 件 中 的 改 变 , 使 用 /sbin/elilo 命令。

2009-12-1 华为机密,未经许可不得扩散 第27页共46页3.3 存储配置在IE 浏览器中输入https://CTRL_IP:8443登录到S2300E 管理系统界面。

3.3.1 创建Raid 组点击“RAID 组”或“所有资源”进入RAID 组管理和所有资源界面。

选择相应硬盘建Raid 组3.3.2 创建LUN在创建的RAID 组基础上,可以点击创建LUN 按钮进入创建LUN的界面,点击上图中创建LUN 按钮,进入LUN 配置界面,根据实际设置LUN 参数。

2009-12-1 华为机密,未经许可不得扩散 第28页共46页3.3.3 主机与LUN 映射建立主机组,选择相应操作系统类型:填加主机,正确选择主机系统类型:填加主机端口,选择与主机对应的HBA 卡的WWN号码2009-12-1 华为机密,未经许可不得扩散第29页共46页说明:在RHEL 5.4版本中查找主机中已安装的HBA 卡WWN 号,如果有多块HBA 卡,则fc_host 目录下将会对应的hostN 目录,每个目录下存储着该HBA 卡的WWN 号。