第五章 对抗搜索分析

检索策略

策略及失误

计算机检索还须选定检索词编制布尔逻辑提问式。 (4)调整检索方案:根据检索过程中出现的各种问题及时调整方案,扩大或缩小检索范围。 明确课题需求、选择数据库 检索过程中的首要环节,就是要明确课题需求,第一步如果搞错了,就谈不上最后检索结果的正 确性。由于用户对自己的需求,特别是潜在的、模糊的需求并不总是非常明确,因此需要进行分 析,以求得一个完整而明确的表达。在用户需求分析中,应搞清楚以下一些问题: (1)分析课题检索的目的通常有几种类型: 1、开始某一项科学研究或承接某项工程设计,需要对课题进行全面的文献普查,并从中筛选出 所需的资料,用以编写可行性报告、计划任务书等。

策略设计

策略设计

络信息检索策略设计应遵循快、准、全及低成本的原则,以实现检索策略最优化。所谓快、准、 全,是指设计出来的检索策略能够快速、准确、全面地从上检索到所需要的信息;低成本则是指 以最低的费用获取所需的信息。由于检索上信息要付通讯费,有些数据库还要付数据库使用费, 因而降低信息成本对消费能力较弱的我国用户有比较重要的意义。 主题分析 明确检索需求后,就要对用户课题的具体内容作主题分析,这是正确选用检索词和逻辑算符的的 关键,它将决定检索策略的质量并影响检索效果。 主题分析就是对用户的课题进行主题概念的分析,并用一定的概念词来表达这些主题内容,同时 明确概念与概念之间的逻辑关系。主题分析必须注意: (1)概念的表达要确切。抓住课题的实质性内容,分析出课题中有几个概念组面。

策略及失误

6、为撰写论文查找相关文献等。以期刊论文、学位论文等学术研究性的数据库为主。 (2)明确题所涉及的学科范围和专业面 明确课题所涉及的主要学科范围、相关学科范围、交叉学科范围,并根据数据库的主题收录范围 进行选择。 (3)对文献的新颖性程度的要求 对文献新颖性要求高,就要选择数据更新周期短、速度快的数据库。 (4)用户对检索的查全与查准要求 为满足查全要求,就要普查多种数据库,为快速满足查准要求,应选择主题范围最专指的数据的乐趣和满足。因为,这不仅是一场搜 索的旅程,更是一场知识的盛宴,一次智慧的挑战。

人工智能导论-第二章对抗搜索

上限置信区间算法在MCTS中应用

上限置信区间(UCB)算法

UCB算法是一种多臂赌博机问题的解决方法,用于在探索和利用之间找到平衡。 在MCTS中,UCB算法被用于指导节点的选择过程。

应用方式

在MCTS的选择阶段,使用UCB算法计算每个子节点的得分,并选择得分最高 的子节点进行扩展和模拟。通过不断调整UCB公式中的参数,可以控制探索和 利用的权衡程度。

优化策略

为了进一步提高Alpha-Beta剪枝算法的效率,可以采用 一些优化策略,如启发式排序、迭代深化搜索等。其中 ,启发式排序是一种基于评估函数的节点排序方法,将 更有可能导致最优解的节点排在前面,从而提前找到最 优解并终止搜索;迭代深化搜索则是一种逐步增加搜索 深度的搜索方法,可以在有限的搜索深度内找到较好的 解。

常见剪枝技术

常见的剪枝技术包括深度优先剪枝、广度优先剪枝、启发式剪枝等。其中,启发 式剪枝是一种基于评估函数的剪枝方法,通过计算每个节点的评估值,提前排除 一些评估值较差的节点,从而减少搜索空间。

Alpha-Beta剪枝算法优化策略

Alpha-Beta剪枝原理

Alpha-Beta剪枝算法是一种基于极大极小值搜索的优化算 法,通过引入两个参数alpha和beta来限制搜索范围,从 而减少搜索空间。在搜索过程中ቤተ መጻሕፍቲ ባይዱ如果发现当前节点的值 已经小于或等于alpha(对于极大值节点)或大于或等于 beta(对于极小值节点),则可以提前终止对该节点的搜 索。

非零和博弈是指博弈中各方的收益和损失总和不为零的情况 。这种博弈更为普遍,因为现实生活中的许多情况都是非零 和的。非零和博弈算法需要考虑到博弈各方的可能合作,以 及利益分配的问题。

完全信息与非完全信息博弈算法

智能体与对抗搜索

第一类:环境独立于智能体本身的变化情况的信息 第二类:智能体的行动如何影响环境的信息

这些关于环境如何变化的知识就是模型

基于目标的智能体(1)

Agent State How the world evolves What the world is like now Environment What it will be like if I do action A Sensors

基于效用的智能体(1)

Agent State How the world evolves What my action do What the world is like now Environment What it will be like if I do action A How happy I will be in such a state Sensors

什么是Agent? (2)

对于智能的不同观点

思维法则:强调逻辑推理,得到正确的推论 理性行动:理性的行为

强调行动:推理是为了得到合理的行为 正确推论 + 正确行动 没有明确是正确的事情时,同样需要行动 反射式行为是不需要推理的

什么是Agent? (3)

理性行为的含义

1 当目标互相矛盾时,只有其中的一些可以达到, 效用函数可进行适当的妥协。 2 当智能体存在若干目标,但是没有一个确定能够 达到时,效用函数就依据目标的重要程度来估计目 标达到的可能性。

Condition-action rules

What action I should do now

Actuators

基于模型的反射型智能体(2)

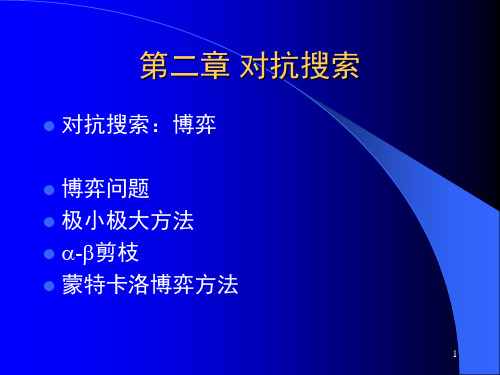

6.博弈搜索

博弈原理

• 参加博弈的各方都希望己方取得胜利。因此,当一方 面临多个行动方案选择时,博弈的各方总是要挑选对 自己最为有利而对对方最不利的那个行动方案。 • 假如A方的目标:尽可能使自己达到最大(或最高)的 分数分枝节点,可用“或”关系来描述,称之为MAX方 节点; • 而当轮到B方行动时,B方的目标:尽可能使A方获得最 小(或最低)的分数分枝节点,这对A方来说,这些行 动方案或分数分枝节点之间,可以用“与”关系来描 述,是由MIN方自主进行控制的,故又称之为MIN节点 。

-搜索策略

• 在极大极小值算法基础上增加了剪枝功能, 并 采用深度优先策略进行搜索。

• α值和β值:对于一个极大节点来说,为了剪除某些分 枝,应该取其子节点中的最大倒推值,把它作为当前 下界的参考,称此值为α值;对于一个极小节点来说, 应取其子节点中的最小倒推值,把它作为当前上界的 参考,称此值为β值。

博弈原理

• 博弈树有如下特点:

(1)博弈的初始格局总是要求从初始节点出发,为寻求某个

确定的方向而选取行动方案; (2)在博弈树中,由于双方轮流地扩展节点,“或”节点和

“与”节点逐层交替出现。如果自己一方扩展的节点之间是

“或”关系,则对方扩展的节点之间是“与”关系。 (3)把本方获胜的终局定义为本原问题,相应最优搜索路径 上的节点是可解节点,而所有使对方获胜的终局和属于对方 最优搜索路径上的节点则是不可解节点。此外,所有其它的

判断游戏是否结束效用函数或称目标函数对终止状态给出一个数值如输赢和平局以0表示双方的初始状态和合法招数定义了游戏的博弈树此为博弈搜索最优解是导致取胜的终止状态的一系列招数博弈原理参加博弈的各方都希望己方取得胜利

博弈搜索 1. 极大极小决策

2. –剪枝

人工智能基础_青岛大学中国大学mooc课后章节答案期末考试题库2023年

人工智能基础_青岛大学中国大学mooc课后章节答案期末考试题库2023年1.AlphoGo在落子选择时用的搜索技术是答案:蒙特卡洛树搜索2.下面关于搜索过程描述错误的是答案:对CLOSED表上的节点进行排序的准则,以便选出一个“最好”的节点作为扩展使用3.以下关于与或树说法错误的是答案:或树中各子节点间用弧链接4.以下关于博弈理论说法错误的是答案:博弈双方均力图选取对自己最为不利的方案5.以下关于说法错误的是答案:剪枝就是在搜索深度不变的情况下,利用已有的搜索信息增加生成的节点数6.关于鲁滨逊归结原理叙述错误的是答案:若子句集S不包含空子句,则称子句集S是可满足的7.下面关于概率分配函数说法错误的是答案:样本空间的概率分配函数值为08.以下关于模糊集合的运算说法错误的是答案:A交B的隶属度等于对应元素隶属度的大者9.以下不是常用的模糊推理模式的是答案:模糊因果推理10.以下哪一项不属于专家系统知识库的建立环节答案:知识排序11.下列属于人工智能的知识表示方法的有答案:状态空间表示法逻辑表示法本体表示法产生式表示法12.状态空间表示法用()和()来表示问题算符状态13.以下情况首选广度优先搜索的有答案:问题的解出现在相对较浅的水平分支因子不是太大没有一条路径是特别深的14.下面关于爬山法叙述正确的是答案:随机选择一个登山的起点每次拿相邻点与当前点进行比对,取两者中较优者,作为爬坡的下一步选择最大点作为本次爬山的顶点,即为该算法获得的最优解重复直至该点的邻近点中不再有比其大的点15.爬山法中可能遇到的问题有山篱问题高原问题山脊问题16.下面关于最佳优先搜索叙述正确的是答案:open表中节点按照节点接近目标状态的启发式估值实现需要open表和closed表不保留重复状态是一种智能搜索算法17.动态规划算法的特点包括答案:使用最优化原理无后效性有重叠子问题18.搜索算法的评价指标包括答案:完备性最优性单调性可接受性19.关于知识表示叙述正确的有答案:知识表示就是把知识形式化或者模型化好的知识表示形式应便于理解知识表示是一种计算机可以接受的数据结构知识表示具有一定的针对性和局限性20.常用的连接词有答案:蕴含析取否定合取21.推理过程中常用的等价性包括答案:德摩根律结合律分配律交换律22.一个良好的规则库应该具有以下哪些特性答案:知识一致表达灵活知识完整组织合理23.模糊集可用的描述方式有答案:图示表示法扎德表示法函数表示法向量表示法24.专家系统中的知识包括答案:知识库级知识数据级知识控制级知识25.专家系统包括答案:推理机综合数据库知识库26.以下哪些情况适合开发为专家系统答案:问题需要使用启发式知识、经验规则才能得到答案问题有一定的实用价值问题可以通过符号操作和符号结构进行求解问题相对较为复杂27.模仿还原就是一个从当前混乱状态寻找路径到达期望即目标状态的过程答案:正确28.如果所求序列可以使得总代价最低,则问题称为最优搜索问题。

第五章 对抗搜索..

第五章、对抗搜索

• 博弈中的优化决策 • –剪枝:允许我们忽略那些不影响最后 决定的部分搜索树 • 不完整的实时决策 • 包含几率因素的游戏 • 部分可观察博弈 • 博弈程序的当前发展水平

不完整的实时决策:对 MINIMAX或–算法的改进

• –算法依然要搜索至少一部分空间直到 终止状态,这样的搜索不现实。 • Shannon提出:

–用估计棋局效用值的启发式评价函数EVAL代 替效用函数 –用可以决策什么时候运用EVAL的截断测试取 代终止测试

不完整的实时决策

• 因此得到如下的启发式极小极大值,s为 状态,d为最大深度: H-MINIMAX(s,d)=

EVAL(s) maxaActions(s) H MINIMAX (RESULT(s, a), d 1) min aActions(s) H MINIMAX (RESULT(s, a), d 1)

例子

–剪枝:如果m比n好,我们就不会走到n。

–剪枝

• =到目前为止我们在路径上的任意选择 点发现的MAX的最佳选择 • =到目前为止我们在路径上的任意选择 点发现的MIN的最佳选择 • –剪枝的效率很大程度上取决于检查后 继的顺序

–如果能够先检查那些可能最好的后继,那么 算法的时间复杂度为O(bd/2)。

如果CUTOFF TEXT (s, d )为真 s为MAX结点 s为MIN结点

如何设计评价函数?

• 应该以和真正的效用函数同样的方式对终 止状态进行排序 • 评价函数的计算不能花费太多的时间 • 对于非终止状态,评价函数应该和取胜的 实际机会密切相关。

评价函数(续)

• 在计算能力有限情况下,评价函数能做到 最好的就是猜测最后的结果 • 大多数评价函数的工作方式是计算状态的 不同,那么对状态的一个合理评价 是加权平均值

人工智能导论--第二章对抗搜索_171603446

(3,2,1,1)

(2,2,2,1) 我方必胜

3

(2,2,1,1,1)

(2,1,1,1,1,1)

中国象棋

一盘棋平均走50步,总状态数约为10的 161次方。 假设1毫微秒走一步,约需10的145次方 年。 结论:不可能穷举。

4

2.2 极小极大过程

1

极大

1

b

0

极小

6

a

0

3

1

0

-3

3

-3

-3

8

围棋落子模型

围棋对弈过程可以看做一个马尔科夫过 程: 五元组:{T,S,A(i),P(· |i,a),r(i,a)}

– T:决策时刻 – S:状态空间,S={i} – A(i):可行动集合(可落子点) – P(· |i,a):状态i下选择行动a的概率

– r(i,a):状态i下选择行动a后课获得的收益

17

更新过程

设ni为当前要模拟的节点,△为模拟获得 的收益 对ni及其祖先的模拟次数加1 ni的收益加△ 更新ni的祖先的收益,同类节点加△,非 同类节点减△ (这里节点的类型按照极大极小节点划分)

18

蒙特卡洛规划算法流程

19

选择落子点的策略

两方面的因素:

– 对尚未充分了解的节点的探索

信心上限树算法(UCT) function UCTSEARCH(S0) 以状态S0创建根节点v0; while 尚未用完计算时长 do: vl = TREEPOLICY(v0); △ = DEFAULTPOLICY(s(vl)); BACKUP(vl,△); end while return a(BESTCHILD(v0,0));

人工智能导论-第5章 搜索求解策略

4

第5章 搜索求解策略

5.1 搜索的概念 5.2 状态空间的搜索策略 5.3 盲目的图搜索策略 5.4 启发式图搜索策略

5

节点, 深度相等的节点按生成次序的盲目搜索。

特点:扩展最深的节点的结果使得搜索沿着状态空间某条

单一的路径从起始节点向下进行下去;仅当搜索到达一个没 有后裔的状态时,才考虑另一条替代的路径。

2023/12/14

Char 5. pp.34

5.3.3 深度优先搜索策略

算法:

防止搜索过程沿着无益的 路径扩展下去,往往给出一 个节点扩展的最大深度—— 深度界限; 与宽度优先搜索算法最根 本的不同:将扩展的后继节 点放在OPEN表的前端。 深度优先搜索算法的OPEN 表后进先出。

O :操作算子的集合。

S 0:包含问题的初始状态是 S 的非空子集。

G :若干具体状态或满足某些性质的路径信息描述。

15

5.2.1 状态空间表示法

求解路径:从 S 0 结点到 G 结点的路径。

状态空间解:一个有限的操作算子序列。

S0 O1 S1 O2 S 2 O3 Ok G O1,, Ok :状态空间的一个解。

Q [q1, q2 ,, qn ]T

操作:表示引起状态变化的过程型知识的一组关 系或函数:

F { f1, f 2 ,, f m}

14

5.2.1 状态空间表示法

状态空间:利用状态变量和操作符号,表示系统或 问题的有关知识的符号体系,状态空间是一个四元 组:

(S , O, S0 , G)

谢宁:第五章 - 部件搜索技术

式中,中值高(h),为阶段1出现的低值组件的中值,t为相应于一个0.95或95%置信度 值。d/d2是sigma(σ)估计值。(d-在检测显著的可重现差值数时已予以定义,它是 高值低值组件的不可重现性相加在一起时的平均范围)。

部件搜索技术步骤

为确定这种不分改变的程度是重要的还是不重要的,必须计算出判断极限。任何交换过程,如果引

起BOB或WOW有一点处于判断极限之外,就意味着部件A肯定是重要的,与其在一起的还有以上其他

有待发现的部件。

08对于第7步所产生的3个结果中的每一个,将原来自BOB部 • 保证原始的BOB或WOW的Y值被复原。如果没有得到这样的结果,那么

在图5-2B中,当变量A由(-)变为(+)时,Y由5变为15个单位,和以前B(-)时 一样。但是,当B由(-)变为(+)时,如果A是(-),Y仅仅增加至8,如果A是(+), 则B对Y的影响是20个单位。此时,AB的交互影响不为零。图中可见:两条线不平行, 交互影响大,不平行度就越大。

交互影响:当与主影响没有隔离时,使得分析因方法产生完全错误的结果。

在计时器案例中:中值(高)=-37°,中值(低)=-5° d=-6°。 所以,判断极限(高)=-37°±2.776 *(-6/1.81)

=-46.2°和27.8° 判断极限(低)=-5°±2.776*(-6/1.81)

=+4.2°和-14.2° 它显示部件A、B、C、E、F和H都还处于高或低极限内,因而他们不重要。 但部件D、G超出了高水平的判断极限,但不是低判断极限,所以D、G是重要的。

=-6° 所以D/d=-32°:-6°=5.33:1,超过1.25. 结论 (1)、(2)的显著性是吻合的,因此阶段1是成功的。意味着红X和粉红X是在部件中,而不在 组装技术里。

《人工智能原理》-03-对抗搜索

默。可能的选项如下:

1)若囚徒A和B彼此揭发对方,则每个囚徒被监禁2年;

2)若囚徒A揭发B、而B保持沉默,则A被释放而B被监禁3年,反

之亦然;

3)若A和B都保持沉默,则他们仅被监禁1年。

囚徒困境源于1950年梅里尔·弗拉德(Merrill Flood)等人的相关困境理论。

v ← −∞

for each a in ACTIONS(state) do v ← MAX(v, MIN-VALUE(RESULT(state, a)))

return v

20

最小最大算法

(a)

(b)

(c)

(d)

双人对抗博弈搜索树:

❖ 正方形MAX方,圆形MIN方。

❖ 每个分支都是某一方的决策。

❖ 双方都基于Minimax算法。

启发式搜索算法,用于某些问题的决策过程;

• 与最小最大算法一样,每个节点对应了一个博弈状态;

• 与最小最大算法不一样,节点的值通过蒙特卡罗仿真来估计:

)

Q

(

v

动作 a 的值

ln

N

(

v

)

+c

N (v )

N (v )

其中:v 是 v 的父节点,Q(v ) 表示 v 的质量,N (v ) 表示访问 v 的次数,

用计算机ENIAC编写了相应的程序。

这些保密工作需要一个代号,尼古拉斯·梅特罗波利斯

(Nicholas Metropolis)建议使用摩纳哥蒙特卡罗赌场的名

字,因为乌拉姆的叔叔经常去那里赌博。

约翰·冯·诺依曼

斯塔尼斯拉夫·乌拉姆

30

蒙特卡罗树搜索

如何提高你的搜索和分析能力

如何提高你的搜索和分析能力在信息化时代,信息洪流日渐猛烈,人们面对的信息量越来越庞大。

在这种背景下,如何提高自己的搜索和分析能力已经成为了一个越来越重要的课题。

因此,本文将从自身的经验和社交网络中获得的经验出发,探讨如何提高搜索和分析能力。

一、提高搜索能力搜索能力是指通过各种搜索工具和技巧,在信息海洋中找到自己所需要的信息并快速有效的获取的能力。

在搜索能力方面,可以从以下几个方面去提高:1.选择正确的搜索引擎目前,市面上的搜索引擎种类繁多,选择哪一个搜索引擎可以快速精准获取所需信息是一门学问。

一般来说,百度、谷歌、必应是大家常用的搜索引擎,但是,就我个人经验而言,百度搜出来的结果大多数是水军和广告,谷歌的搜索结果相对更加权威一些,而必应则与谷歌有异曲同工之妙。

为了达到所需的搜索效果,可以根据个人需求选择不同的搜索引擎。

2.运用搜索技巧除了选择正确的搜索引擎外,操作方式、搜索技巧也是影响搜索效果的重要因素。

在搜索过程中,可以尝试以下技巧:(1)使用双引号在搜索框内加入双引号,可以直接搜索带有双引号内的全部内容,有效提高搜索准确率。

(2)加入排除关键词如果在搜索某个查询项时,系统返回了大量与其不相关的查询结果,可以在查询项前面加入负号或者not,在查询项前面加入排除关键词。

(3)搜索页面标题如果想获取网页内容比较权威的结果,可以尝试搜索网页的标题,因为通常情况下,网页标题会以最能概括网页内容的方式来命名。

3.提高语言能力搜索结果好坏与搜索者的语言能力也有着密切关系,因为搜索引擎系统一般仅能够识别排列着词条的内容,对于语言表达能力差的人来说,搜索结果往往也较为混乱。

提高语言能力可以从以下几个方面入手:(1)扩充词汇量扩充自己的词汇量可以有效提高语言表达的能力,这不仅有助于撰写优质搜索词条,同时也能够更好的理解搜索结果。

(2)提高文献阅读能力通过多读一些文章,可以打磨自己的语言表达能力,对搜索结果的分析和消化也能够更为深入。

对抗学习中的迁移学习方法研究

对抗学习中的迁移学习方法研究引言迁移学习是人工智能领域的一个重要研究方向,它的目标是将在一个任务上学习到的知识迁移到另一个相关任务上。

而在对抗学习中的迁移学习方法研究更是将迁移学习与对抗学习结合,以增强机器学习算法的性能。

本文将介绍对抗学习中的迁移学习方法的研究进展,并探讨一些研究领域,以及未来的发展方向。

一、迁移学习概述迁移学习是指在一个任务上学习到的知识能够对另一个任务产生积极的影响。

它的核心思想是通过利用已有任务的知识来帮助新的任务学习。

迁移学习可以分为同类任务迁移和跨领域迁移两类。

同类任务迁移是指在相似的任务之间进行知识迁移,而跨领域迁移是指在不同领域的任务之间进行知识迁移。

在迁移学习中,有三种常见的知识迁移方式:参数迁移、表示迁移和实例迁移。

参数迁移是指将源任务的训练得到的模型参数直接应用在目标任务上,以加快目标任务的学习速度。

表示迁移是指将源任务的表示表示学习应用在目标任务上,以提取出更具有判别性的特征。

实例迁移是指将源任务的标记样本和未标记样本应用在目标任务中,以增加目标任务的训练数据。

二、对抗学习概述对抗学习是一种通过两个或多个对手之间的对抗来改进机器学习算法的方法。

在对抗学习中,有两个关键的角色:生成器和判别器。

生成器负责生成样本数据以迷惑判别器,而判别器负责判断一个给定的样本是真实的还是生成的。

通过不断对抗的过程,生成器和判别器的能力都会不断提高。

在对抗学习中,生成对抗网络(GANs)是最常用的方法之一。

GANs由一个生成器和一个判别器组成。

生成器试图生成逼真的样本以愚弄判别器,而判别器则试图将生成器生成的样本与真实样本区分开来。

通过对抗的过程,生成器和判别器不断改进,最终生成逼真的样本。

三、对抗学习中的迁移学习方法在对抗学习中的迁移学习方法研究中,有几种常见的方法:领域自适应、生成对抗迁移学习和生成对抗网络的迁移。

1. 领域自适应领域自适应是一种跨领域迁移学习的方法,它的目标是将源领域的知识迁移到目标领域上。

对抗训练在小样本中的应用-概述说明以及解释

对抗训练在小样本中的应用-概述说明以及解释1.引言1.1 概述概述小样本学习是机器学习领域中一个重要的研究方向,它解决的是当训练数据非常有限时,如何建立有效的模型来进行准确的预测或分类的问题。

在实际应用中,我们常常面临着数据稀缺的情况,例如在医学诊断、图像识别以及自然语言处理等领域。

在这些领域中,获取大量标记完整的训练样本非常困难,因此如何有效地利用有限的训练数据来构建高质量的模型便成为了研究的热点之一。

对抗训练(Adversarial Training)作为近年来兴起的一种强大的机器学习技术,它通过引入对抗样本的方法来增强模型的鲁棒性和泛化能力,因此在小样本学习中得到了广泛的应用和探索。

对抗训练通过让一个生成对抗网络(GAN)中的生成器和判别器相互博弈、相互对抗的方式来训练模型,从而使得模型能够更好地适应小样本数据。

本文将探讨对抗训练在小样本学习中的应用。

首先,文章将介绍小样本学习的挑战,包括数据不足、过拟合等问题。

然后,文章将详细介绍对抗训练的基本原理,并阐述对抗训练在小样本学习中的应用方法。

接着,文章将讨论对抗训练在小样本学习中的优势和局限性。

最后,文章将总结对抗训练在小样本学习中的应用,并展望未来对抗训练在小样本学习中的研究方向。

通过本文的研究,我们期望能够深入理解对抗训练在小样本学习中的应用,为解决小样本学习问题提供有效的方法和思路。

同时,我们也希望能够探索出更加高效和创新的对抗训练算法,以应对日益复杂和多样性的实际应用场景。

1.2文章结构1.2 文章结构本文将按照以下结构展开对抗训练在小样本中的应用的论述:第一部分为引言,介绍了本文的主题和意义。

首先,我们会对小样本学习的挑战进行概述,指出小样本学习在实际应用中所面临的问题和困难。

接着,介绍对抗训练的基本原理,以及对抗训练在小样本中的应用。

通过这些基础知识的介绍,读者可以更好地理解对抗训练在小样本中的作用和意义。

第二部分是主体内容,详细论述了对抗训练在小样本中的应用。

对抗学习中的模式发现和异常检测方法

对抗学习中的模式发现和异常检测方法引言对抗学习是一种机器学习的方法,通过模拟两个或多个对立的智能体之间的竞争,以提高模型性能。

在对抗学习中,模式发现和异常检测是两个关键任务。

模式发现旨在从数据中提取出重要的规律和结构,而异常检测则旨在识别与正常行为不一致或不寻常的数据点。

本文将深入研究对抗学习中的模式发现和异常检测方法,并探讨其应用领域和挑战。

一、对抗学习中的模式发现方法1. 生成对抗网络(GANs)生成对抗网络(GANs)是一种常用于无监督学习任务中的深度生成模型。

GANs由一个生成器网络和一个判别器网络组成,两者通过博弈过程相互竞争以提高性能。

生成器试图从随机噪声中合成逼真样本,而判别器则试图区分真实样本与合成样本。

在GANs中进行模式发现时,生成器通过逼真度评估来指导训练过程,并逐渐提升合成样本与真实样本之间的相似度。

这种方法在图像生成、视频生成和自然语言处理等领域取得了显著的成果。

2. 变分自编码器(VAEs)变分自编码器(VAEs)是一种概率生成模型,通过将输入数据映射到潜在空间中的分布来进行模式发现。

VAEs由一个编码器和一个解码器组成,编码器将输入数据映射到潜在空间中的概率分布,解码器则将潜在变量重新映射到原始数据空间。

在对抗学习中,VAEs可以通过最大化生成样本与真实样本之间的对数似然来进行训练。

通过学习潜在空间中的分布,VAEs可以实现对数据中隐藏模式和结构的发现。

3. 自监督学习自监督学习是一种无监督学习方法,通过使用数据本身作为标签来进行训练。

例如,在图像处理任务中,可以通过将图像旋转一定角度作为输入,并要求模型预测旋转角度来进行训练。

自监督学习可以用于对抗学习中的模式发现任务。

通过设计合适的预测任务,并使用生成模型生成合成样本作为负例,可以使得模型能够从数据中提取出有用的特征和结构。

二、对抗学习中的异常检测方法1. 基于生成模型的异常检测基于生成模型的异常检测方法通过训练生成模型来对正常数据进行建模,然后通过比较生成样本和真实样本之间的差异来判断异常数据。

搜索问题求解

Pushbox(a)

Grasp (c,c,1,1) 目标状态 猴子摘香蕉问题的状态空间图 解序列为: {Goto(b), Pushbox(c), Climbbox, Grasp}

12

3. 八数码问题

7 5 8

2

4 6 3 6

1 4 7

2 5 8

3

1

13

八数码问题

状态:状态描述了8个棋子中的每一个以及空位在棋盘的9个方格 上的分布。

有向图

19

4.3 状态空间搜索的结构

有根图具有唯一一个称为根的结点,从根结点出发到图

中任何结点都存在相应路径。

A B C F G H D

E

I

J

有根树,一个家庭关系的例子

20

4.3 状态空间搜索的结构

用来描述结点之间关系:祖先、后裔、父母、子女、兄弟

E

D

C A B

21

4.4 问题的状态空间表示法

初始状态:任何状态都可以被指定为初始状态。注意要到达任何 一个给定的目标,可能的初始状态中恰好只有一半可以作为开始 。 后继函数:用来产生通过四个行动(把空位向Left,Right,Up 或Down移动)能够达到的合法状态。

目标测试:用来检测状态是否能匹配所要求的目标格局。

路径耗散:每一步的耗散值为1,因此整个路径的耗散值为路径 中的步数。

其他结点区别开来, 这样的图称为标记图。

有方向性的弧连接的图是有向图。

图中的弧也可以做上标记,用来给关系取名或表示权 值。当一对结点间有多条弧相连时,这种方法可以使 之区别。

18

E

D

C

A B

结点集={A, B, C, D, E}

搜索求解策略课件

分阶段使用策略

02

在搜索的不同阶段,采用合适的搜索策略,以平衡探索与利用

的矛盾。

自适应混合策略

03

根据搜索进程中的信息,自适应地选择和调整所使用的搜索策

略。

搜索策略的自适应机制

学习与进化机制

引入机器学习和进化算法思想,使搜索策略具备自适应能力。

环境感知与响应

根据问题环境的变化,动态调整搜索策略以适应新的情况。

传算法等。

解的评估与比较

利用目标函数对搜索过程中产生的 解进行评估和比较,选择最优或次 优解。

剪枝与优化

通过剪枝策略和优化方法提高搜索 效率,如α-β剪枝、分支限界法等。

03

搜索策略的设计与实 现

盲目搜索策略

宽度优先搜索

按层次遍历搜索空间,先访问离 起始节点近的节点。

深度优先搜索

沿着搜索树深度方向进行搜索, 直到达到目标节点或无法继续深

掘其潜在价值。

03

强化策略自适应能力

研究如何让搜索求解策略具备更强的自适应能力,以应对不同问题和场

景的变化。

THANK YOU

入。

迭代加深搜索

结合宽度优先搜索和深度优先搜 索,通过设置深度限制来避免盲

目深度搜索。

启发式搜索策略

最佳优先搜索

根据启发式函数评估节点优先级,优先选择最有 希望的节点进行扩展。

贪婪最佳优先搜索

仅考虑当前状态下最有利的节点,忽视其他可能 路径。

A*算法

结合启发式函数和实际代价函数进行搜索,具有 较高的效率和准确性。

搜索求解策略的研究现状

研究热点

目前,搜索求解策略的研 究热点包括启发式搜索、 元启发式搜索、多目标搜 索等。

研究方法

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(a)黑棋有1个马、2个 兵的优势,能够取胜。 (b)黑棋会被白棋吃掉皇后,从而失败。

截断搜索(续)

• 需要更为复杂的截断测试,评价函数应该 只用于那些静止的棋局(静态棋局)。 • 非静止的棋局可以进一步扩展直到静止的 棋局,这种额外的搜索称为静态搜索。

第五章、对抗搜索

• 博弈中的优化决策 • –剪枝:允许我们忽略那些不影响最后 决定的部分搜索树 • 不完整的实时决策 • 包含几率因素的游戏 • 部分可观察博弈 • 博弈程序的当前发展水平

不完整的实时决策:对 MINIMAX或–算法的改进

• –算法依然要搜索至少一部分空间直到 终止状态,这样的搜索不现实。 • Shannon提出:

计算机科学技术学院

第五章

对抗搜索

主讲:徐缙

第五章、对抗搜索

• 在有其它智能体计划与我们对抗的世界中如何 预先计划 • 博弈的概念

–数学中的博弈论把任何多智能体环境看成是一种博 弈游戏,其中每个智能体对其它智能体的影响是“ 显著的”,与智能体是合作的还是竟争的无关。 –AI中的博弈通常指有完整信息的、确定性的、轮流 行动的、两个游戏者的零和游戏。 –游戏因为难解而令人感兴趣!

截断搜索(续)

• 地平线效应:指对手招数导致我方严重损 失并且从理论上基本无法避免。 • 单步延伸是避免地平线效应的一种策略 这样做可能超过深度限制,但由于单步延 伸很少,不会增加太多开销。

对这两节所介绍的技术的总结

Байду номын сангаас• 假设已经实现:

–国际象棋的评价函数 –使用静止搜索的合理截断测试 –一个很大的调换表

例子

–剪枝:如果m比n好,我们就不会走到n。

–剪枝

• =到目前为止我们在路径上的任意选择 点发现的MAX的最佳选择 • =到目前为止我们在路径上的任意选择 点发现的MIN的最佳选择 • –剪枝的效率很大程度上取决于检查后 继的顺序

–如果能够先检查那些可能最好的后继,那么 算法的时间复杂度为O(bd/2)。

s为终止状态 s为MAX 结点 s为MIN 结点

极小极大值的递归算法

多人游戏中的最优决策

第五章、对抗搜索

• 博弈中的优化决策 • –剪枝:允许我们忽略那些不影响最后 决定的部分搜索树 • 不完整的实时决策 • 包含几率因素的游戏 • 部分可观察博弈 • 博弈程序的当前发展水平

–剪枝

• 极小极大值搜索的时间复杂度是O(bm) • 剪枝:剪裁掉那些不影响最后决策的分支 。 • 一般原则:考虑在树中某处的节点n,如 果游戏者在n的父节点或上层的任何节点 有一个更好的选择m,那么在实际的游戏 中就永远不会到达n,即n被剪裁掉。

–初始状态,包括棋盘局面和确定该哪个游戏 者出招。 –ACTION(s)后继函数,返回(move, state)。 –TERMINAL-TEST(s)终止测试 –UTILITY(s,p)效用函数:对终止状态给出一 个数值。

例子:井子棋游戏-博弈树

最优策略

• 最优解是导致取胜的终止状态的一系列招数 • 但,在游戏中MIN还有发言权 • 在对手不犯错误时,最优策略能够导致至少不 比任何其它策略差的结果。

• 那么在“最新的PC”上可每秒生成和评价约一 百万个节点,允许我们在标准时间控制下对每 步棋可搜索约2亿个节点,而 • 国际象棋的分支因子平均为35,355约为5亿。

如果CUTOFF TEXT (s, d )为真 s为MAX结点 s为MIN结点

如何设计评价函数?

• 应该以和真正的效用函数同样的方式对终 止状态进行排序 • 评价函数的计算不能花费太多的时间 • 对于非终止状态,评价函数应该和取胜的 实际机会密切相关。

评价函数(续)

• 在计算能力有限情况下,评价函数能做到 最好的就是猜测最后的结果 • 大多数评价函数的工作方式是计算状态的 不同,那么对状态的一个合理评价 是加权平均值

一颗两层的博弈树

最优策略的确定

• 通过检查每个节点的极小极大值来决定, 记为MINMAX-VALUE(n)。

MINIMAX ( s ) UTILITY ( s ) max aActions ( s ) MINIMAX ( RESULT ( s, a)) min aActions ( s ) MINIMAX ( RESULT ( s, a ))

–用估计棋局效用值的启发式评价函数EVAL代 替效用函数 –用可以决策什么时候运用EVAL的截断测试取 代终止测试

不完整的实时决策

• 因此得到如下的启发式极小极大值,s为 状态,d为最大深度: H-MINIMAX(s,d)=

EVAL(s) maxaActions(s) H MINIMAX (RESULT(s, a), d 1) min aActions(s) H MINIMAX (RESULT(s, a), d 1)

–例如,国际象棋中EVAL通常取为加权线性函 数(假设每个特征的贡献独立于其它特征的 值),

w f (s)

i 1 i i

n

截断搜索

• 用if CUTOFF-TEST(state, depth) then return EVAL(state)代替–算法中 TERMINAL-TEST所在的两行,或 • 使用迭代搜索:当时间用完时,程序就返 回目前完成最深的搜索所选择的招数。

第五章、对抗搜索

• 博弈中的优化决策 • –剪枝:允许我们忽略那些不影响最后 决定的部分搜索树 • 不完整的实时决策 • 包含几率因素的游戏 • 部分可观察博弈 • 博弈程序的当前发展水平

例子:MAX和MIN

• 问题的表述:MAX先行,然后两人轮流出 招,直到游戏结束。在游戏的最后,给优 胜者加分,给失败者罚分。

–剪枝算法

处理搜索树中的重复状态

• 在游戏中重复状态的频繁出现往往是因为 调换—导致同样棋局的不同行棋序列的排 列

– 例如,[a1, b1, a2, b2]和[a2, b2, a1, b1]都结束 于同样的棋局。

• 解决办法:第一次遇见某棋局时将对它的 评价存储在哈希表中(该哈希表称为调换 表)。