HTML解压缩抓取

从html中提取正文的方法

从html中提取正文的方法从HTML中提取正文的方法随着互联网的发展,网页内容呈现多样化的趋势,其中HTML是最常见的网页编程语言之一。

但是在浏览网页的过程中,我们往往只关注页面的主要内容,即正文部分。

如何从HTML中提取出正文内容,成为了一个非常重要的问题。

本文将介绍几种常用的方法来实现这一目标。

一、基于标签的提取方法HTML文档通常由一系列的标签组成,不同的标签有不同的作用和语义。

在提取正文时,我们可以根据标签的特点来进行筛选。

常用的标签有p、div、span等,这些标签通常用来包裹正文内容。

我们可以通过解析HTML文档,找到这些标签,并提取出其中的文本内容。

同时,我们还可以根据标签的属性进行筛选,比如class属性、id 属性等。

通过这种方法,我们可以较为准确地提取出正文内容。

二、基于文本密度的提取方法正文通常具有较高的文本密度,即正文部分的文字数量较多。

而其他非正文的内容,比如导航栏、广告等,通常具有较低的文本密度。

基于这个特点,我们可以通过计算页面中每个标签的文本密度,来判断其是否属于正文内容。

具体的方法可以是统计标签内文本的字符数或词数,然后除以标签的总字符数或词数,得到文本密度的比值。

根据这个比值的大小,我们可以判断标签是否为正文内容。

通过这种方法,我们可以较为准确地提取出正文内容。

三、基于机器学习的提取方法除了基于标签和文本密度的方法,还可以利用机器学习的方法来提取正文内容。

通过训练模型,我们可以将HTML文档中的各个标签和属性作为特征,将其对应的正文内容作为标签,然后利用已有的正文和非正文数据进行训练。

训练完成后,我们可以使用这个模型来预测新的HTML文档中的正文内容。

这种方法的优势在于可以适应不同的网页结构和样式,提取效果较为准确。

从HTML中提取正文内容是一个比较复杂的问题,但是通过合理的方法和技术手段,我们可以实现较为准确地提取。

基于标签、文本密度和机器学习的方法都具有一定的优势和适用场景,可以根据实际需求选择合适的方法。

网站数据爬取方法

网站数据爬取方法随着互联网的蓬勃发展,许多网站上的数据对于研究、分析和商业用途等方面都具有重要的价值。

网站数据爬取就是指通过自动化的方式,从网站上抓取所需的数据并保存到本地或其他目标位置。

以下是一些常用的网站数据爬取方法。

1. 使用Python的Requests库:Python是一种功能强大的编程语言,具有丰富的第三方库。

其中,Requests库是一个非常常用的库,用于发送HTTP请求,并获取网页的HTML内容。

通过对HTML内容进行解析,可以获取所需的数据。

2. 使用Python的Scrapy框架:Scrapy是一个基于Python的高级爬虫框架,可以帮助开发者编写可扩展、高效的网站爬取程序。

通过定义爬虫规则和提取规则,可以自动化地爬取网站上的数据。

3. 使用Selenium库:有些网站使用了JavaScript来加载数据或者实现页面交互。

对于这类网站,使用传统的爬虫库可能无法获取到完整的数据。

这时可以使用Selenium库,它可以模拟人为在浏览器中操作,从而实现完整的页面加载和数据获取。

4.使用API:许多网站为了方便开发者获取数据,提供了开放的API接口。

通过使用API,可以直接获取到所需的数据,无需进行页面解析和模拟操作。

5. 使用网页解析工具:对于一些简单的网页,可以使用网页解析工具进行数据提取。

例如,使用XPath或CSS选择器对HTML内容进行解析,提取所需的数据。

6.使用代理IP:一些网站为了保护自身的数据安全,采取了反爬虫措施,例如设置访问速度限制或者封锁IP地址。

为了避免被封禁,可以使用代理IP进行爬取,轮流使用多个IP地址,降低被封禁的风险。

7.使用分布式爬虫:当需要爬取大量的网站数据时,使用单机爬虫可能效率较低。

这时,可以使用分布式爬虫,将任务分发给多台机器,同时进行爬取,从而提高爬取效率。

8.设置合理的爬取策略:为了避免对网站服务器造成过大的负担,并且避免触发反爬虫机制,需要设置合理的爬取策略。

php截取html字符串及自动补全html标签的方法

php截取html字符串及自动补全html标签的方法摘要:一、引言二、PHP截取HTML字符串的方法1.使用函数2.使用DOM解析三、自动补全HTML标签的方法1.使用JavaScript2.使用jQuery四、实例演示五、总结正文:一、引言在Web开发中,HTML、CSS和JavaScript是最基本的技能。

随着前端技术的不断发展,我们需要掌握更多高效、简洁的方法来处理HTML字符串。

本文将详细介绍如何在PHP中截取HTML字符串及自动补全HTML标签的方法。

二、PHP截取HTML字符串的方法1.使用函数在PHP中,可以使用函数`substr`来截取HTML字符串。

以下是一个示例:```php$html = "<div class="content">Hello, World!<br>This is a sample HTML string.</div>";$substring = substr($html, 0, 20);echo $substring; // 输出:Hello, World!```2.使用DOM解析还可以使用DOM解析器来截取HTML字符串。

以下是一个示例:```php$html = "<div class="content">Hello, World!<br>This is a sample HTML string.</div>";$dom = new DOMDocument();@$dom->loadHTML($html);$node = $dom->getElementsByTagName("div");$substring = $node[0]->nodeValue;echo $substring; // 输出:Hello, World!```三、自动补全HTML标签的方法1.使用JavaScript在HTML中,可以使用JavaScript实现自动补全功能。

java获取html标签内容的方法

java获取html标签内容的方法在Java中,我们可以使用不同的方法来获取HTML标签的内容。

下面介绍几种常用的方法:1. 使用正则表达式:通过正则表达式可以方便地从HTML文档中提取标签内容。

我们可以使用`<标签名>(.*?)</标签名>`的正则表达式来匹配指定标签的内容,并提取出其中的文本。

示例代码如下:```javaString html = "<p>这是一个段落。

</p>";String pattern = "<p>(.*?)</p>";Pattern r = pile(pattern);Matcher m = r.matcher(html);if (m.find()) {String content = m.group(1);System.out.println(content);} else {System.out.println("未匹配到指定标签的内容");}```2. 使用Jsoup库:Jsoup是一个用于解析HTML的Java库,它提供了简洁易用的API来获取HTML标签的内容。

首先,需要使用Maven或者手动下载Jsoup,并将其引入到项目中。

然后,可以使用以下代码来获取指定标签的内容:```javaimport org.jsoup.Jsoup;import org.jsoup.nodes.Document;import org.jsoup.nodes.Element;String html = "<p>这是一个段落。

</p>";Document doc = Jsoup.parse(html);Element element = doc.select("p").first();String content = element.text();System.out.println(content);```3. 使用第三方库:除了Jsoup,还有其他一些开源的第三方库可以用于解析HTML,如HtmlUnit、NekoHTML等。

从html中提取正文的方法

从html中提取正文的方法从HTML中提取正文的方法在网页开发和数据处理中,经常需要从HTML文档中提取出正文内容,以便进行进一步的分析和处理。

本文将介绍一些常用的方法和技巧,以帮助读者快速准确地提取出HTML文档中的正文内容。

一、使用Python的Beautiful Soup库Beautiful Soup是Python的一个HTML/XML解析库,可以方便地从HTML文档中提取出所需的信息。

下面是一个使用Beautiful Soup 提取正文的示例代码:```pythonfrom bs4 import BeautifulSoupdef extract_content(html):soup = BeautifulSoup(html, 'html.parser')content = soup.get_text()return content```在上述代码中,首先导入Beautiful Soup库,并定义了一个名为`extract_content`的函数,用于提取正文。

然后,通过调用`BeautifulSoup`类的构造函数,将HTML文档传入,并指定解析器为'html.parser'。

接下来,使用`get_text`方法提取出所有的文本内容,并将其返回。

二、使用正则表达式如果对正则表达式较为熟悉,也可以使用正则表达式来提取正文。

下面是一个使用正则表达式提取正文的示例代码:```pythonimport redef extract_content(html):pattern = r'<p>(.*?)</p>'content = re.findall(pattern, html, re.S)return '\n'.join(content)```在上述代码中,首先导入re模块,并定义了一个名为`extract_content`的函数,用于提取正文。

从 html 提取文本的 7 个工具

从HTML提取文本的7个工具在互联网时代,信息爆炸,网页内容成了获取信息的重要渠道。

然而,网页虽然内容丰富,读取和分析起来却相对复杂,尤其是对于需要提取文本的人来说。

在这篇文章中,我将共享关于从HTML中提取文本的7个工具,帮助您更轻松获取您需要的信息。

1. BeautifulSoupBeautifulSoup是一个Python库,它能够从HTML或XML文件中提取数据。

通过BeautifulSoup, 不仅能够实现快速而方便的从网页获取数据,还能够解析各种标签和获取它们内部的内容。

与此BeautifulSoup还提供了对于CSS选择器的支持,以便更便捷筛选和提取特定的元素和文本。

BeautifulSoup是一个功能强大而灵活的工具,非常适合用于从HTML中提取文本数据。

2. ScrapyScrapy是一个用于抓取网站并从HTML、XML、JSON等文档中提取数据的框架,它基于Python语言。

相对于BeautifulSoup, Scrapy是一个更加强大的工具,它提供了更高级的功能和更复杂的数据提取方法。

通过Scrapy, 您可以轻松自定义数据提取的流程,并且能够简单处理网页中的各种异步加载或者登录问题。

3. Pandas虽然Pandas被广泛用于数据处理和分析,但它同样可以作为一个强大的HTML文本提取工具。

通过Pandas, 您可以直接将HTML文档转换成DataFrame对象,便于后续对数据的分析和处理。

4. SeleniumSelenium是一个用于Web应用程序测试的工具,但它同样可以用于HTML文本提取。

通过Selenium, 您可以模拟浏览器的行为,比如点击、输入、下拉等操作,以便更好获取网页中的数据。

由于Selenium 能够渲染JavaScript,因此它非常适合用于处理那些需要异步加载的网页,比如单页应用(SPA)。

5. JsoupJsoup是一个Java的HTML解析器,它提供了与jQuery相似的API,方便快速获取HTML文档中的元素和文本。

网页内容抓取工具哪个好用

网页内容抓取工具哪个好用互联网上目前包含大约几百亿页的数据,这应该是目前世界上最大的可公开访问数据库。

利用好这些内容,是相当有意思的。

而网页内容抓取工具则是一种可以将网页上内容,按照自己的需要,导出到本地文件或者网络数据库中的软件。

合理有效的利用,将能大大提高自己的竞争力。

网页内容抓取工具有哪些1. 八爪鱼八爪鱼是一款免费且功能强大的网站爬虫,用于从网站上提取你需要的几乎所有类型的数据。

你可以使用八爪鱼来采集市面上几乎所有的网站。

八爪鱼提供两种采集模式 - 简易模式和自定义采集模式,非程序员可以快速习惯使用八爪鱼。

下载免费软件后,其可视化界面允许你从网站上获取所有文本,因此你可以下载几乎所有网站内容并将其保存为结构化格式,如EXCEL,TXT,HTML或你的数据库。

2、ParseHubParsehub是一个很棒的网络爬虫,支持从使用AJAX技术,JavaScript,cookie 等的网站收集数据。

它的机器学习技术可以读取,分析然后将Web文档转换为相关数据。

Parsehub的桌面应用程序支持Windows,Mac OS X和Linux等系统,或者你可以使用浏览器中内置的Web应用程序。

作为免费软件,你可以在Parsehub中设置不超过五个publice项目。

付费版本允许你创建至少20private项目来抓取网站。

3、ScrapinghubScrapinghub是一种基于云的数据提取工具,可帮助数千名开发人员获取有价值的数据。

它的开源视觉抓取工具,允许用户在没有任何编程知识的情况下抓取网站。

Scrapinghub使用Crawlera,一家代理IP第三方平台,支持绕过防采集对策。

它使用户能够从多个IP和位置进行网页抓取,而无需通过简单的HTTP API进行代理管理。

Scrapinghub将整个网页转换为有组织的内容。

如果其爬虫工具无法满足你的要求,其专家团队可以提供帮助。

4、Dexi.io作为基于浏览器的网络爬虫,Dexi.io允许你从任何网站基于浏览器抓取数据,并提供三种类型的爬虫来创建采集任务。

爬虫提取数据的方法

爬虫提取数据的方法

爬虫提取数据的方法有:HTML解析、XPath或CSS选择器、API调用、正则表达式、数据库查询以及AJAX动态加载数据。

1.HTML解析:爬虫通常会下载网页的HTML源代码,然后使用HTML解析库(例如Beautiful Soup、PyQuery等)来提取所需的数据。

这些库允许您通过标签、类、属性等方式来定位和提取数据。

2.XPath或CSS选择器:XPath和CSS选择器是用于在HTML文档中定位和提取数据的强大工具。

XPath是一种用于选择HTML元素的语言,而CSS选择器是一种常用的用于选择样式表中的元素的语言。

您可以使用XPath和CSS 选择器来提取特定元素及其属性。

3.API调用:许多网站提供API(应用程序编程接口),允许开发者通过API 访问和获取数据。

使用爬虫时,您可以直接调用这些API获取数据,而无需解析HTML。

4.正则表达式:正则表达式是一种强大的文本处理工具,可以用于从HTML 源代码或文本中提取特定的模式数据。

通过编写适当的正则表达式,您可以捕获和提取所需的数据。

5.数据库查询:有些网站将其数据存储在数据库中。

爬虫可以模拟数据库查询语言(如SQL),直接向数据库发送查询请求并提取结果。

6.AJAX动态加载数据:某些网页使用AJAX技术动态加载数据。

在这种情况下,您可能需要使用模拟浏览器行为的工具(如Selenium)来处理JavaScript 渲染,并提取通过AJAX请求加载的数据。

爬虫爬取数据的方式和方法

爬虫爬取数据的方式和方法爬虫是一种自动化的程序,用于从互联网上获取数据。

爬虫可以按照一定的规则和算法,自动地访问网页、抓取数据,并将数据存储在本地或数据库中。

以下是一些常见的爬虫爬取数据的方式和方法:1. 基于请求的爬虫这种爬虫通过向目标网站发送请求,获取网页的HTML代码,然后解析HTML代码获取需要的数据。

常见的库有requests、urllib等。

基于请求的爬虫比较简单,适用于小型网站,但对于大型网站、反爬机制严格的网站,这种方式很容易被限制或封禁。

2. 基于浏览器的爬虫这种爬虫使用浏览器自动化工具(如Selenium、Puppeteer等)模拟真实用户操作,打开网页、点击按钮、填写表单等,从而获取数据。

基于浏览器的爬虫能够更好地模拟真实用户行为,不易被目标网站检测到,但同时也更复杂、成本更高。

3. 基于网络爬虫库的爬虫这种爬虫使用一些专门的网络爬虫库(如BeautifulSoup、Scrapy 等)来解析HTML代码、提取数据。

这些库提供了丰富的功能和工具,可以方便地实现各种数据抓取需求。

基于网络爬虫库的爬虫比较灵活、功能强大,但也需要一定的技术基础和经验。

4. 多线程/多进程爬虫这种爬虫使用多线程或多进程技术,同时从多个目标网站抓取数据。

多线程/多进程爬虫能够显著提高数据抓取的效率和速度,但同时也需要处理线程/进程间的同步和通信问题。

常见的库有threading、multiprocessing等。

5. 分布式爬虫分布式爬虫是一种更为强大的数据抓取方式,它将数据抓取任务分散到多个计算机节点上,利用集群计算和分布式存储技术,实现大规模、高效的数据抓取。

常见的框架有Scrapy-Redis、Scrapy-Cluster 等。

分布式爬虫需要解决节点间的通信、任务分配、数据同步等问题,同时还需要考虑数据的安全性和隐私保护问题。

htmlpage 方法解析

htmlpage 方法解析HTMLPage 类是一个用于解析和操作HTML 页面的重要工具。

这个类提供了多种方法来提取和处理HTML 页面中的数据。

以下是一些常用的HTMLPage 方法及其解析:提取Title:HTMLPage 类提供了提取HTML 页面标题(Title)的方法。

通过调用相应的函数或属性,可以轻松地获取页面的标题信息。

这对于需要分析页面内容或进行网页爬虫等任务非常有用。

解析body 中的节点:HTMLPage 类还可以解析HTML 页面的body 部分中的节点。

这意味着可以提取和操作页面中的各个元素,如段落、列表、链接等。

通过遍历节点树,可以访问和操作页面中的任何元素,从而实现复杂的数据提取或页面修改等操作。

提取页面中的TableTag 节点:HTMLPage 类提供了提取HTML 页面中Table 标签节点的方法。

这对于需要分析和处理表格数据的应用程序非常有用。

通过提取TableTag 节点,可以获取表格的行、列和单元格数据,并进行进一步的处理和分析。

查找节点中包含某个链接的总个数:HTMLPage 类还提供了查找节点中包含特定链接总数的方法。

这可以通过使用特定的Visitor 类(如LinkFindingVisitor)来实现。

通过遍历页面中的所有节点,并检查节点中是否包含指定的链接,可以计算出链接的总数。

这对于分析页面的链接结构或检测恶意链接等任务非常有用。

查找遍历的TextNode 中含有指定字符串的个数:HTMLPage 类还可以查找遍历的文本节点(TextNode)中包含指定字符串的个数。

这可以通过使用StringFindingVisitor 类来实现。

通过遍历页面中的所有文本节点,并检查节点中是否包含指定的字符串,可以计算出字符串出现的次数。

这对于搜索特定内容或进行文本分析等任务非常有用。

查找指定Tag 的所有节点:HTMLPage 类提供了查找指定标签(Tag)的所有节点的方法。

html解析原理

html解析原理HTML(Hypertext Markup Language)是一种用于创建网页的标记语言,它包含了描述网页结构、内容和样式的标记。

HTML解析是将HTML代码转换为可视化的网页的过程。

本文将介绍HTML解析原理,以及常用的HTML解析器和它们的工作方式。

一、HTML解析原理主要包括以下几个步骤:1. 词法分析(Lexical analysis):将HTML代码拆分为一个个标记(token),比如标签名、属性和属性值等。

2. 语法分析(Syntax analysis):根据HTML的语法规则,将词法分析得到的标记构建成一个树状结构,也称为DOM树(Document Object Model)。

DOM树表示了HTML代码的层次结构,包含了标签、文本、属性等元素。

3. 样式计算(Style calculation):根据CSS样式表,计算每个元素最终的样式。

这涉及到继承、层叠和优先级等CSS规则。

4. 布局(Layout):根据DOM树和计算得到的样式,确定每个元素在页面中的位置和大小。

这个过程也称为渲染树的构建。

5. 绘制(Paint):根据布局得到的渲染树,将每个元素绘制到屏幕上。

6. 重排与重绘(Reflow and repaint):当页面的布局或样式改变时,浏览器需要重新计算布局和绘制,这个过程称为重排和重绘。

二、常用HTML解析器1. HTML解析器:HTML解析器是将HTML代码解析为DOM树的工具。

常见的HTML解析器有JSoup、HtmlAgilityPack等。

JSoup是一款Java库,可以用于解析、处理和操作HTML。

它提供了方便的API,可用于提取指定标签、获取属性值、修改DOM树等操作。

HtmlAgilityPack是一款针对.NET平台的HTML解析器,其功能强大且具有较高的灵活性。

它可以通过XPath选择器遍历和操作DOM 树,适用于爬虫和数据抓取等领域。

html前端调取数据写法

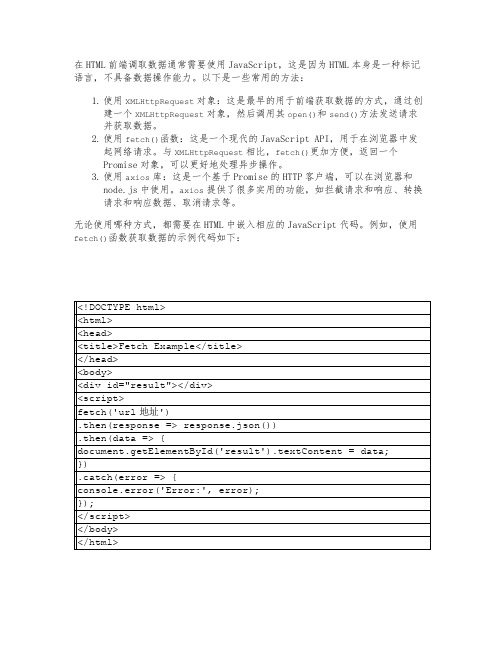

在HTML前端调取数据通常需要使用JavaScript,这是因为HTML本身是一种标记语言,不具备数据操作能力。

以下是一些常用的方法:

1.使用XMLHttpRequest对象:这是最早的用于前端获取数据的方式,通过创

建一个XMLHttpRequest对象,然后调用其open()和send()方法发送请求并获取数据。

2.使用fetch()函数:这是一个现代的JavaScript API,用于在浏览器中发

起网络请求。

与XMLHttpRequest相比,fetch()更加方便,返回一个

Promise对象,可以更好地处理异步操作。

3.使用axios库:这是一个基于Promise的HTTP客户端,可以在浏览器和

node.js中使用。

axios提供了很多实用的功能,如拦截请求和响应、转换请求和响应数据、取消请求等。

无论使用哪种方式,都需要在HTML中嵌入相应的JavaScript代码。

例如,使用fetch()函数获取数据的示例代码如下:。

如何进行数据处理中的数据抓取(四)

数据抓取是数据处理中的重要一环,它指的是从互联网或其他数据源中提取数据的过程。

数据抓取的目的是为了获取所需数据,以进行后续的分析、建模和应用。

本文将探讨数据抓取的基本原理、方法和常见技术,以及如何进行高效的数据抓取。

一、数据抓取的基本原理数据抓取的基本原理是通过网络请求和解析HTML或其他数据格式,从网页或其他数据源中提取所需数据。

通常,数据抓取的过程可以分为以下几个步骤:1. 发送请求:使用HTTP协议向目标网页或API发送请求,获取网页内容或数据。

2. 解析页面:通过解析HTML或其他数据格式,提取出需要的数据。

这可以通过正则表达式、XPath、CSS选择器等方法来实现。

3. 存储数据:将提取到的数据存储到数据库、文件或其他数据结构中,以便后续的处理和分析。

二、数据抓取的方法和技术1. 基于HTTP协议的数据抓取:这是最常见的数据抓取方法。

通过发送HTTP请求,并使用合适的请求头和参数,可以模拟浏览器行为,获取网页内容或API返回的数据。

常用的HTTP库有Python的requests、Java的HttpClient等。

2. 使用爬虫框架:爬虫框架是一种高效的数据抓取工具,它提供了一系列封装好的功能,如发送HTTP请求、解析页面、处理反爬虫机制等。

例如,Python的Scrapy框架就是一个强大的数据抓取工具。

3. 数据抓取工具和软件:市面上也有许多数据抓取工具和软件,如八爪鱼、WebHarvy等。

这些工具通常提供了可视化的界面和配置选项,方便非技术人员进行数据抓取。

4. 使用API接口:有些数据源提供了API接口,开放了部分数据供开发者使用。

通过调用API接口,可以直接获取所需数据,无需进行页面解析。

使用API接口可以提高数据抓取效率和精确度。

三、高效的数据抓取策略1. 了解数据源:在进行数据抓取之前,要先了解所需数据的来源和数据源的特点。

这包括网页的结构、数据的存储方式、反爬虫机制等。

对数据源有充分的了解,可以避免冗余的抓取和处理,提高效率。

抓取在线文件的方法

抓取在线文件的方法

1. 使用网页爬虫,如果文件可以通过网页访问,你可以编写一个网页爬虫程序来抓取文件。

你可以使用Python的BeautifulSoup 或Scrapy等库来编写爬虫程序,或者使用其他语言的类似工具。

通过分析网页结构,找到文件的URL并下载即可。

2. 使用API,一些网站提供API接口,允许你通过编程方式获取文件。

你可以查看网站的文档,了解他们的API接口和如何使用它们来获取文件。

3. 使用特定软件或工具,有些网站可能提供特定的软件或工具来下载他们的文件。

这些软件可能是专门为了方便用户下载文件而设计的,你可以尝试使用这些软件来获取你需要的文件。

4. 使用命令行工具,有些文件可以通过命令行工具来获取,比如使用curl或wget命令来下载文件。

这些工具通常可以通过命令行参数指定需要下载的文件的URL和其他参数。

无论你选择哪种方法,都需要注意遵守网站的使用条款和法律法规,确保你的行为是合法的并且尊重网站的规定。

另外,一些网

站可能对频繁的文件抓取行为进行限制,你需要确保你的抓取行为不会对网站造成不必要的负担或影响其他用户的正常使用。

html获取文本的三种方法

html获取文本的三种方法

获取HTML文本的三种方法包括使用JavaScript的innerText

属性、使用jQuery的text()方法以及使用服务器端的解析方法。

首先,可以使用JavaScript的innerText属性来获取HTML元

素的文本内容。

这种方法适用于纯文本内容,它会返回元素及其所

有后代元素的文本内容,但不包括隐藏的元素或者通过CSS隐藏的

元素。

例如,可以通过

document.getElementById("elementId").innerText来获取特定元

素的文本内容。

其次,使用jQuery的text()方法也是获取HTML文本的一种常

见方法。

这个方法可以用来获取指定元素的文本内容,它会返回指

定元素的所有后代元素的文本内容,但不包括任何HTML标记。

例如,可以通过$("#elementId").text()来获取特定元素的文本内容。

最后,还可以使用服务器端的解析方法来获取HTML文本。

这种

方法适用于需要在服务器端处理HTML文本的情况,可以使用各种编

程语言(如Python的BeautifulSoup库、PHP的DOMDocument类等)来解析HTML文本并提取所需内容。

总之,以上提到的三种方法分别是使用JavaScript的innerText属性、使用jQuery的text()方法以及使用服务器端的解析方法来获取HTML文本的常见途径。

每种方法都有其适用的场景和特点,可以根据具体需求选择合适的方法来获取HTML文本。

html 获取当前文件夹路径的方法

html 获取当前文件夹路径的方法(实用版2篇)目录(篇1)1.获取当前文件夹路径的背景和需求2.实现获取当前文件夹路径的方法3.示例代码和解释4.总结和建议正文(篇1)一、获取当前文件夹路径的背景和需求在网页开发中,我们经常需要获取当前页面所在的文件夹路径,以便于进行文件操作、路径设置等相关任务。

特别是在使用 JavaScript 进行本地文件处理时,获取当前文件夹路径显得尤为重要。

二、实现获取当前文件夹路径的方法要实现获取当前文件夹路径的方法,我们可以使用 HTML 的`<script>`标签在网页中嵌入 JavaScript 代码。

通过 JavaScript 的`window.location.href`属性,我们可以获取当前页面的完整 URL,然后使用正则表达式提取文件夹路径。

三、示例代码和解释下面是一个简单的示例代码,用于获取当前页面所在的文件夹路径:```html<!DOCTYPE html><html lang="zh-CN"><head><meta charset="UTF-8"><title>获取当前文件夹路径示例</title><script>function getCurrentDirectory() {const url = window.location.href;const regex = /^.*/(.*)$/;const result = url.match(regex);if (result) {return result[1];} else {return "";}}document.write(getCurrentDirectory());</script></head><body></body></html>```在这个示例中,我们定义了一个名为`getCurrentDirectory`的函数。

[转帖]利用HtmlAgilityPack抓取XX网站图片并下载~~~~~~邪恶版。。。。

![[转帖]利用HtmlAgilityPack抓取XX网站图片并下载~~~~~~邪恶版。。。。](https://img.taocdn.com/s3/m/4a4885bfdc3383c4bb4cf7ec4afe04a1b071b06d.png)

[转帖]利⽤HtmlAgilityPack抓取XX⽹站图⽚并下载~~~~~~邪恶版。

--声明啊(运⾏后,我不是您想的那种⼈的。

)--!!我看到已经有2⼈反对了这篇⽂章,真是打击呀,我也没怎么伤天害理嘛,⼿下留情,please...由于提前到了学校,昨晚逛博客园的时候,意外发现了HtmlAgilityPack这个好东东,是微软的⼀个类库,⽤来分析Html页⾯的结构啊,等等。

不得不说,HtmlA gilityPack很强⼤,我⽤的很爽啊。

抓取博客园的数据啊等等。

(我搜了⼀些,发现仅仅是抓取⽂字的⽂章,于是⼀个邪恶的念头出现咋我脑海中,我就好奇的试了试。

⼀番折腾后,结果是可⾏的啦,发给我以朋友试了试,结果可以,。

语⽆伦次了。

(别见怪啊啊))记住哦!,在E盘下新建⼀个DownLoadImg⽂件夹主要代码如下:WebClient wc = new WebClient();private static int i = 0;protected void Page_Load(object sender, EventArgs e){}protected void Button1_Click(object sender, EventArgs e){HtmlWeb web = new HtmlWeb();string imgurl = "";//⽬前⼀般XX(你懂的...)⽹站,都是以.../版块/yyyymmdd/⼀堆数字.html结尾//由于XX⽹站⼀般分为好⼏个版块,所以每个.html⽂件在同⼀版块下并不是连续的//我⽤了外层两层循环,最外层循环yyyymmdd(⽇期如2012-02-15)//内层是循环每个.html⽂件,当然你可以⾃⼰修改两个循环for (int k = 20120215; k <= 20120215; k++){for (int j = 124289; j <= 124306; j++){string cnblogs = "";//看这⾥,需要填写某⼀⽹站的格式,在源码下载⾥有HtmlDocument doc = web.Load(cnblogs);HtmlNode node = doc.GetElementbyId("ks_xp");if (node == null){continue;}else{foreach (HtmlNode child in node.SelectNodes("//img")){if (child.Attributes["src"] == null)continue;imgurl = child.Attributes["src"].Value.ToString();DownLoadImg(imgurl);DownLoadImg(imgurl);}}}}}public void DownLoadImg(string url){i++;//string newfilename = DateTime.Now.Year.ToString() + DateTime.Now.Month.ToString() + DateTime.Now.Day.ToString() + DateTime.Now.Hour.ToString() + DateTime.Now.Mi nute.ToString() + DateTime.Now.Second.ToString() + ".jpg";//罪魁祸⾸啊,假如⽤上⾯的名字做为图⽚的名字,会有如下问题//不能把所有图⽚下载下来,因为时间的粒度是秒,⽽不是所有的图⽚都是⼀秒⼀张的,所以进程会⾃动跳过下载。

数据抓取的基本原理

数据抓取的基本原理随着网络技术的不断发展,互联网上的数据量也越来越大,数据的价值也变得越来越重要。

而数据抓取技术,作为一种从互联网上自动获取数据的技术手段,已经成为了现代网络应用开发不可或缺的一部分。

那么,数据抓取是如何实现的呢?本文将会从数据抓取的基本原理出发,为大家介绍数据抓取的实现方式和技术要点。

一、数据抓取的定义数据抓取,也称为网络爬虫(Web Crawler),是一种自动化的抓取互联网上的数据的技术手段。

它主要通过模拟人的浏览行为,访问指定的网站,获取其中的数据并进行分析处理,最终将数据存储到本地或远程服务器上。

二、数据抓取的实现方式数据抓取的实现方式主要有两种:基于页面解析的抓取和基于接口调用的抓取。

1. 基于页面解析的抓取基于页面解析的抓取,是指通过模拟浏览器访问页面的方式,解析页面中的HTML、CSS、Javascript等标记语言和脚本,从而获取页面中所需的数据。

这种方式可以用Python的BeautifulSoup、Scrapy等开源框架实现。

2. 基于接口调用的抓取基于接口调用的抓取,是指通过调用网站的API接口,获取需要的数据。

这种方式相比于基于页面解析的抓取,更加高效可靠,因为API接口一般都是按照一定的规范设计的,而网页的结构和数据内容都是不确定的。

这种方式可以使用Python的requests、urllib 等库实现。

三、数据抓取的技术要点数据抓取的技术要点主要包括:请求头设置、IP代理设置、反爬虫策略等。

1. 请求头设置在进行数据抓取时,很多网站会对请求头进行检测,如果发现请求头中的信息不符合要求,就会拒绝请求。

因此,在进行数据抓取时,需要设置合适的请求头,包括User-Agent、Referer等信息,以模拟正常的浏览器访问行为。

2. IP代理设置为了防止被网站封禁IP,需要使用IP代理,即使用一个IP代理服务器来转发请求。

这样,即使被封禁了某个IP,也可以通过更换IP代理服务器来继续进行数据抓取。

Python网络爬虫中的新闻抓取与摘要生成技术

Python网络爬虫中的新闻抓取与摘要生成技术在当今的信息时代,新闻资源已变得极度丰富且多样化,但大量的信息却给用户带来了浏览和阅读上的困扰。

因此,如何通过高效的方式获取感兴趣的新闻,并生成简洁准确的摘要成为了迫切需要解决的问题。

在Python网络爬虫中,新闻抓取与摘要生成技术成为了一项重要的研究和应用领域。

一、新闻抓取技术1.1 HTML解析在爬取新闻网站数据时,首先需要了解目标网站的HTML结构。

通过Python的HTML解析库(如BeautifulSoup、lxml等),可以方便地提取网页中的文本、链接、图片以及其他需要的信息。

1.2 数据爬取利用Python的网络请求库(如Requests),可以向目标网站发送HTTP请求并获取响应数据。

通过解析网页,可以提取到新闻文章的标题、正文、发布时间等,并进行数据清洗和整理。

1.3 反爬机制应对为了防止被频繁访问和数据抓取,许多新闻网站采取了反爬机制。

为了规避这些机制,可以使用轮换IP、设置请求头信息、合理限制请求频率等手段,保证数据的正常获取。

二、新闻摘要生成技术2.1 文本摘要文本摘要是把长篇文本压缩为几个句子的过程,通过提取关键信息和重要内容,生成简洁明了的摘要。

在Python中,有多种算法可用于文本摘要生成,如基于统计的TF-IDF、基于图算法的TextRank和深度学习模型等。

2.2 关键词提取关键词提取是对新闻文章进行分析,将文章中的重点词汇提取出来。

Python中的库如jieba、NLTK等可以用于对中文和英文文章进行分词,并提取高频词和有意义的关键词。

2.3 摘要生成模型借助Python中的自然语言处理(NLP)库,如NLTK、gensim等,我们可以构建各种模型来生成摘要。

例子包括基于频次的抽取式摘要、基于概率图模型的生成式摘要等。

三、应用场景与发展趋势3.1 自动化新闻生成利用Python网络爬虫技术和新闻摘要生成技术,可以实现自动化的新闻生成。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

public static String getZipMETHODhtml(String cookie,String

htmltype,String httpurl,String method,String params,Boolean changeline) throws IOException {

URL urlx = new URL(httpurl);

HttpURLConnection uc = (HttpURLConnection)

urlx.openConnection();

uc.setFollowRedirects(true);

uc.setInstanceFollowRedirects(true);

uc.setDoOutput(true); // 闇� 鍚戞湇鍔″櫒鍐欐暟鎹�

uc.setDoInput(true); //

uc.setUseCaches(false); // 鑾峰緱鏈嶅姟鍣ㄦ渶鏂扮殑淇℃伅

uc.setAllowUserInteraction(false);

uc.setRequestMethod(method);

uc.setConnectTimeout(10*1000); //10缂佸 甯熺换娑㈠箳閵夈劎孝闁跨噦鎷�

uc.setReadTimeout(10*1000); //30缂佸 甯熼 浼村矗閺嶎剛

孝闁跨噦鎷�

uc.setRequestProperty("Cache-Control", "no-cache,

must-revalidate");

uc.setRequestProperty("Connection", "Keep-Alive");

uc.setRequestProperty("Accept","image/gif, image/x-xbitmap, image/jpeg, image/pjpeg, application/msword, application/vnd.ms-excel, application/vnd.ms-powerpoint, application/x-shockwave-flash, */*");

uc.setRequestProperty("Accept-Language", "zh-cn");

// uc.setRequestProperty("Accept-Encoding", "gzip, deflate");

uc.setRequestProperty("Content-Type",

"application/x-www-form-urlencoded");

uc.setRequestProperty("User-Agent","Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 5.1; SV1)");

if(cookie!=null && !cookie.trim().equals(""))

{

cookie=cookie.replaceAll("\n","");

uc.setRequestProperty("Cookie",cookie);

}

if(method.equals("POST"))

{

uc.getOutputStream().write(params.getBytes());

}

String vhtml = "";

java.io.InputStream inputstream=null;

// try {

// inputstream= uc.getInputStream();

// } catch (Exception e) {

// // TODO Auto-generated catch block

// //e.printStackTrace();

//

System.out.println("InputStream--StringIndexOutOfBoundsException" );

// return "";

// }

try {

inputstream=new

GZIPInputStream(uc.getInputStream());

//解压缩

} catch (Exception e) {

// TODO Auto-generated catch block

inputstream= uc.getInputStream();

System.out.println("解压缩失败");

//e.printStackTrace();

}

BufferedReader bufferedreader = null;

if(htmltype==null||htmltype.trim().equals(""))bufferedreader = new BufferedReader(new InputStreamReader(inputstream));

else bufferedreader = new BufferedReader(new

InputStreamReader(inputstream,htmltype));

String s1;

//String vhtml = "";

while ((s1 = bufferedreader.readLine()) != null) {

if(changeline!=null&& changeline==false)vhtml = vhtml + s1;

else vhtml = vhtml + "\n" + s1;

}

return vhtml;

}。