双机Linux集群服务器的实现

linux双机热备方案

linux双机热备方案在现代信息技术高速发展的背景下,高可用性和数据安全性成为企业日常运营中非常重要的课题。

特别是对于采用Linux操作系统的企业来说,实施一个可靠的双机热备方案是至关重要的。

本文将介绍一种基于Linux操作系统的双机热备方案,以帮助企业实现高可用性和数据容灾。

一、方案概述双机热备方案是通过利用两台运行相同应用和环境的服务器,以实现故障转移和数据灾备的目的。

在该方案中,主服务器负责处理正常的业务请求,而备用服务器则实时复制主服务器上的数据和配置信息,并保持与主服务器的高度同步。

一旦主服务器发生故障,备用服务器将自动接管业务,并在最短的时间内实现故障恢复。

二、硬件要求在部署Linux双机热备方案之前,首先需要确保服务器硬件满足要求。

这包括两个方面:1. 服务器性能要求:主服务器和备用服务器的硬件性能应该相当,以确保业务在两台服务器之间的切换时不会出现性能瓶颈。

服务器应具备足够的处理能力和内存容量,以支持所运行的应用和服务。

2. 存储设备要求:为了实现数据的高可用性和容灾备份,主服务器和备用服务器应采用相同的存储设备。

这可以保证数据在主备服务器之间的实时同步和复制。

三、软件配置在Linux双机热备方案中,需要配置一系列软件来实现主备服务器之间的数据同步和故障转移。

以下是必要的软件配置内容:1. Heartbeat软件:Heartbeat是一种开源软件工具,用于检测主服务器的可用性。

它会定期发送心跳信号给备用服务器,以确认主服务器的正常运行。

一旦主服务器发生故障,备用服务器将接收到心跳信号的中断,并立即启动故障切换操作。

2. DRBD软件:DRBD是一种分布式块设备复制工具,在主备服务器之间实现数据的实时同步。

通过配置DRBD,主服务器上的数据将实时复制到备用服务器上,从而保持数据的高可用性和一致性。

3. Cluster软件:Cluster软件用于管理和控制主备服务器之间的故障转移。

它可以自动监测主服务器的状态,并在主服务器发生故障时触发备用服务器的接管操作,以实现业务的持续运行。

有两台服务器如何做双机热备

有两台服务器如何做双机热备双机热备是一种常见的服务器配置方式,可以提高系统的可用性和容错性。

通过配置两台服务器,当其中一台服务器出现故障时,另一台服务器可以立即接管工作,确保系统的连续性和稳定性。

本文将介绍如何进行双机热备配置,以及配置过程中需要注意的问题。

一、双机热备的基本原理双机热备的基本原理是将两台服务器配置为主备关系。

其中一台服务器作为主服务器(Master),负责处理用户请求和业务逻辑;另一台服务器作为备服务器(Backup),处于待命状态,等待接管主服务器的工作。

主备服务器之间通过网络进行通信,保持数据的同步和一致性。

二、双机热备的配置步骤1. 确定主备服务器的角色和IP地址:首先需要确定哪台服务器将担任主服务器,以及每台服务器的IP地址。

主服务器通常配置为具备更高性能的服务器,而备服务器则配置为相对较低性能的服务器。

2. 安装并配置操作系统:在两台服务器上安装并配置相同版本的操作系统,确保操作系统的版本和配置相同,以保证数据的一致性。

常见的操作系统包括Windows Server和Linux等。

3. 安装并配置数据库和应用程序:根据实际需求,在主备服务器上安装并配置相同版本的数据库和应用程序。

数据库和应用程序的版本、配置和数据结构需要保持一致,以确保数据的同步和一致性。

4. 配置网络和通信:配置主备服务器之间的网络和通信,确保主备服务器可以相互通信并进行数据同步。

可以使用局域网(LAN)或广域网(WAN)进行通信,常见的网络通信协议包括TCP/IP等。

5. 配置双机热备软件:选择并安装适用于双机热备的软件,常见的软件包括Heartbeat、Keepalived和Pacemaker等。

这些软件可以监控主服务器的运行状态,一旦主服务器发生故障,备服务器可以立即接管。

6. 测试和验证:在配置完成后,进行测试和验证,确保主备服务器能够正常工作。

可以模拟主服务器宕机的情况,观察备服务器是否能够顺利接管,并能够继续处理用户请求和业务逻辑。

服务器双机热备解决方案

服务器双机热备解决方案服务器双机热备解决方案是一种为服务器提供高可用性和容错能力的解决方案。

通过使用两台服务器进行镜像备份和故障切换,可以实现在主服务器故障时无缝地切换到备份服务器,确保系统的连续可用性。

以下是一个详细的服务器双机热备解决方案。

1. 硬件配置:首先,选择两台具备相同规格和配置的服务器作为主备服务器,确保它们具备相同的处理能力、存储容量和网络连接性能。

在服务器之间建立高速互联通道,如双机网卡冗余链接(Multiple Network Interface Redundancy)或光纤通道(Fibre Channel),确保数据传输的稳定和可靠性。

2.系统镜像备份:在主服务器上完成系统的安装和配置后,制作主服务器的系统镜像,并定期更新备份服务器的系统镜像。

可以使用备份软件或快照工具来实现系统镜像的制作和恢复。

3. 数据同步:使用数据复制技术实现主备服务器之间数据的实时同步。

常用的数据同步方式包括同步复制(Synchronous Replication)和异步复制(Asynchronous Replication)。

在同步复制中,主服务器将数据写入备份服务器之前,需要确认数据已经被写入备份服务器。

而在异步复制中,主服务器将数据写入备份服务器后马上返回,不等待备份服务器的确认。

根据需求和实际情况选择适当的数据同步方式。

4. 心跳检测:为了监测主备服务器的状态并确保高可用性,需要在主备服务器之间建立心跳检测机制。

心跳检测可以通过心跳包(Heartbeat)或集群管理软件实现。

当主服务器发生故障时,备份服务器可以通过接收不到心跳信号来判断主服务器的故障,并开始服务切换过程。

5. 故障切换:主服务器发生故障后,备份服务器需要尽快接管主服务器的工作。

在故障切换过程中,需要确保数据的一致性和完整性。

可以通过一些技术手段来实现故障切换,如虚拟IP(Virtual IP)、磁盘共享(Shared Disk)或共享文件系统(Shared File System)等。

利用Linux操作系统进行服务器集群管理

利用Linux操作系统进行服务器集群管理在当今信息时代,服务器集群已经成为现代企业中不可或缺的一部分。

而要有效地管理服务器集群,利用Linux操作系统是一个明智的选择。

本文将介绍如何利用Linux操作系统进行服务器集群管理。

一、服务器集群管理的基本概念服务器集群是由多台服务器组成的,旨在提高系统的可靠性、可用性和性能。

服务器集群管理的核心目标是促进集群中服务器的协同工作以提供高负载、高性能和高可用性的服务。

二、Linux操作系统简介Linux操作系统是一个免费且开源的操作系统,具有出色的稳定性和安全性,广泛应用于服务器领域。

Linux操作系统提供了一系列工具和命令,用于管理集群中的多台服务器。

三、服务器集群管理工具1. SSH(Secure Shell)SSH是一种网络协议,可用于在两个网络设备之间进行加密通信。

通过SSH,管理员可以在远程终端登录服务器,执行管理操作。

2. Shell脚本Shell脚本是一种在Linux操作系统中编写的可执行脚本,用于批量执行一系列命令。

管理员可以编写Shell脚本来进行服务器集群管理任务,如自动化安装软件、配置系统参数等。

3. rsyncrsync是一种高效的文件复制工具,可用于在服务器之间同步文件和目录。

管理员可以使用rsync命令将文件从一台服务器复制到集群中的其他服务器,实现数据的同步和备份。

4. PacemakerPacemaker是一个开源的高可用性集群管理软件,可用于监控和管理服务器集群中的资源。

通过配置Pacemaker,管理员可以实现自动故障切换和负载均衡等功能。

四、利用Linux操作系统进行服务器集群管理的步骤1. 安装Linux操作系统首先,管理员需要在每台服务器上安装Linux操作系统。

可以选择适合企业需求的Linux发行版,如Ubuntu、CentOS等。

2. 配置SSH登录在每台服务器上,管理员需要配置SSH服务,以便能够通过SSH 协议远程登录服务器。

服务器双机热备方案

双机热备方案双机热备针对的是服务器的临时故障所做的一种备份技术,通过双机热备,来避免长时间的服务中断,保证系统长期、可靠的服务。

1.集群技术在了解双机热备之前,我们先了解什么是集群技术。

集群(Cluster)技术是指一组相互独立的计算机,利用高速通信网络组成一个计算机系统,每个群集节点(即集群中的每台计算机)都是运行其自己进程的一个独立服务器。

这些进程可以彼此通信,对网络客户机来说就像是形成了一个单一系统,协同起来向用户提供应用程序、系统资源和数据,并以单一系统的模式加以管理。

一个客户端(Client)与集群相互作用时,集群像是一个独立的服务器。

计算机集群技术的出发点是为了提供更高的可用性、可管理性、可伸缩性的计算机系统。

一个集群包含多台拥有共享数据存储空间的服务器,各服务器通过内部局域网相互通信。

当一个节点发生故障时,它所运行的应用程序将由其他节点自动接管。

其中,只有两个节点的高可用集群又称为双机热备,即使用两台服务器互相备份。

当一台服务器出现故障时,可由另一台服务器承担服务任务,从而在不需要人工干预的情况下,自动保证系统能持续对外提供服务。

可见,双机热备是集群技术中最简单的一种。

2. 双机热备适用对象一般邮件服务器是要长年累月工作的,且为了工作上需要,其邮件备份工作就绝对少不了。

有些企业为了避免服务器故障产生数据丢失等现象,都会采用RAID技术和数据备份技术。

但是数据备份只能解决系统出现问题后的恢复;而RAID技术,又只能解决硬盘的问题。

我们知道,无论是硬件还是软件问题,都会造成邮件服务的中断,而RAID及数据备份技术恰恰就不能解决避免服务中断的问题。

要恢复服务器,再轻微的问题或者强悍的技术支持,服务器都要中断一段时间,对于一些需要随时实时在线的用户而言,丢失邮件就等于丢失金钱,损失可大可小,这类用户是很难忍受服务中断的。

因此,就需要通过双机热备,来避免长时间的服务中断,保证系统长期、可靠的服务。

Linux平台Apache高可用双机集群Tomcat负载均衡集群配置手册

Linux平台Apache双机高可用集群+ Tomcat负载均衡集群配置手册在这个配置手册中,使用的操作系统和软件清单如下:操作系统:RedHat Enterprise Linux AS4 U4 64bit(安装时最好选择完全安装)软件:jdk-1_5_0_15-linux-amd64.binTomcat5.5.26httpd-2.0.63.tar.gzjakarta-tomcat-connectors-jk2-src-current.tar.gzipvsadm-1.24.tar.gzlibnet.tar.gzheartbeat-2.1.3-3.el4.centos.x86_64.rpmheartbeat-pils-2.1.3-3.el4.centos.x86_64.rpmheartbeat-stonith-2.1.3-3.el4.centos.x86_64.rpm因为是linux操作系统,所以在安装软件时请使用对应自己操作系统内核的软件,这是整个集群成功的第一步。

本配置手册中的软件都是对应RedHat Enterprise Linux AS4 U4 64bit 这个版本的软件。

jdk-1_5_0_15-linux-amd64.binJAVA环境包使用的是64位1.5版Tomcat版本为公司指定的5.5版本Apache为2.0.63版jakarta-tomcat-connectors-jk2-src-current.tar.gz是连接Apache和Tomcat的连接插件,具体可以去Tomcat网站上查找下载ipvsadm-1.24.tar.gzlibnet.tar.gz这两个是用于2台Apache服务器虚拟一个IP地址使用heartbeat-2.1.3-3.el4.centos.x86_64.rpmheartbeat-pils-2.1.3-3.el4.centos.x86_64.rpmheartbeat-stonith-2.1.3-3.el4.centos.x86_64.rpm这3个软件是用于2台Apache服务器之间的心跳检测结构图Apache1以以以以以Tomcat1Tomcat2Apache22台Tomcat服务器使用Tomcat软件可以自己做集群,2台Apache服务器需要其他的软件实现虚拟服务器功能,工作站访问虚拟IP地址访问2台Apache服务器,再通过Apache服务器访问Tomcat服务器第3 页总13 页1.安装JAVA环境包1)输入命令:./ jdk-1_5_0_15-linux-amd64.bin执行完毕后,会在当前目录下生成一个JDK-1.5.0_15的文件夹2)在 /usr/local/下新建一个名字为JAVA文件夹,将个JDK-1.5.0_15的文件夹拷入到该文件夹下3)设置环境变量。

集群和双机的区别

集群存储软件与双机热备的性能对比集群存储软件是几乎和双机热备一同产生的技术,但是为什么在市场占有率上失去了优势,这是一直都在探究的问题,下面我们就详细的了解下集群存储软件的相关知识。

在双机热备应用方面,有两大类软件产品。

一类是双机软件(HA),另一类则称作集群存储软件(Cluster),这两类软件是有差异的。

它们都是为实现系统的高可用性服务的,都解决了一台服务器出现故障时,由其他服务器接管应用,从而持续可靠地提供服务的问题。

它们都是通过心跳技术在进行系统检测。

但是,双机软件只能支持两台服务器以主从方式或互备方式工作。

而集群存储软件除了支持双机工作外,还可以支持多台服务器(Multi Node)工作,同时部署多个应用,并在多个服务器间灵活地设置接管策略。

在两种情况下需要使用集群存储软件:一是有超过两个应用,本身就需要部署三台或更多的服务器。

二是只有两个应用,但每个应用的负载均较大,不宜采用双机互备的方式,而是需要由第三台服务器来作为这两个应用的备机。

一般地讲,集群存储软件具有更多的技术含量,具备更高的可靠性。

同时,往往价格(平均到每台服务器)也高于双机软件。

在选择产品时,应根据应用的实际情况来确定。

最理想的方式,则是在应用数量少、负载不是很大时先使用双机软件,然后在应用数量增多、负载增大时平滑过渡到集群存储软件。

双机备份和集群的原理与比较什么是双机热备?所谓双机热备就是使用互为备份的两台服务器共同执行同一服务,其中一台主机为工作机(Primary Server),另一台主机为备份机(Standby Server)。

在系统正常情况下,工作机为应用系统提供服务,备份机监视工作机的运行情况(工作机同时也在检测备份机是否正常),当工作机出现异常,不能支持应用系统运营时,备份机主动接管工作机的工作,继续支持关键应用服务,保证系统不间断的运行。

什么情况下需要采用双机热备?用户可以根据系统的重要性以及终端用户对服务中断的容忍程度决定是否使用双机热备。

两台linux主机传送大文件的方法-解释说明

两台linux主机传送大文件的方法-概述说明以及解释1.引言1.1 概述概述:在进行文件传输时,Linux主机之间有多种方法可供选择。

本文将介绍三种常用的方法:使用SCP命令进行文件传输、使用rsync命令进行文件传输,以及使用FTP服务器进行文件传输。

这些方法各有优缺点,我们将对它们进行详细的比较和总结。

同时,我们也会给出我们的最佳推荐方法,并展望未来的发展方向。

文件传输在日常工作和生活中非常常见,特别是在Linux环境下。

无论是在服务器之间进行文件备份、数据同步,还是在不同的开发环境中共享文件,选择合适的文件传输方法能够提高效率、节省时间。

在接下来的章节中,我们将详细介绍每种方法的基本用法和高级用法,并分析它们的优缺点。

首先,我们将介绍SCP命令,它是一种简单直观的文件传输方式。

然后,我们将介绍rsync命令,它提供了更为灵活和高效的文件传输选项。

最后,我们将介绍FTP服务器的搭建和使用方法,探讨它的优势和不足。

通过对这些方法的比较和分析,我们将总结出每种方法的适用场景,并给出我们的最佳推荐方法。

此外,我们也会对未来的文件传输技术发展进行展望,以期提升文件传输的速度、安全性和便利性。

通过本文的阅读,读者将能够了解到不同的文件传输方法之间的差异,为自己的工作环境选择合适的传输方式提供参考和指导。

接下来,让我们开始介绍第一种传输方法:使用SCP命令进行文件传输。

1.2文章结构文章结构部分内容如下:2. 正文2.1 方法一:使用SCP命令进行文件传输2.1.1 SCP命令的基本用法2.1.2 SCP命令的高级用法2.1.3 SCP命令的优缺点2.2 方法二:使用rsync命令进行文件传输2.2.1 rsync命令的基本用法2.2.2 rsync命令的高级用法2.2.3 rsync命令的优缺点2.3 方法三:使用FTP服务器进行文件传输2.3.1 搭建FTP服务器2.3.2 使用FTP客户端进行文件传输2.3.3 FTP服务器的优缺点3. 结论3.1 对比和总结各种方法的优缺点3.2 推荐最佳的方法3.3 展望未来的发展方向在本文中,我们将重点探讨两台Linux主机之间传送大文件的方法。

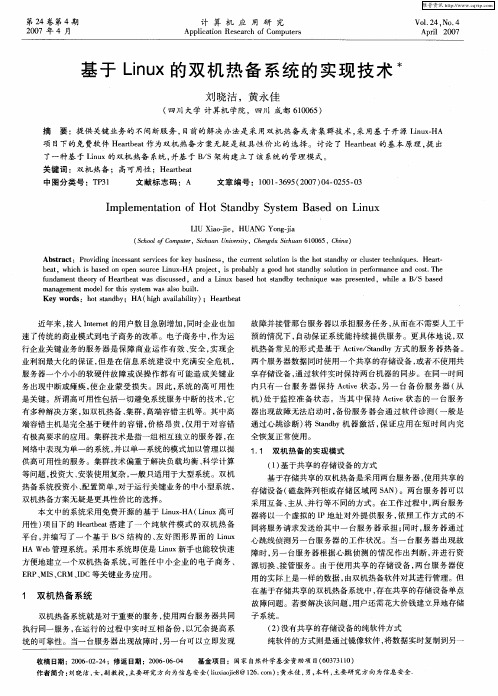

基于Linux的双机热备系统的实现技术

I lme tto fHo tn b y tm s d o iu mp e n ain o tSa d y S se Ba e n L n x

LU Xa-e U N ogj I i j ,H A G Y n-a oi i

( colfC m ue, i u nU i rt,C eg uS h a 0 6 C ia Sho o o p t Sc a nv sy hn d i un610 5, hn ) r h ei c

基 于 Ln x的双 机 热 备 系统 的 实现 技 术 iu

刘 晓洁 ,黄永佳

( 川 大学 计 算机 学院 ,四川 成都 606 ) 四 105

摘 要 :提供 关键 业务 的 不间 断服 务 , 目前 的解决 办 法是 采 用双机 热 备 或者 集群 技 术 , 用基 于 开源 Ln xHA 采 iu —

Ab ta t P o i i g ic s a t e vc s frk y b sn s ,te c r n ou in i te h t tn b rcu trt c n q e .He r s r c : rv dn n e s n r ie o e u ie s h u r t lt s h o a d y o l s e h i u s s e s o s e a— t

双机热备方案

双机热备方案1. 介绍双机热备方案(Dual Server Hot Standby Solution)是一种常见的容灾技术,用于确保系统的高可用性和可靠性。

通过使用两台服务器,当其中一台服务器发生故障时,另一台服务器能够立即接管该服务器的工作,并保持服务的连续性。

在这种方案中,一台服务器处于主机状态,负责处理所有的工作请求,而另一台服务器则处于备机状态,等待接管主机的工作。

2. 实施原理双机热备方案的实施基于以下原理:•心跳机制:主机和备机之间会定期发送心跳信号以保持通信连接。

当主机无法正常发送心跳信号时,备机会假设主机发生故障,并迅速接管主机的工作。

•实时数据同步:主机和备机之间进行实时数据同步,确保备机上的数据与主机保持一致。

这样当主机发生故障时,备机可以无缝切换并继续处理客户端请求。

•故障检测和切换机制:备机会监测主机的运行状态,一旦检测到主机发生故障,备机会立即接管主机的工作,继续提供服务,并通知管理员进行相关处理。

3. 部署步骤以下是一个基本的双机热备方案的部署步骤:步骤1:选择硬件设备选择两台具有相同配置的服务器作为主机和备机。

确保服务器具备足够的处理能力和存储容量来处理和存储系统的数据。

步骤2:安装操作系统在主机和备机上安装相同版本的操作系统。

推荐使用稳定且可靠的操作系统,如Linux。

步骤3:安装服务软件安装所需的服务软件,如Web服务器、数据库服务器等。

确保主机和备机上的软件版本一致。

步骤4:配置双机热备方案配置主机和备机之间的心跳连接和数据同步。

使用专门的软件工具设置心跳连接,并确保主机上的数据能够实时同步到备机上。

步骤5:测试和验证进行测试和验证,确保主机和备机之间的切换过程可以顺利进行,并且系统能够正常工作。

测试过程中应模拟主机故障和切换,以验证备机能否正常接管主机的工作。

步骤6:监控和维护建立监控系统,实时监测主机和备机的运行状态。

定期进行维护和更新工作,以确保系统的可用性和稳定性。

Suse_Linux_11_双机集群配置文档

Suse Linux 11 双机集群配置文档一安装前准备1.两台装有suse 11 sp1操作系统的服务器,每台服务器有两块网卡。

2.Suse 11 sp1系统安装碟或者ISO文件。

3.suse 11 sp1 HA 安装碟或者iso文件SLE-11-SP1-HA-x86_64-GM-Media1.iso二安装Heartbeat通过yast2工具添加heartbeat,选择软件—附加产品如图1:图1附加产品安装添加HA应用url勾选“高可用性”安装三Heartbeat配置下面以浙江移动流量服务器双机热备为例,讲述heartbeat的配置。

1. 网卡设置主服务器:bond0 10.70.238.157/26 bond0:0 10.7.8.1备服务器:bond0 10.70.238.158/26 bond0:0 10.7.8.2浮动IP:10.70.238.159/26(之后将对其进行配置)因浙江移动要求主机双线路,所以服务器上两网卡做了bond,两台服务器的bond0:0口用直通线连接作为心跳线2.主机系统配置(1) 在两台服务器上修改/etc/hosts文件,修改内容如下:10.70.238.157 pc-zjdamglk01.site pc-zjdamglk0110.70.238.158 pc-zjdamglk02.site pc-zjdamglk0210.7.8.1 pc-zjdamglk01.site pc-zjdamglk0110.7.8.2 pc-zjdamglk02.site pc-zjdamglk023. 开启同步服务在主服务器上开启同步服务,配置如下:1、启动YaST 并选择杂项> 群集或在命令行中运行yast2 cluster 启动初始群集配置对话框。

2、在通讯通道类别中,配置用于群集节点间通讯的通道。

此信息会写入/etc/ais/openais.conf 配置文件。

通信通道用10.7.8.0网段,组播地址,端口不变。

双机热备实施方案

双机热备实施方案一、为啥要搞双机热备呢?咱就好比开个小店,要是只有一个收银机,这收银机突然坏了,那咱这生意可就没法顺利做下去了,顾客得排着队干瞪眼,咱也干着急。

双机热备就像是准备了两台收银机,一台要是出问题了,另一台马上就能顶上去,这样就能保证咱的生意(业务)不间断地运行。

二、开始整双机热备前得知道些啥?1. 咱得先搞清楚咱的业务是啥样的。

比如说,这个业务是个24小时都不能停的网上商城呢,还是就白天办公时候才用的办公软件。

这决定了双机热备要达到啥样的要求。

2. 还得看看咱现有的硬件和软件环境。

就像盖房子得知道有多少块砖多少袋水泥一样。

看看咱现在的服务器啥配置啊,用的啥操作系统,运行着哪些软件等等。

三、双机热备的硬件部分。

1. 服务器选择。

咱得挑两台靠谱的服务器。

这就像挑两个得力的助手,要性能差不多。

要是一个是大力士,一个是小弱鸡,那可不行。

它们的CPU、内存、硬盘啥的都得能满足咱业务的基本需求。

比如说,如果咱的业务数据量特别大,那就得选硬盘空间大、读取速度快的服务器。

这两台服务器最好还能放在不同的地方,就像狡兔三窟一样。

万一一个地方发生火灾或者地震啥的,另一个地方的服务器还能完好无损地工作。

这就叫异地双机热备,安全系数更高。

2. 网络连接。

这两台服务器之间得有个好的网络连接,就像它们之间得有个专用的电话线一样。

这个网络要又快又稳定。

可以用光纤连接,速度就像闪电一样快。

而且最好有冗余的网络连接,就像有两条电话线一样,一条断了另一条还能工作。

四、双机热备的软件部分。

1. 操作系统选择。

如果咱的业务是基于Windows的,那就得挑个稳定的Windows版本来装在这两台服务器上。

要是基于Linux的,那也得选个合适的Linux发行版。

这就像给两个助手穿上合适的工作服一样,合适的操作系统才能让服务器更好地运行业务。

2. 热备软件安装。

然后咱得装上双机热备软件。

这个软件就像一个聪明的小管家,它能时刻监测两台服务器的状态。

两台服务器集群方案

两台服务器集群方案服务器集群是一种将多台服务器组合在一起工作的方案,这样可以提高服务器的可靠性、可扩展性和性能。

在设计服务器集群方案时,需要考虑多种因素,包括服务器的选型、负载均衡、故障恢复等等。

下面将介绍两种常见的服务器集群方案。

第一种方案是基于硬件负载均衡器的服务器集群。

这种方案中,多台服务器通过硬件负载均衡器进行流量的分发,可以提高系统的可靠性和性能。

硬件负载均衡器是一种专门用于处理大量网络请求的设备,它可以根据预设的规则将请求分发到不同的服务器上,从而使得服务器的负载均衡。

同时,硬件负载均衡器还可以实现故障检测和故障恢复的功能,当其中一台服务器故障时,负载均衡器可以自动将请求转发到其他正常工作的服务器上。

这样可以提高整个系统的可靠性和容错性。

第二种方案是基于软件负载均衡器的服务器集群。

与硬件负载均衡器相比,软件负载均衡器更加灵活和可定制化。

软件负载均衡器通常运行在服务器集群中的一台或几台服务器上,它可以根据预设的规则将请求分发到不同的服务器上。

软件负载均衡器可以使用多种算法来进行负载均衡,如轮询、加权轮询、最少连接等等。

同时,软件负载均衡器还可以实现故障检测和故障恢复的功能,当其中一台服务器故障时,负载均衡器可以自动将请求转发到其他正常工作的服务器上。

除了负载均衡之外,服务器集群方案还需要考虑数据同步和故障恢复的问题。

对于数据同步,可以使用数据库复制或分布式文件系统来实现。

数据库复制可以将数据从一个主节点复制到多个从节点,从而实现数据的备份和冗余。

分布式文件系统将数据分散存储在多个服务器上,从而提高数据的可靠性和性能。

对于故障恢复,可以使用数据镜像和冗余备份来实现。

数据镜像将数据实时复制到其他服务器上,当其中一台服务器故障时,可以立即切换到备用服务器上。

冗余备份则是将数据存储在多个独立的服务器上,当其中一台服务器故障时,可以从其他服务器上恢复数据。

总结起来,服务器集群是一种将多台服务器组合在一起工作的方案,可以提高服务器的可靠性、可扩展性和性能。

Linux 系统下双机HA的功能实现

1. 软件及安装说明

本文档描述的Linux-HA软件以及参考的文档均来自网站: /。

通过安装该Linux-HA软件,可以实现Linux双机系统的高可用性解决方案,实现双机系统的热备份,并能够做到双机之间的无缝切换,从而对外提供稳定可靠的服务,最终实现系统高性能RAS(reliability, availability, and serviceability)。

此外,还可以向启动脚本传递argument,语法为:scriptname::argument# hello 192.168.8.240/19/eth0/192.168.31.251 httpd tomcat

指定cluster IP为192.168.8.240,子网掩码为255.255.224.0,使用的网络接口卡为eth0,并强制设定广播地址为192.168.31.251。

cd libnet

./configure

make

make install

tar zxf heartbeat-2.0.8.tar.gz

cd heartbeat-2.0.8

./ConfigureMe configure --disable-swig --disable-snmp-subagent

make

1.3.2 配置haresources文件

haresources文件用于指定双机系统的主节点、集群IP、子网掩码、广播地址以及启动的服务等。其配置语句格式如下:

node-name network-config <resource-group>

其中node-name指定双机系统的主节点,取值必须匹配ha.cf文件中node选项设置的主机名中的一个,node选项设置的另一个主机名成为从节点。

Linux并行集群的搭建PBS

Linux并行集群的搭建PBSLinux并行集群的搭建实验环境OS:CentOS 5.10 x86_64(一台admin,两台计算节点)主机名和和IP对应关系如下admin: 192.168.78.11node1:192.168.78.12node2:192.168.78.13软件版本:PBStorque-3.0.6.tar.gzmaui-3.3.1.tar.gzopenmpi-1.8.1.tar.bz2并行软件:apoa1.tar.gzNAMD_2.9_Linux-x86_64-multicore.tar.gz一:环境配置1.修改hosts文件,添加内容如下192.168.78.11 admin192.168.78.12 node1192.168.78.13 node22.设置无密码访问ssh-keygen一直按enter键即可,进入.ssh目录生成认证密码,并设置权限[root@admin ~]#cd.ssh/[**************]#lsid_rsa id_rsa.pub[**************]#cpid_rsa.pubauthorized_keys[**************]#chmod600authorized_keys[**************]#lltotal 12-rw------- 1rootroot 394 Aug 23 03:52 authorized_keys-rw------- 1rootroot 1675 Aug 23 03:50 id_rsa-rw-r--r-- 1rootroot 394 Aug 23 03:50 id_rsa.pub3.然后复制.ssh目录到所有计算节点[root@admin~]# for i in 1 2 ; do scp -r /root/.ssh node$i:/ro ot/ ; done第一次要输入两台计算节点的root密码,以后都是无密码访问了4.复制hosts文件到所有计算节点[root@admin ~]#for i in 1 2 ; do scp /etc/hosts node$i:/etc/ ; done5.配置nfs服务把管理节点上的/export作为共享目录[root@admin~]#mkdir -p /export/{apps,home,scripts,sourc e} //其中apps为软件共享目录,home为共享家目录[root@admin ~]#cat /etc/exports/export 192.168.78.0/255.255.255.0(rw,sync)6.启动nfs服务并检查启动是否成功[root@admin~]#chkconfig portmap on ; /etc/init.d/portma p startStartingportmap: [ OK ][root@admin~]#chkconfig nfs on ; /etc/init.d/nfs start[root@admin~]#showmount -e localhostExport listforlocalhost:/export 192.168.78.0/255.255.255.0[root@admin ~]#7.配置autofs[root@admin ~]#cat /etc/auto.master/home/etc/auto.home --timeout=1200/share/ec/auto.share --timeout=1200[root@admin ~]#cat /etc/auto.share* admin:/export/&[root@admin ~]#cat /etc/auto.home* -nfsvers=3 admin:/export/home/&[root@admin ~]#8.启动autofs服务[root@admin~]#chkconfig autofs on ; /etc/init.d/autofs star t9.复制auto.master auto.share auto.home到所有计算节点[root@admin ~]#for i in 1 2; do scp /etc/auto.master node$i: /etc/; done[root@admin ~]#for i in 1 2; do scp /etc/auto.share node$i:/ etc/; done[root@admin ~]#for i in 1 2; do scp /etc/auto.home node$i: /etc/; done10.启动autofs服务[root@admin ~]#for i in 1 2; do ssh node$i /etc/init.d/autof s start; done[root@admin ~]#for i in 1 2; do ssh node$i chkconfig autofs on; done11.配置NIS服务[root@admin ~]#yum -y install ypserv[root@admin~]#nisdomainname [root@admin~]#echo "NISDOMAIN=">>/etc /sysconfig/network[root@admin ~]#cp /usr/share/doc/ypserv-2.19/securenets /var/yp/[root@admin ~]#vi /var/yp/securenets修改后内容如下[root@admin~]#grep -v "^#" /var/yp/securenets255.0.0.0 127.0.0.0255.255.255.0 192.168.78.0[root@admin ~]#12.启动NIS服务[root@admin~]#/etc/init.d/ypserv start ;chkconfig ypserv o nStarting YP servers ervices: [ OK ][root@admin~]#/etc/init.d/yppasswdd start ;chkconfig yppa sswdd onStarting YP passwd service: [ OK ][root@admin ~]#13.修改/etc/default/useradd文件把HOME=/home更改为HOME=/export/home14.在/etc/skel目录下创建.ssh目录并在.ssh目录下建立一个名为config的文件,设置如下[root@admin~]#mkdir /etc/skel/.ssh[root@admin~]#touch /etc/skel/.ssh/config[root@admin ~]#cat /etc/skel/.ssh/configStrictHostKeyChecking noUserKnownHostsFile /dev/null[root@admin~]#chmod 600 /etc/skel/.ssh/config15.创建用于同步用户的命令◆在/usr/local/sbin目录下创建了一个名为sync_users的脚本,内容如下:#!/bin/bashYPINIT=/usr/lib64/yp/ypinitfor USER in $(sed -n '/export/p' /etc/passwd | awk -F ":" '{pri nt$1}')doif [ -z "$USER" ]; then$YPINIT -melseusermod -d /home/$USER $USERfidone$YPINIT -m◆赋予可执行权限chmod 755/usr/local/sbin/sync_users◆以后执行sync_users命令就可以同步新创建的用户16.创建一个测试用户linuxidc,并同步该用户[root@admin~]#useradd linuxidc[root@admin~]#echo linuxidc | passwd --stdin linuxidc[root@admin~]#sync_users注:以后每添加一个新用户,都需要执行sync_users命令17. 配置NIS客户端,在所有计算节点上安装ypbind,RHEL默认已经安装[root@admin~]# for i in 1 2; do ssh node$i auth-config --en able-nis --nisdomain= \--nisserver=admin --update; done18.验证NIS服务配置是否正确[root@node1~]#ypcat passwdlinuxidc:$1$tsPKQvPP$Kwom9qG/DNR1w/Lq./cQV.:500:500:: /home/linuxidc:/bin/bash[root@admin ~]#for i in 1 2; do ssh node$i id linuxidc; done uid=500(linuxidc) gid=500(linuxidc) groups=500(linuxidc)uid=500(linuxidc) gid=500(linuxidc) groups=500(linuxidc)有上面输出可知,NIS服务配置正确二:安装和配置torque(管理节点)1.首先安装openmpi[root@adminparallel]#tar xjvf openmpi-1.8.1.tar.bz2 -C /usr/ local/src/[root@adminparallel]#cd /usr/local/src/openmpi-1.8.1/[*********************.1]#./configure--prefix=/share/ap ps/openmpi[*********************.1]#make[*********************.1]#makeinstall[*********************.1]#cp-r examples/ /share/apps/ openmpi2.添加环境变量,在/share/scripts目录先建立了一个Path.sh,以后也方便计算节点添加环境变量[root@adminscripts]#pwd/share/scripts[root@adminscripts]#cat Path.sh#!/bin/bashgrep openmpi /etc/profile || cat >>/etc/profile <<EOFexport PATH=/share/apps/openmpi/bin:\$PATHexport LD_LIBRARY_PATH=/share/apps/openmpi/lib:\$LD_LI BRARY_PATHEOF[root@adminscripts]#[root@adminscripts]#sh Path.sh[root@adminscripts]#source /etc/profile3.测试openmpi是否安装成功[root@adminscripts]#which mpirun/share/apps/openmpi/bin/mpirun[root@adminscriptss]#which mpiexec/share/apps/openmpi/bin/mpiexec4.安装torque[root@adminparallel]#tar xzvf torque-3.0.6.tar.gz -C /share/ source/[root@adminparallel]#cd /share/source/torque-3.0.6/[********************.6]#./configure--enable-syslog --e nable-nvidia-gpus --enable-cpuset --disable-gui --with-rcp=scp --with-sendmail[********************.6]#make[********************.6]#makeinstall[********************.6]#pwd/share/source/torque-3.0.6[********************.6]#catinstall.shcd /share/source/torque-3.0.6make install[********************.6]#5.初始化torque创建默认队列[********************.6]#./torque.setuproot initializingTORQUE(admin: root@admin)PBS_Server admin:Create mode and server database exists, do you wishtocontinue y/(n)?yroot 26351 1 0 06:44? 00:00:00 pbs_server -t create Max openservers:10239Max openservers:10239[********************.6]#6.查看创建的默认队列batch[********************.6]#qmgr-c"ps"## Create queues and set their attributes.### Create and define queue batch#create queue batchset queue batch queue_type = Executionset queue batch resources_default.nodes = 1set queue batch resources_default.walltime= 01:00:00set queue batch enabled = Trueset queue batch started = True## Set server attributes.#set server scheduling = Trueset server acl_hosts = adminset server admins= root@adminset server operators = root@adminset server default_queue = batchset server log_events = 511set server mail_from = admset server scheduler_iteration = 600set server node_check_rate = 150set server tcp_timeout = 6set server mom_job_sync = Trueset server keep_completed = 300[********************.6]#7.更改队列batch部分属性,以满足实际需求[********************.6]#qmgr-c"sqbatchresources_de fault.walltime=24:00:00"[********************.6]#qmgr-c"ssquery_other_jobs=t rue"8.建立mom配置文件,用于复制到所有计算节点[root@adminmom_priv]#pwd/var/spool/torque/mom_priv[root@adminmom_priv]#cat config$pbsserver admin$logevent 2259.创建节点信息文件[root@adminserver_priv]#pwd/var/spool/torque/server_priv[root@adminserver_priv]#cat nodesnode1node2[root@adminserver_priv]#10.查看目前节点信息均为down状态[root@adminserver_priv]#pbsnodes -anode1state = downnp = 1ntype = clustermom_service_port = 15002mom_admin_port = 15003gpus = 0node2state = downnp = 1ntype = clustermom_service_port = 15002mom_admin_port = 15003gpus = 0[root@adminserver_priv]#11.复制pbs_server启动脚本,并设置开机自动启动[********************.6]#pwd/share/apps/torque-3.0.6[********************.6]#cpcontrib/init.d/pbs_server/etc /init.d/[********************.6]#chmod755/etc/init.d/pbs_serve r[********************.6]#chkconfigpbs_serveron12.复制pbs_mom脚本,方便复制到计算节点[********************.6]#cpcontrib/init.d/pbs_mom/etc/ init.d/13.安装maui[root@adminparallel]#tar xzvf maui-3.3.1.tar.gz -C /usr/local /src/[root@admin ~]#cd /usr/local/src/maui-3.3.1/[******************.1]#./configure--prefix=/usr/local/ma ui --with-pbs=/usr/local[******************.1]#make[******************.1]#makeinstall14.复制maui启动脚本,设置正确路径,并设置为开机启动[******************.1]#cpetc/maui.d/etc/init.d/mauid[******************.1]#vi/etc/init.d/mauid更改MAUI_PREFIX=/opt/maui为MAUI_PREFIX=/usr/local/m aui[******************.1]#chmod755/etc/init.d/mauid[******************.1]#chkconfigmauidon15.启动maui调度服务[******************.1]#/etc/init.d/mauidstartStartingMAUIScheduler: [ OK ][******************.1]#16.添加maui命令环境变量[******************.1]#vi/etc/profileexport PATH=/share/apps/openmpi/bin:/usr/local/maui/bin: $PATH[******************.1]#source/etc/profile17.安装并行软件到共享目录[root@adminnamd]#tar xzvf NAMD_2.9_Linux-x86_64-multi core.tar.gz -C /share/apps/[root@adminnamd]#tar xzvf apoa1.tar.gz -C /share/apps/ [root@adminapps]#pwd/share/apps[root@adminapps]#mv NAMD_2.9_Linux-x86_64-multicore/ namd18.添加namd命令环境变量,同时也添加到Path.sh方便计算节点添加环境变量[******************.1]#vi/etc/profileexport PATH=/share/apps/openmpi/bin:/usr/local/maui/bin: /share/apps/namd:$PATH[******************.1]#source/etc/profile[root@adminscripts]#which namd2/share/apps/namd/namd2[root@adminscripts]#cat Path.sh#!/bin/bashgrep openmpi /etc/profile || cat >>/etc/profile <<EOFexport PATH=/share/apps/openmpi/bin:/share/apps/namd:\$PATHEOF[root@adminscripts]#至此管理端配置完成三:计算节点配置torque1.计算节点安装torque[root@admin ~]#for i in 1 2; do ssh node$i sh /share/source /torque-3.0.6/install.sh; done2.复制mom配置文件到计算节点[root@admin ~]#for i in 1 2; do scp /var/spool/torque/mom _priv/confignode$i:/var/spool/torque/mom_priv/; done3.复制mom启动脚本到计算节点,启动pbs_mom服务,并设置开机启动[root@admin ~]#for i in 1 2; do scp /etc/init.d/pbs_mom no de$i:/etc/init.d/; done[root@admin ~]#for i in 1 2; do ssh node$i /etc/init.d/pbs_ mom start; doneStartingTORQUEMom: [ OK ]StartingTORQUEMom: [ OK ][root@admin ~]#for i in 1 2; do ssh node$i chkconfig pbs_m om on; done4.设置环境变量[root@admin ~]#for i in 1 2; do ssh node$i sh /share/scripts /Path.sh; done5.测试环境变量设置是否正确[root@admin ~]#for i in 1 2; do ssh node$i which mpirun; d one/share/apps/openmpi/bin/mpirun/share/apps/openmpi/bin/mpirun[root@admin ~]#for i in 1 2; do ssh node$i which namd2; d one/share/apps/namd/namd2/share/apps/namd/namd2[root@admin ~]#6.此时再观察计算节点状态,已经变成free了,即可以提交任务到计算节点了[root@adminapps]#pbsnodes -anode1state = freenp = 1ntype = clusterstatus=rectime=1408751492,varattr=,jobs=,state=free,netlo ad=12996103,gres=,loadave=0.01,ncpus=1,physmem=1024932 kb,availmem=2082428kb,totmem=2165536kb,idletime=0,nuser s=0,nsessions=0,uname=Linuxnode12.6.18-371.el5 #1 SMP Tue Oct 1 08:35:08 EDT 2013 x86_64,opsys=linuxmom_service_port = 15002mom_admin_port = 15003gpus = 0node2state = freenp = 1ntype = clusterstatus=rectime=1408751482,varattr=,jobs=,state=free,netlo ad=12983275,gres=,loadave=0.03,ncpus=1,physmem=1024932 kb,availmem=2082444kb,totmem=2165536kb,idletime=0,nuser s=0,nsessions=0,uname=Linuxnode22.6.18-371.el5 #1 SMP Tue Oct 1 08:35:08 EDT 2013 x86_64,opsys=linuxmom_service_port = 15002mom_admin_port = 15003gpus = 0[root@adminapps]#四:验证并行集群是否搭建成功1.在管理节点上以建立的linuxidc用户登录,首先设置节点间无密码互访,操作和root用户一样,只是不需要复制.ssh目录2.复制namd用软件apoa1到当前目录下[linuxidc@admin ~]$cp -r /share/apps/apoa1/ ./3.创建PBS脚本[linuxidc@admin~]$touch test.pbs脚本内容如下[linuxidc@admin ~]$cat test.pbs#!/bin/bash#PBS -N linuxidcjob1#PBS -j oe#PBS -l nodes=2:ppn=1NP=`cat $PBS_NODEFILE | wc -l`echo "This job's id is $PBS_JOBID@$PBS_QUEUE"echo "This job's workdir is $PBS_O_WORKDIR"echo "This job is running on following nodes:"cat $PBS_NODEFILEecho "This job begins at:" `date`echoechocd $PBS_O_WORKDIRmpirun -np $NP-machinefile $PBS_NODEFILE namd2 apoa1 /apoa1.namdechoechoecho "This job stops at:" `date`[linuxidc@admin ~]$4.提交任务[linuxidc@admin ~]$qsub test.pbs5.查看作业运行状态[linuxidc@admin~]$qstatJobid Name User Time UseS Queue -------------------------------------------------------- -------- - -----1.admin linuxidcjob1 linuxidc 0 R b atch[linuxidc@admin~]$qstat -nadmin:Req'd Req'd ElapJobID Username Queue Jobname SessID NDS TSK Memory Time S Time--------------------------------------- ---------------- ------ ----- ------ ------ ----- - -----1.admin linuxidc batch linuxidcjob1 66762 2 -- 24:00 R --node2/0+node1/0[linuxidc@admin ~]$由上面可知作业已经在node1和node2上运行了至此,linux并行集群搭建完成。

linux双机配置

1.1.1 培训的整体场景说明培训规划示意图IP地址规划Testdb testapp 192.168.139.4/24 192.168.139.3/24 心跳IP (eth1)192.168.139.6/24 192.168.139.5/24 管理IP (eth0)资源组IP Ora_pkg:192.168.139.7/24 Test_pkg:192.168.139.8/24 虚拟机部署规划(教材中和自己一起操作)数据库:Oracle 10.2.0.4软件安装目录:Oracle 软件目录:/opt/oracleOracle 数据目录:/oradata Ceshi-TEST目录:/ceshitest 用户与密码(注意区分操作系统与数据库):操作系统:oracle/oracle 数据库:sys/oracle、system/oracle 1.1.2 虚拟机环境介绍操作系统:RHEL 5.4 (32位)系统用户名/密码:root/root 主机名:testapp、testdb 数据库Oracle 10g软件已安装在目录:/opt/oracle 由于数据库已经部署好,本文档的3.3、5.1.1、5.1.2和5.1.3章节在实际操作的过程中忽略。

验证Oracle程序#su –oracle #sqlplus / as sysdba Java 1.5已安装在目录:/usr/java/jdk1.5.0_10 由于java已经部署好,本文档的6.1.1章节不需要在实际操作的过程中忽略,但要检查一下Java 环境#java -version Ceshi-TEST软件做了tar 包ceshitest.tar.gz,放在虚拟机的testapp的/ceshitest-media目录。

CESHI-test 做了一个tar包,本文档的6.1.2到 6.1.6章节不需要在实际操作的过程中忽略,直接用下面的方式解压即可。

mount 设备到/ceshitest 查看是否已经挂载移动包ceshitest.tar.gz到/ceshitest,到/ceshitest目录下解压缩。

服务器双机热备方案

第1篇

服务器双机热备方案

一、背景

随着信息技术的高速发展,企业对信息系统的依赖程度日益加深,服务器作为信息系统运行的核心,其稳定性、可靠性成为企业关注的焦点。为保障企业信息系统的连续、稳定运行,降低因服务器硬件故障导致的业务中断风险,本项目将制定一套服务器双机热备方案,确保在单台服务器发生故障时,另一台服务器能迅速接管业务,实现业务的无缝切换。

4.业务切换测试

-进行模拟故障切换测试,验证业务切换流程的有效性和可靠性。

-优化切换策略,确保业务连续性。

5.系统验收

-完成系统部署和测试后,进行验收工作,确保系统满足既定目标。

-培训运维人员,确保对双机热备系统的熟练操作。

五、运维管理

1.监控与维护

-实施实时监控,确保双机热备系统的正常运行。

-定期进行系统维护,更新软件补丁,优化系统性能。

2.应急响应

-制定应急预案,明确故障响应流程和职责分配。

-定期进行应急演练,提高故障处理能力。

3.备份策略

-定期对关键数据进行备份,以应对极端情况下的数据恢复。

六、总结

本服务器双机热备方案从硬件选择、软件配置、系统设计、实施步骤到运维管理,全方位考虑了企业关键业务系统的连续性和数据保护需求。通过本方案的实施,将显著提升企业信息系统的稳定性和可靠性,为企业的发展提供坚实的IT支持。同时,本方案的实施严格遵循法律法规,确保了合法合规性。

第2篇

服务器双机热备方案

一、引言

信息时代背景下,企业对信息系统的依赖程度日益加深,服务器作为信息系统的基础设施,承担着关键业务的运行。为保障企业关键业务的连续性和数据的一致性,避免因服务器硬件故障导致的业务中断,特制定本服务器双机热备方案,以实现服务器的高可用性和数据保护。

双机互联和虚拟机的实验报告

双机互联和虚拟机的实验报告

一、实验目的

1.了解双机互联的工作原理,学习有关的知识;

2.掌握虚拟机的相关操作,学习在虚拟机中安装、配置系统等实时操

作技能。

二、实验环境

1. 两台电脑,分别安装了Windows7系统和Linux系统;

2.两台电脑必须连接至同一网络,可以通过路由器或网线连接;

3.两台电脑的显卡需要支持虚拟机。

三、实验步骤

1.配置网络:首先,两台电脑必须通过路由器或网线连接至同一网络,确保两台电脑能够实现网络互联。

2.启动虚拟机:然后,在两台电脑上安装虚拟机,并在虚拟机中安装

相应的操作系统,确保能够正常启动和运行。

3. 配置双机互联:在两台电脑上开启ssh功能,并且配置ssh服务器,使得在宿主机的终端可以连接到虚拟机的终端。

4. 实验:最后,在宿主机上使用ssh登录虚拟机,实现双机互联。

四、实验结果

通过本次实验,我们实现了双机互联的实时操作,成功配置了ssh服

务器,并在宿主机上可以登录虚拟机的终端,实现了双机互联的目的。

五、实验总结

通过本次实验,我们学习了包括网络互联、虚拟机安装、ssh服务器配置等在内的双机互联的一系列的实时操作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

www.tjyj.com

www.tjyjqk.com

tjyj@tjyj.com

—! 微机应用与自动化 "—

tjyjzz@tjyj.com

53

54

TIANJIN METALLURGY

2 0 0 5 年第 6 期 总第 13 1 期

系统将把其上的应用故障后转移到其它服务器上, 防 止剩下的服务器群在性能上显著下降。 2.2.5 故 障 修 复 切 回 模 式 ( Automatic Failback) : 指 当 集群中的故障服务器回到集群中时, 其它服务器将以 前在此节点上运行的应用程序转移回去的工作模式。

第二类是负载均衡集群, 目的是提供和节点个数 成正比的负载能力, 这种集群很适合提供大访问量的 Web 服务。负载均衡集群往往也具有一定的高可用性 特点。Turbo- Linux Cluster Server、Linux 级计算集群, 按照计算关联程度的不

者。

Anode IPaddr::192.168.0.49 servicelist1

# 在 Anode 上 设 置 虚 拟 IP192.168.0.49 提 供 服 务

servicelist1

Bnode IPaddr::192.168.0.50 servicelist2

# 在 Bnode 上 设 置 虚 拟 IP192.168.0.50 提 供 服 务

按照侧重点的不同, 可以把 Linux 集群分为三类[1, 2]:

第一类是高可用性集群, 运行于两个或多个节点 上, 目的是在系统出现某些故障的情况下, 仍能继续 对外提供服务。高可用性集群的设计思想就是要最大 限度地减少服务中断时间。这类集群中比较著名的有 Turbo- Linux Turbo HA、Heartbeat、Kimberlite 等。

servicelist2

( 3) authkeys 文件, 此文件的文件模式( mode) 需设置

为 600。

auth 1

1 crc servicelist1 、servicelist2 分 别 代 表 一 个 或 多 个 服 务, 格式如"httpd smb", 其中 httpd, smb 是服务的启动 脚本名。所以可以在启动脚本里指定和设置需要的服 务, 如通信服务, 数据库服务等。需要注意的是, 这些 脚本应该放在特定的目录下 ( /etc/ha.d/resource.d 和 / etc/rc.d/init.d) , 这样在开机启动后, 集群将自动提供这 些服务, 必要时完成服务接管。 3.3 集群的测试 首先将主机 Bnode 切断电源( 代表故障) , 过一段 时 间 再 重 新 启 动 , 从 下 面 日 志 文 件 ( ha- log) 记 录 中 可 以看到, 集群成功完成了故障切换和故障恢复后的服 务( mach_down) 交还: heartbeat: 2004/05/13_16:49:03 info: Local status now set to: ' up' heartbeat: 2004/05/13_16:51:03 WARN: node Bn- ode: is dead heartbeat: 2004/05/13_16:51:03 info: Local status now set to: ' active' heartbeat: 2004/05/13_16:51:03 info: Resources be- ing acquired from Bnode. heartbeat: 2004/05/13_16:51:04 info: Running /etc/ ha.d/rc.d/status status heartbeat: 2004/05/13_16:51:04 info: Local Re- source acquisition completed. heartbeat: 2004/05/13_16:51:04 info: /usr/lib/heart- beat/mach_down: nice_failback: foreign resources ac- quired heartbeat: 2004/05/13_16:51:04 info: mach_down takeover complete for node Bnode. …… heartbeat: 2004/05/13_16:53:26 info: Link Bnode: eth0 up. heartbeat: 2004/05/13_16:53:27 info: Releasing re- source group: Bnode IPaddr::192.168.0.50 mach_down …… heartbeat: 2004/05/13_16:53:33 info: local resource transition completed. 4 关于可靠性 4.1 系统可靠性 双机与磁盘阵列柜互联结构不采用内存镜像技 术, 因此需要有一定的切换时间, 但它可以有效地避

2 0 0 5 年第 6 期 总第 13 1

双机 Linux 集群服务器的实现

53

双机 Linux 集群服务器的实现

菅希顺 张学启 ( 天津市钢铁有限公司, 300301)

[ 摘要] 介绍了 Linux 集群的基本类型、工作模式和特点, 重点论述了双机互备工作方式的 Linux集群的实现与测试及 软 、硬 件 的 配 置 与 实 现 。 该 方 案 可 用 在 要 求 低 成 本 、高 可 靠 性 的 客 户 工 作 站 实 现 上 。

双机互备工作方式的 Linux 集群的实现, 参见图 1。

图1

集 群 软 件 采 用 开 发 源 代 码 Linux- HA heartbeat

( 可 从 http://linux- ha.org 下 载 ) , heartbeat 是 一 个 著 名

的高可用性集群软件, 有数千个成功的集群采用它来

2.3 Linux 集群的优点 2.3.1 提高系统可用性。

一般地讲, 高可用性配置可以保证当某台服务器 或应用程序发生预计之外的故障时, 集群中的另外一 台服务器可以在继续自己份内工作的同时, 接过发生 故障服务器上的任务。集群的目标是为最终用户尽量 减少服务器和应用程序的停机时间。

2.3.2 能够改善系统可伸缩性。

实现, 重要的是它完全免费。下面描述用 heartbeat 的

集群实现。

为 了 提 高 集 群 的 可 靠 性 、持 久 性 , 采 用 双 机 与 磁

盘阵列柜集群方式。硬件主要配置如下:

服务器: 两台

磁盘阵列柜: 一台

服务器操作系统硬盘: 两块

阵列柜数据存贮硬盘: 一块

网卡: 四块

磁盘阵列柜专用 SCSI 电线: 两根

Linux竞争力很强的原因之一, 是它可以运行于极 为普及的 PC 机上, 不需要购买昂贵的专用硬件设备。 在几台运行 Linux 的 PC 机上, 只要加入相应的集群软 件 , 就 可 以 组 成 具 有 超 强 可 靠 性 、负 载 能 力 和 计 算 能 力的 Linux 集群。 2 Linux 集群的基本类型 2.1 Linux 集群分类

分 别 为 eth0、eth1) , 使 用 其 中 一 个 ( 假 设 为 eth0) 来 配

置正常的网络, 另一块( eth1) 用来配置集群专用网络。

两 块 eth0 通 过 交 换 机 连 接 Internet, eth1 用 交 叉 双 绞

线互相连接对方。Heartbeat 网络配置如下:

同, 又可以分为任务片方式和并行计算方式。这两种 超级计算集群分别适用于不同类型的数据处理工作。 有了超级计算集群软件, 企业利用若干台 PC 机就可 以完成通常只有超级计算机才能完成的计算任务。这 类软件有 Turbo- Linux EnFusion、SCore 等。

高可用性集群与负载均衡集群的工作原理不同, 适用于不同类型的服务。通常, 负载均衡集群适用于 提供静态数据的服务, 如 HTTP 服务; 而高可用性集群 既适用于提供静态数据的服务, 又适用于提供动态数 据的服务, 如数据库等。高可用性集群之所以能适用 于提供动态数据的服务, 是由于节点共享同一存储介 质。也就是说, 在高可用性集群内, 每种服务的用户数 据只有一份, 存储在共用存储设备上, 在任一时刻只 有一个节点能读写这份数据。

可伸缩性指向现有系统内添加节点的能力。在这 样的配置中, 有多台服务器可以执行相同或不同的应 用和数据库操作。当然, 为应付随之增加的复杂性, 系 统管理工具是不可缺少的。

3 双机互备工作方式的 Linux 集群的实现与测试 3.1 双机 Linux 集群的基本工作方式

双机集群有三种工作方式: 3.1.1 双机热备

55

10.0.0.1 (heartbeat 专用 10x net)

Bnode (node2): 192.168.0.22 (192x)

10.0.0.2 (10x)

Netmask: 255.255.255.0 (192x) 255.255.0.0

(10x)

用 Null- Modem 电 缆 线 ( 9 针 ) 将 两 台 机 子 的 串 口

( 默认)

auto_failback on # 自动接管服务功能开, off 为关

闭。

node Anode # 指定节点主机名

node Bnode # 指定节点主机名

( 2) haresources 文件( 两个主机上必须有完全相同的

该文件内容)

此 文 件 为 heartbeat 指 定 服 务 和 服 务 的 默 认 所 有

3.2.3 软件配置

安装 heartbeat 以后, 有三个重要的配置文件需要

在两台主机上进行正确配置, 分别为:

( 1) ha.cf 文件( 位于/etc/ha.d 目录下)

此文件告诉 heartbeat 用什么媒介方式以及配置。