HMM1

HMM-简介

P(O | λ) = ∑ β1 (i) i =1

解码问题—Viterbi算法

Viterbi算法采用动态规划算法。复杂度为O(K 2L) 。其中 K和 L分别为状态个数和序列长

度。

定义δ t (i )

=

max

q1,q2 ,...qt−1

P[q1 q2 ...qt−1 , qt

=

i, O1,O2,…Ot ,

3) 终止:

N

P(O | λ ) = ∑α T (i) i=1

其中递推是整个算法的核心。 后向算法和前向算法性质上是一样的,只是递推方向不同。定义后向变量:

β t (i) = P(Ot +1Ot +1...OT | qt = Si ,λ )

也就是给定模型参数,当时刻 t的状态是Si 的时候,从时刻 t+1到序列结束的输出观察序

对于 HMM 模型,其的状态转换过程是不可观察的,因而称之为“隐”马尔可夫模型。

HMM定义

1) X代表一组状态的集合,其中 X = {S1, S2,..., SN } ,状态数为 N,并用qt 来表示 t时刻的 状态。虽然状态是隐藏的,但对于很多应用来说,有一些物理的意义都和状态或者状态 集相关。状态内部的联系就是从一个状态可以到其它状态。

集合的元素作为混合高斯模型的分量,实现的是带隐变量的

最大似然估计。

的 HMM,可能有aij =0(对于一对或多对 i,j)。

4) 状态 j的观察概率分布 B = {b j (k)} ,表示状态 j输出相应观察值的概率,其中

bj (k )

=

P{O t

= Vk

|q t

=

S },1 ≤ j

j

≤

N

1≤k ≤ M 。

HMM学习笔记_1(从一个实例中学习DTW算法)

HMM学习笔记_1(从⼀个实例中学习DTW算法) DTW为(Dynamic Time Warping,动态时间归准)的简称。

应⽤很⼴,主要是在模板匹配中,⽐如说⽤在孤⽴词语⾳识别,计算机视觉中的⾏为识别,信息检索等中。

可能⼤家学过这些类似的课程都看到过这个算法,公式也有⼏个,但是很抽象,当时看懂了但不久就会忘记,因为没有具体的实例来加深印象。

这次主要是⽤语⾳识别课程⽼师上课的⼀个题⽬来理解DTW算法。

⾸先还是介绍下DTW的思想:假设现在有⼀个标准的参考模板R,是⼀个M维的向量,即R={R(1),R(2),……,R(m),……,R(M)},每个分量可以是⼀个数或者是⼀个更⼩的向量。

现在有⼀个才测试的模板T,是⼀个N维向量,即T={T(1),T(2),……,T(n),……,T(N)}同样每个分量可以是⼀个数或者是⼀个更⼩的向量,注意M不⼀定等于N,但是每个分量的维数应该相同。

由于M不⼀定等于N,现在要计算R和T的相似度,就不能⽤以前的欧式距离等类似的度量⽅法了。

那⽤什么⽅法呢?DTW就是为了解决这个问题⽽产⽣的。

⾸先我们应该知道R中的⼀个分量R(m)和T中的⼀个分量T(n)的维数是相同的,它们之间可以计算相似度(即距离)。

在运⽤DTW 前,我们要⾸先计算R的每⼀个分量和T中的每⼀个分量之间的距离,形成⼀个M*N的矩阵。

(为了⽅便,⾏数⽤将标准模板的维数M,列数为待测模板的维数N)。

然后下⾯的步骤该怎么计算呢?⽤个例⼦来看看。

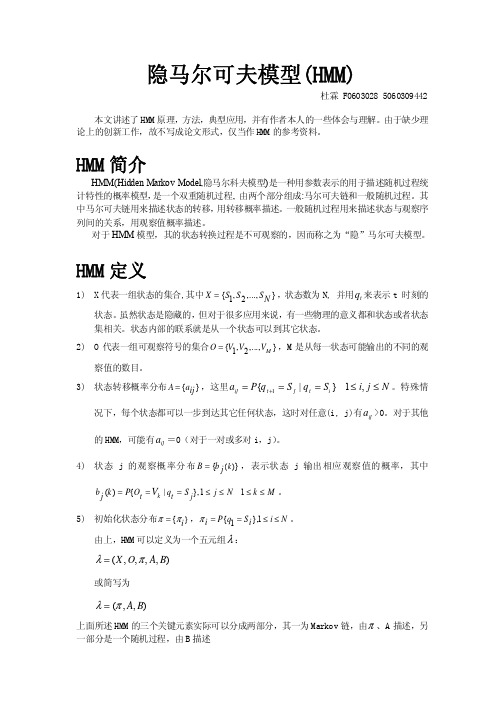

这个例⼦中假设标准模板R为字母ABCDEF(6个),测试模板T为1234(4个)。

R和T中各元素之间的距离已经给出。

如下:既然是模板匹配,所以各分量的先后匹配顺序已经确定了,虽然不是⼀⼀对应的。

现在题⽬的⽬的是要计算出测试模板T和标准模板R之间的距离。

因为2个模板的长度不同,所以其对应匹配的关系有很多种,我们需要找出其中距离最短的那条匹配路径。

现假设题⽬满⾜如下的约束:当从⼀个⽅格((i-1,j-1)或者(i-1,j)或者(i,j-1))中到下⼀个⽅格(i,j),如果是横着或者竖着的话其距离为d(i,j),如果是斜着对⾓线过来的则是2d(i,j).其约束条件如下图像所⽰:其中g(i,j)表⽰2个模板都从起始分量逐次匹配,已经到了M中的i分量和T中的j分量,并且匹配到此步是2个模板之间的距离。

一文搞懂HMM(隐马尔可夫模型)

⼀⽂搞懂HMM(隐马尔可夫模型)什么是熵(Entropy)简单来说,熵是表⽰物质系统状态的⼀种度量,⽤它⽼表征系统的⽆序程度。

熵越⼤,系统越⽆序,意味着系统结构和运动的不确定和⽆规则;反之,,熵越⼩,系统越有序,意味着具有确定和有规则的运动状态。

熵的中⽂意思是热量被温度除的商。

负熵是物质系统有序化,组织化,复杂化状态的⼀种度量。

熵最早来原于物理学. 德国物理学家鲁道夫·克劳修斯⾸次提出熵的概念,⽤来表⽰任何⼀种能量在空间中分布的均匀程度,能量分布得越均匀,熵就越⼤。

1. ⼀滴墨⽔滴在清⽔中,部成了⼀杯淡蓝⾊溶液2. 热⽔晾在空⽓中,热量会传到空⽓中,最后使得温度⼀致更多的⼀些⽣活中的例⼦:1. 熵⼒的⼀个例⼦是⽿机线,我们将⽿机线整理好放进⼝袋,下次再拿出来已经乱了。

让⽿机线乱掉的看不见的“⼒”就是熵⼒,⽿机线喜欢变成更混乱。

2. 熵⼒另⼀个具体的例⼦是弹性⼒。

⼀根弹簧的⼒,就是熵⼒。

胡克定律其实也是⼀种熵⼒的表现。

3. 万有引⼒也是熵⼒的⼀种(热烈讨论的话题)。

4. 浑⽔澄清[1]于是从微观看,熵就表现了这个系统所处状态的不确定性程度。

⾹农,描述⼀个信息系统的时候就借⽤了熵的概念,这⾥熵表⽰的是这个信息系统的平均信息量(平均不确定程度)。

最⼤熵模型我们在投资时常常讲不要把所有的鸡蛋放在⼀个篮⼦⾥,这样可以降低风险。

在信息处理中,这个原理同样适⽤。

在数学上,这个原理称为最⼤熵原理(the maximum entropy principle)。

让我们看⼀个拼⾳转汉字的简单的例⼦。

假如输⼊的拼⾳是"wang-xiao-bo",利⽤语⾔模型,根据有限的上下⽂(⽐如前两个词),我们能给出两个最常见的名字“王⼩波”和“王晓波 ”。

⾄于要唯⼀确定是哪个名字就难了,即使利⽤较长的上下⽂也做不到。

当然,我们知道如果通篇⽂章是介绍⽂学的,作家王⼩波的可能性就较⼤;⽽在讨论两岸关系时,台湾学者王晓波的可能性会较⼤。

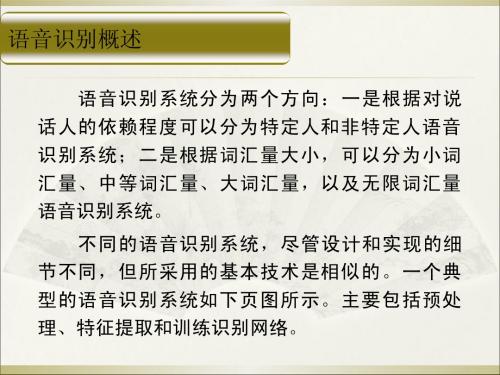

一种基于HMM算法改进的语音识别系统

一种基于HMM 算法改进的语音识别系统随着科技的不断发展,人们对更快、更准、更智能化的语音识别系统越来越期待。

语音识别系统是一种将人类的语音转换成文字的方式,被广泛的应用于语音助手、汽车导航、智能家居等许多领域。

在实际的应用中,语音识别系统往往会受到许多干扰和噪音的影响,影响系统的准确率和可用性。

为了提高语音识别系统的稳定性和精准度,本文提出了一种基于HMM 算法改进的语音识别系统。

一、HMM 算法的基本原理和应用1、HMM 模型概述隐马尔可夫模型(Hidden Markov Model,HMM)是一种统计模型,主要用于对观察序列进行建模,它是一种基于时间序列的模型,利用一些可见的、已经观测到的状态推断出一些不可见的、隐藏的状态。

由于HMM 模型在许多领域都有着广泛的应用,如语音识别、自然语言处理、图像识别等,因此,本文主要针对HMM 模型在语音识别中的应用进行研究和改进。

2、HMM 模型的应用在语音识别中,人们常常使用HMM 模型来进行声学特征的处理,将采集到的语音信号经过分割、预处理、特征提取等步骤后,再利用HMM 模型进行声学模型训练,将语音信号与语音模型相匹配,从而得到语音识别结果。

二、HMM 算法改进对于HMM 算法的改进,本文主要从两个方面进行优化:一是改进初始概率的计算方法,二是改进HMM 模型的训练策略。

1、改进初始概率的计算方法HMM 模型的初始概率是指第一个状态的概率,其中第一个状态可能是任何一个状态。

由于HMM 模型是一个概率模型,因此初始概率的正确性与准确性至关重要。

传统的初始概率计算方法通常根据统计数据和预测比例来进行计算。

然而,在传统的初始概率计算方法中,往往会存在误差和偏差,因此我们需要采用一种更为准确的计算方法。

为了改进初始概率的计算方法,我们可以利用前向算法和后向算法进行计算,即将观察到的语音信号进行分割和分析,从而得出每个观察值在每个时间点上的概率分布。

然后再将概率分布加权求和得到初始概率。

HMM隐马尔可夫模型解析课件

的颜色为O1,并把球放回缸中 n 根据描述缸的转移的概率分布,随机选择下一口缸,

重复以上步骤。

n 为最观后察得值到序一列个O描。述球的颜色的序列O1,O2, … ,称

HMM实例——约束

在上述实验中,有几个要点需要注意:

n (a)转移矩阵没有零值 的Markov链

n (b)转移矩阵有零值的 Markov链

n (c)和(d)是左-右形式表 示的Markov链

HMM实例

Urn 3 Urn 2 Urn 1

Veil

Observed Ball Sequence

HMM实例——描述

n 设有N个缸,每个缸中装有很多彩球,球的颜色 由一组概率分布描述。实验进行方式如下

的统计特性,即状态转移概率确定;这个 状态产生的输出亦为随机的,取决于该状 态生成语音观察量的概率。

n 无跨越模型符合人类的语音特点,广泛应 用于语音识别中。

n 有跨越用于反映音素在发音中可能被吸收 或删除的情况。

Two types of HMM

n State-emission HMM (Moore machine):

n X(t+1) = f(X(t) ) n 现实中存在很多马尔可夫过程

马尔可夫链

n 时间和状态都离散的马尔可夫过程称为马尔可夫链

n 记作{Xn = X(n), n = 0,1,2, …}

n 在时间集T1 = {0,1,2, …}上对离散状态的过程相继观察的结果

n 链的状态空间记做I = {a1, a2, …}, ai∈R.

隐马尔可夫模型 Hidden Markov model

hmm 时间序列 预测方法

HMM时间序列预测方法1. 引言在时间序列分析中,预测未来的数值是一个重要的任务。

HMM(隐马尔可夫模型)是一种常用的时间序列预测方法,它可以用于解决各种具有时序关系的问题,如语音识别、自然语言处理、股票市场预测等。

本文将详细介绍HMM时间序列预测方法的原理、应用以及实现过程。

2. HMM基本原理HMM是一种统计模型,用于描述由一个隐藏状态序列和一个可观察状态序列组成的过程。

隐藏状态是不可直接观察到的,而可观察状态则可以被观察到。

HMM假设隐藏状态之间存在马尔可夫性质,即当前隐藏状态只与前一个隐藏状态相关。

HMM由以下几个要素组成: - 隐藏状态集合:表示可能出现的所有隐藏状态。

-可观察状态集合:表示可能出现的所有可观察状态。

- 初始概率分布:表示初始时刻每个隐藏状态出现的概率。

- 状态转移概率矩阵:表示从一个隐藏状态转移到另一个隐藏状态的概率。

- 观测概率矩阵:表示在给定隐藏状态下,观测到某个可观察状态的概率。

HMM的基本思想是通过给定的观测序列,利用已知的模型参数来推断隐藏状态序列,并进一步预测未来的观测序列。

3. HMM时间序列预测方法步骤HMM时间序列预测方法包括以下几个步骤:步骤1:模型训练•收集历史数据:从过去的时间序列中收集足够数量的观测数据。

•确定隐藏状态和可观察状态:根据具体问题确定隐藏状态和可观察状态的集合。

•估计初始概率分布:根据历史数据统计每个隐藏状态出现的频率,并将其归一化得到初始概率分布。

•估计状态转移概率矩阵:根据历史数据统计每个隐藏状态之间转移的频率,并将其归一化得到状态转移概率矩阵。

•估计观测概率矩阵:根据历史数据统计在给定隐藏状态下,每个可观察状态出现的频率,并将其归一化得到观测概率矩阵。

步骤2:模型推断•给定观测序列:根据已有的观测序列,利用前面训练得到的模型参数,通过前向算法计算每个隐藏状态的前向概率。

•预测隐藏状态序列:利用维特比算法,根据前向概率计算最可能的隐藏状态序列。

HMM隐马尔可夫模型在自然语言处理中的应用

HMM隐马尔可夫模型在自然语言处理中的应用隐马尔可夫模型(Hidden Markov Model,HMM)是自然语言处理中常用的一种概率统计模型,它广泛应用于语音识别、文本分类、机器翻译等领域。

本文将从HMM的基本原理、应用场景和实现方法三个方面,探讨HMM在自然语言处理中的应用。

一、HMM的基本原理HMM是一种二元组( $λ=(A,B)$),其中$A$是状态转移矩阵,$B$是观测概率矩阵。

在HMM中,状态具有时序关系,每个时刻处于某一状态,所取得的观测值与状态相关。

具体来说,可以用以下参数描述HMM模型:- 隐藏状态集合$S={s_1,s_2,...,s_N}$:表示模型所有可能的状态。

- 观测符号集合$V={v_1,v_2,...,v_M}$:表示模型所有可能的观测符号。

- 初始状态分布$\pi={\pi (i)}$:表示最初处于各个状态的概率集合。

- 状态转移矩阵$A={a_{ij}}$:表示从$i$状态转移到$j$状态的概率矩阵。

- 观测概率矩阵$B={b_j(k)}$:表示处于$j$状态时,观测到$k$符号的概率。

HMM的主要任务是在给定观测符号序列下,求出最有可能的对应状态序列。

这个任务可以通过HMM的三种基本问题求解。

- 状态序列概率问题:已知模型参数和观测符号序列,求得该观测符号序列下各个状态序列的概率。

- 观测符号序列概率问题:已知模型参数和状态序列,求得该状态序列下观测符号序列的概率。

- 状态序列预测问题:已知模型参数和观测符号序列,求得使得观测符号序列概率最大的对应状态序列。

二、HMM的应用场景1. 语音识别语音识别是指将语音信号转化成文字的过程,它是自然语言处理的关键技术之一。

HMM在语音识别领域具有广泛应用,主要用于建立声学模型和语言模型。

其中,声学模型描述语音信号的产生模型,是从语音输入信号中提取特征的模型,而语言模型描述语言的组织方式,是指给定一个句子的前提下,下一个字或单词出现的可能性。

hmm 前向后向算法 理解

HMM(隐马尔可夫模型)前向后向算法1. 介绍在自然语言处理和机器学习领域,隐马尔可夫模型(Hidden Markov Model, HMM)是一种常用的统计模型,用于建模具有隐含状态的序列数据。

HMM在语音识别、自然语言处理、生物信息学等领域有广泛的应用。

HMM由状态集合、观测集合、状态转移概率矩阵、观测概率矩阵和初始状态概率向量组成。

在HMM中,状态是不可见的,只能通过观测序列来推断。

HMM的前向后向算法是一种基于动态规划的算法,用于计算给定观测序列下的模型参数。

本文将详细介绍HMM的前向后向算法的原理和实现过程。

2. 前向算法前向算法用于计算给定观测序列下的模型参数,包括观测概率、状态转移概率和初始状态概率。

下面是前向算法的具体步骤:步骤1:初始化初始化前向概率矩阵α,α[i][t]表示在时刻t处于状态i的概率。

初始化方式为α[i][0] = π[i] * B[i][O[0]],其中π是初始状态概率向量,B是观测概率矩阵,O是观测序列。

步骤2:递推计算根据前向概率矩阵α的递推公式,计算α[i][t]的值。

递推公式为α[i][t] = ∑(α[j][t-1] * A[j][i]) * B[i][O[t]],其中A是状态转移概率矩阵。

步骤3:终止条件计算观测序列的概率P(O)。

终止条件为P(O) = ∑α[i][T],其中T为观测序列的长度。

3. 后向算法后向算法用于计算给定观测序列下的模型参数,包括观测概率、状态转移概率和初始状态概率。

下面是后向算法的具体步骤:步骤1:初始化初始化后向概率矩阵β,β[i][t]表示在时刻t处于状态i的概率。

初始化方式为β[i][T] = 1,其中T为观测序列的长度。

步骤2:递推计算根据后向概率矩阵β的递推公式,计算β[i][t]的值。

递推公式为β[i][t] =∑(A[i][j] * B[j][O[t+1]] * β[j][t+1]),其中A是状态转移概率矩阵,B是观测概率矩阵。

HMM(隐马尔可夫模型)及其应用

HMM(隐马尔可夫模型)及其应用摘要:隐马尔可夫模型(Hidden Markov Model,HMM)作为一种统计分析模型,创立于20世纪70年代。

80年代得到了传播和发展,成为信号处理的一个重要方向,现已成功地用于语音识别,行为识别,文字识别以及故障诊断等领域。

本文先是简要介绍了HMM的由来和概念,之后重点介绍了3个隐马尔科夫模型的核心问题。

关键词:HMM,三个核心问题HMM的由来1870年,俄国有机化学家Vladimir V. Markovnikov第一次提出马尔可夫模型。

马尔可夫在分析俄国文学家普希金的名著《叶夫盖尼•奥涅金》的文字的过程中,提出了后来被称为马尔可夫框架的思想。

而Baum及其同事则提出了隐马尔可夫模型,这一思想后来在语音识别领域得到了异常成功的应用。

同时,隐马尔可夫模型在“统计语言学习”以及“序列符号识别”(比如DNA序列)等领域也得到了应用。

人们还把隐马尔可夫模型扩展到二维领域,用于光学字符识别。

而其中的解码算法则是由Viterbi和他的同事们发展起来的。

马尔可夫性和马尔可夫链1. 马尔可夫性如果一个过程的“将来”仅依赖“现在”而不依赖“过去”,则此过程具有马尔可夫性,或称此过程为马尔可夫过程。

马尔可夫性可用如下式子形象地表示:X(t+1)=f(X(t))2. 马尔可夫链时间和状态都离散的马尔可夫过程称为马尔可夫链。

记作{Xn=X(n), n=0,1,2,…}这是在时间集T1={0,1,2,…}上对离散状态的过程相继观察的结果。

链的状态空间记作I={a1, a2,…}, ai ∈R.条件概率Pij(m, m+n)=P{ Xm+n = aj | Xm = aj }为马氏链在时刻m处于状态ai条件下,在时刻m+n转移到状态aj的转移概率。

3. 转移概率矩阵如下图所示,这是一个转移概率矩阵的例子。

由于链在时刻m从任何一个状态ai出发,到另一时刻m+n,必然转移到a1,a2…,诸状态中的某一个,所以有当与m无关时,称马尔可夫链为齐次马尔可夫链,通常说的马尔可夫链都是指齐次马尔可夫链。

GaussianHMM1d 1.1.1 用户指南说明书

Package‘GaussianHMM1d’July8,2023Title Inference,Goodness-of-Fit and Forecast for Univariate GaussianHidden Markov ModelsVersion1.1.1Description Inference,goodness-of-fit test,and prediction densities and intervals for univariate Gaus-sian Hidden Markov Models(HMM).The goodness-of-fit is based on a Cramer-von Mises statis-tic and uses parametric bootstrap to estimate the p-value.The description of the methodol-ogy is taken from Chapter10.2of Remillard(2013)<doi:10.1201/b14285>.Depends R(>=3.5.0),doParallel,parallel,foreach,statsLicense GPL(>=2)Encoding UTF-8RoxygenNote7.2.3NeedsCompilation yesAuthor Bouchra R.Nasri[aut,cre,cph],Bruno N Remillard[aut,ctb,cph]Maintainer Bouchra R.Nasri<**************************>Repository CRANDate/Publication2023-07-0810:50:10UTCR topics documented:EstHMM1d (2)EstRegime (3)ForecastHMMeta (4)ForecastHMMPdf (5)GaussianMixtureCdf (6)GaussianMixtureInv (6)GaussianMixturePdf (7)GofHMM1d (8)Sim.HMM.Gaussian.1d (9)Sim.Markov.Chain (10)SimHMMGaussianInv (10)Sn (11)12EstHMM1d Index13 EstHMM1d Estimation of a univariate Gaussian Hidden Markov Model(HMM)DescriptionThis function estimates parameters(mu,sigma,Q)of a univariate Hidden Markov Model.It com-putes also the probability of being in each regime,given the past observations(eta)and the whole series(lambda).The conditional distribution given past observations is applied to obtains pseudo-observations W that should be uniformly distributed under the null hypothesis.A Cramér-von Mises test statistic is then computed.UsageEstHMM1d(y,reg,max_iter=10000,eps=1e-04)Argumentsy(nx1)vector of datareg number of regimesmax_iter maximum number of iterations of the EM algorithm;suggestion10000eps precision(stopping criteria);suggestion0.0001.Valuemu estimated mean for each regimesigma stimated standard deviation for each regimeQ(reg x reg)estimated transition matrixeta(n x reg)probabilities of being in regime k at time t given observations up to time tlambda(n x reg)probabilities of being in regime k at time t given all observations cvm Cramér-von Mises statistic for the goodness-of-fit testU Pseudo-observations that should be uniformly distributed under the null hypoth-esis of a Gaussian HMMLL Log-likelihoodAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ReferencesChapter10.2of B.Rémillard(2013).Statistical Methods for Financial Engineering,Chapman and Hall/CRC Financial Mathematics Series,Taylor&Francis.EstRegime3ExamplesQ<-matrix(c(0.8,0.3,0.2,0.7),2,2);mu<-c(-0.3,0.7);sigma<-c(0.15,0.05)data<-Sim.HMM.Gaussian.1d(mu,sigma,Q,eta0=1,100)$xest<-EstHMM1d(data,2,max_iter=10000,eps=0.0001)EstRegime Estimated Regimes for the univariate Gaussian HMMDescriptionThis function computes and plots the most likely regime for univariate Gaussian HMM using prob-abilities of being in regime k at time t given all observations(lambda)and probabilities of being in regime k at time t given observations up to time t(eta).UsageEstRegime(t,y,lambda,eta)Argumentst(nx1)vector of dates(years,...);if no dates then t=[1:length(y)]y(nx1)vector of data;lambda(nxreg)probabilities of being in regime k at time t given all observations;eta(nxreg)probabilities of being in regime k at time t given observations up to time t;ValueA Estimated Regime using lambdaB Estimated Regime using etarunsA Estimated number of runs using lambdarunsB Estimated number of runs using etapA Graph for the estimated regime for each observation using lambdapB Graph for the estimated regime for each observation using etaAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ReferencesChapter10.2of B.Rémillard(2013).Statistical Methods for Financial Engineering,Chapman and Hall/CRC Financial Mathematics Series,Taylor&Francis.4ForecastHMMeta ExamplesQ<-matrix(c(0.8,0.3,0.2,0.7),2,2);mu<-c(-0.3,0.7);sigma<-c(0.15,0.05);data<-Sim.HMM.Gaussian.1d(mu,sigma,Q,eta0=1,100)$xt=c(1:100);est<-EstHMM1d(data,2)EstRegime(t,data,est$lambda,est$eta)ForecastHMMeta Estimated probabilities of the regimes given new observationsDescriptionThis function computes the estimated probabilities of the regimes for a Gaussian HMM given new observation after time n.it also computes the associated weight of the Gaussian mixtures that can be used for forecasted density,cdf,or quantile function.UsageForecastHMMeta(ynew,mu,sigma,Q,eta)Argumentsynew new observations(mx1);mu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);Q transition probality matrix(r x r);eta vector of the estimated probability of each regime(r x1)at time n;Valueetanew values of the estimated probabilities at times n+1to n+m,using the new obser-vationsw weights of the mixtures for periods n+1to n+mAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ReferencesChapter10.2of B.Rémillard(2013).Statistical Methods for Financial Engineering,Chapman and Hall/CRC Financial Mathematics Series,Taylor&Francis.ForecastHMMPdf5Examplesmu<-c(-0.3,0.7);sigma<-c(0.15,0.05);Q<-matrix(c(0.8,0.3,0.2,0.7),2,2);eta<-c(.1,.9);x<-c(0.2,-0.1,0.73)out<-ForecastHMMeta(x,mu,sigma,Q,eta)ForecastHMMPdf Density function of a Gaussian HMM at time n+kDescriptionThis function computes the density function of a Gaussian HMM at time n+k,given observation upto time n.UsageForecastHMMPdf(x,mu,sigma,Q,eta,k)Argumentsx points at which the density function is comptuted(mx1);mu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);Q transition probality matrix(r x r);eta vector of the estimated probability of each regime(r x1)at time n;k time of prediction.Valuef values of the density function at time n+kw weights of the mixtureAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ReferencesChapter10.2of B.Rémillard(2013).Statistical Methods for Financial Engineering,Chapman andHall/CRC Financial Mathematics Series,Taylor&Francis.Examplesmu<-c(-0.3,0.7);sigma<-c(0.15,0.05);Q<-matrix(c(0.8,0.3,0.2,0.7),2,2);eta<-c(.9,.1);x<-seq(-1,1,by=0.01)out<-ForecastHMMPdf(x,mu,sigma,Q,eta,3)plot(x,out$f,type="l")6GaussianMixtureInv GaussianMixtureCdf Distribution function of a mixture of Gaussian univariate distributionsDescriptionThis function computes the distribution function of a mixture of Gaussian univariate distributions UsageGaussianMixtureCdf(x,mu,sigma,w)Argumentsx Points at which the distribution function is comptuted(nx1);mu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);w vector of the probability of each regime(r x r).ValueF values of the distribution functionAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019Examplesmu<-c(-0.3,0.7);sigma<-c(0.15,0.05);w<-c(0.8,0.2);x<-seq(-1,1,by=0.01)F<-GaussianMixtureCdf(x,mu,sigma,w)plot(x,F,type="l")GaussianMixtureInv Inverse distribution function of a mixture of Gaussian univariate dis-tributionsDescriptionThis function computes the inverse distribution function of a mixture of Gaussian univariate distri-butionsUsageGaussianMixtureInv(p,mu,sigma,w)GaussianMixturePdf7Argumentsp Points in(0,1)at which the distribution function is computed(nx1);mu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);w vector of the probability of each regime(r x1).Valueq values of the quantile functionAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019Examplesmu<-c(-0.3,0.7);sigma<-c(0.15,0.05);w<-c(0.8,0.2);p<-seq(0.01,0.99,by=0.01)q<-GaussianMixtureInv(p,mu,sigma,w)plot(p,q,type="l")GaussianMixturePdf Density function of a mixture of Gaussian univariate distributionsDescriptionThis function computes the density function of a mixture of Gaussian univariate distributions UsageGaussianMixturePdf(x,mu,sigma,w)Argumentsx Points at which the density is comptuted(n x1);mu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);w vector of the probability of each regime(r x1).Valuef Values of the distribution functionAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,20198GofHMM1dExamplesmu<-c(-0.3,0.7);sigma<-c(0.15,0.05);w<-c(0.8,0.2);x<-seq(-1,1,by=0.01)f<-GaussianMixturePdf(x,mu,sigma,w)plot(x,f,type="l")GofHMM1d Goodness-of-fit test of a univariate Gaussian Hidden Markov ModelDescriptionThis function performs a goodness-of-fit test of a Gaussian HMM based on a Cramér-von Mises statistic using parametric bootstrap.UsageGofHMM1d(y,reg,max_iter=10000,eps=1e-04,n_sample=1000,n_cores)Argumentsy(n x1)data vectorreg number of regimesmax_iter maxmimum number of iterations of the EM algorithm;suggestion10000eps eps(stopping criteria);suggestion0.0001n_sample number of bootstrap samples;suggestion1000n_cores number of cores to use in the parallel computingValuepvalue pvalue of the Cram\’er-von Mises statistic in percentmu estimated mean for each regimesigma estimated standard deviation for each regimeQ(reg x reg)estimated transition matrixeta(n x reg)conditional probabilities of being in regime k at time t given observa-tions up to time tlambda(n x reg)probabilities of being in regime k at time t given all observations cvm Cramér-von Mises statistic for the goodness-of-fit testW Pseudo-observations that should be uniformly distributed under the null hypoth-esis of a Gaussian HMMLL Log-likelihoodSim.HMM.Gaussian.1d9Author(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ReferencesChapter10.2of B.Rémillard(2013).Statistical Methods for Financial Engineering,Chapman and Hall/CRC Financial Mathematics Series,Taylor&Francis.ExamplesQ<-matrix(c(0.8,0.3,0.2,0.7),2,2);mu<-c(-0.3,0.7);sigma<-c(0.15,0.05)data<-Sim.HMM.Gaussian.1d(mu,sigma,Q,eta0=1,100)$xgof<-GofHMM1d(data,2,max_iter=10000,eps=0.0001,n_sample=100,n_cores=2)Sim.HMM.Gaussian.1d Simulation of a univariate Gaussian Hidden Markov Model(HMM)DescriptionThis function simulates observations from a univariate Gaussian HMMUsageSim.HMM.Gaussian.1d(mu,sigma,Q,eta0,n)Argumentsmu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);Q Transition probality matrix(r x r);eta0Initial value for the regime;n number of simulated observations.Valuex Simulated Datareg Markov chain regimesAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ExamplesQ<-matrix(c(0.8,0.3,0.2,0.7),2,2);mu<-c(-0.3,0.7);sigma<-c(0.15,0.05);sim<-Sim.HMM.Gaussian.1d(mu,sigma,Q,eta0=1,n=100)10SimHMMGaussianInv Sim.Markov.Chain Simulation of afinite Markov chainDescriptionThis function generates a Markov chain X(1),...,X(n)with transition matrix Q,starting from a state eta0.UsageSim.Markov.Chain(Q,n,eta0)ArgumentsQ Transition probality matrix(r x r);n length of series;eta0inital value in1,...,r.Valuex Simulated Markov chainAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ExamplesQ<-matrix(c(0.8,0.3,0.2,0.7),2,2);sim<-Sim.Markov.Chain(Q,eta0=1,n=100)SimHMMGaussianInv Simulation of a univariate Gaussian Hidden Markov Model(HMM)DescriptionGenerates a univariate regime-switching random walk with Gaussian regimes starting from a given state eta0,using the inverse method from noise u.Can be useful when generating multiple time series.UsageSimHMMGaussianInv(u,mu,sigma,Q,eta0)Sn11 Argumentsu series of uniform i.i.d.series(n x1);mu vector of means for each regime(r x1);sigma vector of standard deviations for each regime(r x1);Q Transition probality matrix(r x r);eta0Initial value for the regime;Valuex Simulated Dataeta Probability of regimesAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019ReferencesNasri&Remillard(2019).Copula-based dynamic models for multivariate time series.JMV A,vol.172,107–121.ExamplesQ<-matrix(c(0.8,0.3,0.2,0.7),2,2)set.seed(1)u<-runif(250)mu<-c(-0.3,0.7)sigma<-c(0.15,0.05);eta0=1x<-SimHMMGaussianInv(u,mu,sigma,Q,eta0)Sn Cramer-von Mises statistic for goodness-of-fit of the null hypothesis ofa univariate uniform distrubtion over[0,1]DescriptionThis function computes the Cramér-von Mises statistic Sn for goodness-of-fit of the null hypothesis of a univariate uniform distrubtion over[0,1]UsageSn(U)12SnArgumentsU vector of pseudos-observations(apprimating uniform variates)ValueSn Cramér-von Mises statisticAuthor(s)Bouchra R Nasri and Bruno N Rémillard,January31,2019IndexEstHMM1d,2EstRegime,3ForecastHMMeta,4ForecastHMMPdf,5GaussianMixtureCdf,6 GaussianMixtureInv,6 GaussianMixturePdf,7GofHMM1d,8Sim.HMM.Gaussian.1d,9Sim.Markov.Chain,10 SimHMMGaussianInv,10Sn,1113。

HMM模型和Viterbi算法

HMM模型和Viterbi算法⼀、隐含马尔可夫模型(Hidden Markov Model)1、简介 隐含马尔可夫模型并不是俄罗斯数学家马尔可夫发明的,⽽是美国数学家鲍姆提出的,隐含马尔可夫模型的训练⽅法(鲍姆-韦尔奇算法)也是以他名字命名的。

隐含马尔可夫模型⼀直被认为是解决⼤多数⾃然语⾔处理问题最为快速、有效的⽅法。

2、马尔可夫假设 随机过程中各个状态S t的概率分布,只与它的前⼀个状态S t-1有关,即P(S t|S1,S2,S3,…,S t-1) = P(S t|S t-1)。

⽐如,对于天⽓预报,硬性假定今天的⽓温只与昨天有关⽽和前天⽆关。

当然这种假设未必适合所有的应⽤,但是⾄少对以前很多不好解决的问题给出了近似解。

3、马尔可夫链 符合马尔可夫假设的随机过程称为马尔可夫过程,也称为马尔可夫链。

图:马尔可夫链 在这个马尔可夫链中,四个圈表⽰四个状态,每条边表⽰⼀个可能的状态转换,边上的权值是转移概率。

隐含马尔可夫链是上述马尔可夫链的⼀个扩展:任⼀时刻t的状态S t是不可见的。

所以观察者没法通过观察到⼀个状态序列S1,S2,S3,…,S T来推测转移概率等参数。

但是隐含马尔可夫模型在每个时刻t会输出⼀个符号O t,⽽且O t和S t相关且仅和S t相关。

这称为独⽴输出假设。

隐含马尔可夫模型的结构如下图,其中隐含的状态S1,S2,S3,…是⼀个典型的马尔可夫链。

鲍姆把这种模型称为“隐含”马尔可夫模型。

图:隐含马尔可夫模型4、隐含马尔可夫模型的三个基本问题(1)给定⼀个模型,如何计算某个特定的输出序列的概率? Forward-Backward算法(2)给定⼀个模型和某个特定的输出序列,如何找到最可能产⽣这个输出的状态序列? 维特⽐算法(3)给定⾜够量的观测数据,如何估计隐含马尔可夫模型的参数?训练隐含马尔可夫模型更实⽤的⽅式是仅仅通过⼤量观测到的信号O1,O2,O3,….就能推算模型参数的P(S t|S t-1)和P(O t|S t)的⽅法(⽆监督训练算法),其中主要使⽤鲍姆-韦尔奇算法。

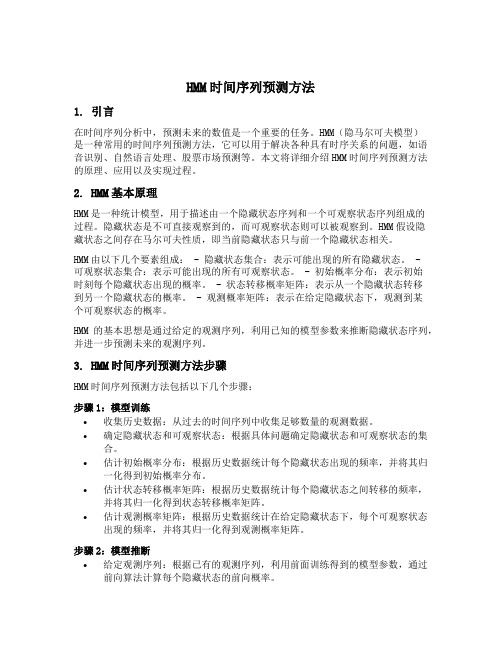

HMM1(CM1)系列塑料外壳式断路器

HMM1(CM1)系列塑料外壳式断路器

一、适用范围

先进技术研制、开发的一种新型断路器之一。

其额定绝缘电压

为800V适用于交流50HZ、额定工作电压690V及以下,额定

工作电流2000A的电路中作不频繁转换及电动机不频繁起动

之用,断路器具有过载、短路和欠电压保护装置,能保护线路

和电源设备不受损坏。

断路器按照其额定极限分断能力(Icu)的高低,分为C型

(基本型)、L型(标准型)、M型(较高分断型)、H型(高分断型)

四类。

该断路器具有体积小、分断高、飞弧短、抗震动等特点、

是陆地及船舶使用的理想产品。

本断路器可垂直安装(即竖装),亦可水平安装(即横装)。

二、工作环境

1.安装地点的海拔高度2000m及以下;

2. 2.周围介质温度不高于+40℃(对船用产品为+45℃)和不低于-5℃;

3.能耐受潮湿空气的影响;

4.能耐受盐雾、油雾的影响

5.能耐受霉菌的影响;

6.能耐受核辐射的影响

7.最大倾斜度为22.5;

8.在受到船舶正常振动时可靠工作;

9.在受到地震情况下(4g)能可靠工作;

10.在无爆炸危险的介质中,且介质无足以腐蚀金属和破坏绝缘的气体和导电尘埃的地

方;

11.无雨雪侵袭的地方;

四、外形尺寸

五、使用及维护

1、断路器各种特性及附近件由制造厂家整定,在使用中不可随意调节。

2、断路器手柄可以处在三个位置,分别表示闭合、断开、脱扣三种状态,当手柄处于脱扣位置时,应向后扳动手柄,使断路器再扣,然后合闸。

隐马尔科夫模型(HMM)详解

马尔科夫过程马尔科夫过程可以看做是一个自动机,以一定的概率在各个状态之间跳转。

考虑一个系统,在每个时刻都可能处于N个状态中的一个,N个状态集合是{S1,S2,S3,...S N}。

我们如今用q1,q2,q3,…q n来表示系统在t=1,2,3,…n时刻下的状态。

在t=1时,系统所在的状态q取决于一个初始概率分布PI,PI(S N)表示t=1时系统状态为S N的概率。

马尔科夫模型有两个假设:1. 系统在时刻t的状态只与时刻t-1处的状态相关;〔也称为无后效性〕2. 状态转移概率与时间无关;〔也称为齐次性或时齐性〕第一条详细可以用如下公式表示:P(q t=S j|q t-1=S i,q t-2=S k,…)= P(q t=S j|q t-1=S i)其中,t为大于1的任意数值,S k为任意状态第二个假设那么可以用如下公式表示:P(q t=S j|q t-1=S i)= P(q k=S j|q k-1=S i)其中,k为任意时刻。

下列图是一个马尔科夫过程的样例图:可以把状态转移概率用矩阵A表示,矩阵的行列长度均为状态数目,a ij表示P(S i|S i-1)。

隐马尔科夫过程与马尔科夫相比,隐马尔科夫模型那么是双重随机过程,不仅状态转移之间是个随机事件,状态和输出之间也是一个随机过程,如下列图所示:此图是从别处找来的,可能符号与我之前描绘马尔科夫时不同,相信大家也能理解。

该图分为上下两行,上面那行就是一个马尔科夫转移过程,下面这一行那么是输出,即我们可以观察到的值,如今,我们将上面那行的马尔科夫转移过程中的状态称为隐藏状态,下面的观察到的值称为观察状态,观察状态的集合表示为O={O1,O2,O3,…O M}。

相应的,隐马尔科夫也比马尔科夫多了一个假设,即输出仅与当前状态有关,可以用如下公式表示:P(O1,O2,…,O t|S1,S2,…,S t)=P(O1|S1)*P(O2|S2)*...*P(O t|S t) 其中,O1,O2,…,O t为从时刻1到时刻t的观测状态序列,S1,S2,…,S t那么为隐藏状态序列。

绝对好的HMM学习文档

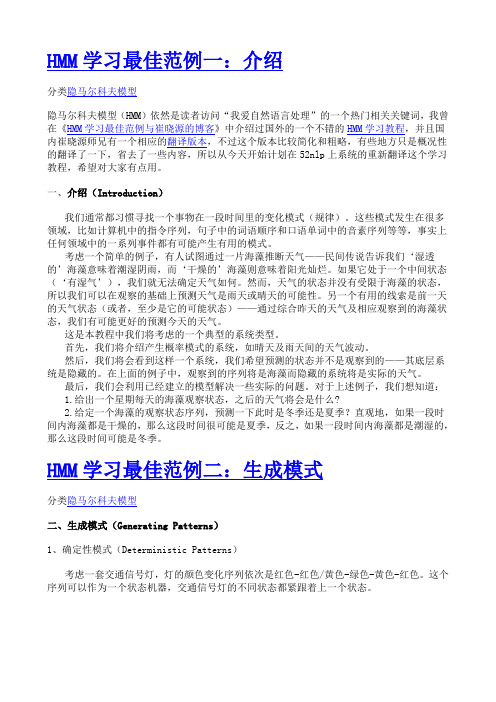

HMM学习最佳范例一:介绍分类隐马尔科夫模型隐马尔科夫模型(HMM)依然是读者访问“我爱自然语言处理”的一个热门相关关键词,我曾在《HMM学习最佳范例与崔晓源的博客》中介绍过国外的一个不错的HMM学习教程,并且国内崔晓源师兄有一个相应的翻译版本,不过这个版本比较简化和粗略,有些地方只是概况性的翻译了一下,省去了一些内容,所以从今天开始计划在52nlp上系统的重新翻译这个学习教程,希望对大家有点用。

一、介绍(Introduction)我们通常都习惯寻找一个事物在一段时间里的变化模式(规律)。

这些模式发生在很多领域,比如计算机中的指令序列,句子中的词语顺序和口语单词中的音素序列等等,事实上任何领域中的一系列事件都有可能产生有用的模式。

考虑一个简单的例子,有人试图通过一片海藻推断天气——民间传说告诉我们‘湿透的’海藻意味着潮湿阴雨,而‘干燥的’海藻则意味着阳光灿烂。

如果它处于一个中间状态(‘有湿气’),我们就无法确定天气如何。

然而,天气的状态并没有受限于海藻的状态,所以我们可以在观察的基础上预测天气是雨天或晴天的可能性。

另一个有用的线索是前一天的天气状态(或者,至少是它的可能状态)——通过综合昨天的天气及相应观察到的海藻状态,我们有可能更好的预测今天的天气。

这是本教程中我们将考虑的一个典型的系统类型。

首先,我们将介绍产生概率模式的系统,如晴天及雨天间的天气波动。

然后,我们将会看到这样一个系统,我们希望预测的状态并不是观察到的——其底层系统是隐藏的。

在上面的例子中,观察到的序列将是海藻而隐藏的系统将是实际的天气。

最后,我们会利用已经建立的模型解决一些实际的问题。

对于上述例子,我们想知道:1.给出一个星期每天的海藻观察状态,之后的天气将会是什么?2.给定一个海藻的观察状态序列,预测一下此时是冬季还是夏季?直观地,如果一段时间内海藻都是干燥的,那么这段时间很可能是夏季,反之,如果一段时间内海藻都是潮湿的,那么这段时间可能是冬季。

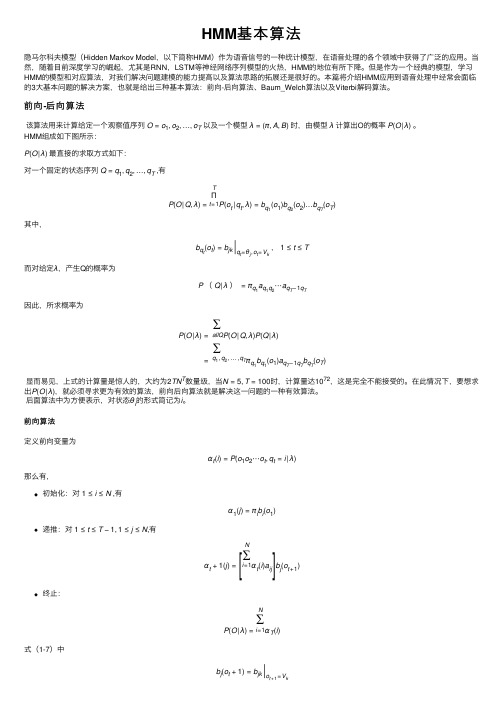

HMM基本算法

HMM 基本算法隐马尔科夫模型(Hidden Markov Model ,以下简称HMM )作为语⾳信号的⼀种统计模型,在语⾳处理的各个领域中获得了⼴泛的应⽤。

当然,随着⽬前深度学习的崛起,尤其是RNN ,LSTM 等神经⽹络序列模型的⽕热,HMM 的地位有所下降。

但是作为⼀个经典的模型,学习HMM 的模型和对应算法,对我们解决问题建模的能⼒提⾼以及算法思路的拓展还是很好的。

本篇将介绍HMM 应⽤到语⾳处理中经常会⾯临的3⼤基本问题的解决⽅案,也就是给出三种基本算法:前向-后向算法、Baum_Welch 算法以及Viterbi 解码算法。

前向-后向算法该算法⽤来计算给定⼀个观察值序列 O =o 1,o 2,…,o T 以及⼀个模型 λ=(π,A ,B ) 时,由模型 λ 计算出O 的概率 P (O |λ) 。

HMM 组成如下图所⽰:P (O |λ) 最直接的求取⽅式如下:对⼀个固定的状态序列 Q =q 1,q 2,…,q T ,有P (O |Q ,λ)=T Πt =1P (o t |q t ,λ)=b q 1(o 1)b q 2(o 2)…b q T(o T )其中,b q t (o t )=b jk q t =θj ,o t =V k,1≤t ≤T⽽对给定λ,产⽣Q 的概率为P (Q |λ)=πq 1a q 1q 2⋯a q T −1q T因此,所求概率为P (O |λ)=∑allQ P (O |Q ,λ)P (Q |λ)=∑q 1,q 2,…,q T πq 1b q 1(o 1)a q T −1q T b q T(o T ) 显⽽易见,上式的计算量是惊⼈的,⼤约为2TN T 数量级,当N =5,T =100时,计算量达1072,这是完全不能接受的。

在此情况下,要想求出P (O |λ),就必须寻求更为有效的算法,前向后向算法就是解决这⼀问题的⼀种有效算法。

后⾯算法中为⽅便表⽰,对状态θi 的形式简记为i 。

保守区域hmm格式

保守区域hmm格式1.引言1.1 概述概述保守区域隐藏马尔可夫模型(HMM)是一种常用的序列建模方法,广泛应用于语音识别、自然语言处理、生物信息学等领域。

它是基于概率统计的一种方法,用于对具有一定规律的序列数据进行建模和预测。

在保守区域HMM中,我们特别关注的是那些具有保守性质的区域,这些区域在不同的序列中保持相对稳定,从而能够帮助我们更好地理解和分析序列数据。

通过使用保守区域HMM,我们可以对序列数据中的保守区域进行建模,并利用模型进行预测和分析。

在建模过程中,首先需要确定保守区域的定义和边界,在某些领域中,保守性质可能与序列中的一些重要特征相关,比如保守蛋白质结构中的保守氨基酸残基。

然后,我们需要选择一种合适的数学模型来描述保守区域的特性,常用的选择是马尔可夫模型。

在保守区域HMM中,保守区域被认为是隐藏状态,而序列数据则是由这些隐藏状态生成的观测序列。

隐藏状态之间的转移概率和隐藏状态生成观测的发射概率可以通过训练数据来估计。

一旦模型训练完毕,我们就可以使用这个模型来进行序列的预测和分析任务。

保守区域HMM在实际应用中广泛发挥作用。

例如,在生物信息学领域,我们可以利用保守区域HMM来预测蛋白质的结构和功能信息。

在语音识别领域,保守区域HMM被用于建模语音信号中的音素,从而实现语音识别任务。

此外,在自然语言处理领域,保守区域HMM也被应用于词性标注、命名实体识别等任务中。

总之,保守区域HMM是一种强大的序列建模方法,能够帮助我们对具有保守性质的区域进行建模和分析。

通过深入理解保守区域HMM的原理和应用,我们可以更好地应用这一模型解决实际问题,并在相关领域取得更好的研究成果。

在接下来的章节中,我们将介绍保守区域HMM的文章结构以及目的,以帮助读者更好地理解和应用这一模型。

1.2 文章结构文章结构部分主要是为了给读者提供一个整体的框架,使其能够更好地理解和组织文章的内容。

本文分为三个主要部分:引言、正文和结论。

HMM原理1

由于

1

t (i ) 表示t时刻处于状态

2 t

t

i

t 1

t2

T

t

t

i

那么,问题1也可以通过同时使用前向后向概 率来求解,即

t (i ) t (i ) P (O , qt S i | )

P (O | )

i 1

N

t

( i ) t ( i ), t 1, 2 , , T ; i 1, 2 ,... N

(一)前向算法

首先要定义一个前向变量

t (i )

t ( i ) P ( O 1 , O 2 ,..., O t ; q t S i | )

即在给定模型条件下,产生t以前的部分观测符号 序列,且t时刻又处于状态Si的概率。

以下是前向变量进行迭代计算的步骤:

(1) 初始化

1 ( i ) i bi ( O1 ) 1 i N

1 2 T

(2) 已知观测序列 O {O , O ,... O }和模型 ( A , B , ) ,如 何选择在某种意义上最佳的状态序列。

1 2 T

(3) 给定观测序列,如何调整参数 率 P O 最大。

( A, B , )

使条件概

第一个问题的求解

这是一个评估问题,即已知模型和一个观测序 列,怎样来评估这个模型(它与给定序列匹配得如 何),或怎样给模型打分,这个问题通常被称为 “前向-后向”的算法解决。

HMM模型原理

隐马尔可夫过程是一个双重随机过程: 一重用于描述非平稳信号的短时平稳段的统计 特征(信号的瞬态特征,可直接观测到);另一重随 机过程描述了每个短时平稳段如何转变到下一个 短时平稳段,即短时统计特征的动态特性(隐含在 观察序列中)。 基于这两重随机过程,HMM既可有效解决怎 样辨识具有不同参数的短时平稳信号段,又可解 决怎样跟踪它们之间的转化等问题。

隐马尔科夫模型HMM(一)HMM模型

隐马尔科夫模型HMM (⼀)HMM 模型 隐马尔科夫模型HMM (⼀)HMM 模型基础 隐马尔科夫模型(Hidden Markov Model ,以下简称HMM )是⽐较经典的机器学习模型了,它在语⾔识别,⾃然语⾔处理,模式识别等领域得到⼴泛的应⽤。

当然,随着⽬前深度学习的崛起,尤其是,等神经⽹络序列模型的⽕热,HMM 的地位有所下降。

但是作为⼀个经典的模型,学习HMM 的模型和对应算法,对我们解决问题建模的能⼒提⾼以及算法思路的拓展还是很好的。

本⽂是HMM 系列的第⼀篇,关注于HMM 模型的基础。

1. 什么样的问题需要HMM 模型 ⾸先我们来看看什么样的问题解决可以⽤HMM 模型。

使⽤HMM 模型时我们的问题⼀般有这两个特征:1)我们的问题是基于序列的,⽐如时间序列,或者状态序列。

2)我们的问题中有两类数据,⼀类序列数据是可以观测到的,即观测序列;⽽另⼀类数据是不能观察到的,即隐藏状态序列,简称状态序列。

有了这两个特征,那么这个问题⼀般可以⽤HMM 模型来尝试解决。

这样的问题在实际⽣活中是很多的。

⽐如:我现在在打字写博客,我在键盘上敲出来的⼀系列字符就是观测序列,⽽我实际想写的⼀段话就是隐藏序列,输⼊法的任务就是从敲⼊的⼀系列字符尽可能的猜测我要写的⼀段话,并把最可能的词语放在最前⾯让我选择,这就可以看做⼀个HMM 模型了。

再举⼀个,我在和你说话,我发出的⼀串连续的声⾳就是观测序列,⽽我实际要表达的⼀段话就是状态序列,你⼤脑的任务,就是从这⼀串连续的声⾳中判断出我最可能要表达的话的内容。

从这些例⼦中,我们可以发现,HMM 模型可以⽆处不在。

但是上⾯的描述还不精确,下⾯我们⽤精确的数学符号来表述我们的HMM 模型。

2. HMM 模型的定义 对于HMM 模型,⾸先我们假设Q 是所有可能的隐藏状态的集合,V 是所有可能的观测状态的集合,即:Q ={q 1,q 2,...,q N },V ={v 1,v 2,...v M } 其中,N 是可能的隐藏状态数,M 是所有的可能的观察状态数。

HMM工具箱命令使用说明

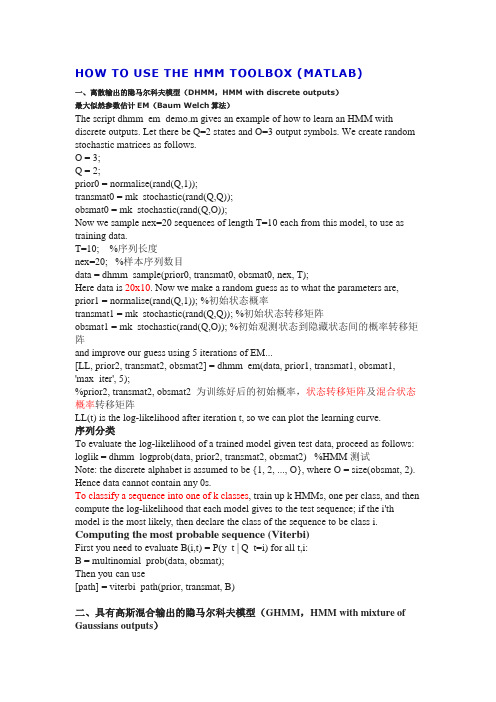

HOW TO USE THE HMM TOOLBOX (MATLAB)一、离散输出的隐马尔科夫模型(DHMM,HMM with discrete outputs)最大似然参数估计EM(Baum Welch算法)The script dhmm_em_demo.m gives an example of how to learn an HMM with discrete outputs. Let there be Q=2 states and O=3 output symbols. We create random stochastic matrices as follows.O = 3;Q = 2;prior0 = normalise(rand(Q,1));transmat0 = mk_stochastic(rand(Q,Q));obsmat0 = mk_stochastic(rand(Q,O));Now we sample nex=20 sequences of length T=10 each from this model, to use as training data.T=10; %序列长度nex=20; %样本序列数目data = dhmm_sample(prior0, transmat0, obsmat0, nex, T);Here data is 20x10. Now we make a random guess as to what the parameters are, prior1 = normalise(rand(Q,1)); %初始状态概率transmat1 = mk_stochastic(rand(Q,Q)); %初始状态转移矩阵obsmat1 = mk_stochastic(rand(Q,O)); %初始观测状态到隐藏状态间的概率转移矩阵and improve our guess using 5 iterations of EM...[LL, prior2, transmat2, obsmat2] = dhmm_em(data, prior1, transmat1, obsmat1,'max_iter', 5);%prior2, transmat2, obsmat2 为训练好后的初始概率,状态转移矩阵及混合状态概率转移矩阵LL(t) is the log-likelihood after iteration t, so we can plot the learning curve.序列分类To evaluate the log-likelihood of a trained model given test data, proceed as follows: loglik = dhmm_logprob(data, prior2, transmat2, obsmat2) %HMM测试Note: the discrete alphabet is assumed to be {1, 2, ..., O}, where O = size(obsmat, 2). Hence data cannot contain any 0s.To classify a sequence into one of k classes, train up k HMMs, one per class, and then compute the log-likelihood that each model gives to the test sequence; if the i'th model is the most likely, then declare the class of the sequence to be class i. Computing the most probable sequence (Viterbi)First you need to evaluate B(i,t) = P(y_t | Q_t=i) for all t,i:B = multinomial_prob(data, obsmat);Then you can use[path] = viterbi_path(prior, transmat, B)二、具有高斯混合输出的隐马尔科夫模型(GHMM,HMM with mixture of Gaussians outputs)Maximum likelihood parameter estimation using EM (Baum Welch)Let us generate nex=50 vector-valued sequences of length T=50; each vector has size O=2.O = 2;T = 50;nex = 50;data = randn(O,T,nex);Now let use fit a mixture of M=2 Gaussians for each of the Q=2 states usingK-means.M = 2;Q = 2;left_right = 0;prior0 = normalise(rand(Q,1));transmat0 = mk_stochastic(rand(Q,Q));[mu0, Sigma0] = mixgauss_init(Q*M, reshape(data, [O T*nex]), cov_type);mu0 = reshape(mu0, [O Q M]);Sigma0 = reshape(Sigma0, [O O Q M]);mixmat0 = mk_stochastic(rand(Q,M));Finally, let us improve these parameter estimates using EM.[LL, prior1, transmat1, mu1, Sigma1, mixmat1] = ...mhmm_em(data, prior0, transmat0, mu0, Sigma0, mixmat0, 'max_iter', 2);Since EM only finds a local optimum, good initialisation is crucial. The initialisation procedure illustrated above is very crude, and is probably not adequate for real applications... Click here for a real-world example of EM with mixtures of Gaussians using BNT.What to do if the log-likelihood becomes positive?It is possible for p(x) > 1 if p(x) is a probability density function, such as a Gaussian. (The requirements for a density are p(x)>0 for all x and int_x p(x) = 1.) In practice this usually means your covariance is shrinking to a point/delta function, so you should increase the width of the prior (see below), or constrain the matrix to be spherical or diagonal, or clamp it to a large fixed constant (not learn it at all). It is also very helpful to ensure the components of the data vectors have small and comparable magnitudes (use e.g., KPMstats/standardize).This is a well-known pathology of maximum likelihood estimation for Gaussian mixtures: the global optimum may place one mixture component on a single data point, and give it 0 covariance, and hence infinite likelihood. One usually relies on the fact that EM cannot find the global optimum to avoid such pathologies.What to do if the log-likelihood decreases during EM?Since I implicitly add a prior to every covariance matrix (see below), what increases is loglik + log(prior), but what I print is just loglik, which may occasionally decrease.This suggests that one of your mixture components is not getting enough data. Try a better initialization or fewer clusters (states).What to do if the covariance matrix becomes singular?Estimates of the covariance matrix often become singular if you have too little data, or if too few points are assigned to a cluster center due to a bad initialization of the means. In this case, you should constrain the covariance to be spherical or diagonal, or adjust the prior (see below), or try a better initialization.How do I add a prior to the covariance matrix?Buried inside of KPMstats/mixgauss_Mstep you will see that cov_prior is initialized to 0.01*I. This is added to the maximum likelihood estimate after every M step. To change this, you will need to modify the mhmm_em function so it callsmixgauss_Mstep with a different value.Sequence classificationTo classify a sequence (e.g., of speech) into one of k classes (e.g., the digits 0-9), proceed as in the DHMM case above, but use the following procedure to compute likelihood:loglik = mhmm_logprob(data, prior, transmat, mu, Sigma, mixmat);Computing the most probable sequence (Viterbi)First you need to evaluate B(t,i) = P(y_t | Q_t=i) for all t,i:B = mixgauss_prob(data(:,:,ex), mu, Sigma, mixmat);where data(:,:,ex) is OxT where O is the size of the observation vector. Finally, use [path] = viterbi_path(prior, transmat, B);三、具有高斯输出的HMMThis is just like the mixture of Gaussians case, except we have M=1, and hence there is no mixing matrix.Online EM for discrete HMMs/ POMDPsFor some applications (e.g., reinforcement learning/ adaptive control), it is necessary to learn a model online. The script dhmm_em_online_demo gives an example of how to do this.隐马尔科夫(HMM)实例分析A 和B是好朋友,但是他们离得比较远,每天都是通过电话了解对方那天作了什么.B 仅仅对三种活动感兴趣:公园散步,购物以及清理房间.他选择做什么事情只凭当天天气.A对于B所住的地方的天气情况并不了解,但是知道总的趋势.在B告诉A每天所做的事情基础上,A想要猜测B所在地的天气情况.A认为天气的运行就像一个马尔可夫链. 其有两个状态“雨”和”晴”,但是无法直接观察它们,也就是说,它们对于A是隐藏的.每天,B有一定的概率进行下列活动:”散步”, “购物”, 或“清理”. 因为B会告诉A他的活动,所以这些活动就是A的观察数据.这整个系统就是一个隐马尔可夫模型HMM.A知道这个地区的总的天气趋势,并且平时知道B会做的事情.也就是说这个隐马尔可夫模型的参数是已知的.下面是概率转移矩阵和两种天气下各种活动的概率:雨天晴天雨天0.7 0.3晴天0.4 0.6散步购物清理雨天0.1 0.4 0.5晴天0.6 0.3 0.1下面是一段程序来描述各个变量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

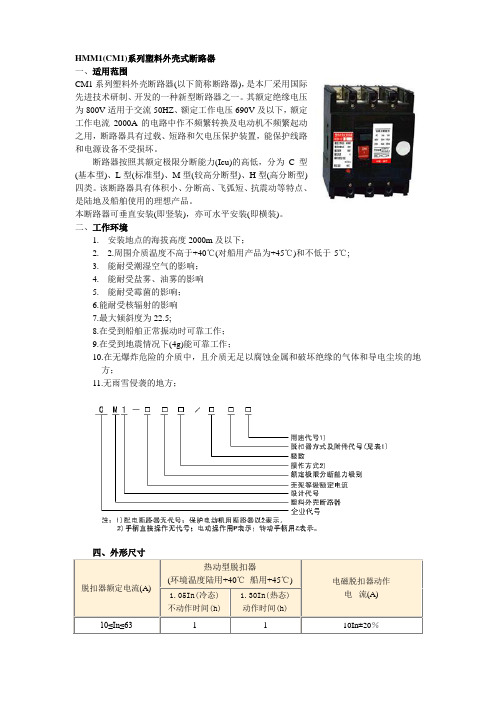

HMM(隐马尔可夫模型)是用来描述隐含未知参数的统计模型,举一个经典的例子:一个东京的朋友每天根据天气{下雨,天晴}决定当天的活动{公园散步,购物,清理房间}中的一种,我每天只能在twitter上看到她发的推“啊,我前天公园散步、昨天购物、今天清理房间了!”,那么我可以根据她发的推特推断东京这三天的天气。

在这个例子里,显状态是活动,隐状态是天气。

任何一个HMM都可以通过下列五元组来描述::paramobs:观测序列:param states:隐状态:paramstart_p:初始概率(隐状态):paramtrans_p:转移概率(隐状态):paramemit_p: 发射概率(隐状态表现为显状态的概率)伪码如下:states = ('Rainy', 'Sunny')observations = ('walk', 'shop', 'clean')start_probability = {'Rainy': 0.6, 'Sunny': 0.4}transition_probability = {'Rainy' : {'Rainy': 0.7, 'Sunny': 0.3},'Sunny' : {'Rainy': 0.4, 'Sunny': 0.6},}emission_probability = {'Rainy' : {'walk': 0.1, 'shop': 0.4, 'clean': 0.5},'Sunny' : {'walk': 0.6, 'shop': 0.3, 'clean': 0.1},}求解最可能的天气求解最可能的隐状态序列是HMM的三个典型问题之一,通常用维特比算法解决。

维特比算法就是求解HMM上的最短路径(-log(prob),也即是最大概率)的算法。

稍微用中文讲讲思路,很明显,第一天天晴还是下雨可以算出来:1.定义V[时间][今天天气] = 概率,注意今天天气指的是,前几天的天气都确定下来了(概率最大)今天天气是X的概率,这里的概率就是一个累乘的概率了。

2. 因为第一天我的朋友去散步了,所以第一天下雨的概率V[第一天][下雨] = 初始概率[下雨] * 发射概率[下雨][散步] = 0.6 * 0.1 = 0.06,同理可得V[第一天][天晴] = 0.24 。

从直觉上来看,因为第一天朋友出门了,她一般喜欢在天晴的时候散步,所以第一天天晴的概率比较大,数字与直觉统一了。

3.从第二天开始,对于每种天气Y,都有前一天天气是X的概率* X转移到Y的概率* Y天气下朋友进行这天这种活动的概率。

因为前一天天气X有两种可能,所以Y的概率有两个,选取其中较大一个作为V[第二天][天气Y]的概率,同时将今天的天气加入到结果序列中4.比较V[最后一天][下雨]和[最后一天][天晴]的概率,找出较大的哪一个对应的序列,就是最终结果。

5.运行完成后根据Viterbi得到结果:6.Sunny Rainy RainyHMM(隐马尔可夫模型)是用来描述隐含未知参数的统计模型,举一个经典的例子:一个东京的朋友每天根据天气{下雨,天晴}决定当天的活动{公园散步,购物,清理房间}中的一种,我每天只能在twitter上看到她发的推“啊,我前天公园散步、昨天购物、今天清理房间了!”,那么我可以根据她发的推特推断东京这三天的天气。

在这个例子里,显状态是活动,隐状态是天气。

2014年11月23日更新:我已利用HMM角色标注实现了中国人名、翻译人名、日本人名、地名、机构名等命名实体的识别,请参考此目录命名实体识别。

任何一个HMM都可以通过下列五元组来描述:1.:param obs:观测序列2.:param states:隐状态3.:param start_p:初始概率(隐状态)4.:param trans_p:转移概率(隐状态)5.:param emit_p:发射概率(隐状态表现为显状态的概率)这个例子可以用如下的HMM来描述:1.states =('Rainy','Sunny')2.3.observations =('walk','shop','clean')4.5.start_probability ={'Rainy':0.6,'Sunny':0.4}6.7.transition_probability ={8.'Rainy':{'Rainy':0.7,'Sunny':0.3},9.'Sunny':{'Rainy':0.4,'Sunny':0.6},10.}11.12.emission_probability ={13.'Rainy':{'walk':0.1,'shop':0.4,'clean':0.5},14.'Sunny':{'walk':0.6,'shop':0.3,'clean':0.1},15.}求解最可能的隐状态序列是HMM的三个典型问题之一,通常用维特比算法解决。

维特比算法就是求解HMM上的最短路径(-log(prob),也即是最大概率)的算法。

稍微用中文讲讲思路,很明显,第一天天晴还是下雨可以算出来:1.定义V[时间][今天天气] = 概率,注意今天天气指的是,前几天的天气都确定下来了(概率最大)今天天气是X的概率,这里的概率就是一个累乘的概率了。

2.因为第一天我的朋友去散步了,所以第一天下雨的概率V[第一天][下雨]= 初始概率[下雨] * 发射概率[下雨][散步] = 0.6 * 0.1 = 0.06,同理可得V[第一天][天晴] = 0.24 。

从直觉上来看,因为第一天朋友出门了,她一般喜欢在天晴的时候散步,所以第一天天晴的概率比较大,数字与直觉统一了。

3.从第二天开始,对于每种天气Y,都有前一天天气是X的概率* X转移到Y的概率* Y天气下朋友进行这天这种活动的概率。

因为前一天天气X有两种可能,所以Y的概率有两个,选取其中较大一个作为V[第二天][天气Y]的概率,同时将今天的天气加入到结果序列中4.比较V[最后一天][下雨]和[最后一天][天晴]的概率,找出较大的哪一个对应的序列,就是最终结果。

这个例子的Python代码:1.# -*- coding:utf-8 -*-2.# Filename: viterbi.py3.# Author:hankcs4.# Date: 2014-05-13 下午8:515.6.states =('Rainy','Sunny')7.8.observations =('walk','shop','clean')9.10.start_probability ={'Rainy':0.6,'Sunny':0.4}11.12.transition_probability ={13.'Rainy':{'Rainy':0.7,'Sunny':0.3},14.'Sunny':{'Rainy':0.4,'Sunny':0.6},15.}16.17.emission_probability ={18.'Rainy':{'walk':0.1,'shop':0.4,'clean':0.5},19.'Sunny':{'walk':0.6,'shop':0.3,'clean':0.1},20.}21.22.# 打印路径概率表23.def print_dptable(V):24.print" ",25.for i in range(len(V)):print"%7d"% i,26.print27.28.for y in V[0].keys():29.print"%.5s: "% y,30.for t in range(len(V)):31.print"%.7s"%("%f"% V[t][y]),32.print33.34.35.def viterbi(obs, states, start_p, trans_p, emit_p):36."""37.38. :param obs:观测序列39. :param states:隐状态40. :param start_p:初始概率(隐状态)41. :param trans_p:转移概率(隐状态)42. :param emit_p: 发射概率(隐状态表现为显状态的概率)43. :return:44. """45.# 路径概率表 V[时间][隐状态] = 概率46. V =[{}]47.# 一个中间变量,代表当前状态是哪个隐状态48. path ={}49.50.# 初始化初始状态 (t == 0)51.for y in states:52. V[0][y]= start_p[y]* emit_p[y][obs[0]]53. path[y]=[y]54.55.# 对 t > 0 跑一遍维特比算法56.for t in range(1, len(obs)):57. V.append({})58. newpath ={}59.60.for y in states:61.# 概率隐状态 = 前状态是y0的概率 * y0转移到y的概率 * y表现为当前状态的概率62.(prob, state)= max([(V[t -1][y0]* trans_p[y0][y]* emit_p[y][obs[t]], y0)for y0 in states])63.# 记录最大概率64. V[t][y]= prob65.# 记录路径66. newpath[y]= path[state]+[y]67.68.# 不需要保留旧路径69. path = newpath70.71. print_dptable(V)72.(prob, state)= max([(V[len(obs)-1][y], y)for y in states])73.return(prob, path[state])74.75.76.def example():77.return viterbi(observations,78. states,79. start_probability,80. transition_probability,81. emission_probability)82.83.84.print example()输出:1.0122.Rainy:0.060000.038400.013443.Sunny:0.240000.043200.002594.(0.01344,['Sunny','Rainy','Rainy'])具体到分词系统,可以将天气当成“标签”,活动当成“字或词”。