EMC VPLEX 连接示意图

EMCVPLEX数据中心虚拟化方案

02

方案设计

根据需求分析结果,设计符合客户需 求的虚拟化方案,包括资源分配、网 络设计、安全策略等。

01

03

安装部署

根据设计方案进行虚拟化软件的安装 和硬件资源的配置。

上线运行

将虚拟化系统正式投入使用,并进行 长期的监控和维护。

05

04

系统调试

对安装好的虚拟化系统进行调试,确 保系统的稳定性和性能。

实施效果

通过虚拟化方案的实施,该企业的数据中心性能得到了显著提升,同时降低了运营成本, 提高了服务质量和可靠性。容灾备份方案的实施也确保了数据的安全性和业务的连续性。

06

EMC Vplex未来展望与 总结

Vplex未来发展趋势

扩展性

Vplex继续提供更高的可扩展性,以满足不 断增长的数据需求。

安全

04

EMC Vplex解决方案详 解

Vplex数据中心架构

架构概述:Vplex数据中心架构是一种高 度可扩展的虚拟化平台,旨在提高数据 中心的效率、灵活性和可用性。

多租户支持:Vplex支持多租户隔离,为 不同业务部门提供独立的资源池。

分布式架构:Vplex采用分布式架构,可 扩展至数千个节点,满足大型企业的需 求。

02

数据中心虚拟化概述

什么是数据中心虚拟化?

数据中心虚拟化是一种将物理服务器和基础设施资源抽象成逻辑资源的技术,它 允许在一个物理服务器上运行多个虚拟机,每个虚拟机都有自己的操作系统和应 用程序。

数据中心虚拟化通过软件定义的网络和存储技术,将网络和存储资源划分为可动 态分配的虚拟机,从而提高了服务器的利用率,简化了管理流程,并降低了运营 成本。

纵向扩展:Vplex支持 纵向扩展,通过升级硬 件设备提高单节点的性 能和容量。

EMC-VPLEX

Q1:EMC VPLEX是什么?A1:VPLEX是一款分布式、全冗余的存储硬件产品,用来对现有数据中心中已有或者边缘存储资源(EMC或者第三方存储阵列)提供集成的访问与扩展的平台。

简单来说,就是整和EMC和非EMC存储,提供跨地域的单点数据访问与数据迁移。

Q2:VPLEX可以解决什么问题?A2:VPLEX解决的问题有两点:1.从异地数据中心同时访问同一个存储设备,典型的案例就是配合Oracle RAC实现双活数据中心。

2.规划与实现数据中心内或者跨数据中心间的数据迁移.比如将数据通过VPLEX从一个存储阵列(同厂商同类型,或者不同厂商不同类型的存储阵列)迁移到另外一个、将应用从一个数据中心迁移到另外一个数据中心。

Q3:VPLEX有什么特别之处?A3:VPLEX主要特别之处有三点:1.VPLEX组成的集群可以方便的横向(增加集群)与纵向扩展(添加引擎)。

2.分布式全局缓存提供分布式数据访问.3.支持长距离的异步传输和(VPLEX Geo版本)多集群架构。

Q4:VPLEX中硬件层面包含哪些主要组件?A4:VPLEX的工作单元叫做Director,和EMC自家的Symmetrix VMAX存储阵列类似。

两个Active/Active Director组成一个Engine,通过VPLEX Cluster,由不同数量的VPLEX Cluster 结合不同的部署位置组成VPLEX的三种解决方案VPLEX Local、VPLEX Metro和VPLEX Geo. Q5:VPLEX Engine硬件VS2和VS1有什么区别?A5:VPLEX目前为止推出两款硬件型号,VS1和VS2。

VS1和VS2都是用2。

4 GHz的Xeon CPU。

区别在于VS2的Engine相比VS1引擎在硬件规格上的差别主要体现在VS2使用了PCI Express V2,前者为PCI Express V1,VS2的吞吐量提升了1。

5倍。

实现Director间通讯的网络方面,VS2也从VS1的4GB提升到8GB,以提供内部通讯更大的带宽。

EMC VPLEX-介绍

© 版权所有 2010 EMC Corporation。保留所有权利。

18

用VPLEX构建跨阵列的主机集群技术

HACMP/主机集群

Server Cluster

• 部署跨阵列的服务器集 群方案

• 部署跨楼层的服务器集 群技术 • 减少服务器切换的频率 • 提高系统的可用性

分布式共享卷

Source

Target

EMC VPLEX虚拟存储交流

© 版权所有 2010 EMC Corporation。保留所有权利。

1

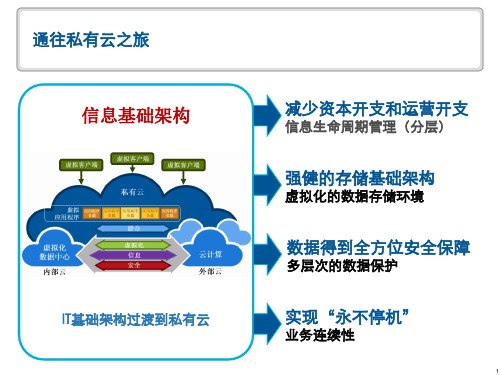

构建虚拟数据中心

• 物理数据中心-虚拟数据中心-私有云 • 虚拟化是过渡到私有云的技术基础 • 虚拟化主要包括服务器虚拟化和存储虚拟化

– VMware主要提供服务器虚拟化解决方案 – EMC提供业界最为全面的存储虚拟化解决方案

• 虚拟化数据中心带来的好处:

– – – – –

高利用率 高可用性 高效率 低成本 管理简化

© 版权所有 2010 EMC Corporation。保留所有权利。

2

EMC关于虚拟化数据中心的规划

Application

• • • •

服务器和存储的联合体系 资源协作池 应用和数据的动态迁移 构建“IT即服务”的系统

23

VPLEX 管理界面

基于 Web 的 GUI

• VPLEX 管理控制台 • 支持存储查看和资源调配

–本地 –分布式

• 在线帮助

CLI

• 支持完整配置、资源调配和高级系 统管理功能

© 版权所有 2010 EMC Corporation。保留所有权利。

24

VPLEX 管理界面

© 版权所有 2010 EMC Corporation。保留所有权利。

EMCVPLEX安装实施实施方案

EMCVPLEX安装实施实施方案————————————————————————————————作者:————————————————————————————————日期:VPLEX-LOCAL的硬件配置信息此次安装的VPLEX-Local有单台台VPLEX组成,VPLEX的硬件配置如下:1)1个Engine2)2个Director,每个Engine由两个Director组成3)8个8Gb前端FC端口,每个Director包含一块前端FC卡,共4个8Gb的前端FC端口,由于交换机端口限制,本次使用4个前端FC端口(每个Directo上两个)。

4)8个8Gb后端FC端口,每个Director包含一块后端FC卡,共4个8Gb的后端FC端口。

本次使用4个前端FC端口(每个Directo上两个)5)4个可用的8Gb的VPLEX-Local级联FC端口,每个Director包含一块VPLEX-Local级联FC卡,共4个8Gb的级联FC端口,但是只有两个可用VPLEX-LOCAL的硬件介绍单台VPLEX的硬件布局VPLEX的ENGINE的硬件布局VPLEX-LOCAL的级联端口连接VPLEX-LOCAL拓扑结构VPLEX-LOCAL 的FABRIC 拓扑图Fabric Switch Engine power supplyManagement serverFabric SwitchVNX VNXVPLEX Host HostVPLEX-LOCAL 后端存储系统的配置VMAX_3358Vplex Meta volume ( >= 78GB, using 144GB )Vplex Meta volume backup ( >=78GB, using 144GB )VPLEX logging volume ( >=10GB, using 72GB )Host data volumeVMAX_0251HOST_BAKHOST_PRD VPLEX_0550VPLEX_0549Host data volumeHost data volumeMETA VOLUME的配置请注意每台VNX必须使用两个RG,每个RG各提供两个80G LUN。

Vplex实施手册

Vplex-Metro实施手册项目名称:标题文档版本号: 1.1 文档作者:生成日期:文档维护记录版本号维护日期作者/维护人描述1.01. 系统topo (6)2. 系统概述 (7)3. 系统配置前准备 (7)3.1. VNX 5700配置(代理商完成) (7)3.2. 光纤线部署 (7)3.3. 网线部署 (8)3.4. 在san switch上创建alias (8)4. vplex配置步骤 (10)4.1. 配置VPLEX的hostname和管理网口IP (10)4.1.1. 配置AVPLEX01的hostname和管理网口IP (10)4.1.2. 配置BVPLEX01的hostname和管理网口IP (10)4.2. Cluster1 EZ-SETUP (10)4.3. 分配AVNX570001磁盘给AVPLEX01 BE port (11)4.3.1. 创建AVNX570001到AVPLEX01 BE PORT的zoning (11)4.3.2. 在AVNX570001上注册AVPLEX01 (11)4.3.3. 在AVNX570001创建LUN (11)4.3.4. 在AVNX570001上创建storage group (12)4.4. 继续cluster1安装 (12)4.4.1. 继续EZ-SETUP (12)4.4.2. 配置meta-volume (12)4.4.3. 配置meta-volume backup (12)4.4.4. enable vplex FE port (12)4.5. Cluster2 和Cluster1时间同步 (12)4.6. Cluster2 EZ-SETUP (12)4.7. 分配BVNX570001磁盘给BVPLEX01 BE port (13)4.7.1. 创建BVNX570001到BVPLEX01 BE PORT的zoning (13)4.7.2. 在BVNX570001上注册BVPLEX01 (13)4.7.3. 在BVNX570001创建LUN (14)4.7.4. 在BVNX570001上创建storage group (14)4.8. 继续cluster2安装 (14)4.8.1. 继续EZ-SETUP (14)4.8.2. 配置meta-volume (14)4.8.3. 配置meta-volume backup (14)4.9. 在cluster1上完成系统配置 (15)4.10. 在cluster2上完成系统配置 (15)4.11. 配置WAN interface连接 (15)4.12. cluster2 join cluster (15)4.13. 配置cluster2 上的logging volume (15)4.14. 配置cluster1 上的logging volume (16)5. 升级vplex到最新版本 (16)5.1. 在cluster1上执行pre-check (16)5.2. 升级cluster1的management server (16)5.3. 在cluster2上执行pre-check (16)5.4. 升级cluster2的management server (16)5.5. 在cluster1上 (16)6. Vplex Witness部署 (17)6.1. 登陆到ESXi,通过OVA文件部署Witness的VM (17)6.2. Poweron Witness vm,登录到console进行配置 (17)6.3. 配置三路VPN (17)6.3.1. 配置cluster1 上配置三路VPN (17)6.3.2. 配置cluster2 上配置三路VPN (17)6.3.3. 在cluster1 上确认VPN状态 (17)6.3.4. 在cluster2 上确认VPN状态 (17)7. 创建virtual volume (17)7.1. Claim storage volume (17)7.1.1. Claim cluster1的storage volume (17)7.1.2. Claim cluster2的storage volume (18)7.2. 在cluster1上创建extent (18)7.3. 在cluster2上创建extent (21)7.4. 在cluster1上创建device (21)7.5. 在cluster2上创建device (25)7.6. 创建distributed devices (25)8. ESXi磁盘分配 (30)8.1. 安装powerpath/VE (30)8.1.1. 安装esxcli (30)8.1.2. 安装powerpath/VE (30)8.1.3. Reboot esxi 服务器 (30)8.1.4. 安装rtools (30)8.2. 创建ESXi到VPLEX FE PORT的zoning (31)8.2.1. 创建ESXi到同SAN switch相连的VPLEX的zoning (31)8.2.2. 创建ESXi到同SAN switch相连的VPLEX的zoning (32)8.3. 在BVPLEX01上注册ESXi initiator (33)8.4. 在AVPLEX01上注册ESXi initiator (34)8.5. 在BVPLEX01上创建storage view (35)8.6. 在ESXi上扫描磁盘 (38)8.7. 在ESXi上创建Datastore (40)9. 可用性测试 (40)9.1. 测试前准备 (40)9.2. 拔vplex前端口测试 (40)9.3. 拔vplex后端口测试 (41)9.4. 拔vplex wan 光纤测试 (41)9.5. 关闭后端存储测试 (41)9.6. 关闭一台vplex测试 (41)10. 系统当前配置 (41)10.1. 密码配置 (41)10.2. VNX5300配置信息 (42)10.2.1. AVNX570001配置信息 (42)10.2.2. BVNX570001配置信息 (42)10.3. VPLEX配置 (42)10.3.1. Cluster_1配置信息 (42)10.3.2. Cluster_2配置信息 (42)10.4. SAN switch配置 (43)10.4.1. Fabric1配置 (43)10.4.2. Fabric2配置 (43)1.系统topo2.系统概述本次xxx使用EMC Vplex Metro技术来实现存储系统的高可用访问,系统topo结构入第一节所示,两台VPLEX CLUSTER各自使用后端口链接一台VNX5300,其前端口供4台ESXi服务器交叉访问。

VPLEX介绍

3

SAN

Fiber Channel

SAN

VPLEX 引擎

1

VPLEX 引擎

闪存 光纤 S10 EMC Corporation. All rights reserved.

22

Canon 更新拓扑架构

4

非虚拟化应用 备份服务器

3 5

非 虚 拟 化 应 用 存 储

CPU 复合

核心 核心

核心 核心

核心 核心

核心 核心

全局内存

全局内存

• 每个引擎配有高可用性双 控制器 • 冗余电源 • 集成的电池备份 • “呼叫总部”和远程支持

VPLEX 引擎规格

连接性 内部连接 处理器 内存 32 个 8 Gb/s 光纤通道交换机/ 阵列端口 控制器之间采用光纤通道互连 Intel 多核 CPU 64 GB(裸)读缓存

对主机群集的支持

ESX 群集之间的远距离 Vmotion(100 公里)

管理服务器 8 端口光纤通道交换机 8 端口光纤通道交换机 交换机电源 交换机电源

引擎电源 引擎电源 引擎电源 引擎电源

引擎电源

具有 Hyper-V 功能的 MSCS/CSV(100 公里)* 群集文件系统*

* 请参考 Powerlink 上的 E-Lab 文档“EMC VPLEX 简单支持列表”

© Copyright 2010 EMC Corporation. All rights reserved.

13

VPLEX Metro

管理服务器 8 端口光纤通道交换机 8 端口光纤通道交换机 交换机电源 交换机电源

AccessAnywhere

最多 8 个虚拟化引擎 总计 16,000 个虚拟化 LUN 在数据中心内或跨数据中心 支持同步距离

emc云存储设备vplex

– 在可预测的服务级别从小到大逐步 扩展性能

高级数据缓存

Brocade、 Cisco VPLEX

– 提高 I/O 性能并减少存储阵列争用

分布式缓存一致性

– 在数据中心内和数据中心之间实现 存储域自动平衡和故障切换

Brocade、 Cisco

HP、Oracle (Sun)、Hitachi、HP (3PAR)、IBM、EMC

实现应用程序正常运行时间

站点 1 站点 2

• 连续可用性 • 易于安装和配置

WITNESS

VPLEX

• 最佳性能 • 不降低性能地扩展

主动

站点 3

主动

Federated AccessAnywhere

• 仍可用于非 RAC 服务器

EMC 保密资料 — 要求签署保密协议

12

VPLEX 和 EMC RecoverPoint

利用两个站点的资源 无中断地移动和共享数据

EMC 保密资料 — 要求签署保密协议

22

为什么分布您的数据中心?

提高可用性

– 两个分布式中心都承担生产工作负载并且同时互相提供 恢复能力

提高资产利用率

– 被动分布式中心价格昂贵并且通常闲置资源

提高性能(局部访问数据)

– 数据不需要从“生产”站点读取,因为在两个站点上可以 读写访问同样的数据

EMC 保密资料 — 要求签署保密协议

14

协作性:通过 VPLEX 得到优化

在不同的位置同时使用数据

站点 1 站点 2

一个拷贝 — 始终最新 立即可用

无管理开销

WITNESS

VPLEX

站点 3

Federated AccessAnywhere

emc_vplex_solution

• VPLEX 使相同的数据同 时在两个地方 • 主机群集现在可以被扩展 • 结合了 HA 和 DR 的好 处 1+1=3!

活动

被动 活动

距离 复制

© Copyright 2013 EMC Corporation. All rights reserved.

29

通过 VPLEX 实现 VMware 连续可用性

15

场景之三:分布式数据协作

10101

01010

“AccessAnywhere” 以跨越更远距离 共享(而非复制)相 同的数据

VPLEX

VPLEX 优势

© Copyright 2013 EMC Corporation. All rights reserved.

• 数据可在任何时候供所有用户访问 • AccessAnywhere 可维护一致性 • 降低带宽要求

11

场景之二:高可用性

服务器群集

一般方法

• • • •

目标

源

复制

服务器群集 主机镜像 主动/被动 远程复制

传统 挑战

• 镜像或群集需要进行服务器循环 • 出现故障之后需要重新启动应用程序 • 远程复制的 RTO/RPO 影响

© Copyright 2013 EMC Corporation. All rights reserved.

站点 A 站点 B

一般方法

• 磁带备份/恢复 • 主机或网络复制 • 远程复制

传统 挑战

• 需要大量时间和计划工作 • 调整应用程序位置的进展缓慢且会中断 • 远距离调整位置更加困难

© Copyright 2013 EMC Corporation. All rights reserved.

emcvplex安装实施方案(20200515182405)

VPLEX_GATEWAY eth3

【 VPLEXCLI_CLUSTER_】1 # ll /management-server/ports/eth3

8. 运行 exit 命令,退出 VPLEX_01到 Manager Server ,检查公用管理网络的连通性

【 VPLEXCLI_CLUSTER_】1 # exit

【 MS_CLUSTER_】1 # cat /etc/HOSTNAME

6. 运行 vplexcli 命令登陆到 VPLEX_01,用户名为 service ,密码为 Mi@Dim7T

【 MS_CLUSTER_】1 # vplexcli

7. 配置 Manager Server 的管理公用 IP 地址

【 VPLEXCLI_CLUSTER_】1 # management-server set-ip -i VPLEX_01_IP:VPLEX_NETMASK-g

【 MS_CLUSTER_】1 # ping VPLEX_GATEWAY

9. 配置 NTP时钟服务器,同步时间

【 MS_CLUSTER_】1 # vi /etc/

; 设置外部 server 为 NTP_IP

【 MS_CLUSTER_】1 # sudo /etc/ntp restart 【 MS_CLUSTER_】1 # date 10. 运行 exit 命令,退出 VPLEX_01的 Manager Server 【 MS_CLUSTER_】1 # exit

VPLEX-LOCAL 的 硬 件 配 置 信 息

此次安装的 VPLEX-Local 有单台台 VPLEX组成, VPLEX的硬件配置如下: 1) 1 个 Engine 2) 2 个 Director ,每个 Engine 由两个 Director 组成 3) 8 个 8Gb 前端 FC端口,每个 Director 包含一块前端 FC卡,共 4 个 8Gb 的前端 FC端口,

EMC VPLEX-介绍 - customer

© 版权所有 2010 EMC Corporation。保留所有权利。

10

VPLEX仲裁机制:Witness

Site 1 Site 2

• 适用于VPLEX Metro和 VPLEX Geo • 实现无缝切换 • 防止“脑裂”出现

VPLEX

WITNESS

• 运行在一个虚机上面 • 通过IP连接到 VPLEX上 实现自动的切换和恢复

• 数据库以DB2为主;

• 业务系统为全部渠道类 业务;

© 版权所有 2010 EMC Corporation。保留所有权利。

Site A Site B

Active-Active

VPLEX Metro

分布式共享卷 光纤链路

VPLEX 可以让两边资源同时处于活动 状态

当A站点存储失败时,主机可以通过 VPLEX无中断的访问B站点的数据

当A站点主机失败时,两站点的数据依 然保持同步 底层数据通过VPLEX实时同步

EMC VPLEX系列介绍

© 版权所有 2010 EMC Corporation。保留所有权利。

1

EMC存储虚拟化解决方案

阵列内虚拟化 阵列联邦 SAN存储虚拟化

Storage Federation

SAN Virtualization

FAST

全自动存储分层

FTS 基于阵列的存储联合

VPLEX 基于SAN的存储虚拟化

LAN Backbone LAN Backbone Oracle RAC cluster

RAC interconnect

Primary I/O path

Primary I/O path

Simplif y

Dual SAN switches VPLEX Clusters

EMC_VPlex存储双活建设方案详细

将VPlex不兼容的存储系统上的数据,通过第三方数据迁移工具迁移到VPlex存储资源池中;

4.

A.省局数据的备份:所有的备份数据,都通过备份软件平台进行管理,备份到虚拟带库DataDomain DD620中;备份服务器可以对备份集、备份空间、备份作业调度进行统一的管理,备份存储DD可以对所有写进来的备份数据进行重复数据消除;

VNX 7500还支持LUN的条带化或级联式扩展,以将数据分散到更多的磁盘上;

C.中心机房-存储虚拟化:以EMC VPlex Local作为存储虚拟化;应用系统只需要访问虚拟化存储,而不需要直接管理后端的具体的存储系统;通过存储虚拟化,可以达到两台存储之间双活,可以支持异构的存储系统,对数据进行跨存储的本地及远程保护,统一管理接口和访问接口;

EMC VNX 7500存储系统可同时提供光纤SAN、IP SAN、NAS等多种存储模式,最大可扩展到1000块磁盘,支持光纤盘、闪存盘、SATA盘、SAS盘、NL-SAS盘等多种磁盘混插,大大增强存储系统的可扩展性;

VNX 7500支持将闪存盘作为可读写的二级缓存来使用,VNX7500最大可支持2.1TB二级缓存。同时支持自动的存储分层(FAST),提高存储系统的整体性能;

当VPlex系统自身出现故障时,由于在Vplex中的设置,VPlex不会修改存储系统LUN的配置信息,即,用户可以将存储系统A或B的LUN直接挂到应用系统,保证应用系统的继续运行,不会产生数据丢失。

vplex+vnx方案

第1章IT建设方案说明1.1服务器部分说明数据库服务器采用两台X3850X5服务器,通过ROSEHA实现高可用双机环境。

应用服务器采用3台X3650M4服务器。

1.2存储部分说明新购VNX5100存储,建立统一存储资源环境,用于集中存放核心数据库数据。

采用两台24口交换机(激活16口)构建SAN网络,数据库服务器通过SAN 网络访问VNX5100磁盘阵列,提供高速,安全,稳定的链路环境。

1.3存储高可用说明配置VPLEX存储虚拟化引擎,建立数据中心内部存储高可用架构平台,消除磁盘阵列的单点故障,保证核心数据库业务连续性要求,当出现硬件故障时,无需人为参与切换,高可用平台自动进行调整保证核心业务不会中断。

并且提供动态资源调度,能够灵活的进行管理,提高整体应用平台的弹性。

第2章IT存储系统详细设计2.1存储基础架构图2.2核心存储设计针对客户的需求,推荐使用一台EMC VNX系列统一存储产品作为数据库的核心存储。

VNX是EMC新一代的中端存储产品,它将Celerra (NS) 和CLARiiON (CX4) 统一到单个产品品牌中,将Celerra和CLARiiON的所有价值推广到 VNX 系列的客户。

它面向要求高级功能、灵活性和可配置性的中端和企业存储环境。

VNX 系列在效率、简洁性和性能上有巨大的进步。

VNX 建议配置如下:VNX5100磁盘阵列:双SAN控制器,8G高速缓存,4个8Gb FC前端口,配置4个6Gb四通道SAS磁盘接口,14块 600GB 15000转SAS硬盘。

配置图形化管理软件Unisphere。

配置说明:使用了600GB 15000转的SAS盘(核心数据库数据),同样类型硬盘做RAID5数据保护,并且配置了hot spare热备盘,提升磁盘阵列的可靠性和安全性;配置容量足以支持客户现有业务发展和数据增长;同时通过8Gb/s FC光纤链路将磁盘阵列两个控制器的FC主机端口分别与两台FC光纤交换机相连,实现磁盘阵列的链路冗余和负载均衡;通过基于WEB的阵列管理软件Unisphere可以在单一WEB管理界面实现存储管理和监控,操作简单易懂。

5. EMC VPLEX

用户痛点

核心业务系统非常重要,无法容忍停机和丢失任何数据 异构存储之间无法实现数据迁移和整合 多台不同品牌存储阵列管理复杂,老存储利旧问题 虚拟化导致的架构扩展问题

解决方案

单VPLEX群集管理本地数据中心的EMC和非EMC存储,通过存储虚拟 化整合异构存储系统,结合VPLEX Local RAID 1镜像技术扩展业务连 续性,让应用系统在出现阵列故障和维护操作时可继续处理。

– 这是VPLEX最重要的卖点,几乎所有做容灾的客户都会对这个 理念感兴趣。 – 对于非EMC Install Base的客户,使用VPLEX作整合,可以帮 助EMC进入这个客户,且一般会带来存储的生意。 – 对于远程异地容灾系统,距离较远或不具备光纤条件,或当前 存储非EMC设备的,我会推荐RecoverPoint方案。这时VPLEX作 为拆分器和本地存储整合利旧方案,可以提供打包给客户。 – 对于很多不做容灾的客户,VPLEX Local可以实现本地存储的 双活。

Enhanced Availability AND Workload Mobility

Active – Active Solution Support for all major server clustering technologies Enables separation of cluster nodes over distance Standard clustering – requires no special functionality or ―glue‖

Volume

Volume

Storage

Storage

© 版权所有 2014 EMC Corporation。保留所有权利。

15

VPLEX介绍课件完整

设备

数据区

设备

存储卷

数据区

存储卷

LUN

存储卷

启动器

启动器

主机

虚拟卷

顶层设备 (TLD)

使用 VPLEX Management Console

Tasks

Provisioning Overview

Provision Storage

EMC VPLEX 运行机制-分布式缓存一致性

引擎缓存一致性目录

VPLEX 引擎:核心组件

引擎

控制器

前端端口

后端端口

通信端口

网络端口

EMC 和 非 EMC 阵列

EMC 和 非 EMC 阵列

VPLEX 管理服务器

群集 2/站点 B

主机

虚拟卷

虚拟卷

虚拟卷

虚拟卷

VPLEX 控制器

VPLEX 后端端口

LCOM

VPLEX 前端端口

虚拟卷

虚拟卷

虚拟卷

虚拟卷

VPLEX 管理服务器

数据通过缓存写入后端存储。

后端阵列发出数据确认。

数据写入磁盘后,就会向主机发出确认。

10110…

10110…

10110…

10110…

ACK

ACK

ACK

ACK

EMC VPLEX应用场景总结

支持 EMC 与 非 EMC 阵列之间的移动性

在不影响用户的情况下 移动数据以减少停机

简化和加快技术更新

简化多阵列存储管理

数据通过缓存写入后端存储。

后端阵列发出数据确认。

数据写入磁盘后,就会向主机发出确认。

分布式设备:I/O 操作

10110…

10110…

emcvplex安装方案

VPLEX-LOCAL 的硬件配置信息此次安装的VPLEX-Local 有单台台VPLEX构成, VPLEX的硬件配置以下:1) 1 个 Engine2)2个 Director ,每个 Engine由两个Director 构成3)8个 8Gb 前端 FC端口,每个Director包括一块前端FC卡,共 4 个 8Gb 的前端 FC端口,因为互换机端口限制,本次使用 4 个前端 FC 端口(每个 Directo 上两个)。

4)8个 8Gb 后端 FC端口,每个Director包括一块后端FC卡,共 4 个 8Gb 的后端 FC端口。

本次使用 4 个前端 FC 端口(每个 Directo 上两个)5)4个可用的8Gb 的 VPLEX-Local 级联 FC端口,每个Director 包括一块 VPLEX-Local 级联FC 卡,共 4 个 8Gb 的级联 FC端口,可是只有两个可用VPLEX-LOCAL 的硬件介绍单台 VPLEX的硬件布局VPLEX 的 ENGINE 的硬件布局VPLEX-LOCAL 的级联端口连结PLEX-LOCAL 拓扑结构VPLEX-LOCAL 的 FABRIC 拓扑图Host HostFabric Switch Fabric SwitchManagement serverEngine power supplyVNX VPLEX VNX VPLEX-LOCAL 后端储存系统的配置HOST_PRD HOST_BAK VPLEX_0550VMAX_3358Vplex Meta volume ( >= 78GB, using 144GB ) Host data volume Vplex Meta volume backup ( >=78GB, using 144GB )Host data volumeVPLEX_0549VMAX_0251VPLEX logging volume ( >=10GB, using 72GB )Host data volumeMETA VOLUME的配置请注意每台 VNX一定使用两个 RG,每个 RG各供给两个 80G LUN。

EMC VPLEX

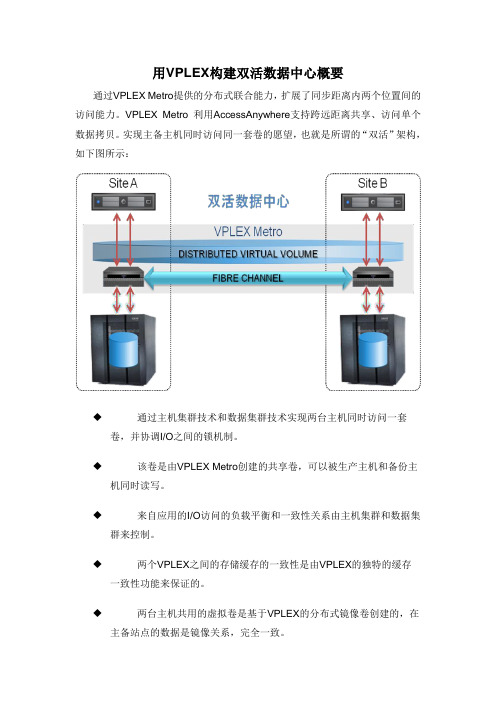

用VPLEX构建双活数据中心概要

通过VPLEX Metro提供的分布式联合能力,扩展了同步距离内两个位置间的访问能力。

VPLEX Metro 利用AccessAnywhere支持跨远距离共享、访问单个数据拷贝。

实现主备主机同时访问同一套卷的愿望,也就是所谓的“双活”架构,如下图所示:

◆通过主机集群技术和数据集群技术实现两台主机同时访问一套

卷,并协调I/O之间的锁机制。

◆该卷是由VPLEX Metro创建的共享卷,可以被生产主机和备份主

机同时读写。

◆来自应用的I/O访问的负载平衡和一致性关系由主机集群和数据集

群来控制。

◆两个VPLEX之间的存储缓存的一致性是由VPLEX的独特的缓存

一致性功能来保证的。

◆两台主机共用的虚拟卷是基于VPLEX的分布式镜像卷创建的,在

主备站点的数据是镜像关系,完全一致。

在生产主机正常进行读写的同时,备份主机可以接受只读I/O请求,而且从备份主机读出来的数据是实时更新的生产数据。

08_VPLEX

Brocade、 Cisco VPLEX

• 高级数据缓存

– 提高 I/O 性能,减少存储阵列争 用

• 分布式缓存一致性

Brocade、 Cisco

– 在数据中心内和跨数据中心自动对 存储域实施平衡和故障切换

HP、Sun、Hitachi、3PAR、IBM、EMC

© 版权所有 2011 EMC Corporation。保留所有权利。

3

满足当今的业务和 IT 需求

分布式. 动态. 智能.

VPLEX Local VPLEX Metro VPLEX Geo

VS1

VS2

数据中心内

远距离 AccessAnywhere 同

远距离 AccessAnywhere 异步

一个、两个或 四个引擎

步

© 版权所有 2011 EMC Corporation。保留所有权利。

6

主动-被动数据访问

使用 VPLEX 之前

站点 A 站点 B

主动-被动站点

在发生故障时使用 灾难恢复站点上的数据 停机以移动应用程序

同步/异步复制

© 版权所有 2011 EMC Corporation。保留所有权利。

7

联合数据访问

使用 VPLEX

站点 A 站点 B

主动-主动站点

VPLEX Metro 或 VPLEX Geo

2

VPLEX 系列概述 它是什么?

• 硬件和软件虚拟化平台

• 作为基于 SAN 的解决方案实施 • 支持本地和分布式联合

有何独特之处?

• AccessAnywhere • 高可用性、横向扩展群集体系结构 • 独特的技术支持员工远距离协作

© 版权所有 2011 EMC Corporation。保留所有权利。

VPLEX Metro

产品介绍在数据中心内、跨数据中心和在数据中心之间进行透明的信息移动用于私有云的新存储平台多少年来,用户都依赖传统的物理存储来满足其信息需要。

不断发展的变化,如服务器虚拟化以及用户网络中的多个站点的增长,已对存储管理以及信息访问的方式有了新的要求。

为跟上这些新的要求,存储必须改进,以提供新的将数据从物理设备中解放出来的方法。

存储必须能够连接到虚拟环境,同时仍然可以提供自动化、与现有基础架构的集成、按需使用、安全性、成本效益、可用性和安全性。

EMC® VPLEX™ 系列是用于在数据中心内、跨数据中心和在数据中心之间进行信息移动和访问的新一代解决方案。

它是世界上第一个同时提供本地联合和分布式联合的平台。

• 本地联合提供站点内物理元素的透明协作。

• 分布式联合跨远距离扩展了两个位置之间的访问能力。

VPLEX 是一个用于联合 EMC 和非 EMC 存储的解决方案。

VPLEX 存储联合为私有云计算时代提供了广泛的新特性和功能。

• AccessAnywhere™随 VPLEX 一起提供,是 EMC 的一种突破性技术,支持跨远距离共享、访问和移置单个数据拷贝。

EMC GeoSynchrony™ 是 VPLEX操作系统。

由于 VPLEX 消除了物理障碍,使用户能够在不同地理位置访问单个数据拷贝,所以它还帮助实现了地理位置延伸的虚拟和物理主机群集,这样就允许在多个站点之间透明地共享负载,并可以灵活地在站点之间移置工作负载以应对计划中的事件。

另外,如果在其中一个数据中心发生了可能导致运营中断的计划外事件,则停下的服务可以在幸存下来的站点上重启,而这只需要最小的工作量,并最大限度地减少了恢复时间。

VPLEX 彻底改变了管理和提供 IT 服务的方式—特别是与服务器虚拟化一起部署时。

通过为操作和管理 IT 启用新的计算模型,可对资源进行联合,亦即让它们加入共用池并跨整个堆栈进行协作,另外还可以跨地理位置和服务提供商动态移动应用程序和数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

拓扑图

Ethernet 物理服务器

虚拟化服务器

SAN EMC VPLEX

EMC VNX5400

EMC VNX5400

VPLEX– 连接示意图

0.2 到 0.5 ms 的延 迟

服务器

ห้องสมุดไป่ตู้

服务器

SAN交换机

SAN交换机

VNX 5400

之前

VNX 5400

之后

关于VPLEX单点故障的疑问

• VPLEX是独立专业硬件,不影响主机和存储的性能,不影 响主机与存储的逻辑关系,可以根据需要扩展性能。 • VPLEX本身具有99.999%的高可用性,每个引擎具备双控制 器,硬件上完全冗余,同时达可以扩展多个节点。 • 即使退一万步来讲,所有的VPLEX都坏掉了,存储上的数 据还是可以访问的。只要通过相关主机命令如:AIX的 cfgmgr等重新识别设备就能访问磁盘了。 • VPLEX 能够提高主机对存储数据读写的性能。Vplex所有的 写是Write Through,同时还可以组成Cluster做横向扩展, 而且VPLEX采用分布式横向扩展的集群架构,按需添加 VPLEX引擎线性扩展性能。