手势识别代码以及部分原理

手势识别的原理

手势识别的原理一、引言随着智能手机、智能手表等智能设备的普及,手势识别技术也越来越受到关注。

手势识别技术是指通过对人类动作的感知和分析,来实现人机交互的一种技术。

本文将从手势识别的定义、分类、原理、应用等方面进行详细介绍。

二、手势识别的定义和分类1. 定义手势识别是指通过对人类动作的感知和分析,来实现人机交互的一种技术。

它可以使用户通过简单自然的动作来控制设备,而不需要使用鼠标或键盘等传统输入设备。

2. 分类根据输入方式不同,手势识别可以分为以下几类:(1)触摸屏幕手势:用户通过在触摸屏幕上进行滑动、点击等操作来控制设备。

(2)摄像头手势:用户通过在摄像头前做出特定动作来控制设备。

(3)传感器手势:用户通过在空中做出特定动作来控制设备,如微软Kinect。

三、手势识别的原理1. 触摸屏幕手势识别原理触摸屏幕手势识别主要是通过对电容屏幕或电阻屏幕的触摸信号进行分析来实现的。

具体原理如下:(1)电容屏幕手势识别原理电容屏幕是一种基于电容原理的触控技术,它利用了人体和物体表面都具有一定的电容特性这一事实。

当用户手指接触到电容屏幕时,会改变屏幕上的电场分布,从而产生一个与手指位置有关的信号。

系统通过对这个信号进行处理,就可以确定用户手指在屏幕上的位置和动作。

(2)电阻屏幕手势识别原理电阻屏幕是一种基于压力感应原理的触控技术,它由两个互相垂直的导电膜组成。

当用户用手指或者其他物体轻按在屏幕上时,会使导电膜之间产生接触点,从而形成一个闭合回路。

系统通过检测这个回路中流过的电流大小和方向来确定用户手指在屏幕上的位置和动作。

2. 摄像头手势识别原理摄像头手势识别主要是通过对用户动作的图像进行分析来实现的。

具体原理如下:(1)色彩空间转换首先,系统需要将摄像头获取到的RGB图像转换为HSV或YCbCr等颜色空间。

这是因为在这些颜色空间中,人类肉眼难以区分的颜色差异可以被更好地区分出来。

(2)肤色检测接下来,系统会对图像进行肤色检测,以便识别出用户手部所在的位置。

python手势识别总结

python手势识别总结Python手势识别是一种利用计算机视觉技术,通过分析和识别人手在摄像头中的姿势和动作,来实现特定功能的技术。

它可以应用于许多领域,如人机交互、虚拟现实、智能家居等。

本文将介绍Python手势识别的原理、应用以及相关的开源库和工具。

一、Python手势识别的原理Python手势识别利用计算机视觉技术中的图像处理和机器学习算法,对手部图像进行分析和识别。

首先,需要获取手部图像,可以通过摄像头实时捕捉手部图像或者从视频中提取手部图像。

然后,对手部图像进行预处理,包括去噪、边缘检测、图像增强等操作,以提高后续识别的准确性。

接下来,使用特征提取算法从手部图像中提取出关键特征,如手指的位置、角度、曲率等。

最后,通过训练好的机器学习模型或者深度学习模型,对提取到的特征进行分类和识别,从而实现对手势的识别。

二、Python手势识别的应用1. 人机交互:通过手势识别可以实现与计算机的自然交互,用户可以通过手势来控制计算机的操作,比如手势点击、手势滑动等。

2. 虚拟现实:在虚拟现实环境中,用户可以通过手势来进行操作和交互,比如手势控制虚拟角色的动作、手势操作虚拟物体等。

3. 智能家居:通过手势识别可以实现智能家居的控制,比如通过手势来控制灯光的开关、调节音量等。

4. 医疗辅助:手势识别可以应用于医疗领域,比如通过手势来进行手术操作的训练、辅助残障人士的康复训练等。

三、Python手势识别的开源库和工具1. OpenCV:OpenCV是一个开源的计算机视觉库,提供了丰富的图像处理和计算机视觉算法,包括手势识别。

它支持多种编程语言,包括Python。

2. Mediapipe:Mediapipe是Google开源的一款多媒体处理框架,提供了一系列的计算机视觉和机器学习算法,包括手势识别。

它支持实时手势识别和姿势估计等功能。

3. TensorFlow:TensorFlow是一个开源的深度学习框架,可以用于训练和部署机器学习模型。

手势识别原理

手势识别原理

手势识别技术是一种通过分析和识别人体动作来理解人类意图的方法。

它主要基于计算机视觉和机器学习算法,在摄像头捕捉到的图像或视频中检测和识别出人体动作,进而将其转化为可理解的指令或控制信号。

手势识别的原理包括以下几个步骤:

1. 数据采集:使用摄像头或其他图像传感器采集人体动作的图像或视频数据。

2. 预处理:对采集到的图像或视频进行预处理,包括调整图像大小、滤波、边缘检测等,以提高后续处理的准确性和效率。

3. 特征提取:利用图像处理算法提取出与手势有关的特征,例如手的形状、运动轨迹、手指关节的位置等。

这些特征可以用来描述手势的形态和动作。

4. 特征选择和降维:从提取到的特征中选择最具代表性的几个特征,并进行降维处理。

这样可以减少特征维度,提高后续分类和识别的效果。

5. 分类和识别:利用机器学习算法,将特征与已有的手势模式进行比对和分类。

常用的算法包括支持向量机(SVM)、随机森林(Random Forest)和卷积神经网络(Convolutional Neural Networks, CNN)等。

6. 动作解析:识别出手势后,将其转化为控制信号或指令,以达到相应的功能。

例如,手势“握拳”可能对应着“点击”操作,手势“上下移动”可能对应着滚动页面。

手势识别技术广泛应用于各个领域,如智能家居控制、虚拟现实和增强现实交互、手势密码解锁等。

随着深度学习和人工智能的发展,手势识别技术将越来越智能和准确。

基于计算机视觉的手势识别技术简介

基于计算机视觉的手势识别技术简介手势识别是一种利用人体手部运动或姿态来实现人机交互的技术。

随着计算机视觉和机器学习的不断发展,基于计算机视觉的手势识别技术得到了极大的改进和应用。

本文将介绍基于计算机视觉的手势识别技术的原理、方法以及应用领域。

首先,基于计算机视觉的手势识别技术的原理是通过摄像机或深度传感器捕捉手部的图像或深度信息,然后利用图像处理和模式识别的方法来提取手势特征并进行分类识别。

其中,模式识别是手势识别的核心技术之一,主要利用机器学习算法对手势进行分类和识别。

在手势识别方法方面,基于计算机视觉的手势识别技术可分为离线和实时两种。

离线手势识别是对预先录制的手势视频进行分析和识别,通常采用静态图像处理和机器学习算法来进行手势分类。

而实时手势识别是在实时视频流中进行手势识别,要求实时性较高,因此采用动态图像处理和实时机器学习算法来实现。

基于计算机视觉的手势识别技术有多种应用领域。

其中,最为重要的应用领域之一是人机交互。

手势识别技术能够通过手势控制设备,实现电脑、智能手机和游戏机等的操作,提供更加直观、自然的交互方式。

此外,在虚拟现实和增强现实领域,手势识别技术也被广泛应用,能够实现用户手势与虚拟场景的交互,提升用户体验。

此外,基于计算机视觉的手势识别技术还应用于健康护理领域。

通过识别手势,可以实现手势导航、手势遥控等功能,帮助老年人或残障人士更加方便地使用电子设备。

同时,手势识别技术还可以应用于手势监测和手势分析,用于康复治疗和人类动作分析等领域。

需要注意的是,基于计算机视觉的手势识别技术还面临一些挑战和限制。

首先,手势特征的提取和分类是手势识别中的关键问题,需要有效的算法和模型来提高准确度和鲁棒性。

其次,不同的手势识别系统对硬件设备的要求也不同,需要根据具体应用场景选择合适的摄像头或深度传感器。

此外,光线条件、背景干扰和手势多样性也会对手势识别的效果产生影响。

综上所述,基于计算机视觉的手势识别技术在人机交互、虚拟现实、健康护理等领域具有广泛的应用前景。

android gesturedetector原理 -回复

android gesturedetector原理-回复Android GestureDetector 原理及使用Android 提供了GestureDetector 类来帮助开发者实现手势识别功能。

本文将详细介绍GestureDetector 的原理和使用方法。

一、GestureDetector 原理GestureDetector 是Android 框架为开发者封装的一个手势识别工具类。

它可以用来监听和处理用户的触摸手势事件,如滑动、点击、长按等。

GestureDetector 使用了事件监听器的设计模式,通过回调方法通知开发者触摸手势的开始、结束、移动等事件。

在Android 中,触摸手势是由MotionEvent 对象来表示的。

MotionEvent 包含了触摸事件的详细信息,如触摸的坐标、触摸的时间、触摸的压力等。

GestureDetector 利用MotionEvent 对象中的信息来判断用户的手势操作。

在GestureDetector 的实现中,主要使用了以下几个方法:1. onDown(MotionEvent e):当用户按下屏幕时调用,返回值表示是否消耗该事件。

2. onShowPress(MotionEvent e):当用户按下屏幕后未松开时调用。

3. onSingleTapUp(MotionEvent e):当用户手指离开屏幕并且没有发生滑动操作时调用,返回值表示是否消耗该事件。

4. onScroll(MotionEvent e1, MotionEvent e2, float distanceX, float distanceY):当用户滑动屏幕时调用。

5. onLongPress(MotionEvent e):当用户长按屏幕时调用。

6. onFling(MotionEvent e1, MotionEvent e2, float velocityX, float velocityY):当用户快速滑动屏幕时调用。

人机交互中的手势识别技术使用教程

人机交互中的手势识别技术使用教程手势识别技术是一种基于图像或传感器数据的人机交互技术,它可以将人的手势动作转化为计算机可以理解的命令,从而实现对计算机的控制。

手势识别技术在近些年得到了广泛应用,例如智能手机、虚拟现实设备和游戏控制器等领域。

本篇文章将介绍手势识别技术的基本原理和使用教程。

手势识别技术的基本原理主要包括手势检测、手势跟踪和手势分类三个步骤。

首先,手势检测是指通过摄像头或传感器来捕捉用户的手势动作。

可以使用基于摄像头的视觉手势识别方法,或者采用基于传感器的加速度计或陀螺仪来捕捉用户的手势动作。

其次,手势跟踪是指在连续的图像帧中跟踪用户手势的位置和轨迹。

最后,手势分类是指将已跟踪的手势与事先定义好的手势模型进行比较,以确定用户的具体手势动作。

为了使用手势识别技术,首先需要选择合适的硬件设备。

对于基于摄像头的手势识别,可以选择具备高像素和高帧率的摄像头。

对于基于传感器的手势识别,需要选择性能稳定且精度高的传感器。

接下来,需要选择合适的手势识别软件或开发工具。

常见的手势识别软件包括OpenCV、Leap Motion、Kinect等。

根据自身的需要和技术水平,选择适用的工具进行开发。

在进行手势识别的开发过程中,首先需要进行手势数据的采集和录入。

可以通过收集大量的手势数据样本,并将其与相应的命令或操作进行关联。

接下来,需要进行手势模型的训练。

手势模型可以采用机器学习算法进行训练,例如支持向量机、决策树或神经网络等。

训练过程需要将手势样本数据输入到机器学习算法中,让算法学习手势与命令之间的对应关系。

完成模型训练后,就可以使用训练好的手势模型进行手势识别。

手势识别技术的应用场景非常广泛。

在智能手机上,手势识别可以实现屏幕操作的替代,例如通过手势划屏来实现导航功能。

在虚拟现实设备中,手势识别可以用于交互控制,例如通过手势来选择和操控虚拟物体。

在游戏控制器中,手势识别可以用于实现体感游戏,例如通过手势动作来控制游戏角色的动作。

ios开发中的6种手势识别的实现

ios开发中的6种手势识别的实现IOS开发中手势识别有六种:轻击手势(TapGestureRecognizer),轻扫手势(SwipeGestureRecognizer),长按手势(LongPressGestureRecognizer),拖动手势(PanGestureRecognizer),捏合手势(PinchGestureRecognizer),旋转手势(RotationGestureRecognizer),1、轻击手势(TapGestureRecognizer)2、长按手势(LongPressGestureRecognizer)3、轻扫手势(SwipeGestureRecognizer)4、捏合手势(PinchGestureRecognizer)5、拖动手势(PanGestureRecognizer)6、旋转手势(RotationGestureRecognizer)关注我学院微信公众号(woxueyuan_)com),就可以随时随地观看你喜欢的视频教程,我学院教程全面覆盖PC、手机及MAC端。

只要你想学,随时随地都可以。

When you are old and grey and full of sleep,And nodding by the fire, take down this book,And slowly read, and dream of the soft lookYour eyes had once, and of their shadows deep;How many loved your moments of glad grace,And loved your beauty with love false or true,But one man loved the pilgrim soul in you,And loved the sorrows of your changing face; And bending down beside the glowing bars, Murmur, a little sadly, how love fledAnd paced upon the mountains overheadAnd hid his face amid a crowd of stars.The furthest distance in the worldIs not between life and deathBut when I stand in front of youYet you don't know thatI love you.The furthest distance in the worldIs not when I stand in front of youYet you can't see my loveBut when undoubtedly knowing the love from both Yet cannot be together.The furthest distance in the worldIs not being apart while being in loveBut when I plainly cannot resist the yearningYet pretending you have never been in my heart.The furthest distance in the world Is not struggling against the tides But using one's indifferent heart To dig an uncrossable riverFor the one who loves you.。

手势识别(一)--手势基本概念和ChaLearnGestureChallenge

⼿势识别(⼀)--⼿势基本概念和ChaLearnGestureChallenge以下转⾃:像点击(clicks)是GUI平台的核⼼,轻点(taps)是触摸平台的核⼼那样,⼿势(gestures)是Kinect应⽤程序的核⼼。

和图形⽤户界⾯中的数字交互不同,⼿势是现实⽣活中存在的动作。

如果没有电脑我们就不需要⿏标,但是没了Kinect,⼿势依然存在。

从另⼀⽅⾯讲,⼿势是⽇常⽣活中⼈与⼈之间相互交流的⼀部分。

⼿势能够增强演讲的说服⼒,能够⽤来强调和传递情感。

像挥⼿(waving)或者指向(pointing)这些⼿势都是某种⽆声的演讲。

Kinect应⽤程序的设计和开发者的任务就是将这些现实⽣活中存在的⼿势映射到计算机交互中去以传达⼈的想法。

尝试从⿏标或触摸式的GUI设计移植基于⼿势的⾃然交互界⾯要做很多⼯作。

借鉴过去30多年来对于这⼀概念的研究,以及从⼀些Kinect for Xbox的体感游戏中获取⼀些设计理念,计算机⼯程师和交互设计师⼀起为Kinect创建了⼀系列新的⼿势库。

本⽂将会介绍⽤户体验的⼀些知识,并讨论如何将⼿势应⽤到Kinect应⽤程序中。

我们将展⽰Kinect如何作为⾃然交互界⾯(Natural User Interface)的⼈机交互模型的⼀部分。

我们将讨论⼀些具体的使⽤Kinect来进⾏⼿势识别及交互的例⼦。

更重要的是,将会展⽰⼀些已经作为Kinect⼿势识别库中的⼿势1. 什么是⼿势在许多不同的学科中,⼿势(gesture)有着其独特的含义,可能这些含义之间有某些异同。

在艺术领域,⼿势被⽤来传达舞蹈中最富表现⼒的部分,特别是在亚洲舞蹈艺术中,⼿势被作为某些宗教符号或者象征。

在交互设计领域,在基于触摸的⾃然交互界⾯中⼿势和操控有很⼤区别。

以上这些说明⼿势在不同的学科领域都有⾃⼰独特的含义。

在学术领域都试图对⼿势定义⼀个抽象的概念。

在⽤户体验设计领域使⽤最⼴泛的关于⼿势的定义实在Eric Hulteen 和Gord Kurtenbach 1990年发表的⼀篇名为⼈机交互中的⼿势(Gestures in Human-Computer Communication),定义如下:”⼿势是⾝体的运动,他包含⼀些信息。

手势识别技术与动作跟踪

手势识别技术与动作跟踪近年来,手势识别技术和动作跟踪技术在各种领域得到了广泛的应用。

这些技术的出现,可以使得人们更加自然地与计算机交互,提高了计算机人机交互的便利性和舒适性。

本文将详细介绍手势识别技术和动作跟踪技术的基本原理和应用场景。

一、手势识别技术的基本原理手势识别技术是一种通过分析人体姿态,来识别人体特定动作的科技手段。

其基本原理是通过摄像机采集人体运动的通过姿态估计和行为识别的方式将人的动作转化为对应的指令。

手势识别技术最常用的方法是基于深度学习的方法。

这种方法需要大量的标注数据和算力支持,但是准确性相当高,可以应用于手势和身体行为的识别,例如跳舞、打球等。

二、手势识别技术的应用场景手势识别技术可以应用到很多领域,例如智能家居、疾病康复,以及虚拟现实等。

以下是手势识别技术的一些应用场景:1. 智能家居在智能家居中,手势识别技术可以使得人们更加自然地与智能设备交互,例如通过手势控制电灯、控制电视等。

这种方式消除了人们与设备之间的物理媒介,让人们更加方便地完成各种任务。

2. 疾病康复手势识别技术可以帮助康复患者进行自闭疗法,通过识别患者的行为,完成一些简单的游戏,例如拼图、打砖块等。

这种方法可以帮助疾病康复患者恢复部分感知和行动能力。

3. 虚拟现实手势识别技术也可以应用到虚拟现实领域,使得用户更加自然地与虚拟环境交互。

例如通过手势控制电影放映器、游戏主体角色等,让用户更加身临其境,获得更加真实的沉浸式体验。

三、动作跟踪技术的基本原理动作跟踪技术是一种通过分析图像或视频中的目标物体,来把它在整个视频中的位置和状态进行跟踪的技术手段。

其基本原理是利用视觉特征和各种跟踪算法,从一帧到下一帧的图像中找到目标,由此追踪目标的位置和运动状态变化,从而实现目标的实时跟踪。

动作跟踪技术最常用的方法包括基于深度学习和传统机器学习的方法,基于特征点追踪和区域追踪等方法。

四、动作跟踪技术的应用场景动作跟踪技术也可以应用到很多领域,例如视频监控、人体姿态估计等。

手势识别技术原理及解决方案

手势识别对于我们来说并不陌生,手势识别技术很早就有,目前也在逐渐成熟,现在大部分消费类应用都在试图增加这一识别功能,无论是智能家居,智能可穿戴以及VR 等应用领域,增加了手势识别控制功能,必能成为该应用产品的一大卖点。

手势识别可以带来很多的好处,功能炫酷,操作方便,在很多应用场合都起到了良好的助力功能。

手势识别技术的发展说起手势识别技术的发展,可以粗略分为两个阶段:二维手势识别以及三维手势识别。

早期的手势识别识别是基于二维彩色图像的识别技术,所谓的二维彩色图像是指通过普通摄像头拍出场景后,得到二维的静态图像,然后再通过计算机图形算法进行图像中内容的识别。

二维的手型识别的只能识别出几个静态的手势动作,而且这些动作必须要提前进行预设好。

相比较二维手势识别,三维手势识别增加了一个Z轴的信息,它可以识别各种手型、手势和动作。

三维手势识别也是现在手势识别发展的主要方向。

不过这种包含一定深度信息的手势识别,需要特别的硬件来实现。

常见的有通过传感器和光学摄像头来完成。

手势识别的关键技术手势识别中最关键的包括对手势动作的跟踪以及后续的计算机数据处理。

关于手势动作捕捉主要是通过光学和传感器两种方式来实现。

手势识别推测的算法,包括模板匹配技术(二维手势识别技术使用的)、通过统计样本特征以及深度学习神经网络技术。

根据硬件实现方式的不同,目前行业内所采用的手势识别大约有三种:1、结构光(Structure Light),通过激光的折射以及算法计算出物体的位置和深度信息,进而复原整个三维空间。

结构光的代表产品有微软的Kinect一代。

不过由于以来折射光的落点位移来计算位置,这种技术不能计算出精确的深度信息,对识别的距离也有严格的要求。

2、光飞时间(TIme of Flight),加载一个发光元件,通过CMOS传感器来捕捉计算光子的飞行时间,根据光子飞行时间推算出光子飞行的距离,也就得到了物体的深度信息。

代表作品为Intel带手势识别功能的三维摄像头。

手势识别的代码

clear;

hand_M=[];%定义训练集的特征向量

T=zeros(10,50);%定义训练集的目标向量

for ii=1:10 %手势类别循环

for jj=1:5 %手势个数循环

T(ii,(ii-1)*5+jj)=1;%

str=strcat('D:\ibm d盘\学习\研究生\任务\0323手势\训练集\',num2str(ii),'_',num2str(jj),'.bmp');%定义文件读取路径,可以根据实际情况修改

hand_hsv_1(i,j,:)=0;

else hand_hsv_1(i,j,:)=1;

end

if (hand_hsv_2(i,j,1)<=h4)&&(hand_hsv_2(i,j,1)>=h3)&&(hand_hsv_2(i,j,2)>=s1)&&(hand_hsv_2(i,j,2)<=s2)&&(hand_hsv_2(i,j,3)>=v1)&&(hand_hsv_2(i,j,3)<=v2)

hand_M((ii-1)*5+jj,3)=hand_M((ii-1)*5+jj,3)+(x_i-centroid_x)*(y_i-centroid_y)*f(x_i,y_i);%重心矩

end

end

hand_M((ii-1)*5+jj,4)=0;

for x_i=1:x

for y_i=1:y

%下面这部分就是通过阈值提取手部粗图像

for i=1:m

HTML5 手势检测原理和实现

前言随着Hybrid 应用的丰富,HTML5 工程师们已经不满足于把桌面端体验简单移植到移动端,他们觊觎移动原生应用人性化的操作体验,特别是原生应用与生俱来的丰富的手势系统。

HTML5 没有提供开箱即用的手势系统,但是提供了更底层一些的对touch 事件的监听。

基于此,我们可以做出自己的手势库。

手势常用的HTML5 手势可以分为两类,单点手势和两点手势。

单点手势有tap(单击),double tap(双击),long tap(长按),swipe(挥),move(移动)。

两点手势有pinch(缩放),rotate(旋转)。

接下来我们实现一个检测这些手势的javaScript 库,并利用这个手势库做出炫酷的交互效果。

移动关于移动手势检测我们这里不再赘述。

总结一下就是在每次touchmove事件发生时,把两个位移点之间的坐标位置相减,就可以了。

单击(tap)手势检测的关键是用 touchstart,touchmove,touchend 三个事件对手势进行分解。

那么怎么分解单击事件呢?1.在touchstart 发生时进入单击检测,只有一个接触点。

因为单击事件限制为一个手指的动作。

2.没有发生touchmove 事件或者touchmove 在一个很小的范围(如下图)。

限制touchmove 在一个很小范围,是为了给用户一定的冗余空间,因为不能保证用户手指在接触屏幕的时候不发生轻微的位移。

3.touchend 发生在touchstart后的很短时间内(如下图)。

这个时间段的阈值是毫秒级,用来限制手指和屏幕接触的时间。

因为单击事件从开始到结束是很快的。

有了上面的流程,就可以开始实现tap 事件监测了。

双击(double tap)和单击一样,双击事件也需要我们对手势进行量化分解。

1.双击事件是一个手指的行为。

所以在touchstart 时,我们要判断此时屏幕有几个接触点。

2.双击事件中包含两次独立的单击行为。

python手势识别总结

python手势识别总结Python手势识别手势识别是一种利用计算机视觉技术来识别人体手势动作的技术。

而Python作为一种广泛应用于人工智能领域的编程语言,也可以用来进行手势识别的开发和实现。

本文将介绍Python手势识别的原理、应用和相关开发工具,帮助读者了解和掌握这一技术。

一、手势识别的原理手势识别的原理是基于计算机视觉和机器学习的技术。

首先,通过摄像头或深度传感器获取人体手势的图像或数据,然后利用图像处理算法对手势进行分析和提取特征。

最后,通过机器学习算法对提取的特征进行分类和识别,实现对手势的识别和理解。

二、Python手势识别的应用1. 手势控制:通过手势识别技术可以实现手势控制电脑、手机等设备的操作,例如通过手势来控制音乐播放、视频切换等。

2. 手势交互:手势识别可以实现人机交互的方式,例如通过手势来进行游戏操作、图像编辑等。

3. 手势辅助:手势识别可以应用于辅助设备的开发,例如通过手势来控制智能家居、无人机等。

三、Python手势识别的开发工具1. OpenCV:OpenCV是一个开源的计算机视觉库,提供了丰富的图像处理和计算机视觉算法,可以用来实现手势识别的图像处理部分。

2. TensorFlow:TensorFlow是一个开源的机器学习框架,提供了强大的机器学习算法和模型,可以用来实现手势识别的机器学习部分。

3. Mediapipe:Mediapipe是一个开源的多媒体处理框架,提供了丰富的手势识别算法和模型,可以用来快速实现手势识别的开发。

四、Python手势识别的实现步骤1. 数据采集:通过摄像头或深度传感器采集手势图像或数据,并进行预处理,例如裁剪、滤波等。

2. 特征提取:利用图像处理算法对手势图像进行分析和特征提取,例如提取手部轮廓、手指关节点等。

3. 特征分类:通过机器学习算法对提取的特征进行分类和识别,例如使用支持向量机、深度神经网络等算法。

4. 实时识别:将实时采集到的手势图像输入到模型中,实时进行手势识别和动作判断,并进行相应的操作或反馈。

leap motion原理

leap motion原理Leap Motion是一种基于光学技术的手势识别设备,能够实时捕捉和分析手部动作。

它采用先进的图像传感器和红外线摄像头,能够精确地追踪人手的高度和位置,实现对手势的精确识别。

它的原理包括红外线发射器、红外线摄像头、图像处理和手势识别等关键步骤。

红外线发射器是Leap Motion中的一个重要组件,它发射出具有特定频率的红外线。

这些红外线被反射回设备,红外线摄像头通过对反射红外线的探测来确定手的位置和姿势。

由于红外线不可见,因此可以保持无干扰的交互过程。

红外线发射器通常由红外发光二极管(IR LED)构成,它是通过电流在半导体材料中产生光辐射来发射红外线。

红外线摄像头是Leap Motion中另一个重要的组成部分,它能够捕捉到红外线的反射图像。

红外线摄像头通常由具有红外感光能力的图像传感器构成,它能够感应到红外线的能量并将其转换为电信号。

通过红外线摄像头,Leap Motion可以得到手部的三维形状、位置和运动信息。

在图像处理阶段,Leap Motion使用算法对从红外线摄像头中捕捉到的图像进行处理。

首先,通过处理算法将捕捉到的图像转换为灰度图像,并进行去噪处理,以去除干扰和噪声。

然后,使用基于图像特征的方法来提取手部的特征点和轮廓信息。

最后,通过对特征点和轮廓信息的分析,识别出手部的位置、姿势和手势。

Leap Motion利用上述原理实现了对人手的高精度追踪和手势识别。

在应用层面上,它可以用于虚拟现实(VR)交互、游戏控制、手势操作等多种场景。

例如,在虚拟现实应用中,用户可以通过手势操作来选择和操作虚拟场景中的对象;在游戏控制中,用户可以通过手势来进行游戏的控制和操作。

Leap Motion提供了一种直观、自然且高精度的人机交互方式,为用户带来了全新的体验。

总结起来,Leap Motion的原理是通过红外线发射器和红外线摄像头来捕捉和分析手部动作。

红外线发射器发射出特定频率的红外线,红外线摄像头通过对反射红外线的探测来确定手的位置和姿势。

手势识别中np.interp()函数原理

手势识别中np.interp()函数原理np.interp()是Python中的一个NumPy库函数,用于线性插值。

在手势识别中,它可以用来处理传感器数据,以获得更为精确的手势信息。

线性插值是指根据给定的数据点来推测某个未知点的值。

这个未知点通常位于给定点之间的某个位置。

假设有一条直线,已知两个数据点(x1,y1)和(x2,y2),如果想求出把这条线延长后的某一点的值,我们就可以使用线性插值算法来计算。

1. 确定两个数据点的位置2. 求出这两个点之间的斜率3. 根据斜率和传感器的输出值确定手势的位置基本的插值方法有两种:线性插值和多项式插值。

线性插值方法适用于传感器输出的离散数据点,其中假设两个数据点之间的变化量是均匀的。

np.interp()函数实现了线性插值算法。

这个函数原则上可以接受任何一维数据。

它的基本用法是:np.interp(x,xp,fp,left=None,right=None)其中:- x:要插值的值,可以是标量或数组。

- xp:插值的x坐标,必须单调递增。

- fp:插值的y坐标,与xp对应。

- left:如果x < xp[0],返回的值。

- right:如果x > xp[-1],返回的值。

当插值的值x落在xp的两端时,可以通过left和right来指定返回的值。

如果没有指定,则在这些情况下,插值函数将会返回 NaN。

```pythonimport numpy as npimport matplotlib.pyplot as plt# 模拟数据x = np.linspace(0, 10, num=11, endpoint=True)y = np.cos(-x ** 2 / 9.0)# 坐标轴绘制plt.figure(figsize=(6, 4))plt.plot(x, y, 'o')plt.title('Original Data', fontsize=18)这个例子中,我们从模拟数据中提取了11个数据点,这些点处的函数值是cos(-x^2/9)。

hololens手势识别原理

Hololens手势识别原理1.概述Hololens是由微软公司研发的混合现实头盔,它能够将虚拟图像与现实世界相结合,为用户带来全新的交互体验。

Hololens手势识别是其重要的交互方式之一,它能够识别用户的手势并将其转化为相应的操作指令,从而实现用户与虚拟内容的交互。

本文将详细介绍Hololens 手势识别的原理和技术实现。

2.深度摄像头Hololens头盔内置了多个深度摄像头,它们能够实时捕捉用户的手部动作,并通过计算和分析实现手势的识别。

这些深度摄像头能够获取关于手部位置、形状和动作的三维信息,为后续的手势识别和跟踪奠定了基础。

3.骨骼跟踪Hololens使用骨骼跟踪技术实现对用户手部动作的识别。

在捕捉到手部图像后,系统会通过计算和分析确定手指、手掌等骨骼的位置和运动轨迹,从而实现对手势的实时跟踪。

这一技术能够有效地将用户的手势转化为数字化的信息,为后续的交互操作提供了可靠的基础。

4.手势识别算法Hololens手势识别采用了一系列先进的图像处理和模式识别算法,例如机器学习、深度神经网络等。

这些算法能够对深度摄像头捕获到的图像进行高效的处理和分析,从而实现对用户手势的快速、准确的识别。

而且,Hololens还可以根据不同的应用场景和用户需求,动态调整手势识别算法的参数和模型,以提高识别的准确性和稳定性。

5.手势指令映射一旦用户的手势被成功识别,Hololens将会根据预先设定的映射规则将手势转化为相应的操作指令。

这些操作指令可以包括平移、旋转、缩放、点击等,从而实现对虚拟场景中的对象进行操控和交互。

Hololens还支持用户自定义手势映射,使用户可以根据自己的习惯和需求进行个性化操作设置。

6.应用场景Hololens手势识别技术的应用场景非常广泛,它可以用于虚拟现实游戏、工业设计、教育培训、医疗卫生等多个领域。

通过手势识别,用户可以轻松地操控虚拟对象、与虚拟人物进行互动、进行实时的三维建模等,极大地拓展了混合现实技术的应用领域。

Android手势识别类(二)GestureDetector源码浅析

Android⼿势识别类(⼆)GestureDetector源码浅析前⾔:Android 关于⼿势的操作提供两种形式:⼀种是针对⽤户⼿指在屏幕上划出的动作⽽进⾏移动的检测,这些⼿势的检测通过android提供的监听器来实现;另⼀种是⽤户⼿指在屏幕上滑动⽽形成⼀定的不规则的⼏何图形(即为多个持续触摸事件在屏幕形成特定的形状);本⽂主要是针对第⼆种⼿势的绘制原理进⾏浅析,我们姑且称它为输⼊法⼿势;⼀. 输⼊法⼿势在Android源码中,⾕歌提供了相关的⼿势库源码,供给开发者丰富多彩的接⼝调⽤实现;这些提供相关接⼝的类所在的源码路径为frameworks/base/core/java/android/gesture;如下图gesture⽂件中的相关类:绘制⼿势需要⼀个视图界⾯平台,⽽这个视图界⾯平台由GestureOverlayView这个类来实现,该类继承FrameLayout容器视图类。

所以,当我们在⼿机屏幕上画⼿势时,GestureOverlayView主要负责显⽰和处理⼿指在屏幕上滑动所形成的⼿势。

以下举⼀个简单的Demo来说明如何通过GestureOverlayView实现在屏幕上绘制⼿势;1). main.xml⽂件代码如下:[html]1. <?xml version="1.0" encoding="utf-8"?>2. <LinearLayout xmlns:android="/apk/res/android"3. android:layout_width="fill_parent"4. android:layout_height="fill_parent"5. android:orientation="vertical" >6.7. <android.gesture.GestureOverlayView8. android:id="@+id/gesture"9. android:layout_width="fill_parent"10. android:layout_height="fill_parent"11. >12. </android.gesture.GestureOverlayView>13.14. </LinearLayout>很简单,添加⼀个android.gesture.GestureOverlayView的布局组件;2). 加载布局⽂件和实现⼿势绘制的Actitivty代码如下:[java]1. package com.stevenhu.hu.dgt;2.3. import android.app.Activity;4. import android.gesture.Gesture;5. import android.gesture.GestureOverlayView;6. import android.gesture.GestureOverlayView.OnGesturePerformedListener;7. import android.gesture.GestureOverlayView.OnGesturingListener;8. import android.os.Bundle;9. import android.widget.Toast;10.11. public class DrawGestureTest extends Activity implements OnGesturePerformedListener, OnGesturingListener12. {13.14. private GestureOverlayView mDrawGestureView;15. /** Called when the activity is first created. */16. @Override17. public void onCreate(Bundle savedInstanceState)18. {19. super.onCreate(savedInstanceState);20. setContentView(yout.main);21.22. mDrawGestureView = (GestureOverlayView)findViewById(R.id.gesture);23.24. //设置⼿势可多笔画绘制,默认情况为单笔画绘制25. mDrawGestureView.setGestureStrokeType(GestureOverlayView.GESTURE_STROKE_TYPE_MULTIPLE);26. //设置⼿势的颜⾊(蓝⾊)27. mDrawGestureView.setGestureColor(gestureColor(R.color.gestureColor));28. //设置还没未能形成⼿势绘制是的颜⾊(红⾊)29. mDrawGestureView.setUncertainGestureColor(gestureColor(R.color.ungestureColor));30. //设置⼿势的粗细31. mDrawGestureView.setGestureStrokeWidth(4);32. /*⼿势绘制完成后淡出屏幕的时间间隔,即绘制完⼿指离开屏幕后相隔多长时间⼿势从屏幕上消失;33. * 可以理解为⼿势绘制完成⼿指离开屏幕后到调⽤onGesturePerformed的时间间隔34. * 默认值为420毫秒,这⾥设置为2秒35. */36. mDrawGestureView.setFadeOffset(2000);37.38. //绑定监听器39. mDrawGestureView.addOnGesturePerformedListener(this);40. mDrawGestureView.addOnGesturingListener(this);41. }42.43. //⼿势绘制完成时调⽤44. @Override45. public void onGesturePerformed(GestureOverlayView overlay, Gesture gesture)46. {47. // TODO Auto-generated method stub48. showMessage("⼿势绘制完成");49. }50.51. private int gestureColor(int resId)52. {53. return getResources().getColor(resId);54. }55.56. private void showMessage(String s)57. {58. Toast.makeText(this, s, Toast.LENGTH_SHORT).show();59. }60.61. //结束正在绘制⼿势时调⽤(⼿势绘制完成时⼀般是先调⽤它在调⽤onGesturePerformed)62. @Override63. public void onGesturingEnded(GestureOverlayView overlay)64. {65. // TODO Auto-generated method stub66. showMessage("结束正在绘制⼿势");67. }68.69. //正在绘制⼿势时调⽤70. @Override71. public void onGesturingStarted(GestureOverlayView overlay)72. {73. // TODO Auto-generated method stub74. showMessage("正在绘制⼿势");75. }76.77. @Override78. protected void onDestroy()79. {80. // TODO Auto-generated method stub81. super.onDestroy();82. //移除绑定的监听器83. mDrawGestureView.removeOnGesturePerformedListener(this);84. mDrawGestureView.removeOnGesturingListener(this);85. }86.87. }⼆. GestureOverlayView类浅析其实⼿势的绘制原理和前篇中绘制轨迹线的原理差不多,只不过在GestureOverlayView中的处理相对⽐较复杂;GestureOverlayView继承FrameLayout,所以它也是ViewGroup类型(继承 View),GestureOverlayView重写View的dispatchTouchEvent⽅法。

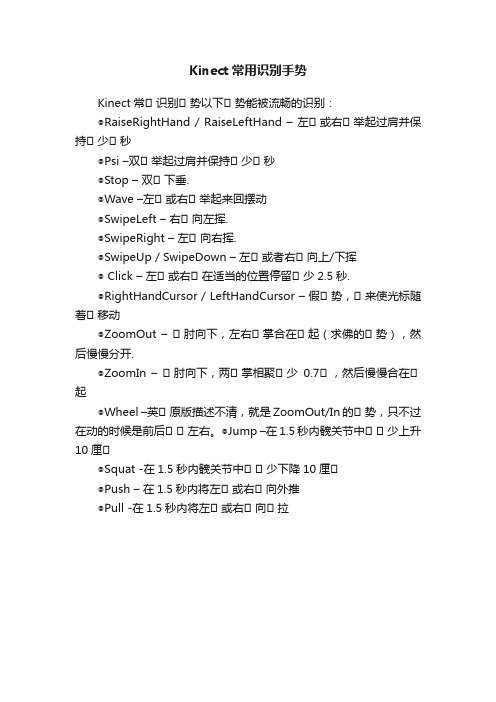

Kinect常用识别手势

Kinect常用识别手势

Kinect常⽤识别⽤势以下⽤势能被流畅的识别:

◎RaiseRightHand / RaiseLeftHand –左⽤或右⽤举起过肩并保持⽤少⽤秒

◎Psi –双⽤举起过肩并保持⽤少⽤秒

◎Stop –双⽤下垂.

◎Wave –左⽤或右⽤举起来回摆动

◎SwipeLeft –右⽤向左挥.

◎SwipeRight –左⽤向右挥.

◎SwipeUp / SwipeDown –左⽤或者右⽤向上/下挥

◎ Click –左⽤或右⽤在适当的位置停留⽤少2.5秒.

◎RightHandCursor / LeftHandCursor –假⽤势,⽤来使光标随着⽤移动

◎ZoomOut –⽤肘向下,左右⽤掌合在⽤起(求佛的⽤势),然后慢慢分开.

◎ZoomIn –⽤肘向下,两⽤掌相聚⽤少0.7⽤,然后慢慢合在⽤起

◎Wheel –英⽤原版描述不清,就是ZoomOut/In的⽤势,只不过在动的时候是前后⽤⽤左右。

◎Jump –在1.5秒内髋关节中⽤⽤少上升10厘⽤

◎Squat -在1.5秒内髋关节中⽤⽤少下降10厘⽤

◎Push –在1.5秒内将左⽤或右⽤向外推

◎Pull -在1.5秒内将左⽤或右⽤向⽤拉。

手势控制原理

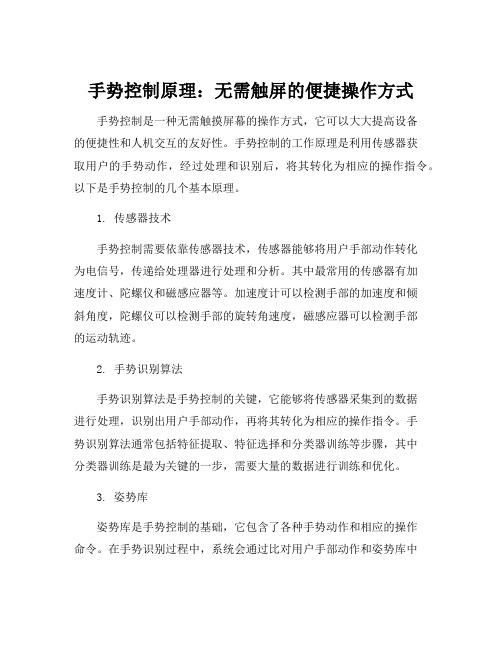

手势控制原理:无需触屏的便捷操作方式

手势控制是一种无需触摸屏幕的操作方式,它可以大大提高设备

的便捷性和人机交互的友好性。

手势控制的工作原理是利用传感器获

取用户的手势动作,经过处理和识别后,将其转化为相应的操作指令。

以下是手势控制的几个基本原理。

1. 传感器技术

手势控制需要依靠传感器技术,传感器能够将用户手部动作转化

为电信号,传递给处理器进行处理和分析。

其中最常用的传感器有加

速度计、陀螺仪和磁感应器等。

加速度计可以检测手部的加速度和倾

斜角度,陀螺仪可以检测手部的旋转角速度,磁感应器可以检测手部

的运动轨迹。

2. 手势识别算法

手势识别算法是手势控制的关键,它能够将传感器采集到的数据

进行处理,识别出用户手部动作,再将其转化为相应的操作指令。

手

势识别算法通常包括特征提取、特征选择和分类器训练等步骤,其中

分类器训练是最为关键的一步,需要大量的数据进行训练和优化。

3. 姿势库

姿势库是手势控制的基础,它包含了各种手势动作和相应的操作

命令。

在手势识别过程中,系统会通过比对用户手部动作和姿势库中

的手势动作,来判断用户所需要执行的命令。

因此,姿势库的设计和更新也是手势控制中非常重要的一环。

手势控制已经广泛应用于智能手机、智能手表、电视等设备中,它可以使用户通过手势轻松地完成打电话、切换频道、播放音乐等操作,无需触摸屏幕,更加便捷和人性化。

随着技术的发展,手势控制也将不断地优化和升级,成为未来设备操作中更为重要的一部分。

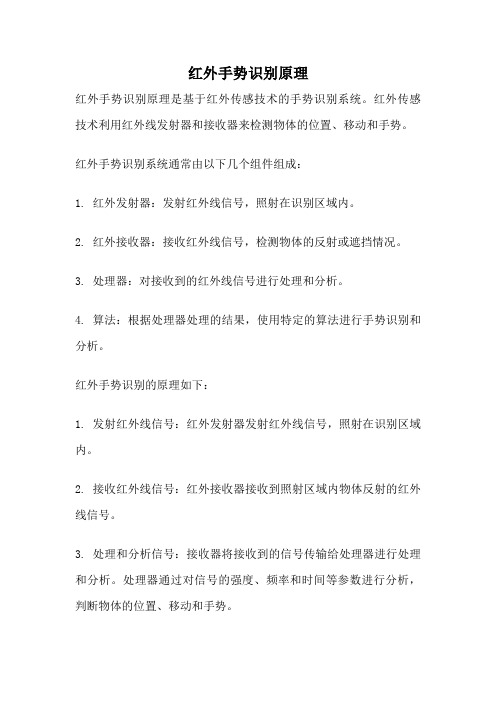

红外手势识别原理

红外手势识别原理

红外手势识别原理是基于红外传感技术的手势识别系统。

红外传感技术利用红外线发射器和接收器来检测物体的位置、移动和手势。

红外手势识别系统通常由以下几个组件组成:

1. 红外发射器:发射红外线信号,照射在识别区域内。

2. 红外接收器:接收红外线信号,检测物体的反射或遮挡情况。

3. 处理器:对接收到的红外线信号进行处理和分析。

4. 算法:根据处理器处理的结果,使用特定的算法进行手势识别和分析。

红外手势识别的原理如下:

1. 发射红外线信号:红外发射器发射红外线信号,照射在识别区域内。

2. 接收红外线信号:红外接收器接收到照射区域内物体反射的红外线信号。

3. 处理和分析信号:接收器将接收到的信号传输给处理器进行处理和分析。

处理器通过对信号的强度、频率和时间等参数进行分析,判断物体的位置、移动和手势。

4. 手势识别和分析:根据处理器处理的结果,使用特定的算法进行手势识别和分析。

算法可以根据不同的手势模式和动作规律,识别出手势的类型和意图。

红外手势识别原理的优势在于可以实现非接触式的手势识别,无需触摸屏或其他传感器,具有较高的灵敏度和精确度。

同时,红外手势识别技术也可以应用于各种领域,如智能家居、智能手机、虚拟现实等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

void displayCallback(IplImage* img, hvAction action)

{

if (sync_display) {

cvCopy(img, display_image);

} else {

showFrame(img, action);

}

}

int main( int argc, char** argv )

* recognition.

* Copyright (C) 2004 Mathias Kolsch, matz@

*

* This program is free software; you can redistribute it and/or

* modify it under the terms of the GNU General Public License

}

/* 设置鼠标事件的回调参数 */

cvSetMouseCallback( "HandVu", OnMouse );

/* 设置窗口 */

int success = cvNamedWindow( "HandVu", 1 );

if (success!=1) {

printf("can't open window - did you compile OpenCV with highgui support?");

#include <cv.h>

#include <highgui.h>

#include <ctype.h>

#include <time.h>

#include "HandVu.h"

IplImage *capture_image = 0;

IplImage *display_image = 0;

if( argc == 2 || argc == 3) {

int num = 0;

if (argc==3) {

num = atoi(argv[2]);

}

capture = cvCaptureFromCAM( num );

if (!capture) {

capture = cvCaptureFromAVI( argv[2] );

return -1;

}

string conductor_fname(argv[1]);//声明配置参数的对象

printf("will load conductor from file:\n%s\n", conductor_fname.c_str());//屏显提示

/*是否设定特定的摄像头,并初始化摄像头 */

}

}

if( !capture )

{

fprintf(stderr,"Could not initialize capturing through OpenCV.\n");

return -1;

}

/* 屏显提示 */

printf( "Hot keys: \n"

"\tESC - quit the program\n"

// processing on it - keep going

// printf("HandVuFilter: supposed to skip frame\n");

} else if (action==HV_PROCESS_FRAME) {

// full processing was done and is recommended for following steps;

hvInitialize(size.width, size.height);//初始化要分析的图像大小

hvLoadConductor(conductor_fname);//装载参数

hvStartRecognition();//开始识别

hvSetOverlayLevel(2);//设置识别的覆盖区级别

*

* You should have received a copy of the GNU General Public License

* along with this program; if not, write to the Free Software

* Foundation, Inc., 59 Temple Place - Suite 330,

// printf("HandVuFilter: dropping frame\n");

return;

} else if (action==HV_SKIP_FRAME) {

// HandVu recommends displaying the frame, but not doing any further

sel_area_top = MAX( sel_area_top, 0 );

sel_area_right = MIN( sel_area_right, capture_image->width );

sel_area_bottom = MIN( sel_area_bottom, capture_image->height );

if ( !capture_image ) {

fprintf(stderr,"Could not retrieve image through OpenCV.\n");

return -1;

}

/* allocate all the buffers */

CvSize size = cvGetSize(capture_image);

图像处理,

目标识别,

目标跟踪,

模式识别

OpenCV学习——利用HandVu进行手部动作识别分析(转)

2011-04-06 17:29:26| 分类: 默认分类 | 标签:opencv 手部识别 |举报|字号 订阅

/**

* HandVu - a library for computer vision-based hand gesture

{

if( !capture_image )

return;

if( capture_image->origin )

y = capture_image->height - y;

if( select_object )

{

sel_area_left = MIN(x,origin.x);

sel_area_top = MIN(y,origin.y);

* as published by the Free Software Foundation; either version 2

* of the License, or (at your option) any later version.

*

* This program is distributed in the hope that it will be useful,

}

switch( event )

{

case CV_EVENT_LBUTTONDOWN:

origin = cvPoint(x,y);

sel_area_left = sel_area_right = x;

sel_area_top = sel_area_bottom = y;

select_object = 1;

/* 设置同步/异步识别 */

if (async_processing) {

hvAsyncSetup(num_async_bufs, displayCallback);

if (sync_display) display_image = cvCloneImage(capture_image);

int select_object = 0;

int sel_area_left=0, sel_area_top=0, sel_area_right=0, sel_area_bottom=0;

bool correct_distortion = false;

void OnMouse( int event, int x, int y, int /*flags*/, void* /*params*/ )

sel_area_right = sel_area_left + CV_IABS(x - origin.x);

sel_area_bottom = sel_area_top + CV_IABS(y - origin.y);

sel_area_left = MAX( sel_area_left, 0 );

break;

case CV_EVENT_LBUTTONUP:

select_object = 0;

break;

}

}

void showFrame(IplImage* img, hvAction action)

{

if (action==HV_DROP_FRAME) {

// HandVu recommends dropping the frame entirely

if( sel_area_right-sel_area_left > 0 && sel_area_ttom-sel_area_top> 0 )