Linux负载均衡的设置步骤

负载均衡_应用实验报告

一、实验背景随着互联网的快速发展,网站和应用程序的用户量急剧增加,对服务器性能和可靠性的要求也越来越高。

负载均衡技术作为一种有效的资源分配策略,能够将用户请求分配到多个服务器上,从而提高系统的处理能力和响应速度。

本实验旨在通过搭建负载均衡环境,验证不同负载均衡策略对系统性能的影响,并分析其适用场景。

二、实验环境1. 操作系统:Linux CentOS 7.42. 服务器:2台物理服务器(Intel Xeon CPU E5-2680 v3,16GB内存)3. 负载均衡器:Nginx4. 被均衡服务器:Tomcat 8.55. 实验工具:Apache JMeter三、实验目的1. 熟悉负载均衡器的配置和操作。

2. 掌握常见的负载均衡策略,如轮询、加权轮询、最少活跃调用等。

3. 分析不同负载均衡策略对系统性能的影响。

4. 评估负载均衡技术在实际应用中的适用性。

四、实验步骤1. 配置负载均衡器(1)安装Nginx:```yum install nginx```(2)配置Nginx负载均衡:```server {listen 80;server_name localhost;location / {proxy_pass http://backend; include proxy_params;}}upstream backend {server server1:80;server server2:80;# 添加加权轮询策略server server1:80 weight=2;server server2:80 weight=1;}```2. 部署被均衡服务器(1)安装Tomcat 8.5:```yum install tomcat8```(2)配置Tomcat:```cat >> /usr/local/tomcat8/conf/server.xml << EOF<Connector port="8080" protocol="HTTP/1.1"connectionTimeout="20000"redirectPort="8443" />EOF```3. 运行Apache JMeter进行压力测试(1)创建测试计划:- 选择“线程组”作为测试计划- 设置线程数和循环次数- 选择“HTTP请求”作为请求类型- 设置请求的URL为“http://localhost/”(2)启动JMeter,观察结果五、实验结果与分析1. 轮询策略在轮询策略下,两个服务器接收到的请求数量基本相同。

负载均衡配置方法

负载均衡配置方法在现代的计算机系统中,负载均衡是保证高性能和可靠性的重要因素之一。

通过合理的负载均衡配置,可以最大程度地利用系统资源,提高系统响应速度和可扩展性。

本文将介绍一些常见的负载均衡配置方法,帮助您更好地理解和应用负载均衡技术。

一、负载均衡概述负载均衡是一种通过在多个服务器之间分配工作负载,以达到提高系统性能和可用性的技术。

它可以确保每台服务器都能够平均分担任务,避免单个服务器过载,从而提高系统的整体性能。

二、硬件负载均衡配置方法硬件负载均衡通常通过专门的硬件设备来实现,如负载均衡器。

以下是一些常用的硬件负载均衡配置方法:1. 服务器冗余:在配置硬件负载均衡之前,建议先将系统中的服务器设置为冗余模式。

这意味着将每个功能模块配置为备份模式,以确保在故障发生时可以无缝切换到备份服务器。

2. 负载均衡器选择:根据实际需求选择适当的负载均衡器。

常见的负载均衡器有硬件负载均衡器和软件负载均衡器。

硬件负载均衡器通常具有更高的性能和可靠性,但价格较高。

软件负载均衡器则更加灵活和经济实惠。

3. 负载均衡算法选择:负载均衡器通常使用一些算法来决定如何将任务分配给服务器。

常见的算法有轮询、最小连接和最少响应时间等。

根据应用场景的特点选择合适的负载均衡算法,以确保任务能够平均分配给服务器,并提高整体性能。

4. 健康检查和故障恢复:负载均衡器通常会周期性地检查服务器的健康状态,以便及时发现故障和性能问题。

一旦发现故障,负载均衡器将自动将任务重新分配给其他正常工作的服务器,并通过故障恢复机制尽快恢复故障服务器的功能。

三、软件负载均衡配置方法除了硬件负载均衡器,还可以使用软件来实现负载均衡。

以下是一些常用的软件负载均衡配置方法:1. 反向代理:通过将负载均衡器配置为反向代理服务器,可以将客户端的请求分发给多个后端服务器。

反向代理服务器可以根据不同的策略选择请求目标服务器,并将响应返回给客户端。

2. DNS负载均衡:通过在DNS服务器中配置多个IP地址,可以将客户端的请求平均分配给这些IP地址,并最终分发到不同的服务器。

服务器负载均衡方案

服务器负载均衡方案第1篇服务器负载均衡方案一、背景随着互联网的迅速发展,业务量不断攀升,服务器承受的压力越来越大。

为保障业务连续性和用户体验,提高服务器资源利用率,降低单点故障风险,有必要引入服务器负载均衡技术。

本方案旨在制定一套合法合规的服务器负载均衡方案,确保业务稳定、高效运行。

二、目标1. 提高服务器资源利用率,降低硬件投资成本。

2. 确保业务连续性,提高系统可用性。

3. 提升用户体验,降低访问延迟。

4. 合法合规,确保数据安全。

三、方案设计1. 负载均衡器选型根据业务需求,选择合适的负载均衡器。

本方案推荐使用硬件负载均衡器,如F5、深信服等品牌。

硬件负载均衡器具有高性能、高可靠性、易于管理等优点,适用于大型企业及重要业务场景。

2. 负载均衡策略(1)轮询(Round Robin)将客户端请求按顺序分配到后端服务器,适用于服务器性能相近的场景。

(2)最小连接数(Least Connections)将客户端请求分配给当前连接数最少的服务器,适用于服务器性能不均的场景。

(3)源地址哈希(Source Hash)根据客户端IP地址进行哈希计算,将请求分配到固定的服务器,适用于有状态业务场景。

(4)权重(Weight)为每台服务器分配不同的权重,根据权重比例分配请求,适用于服务器性能差异较大的场景。

3. 健康检查负载均衡器定期对后端服务器进行健康检查,确保服务器正常运行。

检查方式包括:TCP连接、HTTP请求等。

当检测到服务器故障时,自动将其从负载均衡列表中剔除,待服务器恢复正常后,重新加入负载均衡列表。

4. 会话保持为保持用户会话状态,负载均衡器支持会话保持功能。

可根据业务需求选择以下方式:(1)源地址保持:根据客户端IP地址保持会话。

(2)Cookie保持:根据客户端Cookie信息保持会话。

5. 安全防护(1)负载均衡器支持SSL加密,确保数据传输安全。

(2)负载均衡器支持防火墙功能,对非法请求进行过滤,防止恶意攻击。

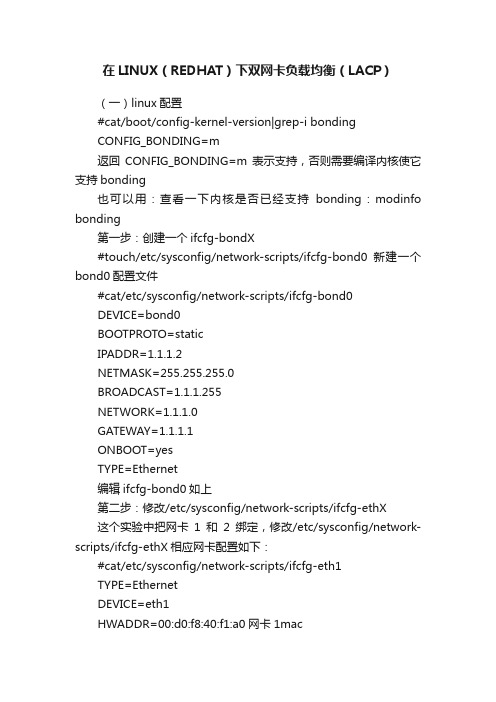

在LINUX(REDHAT)下双网卡负载均衡(LACP)

在LINUX(REDHAT)下双网卡负载均衡(LACP)(一)linux配置#cat/boot/config-kernel-version|grep-i bondingCONFIG_BONDING=m返回CONFIG_BONDING=m表示支持,否则需要编译内核使它支持bonding也可以用:查看一下内核是否已经支持bonding:modinfo bonding第一步:创建一个ifcfg-bondX#touch/etc/sysconfig/network-scripts/ifcfg-bond0新建一个bond0配置文件#cat/etc/sysconfig/network-scripts/ifcfg-bond0DEVICE=bond0BOOTPROTO=staticIPADDR=1.1.1.2NETMASK=255.255.255.0BROADCAST=1.1.1.255NETWORK=1.1.1.0GATEWAY=1.1.1.1ONBOOT=yesTYPE=Ethernet编辑ifcfg-bond0如上第二步:修改/etc/sysconfig/network-scripts/ifcfg-ethX这个实验中把网卡1和2绑定,修改/etc/sysconfig/network-scripts/ifcfg-ethX相应网卡配置如下:#cat/etc/sysconfig/network-scripts/ifcfg-eth1TYPE=EthernetDEVICE=eth1HWADDR=00:d0:f8:40:f1:a0网卡1macBOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0SLAVE=yes#cat/etc/sysconfig/network-scripts/ifcfg-eth2TYPE=EthernetDEVICE=eth2HWADDR=00:d0:f8:00:0c:0c网卡2macBOOTPROTO=noneONBOOT=yesUSERCTL=noMASTER=bond0SLAVE=yes第三步:配置/etc/modprobe.conf,添加alias bond0bonding #cat/etc/modprobe.confalias eth0e100alias snd-card-0snd-intel8x0options snd-card-0index=0options snd-intel8x0index=0remove snd-intel8x0{/usr/sbin/alsactl store0>/dev/null2>&1||:;};/sbin/modprobe-r --ignore-remove snd-intel8x0alias eth18139toooptions3c501irq=3alias eth2tulip上面是三网卡本身的配置如果要绑定和做lacp只要再加上下面两条配置alias bond0bonding绑定options bond0miimon=100mode=4mode=4是lacp第四步:配置/etc/rc.d/rc.local,添加需要绑定的网卡#cat/etc/rc.d/rc.localtouch/var/lock/subsys/local配置本身就有这条命令ifenslave bond0eth1eth2这条命令是添加需要绑定的网卡1和2 到这里就完成bonding的配置了可以查看一下第五步:重启网络服务和重启pc#service network restart重启网络服务#shutdown-r now重启pc重启后可以查看bonding情况:网卡1和2都绑定上了,模式为802.3ad#cat/proc/net/bonding/bond0Ethernet Channel Bonding Driver:v3.0.3(March23,2006)Bonding Mode:IEEE802.3ad Dynamic link aggregationTransmit Hash Policy:layer2(0)MII Status:upMII Polling Interval(ms):100Up Delay(ms):0Down Delay(ms):0802.3ad infoLACP rate:slowActive Aggregator Info:Aggregator ID:1Number of ports:2Actor Key:9Partner Key:1Partner Mac Address:00:d0:f8:22:33:baSlave Interface:eth1MII Status:upLink Failure Count:0Permanent HW addr:00:d0:f8:40:f1:a0Aggregator ID:1Slave Interface:eth2MII Status:upLink Failure Count:0Permanent HW addr:00:d0:f8:00:0c:0cAggregator ID:1接口配置信息:新增了bond0的配置信息,接口bond0和eth1,eth2,绑定后三个接口使用的mac都是同一个:00:D0:F8:40:F1:A0 #ifconfigbond0Link encap:Ethernet HWaddr00:D0:F8:40:F1:A0inet addr:1.1.1.2Bcast:1.1.1.255Mask:255.255.255.0inet6addr:fe80::2d0:f8ff:fe40:f1a0/64Scope:LinkUP BROADCAST RUNNING MASTER MULTICAST MTU:1500Metric:1RX packets:128errors:0dropped:0overruns:0frame:0TX packets:259errors:0dropped:0overruns:0carrier:0collisions:0txqueuelen:0RX bytes:15466(15.1KiB)TX bytes:39679(38.7KiB)eth0Link encap:Ethernet HWaddr00:11:11:EB:71:E2inetaddr:192.168.180.8Bcast:192.168.180.15Mask:255.255.255.240 inet6addr:fe80::211:11ff:feeb:71e2/64Scope:LinkUP BROADCAST RUNNING MULTICAST MTU:1500Metric:1 RX packets:311errors:0dropped:0overruns:0frame:0TX packets:228errors:0dropped:0overruns:0carrier:0collisions:0txqueuelen:1000RX bytes:30565(29.8KiB)TX bytes:35958(35.1KiB)eth1Link encap:Ethernet HWaddr00:D0:F8:40:F1:A0inet6addr:fe80::2d0:f8ff:fe40:f1a0/64Scope:LinkUP BROADCAST RUNNING SLAVE MULTICASTMTU:1500Metric:1RX packets:54errors:0dropped:0overruns:0frame:0TX packets:97errors:0dropped:0overruns:0carrier:0collisions:0txqueuelen:1000RX bytes:6696(6.5KiB)TX bytes:13821(13.4KiB)Interrupt:209Base address:0x2e00eth2Link encap:Ethernet HWaddr00:D0:F8:40:F1:A0inet6addr:fe80::2d0:f8ff:fe40:f1a0/64Scope:LinkUP BROADCAST RUNNING SLAVE MULTICAST MTU:1500Metric:1RX packets:74errors:0dropped:0overruns:0frame:0TX packets:162errors:0dropped:0overruns:0carrier:0collisions:0txqueuelen:1000RX bytes:8770(8.5KiB)TX bytes:25858(25.2KiB)Interrupt:201Base address:0x2f00lo Link encap:Local Loopbackinet addr:127.0.0.1Mask:255.0.0.0inet6addr:::1/128Scope:HostUP LOOPBACK RUNNING MTU:16436Metric:1RX packets:6283errors:0dropped:0overruns:0frame:0TX packets:6283errors:0dropped:0overruns:0carrier:0collisions:0txqueuelen:0RX bytes:9783674(9.3MiB)TX bytes:9783674(9.3MiB)(二)锐捷交换机配置:lacp system-priority100全局配置lacp优先级interface GigabitEthernet0/23no switchportlacp port-priority100接口的lacp优先级port-group1mode active接口下开启lacp主动模式interface GigabitEthernet0/24no switchportlacp port-priority100port-group1mode activeinterface AggregatePort1no switchportno ip proxy-arpip address1.1.1.1255.255.255.0和linux成功建立lacp后状态信息如下:Show lacp summarySystem Id:100,00d0.f822.33baFlags:S-Device is requesting Slow LACPDUs F-Device is requesting Fast LACPDUs. A-Device is in active mode.P-Device is in passive mode.Aggregate port1:Local information:LACP port Oper Port Port Port Flags State Priority Key Number State----------------------------------------------------------------------Gi0/23SA bndl1000x10x170x3dGi0/24SA bndl1000x10x180x3d Partner information:LACP port Oper Port Port Port Flags Priority Dev ID Key Number State---------------------------------------------------------------------Gi0/23SA25500d0.f840.f1a00x90x20x3dGi0/24SA25500d0.f840.f1a00x90x10x3d State表示状态信息:bndl表示lacp建立成功,sup表示不成功。

linux 负载load正常范围

linux 负载load正常范围(最新版)目录1.引言:介绍 Linux 负载的概念2.Linux 负载的正常范围3.监控 Linux 负载的方法4.如何调整 Linux 负载5.结论:总结 Linux 负载的重要性和合理调整负载的意义正文【引言】在 Linux 操作系统中,负载(load)是一个重要的性能指标,用于衡量系统当前的工作负载情况。

一个稳定且合理的负载范围可以保证系统的正常运行和性能。

本文将为您介绍 Linux 负载的概念,以及如何监控和调整负载,使其保持在正常范围内。

【Linux 负载的正常范围】Linux 负载的正常范围通常在 1.0 至 5.0 之间。

当负载值在这个范围内时,表示系统资源利用率较为均衡,系统性能较为稳定。

然而,这并不意味着负载值越低越好。

实际上,一个适当的负载值可以提高系统资源的利用率,从而提高整体性能。

【监控 Linux 负载的方法】要监控 Linux 负载,可以使用以下命令:1.`top`:这是一个实时显示系统状态的命令行工具,可以查看实时的负载情况。

2.`ps`:通过查看进程状态,可以了解当前系统中运行的进程数量和负载分布。

3.`vmstat`:这是一个虚拟内存状态命令,可以查看系统的虚拟内存状态、CPU 使用状况、磁盘 I/O 等信息,从而了解系统的负载状况。

【如何调整 Linux 负载】如果发现 Linux 负载过高,可以采取以下措施进行调整:1.优化进程调度:通过调整进程的优先级,可以影响进程的执行顺序,从而改变系统的负载分布。

2.合理分配资源:对于多用户共享的系统,可以根据用户的需求和权限,合理分配系统资源,降低不必要的负载。

3.减少不必要的进程:通过杀死或暂停暂时不需要的进程,可以降低系统的负载。

4.升级硬件或优化软件:提高硬件配置或优化软件性能,可以提高系统的处理能力,降低负载。

【结论】Linux 负载是衡量系统性能的重要指标,合理的负载范围可以保证系统的稳定运行。

三层交换机负载均衡配置方法

三层交换机负载均衡配置方法三层交换机负载均衡配置方法下面是负载均衡在三层交换机上的配置的全过程,按照以下的步骤,相信你一定可以成功完成整个配置步骤。

三层交换机配置——配置一组二层端口configure terminal 进入配置状态nterface range {port-range} 进入组配置状态三层交换机配置——配置三层端口configure terminal 进入配置状态interface {{fastethernet | gigabitethernet} interface-id} | {vlan vlan-id} | {port-channel port-channel-number} 进入端口配置状态no switchport 把物理端口变成三层口ip address ip_address subnet_mask 配置IP地址和掩码no shutdown 激活端口例:Switch(config)# interface gigabitethernet0/2Switch(config-if)# no switchportSwitch(config-if)# ip address 192.20.135.21 255.255.255.0Switch(config-if)# no shutdown三层交换机配置——配置VLANconfigure terminal 进入配置状态vlan vlan-id 输入一个VLAN号, 然后进入vlan配态,可以输入一个新的VLAN号或旧的来进行修改name vlan-name 可选)输入一个VLAN名,如果没有配置VLAN 名,缺省的名字是VLAN号前面用0填满的4位数,如VLAN0004是VLAN4的缺省名字mtu mtu-size (可选) 改变MTU大小例:Switch# configure terminalSwitch(config)# vlan 20Switch(config-vlan)# name test20Switch(config-vlan)# end或Switch# vlan databaseSwitch(vlan)# vlan 20 name test20Switch(vlan)# exit三层交换机配置——端口分配给一个VLANconfigure terminal 进入配置状态interface interface-id 进入要分配的端口switchport mode access 定义二层口switchport access vlan vlan-id 把端口分配给某一VLAN例:Switch# configure terminalEnter configuration commands, one per line. End with CNTL/Z.Switch(config)# interface fastethernet0/1Switch(config-if)# switchport mode accessSwitch(config-if)# switchport access vlan 2Switch(config-if)# endSwitch#配置VLAN trunkconfigure terminal 进入配置状态interface interface-Id 进入端口配置状态switchport trunk encapsulation {isl | dot1q | negotiate}配置trunk封装ISL 或 802.1Q 或三层交换机配置——自动协商例:switchport mode {dynamic {auto | desirable} | trunk} 配置二层trunk模式。

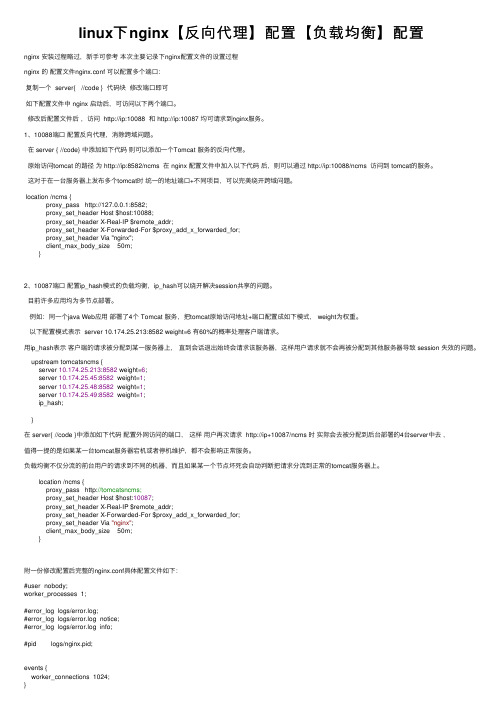

linux下nginx【反向代理】配置【负载均衡】配置

linux下nginx【反向代理】配置【负载均衡】配置nginx 安装过程略过,新⼿可参考本次主要记录下nginx配置⽂件的设置过程nginx 的配置⽂件nginx.conf 可以配置多个端⼝:复制⼀个 server{ //code } 代码块修改端⼝即可如下配置⽂件中 nginx 启动后,可访问以下两个端⼝。

修改后配置⽂件后,访问 http://ip:10088 和 http://ip:10087 均可请求到nginx服务。

1、10088端⼝配置反向代理,消除跨域问题。

在 server { //code} 中添加如下代码则可以添加⼀个Tomcat 服务的反向代理。

原始访问tomcat 的路径为 http://ip:8582/ncms 在 nginx 配置⽂件中加⼊以下代码后,则可以通过 http://ip:10088/ncms 访问到 tomcat的服务。

这对于在⼀台服务器上发布多个tomcat时统⼀的地址端⼝+不同项⽬,可以完美绕开跨域问题。

location /ncms {proxy_pass http://127.0.0.1:8582;proxy_set_header Host $host:10088;proxy_set_header X-Real-IP $remote_addr;proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;proxy_set_header Via "nginx";client_max_body_size 50m;}2、10087端⼝配置ip_hash模式的负载均衡,ip_hash可以绕开解决session共享的问题。

⽬前许多应⽤均为多节点部署。

例如:同⼀个java Web应⽤部署了4个 Tomcat 服务,把tomcat原始访问地址+端⼝配置成如下模式, weight为权重。

以下配置模式表⽰ server 10.174.25.213:8582 weight=6 有60%的概率处理客户端请求。

Linux1 DNS服务器 配置DNS负载均衡功能

Linux1 DNS服务器配置DNS负载均衡功能随着网络的规模越来越大,用户数量急剧增加,网络服务器的负担也变得越来越重,一台服务器要同时应付成千上万用户的并发访问,必然会导致服务器过度繁忙,响应时间过长的结果。

为了解决这个问题,可以在DNS服务器上配置负载均衡功能,DNS负载均衡是在DNS服务器中为同一个域名配置多个IP地址(为一个主机名设置多条A资源记录),在应答DNS查询时,DNS服务器对每个查询将以DNS文件中主机记录的IP地址按顺序返回不同的解析结果,将客户端的访问引导到不同的计算机上去,从而达到负载均衡的目的。

下面是一个实现邮件服务器负载均衡的配置片段(在区域数据文件中),如图6-45所示。

图6-45 负载均衡在以上配置中,mail、mail1和mail2均是“.”域中的邮件服务器,而且优先级都是10。

当客户端(通常是SMTP软件)查询邮件服务器IP地址时,Bind 将根据“rrset-order”语句定义的次序把配置中设定的3条A记录都发送给客户端,客户端可以使用自己规定的算法从3条记录中挑选一条。

“rrset-order”语句是主配置文件中“options”主语句的一条子语句,可以定义固定、随机和轮询的次序。

下面的配置是另一种实现邮件服务器负载平衡的方法,如图6-46所示。

图6-46 负载均衡在以上配置中,“”对应了3个IP地址,此时,具体选择哪一条A 记录,也是由“rrset-order”语句决定。

另外,在反向解析文件中,这3个IP都要对应mail主机,以免有些邮件服务器为了反垃圾邮件进行反向查询时出现问题。

除了邮件服务器以下,其他的服务也可以采用类似的配置实现负载均衡。

例如,要使用3台内容相同的FTP服务器共同承担客户机的访问,它们的IP地址分别是“10.10.1.10”、“10.10.1.11”和“10.10.1.12”。

可以在在区域数据文件中输入以下内容来达到目的,如图6-47所示。

Linux平台Apache高可用双机集群Tomcat负载均衡集群配置手册

Linux平台Apache双机高可用集群+ Tomcat负载均衡集群配置手册在这个配置手册中,使用的操作系统和软件清单如下:操作系统:RedHat Enterprise Linux AS4 U4 64bit(安装时最好选择完全安装)软件:jdk-1_5_0_15-linux-amd64.binTomcat5.5.26httpd-2.0.63.tar.gzjakarta-tomcat-connectors-jk2-src-current.tar.gzipvsadm-1.24.tar.gzlibnet.tar.gzheartbeat-2.1.3-3.el4.centos.x86_64.rpmheartbeat-pils-2.1.3-3.el4.centos.x86_64.rpmheartbeat-stonith-2.1.3-3.el4.centos.x86_64.rpm因为是linux操作系统,所以在安装软件时请使用对应自己操作系统内核的软件,这是整个集群成功的第一步。

本配置手册中的软件都是对应RedHat Enterprise Linux AS4 U4 64bit 这个版本的软件。

jdk-1_5_0_15-linux-amd64.binJAVA环境包使用的是64位1.5版Tomcat版本为公司指定的5.5版本Apache为2.0.63版jakarta-tomcat-connectors-jk2-src-current.tar.gz是连接Apache和Tomcat的连接插件,具体可以去Tomcat网站上查找下载ipvsadm-1.24.tar.gzlibnet.tar.gz这两个是用于2台Apache服务器虚拟一个IP地址使用heartbeat-2.1.3-3.el4.centos.x86_64.rpmheartbeat-pils-2.1.3-3.el4.centos.x86_64.rpmheartbeat-stonith-2.1.3-3.el4.centos.x86_64.rpm这3个软件是用于2台Apache服务器之间的心跳检测结构图Apache1以以以以以Tomcat1Tomcat2Apache22台Tomcat服务器使用Tomcat软件可以自己做集群,2台Apache服务器需要其他的软件实现虚拟服务器功能,工作站访问虚拟IP地址访问2台Apache服务器,再通过Apache服务器访问Tomcat服务器第3 页总13 页1.安装JAVA环境包1)输入命令:./ jdk-1_5_0_15-linux-amd64.bin执行完毕后,会在当前目录下生成一个JDK-1.5.0_15的文件夹2)在 /usr/local/下新建一个名字为JAVA文件夹,将个JDK-1.5.0_15的文件夹拷入到该文件夹下3)设置环境变量。

在Linux虚拟机中搭建Nginx服务器以及SSL、反向代理和负载均衡的实现

在Linux虚拟机中搭建Nginx服务器以及SSL、反向代理和负载均衡的实现目录一、虚拟机下网络的网络配置 (2)1、Bridged模式 (2)2、NAT 模式 (3)3、host-only 模式: (4)4、作业环境网络拓扑图 (4)二、Nginx的安装与配置 (5)1、Nginx简介 (5)2、安装前的环境准备 (5)3、下载安装 (6)4、控制Nginx服务 (6)5、配置nginx (7)6、负载测试 (9)三、基于OpenSSL部署https网站 (9)1、OpenSSL以及SSL/TLS协议简介: (9)2、Linux下配置https (10)3、SSL/TSL协议分析 (12)四、用Nginx实现负载均衡和反向代理 (15)1、反向代理的实现 (15)2、负载均衡 (18)一、虚拟机下网络的网络配置1、Bridged模式在桥接模式下,VMware虚拟机里的系统就像是局域网中的一台独立的主机,它可以访问同一个网段内任何一台机器,即可以相互ping通。

在桥接模式下,你需要手工为虚拟系统配置IP地址、子网掩码,而且还要和宿主机器处于同一网段,这样虚拟系统才能和宿主机器进行通信。

同时,由于这个虚拟系统是局域网中的一个独立的主机系统,就可以手工配置它的IP,DNS服务器,网关等信息,以实现通过局域网的网关或通过交换机访问外网。

图1本地物理网卡和虚拟网卡通过虚拟交换机进行桥接,物理网卡和虚拟网卡在拓扑图上处于同等地位。

Vmware默认给虚拟系统提供了一个虚拟网卡(linux下默认为eth0设备),虚拟系统通过该网卡与外部通信。

图中虚拟交换机由vmware提供,其默认设备名为VMnet0。

如图1所示。

2、NAT 模式NAT 即Network Address Translation 缩写,即网络地址转换,由NAT服务完成,在vmware里默认为VMnet8虚拟交换机,它将虚拟系统的IP地址转换成宿主机的IP地址,从而借用宿主机访问其他主机。

Linux集群下的校园网络负载均衡方案

常熟理工学院学报(自然科学)Journal of Changshu Institute Technology (Natural Sciences )第26卷第8Vol.26No.82012年8月Aug.,2012收稿日期:2012-04-16基金项目:安徽省教育厅优秀青年人才基金项目“基于自适应算法的校园网络链路负载均衡研究与应用”(2012SQRL263)作者简介:胡秀建(1979—),男,安徽宿州人,讲师,硕士,研究方向:计算机网络管理、信息安全等.Linux 集群下的校园网络负载均衡方案胡秀建1,王浩2,廉祥丽1,陈伟1(1.宿州职业技术学院计算机信息系,安徽宿州234011;2.阜阳师范学院计算机与信息学院,安徽阜阳236037)摘要:为了解决大量的校园网络服务带来的网络拥挤问题,提出了基于Linux 集群的校园网络负载均衡方案.它采用地址转换和IP 隧道两种方式,将计算机集群虚拟化为一个虚拟服务器,从而在IP 层上实现负载均衡调度.该方案能够充分发挥校园网络设备的利用率,提高校园网络的整体性能,减少资金的投入和降低维护成本.关键词:负载均衡;网络地址转换;IP 隧道;虚拟服务器中图分类号:TP393.1文献标识码:A 文章编号:1008-2794(2012)08-0109-05随着高校信息化水平的不断提高,高校校园网络的规模和服务功能也在不断扩展,新的网络设备和网络应用平台也不断更新和投入使用[1].校园网络要承担教学管理、科学研究、远程教育、Web 服务等诸多任务.网络中心作为校园网络的核心机构,还要承担数据存储、信息发布、流量监控、用户管理、负载均衡、信息安全、病毒防治等一系列网络管理任务.总体来说,校园网络用户群体庞大、资源利用率高、管理难度大.并且由网络服务功能的扩展带来的流量监控和负载均衡问题日益突出,占用了大量的人力和物力,使网络运营维护成本居高不下.本文提出的基于Linux 集群技术设计的校园网络负载均衡方案可以有效地解决这一问题.1负载均衡假如学校网络有N 台服务器,网络内同一时间的访问请求个数为M (一般情况下M 远远大于N ),这就要求网络中部署一个设备或软体,它负责将M 个访问请求调度到N 个不同服务器上去,这就是负载均衡器的作用[2].负载均衡器是服务器集群的唯一入口,它可以是一个独立的硬件实体,也可以是一个安装在代理服务器内的软体.在校园网络中,计算机集群是通过负载均衡设备将统一的一个公有IP 地址映射到整个集群中的多个IP 地址主机上,以实现单一客户端对整个集群的访问.公有的虚拟IP 地址相当于一个虚拟服务器,和集群内主机IP 地址的关系是一对多的映射关系,这种映射关系可以有效解决校园网络IP 地址短缺问题.在工作过程当中,若负载均衡器出现故障,则很可能造成整个集群负载失效[3].因此,在实际应用中,我们可以部署多个均衡器,用以提供必要的负载均衡容错机制,对负载均衡器进行备份并对其工作状态进行监控,可以在网络负载均衡设备出现故障情况下进行有效转换,利用备份负载均衡设备替换故障设备,并对2012年常熟理工学院学报(自然科学)故障设备进行报警、检查、恢复等操作,使其恢复正常工作.1.1Linux中负载均衡模型上述所提到的负载均衡实现方法是基于IP协议层实现的负载均衡技术,它将整个网络的接入请求划分成一个个单一的网络请求,通过负载均衡器将它们分别调度到服务器集群中的单一主机上,由整个集群的主机来分担任务,以最大限度地发挥整个网络的性能.实现负载均衡的关键技术在于IP层的负载分配,该技术具有良好的兼容性、高效的执行效率、简单的体系结构等特点.在Linux系统中,这种基于IP层交换的负载均衡技术具备良好的可扩展性、易管理性,可以大幅提高整个集群系统的性能,从而实现以负载均衡为核心的Linux集群系统[4].该系统可通过三种不同负载均衡模型来实现,分别是:地址转换(NAT)模型、IP隧道模型和直接路由(DR)模型[5].本文重点对前两种模型进行分析和研究.在地址转换(NAT)模型中,集群内部的IP地址与外部网络隔开,服务器内部结点拥有一个IP地址池,每个数据请求和应答都通过负载均衡设备,负载均衡设备负责对IP数据包进行处理然后和客户端进行通信.在IP隧道模型中,整个网络是个开放的体系结构,集群系统中的每个主机在互联网上都有一个合法的IP地址,客户端和服务器端的通信通过路由应答方式来实现.其实现过程为,客户端向虚拟IP地址主机(负载均衡器)发送通信请求,虚拟IP主机(负载均衡器)通过IP隧道对该数据包进行封装并选定目的主机结点作为新的IP主机地址,然后发送到对应IP主机结点上;对应IP主机结点接收虚拟IP地址主机(负载均衡器)发送的IP隧道数据后将数据包解包进行数据处理,并根据源客户端的IP地址将应答数据包直接反馈给源客户端,但此时应答数据包的源地址为虚拟IP地址,即负载均衡器的IP地址.在直接路由(DR)模型中,整个集群内的主机和负载均衡器都有共同的虚拟IP地址,但负载均衡器和每个主机都不解析虚拟IP的RAP地址,只接收符合自己MAC地址的数据包.客户端向负载均衡器发送数据请求后,负载均衡器根据当前集群工作状态选择集群内部主机结点并重写数据包的MAC地址,然后将数据包广播到所属网段内[6].当对应的主机收到负载均衡器广播的数据包后,便会直接和客户端进行通信,并将处理后的数据反馈给客户端.总的来说,客户端始终和有着同一虚拟IP地址的负载均衡服务器集群进行通信.1.2三种负载均衡模型的比较根据以上对三种模型的介绍,从连接通信方式、数据包处理等方面对它们进行对比分析.结果见表1.2基于IP层负载均衡调度的解决方法2.1负载均衡调度在硬件中的实现通过对以上三种模型的对比可知,不论采用哪一种负载均衡模型,其工作的基本原理是一致的,即客户端访问负载均衡设备,负载均衡设备接收到访问请求后对它进行封包转发,然后从一组服务器集群中选择一个主机,将请求数据包发送给它,集群内主机接收到请求数据包后对数据包进行处理,然后将响应数据包名称NAT IP隧道DR 通信方式双工单工单工数据包处理IP封包IP封包MAC封包优点方法简单、易于在客户端和集群系统中实现IP层请求和应答的转换,适合网络数据流量小的校园网络应答数据包直接反馈给客户端,具有通信效率高和良好的可扩展性优点应答数据包直接反馈给客户端,具有通信效率高、可扩展性等特点,缺点速度慢,在大量较重负载的网络中应用时候会造成网络瓶颈网络安全性低网络安全性低、管理相对复杂表1三种负载均衡模型对照分析110胡秀建,王浩,廉祥丽,等:Linux 集群下的校园网络负载均衡方案8反馈给负载均衡设备或者直接反馈给客户端.目前,很多企业在设计自己的负载均衡设备时,都采用地址转换方法来实现,比如Berkeley 的Magic Router 、Cisco 的Local Director 、Alteon 的ACE Director 和F5的Big/IP 等都是使用网络地址转换方法[7].2.2NAT 实现虚拟服务器(VS/NAT )集群负载均衡在Internet 迅猛发展的今天,IPV4地址已经接近枯竭,为了节约IPV4地址,网络在进行NAT 转换时可以使用专门为内部网络保留的IP 地址,比如10.0.0.0/255.0.0.0、192.168.0.0/255.255.0.0等.通过NAT 将不同IP 地址的主机变成一个虚拟服务器集群(VS ),其示意图如图1所示.在图1中,VS 由一个负载均衡设备、一个交换机、若干服务器主机组成.当客户端通过Internet 对VS 进行访问时,负载均衡设备负责将请求数据包调度给相应主机,不管请求数据包被调度到哪台主机上,其反馈的结果没有任何不同.在图1中,负载均衡设备接收到请求数据包后并对它进行封包,然后采用一定的算法将数据包调度到相应主机上.目前常用的调度算法是动态反馈负载均衡调度算法[8],该算法将影响负载均衡的几个主要元素采用权值计算方式纳入到调度决策过程中,有效地解决负载调度的效率问题.2.3VS/NAT 实验分析为了进一步说明VS/NAT 工作过程,在这里设计一个案例并对之进行分析.具体的VS/NAT 的配置如图2所示.设定VIP (虚拟IP )地址为10.3.1.5,80端口的数据请求都被调度到集群内主机173.1.0.1:80和173.1.0.1:8000上(web 服务);21端口的数据请求被调度到集群内主机173.1.0.1:21上(ftp 服务),如表2所示.根据上面的请求数据包负载调度对照表,下面我们详细分析具体的客户端请求数据包改写流程.设定访问Web 服务器的客户端请求为:源地址:102.1.1.2:3688,目的地址:10.3.1.5:80;当负载均衡器接收到数据包请求后,便通过调度程序按相应从集群系统中选择一台主机,假如选择173.1.0.2:80.这时候数据包被封包,并将地址改写,然后发送到173.1.0.2:80.地址改写如下:源地址:102.1.1.2:3688,目的地址:173.1.0.2:80;主机173.1.0.2接收到数据包以后,首先将数据包解包,处理后反馈响应数据包给负载均衡设备,地址变换为:源地址:173.1.0.2:80,目的地址:102.1.1.2:3688;负载均衡设备接收到反馈数据包后,对源地址进行改写,将源地址改写成虚拟IP 地址,地址变换为:源地址:10.3.1.5:80,目的地址:102.1.1.2:3688;客户端接收到的数据包的源地址便是虚拟IP 地址10.3.1.5:80,而不是集群内主机173.1.0.2:80地址.这个地址转换过程是双工转换,整个过程完成了对集群内主机IP 的屏蔽.不论集群内是哪一台主机响应了外部客户端的请求,其结果都是一样的.图1VS/NAT的体系结构表2VS/NAT 集群负载均衡调度对照表协议TCP VIP 10.3.1.5端口8021集群内主机IP 173.1.0.1173.1.0.1173.1.0.1端口80800021权1211112012年常熟理工学院学报(自然科学)3通过IP 隧道实现虚拟服务器(VS/TUN )集群负载均衡采用NAT 实现VS 集群系统只适合请求和响应的数据包较小的情况,而当集群内服务器数目较多、请求和响应数据包较大的时候采用VS/NAT 模式就会严重影响整个系统的性能,并使之成为整个系统的瓶颈.若能将请求数据包和响应数据包分开处理,采用单工方式对请求数据包进行封包,将响应数据包直接反馈给客户端[9],这样就可以大大提高整个集群系统性能,IP 隧道(TUN )模式就是基于单工机制来实现服务器集群负载均衡的.3.1IP TUN 工作原理首先,在服务器集群中建立IP 隧道.在IP TUN 体系结构(如图3所示)中,有一个统一的VIP (虚拟IP )地址,服务器集群中每个主机都将VIP 地址配置到自己的IP 隧道设备上[10].其次,所有的网络服务全部虚拟到VIP 服务器上以供外部网络访问.数据包处理工作过程为,客户端发送服务请求到VIP 服务器上,VIP 服务器对请求数据包进行IP 封包后通过负载均衡设备对集群内主机进行选择,集群内主机接收到请求数据包后对数据包进行处理并直接将处理结果反馈给客户端.3.2IPTUN 封包和数据包反馈过程如图3所示,在IP TUN 工作过程中,客户请求数据包发送到统一的虚拟IP 地址服务器上,要将数据包进行封装,然后通过隧道发送到相应主机上,最后通过主机直接反馈给客户端,假定外网客户端IP 地址为102.1.1.2,其过程如图4所示.这里需要注意的是,经过实际服务器处理后的IP packet 中,实际反馈给客户端的数据包的源地址是VIP.4结论随着人们对Linux 服务器依赖的加深,对其可靠性、负载能力和计算能力也倍加关注,Linux 集群技术应运而生.本文提出了基于Linux 系统的校园网络负载均衡方案,重点讨论了基于IP 层负载均衡调度的解决方法,提出了VS/NAT 和VS/TUN 实现模型,并对VS/图3VS/TUN 的体系结构图2VS/NAT的例子图4IP TUN封包和数据包反馈过程112113胡秀建,王浩,廉祥丽,等:Linux集群下的校园网络负载均衡方案8NAT模型进行例证分析,证明了其应用的可靠性.参考文献:[1]董静宜,王鹏,陈磊,等.云计算集群系统负载均衡算法的熵值判定[J].成都信息工程学院学报,2010,25(6):580-583.[2]陈超.利用LVS中的IP负载均衡技术建立可伸缩性网络服务[J].四川理工学院学报(自然科学版),2006,19(4):81-85.[3]李文中,郭胜,许平,等.服务组合中一种自适应的负载均衡算法[J].软件学报,2006,17(5):1068-1075.[4]戴艺,苏金树,孙志刚.基于流映射的负载均衡调度算法研究[J].计算机学报,2012,35(2):218-227.[5]郭成城,晏蒲柳.一种异构Web服务器集群动态负载均衡算法[J].计算机学报,2005,28(2):179-184.[6]Christopher Negus.Linux Bible,2011Edition[M].Hoboken:Wiley Publishing,2011:503-510.[7]李飞,杨放春,苏森.分布式W曲勇爱务QoS注册中的高效负载均衡方法[J].电子与信息学报,2009,32(5):1022-1025.[8]Lada A Adamic,Bernardo A Huberman.Zipf’s Law and the Internet[J].Glottometrics,2002(3):143-150.[9]Koloniari G,Pitoura E.Peer-to-peer management of XML data:Issues and research challenges[J].ACM SIGMOD Record,2005,34 (2):6-17.[10]董丽丽.基于Linux集群负载均衡算法的分析与研究[D].西安:西安建筑科技大学,2009.The Balancing Scheme for Campus Network Load Based on Linux ClusterHU Xiu-jian1,WANG Hao2,LIAN Xiang-li1,CHEN Wei1(1.Department of Computer and Information,Suzhou Vocational and Technological College,Suzhou234011,China;2.School of Computer and Information,Fuyang Teachers College,Fuyang36037,China)Abstract:In order to solve the problem of campus network congestion,this paper puts forward a balancing scheme for campus network load based on Linux cluster,in which address translation and IP tunnel are used.. The two ways can make the computer cluster into a virtualization server so as to realize load balance scheduling in terms of IP layer.This scheme can give full play to the campus network equipment utilization,reduce the unit capital investment and maintenance costs,and thus improve the overall performance of the campus network. Key words:load balancing;network address translation;IP tunnel;virtual server。

linux中bonding配置步骤详解

本文介绍linux下的bonding 技术,linux 2.4.x 的内核中采用了这种技术,利用bonding 技术可以将多块网卡接口通过绑定虚拟成为一块网卡,在用户看来这个聚合起来的设备好像是一个单独的以太网接口设备,通俗点讲就是多块网卡具有相同的IP 地址而并行连接聚合成一个逻辑链路工作。

二、bond的几种算法Linux的bond支持7种工作模式,可以参考内核源码包文件:Documentation/networking/bonding.txt 。

这里逐一介绍。

模式1:mode=0 ,即:(balance-rr) Round-robin policy(平衡轮循策略)特点:传输数据包顺序是依次传输(即:第1个包走eth0,下一个包就走eth1….一直循环下去,直到最后一个传输完毕),此模式提供负载平衡和容错能力;但是我们知道如果一个连接或者会话的数据包从不同的接口发出的话,中途再经过不同的链路,在客户端很有可能会出现数据包无序到达的问题,而无序到达的数据包需要重新要求被发送,这样网络的吞吐量就会下降。

模式2:mode=1,即:(active-backup) Active-backup policy(主-备份策略)特点:只有一个设备处于活动状态,当一个宕掉另一个马上由备份转换为主设备。

mac地址是外部可见得,从外面看来,bond的MAC地址是唯一的,以避免switch(交换机)发生混乱。

此模式只提供了容错能力;由此可见此算法的优点是可以提供高网络连接的可用性,但是它的资源利用率较低,只有一个接口处于工作状态,在有N 个网络接口的情况下,资源利用率为1/N模式3:mode=2,即:(balance-xor) XOR policy(平衡策略)特点:基于指定的传输HASH策略传输数据包。

缺省的策略是:(源MAC地址XOR 目标MAC地址) % slave数量。

其他的传输策略可以通过xmit_hash_policy选项指定,此模式提供负载平衡和容错能力。

负载均衡设计方案

负载均衡设计方案负载均衡是指将网络流量合理分配到多个服务器上,使得每个服务器负载均匀,提高系统的可用性和性能。

以下是一个负载均衡的设计方案:1. 确定负载均衡的算法:负载均衡的算法有很多种,常见的有轮询、最少连接、IP哈希等。

根据系统的需求和规模,选择适合的负载均衡算法。

2. 引入负载均衡设备:在系统架构中引入负载均衡设备,如硬件负载均衡器或软件负载均衡器。

负载均衡设备可以根据负载均衡算法将流量分发到后端服务器。

3. 添加后端服务器:根据系统的性能需求和负载均衡设备的性能,确定后端服务器的数量。

后端服务器可以是物理服务器、虚拟机或者容器。

确保每个后端服务器都具有相同的应用程序和数据副本。

4. 监控后端服务器:使用监控工具监控每个后端服务器的性能指标,如CPU使用率、内存使用率、网络流量等。

通过这些指标可以及时发现负载过高或发生故障的服务器。

5. 动态调整负载均衡策略:根据监控数据和负载均衡算法,动态调整负载均衡策略。

例如,当某个后端服务器负载过高时,可以将部分流量转发到其他服务器上,以减轻其负载。

6. 安全策略:在负载均衡设备上设置安全策略,如访问控制列表(ACL)、防火墙等,以保护系统免受攻击。

7. 故障恢复:当某个后端服务器发生故障时,负载均衡设备可以自动将流量转发到其他正常的服务器上,以保证系统的可用性。

8. 水平扩展:根据系统的负载情况,根据预测的流量增长趋势,可以动态增加后端服务器的数量,以满足系统的性能需求。

综上所述,一个负载均衡的设计方案包括确定负载均衡的算法,引入负载均衡设备,添加后端服务器,监控后端服务器,动态调整负载均衡策略,设置安全策略,故障恢复以及水平扩展。

通过合理的设计和配置,可以提高系统的性能和可用性,提升用户体验。

ipvs 负载实现规则

ipvs 负载实现规则实现负载均衡的核心技术之一是IPVS(IP Virtual Server),它是一个在Linux 内核中实现的高性能、可伸缩的负载均衡解决方案。

本文将以中括号为主题,详细讨论IPVS的实现规则及其在负载均衡中的应用。

下面将一步一步回答您关于IPVS负载实现规则的问题。

一、什么是IPVS?IPVS是一种在Linux内核中实现的负载均衡技术。

它通过在内核中建立一个虚拟服务器,将外部请求分发到后端服务器上,从而提高系统的性能和可靠性。

二、IPVS负载实现规则的基础概念1. 虚拟服务器(Virtual Server):在IPVS中,虚拟服务器是一个逻辑实体,它代表了一个服务(如HTTP、FTP等),并分配一个独立的IP地址和端口号。

2. 调度算法(Scheduling Algorithm):调度算法是IPVS负载均衡的核心,它决定了如何选择后端服务器来处理请求。

常见的调度算法包括轮询(Round Robin)、源地址散列(Source IP Hashing)等。

3. 后端服务器(Real Server):后端服务器是实际处理请求的服务器,它们接收来自虚拟服务器的请求,并返回响应。

三、IPVS负载实现规则的配置步骤1. 安装IPVS:首先,需要在Linux服务器上安装IPVS软件包。

可以使用包管理器(如yum、apt)来安装。

2. 配置IPVS内核模块:在Linux内核中启用IPVS功能,可以使用modprobe 命令来加载IPVS内核模块,例如:modprobe ip_vs。

3. 创建虚拟服务器:使用ipvsadm命令创建虚拟服务器,并指定虚拟服务器的IP地址、端口号以及调度算法。

例如:ipvsadm -A -t 192.168.1.100:80 -s rr。

4. 添加后端服务器:使用ipvsadm命令添加后端服务器,并指定其IP地址和权重。

例如:ipvsadm -a -t 192.168.1.100:80 -r 192.168.1.200 -g -w 1。

使用LVS实现负载均衡原理及安装配置详解

如上图。FULLNAT模式对入报文做了DNAT+SNAT,即将报文的目的地址改为RS的地址,源地址改为LVS设备地址;RS上不需要配置路由策略,出报文到了LVS设备上后做 SNAT+DNAT,即将报文的源地址改为LVS设备上的地址,目的地址改为真实的用户地址。

LVS FULLNAT类型特性

ipvsadm:用户空间的命令行工具,规则管理器,用于管理集群服务及RealServer ipvs:工作于内核空间的netfilter的INPUT钩子之上的框架

LVS集群类型中的术语

Director:负载均衡器,也称VS(Virtual Server) RS:真实服务器(RealServer) CIP:客户端IP(Client IP) VIP: Client所请求的,提供虚拟服务的IP,可以用Keepalive做高可用 DIP:在Director实现与RS通信的IP RIP:RealServer IP

1.VIP是公网地址,RIP和DIP是私网地址,且通常不在同一IP网络,因此,RIP的网关一般不会指向DIP 2.RS收到的请求报文源地址是DIP,因此只需响应给DIP, Dirctor收到RS的回复报文后将其发往Client 3.请求和响应报文都经由Dirctor 4.支持端口映射

三、LVS调度方法(Scheduler)

2.2 LVS/DR(Direct Routing直接路由) 通过为请求报文重新封装一个MAC首部进行转发,源MAC是DIP所在的接口的MAC,目标MAC是挑选出的RS的RIP所在接口的MAC地址;源IP/PORT,以及目标IP/PORT均保持不变, 请求报文经过Dirctor但响应报文不再经过Dirctor

二、LVS集群的类型

LVS转发模式有四种: lvs-nat: 修改请求报文的目标IP lvs-dr: 操纵封闭新的MAC地址 lvs-tun: 在原请求IP报文之外新加一个IP首部 lvs-fullnat: 修改请求报文的源和目标IP

负载均衡设备主要参数配置说明

(初稿)Radware负载均衡设备主要参数配置说明2007年10月radware北京代表处目录一、基本配置 (3)1.1 Tuning配置 (3)1.2 802.1q配置 (4)1.2 IP配置 (6)1.3 路由配置 (7)二、四层配置 (8)2.1 farm 配置 (8)2.2 servers配置 (10)2.3 Client NAT配置 (11)2.4 Layer 4 Policy配置 (16)三、对服务器健康检查 (18)3.1 基于连接的健康检查 (19)3.2 高级健康检查 (21)四、常用系统命令 (25)一、基本配置Radware负载均衡设备的配置主要包括基本配置、四层配置和对服务器健康检查配置。

注:本文档内容,用红色标注的字体请关注。

1.1 Tuning配置Rradware设备tuning table的值是设备工作的环境变量,在做完简单初始化后建议调整tuning值的大小。

调整完tuning table后,强烈建议,一定要做memory check,系统提示没有内存溢出,才能重新启动设备,如果系统提示内存溢出,说明某些表的空间调大了,需要把相应的表调小,然后,在做memory check,直到没有内存溢出提示后,重启设备,使配置生效。

点击service->tuning->device 配置相应的环境参数,Tuning for AppDirector AS2 AS4缺省值最大值建议值缺省值最大值建议值Bridge Forwarding Table: 1,02432,76732,7671,02432,76732,767 IP Forwarding Table: 32,768262,144256,00032,768262,144256,000 ARP Forwarding Table: 1,02432,7679,0001,02432,7679,000 Client Table: 65,536537,000400,00065,5361,396,685800,000 Routing Table: 51232,76751251232,767512在做一般的配置时主要调整的参数如下:Bridge Forwarding Table、IP Forwarding Table、ARP Forwarding Table、Client Table等。

如何实现服务器的负载均衡

如何实现服务器的负载均衡服务器负载均衡是指在高访问量的情况下,将网络请求均匀地分配到多个服务器上,以提高系统的可用性、稳定性和性能。

本文将介绍如何实现服务器的负载均衡,包括硬件负载均衡和软件负载均衡两个方面。

一、硬件负载均衡硬件负载均衡是通过专门的负载均衡设备来实现的,这些设备通常被称为负载均衡器或负载均衡交换机。

硬件负载均衡器可以根据预设的负载均衡算法将网络请求分发到后端多个服务器上。

1. 服务器集群首先,需要配置一个服务器集群,该集群由多台服务器组成,每台服务器都装有相同的系统和应用程序,并且能够提供相同的服务。

服务器集群的规模可以根据实际需求进行扩展。

2. 负载均衡器配置将负载均衡器安装在服务器集群之前,配置其网络接口和IP地址。

然后,通过负载均衡器的管理界面,添加服务器集群的成员,并为每个成员分配权重,用于控制负载均衡器将请求发送到每个成员的比例。

3. 负载均衡算法负载均衡器使用的算法决定了将请求分发到服务器集群中的哪个成员。

常用的负载均衡算法包括轮询、最小连接数和源IP Hash等。

轮询算法会依次将请求分发到每个成员上,最小连接数算法会将请求分发到当前连接数最少的成员上,源IP Hash算法会根据客户端的IP地址将请求分发到相同服务器上。

4. 健康检查健康检查是负载均衡器保证服务器集群可用性的重要机制。

负载均衡器会定期发送请求到服务器成员,并根据响应状态判断服务器是否正常工作。

如果某个服务器无法响应或响应较慢,负载均衡器会将该服务器从集群中暂时移除,待其恢复正常后再加入集群。

二、软件负载均衡软件负载均衡是借助软件来实现服务器负载均衡的方法,其中最常见的方式是使用反向代理服务器来分发网络请求。

1. 反向代理服务器反向代理服务器是位于客户端与服务器之间的一个中间层,客户端的请求首先到达反向代理服务器,然后由代理服务器将请求转发到后端的服务器上。

客户端并不知道实际提供服务的后端服务器,而是与反向代理服务器进行通信。

负载均衡配置调度规则

负载均衡配置调度规则负载均衡配置调度规则通常包括以下几种:1. 轮询调度法(Round Robin Scheduling):这是最简单的负载调度算法,按照服务请求到达的先后次序,逐一分配给服务器。

轮询调度法简单且易于理解,但当后到的服务请求分配到的是状态较差的服务器时,会导致性能降低。

2. IP哈希法(IP Hash):该方法基于轮询调度法进行改进,它将请求的IP地址通过哈希算法转化为服务器列表的位置,每次都固定访问相同的服务器,因此可以将不同的服务器隔离出来,提高了安全性。

3. 加权轮询:给每台服务器分配一个权重值,代表服务器的处理能力,优先处理处理能力强的服务器,均衡考虑所有服务器。

这种调度规则有助于合理分配网络带宽,将瓶颈缩小到单个服务器,使系统资源能够被更好地利用。

4. 加权最少连接(WLC):每台服务器都有一个最小的连接数作为“资产”,此方法通过把请求分配给具有最小连接数的服务器来工作。

当多台服务器的空闲资源相当时,WLC方法将更有效地利用服务器的处理能力。

5. 最小活跃连接(MAC):此方法选择具有最小活跃连接的服务器来接收新的服务请求。

它倾向于选择状态最佳的服务器来处理新的服务请求,有助于提高系统的整体性能。

6. 最大响应时间(MRR):根据服务器的最大响应时间来分配请求,具有更小最大响应时间的服务器会收到更多的请求。

这是一种较为先进的调度算法,需要具有更多的系统信息以更好地评估服务器的性能。

在实际应用中,负载均衡的配置调度规则需要结合实际应用场景、服务器性能等因素综合考虑。

选择适合的调度规则可以有效地提高系统性能和稳定性。

LINUX集群LVS负载均衡配置

作者:潜小生 open.source.niche@LINUX 集群LVS 负载均衡配置基础基础原理篇原理篇原理篇::LVS 是Linux Virtual Server 的缩写,意思是Linux 虚拟服务器。

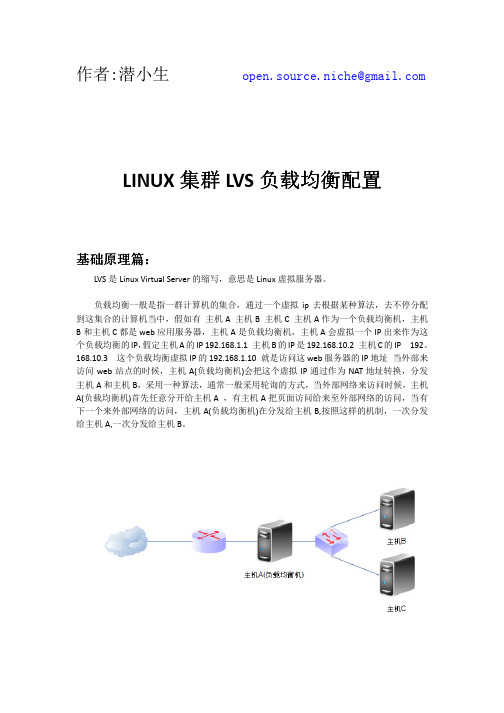

负载均衡一般是指一群计算机的集合,通过一个虚拟ip 去根据某种算法,去不停分配到这集合的计算机当中,假如有 主机A 主机B 主机C 主机A 作为一个负载均衡机,主机B 和主机C 都是web 应用服务器,主机A 是负载均衡机,主机A 会虚拟一个IP 出来作为这个负载均衡的IP ,假定主机A 的IP 192.168.1.1 主机B 的IP 是192.168.10.2 主机C 的IP 192。

168.10.3 这个负载均衡虚拟IP 的192.168.1.10 就是访问这web 服务器的IP 地址 当外部来访问web 站点的时候,主机A(负载均衡机)会把这个虚拟IP 通过作为NAT 地址转换,分发主机A 和主机B ,采用一种算法,通常一般采用轮询的方式,当外部网络来访问时候,主机A(负载均衡机)首先任意分开给主机A ,有主机A 把页面访问给来至外部网络的访问,当有下一个来外部网络的访问,主机A(负载均衡机)在分发给主机B,按照这样的机制,一次分发给主机A,一次分发给主机B 。

LVS有三种负载均衡的模式,分别是VS/NAT(nat模式)VS/DR(路由模式) VS/TUN(隧道模式)介绍模式介绍VS/NAT模式这种模式当来访问这个网络的时候,负载均衡机会会通过NAT的转换分别分发给应用服务器A或应用服务器B。

应用服务器返回给来至外部的访问,要在次通过负载机访问给来至外部的访问。

这种模式通常是应用服务器是IP是私有IP地址,需要通过NAT地址来转换成公网IP地址。

返回给外部网络的不在通过这个负载均衡机出去,而且自己通过路由返回给外部网络,自己去查路由,去返回。

vs/tun模式介绍隧道模式,负载均衡机和集群集合的服务器和负载均衡虚拟出来IP不属于同一个网段,分别分布在不同网段,这时候我需要隧道模式,好比这个负载均衡机和这个集群集合的服务器建议一条用来专门用来负载均衡隧道,隧道模式首先外部网络访问时候,经负载均衡机来分发到应用服务器,应用服务器也是和路由模式一样的方式,自己路由出去返回结果给来至外部的访问,也不经在过负载均衡机出返回给来至外部网络的访问。

如何优化负载均衡器的配置参数(一)

如何优化负载均衡器的配置参数在现代高负载的计算环境中,负载均衡器扮演着至关重要的角色。

负载均衡器是一种网络设备或服务,用于将流量分发到多个服务器上,以提高系统的性能、可用性和可伸缩性。

为了实现最佳的负载均衡效果,配置参数的优化至关重要。

本文将讨论如何优化负载均衡器的配置参数,以确保系统的稳定性和性能。

1. 负载均衡算法选择负载均衡器的核心功能是根据服务器的负载情况将请求流量分发到不同的服务器上。

选择适合应用场景的负载均衡算法是优化配置参数的第一步。

常见的负载均衡算法包括轮询、加权轮询、最小连接、源地址哈希等。

根据应用需求和服务器负载情况选择合适的算法,可以实现更好的负载均衡效果。

2. 健康检查配置负载均衡器需要定期检查后端服务器的健康状态,以确保只将流量分发到健康的服务器上。

通过配置适当的健康检查参数,可以避免将流量发送到不可用或故障状态的服务器上,提高系统的可用性。

常见的健康检查参数包括心跳时间间隔、超时时间和重试次数等。

3. 连接超时和保持活动时间负载均衡器在处理请求时可能会面临连接超时和保持活动时间的问题。

连接超时是指在一定时间内无法建立连接或获取响应,而保持活动时间是指连接保持打开的时间。

根据应用场景和服务需求,调整连接超时和保持活动时间的参数可以避免不必要的连接超时和提高系统的响应速度。

4. 并发连接数和会话保持并发连接数是指同时建立的连接数量,而会话保持是指将同一个客户端的请求发送到同一个后端服务器上。

根据应用需求和服务器性能,调整并发连接数和会话保持的参数可以有效优化负载均衡器的性能。

合理分配并发连接数和启用适当的会话保持策略,可以提高系统的稳定性和性能。

5. 缓存配置负载均衡器可以使用缓存来存储常用的数据或响应,以减轻后端服务器的负载并提高系统的响应速度。

通过合理配置缓存参数,如缓存大小、缓存时间和缓存更新策略等,可以最大化利用缓存,并确保数据的一致性和可用性。

6. 日志和监控配置负载均衡器的日志和监控可以提供有关系统运行状态和性能的重要信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux负载均衡的设置步骤

本文主要介绍了Linux负载均衡的设置步骤。

包括ipvsadm的安装,设置IPVS,Load Balancer,LDirectord等方面的具体介绍,希望大家通过本文的学习能对这方面有所了解。

Linux作为一个具有代表性的开源系统,受到广大的用户所喜爱。

那么如何在LVS下进行负载均衡的使用呢?现在我们就来详细地为大家介绍一下,主要是使用ipvsadm来实现负载均衡。

那么按照一贯的程序,首先是安装程序,然后是配置。

Linux Virtua Server负载均衡ipvsadm使用方法

1.安装ipvsadm

下载ipvsadm,下载时需注意对应自己的内核版本?

ipvsadm下载网址:http://www.Linux /software/

本文使用的是FC8系统,内核版本2.6.23.1,对应ipvsadm版本1.24?

安装时需要Linux内核源码,如果安装系统时没有安装源码,需要再下载内核源码?本文使用的内核是Linux-2.6.23.1.tar.bz2?把内核解压到/usr/src/Linux-2.6.23.1?下面开始编译安装:

建立内核快捷方式:ln-s/usr/src/Linux-2.6.23.1/usr/src/Linux

解压ipvsadm:tar zxvf ipvsadm-1.24.tar.gz

安装ipvsadm:

cd ipvsadm-1.24

make

make install

安装完成后,下一步我们开始配置IPVS,本文主要介绍Direct Routing方式的配置?

2.配置IPVS(Direct Routing)

2.1.网络结构

三台计算机,一台Director安装Linux作负载均衡器,另两台ReaServer提供服务?

Director:eth0=192.168.34.40,eth0:0(VirtuaIP) =192.168.34.41

RealServer1:IP=192.168.34.26

RealServer2:IP=192.168.34.27

服务端口:443

客户通过VirtuaIP 192.168.34.41访问服务器?Load Balancer将来自客户的访问按一定的负载均衡机制分发到192.168.34.26和192.168.34.27这两台实际提供服务的服务器?

2.2.Load Balancer配置

步骤1:配置Director IP

在Director上配置好eth0的IP(192.168.34.40),然后在eth0上新增一个IP(192.168.34.41),命名为eth0:0,作为VirtuaIP?

步骤2:配置IPVS Table脚本

编写sh脚本如下:

VIP=192.168.34.41 #VrituaIP地址

RIP1=192.168.34.27 #ReaServer 1 IP

RIP2=192.168.34.26 #ReaServer 2 IP

GW=192.168.34.1 #ReaServer 网关IP

#清除IPVS Table

ipvsadm-C

#设置IPVS Table

ipvsadm-A-t $VIP:443-s wlc

ipvsadm-a-t $VIP:443-r $RIP1:443-g-w 1

ipvsadm-a-t $VIP:443-r $RIP2:443-g-w 1

#将IPVS Table保存到/etc/sysconfig/ipvsadm

/etc/rc.d/init.d/ipvsadm save

#启动IPVS

service ipvsadm start #或者/etc/rc.d/init.d/ipvsadm start也可以

#显示IPVS状态

ipvsadm-l

#脚本结束----------------------------

该脚本配置IPVS Table,并将配置保存到/etc/sysconfig/ipvsadm文件中?

以后修改IPVS TABLE可直接修改该脚本?当然,您也可以直接编辑该文件来实现IPVS Table的配置?

配置完毕后执行/etc/rc.d/init.d/ipvsadm start(或service ipvsadm start)启动IPVS?

通过以上两个步骤,就完成了负载均衡器IPVS的配置?

2.3.ReaServer配置

ReaServer主要做两个配置,一是添加一个虚拟IP,二是关闭该IP的ARP响应?

2.3.1.Windows系统

对于Windows系统的服务器,只要添加一个Loopback的网卡,IP地址设置成虚拟

IP(192.168.34.41),子网掩码设置成255.255.255.255,网关地址留空?

操作:

从控制面板选择添加硬件;

选择"是,硬件已连好";

选择"添加新的硬件设备";

选择"安装我手动从列表选择的硬件";

选择"网络适配器";

从厂商列表选择"Microsoft",从网卡列表选择"Microsoft Loopback Adapter";

点下一步开始安装硬件,安装完毕后出现一个新的网卡,配置好IP和子网掩码?Windows子网掩码无法配置成255.255.255.255,我们可以先按默认的保存配置,然后从注册表修改子网掩码?

注册表修改子网掩码:

从注册表

[HKEY_LOCAL_MACHINESYSTEMCurrentControlSetServicesTcpipParametersInterface s]下找到对应的网卡,将SubnetMask修改成255.255.255.255?然后禁用再启用该网卡即可?

3.配置LDirectord RealServer故障检测及管理

LDirectord进程定时检测各ReaServer运行状态,当检测到某台ReaServer故障时,则将该Server从负载均衡调度列表删除,当恢复正常时再加入?

3.1.安装LDirectord

LDirectord软件包含在HeartBeat软件包中?安装HeartBeat时就同时安装了LDirectord?HeartBeat下载网址:http://www.Linux /software/?

安装HeartBeat还需要安装libnet等软件包?可以到网上下载这些软件包来安装?Libnet下载网址:/libnet/dist/libnet.tar.gz

安装libnet:

tar zxf libnet.tar.gz

cd libnet

./configure

make

make install

安装HeartBeat:

./ConfigureMe configure

make

make install

安装完后执行以下命令加入自启动项:

chkconfig-add ldirectord

3.2.配置LDirectord

heartbeat/ldirectord目录下有个ldirectord.cf文件?该文件是ldirectord的配置范例?在/etc/ha.d/目录下新建一个ldirectord.cf文件,按配置范例格式进行配置,主要配置项如下:

checktimeout=3 #检测超时3s

checkinterval=1 #检测间隔1s

fallback=127.0.0.1:443 #所有服务器都故障时访问该服务器

autoreload=yes #配置文件改变时自动加载

logfile="/var/log/ldirectord.log" #日志文件

quiescent=yes

virtual=192.168.34.41:443 #虚拟IP

real=192.168.34.26:443 gate

real=192.168.34.27:443 gate

fallback=127.0.0.1:443 #所有服务器都故障时访问该服务器

service=none

scheduler=wlc

persistent=600

protocol=tcp

checktype=on

3.3.启动ldirectord

/etc/rc.d/init.d ldirectord start

Linux负载均衡安装中注意:启动时如果提示ldirectord某行出错,一般是有些运行需要的软件没安装,大部分是perl开头的软件包?

net-snmp-5.3-4.2.i386.rpm

net-snmp-libs-5.3-4.2.i386.rpm

perl-Compress-Zlib-1.41-1.2.2.i386.rpm

perl-HTML-Parser-3.50-1.i386.rpm

perl-HTML-Tagset-3.10-2.1.noarch.rpm

perl-libwww-perl-5.805-1.1.noarch.rpm

perl-MailTools-1.74-1.fc5.noarch.rpm

perl-TimeDate-1.16-3.2.noarch.rpm

perl-URI-1.35-2.2.noarch.rpm。