2014年数据库技术大会_王宝晗-大云Hadoop平台及应用-20140408

大数据华为认证考试(习题卷3)

大数据华为认证考试(习题卷3)第1部分:单项选择题,共51题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]ElasticSearch 存放所有关键词的地方是()A)字典B)关键词C)词典D)索引答案:C解析:2.[单选题]DWS DN的高可用架构是:( )。

A)主备从架构B)一主多备架构C)两者兼有D)其他答案:A解析:3.[单选题]关于Hive与传统数据仓库的对比,下列描述错误的是:( )。

A)Hive元数据存储独立于数据存储之外,从而解耦合元数据和数据,灵活性高,二传统数据仓库数据应用单一,灵活性低B)Hive基于HDFS存储,理论上存储可以无限扩容,而传统数据仓库存储量有上限C)由于Hive的数据存储在HDFS上,所以可以保证数据的高容错,高可靠D)由于Hive基于大数据平台,所以查询效率比传统数据仓库快答案:D解析:4.[单选题]以下哪种机制使 Flink 能够实现窗口中无序数据的有序处理?()A)检查点B)窗口C)事件时间D)有状态处理答案:C解析:5.[单选题]下面( )不是属性选择度量。

A)ID3 使用的信息增益B)C4.5 使用的增益率C)CART 使用的基尼指数D)NNM 使用的梯度下降答案:D解析:C)HDFSD)DB答案:C解析:7.[单选题]关于FusionInsight HD Streaming的Supervisor描述正确的是:( )。

A)Supervisor负责资源的分配和任务的调度B)Supervisor负责接受Nimbus分配的任务,启动停止属于自己管理的Worker进程C)Supervisor是运行具体处理逻辑的进程D)Supervisor是在Topology中接收数据然后执行处理的组件答案:B解析:8.[单选题]在有N个节点FusionInsight HD集群中部署HBase时、推荐部署( )个H Master进程,( )个Region Server进程。

区块链系统中的分布式数据管理技术——挑战与展望

第44卷 第1期2021年1月计 算 机 学 报CHINESEJOURNALOFCOMPUTERSVol.44No.1Jan.2021收稿日期:2019 03 22;在线发布日期:2019 10 31.本课题得到国家重点研发计划项目(2018YFB1003404)、国家自然科学基金(U1811261,61672142)、辽宁省科学技术基金(20180550321)资助.于 戈,博士,教授,中国计算机学会(CCF)会员,主要研究领域为分布式数据库、分布与并行计算、区块链.E mail:yuge@mail.neu.edu.cn.聂铁铮(通信作者),博士,副教授,中国计算机学会(CCF)会员,主要研究方向为数据库、数据集成、区块链.E mail:nietiezheng@mail.neu.edu.cn.李晓华,博士,讲师,中国计算机学会(CCF)会员,主要研究方向为信息安全、区块链.张岩峰,博士,教授,中国计算机学会(CCF)高级会员,主要研究领域为分布式数据处理、云计算.申德荣,博士,教授,中国计算机学会(CCF)高级会员,主要研究领域为分布式数据库、数据集成.鲍玉斌,博士,教授,中国计算机学会(CCF)高级会员,主要研究领域为数据仓库、OLAP.区块链系统中的分布式数据管理技术———挑战与展望于 戈 聂铁铮 李晓华 张岩峰 申德荣 鲍玉斌(东北大学计算机科学与工程学院 沈阳 110169)摘 要 区块链是在数字加密货币的应用基础之上发展起来的一种分布式数据库技术.区块链系统具有去中心化、不可篡改、分布共识、可溯源和最终一致性等特点,这使其可以用于解决不可信环境下数据管理问题.区块链独特的数据管理功能已经成为各领域应用中发挥区块链价值的关键.本文基于对比特币、以太坊、超级账本等代表性区块链系统的研究分析,阐述区块链系统中分布式数据管理技术.首先,深入讨论区块链系统与传统分布式数据库系统之间的异同点,从分布式部署模式、节点角色、链拓扑结构等多个方面给出区块链的分类.然后,详细分析各类区块链系统所使用的数据存储结构、分布式查询处理与优化技术及其优缺点.最后,总结区块链系统的分布式数据管理技术在各专门领域应用中所面临的挑战和发展趋势.关键词 区块链;分布式数据管理;数据存储;查询处理中图法分类号TP311 犇犗犐号10.11897/SP.J.1016.2021.00028犜犺犲犆犺犪犾犾犲狀犵犲犪狀犱犘狉狅狊狆犲犮狋狅犳犇犻狊狋狉犻犫狌狋犲犱犇犪狋犪犕犪狀犪犵犲犿犲狀狋犜犲犮犺狀犻狇狌犲狊犻狀犅犾狅犮犽犮犺犪犻狀犛狔狊狋犲犿狊YUGe NIETie Zheng LIXiao Hua ZHANGYan Feng SHENDe Rong BAOYu Bin(犛犮犺狅狅犾狅犳犆狅犿狆狌狋犲狉犛犮犻犲狀犮犲犪狀犱犈狀犵犻狀犲犲狉犻狀犵,犖狅狉狋犺犲犪狊狋犲狉狀犝狀犻狏犲狉狊犻狋狔,犛犺犲狀狔犪狀犵 110169)犃犫狊狋狉犪犮狋 Blockchainisatechniqueofdistributeddatabasewhichisdevelopedwiththeapplicationsofdigitalencryptedcurrency.Ablockchainsystemhasthecharacteristicsofdecentralization,non tampering,distributedconsensus,provenanceandeventualconsistency,whichmakesitbeappliedtosolvedatamanagementproblemsoftheuntrustedenvironments.Thedatamanagementfunctionofablockchainsystemhasalreadybecometheimportantfeatureforplayingitsvalueintheapplicationsofdifferentdomains.Blockchainsystemsmakeeverynodecontainacompletecopyofledgerdata,andusedistributedconsensusalgorithmstoensuretheconsistencyofdata.Therefore,ablockchainsystemisanewkindofdistributeddatamanagementsystemscomparedwithtraditionaldistributeddatabasesystems.WithanalyzingtherepresentativeblockchainsystemsincludingBitcoin,EthereumandHyperledgerFabric,thispaperfocusesonthedistributeddatamanagementtechniquesinexistingblockchainsystems,whichcoversqueryprocessing,smartcontract,networkcommunication,anddatastoragelayersinthearchitectureofblockchainsystems.Thispaperfirstdiscussesthemaindifferencesandsimilaritiesbetweenablockchainsystemandatraditionaldistributeddatabasesystem.Justlikeadistributeddatabasesystem,ablockchainsystemhasfeaturesofdistribution,transparency,autonomyandscalabilityonmanagingdata,butitisalsodifferentfrommostofdistributeddatabasesystemsontopologic,datadistribution,queryprocessing,consistencyandsecuritymechanism.Then,thispaperpresentstheclassificationofblockchainsystemsondifferentaspectsofdistributeddeploymentstyles,noderolesandtopologicalstructures.Withthedevelopmentofblockchaintechnology,blockchainsystemsaredesignedtoadaptblockchainapplicationenvironments.Themodelsofpublicblockchain,consortiumblockchainandprivateblockchainareproposed,andfunctionsofblockchainareregroupedanddeployedtomakenodesplaydifferentrolesinasystem.Moreover,themultipletopologicstructuresofblockchainareproposed.Besidesthechainstructureoftraditionalblockchain,theDAGstructures,suchasTangleandLattice,areappliedtoimprovetheefficiencyofblockchainsystems.Thirdly,thispaperanalyzesthetechniquesofdistributeddatastoragemanagement,distributedqueryprocessingandoptimizationusedinblockchainsystemsanddiscussestheiradvantagesanddisadvantages.Specifically,thedatastoragetechniquesofexistingblockchainsystemsaredeeplyanalyzed,includingthedatastructuresofstorage,aswellastheorganizationofdatafilesandoptimizationtechniques.Key ValuedatabasessuchasLevelDBareusuallyusedinblockchainsystemstoimprovetheefficiencyofaccessingledgerdataandstatedata.Currently,moreresearchworksfocusonusingdifferentmethods,includingdatabase,indexanddistributedstorage,tooptimizethestorageofblockchain.Thispaperalsoanalyzesvariousqueriesintheexistingblockchainsystemsandclassifiesthemintothreetypes:accountquery,transactionqueryandcontractquery.Thedistributedqueryprocessingtechniquesusedinblockchainsystemsarediscussed.Fourthly,thispaperpointsoutthechallengesanddevelopmenttrendsofdistributeddatamanagementtechniquesforblockchainsystems,includingdistributedstorageforblockchaindata,efficientandsecureconsensusmechanismforblockchaintransactions,highavailablequeryprocessing,distributedmanagementofsmartcontracts,privacyprotectionforblockchaindata,dataauditandmonitoringinblockchainsystem.Finally,thispapershowsthedistributeddatamanagementofblockchainsystemsinvariousdomain specificapplications,suchasfinance,manufacture,networkstorage,creditandotherfields.犓犲狔狑狅狉犱狊 blockchain;distributeddatamanagement;datastorage;queryprocessing1 引 言在“互联网+”应用日益普及的大环境下,大量应用需要将发生的事件、行为、状态持久地记录在分布式环境中以用于日后的查询,即进行分布式记账.分布式记账已经逐渐成为互联网应用中的一项重要功能.以电子商务交易系统为例,客户需要执行提交订单、通过电子银行向商家支付货款、从物流公司收货等操作,商家需要执行接受订单、通过物流公司发货、通过电子银行收款等操作,电子银行方需要执行从客户收款、向商家付款等操作,物流公司需要执行从商家收货、收取物流款、向客户发货等操作.客户、商家、物流公司、电子银行共四方处于一个分布式环境中,在每一个环节都需要记录相关的操作和信息.由于各方之间并不存在完全信任关系,最终以哪一方记录的账目为确认信息是一个重要的问题.传统的方法采用由电子商务交易服务平台作为公正的第三方进行统一记账,所有的交易信息的查询操作全部在这个平台上进行处理,物流公司和银行的部分数据也以接入的方式添加至交易服务平台.在这种传统集中式记账方式里,主要的交易信息存储在单一的记账方,这是一种“逻辑”上的集中式存储模式,即交易数据存储在唯一的某业务参与方并由其负责管理.集中式记账方式存在的问题包括:(1)记账方为了保证可靠性需要存储数据的多个副本,从而造成了数据存储的性能瓶颈;(2)交易数据可能被记账方篡改且无法验证,因此各参与方需要完全信任记账方;(3)记账方受到攻击后数据难以恢复.因此,传统集中式记账方式存在着存储效率低、可信性差、易受攻击等弊端.为了解决以上难题,采用分布式记账方式的比921期于 戈等:区块链系统中的分布式数据管理技术———挑战与展望特币系统(Bitcoin)[1]在2008年被首次提出,并受到广泛关注.随后,区块链技术作为比特币系统所采用的底层技术逐渐引起工业界与学术界的重视,比特币系统所具有的分布共享性、共识性、不可篡改性、可溯源性和最终一致性等特点均来源于区块链技术.在基于区块链技术的分布式记账方式中,所有参与方都可以保存一份相同的完全账本,新加入的参与方可以下载完全账本并验证账本的正确性.这种方式降低了传统集中式记账方式中记账方的多副本数据维护成本,同时参与方也可以通过访问本地数据提高访问效率.此外,在区块链系统中,交易的账目采用数字签名和加密算法处理,从而提高了系统中数据的安全性,而区块之间通过哈希值串联的数据关联方式和基于共识算法确认区块的数据写入机制也使得区块链上的数据极难被篡改.起初,区块链技术所支撑的比特币系统仅是一个专用的交易系统,并不支持虚拟货币交易以外的其他功能,这严重限制了区块链技术在分布式数据管理上的应用.随着区块链技术的发展,产生了大量新型区块链系统.2014年由Buterin基于区块链技术推出了以太坊(Etherum)平台[2].以太坊提供了基于智能合约的编程功能,支持区块链应用的二次开发,这标志着区块链2.0时代的诞生.超级账本(HyperledgerFabric)[3]则是基于IBM早期贡献出的OpenBlockchain为主体搭建而成的Linux基金会的区块链项目,其主要目的是发展跨行业的商用区块链平台技术.在超级账本框架中,包括了HyperledgerFabric①、HyperledgerBurrow②、HyperledgerSawtooth③和HyperledgerIroha等多个项目,构成了完整的生态环境.区块链3.0时代[4]则是将区块链技术的应用范围扩展到各类应用之中,服务领域除金融、经济之外,还包括政府、健康、科学、文化等领域.区块链技术将支持各类资产交易与登记的去中心化可信处理,并与物联网等技术融合.未来,区块链技术将会与其他新兴技术相结合用于各类应用之中,诸如区块链+科学、区块链+医疗、区块链+教育、区块链+能源等应用将会迅速发展.目前,区块链技术已应用于多个领域之中.在数字货币服务领域,支持支付、兑换、汇款、交易功能;在金融服务领域,支持清算、结算、安全监管、反洗钱等功能;在B2C服务领域,支持无人管理的商亭等新业务;在P2P租赁管理领域,支持无需中介的货物交换、租赁等共享经济新业务;在供应链管理领域,支持物理资产签名、物流跟踪和交付等功能;在知识产权保护领域,用于建立不可篡改的权利和拥有权;在征信管理领域,支持身份认证、日志审计和监管等;在溯源管理领域,支持数据鉴别与存证、防伪溯源等功能.区块链技术是一种建立在多种技术之上的分布式共享账本技术,而区块链本质上是一种多方参与共同维护的分布式数据库.相对于集中式数据库管理系统,区块链系统采用去中心化或者弱中心化的数据管理模式,没有中心节点,所有参与节点均可以存储数据,而事务的持久性则依靠参与节点共同维护的不断增长的数据链和非集中式的共识机制予以实现,保证了数据在基于验证基础上的可信性.此外,相比于传统的分布式数据库和分布式数据存储系统,区块链系统的参与节点可以获得完整的数据副本,而非部分数据的副本.区块链系统的特殊数据存储机制和一致性共识机制是其不同于传统分布式数据库系统的主要原因.区块链的数据存储结构和数据组织方式不同于其他数据存储系统.区块链将数据记录组织成区块(Block),并在每个区块的区块头中通过记录前一区块的哈希值将区块组织成链式结构.这种结构使区块链的数据存储具有不易篡改性、可溯源性和可验证性.然而,区块链的存储结构和基于密码学算法的共识机制也为数据管理带来了交易确认效率低和查询不便等诸多弊端.例如在记录交易的吞吐量方面,使用区块链技术的比特币系统仅支持每秒处理7笔交易数,并且还需要经过1小时以上时间才可以确认写到区块(相关研究表明43%的比特币交易未能在一小时内得到处理④).此外,区块链的数据记录按时间顺序存储在区块中,这为交易数据的查询处理带来了挑战,当前很多数字货币系统的查询处理都要依赖于某种键值数据库系统.其次,区块链的共识机制也不同于分布式数据库系统.区块链系统为了在P2P网络环境下保证交易操作符合事务特性,需要维护数据一致性,并避免“双重支付”(DoubleSpends)的发生,这是区块链共03计 算 机 学 报2021年①②③④HyperledgerFabric.https://www.hyperledger.org/projects/fabricHyperledgerBurrow.https://www.hyperledger.org/projects/hyperledger burrowHyperledgerSawtooth.https://www.hyperledger.org/projects/sawtoothStudy:43%ofBitcoinTransactionsAren’tProcessedafterFirstHour.2017.https://www.ccn.com/43 bitcoin transactions not processed one hour study says识机制的主要考虑的问题.同时,由于区块链网络本身是一个去中心化的网络,参与节点完全自治,并没有统一的节点负责管理和维护,为此区块链节点之间需要使用P2P技术实现数据广播以更新节点的状态信息和账本信息.区块链系统公认的基础架构模型[5]主要分为6层,本文在其基础上增加了查询层,以便对区块链系统的查询处理机制进行分析.这样,区块链系统架构扩展为7层,如图1所示,主要包括:(1)应用层.基于区块链的各类应用,如数字货币、区块链金融、区块链征信等;(2)查询层.实现对交易账本数据的访问和验证,以及对账号状态的查询;(3)合约层.由脚本、算法机制和智能合约所构成的可编程基础框架;(4)激励层.负责为奖励记帐工作而进行货币发行、交易费用分配任务;(5)共识层.封装网络节点的PoW、PoS、DPoS和PBFT等各类共识算法,实现分布式共识机制;(6)网络层.封装P2P组网机制,数据传播机制和数据验证机制;(7)数据层.封装底层数据区块的数据结构和加密机制.当前的区块链系统大多基于该系统架构进行实现,其中数据层、网络层、共识层和查询层是区块链系统的必要元素.现有相关工作针对区块链系统不同层次的技术和区块链在各领域上的应用进行了大量研究与综述.对于区块链系统所包含的关键技术和研究现状,以及未来的发展趋势,袁勇等人[5]在区块链的基础架构模型方面对比特币的原理和技术进行了系统的阐述,何蒲等人[6]结合比特币系统介绍了区块链的概念和技术,并对前景进行了展望,邵奇峰等人[7]对比特币、以太坊和超级账本等多个区块链平台进行分析,总结了区块链的优势、劣势和发展趋势.在应用层方面,文献[8]对区块链在数字货币上的应用进行了全面的综述,刘敖迪等人[9]介绍了区块链技术在信息安全领域的研究现状和进展.由于区块链具有健壮的数据存储能力,因此相关研究工作在数据存储系统上进行区块链技术的应用[10 11].对于合约层,贺海武等人[12]结合多个领域应用场景对智能合约技术的概念、关键技术和面临的问题进行了阐述.此外,对于共识层、网络层和数据层,已有研究分别对区块链系统的共识机制[13 14]、安全机制[15 16]、网络协议[17]、可信数据管理[18]和查询处理[19]进行了整理和综述.区块链在设计之初就是以进行防篡改的数据存储和管理为目的,分布式数据管理是区块链系统的主要功能之一.区块链技术中涉及分布式数据管理的部分主要集中在区块链架构的查询层、合约层、网络层和数据层,其中查询层和合约层在区块链系统中负责实现对数据的处理操作,如图1所示.本文主要以分布式数据管理为视角,基于对当前主流的区块链系统分析,对比不同区块链系统在数据管理上的差异,对其中分布式数据管理所涉及的数据存储技术、查询处理机制和算法进行阐述和分析,并对区块链研究中涉及分布式数据管理的挑战进行探讨,对各领域的应用进行展望.本文第2节对区块链系统的分布式数据管理机制进行分析,对比区块链系统和传统分布式数据管131期于 戈等:区块链系统中的分布式数据管理技术———挑战与展望理系统的异同;第3节介绍区块链系统的分类;第4节介绍区块链系统中的数据存储技术,包括物理存储结构,对比不同区块链系统在物理存储机制上的差异,以及区块链系统所采用的数据存储优化技术;第5节介绍区块链系统的数据查询处理技术;第6节探讨区块链系统在分布式数据管理方面所面临的研究挑战和发展方向;第7节展望区块链所支持领域应用的场景和待解决的问题;第8节总结全文.2 区块链系统的分布式数据管理区块链系统作为一种分布式数据库管理系统,主要以解决数字货币的货币转移、兑换和支付功能而被提出.区块链的特征主要体现在数据的公开透明、不可篡改和网络结构的去中心化等几个方面.由于区块链主要面向的是不可信数据存储环境下的记账应用,因此在数据存储上采用了去中心化、全副本的分布式方式,即所有参与方均通过P2P网络结构连接,并可以存储完整的共享账本.由此可见,区块链系统在管理交易记账上虽然使用了分布式数据管理方式,但与传统的集中式数据管理和分布式数据库系统管理数据的方式均有所差别.本节主要将区块链系统与传统数据管理方式进行对比和分析,并阐述彼此间的共同点和差异性.图2 记账业务流程对比2 1 区块链与传统分布式数据库的共同点区块链技术主要是针对现有金融机构的集中式记账系统的信任问题而被提出的,其本身是由分布式存储、P2P网络、加密算法、共识机制等多种技术所构成的.中本聪基于区块链技术设计并发行了数字货币“比特币”,用以解决美国次贷危机中所展现的金融机构信任问题.相比于金融机构的集中式记账系统,基于区块链技术的交易记账系统具有公开透明、去中心化、可溯源查询和不可篡改等诸多的优势,从而避免了集中式记账方式中账本的真实性高度依赖于对记账方信任的弊端.这里以电子商务的交易记账应用为例,对传统基于清算中心的集中式记账方式和基于区块链的分布式记账方式的记账业务流程进行对比.传统集中式记账方式如图2(a)所示,交易相关的账目数据集中存储在清算中心的数据库中,交易的参与各方如果需要调用完整的交易信息需要访问清算中心,其弊端主要体现在完全依赖于对清算中心记账方的信任,一旦记账方失信或遭受攻击,其保存的数据也随之失去可信性.区块链的分布式记账方式如图2(b)所示,其中账本数据是整体共享的,以区块为单位通过密码学算法链接在一起,且网络中任何一个参与方均可以存储完整的共享账本副本,而数据的安全性则也是基于密码学算法予以保证.由于所有参与方均保存有共识后的共享账本,因此任何一个参与方进行双重支付或篡改账本数据的难度变得极大,从而保证账本数据在不可信环境中的可信性.区块链系统的分布式记账方式使其在数据存储管理的方式上与分布式数据库相同,即存储结构化的数据集合,这些数据逻辑上属于同一系统,物理上分布在计算机网络的各个不同场地上[17].区块链系统同样具有分布式数据库所具有的诸多特性:(1)分布性区块链系统与分布式数据库系统在数据的存储方面都是物理上分散、逻辑上统一的系统.区块链系统中具有全局统一的数据模式,数据以副本形式存储在参与节点中,每个参与节点存储的是数据模式相同且数据一致的共享账本.(2)透明性区块链系统在数据访问上具有透明性,用户看到的共享账本是全局数据模型的描述,就如同使用集中式数据库一样,在记录交易数据时也不需要考虑共享账本的存储场地和操作的执行场地.在数据复制方面,区块链系统的共享账本存储在各个参与节点上,并通过共识机制自动维护数据的一致性.23计 算 机 学 报2021年(3)自治性区块链系统的参与节点具有高度的自治性.在通信方面,参与节点可以独立地决定如何与其他参与者进行通信;在查询方面,参与节点本地就保存了完整的共享账本,可以在本地执行对账本数据的访问.(4)可伸缩性区块链系统支持参与节点规模的任意扩展.区块链系统允许参与节点在任意时刻加入和退出系统.而且,由于区块链的参与节点保存的是完整共享账本,因此对于参与节点重新加入区块链系统后,仅需要从其他节点更新缺失的区块数据即可完成数据的重新分布,不会影响整体的系统性能.2 2 区块链与传统分布式数据库的差异区块链系统原始的设计目的之一是解决非信任环境下数据的可信性问题.所谓的非信任环境是指负责数据存储的节点可能随意篡改数据而其他参与节点又无法识别,这将造成参与节点之间的互不信任问题.对于传统分布式数据库管理系统而言,系统建立在信任环境,其中参与节点采用统一管理的方式,节点之间具备完全相互信任的关系.因此区块链与传统的分布式数据库在数据管理方式上又具有显著的差异,如图3所示,具体体现在以下几个方面:(1)去中心化拓扑结构在参与节点的网络拓扑结构方面,区块链系统的去中心化结构采用了基于P2P的分布式模式,这种结构与基于P2P网络结构[20]的数据库系统(P2PDBS)[21 22]相似.如图3(b)所示,区块链节点通过通信控制器(CM)仅基于邻居地址进行通信,其加入和退出都是随意和动态的.传统分布式数据库虽然数据分布在不同的场地,但是通常采用中心化的主从结构,由全局的网络管理层存储各个局部数据库节点的地址和局部数据的模式信息,以用于查询处理时进行全局优化和调度,如图3(a)所示.(2)数据分布方式分布式数据管理的数据存储方式,通常分为两类[23]:①分割式.数据被划分成若干个不相交的分片,分别保存在不同的节点上,数据的划分方法分为水平分片和垂直分片;②复制式.同一个数据分片保存在一个以上的节点上,复制方式分为部分复制和全复制.分割式能够节省数据的存储空间,查询时需要在节点间传输数据,虽然使用半连接等算法可进行优化,但效率依然较低.复制式通过多节点的数据冗余存储可提高查询效率,但耗费存储空间且需要维护数据一致性.区块链系统的数据分布采用的是全复制式,即每个参与节点都在本地复制了具有全局模式的全部数据.因此,数据在区块链系统中是全局共享的,如图3(b)所示.相比于区块链系统,传统分布式数据库的分布方式主要基于在全局模式创建局部模式,再对数据进行垂直分片和水平分片,如图3(a)所示,每个节点存储的是全局数据分片的副本,再通过数据分片的元信息管理实现全局数据的访问和查询处理.当前很多基于分布式数据库技术的大数据存储系统,如HBase①等,均采用集中式的元信息管理节点管理数据副本的分布信息.图3 区块链系统与传统分布式数据库系统对比(3)数据查询处理区块链系统中对账本信息的查询处理通常在存331期于 戈等:区块链系统中的分布式数据管理技术———挑战与展望①ApacheHBaseReferenceGuide.http://hbase.apache.org/book.html储了完整共享数据的参与节点本地执行.由于区块数据采用基于文件的存储方式且本身缺少索引结构,因此在区块链上直接执行对账本查询只能使用顺序扫描的方式访问所有区块数据.目前区块链系统常用的查询优化方式是将账本记录存储在Key Value数据库中,以提高数据的访问效率.当前,比特币和以太坊等系统都使用了LevelDB①存储和检索数据.需要说明的是,在以太坊这类支持智能合约的第二代区块链系统中,智能合约代码的执行处理是嵌入在区块链记账功能中的.因此,对智能合约代码的调用是在所有参与进行共识验证的节点上执行.传统分布式数据库的查询处理主要基于数据副本的大小和分布场地进行优化[24],而在面向大数据的分布式数据库上则采用基于并行计算思想的查询优化方法[25].(4)数据一致性维护数据一致性是保证数据正确性和可信性的关键,区块链系统采用共识机制来保证各节点上数据的一致性.在数字货币的应用中通常采用工作量证明机制(PoW)通过算力竞争保证分布式的一致性[26],如解决基于SHA256、Ethash②等算法的数学难题,而从节约能耗的角度,则会采用权益证明机制(Proof of Stake,PoS)和授权权益证明机制(DelegatedProof of Stake,DPoS)等③方法.其中,使用工作量证明机制进行一致性维护的最大问题在于共识的效率过低,一个区块的一致性需要在其后生成一定长度的后续区块之后才能够被确认.分布式数据库系统通常采用包括实用拜占庭容错PBFT[27]、Paxos[28]、Gossip[29]、RAFT[30]等高效的算法维护数据的一致性,而这些算法也被一些面向联盟链应用的区块链系统所采用.(5)数据安全性机制区块链系统在安全性方面主要为用户提供了数据篡改验证、数据溯源和加密安全机制.数据的篡改可以通过校验前后区块的哈希值进行验证,因此要篡改数据并被所有参与者认可就需要在算力上付出高昂代价以重新生成区块,其难度相比传统的集中式和分布式数据库都要大很多.但是在数据的可访问性上,由于区块链的共享性,所有用户均可访问完整数据,而传统数据库管理系统则基于用户身份验证方式控制数据的访问.为了解决共享数据上的隐私安全性问题,区块链采用了基于非对称加密的交易方式实现匿名交易,其优点是很好地保护了用户隐私,缺点是一旦密钥丢失,用户的账号信息将无法恢复.综上所述,区块链系统相比传统分布式数据库系统,在记账方式上提供了更好的分布性、透明性和可信性,在功能上提供了防篡改验证机制和智能合约机制,因此更加适合在非可信环境下的匿名使用.另一方面,相比传统的分布式数据库系统,区块链系统在网络结构、数据存储和访问方式上也具有显著的差异.3 区块链系统的分类3 1 区块链系统部署方式的分类区块链系统根据其分布式部署方式和开放对象被划分为三种:“公有链”(PublicBlockchain)、“联盟链”(ConsortiumBlockchain)和“私有链”(PrivateBlockchain).三类区块链系统的对比如表1所示.表1 各区块链系统类型对比公有链联盟链私有链网络结构完全去中心化部分去中心化(多)可信中心节点规模无控制可控有限加入机制随时可以参加特定群体或有限第三方机构内部节点记账方任意参与节点预选节点机构内部节点数据读取任意读取受限读取受限读取共识机制容错性高、交易效率低(PoW或PoS等)容错性和交易效率适中(PBFT,RAFT)容错性低、交易效率高(Paxos,RAFT)激励机制有代币激励无代币激励无代币激励代码开放完全开源部分开源或定向开源不开源(1)公有链公有链是对所有人开放的,任何互联网用户都能够随时加入并任意读取数据,能够发送交易和参与区块的共识过程.比特币和以太坊等虚拟货币系统就是典型的公有链系统.公有链是完全去中心化的结构,其共识机制主要采用PoW、PoS或DPoS等方式,将经济奖励和加密算法验证相结合,以保证经济奖励和共识过程贡献成正比.此外,公有链中程序开发者对系统的代码是完全开源的,而且开发者无权干涉用户.在分布式数据管理方面,公有链系统的优势和缺陷主要包括以下几个方面:43计 算 机 学 报2021年①②③LevelDB.http://leveldb.org/RayJ.Ethash.https://github.com/ethereum/wiki/wiki/EthashBitshares.DelegatedProofofStake.http://docs.bits hares.org/bitshares/dpos.html。

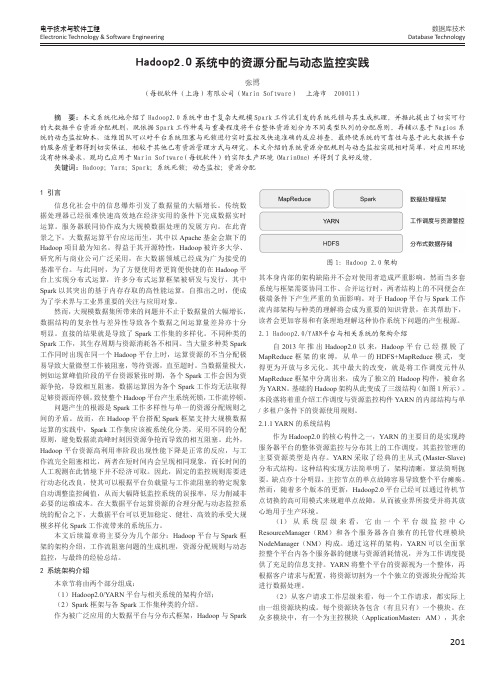

Hadoop2.0系统中的资源分配与动态监控实践

201数据库技术Database Technology电子技术与软件工程Electronic Technology & Software Engineering1 引言信息化社会中的信息爆炸引发了数据量的大幅增长。

传统数据处理器已经很难快速高效地在经济实用的条件下完成数据实时运算。

服务器联同协作成为大规模数据处理的发展方向。

在此背景之下,大数据运算平台应运而生,其中以Apache 基金会旗下的Hadoop 项目最为知名。

得益于其开源特性,Hadoop 被许多大学、研究所与商业公司广泛采用,在大数据领域已经成为广为接受的基准平台。

与此同时,为了方便使用者更简便快捷的在Hadoop 平台上实现分布式运算,许多分布式运算框架被研发与发行,其中Spark 以其突出的基于内存存取的高性能运算,自推出之时,便成为了学术界与工业界重要的关注与应用对象。

然而,大规模数据集所带来的问题并不止于数据量的大幅增长,数据结构的复杂性与差异性导致各个数据之间运算量差异亦十分明显。

直接的结果就是导致了Spark 工作集的多样化。

不同种类的Spark 工作,其生存周期与资源消耗各不相同。

当大量多种类Spark 工作同时出现在同一个Hadoop 平台上时,运算资源的不当分配极易导致大量微型工作被阻塞,等待资源,直至超时。

当数据量极大,例如运算峰值阶段的平台资源紧张时期,各个Spark 工作会因为资源争抢,导致相互阻塞,数据运算因为各个Spark 工作均无法取得足够资源而停顿,致使整个Hadoop 平台产生系统死锁,工作流停顿。

问题产生的根源是Spark 工作多样性与单一的资源分配规则之间的矛盾。

故而,在Hadoop 平台搭配Spark 框架支持大规模数据运算的实践中,Spark 工作集应该被系统化分类,采用不同的分配原则,避免数据流高峰时刻因资源争抢而导致的相互阻塞。

此外,Hadoop 平台资源高利用率阶段出现性能下降是正常的反应,与工作流完全阻塞相比,两者在短时间内会呈现相同现象,而长时间的人工观测在此情境下并不经济可取。

Hadoop在大数据处理中的应用

Hadoop在大数据处理中的应用第一章概述Hadoop是一种跨平台、开源的分布式计算框架,由Apache开发和维护。

它能够处理海量数据,帮助我们进行数据存储、管理和处理,并可以应用于数据挖掘、机器学习、网络搜索、自然语言处理等多个领域。

在大数据处理中,Hadoop起到了至关重要的作用。

第二章 Hadoop架构Hadoop的核心组件包括Hadoop Distributed File System(HDFS)和MapReduce计算模型。

HDFS是一种分布式文件系统,它能够存储海量数据,并能够在不同的计算节点上访问这些数据。

MapReduce计算模型是用于分布式处理数据的一种编程模型。

它能够将任务分解为多个子任务,并将它们分发到不同的计算节点进行计算,最后将结果汇总。

除了核心组件之外,Hadoop还包括许多其他组件,例如YARN资源管理器,它管理计算集群的资源分配。

此外,Hadoop还支持许多数据处理工具,例如Hive,用于SQL查询,Pig,用于数据处理和清洗,以及Spark,用于迭代式计算和数据分析。

第三章 Hadoop的优势Hadoop在大数据处理中的优势主要体现在以下几个方面:1.可扩展性:Hadoop可以通过添加更多的计算节点来扩展性能,因此可以处理多达数百TB的数据。

2.价格效益:开源和“共享”模式使得Hadoop成本低廉,同时也让更多的开发人员可以了解和使用这种技术。

3.可靠性:Hadoop在其HDFS上使用数据备份技术,从而提高了数据的可靠性和可恢复性。

4.灵活性:Hadoop可以与多种数据处理工具和技术集成,使其具有更广泛的适用性。

第四章 Hadoop的应用Hadoop已在许多领域得到广泛应用,包括以下几个方面:1.数据挖掘和分析:Hadoop可以帮助在海量数据中找到有价值的信息。

许多公司使用Hadoop进行大规模数据挖掘和分析,以生成报告和动态信息图表。

2.机器学习:Hadoop可以在分析海量数据的基础上学习新的数据模式,从而提高预测准确性,这在电子商务和金融领域非常有用。

hadoop大数据处理与存储技术书

《Hadoop大数据处理与存储技术》是一本涵盖了Hadoop全方位知识的权威专著,旨在帮助读者深入了解Hadoop大数据处理与存储技术,熟悉Hadoop评台的搭建、维护和应用。

本书将系统介绍Hadoop的原理、架构和应用,帮助读者掌握Hadoop的相关技术,从而提高大数据处理和存储的能力。

一、Hadoop介绍Hadoop是一个开源的分布式存储和处理大数据的框架。

它由Apache基金会开发,使用Java编程语言。

Hadoop能够高效地存储和处理大规模数据,其核心架构包括HDFS分布式文件系统和MapReduce计算框架。

Hadoop的设计理念是通过横向扩展的方式,将数据和计算任务分散到集裙中的不同节点上,从而实现大规模数据的存储和处理。

二、Hadoop的原理和架构Hadoop的核心原理是分布式存储和计算。

其架构主要包括HDFS、MapReduce、YARN等模块。

HDFS是Hadoop分布式文件系统,用于存储大规模数据。

MapReduce是Hadoop的计算框架,用于并行处理数据。

YARN是Hadoop的资源管理器,用于调度集裙资源。

了解Hadoop的原理和架构,有助于读者深入理解Hadoop的工作机制和实现原理。

三、Hadoop评台的搭建和配置本书还详细介绍了如何在Linux系统上搭建、配置和管理Hadoop评台。

读者可以通过本书提供的实例和步骤,学习如何安装Hadoop集裙、配置Hadoop环境、管理Hadoop服务等操作。

本书还介绍了Hadoop的安全性和高可用性配置,帮助读者构建稳定、安全的Hadoop评台。

四、Hadoop的应用与案例分析除了理论知识,本书还针对Hadoop在实际应用中的场景进行了深入讲解。

Hadoop在企业数据分析、大规模日志处理、推荐系统、人工智能等领域的应用。

本书还通过一些经典的案例分析,展示了Hadoop在不同行业中的成功应用,帮助读者加深对Hadoop技术的理解。

基于Hadoop和双密钥的云计算数据安全存储策略设计

基于Hadoop和双密钥的云计算数据安全存储策略设计凃云杰;白杨【摘要】针对原有的Hadoop平台仅通过CRC-32循环冗余校验保证数据存储的安全性,设计了一种基于双密钥和混沌信号的云计算安全存储策略;首先,介绍了原有的Hadoop框架下的数据存储对应的文件读写过程,并基于加密机制设计了改进的Hadoop数据存储模型,然后根据云存储数据量大和响应要求及时的特点,设计了一种基于双密钥的改进对称密钥算法,在传统的私钥的基础上加入动态公钥,并作为敏感函数的输入获得最终的密钥,从而实现明文的加密和密文的解密,最终定义了具体的基于Hadoop和改进双密钥对称加密算法的云计算安全存储算法;通过搭建Hadoop仿真实验平台进行实验,结果表明文中方法能有效地实现云计算环境下的安全存储,存储时间与其它方法相比少15%以上,具有安全性高和存储效率高的优点,具有一定的优越性.【期刊名称】《计算机测量与控制》【年(卷),期】2014(022)008【总页数】3页(P2629-2631)【关键词】云计算;数据存储;安全策略;密钥【作者】凃云杰;白杨【作者单位】呼伦贝尔学院计算机科学与技术学院,内蒙古海拉尔021008;呼伦贝尔学院计算机科学与技术学院,内蒙古海拉尔021008【正文语种】中文【中图分类】TP3930 引言传统软件企业需要购买新的硬件设备和对软件进行升级[1],而业务量减少时部分基础设施硬件会闲置而造成浪费。

云计算[2-3](Cloud Computing)应运而生,云存储[4-5]即企业和个人用户将数据和服务交给第三方的云服务提供商,由云服务提供商对数据和服务进行存储、发布和维护,使得用户仅需要花费较小的代价就能弥补软硬件资源的不足,并能有效地防止数据的丢失、设备损坏和移动性弱等方面的问题。

文献[6]设计了一种基于属性加密体制的云存储模型,通过将模型分为加密、存储和解密3个阶段以充分保障模型健壮性。

文献[7-8]设计了一种分布式纠删码的安全云存储模型,通过引入纠删码技术提高模型的健壮性,能有效地规模云存储的安全风险。

云计算开源先锋Hadoop——第四届Hadoop中国云计算大会纪实

方面 说 明云计 算正 处于 热 烈发展 的 时

期 , 另 一 方 面 也 说 明 H d o 是 一 个 开 a op 源 的体 系 ,是 一 个 人 民 战争 的思 路 ,得 到 了很 多人 的 参 与 和 贡献 。

海 数 处t!, l' 机遇 挑 战 ll l P j j -

是 如何 存储 、组 织和索 引数据 的呢? 又

应 该 怎 样 搜 索和 访 问 有 价 值 的 数 据 呢 ?

程 学旗 表 示这样 大 的规 模处理 也 带来

了巨大的挑战。

大规模数据处理算法的挑战

程 学 旗 认 为 W e 规 模 的 增 长 对 数 b

据处理算法带来了极大的挑 战。他认 为

Had ooP存 在 的

挑 战

程 学 旗 认 为 类、检测等 ,数据算法也有很多 ,但是 H d o 技 术 目 前 还 是 不 够 成 熟 ,主 要 aop

这 些 算 法 能否 使 用 通 用 的 机 制 对 性 能 进 表现在三个方面:第一,在数 据存储方

行质 的改 进? 这是一个 非常大 的挑 战 。

t e Fu ur f It ne a e Cl d h t e o n er tSc l ou

些算法的理论可能很好 ,但是在 实践 中

大 会 由 中 科 院 计 算 所 副 研 究 员 Co mp tn u i g” , 他 提 到 Ha o p d o 是 未 必 能够 发挥 出作 用 。现 在 对 数 据 进 行

查 礼 主 持 , 中科 院 计 算 所 常 务 副 所 长 M a Re u e 最 佳 实 现 , 与 传 统 的 分析 的方 法包 括 密度 估计 、分 析 、分 P d c的

大数据技术及应用_东北师范大学中国大学mooc课后章节答案期末考试题库2023年

大数据技术及应用_东北师范大学中国大学mooc课后章节答案期末考试题库2023年1.关系数据库是基于行模式存储的,而HBase也是基于行模式存储的。

参考答案:错误2.对于Hive中分区的概念,下列描述错误的是()。

参考答案:分区字段只能有一个3.Action API完成返回数据集中的元素个数的操作命令是()。

参考答案:count()4.HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是()。

参考答案:一次写入,多次读写5.MapReduce作业的初始化调用的方法是()。

参考答案:JobTracker.initJob()6.下述关于 Hadoop的阐述,正确的是()。

参考答案:是一个分布式存储与分布式并行运算系统7.Hadoop是一个能够对大量数据进行分布式处理的软件框架。

参考答案:正确8.以下选项中,不是HBase添加数据需要用到的类和接口的是()。

参考答案:Scan9.关于HDFS的文件写入操作描述正确的是()。

参考答案:默认将文件块复制成三份存放10.HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是?参考答案:一次写入,多次读写11.分布式文件系统HDFS 中的 block 默认保存几份?参考答案:3 份12.Hbase是一个针对结构化数据的可申缩、高可靠,高性能、分布式和面向()的动态模式数据库。

参考答案:列13.YARN是新一代Hadoop(),用户可以运行和管理同一个物理集群机上多种作业。

参考答案:资源管理器14.HDFS采用块的概念,默认的一个块大小是64MB。

参考答案:正确15.MapReduce框架采用了Master/Slave架构,包括一个Master和若干个Slave。

Master上运行JobTracker,Slave上运行TaskTracker 。

大数据存储与管理技术应用考试 选择题 62题

1. 在大数据技术中,Hadoop的核心组件是什么?A. HDFS和YARNB. HDFS和MapReduceC. YARN和MapReduceD. HDFS、YARN和MapReduce2. 下列哪个不是NoSQL数据库的类型?A. 键值存储B. 列存储C. 文档存储D. 关系存储3. HDFS的默认块大小是多少?A. 64MBB. 128MBC. 256MBD. 1GB4. 在Hadoop生态系统中,用于数据仓库和分析的工具是?A. HiveB. PigC. SparkD. Flume5. 下列哪个技术不是用于大数据处理?A. Apache KafkaB. Apache StormC. Apache FlinkD. Apache Tomcat6. 在Spark中,用于大规模数据处理的编程模型是?A. RDDB. DataFrameC. DatasetD. GraphX7. 下列哪个是分布式文件系统的优点?A. 高可用性B. 低成本C. 易于扩展D. 所有上述选项8. 在Hadoop中,NameNode的主要功能是什么?A. 数据存储B. 数据处理C. 元数据管理D. 数据备份9. 下列哪个不是HBase的特点?A. 高可靠性B. 高性能C. 高扩展性D. 高一致性10. 在Spark中,用于实时数据处理的组件是?A. Spark SQLB. Spark StreamingC. MLlibD. GraphX11. 下列哪个是用于大数据集的内存计算平台?A. HadoopB. SparkC. FlinkD. Storm12. 在Hadoop中,用于数据收集和聚合的工具是?A. FlumeB. SqoopC. OozieD. Zookeeper13. 下列哪个是用于大规模数据集的批处理框架?A. KafkaB. StormC. FlinkD. MapReduce14. 在NoSQL数据库中,CAP理论中的C代表什么?A. ConsistencyB. AvailabilityC. Partition toleranceD. Performance15. 下列哪个是用于数据仓库的工具?A. HiveB. PigC. SparkD. Flink16. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX17. 下列哪个是用于实时数据流的处理框架?A. KafkaB. StormC. FlinkD. MapReduce18. 在Spark中,用于机器学习的库是?A. Spark SQLB. Spark StreamingC. MLlibD. GraphX19. 下列哪个是用于数据流的分布式消息系统?A. KafkaB. StormC. FlinkD. MapReduce20. 在Hadoop中,用于任务调度和集群管理的工具是?A. YARNB. HDFSC. MapReduceD. Zookeeper21. 下列哪个是用于数据集成的工具?A. FlumeB. SqoopC. OozieD. Zookeeper22. 在NoSQL数据库中,BASE理论中的B代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing23. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce24. 在Hadoop中,用于数据存储的文件系统是?A. HDFSB. YARNC. MapReduceD. Zookeeper25. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce26. 在Spark中,用于图处理的库是?A. Spark SQLB. Spark StreamingC. MLlibD. GraphX27. 下列哪个是用于数据处理的批处理框架?A. KafkaB. StormC. FlinkD. MapReduce28. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX29. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce30. 在NoSQL数据库中,BASE理论中的A代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing31. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce32. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX33. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce34. 在NoSQL数据库中,BASE理论中的S代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing35. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce36. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX37. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce38. 在NoSQL数据库中,BASE理论中的E代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing39. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce40. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX41. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce42. 在NoSQL数据库中,BASE理论中的B代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing43. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce44. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX45. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce46. 在NoSQL数据库中,BASE理论中的A代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing47. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce48. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX49. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce50. 在NoSQL数据库中,BASE理论中的S代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing51. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce52. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX53. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce54. 在NoSQL数据库中,BASE理论中的E代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing55. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce56. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX57. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce58. 在NoSQL数据库中,BASE理论中的B代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing59. 下列哪个是用于数据处理的实时计算框架?A. KafkaB. StormC. FlinkD. MapReduce60. 在Hadoop中,用于数据处理的编程模型是?A. RDDB. DataFrameC. MapReduceD. GraphX61. 下列哪个是用于数据处理的分布式计算框架?A. KafkaB. StormC. FlinkD. MapReduce62. 在NoSQL数据库中,BASE理论中的A代表什么?A. Basically AvailableB. Soft stateC. Eventual consistencyD. Batch processing答案:1. D2. D3. B4. A5. D6. A7. D8. C9. D10. B12. A13. D14. A15. A16. C17. B18. C19. A20. A21. B22. A23. D24. A25. B26. D27. D28. C29. D30. B31. B32. C33. D34. B35. B36. C37. D38. C39. B40. C41. D42. A43. B44. C45. D46. A47. B48. C49. D50. B51. B52. C53. D54. C55. B56. C57. D58. A59. B60. C62. A。

大数据平台运维与监控考试 选择题 60题

1. 在大数据平台中,Hadoop的核心组件是:A) HBaseB) HiveC) HDFS和MapReduceD) ZooKeeper2. 下列哪个不是Hadoop生态系统中的组件?A) SparkB) CassandraC) FlumeD) Oozie3. 在Hadoop中,NameNode的主要功能是:A) 存储数据B) 管理文件系统的命名空间C) 执行数据计算D) 监控集群状态4. HDFS的数据块默认大小是:A) 64MBB) 128MBC) 256MBD) 128KB5. 在Hadoop集群中,DataNode的主要职责是:A) 存储数据块B) 管理文件系统的命名空间C) 执行数据计算D) 监控集群状态6. 下列哪个工具可以用于Hadoop集群的数据导入?A) SqoopB) PigC) MahoutD) Tez7. Hive是基于Hadoop的一个:A) 数据仓库工具B) 数据处理工具C) 数据分析工具D) 数据存储工具8. 在Hive中,用于定义和管理表结构的组件是:A) HCatalogB) HiveQLC) MetastoreD) WebHCat9. Spark的核心组件是:A) Spark SQLB) Spark StreamingC) MLlibD) Spark Core10. 在Spark中,RDD的全称是:A) Resilient Distributed DatasetB) Relational Distributed DatabaseC) Remote Distributed DataD) Real-time Distributed Data11. 下列哪个不是Spark的组件?A) GraphXB) TachyonC) FlinkD) SparkR12. 在Spark中,用于实时数据处理的组件是:A) Spark SQLB) Spark StreamingC) MLlibD) GraphX13. Kafka是一个:A) 分布式消息系统B) 数据仓库C) 数据处理框架D) 数据分析工具14. 在Kafka中,消息的持久化是通过什么实现的?A) 内存B) 磁盘C) 缓存D) 网络15. 下列哪个工具可以用于Kafka集群的管理?A) Kafka ManagerB) Kafka ConnectC) Kafka StreamsD) Kafka MirrorMaker16. Zookeeper在Hadoop集群中的主要作用是:A) 数据存储B) 协调服务C) 数据处理D) 数据分析17. 在Zookeeper中,znode的类型不包括:A) 持久节点B) 临时节点C) 顺序节点D) 循环节点18. 下列哪个不是Zookeeper的应用场景?A) 分布式锁B) 配置管理C) 命名服务D) 数据备份19. 在Hadoop集群中,用于监控集群状态的工具是:A) AmbariB) GangliaC) NagiosD) Cloudera Manager20. 下列哪个工具可以用于Hadoop集群的性能监控?A) HBaseB) HiveC) FlumeD) Ganglia21. 在Hadoop集群中,用于日志收集和分析的工具是:A) FlumeB) SqoopC) OozieD) Hue22. 下列哪个工具可以用于Hadoop集群的任务调度?A) OozieB) HueC) FlumeD) Sqoop23. 在Hadoop集群中,用于数据清洗和转换的工具是:A) PigB) HiveC) MahoutD) Tez24. 下列哪个工具可以用于Hadoop集群的数据分析?A) MahoutB) HueD) Sqoop25. 在Hadoop集群中,用于机器学习的工具是:A) MahoutB) HueC) FlumeD) Sqoop26. 下列哪个工具可以用于Hadoop集群的图形处理?A) GraphXB) HueC) FlumeD) Sqoop27. 在Hadoop集群中,用于交互式查询的工具是:A) HueB) HiveC) PigD) Tez28. 下列哪个工具可以用于Hadoop集群的数据可视化?A) HueB) HiveC) PigD) Tez29. 在Hadoop集群中,用于数据仓库管理的工具是:A) HCatalogB) HueC) FlumeD) Sqoop30. 下列哪个工具可以用于Hadoop集群的数据导入导出?A) SqoopB) HueC) FlumeD) Oozie31. 在Hadoop集群中,用于数据流处理的工具是:A) FlumeB) SqoopC) OozieD) Hue32. 下列哪个工具可以用于Hadoop集群的数据同步?A) Kafka MirrorMakerB) HueD) Sqoop33. 在Hadoop集群中,用于数据实时处理的工具是:A) Spark StreamingB) HueC) FlumeD) Sqoop34. 下列哪个工具可以用于Hadoop集群的数据流分析?A) Kafka StreamsB) HueC) FlumeD) Sqoop35. 在Hadoop集群中,用于数据仓库查询的工具是:A) HiveB) HueC) FlumeD) Sqoop36. 下列哪个工具可以用于Hadoop集群的数据处理?A) PigB) HueC) FlumeD) Sqoop37. 在Hadoop集群中,用于数据分析的工具是:A) MahoutB) HueC) FlumeD) Sqoop38. 下列哪个工具可以用于Hadoop集群的图形计算?A) GraphXB) HueC) FlumeD) Sqoop39. 在Hadoop集群中,用于数据仓库管理的工具是:A) HCatalogB) HueC) FlumeD) Sqoop40. 下列哪个工具可以用于Hadoop集群的数据导入导出?A) SqoopB) HueD) Oozie41. 在Hadoop集群中,用于数据流处理的工具是:A) FlumeB) SqoopC) OozieD) Hue42. 下列哪个工具可以用于Hadoop集群的数据同步?A) Kafka MirrorMakerB) HueC) FlumeD) Sqoop43. 在Hadoop集群中,用于数据实时处理的工具是:A) Spark StreamingB) HueC) FlumeD) Sqoop44. 下列哪个工具可以用于Hadoop集群的数据流分析?A) Kafka StreamsB) HueC) FlumeD) Sqoop45. 在Hadoop集群中,用于数据仓库查询的工具是:A) HiveB) HueC) FlumeD) Sqoop46. 下列哪个工具可以用于Hadoop集群的数据处理?A) PigB) HueC) FlumeD) Sqoop47. 在Hadoop集群中,用于数据分析的工具是:A) MahoutB) HueC) FlumeD) Sqoop48. 下列哪个工具可以用于Hadoop集群的图形计算?A) GraphXB) HueD) Sqoop49. 在Hadoop集群中,用于数据仓库管理的工具是:A) HCatalogB) HueC) FlumeD) Sqoop50. 下列哪个工具可以用于Hadoop集群的数据导入导出?A) SqoopB) HueC) FlumeD) Oozie51. 在Hadoop集群中,用于数据流处理的工具是:A) FlumeB) SqoopC) OozieD) Hue52. 下列哪个工具可以用于Hadoop集群的数据同步?A) Kafka MirrorMakerB) HueC) FlumeD) Sqoop53. 在Hadoop集群中,用于数据实时处理的工具是:A) Spark StreamingB) HueC) FlumeD) Sqoop54. 下列哪个工具可以用于Hadoop集群的数据流分析?A) Kafka StreamsB) HueC) FlumeD) Sqoop55. 在Hadoop集群中,用于数据仓库查询的工具是:A) HiveB) HueC) FlumeD) Sqoop56. 下列哪个工具可以用于Hadoop集群的数据处理?A) PigB) HueD) Sqoop57. 在Hadoop集群中,用于数据分析的工具是:A) MahoutB) HueC) FlumeD) Sqoop58. 下列哪个工具可以用于Hadoop集群的图形计算?A) GraphXB) HueC) FlumeD) Sqoop59. 在Hadoop集群中,用于数据仓库管理的工具是:A) HCatalogB) HueC) FlumeD) Sqoop60. 下列哪个工具可以用于Hadoop集群的数据导入导出?A) SqoopB) HueC) FlumeD) Oozie答案:1. C2. B3. B4. B5. A6. A7. A8. C9. D10. A11. C12. B13. A14. B15. A16. B17. D18. D19. A20. D21. A22. A23. A24. A25. A26. A27. A28. A29. A30. A31. A32. A33. A34. A35. A36. A37. A38. A39. A40. A41. A42. A43. A44. A45. A46. A47. A48. A49. A50. A51. A52. A53. A54. A55. A56. A57. A58. A59. A60. A。

大数据处理中的常用工具和技术

大数据处理中的常用工具和技术随着互联网的快速发展,大数据处理已经成为了一个热门的话题。

在日常生活中,我们不断产生的数据量无处不在,如何有效地处理和分析这些海量数据成为了一个重要的挑战。

在大数据处理中,有许多常用的工具和技术可以帮助我们更好地处理和分析数据。

接下来,我将介绍一些常见的工具和技术。

1. Hadoop: Hadoop是一个开源的分布式计算平台,可以用于存储和处理大规模的数据。

它基于MapReduce算法,分为HDFS(Hadoop分布式文件系统)和MapReduce两个主要组件。

Hadoop提供了高性能、高可靠性的数据处理和存储能力,被广泛应用于大数据分析中。

2. Spark: Spark是另一个流行的大数据处理框架,它提供了内存计算的能力,相比于Hadoop更快速和高效。

Spark支持多种编程语言,如Java、Scala和Python,提供了丰富的API,方便用户处理和分析大数据。

3. SQL: SQL是结构化查询语言,用于管理和操作关系型数据库。

对于大数据处理来说,SQL仍然是一种很重要的工具。

许多大数据处理框架都支持使用SQL来查询和分析数据,比如Hive和Impala。

此外,还有一些专门用于大数据处理的SQL引擎,如Apache Drill和Presto。

4. NoSQL数据库: NoSQL数据库是一种非关系型数据库,在大数据处理中得到了广泛应用。

NoSQL数据库可以存储和处理非结构化或半结构化的数据,比如文档、键值对和图数据。

常见的NoSQL数据库包括MongoDB、Cassandra和Redis。

5.数据仓库:数据仓库是一个用于存储和管理大量结构化数据的数据库系统。

数据仓库可以提供快速的数据查询和分析,它通过将数据存储在专门的硬件设备上,并使用特定的存储和索引技术,提高数据的读写性能。

常见的数据仓库包括Teradata、Snowflake和Amazon Redshift。

6.数据可视化工具:数据可视化工具用于将大数据转换为可视化图表和仪表盘,以便更直观地展示和分析数据。

淘宝大数据案例

淘宝大数据案例【篇一:淘宝大数据案例】【编者按】近两年,“大数据”这个词越来越为大众所熟悉,“大数据”一直是以高冷的形象出现在大众面前,面对大数据,相信许多人都一头雾水。

下面我们通过十个经典案例,让大家实打实触摸一把“大数据”。

你会发现它其实就在身边而且也是很有趣的。

马云说:互联网还没搞清楚的时候,移动互联就来了,移动互联还没搞清楚的时候,大数据就来了。

近两年,“大数据”这个词越来越为大众所熟悉,“大数据”一直是以高冷的形象出现在大众面前,面对大数据,相信许多人都一头雾水。

下面我们通过十个经典案例,让大家实打实触摸一把“大数据”。

你会发现它其实就在身边而且也是很有趣的。

啤酒与尿布全球零售业巨头沃尔玛在对消费者购物行为分析时发现,男性顾客在购买婴儿尿片时,常常会顺便搭配几瓶啤酒来犒劳自己,于是尝试推出了将啤酒和尿布摆在一起的促销手段。

没想到这个举措居然使尿布和啤酒的销量都大幅增加了。

如今,“啤酒+尿布”的数据分析成果早已成了大数据技术应用的经典案例,被人津津乐道。

数据新闻让英国撤军2010年10月23日《卫报》利用维基解密的数据做了一篇“数据新闻”。

将伊拉克战争中所有的人员伤亡情况均标注于地图之上。

地图上一个红点便代表一次死伤事件,鼠标点击红点后弹出的窗口则有详细的说明:伤亡人数、时间,造成伤亡的具体原因。

密布的红点多达39万,显得格外触目惊心。

一经刊出立即引起朝野震动,推动英国最终做出撤出驻伊拉克军队的决定。

意料之外:胸部最大的是新疆妹子淘宝数据平台显示,购买最多的文胸尺码为b罩杯。

b罩杯占比达41.45%,其中又以75b的销量最好。

其次是a罩杯,购买占比达25.26%,c罩杯只有8.96%。

在文胸颜色中,黑色最为畅销。

以省市排名,胸部最大的是新疆妹子。

qq圈子把前女友推荐给未婚妻2012年3月腾讯推出qq圈子,按共同好友的连锁反应摊开用户的人际关系网,把用户的前女友推荐给未婚妻,把同学同事朋友圈子分门别类,利用大数据处理能力给人带来“震撼”。

《大数据技术原理与操作应用》第2章习题答案

第2章课后习题答案一、单选题1.下列选项中,哪个配置文件可以配置 HDFS 地址、端口号以及临时文件目录( ) 。

A. core-site. xmlB. hdfs-site. xmlC. mapred-site. xmlD. yarn-site. xml参考答案:A2.Hadoop 集群启动成功后,用于监控 HDFS 集群的端口是(A. 50010B. 50075C. 8485D. 50070参考答案:D3.下列选项中,可以进行重启引导系统的是( ) 。

A. OKB. CancelC. RebootD. Apply参考答案:C4.下列选项中,关于 SSH 服务说法正确的是( ) 。

A. SSH 服务是一种传输协议B. SSH 服务是一种通信协议C. SSH 服务是一种数据包协议D. SSH 服务是一种网络安全协议参考答案:D5.下列选项中,一键启动 HDFS 集群的命令是( ) 。

A. start-namenode. shB. start-datanode. shC. start-dfs. shD. start-slave. sh参考答案:C6.在 Hadoop 的解压目录下,可以查看 Hadoop 的目录结构的命令是() 。

A. jpsB. llC. tarD. find参考答案:B7.下列选项中,存放 Hadoop 配置文件的目录是( )A. includeB. binC. libexeD. etc参考答案:D8. 在配置 Linux 网络参数时,固定 IP 地址是将路由协议配置为( ) 。

A. staticB. dynamicC. immutableD. variable参考答案:A9.下列选项中,可以对 Hadoop 集群进行格式化的是(A. hadoop namenode -formatB. hadoop namenode -lsC. hdfs datanode -lsD. hdfs datanode -format参考答案:A10.下列选项中,查看 Linux 系统的 IP 配置的命令是( ) 。

hadoop应用的期末考试题目及答案

hadoop应用的期末考试题目及答案一、选择题(每题2分,共10分)1. Hadoop的HDFS是一种()。

A. 文件系统B. 数据库C. 缓存系统D. 操作系统答案:A2. Hadoop生态系统中,用于数据仓库的组件是()。

A. HBaseB. HiveC. PigD. Sqoop答案:B3. Hadoop的MapReduce编程模型中,Map阶段的主要任务是()。

A. 数据排序B. 数据合并C. 数据分发D. 数据处理答案:D4. Hadoop中,NameNode和DataNode分别负责()。

A. 数据存储和数据管理B. 数据管理C. 数据存储D. 数据存储和任务调度答案:A5. Hadoop的YARN是用于()。

A. 数据存储B. 数据处理C. 任务调度D. 数据传输答案:C二、填空题(每题2分,共10分)1. Hadoop的HDFS设计用于存储大规模数据集,其默认的副本因子是________。

答案:32. Hadoop的MapReduce框架中,Map任务的输出会经过________阶段,然后传递给Reduce任务。

答案:Shuffle and Sort3. Hadoop生态系统中,________组件用于处理实时数据流。

答案:Apache Storm4. Hadoop的HDFS支持________,允许用户在文件系统中存储多个版本的文件。

答案:Snapshot5. Hadoop的YARN中的________负责监控所有集群节点上的资源使用情况。

答案:ResourceManager三、简答题(每题10分,共30分)1. 简述Hadoop的HDFS的架构特点。

答案:Hadoop的HDFS(Hadoop Distributed File System)是一个分布式文件系统,设计用于存储大规模数据集。

它具有以下特点:- 高容错性:通过在多个节点上存储数据副本来实现。

- 高吞吐量:适用于大规模数据集的访问。

云计算之Hadoop专场

云计算大数据之Hadoop专场在这个信息迅速发展的时代,数据已经成为当今企业的核心竞争力,拥有大数据并有效地进行使用和运营成为企业通往成功之路的必不可少的要素。

中国电子学会为了更好地交流云计算大数据的实践经验,进一步推进云计算技术创新和大数据应用,展示国内外云计算、大数据领域的最新成果,将于2014年5月20-23日在北京举办“第六届中国云计算大会”。

Hadoop作为迅猛发展的大数据开源技术、计算大数据的核心技术必然会成为重头戏。

Hadoop 是一个能够对大量数据进行分布式处理的软件框架。

但是 Hadoop 是以一种可靠、高效、可伸缩的方式进行处理的。

Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。

Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。

Hadoop 还是可伸缩的,能够处理 PB 级数据。

此外,Hadoop 依赖于社区服务器,因此它的成本比较低,任何人都可以使用Hadoop所提供的实用、经济有效、可扩展的架构,对累积了海量数据资产的企业来说意义非凡,它可以在商业服务器集群上分布数据和执行并行处理,侦测和处理对于分布式处理至关重要的故障,帮助企业存储、管理和处理海量数据,引起了业界的广泛兴趣和投资,形成了包括开源软件和商业化软件的整个生态系统。

据泰一舆情监测系统监测,5月8日由英特尔公司和Cloudera公司联合举办的主题为“强强联手聚焦中国领航大数据”的合作启动仪式暨新闻发布会,继7日于上海成功召开后,今日到访北京。

双方宣布将不断加强战略合作伙伴关系,开展协作创新,进一步推动中国大数据技术和产业发展,更好的服务中国市场和用户。

通过在中国建立其业务机构以提供更高效的软、硬件大数据解决方案和相关支持。

安全狗创始人陈奋在接受采访时称其公司从一开始就非常重视安全数据的积累,目前日均拦截的攻击日志超过亿次。

DTCC2014:大云Hadoop平台及应用-王宝晗_IT168文库

查询能力

SQL引擎

Scan

MR

适应运营商场景 的多种存储引擎 支持

监控/管理

元数据存储

索引存储

TextFile Hfile RCFile HBase

存储引擎

数据存储

基础存储部件选 择

分布式文件系统

分布式KV-Store

关系型数据库

HDFS

HBase

MySQL

• • •

支持数据的IUD操作 HBase存储引擎:支持同一份数据进行实时查询和统计分析:Hive直接读Hfile进行统计,通过HBase实时查询 Join优化:按照join key将两个表的数据存储在同一个HBase Table的不同column.

并行 数据ETL

BC-BSP

并行 数据探索

并行 数据挖掘

社交 用户权限管 网络分析 理

HugeTable

任 务 数据分割 子任 务 任务分解

block3

PC节点

MapReduce

M1 M2 Mi R1 R2 Rj

…

元数据服务器

M2

block2

PC节点

… …

分布式集群 管理服务器

任务分发服务器

block1 block2

120 100 80 60 40 20 0 流程3 流程4 流程5 流程6 流程7 现网时间(min) HIVE时间(min) MR时间

现网时间 云ETL时 (min) 间(min) MR时间 流程3 流程4 流程5 流程6 流程7 90 130 60 80 130 10 59 14 25 47 无 40 无 无 无

Superstep 1-n

Result files

/cmri/

一种多粒度集群数据库并发控制新算法

一种多粒度集群数据库并发控制新算法王大海;贾玉珍;靳冰【摘要】为保证集群系统中全局事务的并发正确执行,采用基于谓词级的多级粒度冲突检测机制,并通过检测谓词冲突图中是否存在环的方法来避免冲突的全局事务可能会产生的全局死锁,不仅减小了死锁检测粒度,而且还提高了全局事务处理的并发度,同时也保持了集群中局部数据库的自治性.此外,还改进了一种以事务提交图为中心的并发事务调度算法来保证全局事务的可串行化提交,实验结果表明,该算法有效地提高了全局事务执行的并发度,增加了事务吞吐率和减少了响应时间.【期刊名称】《河北工程大学学报(自然科学版)》【年(卷),期】2010(027)004【总页数】6页(P86-91)【关键词】集群系统;多级粒度冲突检测;死锁【作者】王大海;贾玉珍;靳冰【作者单位】新乡职业技术学院,河南,新乡,453000;南阳理工学院,软件学院,河南,南阳,473004;南阳理工学院,软件学院,河南,南阳,473004【正文语种】中文【中图分类】TP391数据库集群系统以集群技术与数据库系统相结合,是一组完整的、自治的计算处理单元,每个节点均有独自的CPU、内存以及磁盘等硬件资源,运行独立的操作系统和自治的数据库系统,通过高速专用网络或商业通用网络互连,彼此协同计算,作为统一的数据库系统提供并行事务处理服务[1]。

近年来,集群系统中的负载平衡问题受到人们的关注。

负载平衡包含许多因素,例如系统结构[2]、算法[3]、资源管理[4]和数据分布[5]以及负载应用类型[3]等都会影响系统的性能平衡。

为了保证全局事务执行的正确性和一致性,本文在研究数据库集群中的事务并发控制方法的基础上,提出了一种多粒度的冲突判断和死锁检测方法,使事务并发控制的粒度达到谓词级,并讨论各种谓词的提取方法,既提高全局事务处理效率,又不需要对局部数据库做任何限制。

本文还改进了一种以事务提交图为中心的并发事务调度算法来保证集群系统中全局事务的可串行化提交,以增加吞吐率和减少响应时间。

SQL Server数据库的应用级持续数据保护系统

SQL Server数据库的应用级持续数据保护系统①王蒙蒙1, 邬玉良2, 张铁峰11(华北电力大学电气与电子工程学院, 保定071003)2(北京中科同向信息技术有限公司, 北京100086)摘要: 针对传统数据容灾系统备份窗口大、容灾等级低等问题, 提出并设计了与SQL Server数据库相结合的应用级持续数据保护容灾系统. 系统通过SQL Server提供的应用程序接口API, 读取数据库事务日志变化, 从而实时捕获数据库数据变化, 将捕获的数据变化以日志的形式缓存并传送到异地进行操作重放, 实现异地远程容灾. 当发生灾难时利用心跳检测、IP浮动等技术进行远程异地接管; 当发生误操作时可根据日志文件恢复到之前的任意时间点, 有效应对人为或意外造成的数据丢失和损坏关键词: 事务日志; 变动数据捕获; 持续数据保护; 容灾Application-Level Continuous Data Protection System for SQL Server DatabaseWANG Meng-Meng1, WU Yu-Liang2, ZHANG Tie-Feng11(School of Electric and Electronic Engineering, North China Electric Power University, Baoding 071003, China)2(Beijing HeartsOne Technology Company, Beijing 100086, China)Abstract: To solve the problems of traditional data disaster recovery system with large backup window and low disaster immunity, an application-level continuous data protection disaster recovery system combined with SQL Server database is introduced and designed. Application program interface provided by SQL Server is used to read the database transaction log file in the system, then date changes are captured online. The captured data change is recorded in log file and stored in cache-quene. It will be sent to other places to achieve remote offsite disaster recovery. When a disaster occurs, the system uses heartbeat detection, floating IP technologies to take over the broken system. When a malfunction occurs, the system can return to any time point according to the log file. So the system can effectively avoid data loss which caused by man-made or accident.Key words: transaction log file; change data capture; continuous data protection; disaster recovery随着计算机技术的发展、信息化程度的不断深入, 数据库作为企事业单位存放数据的主要管理系统逐渐普及, 其对数据安全的保障关系着企业的利益和生命. 目前造成数据丢失的原因[1]主要有以下几种: 硬件故障、软件故障、人为误操作、病毒入侵以及不可抗拒的自然灾害. 针对硬件故障, 目前主要采取RAID[2]磁盘保护技术避免磁盘故障带来的数据丢失; 针对软件故障、人为误操作以及病毒入侵, 目前主要通过传统的数据保护技术如备份、复制、快照等方式进行; 针对人为不可抗拒的自然灾害, 目前主要利用现有的备①收稿时间:2014-06-09;收到修改稿时间:2014-07-07份手段结合网络或人工方式建立异地容灾中心, 以防止自然灾害发生时的数据丢失及应用中断.传统的数据库保护技术, 无论备份方式是热备份, 还是冷备份; 备份策略是全备份、增量备份、异地备份或备份策略的组合; 备份地点无论是本机备份还是异地远程备份; 备份手段是采用镜像或快照等技术, 备份的基本思想都是周期性备份[3]. 当灾难发生时, 备份只能恢复到前一次备份的时间点, 造成数据或多或少的丢失. 定时周期太长灾难发生时, 会丢失大量的数据. 定时周期太小, 又会因为备份动作的频繁操作, 造成系统的负担和内存资源的浪费.针对以上缺点, 本文将SQL Server数据库管理系统与持续数据保护系统相结合, 利用数据库事务日志捕获本机数据库变动, 将数据实时传送到备份机, 并实时写入所备份的数据库日志中, 利用数据库管理系统重做日志文件更改机制, 实现数据的实时同步; 当本机宕机或网络中断时, 备份机利用IP浮动技术, 接管主机IP继续对外提供服务, 有效保证了业务的连续性, 提高了系统容灾的等级.1持续数据保护系统概述1.1 CDP的概念及发展历程CDP是针对传统数据备份容灾系统无法对数据进行持续的保护, 细粒度的备份和恢复而提出的一种可持续的数据备份和恢复技术, 这个概念最初产生于2005年左右. 全球网络存储工业协会(SNIA)作为研究CDP的重要机构, 从2005年开始着手研究CDP, 历时几年后, 出台了一份研究文档[4], 明确给出了CDP的定义. CDP至少要满足三个条件, 第一、数据有变化就备份. 第二、能够备份到本机以外的其他地方. 第三、能够恢复到任意时间点, 实现数据的零丢失, 零窗口备份. CDP突破了传统数据保护技术, 为恢复对象提供足够细的备份和恢复粒度, 实现几乎任意时间点的数据恢复, 管理者不必关心备份过程中数据的变化, 从而实现对动态数据的自动保护.1.2 CDP的研究现状及目前存在的问题CDP从诞生之日迅速成为研究的热点, CDP系统按实现层次可以分为文件级CDP、块级CDP和应用级CDP[5]. 文件级CDP[6], 部署在文件系统上, 利用文件过滤驱动程序捕获被保护文件或目录文件数据的变化; 块级CDP部署在系统的块设备驱动层, 利用磁盘过滤驱动程序实时捕获磁盘的每一个写操作; 应用级CDP 利用所保护应用自身的机制, 如数据库可利用事务日志文件捕获变动数据.由于文件级和块级CDP通用性较好, 目前国内外的研究主要集中在文件级和块级实现CDP.文件级CDP目前存在的问题在于无法跨越不同的系统平台, 而且对于数据库文件而言, 由于数据库系统自身的特点, 使得其与普通文件在本质上存在着区别, 利用普通文件分析方式分析数据库文件, 难以保证数据库元数据与备份数据的一致性以及备份数据的可用性.块级CDP系统采取的备份策略和机制需要在本机和备份机之间传输大量的数据, 其对存储系统的开销巨大, 恢复时间长. 目前为了减少存储系统开销的问题, 研究集中在优化存储策略, 改进压缩算法(如异或算法或引入重复数据删除技术)[7], 但采用压缩机制后虽然减少了存储开销, 但系统恢复时需要对压缩数据进行反操作, 这在一定程度上增加了数据恢复的时间, 无法达到两全其美的效果, 使得目前块级CDP研究趋于瓶颈.应用级CDP将CDP系统与具体的应用相结合, 利用应用自身的特点建立相应的变动数据捕获和恢复机制, 有效避免了文件级和块级CDP存在的问题, 并保证了备份数据的一致性. 与具体应用紧密结合, 用户管理更加方便灵活同时降低了部署和实施的难度. 由于应用级CDP仅对某一具体应用有效且通用性较差, 目前研究较少, 且就数据库系统而言, 有深刻的研究意义.2系统架构本论文提出的CDP容灾系统建立在SQL Server 这一具体应用之上, 利用数据库事务日志, 捕获数据库数据变化; 通过日志记录数据库数据变化, 为数据恢复提供依据; 将数据实时传送到异地重放, 实现应用级容灾; 通过IP浮动保证灾难后业务的不中断. 系统结构如图1所示.图1 数据库容灾系统框图该方案应用场景为双机场景, 一台为主机, 一台为从机, 两台机子上装有相同的系统和数据库. 主机上主要部署的模块为变动数据捕获模块、读/写模块、缓存模块和SOCKET通信模块; 从机上部署的模块有SOCKET通信模块、缓存模块、读/写模块、接管模块和数据恢复模块. 正常情况下, 主机通过变动数据捕获模块定位主机上数据库数据的变化, 利用读/写模块读取变化, 并将其存入缓存队列等待传送, 传送模块将缓存模块中的数据打包经TCP/IP链路传送到异地的从机上, 从机接收数据后, 一方面将数据实时写入与主站路径一致的数据库管理系统默认数据目录中的数据库文件中, 另一方面将数据库初始完整备份写入设定的备份目录中, 将后续捕获的数据变动写入cdp_change, 并在cdp_log文件中记录相关信息, 供数据恢复时使用. 备份过程数据流向如图1中①号线路所示. 当发生人为误操作或软件故障、病毒入侵等造成的错误数据传入时, 可利用从机上的数据恢复模块将数据恢复到错误之前的时间点. 数据恢复和回退过程如图1中③号线路所示. 当发生不可抗拒的自然灾害, 如地震、火灾时, 可利用从机上的接管模块, 通过图1中的②号线路实时监听主从通信状态, 当主机由于上述等原因宕机或网络中断后, 从机可在设定的时间内接管主机IP使原来向主机传送的数据传送到从机, 从而保证应用的连续性, 避免主机故障造成的应用中断.3系统的设计和实现3.1 变动数据捕获模块数据库变动数据捕获的主要方法有以下几种[8,9]:基于快照差分的捕获方法. 基于快照差分的变动数据捕获方法是利用快照技术首先生成两个数据源的快照, 通过比较两次快照的差异计算出变动数据. 这种方式捕获效率低, 且无法达到持续保护的设计目标.基于触发器的捕获方法. 基于触发器的捕获方法是利用数据库提供的触发机制捕获变动数据, 实时性好, 但对主机数据库目前正在运行的事务影响较大.基于事务日志的捕获方法. 基于事务日志的捕获方法是利用数据库的日志机制, 分析数据库的事务日志, 得出变动数据.利用数据库自身提供的变动数据捕获方法. 这种方法仅限于部分提供该功能的数据库, 如SQL Server 2008,但之前的数据库版本并不提供该功能, 因此具有局限性, 且该方式将提取的变动数据通过在对应数据库如TEST中新建表, 在表中保存变更信息, 这同样会影响系统目前正在运行的事务.综上分析, 我们采用基于事务日志的变动数据捕获方法实时捕获数据库变动信息. 由于对于几乎所有的数据库而言, 数据写入到库过程中, 会先将操作记录在日志文件中, 随后记录到数据文件中, 所以针对数据库的应用级CDP的研究, 可以从数据库日志着手捕获变动数据. 对于SQL Server数据库管理系统, 微软虽然不提供事务日志的内部格式文档, 但是可通过应用程序接口API访问数据库事务日志信息, 如可用fn_dblog或DBCC LOG命令查看数据库的联机事务日志.基于数据库事务日志捕获数据库数据变化, 有两种方法: 一种可从DBCC[10]相关命令或函数返回的日志信息中, 得到每条日志记录信息, 分析整个事务过程中的所有的日志记录[11], 转换成对应的操作语句, 利用异地数据库加载该操作语句, 实现数据库数据同步; 另一种可从捕获到的事务记录信息上定位整个事务所在的日志段, 以及该日志段所在的数据块, 将整个事务所涉及到的数据块中的信息读取出来, 在异地将这些信息写入数据库事务日志文件的对应位置, 从而实现数据库数据同步.第一种方法由于SQL Server提供的日志信息有限, 在没有微软支持的情况下很难从捕获的十六进制的日志记录信息上分析出其对应的SQL语句, 而且由于SQL操作语句种类很多, 需要分析的工作量很大, 因此很难实现. 而第二种方法相对第一种方法可行性要强, 无需分析数据库具体进行了什么操作, 当数据库数据变化时, 只要定位准确, 将变动数据从事务日志文件中提取出来, 实时写入异地数据库日志文件中, 利用数据库管理系统自身的重做和回滚特性, 即可有效保证主从数据库数据同步的高效性和一致性. 本设计中变动数据捕获模块采用的即是第二种方法.变动数据捕获模块又可细化如图2.图2 变动数据捕获模块结构图3.1.1 数据库连接通过ADO 方式连接数据库. ADO 是Microsoft 数据库应用程序开发的新接口, 是微软最新的数据访问技术. 其简化了数据访问的过程, 增加了数据访问的灵活性, 是当前数据访问接口的主流技术. ADO 库包含三个基本接口:_ConnectionPtr 接口、_CommandPtr 接口和_RecordsetPtr 接口.在VC 中使用ADO 访问数据库基本过程是:1) 初始化COM 库, 引入ADO 库文件. 2) 创建连接对象.m_pConn.CreateInstance("ADODB.Connection"); 3)连接数据库. m_pConn->Open((_bstr_t)strConn,"","", adModeUnknown);4)执行SQL 语句, 返回查询信息._RecordsetPtr& CconsqlDlg::GetRS(CString strSQL) ;5)释放连接.if(m_pConnection )m_pConnection->Close(); m_pConnection = NULL; 3.1.2变动监测SQL Server 事务日志中的每个记录都由一个日志序列号 (LSN) 唯一标识. 利用SQL Server 提供的fn_dblog()函数获得日志记录的LSN 信息, 返回大于lastLSN 的记录, 若返回为空则循环比较, 判定为无数据变化, 若不为空, 则判定为有数据变化, 然后根据得到的LSN 信息, 定位事务日志文件的变化, 得到此事务包含的日志记录数目, 重新设置lastLSN. 变动监测流程如图3所示.图3 变动监测流程图3.1.3定位数据变动利用::fn_dblog(@StartingLSN, @EndingLSN), 以及dbcc loginfo 命令提取需要的信息, 定位变动数据在事务日志中的具体位置.SELECT [Current LSN],Operation, Context, [Transaction ID] from::fn_dblog (null, null) where [Current LSN] > '00000011:00000134:0009'; dbcc loginfo; 捕获信息如图4所示.图4 变动捕获实例由捕获的上述信息可定位事务日志变化部分的具体位置, 具体定位过程如下:1)首先由LSN 的3部分信息, 提取其所在的VLF 编号、起始数据块号、日志段中的SLOT 序号. 2)由dbcc loginfo 命令得到正在使用的VLF 的StartOffset, 定位到变化事务所在的VLF 的起始位置, 可记为begin vlf _.3)由1)、2)步骤得到的信息, 将得到的数据块号记为number bk _, 则日志记录所在日志段的起始位置可用以下公式计算得到.512*__number bk begin vlf +4)在日志段的起始处记录了此日志段的大小记为size block _, 由公式1512\_+size block 得到该日志段占居的数据块, 从而成功定位变动信息, 之后利用读/写模块读取变动信息. 3.2 读/写模块读/写模块主要分为两部分, 一部分为读, 一部分为写. 对于热备主机主要用于初始时刻的完整备份, 以及在变动捕获模块定位到事务日志文件中数据变化的日志段后, 利用得到的vlf_begin, 以及block_size 的两个参数, 将变化事务所在的日志段读取出来, 并写入缓存队列, 传送到异地.对于热备从机, 对于初始的完整备份,一方面写入到设定的备份目录中, 另一方面写入从机数据库管理系统的默认数据目录中; 对于后续的变动数据一方面实时写入数据管理系统默认数据目录中相应数据库事务日志文件的对应位置, 一方面写入备份目录的cdp_change文件中, 并将写入的对应位置、时间等相关信息保存在cdp_log文件中. 备份过程的数据流向如图5所示.图5 备份数据流向图其中cdp_change文件为只追加文件, 将变动数据依次写入文件中. cdp_log目录记录变动数据的对应关系的相应信息, 具体包含内容如表1所示.表1 cdp_log记录项cdp_log 项各项属性dbname 备份数据库名称Ch_time 变动数据捕获时间点step 步数, 累加Cl_offset 捕获的变动数据在cdp_log中的偏移量ldf_offset 捕获的变动数据在源数据库事务日志中的偏移量block_size 变动数据所占数据块大小3.3 缓存模块在主机和从机两端都设有缓存模块. 主从数据同步有两种方式, 一种采用同步方式传输, 一种采用异步传输机制. 由于在捕获日志信息后, 需要先对日志信息进行分析后, 再进行传输, 故分析后选用异步传输机制. 异步传输过程中涉及到数据不一致和断点续传问题, 为了保证数据一致性, 设置数据缓存模块. 在缓存模块中采用堆栈结构, 遵循先进先出的原则. 3.4 数据传输模块数据传输模块可具体细化为传送模块和接受模块两部分. 该设计适用于局域网和广域网环境, 利用TCP/IP协议, 设置软件监听端口, 利用SOCKET编程技术, 实现数据的主从同步.3.5 恢复模块CDP系统恢复有三种恢复策略, 对应于三种参考模型, 分别为基准参考数据模型、复制参考数据模型和合成参考数据模型. 这三种方式分别通过正向、逆向、正逆向相结合的方式记录和保存变化的数据来实现, 各自的优缺点如下:基准参考数据模型原理简单, 实现容易, 但越是靠近当前的时间点, 恢复时间越长.复制参考模型恢复的时间点越靠近当前恢复时间越短, 但是由于数据存储过程中需要同时进行数据和日志记录的同步, 需要较多的系统资源.合成参考数据模式, 将前两者存在的问题折衷, 在资源占用和恢复效果上都不错, 但是实现起来复杂, 需要复杂的软件管理和数据处理功能.对于数据库管理系统, 由于其自身的日志重做机制, 采用的恢复策略类似于基准参考数据模型.本设计的恢复原理: 在备份目录存放有备份数据库初始的完整备份, 恢复过程中首先比对从站数据库目录中的数据库数据文件是否为初始的完整备份, 如果不是则将备份目录的初始完整备份拷贝到数据库指定的数据目录中, 直至一致. 之后按照要恢复到的时间点和具体的回退步数, 依照CDP_Change以及CDP_Log 中记录的信息将初始时刻到该时刻对应步数的变动写入到数据库事务日志文件的相应位置. 数据库管理系统重新启动后会重做事务日志文件中记录的所有变动, 从而实现对任意时间点的回退, 有效避免了由于人为误操作或病毒入侵等造成的数据损坏或丢失. 恢复流程如图6所示.3.6 接管模块接管模块主要利用心跳检测技术和IP浮动技术, 实现对主机数据库的接管, 避免数据库支持的业务中断以及数据丢失. 通过在主从之间发送心跳检测包, 探测主从的连接情况, 判断主机状态. 本设计中从机周期性的发送心跳检测包, 根据主机反馈回来的信息, 判定主机状态, 可根据情况人为调节发送周期. 如果主机网络中断或宕机, 则从站利用IP浮动技术, 接管主机IP继续对外提供服务,并启动从机数据库相应服务, 具体流程如下图7.图6 恢复流程图图7 接管模块流程4 结语CDP系统相对于传统数据保护策略存在很多优势, 但实现过程也比较复杂, 目前针对CDP的研究主要集中在基于文件级以及块级实现, 而针对具体应用的研究寥寥无几. 对于目前企事业单位存储关键数据常用的数据库管理系统而言, 虽然文件级CDP和块级CDP 系统也能够实现对其数据的持续保护, 但都存在着一定的问题, 本文从数据库事务日志入手, 针对具体数据库建立一套应用级的持续数据保护系统, 分析了如何捕获数据库任意时刻变化及恢复到任意时间点, 建立瞬时接管机制, 提高了系统的容灾等级. 但对于CDP系统而言, 基于应用的研究还有很长的路要走, 本文仅对人们常用SQL Server数据库管理系统提出了详细的设计方案和实现方法, 还有待更为广泛的扩展, 以及更为深入的研究.参考文献1 Wallis J. Common causes for data loss. http://www.isnare. com/?aid=222505&ca=Computers+and+Technology. [2008- 10-08].2 Patterson DA, Gibson G, Katz RH. A case for redundant arrays of inexpensive disks (RAID). ACM, 1988: 109–116.3 Rock M, Poresky P. Shorten your backup window. Special Issue on Managing the Information that Drives the Enterprise, 2005: 28-34.4 Continuous data protection. https:///sites/default/files/ SNIA_DMF_V6_DPI_Guide_4WEB.pdf.5 Flouris M, Bilas A. Clotho: transparent data versioning at the block I/O level. Proc. of the 21st IEEE/12th NASA Goddard Conference on Mass Storage Systems and Technologies. Washington, DC, USA. IEEE Computer Society. 2004: 315–328.6 黄志刚,郭玉东,杨宗博.文件级CDP的设计和实现.计算机应用,2008,S2:277–279.7 Wang C, Li ZH, Hu N, Nie YM. S-TRAP: Optimization and evaluation of timely recovery to any point-in-time (TRAP). Computer Science and Information Systems/ComSIS, 2012, 9(1): 431–454.8 黄建平.基于SQL Server数据库日志的信息源监测方法的研究与实现[学位论文].广州:暨南大学,2007.9 邹先霞,贾维嘉,潘久辉.基于数据库日志的变化数据捕获研究.小型微型计算机系统,2012,3:531–536.10 向猛,谢立靖.SQL SERVER 2005基于事务日志的备份与恢复深入研究.计算机系统应用,2013,22(6):18–23,74.11 李爱武.SQL Server实例恢复中重做日志记录定位机制研究.现代计算机(专业版),2009,9:107–109,138.。

基于Hadoop云计算平台的资源搜索系统

基于Hadoop云计算平台的资源搜索系统王皎;呼明亮【期刊名称】《电脑知识与技术》【年(卷),期】2014(000)019【摘要】Aiming at the current user can not quickly and accurately accessto network information, A resource search system based on Hadoop is designed, The search system is verified by the experiment ,and the test shows that the Hadoop system is to save time with the increase of data quantity.%针对当前用户难以快速准确地获取到自己需要的网络信息,设计了基于Hadoop云计算平台的资源搜索系统,并对该搜索系统进行了实验验证,结果表明,随着数据量的不断增大,Hadoop版本系统节约的时间越多,优势越明显。

【总页数】4页(P4463-4465,4480)【作者】王皎;呼明亮【作者单位】中航工业西安航空计算技术研究所,陕西西安710065;中航工业西安航空计算技术研究所,陕西西安710065【正文语种】中文【中图分类】TP393【相关文献】1.基于云计算平台Hadoop的HKM聚类算法设计研究 [J], 张淑芬;董岩岩;陈学斌2.基于Hadoop云计算平台的车牌识别 [J], 侯向宁;刘华春3.基于Hadoop云计算平台的数据处理研究 [J], 朱晓丽;邓惠俊;陈小虎4.基于Hadoop的云计算平台安全机制研究 [J], 陈叶琪;李权威;宋燕燕;秦军5.基于Hadoop云计算平台的构建 [J], 倪星宇因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中国移动“大云” 云计算平台

经分KPI 集中运算 经分系统 ETL/DM 结算 系统 信令 系统 云计算 资源池系统 物联 网应用 EMail IDC服务

…

PaaS 产品

数据管理/分析类

实时交易类

“大云”产品

IaaS 产品

计算/存储资源池

商务智能平台

挖掘工 并行数据挖掘工具集 搜索引擎 集BC-PDM BC-SE BC-PDM

FTP

Phoenix

Hive

Pig

R

Solr

Ambari

Sqoop MR1/MR2

Flume NG

Spark

BC-BSP Hcatalog

Storm

HDFS Fuse

HBase

YARN

ZK

黄色框 是 BC-Hadoop的组件,正在整合Spark

BC-Hadoop 1.0 主节点HA

参考Facebook AvatarNode 的实现,采用双主 NameNode的自动故障检测与切换,大大缩短了 NameNode切换时间和对应用系统的影响

关系型数据库

HDFS

HBase

MySQL

• • •

支持数据的IUD操作 HBase存储引擎:支持同一份数据进行实时查询和统计分析:Hive直接读Hfile进行统计,通过HBase实时查询 Join优化:按照join key将两个表的数据存储在同一个HBase Table的不同column.

并行数据挖掘工具集(BC-PDM)

Worker1

Worker1

write

Output File1

DB

read

Worker2

vertexhash

Worker2

message

Worker2

Output File2

HDFS

Split4

Split5 Worker3 Worker3 compute Worker3

Output File3

HBase

ZooKeeper 1

ZooKeeper 2

任务 3 任务 4 Worker 2 超步S

2: 局部同步

等待

检查点 检查点 Worker 2

任务 3 任务 4

同步控制

超步S+1

• • •

先对同一个Worker上同一Job的多个Task进行局部同步,再以Worker为粒度进行全局同步 周期性进行数据检查点保存,与自动恢复 在计算任务的同时进行数据交换,降低数据交换时间

Run a Job BSPprogram BSP SubmitJob BSP JobClient Controller assign staff

File

Distributed Synchronization

Barrier Synchronization

assign staff

Worker1 Split1 Split2 Split3

– 资源管理:cpu,内存 – 资源调度:fair scheduler,DRF – Appmaster实现机制

• TODO

– 集成计算框架如spark – 多租户,资源抽象由slot变为<vcore,mem>

图计算平台(BC-BSP)

BC-BSP:针对社交网络分析、用户精准营销、搜索引擎PageRank计算等图计算领域的数据挖 掘需求而研发的并行计算框架,针对迭代计算,计算效率优于MapReduce框架

查询能力

SQL引擎

Scan

MR

适应运营商场景 的多种存储引擎 支持

监控/管理

导入导出工具

加载工具HTLoad

元数据存储 索引存储

TextFile Hfile RCFile HBase

自劢化测试工具

一致性检验工具 开发者工具包SDK

存储引擎

数据存储

基础存储部件选 择

分布式文件系统

分布式KV-Store

Web GUI/工作流引擎 SQL脚本 CLI命令行

广 域 网

数据交换

并行 数据ETL

并行 数据探索

并行 数据挖掘

社交 用户权限管 网络分析 理

BC-BSP

HugeTable

任 数据 务 割

block2

PC节点

MapReduce

子任 务 M1 M2 Mi R1 R2 Rj

…

元数据服务器

任务分解

b lock3 任务分发服务器

无 40

流程5

流程6 流程7

60

80 130

14

25 47

无

无 无

4.28

2.50 2.76

0.8

0.9 1.9

典型的应用场景之二:大数据查询系统

– Puppet部署和管理hadoop服务 – Ganglia 收集hadoop 服务数据与生成图表 – Nagios监控集群服务状态并报警

HTTr部署在同一台服务

Ambari-web

(与server在同一个container)

Metrics

Shell

Ganglia

Client

RS级别结果汇聚 线程池管理

RegionServer

内部异步调用

异步IPC调用 (走网络)

Region Region

本地调用

HConnectionManager 1,定位所有region

RegionServer Region

ProtocolHandler

•

优点 – 计算分摊:Client端的计算被分布到每个RS上

BC-PDM:支持SaaS模式的海量数据并行处理、分析与挖掘系统。适用于经营决策、用户行 为分析、精准营销、网络优化、移劢互联网等领域的智能数据分析与挖掘应用

应用

各种海量数据处理、挖掘应用

主要特点

• 数据交换:支持与RDB直接交换数据 、支持CSV格式数据 • 数据ETL:支持数据清洗、转换、集 成等7大类45种ETL • 数据探索:支持数据统计、变量分析 、分布特征探索等 • 数据挖掘算法:支持分类、聚类、关 联分析等3大类共15种算法 • 社交网络分析:支持网络特征分析、 社团发现和演化、社团展示等 • 支持SaaS服务模式:Web浏览器使用 ,并可支持应用共享 • 支持丰富的用户UI: 支持Web图形化 方式创建数据分析逻辑,支持SQL脚 本方式,支持CLI命令行方式 • 支持二次开发:Java API、Web Service

Nagios Yum

获取RPM

REST

DB

HTTP/cgi->rrd

HTTP/php

Ambari-agent

Ambari-client (python cli)

REST

Puppet

基于该配置执行

Ambari-server

(http server/jetty)

HTTPS (heartbeat/json)

“大云”Hadoop平台及应用

王宝晗 中国移动研究院 云计算系统部 wangbaohan@

电信运营商具有更多的数据

移劢互联网 服务商

专业SNS 博客 电商 SNS 音乐 图片

消息

视频 优惠券

新闻

点评

地图 问答

电信运营商

微博 签到 论坛

2G、3G、4G、WIFI

除了像移动互联网服务商那样关注“结果”,电信运营商还需要关注“过程”!

数据仓库系统 HugeTable

BC-BSP 数据并行框架 架

数据存 BC-Hadoop 数据存储与 储和分析平台 处理

分布式内 存引擎 BC-DME

消息队列 BCQueue

其他平台中间件

IT基础资源

BC-Hadoop项目介绍

BC-Hadoop:对开源Hadoop/HBase进行扩展和增强,为大云其他组件提供基 本的存储计算能力。分别基于Hadoop 1.0 和 2.0 提供1.0和2.0两个版本。

解析json取到command (state/execute/upgrade) 调用

Python

生成

site#.pp .repo (第一次或upgrage)

基于Ambari的Hadoop监控管理工具

DONE: • JobTracker HA管理 • 告警逻辑修改 TODO:

走向YARN

• 功能测试及源码熟悉

现网时 间 (min)

流程3 流程4 90 130

云ETL时 MR时间 间(min)

云ETL脚 本 加速比例

9.00 3.25

时间减 少绝对 值(小 时)

1.3 1.5

100 80 60 40 20 0 流程3 流程4 流程5 流程6 流程7 现网时间(min) HIVE时间(min) MR时间

10 59

能力开放平台

分布式 SQL SQL K-V数据库 分布式 数据库 库 BC-kvDB BC-RDB BC-RDB CloudSecurity 系 统 监 控 和 管 理 CloudMaster 平 台 安 全 管 理

并行数据

文件中间件 弹性计算 BC-NAS BC-EC

对象存储 弹性块存储 BC-oNest BC-Block store

PC节点

M2

… …

分布式集群 管理服务器

M1

block1 block2

PC节点

block1 block3

PC节点

block1

Rj

PC节点

block2

PC节点

block3

PC节点

R1

R2

PC节点

Mi

PC节点

典型的应用场景之一:大数据批处理系统

目标:针对海量结构化、非结构化数据的ETL操作。从各种数据源获取数据,并进 行清洗、转换、去重、缺值补充等操作。通常采用MapReduce等并行计算技术。