基于weka的数据分类分析实验报告

weka实验报告总结

weka实验报告总结

Weka是一款非常流行的机器学习和数据挖掘工具,用于实现各

种数据分析任务。

下面是对Weka实验报告的总结:

在本次实验中,我们使用Weka工具进行了一系列的数据挖掘和

机器学习实验。

我们首先对数据集进行了探索性数据分析,包括数

据的统计特征、缺失值处理、异常值检测等。

通过这些分析,我们

对数据集的特点有了更全面的了解,并为后续的实验做好了准备。

接下来,我们使用Weka提供的各种机器学习算法进行了模型的

训练和评估。

我们尝试了多种算法,包括决策树、支持向量机、朴

素贝叶斯等。

通过对比不同算法在训练集和测试集上的表现,我们

评估了它们的性能,并选择了最合适的算法作为我们的模型。

在模型训练过程中,我们还进行了特征选择和特征工程的实验。

通过选择最相关的特征或者提取新的特征,我们尝试提高模型的性

能和泛化能力。

同时,我们还使用交叉验证等方法来评估模型的稳

定性和鲁棒性。

最后,我们对模型进行了性能评估和结果分析。

通过计算准确

率、召回率、F1值等指标,我们评估了模型的分类效果。

同时,我们还进行了误差分析,找出模型在分类错误的样本上的共同特征,以便进一步改进模型。

综上所述,本次实验中我们使用Weka工具进行了一系列的数据挖掘和机器学习实验。

通过探索性数据分析、模型训练和评估、特征选择和工程,以及性能评估和结果分析,我们得到了一个具有较好性能的模型,并对数据集有了更深入的理解。

这些实验为我们进一步研究和应用机器学习提供了有益的经验和启示。

基于weka的数据分类和聚类分析实验报告

基于w e k a的数据分类和聚类分析实验报告文件编码(008-TTIG-UTITD-GKBTT-PUUTI-WYTUI-8256)基于w e k a的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka中的三种常见分类和聚类方法(决策树J48、KNN和k-means)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理格式转换方法(1)打开“”另存为CSV类型,得到“”。

(2)在WEKA中提供了一个“Arff Viewer”模块,打开一个“”进行浏览,然后另存为ARFF文件,得到“”。

3. 实验过程及结果截图决策树分类(1)决策树分类用“Explorer”打开数据“”,然后切换到“Classify”。

点击“Choose”,选择算法“trees-J48”,再在“Test options”选择“Cross-validation(Flods=10)”,点击“Start”,开始运行。

系统默认trees-J48决策树算法中minNumObj=2,得到如下结果=== Summary ===Correctly Classified Instances 23 %Incorrectly Classified Instances 3 %Kappa statisticMean absolute errorRoot mean squared errorRelative absolute error %Root relative squared error %Total Number of Instances 26=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0 1 N1 1 YWeighted Avg.=== Confusion Matrix ===a b <-- classified as14 3 | a = N0 9 | b = Y使用不同的参数准确率比较:由上表,可知minNumObj为2时,准确率最高。

基于weka的数据分类和聚类分析实验报告.docx

基于w e k a的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka 中的三种常见分类和聚类方法(决策树J48、KNN 和 k-means)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

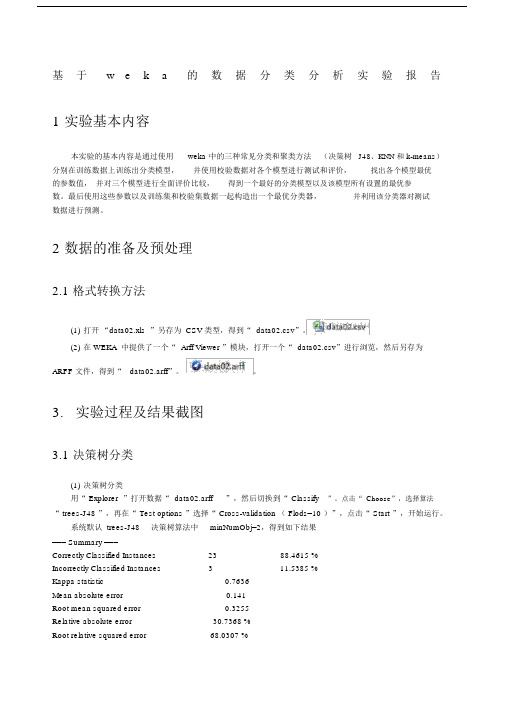

2数据的准备及预处理2.1 格式转换方法(1)打开“data02.xls ”另存为 CSV 类型,得到“ data02.csv”。

(2)在 WEKA 中提供了一个“ Arff Viewer ”模块,打开一个“ data02.csv”进行浏览,然后另存为ARFF 文件,得到“data02.arff”。

3.实验过程及结果截图3.1 决策树分类(1)决策树分类用“ Explorer ”打开数据“ data02.arff”,然后切换到“Classify”。

点击“ Choose”,选择算法“ trees-J48 ”,再在“ Test options ”选择“ Cross-validation ( Flods=10 )”,点击“ Start ”,开始运行。

系统默认 trees-J48决策树算法中minNumObj=2,得到如下结果=== Summary ===Correctly Classified Instances2388.4615 %Incorrectly Classified Instances311.5385 %Kappa statistic0.7636Mean absolute error0.141Root mean squared error0.3255Relative absolute error30.7368 %Root relative squared error68.0307 %Total Number of Instances26=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.824010.8240.9030.892N10.1760.7510.8570.892Y Weighted Avg.0.8850.0610.9130.8850.8870.892=== Confusion Matrix ===a b<-- classified as14 3 | a = N09 | b = Y使用不同的参数准确率比较:minNumObj2345Correctly23222323 Classified( 88.4615 %)( 84.6154 %)( 88.4615 %)( 88.4615 %)Instances由上表,可知minNumObj为 2 时,准确率最高。

数据挖掘实验报告Weka的数据聚类分析

甘肃政法学院本科生实验报告(2)姓名:学院:计算机科学学院专业:信息管理与信息系统班级:实验课程名称:数据挖掘实验日期:指导教师及职称:实验成绩:开课时间:2013—2014 学年一学期甘肃政法学院实验管理中心印制二.实验环境Win 7环境下的Eclipse三、实验内容在WEKA中实现K均值的算法,观察实验结果并进行分析。

四、实验过程与分析一、实验过程1、添加数据文件打开Weka的Explore,使用Open file点击打开本次实验所要使用的raff格式数据文件“auto93.raff”2、选择算法类型点击Cluster中的Choose,选择本次实验所要使用的算法类型“SimpleKMeans”3、得出实验结果选中“Cluster Mode”的“Use training set”,点击“Start”按钮,观察右边“Clusterer output”给出的聚类结果如下:=== Run information ===Scheme: weka.clusterers.SimpleKMeans -N 2 -S 10Relation: sInstances: 93Attributes: 23ManufacturerTypeCity_MPGHighway_MPGAir_Bags_standardDrive_train_typeNumber_of_cylindersEngine_sizeHorsepowerRPMEngine_revolutions_per_mile5528.8462 2622.3077 1 15.1346 4.7115 174.8654 100.2692 67.0385 36.8462 26.891 12.6069 2722.3077 0 16.4019Std Devs: N/A N/A 6.0746 5.7467 N/A N/A 0.7301 0.5047 40.8149 484.7019 377.1753 N/A 3.0204 0.848 11.2599 5.5735 2.4968 2.338 2.7753 2.3975 492.4971 N/A 7.9863Clustered Instances0 41 ( 44%)52 ( 56%)4、修改Seed值5、得出修改Seed值后的实验结果=== Run information ===Scheme: weka.clusterers.SimpleKMeans -N 2 -S 8Relation: sInstances: 93Attributes: 23ManufacturerTypeCity_MPGHighway_MPG二、实验分析本次实验采用的数据文件是“1993NewCarData ”。

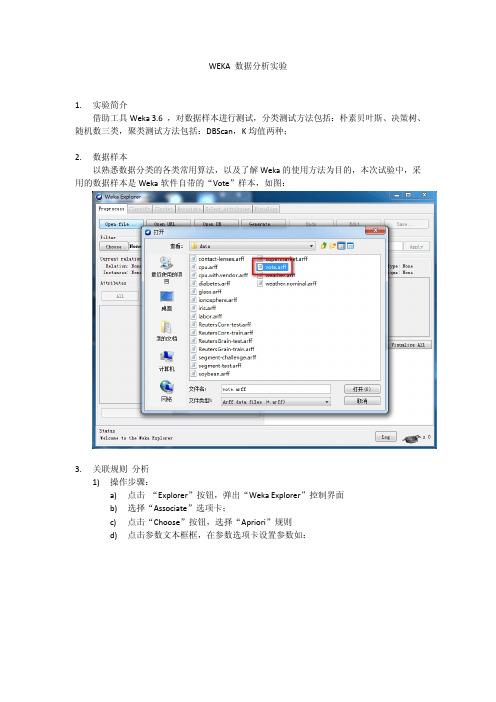

WEKA数据分析实验

WEKA 数据分析实验1.实验简介借助工具Weka 3.6 ,对数据样本进行测试,分类测试方法包括:朴素贝叶斯、决策树、随机数三类,聚类测试方法包括:DBScan,K均值两种;2.数据样本以熟悉数据分类的各类常用算法,以及了解Weka的使用方法为目的,本次试验中,采用的数据样本是Weka软件自带的“Vote”样本,如图:3.关联规则分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Associate”选项卡;c)点击“Choose”按钮,选择“Apriori”规则d)点击参数文本框框,在参数选项卡设置参数如:e)点击左侧“Start”按钮2)执行结果:=== Run information ===Scheme: weka.associations.Apriori -I -N 10 -T 0 -C 0.9 -D 0.05 -U 1.0 -M 0.5 -S -1.0 -c -1 Relation: voteInstances: 435Attributes: 17handicapped-infantswater-project-cost-sharingadoption-of-the-budget-resolutionphysician-fee-freezeel-salvador-aidreligious-groups-in-schoolsanti-satellite-test-banaid-to-nicaraguan-contrasmx-missileimmigrationsynfuels-corporation-cutbackeducation-spendingsuperfund-right-to-suecrimeduty-free-exportsexport-administration-act-south-africaClass=== Associator model (full training set) ===Apriori=======Minimum support: 0.5 (218 instances)Minimum metric <confidence>: 0.9Number of cycles performed: 10Generated sets of large itemsets:Size of set of large itemsets L(1): 12Large Itemsets L(1):handicapped-infants=n 236adoption-of-the-budget-resolution=y 253physician-fee-freeze=n 247religious-groups-in-schools=y 272anti-satellite-test-ban=y 239aid-to-nicaraguan-contras=y 242synfuels-corporation-cutback=n 264education-spending=n 233crime=y 248duty-free-exports=n 233export-administration-act-south-africa=y 269Class=democrat 267Size of set of large itemsets L(2): 4Large Itemsets L(2):adoption-of-the-budget-resolution=y physician-fee-freeze=n 219adoption-of-the-budget-resolution=y Class=democrat 231physician-fee-freeze=n Class=democrat 245aid-to-nicaraguan-contras=y Class=democrat 218Size of set of large itemsets L(3): 1Large Itemsets L(3):adoption-of-the-budget-resolution=y physician-fee-freeze=n Class=democrat 219Best rules found:1. adoption-of-the-budget-resolution=y physician-fee-freeze=n 219 ==> Class=democrat 219 conf:(1)2. physician-fee-freeze=n 247 ==> Class=democrat 245 conf:(0.99)3. adoption-of-the-budget-resolution=y Class=democrat 231 ==> physician-fee-freeze=n 219 conf:(0.95)4. Class=democrat 267 ==> physician-fee-freeze=n 245 conf:(0.92)5. adoption-of-the-budget-resolution=y 253 ==> Class=democrat 231 conf:(0.91)6. aid-to-nicaraguan-contras=y 242 ==> Class=democrat 218 conf:(0.9)3)结果分析:a)该样本数据,数据记录数435个,17个属性,进行了10轮测试b)最小支持度为0.5,即至少需要218个实例;c)最小置信度为0.9;d)进行了10轮搜索,频繁1项集12个,频繁2项集4个,频繁3项集1个;4.分类算法-随机树分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Classify ”选项卡;c)点击“Choose”按钮,选择“trees” “RandomTree”规则d)设置Cross-validation 为10次e)点击左侧“Start”按钮2)执行结果:=== Run information ===Scheme:weka.classifiers.trees.RandomTree -K 0 -M 1.0 -S 1Relation: voteInstances:435Attributes:17handicapped-infantswater-project-cost-sharingadoption-of-the-budget-resolutionphysician-fee-freezeel-salvador-aidreligious-groups-in-schoolsanti-satellite-test-banaid-to-nicaraguan-contrasmx-missileimmigrationsynfuels-corporation-cutbackeducation-spendingsuperfund-right-to-suecrimeduty-free-exportsexport-administration-act-south-africaClassTest mode:10-fold cross-validation=== Classifier model (full training set) ===RandomTree==========el-salvador-aid = n| physician-fee-freeze = n| | duty-free-exports = n| | | anti-satellite-test-ban = n| | | | synfuels-corporation-cutback = n| | | | | crime = n : republican (0.96/0)| | | | | crime = y| | | | | | handicapped-infants = n : democrat (2.02/0.01) | | | | | | handicapped-infants = y : democrat (0.05/0)| | | | synfuels-corporation-cutback = y| | | | | handicapped-infants = n : democrat (0.79/0.01)| | | | | handicapped-infants = y : democrat (2.12/0)| | | anti-satellite-test-ban = y| | | | adoption-of-the-budget-resolution = n| | | | | handicapped-infants = n : democrat (1.26/0.01)| | | | | handicapped-infants = y : republican (1.25/0.25)| | | | adoption-of-the-budget-resolution = y| | | | | handicapped-infants = n| | | | | | crime = n : democrat (5.94/0.01)| | | | | | crime = y : democrat (5.15/0.12)| | | | | handicapped-infants = y : democrat (36.99/0.09)| | duty-free-exports = y| | | crime = n : democrat (124.23/0.29)| | | crime = y| | | | handicapped-infants = n : democrat (16.9/0.38)| | | | handicapped-infants = y : democrat (8.99/0.02)| physician-fee-freeze = y| | immigration = n| | | education-spending = n| | | | crime = n : democrat (1.09/0)| | | | crime = y : democrat (1.01/0.01)| | | education-spending = y : republican (1.06/0.02)| | immigration = y| | | synfuels-corporation-cutback = n| | | | religious-groups-in-schools = n : republican (3.02/0.01)| | | | religious-groups-in-schools = y : republican (1.54/0.04)| | | synfuels-corporation-cutback = y : republican (1.06/0.05)el-salvador-aid = y| synfuels-corporation-cutback = n| | physician-fee-freeze = n| | | handicapped-infants = n| | | | superfund-right-to-sue = n| | | | | crime = n : democrat (1.36/0)| | | | | crime = y| | | | | | mx-missile = n : republican (1.01/0)| | | | | | mx-missile = y : democrat (1.01/0.01)| | | | superfund-right-to-sue = y : democrat (4.83/0.03)| | | handicapped-infants = y : democrat (8.42/0.02)| | physician-fee-freeze = y| | | adoption-of-the-budget-resolution = n| | | | export-administration-act-south-africa = n| | | | | mx-missile = n : republican (49.03/0)| | | | | mx-missile = y : democrat (0.11/0)| | | | export-administration-act-south-africa = y| | | | | duty-free-exports = n| | | | | | mx-missile = n : republican (60.67/0)| | | | | | mx-missile = y : republican (6.21/0.15)| | | | | duty-free-exports = y| | | | | | aid-to-nicaraguan-contras = n| | | | | | | water-project-cost-sharing = n| | | | | | | | mx-missile = n : republican (3.12/0)| | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | | water-project-cost-sharing = y : democrat (1.15/0.14) | | | | | | aid-to-nicaraguan-contras = y : republican (0.16/0)| | | adoption-of-the-budget-resolution = y| | | | anti-satellite-test-ban = n| | | | | immigration = n : democrat (2.01/0.01)| | | | | immigration = y| | | | | | water-project-cost-sharing = n| | | | | | | mx-missile = n : republican (1.63/0)| | | | | | | mx-missile = y : republican (1.01/0.01)| | | | | | water-project-cost-sharing = y| | | | | | | superfund-right-to-sue = n : republican (0.45/0)| | | | | | | superfund-right-to-sue = y : republican (1.71/0.64) | | | | anti-satellite-test-ban = y| | | | | mx-missile = n : republican (7.74/0)| | | | | mx-missile = y : republican (4.05/0.03)| synfuels-corporation-cutback = y| | adoption-of-the-budget-resolution = n| | | superfund-right-to-sue = n| | | | anti-satellite-test-ban = n| | | | | physician-fee-freeze = n : democrat (1.39/0.01)| | | | | physician-fee-freeze = y| | | | | | water-project-cost-sharing = n : republican (1.01/0)| | | | | | water-project-cost-sharing = y : democrat (1.05/0.05)| | | | anti-satellite-test-ban = y : democrat (1.13/0.01)| | | superfund-right-to-sue = y| | | | education-spending = n| | | | | physician-fee-freeze = n| | | | | | crime = n : democrat (0.09/0)| | | | | | crime = y| | | | | | | handicapped-infants = n : democrat (1.01/0.01)| | | | | | | handicapped-infants = y : democrat (1/0)| | | | | physician-fee-freeze = y| | | | | | immigration = n| | | | | | | export-administration-act-south-africa = n : democrat(0.34/0.11)| | | | | | | export-administration-act-south-africa = y| | | | | | | | crime = n : democrat (0.16/0)| | | | | | | | crime = y| | | | | | | | | mx-missile = n| | | | | | | | | | handicapped-infants = n : republican (0.29/0) | | | | | | | | | | handicapped-infants = y : republican (1.88/0.87) | | | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | immigration = y : republican (1.01/0)| | | | education-spending = y| | | | | physician-fee-freeze = n| | | | | | handicapped-infants = n : democrat (1.51/0.01)| | | | | | handicapped-infants = y : democrat (2.01/0)| | | | | physician-fee-freeze = y| | | | | | crime = n : republican (1.02/0)| | | | | | crime = y| | | | | | | export-administration-act-south-africa = n| | | | | | | | handicapped-infants = n| | | | | | | | | immigration = n| | | | | | | | | | mx-missile = n| | | | | | | | | | | water-project-cost-sharing = n : democrat (1.01/0.01)| | | | | | | | | | | water-project-cost-sharing = y : republican (1.81/0)| | | | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | | | | immigration = y| | | | | | | | | | mx-missile = n : republican (2.78/0)| | | | | | | | | | mx-missile = y : democrat (0.01/0)| | | | | | | | handicapped-infants = y| | | | | | | | | mx-missile = n : republican (2/0)| | | | | | | | | mx-missile = y : democrat (0.4/0)| | | | | | | export-administration-act-south-africa = y| | | | | | | | mx-missile = n : republican (8.77/0)| | | | | | | | mx-missile = y : democrat (0.02/0)| | adoption-of-the-budget-resolution = y| | | anti-satellite-test-ban = n| | | | handicapped-infants = n| | | | | crime = n : democrat (2.52/0.01)| | | | | crime = y : democrat (7.65/0.07)| | | | handicapped-infants = y : democrat (10.83/0.02)| | | anti-satellite-test-ban = y| | | | physician-fee-freeze = n| | | | | handicapped-infants = n| | | | | | crime = n : democrat (2.42/0.01)| | | | | | crime = y : democrat (2.28/0.03)| | | | | handicapped-infants = y : democrat (4.17/0.01)| | | | physician-fee-freeze = y| | | | | mx-missile = n : republican (2.3/0)| | | | | mx-missile = y : democrat (0.01/0)Size of the tree : 143Time taken to build model: 0.01seconds=== Stratified cross-validation ====== Summary ===Correctly Classified Instances 407 93.5632 %Incorrectly Classified Instances 28 6.4368 %Kappa statistic 0.8636Mean absolute error 0.0699Root mean squared error 0.2379Relative absolute error 14.7341 %Root relative squared error 48.8605 %Total Number of Instances 435=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.955 0.095 0.941 0.955 0.948 0.966 democrat0.905 0.045 0.927 0.905 0.916 0.967 republicanWeighted Avg. 0.936 0.076 0.936 0.936 0.935 0.966 === Confusion Matrix ===a b <-- classified as255 12 | a = democrat16 152 | b = republican3)结果分析:a)该样本数据,数据记录数435个,17个属性,进行了10轮交叉验证b)随机树长143c)正确分类共407个,正确率达93.5632 %d)错误分类28个,错误率6.4368 %e)测试数据的正确率较好5.分类算法-随机树分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Classify ”选项卡;c)点击“Choose”按钮,选择“trees” “J48”规则d)设置Cross-validation 为10次e)点击左侧“Start”按钮2)执行结果:=== Run information ===Scheme:weka.classifiers.trees.J48 -C 0.25 -M 2Relation: voteInstances:435Attributes:17handicapped-infantswater-project-cost-sharingadoption-of-the-budget-resolutionphysician-fee-freezeel-salvador-aidreligious-groups-in-schoolsanti-satellite-test-banaid-to-nicaraguan-contrasmx-missileimmigrationsynfuels-corporation-cutbackeducation-spendingsuperfund-right-to-suecrimeduty-free-exportsexport-administration-act-south-africaClassTest mode:10-fold cross-validation=== Classifier model (full training set) ===J48 pruned tree------------------physician-fee-freeze = n: democrat (253.41/3.75)physician-fee-freeze = y| synfuels-corporation-cutback = n: republican (145.71/4.0)| synfuels-corporation-cutback = y| | mx-missile = n| | | adoption-of-the-budget-resolution = n: republican (22.61/3.32) | | | adoption-of-the-budget-resolution = y| | | | anti-satellite-test-ban = n: democrat (5.04/0.02)| | | | anti-satellite-test-ban = y: republican (2.21)| | mx-missile = y: democrat (6.03/1.03)Number of Leaves : 6Size of the tree : 11Time taken to build model: 0.06seconds=== Stratified cross-validation ====== Summary ===Correctly Classified Instances 419 96.3218 % Incorrectly Classified Instances 16 3.6782 % Kappa statistic 0.9224Mean absolute error 0.0611Root mean squared error 0.1748Relative absolute error 12.887 %Root relative squared error 35.9085 %Total Number of Instances 435=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.97 0.048 0.97 0.97 0.97 0.971 democrat0.952 0.03 0.952 0.952 0.952 0.971 republicanWeighted Avg. 0.963 0.041 0.963 0.963 0.963 0.971=== Confusion Matrix ===a b <-- classified as259 8 | a = democrat8 160 | b = republican3)结果分析:a)该样本数据,数据记录数435个,17个属性,进行了10轮交叉验证b)决策树分6级,长度11c)正确分类共419个,正确率达96.3218 %d)错误分类16个,错误率3.6782 %e)测试结果接近随机数,正确率较高6.分类算法-朴素贝叶斯分析1)操作步骤:a)点击“Explorer”按钮,弹出“Weka Explorer”控制界面b)选择“Classify ”选项卡;c)点击“Choose”按钮,选择“bayes” “Naive Bayes”规则d)设置Cross-validation 为10次e)点击左侧“Start”按钮2)执行结果:=== Stratified cross-validation ====== Summary ===Correctly Classified Instances 392 90.1149 %Incorrectly Classified Instances 43 9.8851 %Kappa statistic 0.7949Mean absolute error 0.0995Root mean squared error 0.2977Relative absolute error 20.9815 %Root relative squared error 61.1406 %Total Number of Instances 435=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.891 0.083 0.944 0.891 0.917 0.973democrat0.917 0.109 0.842 0.917 0.877 0.973republicanWeighted Avg. 0.901 0.093 0.905 0.901 0.902 0.973 === Confusion Matrix ===a b <-- classified as238 29 | a = democrat14 154 | b = republican3)结果分析a)该样本数据,数据记录数435个,17个属性,进行了10轮交叉验证b)正确分类共392个,正确率达90.1149 %c)错误分类43个,错误率9.8851 %d)测试正确率较高7.分类算法-RandomTree、决策树、朴素贝叶斯结果比较:RandomTree 决策树朴素贝叶斯正确率93.5632% 96.3218 % 90.1149 %混淆矩阵 a b <-- classified as255 12 | a = democrat16 152 | b = republican a b <-- classified as259 8 | a = democrat8 160 | b = republicana b <-- classified as238 29 | a = democrat14 154 | b =republican标准误差48.8605 % 35.9085 % 61.1406 % 根据以上对照结果,三类分类算法对样板数据Vote测试准确率类似;8.。

数据挖掘weka实验报告

数据挖掘weka实验报告数据挖掘Weka实验报告引言:数据挖掘是一门利用统计学、人工智能和机器学习等技术从大量数据中提取有用信息的学科。

Weka是一款强大的数据挖掘工具,它提供了丰富的算法和功能,使得数据挖掘变得更加容易和高效。

本文将对Weka进行实验,探索其在数据挖掘中的应用。

一、数据集选择和预处理在本次实验中,我们选择了一个关于房价的数据集作为实验对象。

该数据集包含了房屋的各种属性,如面积、位置、卧室数量等,以及对应的房价。

首先,我们需要对数据集进行预处理,以便更好地进行数据挖掘。

1. 缺失值处理在数据集中,我们发现了一些缺失值。

为了保证数据的完整性和准确性,我们采用了Weka提供的缺失值处理方法,如删除缺失值、插补缺失值等。

通过比较不同方法的效果,我们选择了最适合数据集的缺失值处理方式。

2. 特征选择数据集中可能存在一些冗余或无关的特征,这些特征对于数据挖掘的结果可能没有太大的贡献。

因此,我们使用Weka中的特征选择算法,如信息增益、卡方检验等,来选择最具有代表性和相关性的特征。

二、数据挖掘算法应用在预处理完成后,我们开始应用各种数据挖掘算法,探索数据集中隐藏的规律和模式。

1. 分类算法我们首先尝试了几种分类算法,如决策树、朴素贝叶斯等。

通过比较不同算法的准确率、召回率和F1值等指标,我们找到了最适合该数据集的分类算法,并对其进行了优化。

2. 聚类算法除了分类算法,我们还尝试了一些聚类算法,如K均值聚类、层次聚类等。

通过可视化聚类结果,我们发现了数据集中的一些簇,从而更好地理解了数据集的结构和分布。

3. 关联规则挖掘关联规则挖掘是一种发现数据集中项集之间关系的方法。

我们使用了Apriori算法来挖掘数据集中的关联规则,并通过支持度和置信度等指标进行评估。

通过发现关联规则,我们可以了解到不同属性之间的相关性和依赖性。

三、实验结果分析通过实验,我们得到了一系列数据挖掘的结果。

根据实验结果,我们可以得出以下结论:1. 分类算法的准确率较高,可以用于预测房价等问题。

数据挖掘WEKA实验报告

数据挖掘WEKA实验报告一、实验目的本实验旨在使用WEKA数据挖掘工具,对给定的数据集进行分析和挖掘,探索其中的隐藏规律和关联关系,为决策提供科学依据。

二、实验过程1.数据集选择2.数据预处理首先,对数据集进行了探索性数据分析,了解数据的特征和分布情况。

随后,针对缺失数据和异常值进行了处理操作,采用了替换和删除的策略,以保证数据的质量和准确性。

3.特征选择使用WEKA提供的属性选择过程,对数据集中的特征进行了选择。

通过比较不同的特征选择算法(如信息增益、卡方检验、相关系数等),选取了最优的特征子集用于后续的建模。

4.分类建模为了预测年收入水平,我们选择了几个常用的分类算法进行建模和评估。

包括朴素贝叶斯、决策树、随机森林和支持向量机等。

对于每一种算法,我们使用了10折交叉验证的方式进行模型的训练和测试,并记录了准确率、召回率和F1值等指标作为评估结果。

5.结果分析通过比较不同算法的评估结果,我们发现随机森林算法在该数据集上的表现最好,准确率达到了80%以上。

决策树和朴素贝叶斯算法也有不错的表现,分别达到了75%和70%的准确率。

而支持向量机算法的准确率相对较低,仅为60%左右。

三、实验总结通过本次实验,我们学习并掌握了使用WEKA工具进行数据挖掘的基本操作和流程。

通过数据预处理、特征选择和分类建模等步骤,我们成功地对给定的数据集进行了分析和挖掘,并得到了有意义的结果。

但是需要注意的是,数据挖掘并非一种万能的解决方案,其结果也往往受到多个因素的影响。

因此,在实际应用中,我们需要根据具体情况选择合适的算法和方法,并对结果进行合理的解释和评估。

综上所述,本次实验为我们提供了一个良好的实践机会,帮助我们理解和掌握数据挖掘的基本理论和技术,为今后的科学研究和决策提供了有力的支持。

weka实验报告

weka实验报告一、实验背景在当今数据驱动的时代,数据分析和挖掘技术变得越来越重要。

Weka(Waikato Environment for Knowledge Analysis)作为一款功能强大且广泛使用的开源数据挖掘工具,为我们提供了丰富的算法和工具,以帮助我们从大量数据中发现有价值的信息和模式。

本次实验旨在深入探索 Weka 的功能和应用,通过实际操作和分析,加深对数据挖掘技术的理解和掌握。

二、实验目的1、熟悉 Weka 的操作界面和基本功能。

2、运用Weka 中的数据预处理技术对给定数据集进行清洗和转换。

3、选择合适的分类算法对数据集进行建模,并评估模型的性能。

4、分析实验结果,比较不同算法的优劣,总结经验教训。

三、实验环境1、操作系统:Windows 102、 Weka 版本:3853、数据集:鸢尾花数据集(Iris Dataset)四、实验步骤1、数据导入首先,打开 Weka 软件,选择“Explorer”选项。

在“Preprocess”标签页中,点击“Open file”按钮,选择鸢尾花数据集(irisarff)进行导入。

2、数据探索在导入数据后,对数据进行初步的探索和分析。

查看数据集的属性信息、数据分布、缺失值等情况。

通过“Visualize”按钮可以直观地观察数据的分布情况。

3、数据预处理(1)处理缺失值:检查数据集中是否存在缺失值,如果有,根据具体情况选择合适的方法进行处理,如删除包含缺失值的行或使用均值、中位数等进行填充。

(2)数据标准化/归一化:为了消除不同属性量纲的影响,对数据进行标准化或归一化处理。

4、分类算法选择与应用(1)决策树算法(J48)选择“Classify”标签页,在“Classifier”中选择“J48”决策树算法。

设置相关参数,如剪枝选项等,然后点击“Start”按钮进行训练和分类。

(2)朴素贝叶斯算法(NaiveBayes)同样在“Classifier”中选择“NaiveBayes”朴素贝叶斯算法,进行训练和分类。

基于weka的数据分类分析实验报告

基于weka的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka中的三种常见分类方法(朴素贝叶斯,KNN和决策树)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理格式转换方法原始数据是excel文件保存的xlsx格式数据,需要转换成Weka支持的arff文件格式或csv文件格式。

由于Weka对arff格式的支持更好,这里我们选择arff格式作为分类器原始数据的保存格式。

转换方法:在excel中打开“”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“total_data”,保存类型选择“CSV(逗号分隔)”,保存,我们便可得到“”文件;然后,打开Weka的Exporler,点击Open file按钮,打开刚才得到的“total_data”文件,点击“save”按钮,在弹出的对话框中,文件名输入“total_data”,文件类型选择“Arff data files(*.arff)”,这样得到的数据文件为“”。

如何建立数据训练集,校验集和测试集数据的预处理过程中,为了在训练模型、评价模型和使用模型对数据进行预测能保证一致性和完整性,首先要把和合并在一起,因为在生成arff文件的时候,可能会出现属性值不一样的情况,否则将为后来的测试过程带来麻烦。

通过统计数据信息,发现带有类标号的数据一共有100行,为了避免数据的过度拟合,必须把数据训练集和校验集分开,目前的拆分策略是各50行。

类标号为‘female’的数据有21条,而类标号为‘male’的数据有79条,这样目前遇到的问题是,究竟如何处理仅有的21条female数据?为了能在训练分类模型时有更全面的信息,所以决定把包含21条female类标号数据和29条male类标号数据作为模型训练数据集,而剩下的另49条类标号类male的数据将全部用于校验数据集,这是因为在校验的时候,两种类标号的数据的作用区别不大,而在训练数据模型时,则更需要更全面的信息,特别是不同类标号的数据的合理比例对训练模型的质量有较大的影响。

基于weka的数据聚类分析实验.pdf

基于Weka的数据聚类分析实验姓名:覃丽萍专业:计算机应用技术学号:20610020471.实验基本原理及目的聚类分析中的“类”(cluster)和前面分类的“类”(class)是不同的,对cluster更加准确的翻译应该是“簇”。

聚类的任务是把所有的实例分配到若干的簇,使得同一个簇的实例聚集在一个簇中心的周围,它们之间距离的比较近;而不同簇实例之间的距离比较远。

对于由数值型属性刻画的实例来说,这个距离通常指欧氏距离。

在本实验中,我们对前面的“bank-data”作聚类分析,使用最常见的K均值(K-means)算法。

下面我们简单描述一下K均值聚类的步骤。

K均值算法首先随机的指定K个簇中心。

然后:(1)将每个实例分配到距它最近的簇中心,得到K个簇;(2)计分别计算各簇中所有实例的均值,把它们作为各簇新的簇中心。

重复(1)和(2),直到K个簇中心的位置都固定,簇的分配也固定。

本次实验的目的,是通过利用Weka中提供的simpleKmeans方法对“bank-data”进行聚类分析,更深刻的理解k均值算法,并通过对实验结果进行观察分析,找出实验中所存在的问题。

2.数据的准备及预处理原始数据“bank-data.xls”是excel文件格式的数据,需要转换成Weka支持的ARFF文件格式的。

转换方法:在excel中打开“bank-data.xls”,选择菜单文件—>另存为,在弹出的对话框中,文件名输入“bank-data”,保存类型选择“CSV(逗号分隔)”,保存,我们便可得到“bank-data.csv”文件;然后,打开Weka的Exporler,点击Open file按钮,打开刚才得到的“bank-data.csv”文件,点击“save”按钮,在弹出的对话框中,文件名输入“bank-data.arff”,文件类型选择“Arff data files(*.arff)”,这样得到的数据文件为“bank-data.arff”。

weka 聚类实验报告

weka 聚类实验报告Weka 聚类实验报告引言聚类是一种常用的数据分析方法,它可以将数据集中的对象划分为不同的组别,使得同一组别内的对象具有相似的特征。

Weka 是一款流行的数据挖掘工具,其中包含了丰富的聚类算法,如K-means、DBSCAN、EM 等。

本实验旨在利用Weka 进行聚类实验,探索不同算法对数据集的聚类效果。

实验设计本次实验选择了UCI数据集中的Iris 数据集,该数据集包含了150 条记录,每条记录包括了4 个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和一个类别标签(鸢尾花的品种)。

我们将利用Weka 中的K-means、DBSCAN 和EM 等算法对该数据集进行聚类,并比较它们的聚类效果。

实验步骤1. 数据预处理:首先,我们将数据集导入Weka,并进行数据预处理,包括缺失值处理、标准化等操作。

2. K-means 聚类:利用Weka 中的K-means 算法对数据集进行聚类,并选择合适的聚类数目。

3. DBSCAN 聚类:利用Weka 中的DBSCAN 算法对数据集进行聚类,并调节合适的参数。

4. EM 聚类:利用Weka 中的EM 算法对数据集进行聚类,并选择合适的分布类型。

实验结果经过实验,我们得到了以下聚类结果:1. K-means 聚类:选择3 个聚类中心,得到了较好的聚类效果,三个类别分别对应于数据集中的三种鸢尾花品种。

2. DBSCAN 聚类:通过调节参数,我们得到了较好的聚类效果,但需要注意对噪声点的处理。

3. EM 聚类:选择高斯混合模型作为分布类型,得到了较好的聚类效果,但需要注意模型的收敛情况。

结论本次实验利用Weka 进行了聚类实验,并比较了K-means、DBSCAN 和EM 等算法的聚类效果。

通过实验结果,我们发现K-means 算法在该数据集上表现较好,能够有效地将数据集分为三个类别,对应于三种鸢尾花品种。

DBSCAN 算法和EM 算法也取得了较好的聚类效果,但需要注意参数的调节和模型的收敛情况。

数据挖掘实验报告Weka的数据聚类分析

甘肃政法学院本科生实验报告(2)姓名:学院:计算机科学学院专业:信息管理与信息系统班级:实验课程名称:数据挖掘实验日期:指导教师及职称:实验成绩:开课时间:2013—2014 学年一学期甘肃政法学院实验管理中心印制二.实验环境Win 7环境下的Eclipse三、实验内容在WEKA中实现K均值的算法,观察实验结果并进行分析。

四、实验过程与分析一、实验过程1、添加数据文件打开Weka的Explore,使用Open file点击打开本次实验所要使用的raff格式数据文件“auto93.raff”2、选择算法类型点击Cluster中的Choose,选择本次实验所要使用的算法类型“SimpleKMeans”3、得出实验结果选中“Cluster Mode”的“Use training set”,点击“Start”按钮,观察右边“Clusterer output”给出的聚类结果如下:=== Run information ===Scheme: weka.clusterers.SimpleKMeans -N 2 -S 10Relation: sInstances: 93Attributes: 23ManufacturerTypeCity_MPGHighway_MPGAir_Bags_standardDrive_train_typeNumber_of_cylindersEngine_sizeHorsepowerRPMEngine_revolutions_per_mile5528.8462 2622.3077 1 15.1346 4.7115 174.8654 100.2692 67.0385 36.8462 26.891 12.6069 2722.3077 0 16.4019Std Devs: N/A N/A 6.0746 5.7467 N/A N/A 0.7301 0.5047 40.8149 484.7019 377.1753 N/A 3.0204 0.848 11.2599 5.5735 2.4968 2.338 2.7753 2.3975 492.4971 N/A 7.9863Clustered Instances0 41 ( 44%)52 ( 56%)4、修改Seed值5、得出修改Seed值后的实验结果=== Run information ===Scheme: weka.clusterers.SimpleKMeans -N 2 -S 8Relation: sInstances: 93Attributes: 23ManufacturerTypeCity_MPGHighway_MPG二、实验分析本次实验采用的数据文件是“1993NewCarData ”。

weka实验报告

DW&DM课程实验报告班级:信管11-1姓名:***学号:************一、实验目的验证二、实验内容(一)聚类分析(1)数据准备1. 数据文件格式转换使用WEKA作数据挖掘,面临的第一个问题往往是我们的数据不是ARFF格式的。

幸好,WEKA还提供了对CSV文件的支持,而这种格式是被很多其他软件,比如Excel,所支持的。

现在我们打开“bank-data.csv”。

利用WEKA可以将CSV文件格式转化成ARFF文件格式。

ARFF 格式是WEKA支持得最好的文件格式。

此外,WEKA还提供了通过JDBC访问数据库的功能。

2.“Explorer”界面“Explorer”提供了很多功能,是WEKA使用最多的模块。

3.bank-data数据各属性的含义如下:id: a unique identification numberage: age of customer in years (numeric)sex: MALE / FEMALEregion: inner_city/rural/suburban/townincome: income of customer (numeric)married: is the customer married (YES/NO)children: number of children (numeric)car: does the customer own a car (YES/NO)save_act: does the customer have a saving account (YES/NO)current_act:does the customer have a current account (YES/NO) mortgage: does the customer have a mortgage (YES/NO)pep: did the customer buy a PEP (Personal Equity Plan,个人参股计划) after the last mailing (YES/NO)上图显示的是“Explorer”打开“bank-data.csv”的情况。

WEKA实验报告

基于weka的数据分类分析学号:Z15030739 姓名:刘丽丽专业:计算机技术一、实验目的1、使用数据挖掘中的分类算法,对数据集进行分类训练并测试;2、应用不同的分类算法,比较他们之间的不同;3、了解Weka平台的基本功能与使用方法。

二、实验环境Windows7+weka三、实验内容与步骤1、数据准备及预处理2、三种分类方法分析(1)、决策树分类;(2)、K最近邻算法分类;(3)、贝叶斯分类;3、三类分类方法的校验结果比较四、实验内容与步骤1、实验数据预处理首先是格式处理,一般情况下,数据的储存格式是xlsx格式。

使用weka进行数据分析时,需要将数据的格式利用格式转换工具转换成arff格式。

比如先使用UltraEdit软件将xlsx转换成csv格式,然后再在weka中导入csv格式的数据,然后点击“save”,选择”.arff”格式。

本次实验选择的是“breast-cancer.arff”作为分析数据。

所以无需格式转换处理。

其次是数据处理过程,用“Explorer”打开“breast-cancer.arff”。

总共有286条数据。

第1步:从“breast-cancer.arff”中截取86条,另存储为“breast-data.arff”,作为校验数据。

第2步:把剩下的200条另存储为“breast-train.arff”,作为训练数据。

第3步:点击”undo”恢复原“breast-cancer.arff”。

2、实验过程及结果2.1决策树分类用“Explorer”打开“breast-train.arff”切换到classify面板,选择trees->J48分类器。

选择默认参数。

点击start按钮,启动实验。

结果如下:校验数据集决策树得出的结果:初步结果分析:使用决策树进行分类,对于已知的数据“breast-data.arff”进行比较准确的分类,准确率达到75.5814 %。

2. 2、K最近邻算法分类点“Choose”按钮选择“laze->ibk”,选择Cross-Validatioin folds=10,然后点击“start”按钮,结果如下图:使用不同的叶子节点的实例个数初步结果分析:使用K最近邻算法分类时,K的最优值为9或10。

weka实验报告

基于w e k a的数据分类分析实验报告1 实验目的(1)了解决策树C4.5和朴素贝叶斯等算法的基本原理。

(2)熟练使用weka实现上述两种数据挖掘算法,并对训练出的模型进行测试和评价。

2 实验基本内容本实验的基本内容是通过基于weka实现两种常见的数据挖掘算法(决策树C4.5和朴素贝叶斯),分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

3 算法基本原理(1)决策树C4.5C4.5是一系列用在机器学习和数据挖掘的分类问题中的算法。

它的目标是监督学习:给定一个数据集,其中的每一个元组都能用一组属性值来描述,每一个元组属于一个互斥的类别中的某一类。

C4.5的目标是通过学习,找到一个从属性值到类别的映射关系,并且这个映射能用于对新的类别未知的实体进行分类。

C4.5由J.Ross Quinlan在ID3的基础上提出的。

ID3算法用来构造决策树。

决策树是一种类似流程图的树结构,其中每个内部节点(非树叶节点)表示在一个属性上的测试,每个分枝代表一个测试输出,而每个树叶节点存放一个类标号。

一旦建立好了决策树,对于一个未给定类标号的元组,跟踪一条有根节点到叶节点的路径,该叶节点就存放着该元组的预测。

决策树的优势在于不需要任何领域知识或参数设置,适合于探测性的知识发现。

从ID3算法中衍生出了C4.5和CART两种算法,这两种算法在数据挖掘中都非常重要。

属性选择度量又称分裂规则,因为它们决定给定节点上的元组如何分裂。

属性选择度量提供了每个属性描述给定训练元组的秩评定,具有最好度量得分的属性被选作给定元组的分裂属性。

目前比较流行的属性选择度量有--信息增益、增益率和Gini指标。

(2)朴素贝叶斯贝叶斯分类是一类分类算法的总称,这类算法均以贝叶斯定理为基础,故统称为贝叶斯分类。

WEKA数据挖掘实验报告

WEKA实验报告一、数据集实验采用Wisconsin医学院的William H.Wolberg博士提供的乳腺癌的数据样本。

所有数据来自真实临床案例,每个案例有10个属性。

其中前九个属性是检测指标,每个属性值用1到10的整数表示,1表示检测指标最正常,10表示最不正常。

第十个属性是分类属性,指示该肿瘤是否为恶性。

数据集中的肿瘤性质是通过活检得出的结果。

肿块厚度 Clump_Thickness integer [1,10]细胞大小的均匀性 Cell_Size_Uniformity integer [1,10]细胞形状的均匀性 Cell_Shape_Uniformity integer [1,10]边缘粘性 Marginal_Adhesion integer [1,10]单上皮细胞的大小 Single_Epi_Cell_Size integer [1,10]裸核 Bare_Nuclei integer [1,10]乏味染色体 Bland_Chromatin integer [1,10]正常核 Normal_Nucleoli integer [1,10]有丝分裂 Mitoses integer [1,10]肿瘤性质 Class { benign, malignant}该数据集共有669个实例。

本次实验对以上数据集进行了分类、聚类、关联规则三部分操作,以熟悉weka软件的操作使用,并尝试挖掘数据中的实际价值。

分类中,尝试用前九个属性值来预测肿瘤的性质(良性、恶性);聚类中,寻找各个簇病人(尤其是恶性肿瘤病人)的显著特征,可用来辅助制定针对性治疗计划;关联规则的探索,寻找不同属性值之间的相关性。

二、分类1.数据预处理将wisconsin-breast-cancer数据集分割为两个,分别作为train set(469个)和test set(200个)。

2.实验过程用j48分类树对train set进行分类运算,结果如下:结果表明,模型分类的准确率达到了96%。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于weka的数据分类分析实验报告

1实验基本内容

本实验的基本内容是通过使用weka中的三种常见分类方法(朴素贝叶斯,KNN和决策树C4.5)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理

2.1格式转换方法

原始数据是excel文件保存的xlsx格式数据,需要转换成Weka支持的arff文件格式或csv文件格式。

由于Weka对arff格式的支持更好,这里我们选择arff格式作为分类器原始数据的保存格式。

转换方法:在excel中打开“movie_given.xlsx”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“total_data”,保存类型选择“CSV(逗号分隔)”,保存,我们便可得到“total_data.csv”文件;然后,打开Weka的Exporler,点击Open file按钮,打开刚才得到的“total_data”文件,点击“save”按钮,在弹出的对话框中,文件名输入“total_data”,文件类型选择“Arff data files(*.arff)”,这样得到的数据文件为“total_data.arff”。

2.2如何建立数据训练集,校验集和测试集

数据的预处理过程中,为了在训练模型、评价模型和使用模型对数据进行预测能保证一致性和完整性,首先要把movie_given.xslx和test.xslx合并在一起,因为在生成arff文件的时候,可能会出现属性值不一样的情况,否则将为后来的测试过程带来麻烦。

通过统计数据信息,发现带有类标号的数据一共有100行,为了避免数据的过度拟合,必须把数据训练集和校验集分开,目前的拆分策略是各50行。

类标号为‘female’的数据有21条,而类标号为‘male’的数据有79条,这样目前遇到的问题是,究竟如何处理仅有的21条female数据?为了能在训练分类模型时有更全面的信息,所以决定把包含21条female类标号数据和29条male类标号数据作为模型训练数据集,而剩下的另49条类标号类male的数据将全部用于校验数据集,这是因为在校验的时候,两种类标号的数据的作用区别不大,而在训练数据模型时,则更需要更全面的信息,特别是不同类标号的数据的合理比例对训练模型的质量有较大的影响。

2.3预处理具体步骤

第一步:合并movie_given.xlsx和test.xlsx,保存为total_data.xlsx;

第二步:在total_data.xlsx中删除多余的ID列信息;

第三步:在excel中打开“total_data.xlsx”,选择菜单文件->另存为,在弹出的对话框中,文件名输入“total_data”,保存类型选择“CSV(逗号分隔)”;

第四步:使用UltraEdit工具把total_data.csv中的数据缺失部分补上全局常量‘?’;

第五步:打开Weka的Exporler,点击Open file按钮,打开刚才得到的“total_data.csv”文件,点击“save”按钮,在弹出的对话框中,文件名输入“total_data”,文件类型选择“Arff data files(*.arff)”,这样得到的数据文件为“total_data.arff”。

第六步:从total_data.arff文件里面剪切所有没有分类标号的数据作为预测数据集(test.arff),共26项。

第七步:把剩下含有类标号数据的total_data.arff文件复制一份,作为总的训练数据集。

文件名称为build_model.arff。

第八步:从total_data.arff文件中剩下的数据里面选取所有分类标号为male的49行数据作为校验数据集(validate_data.arff)。

第九步:从把剩下的total_data.arff文件改名为train_data.arff。

3. 实验过程及结果截图

3.1决策树分类

用“Explorer”打开刚才得到的“train-data.arff”,并切换到“Class”。

点“Choose”按钮选择“tree (weka.classifiers.trees.j48)”,这是WEKA中实现的决策树算法。

配置不同的叶子节点的实例个数

实例数/叶节点 2 3 4 5 6

准确率54% 60% 56% 56% 56% 结果分析:使用决策树时,每个叶子节点最优的实例个数为3。

校验数据集校验决策树得出的结果

初步结果分析:

使用决策树进行分类,对于已知的49个类标号为male的数据都进行了准确的分类,并且达到100%;虽然是个很好的数据,但是完美背后隐藏了缺陷,是以对female类的低准确率作为代价的,因为这样会说明该分类器很有可能偏向male类。

3.2 K最近邻算法分类

点“Choose”按钮选择“laze->ibk”,这是WEKA中实现的决策树算法。

选择Cross-Validatioin folds=10,然后点击“start”按钮:

训练数据集训练KNN得出的结果

配置不同的叶子节点的实例个数

K值 1 2 3 4 5 6 7 8 9 10 准确率52% 54% 56% 58% 60% 58% 60% 68% 62% 62% 结果分析:使用KNN算法分类时,K最优值为8。

校验数据集校验KNN得出的结果

初步结果分析:

对使用k=8训练出来的分类模型进行校验的结果,准确率达到77.6%,算是一个比较合理的分类结果。

3.3 朴素贝叶斯分类

点“Choose”按钮选择“bayes”,这是WEKA中实现的决策树算法。

选择Cross-Validatioin folds=10,然后点击“start”按钮:

训练数据集训练Naïve Bayes得出的结果

校验数据集校验Naïve Bayes得出的结果

初步结果分析:

评价结果中准确率仅仅达到59.1%,结果不是很让人满意。

3.4 三类分类方法的校验结果比较

决策树K最近邻朴素贝叶斯

校验准确率100% 77.55% 59.18% 训练

混淆矩阵

校验

混淆矩阵

标准误差0.42 0.4654 0.5918

比较结果分析:

根据上述数据,虽然决策树有最高的完美的准确率和相对较好的标准误差,但是这种完美的背后,很有可能是以类标号female的较大错误率作为代价,这点可以从训练混淆矩阵中得到印证;而朴素贝叶斯分类算法的准确率相对较低,而标准误差也较高,综合评价可以得知,当前最好的分类算法是KNN算法,并且它是最优设置参数为k=8。

3.5 训练最优模型

使用预处理中的buildmodel_data.arff数据文件训练分类模型,算法为k=8的KNN。

数据集训练KNN得出的结果

使用最终模型对测试集进行预测结果

4.三种算法在进行测试的性能比较4.1实验结果

决策树的测试结果:

KNN测试结果:

朴素贝叶斯测试结果:

比较分析结论:

性能分析应该包括两个部分,一个部分是测试速度,另一个部分是测试的质量。

由于本次使用所使用的数据量太少,在测试速度的对比上相差太少,无法进行准确的分析。

而在测试质量上,可以从上述数据中得到,决策树依然是由于它对与male类标号的偏爱,导致质量的降低;而KNN与朴素贝叶斯相比,KNN具有较高的准确率,从性能角度上讲,KNN 算法略胜一筹。

5.实验总结

本次实验进行比较顺利,使我对如何在Weka中进行分类分析有了更深刻的了解,对Weka中进行分类分析的KNN算法,朴素贝叶斯算法和决策树算法都有了进一步的理解,同时也深刻体会到数据预处理对于数据挖掘的重要性。