hadoop练习题--带答案资料

Hadoop试题试题库完整

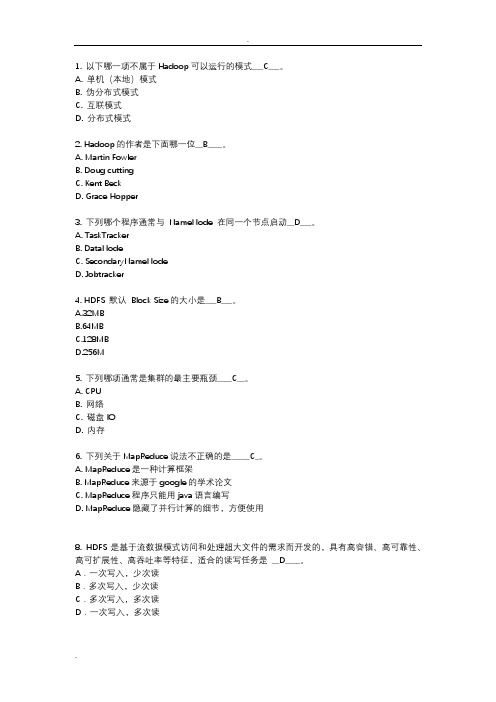

1.以下哪一项不属于Hadoop 可以运行的模式 C 。

A.单机(本地)模式B.伪分布式模式C.互联模式D.分布式模式2.Hadoop 的作者是下面哪一位 B 。

A.Martin FowlerB.Doug cuttingC.Kent BeckD.Grace Hopper3.下列哪个程序通常与NameNode 在同一个节点启动 D 。

A.TaskTrackerB.DataNodeC.SecondaryNameNodeD.Jobtracker4.HDFS 默认 Block Size 的大小是 B 。

A.32MBB.64MBC.128MBD.256M5.下列哪项通常是集群的最主要瓶颈 C 。

A.CPUB.网络C.磁盘 IOD.内存6.下列关于MapReduce 说法不正确的是C_ 。

A.MapReduce 是一种计算框架B.MapReduce 来源于 google 的学术论文C.MapReduce 程序只能用 java 语言编写D.MapReduce 隐藏了并行计算的细节,方便使用8.HDFS 是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、D 。

高可扩展性、高吞吐率等特征,适合的读写任务是A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9.HBase 依靠 A 存储底层数据。

A.HDFSB.HadoopC.MemoryD.MapReduce10.HBase 依赖 D 提供强大的计算能力。

A.ZookeeperB.ChubbyC.RPCD.MapReduce11.HBase 依赖 A 提供消息通信机制A.ZookeeperB.ChubbyC.RPCD.Socket12.下面与HDFS 类似的框架是 C ?A.NTFSB.FAT32C.GFSD.EXT313.关于 SecondaryNameNode 下面哪项是正确的 C 。

A.它是 NameNode 的热备B.它对内存没有要求C.它的目的是帮助NameNode 合并编辑日志,减少NameNode 启动时间D.SecondaryNameNode 应与 NameNode 部署到一个节点14.大数据的特点不包括下面哪一项 D 。

Hadoop试题试题库

1. 以下哪一项不属于Hadoop可以运行的模式___C___。

A. 单机(本地)模式B. 伪分布式模式C. 互联模式D. 分布式模式2. Hadoop的作者是下面哪一位__B____。

A. Martin FowlerB. Doug cuttingC. Kent BeckD. Grace Hopper3. 下列哪个程序通常与NameNode 在同一个节点启动__D___。

A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker4. HDFS 默认Block Size的大小是___B___。

A.32MBB.64MBC.128MBD.256M5. 下列哪项通常是集群的最主要瓶颈____C__。

A. CPUB. 网络C. 磁盘IOD. 内存6. 下列关于MapReduce说法不正确的是_____C_。

A. MapReduce是一种计算框架B. MapReduce来源于google的学术论文C. MapReduce程序只能用java语言编写D. MapReduce隐藏了并行计算的细节,方便使用8. HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是__D____。

A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9. HBase依靠__A____存储底层数据。

A. HDFSB. HadoopC. MemoryD. MapReduce10. HBase依赖___D___提供强大的计算能力。

A. ZookeeperB. ChubbyC. RPCD. MapReduce11. HBase依赖___A___提供消息通信机制A. ZookeeperB. ChubbyC. RPCD. Socket12. 下面与HDFS类似的框架是___C____?A. NTFSB. FAT32C. GFSD. EXT313. 关于SecondaryNameNode 下面哪项是正确的___C___。

(完整版)hadoop常见笔试题答案

Hadoop测试题一.填空题,1分(41空),2分(42空)共125分1.(每空1分) datanode 负责HDFS数据存储。

2.(每空1分)HDFS中的block默认保存 3 份。

3.(每空1分)ResourceManager 程序通常与NameNode 在一个节点启动。

4.(每空1分)hadoop运行的模式有:单机模式、伪分布模式、完全分布式。

5.(每空1分)Hadoop集群搭建中常用的4个配置文件为:core-site.xml 、hdfs-site.xml、mapred-site.xml 、yarn-site.xml 。

6.(每空2分)HDFS将要存储的大文件进行分割,分割后存放在既定的存储块中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。

7.(每空2分)一个HDFS集群包括两大部分,即namenode 与datanode 。

一般来说,一个集群中会有一个namenode 和多个datanode 共同工作。

8.(每空2分) namenode 是集群的主服务器,主要是用于对HDFS中所有的文件及内容数据进行维护,并不断读取记录集群中datanode 主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。

9.(每空2分) datanode 在HDFS集群中担任任务具体执行角色,是集群的工作节点。

文件被分成若干个相同大小的数据块,分别存储在若干个datanode 上,datanode 会定期向集群内namenode 发送自己的运行状态与存储内容,并根据namnode 发送的指令进行工作。

10.(每空2分) namenode 负责接受客户端发送过来的信息,然后将文件存储位置信息发送给client ,由client 直接与datanode 进行联系,从而进行部分文件的运算与操作。

11.(每空1分) block 是HDFS的基本存储单元,默认大小是128M 。

(完整版)hadoop常见笔试题答案

(完整版)hadoop常见笔试题答案Hadoop测试题一.填空题,1分(41空),2分(42空)共125分1.(每空1分) datanode 负责HDFS数据存储。

2.(每空1分)HDFS中的block默认保存 3 份。

3.(每空1分)ResourceManager 程序通常与NameNode 在一个节点启动。

4.(每空1分)hadoop运行的模式有:单机模式、伪分布模式、完全分布式。

5.(每空1分)Hadoop集群搭建中常用的4个配置文件为:core-site.xml 、hdfs-site.xml、mapred-site.xml 、yarn-site.xml 。

6.(每空2分)HDFS将要存储的大文件进行分割,分割后存放在既定的存储块中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。

7.(每空2分)一个HDFS集群包括两大部分,即namenode 与datanode 。

一般来说,一个集群中会有一个namenode 和多个datanode 共同工作。

8.(每空2分) namenode 是集群的主服务器,主要是用于对HDFS 中所有的文件及内容数据进行维护,并不断读取记录集群中datanode 主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。

9.(每空2分) datanode 在HDFS集群中担任任务具体执行角色,是集群的工作节点。

文件被分成若干个相同大小的数据块,分别存储在若干个datanode 上,datanode 会定期向集群内namenode 发送自己的运行状态与存储内容,并根据namnode 发送的指令进行工作。

10.(每空2分) namenode 负责接受客户端发送过来的信息,然后将文件存储位置信息发送给client ,由client 直接与datanode 进行联系,从而进行部分文件的运算与操作。

11.(每空1分) block 是HDFS的基本存储单元,默认大小是128M 。

(完整版)hadoop习题册

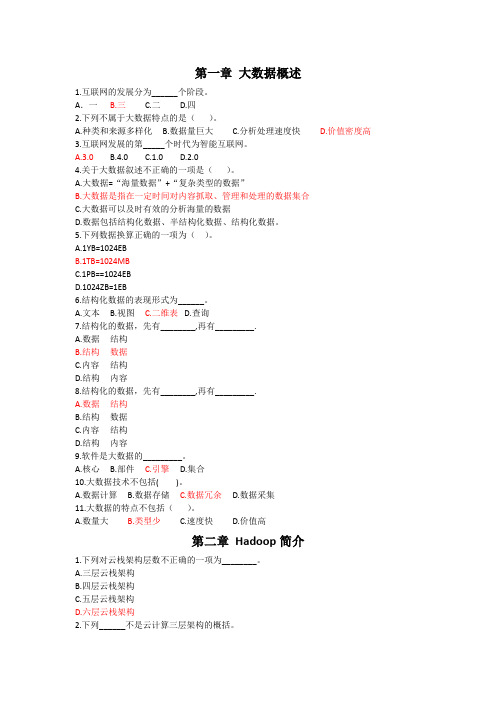

第一章大数据概述1.互联网的发展分为______个阶段。

A.一 B.三 C.二 D.四2.下列不属于大数据特点的是()。

A.种类和来源多样化B.数据量巨大C.分析处理速度快D.价值密度高3.互联网发展的第_____个时代为智能互联网。

A.3.0B.4.0C.1.0D.2.04.关于大数据叙述不正确的一项是()。

A.大数据=“海量数据”+“复杂类型的数据”B.大数据是指在一定时间对内容抓取、管理和处理的数据集合C.大数据可以及时有效的分析海量的数据D.数据包括结构化数据、半结构化数据、结构化数据。

5.下列数据换算正确的一项为()。

A.1YB=1024EBB.1TB=1024MBC.1PB==1024EBD.1024ZB=1EB6.结构化数据的表现形式为______。

A.文本B.视图C.二维表D.查询7.结构化的数据,先有________,再有_________.A.数据结构B.结构数据C.内容结构D.结构内容8.结构化的数据,先有________,再有_________.A.数据结构B.结构数据C.内容结构D.结构内容9.软件是大数据的_________。

A.核心B.部件C.引擎D.集合10.大数据技术不包括( )。

A.数据计算B.数据存储C.数据冗余D.数据采集11.大数据的特点不包括()。

A.数量大B.类型少C.速度快D.价值高第二章Hadoop简介1.下列对云栈架构层数不正确的一项为________。

A.三层云栈架构B.四层云栈架构C.五层云栈架构D.六层云栈架构2.下列______不是云计算三层架构的概括。

A.IaaSB.PaaSC.SaaPD.SaaS3.IaaS基础设施及服务可以称为______。

A.弹性计算B.效用计算C.有效计算D.随需应用4.四层云栈模式,是将三层模式中的_________进行分解,分为两层,一层为硬件层,一层为虚拟资源层。

A.硬件部分B.虚拟化部分C.基础设施D.平台5.五层云栈模式,第五层为______。

Hadoop基础(习题卷18)

Hadoop基础(习题卷18)第1部分:单项选择题,共53题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]下列不属于Python中Flask框架特点的是?A)内置开发服务器和调试器B)与Python单元测试功能无缝衔接C)使用Jinja2模板D)端口号固定为5000,且无法修改答案:D解析:2.[单选题]在Java中,方法resume( )负责重新开始▁▁线程的执行A)被stop( )方法停止B)被sleep( )方法停止C)被wait( )方法停止D)被suspend( )方法停止答案:D解析:3.[单选题]在Java中,假如电脑上E盘没有xxx目录,则下面程序功能描述正确是_x000D_File file1=new File("e:\\xxx\\yyy"); file1.mkdir()A)在当前目录下生成子目录:\xxx\yyyB)在E盘自动创建xxx/yyy目录C)在当前目录下生成文件xxx.yyyD)代码执行后E盘不会产生任何目录答案:D解析:4.[单选题]在Hadoop上提交Job时不涉及哪个实体()A)客户端B)HDFSC)SecondaryNodeD)JobTracker答案:C解析:5.[单选题]下面哪些不是引起 Spark 负载不均的原因?( )A)Spark 读入的数据源是倾斜的B)Shuffle 阶段 Key 值过于集中C)在数据过滤阶段需要处理的数据量差异D)Spark 的运行方式差异答案:D解析:6.[单选题]配置Hadoop时,JAVA_HOME包含在哪一个配置文件中?A)hadoop-default.xmlC)hadoop-site.xmlD)configuration.xml答案:B解析:7.[单选题]在 hadoop 配置中 yarn-site.xml 作用是( )A)用于定义系统级别的参数B)用于名称节点和数据节点的存放位置C)用于配置 JobHistory Server 和应用程序参数D)配置 ResourceManager,NodeManager 的通信端口答案:D解析:8.[单选题]HDFS中的block默认保存____份。

Hadoop试题试题库完整

Hadoop试题试题库完整1. 以下哪⼀项不属于Hadoop可以运⾏的模式___C___。

A. 单机(本地)模式B. 伪分布式模式C. 互联模式D. 分布式模式2. Hadoop的作者是下⾯哪⼀位__B____。

A. Martin FowlerB. Doug cuttingC. Kent BeckD. Grace Hopper3. 下列哪个程序通常与 NameNode 在同⼀个节点启动__D___。

A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker4. HDFS 默认 Block Size的⼤⼩是___B___。

A.32MBB.64MBC.128MBD.256M5. 下列哪项通常是集群的最主要瓶颈____C__。

A. CPUB. ⽹络C. 磁盘IOD. 内存6. 下列关于MapReduce说法不正确的是_____C_。

A. MapReduce是⼀种计算框架B. MapReduce来源于google的学术论⽂C. MapReduce程序只能⽤java语⾔编写D. MapReduce隐藏了并⾏计算的细节,⽅便使⽤8. HDFS是基于流数据模式访问和处理超⼤⽂件的需求⽽开发的,具有⾼容错、⾼可靠性、⾼可扩展性、⾼吞吐率等特征,适合的读写任务是 __D____。

A.⼀次写⼊,少次读C.多次写⼊,多次读D.⼀次写⼊,多次读9. HBase依靠__A____存储底层数据。

A. HDFSB. HadoopC. MemoryD. MapReduce10. HBase依赖___D___提供强⼤的计算能⼒。

A. ZookeeperB. ChubbyC. RPCD. MapReduce11. HBase依赖___A___提供消息通信机制A. ZookeeperB. ChubbyC. RPCD. Socket12. 下⾯与HDFS类似的框架是___C____?A. NTFSB. FAT32C. GFSD. EXT313. 关于 SecondaryNameNode 下⾯哪项是正确的___C___。

Hadoop基础(习题卷3)

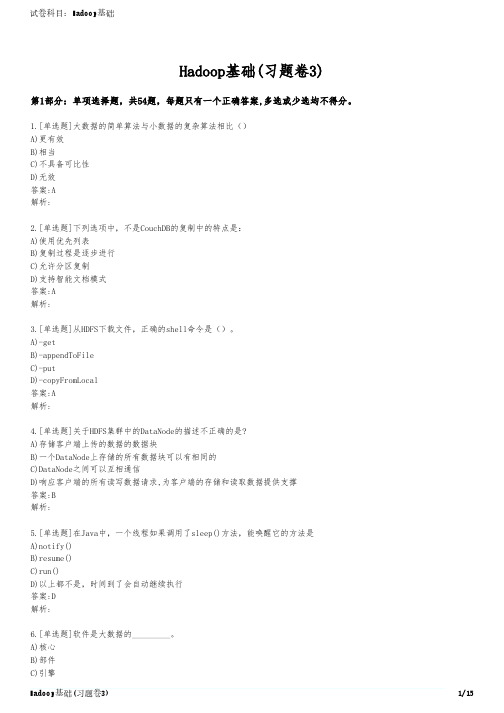

Hadoop基础(习题卷3)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]大数据的简单算法与小数据的复杂算法相比()A)更有效B)相当C)不具备可比性D)无效答案:A解析:2.[单选题]下列选项中,不是CouchDB的复制中的特点是:A)使用优先列表B)复制过程是逐步进行C)允许分区复制D)支持智能文档模式答案:A解析:3.[单选题]从HDFS下载文件,正确的shell命令是()。

A)-getB)-appendToFileC)-putD)-copyFromLocal答案:A解析:4.[单选题]关于HDFS集群中的DataNode的描述不正确的是?A)存储客户端上传的数据的数据块B)一个DataNode上存储的所有数据块可以有相同的C)DataNode之间可以互相通信D)响应客户端的所有读写数据请求,为客户端的存储和读取数据提供支撑答案:B解析:5.[单选题]在Java中,一个线程如果调用了sleep()方法,能唤醒它的方法是A)notify()B)resume()C)run()D)以上都不是,时间到了会自动继续执行答案:D解析:6.[单选题]软件是大数据的_________。

A)核心解析:7.[单选题]_______模式,只适合于Hive简单试用及单元测试。

A)单用户模式B)多用户模式C)多用户远程模式D)单用户远程模式答案:A解析:8.[单选题]下列关于Hive描述错误的是()。

A)hive学习成本低,支持标准的SQL语法B)hive运行效率低,延迟高C)HQL的表达能力有限D)Hive支持迭代计算答案:D解析:9.[单选题]下面哪个选项不是我们需要Hadoop的主要原因()A)我们需要处理PB级别的数据B)为每个应用建立一个可靠的系统是很昂贵的C)几乎每天都有结点坏掉D)把一个任务分割成多个子任务的方式是不好的答案:D解析:10.[单选题]为了让集群中的机器能够正常通信,所有集群的IP必须设置成静态IP,防止机器重启之后而找不到机器的情况,那么IP地址配置需要修改那个文件()A)ifcfg-loB)network-functionsC)ifcfg-ens33D)network-functions-ipv6答案:C解析:11.[单选题]Spark生态系统组件Spark Streaming的应用场景是?A)基于历史数据的数据挖掘B)图结构数据的处理C)基于历史数据的交互式查询D)基于实时数据流的数据处理答案:D解析:12.[单选题]关于HDFS集群中的DataNode的描述不正确的是?A)DataNode之间都是独立的,相互之间不会有通信B)存储客户端上传的数据的数据块C)响应客户端的所有读写数据请求,为客户端的存储和读取数据提供支撑13.[单选题]Hadoop2.x版本中的数据块大小默认是多少? ()A)64MB)128MC)256MD)512M答案:B解析:14.[单选题]HDFS分布式文件系统的特点为____________。

Hadoop基础(习题卷1)

Hadoop基础(习题卷1)说明:答案和解析在试卷最后第1部分:单项选择题,共145题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]以下哪一项不属于Hadoop可以运行的模式()A)单机模式B)伪分布式模式C)互联模式D)分布式模式2.[单选题]下列哪一个不属于Hadoop的大数据层的功能?A)数据挖掘B)离线分析C)实时计算D)BI分析3.[单选题]用于检查节点自身的健康状态的进程是( )A)ResourceManagerB)NodeManagerC)NameNodeD)DataNode4.[单选题]下面与Zookeeper类似的框架是?A)ProtobufB)JavaC)KafkaD)Chubby5.[单选题]哪个不是HDFS的特点?A)高容错B)高吞吐量C)低延迟读取D)大文件存储6.[单选题]在mapreduce任务中,下列哪一项会由hadoop系统自动排序()A)keys of mapper's outputB)values of mapper's outputC)keys of reducer's outputD)values of reducer's output7.[单选题]HDFS的是基于流数据模式访问和处理超大文件的需求而开发的,默认的最基本的存储单位是64M,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是?A)一次写入,多次读写B)一次写入,少次读写C)多次写入,少次读写D)多次写入,多次读写8.[单选题]下列哪项通常是集群的最主要的性能瓶颈? ()A)CPUB)网络C)磁盘D)内存9.[单选题]以下选项中,哪种类型间的转换是被Hive查询语言所支持的()A)Double-NumberB)BigInt-DoubleC)Int-BigIntD)String--Double10.[单选题]下面哪个选项中的Daemon总是运行在同一台主机上()A)Name Node & Job TrackerB)Secondary Name Node & Job TrackerC)Name Node & Secondary Name NodeD)Data Node & Task Tracker11.[单选题]2003年,Google公司发表了主要讲解海量数据的可靠存储方法的论文是?A)“TheGoogleFileSystem”B)“MapReduce:SimplifiedDataProcessingonLargeClusters”C)“Bigtable:ADistributedStorageSystemforStructuredData”D)“TheHadoopFileSystem”12.[单选题]下列_______通常与NameNode在一个节点启动。

Hadoop基础(习题卷11)

Hadoop基础(习题卷11)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]在文件属性中, 文件的权限用第( )列字符表示。

A)1-5B)2-10C)3-9D)1-8答案:B解析:2.[单选题]下列______不是云计算三层架构的概括。

A)IaaSB)PaaSC)SaaPD)SaaS答案:C解析:3.[单选题]验证java运行环境是否安装成功,使用哪个命令查看java版本,若出现版本号则表示 安装成功()A)java-versionB)java-ipconfigC)java-editionD)java-Release答案:A解析:4.[单选题]在Hadoop官方的示例程序包hadoop-maprecduceexamples-2.6.4.jar中,封装了一些常用的测试模块。

可以获得文件中单词长度的中位数的模块是(C)。

A)wordcountB)wordmeanC)wordmedianD)wordstandarddeviation答案:C解析:5.[单选题]在 MapReduce 中 Shuffle 的主要作用是( )A)将数据进行拆分B)对映射后的数据进行排序, 然后输入到 ReducerC)经过映射后的输出数据会被排序, 然后每个映射器会进 行分区D)通过实现自定义的 Partitioner 来指定哪些数据进入哪个Reducer答案:B解析:B)HTTPSC)SSHD)ClientProtocol答案:C解析:7.[单选题]关于ApplicationMaster组件描述错误的是()。

A)与资源管理器协商获取资源B)与节点管理器通信以启动或停止具体的任务C)监控应用程序所有任务的状态D)定时向资源管理器汇报资源使用情况答案:A解析:8.[单选题]SecondaryNameNode 是对主NameNode的一个补充,他会定期地执行对HDFS元数据的检查点。

当前设计仅允许每个HDFS只有()SecondaryNameNode节点。

(完整版)hadoop习题册

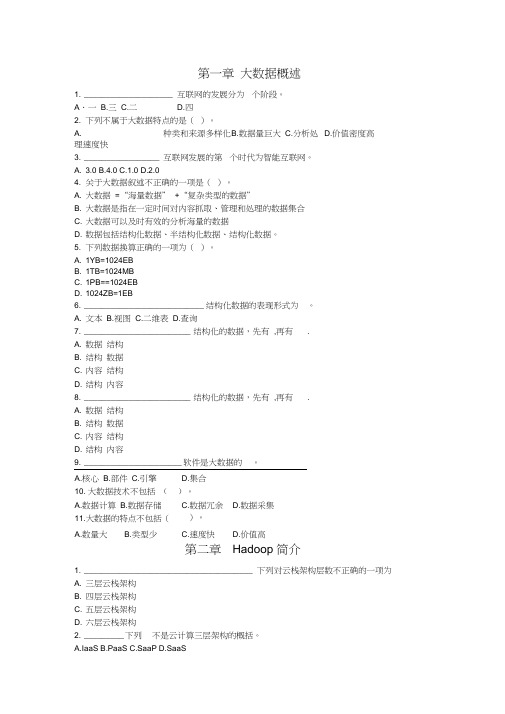

第一章大数据概述1. ____________________ 互联网的发展分为个阶段。

A.一 B.三 C.二 D.四2. 下列不属于大数据特点的是()。

D.价值密度高A. 种类和来源多样化B.数据量巨大C.分析处理速度快3. _________________ 互联网发展的第个时代为智能互联网。

A. 3.0B.4.0C.1.0D.2.04. 关于大数据叙述不正确的一项是()。

A. 大数据=“海量数据” +“复杂类型的数据”B. 大数据是指在一定时间对内容抓取、管理和处理的数据集合C. 大数据可以及时有效的分析海量的数据D. 数据包括结构化数据、半结构化数据、结构化数据。

5. 下列数据换算正确的一项为()。

A. 1YB=1024EBB. 1TB=1024MBC. 1PB==1024EBD. 1024ZB=1EB6. ___________________________ 结构化数据的表现形式为。

A. 文本B.视图C.二维表D.查询7. ________________________ 结构化的数据,先有,再有.A. 数据结构B. 结构数据C. 内容结构D. 结构内容8. ________________________ 结构化的数据,先有,再有.A. 数据结构B. 结构数据C. 内容结构D. 结构内容9. ______________________ 软件是大数据的。

A.核心B.部件C.引擎D.集合10. 大数据技术不包括()。

A.数据计算B.数据存储C.数据冗余D.数据采集11.大数据的特点不包括()。

A.数量大B.类型少C.速度快D.价值高第二章Hadoop 简介1. ______________________________________ 下列对云栈架构层数不正确的一项为A. 三层云栈架构B. 四层云栈架构C. 五层云栈架构D. 六层云栈架构2. _________ 下列不是云计算三层架构的概括。

Hadoop基础(习题卷2)

Hadoop基础(习题卷2)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]HDFS 中的 block 默认保存几个备份。

A)1B)2C)3D)4答案:C解析:2.[单选题]HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠行、高扩展性、高吞吐率等特征,适合的读写任务是________。

A)一次写入,少次读取B)多次写入,少次读取C)多次写入,多次读取D)一次写入,多次读取答案:D解析:3.[单选题]下面哪个选项不属于Google的三驾马车?A)HDFSB)MapReduceC)BigTableD)GFS答案:A解析:4.[单选题]下面描述错误的是:A)Hive的功能十分强大,可以支持采用SQL方式查询Hadoop平台上的数据B)在实际应用中,Hive也暴露出不稳定的问题,在极少数情况下,甚至会出现端口不响应或者进程丢失的问题C)在Hive HA中,在Hadoop集群上构建的数据仓库是由单个Hive实例进行管理的D)在Hive HA中,客户端的查询请求首先访问HAProxy,由HAProxy对访问请求进行转发答案:C解析:5.[单选题]下列关于配置机架感知的相关描述哪项不正确?A)如果一个机架出问题,不会影响数据读写和正确性B)MapReduce 会根据机架的拓扑获取离自己比较近的数据块C)写入数据的时候多个副本会写到不同机架的 DataNode 中D)数据块的第一个副本会优先考虑存储在客户端所在节点答案:C解析:6.[单选题]在java网络编程中,使用TCP编程时编写服务端的套接字类是A)SocketC)ServerSocketD)DatagramPacket答案:C解析:7.[单选题]HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce任务读取该文件时input split大小为?A)一个map读取64MB,另外一个map读取11MBB)128MBC)75MBD)75MB答案:C解析:8.[单选题]配置机架感知的下面哪项正确?A)都正确B)MapReduce会根据机架获取离自己比较近的网络数据C)写入数据的时候会写到不同机架的DataNodeD)如果一个机架出问题,不会影响数据读写答案:A解析:9.[单选题]在下列压缩格式中,哪一个压缩格式压缩速度最慢。

Hadoop基础(习题卷5)

Hadoop基础(习题卷5)说明:答案和解析在试卷最后第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]使用下面那个命令可以将HDFS目录中所有文件合并到一起A)putmergeB)getmergeC)remergeD)mergeALL2.[单选题]下列关于Map/Reduce并行计算模型叙述正确的一项为________。

A)Map/Reduce把待处理的数据集分割成许多大的数据块B)大数据块经Map()函数并行处理后输出新的中间结果C)reduce()函数把多任务处理后的中间结果进行汇总D)reduce阶段的作用接受来自输出列表的迭代器3.[单选题]Hadoop伪分布式是()A)一个操作系统B)一台机器C)一个软件D)一种概念4.[单选题]在MapReduce任务中,下列哪一项会由hadoop自动排序?A)keys of mapper's outputB)values of mapper's outputC)keys of reducer's outputD)values of reducer's output5.[单选题]使配置的环境变量生效的命令是( )A)vi ~/.bashrcB)source ~/bashrcC)cat ~/.bashrcD)source ~/.bashrc6.[单选题]在命令模式中,以下那个命令不会进入输入模式?A)qB)oC)iD)a7.[单选题]DataNode默认存放目录为()A)/opt/hadoop-record/softC)/home/hadoop-record/softD)/opt/hadoop-record/data8.[单选题]HDFS 2.x默认Block Size ( )A)16MBB)32MBC)64MBD)128MB9.[单选题]在本次项目实施中,需求调研前的准备不包括( )。

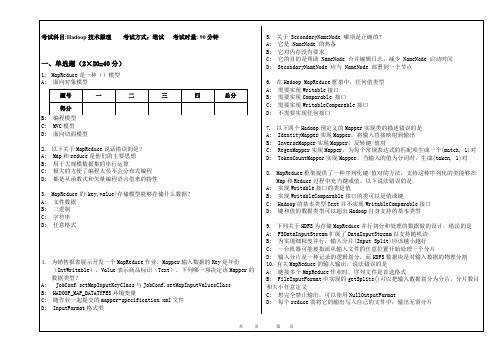

《Hadoop技术原理》试卷

B: HADOOP_MAP_DATATYPES环境变量

C: 随作业一起提交的mapper-specification.xml文件

D: InputFormat格式类

5.关于 SecondaryNameNode 哪项是正确的?

D: 可控性,hadoop rpc实现了自定义的rpc框架。

5.关于ZooKeeper的配置参数,下列说明正确的是()【选两项】

A: tickTime:服务器与客户端之间的心跳时间间隔。

B: initLimit:设定了所有跟随者与领导者进行连接并同步的时间范围。

C: syncLimit:允许一个跟随者与领导者进行的交换数据时间。

A: 实现Writable接口的类是值

B: 实现WritableComparable接口的类可以是值或键

C: Hadoop的基本类型Text并不实现WritableComparable接口

D: 键和值的数据类型可以超出Hadoop自身支持的基本类型

9.下列关于HDFS为存储MapReduce并行切分和处理的数据做的设计,错误的是

B: NameNode

C: DataBases

D: Secondary NameNode

3.每次格式化Hadoop的文件系统都会删除哪两个文件中的数据()【选两项】

A: .dir

B: .dir

C: dfs.datanode.data.dir

会产生多少个maptask 4个 65M这个文件只有一个切片《原因参见笔记汇总TextInputformat源码分析部分பைடு நூலகம்。

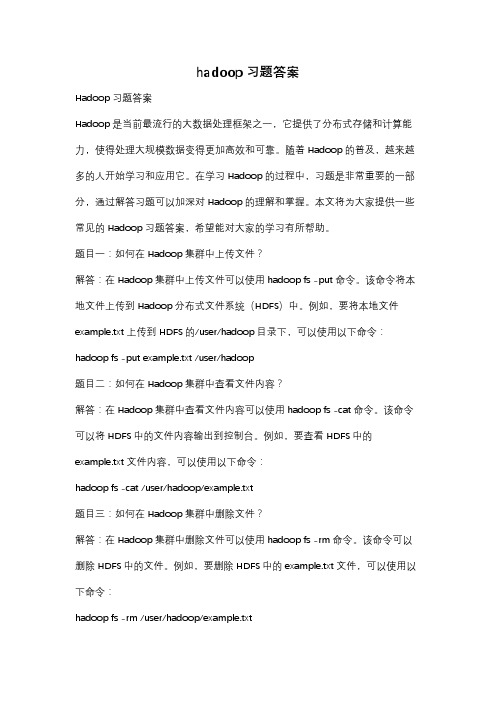

hadoop习题答案

hadoop习题答案Hadoop习题答案Hadoop是当前最流行的大数据处理框架之一,它提供了分布式存储和计算能力,使得处理大规模数据变得更加高效和可靠。

随着Hadoop的普及,越来越多的人开始学习和应用它。

在学习Hadoop的过程中,习题是非常重要的一部分,通过解答习题可以加深对Hadoop的理解和掌握。

本文将为大家提供一些常见的Hadoop习题答案,希望能对大家的学习有所帮助。

题目一:如何在Hadoop集群中上传文件?解答:在Hadoop集群中上传文件可以使用hadoop fs -put命令。

该命令将本地文件上传到Hadoop分布式文件系统(HDFS)中。

例如,要将本地文件example.txt上传到HDFS的/user/hadoop目录下,可以使用以下命令:hadoop fs -put example.txt /user/hadoop题目二:如何在Hadoop集群中查看文件内容?解答:在Hadoop集群中查看文件内容可以使用hadoop fs -cat命令。

该命令可以将HDFS中的文件内容输出到控制台。

例如,要查看HDFS中的example.txt文件内容,可以使用以下命令:hadoop fs -cat /user/hadoop/example.txt题目三:如何在Hadoop集群中删除文件?解答:在Hadoop集群中删除文件可以使用hadoop fs -rm命令。

该命令可以删除HDFS中的文件。

例如,要删除HDFS中的example.txt文件,可以使用以下命令:hadoop fs -rm /user/hadoop/example.txt题目四:如何在Hadoop集群中创建目录?解答:在Hadoop集群中创建目录可以使用hadoop fs -mkdir命令。

该命令可以在HDFS中创建新的目录。

例如,要在HDFS的根目录下创建一个名为data 的目录,可以使用以下命令:hadoop fs -mkdir /data题目五:如何在Hadoop集群中运行MapReduce作业?解答:在Hadoop集群中运行MapReduce作业可以使用hadoop jar命令。

hadoop应用的期末考试题目及答案

hadoop应用的期末考试题目及答案一、选择题(每题2分,共10分)1. Hadoop的HDFS是一种()。

A. 文件系统B. 数据库C. 缓存系统D. 操作系统答案:A2. Hadoop生态系统中,用于数据仓库的组件是()。

A. HBaseB. HiveC. PigD. Sqoop答案:B3. Hadoop的MapReduce编程模型中,Map阶段的主要任务是()。

A. 数据排序B. 数据合并C. 数据分发D. 数据处理答案:D4. Hadoop中,NameNode和DataNode分别负责()。

A. 数据存储和数据管理B. 数据管理C. 数据存储D. 数据存储和任务调度答案:A5. Hadoop的YARN是用于()。

A. 数据存储B. 数据处理C. 任务调度D. 数据传输答案:C二、填空题(每题2分,共10分)1. Hadoop的HDFS设计用于存储大规模数据集,其默认的副本因子是________。

答案:32. Hadoop的MapReduce框架中,Map任务的输出会经过________阶段,然后传递给Reduce任务。

答案:Shuffle and Sort3. Hadoop生态系统中,________组件用于处理实时数据流。

答案:Apache Storm4. Hadoop的HDFS支持________,允许用户在文件系统中存储多个版本的文件。

答案:Snapshot5. Hadoop的YARN中的________负责监控所有集群节点上的资源使用情况。

答案:ResourceManager三、简答题(每题10分,共30分)1. 简述Hadoop的HDFS的架构特点。

答案:Hadoop的HDFS(Hadoop Distributed File System)是一个分布式文件系统,设计用于存储大规模数据集。

它具有以下特点:- 高容错性:通过在多个节点上存储数据副本来实现。

- 高吞吐量:适用于大规模数据集的访问。

Hadoop测试题

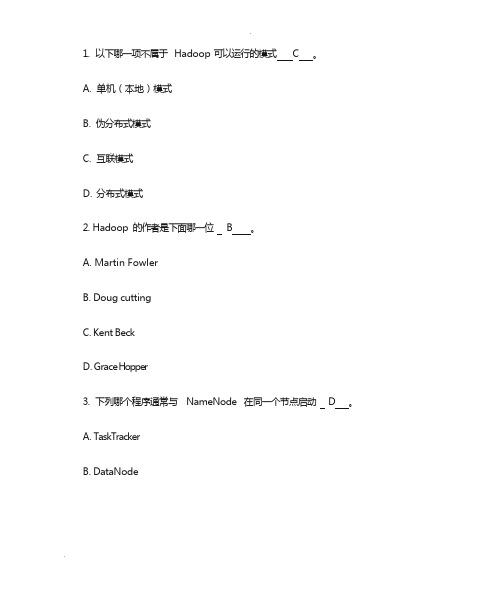

Hadoop测试题(100分)1、下面哪个程序负责HDFS 数据存储?(单选题)【单选题】NodeB.JobtrackerC.DatanodeD.secondaryNameNodeE.tasktracker正确答案: C2、HDfS 中的block 默认保存几份?(单选题)【单选题】A.3 份B.2 份C.1 份D.不确定正确答案: A3、下列哪个程序通常与NameNode 在一个节点启动?(单选题)【单选题】A.SecondaryNameNodeB.DataNodeC.TaskTrackerD.Jobtracker正确答案: D4、Hadoop 作者是哪位?(单选题)【单选题】A.Martin FowlerB.Kent BeckC.Doug cutting正确答案: C5、HDFS 默认Block Size是多少?(单选题)【单选题】A.32MBB.64MBC.128MB正确答案: B6、下列哪项通常是集群的最主要瓶颈?(单选题)【单选题】A.CPUB.网络C.磁盘IOD.内存正确答案: C7、关于SecondaryNameNode 哪项是正确的?(单选题)【单选题】A.它是NameNode 的热备B.它对内存没有要求C.它的目的是帮助NameNode 合并编辑日志,减少NameNode 启动时间D.SecondaryNameNode 应与NameNode 部署到一个节点正确答案: C8、Client 端上传文件的时候下列哪项正确?(单选题)【单选题】A.数据经过NameNode 传递给DataNodeB.Client 端将文件切分为Block,依次上传C.Client 只上传数据到一台DataNode,然后由NameNode 负责Block 复制工作正确答案: B9、配置机架感知的下面哪项正确?(多选题)【多选题】(10分)A.如果一个机架出问题,不会影响数据读写B.写入数据的时候会写到不同机架的DataNode 中C.MapReduce 会根据机架获取离自己比较近的网络数据正确答案: ABC10、下列哪个是Hadoop 运行的模式?(多选题)【多选题】(10分)A.单机版B.伪分布式C.分布式正确答案: ABC。

(完整版)hadoop练习题--带答案

Hadoop 练习题姓名:分数:单项选择题1.下面哪个程序负责HDFS数据存储。

a)NameNodeb)Jobtrackerc)Datanode √d)secondaryNameNodee)tasktracker2.HDfS中的block默认保存几份?a)3份√b)2份c)1份d)不确定3.下列哪个程序通常与NameNode在一个节点启动?a)SecondaryNameNodeb)DataNodec)TaskTrackerd)Jobtracker√4.Hadoop作者a)Martin Fowlerb)Kent Beckc)Doug cutting√5.HDFS默认Block Sizea)32MBb)64MB√c)128MB6.下列哪项通常是集群的最主要的性能瓶颈a)CPUb)网络c)磁盘√d)内存7.关于SecondaryNameNode哪项是正确的?a)它是NameNode的热备b)它对内存没有要求c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√d)SecondaryNameNode应与NameNode部署到一个节点8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block?a) 1b)2√c) 3d) 49.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce任务读取该文件时input split大小为?a)64MBb)75MB√c)一个map读取64MB,另外一个map读取11MB10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce任务读取该文件时input split大小为?a)64MBb)75MBc)一个map读取64MB,另外一个map读取11MB√多选题:11.下列哪项可以作为集群的管理工具a)Puppet√b)Pdsh√c)Cloudera Manager√d)Rsync + ssh + scp√12.配置机架感知的下面哪项正确a)如果一个机架出问题,不会影响数据读写√b)写入数据的时候会写到不同机架的DataNode中√c)MapReduce会根据机架获取离自己比较近的网络数据√13.Client端上传文件的时候下列哪项正确a)数据经过NameNode传递给DataNodeb)Client端将文件以Block为单位,管道方式依次传到DataNode√c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作d)当某个DataNode失败,客户端会继续传给其它DataNode √14.下列哪个是Hadoop运行的模式a)单机版√b)伪分布式√c)分布式√15.Cloudera提供哪几种安装CDH的方法a)Cloudera manager√b)Tar ball√c)Yum√d)Rpm√判断题:(全部错)16.Ganglia不仅可以进行监控,也可以进行告警。

Hadoop试题试题库

1.以下哪一项不属于 Hadoop 可以运行的模式 C 。

A.单机(本地)模式B.伪分布式模式C.互联模式D.分布式模式2.Hadoop 的作者是下面哪一位 B 。

A.Martin FowlerB.Doug cuttingC.Kent BeckD.Grace Hopper3.下列哪个程序通常与NameNode 在同一个节点启动 D 。

A.TaskTrackerB.DataNodeC.SecondaryNameNodeD.Jobtracker4.HDFS 默认Block Size 的大小是 B 。

A.32MBB.64MBC.128MBD.256M5.下列哪项通常是集群的最主要瓶颈 C 。

A.CPUB.网络C.磁盘 IOD.内存6.下列关于 MapReduce 说法不正确的是C_ 。

A.M apReduce 是一种计算框架B.MapReduce 来源于 google 的学术论文C.M apReduce 程序只能用 java 语言编写D.MapReduce 隐藏了并行计算的细节,方便使用8.HDFS 是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是 D 。

A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9.HBase 依靠 A 存储底层数据。

A.HDFSB.HadoopC.MemoryD.MapReduce10.HBase 依赖 D 提供强大的计算能力。

A.ZookeeperB.ChubbyC.RPCD.MapReduce11.HBase 依赖 A 提供消息通信机制A.ZookeeperB.ChubbyC.RPCD.Socket12.下面与 HDFS 类似的框架是 C ?A.NTFSB.FAT32C.GFSD.EXT313.关于SecondaryNameNode 下面哪项是正确的 C 。

A.它是NameNode 的热备B.它对内存没有要求C.它的目的是帮助NameNode 合并编辑日志,减少NameNode 启动时间D.SecondaryNameNode 应与NameNode 部署到一个节点14.大数据的特点不包括下面哪一项 D 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

h a d o o p练习题--带

答案

Hadoop 练习题姓名:分数:

单项选择题

1.下面哪个程序负责HDFS数据存储。

a)NameNode

b)Jobtracker

c)Datanode √

d)secondaryNameNode

e)tasktracker

2.HDfS中的block默认保存几份?

a)3份√

b)2份

c)1份

d)不确定

3.下列哪个程序通常与NameNode在一个节点启动?

a)SecondaryNameNode

b)DataNode

c)TaskTracker

d)Jobtracker√

4.Hadoop作者

a)Martin Fowler

b)Kent Beck

c)Doug cutting√

5.HDFS默认Block Size

a)32MB

b)64MB√

c)128MB

6.下列哪项通常是集群的最主要的性能瓶颈

a)CPU

b)网络

c)磁盘√

d)内存

7.关于SecondaryNameNode哪项是正确的?

a)它是NameNode的热备

b)它对内存没有要求

c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√

d)SecondaryNameNode应与NameNode部署到一个节点

8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block?

a) 1

b)2√

c) 3

d) 4

9.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。

当运行mapreduce

任务读取该文件时input split大小为?

a)64MB

b)75MB√

c)一个map读取64MB,另外一个map读取11MB

10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB。

当运

行mapreduce任务读取该文件时input split大小为?

a)64MB

b)75MB

c)一个map读取64MB,另外一个map读取11MB√

多选题:

11.下列哪项可以作为集群的管理工具

a)Puppet√

b)Pdsh√

c)Cloudera Manager√

d)Rsync + ssh + scp√

12.配置机架感知的下面哪项正确

a)如果一个机架出问题,不会影响数据读写√

b)写入数据的时候会写到不同机架的DataNode中√

c)MapReduce会根据机架获取离自己比较近的网络数据√

13.Client端上传文件的时候下列哪项正确

a)数据经过NameNode传递给DataNode

b)Client端将文件以Block为单位,管道方式依次传到DataNode√

c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作

d)当某个DataNode失败,客户端会继续传给其它DataNode √

14.下列哪个是Hadoop运行的模式

a)单机版√

b)伪分布式√

c)分布式√

15.Cloudera提供哪几种安装CDH的方法

a)Cloudera manager√

b)Tar ball√

c)Yum√

d)Rpm√

判断题:(全部错)

16.Ganglia不仅可以进行监控,也可以进行告警。

()

17.Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。

()

18.如果NameNode意外终止,SecondaryNameNode会接替它使集群继续工作。

()

19.Cloudera CDH是需要付费使用的。

()

20.Hadoop是Java开发的,所以MapReduce只支持Java语言编写。

()

21.Hadoop支持数据的随机写。

()

Node负责管理metadata,client端每次读写请求,它都会从磁盘中读取或则会写

入metadata信息并反馈client端。

()

Node本地磁盘保存了Block的位置信息。

()

24.Slave节点要存储数据,所以它的磁盘越大越好。

()

25.Hadoop默认调度器策略为FIFO,并支持多个Pool提交Job。

()

26.集群内每个节点都应该配RAID,这样避免单磁盘损坏,影响整个节点运行。

()

27.因为HDFS有多个副本,所以NameNode是不存在单点问题的。

()

28.每个map槽就是一个线程。

()

29.Mapreduce的input split就是一个block。

()

30.Hadoop环境变量中的HADOOP_HEAPSIZE用于设置所有Hadoop守护线程的内存。

它默

认是200MB。

()

31.DataNode首次加入cluster的时候,如果log中报告不兼容文件版本,那需要

NameNode执行“hadoop namenode -format”操作格式化磁盘。

()

32.Hadoop1.0和2.0都具备完善的HDFS HA策略。

()

33.GZIP压缩算法比LZO更快。

()

34.PIG是脚本语言,它与mapreduce无关。

()。