Hadoop-0.20.2详细安装及疑难问题

在 Ubuntu 上安装Hadoop-0.20.2 教程

在Ubuntu 上安装Hadoop 教程实践环境:U buntu8.04+jdk1.6+hadoop-0.20.1 ( 三台实体机)机器名IP 作用Ubuntu01 192.168.0.4 NameNode 、master 、jobTrackerUbuntu02 192.168.0.3 DataNode 、slave 、taskTracker1 、安装ubuntu8.04更新源修改2 、安装jdk1.6sudo apt-get install sun-java6-jdk(物理机可能安装不上,直接下载jdk安装jdk-1_5_0_14-linux-i586.bin文件安装# chmod a+x jdk-1_5_0_14-linux-i586.bin ←使当前用户拥有执行权限# ./jdk-1_5_0_14-linux-i586.bin ←选择yes直到安装完毕)安装后,添加如下语句到/etc/profile 中:export JA VA_HOME=/usr/lib/jvm/java-6-sunexport JRE_HOME=/usr/lib/jvm/java-6-sun/jreexport CLASSPATH=.:$JA V A_HOME/lib:$JRE_HOME/lib:$CLASSPATHexport PA TH=$JA V A_HOME/bin:$JRE_HOME/bin:$PA TH注意:每台机器的java 环境最好一致。

安装过程中如有中断,切换为root 权限来安装。

(7 、安装hadoop下载hadoop-0.20.1.tar.gz :$ wget /apache-mirror/hadoop/core/hadoop-0.20.2/hadoop-0.20.2.tar.gz解压:$ tar -zvxf hadoop-0.20.2.tar.gz把Hadoop 的安装路径添加到/etc/profile 中:export HADOOP_HOME=/home/wl826214/hadoop-0.20.2export PA TH=$HADOOP_HOME/bin:$PA TH8 、配置hadoophadoop 的主要配置都在hadoop-0.20. 2 /conf 下。

解决Hadoop使用中常见的问题

解决Hadoop使用中常见的问题在大数据时代,Hadoop已经成为了处理海量数据的重要工具。

然而,随着Hadoop的普及,一些常见的问题也随之出现。

本文将探讨这些问题并提供解决方案,帮助用户更好地使用Hadoop。

一、数据丢失问题在使用Hadoop时,数据丢失是一个常见的问题。

这可能是由于硬件故障、网络问题或软件错误引起的。

为了解决这个问题,我们可以采取以下措施:1. 数据备份:在Hadoop集群中,数据通常会被复制到多个节点上。

这样,即使一个节点发生故障,数据仍然可以从其他节点中恢复。

因此,我们应该确保数据的备份策略已经正确配置。

2. 定期监控:通过监控Hadoop集群的状态,我们可以及时发现并解决数据丢失的问题。

可以使用一些监控工具,如Ambari、Ganglia等,来实时监控集群的健康状况。

二、任务执行时间过长问题在处理大规模数据时,任务执行时间过长是一个普遍存在的问题。

这可能是由于数据倾斜、节点负载不均衡等原因引起的。

为了解决这个问题,我们可以采取以下措施:1. 数据倾斜处理:当某个任务的输入数据不均匀地分布在各个节点上时,会导致某些节点的负载过重,从而影响整个任务的执行效率。

我们可以通过数据倾斜处理算法,如Dynamic Partitioning、Salting等,将数据均匀地分布到各个节点上,从而提高任务的执行效率。

2. 节点负载均衡:通过调整Hadoop集群的配置,我们可以实现节点负载的均衡。

例如,可以使用Hadoop的资源管理器(ResourceManager)来动态分配任务给各个节点,从而使得节点的负载更加均衡。

三、数据安全问题随着大数据的快速发展,数据安全问题变得尤为重要。

在Hadoop中,数据安全主要包括数据的保密性和完整性。

为了解决这个问题,我们可以采取以下措施:1. 数据加密:我们可以使用Hadoop提供的加密功能来保护数据的机密性。

可以使用Hadoop的加密文件系统(HDFS Encryption)来对数据进行加密,从而防止未经授权的访问。

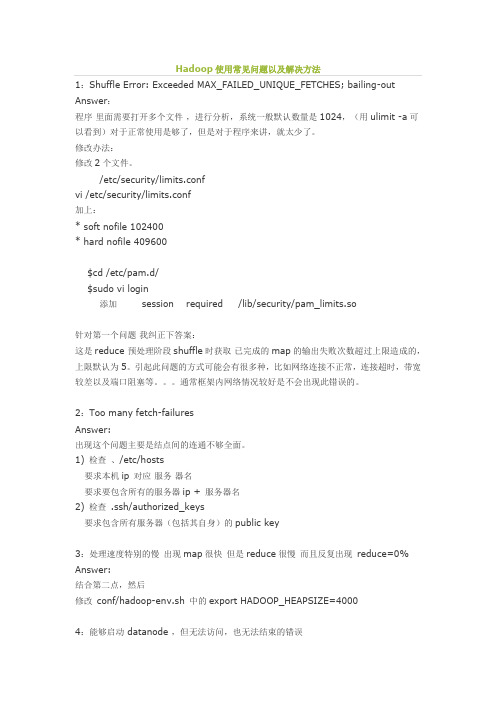

Hadoop使用常见问题以及解决方法

Hadoop使用常见问题以及解决方法1:Shuffle Error: Exceeded MAX_FAILED_UNIQUE_FETCHES; bailing-out Answer:程序里面需要打开多个文件,进行分析,系统一般默认数量是1024,(用ulimit -a可以看到)对于正常使用是够了,但是对于程序来讲,就太少了。

修改办法:修改2个文件。

/etc/security/limits.confvi /etc/security/limits.conf加上:* soft nofile 102400* hard nofile 409600$cd /etc/pam.d/$sudo vi login添加 session required /lib/security/pam_limits.so针对第一个问题我纠正下答案:这是reduce 预处理阶段shuffle时获取已完成的map的输出失败次数超过上限造成的,上限默认为5。

引起此问题的方式可能会有很多种,比如网络连接不正常,连接超时,带宽较差以及端口阻塞等。

通常框架内网络情况较好是不会出现此错误的。

2:Too many fetch-failuresAnswer:出现这个问题主要是结点间的连通不够全面。

1) 检查、/etc/hosts要求本机ip对应服务器名要求要包含所有的服务器ip + 服务器名2) 检查 .ssh/authorized_keys要求包含所有服务器(包括其自身)的public key3:处理速度特别的慢出现map很快但是reduce很慢而且反复出现reduce=0% Answer:结合第二点,然后修改conf/hadoop-env.sh 中的export HADOOP_HEAPSIZE=40004:能够启动 datanode ,但无法访问,也无法结束的错误在重新格式化一个新的分布式文件时,需要将你NameNode上所配置的.dir 这一namenode用来存放NameNode持久存储名字空间及事务日志的本地文件系统路径删除,同时将各DataNode上的dfs.data .dir的路径DataNode存放块数据的本地文件系统路径的目录也删除。

hadoop安装及运行维护汇总小问题共13页word资料

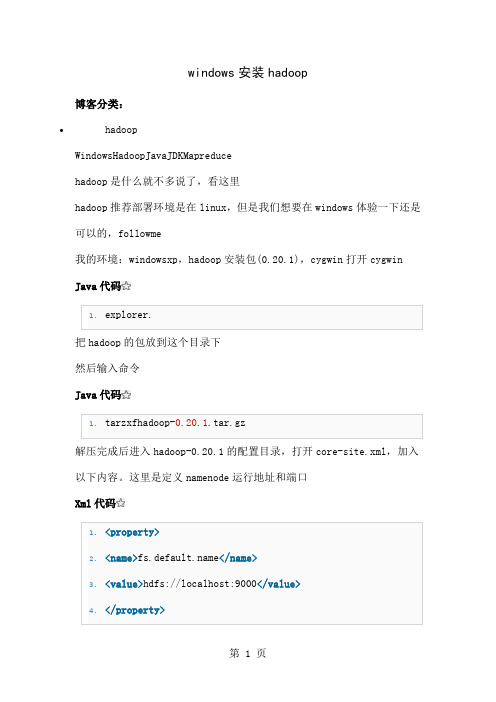

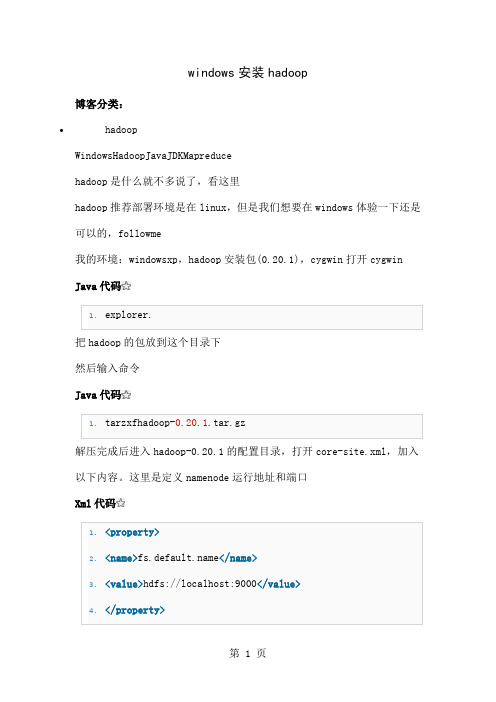

windows安装hadoop博客分类:•hadoopWindowsHadoopJavaJDKMapreducehadoop是什么就不多说了,看这里hadoop推荐部署环境是在linux,但是我们想要在windows体验一下还是可以的,followme我的环境:windowsxp,hadoop安装包(0.20.1),cygwin打开cygwin Java代码1.explorer.把hadoop的包放到这个目录下然后输入命令Java代码1.tarzxfhadoop-0.20.1.tar.gz解压完成后进入hadoop-0.20.1的配置目录,打开core-site.xml,加入以下内容。

这里是定义namenode运行地址和端口Xml代码1.<property>2.<name></name>3.<value>hdfs://localhost:9000</value>4.</property>打开hdfs-site.xml,加入以下内容Java代码1.<property>2.<name>dfs.replication</name>3.<value>1</value>4.</property>这里把复制因子设置为1是因为我们在windows上做伪分布,只能启动一个datanode接下来可以定义namenode数据目录,和datanode数据目录。

当然这个不是必须的,默认是在/tmp目录下面Xml代码1.<property>2.<name>.dir</name>3.<value>c:/filesystem/name</value>4.</property>5.<property>6.<name>dfs.data.dir</name>7.<value>c:/filesystem/data</value>8.</property>最后修改hadoop-env.sh,把下面注释的这行打开,并设置为你的jdk路径。

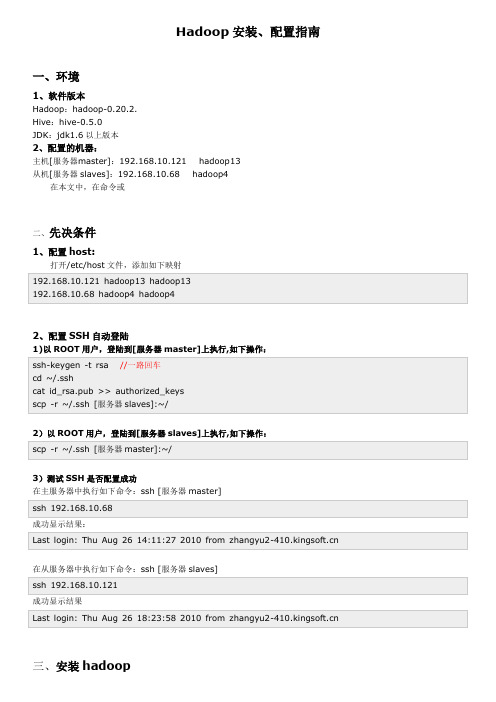

hadoop安装配置指南

Hadoop安装、配置指南一、环境1、软件版本Hadoop:hadoop-0.20.2.Hive:hive-0.5.0JDK:jdk1.6以上版本2、配置的机器:主机[服务器master]:192.168.10.121 hadoop13从机[服务器slaves]:192.168.10.68 hadoop4在本文中,在命令或二、先决条件1、配置host:打开/etc/host文件,添加如下映射192.168.10.121 hadoop13 hadoop13192.168.10.68 hadoop4 hadoop42、配置SSH自动登陆1)以ROOT用户,登陆到[服务器master]上执行,如下操作:ssh-keygen -t rsa //一路回车cd ~/.sshcat id_rsa.pub >> authorized_keysscp -r ~/.ssh [服务器slaves]:~/2)以ROOT用户,登陆到[服务器slaves]上执行,如下操作:scp -r ~/.ssh [服务器master]:~/3)测试SSH是否配置成功在主服务器中执行如下命令:ssh [服务器master]ssh 192.168.10.68成功显示结果:Last login: Thu Aug 26 14:11:27 2010 from 在从服务器中执行如下命令:ssh [服务器slaves]ssh 192.168.10.121成功显示结果Last login: Thu Aug 26 18:23:58 2010 from 三、安装hadoop1、JDK安装,解压到/usr/local/jdk1.6.0_17,并配置/etc/profile环境export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jarJDK路径:/usr/local/jdk/jdk1.7.0export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jar/usr/local/jdk/jdk1.7.02、下载Hadoop 并解压到[服务器master]的/root/zwmhadoop目录下tar zxvf hadoop-0.20.2.tar.gz四、配置hadoop1.配置主机[服务器master]到zwm hadoop/hadoop-0.20.2/ hadoop 目录下,修改以下文件:1)配置conf/hadoop-env.sh文件,在文件中添加环境变量,增加以下内容:export JAVA_HOME=/usr/local/jdk1.6.0_17export HADOOP_HOME=/root/zwmhadoop/hadoop-0.20.2/2)配置conf/core-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name></name><value>hdfs://192.168.10.121:9000</value>//你的namenode的配置,机器名加端口<description>The nam e of the default file system. Either the literal string "local" o r a host:port for DFS.</description></property></configuration>3)配置conf/hdfs-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name>hadoop.t m p.dir</name><value>/root/zwmhadoop/t m p</value>//Hadoop的默认临时路径,这个最好配置,然后在新增节点或者其他情况下莫名其妙的DataNode启动不了,就删除此文件中的t mp目录即可。

Hadoop伪分布式安装步骤(hadoop0.20.2版本)

Hadoop伪分布式安装步骤(hadoop0.20.2版本)最近在学习hadoop,⾃⼰下了个视频教程,他的教学版本是hadoop0.20.2版本,现在的最新版本都到了3.0了,版本虽然有点⽼,但是还是学了⼀下,觉得有借鉴的价值。

不废话了,开始介绍:先说⼀下环境:ubuntu14.04,其中要装上ssh open-server服务,装上jdk环境。

伪分布式模式安装和配置步骤如下图:详细步骤1 ⾸先把⽂件导⼊linux系统(我⽤的ubuntu虚拟机,hadoop-0.20.2.tar.gz安装包放在了桌桌⾯)。

⾸先把这个安装包放在/opt⽬录下,并解压:2 配置相关⽂件hadoop-env.sh⽂件配置(版本不同,⽂件位置可能不⼀样,hadoop0.20.2在/conf下)core-site.xml (/conf下)修改hdfs-site.xmlhdfs-site.xml配置⽂件中还有其他⼀些配置,此次配置没有⽤到,如下图:mapred-site.xml配置下图是mapred-site.xml其他⼀些配置,此次没⽤到,列到这⾥:注意:由于我布置的是伪分布式,只有⼀个节点(即本机),所以core-site.xml和mapred-site.xml两个配置⽂件中的相关ip地址是localhost,如果完全分布式部署,是要写相应的IP的。

另外,9000和9001是hadoop缺省端⼝,⼀般没必要修改。

ssh设置⾸先进⼊/root然后按照下图输⼊(让每个节点之间互通免密码)这样就⼤功告成啦完全分布式安装⼤致步骤如下:1 配置host⽂件2 简历hadoop运⾏账号3 配置ssh免密码连接4 下载hadoop并解压5 配置namenode,修改site⽂件6 配置hadoop-env.sh7 配置master和slaves⽂件8 向各节点复制hadoop9 格式化namenode10 启动hadoop11 ⽤jps检查阁后台进程是否成功启动后续:以上都是基于hadoop0.20.2版本的,属于⽐较过时的东西,推荐⼀个⼤神总结的hadoop2.6.0的安装和配置,写的很详细,⽽且也是正确的。

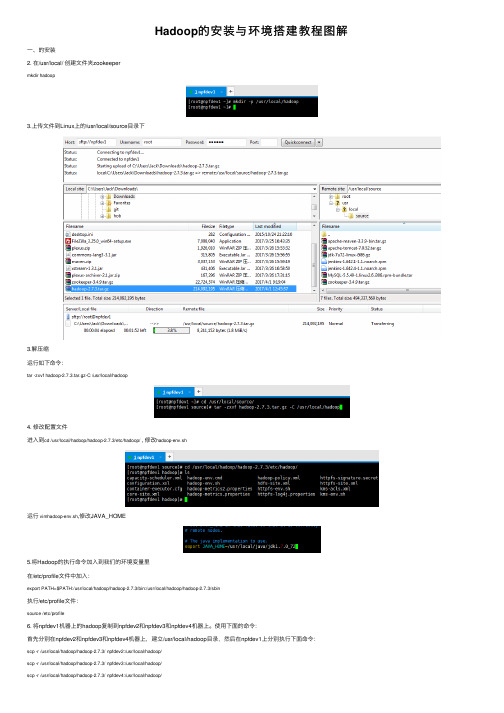

Hadoop的安装与环境搭建教程图解

Hadoop的安装与环境搭建教程图解⼀、的安装2. 在/usr/local/ 创建⽂件夹zookeepermkdir hadoop3.上传⽂件到Linux上的/usr/local/source⽬录下3.解压缩运⾏如下命令:tar -zxvf hadoop-2.7.3.tar.gz-C /usr/local/hadoop4. 修改配置⽂件进⼊到cd /usr/local/hadoop/hadoop-2.7.3/etc/hadoop/ , 修改hadoop-env.sh运⾏vimhadoop-env.sh,修改JAVA_HOME5.将Hadoop的执⾏命令加⼊到我们的环境变量⾥在/etc/profile⽂件中加⼊:export PATH=$PATH:/usr/local/hadoop/hadoop-2.7.3/bin:/usr/local/hadoop/hadoop-2.7.3/sbin执⾏/etc/profile⽂件:source /etc/profile6. 将npfdev1机器上的hadoop复制到npfdev2和npfdev3和npfdev4机器上。

使⽤下⾯的命令:⾸先分别在npfdev2和npfdev3和npfdev4机器上,建⽴/usr/local/hadoop⽬录,然后在npfdev1上分别执⾏下⾯命令:scp -r /usr/local/hadoop/hadoop-2.7.3/ npfdev2:/usr/local/hadoop/scp -r /usr/local/hadoop/hadoop-2.7.3/ npfdev3:/usr/local/hadoop/scp -r /usr/local/hadoop/hadoop-2.7.3/ npfdev4:/usr/local/hadoop/记住:需要各⾃修改npfdev2和npfdev3和npfdev4的/etc/profile⽂件:在/etc/profile⽂件中加⼊:export PATH=$PATH:/usr/local/hadoop/hadoop-2.7.3/bin:/usr/local/hadoop/hadoop-2.7.3/sbin执⾏/etc/profile⽂件:source /etc/profile然后分别在npfdev1和npfdev2和npfdev3和npfdev4机器上,执⾏hadoop命令,看是否安装成功。

hadoop小型机群配置

HADOOP-0.20.2分布式集群配置本文以安装和使用hadoop-0.20.2为例。

硬件环境1.虚拟机VMWare Workstation 6.5.2build2.三台机器均安装redhat linux9.03.java jdk1.6.0_24node:192.168.1.100 hadoop1datanode:192.168.1.101 hadoop2datanode:192.168.1.102 hadoop3注意:三台机器dns 和默认网关必须一致。

登陆密码一致最好。

而且务必三台机器互相ping通主机,即主机名和ip解析正确。

若ping不通,修改/etc/hosts文件,使用sudo vi /etc/hosts 命令,设置如下(namenode):192.168.1.100hadoop1192.168.1.101hadoop2192.168.1.102hadoop3Hadoop2(datanode)的设置为:192.168.1.100 hadoop1192.168.1.101 hadoop2Hadoop3(datanode)的设置为:192.168.1.100 hadoop1192.168.1.102 hadoop3.本集群将namenode和jobtracker 设置成一台机器即hadoop1。

配置sshRedhat linux9 自带ssh。

开启命令:service sshd restart。

必须配置SSH使用无密码公钥来进行免密码登陆各个节点。

本集群设置如下:在namenode节点即hadoop1上根目录下执行:[root@hadoop1 root]$ssh-keygen –t dsa一路回车,遇到y/n 选择y。

即在默认目录下/root/.ssh/生成id_dsa 和id_dsa.pub 2个文件,第一个为私钥,第二个为公钥。

[root@hadoop1 root]$cd .ssh进入.ssh目录下,将id_dsa.pub 复制给authorized_keys文件,并给予权限。

在 Ubuntu 上安装Hadoop-0.20.2 教程

在Ubuntu 上安装Hadoop 教程实践环境:U buntu8.04+jdk1.6+hadoop-0.20.1 ( 三台实体机)机器名IP 作用Ubuntu01 192.168.0.4 NameNode 、master 、jobTrackerUbuntu02 192.168.0.3 DataNode 、slave 、taskTracker1 、安装ubuntu8.04更新源修改2 、安装jdk1.6sudo apt-get install sun-java6-jdk(物理机可能安装不上,直接下载jdk安装jdk-1_5_0_14-linux-i586.bin文件安装# chmod a+x jdk-1_5_0_14-linux-i586.bin ←使当前用户拥有执行权限# ./jdk-1_5_0_14-linux-i586.bin ←选择yes直到安装完毕)安装后,添加如下语句到/etc/profile 中:export JA VA_HOME=/usr/lib/jvm/java-6-sunexport JRE_HOME=/usr/lib/jvm/java-6-sun/jreexport CLASSPATH=.:$JA V A_HOME/lib:$JRE_HOME/lib:$CLASSPATHexport PA TH=$JA V A_HOME/bin:$JRE_HOME/bin:$PA TH注意:每台机器的java 环境最好一致。

安装过程中如有中断,切换为root 权限来安装。

(7 、安装hadoop下载hadoop-0.20.1.tar.gz :$ wget /apache-mirror/hadoop/core/hadoop-0.20.2/hadoop-0.20.2.tar.gz解压:$ tar -zvxf hadoop-0.20.2.tar.gz把Hadoop 的安装路径添加到/etc/profile 中:export HADOOP_HOME=/home/wl826214/hadoop-0.20.2export PA TH=$HADOOP_HOME/bin:$PA TH8 、配置hadoophadoop 的主要配置都在hadoop-0.20. 2 /conf 下。

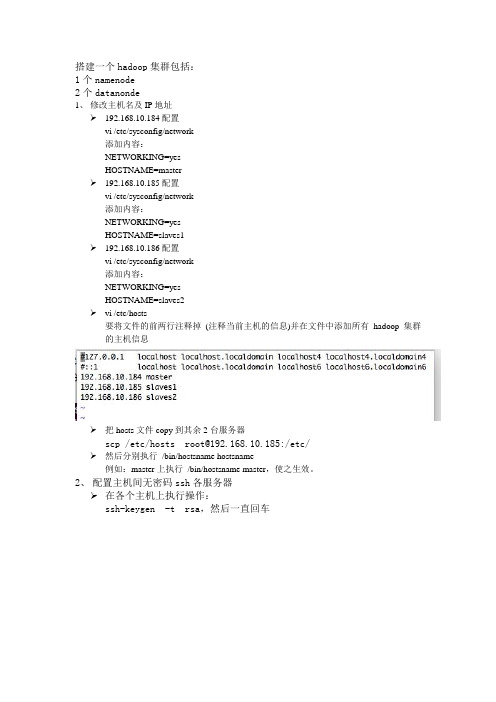

hadoop0.20.2集群配置

搭建一个hadoop集群包括:1个namenode2个datanonde1、修改主机名及IP地址192.168.10.184配置vi /etc/sysconfig/network添加内容:NETWORKING=yesHOSTNAME=master192.168.10.185配置vi /etc/sysconfig/network添加内容:NETWORKING=yesHOSTNAME=slaves1192.168.10.186配置vi /etc/sysconfig/network添加内容:NETWORKING=yesHOSTNAME=slaves2vi /etc/hosts要将文件的前两行注释掉(注释当前主机的信息)并在文件中添加所有hadoop集群的主机信息把hosts文件copy到其余2台服务器scp /etc/hosts root@192.168.10.185:/etc/然后分别执行/bin/hostsname hostsname例如:master上执行/bin/hostsname master,使之生效。

2、配置主机间无密码ssh各服务器在各个主机上执行操作:ssh-keygen -t rsa,然后一直回车在/root/.ssh/目录下生成了两个文件id_rsa 和id_rsa.pubcp id_rsa.pub authorized_keys修改authorized_keys的权限为600chmod 600 ~/.ssh/authorized_keys先将所有authorized_keys合并cat ~/.ssh/authorized_keys | ssh root@192.168.10.167 'cat >> ~/.ssh/authorized_keys'合并结果如下图:然后复制分发到其他服务器(若没有.ssh文件夹需要自行创建)scp authorized_keys root@192.168.10.185:/root/.ssh/ 验证能否无密码ssh,在master服务器上执行操作:注意:第一次可能会提示输入yes or no,之后就可以直接ssh到其他主机上去了。

Hadoop分布式详细安装步骤

Hadoop分布式详细安装步骤版本:0.20.2准备工作:由于Hadoop要求所有主机上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

二台机器上是这样的:都有一个coole的帐户,主目录是/home/coole两台机器(内存应在512以上,否则可能会出现计算极度缓慢的情况):一台机器名:master IP:211.87.239.181一台机器名:slave IP:211.87.239.182每台都建coole用户如果是ubuntu,为了便于用coole帐号修改系统设置和访问系统文件,推荐把coole也设为sudoers(有root 权限的用户),具体做法是用已有的sudoer登录系统,执行sudo visudo –f /etc/sudoers,并在此文件中添加以下一行:mapred ALL=(ALL) ALL一、更改主机名:1、修改/etc/sysconfig/networkNETWORKING=yesHOSTNAME=yourname (在这修改hostname,把yourname换成你想用的名字)NISDOMAIN=修改后机器211.87.239.181中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=master修改后机器211.87.239.182中/etc/sysconfig/network文件内容为:NETWORKING=yesHOSTNAME=slave2、最后在终端下执行:# hostname ***** (*****为修改后的hostname,即你想用的名字)例如#hostname master特别提示:各处修改的名字要保持一致,否则会出现问题。

3、修改每台机器的/etc/hosts,保证每台机器间都可以通过机器名解析配置etc/hosts文件,以root 身份打开/etc/hosts文件。

Master/slave做同样修改。

Hadoop和Hive的安装配置

Hadoop和Hive的安装配置hadoop安装指南/hive安装指南Hadoop集群需要一台机器作为主节点,其余都是从节点。

配置单元只需要在主节点中安装和配置。

配置hadoopHadoop的配置相对简单。

下面详细介绍安装和配置步骤。

要配置Hadoop 0,请以版本20.2为例。

(1)从hadoop官网上下载hadoop-0.20.2.tar.gz文件,并解压产生hadoop-0.20.2目录,将该目录到/opt/hadoop目录下(如果你解压缩到了其它目录中,注意后面要相应的修改配置项)。

输入命令以建立$ln-shadow-0.20.2hadoop的软连接(其优点是,如果使用其他版本的Hadoop,则无需重新配置)(2)hadoop和hive都需要机器名。

用hostname命令修改本机的机器名,例如修改10.10.10.1的机器名为hadoop139需要键入#hostnamehadoop1修改/etc/hosts文件,添加hadoop集群中所有的机器名和ip地址的对应关系。

master节点和所有slave节点一定都要添加,否则会出问题。

例如在我的所有hadoop机器的/etc/hosts文件都添加10.10.10.1 Hadoop 110。

10.10.2 Hadoop 210。

10.10.3 ADOP310。

10.10.4hadoop410。

10.10.5 Hadoop 510。

10.10.6 Hadoop 610。

10.10.7 Hadoop 7(3)由于主节点的机器需要在没有密码的情况下登录到所有从节点,因此所有机器都需要以下配置。

在本文中hadoop1是master节点。

打开/etc/SSH/sshd_uu-Config文件以确保SSH不使用SSH2协议,或者将所有协议2修改为协议1。

如果修改了该文件,用servicesshdrestart命令重启一下ssh服务。

键入以下命令#cd~/.ssh/#ssh-keygen-trsa1-c\#身份。

ubuntu下hadoop集群的配置

Ubuntu下Hadoop-0.20.2集群配置文档一、集群网络环境配置(1)集群包含三台机器,操作系统是ubuntu9.10,并且有一个相同的用户hadoop(具有管理员权限),节点之间局域网连接,可以相互ping 通,三台电脑的IP地址分别设为192.168.90.91、192.168.90.92、192.168.90.93。

(2)更改计算机名因为计算机名存放在/etc/hostname中,在每台ubuntu中,分别运行:sudo gedit /etc/hostname把三台电脑分别改名为ubuntu1,ubuntu2和ubuntu3。

ubuntu1将来要做namenode,ubuntu2和ubuntu3将来要做datanode。

(3)添加IP地址和主机名之间的映射映射关系保存在/etc/hosts中。

因此须在每台ubuntu的/etc/hosts中均添加如下内容:192.168.90.91 ubuntu1192.168.90.92 ubuntu2192.168.90.93 ubuntu3添加完成之后,以后凡是遇到ubuntu1、ubuntu2、ubuntu3等,就能解析出正确的IP地址二、安装Java JDK 1.6因为hadoop是用java开发的,因此需要jdk的支持才能运行,在每台ubuntu下均安装jdk,步骤如下:1),打开终端,执行以下命令:sudo apt-get install sun-java6-jdk(或者default-jdk,相应地,下面的两点需要稍微修改一下)2),配置JAVA 环境变量:sudo gedit /etc/environment在其中添加如下两行:CLASSPATH=.:/usr/lib/jvm/java-6-sun/libJAVA_HOME=/usr/lib/jvm/java-6-sun3),执行命令:sudo gedit /etc/jvm,在最前面加入:/usr/lib/jvm/java-6-sun4),保存完之后更新一下系统配置文件,使环境变量生效,运行命令:source /etc/environment三、S SH无密码验证配置Hadoop需要使用SSH协议,namenode使用SSH无密码登录并启动datanode进程。

hadoop安装实验总结

hadoop安装实验总结Hadoop安装实验总结一、引言Hadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。

在本次实验中,我们将介绍Hadoop的安装过程,并总结一些注意事项和常见问题的解决方法。

二、安装过程1. 确定操作系统的兼容性:Hadoop支持多种操作系统,包括Linux、Windows等。

在安装之前,我们需要确认所使用的操作系统版本与Hadoop的兼容性。

2. 下载Hadoop软件包:我们可以从Hadoop的官方网站或镜像站点上下载最新的稳定版本的Hadoop软件包。

确保选择与操作系统相对应的软件包。

3. 解压缩软件包:将下载的Hadoop软件包解压缩到指定的目录下。

可以使用命令行工具或图形界面工具进行解压缩操作。

4. 配置环境变量:为了方便使用Hadoop命令行工具,我们需要配置环境变量。

在Linux系统中,可以编辑.bashrc文件,在其中添加Hadoop的安装路径。

在Windows系统中,可以通过系统属性中的环境变量设置来配置。

5. 配置Hadoop集群:在Hadoop的安装目录下,找到conf文件夹,并编辑其中的配置文件。

主要包括core-site.xml、hdfs-site.xml 和mapred-site.xml等。

根据实际需求,配置Hadoop的相关参数,如文件系统路径、副本数量、任务调度等。

6. 格式化文件系统:在启动Hadoop之前,需要先格式化文件系统。

使用命令行工具进入Hadoop的安装目录下的bin文件夹,并执行格式化命令:hadoop namenode -format。

7. 启动Hadoop集群:在命令行工具中输入启动命令:start-all.sh(Linux)或start-all.cmd(Windows)。

Hadoop集群将会启动并显示相应的日志信息。

8. 验证Hadoop集群:在启动Hadoop集群后,我们可以通过访问Hadoop的Web界面来验证集群的运行状态。

hadoop安装准备的思考题

hadoop安装准备的思考题在准备安装Hadoop之前,有一些重要的思考题需要考虑。

下面我将从多个角度回答这些问题。

1. 硬件需求:你计划在多少台机器上安装Hadoop?每台机器的配置是什么?每台机器上有多少可用的磁盘空间?是否满足Hadoop的存储需求?每台机器上有多少可用的内存?是否满足Hadoop的内存需求?每台机器的网络带宽如何?是否足够支持Hadoop的数据传输需求?2. 操作系统选择:你打算在哪个操作系统上安装Hadoop?例如,Linux、Windows等。

你选择的操作系统是否与Hadoop的版本兼容?3. Hadoop版本选择:你打算安装哪个版本的Hadoop?是否有特定的需求或功能要求?你是否考虑使用Hadoop的发行版,如Cloudera、Hortonworks或Apache原生版本?4. 网络拓扑规划:你打算如何组织Hadoop集群的网络拓扑结构?例如,是否有独立的主节点和从节点?你打算使用哪种网络协议进行节点间的通信?例如,TCP/IP、InfiniBand等。

5. 安全性考虑:你打算如何保护Hadoop集群的安全性?是否需要配置用户认证、访问控制等功能?你是否需要加密Hadoop集群中的数据传输?6. 存储和备份策略:你打算使用哪种存储系统来存储Hadoop的数据?例如,HDFS、NFS等。

你是否考虑设置数据备份策略,以防止数据丢失?7. 软件依赖和配置:你的Hadoop集群是否依赖其他软件或库?例如,Java、Zookeeper等。

你打算如何配置Hadoop的各个组件,以满足你的需求?8. 监控和调优:你是否考虑设置监控系统来监视Hadoop集群的运行状态?你是否需要进行性能调优,以提高Hadoop集群的性能和吞吐量?以上是一些在准备安装Hadoop时需要考虑的思考题。

通过对这些问题的全面思考和策划,你可以更好地准备和规划Hadoop的安装过程,以确保成功地部署和运行Hadoop集群。

实验-hadoop开发环境部署

实验-hadoop开发环境部署hadoop-0.20.2⾃带了eclipse插件,⽐如1.0.0和2.2.0就没有1.windows下1)把插件hadoop-0.20.2-eclipse-plugin.jar复制到eclipse⽬录下的plugins⽬录中;2)启动eclipse;3) windown->preferences->Hadoop Map/Reduce4)打开Map/Reduce视图window->show view->Map/Reduce Location5)配置hadoop右键选择New Hadoop location(名字随意、第⼀个是MR的地址和端⼝,第⼆个是HDFS的地址和端⼝,要配的和配置⽂件中的⼀样,特别注意User name⼀定要填Namenode的⽤户名,之前因为没注意,⼀直报错)然后运⾏集群,即可链接如果链接不上<1>.namenode的防⽕墙关掉(root⽤户);<2>.关掉HDFS的⽤户检查6)能查看HDFS上的⽂件说明HDFS链接成功了,再测试⼀下MR<1>.新建⼀个hadoop⼯程<2>.⾃⼰写个代码或者直接贴上wordcount的代码<3>.运⾏。

设置输⼊输出参数这时出现问题:windows中chmod这个命令,解决办法:安装cygwin,然后把它的安装⽬录bin⽬录设置到环境变量Path中就可以了2.Linux下(这个要更简单点)1)安装eclipse(省略)2)安装hadoop插件、Map/Reduce Locations、Hadoop installation Directoy等这个不需要配置Linux环境和不⽤关⼼⽤户问题。

3)测试wordcount也同上。

其中有个问题我没懂得就是在配置运⾏参数的时候不能直接⽤/input/ /output/,必须⽤hdfs://192.168.126.129:9000/in这样的全称我看到别⼈的⽂档中可以,不知道是我哪⼉设置有问题还是他们在忽悠⼈。

hadoop安装及运行维护汇总小问题共13页word资料

windows安装hadoop博客分类:•hadoopWindowsHadoopJavaJDKMapreducehadoop是什么就不多说了,看这里hadoop推荐部署环境是在linux,但是我们想要在windows体验一下还是可以的,followme我的环境:windowsxp,hadoop安装包(0.20.1),cygwin打开cygwin Java代码1.explorer.把hadoop的包放到这个目录下然后输入命令Java代码1.tarzxfhadoop-0.20.1.tar.gz解压完成后进入hadoop-0.20.1的配置目录,打开core-site.xml,加入以下内容。

这里是定义namenode运行地址和端口Xml代码1.<property>2.<name></name>3.<value>hdfs://localhost:9000</value>4.</property>打开hdfs-site.xml,加入以下内容Java代码1.<property>2.<name>dfs.replication</name>3.<value>1</value>4.</property>这里把复制因子设置为1是因为我们在windows上做伪分布,只能启动一个datanode接下来可以定义namenode数据目录,和datanode数据目录。

当然这个不是必须的,默认是在/tmp目录下面Xml代码1.<property>2.<name>.dir</name>3.<value>c:/filesystem/name</value>4.</property>5.<property>6.<name>dfs.data.dir</name>7.<value>c:/filesystem/data</value>8.</property>最后修改hadoop-env.sh,把下面注释的这行打开,并设置为你的jdk路径。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

安装

2011年4月4日

10:13

Hadoop-0.20.2安装使用

1、Cygwin 安装 ssh

2、按照以下的文档配置ssh

在Windows上安装Ha

doop教程.pdf

3、几个配置文件的配置

3.1、conf/core-site.xml

<property>

<name></name>

<value>hdfs://localhost:9000</value>

<final>true</final>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/workspace/temp/hadoop/tmp/hadoop-

${}</value>

<final>true</final>

</property>

3.2、conf/hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

<final>true</final>

</property>

<property>

<name>.dir</name>

<value>/workspace/temp/hadoop/data/hadoop/name</value>

<final>true</final>

</property>

<property>

<name>dfs.data.dir</name>

<value>/workspace/temp/hadoop/data/hadoop/data</value>

<final>true</final>

</property>

3.3、conf/mapred-site.xml

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

<final>true</final>

</property>

3.4、conf/hadoop-env.sh

export JAVA_HOME=D:/workspace/tools/jdk1.6

4、解决启动的时候 ClassNotFound: org.apache.hadoop.util.PlatformName

将 %hadoop_home%\bin\hadoop-config.sh中的第190行

修改为如下:

JAVA_PLATFORM=`CLASSPATH=${CLASSPATH} ${JAVA} -Xmx32m -classpath ${HADOOP_COMMON_HOME}/hadoop-common-0.21.0.jar

org.apache.hadoop.util.PlatformName | sed -e "s/ /_/g"`

5、命令

6、创建HBase文件夹

bin/hadoop dfs -mkdir Hbase

bin/hadoop dfs -mkdir tmp

http://localhost:50070/

http://localhost:50030/

1、修改bin/hbase-env.sh 中的

export JAVA_HOME

export HBASE_MANAGES_ZK=true

2、将conf/hbase-default.xml文件中的内容完全复制到conf/hbase-site.xml中

3、对conf/hbase-site.xml文件做如下修改:

<property>

<name>hbase.rootdir</name>

<value>hdfs://localhost:9000/hbase</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/workspace/temp/hadoop/tmp/hbase-${}</value>

<description>Temporary directory on the local filesystem.</description> </property>

<property>

<name>hbase.cluster.distributed</name>

<value>false</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>127.0.0.1</value>

</property>

<property>

<name>hbase.zookeeper.property.clientPort</name>

<value>2222</value>

<description>Property from ZooKeeper's config zoo.cfg.

The port at which the clients will connect.

</description>

</property>

Hive-0.5.0安装和使用

一、创建Hive所需目录

bin/hadoop dfs -mkdir /user/hive/warehouse

bin/hadoop dfs -mkdir /tmp

bin/hadoop dfs -chmod g+w /user/hive/warehouse

bin/hadoop dfs -chmod g+w /tmp

二、修改bin/hive-config.sh文件,增加以下内容

export HIVE_HOME=/cygdrive/d/workspace/tools/hadoop/run/hive export HADOOP_HOME=/cygdrive/d/workspace/tools/hadoop/run/hadoop。