数据库性能测试报告-1.0.0

Veeam Availability Suite-POC测试报告 v1.0

某某客户Veeam Availability Suite v9 POC 测试报告目录1测试介绍和目的 (4)2系统架构 (6)2.1部署拓扑图 (6)2.2测试环境信息 (7)2.3组件介绍 (7)Veeam Backup Server (7)Backup Proxy (8)Backup Repository (9)Veeam ONE Server (9)3功能验证 (11)3.1与VMware集成 (11)特点 (11)POC验证截图 (11)3.2备份任务的负载均衡 (13)特点 (13)POC验证截图 (14)3.3备份空间的灵活扩展 (14)特点 (14)POC验证截图 (15)3.4数据备份 (16)特点 (16)POC验证截图 (16)3.5数据恢复 (20)特点 (20)POC验证截图 (21)3.6即时恢复(高速迁移) (22)特点 (22)POC验证截图 (23)3.7SureBackup(验证备份可恢复性) (24)特点 (24)POC验证截图 (26)3.8Replication复制功能 (26)特点 (26)POC验证截图 (27)4测试记录 (31)4.1常规项目测试 (31)系统安装搭建过程 (31)系统操控性与界面友好性 (32)4.2备份策略与任务 (33)4.3虚拟机的备份功能、监测与性能 (36)虚拟机的image恢复功能、监测与性能 (37)虚拟机的instance恢复功能、监测与性能 (38)4.4虚拟机恢复验证测试策略功能(SureBackup) (40)4.5虚拟机复制功能、监测与性能 (41)4.6Veeam one监控报表功能 (42)5测试结论 (44)1 测试介绍和目的某某客户(以下简称:)使用了VMware虚拟化作为应用系统的基础架构,虚拟化环境已经投入xx百台ESXi物理服务器,当前VM虚机规模1xxx左右.虚拟机系统以Linux为主(Linux系统占虚拟机的x0%,Windows系统占虚拟机的x0%),为避免虚机系统因人员误操作、安全漏洞、设备故障等原因造成的数据损坏或业务中断,目前宜信正在为提升服务器虚拟化平台的数据完整性、业务连续性做调研和论证.本次测试主要针对用户VMWARE平台的备份/恢复工作,通过使用Veeam旗舰级产品Veeam Availability Suite软件套件进行全面、深入的测试,来检验Veeam数据保护和管理系统是否能满足用户对数据完整性和可用性、业务连续性等各类迫切的实际需求,为本次项目提供更有效、更可靠、更全面的技术参考与实际测试依据,此次测试内容如下:2 系统架构2.1 部署拓扑图本次POC部署拓扑图如下所示:图表2-1 POC环境部署图测试环境准备:1、采用了1台服务器(本次使用虚拟机进行测试)部署Veeam Backup Server和Veeam VeeamONE Server。

数据库性能测试:sysbench用法详解

数据库性能测试:sysbench⽤法详解1.简介和安装sysbench是⼀个很不错的数据库性能测试⼯具。

如果是编译安装,需要先安装好mysql的开发包(尽管编译错误时提⽰的是缺少Mysql库⽂件)。

yum -y install mysql-community-develtar xf 1.0.15.tar.gzcd sysbench-1.0.15./autogen.sh./configuremake -jmake install安装后,只有⼀个⼆进制⽂件sysbench,还提供了很多个lua脚本。

[root@s1 ~]# rpm -ql sysbench | grep 'bin\|lua'/usr/bin/sysbench/usr/share/sysbench/bulk_insert.lua/usr/share/sysbench/oltp_common.lua/usr/share/sysbench/oltp_delete.lua/usr/share/sysbench/oltp_insert.lua/usr/share/sysbench/oltp_point_select.lua/usr/share/sysbench/oltp_read_only.lua/usr/share/sysbench/oltp_read_write.lua/usr/share/sysbench/oltp_update_index.lua/usr/share/sysbench/oltp_update_non_index.lua/usr/share/sysbench/oltp_write_only.lua/usr/share/sysbench/select_random_points.lua/usr/share/sysbench/select_random_ranges.lua/usr/share/sysbench/tests/include/inspect.lua/usr/share/sysbench/tests/include/oltp_legacy/bulk_insert.lua/usr/share/sysbench/tests/include/oltp_legacy/common.lua/usr/share/sysbench/tests/include/oltp_legacy/delete.lua/usr/share/sysbench/tests/include/oltp_legacy/insert.lua/usr/share/sysbench/tests/include/oltp_legacy/oltp.lua/usr/share/sysbench/tests/include/oltp_legacy/oltp_simple.lua/usr/share/sysbench/tests/include/oltp_legacy/parallel_prepare.lua/usr/share/sysbench/tests/include/oltp_legacy/select.lua/usr/share/sysbench/tests/include/oltp_legacy/select_random_points.lua/usr/share/sysbench/tests/include/oltp_legacy/select_random_ranges.lua/usr/share/sysbench/tests/include/oltp_legacy/update_index.lua/usr/share/sysbench/tests/include/oltp_legacy/update_non_index.lua本⽂介绍的是新版本sysbench oltp lua脚本的⽤法(/usr/share/sysbench/*.lua),所以不涉及传统的lua(tests/include/oltp_legacy/*.lua),如果想要了解这些传统Lua脚本的⽤法,⽹上随便找。

移动通信网网络管理技术规范 OMC北向接口 PCRF性能测量数据V1.0.0

1范围 (1)2规范性引用文件 (1)3术语、定义和缩略语 (1)3.1术语和定义 (1)3.1.1性能测量族 (1)3.2缩略语 (1)4PCRF GX接口消息测量数据 (2)4.1CC发起请求次数 (2)4.2CC发起成功次数 (2)4.3CC发起失败次数 (3)4.4CC更新请求次数 (3)4.5CC更新成功次数 (4)4.6RA请求次数 (4)4.7RA成功次数 (5)4.8RA失败次数 (5)4.9RA超时次数 (6)4.10CC结束请求次数 (6)4.11CC结束成功次数 (7)5SCTP偶联性能测量数据 (8)6以太网端口性能测量数据 (8)7系统负荷测量数据 (8)8编制历史 (8)本标准主要用于PCRF OMC北向接口性能测量。

本标准包括的主要内容为PCRF性能测量数据定义。

本标准是LTE OMC北向接口信息模型系列标准之一,该系列标准的结构、名称或预计的名称如下:标准需与QB-W-002-2009《移动通信网网络管理接口技术规范OMC北向接口-公共性能测量参数》配套使用。

1范围本标准规定了LTE网络管理接口中PCRF性能测量参数。

本规范支持LTE核心网网络质量指标分析,有关指标算法定义参见核心网网络管理指标技术规范。

本标准的用户群可能包括:运营商管理人员、运营商网络维护人员、运营商业务流量分析人员、运营商客服服务人员、设备商性能建模分析人员和设备商工程建设人员。

2规范性引用文件下列文件中的条款通过本标准的引用而成为本标准的条款。

凡是注日期的引用文件,其随后所有的修改单(不包括勘误的内容)或修订版均不适用于本标准,然而,鼓励根据本标准达成协议的各方研究是否可使用这些文件的最新版本。

凡是不注日期的引用文件,其最新版本适用于本标准。

3术语、定义和缩略语3.1术语和定义3.1.1性能测量族3.2缩略语4PCRF Gx接口消息测量数据4.1CC发起请求次数a) 重要度:Ab) 英文名称:InitialRequestc) 中文名称:CC发起请求次数d) 定义:发起Credit Control请求次数;e) 触发点:PCRF收到CC-Request(CC-Request-Type=INITIAL_REQUEST)消息(见3GPP TS29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.2CC发起成功次数a) 重要度:Ab) 英文名称:InitialSuccessc) 中文名称:CC发起成功次数d) 定义:发起Credit Control的成功次数;e) 触发点:PCRF发出CC-Answer(CC-Request-Type=INITIAL_REQUEST,Result-Code=2001)消息(见3GPP TS 29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.3CC发起失败次数a) 重要度: (0)B (1)Cb) 英文名称:(0)InitialFail (1)InitialFail._Causec) 中文名称:(0)CC发起失败次数(1)分原因的CC发起失败次数d) 定义:发起Credit Control失败次数,并按不同的原因码分类统计e) 触发点:PCRF发出CC-Anwser(Result-Code≠2001)消息;f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:(0)否(1)否m) 备注:4.4CC更新请求次数a) 重要度:Ab) 英文名称:UpdateRequestc) 中文名称:CC更新请求次数d) 定义:更新Credit Control请求次数;e) 触发点:PCRF收到CC-Request(CC-Request-Type=UPDATE_REQUEST)消息(见3GPP TS29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.5CC更新成功次数a) 重要度:Ab) 英文名称:UpdateSuccessc) 中文名称:CC更新成功次数d) 定义:更新Credit Control的成功次数;e) 触发点:PCRF发出CC-Answer(CC-Request-Type=UPDATE_REQUEST,Result-Code=2001)消息(见3GPP TS 29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.6RA请求次数a) 重要度:Ab) 英文名称:DIAM.ReAuthRequestc) 中文名称:RA请求次数d) 定义:Re-Auth请求次数;e) 触发点:PCRF发出Re-Auth-Request消息(见3GPP TS 29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.7RA成功次数a) 重要度:Ab) 英文名称:DIAM.ReAuthSuccessc) 中文名称:RA成功次数d) 定义:Re-Auth成功次数e) 触发点:PCRF收到Re-Auth-Anwer(Result- Code=2001)消息(见3GPP TS 29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.8RA失败次数a) 重要度: (0)B (1)Cb) 英文名称:(0)DIAM.ReAuthFail (1)DIAM.ReAuthFail._Causec) 中文名称:(0)RA失败次数(1)分原因的RA失败次数d) 定义:Re-Auth失败次数,并按不同的原因码分类统计e) 触发点:PCRF收到Re-Auth-Anwser(Result-Code≠2001)消息;f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:(0)否(1)否m) 备注:4.9RA超时次数a) 重要度:Bb) 英文名称:DIAM.ReAuthTimeoutc) 中文名称:RA超时次数d) 定义:Re-Auth超时次数;e) 触发点:PCRF的等待定时器超时仍未收到Re-Auth-Answer消息(见3GPP TS 29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:否m) 备注:4.10CC结束请求次数a) 重要度:Ab) 英文名称:TerminateRequestc) 中文名称:CC结束请求次数d) 定义:结束Credit Control请求次数;e) 触发点:PCRF收到CC-Request(CC-Request-Type=TERMINATE_REQUEST)消息(见3GPP TS29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:4.11CC结束成功次数a) 重要度:Ab) 英文名称:TerminateSuccessc) 中文名称:CC结束成功次数d) 定义:结束Credit Control的成功次数;e) 触发点:PCRF发出CC-Answer(CC-Request-Type=TERMINATE_REQUEST,Result-Code=2001)消息(见3GPP TS 29.212);f) 采集方式:CCg) 数据类型:整型h) 单位:次i) 空间粒度:EpRpDynGxPcrfj) 时间粒度:15分钟k) 上报周期:15分钟l) 测试要求:是m) 备注:5SCTP偶联性能测量数据参见《移动通信网网络管理技术规范 OMC北向接口 eNodeB性能测量数据》的公共性能测量数据的4.2节。

产品性能测试报告

产品性能测试报告报告编号:CPM2022-001报告日期:2022年10月10日报告主题:产品性能测试报告1. 背景介绍对于任何产品,性能是其最重要的指标之一。

本报告旨在对XXX公司新产品进行全面的性能测试和分析,以评估其在实际环境中的表现,并为产品改进提供参考。

2. 测试目的本次性能测试的主要目的如下:- 评估产品的各项性能指标,包括但不限于速度、稳定性和资源利用率。

- 针对测试结果进行分析,发现性能瓶颈和优化方向,提供改进建议。

- 验证产品是否满足设计规格和用户需求,确保产品质量和可靠性。

3. 测试环境为了保证测试结果的准确性和可比性,我们在以下环境中进行了测试:- 操作系统:Windows 10 Professional- 处理器:*************************- 内存:16GB- 硬盘:500GB SSD- 软件版本:XXX产品版本1.0.04. 测试方法我们采用了以下测试方法来评估产品的性能:- 压力测试:模拟高负载情况下的产品表现,测试其稳定性和响应时间。

- 并发测试:通过同时模拟多个用户请求,评估产品在多线程场景下的性能表现。

- 资源利用率测试:监测产品在运行过程中的CPU、内存和磁盘利用率,以评估其资源消耗情况。

- 容量测试:测试产品在处理大量数据时的性能表现和容量限制。

5. 测试结果与分析经过一系列测试,我们得出了以下结论和分析结果:5.1 速度和响应时间在压力测试中,产品的平均响应时间表现稳定,均低于1秒。

根据用户需求,这个响应时间已经满足了产品的性能要求。

5.2 稳定性产品在长时间高负载运行的情况下,未出现任何异常崩溃或错误,表现出令人满意的稳定性。

5.3 并发性能在并发测试中,产品在100个同时请求的情况下,每秒能够处理150个请求,响应时间保持在合理的范围内。

然而,在高并发场景下,我们观察到了轻微的性能下降,建议在后续版本中进一步优化处理能力。

5.4 资源利用率产品在正常运行情况下,对CPU和内存的利用率保持在合理范围内,但在某些特定操作下,磁盘利用率较高,建议优化磁盘读写性能,以提升整体性能。

BingoCloud云平台Intel CAS测试报告_v1.0

1.2.3 产品规格和系统要求

本测试中 Linux 版本的 Intel CAS 支持的操作系统及系统要求如表 1-2 所示。

表 1-2 系统要求 操作系统

内存 CPU 资源占用率 固态硬盘

ise Linux(RHEL) 5.6 Built and configured with x86_64,Kernel 2.6.18

Red Hat Enterprise Linux(RHEL) 6.1 Built and configured with x86_64,Kernel 2.6.32

1.2 测试对象

1.2.1 软件简介

本次测试的对象是 iCAS 软件,该软件是由 Intel 研发的部署在服务器端的基于固态硬盘(SSD) 的热点数据缓存加速软件,旨在帮助优化数据中心环境中的固态驱动器硬件的性能。

本次测试选择的软件版本和名称详情如表 1-1 所示。

表 1-1 测试软件版本和名称

软件

3 测试场景和用例 .................................................................. 6 3.1 硬盘读取性能测试 .......................................................... 6 3.1.1 用例一:硬盘随机读取性能测试 ........................................ 6 3.1.2 用例二:硬盘连续读取性能测试 ........................................ 6 3.2 数据库访问性能测试 ........................................................ 6 3.2.1 用例三:不同负载下数据库访问性能测试 ................................ 6 3.2.2 用例四:数据库备份性能测试 .......................................... 7 3.3 Exchange 邮件系统压力测试 ................................................. 7 3.3.1 用例五:Exchange 数据库压力测试 ...................................... 7

性能测试报告

2.0和1.0默认对比百分比

20.62

dubbo序列化相比hessian2序列化百分比

4.82

1k TPS

1k Response

TPS成功平均值

响应时间成功平均值(ms)

dubbo1(hessian2序列化+mina

1962.7

10813.5

dubbo2 (hessian2序列化+netty)

11994

dubbo2 (dubbo序列化+netty)

13620

rmi

2461.79

hessian

2417.7

http(json序列化)

8179.08

JVM 内存运行稳定,无 OOM,堆内存中无不合理的大对象的占用。通过

CPU、内存、网络、磁盘、文件句柄占用平稳。通过

无频繁线程锁,线程数平稳。通过

业务线程负载均衡。通过

性能测试场景(10 并发)

传入 1k String,不做任何处理,原样返回

传入 50k String,不做任何处理,原样返回

本次性能测试考察的是 dubbo 本身的性能,实际使用过程中的性能有待应用来验证。

由于 dubbo 本身的性能占用都在毫秒级,占的基数很小,性能提升可能对应用整体的性能变化不大。

由于邮件篇幅所限没有列出所有的监控图,如需获得可在大力神平台上查询。

ቤተ መጻሕፍቲ ባይዱ

11940

dubbo2 (hessian2序列化+netty)

14402

dubbo2 (dubbo序列化+netty)

15096

rmi

软件压力测试报告

软件压力测试报告压力测试报告1. 测试概述在本次压力测试中,我们对软件进行了一系列压力测试以评估其在高负载情况下的性能表现。

测试的目标是确定软件在正常使用情况下的性能限制和最大负载能力。

2. 测试环境- 操作系统:Windows 10- 处理器:Intel Core i7- 内存:8GB- 软件版本:1.0.03. 测试方法我们使用了压力测试工具来模拟大量用户同时访问软件,并记录软件在不同负载下的响应时间、吞吐量和错误率等指标。

我们根据测试结果绘制了性能曲线图以便于分析软件的性能表现。

4. 测试结果- 响应时间:在轻负载情况下,软件的响应时间平均为500毫秒。

但随着负载的增加,响应时间逐渐增加,最终达到了2秒的峰值。

- 吞吐量:在轻负载情况下,软件的吞吐量平均为100个请求/分钟。

但随着负载的增加,吞吐量逐渐下降,最终达到了50个请求/分钟的峰值。

- 错误率:在轻负载情况下,软件的错误率非常低,仅为0.5%。

但随着负载的增加,错误率逐渐增加,最终达到了5%的峰值。

5. 结论根据测试结果,我们可以得出以下结论:- 软件在轻负载情况下表现良好,响应时间短,吞吐量高,并且错误率低。

- 软件在高负载情况下性能有所下降,响应时间增加,吞吐量下降,并且错误率增加。

- 软件的最大负载能力是50个请求/分钟,在这个负载下软件的性能已达到其极限。

6. 建议鉴于测试结果,我们建议以下改进措施以提升软件的性能: - 优化软件的代码,提高其执行效率,从而减少响应时间。

- 增加软件的服务器容量,提高其吞吐量。

- 定期进行性能测试,并根据测试结果优化软件的设计和架构。

注:以上报告仅是假设的示例,实际报告会根据具体测试情况和要求进行编写。

软件测试报告性能测试评估

软件测试报告性能测试评估一、背景介绍在软件开发过程中,性能是一个非常重要的考量因素。

为了确保软件的稳定性和可靠性,需要进行性能测试评估。

本文将对软件的性能测试结果进行报告,并对性能测试评估进行分析和总结。

二、测试环境1. 软件版本:XXX软件 V1.02. 操作系统:Windows 103. 处理器:Intel Core i7-87004. 内存:16GB DDR45. 硬盘:256GB SSD6. 浏览器:Google Chrome 92.0.4515.159三、测试方法我们采用了以下的测试方法来评估软件的性能:1. 负载测试:通过给软件施加不同负载,观察其在高负载下的表现。

2. 压力测试:通过给软件施加高并发请求,观察其在并发情况下的响应时间和资源利用率。

3. 容量测试:通过逐渐增加数据量,观察软件在不同数据量下的性能表现。

4. 稳定性测试:通过长时间运行软件,观察其在连续运行时的稳定性和资源消耗情况。

四、测试结果经过以上测试方法的评估,我们得到了以下的测试结果:1. 负载测试结果:在负载测试中,软件在正常负载下的表现良好,平均响应时间为X毫秒。

在高负载情况下,平均响应时间略有增加,为X毫秒。

整体来说,软件的性能在负载测试中表现稳定。

2. 压力测试结果:在压力测试中,软件在并发请求数量为X时,平均响应时间为X毫秒,资源利用率为X%。

随着并发请求数量的增加,平均响应时间逐渐增加,资源利用率也有所增加。

我们推测软件在极限并发情况下可能会出现性能瓶颈,建议在实际应用部署时进行进一步优化。

3. 容量测试结果:在容量测试中,我们逐渐增加数据量,观察软件的性能表现。

结果显示,软件在处理小规模数据时表现良好,平均响应时间为X毫秒。

随着数据量的增加,平均响应时间逐渐增加。

对于大规模数据,软件的性能有所下降。

建议在处理大规模数据时优化算法和资源配置,以提高性能。

4. 稳定性测试结果:在连续运行测试中,我们发现软件在长时间运行时表现非常稳定,没有出现明显的崩溃和性能下降情况。

智能家居控制系统软件测试报告

编号:ZNSH-1.0.0智能家居控制系统软件测试报告[V1.0.0]单位:嘉兴学院数理与信息工程学院测试人员:周伟专业:软件工程学号:************2017年12月目录1 简介 (3)1.1 编写目的 (3)1.2 项目背景 (3)1.3系统简介 (3)1.4 数据库设计 (4)1.4.1 数据库设计概述 (4)1.4.2 数据分析 (4)1.5 数据库的详细设计 (5)1.5.1 数据库的E-R图的设计 (5)1.6参考资料 (6)2 测试概要 (6)2.1测试用例设计 (6)2.2测试环境与配置 (10)2.3测试方法(和工具) (11)2.3.1 白盒测试 (11)2.3.2 黑盒测试 (13)3 测试结果及缺陷分析 (14)3.1 测试执行情况与记录 (14)3.1.1 测试计划 (16)3.1.2 测试版本 (16)3.2 覆盖分析 (17)3.2.1 需求覆盖 (17)3.2.2 测试覆盖 (17)3.3 缺陷的统计与分析 (18)4 测试结论 (20)1简介1.1编写目的本本测试报告为智能家居控制系统的测试报告,目的在于总结测试阶段的测试情况以及分析测试结果,描述系统是否符合用户需求,是否已达到用户预期的功能目标,并对测试质量进行分析。

测试报告参考文档提供给用户、测试人员、开发人员、项目管理者、其他管理人员和需要阅读本报告的高层经理阅读。

1.2项目背景智能家居现作为一个新生产业,处于一个导入期与成长期的临界点,市场消费观念还未形成,但随着智能家居市场推广普及的进一步落实,培育起消费者的使用习惯,智能家居市场的消费潜力必然是巨大的,产业前景光明,今后也必将成为家居领域发展的趋势。

且制造企业在产业调整和转型中,都需要运用到大数据。

今后,数据将成为推进社会进步的第四生产力,市场潜力巨大。

在智能家居控制系统中,用户可以直接对安防、监控、灯光、窗帘、电器、影音娱乐、多屏互动等家居进行管理和操作,但必须由中心管理员进行权限授予。

测试报告模板

测试报告模板第一篇:测试报告模板(概述部分)一、测试对象测试对象名称:xxxxx测试对象版本号:V1.0测试日期:20xx年xx月xx日测试人员:xxx二、测试目的本次测试旨在验证测试对象的功能、性能和稳定性,发现和修复其中存在的问题,以保证其产品质量和用户体验。

三、测试需求1.功能测试1)测试对象的各个功能是否能正常运行;2)测试对象的各个功能是否符合需求文档的规定;3)测试对象的各个功能是否能与系统的其他模块协同工作。

2.性能测试1)测试对象是否能在规定时间内响应用户的请求;2)测试对象是否能在一定的负载下保持稳定的响应速度。

3.稳定性测试1)测试对象是否会出现系统崩溃或异常。

四、测试策略1.功能测试1)测试用例编写:编写测试用例并根据需求文档进行覆盖测试;2)测试用例执行:按照测试用例执行测试,并统计测试数据;3)缺陷报告:对测试中发现的各种缺陷进行详细的记录和报告。

2.性能测试1)测试用例编写:根据性能测试需求编写测试用例;2)测试用例执行:执行测试用例并统计测试数据;3)测试结果分析:根据测试结果进行数据处理并给出测试报告。

3.稳定性测试1)测试用例编写:针对系统的稳定性问题编写测试用例;2)测试用例执行:执行测试用例并进行统计;3)缺陷报告:对于测试中发现的系统崩溃或异常等问题进行详细的记录和报告。

五、测试进度本次测试计划工作日共计10个工作日,具体进度如下:1.功能测试:3天2.性能测试:3天3.稳定性测试:2天4.测试报告编写:2天六、测试环境1)硬件环境:CPU xx GHz,内存 xx GB,硬盘 xx GB;2)软件环境:操作系统 xx,数据库 xx,浏览器 xx。

七、测试标准1)功能测试:通过率≥90%;2)性能测试:响应时间≤1秒,吞吐量≥5000个请求/分钟;3)稳定性测试:故障率≤5%。

八、测试结论在本次测试中,测试对象的各个功能均能够正常工作,并且能够满足需求文档的规定。

性能测试报告模板

XXX系统性能测试报告修订历史记录1.性能测试背景1.1编写目的............................................. 错误!未定义书签。

1.2项目背景............................................. 错误!未定义书签。

1.3定义................................................. 错误!未定义书签。

1.4参考资料............................................. 错误!未定义书签。

2.性能测试目标. (5)3.性能测试范围 (6)4.名词术语约定 (7)5.测试环境 (8)5.1生产环境系统架构 (8)5.2测试环境系统架构 (8)5.3生产环境软硬件配置 (8)5.4测试环境软硬件配置 (8)5.5负载机软硬件配置 (9)6.测试数据101.性能测试背景略2.性能测试目标基于XX 业务量的要求,评估XXX 系统能否满足性能要求。

进行配置测试,找到相对合理的配置。

对XXX 系统进行定容定量,提供规划参考。

验证系统的稳定性,验证系统的容错能力,测试并找出系统可能存在的性能问题,分析系统瓶颈风险。

3.性能测试范围通过性能测试需求调研,分析用户使用行为,对系统的用户及业务数据量作了定量分析,性能测试将主要集中在如下表业务过程中。

4.名词术语约定负载:模拟业务操作对服务器造成压力的过程。

性能测试(Performance Testing):模拟用户负载来测试系统在负载情况下,系统的响应时间、吞吐量等指标是否满足性能要求。

负载测试(Load Testing):在一定软硬件环境下,通过不断加大负载(不同虚拟用户数)来确定在满足性能指标情况下能够承受的最大用户数。

简单来说,可以帮我们对系统进行定容定量,找出系统性能的拐点,给予生产环境规划建议。

这里的性能指标包括TPS (每秒事务数)、RT(事务平均响应时间)、CPU Using (CPU 利用率)、Mem Using(内存使用情况)等软硬件指标。

10-YIOYE系统系统测试报告【各平台系统通用模板】

YIOYE系统测试报告XX公司技术股份有限公司变更历史版权所有:XX公司技术股份有限公司目录1引言 (4)1.1文章概述 (4)1.3系统简介 (4)1.4参考资料 (4)2测试环境 (4)2.1硬件配置 (4)2.2软件配置 (5)2.3测试配置 (5)3测试时间安排 (5)3.1测试组织 (5)3.2测试时间 (5)4测试结果分析 (6)4.1测试执行情况与记录 (7)4.2B UG分类 (8)5缺陷的统计与分析 (9)5.1缺陷汇总 (9)5.2缺陷分析 (9)5.3残留缺陷与未解决问题 (10)6测试结论与建议 (10)6.1测试结论 (10)6.2建议 (10)1引言1.1文章概述本文档是系统测试报告(记录),使用者包括项目管理人员、软件测试人员、软件开发人员、监理及建设方相关人员。

本文档属于项目内部文件,在项目组范围内使用,并在项目结束后与其他文档资料和软件系统一起移交给建设方。

未经开发方和建设方的书面同意,任何项目组成员不得将此文档提供给非项目组成员的其他人员或机构使用。

1.3系统简介园区云平台项目包含”5+1”现代产业,园区概况,平台服务,园区要闻,大数据信息于一体的XX省省产业园区信息平台。

1.4参考资料2测试环境2.1硬件配置数据库服务器配置CPU:4核内存:8GB硬盘:可用空间大小40G操作系统:windows server 2012应用软件:园区云平台机器网络名:经典网络2.2软件配置操作系统:windows server 2012安装软件:Apache Tomcat 8.0,JA V A 82.3测试配置BUG管理工具:禅道web端测试工具:selenium、AutoRunner、postman 性能测试工具:Loadrunner、Jmeter抓包分析工具:fiddler数据库工具:mysql3测试时间安排3.1测试组织测试组架构图,介绍如下:测试:刘代珏婷3.2测试时间主要列出测试的跨度和分配如下:界面测试时间:2(天)确保用户界面会通过测试对象的功能来为用户提供相应的访问或浏览功能,满足客户的需求,并且用户界面符合公司或行业的标准。

测试报告模板1.0

XXX项目验收测试报告XX有限公司二〇XX年XX月XX日目录目录 .................................................................................................................................................. I I 测试报告概述.................................................................................................................................. I II 第1章样品描述 . (1)第2章测试环境 (2)2.1 硬件环境 (2)2.2 软件环境 (2)第3章合格标准 (3)第4章测试结果 (4)4.1 功能性 (4)4.1.1 适用性和准确性 (4)4.1.1.1 XX子系统 (4)4.2 安全性 (4)4.3 可靠性 (5)4.4 易用性 (7)4.5 适应性 (7)4.6 互操作 (8)4.7 易用性 (8)4.8 可拓展性 (8)4.9 用户文档 (9)4.10 系统性能 (9)4.10.1 测试结果分析 (10)4.10.1.1 基本能力测试 (10)测试报告概述第1章样品描述本期项目的主要建设任务是开发核心业务工作平台,从根本上对原有系统应用模式、数据存储策略、程序底层架构、软件业务实现等各方面进行重新规划,把现有核心业务应用系统架构转换为B/S 构架,实现XX核心业务应用系统与核心信息资源的集中处理与存储,完成核心业务分散应用模式向大集中应用模式的转变。

……第2章测试环境2.1硬件环境2.2软件环境第3章合格标准编写参考如下:满足以下所有条件,则测试结果为合格;否则,测试结果为不合格:功能测试:致命错误数、严重数为0,一般错误率≤10%,轻微错误率≤12%;性能测试:满足合同需求;互操作性测试:测试数据期望值与实际结果相差<10%;易用性测试:测试项通过率为85%;适应性测试:测试项通过率为85%;易安装性测试:测试项通过率为85%;可扩展性测试:测试项通过率100%;互操作性测试:测试项正确率100%;可靠性测试标准:要求系统可用度≥99.8%,平均失效恢复时间<30 分钟,偶然故障率不超过1,初期故障率不超过1;安全性测试:严重错误数为0,一般错误数少于 2 个;文档测试:满足《GB/T 17544-1998 信息技术软件包质量要求和测试》第3.2 条的要求。

软件系统性能测试报告(通用模板)

软件系统性能测试报告(通用模板)

1. 测试目的

该文档的目的是记录软件系统的性能测试结果,并对结果进行分析和总结,为软件系统的性能优化提供参考和指导。

2. 测试环境

- 软件系统版本:v1.0.0

- 操作系统版本:Windows 10

- CPU:Intel Core i7-8700 3.20GHz

- 内存:16GB

3. 测试内容

本次性能测试主要分为以下几个方面:

1. 资源占用情况测试

2. 响应时间测试

3. 并发性测试

4. 吞吐量测试

4. 测试结果

4.1 资源占用情况测试

在运行软件系统时,其资源占用情况如下所示:

4.2 响应时间测试

对于用户请求的响应时间测试,测试结果如下所示:

4.3 并发性测试

在模拟100个用户同时访问软件系统时,测试结果如下所示:

4.4 吞吐量测试

在60秒内模拟100个用户对系统进行请求时,测试结果如下所示:

5. 测试结论

根据以上测试结果,我们可以得出以下结论:

1. 在运行软件系统时,其资源占用情况较为稳定,未出现占用率过高的情况。

2. 对于用户请求的响应时间较长,需要进一步优化。

3. 在并发情况下,系统响应较慢,需要进一步优化。

4. 吞吐量测试结果较为理想。

6. 总结

通过本次性能测试,我们发现软件系统在资源占用情况和吞吐量方面表现良好,但在响应时间和并发情况下存在问题,需要进行进一步优化。

希望本次测试结果可以为系统性能优化提供参考和指导。

性能测试报告模板_2

XXXX硬件性能测试报告版本号例:3010硬件平台性能测试报告v1.0文档命名:LinkTrust_SPEC_ALL_002_CN_004_RD_ZHANGZY_090312_I文档编号:2401002004I目录产品型号.软件版本号性能测试报告版本号 (1)性能测试报告 v1.0目录 (2)目录 (2)一、测试目的 (3)二、测试人员和测试时间 (3)三、测试环境描述 (3)●被测设备描述: (3)●测试仪描述: (3)四、测试项目 (4)五、测试结果 (4)1. 网卡型号/其他硬件变化吞吐量 (4)2.网卡型号/其他硬件变化延迟 (4)3.网卡型号/其他硬件变化最大并发TCP连接数 (5)4.网卡型号/其他硬件变化最大TCP连接建立速率 (5)5.网卡型号/其他硬件变化HTTP-A V处理能力 ....................... 错误!未定义书签。

6. 最大吞吐量 (5)六、数据分析 (6)附录: (7)一、测试目的该项测试的目的是评估该产品(包括软硬件描述)的基础性能指标测试项目包括八个基础测试项:吞吐量、延迟、最大并发TCP连接数、最大TCP连接建立速率、HTTP-A V处理能力和最大吞吐量,测试涵盖该设备的所有类型的网卡。

二、测试人员和测试时间●测试人员:●测试时间:三、测试环境描述●被测设备描述:●测试仪描述:测试仪型号:Avalanche2500;Reflector2500;IXIA1600或IXIA400T测试软件版本:Avalanche7.5.0.41452;IxScriptMate5.20_SP3四、测试项目1.网卡型号/其他硬件变化吞吐量2.网卡型号/其他硬件变化延迟3.网卡型号/其他硬件变化最大并发TCP连接数4.网卡型号/其他硬件变化最大TCP连接建立速率5.网卡型号/其他硬件变化HTTP-A V处理能力6.最大吞吐量7.最大吞吐量稳定时长五、测试结果1.网卡型号/其他硬件变化吞吐量●被测设备配置:插入配置文件●测试仪配置:测试流方向、测试端口配置、测试时长、测试次数、其他特殊配置2.网卡型号/其他硬件变化延迟●被测设备配置:插入配置文件●测试仪配置:测试流方向、测试端口配置、延迟类型、测试时长、测试次数、其他特殊配置3.网卡型号/其他硬件变化最大并发TCP连接数●被测设备配置:插入配置文件●测试仪配置:客户端地址数量、服务器地址数量、页面大小、HTTP类型、其他特殊配置4.网卡型号/其他硬件变化最大TCP连接建立速率●被测设备配置:插入配置文件●测试仪配置:客户端地址数量、服务器地址数量、页面大小、HTTP类型、其他特殊配置5.最大吞吐量●被测设备配置:端口数量、端口配置、策略配置、其他特殊配置●测试仪配置:测试流方向、测试类型、测试端口配置、测试时长、测试次数、其他特殊配置6.最大吞吐稳定时长●被测设备配置:端口数量、端口配置、策略配置、其他特殊配置●测试仪配置:测试流方向、测试类型、测试端口配置、测试时长、测试次数、其他特殊配置该项测试最大时长为48小时。

Elasticsearch的几种架构(ELK,EL,EF)性能对比测试报告

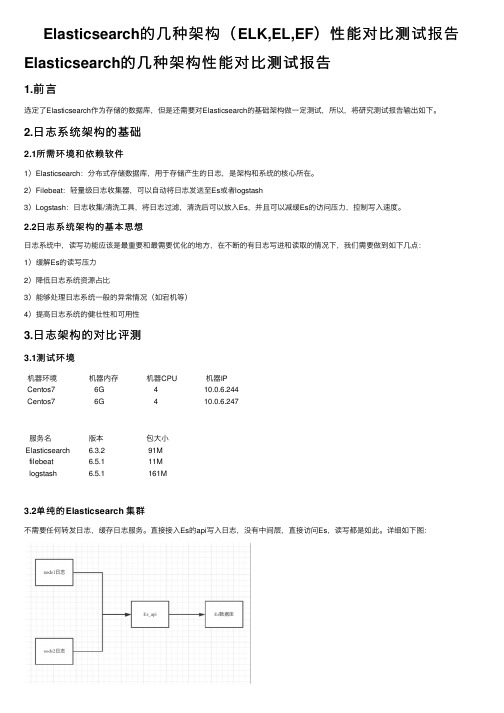

Elasticsearch的⼏种架构(ELK,EL,EF)性能对⽐测试报告Elasticsearch的⼏种架构性能对⽐测试报告1.前⾔选定了Elasticsearch作为存储的数据库,但是还需要对Elasticsearch的基础架构做⼀定测试,所以,将研究测试报告输出如下。

2.⽇志系统架构的基础2.1所需环境和依赖软件1)Elasticsearch:分布式存储数据库,⽤于存储产⽣的⽇志,是架构和系统的核⼼所在。

2)Filebeat:轻量级⽇志收集器,可以⾃动将⽇志发送⾄Es或者logstash3)Logstash:⽇志收集/清洗⼯具,将⽇志过滤,清洗后可以放⼊Es,并且可以减缓Es的访问压⼒,控制写⼊速度。

2.2⽇志系统架构的基本思想⽇志系统中,读写功能应该是最重要和最需要优化的地⽅,在不断的有⽇志写进和读取的情况下,我们需要做到如下⼏点:1)缓解Es的读写压⼒2)降低⽇志系统资源占⽐3)能够处理⽇志系统⼀般的异常情况(如宕机等)4)提⾼⽇志系统的健壮性和可⽤性3.⽇志架构的对⽐评测3.1测试环境机器环境机器内存机器CPU机器IPCentos7 6G 410.0.6.244Centos7 6G 410.0.6.247服务名版本包⼤⼩Elasticsearch 6.3.2 91Mfilebeat 6.5.1 11Mlogstash 6.5.1 161M3.2单纯的Elasticsearch 集群不需要任何转发⽇志,缓存⽇志服务。

直接接⼊Es的api写⼊⽇志,没有中间层,直接访问Es,读写都是如此。

详细如下图:直接通过封装好的Es_api进⾏数据读写,在上层将数据进⾏清洗或者是处理之后写⼊Es。

测试分别导⼊500,1000,10000条数据。

Elasticsearch占⽤资源和系统压⼒如下:导⼊数据 Es占⽤内存 Es占⽤CPU导⼊时间500条⽇志 22.3%(占2.3%1-3S⽤)2.3%-12%2-6S1000条⽇志 22.6%(占⽤)2.3%-40% 9S10000条⽇志 22.9%(占⽤)适⽤场景:⽇志不多,但是需要分布式的系统,⼀万条数据存储的index⼤概是1.3M,两台机器就是2.6M。

[整理]Report(数据库性能检测).

![[整理]Report(数据库性能检测).](https://img.taocdn.com/s3/m/b48f2b0f376baf1ffc4fad7e.png)

广东联通数据库性能检查报告Prepared for广东联通公司2009年1月15日Version 1.0Prepared by邱诗扬Premier Field Engineershiyang.qiu@目录1总结 (1)2数据收集和分析工具 (2)3发现的问题与建议 (3)3.1内存不足 (3)3.2磁盘慢 (3)3.3编译,重编译过多 (4)3.4不成比例的连接数 (4)3.5过高的登录注销数 (4)3.6索引设计和维护 (5)3.7阻塞类型分析 (5)3.8在选择语句中使用用户函数 (6)3.9使用游标 (6)3.10JOIN没有使用ON从句 (7)3.11测试环境和生产环境的混合 (7)3.12不恰当的文件自动增长率 (7)4附录1 重要性能计数器数据 (8)5附录2 OAS库中没有任何索引和没有聚集索引的表 (11)6附录3 阻塞类型统计 (17)7参考资料 (18)1 总结本报告为广东联通公司SQLCLUSTER03实例的性能检查报告。

广东联通公司的OA系统的响应时间过长,希望微软工程师从数据库层进行性能检查,找出性能瓶颈,通过优化性能差的语句缩短查询时间。

本次调优不涉及应用层的代码分析。

在检查中发现,不良索引设计是引起性能问题的最主要原因。

2 数据收集和分析工具1.用PSSDIAG工具捕获如下主要信息(1月12-13日):∙SQL Server Profiler(至存储过程/批处理级别)∙Perfmon(间隔15秒)∙阻塞情况2.用Relog分析Perfmon的输出。

3.用RML分析Profiler Trace,找出性能不良的查询。

4.用阻塞脚本分析阻塞情况。

5.检查OAS库存储过程和用户定义函数的代码。

3 发现的问题与建议3.1 内存不足3.2 磁盘慢3.3 编译,重编译过多3.4 不成比例的连接数3.5 过高的登录注销数3.6 索引设计和维护3.7 阻塞类型分析3.8 在选择语句中使用用户函数3.9 使用游标3.10 JOIN没有使用ON从句3.11 测试环境和生产环境的混合3.12 不恰当的文件自动增长率4 附录1重要性能计数器数据5 附录2OAS库中没有任何索引和没有聚集索引的表没有任何索引的表:没有聚集索引的表:6 附录3阻塞类型统计7 参考资料PSSDIAG 工具下载-/downloads/details.aspx?familyid=5564386A-28C2-4483-8293-76FFF67B9EB 3&displaylang=en了解更多PSSDIAG背景资料,可以访问以下KB文章:/kb/830232MPSReport 工具下载-/downloads/details.aspx?FamilyId=CEBF3C7C-7CA5-408F-88B7-F9C79B73 06C0&displaylang=en与SQL Server相关的MPSReport,,可以访问以下KB文章:/kb/883724在Windows Server 2003 和Windows 2000上的大内存支持/?id=283037sys.dm_db_index_physical_stats/zh-cn/library/ms188917(SQL.90).aspxSQL Server等待类型/kb/822101/en-us。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

数据库性能测试报告

目录

1.前言 (4)

2.测试方法概述 (4)

2.1.测试环境 (4)

2.1.1.硬件环境 (4)

2.1.2.软件环境 (5)

2.2.测试工具 (5)

2.2.1.Tpch介绍 (5)

2.2.2.Jmeter介绍 (7)

2.2.3.Nmon介绍 (7)

2.3.测试方法 (7)

3.测试过程 (8)

3.1.测试数据库搭建 (8)

3.2.测试脚本准备 (8)

3.2.1.DDL脚本 (8)

3.2.2.平面数据文件 (8)

3.2.3.查询sql语句 (8)

3.3.测试数据规模 (26)

3.4.测试工具开发 (26)

3.4.1.插入数据功能 (26)

3.5.测试步骤 (27)

4.测试结果 (28)

4.1.数据量级—1GB (28)

4.1.1.装载时间对比 (29)

4.1.2.串行时间对比 (29)

4.1.3.并行时间对比 (30)

bright资源消耗情况 (30)

4.1.5.PostgreSQL资源消耗情况 (31)

4.2.数据量级—10GB (33)

4.2.1.装载时间对比 (34)

4.2.2.串行时间对比 (35)

4.2.3.并行时间对比 (35)

bright资源消耗情况 (36)

4.2.5.PostgreSQL资源消耗情况 (38)

4.3.数据量级—30GB (41)

4.3.1.装载时间对比 (42)

4.3.2.串行时间对比 (42)

4.3.3.并行时间对比 (43)

bright资源消耗情况 (43)

4.3.5.PostgreSQL资源消耗情况 (46)

4.4.数据量级—100GB (48)

4.4.2.串行时间对比 (50)

4.4.3.并行时间对比 (50)

bright资源消耗情况 (51)

4.4.5.PostgreSQL资源消耗情况 (55)

5. 测试总结 (61)

1.前言

通过测试Oracle、Infobright、PostgreSQL三种数据库在TPC-H中的性能表现,作为数据仓库选型的决策依据之一。

2.测试方法概述

2.1.测试环境

2.1.1.硬件环境

2.1.2.软件环境

2.2.测试工具

2.2.1.TPC-H介绍

是什么

TPC Benchmark H(TPC-H)是一个决策支持的基准,它由一系列面向商务应用的查询

和并行数据修改组成。

●模拟表

●表之间的关系

2.2.2.Jmeter介绍

拥有如下功能:

单步测试

流程测试

并发测试

2.2.

3.Nmon介绍

服务器资源监控工具(监控内容包括:cpu、磁盘IO等)

2.3.测试方法

参照标准TPC-H方案,针对1GB、10GB、30GB、100GB不同级别的数据量进行测试。

3.测试过程

3.1.测试数据库搭建

3.2.测试脚本准备

3.2.1.DDL脚本

●Infobright

建表语句:

●oracle

建表语句:索引语句:●PostgreSQL

建表语句:索引语句:3.2.2.平面数据文件

初始化数据:./dbgen –vf –s 1

更新数据:./dbgen –vf –U 2 –s 1

3.2.3.查询sql语句

3.3.测试数据规模

3.4.测试工具开发

3.4.1.插入数据功能

1)找到需要删除的数据(平面文件中)

2)解析文件内容并找到要删除表的主键值

3)拼接删除的sql语句进行删除

4)先删除lineitem表的数据、最后删除orders表的数据

5)数据大小不超过总大小的0.1%

3.4.2.删除数据功能

1)找到需要删除的数据(平面文件中)

2)解析文件内容并找到要删除表的主键值

3)拼接删除的sql语句进行删除

4)先删除lineitem表的数据、最后删除orders表的数据

5)数据大小不超过总大小的0.1%

3.5.测试步骤

1)选择一种数据库,通过客户端登陆

2)删表。

如果测试表存在,则删除表

3)创建测试表

4)选择一个数据级的测试数据导入至对应的测试表

5)建立相应的主键、外键约束(infobright不需要创建约束,因为它是列式存储的)

6)记录装载数据的开始、结束时间

7)开始单步顺序执行22条查询语句

8)记录第一条查询开始的时间和最后一条查询结束的时间

9)记录每条语句的响应时间

10)开始并发执行组合1(随机组合的查询语句)的查询

11)开始并发执行组合2(随机组合的查询语句)的查询

12)记录并发执行的开始时间、结束时间

13)记录每条查询语句的响应时间

14)提取nmon的数据,整理出服务器资源消耗的情况

15)根据整理的时间、资源消耗情况绘制出折线图4.测试结果

4.1.数据量级—1GB

4.1.2.串行时间对比

说明:此处纵轴的400秒代表sql执行响应时间至少超过了1800秒

说明:此处纵轴的500秒代表sql执行响应时间至少超过了1800秒bright资源消耗情况

CPU+IO

●内存情况(总内存:32GB,单位:MB)

4.1.

5.PostgreSQL资源消耗情况

●CPU+IO消耗情况

内存消耗情况(总内存:32GB,单位:MB)

4.2.数据量级—10GB

4.2.1.装载时间对比

4.2.2.串行时间对比

说明:此处纵轴的400秒代表sql执行响应时间至少超过了1800秒4.2.3.并行时间对比

说明:此处纵轴的3000秒代表sql执行响应时间至少超过了1小时

说明:此处纵轴的400秒代表sql执行响应时间未知bright资源消耗情况 CPU+IO使用情况

内存使用情况(总内存:32GB,单位:MB)

4.2.

5.PostgreSQL资源消耗情况 CPU+IO资源消耗

内存资源消耗(总内存:32GB,单位:MB)

4.3.数据量级—30GB

4.3.2.串行时间对比

说明:此处纵轴的700秒代表sql执行响应时间至少超过了1800秒

说明:此处纵轴的2000秒代表sql执行响应时间未知

说明:此处纵轴的600秒代表sql执行响应时间未知bright资源消耗情况 CPU+IO资源消耗

内存消耗(总内存:64GB,单位:MB)

4.3.

5.PostgreSQL资源消耗情况 CPU+IO资源消耗

内存资源消耗(总内存:32GB,单位:MB)

4.4.数据量级—100GB

4.4.1.装载时间对比

4.4.2.串行时间对比

说明:此处纵轴的1400秒代表sql执行响应时间至少超过了2000秒4.4.3.并行时间对比

说明:此处纵轴的2000秒代表sql执行响应时间未知。