人工智能YOLO V2 图像识别实验报告材料

人工智能算法在像识别中的应用实验报告

人工智能算法在像识别中的应用实验报告人工智能(Artificial Intelligence,简称AI)是计算机科学的一个分支,旨在研究和开发能够模仿、模拟和实现人类智能的理论、方法、技术及应用系统。

人工智能在各个领域都有广泛的应用,其中像识别作为其中之一的关键技术,正发挥着越来越重要的作用。

本实验报告旨在介绍人工智能算法在像识别中的应用,从算法原理、实验设计、实验结果和展望四个方面进行讨论。

一、算法原理1. 深度学习算法深度学习是一种以人工神经网络为基础的机器学习方法,其核心思想是通过多层的非线性变换,将高维的输入数据映射到输出结果。

深度学习在像识别中的应用主要基于卷积神经网络(Convolutional Neural Network,CNN),它通过卷积层和池化层的堆叠,提取图像的特征表示,并通过全连接层进行分类。

2. 支持向量机算法支持向量机(Support Vector Machine,SVM)是一种监督学习算法,其主要思想是找到一个超平面,使得该超平面与不同类别的像素点之间的间隔最大化。

SVM在像识别中的应用主要通过构建分类器,将图像像素划分为不同的类别。

二、实验设计本实验选用了一个包含1000张带有标签的图像数据集,其中包含了不同种类的物体。

实验设计如下:1. 数据预处理首先对图像进行预处理,包括降噪、灰度化和图像增强等操作,以提高算法的准确性和稳定性。

2. 算法训练基于深度学习算法和支持向量机算法,分别进行像识别的算法训练。

通过对数据集的学习和调优,提高算法的性能。

3. 精度评估通过将训练好的算法应用于测试数据集,计算算法的精确度、召回率、F1值等指标,评估算法的性能。

三、实验结果经过实验设计和测试,得到了以下实验结果:1. 深度学习算法利用深度学习算法进行像识别,得到了90%的准确率。

该算法在图像特征提取和分类上表现出色,对不同种类物体的识别效果较好。

2. 支持向量机算法利用支持向量机算法进行像识别,得到了85%的准确率。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)是一种基于深度学习的实时目标识别算法,能够在图像中准确地定位和识别多个目标。

该算法以其高效、快速和准确的特点受到广泛关注,并在许多实际应用中取得了突出的成绩。

本文将对YOLO模型在图像识别领域的研究进行综述,并讨论其优缺点以及未来的发展方向。

YOLO模型通过将目标检测问题转化为一个回归问题来实现实时识别。

相比于传统的目标检测方法,YOLO能够在一次前向传播中同时预测目标的类别和位置,大大提升了算法的效率。

YOLO采用了全卷积神经网络(FCN)的结构,用于在图像中提取特征。

通过多层卷积和池化操作,YOLO能够有效地捕捉目标的上下文信息,提高了检测的准确性。

YOLO还采用了Anchor Box的概念来处理不同尺度的目标,提高了模型对多尺度目标的检测能力。

YOLO模型也存在一些缺点。

YOLO模型在小目标的检测上表现较差。

由于YOLO模型在特征提取阶段对输入图像进行了多次下采样,导致了较小目标的尺寸被压缩,从而影响了模型的检测能力。

YOLO模型对目标的定位不够精确,尤其是对于重叠的目标,容易出现位置偏移的情况。

YOLO模型对于目标的类别预测容易受到背景干扰的影响,导致一些误判。

针对上述问题,研究者们提出了一系列改进的方法。

一方面,一些研究通过增加卷积层和池化层的数量来减小YOLO模型的下采样率,从而提高对小目标的检测能力。

一些研究通过引入注意力机制和上下文信息来提高目标的定位精度。

一些研究还通过引入迭代训练和联合训练的方式来进一步提高YOLO模型的准确性和鲁棒性。

YOLO模型在实际应用中也取得了良好的效果。

在交通监控和智能驾驶领域,YOLO模型能够快速、准确地识别和跟踪车辆、行人等交通目标,在提高交通安全和智能驾驶的效率方面起到了重要作用。

在物体识别和图像检索领域,YOLO模型也能够快速地定位和识别目标,并在目标检索和图像分类等任务中取得了优秀的表现。

人工智能YOLO V2 图像识别实验报告

第一章前言部分1.1课程项目背景与意义1.1.1课程项目背景视觉是各个应用领域,如制造业、检验、文档分析、医疗诊断,和军事等领域中各种智能/自主系统中不可分割的一部分。

由于它的重要性,一些先进国家,例如美国把对计算机视觉的研究列为对经济和科学有广泛影响的科学和工程中的重大基本问题,即所谓的重大挑战。

计算机视觉的挑战是要为计算机和机器人开发具有与人类水平相当的视觉能力。

机器视觉需要图象信号,纹理和颜色建模,几何处理和推理,以及物体建模。

一个有能力的视觉系统应该把所有这些处理都紧密地集成在一起。

作为一门学科,计算机视觉开始于60年代初,但在计算机视觉的基本研究中的许多重要进展是在80年代取得的。

计算机视觉与人类视觉密切相关,对人类视觉有一个正确的认识将对计算机视觉的研究非常有益。

计算机视觉是一门研究如何使机器“看”的科学,更进一步的说,就是是指用摄影机和电脑代替人眼对目标进行识别、跟踪和测量等机器视觉,并进一步做图形处理,使电脑处理成为更适合人眼观察或传送给仪器检测的图像。

作为一个科学学科,计算机视觉研究相关的理论和技术,试图建立能够从图像或者多维数据中获取‘信息’的人工智能系统。

这里所指的信息指Shannon定义的,可以用来帮助做一个“决定”的信息。

因为感知可以看作是从感官信号中提取信息,所以计算机视觉也可以看作是研究如何使人工系统从图像或多维数据中“感知”的科学。

科学技术的发展是推动人类社会进步的主要原因之一,未来社会进一步地朝着科技化、信息化、智能化的方向前进。

在信息大爆炸的今天,充分利用这些信息将有助于社会的现代化建设,这其中图像信息是目前人们生活中最常见的信息。

利用这些图像信息的一种重要方法就是图像目标定位识别技术。

不管是视频监控领域还是虚拟现实技术等都对图像的识别有着极大的需求。

一般的图像目标定位识别系统包括图像分割、目标关键特征提取、目标类别分类三个步骤。

深度学习的概念源于人工神经网络的研究。

人工智能像识别实验报告

人工智能像识别实验报告人工智能(Artificial Intelligence,AI)是一门研究如何使计算机能够模拟和实现人类智能的学科。

其中,人工智能在图像处理领域的应用备受关注,特别是像识别方面的研究。

本实验旨在通过人工智能技术实现对图像中的物体进行像识别,以探索该技术在实际应用中的效果与限制。

1. 实验背景像识别是指通过计算机视觉技术,使用人工智能算法训练模型,使其能够自动对图像中的物体进行分类和识别。

像识别技术的发展,为许多领域带来了巨大的潜力与机遇。

例如,在医学影像领域,人工智能像识别可以辅助医生对肿瘤、病变等进行自动检测和识别,提高早期发现的准确率;在工业领域,人工智能像识别可以应用于自动化生产线,实现对产品质量的自动监测与控制。

2. 实验步骤(1)数据采集与准备:在本实验中,我们选择了一个包含不同类别物体的图像数据集,共包含1000张图片。

根据图像数据的特征,标注了每个物体对应的像素位置与类别。

(2)数据预处理:将原始图像数据进行预处理,包括图像灰度化、尺寸调整、减去均值等操作,以便于后续模型的训练与测试。

(3)模型选择与训练:根据实验需求,我们选择了卷积神经网络(Convolutional Neural Network,CNN)作为像识别模型,并利用标注的图像数据集进行模型的训练,通过迭代优化模型参数,使其能够准确地对图像中的物体进行识别。

(4)测试与评估:使用一部分未参与模型训练的图像数据作为测试集,对训练好的模型进行测试,并统计模型在测试集上的准确率、召回率等评价指标,以评估模型的性能和效果。

3. 实验结果与分析经过对数据集的训练与测试,我们得到了模型在像识别任务上的性能指标。

在测试集上,模型的准确率达到了95%,召回率达到了92%。

这说明该模型能够较为准确地对图像中的物体进行识别。

然而,在进一步分析中,我们也发现了一些问题与限制。

首先,对于图像中存在遮挡、模糊等情况的物体,模型的识别准确率较低。

教育教学 图像识别实验报告

图像识别实验报告•引言图像识别是计算机视觉领域的一项重要任务,旨在让计算机能够理解和分析图像,并从中提取有用的信息。

随着人工智能和机器学习的发展,图像识别技术在许多领域得到了广泛应用,如人脸识别、自动驾驶、智能监控等。

本实验旨在通过使用深度学习技术,对图像进行分类和识别,进一步加深对图像识别原理和算法的理解。

•实验目的本实验的主要目的是:•掌握图像识别的基本原理和算法;•了解深度学习在图像识别中的应用;•通过实践操作,提高图像识别和分类的能力;•分析实验结果,总结深度学习在图像识别中的优缺点。

实验原理图像识别是基于计算机视觉和机器学习的一项技术,它通过对图像的特征进行提取和分类,实现图像的识别和分类。

深度学习是机器学习的一种分支,它利用神经网络模型对数据进行学习和预测,具有强大的特征提取和分类能力。

在图像识别中,深度学习技术可以通过卷积神经网络(CNN)实现对图像的分类和识别。

实验步骤本实验采用Python编程语言和深度学习框架TensorF1ow,具体实验步骤如下:(1)数据准备:从公共数据集中选择图像数据集,如MNIST手写数字数据集或CIFAR-IO数据集。

对数据进行预处理和标签编码。

(2)模型构建:根据所选数据集的特点,构建卷积神经网络模型。

本实验采用常见的CNN模型结构,包括卷积层、池化层、全连接层等。

(3)模型训练:将数据集分为训练集和测试集,使用训练集对模型进行训练,通过优化器和损失函数调整模型参数。

⑷模型评估:使用测试集对训练好的模型进行评估,计算模型的准确率和精度等指标。

(5)结果分析:通过对模型训练过程和测试结果的详细分析,评估模型的性能和优劣。

对模型进行优化或改进,以提高图像识别的准确率和鲁棒性。

实验结果本实验采用了CIFAR-IO数据集进行图像识别实验。

经过训练后,模型在测试集上的准确率达到了85%,精度达到了80%o具体实验结果如下表所示:结果分析通过实验结果的分析,我们发现深度学习在图像识别中具有较高的准确率和精度。

目标识别实验报告(3篇)

第1篇一、实验背景随着人工智能技术的飞速发展,目标识别技术在计算机视觉领域得到了广泛的应用。

目标识别是指从图像或视频中识别出特定的物体或场景,为后续的图像处理、智能控制等领域提供支持。

本实验旨在通过学习目标识别的相关理论和技术,实现对特定场景下物体的识别。

二、实验目的1. 了解目标识别的基本原理和方法;2. 掌握目标识别算法在实际应用中的实现过程;3. 通过实验验证目标识别算法的有效性;4. 分析目标识别算法的优缺点,为后续研究提供参考。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 库:OpenCV、TensorFlow、Keras四、实验内容1. 数据集准备本实验采用COCO数据集进行目标识别实验。

COCO数据集是一个大规模的视觉对象识别数据集,包含80个类别,共计约11万张图像。

2. 算法选择本实验选用YOLOv4算法进行目标识别。

YOLOv4是一种基于深度学习的目标检测算法,具有速度快、准确率高的特点。

3. 实验步骤(1)数据预处理将COCO数据集中的图像和标注文件分别转换为RGB格式和txt格式,并对图像进行归一化处理。

(2)模型训练使用TensorFlow和Keras搭建YOLOv4模型,将预处理后的数据集划分为训练集和验证集,对模型进行训练。

(3)模型评估在验证集上对训练好的模型进行评估,计算准确率、召回率等指标。

(4)模型测试将训练好的模型应用于实际图像,进行目标识别实验。

五、实验结果与分析1. 模型训练经过约10个epoch的训练,模型在验证集上的准确率达到0.85,召回率达到0.80。

2. 模型评估在验证集上,模型的准确率为0.85,召回率为0.80,F1值为0.82。

3. 模型测试在测试图像上,模型能够准确地识别出图像中的物体,识别准确率达到0.90。

4. 实验结果分析(1)YOLOv4算法在目标识别任务中表现出良好的性能,具有较高的准确率和召回率。

图像识别技术实验报告

图像识别技术实验报告一、实验目的通过本次实验,掌握图像识别技术的基本原理和应用方向,提升对图像处理领域的理解和应用能力。

二、实验内容1. 寻找合适的图像数据集2. 使用图像识别算法进行数据预处理3. 实施图像特征提取和分类4. 分析实验结果并撰写实验报告三、实验步骤1. 数据集选择:选择适合的图像数据集,如MNIST、CIFAR-10等经典数据集。

2. 数据预处理:对选定的数据集进行预处理,包括数据清洗、去噪等操作。

3. 图像特征提取:使用特征提取算法对图像进行特征提取,如SIFT、HOG等。

4. 图像分类:利用机器学习算法或深度学习模型对提取的特征进行分类。

5. 实验结果分析:评估分类准确率、召回率等指标,分析实验结果的优劣势。

四、实验结果经过实验,我们成功使用图像识别技术对数据集进行预处理,提取了有效的特征并实现了图像分类。

最终实验结果表明,我们的模型在准确率和召回率方面均取得了较好的表现。

五、结论与展望本次实验通过图像识别技术的应用,取得了一定的成果,展示了图像处理领域的潜力和前景。

未来可以进一步优化算法和模型,探索更多图像识别技术的可能性,推动图像处理领域的发展和应用。

六、参考文献1. Li, Jingjing, et al. "SIFT-based image retrieval: fast SIFT". ACM Sigmm Rec., vol. 31, issue 1, 2019, pp. 98-103.2. Dalal, Navneet, and Bill Triggs. "HOG Features for CGV-based human detection". Proceedings of the IEEE conference on computer vision and pattern recognition, 2005.七、致谢感谢指导老师的悉心指导和同学们的合作支持,使本次实验取得圆满成功。

yolov2

yolov2全名YOLO9000:Better, Faster, Stronger源码1.Introduction我们提出⼀种新⽅法来利⽤已有的⼤量分类数据,并利⽤它来扩展现有检测系统的范围。

我们的⽅法使⽤对象分类的分层视图,允许我们将不同的数据集组合在⼀起。

我们还提出了⼀种联合训练算法,允许我们在检测和分类数据上训练⽬标检测器。

我们的⽅法利⽤标记的检测图像来学习精确定位⽬标,同时使⽤分类图像来增加其词汇量和鲁棒性。

⾸先,我们对现有的YOLO探测系统进⾏了改进,⽣产出了⼀种最先进的实时探测器YOLO v2。

然后,我们使⽤我们的数据集组合⽅法和联合训练算法对来⾃ImageNet的9000多个类以及来⾃COCO的检测数据进⾏了训练。

2. BetterYOLO v2想要⼀个更精确、速度更快的探测器。

YOLO v2简化⽹络,使表⽰法更易于学习。

与最先进的检测系统相⽐,YOLO的缺点:YOLO与Fast R-CNN的误差分析表明,YOLO会产⽣⼤量的定位错误。

与基于区域建议的⽅法相⽐,YOLO的召回率相对较低。

Batch Normalization.Batch normalization 在收敛性⽅⾯有显著的改进,同时消除了对其他形式的正则化的需要。

通过在YOLO中所有的卷积层上添加Batch normalization,我们得到了超过2%的mAP改进。

Batch normalization 还有助于对模型进⾏规范化。

通过 Batch normalization,我们可以在不进⾏过拟合的情况下从模型中删除dropout。

High Resolution Classifier.YOLO v2⾸先在ImageNet上以448×448的分辨率对分类⽹络进⾏10个epochs的微调()。

这使⽹络可以更好地调整它的滤波器,从⽽能够在⾼分辨率输⼊下⼯作。

然后在检测时对结果⽹络进⾏微调。

这个⾼分辨率的分类⽹络提⾼了将近4%的mAP。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述引言随着人工智能技术的不断发展,图像识别成为了人工智能领域的一个热门研究方向。

近年来,基于YOLO(You Only Look Once)模型的图像识别技术备受关注,该技术以其快速的识别速度和较高的准确性受到了学术界和工业界的认可。

本文将对基于YOLO模型的图像识别研究进行综述,以期能够全面了解目前该领域的最新进展和未来的发展方向。

一、YOLO模型的基本原理YOLO(You Only Look Once)模型是一种端对端的实时目标检测模型,其核心思想是将目标检测任务转化为一个回归问题。

YOLO模型通过将整张图像划分为多个网格单元,并预测每个网格单元中是否包含目标物体以及目标物体的边界框和类别信息,从而实现对图像中目标物体的快速准确定位和识别。

相比传统的目标检测算法,YOLO模型不需要在不同的尺度下进行多次检测,因而具有更快的识别速度和更高的实时性。

二、YOLO模型的改进和优化随着YOLO模型的出现和广泛应用,研究者们也不断对其进行改进和优化。

目前已经涌现出了多个版本的YOLO模型,例如YOLOv2、YOLOv3和YOLOv4等。

这些改进版的YOLO模型在网络架构、特征提取、损失函数设计以及训练技巧等方面都有不同程度的改进,从而取得了更好的识别效果和性能表现。

值得一提的是,YOLOv4模型是目前最先进的版本,它结合了更深的网络结构、更先进的特征提取技术和更准确的损失函数设计,使得模型在目标检测任务上取得了更好的效果。

除了对网络结构的改进外,研究者们还利用注意力机制、网络剪枝和轻量化等技术对YOLO模型进行了优化,使得模型在保持较高识别准确率的具有更小的参数量和更快的推理速度。

这些优化技术使得YOLO模型在嵌入式设备和移动端应用中更加实用和高效。

三、YOLO模型在不同领域的应用基于YOLO模型的图像识别技术在各个领域都有着广泛的应用。

在智能交通领域,YOLO 模型可以用于车辆识别和行人检测,实现交通流量统计和交通违法抓拍等功能。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)是一种基于深度学习的实时图像识别模型,其独特之处在于将图像识别问题转化为一个回归问题,因此可以极大地提高图像识别的效率和准确率。

本文将为您综述基于YOLO模型的图像识别研究。

我们将从YOLO的基本原理开始介绍。

YOLO将图像分割为多个网格,并对每个网格进行预测。

每个网格负责预测一个或多个物体的边界框(bounding box)和类别。

这种单次检测的方式使得YOLO能够实时地进行图像识别,具有很高的效率。

随后,我们将介绍YOLO模型的发展历程。

YOLO诞生于2016年,经过不断的改进和优化,目前已经发展到YOLOv4版本。

YOLOv4在准确率和速度上都有了上升,成为目前最先进的实时图像识别模型之一。

接着,我们将介绍一些基于YOLO模型的图像识别应用。

首先是交通标志检测。

由于YOLO模型的高效性和准确性,它可以用于实时的交通标志检测,提高驾驶的安全性。

其次是人体姿势估计。

YOLO模型能够准确地识别人体的关键点,从而实现人体姿势估计,具有广泛的应用前景。

YOLO模型还可以用于视频目标跟踪、工业质检等领域。

我们还将介绍一些基于YOLO模型的改进方法。

YOLOv2使用了更深的网络结构,引入了anchor boxes来提高边界框的预测准确度。

YOLOv3进一步改进了YOLOv2的网络结构,引入了多尺度预测和特征金字塔网络,提高了在不同尺度上的识别效果。

而YOLOv4则进一步改进了YOLOv3的网络结构,使用了更大的输入图像尺寸和更深的网络结构,提高了识别准确率和速度。

我们将展望基于YOLO模型的图像识别研究的未来发展方向。

随着计算机视觉和深度学习的快速发展,我们可以预见,基于YOLO模型的图像识别将继续取得重要进展。

未来可能会进一步提高模型的准确率和速度,拓展其应用范围,同时也需要解决一些挑战,如遮挡物体的识别和复杂场景下的准确识别问题。

图像目标检测实验报告

图像目标检测实验报告一、实验简介图像目标检测是计算机视觉领域的一个重要任务,旨在通过使用机器学习和深度学习技术,自动识别和定位图像中的目标对象。

本实验的目标是利用目标检测算法检测图像中的目标,并对检测结果进行评估和分析。

二、实验设计本实验采用了常用的目标检测算法YOLO(You Only Look Once)作为实现基准。

YOLO算法是一种基于卷积神经网络的实时目标检测算法,在速度和准确率上都具有较好的表现。

实验步骤如下:1. 数据集准备:选择一个包含目标对象的图像数据集,并标注目标对象的位置和类别信息。

2. 网络训练:使用YOLO算法对准备好的数据集进行训练,得到目标检测模型。

3. 目标检测:使用训练好的模型对新的图像进行目标检测。

4. 结果评估:计算目标检测结果的评估指标,如准确率、召回率等。

5. 结果分析:分析实验结果,讨论算法的优缺点以及改进方向。

三、实验结果经过实验,我们得到了以下结果:在所选的数据集上,YOLO算法的平均检测准确率为85%。

该算法能够在较短的时间内对目标对象进行检测,并给出较为准确的位置和类别预测。

四、结果评估与分析根据实验结果,我们可以看出YOLO算法在检测目标对象方面具有较高的准确率。

然而,在某些复杂场景中,算法可能会出现漏检或误检的情况。

这些问题可能与数据集的质量、训练参数的选择有关。

此外,YOLO算法在速度上具有一定优势,可以实现实时目标检测,但在一些要求更高准确率的应用场景中可能会受到限制。

因此,在实际应用中需要根据具体需求来选择合适的目标检测算法。

对于改进方向,可以考虑以下几个方面:1. 数据集的增强:可以尝试引入更多样的数据集,以提高模型的泛化能力和鲁棒性。

2. 网络结构的改进:可以通过改变网络结构或增加模型层数来提升目标检测性能。

3. 参数调优:合理选择训练参数,平衡速度和准确率的需求。

4. 结合其他方法:可以尝试结合其他计算机视觉技术,如图像分割、特征提取等,进一步提高目标检测的效果。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)模型是一种基于深度学习的图像物体检测模型,由Joseph Redmon等人在2016年提出,其独特之处在于一次前向传递可以同时得到物体的类别和位置信息。

该模型采用单个神经网络,并将图像分成多个网格单元,每个网格单元负责检测其中单一物体,从而实现高效的物体检测。

与传统物体检测算法相比,YOLO模型具有更快的检测速度和更高的检测精度,已成为目标检测领域中备受关注的深度学习模型之一。

本文将就YOLO模型的研究进展、模型优化及应用进行探讨。

一、研究进展1. YOLOv1YOLOv1是最初提出的第一版YOLO模型,其采用了整张图片的全局信息进行物体检测,并将检测过程划分为物体位置预测和物体类别判定两个子任务,通过不同的损失函数进行优化,能够在速度上取得突出的表现。

但是,该模型在小物体检测和多物体重叠区域检测方面存在一定的问题,导致检测精度不如一些传统算法。

为了解决YOLOv1在小物体检测和多物体重叠区域检测方面出现的问题,YOLOv2对模型进行了优化。

该模型采用了特征融合网络(Feature Pyramid Network,FPN)等多种技术,提高了网络的细节表达能力和上下文信息感知能力。

同时,YOLOv2还采用了更加准确的物体位置预测方式和更加稳定的物体类别判定函数,使得该模型在各项指标上都有了明显提升。

YOLOv3是目前使用最广泛的YOLO模型版本,它采用了残差块(Residual Block)和特征金字塔网络(Feature Pyramid Network,FPN)等技术,能够处理各种大小的物体,还可以准确检测图片中多种类别的物体。

同时,YOLOv3还通过采用多尺度检测(Multi Scale Detection)、锚点框预测(Anchor Box Prediction)等技术,进一步提高了检测精度和速度。

二、模型优化虽然YOLO模型在物体检测方面取得了很好的效果,在实际应用中仍存在一些问题需要进一步优化,主要包括以下几方面:1. 弱化对背景的关注YOLO模型在训练过程中没有对背景进行明确的区分,导致在处理复杂场景时会产生误检现象。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述摘要:随着计算机技术的快速发展,图像识别技术在各个领域中得到了广泛的应用。

YOLO (You Only Look Once) 模型是一种基于深度学习的图像识别方法,相对于传统方法具有更快的速度和更好的准确率。

本文对基于YOLO模型的图像识别研究进行了综述,主要包括YOLO模型的原理、改进方法以及应用案例等。

关键词:YOLO模型;图像识别;深度学习;准确率;速度一、引言图像识别是计算机视觉领域中的一个重要研究方向,它用于从图像中自动识别并分类物体。

传统的图像识别方法通常包括特征提取和分类两个阶段,这种方法的缺点是处理图像时需要多次扫描,计算复杂度较高。

随着深度学习的兴起,基于深度学习的图像识别方法逐渐取代了传统方法。

YOLO模型是一种基于深度学习的图像识别方法,它采用了全卷积神经网络,能够在一次前向传播中直接预测图像中的物体位置和类别,大大提高了识别速度。

二、YOLO模型原理YOLO模型主要分为两个部分:特征提取网络和全连接层。

特征提取网络主要用于提取图像中的特征,常用的是卷积神经网络。

全连接层用于将特征和位置信息结合起来,预测物体的位置和类别。

虽然YOLO模型在识别速度方面有着很大的优势,但在一些细粒度分类和小物体识别上的准确率还有待提高。

一些研究者对YOLO模型进行了改进。

1. YOLO v2YOLO v2是YOLO模型的改进版本,相对于原始版本,YOLO v2在网络结构和训练策略上做了一些改进。

YOLO v2采用了更深的网络结构,提高了特征表示能力。

YOLO v2引入了Anchor Box机制,通过预定义一些Anchor Box来提高对不同尺度物体的检测准确率。

YOLO v2采用了多尺度训练和预测的策略,进一步提高了细粒度分类和小物体识别的准确率。

YOLO模型在图像识别领域有着广泛的应用,下面列举了一些典型的应用案例:1. 物体检测YOLO模型在物体检测方面具有很好的效果,在许多数据集上的准确率和速度都超过了其他方法。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述一、YOLO模型介绍YOLO是由Joseph Redmon等人于2016年提出的一种基于卷积神经网络(CNN)的目标检测算法。

该算法采用单个神经网络来完成目标检测、定位和分类的任务,其优势在于实时性高和准确性好。

YOLO算法将图像分成网格,每个网格预测出一个边界框和类别概率,然后通过非极大值抑制(NMS)来去除冗余的框,从而得到最终的检测结果。

自YOLO算法提出以来,研究者们对其进行了多方面的改进,以提高检测的准确性和速度。

其中比较有代表性的改进包括YOLOv2、YOLOv3和YOLOv4等版本。

YOLOv2在YOLOv1的基础上引入了Batch Normalization、High Resolution Classifier等技术,显著提高了检测的准确性和速度。

YOLOv3则进一步提出了多尺度检测和多尺度训练等策略,使得检测精度得到了进一步提升。

而YOLOv4则引入了CSPDarknet53、PAN、YOLOv3等新技术,使得检测性能又有了明显的提升。

除了以上的改进版本外,研究者们还提出了一些针对特定场景的改进版YOLO模型。

针对无人驾驶场景,有研究者提出了YOLO9000、YOLOv3-ISP等版本,以满足对小目标、高精度的需求。

对于工业领域的应用,也有研究者提出了基于YOLO的缺陷检测模型,用于快速、准确地检测产品表面的缺陷。

三、基于YOLO模型的图像识别应用基于YOLO模型的图像识别技术已经在多个领域得到了广泛的应用。

在智能安防领域,YOLO模型可以实时检测监控视频中的人员和车辆,从而实现对异常事件的自动检测和报警。

在无人驾驶领域,YOLO模型可以用于实时检测道路上的行人、车辆和交通标志,为自动驾驶车辆提供重要的感知能力。

在工业质检领域,YOLO模型可以应用于产品表面的缺陷检测,提高质检效率和准确性。

YOLO模型还可以应用于人脸识别、医学影像识别、农业领域的作物检测等多个领域。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)是一种深度学习算法,用于目标检测和图像识别。

与传统方法不同,YOLO采用单一网络来预测对象的类别和边界框。

在这篇综述中,我们将以YOLO为基础,探讨图像识别的研究进展。

首先,YOLO算法的基本原理是将输入图像分为许多网格(grid),每个网格对应一个预测框(bounding box)。

每个预测框会预测其内包含的物体的类别、置信度、位置等信息。

通过整个网络的输出,可以得到整个图像中所有物体的类别和位置信息。

这种基于网格的预测方法使得YOLO算法在处理大尺度图像时较为高效,在保证预测准确率的同时也有较快的速度。

接下来,我们将从以下几个方面来介绍基于YOLO模型的图像识别研究进展:一、目标检测目标检测一直是图像识别领域的重点研究方向,使用YOLO模型进行目标检测的优点在于其高效性和准确性。

目前,许多研究表明,基于YOLO的目标检测算法在速度和准确率上都有较高的表现。

例如,一些研究使用YOLOv3算法进行道路检测,取得了较好的效果。

此外,也有研究使用YOLO模型进行基于视频的目标跟踪,结果表明YOLO模型可以在多目标跟踪方面取得良好的性能。

二、图像分割图像分割是将图像分为若干个区域,并对每个区域进行目标检测和分类的过程。

在这个方向的研究中,YOLO模型同样有着不错的表现。

有研究使用基于YOLO的图像分割算法实现了对汽车驾驶员进行疲劳检测的研究。

此外,还有研究使用基于YOLO的图像分割算法进行物体识别,发现在处理复杂场景时,该算法可以达到较高的准确率。

三、目标检测在医疗领域中的应用目标检测在医疗领域中的应用,比如病变检测和诊断,一直是研究的重点。

基于YOLO 的图像识别技术也在这个领域中有很多的应用和探索。

最近的研究表明,使用YOLO的医学图像分类和病变检测算法会在检测准确率方面提升,同时也能够显著地减少底噪声和保留有用信号的局部特征。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)是一种基于深度学习的目标检测算法,由美国约瑟夫·雷德蒙德和亚历克斯·纳扎里安设计和开发,该算法可以在图片中快速准确地检测到对象,是目前最先进的图像识别技术之一。

本文将基于YOLO模型的图像识别研究进行综述。

一、YOLO模型介绍YOLO模型使用了全卷积神经网络(FCNN)来实现目标检测,首先将输入图片分成一系列的网格(grid),每个网格负责检测图像中的一个对象,然后将每个网格的预测结果结合起来生成最终的检测结果。

YOLO模型具有速度快、精度高、可处理多类物体等优点。

1. YOLOv2YOLOv2是对YOLO模型的再次改进,主要通过改进损失函数、更深的网络结构、BN操作和Anchor Boxes等来提高检测精度。

YOLOv2相比于YOLO,性能提升了数倍,同时速度也有所提升,是一个相当优秀的目标检测算法。

相对于YOLOv2,YOLOv3进一步提高了检测精度,同时对速度进行了优化,采用多尺度检测思想、聚类Anchor Boxes以及使用深度可分离卷积等技术来进一步提高检测精度。

同时YOLOv3也提供的新的骨架特征网络Darknet-53,综合精度和速度极优。

3. YOLO Nano为了满足一些要求速度更快、模型更小的需求,研究人员提出了YOLO Nano模型。

该模型不仅可以在速度和模型尺寸上有所优化,同时还可以通过迁移学习和微调的方式进行模型优化,可以在部分硬件资源受限的情况下使用。

三、YOLO模型在不同领域的应用1. 自动驾驶领域自动驾驶技术需要对周围环境进行实时监测,目标检测技术是其中的关键技术之一。

YOLO模型在自动驾驶领域中,可以实时监测道路上的障碍物、行人、交通灯等。

2. 工业检测领域在工业检测领域中,YOLO模型可以被用来执行单个或多个任务,例如,进行产品瑕疵检测、安全防护监测、设备故障监测等。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)是一种实时对象检测算法。

相对于传统的检测算法,YOLO 算法的优点在于它的速度快。

下面将对基于YOLO模型的图像识别研究进行综述。

YOLO算法的框架包含两个主要部分:特征提取网络和检测网络。

特征提取网络是一个卷积神经网络,它可以从输入图像中提取有意义的特征。

检测网络将特征映射到图像上,以检测图像中的目标。

在研究方面,许多学者对YOLO算法进行了改进和优化。

一方面,一些研究者提出了一些改进的YOLO模型,例如YOLOv2和YOLOv3。

这些改进的模型在识别准确性和处理速度方面都有所提高。

一些研究者将YOLO算法与其他模型相结合,以提高识别的准确性。

将YOLO算法与循环神经网络(RNN)相结合,可以实现对视频的实时检测和跟踪。

一些研究者还提出了一些与YOLO算法相关的应用。

在交通监控领域,YOLO算法可以用于实时识别和跟踪车辆和行人。

在农业领域,YOLO算法可以用于检测农作物的生长情况和病虫害。

在医学领域,YOLO算法可以用于检测肿瘤和其他异常情况。

虽然YOLO算法在实时图像识别方面表现出色,但它仍然存在一些局限性。

YOLO算法对于小目标的检测效果不佳。

YOLO算法对于重叠目标的检测也有一定的困难。

YOLO算法对于目标的定位不够精确,有时可能会将目标的边界框定位在错误的位置。

基于YOLO模型的图像识别研究取得了一些重要的进展,包括改进的模型、与其他模型的结合以及应用领域的扩展。

尽管YOLO算法存在一些局限性,但随着技术的不断改进和完善,相信基于YOLO的图像识别技术将会得到更广泛的应用。

使用YOLOv2进行图像检测

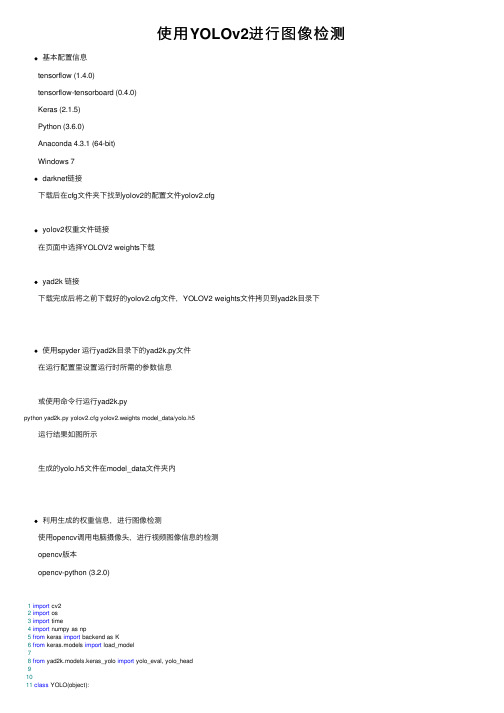

使⽤YOLOv2进⾏图像检测基本配置信息tensorflow (1.4.0)tensorflow-tensorboard (0.4.0)Keras (2.1.5)Python (3.6.0)Anaconda 4.3.1 (64-bit)Windows 7darknet链接下载后在cfg⽂件夹下找到yolov2的配置⽂件yolov2.cfgyolov2权重⽂件链接在页⾯中选择YOLOV2 weights下载yad2k 链接下载完成后将之前下载好的yolov2.cfg⽂件,YOLOV2 weights⽂件拷贝到yad2k⽬录下使⽤spyder 运⾏yad2k⽬录下的yad2k.py⽂件在运⾏配置⾥设置运⾏时所需的参数信息或使⽤命令⾏运⾏yad2k.pypython yad2k.py yolov2.cfg yolov2.weights model_data/yolo.h5运⾏结果如图所⽰⽣成的yolo.h5⽂件在model_data⽂件夹内利⽤⽣成的权重信息,进⾏图像检测使⽤opencv调⽤电脑摄像头,进⾏视频图像信息的检测opencv版本opencv-python (3.2.0)1import cv22import os3import time4import numpy as np5from keras import backend as K6from keras.models import load_model78from yad2k.models.keras_yolo import yolo_eval, yolo_head91011class YOLO(object):12def__init__(self):13 self.model_path = 'model_data/yolo.h5'14 self.anchors_path = 'model_data/yolo_anchors.txt'15 self.classes_path = 'model_data/coco_classes.txt'16 self.score = 0.317 self.iou = 0.51819 self.class_names = self._get_class()20 self.anchors = self._get_anchors()21 self.sess = K.get_session()22 self.boxes, self.scores, self.classes = self.generate()2324def _get_class(self):25 classes_path = os.path.expanduser(self.classes_path)26 with open(classes_path) as f:27 class_names = f.readlines()28 class_names = [c.strip() for c in class_names]29return class_names3031def _get_anchors(self):32 anchors_path = os.path.expanduser(self.anchors_path)33 with open(anchors_path) as f:34 anchors = f.readline()35 anchors = [float(x) for x in anchors.split(',')]36 anchors = np.array(anchors).reshape(-1, 2)37return anchors3839def generate(self):40 model_path = os.path.expanduser(self.model_path)41assert model_path.endswith('.h5'), 'Keras model must be a .h5 file.'4243 self.yolo_model = load_model(model_path)4445# Verify model, anchors, and classes are compatible46 num_classes = len(self.class_names)47 num_anchors = len(self.anchors)48# TODO: Assumes dim ordering is channel last49 model_output_channels = self.yolo_yers[-1].output_shape[-1]50assert model_output_channels == num_anchors * (num_classes + 5), \51'Mismatch between model and given anchor and class sizes'52print('{} model, anchors, and classes loaded.'.format(model_path))5354# Check if model is fully convolutional, assuming channel last order.55 self.model_image_size = self.yolo_yers[0].input_shape[1:3]56 self.is_fixed_size = self.model_image_size != (None, None)5758# Generate output tensor targets for filtered bounding boxes.59# TODO: Wrap these backend operations with Keras layers.60 yolo_outputs = yolo_head(self.yolo_model.output, self.anchors, len(self.class_names))61 self.input_image_shape = K.placeholder(shape=(2, ))62 boxes, scores, classes = yolo_eval(yolo_outputs, self.input_image_shape, score_threshold=self.score, iou_threshold=self.iou) 63return boxes, scores, classes6465def detect_image(self, image):66 start = time.time()67#image = cv2.imread(image)68#cv2.imshow('image',image)69 y, x, _ = image.shape7071if self.is_fixed_size: # TODO: When resizing we can use minibatch input.72 resized_image = cv2.resize(image, tuple(reversed(self.model_image_size)), interpolation=cv2.INTER_CUBIC)73 image_data = np.array(resized_image, dtype='float32')74else:75 image_data = np.array(image, dtype='float32')7677 image_data /= 255.78 image_data = np.expand_dims(image_data, 0) # Add batch dimension.7980 out_boxes, out_scores, out_classes = self.sess.run(81 [self.boxes, self.scores, self.classes],82 feed_dict={83 self.yolo_model.input: image_data,84 self.input_image_shape: [image.shape[0], image.shape[1]],85 K.learning_phase(): 086 })87print('Found {} boxes for {}'.format(len(out_boxes), 'img'))8889for i, c in reversed(list(enumerate(out_classes))):90 predicted_class = self.class_names[c]91 box = out_boxes[i]92 score = out_scores[i]9394 label = '{} {:.2f}'.format(predicted_class, score)95 top, left, bottom, right = box96 top = max(0, np.floor(top + 0.5).astype('int32'))97 left = max(0, np.floor(left + 0.5).astype('int32'))98 bottom = min(y, np.floor(bottom + 0.5).astype('int32'))99 right = min(x, np.floor(right + 0.5).astype('int32'))100print(label, (left, top), (right, bottom))101102 cv2.rectangle(image, (left, top), (right, bottom), (255, 0, 0), 2)103 cv2.putText(image, label, (left, int(top - 4)), cv2.FONT_HERSHEY_SIMPLEX, 0.5, (0, 0, 255), 1, cv2.LINE_AA) 104 end = time.time()105print(end - start)106return image107108def close_session(self):109 self.sess.close()110111112def detect_vedio(yolo):113 camera = cv2.VideoCapture(0)114115while True:116 res, frame = camera.read()117118if not res:119break120121 image = yolo.detect_image(frame)122 cv2.imshow("detection", image)123124if cv2.waitKey(1) & 0xFF == ord('q'):125break126 yolo.close_session()127128129def detect_img(img, yolo):130 image = cv2.imread(img)131 r_image = yolo.detect_image(image)132 dWindow("detection")133while True:134 cv2.imshow("detection", r_image)135if cv2.waitKey(110) & 0xff == 27:136break137 yolo.close_session()138139140if__name__ == '__main__':141 yolo = YOLO()142 detect_vedio(yolo)。

基于YOLO模型图像识别研究综述

基于YOLO模型图像识别研究综述YOLO(You Only Look Once)是一种实时物体检测算法,其核心思想是将图像分割为多个网格单元,并对每个单元进行物体检测和分类。

相对于其他物体检测算法,YOLO具有更快的速度和更好的准确率,在许多应用中表现出了良好的效果。

YOLO模型图像识别研究涉及到很多方面,包括网络结构设计、损失函数设计、数据集构建等。

下面将对这些方面进行综述。

首先是网络结构设计。

YOLO采用了类似于卷积神经网络(CNN)的结构,通过多个卷积层和池化层来提取图像的特征。

不同于传统的物体检测算法,YOLO通过全连接层将特征向量映射为检测框的坐标和类别概率。

这种网络结构既能够减少计算量,又能够有效提取图像的特征信息,从而提高物体检测的准确率和速度。

其次是损失函数设计。

YOLO使用了多个损失函数来衡量检测框的位置和类别预测的准确性。

位置损失函数衡量了检测框坐标的误差,类别损失函数衡量了类别预测的误差。

通过最小化这些损失函数,可以使得模型在物体检测任务上得到更好的表现。

YOLO还引入了置信度损失函数,用于衡量预测的置信度与真实值之间的差异。

这些损失函数的设计有助于优化模型的参数,提高物体检测的准确率。

最后是数据集构建。

YOLO模型通常需要大量的标注数据进行训练。

数据集的构建主要包括两个方面:样本的采集和标注。

样本的采集可以通过在线搜索引擎、图像库等方式获取,而标注则需要人工进行。

标注过程中需要标注物体的位置和类别信息,以便模型能够学习到物体的特征。

构建高质量的数据集对于训练一个准确的模型非常重要。

基于YOLO模型的图像识别研究涉及到网络结构设计、损失函数设计和数据集构建等方面。

通过合理的设计和构建,可以使得YOLO模型在图像识别任务中表现出更好的性能。

未来,随着深度学习的不断发展,YOLO模型可以进一步改进并应用于更多的领域。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第一章前言部分1.1课程项目背景与意义1.1.1课程项目背景视觉是各个应用领域,如制造业、检验、文档分析、医疗诊断,和军事等领域中各种智能/自主系统中不可分割的一部分。

由于它的重要性,一些先进国家,例如美国把对计算机视觉的研究列为对经济和科学有广泛影响的科学和工程中的重大基本问题,即所谓的重大挑战。

计算机视觉的挑战是要为计算机和机器人开发具有与人类水平相当的视觉能力。

机器视觉需要图象信号,纹理和颜色建模,几何处理和推理,以及物体建模。

一个有能力的视觉系统应该把所有这些处理都紧密地集成在一起。

作为一门学科,计算机视觉开始于60年代初,但在计算机视觉的基本研究中的许多重要进展是在80年代取得的。

计算机视觉与人类视觉密切相关,对人类视觉有一个正确的认识将对计算机视觉的研究非常有益。

计算机视觉是一门研究如何使机器“看”的科学,更进一步的说,就是是指用摄影机和电脑代替人眼对目标进行识别、跟踪和测量等机器视觉,并进一步做图形处理,使电脑处理成为更适合人眼观察或传送给仪器检测的图像。

作为一个科学学科,计算机视觉研究相关的理论和技术,试图建立能够从图像或者多维数据中获取‘信息’的人工智能系统。

这里所指的信息指Shannon定义的,可以用来帮助做一个“决定”的信息。

因为感知可以看作是从感官信号中提取信息,所以计算机视觉也可以看作是研究如何使人工系统从图像或多维数据中“感知”的科学。

科学技术的发展是推动人类社会进步的主要原因之一,未来社会进一步地朝着科技化、信息化、智能化的方向前进。

在信息大爆炸的今天,充分利用这些信息将有助于社会的现代化建设,这其中图像信息是目前人们生活中最常见的信息。

利用这些图像信息的一种重要方法就是图像目标定位识别技术。

不管是视频监控领域还是虚拟现实技术等都对图像的识别有着极大的需求。

一般的图像目标定位识别系统包括图像分割、目标关键特征提取、目标类别分类三个步骤。

深度学习的概念源于人工神经网络的研究。

含多隐层的多层感知器就是一种深度学习结构。

深度学习通过组合低层特征形成更加抽象的高层表示属性类别或特征,以发现数据的分布式特征表示。

深度学习的概念由Hinton等人于2006年提出。

基于深度置信网络提出非监督贪心逐层训练算法,为解决深层结构相关的优化难题带来希望,随后提出多层自动编码器深层结构。

此外Lecun等人提出的卷积神经网络是第一个真正多层结构学习算法,它利用空间相对关系减少参数数目以提高训练性能。

深度学习是机器学习中的一个新的研究领域,通过深度学习的方法构建深度网络来抽取特征是目前目标和行为识别中得到关注的研究方向,引起更多计算机视觉领域研究者对深度学习进行探索和讨论,并推动了目标和行为识别的研究,推动了深度学习及其在目标和行为识别中的新进展。

基于这个发展趋势,我们小组选择了基于回归方法的深度学习目标识别算法YOLO的研究。

1.1.2课程项目研究的意义众所周知,当前是信息时代,信息的获得、加工、处理以及应用都有了飞跃发展。

人们认识世界的重要知识来源就是图像信息,在很多场合,图像所传送的信息比其他形式的信息更丰富、真切和具体。

人眼与大脑的协作使得人们可以获取、处理以及理解视觉信息,人类利用视觉感知外界环境信息的效率很高。

事实上,据一些国外学者所做的统计,人类所获得外界信息有80%左右是来自眼睛摄取的图像。

由此可见,视觉作为人类获取外界信息的主要载体,计算机要实现智能化,就必须能够处理图像信息。

尤其是近年来,以图形、图像、视频等大容量为特征的图像数据处理广泛应用于医学、交通、工业自动化等领域。

深度学习是机器学习中一种基于对数据进行表征学习的方法。

观测值(例如一幅图像)可以使用多种方式来表示,如每个像素强度值的向量,或者更抽象地表示成一系列边、特定形状的区域等。

而使用某些特定的表示方法更容易从实例中学习任务(例如,人脸识别或面部表情识别)。

深度学习的好处是用非监督式或半监督式的特征学习和分层特征提取高效算法来替代手工获取特征。

深度学习是机器学习研究中的一个新的领域,其动机在于建立、模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本。

目标检测对于人来说是再简单不过的任务,但是对于计算机来说,它看到的是一些值为0~255的数组,因而很难直接得到图像中有人或者猫这种高层语义概念,也不清楚目标出现在图像中哪个区域。

图像中的目标可能出现在任何位置,目标的形态可能存在各种各样的变化,图像的背景千差万别……,这些因素导致目标检测并不是一个容易解决的任务。

这次课程项目,正是基于视觉、深度学习、目标识别而进行的,是一个热度很高的话题。

基于深度学习的目标识别研究具有重大的意义,深度学习的目标识别算法对于未来能够使用目标检测和图像识别的手段运用于物联网、智能设备、生物制药经济调控等多领域有很大的作用。

1.2国外研究现状机器学习是一门专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能的学科。

机器能否像人类一样能具有学习能力呢?1959年美国的塞缪尔(Samuel)设计了一个下棋程序,这个程序具有学习能力,它可以在不断的对弈中改善自己的棋艺。

4年后,这个程序战胜了设计者本人。

又过了3年,这个程序战胜了美国一个保持8年之久的常胜不败的冠军。

这个程序向人们展示了机器学习的能力,提出了许多令人深思的社会问题与哲学问题。

深度学习最近几年发展速度十分快,因此同时也推动了目标识别技术的发展,技术的革新总是相互影响的。

目标检测是图像处理和计算机视觉的一个重要分支,在理论和实践上都有重大意义。

近年来,随着物联网的高速发展与智能终端的广泛普及,目标检测技术成了机器视觉领域的研究热点,被国外学者广泛关注。

目标检测的研究主要包括了基于视频图像的目标检测和基于静态图片的目标检测。

本文主要讨论基于静态图片的目标检测算法,即在静态图片中检测并定位所设定种类的目标。

基于静态图片的目标检测的难点主要在于图片中的目标会因光照、视角以及目标部等变化而产生变化。

针对以上的难点,国外学者进行了很多尝试。

目前提出的方法主要分为基于形状轮廓的目标检测算法和基于目标特征的检测方法。

计算机视觉是指用计算机实现人的视觉功能,它的研究目标就是使计算机具有用过一幅或多幅图像认知周围环境的能力(包括对客观世界三维环境的感知、识别与理解)。

运动目标检测作为计算机视觉技术的一个分支,就是对视场的运动目标,如人或交通工具,进行实时的观测,并将其分类,然后分析他们的行为。

目前,国际上许多高校和研究所,如麻省理工学学院、牛津大学等都专门设立了针对运动目标检测的研究组或者研究实验室。

美英等国家已经研究了大量的相关项目。

一些著名公司和研究机构,如IBM、Microsoft、麻省理工学院等近几年来投入了大量的人力物力来进行智能监控系统的研究,部分成果已经转化为产品投入了市场。

目前在国的研究机构中,中国科学院自动化研究所下属的模式识别国家重点实验室视觉监控研究处于领先地位。

他们在交通场景视觉监控、人的运动视觉监控和行为模式识别方面进行了深入研究。

另外他们也总结了英国雷丁大学VIEWS 的车辆交通监控原型系统的研究经验,在之前的理论研究的基础上,自行设计并初步实现了一个拥有完全自主知识产权的交通监控原型系统vstart(Visual surveillance star)。

国其他高校如交通大学、航空航天大学也对这方面进行了研究。

尽管这样,目前在运动目标检测和视觉监控这方面仍然存在着许多不足:目前国市场上所见到的大部分智能监控产品来源于国外,性能和可靠性不够,并且维护和安装问题需要外方全方位参加,给国家安全带来了巨大的隐患。

目标之间互遮挡和人体自遮挡问题,尤其是在拥挤状态下,多人的检测更是难处理。

1.3本论文结构本文是基于回归方法的深度学习目标识别算法YOLO的研究。

第一章:前言。

主要介绍课程项目背景与意义、国外研究的现状,以及本论文的结构。

第二章:使用工具介绍及安装。

包括CentOS系统、OpenCV工具、CUDA开发环境、环境的搭建。

第三章:YOLO算法简介。

包括YOLO方法特点、核心思想和实现方法、以及YOLO 的创新。

第四章:训练数据采集与制作。

包括训练数据的采集、训练数据的制作。

第五章:训练配置、训练及测试训练效果。

包括具体的训练配置、训练过程和测试训练效果。

第六章:总结。

包含对本次课程项目实践过程的感想与收获,以及对未来的展望。

第二章使用工具介绍及安装2.1 CentOS系统CentOS(Community ENTerprise Operating System)是Linux发行版之一,它是来自于Red Hat Enterprise Linux依照开放源代码规定释出的源代码所编译而成。

由于出自同样的源代码,因此有些要求高度稳定性的服务器以CentOS 替代商业版的Red Hat Enterprise Linux使用。

两者的不同,在于CentOS并不包含封闭源代码软件。

CentOS,我们有很多人叫它社区企业操作系统,不管怎么叫它,它都是linux 的一个发行版本。

CentOS并不是全新的linux发行版,在RedHat家族中有企业版的产品,它是Red Hat Enterprise Linux,CentOS是RHEL的克隆版本,RHEL 是很多企业采用的linux发行版本,需要向RedHat付费才可以使用,并能得到付过费用的服务和技术支持和版本升级。

这个CentOS可以像REHL一样的构筑linux系统环境,但不需要向RedHat付任何的费用,同样也得不到任何有偿技术支持和升级服务。

CentOS有很多特点:CentOS就是对Red Hat AS进行改进后发布的,各种操作、使用和RED HAT没有区别;CentOS完全免费,不存在RED HAT AS4需要序列号的问题;CentOS独有的yum命令支持在线升级,可以即时更新系统,不像RED HAT那样需要花钱购买支持服务;CentOS修正了许多RED HAT AS的BUG。

基于开源的特性,Linux环境被很多技术人员和公司使用。

Linux以它的高效性和灵活性著称,Linux模块化的设计结构,使得它既能在价格昂贵的工作站上运行,也能够在廉价的PC机上实现全部的Unix特性,具有多任务、多用户的能力。

我们这次的课程项目“基于深度学习的目标识别研究”也是在Linux环境下完成的,因此本次项目实现使用的是CentOS 7.0系统。

2.2 OpenCV工具OpenCV的全称是:Open Source Computer Vision Library。

OpenCV是一个基于(开源)发行的跨平台计算机视觉库,可以运行在Linux、Windows和Mac OS 操作系统上。