BP中的训练样本和测试样本

BP

BP神经网络建立船舶耐波性评价的GUI实现作者:李生长李勇来源:《科技创新导报》2012年第25期摘要:应用BP神经网络建立船舶的耐波性评价模型,通过调用Matlab中的神经网络工具箱来完成评价模型的GUI实现。

在GUI设置界面内加入神经网络的输入向量和输出向量,同时设置网络需要的各种参数,可以很直观的查看评价模型的结构,减轻了使用者的认知负担。

应用GUI窗口训练评价网络,然后加入测试样本进行仿真测验,整个实现过程操作方便,使船舶耐波性的评价更人性化。

关键词:BP神经网络船舶耐波性评价 GUI中图分类号:U675.91 文献标识码:A 文章编号:1674-098X(2012)09(a)-0009-02人工神经网络是一种新型信息处理体系,其智能化特征与能力使其应用在诸多领域,并且在解决问题方面取得了良好的效果。

BP神经网络是基于误差反向传播算法的多层前馈型神经网络,适用于多因素共同作用下的系统安全状态综合评价。

在Matlab环境下应用BP神经网络建立的船舶耐波性评价模型,为耐波性评价及指导船舶操纵提供了一种有效的方法。

[1]GUI(Graphical User Interface)是指人机交互图形用户界面设计,用户可以通过选择、激活图形对象,实现某种特定的功能,使操作更人性化,减轻使用者的认知负担[2]。

本文通过GUI界面的网络设计,能够实现船舶耐波性评价的BP神经网络模型,从而进行船舶的安全评价,提高船舶耐波性评价效率,能够更方便、更有效的指导船舶操纵。

1 船舶耐波性评价模型的建立船舶耐波性是指船舶在波浪扰动下,产生各种摇荡运动、砰击、甲板上浪、失速、螺旋桨出水以及波浪弯矩等,仍能维持一定航速在波浪中安全航行的性能。

建立船舶耐波性评价模型首先要确定影响船舶安全的耐波性因素,影响船舶航行安全的耐波性因素有横摇、横荡、纵摇、纵荡、升沉、首摇、砰击、失速、晕船率、甲板上浪、甲板淹埋、稳性损失、螺旋桨出水、纵向波浪弯矩、船体某横剖面加速度、横向加速度、操纵性能恶化等。

bp分类的基本概念

bp分类的基本概念BP分类(Backpropagation)是一种基于梯度下降算法的神经网络分类方法。

它是一种监督学习算法,通过反向传播误差来训练神经网络模型。

基本概念如下:1. 前向传播(Forward Propagation):在神经网络中,输入样本通过网络的输入层向前传播,经过隐藏层的计算,最终在输出层得到分类结果。

2. 反向传播(Backward Propagation):反向传播是BP分类算法的核心,通过计算输出层与目标输出之间的误差,并将误差向后传播到隐藏层和输入层,用来更新网络的权重和偏置值。

3. 激活函数(Activation Function):激活函数在神经网络的每个神经元中使用,它们负责将输入信号进行非线性转换,增加网络的表达能力。

常用的激活函数有Sigmoid、ReLU、Tanh等。

4. 损失函数(Loss Function):损失函数衡量了模型的输出值与目标值之间的差距,是用来衡量模型预测的准确性的指标。

常见的损失函数包括均方误差(Mean Squared Error)、交叉熵(Cross-Entropy)等。

5. 权重更新(Weight Update):根据反向传播算法中计算得到的梯度信息,通过梯度下降算法对网络中的权重进行更新,使网络的预测结果逐步逼近目标输出。

6. 学习率(Learning Rate):学习率是用来控制权重更新的步长,它决定了每次权重更新的幅度大小。

合适的学习率可以加快收敛速度,但过大或过小的学习率都会导致训练效果不佳。

7. 批量学习(Batch Learning):在BP分类中,通常会将训练数据集分成若干个批次进行训练,每个批次包含多个样本。

通过计算每个样本的误差平均值来更新权重,以减小计算量和提高训练速度。

以上是BP分类的基本概念,理解这些概念对于掌握BP分类算法的原理和实现是很重要的。

BP神经网络实验报告

BP神经网络实验报告一、引言BP神经网络是一种常见的人工神经网络模型,其基本原理是通过将输入数据通过多层神经元进行加权计算并经过非线性激活函数的作用,输出结果达到预测或分类的目标。

本实验旨在探究BP神经网络的基本原理和应用,以及对其进行实验验证。

二、实验方法1.数据集准备本次实验选取了一个包含1000个样本的分类数据集,每个样本有12个特征。

将数据集进行标准化处理,以提高神经网络的收敛速度和精度。

2.神经网络的搭建3.参数的初始化对神经网络的权重和偏置进行初始化,常用的初始化方法有随机初始化和Xavier初始化。

本实验采用Xavier初始化方法。

4.前向传播将标准化后的数据输入到神经网络中,在神经网络的每一层进行加权计算和激活函数的作用,传递给下一层进行计算。

5.反向传播根据预测结果与实际结果的差异,通过计算损失函数对神经网络的权重和偏置进行调整。

使用梯度下降算法对参数进行优化,减小损失函数的值。

6.模型评估与验证将训练好的模型应用于测试集,计算准确率、精确率、召回率和F1-score等指标进行模型评估。

三、实验结果与分析将数据集按照7:3的比例划分为训练集和测试集,分别进行模型训练和验证。

经过10次训练迭代后,模型在测试集上的准确率稳定在90%以上,证明了BP神经网络在本实验中的有效性和鲁棒性。

通过调整隐藏层结点个数和迭代次数进行模型性能优化实验,可以发现隐藏层结点个数对模型性能的影响较大。

随着隐藏层结点个数的增加,模型在训练集上的拟合效果逐渐提升,但过多的结点数会导致模型的复杂度过高,容易出现过拟合现象。

因此,选择合适的隐藏层结点个数是模型性能优化的关键。

此外,迭代次数对模型性能也有影响。

随着迭代次数的增加,模型在训练集上的拟合效果逐渐提高,但过多的迭代次数也会导致模型过度拟合。

因此,需要选择合适的迭代次数,使模型在训练集上有好的拟合效果的同时,避免过度拟合。

四、实验总结本实验通过搭建BP神经网络模型,对分类数据集进行预测和分类。

BP神经网络的基本原理_一看就懂

5.4 BP神经网络的基本原理BP(Back Propagation)网络是1986年由Rinehart和McClelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。

BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。

它的学习规则是使用最速下降法,通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。

BP神经网络模型拓扑结构包括输入层(input)、隐层(hide layer)和输出层(output layer)(如图5.2所示)。

5.4.1 BP神经元图5.3给出了第j个基本BP神经元(节点),它只模仿了生物神经元所具有的三个最基本也是最重要的功能:加权、求和与转移。

其中x1、x2…xi…xn分别代表来自神经元1、2…i…n的输入;wj1、wj2…wji…wjn则分别表示神经元1、2…i…n与第j个神经元的连接强度,即权值;bj 为阈值;f(·)为传递函数;yj为第j个神经元的输出。

第j个神经元的净输入值为:(5.12)其中:若视,,即令及包括及,则于是节点j的净输入可表示为:(5.13)净输入通过传递函数(Transfer Function)f (·)后,便得到第j个神经元的输出:(5.14)式中f(·)是单调上升函数,而且必须是有界函数,因为细胞传递的信号不可能无限增加,必有一最大值。

5.4.2 BP网络BP算法由数据流的前向计算(正向传播)和误差信号的反向传播两个过程构成。

正向传播时,传播方向为输入层→隐层→输出层,每层神经元的状态只影响下一层神经元。

若在输出层得不到期望的输出,则转向误差信号的反向传播流程。

通过这两个过程的交替进行,在权向量空间执行误差函数梯度下降策略,动态迭代搜索一组权向量,使网络误差函数达到最小值,从而完成信息提取和记忆过程。

5.4.2.1 正向传播设 BP网络的输入层有n个节点,隐层有q个节点,输出层有m个节点,输入层与隐层之间(·),的权值为,隐层与输出层之间的权值为,如图5.4所示。

神经网络的BP算法实验报告

计算智能基础实验报告实验名称:BP神经网络算法实验班级名称:341521班专业:探测制导与控制技术姓名:***学号:********一、 实验目的1)编程实现BP 神经网络算法;2)探究BP 算法中学习因子算法收敛趋势、收敛速度之间的关系;3)修改训练后BP 神经网络部分连接权值,分析连接权值修改前和修改后对相同测试样本测试结果,理解神经网络分布存储等特点。

二、 实验要求按照下面的要求操作,然后分析不同操作后网络输出结果。

1)可修改学习因子2)可任意指定隐单元层数3)可任意指定输入层、隐含层、输出层的单元数4)可指定最大允许误差ε5)可输入学习样本(增加样本)6)可存储训练后的网络各神经元之间的连接权值矩阵;7)修改训练后的BP 神经网络部分连接权值,分析连接权值修改前和修改后对相同测试样本测试结果 。

三、 实验原理1BP 神经网络算法的基本思想误差逆传播(back propagation, BP)算法是一种计算单个权值变化引起网络性能变化的较为简单的方法。

由于BP 算法过程包含从输出节点开始,反向地向第一隐含层(即最接近输入层的隐含层)传播由总误差引起的权值修正,所以称为“反向传播”。

BP 神经网络是有教师指导训练方式的多层前馈网络,其基本思想是:从网络输入节点输入的样本信号向前传播,经隐含层节点和输出层节点处的非线性函数作用后,从输出节点获得输出。

若在输出节点得不到样本的期望输出,则建立样本的网络输出与其期望输出的误差信号,并将此误差信号沿原连接路径逆向传播,去逐层修改网络的权值和节点处阈值,这种信号正向传播与误差信号逆向传播修改权值和阈值的过程反复进行,直训练样本集的网络输出误差满足一定精度要求为止。

2 BP 神经网络算法步骤和流程BP 神经网络步骤和流程如下:1) 初始化,给各连接权{},{}ij jt W V 及阈值{},{}j t θγ赋予(-1,1)间的随机值;2) 随机选取一学习模式对1212(,),(,,)k k k k k k k n k n A a a a Y y y y ==提供给网络;3) 计算隐含层各单元的输入、输出;1n j ij i j i s w a θ==⋅-∑,()1,2,,j j b f s j p ==4) 计算输出层各单元的输入、输出;1t t jt j t j l V b γ==⋅-∑,()1,2,,t t c f l t q ==5) 计算输出层各单元的一般化误差;()(1)1,2,,k k t t tt t t d y c c c t q =-⋅-=6) 计算中间层各单元的一般化误差;1[](1)1,2,,q kk jt jt j j t e d V b b j p ==⋅⋅-=∑7) 修正中间层至输出层连接权值和输出层各单元阈值;(1)()k jt jt t j V iter V iter d b α+=+⋅⋅(1)()k t t t iter iter d γγα+=+⋅8) 修正输入层至中间层连接权值和中间层各单元阈值;(1)()kk ij ij j i W iter W iter e a β+=+⋅⋅(1)()kj j j iter iter e θθβ+=+⋅9) 随机选取下一个学习模式对提供给网络,返回步骤3),直至全部m 个模式训练完毕;10) 重新从m 个学习模式对中随机选取一个模式对,返回步骤3),直至网络全局误差函数E 小于预先设定的一个极小值,即网络收敛;或者,当训练次数大于预先设定值,强制网络停止学习(网络可能无法收敛)。

BP神经网络实验详解(MATLAB实现)

BP神经网络实验详解(MATLAB实现)BP(Back Propagation)神经网络是一种常用的人工神经网络结构,用于解决分类和回归问题。

在本文中,将详细介绍如何使用MATLAB实现BP神经网络的实验。

首先,需要准备一个数据集来训练和测试BP神经网络。

数据集可以是一个CSV文件,每一行代表一个样本,每一列代表一个特征。

一般来说,数据集应该被分成训练集和测试集,用于训练和测试模型的性能。

在MATLAB中,可以使用`csvread`函数来读取CSV文件,并将数据集划分为输入和输出。

假设数据集的前几列是输入特征,最后一列是输出。

可以使用以下代码来实现:```matlabdata = csvread('dataset.csv');input = data(:, 1:end-1);output = data(:, end);```然后,需要创建一个BP神经网络模型。

可以使用MATLAB的`patternnet`函数来创建一个全连接的神经网络模型。

该函数的输入参数为每个隐藏层的神经元数量。

下面的代码创建了一个具有10个隐藏神经元的单隐藏层BP神经网络:```matlabhidden_neurons = 10;net = patternnet(hidden_neurons);```接下来,需要对BP神经网络进行训练。

可以使用`train`函数来训练模型。

该函数的输入参数包括训练集的输入和输出,以及其他可选参数,如最大训练次数和停止条件。

下面的代码展示了如何使用`train`函数来训练模型:```matlabnet = train(net, input_train, output_train);```训练完成后,可以使用训练好的BP神经网络进行预测。

可以使用`net`模型的`sim`函数来进行预测。

下面的代码展示了如何使用`sim`函数预测测试集的输出:```matlaboutput_pred = sim(net, input_test);```最后,可以使用各种性能指标来评估预测的准确性。

数据挖掘实验(一)bp神经网络实验指导书48

数据挖掘实验(一)BP神经网络实验吴诗乐通信7班20123100053一、实验目的初步熟悉MATLAB 工作环境,熟悉命令窗口,学会使用帮助窗口查找帮助信息。

二、实验内容1、网络设计,包括输入层、隐含层、输出层节点个数的设计。

2、算法步骤3、编程,注意原始数据的通用化,数据输入的随机性。

4、网络训练,注意训练数据与验证数据分开。

5、网络验证6、结果分析,修改隐含层节点个数,修改学习率,分别对结果的影响。

三、实验数据本实验以Fisher的Iris数据集作为神经网络程序的测试数据集。

Iris数据集可以在/wiki/Iris_flower_data_set 找到。

也可以在UCI数据集中下载。

Iris数据集中Iris花可分为3个品种,现需要对其进行分类。

不同品种的Iris 花的花萼长度、花萼宽度、花瓣长度、花瓣宽度会有差异。

现有一批已知品种的Iris花的花萼长度、花萼宽度、花瓣长度、花瓣宽度的数据。

要求用已有的数据训练一个神经网络用作分类器。

四、神经网络实现1. 数据预处理在训练神经网络前一般需要对数据进行预处理,一种重要的预处理手段是归一化处理。

下面简要介绍归一化处理的原理与方法。

(1) 什么是归一化?数据归一化,就是将数据映射到[0,1]或[-1,1]区间或更小的区间,比如(0.1,0.9) 。

(2) 为什么要归一化处理?<1>输入数据的单位不一样,有些数据的范围可能特别大,导致的结果是神经网络收敛慢、训练时间长。

<2>数据范围大的输入在模式分类中的作用可能会偏大,而数据范围小的输入作用就可能会偏小。

<3>由于神经网络输出层的激活函数的值域是有限制的,因此需要将网络训练的目标数据映射到激活函数的值域。

例如神经网络的输出层若采用S形激活函数,由于S形函数的值域限制在(0,1),也就是说神经网络的输出只能限制在(0,1),所以训练数据的输出就要归一化到[0,1]区间。

BP人工神经网络试验报告一

BP⼈⼯神经⽹络试验报告⼀学号:北京⼯商⼤学⼈⼯神经⽹络实验报告实验⼀基于BP算法的XX及Matlab实现院(系)专业学⽣姓名成绩指导教师2011年10⽉⼀、实验⽬的:1、熟悉MATLAB 中神经⽹络⼯具箱的使⽤⽅法;2、了解BP 神经⽹络各种优化算法的原理;3、掌握BP 神经⽹络各种优化算法的特点;4、掌握使⽤BP 神经⽹络各种优化算法解决实际问题的⽅法。

⼆、实验内容:1 案例背景1.1 BP 神经⽹络概述BP 神经⽹络是⼀种多层前馈神经⽹络,该⽹络的主要特点是信号前向传递,误差反向传播。

在前向传递中,输⼊信号从输⼊层经隐含层逐层处理,直⾄输出层。

每⼀层的神经元状态只影响下⼀层神经元状态。

如果输出层得不到期望输出,则转⼊反向传播,根据预测误差调整⽹络权值和阈值,从⽽使BP 神经⽹络预测输出不断逼近期望输出。

BP 神经⽹络的拓扑结构如图1.1所⽰。

图1.1 BP 神经⽹络拓扑结构图图1.1中1x ,2x , ……n x 是BP 神经⽹络的输⼊值1y ,2y , ……n y 是BP 神经的预测值,ij ω和jk ω为BP 神经⽹络权值。

从图1.1可以看出,BP 神经⽹络可以看成⼀个⾮线性函数,⽹络输⼊值和预测值分别为该函数的⾃变量和因变量。

当输⼊节点数为n ,输出节点数为m 时,BP 神经⽹络就表达了从n 个⾃变量到m 个因变量的函数映射关系。

BP 神经⽹络预测前⾸先要训练⽹络,通过训练使⽹络具有联想记忆和预测能⼒。

BP 神经⽹络的训练过程包括以下⼏个步骤。

步骤1:⽹络初始化。

根据系统输⼊输出序列()y x ,确定⽹络输⼊层节点数n 、隐含层节点数l ,输出层节点数m ,初始化输⼊层、隐含层和输出层神经元之间的连接权值ij ω和式中, l 为隐含层节点数; f 为隐含层激励函数,该函数有多种表达形式,本章所选函数为:步骤3:输出层输出计算。

根据隐含层输出H ,连接权值jk ω和阈值b ,计算BP 神经⽹络预测输出O 。

bp和rbf的区别

bp和rbf的区别1、BP网络BP神经元的传输函数为非线性函数,最常用的是logsing和tansig,有的输出层也采用线性函数(purelin)。

BP网络一般为多层神经网络,经验表明一般情况下两层即可满足。

如果多层BP网络的输出层采用S型传输函数,其输出值将会限制在一个较小的范围内(0,1);而采用线性传输函数则可以取任意值。

BP网络的学习过程分为两个阶段:(1)输入已知学习样本,通过设置网络结构和前一次迭代的权值和阈值,从网络的第一层向后计算各神经元的输出。

(2)对权值和阈值进行修改,从最后一层向前计算各权值和阈值对总误差的影响(梯度),据此对各权值和阈值进行修改。

BP网络的学习算法:最速下降BP算法(traingd)、动量BP算法(traingdm)、学习率可变的BP算法(traingdx)、弹性BP算法(trainrp)、变梯度算法(traincgf,traincgp,traincgb,trainscg)、拟牛顿算法(trainoss)、LM算法(trainlm)。

提高BP网络泛化能力的方法:归一化法和提前终止法。

BP网络的局限性:(1)学习率与稳定性的矛盾:梯度算法进行稳定学习的学习率较小,所以通常学习过程得收敛速度很慢。

附加动量法通常比简单的梯度算法快,因为在保证学习时间的同时,可以采用很高的学习率,但对于实际应用仍然很慢。

以上两种个方法只适用于希望增加训练次数的情况。

如果有足够的存储空间,则对于中小规模的神经网络可采用LM算法;如果存储空间有问题,则可采用其他多种快速算法,例如对于大规模的神经网络采用trainrp或trainscg(变梯度算法的一种)。

(2)学习率的选择缺乏有效的方法。

对于线性网络,学习率选择的太大,容易导致学习不稳定;反之,学习率选择的太小,则导致无法忍受的过长的学习时间。

对于非线性网络,还没有找到一种简单易行的方法。

(3)训练过程可能限于局部最小。

在实际应用过程中,BP网络往往在训练过程中,也可能找不到某个问题具体地解,比如在训练过程中陷入局部最小的情况。

BP算法的C语言实现

终于搞定了,输出结果完全正确,运行训练次数竟然有几万次!汗!(适合普通BP算法和改进型BP[带缓冲项]算法)//训练样本大概是这些(每组前三个为in样本数据后面为out结果)://0 0 0 0.9//0 0 1 0.1//0 1 0 0.1//0 1 1 0.9//1 0 0 0.1//1 0 1 0.9//1 1 0 0.9//1 1 1 0.1测试样本可以自己试试这些数据//0 0.1 0.9(期望:0.1)//0.9 0.9 0.1(期望0.9)-----------------------------------------分割线-----------------------------------------#include "stdlib.h"#include "math.h"#include "conio.h"#include "stdio.h"#include "time.h"#define N 8 /*学习样本个数(测试样本个数)*/ #define IN 3 /*输入层神经元数目*/#define HN 2 /*隐层神经元数目*/#define ON 1 /*输出层神经元数目*/float P[IN]; /*单个样本输入数据*/float T[ON]; /*单个样本教师数据*/float W[HN][IN]; /*输入层至隐层权值*/ float V[ON][HN]; /*隐层至输出层权值*/ float X[HN]; /*隐层的输入*/float Y[ON]; /*输出层的输入*/float H[HN]; /*隐层的输出*/float O[ON]; /*输出层的输出*/float YU_HN[HN]; /*隐层的阈值*/float YU_ON[ON]; /*输出层的阈值*/float err_m[N]; /*第m个样本的总误差*/float a; /*输出层至隐层学习效率*/float b; /*隐层至输入层学习效率*/float alpha; /*/动量因子,改进型bp算法使用*/ float d_err[ON];/*δk*/float e_err[HN];/*δj*/FILE *fp;/*定义一个放学习样本的结构*/struct {float input[IN];float teach[ON];}Study_Data[N];/*定义一个放测试样本的结构*/struct {float input[IN];float expect[ON];}Test_Data[N];/*改进型bp算法用来保存每次计算的权值*/float old_W[HN][IN];float old_V[ON][HN];int Start_Show(){clrscr();printf("\n *********************** \n");printf(" * Welcome to use *\n");printf(" * this program of *\n");printf(" * calculating the BP *\n");printf(" * model! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");printf("\n\nBefore starting,please read the follows carefully:\n\n");printf(" The program of BP can study itself for no more than 200000 times.\nAnd surpassing the number,the program will be ended by itself in\npreventing running infinitely because of error!\n");printf("\n\n\n");printf("Now press any key to start...\n");getch();clrscr();}int End_Show(){printf("\n\n---------------------------------------------------\n");printf("The program has reached the end successfully!\n\nPress any key to exit!\n\n"); printf("\n ***********************\n");printf(" * This is the end *\n");printf(" * of the program which*\n");printf(" * can calculate the BP*\n");printf(" * model! *\n");printf(" ***********************\n");printf(" * Thanks for using! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n"); getch();exit(0);}/*读取训练样本*/GetTrainingData(){int i,j,m;float datr;if((fp=fopen("sample.txt","r"))==NULL){printf("Cannot open file strike any key exit!");getch();exit(1);}for(i=0;i<N;i++){j=0;while(j!=(IN+ON)&&fscanf(fp,"%f",&datr)!=EOF){if(j>IN-1) Study_Data[i].teach[j-IN]=datr;else Study_Data[i].input[j]=datr;/*printf("\nthe Study_Data[%d].input[%d]=%f\n %f",i,j,Study_Data[i].input[j],datr);getch();*/ /*use to check the loaded training datas*/j++;}}fclose(fp);printf("\nThere are [%d] sample datas that have been loaded successfully!\n",N*(IN+ON)); printf("\nShow the data which has been loaded as follows:\n");for(m=0;m<N;m++){for(i=0;i<IN;i++){printf("Study_Data[%d].input[%d]=%f ",m,i,Study_Data[m].input[i]);}for(j=0;j<ON;j++){printf("Study_Data[%d].teach[%d]=%f ",m,j,Study_Data[m].teach[j]);}}printf("\n\n\nPress any key to begin Study...");getch();clrscr();return 1;}/*初始化权、阈值子程序*/initial(){int i;int ii;int j;int jj;int k;int kk;printf("\nRandsom Weight value and Bias value as follow:\n"); srand(time(NULL));/*随机函数种子*/printf("\nWeight Value:\n");for(i=0;i<HN;i++) {for(j=0;j<IN;j++) {W[i][j]=(float)(((rand()/32767.0)*2-1)/2);/*初始化输入层到隐层的权值,随机模拟0.5~-0.5 */printf("\nw[%d][%d]=%f",i,j,W[i][j]);}}for(ii=0;ii<ON;ii++) {for(jj=0;jj<HN;jj++) {V[ii][jj]= (float)(((rand()/32767.0)*2-1)/2); /*初始化隐层到输出层的权值,随机模拟0.5~-0.5 */printf("\nV[%d][%d]=%f",ii,jj,V[ii][jj]);}}printf("\n\nBias Value:\n");for(k=0;k<HN;k++) {YU_HN[k] = 1.0;/*隐层阈值初始化,-0.01 ~ 0.01 之间*/printf("\nYU_HN[%d]=%f",k,YU_HN[k]);}for(kk=0;kk<ON;kk++) {YU_ON[kk] = 1.0;/*输出层阈值初始化,-0.01 ~ 0.01 之间*/printf("\nYU_ON[%d]=%f\n",kk,YU_ON[kk]);}printf("\n\n\n\n\nPress any key to start culculating...:\n"); getch();clrscr();printf("Please wait...");return 1;}/*第m个学习样本输入子程序*/input_P(int m){ int i,j;for(i=0;i<IN;i++) {P[i]=Study_Data[m].input[i];}return 1;}/*第m个样本教师信号子程序*/input_T(int m){int k;for(k=0;k<ON;k++) {T[k]=Study_Data[m].teach[k];} return 1;}/*求净输入,输出*/IN_OUT(){float sigma1,sigma2;int i,j,ii,jj;for(i=0;i<HN;i++) {for(j=0;j<IN;j++){sigma1+=W[i][j]*P[j];}/*求隐层内积*/ X[i]=sigma1+YU_HN[i];H[i]=1.0/(1.0+exp(-X[i]));}for(ii=0;ii<ON;ii++) {sigma2=0.0;for(jj=0;jj<HN;jj++){sigma2+=V[ii][jj]*H[jj];}Y[ii]=sigma2+YU_ON[ii];O[ii]=1.0/(1.0+exp(-Y[ii]));}return 1;}/*误差分析*//*δk*/{int k;float abs_err[ON];float sqr_err=0.0;for (k=0;k<ON;k++) {abs_err[k]=T[k]-O[k];sqr_err+=(abs_err[k])*(abs_err[k]);d_err[k]=abs_err[k]*O[k]*(1.0-O[k]);err_m[m]=sqr_err/2;}return 1;}/*δj*/int Err_H_I(){int j,k;float sigma;sigma=0.0;for(k=0;k<ON;k++){sigma+=d_err[k]*V[k][j];}e_err[j]=sigma*H[j]*(1-H[j]);}return 1;}/*总误差*/float Err_Sum(){int m;float total_err=0.0;for(m=0;m<N;m++){total_err+=err_m[m];}return total_err;}/*新旧权值更新量交替--改进型Bp算法*/{int i;int ii;int j;int jj;for(i=0;i<HN;i++) {for(j=0;j<IN;j++){old_W[i][j] =b*e_err[i]*P[j];}}for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++){old_V[ii][jj] =a*d_err[ii]*H[jj];} }return 1;}/*更新权值,阈值*/int Delta_O_H(int n,int study){int k,j;if((n<=1)||(study=1)){for (k=0;k<ON;k++) {for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j];}YU_ON[k]+=a*d_err[k];}}else{for (k=0;k<ON;k++) {for (j=0;j<HN;j++){V[k][j]=V[k][j]+(1.0-alpha)*a*d_err[k]*H[j]+alpha*old_V[k][j];} YU_ON[k]+=a*d_err[k];}return 1;}/*隐层*/Delta_H_I(int n,int study){int i,j;if((n<=1)||(study=1)){for (j=0;j<HN;j++) {for (i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i];}YU_HN[j]+=b*e_err[j];}}else{for(i=0;i<IN;i++){W[j][i]=W[j][i]+(1.0-alpha)*b*e_err[j]*P[i]+alpha*old_W[j][i];} YU_HN[j]+=b*e_err[j];}}return 1;}/*保存更新*/void savequan(){ int i,j,k;int ii,jj,kk;/*save weight*/if((fp=fopen("weight.txt","a"))==NULL){printf("Cannot open file strike any key exit!");getch();}for(i=0;i<HN;i++){for(j=0;j<IN;j++) fprintf(fp,"W[%d][%d]=%f\n",i,j,W[i][j]); }fprintf(fp,"\n");for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++) fprintf(fp,"V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}fclose(fp);printf("\nThe result of weight.txt(quanzhi) has been saved successfully!"); /*save limit*/if((fp=fopen("limit.txt","a"))==NULL){printf("Cannot open file strike any key exit!");getch();exit(1);}for(k=0;k<ON;k++) fprintf(fp,"YU_ON[%d]=%f\n",k,YU_ON[k]);fclose(fp);printf("\nThe result of limit.txt(yuzhi) has been saved successfully!\n\n\n\n\nPress any key to Test..."); getch();clrscr();}/*读取测试样本*/GetTestData(){int i,j,m;float datr;if((fp=fopen("test.txt","r"))==NULL){printf("Cannot open file strike any key exit!");getch();exit(1);}while(j!=(IN+ON)&&fscanf(fp,"%f",&datr)!=EOF){if(j>IN-1) Test_Data[i].expect[j-IN]=datr;else Test_Data[i].input[j]=datr;j++;}}fclose(fp);printf("\nThere are [%d] test datas that have been loaded successfully!\n",N*(IN+ON)); printf("\nShow the data which has been loaded as follows:\n");for(m=0;m<N;m++){for(i=0;i<IN;i++){printf("Test__Data[%d].input[%d]=%f ",m,i,Test_Data[m].input[i]);}for(j=0;j<ON;j++){printf("Test__Data[%d].expec[%d]=%f ",m,j,Test_Data[m].expect[j]);}}printf("\n\n\n\nPress any key to culculating...");clrscr();return 1;}/*样本测试及结果*/Test(){int i,j,k,m;float net1[HN],net2[ON],H_net[HN],O_net[ON]; for(m=0;m<N;m++){for(i=0;i<HN;i++){net1[i]=0.0;for(j=0;j<IN;j++){net1[i]+=Test_Data[m].input[j]*W[i][j];}net1[i]=net1[i]+YU_HN[i];H_net[i]=1.0/(1.0+exp(-net1[i]));for(k=0;k<ON;k++){net2[k]=0.0;for(j=0;j<HN;j++){net2[k]+=H_net[j]*V[k][j];}net2[k]=net2[k]+YU_ON[k];O_net[k]=1.0/(1.0+exp(-net2[k]));printf("\nTest result[%d]=%f\n",m,O_net[k]);}}}/*直接输入测试*/OnlineSet(){char s;printf("\n\n\n\nIf you want to test the data you inputted now,press Y(or other button except Q);\nOr press Q to quit Test!\n");s=getch();switch(s) {case 'Q':clrscr();End_Show();default:Online_Test();break;}printf("\nTo continue testing press Y(or other button except Q);\nOr press Q to quit Test!\n");}getch();}Online_Test(){int i,j,k;float datr,TS[IN];float net1[HN],net2[ON],H_net[HN],O_net[ON];printf("\nPlease Input %d test datas with a space between each two datas:\n",IN); for(i=0;i<IN;i++){scanf("%f",&datr);TS[i]=datr;}for(i=0;i<HN;i++){net1[i]=0.0;for(j=0;j<IN;j++){net1[i]+=TS[j]*W[i][j];}net1[i]=net1[i]+YU_HN[i];H_net[i]=1.0/(1.0+exp(-net1[i]));}for(k=0;k<ON;k++){net2[k]=0.0;for(j=0;j<HN;j++){net2[k]+=H_net[j]*V[k][j];net2[k]=net2[k]+YU_ON[k];O_net[k]=1.0/(1.0+exp(-net2[k]));printf("\nTest result:%f\n",O_net[k]);}}/**********************//**程序入口,即主程序**//**********************/void main(){float Pre_error;float sum_err;long int study;long int flag;int n=1;/*n=1:普通Bp算法;n=2:改进型Bp算法*/ flag=200000;a=0.5;alpha=0.5;study=0;Pre_error=0.000001;/*可接受误差*/ Start_Show(); GetTrainingData();initial();do{int m;++study;for(m=0;m<N;m++){input_P(m);input_T(m);IN_OUT();Err_O_H(m);Err_H_I();Delta_O_H(n,study);Delta_H_I(n,study);saveWV();}sum_err=Err_Sum();if(study>flag){printf("\n*******************************\n");printf("The program is ended by itself because of error!\nThe learning times is surpassed!\n");printf("*****************************\n");getch();break;}}while (sum_err>Pre_error);printf("\n****************\n");printf("\nThe program have studyed for [%ld] times!\n",study);printf("\n****************\n");savequan(); /*save the results*/GetTestData();printf("\nThe Result of the Test As follows:\n");Test();OnlineSet();End_Show();}----------------------------------------------------------------------------------。

BP神经网络算法步骤

BP神经网络算法步骤

1.初始化神经网络参数

-设置网络的输入层、隐藏层和输出层的神经元数目。

-初始化权重和偏置参数,通常使用随机小值进行初始化。

2.前向传播计算输出

-将输入样本数据传入输入层神经元。

-根据权重和偏置参数,计算隐藏层和输出层神经元的输出。

- 使用激活函数(如Sigmoid函数)将输出映射到0到1之间。

3.计算误差

4.反向传播更新权重和偏置

-根据误差函数的值,逆向计算梯度,并将梯度传播回网络中。

-使用链式法则计算隐藏层和输出层的梯度。

-根据梯度和学习率参数,更新权重和偏置值。

5.重复迭代训练

-重复执行2-4步,直到网络输出误差满足预定的停止条件。

-在每次迭代中,使用不同的训练样本对网络进行训练,以提高泛化性能。

-可以设置训练轮数和学习率等参数来控制训练过程。

6.测试和应用网络

-使用测试集或新样本对训练好的网络进行测试。

-将测试样本输入网络,获取网络的输出结果。

-根据输出结果进行分类、回归等任务,评估网络的性能。

7.对网络进行优化

-根据网络在训练和测试中的性能,调整网络的结构和参数。

-可以增加隐藏层的数目,改变激活函数,调整学习率等参数,以提高网络的性能。

以上是BP神经网络算法的基本步骤。

在实际应用中,还可以对算法进行改进和扩展,如引入正则化技术、批量更新权重等。

同时,数据的预处理和特征选择也对网络的性能有着重要的影响。

在使用BP神经网络算法时,需要根据实际问题对网络参数和训练策略进行适当调整,以获得更好的结果。

基于BP神经网络的建筑工程造价估算研究

工程建设领域存在许多因了解不充分而导致实际投资金额与估算值之间出现明显偏差的情况,这种偏差不仅会对投资者和施工企业造成巨大损失,还会影响整个工程项目的成功与盈利能力。

因此,项目成本估算变得至关重要,既涉及项目的盈亏状况,又直接影响项目方案的选择,为项目决策提供了可靠依据。

然而,成本估算本身充满了挑战,因为工程项目的特性和条件多种多样,充满了不确定性。

因此,准确估算工程造价一直是一项复杂而困难的任务。

考虑到估算结果的准确性对项目的投资和决策有着直接而深远的影响,工程造价估算模型的研究显得尤为重要[1]。

传统的成本估算方法通常依赖于统计分析和简单的回归理论。

然而,这些方法存在精度较低和耗时较长的缺点,限制了其在复杂工程项目中的应用。

近年来,随着计算机技术的飞速发展,新的估算方法被引入成本估算,为提高准确性和效率提供了新的途径。

这些方法包括遗传算法、神经网络和决策树等,借助计算机的强大计算能力,能够更好地处理大量的数据和不确定性因素,并取得了令人满意的成果[2]。

Yang [3]提出了一种用于环境治理成本估计的粒子群算法优化支持向量机(PSO-SVM)算法,并采用聚类分析对样本进行分类,通过实验结果发现,该方法对环境成本预测具有良好的指导作用;Wang [4]基于Fuzzy 数学估算了建设项目成本,通过案例分析验证该方法具有良好的适用性,有助于提高建筑企业的竞争力;El-Saw⁃alhi [5]利用SVM 回归器估算公路项目成本,确定了影响模型的12个主要因素,通过对70个实际案例的训练和测试,发现模型的预测精度达到95%;Ma [6]通过增强的回归树(Regression Trees)估计成本,并对234个实际成本数据进行了实验,证明了该方法在成本估计中的适用性;Sun 等人[7]利用遗传算法对神经网络进行了优化,建立了成本估算模型,实现了电力工程成本的估算。

本研究对建筑成本的影响因素进行了分析和筛选,建立了基于BP 神经网络的建筑成本估算模型,并通过实例分析证明了模型的有效性和准确性。

BP算法程序实现

BP算法程序实现BP算法(Back Propagation Algorithm,即反向传播算法)是一种用于训练神经网络的常用算法。

它的基本思想是通过不断地调整神经元之间的连接权值,使得网络的输出接近于期望的输出。

在实现BP算法时,需要进行以下几个步骤:1.初始化参数:首先,需要初始化神经网络的权值和偏置,通常可以使用随机的小数来初始化。

同时,需要设置好网络的学习率和最大迭代次数。

2.前向传播:通过前向传播过程,将输入数据输入到神经网络中,并计算出每个神经元的输出。

具体来说,对于第一层的神经元,它们的输出即为输入数据。

对于后续的层,可以使用如下公式计算输出:a[i] = sigmoid(z[i])其中,a[i]表示第i层的输出,z[i]为第i层的输入加权和,sigmoid为激活函数。

3.计算误差:根据网络的输出和期望的输出,可以计算出网络的误差。

一般来说,可以使用均方差作为误差的度量指标。

loss = 1/(2 * n) * Σ(y - a)^2其中,n为训练样本的数量,y为期望输出,a为网络的实际输出。

4.反向传播:通过反向传播算法,将误差从输出层向输入层逐层传播,更新权值和偏置。

具体来说,需要计算每一层神经元的误差,并使用如下公式更新权值和偏置:delta[i] = delta[i+1] * W[i+1]' * sigmoid_derivative(z[i])W[i] = W[i] + learning_rate * delta[i] * a[i-1]'b[i] = b[i] + learning_rate * delta[i]其中,delta[i]为第i层的误差,W[i]为第i层与i+1层之间的权值,b[i]为第i层的偏置,learning_rate为学习率,sigmoid_derivative为sigmoid函数的导数。

5.迭代更新:根据步骤4中的更新公式,不断迭代调整权值和偏置,直到达到最大迭代次数或误差小于一些阈值。

多尺度排列熵及其在滚动轴承故障诊断中的应用

多尺度排列熵及其在滚动轴承故障诊断中的应用郑近德;程军圣;杨宇【摘要】A definition of MPE was presented to extract the fault characteristics of dynamics chan-ges from bearing vibration signals.And in combination with SVM,a bearing fault diagnosis approach was put forward based on MPE and SVM.Firstly the algorithms of PE and MPE were introduced. Then experimental data were used to demonstrate the validity of the approach.Also for comparision with SVM,the BP neural network was used and the analysis results indicate that the proposed ap-proach can extract the fault feature and identify the fault categories effectively.%引入多尺度排列熵(MPE)的概念,用来检测振动信号不同尺度下的动力学突变行为,并将其应用于机械故障诊断中滚动轴承故障特征的提取,结合支持向量机(SVM),提出了一种基于 MPE 和SVM的滚动轴承故障诊断方法,将新提出的滚动轴承故障诊断方法应用于实验数据分析,并通过与BP神经网络对比,结果表明,该方法能够有效地提取故障特征,实现故障类型的诊断。

【期刊名称】《中国机械工程》【年(卷),期】2013(000)019【总页数】6页(P2641-2646)【关键词】排列熵;多尺度排列熵;滚动轴承;故障诊断;支持向量机【作者】郑近德;程军圣;杨宇【作者单位】湖南大学汽车车身先进设计制造国家重点实验室,长沙,410082;湖南大学汽车车身先进设计制造国家重点实验室,长沙,410082;湖南大学汽车车身先进设计制造国家重点实验室,长沙,410082【正文语种】中文【中图分类】TH133;TP306.30 引言时频分析方法由于能够提供振动信号时域和频域局部信息而在故障诊断领域得到了广泛应用,是目前故障诊断的重要手段[1-2]。

bp的练习题

bp的练习题BP(Back Propagation)是一种常用的神经网络算法,用于训练多层前馈神经网络。

在这篇文章中,我们将探讨BP的练习题,帮助读者更好地理解和应用这一算法。

一、问题描述假设我们要使用BP算法来训练一个两层的前馈神经网络,输入层有2个神经元,隐藏层有3个神经元,输出层有1个神经元。

网络的激活函数为Sigmoid函数。

我们现在给定以下的数据集,其中每个样本有2个特征和1个标签:样本1:(1, 0),标签:1样本2:(0, 1),标签:1样本3:(0, 0),标签:0样本4:(1, 1),标签:0请问,使用BP算法训练这个神经网络,经过若干轮迭代后,网络的权重参数将如何变化?二、解答过程为了解答这个问题,我们需要逐步进行BP算法的计算和迭代。

1. 初始化权重参数在BP算法中,我们需要随机初始化连接权重和阈值。

假设我们初始化的权重参数如下:输入层到隐藏层的连接权重:w1 = 0.15, w2 = 0.25, w3 = 0.35w4 = 0.4, w5 = 0.5, w6 = 0.6隐藏层到输出层的连接权重:w7 = 0.4, w8 = 0.45, w9 = 0.5隐藏层的阈值:b1 = 0.5, b2 = 0.55, b3 = 0.6输出层的阈值:b4 = 0.452. 前向传播通过前向传播计算,我们可以得到各个神经元的输出值。

隐藏层第一个神经元的输入:net1 = w1 * x1 + w4 * x2 + b1隐藏层第一个神经元的输出:out1 = sigmoid(net1)隐藏层第二个神经元的输入:net2 = w2 * x1 + w5 * x2 + b2隐藏层第二个神经元的输出:out2 = sigmoid(net2)隐藏层第三个神经元的输入:net3 = w3 * x1 + w6 * x2 + b3隐藏层第三个神经元的输出:out3 = sigmoid(net3)输出层的输入:net4 = w7 * out1 + w8 * out2 + w9 * out3 + b4输出层的输出:out4 = sigmoid(net4)3. 反向传播通过反向传播,我们可以计算出误差,然后根据误差更新权重参数。

基于BP神经网络算法的函数逼近

基于BP神经网络算法的函数逼近神经网络是一种基于生物神经元工作原理构建的计算模型,可以通过学习和调整权重来逼近非线性函数。

其中,基于误差反向传播算法(BP)的神经网络是最常见和广泛应用的一种,其能够通过反向传播来调整网络的权重,从而实现对函数的近似。

BP神经网络的算法包括了前馈和反向传播两个过程。

前馈过程是指输入信号从输入层经过隐藏层传递到输出层的过程,反向传播过程是指将网络输出与实际值进行比较,并根据误差来调整网络权重的过程。

在函数逼近问题中,我们通常将训练集中的输入值作为网络的输入,将对应的目标值作为网络的输出。

然后通过反复调整网络的权重,使得网络的输出逼近目标值。

首先,我们需要设计一个合适的神经网络结构。

对于函数逼近问题,通常使用的是多层前馈神经网络,其中包括了输入层、隐藏层和输出层。

隐藏层的神经元个数和层数可以根据具体问题进行调整,一般情况下,通过试验和调整来确定最优结构。

然后,我们需要确定误差函数。

对于函数逼近问题,最常用的误差函数是均方误差(Mean Squared Error)。

均方误差是输出值与目标值之间差值的平方和的均值。

接下来,我们进行前馈过程,将输入值通过网络传递到输出层,并计算出网络的输出值。

然后,我们计算出网络的输出与目标值之间的误差,并根据误差来调整网络的权重。

反向传播的过程中,我们使用梯度下降法来最小化误差函数,不断地调整权重以优化网络的性能。

最后,我们通过不断训练网络来达到函数逼近的目标。

训练过程中,我们将训练集中的所有样本都输入到网络中,并根据误差调整网络的权重。

通过反复训练,网络逐渐优化,输出值逼近目标值。

需要注意的是,在进行函数逼近时,我们需要将训练集和测试集分开。

训练集用于训练网络,测试集用于评估网络的性能。

如果训练集和测试集中的样本有重叠,网络可能会出现过拟合现象,导致在测试集上的性能下降。

在神经网络的函数逼近中,还有一些注意事项。

首先是选择适当的激活函数,激活函数能够在网络中引入非线性,使网络能够逼近任意函数。

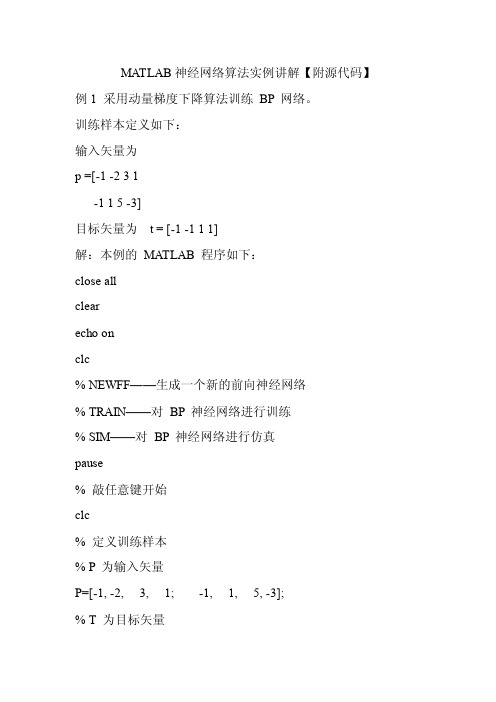

MATLAB神经网络算法实例讲解【附源代码】

MA TLAB神经网络算法实例讲解【附源代码】例1 采用动量梯度下降算法训练BP 网络。

训练样本定义如下:输入矢量为p =[-1 -2 3 1-1 1 5 -3]目标矢量为t = [-1 -1 1 1]解:本例的MA TLAB 程序如下:close allclearecho onclc% NEWFF——生成一个新的前向神经网络% TRAIN——对BP 神经网络进行训练% SIM——对BP 神经网络进行仿真pause% 敲任意键开始clc% 定义训练样本% P 为输入矢量P=[-1, -2, 3, 1; -1, 1, 5, -3];% T 为目标矢量T=[-1, -1, 1, 1];pause;clc% 创建一个新的前向神经网络net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值inputW eights=net.IW{1,1}inputbias=net.b{1}% 当前网络层权值和阈值layerW eights=net.LW{2,1}layerbias=net.b{2}pauseclc% 设置训练参数net.trainParam.show = 50;net.trainParam.lr = 0.05;net.trainParam.mc = 0.9;net.trainParam.epochs = 1000;net.trainParam.goal = 1e-3;pauseclc% 调用TRAINGDM 算法训练BP 网络[net,tr]=train(net,P,T);pauseclc% 对BP 网络进行仿真A = sim(net,P)% 计算仿真误差E = T - AMSE=mse(E)pauseclcecho off例2 采用贝叶斯正则化算法提高BP 网络的推广能力。

7基于神经网络的模式识别实验要求

实验七基于神经网络的模式识别实验一、实验目的理解BP神经网络和离散Hopfield神经网络的结构和原理,掌握反向传播学习算法对神经元的训练过程,了解反向传播公式。

通过构建BP网络和离散Hopfield 网络模式识别实例,熟悉前馈网络和反馈网络的原理及结构。

二、实验原理BP学习算法是通过反向学习过程使误差最小,其算法过程从输出节点开始,反向地向第一隐含层(即最接近输入层的隐含层)传播由总误差引起的权值修正。

BP 网络不仅含有输入节点和输出节点,而且含有一层或多层隐(层)节点。

输入信号先向前传递到隐节点,经过作用后,再把隐节点的输出信息传递到输出节点,最后给出输出结果。

离散Hopfield神经网络的联想记忆过程分为学习和联想两个阶段。

在给定样本的条件下,按照Hebb学习规则调整连接权值,使得存储的样本成为网络的稳定状态,这就是学习阶段。

联想是指在连接权值不变的情况下,输入部分不全或者受了干扰的信息,最终网络输出某个稳定状态。

三、实验条件Matlab 7.X 的神经网络工具箱:在Matlab 7.X 的命令窗口输入nntool,然后在键盘上输入Enter键,即可打开神经网络工具箱。

四、实验内容1.针对教材P243例8.1,设计一个BP网络结构模型(63-6-9),并以教材图8.5 为训练样本数据,图8.6为测试数据。

(1)运行train_data.m和test_data.m文件,然后从Matlab工作空间导入(Import)训练样本数据(inputdata10,outputdata10)和测试数据(testinputdata,testoutputdata),其次新建一个神经网络(New Network),选择参数如下表1,给出BP神经网络结构图。

表1 BP网络结构模型的各项参数设置Network Name(神经网络名称)nn10_1Network Type(神经网络类型)Feed-forward backprop(前馈反向传播)Input ranges(输入信息范围)来自训练样本的输入数据(inputdata10)Training function(训练函数)TRAINGD(梯度下降BP算法)Performance function(性能函数)MSE(均方误差)Number of layers(神经网络层数)2Layer1(第1层)的Number ofneurons (神经元个数)6Layer1(第1层)的TransferFunction (传递函数)LOGSIG(S型函数)Layer2(第2层)的Number ofneurons (神经元个数)9Layer2(第2层)的TransferFunction (传递函数)LOGSIG(S型函数)(2)输入训练样本数据(inputdata10,outputdata10),随机初始化连接权(Initialize Weights),然后进行训练(Train),训练参数设置如表2所示,并观察训练目标值变化曲线图,最后把BP神经网络训练成功后(即误差不再变化后)的误差值填入表3。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

训练样本和测试样本

一,训练样本和测试样本

训练样本的目的是数学模型的参数,经过训练之后,可以认为你的模型系统确立了下来。

建立的模型有多好,和真实事件的差距大不大,既可以认为是测试样本的目的。

一般训练样本和测试样本相互独立,使用不同的数据。

网上有人说测试样本集和验证样本集不一样,测试样本集数据主要用于模型可靠程度的检验,验证样本集的样本数据要在同样条件下,再另外采集一些数据用来对模型的准确性进行验证。

(?)

有人采用交叉验证,交叉验证指的的训练样本集、测试样本集、验证样本集、三中数据集都组合在一起,数据的划分采用交叉取样的方法。

二,如何选择训练集和测试集

未完待续

网上有人说经常采用的是m-folder cross validation的方法,把样本分成m份,轮流把其中一份作为测试集。

至于m取多少看样本数量而定,样本充足的话m=10,另外m=3也是经常被使用的

至于验证集,通常并不需要。

三,Clementine中如何选择节点将数据分为训练集和测试集

前期整理好数据后,选择partition节点连接入数据流,在里面可以设置训练集、测试集及验证集,若要平分在测试集及训练集栏位内填上50%。

另外可以设置标签及数值;下面的设置是对数据表中增加标志字段(区分测试集和训练集)的数值进行选择,第一个表示使用1、2、3这样的数值来表示,第二个是使用“1_training“等来表示,第三个是使用”training“等来表示,可以通过第二个图中的value来观察。

此外下面还有设置随机种子的选项。

ps:在分割完不同集合后,可以右击partition节点,选择cache中enable,这样随机分割完的数据就可以暂时存在缓存中,这样不同时候进行不同建模的时候就不会因为样本不同而使结构受影响!(第一次执行后会在节点的右上方出现绿色的文件件的标签)

四,如何建立测试模型

如果训练好模型后,把所得的模型节点从右上方拖到数据流的测试集后,建立连接后,再加个分析节点或一些结果的节点就可以了。