ceph故障恢复

ceph_health_status 指标 -回复

ceph_health_status 指标-回复Ceph是一个分布式存储系统,被广泛用于构建高可靠性、高性能的存储解决方案。

Ceph提供了大规模数据存储和访问的能力,并能适应各种应用和工作负载。

在Ceph中,ceph_health_status指标被用于表示Ceph 集群的健康状态。

本文将深入探讨ceph_health_status指标,并逐步回答一些与该指标相关的问题。

第一步:理解ceph_health_status指标及其意义Ceph健康状态(ceph_health_status)是一个用于描述Ceph集群整体健康状况的指标。

它通过检查集群的各个组件和子系统,并分析其状态来确定集群的健康性。

健康状态的不同取值代表了集群不同的健康程度,通常包括健康(HEALTH_OK)、警告(HEALTH_WARN)和错误(HEALTH_ERR)三种状态。

对于一个复杂的分布式系统来说,监控其健康状态非常重要。

健康状态能够提供集群的整体运行状态,允许管理员及时发现并解决问题,确保系统的正常运行。

第二步:指标的获取和展示在Ceph中,可以使用命令行工具(如ceph status)或通过RESTful API 来获取ceph_health_status指标的值。

这些工具将显示集群的整体健康状态并提供详细的健康报告。

管理员可以根据这些信息来诊断和解决问题。

第三步:指标的含义和可能的取值ceph_health_status指标的取值可以是HEALTH_OK、HEALTH_WARN 或HEALTH_ERR。

每个取值代表了集群不同的健康程度和可能的问题:1. HEALTH_OK:表示集群正常运行,各个组件和子系统都处于健康状态。

这是理想的状态,表明集群没有明显的问题。

2. HEALTH_WARN:表示集群存在潜在的问题,但集群依然可以正常运行。

这些问题可能包括未达到预期的数据复制级别、故障磁盘或网络问题。

虽然集群仍然可用,但管理员应该尽快解决这些问题,以避免进一步的故障。

ceph分布式存储恢复数据原理

Ceph分布式存储系统是一个高可靠、高性能的分布式存储解决方案,它采用了对象存储的方式来存储和管理数据。

当数据在Ceph集群中的某个节点发生故障时,Ceph会通过数据恢复机制来保证数据的可靠性和完整性。

以下是Ceph分布式存储恢复数据的原理:1.数据冗余:Ceph通过数据冗余机制来实现数据的容错能力。

每个对象都会被分成多个数据块,并将这些数据块复制到不同的存储节点上。

默认情况下,Ceph会将每个对象的三个副本分布在不同的存储节点上,以保证数据的可靠性。

2.数据恢复:当一个存储节点发生故障时,Ceph会自动检测到节点的故障,并将故障节点上的数据块复制到其他节点上的副本进行恢复。

Ceph使用智能的恢复算法,可以根据网络状况和存储节点的负载情况来选择最佳的恢复路径,以加快数据恢复的速度。

3.故障域:Ceph支持将存储节点分组为故障域,例如机架、机柜或数据中心。

当一个故障域发生故障时,Ceph会优先选择其他故障域中的存储节点来进行数据恢复,以提高数据的可用性和可靠性。

4.副本替换:当一个存储节点永久性地离线或被删除时,Ceph会自动创建新的副本来替换故障的节点。

Ceph会根据预定义的规则来选择替代节点,并将故障节点上的数据块复制到替代节点上,以保证数据的完整性和可靠性。

5.数据平衡:Ceph会自动监测集群中各个存储节点的负载情况,并在需要时将数据块迁移或复制到其他节点上,以实现数据的均衡分布。

这样可以提高存储系统的性能和可扩展性。

总之,Ceph通过数据冗余、智能的恢复算法、故障域管理、副本替换和数据平衡等机制来保证数据的可靠性和完整性。

当一个存储节点发生故障时,Ceph会自动进行数据恢复,将故障节点上的数据复制到其他节点上,以保证数据的可用性和持久性。

ceph运维手册

ceph运维手册一、介绍Ceph是一个分布式存储系统,具有高性能、高可靠性和高可扩展性的特点。

在大规模数据存储领域,Ceph已经成为一种非常流行的解决方案。

本文将深入探讨Ceph的运维手册,包括必要的配置、监控、故障处理等方面。

二、环境准备在进行Ceph的运维工作之前,需要准备以下环境:1.硬件设备:Ceph要求至少3台服务器,并且每台服务器要有足够的计算和存储资源。

2.操作系统:推荐使用Linux操作系统,例如CentOS、Ubuntu等。

3.网络配置:确保服务器之间能够正常通信,并且网络带宽要足够支持存储系统的数据传输。

三、Ceph集群部署3.1 安装Ceph软件包在每台服务器上执行以下命令,安装Ceph软件包:$ sudo apt-get install ceph -y3.2 配置Ceph集群1.创建一个用于存储Ceph配置文件的目录:$ sudo mkdir /etc/ceph2.在主节点上执行以下命令,生成配置文件:$ sudo ceph-deploy new <主节点>3.编辑生成的Ceph配置文件,添加以下内容:osd pool default size = 2osd crush chooseleaf type = 14.在主节点上执行以下命令,部署配置文件到所有节点:$ sudo ceph-deploy --overwrite-conf config push <所有节点>3.3 启动Ceph集群在主节点上执行以下命令,启动Ceph集群:$ sudo ceph-deploy mon create-initial四、Ceph监控Ceph提供了一套监控工具,可以用于实时监控集群的状态和性能。

4.1 安装和配置监控工具在主节点上执行以下命令,安装和配置监控工具:$ sudo apt-get install ceph-mgr ceph-mgr-dashboard -y4.2 访问监控面板通过浏览器访问主节点的IP地址和监控面板端口,例如:主节点IP地址>:7000。

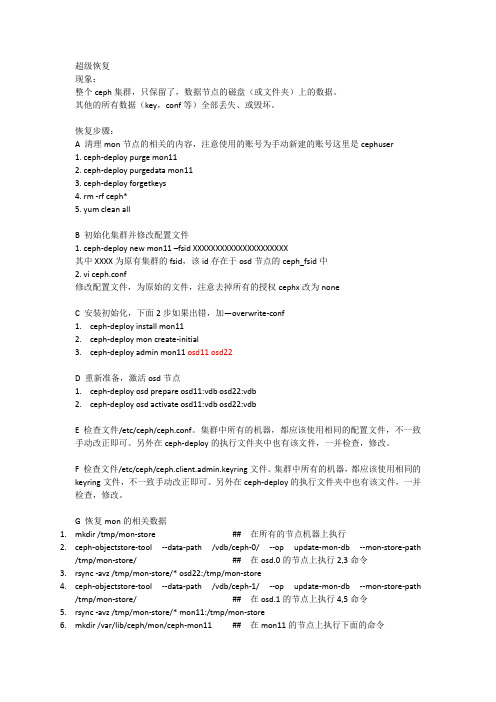

ceph终级数据恢复文档

超级恢复现象:整个ceph集群,只保留了,数据节点的磁盘(或文件夹)上的数据。

其他的所有数据(key,conf等)全部丢失、或毁坏。

恢复步骤:A 清理mon节点的相关的内容,注意使用的账号为手动新建的账号这里是cephuser1. ceph-deploy purge mon112. ceph-deploy purgedata mon113. ceph-deploy forgetkeys4. rm -rf ceph*5. yum clean allB 初始化集群并修改配置文件1. ceph-deploy new mon11 –fsid XXXXXXXXXXXXXXXXXXXXX其中XXXX为原有集群的fsid,该id存在于osd节点的ceph_fsid中2. vi ceph.conf修改配置文件,为原始的文件,注意去掉所有的授权cephx改为noneC 安装初始化,下面2步如果出错,加—overwrite-conf1.ceph-deploy install mon112.ceph-deploy mon create-initial3.ceph-deploy admin mon11 osd11 osd22D 重新准备,激活osd节点1.ceph-deploy osd prepare osd11:vdb osd22:vdb2.ceph-deploy osd activate osd11:vdb osd22:vdbE 检查文件/etc/ceph/ceph.conf。

集群中所有的机器,都应该使用相同的配置文件,不一致手动改正即可。

另外在ceph-deploy的执行文件夹中也有该文件,一并检查,修改。

F 检查文件/etc/ceph/ceph.client.admin.keyring文件。

集群中所有的机器,都应该使用相同的keyring文件,不一致手动改正即可。

另外在ceph-deploy的执行文件夹中也有该文件,一并检查,修改。

ceph运维手册

ceph运维手册Ceph是一个开源的分布式存储系统,可提供高可用性、高性能和可扩展性。

为了能够有效地管理和维护Ceph集群,需要掌握一些运维技巧和最佳实践。

以下是关于Ceph运维的一些指南和手册。

1. 部署和安装Ceph集群:- 选择合适的硬件配置:了解Ceph的硬件要求,并根据需要选择适当的硬件,如存储设备、网络等。

- 安装Ceph软件包:根据操作系统版本和类型,选择合适的Ceph 软件包,并按照官方文档进行安装。

- 配置Ceph集群:了解Ceph的配置文件和参数,按照需求进行相应的配置,如存储池、存储节点等。

2. 监控和调优Ceph集群:- 使用Ceph管理工具:了解Ceph提供的管理工具,如cephadm、ceph-deploy等,可以方便地监控和管理Ceph集群。

- 监控集群状态:配置和使用监控工具,如Ceph Dashboard、Prometheus等,定期监控集群的状态和性能指标,及时发现和解决问题。

- 调优集群性能:根据实际需求和负载特点,调整Ceph集群的参数和配置,例如调整副本数、调整缓存策略等,以提高性能和可靠性。

3. 故障排除和故障恢复:- 日志分析和排查:仔细分析Ceph集群的日志,找出可能的问题根源,并采取相应的解决措施。

- 数据恢复和修复:当发生数据丢失或损坏时,根据Ceph提供的工具和方法,进行数据恢复和修复操作,确保数据的完整性和可用性。

- 灾难恢复:制定和实施灾难恢复计划,确保在灾难事件发生时,能够快速恢复Ceph集群的运行。

4. 安全和权限管理:- 访问控制和身份认证:了解Ceph的访问控制机制,配置和管理用户、角色和权限,确保集群的安全性。

- 数据加密和传输安全:配置和使用Ceph的加密功能,保护数据的隐私和机密性,确保数据在传输过程中的安全性。

5. 升级和扩展Ceph集群:- 升级Ceph软件:根据官方文档,了解和执行Ceph软件的升级过程,确保平滑升级,并避免数据丢失或故障。

ceph分布式存储多副本恢复机制

ceph分布式存储多副本恢复机制摘要:1.Ceph 分布式存储的概念与基本原理2.Ceph 多副本恢复机制的工作原理3.多副本恢复机制在数据修复、数据安全、运维等方面的优势4.与其他分布式存储技术的对比5.Ceph 多副本恢复机制的实际应用案例正文:Ceph 是一种开源的分布式存储系统,其基本原理是通过数据去重、数据分布和数据副本来实现大规模数据的存储和处理。

在Ceph 中,数据被分为多个数据块,并通过数据副本技术来保证数据的可靠性和安全性。

当某个数据块发生故障时,Ceph 的多副本恢复机制可以自动进行数据修复,从而保证数据的完整性和可用性。

Ceph 的多副本恢复机制的工作原理是,当检测到某个数据块发生故障时,Ceph 会自动在其他副本上复制一份数据块,并使用CRUSH 算法来计算出需要复制的数据块数量和位置。

CRUSH 算法是一种基于数据块副本数量和位置的算法,可以自动计算出最优的数据块复制策略,从而实现数据的恢复和修复。

多副本恢复机制在数据修复、数据安全、运维等方面具有显著的优势。

首先,通过数据副本技术,可以实现数据的容错和恢复,从而保证数据的可靠性和安全性。

其次,多副本恢复机制可以降低运维的复杂度和成本,因为只需要对故障的数据块进行修复,而不需要对整个系统进行维护。

与其他分布式存储技术相比,Ceph 的多副本恢复机制具有更高的灵活性和可扩展性。

例如,与传统的RAID 技术相比,Ceph 可以实现数据的去重和分布,从而提高存储效率和性能。

此外,Ceph 还可以与现有的存储系统进行集成,从而实现数据的统一管理和保护。

Ceph 多副本恢复机制在实际应用中具有广泛的应用前景。

例如,在云计算和大数据领域,Ceph 可以提供高性能、高可靠性和高安全性的数据存储和处理服务,从而满足用户的需求。

此外,Ceph 还可以应用于虚拟化和容器化领域,实现数据的统一管理和保护,从而提高运维的效率和质量。

ceph 故障域作用

ceph 故障域作用Ceph是一种开源的分布式存储系统,具有高可靠性和可扩展性。

在Ceph中,故障域是一种重要的概念,它对数据的可靠性和性能有着重要的影响。

故障域可以理解为一组物理或逻辑上相关联的节点或设备,当其中的一个节点或设备发生故障时,其他节点或设备可以继续提供服务。

在Ceph中,故障域常常用于实现数据的冗余和故障恢复。

故障域可以用于实现数据的冗余。

通过将数据复制到不同的故障域中,可以提高数据的可靠性。

当一个故障域中的节点或设备发生故障时,其他故障域中的节点或设备仍然可以提供数据服务,保证数据的可用性。

Ceph支持多种冗余策略,例如副本和EC(Erasure Coding),可以根据实际需求选择合适的故障域配置。

故障域还可以影响数据的性能。

在Ceph中,数据通常会被分布在不同的故障域中,这样可以实现数据的负载均衡。

当用户请求数据时,Ceph可以根据数据的位置和负载情况选择最近的故障域来提供服务,提高数据的访问速度。

此外,Ceph还支持故障域感知的数据迁移和重平衡,可以根据故障域的状态和负载情况动态调整数据的分布,提高系统的整体性能。

除了数据的冗余和性能,故障域还对系统的可维护性和可扩展性有着重要的影响。

通过将节点或设备组织成故障域,可以方便地进行故障诊断和维护。

当一个故障域中的节点或设备发生故障时,可以很容易地定位和修复故障,而不会影响其他故障域中的节点和设备。

此外,通过增加故障域,可以方便地扩展系统的容量和性能。

当需要增加存储空间或处理能力时,可以简单地添加新的故障域,而不需要对整个系统进行改动。

然而,故障域的设计和配置也需要考虑一些问题。

首先,故障域之间的距离和网络连接对数据的同步和传输有影响。

如果故障域之间的距离过远或网络连接不稳定,可能会导致数据同步延迟或传输失败。

因此,在设计故障域时需要考虑节点之间的距离和网络连接的可靠性,以保证数据的一致性和可用性。

故障域的大小和数量也需要合理配置。

ceph三副本冗余机制

ceph三副本冗余机制Ceph三副本冗余机制概述Ceph是一种分布式存储解决方案,它采用了一种称为三副本冗余机制的数据冗余策略。

这种机制可以提供高可用性和容错能力,确保数据的持久性和一致性。

本文将详细介绍Ceph三副本冗余机制的工作原理和优点。

1. 三副本冗余机制的工作原理Ceph采用三副本冗余机制来保证数据的可靠性和可用性。

当数据写入Ceph存储集群时,它会被分成多个对象,并通过CRUSH算法将这些对象分布到不同的存储节点上。

每个对象会被复制成三个副本,分别存储在不同的节点上。

2. 数据的冗余和一致性三副本冗余机制确保了数据的冗余性,即每个对象有三个副本。

这样一来,即使发生硬件故障或节点失效,仍然可以通过其他副本恢复数据。

此外,Ceph还采用了一致性哈希算法,确保数据在多个副本之间的一致性。

当节点失效或副本需要迁移时,CRUSH算法将自动重新分配副本,以保持数据的一致性。

3. 故障恢复和数据平衡Ceph的三副本冗余机制还能够实现自动的故障恢复和数据平衡。

当某个节点失效或副本损坏时,Ceph会自动将副本从其他节点复制到新的节点上,以恢复数据的可用性。

同时,Ceph还能够根据存储集群的负载情况,自动调整对象的分布,实现数据的平衡,提高整体性能。

4. 优点Ceph三副本冗余机制具有以下几个优点:- 高可用性:即使发生硬件故障或节点失效,数据仍然可用。

- 容错能力:即使多个节点同时失效,数据仍然可以通过其他副本恢复。

- 数据一致性:通过一致性哈希算法,保证多个副本之间的数据一致性。

- 故障恢复:自动将副本从其他节点复制到新的节点上,实现故障恢复。

- 数据平衡:根据集群负载情况,自动调整对象的分布,实现数据的平衡。

5. 注意事项在使用Ceph三副本冗余机制时,需要注意以下几点:- 硬件选择:选择可靠的硬件设备,以确保数据的可靠性和性能。

- 网络带宽:保证存储集群的网络带宽足够,以避免数据传输的延迟和拥塞。

ceph分布式存储多副本恢复机制

ceph分布式存储多副本恢复机制摘要:1.Ceph 分布式存储概述2.多副本恢复机制的原理3.多副本恢复机制的实现过程4.多副本恢复机制的优点与不足5.总结正文:1.Ceph 分布式存储概述Ceph 是一种开源的分布式存储系统,旨在提供优秀的性能、可靠性和可扩展性。

它采用去中心化的设计,通过多个节点的存储数据副本来实现数据冗余和故障恢复。

Ceph 支持多种存储类型,如对象存储、块存储和文件存储等,能够满足不同应用场景的需求。

2.多副本恢复机制的原理Ceph 的分布式存储系统通过数据副本来实现数据的可靠性和容错能力。

在Ceph 中,每个数据节点(OSD)都可以存储多个数据副本,这些副本分布在不同的节点上。

当某个节点发生故障时,Ceph 会根据副本的数量和分布情况,自动选择一个或多个副本来恢复数据。

这种机制被称为多副本恢复机制。

3.多副本恢复机制的实现过程多副本恢复机制的实现过程主要包括以下几个步骤:(1)数据写入:当客户端写入数据时,Ceph 会在多个节点上存储数据的副本,以实现数据的冗余。

(2)数据监控:Ceph 会实时监控各个节点的状态,以检测可能的故障。

(3)故障检测:当某个节点发生故障时,Ceph 会立即进行故障检测,并确定需要恢复的数据副本。

(4)数据恢复:Ceph 会根据故障检测的结果,选择一个或多个副本来恢复数据。

恢复过程可能涉及到数据迁移、数据重构等操作。

(5)恢复完成:恢复完成后,Ceph 会将恢复后的数据返回给客户端,确保业务的正常运行。

4.多副本恢复机制的优点与不足多副本恢复机制具有以下优点:(1)较高的数据可靠性:通过多个副本的存储,提高了数据的可靠性和容错能力。

(2)自动故障恢复:当发生硬件故障时,Ceph 能够自动检测并进行恢复。

(3)可扩展性:多副本恢复机制可以灵活地扩展存储容量,以满足业务需求。

然而,多副本恢复机制也存在一些不足:(1)存储空间利用率:多个副本会占用更多的存储空间,可能导致存储空间的浪费。

ceph pgs原理 -回复

ceph pgs原理-回复Ceph(PG)原理Ceph是一个分布式存储系统,旨在提供具有高可靠性和高性能的对象存储、块存储和文件存储。

它的可扩展性以及对故障和硬件故障的自动恢复使其成为数据中心的理想选择。

本文将深入探讨Ceph中PG(Placment Group,即存放组)的原理。

一、Ceph的背景Ceph是为大规模的分布式存储而设计的,其核心原则之一是数据的可扩展性和冗余性。

若干个OSD(对象存储器)被组织成一个集群,每个OSD 都有其自己的存储能力和计算能力。

Ceph的基本单位是PG,且每个PG 都被分布在不同的OSD上。

PG包含了存储对象的内容以及元数据,而OSD则负责存储和服务这些PG。

每个PG由一个叫做PG mapping的映射规则与之相关联,用于帮助Ceph集群进行数据的读写及恢复。

二、PG的概念PG是Ceph中最基本的单位, 即Placment Group的缩写。

PG被设计用来提供数据的冗余性和容错能力。

每个PG包含一个主OSD和一组备用OSD,它们负责存储PG中的对象。

PG数目的多少决定了数据的冗余性,同时也影响着系统的性能和恢复速度。

PG数目越大,Ceph集群的性能越高,但恢复速度也相应减慢。

因此,需要根据实际需求来确定适当的PG数目。

三、PG mapping映射规则每个PG都有一个PG mapping映射规则,该规则决定了PG应该被分配到哪些OSD上。

PG mapping映射规则采用的是哈希函数的方式来决定PG的位置。

PG mapping分为两个部分,一个是PG地址,它定义了PG 在Ceph集群中的位置;另一个是PG状态,它定义了PG所处的当前状态。

1. PG地址PG地址是一个32位的整数,它是通过哈希函数将对象的名称转换成的。

PG地址的范围是从0到2^32-1,也就是0到4294967295。

在一个Ceph 集群中,该范围会被划分为若干个子范围,每个子范围由一组连续的PG 地址组成。

ceph 多站点原理 -回复

ceph 多站点原理-回复Ceph是一个强大的分布式存储系统,具有高可靠性、可扩展性和高性能的特点。

它能够在多个站点之间实现数据的高效复制和故障恢复,从而提供更好的数据可用性和持久性。

本文将详细介绍Ceph多站点原理,并以步骤方式逐一解释。

第一步:理解Ceph多站点的概念Ceph多站点是指在多个地理位置分布的站点之间构建一个分布式存储环境。

每个站点都有自己的Ceph存储集群,包含多个存储节点和监控节点。

这些站点之间通过网络连接,可以进行数据的复制、同步和故障恢复操作。

第二步:构建Ceph多站点集群要实现Ceph多站点,首先需要在每个站点上构建一个独立的Ceph 存储集群。

每个集群都应包含多个存储节点和至少一个监控节点。

存储节点负责存储和处理实际数据,监控节点负责管理所有的Ceph服务,并维护集群的状态和配置信息。

第三步:配置Ceph多站点的网络连接为了实现多站点之间的数据复制和通信,需要配置站点之间的网络连接。

通常,每个站点都会拥有自己的网络子网,但都能够通过公共网络进行通信。

可以使用虚拟专用网络(VPN)或专用连接等方法来确保站点之间的安全、可靠和高速通信。

第四步:设置Ceph多站点复制策略Ceph多站点通过使用复制策略来实现数据的复制和故障恢复。

复制策略定义了在多个站点之间如何复制数据以确保数据的可用性和持久性。

最常用的策略是同步复制和异步复制。

- 同步复制:在同步复制中,数据在写入之前会被复制到其他站点,只有所有站点都确认数据已复制后,写操作才被视为成功。

这样可以确保在任何站点发生故障时,数据仍然可用,但由于需要等待所有站点的确认,写操作可能会有一定的延迟。

- 异步复制:在异步复制中,数据会立即写入本地站点,然后异步地复制到其他站点。

这个过程是非阻塞的,因此写操作的延迟较低,但在故障发生时,可能会丢失部分数据。

第五步:配置Ceph多站点故障恢复为了保证Ceph多站点环境的可靠性和持久性,需要配置故障恢复机制。

ceph分布式存储多副本恢复机制

ceph分布式存储多副本恢复机制(最新版)目录1.Ceph 分布式存储的概念与基本架构2.多副本恢复机制的原理与实现3.多副本恢复机制的优缺点分析4.Ceph 分布式存储在实际应用中的案例与效果正文一、Ceph 分布式存储的概念与基本架构Ceph 是一种开源的分布式存储系统,旨在提供优秀的性能、可靠性和可扩展性。

它采用去中心化的设计理念,将数据分布在多个节点上,从而实现数据的高可靠性和容错能力。

Ceph 的架构主要包括三个部分:Ceph Monitor、Ceph OSD 和 Ceph Metadata。

其中,Ceph Monitor 负责监控整个集群的状态和性能,Ceph OSD 负责存储数据,Ceph Metadata 则负责存储元数据信息。

二、多副本恢复机制的原理与实现Ceph 分布式存储的多副本恢复机制是一种基于数据副本的数据保护和恢复策略。

在 Ceph 中,每个数据副本都会存储在不同的节点上,以确保数据的可靠性和容错能力。

当某个节点上的数据副本发生故障时,Ceph 会自动在其他节点上的副本中查找并恢复数据。

这种机制可以有效地保障数据的安全性和可靠性。

具体来说,Ceph 的多副本恢复机制主要包括以下几个步骤:1.数据写入:当客户端写入数据时,Ceph 会根据数据副本的数量和分布式策略,将数据同时写入多个节点上的副本。

2.数据读取:当客户端读取数据时,Ceph 会根据数据副本的分布式策略,从多个节点上的副本中读取数据,并根据副本的权重和可靠性等因素进行数据合并和校验。

3.数据恢复:当某个节点上的数据副本发生故障时,Ceph 会自动在其他节点上的副本中查找并恢复数据。

这种恢复机制可以有效地保障数据的安全性和可靠性。

三、多副本恢复机制的优缺点分析Ceph 分布式存储的多副本恢复机制具有以下几个优点:1.高可靠性:通过多个节点上的数据副本,可以有效地保障数据的安全性和可靠性。

2.高性能:通过数据分片和并行处理等技术,可以实现高并发和高性能的数据读写操作。

ceph osd的常用命令 -回复

ceph osd的常用命令-回复Ceph是一种开源的分布式存储系统,它提供了可靠的存储和高性能的对象、块和文件系统服务。

OSD(Object Storage Daemon)是Ceph中存储对象数据的核心组件之一。

在本文中,将介绍一些常用的Ceph OSD 命令,帮助您管理和维护Ceph集群。

1. `ceph osd ls` - 列出当前Ceph集群中所有的OSD编号。

这个命令可以帮助您了解集群中可用的物理存储设备数量。

2. `ceph osd tree` - 显示Ceph集群中的OSD树形结构。

这个命令将以树形结构展示监视器、存储池、主机和OSD之间的关系。

通过查看这个结构,您可以了解集群的拓扑结构,并对其进行优化。

3. `ceph osd df` - 查看当前OSD的存储使用情况。

这个命令将显示每个OSD的存储容量、已使用容量、可用容量和利用率等信息。

通过定期运行此命令,您可以监视存储资源的使用情况,以便及时做出调整。

4. `ceph osd dump` - 提供有关每个OSD状态的详细信息,包括权重、状态、健康状况和存储位置等。

这个命令将显示OSD的全局唯一ID,以及与之相关联的设备和主机等信息。

5. `ceph osd status` - 显示Ceph集群中每个OSD的状态信息。

这个命令报告当前OSD的运行情况,包括接收和发送的数据量、容错域和延迟等指标。

通过监视OSD状态,您可以尽早发现并处理任何潜在的问题。

6. `ceph osd out {osd-id}` - 从Ceph集群中排除指定的OSD。

使用此命令可以暂时关闭一个OSD,并将其从集群中移除。

这对于维护、升级和故障排除非常有用。

7. `ceph osd in {osd-id}` - 将排除的OSD重新加入Ceph集群中。

使用此命令可以恢复先前排除的OSD,使其重新参与数据存储和分发。

8. `ceph tell osd.{osd-id} injectargs '{option}'` - 向指定的OSD进程注入特定的运行时参数。

ceph swift原理 -回复

ceph swift原理-回复Ceph Swift原理是一种针对分布式文件存储系统的解决方案。

它结合了Ceph分布式存储系统和OpenStack Swift对象存储系统的优点,提供高可靠性、高扩展性和高性能的存储服务。

一、Ceph简介Ceph是一种旨在提供可靠的、多租户的对象和块存储以及文件系统服务的开源分布式存储系统。

它以容忍故障的设计方式构建,具有自动数据复制和恢复的能力。

Ceph存储系统由多个存储集群组成,每个集群由多个存储节点组成,每个节点又包含多个硬盘。

Ceph存储集群使用CRUSH算法确定数据的存储位置。

CRUSH算法将对象的ID映射到存储节点和介质上的位置,以实现负载均衡和故障恢复。

Ceph存储集群提供强一致性、高可靠性的存储服务,对于海量存储有着优异的性能和可扩展性。

二、Swift简介OpenStack Swift是一种分布式对象存储系统,旨在为云存储提供可扩展和高可靠性的存储服务。

Swift的设计原则是通过通过物理位置和命名空间的虚拟化将数据分散存储在多个存储节点上,从而实现高可用性和数据冗余。

Swift具有非常灵活的架构,它通过Ring实现数据的分发和复制。

Ring 是一个存储设备的逻辑描述,它包括设备的ID、位置和权重等信息。

Swift 使用Ring将对象分发到多个存储节点上,并在节点之间进行数据复制以实现数据冗余和容错能力。

Swift系统提供了强大的对象元数据管理、访问控制和数据访问接口等功能。

三、Ceph Swift原理Ceph Swift结合了Ceph和Swift的优点,提供了更强大和灵活的存储服务。

Ceph Swift基于Ceph存储系统构建,它使用Rados Gateway作为其对象存储接口。

Rados Gateway是Ceph存储系统的一部分,它充当了Ceph存储系统和任何符合Swift API标准的应用程序之间的中间层。

Ceph Swift支持Swift API的所有功能,并具有更强大的性能和可靠性。

ceph 容灾恢复流程

Ceph 容灾恢复流程主要包括以下步骤:

1. 感知集群状态:首先,Ceph通过某种方式及时感知集群故障,确定集群中节点的状态,判定哪些节点离开了集群,为确定哪些数据的副本受到故障影响提供权威依据。

2. 确定受故障影响的数据:Ceph根据新的集群状态计算和判定副本缺失的数据。

3. 恢复受影响的数据:对于受故障影响的数据,需要进行恢复操作。

恢复的具体方法可能会因故障类型和具体情况而有所不同,但通常包括从备份中恢复数据、重新复制数据、修复损坏的节点等步骤。

在恢复数据之前,可能需要进行一些准备工作,例如备份Ceph集群的数据,以便在恢复过程中使用。

此外,如果系统盘根目录损坏无法读取,也可以考虑采用CentOS通过光盘启动救援数据的方式进行备份。

总的来说,Ceph容灾恢复流程需要根据具体的故障情况和需求进行灵活调整和实施。

同时,为了确保数据的可靠性和安全性,建议在集群运行期间定期进行备份和监控,及时发现和处理潜在的问题。

ceph recovery流程

ceph recovery流程cephrecovery流程回收过程分析张建伟一、恢复开始时间recovery是对已知的副本不一致或者副本数不足进行修复。

以pg为单位进行操作。

大概有三个启动时机:1、peering完成后2、scrub完成后3.读写时,如果操作的oid处于缺失状态,则首先恢复对象。

osd维护了名为recovery_wq线程池,用于执行所有pg的recovery。

二、窥视后恢复peering在某个pg由degrade状态重新恢复到active状态后启动。

通过对比pg的每个osd的pglog,得到osd缺少的oid。

primary缺少的的放到pg_log对象的missing结构中。

replica缺少的放到peer_missing结构中。

recovery就是修复missing和peer_missing中的oid。

恢复流程图:waitlocalrecoveryreservationwaitremoterecoveryreservation将本pg放入recovery_wq线程池队列副本修复和主修复的流程图:replicatedpg::recover_u副本:为每个副本遍历对等点u缺失调用中缺失的oid准备uo对象o副本o检查后,它用replicatedbackend::run_uuRecovery_uuoOpreplicatedBackend::send_uoPush将数据发送到ReplicateOSD::do_uoRecoveryReplicatedPG::start_uoRecovery_uoOpsRecover_o副本修复副本,对应于对等的丢失恢复o主副本:修复主副本,对应于丢失。

你需要回填吗?ybackfillreplicatedpg::recover_u主节点遍历missing中主节点缺失的oid,并调用recover_uMissing进行一些检查后,将其填充到ReplicateBackend的pulls数组中。