GoogLeNet深度学习模型的Caffe复现模型

efficientnetv2基本原理

在撰写一篇有效的文章之前,我们需要首先对提供的主题——efficientnetv2基本原理进行全面评估。

efficientnetv2是一种用于图像分类和识别的深度学习模型,是Google Brain团队在efficientnetv1的基础上进行了改进和优化的版本。

我们需要深入了解efficientnetv2的原理、其在深度学习领域的作用以及其带来的创新之处。

在进行文章撰写时,首先要简要介绍efficientnetv2的背景和相关概念。

efficientnetv2是一种基于神经网络的模型,其设计初衷是在保持网络结构轻量化和高效率的提高图像分类和识别的准确性。

文章需要以从简到繁的方式,逐步介绍efficientnetv2的基本原理,包括网络结构、层级关系、模型优化和参数调整等。

这样的方法可以帮助读者更深入地了解efficientnetv2的内部工作机制。

在文章的主体部分,我们需要多次提及efficientnetv2的基本原理,并详细探讨其在图像分类和识别方面的应用。

可以从卷积神经网络的发展历程、深度学习算法的改进、模型训练和优化等方面展开讨论,以便读者能够全面理解efficientnetv2的工作原理及其在实际应用中的优势。

在文章的总结和回顾性内容中,我们需要对efficientnetv2的基本原理进行总结,并指出其在图像分类和识别领域的重要意义。

可以共享个人的观点和理解,例如对efficientnetv2模型在未来发展中的潜力及其对深度学习领域的影响。

文章的撰写应遵循知识文章格式,使用普通文本格式,注重内容的逻辑清晰和层次分明。

文章字数应在3000字以上,不需要出现字数统计。

通过以上步骤的深入分析和评估,我们可以撰写一篇高质量、深度和广度兼具的文章,帮助读者深入理解efficientnetv2的基本原理及其在深度学习领域的作用。

efficientnetv2是一种深度学习模型,是Google Brain团队根据efficientnetv1进行改进和优化后推出的版本。

caffe的运用

caffe的运用Caffe是一种流行的深度学习框架,广泛应用于计算机视觉、自然语言处理等领域。

它以C++编写,支持CUDA加速,具有高效、灵活和可扩展的特点。

Caffe的运用主要体现在以下几个方面:1. 模型定义与训练:Caffe使用Protobuf格式定义模型结构,包括网络层、损失函数、优化器等。

用户可以根据自己的需求自定义网络结构,或者使用已有的经典网络模型如AlexNet、VGGNet等。

通过调用Caffe提供的接口,可以进行模型的训练和优化。

2. 数据预处理:在深度学习中,对输入数据进行预处理是非常重要的。

Caffe提供了一系列的数据处理工具,包括图像的缩放、裁剪、翻转等操作,以及数据增强技术如随机旋转、随机扰动等。

这些工具可以帮助用户快速、高效地准备训练数据。

3. 模型部署与推理:Caffe支持将训练好的模型部署到不同的硬件平台上进行推理。

用户可以选择将模型转换为Caffe模型文件,然后使用Caffe提供的工具进行推理;也可以将模型转换为其他框架支持的格式,如TensorFlow、PyTorch等。

Caffe还提供了Caffe2Go工具,可以将模型部署到移动设备上进行推理。

4. 模型调试与优化:Caffe提供了丰富的调试工具,可以帮助用户分析模型的性能和效果。

用户可以使用Caffe自带的可视化工具,如caffe-draw和caffe-vis,对网络结构进行可视化;还可以使用caffe-time工具,对模型的前向传播和反向传播进行性能分析。

此外,Caffe还提供了一些优化技术,如网络剪枝、量化等,可以帮助用户减少模型的计算量和内存占用。

5. 社区支持与资源共享:Caffe拥有庞大的用户社区,用户可以在社区中分享自己的经验和代码,获取帮助和反馈。

Caffe官方网站上提供了丰富的教程、示例代码和文档,用户可以根据自己的需要进行学习和参考。

总的来说,Caffe的运用在深度学习领域具有重要的意义。

【paddle学习】图像分类

【paddle学习】图像分类深度学习模型中的卷积神经⽹络(Convolution Neural Network, CNN)近年来在图像领域取得了惊⼈的成绩,CNN直接利⽤图像像素信息作为输⼊,最⼤程度上保留了输⼊图像的所有信息,通过卷积操作进⾏特征的提取和⾼层抽象,模型输出直接是图像识别的结果。

这种基于”输⼊-输出”直接端到端的学习⽅法取得了⾮常好的效果,得到了⼴泛的应⽤。

卷积层(convolution layer): 执⾏卷积操作提取底层到⾼层的特征,发掘出图⽚局部关联性质和空间不变性质。

池化层(pooling layer): 执⾏降采样操作。

通过取卷积输出特征图中局部区块的最⼤值(max-pooling)或者均值(avg-pooling)。

降采样也是图像处理中常见的⼀种操作,可以过滤掉⼀些不重要的⾼频信息。

全连接层(fully-connected layer,或者fc layer): 输⼊层到隐藏层的神经元是全部连接的。

⾮线性变化: 卷积层、全连接层后⾯⼀般都会接⾮线性变化层(探测层),例如Sigmoid、Tanh、ReLu等来增强⽹络的表达能⼒,在CNN⾥最常使⽤的为ReLu激活函数。

ReLu激活函数:f(x)=max(0,x)Dropout [] : 在模型训练阶段随机让⼀些隐层节点不⼯作(权重置为0),提⾼⽹络的泛化能⼒,⼀定程度上防⽌过拟合。

另外,在训练过程中由于每层参数不断更新,会导致下⼀次输⼊分布发⽣变化,这样导致训练过程需要精⼼设计超参数。

如2015年Sergey Ioffe和Christian Szegedy提出了Batch Normalization (BN)算法 [] 中,每个batch对⽹络中的每⼀层特征都做归⼀化,使得每层分布相对稳定。

BN算法不仅起到⼀定的正则作⽤,⽽且弱化了⼀些超参数的设计。

经过实验证明,BN算法加速了模型收敛过程,在后来较深的模型中被⼴泛使⽤。

【总结】GoogLeNet详解

【总结】GoogLeNet详解接下来简单聊聊GoogLeNet的⼀些创新点:1. NetWork In NetWork和1x1卷积顾名思义,1x1卷积就是卷积核⼤⼩为1。

第⼀反应就是:给特征响应图的每个值都乘了同⼀个系数。

如果是⼀通道输⼊,⼀通道输出的情况下确实如此,但是对于多通道输⼊,多通道输出的情况就不同了。

如下图所⽰: 图:1x1 卷积⽰意图图中画出的是⼀组m通道的特征响应图通过1x1卷积得到n通道的新的n通道的特征响应⽰意图。

我们关注特征图上某⼀位置的像素,或者说是同⼀位置的⼀组m个像素,经过1x1卷积后再对应位置会得到⼀组新的n个像素。

所以如果只看特征图上指定位置的像素的话,其实就是⼀个全连接层,我们⽤xi表⽰第i个输⼊通道上指定位置的像素值,xj'表⽰第j个输出通道对应位置的像素值,则公式表⽰如下: xj' = w j1x1 + w j2x2 + ... + w jm x m + b j = w j x T + b j其中x=(x1,x2,...,xm)是把所有对应位置的像素看作是⼀个向量,进⼀步考虑所有输出通道对应位置像素的向量: x' = [w1 w2 ... w n]*x T + b因为卷积核是对每位置像素进⾏同样的操作,所以1x1卷积相当于对所有的输⼊特征响应图做了⼀次线性组合,然后输出新的⼀组特征响应图。

特别是如果m>n的情况下,通过训练之后相当于降维,这样再接新的卷积层就只需要在更少的n个通道上做卷积,节省了计算资源。

NIN论⽂⾥还提出了另外⼀种被⼴泛应⽤的⽅法叫做全局平均池化(Global Average Pooling),就是对最后⼀层卷积的响应图,每个通道求整个响应图的均值,这个就是全局池化。

然后再接⼀层全连接,因为全局池化后的指相当于⼀像素,所以最后的全连接其实就成了⼀个加权相加的操作。

这种结构⽐起直接的全连接更直观,并且泛化性能更好,成功运⽤到GoogLeNet当中。

efficientnet解读 -回复

efficientnet解读-回复什么是EfficientNet?EfficientNet是一种高效的卷积神经网络(Convolutional Neural Network, CNN)架构,由Google研究团队在2019年提出。

它通过优化网络的深度、宽度和分辨率,达到了在图像分类任务上,比目前其他SOTA(State-of-the-Art)的模型具有更高的精度和更好的效能。

EfficientNet的创新点在于使用了一种称为Compound Scaling的方法,该方法为网络的不同维度(深度、宽度和分辨率)选择了合适的比例,从而使网络在三个方面都能够提供良好的性能。

这意味着EfficientNet不仅提升了模型的准确性,同时还减少了可训练参数的数量,使得模型更加高效。

EfficientNet的核心思想是通过在网络的不同层次上相对比例地缩放深度、宽度和分辨率,从而平衡网络的规模和性能。

具体地说,EfficientNet利用了一个复合缩放系数phi(ϕ),它控制了网络的总体缩放比例。

该phi 参数是通过在一定范围内进行搜索和验证,确定出最佳值的。

在EfficientNet的工作中,研究人员通过在Imagenet上进行大规模的实验评估,找到了一个最佳的复合缩放系数phi=1.2。

在EfficientNet的网络结构中,首先进行的是深度方向的缩放。

通过复制某个输入模型(例如ResNet)的某个重复模块,即可扩展EfficientNet的深度。

而深度可以同时扩展子层的数量和整体的网络深度。

然后,进行的是宽度方向的缩放,即扩展通道/特征维度的数量。

为了平衡不同层级的性能,EfficientNet限制了扩展的范围。

这样,即使在更高分辨率的层级中,EfficientNet也能保证较高的计算效率。

最后,进行的是分辨率方向的缩放,即调整图像输入的分辨率。

通过在训练过程中逐渐增加分辨率,EfficientNet能够提高网络对更高分辨率图像的适应能力。

caffe的运用

caffe的运用Caffe的运用Caffe是一个流行的深度学习框架,被广泛应用于图像分类、目标检测和语义分割等领域。

它以C++编写,提供了Python和MATLAB接口,具有高效、灵活和易用的特点。

本文将介绍Caffe 的运用,从数据准备、网络定义到模型训练和推理等方面进行详细阐述。

数据准备是使用Caffe的第一步。

Caffe接受LMDB和LevelDB两种格式的数据作为输入。

LMDB是一种高效的键值对数据库,用于存储图像和标签数据。

LevelDB是Google开发的一种轻量级键值对数据库,也可用于存储图像和标签数据。

在数据准备阶段,需要将图像数据转换为LMDB或LevelDB格式,并生成相应的标签文件。

接下来,需要定义网络结构。

Caffe使用一种名为“网络描述文件”的配置文件来定义网络结构。

该文件以Protobuf格式编写,包含了网络的层次结构、参数设置和数据输入等信息。

Caffe提供了丰富的层类型,如卷积层、池化层和全连接层,可以根据不同任务需求灵活选择。

通过网络描述文件,可以构建出具有多个层的深度神经网络。

模型训练是Caffe的核心部分。

在进行模型训练之前,需要对网络进行初始化,并设置相应的超参数,如学习率、优化器和正则化等。

Caffe支持多种优化器,包括SGD、Adam和RMSprop等,可以根据不同任务的特点选择最合适的优化器。

在模型训练过程中,Caffe会根据定义的网络结构和超参数,逐步更新网络参数,以减小损失函数的值。

模型训练完成后,可以进行模型的推理。

在推理阶段,可以使用训练好的模型对新的数据进行分类或检测。

Caffe提供了相应的Python接口,可以方便地加载模型,并通过前向传播得到预测结果。

此外,Caffe还支持将模型转换为C++代码,以实现更高效的推理过程。

除了基本功能外,Caffe还提供了一些扩展功能,如模型压缩和模型部署等。

模型压缩可以通过减少模型参数的数量和精度来降低模型的存储和计算开销。

caffe转onnx模型代码

一、概述在深度学习领域,模型转换是一个非常重要且常见的问题。

在实际的应用中,我们常常需要在不同的评台或框架之间进行模型的转换,以便在不同的环境下使用这些模型。

而目前,caffe和onnx都是非常流行的深度学习框架,将caffe模型转换为onnx模型成为了一个非常常见的需求。

二、caffe模型转onnx模型的常见问题1. 兼容性问题:由于caffe和onnx的设计理念和实现方式有所不同,因此在进行模型转换时,往往会面临一些兼容性的问题,例如不支持的层类型、参数不兼容等等。

2. 性能问题:由于caffe和onnx在模型表示和计算方式上有所不同,因此进行模型转换往往会导致性能的损失,导致转换后的模型在推理和训练时表现不佳。

三、caffe模型转onnx模型的解决方案1. 使用已有的工具:目前已经有一些开源的工具可以用来进行caffe 模型到onnx模型的转换,例如onnx-caffe2的工具包。

这些工具在很大程度上简化了模型转换的过程,可以帮助用户避免一些常见的问题。

2. 手动调整:对于一些复杂的模型结构或者对性能要求较高的模型,使用工具去进行模型转换可能会导致一些问题。

此时,我们可以选择手动调整模型,对不兼容的层进行重新实现,以保证转换后的模型能够正确地被onnx框架所使用。

四、caffe模型转onnx模型的具体步骤1. 安装依赖库:在进行模型转换之前,首先需要安装一些必要的依赖库,例如caffe、onnx等。

2. 导出caffe模型:使用caffe框架提供的工具,将已经训练好的caffe模型导出为一个可以被外部调用的中间表示文件。

3. 转换模型:使用onnx-caffe2或其他类似的工具,对导出的中间表示文件进行转换,生成对应的onnx模型文件。

4. 验证模型:使用onnx框架提供的工具,对转换后的模型进行验证,确保模型的正确性和性能。

五、结论在深度学习领域,模型转换是一个非常重要的问题。

本文介绍了将caffe模型转换为onnx模型的一些常见问题和解决方法,并给出了具体的转换步骤。

基于深度学习的图像分类模型

基于深度学习的图像分类模型深度学习是人工智能领域中的一个重要分支,其强大的图像分类能力使之成为许多计算机视觉任务的首选方法。

基于深度学习的图像分类模型能够根据输入的图像数据自动学习特征,并将其分为不同的类别。

本文将详细介绍基于深度学习的图像分类模型的原理、发展历程以及常用的模型架构。

1. 深度学习的图像分类模型原理基于深度学习的图像分类模型的核心原理是使用深层神经网络从图像数据中学习特征表示和分类决策。

这些模型通常包含卷积神经网络(CNN)和全连接神经网络(FCN)两个主要组成部分。

卷积神经网络通过一系列的卷积层、池化层和激活函数层构建,用于提取输入图像中的局部特征。

卷积层通过滤波器的卷积操作将原始图像转化为特征图,池化层则对特征图进行降采样,保留主要特征。

激活函数层则为模型添加非线性能力,增强学习的表达能力。

全连接神经网络仅在最后几层使用,负责将卷积网络提取的特征进行分类。

全连接层通过权重矩阵将特征映射到不同的类别,最终输出模型对输入图像的分类结果。

2. 基于深度学习的图像分类模型的发展历程基于深度学习的图像分类模型的发展可以追溯到2012年的ImageNet竞赛中,当时Hinton等人提出了AlexNet模型,成功地将深度学习应用于图像识别任务,并取得了优异的成绩。

随后,深度学习模型在图像分类领域取得了长足的进步。

在此之后,出现了一系列的深度学习模型,如VGGNet、GoogLeNet、ResNet 等。

这些模型通过增加网络的深度、宽度和复杂性来提高模型的表示能力,进一步提升图像分类的准确性。

同时,一些创新的组件如残差连接、多尺度卷积等也被提出,有效地解决了深层网络训练的困难。

3. 常用的基于深度学习的图像分类模型目前,许多基于深度学习的图像分类模型被广泛使用。

以下是几个常用的模型:- AlexNet:作为深度学习在图像分类任务中的先驱,AlexNet在ImageNet竞赛中取得了显著的成绩。

深度学习方法用于遥感图像处理的研究进展

深度学习方法用于遥感图像处理的研究进展罗仙仙;曾蔚;陈小瑜;张东水;庄世芳【摘要】深度学习是当前机器学习与人工智能研究热点,深度学习方法用于遥感图像处理取得快速发展.首先简要介绍现有遥感数据源及其非监督与监督分类方法.在总结深度学习典型方法及其最新演化模型基础上,分析了深度信念网络、卷积神经网络、自动编码器在遥感图像处理中的国内外研究现状.针对当前应用现状与存在问题,指出今后研究方向:一方面要适应智能化遥感图像处理的发展趋势,加强算法理论研究,尤其人机协同工作、典型方法应用与修正、新模型拓展与应用;另一方面针对遥感大数据的应用需求,应加强遥感数据集建设、构建行业统一遥感大数据监测平台.【期刊名称】《泉州师范学院学报》【年(卷),期】2017(035)006【总页数】7页(P35-41)【关键词】遥感;深度学习;图像处理【作者】罗仙仙;曾蔚;陈小瑜;张东水;庄世芳【作者单位】泉州师范学院数学与计算机科学学院,福建泉州 362000;福建省大数据管理新技术与知识工程重点实验室,福建泉州 362000;智能计算与信息处理福建省高等学校重点实验,福建泉州 362000;泉州师范学院数学与计算机科学学院,福建泉州 362000;福建省大数据管理新技术与知识工程重点实验室,福建泉州362000;智能计算与信息处理福建省高等学校重点实验,福建泉州 362000;泉州师范学院资源与环境科学学院,福建泉州 362000;湖南科技大学资源环境与安全工程学院,湖南湘潭 411201;泉州师范学院数学与计算机科学学院,福建泉州362000;福建省大数据管理新技术与知识工程重点实验室,福建泉州 362000;智能计算与信息处理福建省高等学校重点实验,福建泉州 362000【正文语种】中文【中图分类】TP39121世纪以来,以对地观测技术为核心的空间地球信息科技已经成为一个国家科技水平、经济实力和国家安全保障能力的综合体现[1].遥感,作为采集地球数据及其变化信息的重要技术手段,被广泛应用于全球气候变化研究、航空航天、军事指挥、环境监测和国土资源调查等领域,遥感数据源向高光谱分辨率、高空间分辨率和高时间分辨率的方向发展.遥感技术的快速发展与广泛应用,使得遥感大数据逐步成为研究自然环境与社会经济的重要技术途径,已成为智慧城市发展的重要支撑.目前,影响遥感图像处理结果主要有两个影响因素:一是遥感数据源的质量,二是遥感图像处理方法,包括遥感图像预处理与分类方法.综合提取多种遥感影像特征并提高计算机自动解译精度,是遥感图像自动解译的一个发展方向.深度学习是人工智能研究的一个重要分支,由加拿大多伦多大学Hinton教授于2006年提出的一种有效的特征提取及分类方法[2],被应用到语音识别、图像识别、计算机视觉等领域,并取得了良好的效果.Google、Facebook、微软、百度、腾讯以及其他创业公司都在使用深度学习做到顶级的智能识别实用精度.深度学习方法能够自动进行特征提取,越来越多应用遥感领域.本文总结深度学习方法用于遥感图像处理中的研究成果,指出当前研究存在问题,展望今后发展趋势,以期为拓展深度学习在不同行业遥感应用提供参考.1 遥感数据源及其分类方法1.1 遥感数据源遥感影像记录的是观测区在某一时间内地物的电磁波辐射,其亮度值反映了地物的辐射光谱能量的特征,其纹理特征反映了地物的光谱结构特征[3].目前,常用的遥感卫星影像数据有Landsat、Spot、NOAA、Quickbird、IKONOS、ASTER等.不同类型的遥感影像数据具有不同的空间分辨率、光谱分辨率、辐射分辨率、时间分辨率,其信息提取精度也就不同,从而适应于不同的研究尺度及不同的研究领域.如NOAA气象卫星,其空间分辨率低,但实时性强,因而常用于洲级或全球范围尺度的土地利用/土地覆盖、海洋的遥感变化研究;而Landsat卫星系列影像,其最低空间分辨率为30 m,在中尺度的资源环境、生态效益等的综合调查及监测,具有明显的经济与技术优势.1.2 遥感图像分类方法1.2.1 非监督分类非监督分类又称边学习边分类,它的前提是假定遥感影像上同类物体在同样条件下具有相同的光谱信息特征.非监督分类不必对影像地物获取先验知识,仅依靠影像上不同种类的地物光谱信息特征进行特征提取,再统计特征的差别来达到分类的目的,最后对已分出的各个类别的实际属性进行确认[4].非监督分类方法有:K均值、ISODATA方法等.研究者对非监督分类产生的类别较难控制,并不一定是研究者想要的,因而还必须与想要的类别匹配,结果不一定理想.1.2.2 监督分类监督分类是一种常用的精度较高的统计判别分类,又称为训练区分类.监督分类是先选择具有代表性的典型训练区,用从训练区中获取的地物样本的光谱特征来选择特征参数、确定判别函数或判别规则,从而把影像中的各个像元划归到各个给定类的分类方法[3-4].这种方法要求对所要分类的地区必须要有先验的类别知识,即先要从所研究地区中选择出所有要区分的各类地物的训练区,用于建立判别函数.常用的监督分类方法有:K近邻法、马氏距离分类、最大似然法等方法.2 深度学习典型方法、演化模型与经典遥感数据集深度学习通常是指超过三层的神经网络模型[5],模仿人类大脑的层次结构,是一组尝试通过使用体系结构的多个非线性变换组成模型中数据的高级抽象机器学习算法.在深度学习结构中,每个中间层的输出可以视为原始输入数据的表征.每一层使用由前一层生成的表征作为输入,并生成新的表征作为输出,然后传到更高的层.底层的输入是原始数据,最后一层的输出为最终的低维特征.这一特征学习的过程是从低层到高层特征自动的提取.深度学习典型方法包括限制玻尔兹曼机(restricted Boltzmann machines,RBM)、深度信念网络(deep belief network,DBN),卷积神经网络(convolution neural network,CNN)和自动编码器(auto encoder,AE)等[6].新型深度学习方法包括递归神经网络(recurrent neural network,RNN)及其变种模型长短时记忆模型(long short-term memory,LSTM)、生成对抗网络(generative adversarial nets,GAN)等.RNN中具有反馈机制,每层神经元的输入包括前一层神经元的输出、自身在上一时间点的输出,使得RNN对序列数据具有较好处理能力,被广泛应用于语音识别、自然语言处理等.GAN由Goodfellow等提出.GAN同时训练两个相互对抗的模型,一个是生成模型G,另一个是判别模型D.生成模型G负责生成服从真实样本分布的假样本,判别模型D负责对输入的样本进行二分类判别,即尽量正确识别出是真实样本还是假样本.GAN的训练过程是一个极大极小博弈问题,在训练过程中,固定其中一个模型,更新另一个模型的权重,双方不断优化,从而形成对抗关系,直至达成纳什均衡.目前,GAN主要应用于图像、语音及语言生成.2.1 深度信念网络限制玻尔兹曼机是一种典型神经网络,具有两层结构,一层为可视层,另一层为隐层.可视层是数据输入层,隐层是特征提取层.层间全连接,层内无连接[7].预训练采用无监督贪心逐层方式来获取生成性权值,使用梯度下降的方法训练避免局部最小的情况,如对比散度、连续对比散度算法等.深度信念网络通过多层的RBM和一层分类器组成.其训练过程分为两步.第一步是对DBN进行网络预训练,即自下而上对每层的RBM进行无监督学习.第二步是网络微调,即自上向下的监督学习.此时使用的训练集是有标签的训练集,训练算法是标准的误差反向传播算法.对无监督学习阶段得到的特征信息进行总结、归纳、取舍,最后达到一个较好的识别水平.2.2 卷积神经网络卷积神经网络是当前应用较为广泛一种,其低隐含层由卷积层、池化层(降采样层)交替组成,高层通常由全连接层作为分类器使用[8].卷积层进行线性操作,负责特征提取,通常为组合卷积,其参数包括卷积核数量、核尺寸、步长、填充方式等;卷积层后加一个激活函数,通常是非线性激活函数,如Sigmoid、Tanh、ReLU,进行非线性操作,减轻梯度消失问题;池化层在于减少特征图尺寸规模,增强特征对于旋转和变形的鲁棒性;全连接层全负责推断与分类.卷积神经网络不断改进与优化,演化模型分别是Caffenet、AlexNet、VGG、GoogleNet、ResNet、ResNeXt,CNN进化网络比较见表1.从表可知,采取技术不断优化,网络深度扩大,Top-5错误率在减少.表1 CNN进化网络比较Tab.1 Comparison among evolutionary networks of CNN进化网络网络深度卷积层数全连接层数Top 5错误率/%ImageNetILSVRC竞赛时间主要技术AlexNet85316.40 2012年第一ReLU、最大池化、随机失活、局部响应归一化VGG191637.30 2014年第二核分解、随机失活GoogleNet(V1)222116.70 2014年第一InceptionV1:取消全连接层、2个辅助分类器InceptionV2:批归一化InceptionV3:非对称卷积、取消浅层的辅助分类器ResNet15215113.57 2015年批归一化近年来,以卷积神经网络为基础拓展的网络不断改进与优化.2014年,Ross等提出的区域卷积神经网络(region-based CNN,R-CNN)[9]用于图像检测,主要使用选择性搜索方法生成大量候选区域,便于后续高维特征形成,但训练时间长.空间金字塔网络(spatial pyramid pooling networks,SPP-Net)对此进行2大改进,一是引入空间金字塔池化层,二是放宽输入图像尺寸限制,所有区域共享卷积计算.但SPP-Net需要存储大量特征和复杂的多阶段训练.在SPP-Net基础上,2015年Ross等提出了Fast R-CNN[10],引入2个新技术,一是感兴趣区域池化层,二是多任务损失函数.同年,Ren等提出Faster R-CNN[11],用区域提议网络(regional proposal network)取代选择性搜索方法,解决了计算区域提议时间开销大的瓶颈问题.2015年,Long等提出的用于图像语义分割的全卷积神经网络(fully convolutional neural networks,FCN)[12],该网络所有层都是卷积层,并采取反卷积/逆卷积/去卷积(Deconvolution)操作,将低分辨率图片进行上采样,生成同分辨率的分割图片.2016年,Dai等提出区域全卷积神经网络(R-FCN)[13].2.3 自动编码器自动编码器由编码器和解码器两部分组成.编码器将输入数据映射到特征空间,解码器将特征映射回数据空间,完成对输入数据的重建.自动编码器演化模型包括栈式自动编码器、去噪自动编码器、稀疏自动编码器、收缩自动编码器等.2.4 典型遥感数据集当前,深度学习用于遥感图像处理中的典型数据集见表1,多数为高光谱遥感数据集,最常用的为印第安纳西北部的印第安纳农场数据集和意大利帕维亚大学数据集.在数据集中,多数在美国,我国数据集建设尚处空白.同时,由于深度学习方法训练与测试需要大量样本数据,实际应用微乎其微.表2 典型遥感数据集Tab.2 Typical data sets of remote sensing类型波谱范围/μm波段数物体类别数像素大小空间分辨率/m美国印第安纳州印第安纳农场(IndianPines)0.4~2.522416144×14420意大利帕维亚大学(UniversityofPavia)0.43~0.861159610×3403.7美国加州大学默塞德分校(UCMerced)//21256×2560.3美国加州萨利纳斯谷(Salinas)/22019512×2171.3美国佛罗里达州的混合植被图(KSC)0.4~0.2522413512×614183 深度学习在遥感图像处理中的应用现状深度学习能从原始数据自动进行特征学习,通过多层非线性网络逼近复杂分类问题,从海量的大数据中寻找和发现图像目标的内部结构和关系.深度学习应用于遥感图像处理尚处于起步阶段,用于高分辨率遥感与高光谱遥感影像居多,少数用于无人机;应用方法集中在DBN、CNN、SAE.3.1 深度信念网络在遥感图像处理中的应用现状目前深度信念网络应用遥感数据主要有高光谱遥感、合成孔径侧视雷达、高分辨率遥感,但主要是经典数据集,需要进一步拓展不同遥感数据应用、不同行业应用.从网络参数看,最优隐藏层数集中于2~3层,且3层较多.受输入与输出大小影响,各隐藏层的节点数差异较大,幅度在50~500之间,部份研究尚未探讨节点数对分类精度影响;绝大多数学习率是0.01和0.1.从分类结果看,多数分类精度达到90%以上,大大超出常规目视解译、专家检验和多次纠正分类结果.从具体应用层面看,吕启等首次利用深度信念网络应用于极化合成孔径雷达图像(Radarsat-2)分类中,当层数为3、各隐含层节点数为64时,总体分类精度最高,达到77%,好于支持向量机与传统神经网络方法[14].陈雨时等[15]首次利用深度信念网络方法进行高光谱遥感图像特征提取,顶层采取逻辑回归的分类方法,研究提出纯光谱特征、空间特征、谱域-空域特征高光谱数据分类方法,研究提出的DBN-LR分类精度好于SVM方法.刘大伟等利用深度信念网络对美国佐治亚州亚特兰市北部一住宅小区的高分辨率影像(Resurs Dk1) 的6种地类进行分类研究[16].邓磊等利用深度信念网络对美国旧金山地区的NASA/JPL AIRSAR系统C波段极化SAR图像的6种地类进行分类研究,提取极化类、辐射类、空间类和子孔径类特征共267个作为DBN输入,人工均匀选取2×104个像素点作样本,研究表明分类特征增加提高分类精[17].李新国等则利用空间特征进行样本扩充,采用自编码器和主成分分析进行数据降维,利用DBN对高光谱的Salinas和PaviaU两个数据集,提高分类精度.每类地物选取约1 000个像素点,其中2/3样本用于无监督训练,1/3样本用于有监督微调;通过非下采样轮廓波变换提取纹理特征,同时作为DBN的输入,提高高分辨率遥感分类精度.当隐含层数为3,节点数为56时,总体精度与Kappa系数达到最大,分别为81.2%和77.2%[18].高鑫等提出一种基于改进的扩散平滑方法,利用图像的二阶偏导数和梯度共同控制扩散速度,并针对不同区域使用自适应扩散系数对高光谱图像进行去噪,再利用DBN对Indian Pines高光谱数据集进行分类,结果好于未去噪的DBN方法[19].3.2 卷积神经网络在遥感图像处理中的应用现状1989年LeCun等提出了一种用于字符识别的卷积神经网络LeNet-5[20],该网络使用7层神经层,识别对象是MNIST手写字符库,识别结果达到了当时的顶尖水平[21].曲景影等在传统LeNet-5网络结构的基础上,引入ReLU激活函数,提出了基于矩阵乘法的卷积展开技术优化模型(matrix multiple CNN,MMCNN),并应用于高分辨率遥感图像(quick bird)的5类对象识别.同时,探讨学习率、网络层数、各层滤波器数量和大小对分类结果影响.实验表明,学习率为0.01,卷积层和采样层为4,卷积核大小分别是21×21、17×17、卷积核数量6和12时效果最好,总体精度达到91.196%,优于其他方法[22].曹林林等把CNN应用于昆明城区2007年高分辨率遥感图像(quick bird)地表7种类型划分,总体精确达98.21%[23].陈文康把CNN应用于四川省丹棱县内无人机遥感影像农村建筑物识别研究发现,池化层置于归一层前面有利提高建筑物提取精度[24].杜敬先利用最大稳定极值区域对无人机遥感影像进行影像分割得到待识别目标子区,然后采用共7层CNN模型(1层输入层、2层卷积层、2层采样层、1层全连接层、1层输出层)对水体进行识别,识别率达到95.36%[25].王万国等基于Caffee框架实现了Faster R-CNN的多旋翼无人机和直升机巡检图像3类小型电力部件(间隔棒、防震锤、均压坏)识别,准确率达92.7%[26],并探讨了随机失活比例、最大迭代次数、批处理尺寸、非极大值抑制前后区域保留个数对平均准确率均值影响.Liang等结合稀疏表示理论和CNN对Indian Pines和PaviaU两个高光谱数据集进行研究,探讨CNN最优配置结构[27].Scott等利用迁移学习和3种CNN网络(CaffeNet、GoogleNet、ResNet50)对高分遥感数据集进行研究,取得较好研究结果[28].为克服标签样本不足,采用数据扩充技术,主要对遥感原始图像进行水平、垂直镜像,分别对原始图像、镜像图像进行0°,7°,90°,97°,180°,187°,270°,277°等7个方向旋转.Nogueira等采用3种训练策略(全训练、微调、特征提取方法)对6类CNN(Overfeat,AlexNet,CaffNet,GoogleNet,VGG16,PatreoNet)进行3个遥感数据集研究,研究结果表明微调是最优训练策略,并取得这3数据集最好的分类精度[29].在CNN演化模型应用方面,Maggiori等利用全卷积神经网络(4层卷积层、1层去卷积层)对马萨诸塞州的建筑集进行建筑与非建筑2种类型分类,训练数据340 km2、测试数据22.5 km2,从精度与计算时间指标上,均好于传统方法[30].Fu等利用膨胀卷积(atrous convolution)、跳层结构(skip-layer structure)和条件随机场(conditional random fields)改进了全卷积神经网络,并应用于高分辨率遥感,取得较好结果[31].但是,全卷积神经网络没有利用低层卷积层特征,对小而复杂的地物识别时效果不佳.Wang等提出门控分割网络(gated segmentationnetwork,GSN)用于高分辨遥感图像语义分割[32].门控分割网络包含编码器和解码器两个部份.在编码器部份,采用了残差网络(ResNet-101)作为特征提取,在解码器部份,采用了熵控制模块(entropy control module,ECM)作为特征融合. 3.3 自动编码器在遥感图像处理中的应用现状林洲汉较早应用自动编码机进行高光谱数据特征提取,好于传统特征提取方法.并提出了一种基于PCA变换与像素邻域的空间信息占优的提取方法,研究表明,融合光谱特征与空间信息占优的特征所形成的空谱联合分类对分类精度改进是有效的[33].Liu等构建了wacDAE(小波深度自动编码器)对光学遥感图像进行山崩自然灾害分类研究,该网络先进行小波变换和去噪等预处理,包含1个输入层、2层隐藏层和1层输出层,隐藏层节点数固定为100.700张遥感图像作为训练集、500张遥感图像作为测试集.实验结果表明,wacDAE有利于山崩识别[34].阚希等利用层叠去噪自动编码器和风云三号卫星(FY-3A/VIRR)对青藏高原积雪进行识别,把10个光谱通道和4个地理信息要素作为输入层,采用三隐藏层结构(第1、2、3隐藏层单元数分别为80、10、3)和Softmax分类器对云、积雪、无雪地物进行识别,年平均精度达93.96%.研究指出根据青藏高原特征,需要进一步训练季节性的积雪判识的深度网络,以提高整体分类精度[35].张一飞等利用栈式去噪自动编码器和高分一号遥感对湖北省蕲春县土地覆盖8种类型进行分类,在自动编码器的基础上,对训练数据随机置0方式加入噪声,增强无监督训练过程的鲁棒性,实验结果表明,当隐藏层数目为2,每层单元数为180,去噪系数为0.2时分类性能最优[36].Wang等把主成分分析方法和导向滤波融合到自动编码器中,构建了GF-FSAE模型对高光谱数据集PaviaU和Salinas进行测试,实验结果该模型好于传统SAE和SAE-LR方法[37].4 深度学习用于遥感图像处理中存在问题与发展趋势4.1 算法理论的深入研究深度学习网络结构趋势向更深、更宽方向发展,但网络结构选取目前尚没有完善的理论依据.而网络结构是影响遥感图像分类精度的重要参数,如何找到最合适的网络结构?不同隐藏层对遥感图像特征提取的物理意义是什么?如何理解深度学习中各参数变化对分类结果影响?能否找到不同遥感数据源具备一定分类性能的网络结构?如何进一步进行遥感图像多任务问题解决,例如遥感图像描述与智能回答.这是迫切需要回答的问题.4.2 典型方法的应用与修正深度学习中典型方法在遥感领域应用有初步成果,一方面需要利用现有成果进行遥感图像处理规范建设.例如,如何均值处理、归一化、大小调整来进行遥感数据规范.另一方面,也要巩固现有成果进行技术标准化研究.如,使用修正的非线性激活函数ReLU函数解决训练速度慢;采取随机失活dropout技术和权重衰减方法防止过拟合问题;采用随机梯度下降方法解决梯度消失问题.同时,已有的优化模型可否直接应用于不同遥感数据源处理?若是借鉴,如何修改?改哪里?新的参数如何确定?若是重新设计,新网络结构是什么?各种网络如何合作并发挥各网络功能进行智能化处理?为什么这种结构可以用?如何更好人机合作提高遥感图像处理精度与效率?4.3 新模型的拓展与应用典型方法应用仅局限于经典几个数据集研究当中,实际应用成果较少,尚未见文献报道有新的模型应用于遥感图像处理中.如何将区域神经网络应用于遥感图像分类、定位以及相关物体检测,将有利于自然灾害监测、军事指挥等领域;如何利用递归神经网络以及长短时记忆模型的记忆功能,应用于遥感图像动态监测中,如何应用综合网络于不同遥感图像融合并提高识别精度?这些值得遥感领域学者进一步研究,拓展深度学习应用领域与研究方向.4.4 遥感大数据监测平台的建设由于遥感数据源丰富、获取速度快、更新周期短、应用范围广、时效性强,因此,针对某一行业特点,迫切需要建立行业统一遥感大数据监测平台,将海量多源异构遥感大数据集成到该平台中.一方面,加强用于训练与测试的遥感数据集建设,侧重研究遥感数据扩充技术,例如两个对抗深度网络可以产生各式各样的样本,提高训练与测试样本量,提高泛化能力.另一方面,探索小样本甚至零样本学习问题;探索有效的可并行训练算法,减少深度学习训练时间,必定促进全球尺度遥感大数据监测.参考文献:[1] 何国金,王力哲,马艳,等.对地观测大数据处理:挑战与思考[J].科学通报,2015,60:470-478.[2] HINTON G E,SALAKHUTDINOV R R.Reducing the dimensionality of data with neural networks[J].Science,2006,313(5786):504-507.[3] RICHARDS J A,JIA X P.Remote sensing digital image analysis[M].New York:Springer-Verlag,1999:229-239.[4] 梅安新,彭望碌,秦其明,等.遥感导论[M].北京:高等教育出版社,2006:196-201.[5] ETHERN Alpaydin.Introduction to machine learning[M].London:The MIT Press,2014:436-444.[6] 余凯,贾磊,陈雨强,等.深度学习的昨天、今天和明天[J].计算机研究与发展,2013,50(9):1799-1804.[7] 余滨,李绍滋,徐素霞,等.深度学习:开启大数据时代的钥匙[J].工程研究,2014,6(3):233-243.[8] YANN LeCun,YOSHUA Bengio,GEOFFREY Hinton.Deeplearning[J].Nature,2015,521(7663):436-444.[9] GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and PatternRecognition,2014:580-587.[10] GIRSHICK R.R-CNN[C]//IEEE International Conference on Computer Vision,2015:1440-1448.[11] REN S Q,HE K M,GIRSHICK R,et al.Faster R-CNN:towards real-time object detection with region proposal networks[C]//International Conference on Computer Vision,2016.[12] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[J].IEEE Conference on Computer Vision and Pattern Recognition,2015,79(10):1337-1342.[13] DAI J F,LI Y,HE K M,et al.R-FCN:Object detection via region-based fully convolutional networks[C]//International Conference on Computer Vision,2016.[14] 吕启,窦勇,牛新,等.基于DBN模型的遥感图像分类[J].计算机研究与发展,2014,51(9):1911-1918.[15] CHEN Y S,ZHAO X,JIA X P.Spectral-spatial classification of hyperspectral data based on deep belief network[J].IEEE Journal of Selected Topics in Applied Earth Observations and RemoteSensing,2015:1-12.[16] 刘大伟,韩玲,韩晓勇.基于深度学习的高分辨率影像分类研究[J].光学学报,2016,36(4):1-9.[17] 邓磊,付姗姗,张儒侠.深度置信网络在极化SAR图像分类中的应用[J].中。

深度学习中几种常用的模型

深度学习中⼏种常⽤的模型 最近再从事深度学习⽅⾯的⼯作,感觉还有很多东西不是很了解,各种⽹络模型的结构的由来还不是很清晰,在我看来所有的⽹络都是⼀层层的卷积像搭积⽊⼀样打起来的,由于还没实际跑所以还没很深刻感受到⼏种⽹络类型的区别,在此我想梳理⼀下⼏种常见的⽹络结构,加深⼀下理解。

本⽂转⾃此⽂,此⽂条理清晰,总结较为到位。

⽬前常见的⽹络结构:AlexNet、ZF、GoogLeNet、VGG、ResNet等等都可谓曾⼀战成名,它们都具有⾃⾝的特性,它们都提出了创新点。

LeNet是由Yann LeCun完成的具有开拓性的卷积神经⽹络,是⼤量⽹络结构的起点。

⽹络给出了卷积⽹络的基本特性:1.局部感知。

⼈对外界的认知是从局部到全局的,相邻局部的像素联系较为紧密。

每个神经元没必要对全局图像进⾏感知,只需要对局部进⾏感知,然后更⾼层将局部的信息综合起来得到全局的信息。

2.多层卷积。

层数越⾼,学到的特征越全局化。

3.参数共享。

每个卷积都是⼀种提取特征的⽅式,⼤⼤降低了参数的数⽬。

4.多卷积核。

提取多类特征,更为丰富。

5.池化。

降低向量维度,并避免过拟合。

特性1⾃然引出了特性2,特性3⾃然引出了特性4。

⽹络⽤于mnist⼿写体识别任务,⽹络结构⽤查看,常见⽹络:AlexNet2012年,深度学习崛起的元年,Alex Krizhevsky 发表了Alexet,它是⽐LeNet更深更宽的版本,并以显著优势赢得了ImageNet竞赛。

贡献有:1.使⽤RELU作为激活单元。

2.使⽤Dropout选择性忽略单个神经元,避免过拟合。

3.选择最⼤池化,避免平均池化的平均化效果。

AlexNet是⽬前应⽤极为⼴泛的⽹络,结构讲解见:。

⽹络整体上给我们带来了三个结构模块:1、单层卷积的结构:conv-relu-LRN-pool。

前⾯的卷积步长⼤,快速降低featureMap的⼤⼩(较少后⾯的计算量),后⾯深层卷积保持featureMap⼤⼩不变。

Windows下使用caffe进行VGG人脸识别深度神经网络模型的微调训练

Windows下采用caffe进行VGG人脸识别深度神经网络模型的微调训练2016-8-29本文介绍在Windows环境下,采用采用caffe进行VGG人脸识别深度神经网络模型的fine-tune(微调训练)。

运行环境为:windows7+vs2013+matlab2015a+caffe(微软版)。

1.代码和文件准备代码caffe:https:///BVLC/caffe/tree/windows,这个只要采用VS2013编译好就可以用了,配置编译按照网页上的说明进行即可完成。

vgg-face模型:/~vgg/software/vgg_face/。

该网页包括caffe,matconvnet,torch三个版本,下载caffe版本即可。

2.数据准备收集人脸图像数据及对应的标签数据,vgg处理的图片的尺寸是224*224,因此不符合尺寸要求的要对尺寸进行修正。

然后采用caffe中的convert_imageset工具将人脸图像及对应的标签转换为leveldb格式的库文件。

并采用caffe中的compute_image_mean工具计算leveldb库文件中所包含人脸的均值文件face_mean.binaryproto。

将训练数据和评估数据的库文件分别放置在下述位置:J:/caffe-windows/vggface_mycmd/vggface_train_leveldbJ:/caffe-windows/vggface_mycmd/vggface_val_leveldb3.训练网络第三部分就开始训练网络了,首先需要到vggface的官网上下载vggface的caffe模型(官网还包括matconvnet模型,试过finetuning太慢了,torch没有试过),下载好了,就会有两个文件,一个是VGG_FACE_deploy.prototxt,一个是VGG_FACE.caffemodel(深度网络的模型文件)。

Caffe入门

2.

开发工具

① ② ③ Visual Studio 2013 Anaconda2(Python) Matlab 2014b

3.

安装过程 ① 【caffe-Windows】caffe+VS2013+Windows无GPU快速配置教程 ② /zb1165048017/article/details/51355143

Caffe学习路线图

1. 安装Caffe环境,编译Caffe 2. 运行和测试经典实例,如:

① ② MNIST:手写数字识别 CiFar10:10类图片识别

3. 可视化

① 模型、数据和权重、特征图

4. 应用到自己的案例

① 设计、训练自己的模型

5. 改进和设计Caffe

安装Caffe环境

1. 操作系统

深度学习框架Caffe入门

做一个测试

• 手写数籍

– 《深度学习 21天实战Caffe》 – 《深度学习 Caffe经典模型详解与实战》

• 2、电子书籍

– 《Caffe官方教程中译本》 – 《caffe学习笔记1-7-完整版-薛开宇》 – 《神经网络与深度学习》

推荐几个网址

演示

• 安装好的环境 • 数据

– 从数据集及标签文件到数据库

• 模型

– LeNet、CiFar10

• 训练和测试

– Caffe train/Caffe test

• 可视化

GPU支持

• 安装过程

– 【caffe-Windows】caffe+VS2013+Windows+GPU 配置+cifar使用 – /zb1165048017/article/details /51549105

基于深度学习的图像分类算法设计

基于深度学习的图像分类算法设计深度学习(Deep Learning)是一种基于神经网络的机器学习方法,近年来在图像分类中取得了显著的突破。

本文将探讨基于深度学习的图像分类算法设计,讨论其原理和应用,并介绍一些常用的算法模型。

一、基本原理深度学习的图像分类算法基于深度神经网络(Deep Neural Network,DNN)。

它通过分析图像的像素值,并在多个卷积层和全连接层中学习特征,并最终将图像分类为不同的类别。

卷积神经网络(Convolutional Neural Network,CNN)是最常用的深度学习模型之一,它包括卷积层、池化层和全连接层。

在卷积层中,通过使用滤波器(卷积核)来提取图像的局部特征。

池化层则用于减少特征的维度,提高运算速度。

全连接层则将低维特征映射到不同的类别。

二、常用的深度学习算法1. LeNet-5LeNet-5是最早用于手写数字识别的卷积神经网络模型。

它由卷积层、池化层和全连接层组成,其设计思想为多个卷积层交替进行特征提取,再通过全连接层实现分类。

LeNet-5的结构相对简单,适合处理一些简单的图像分类任务。

2. AlexNetAlexNet是2012年ImageNet图像分类比赛的冠军算法,它是第一个成功使用深度神经网络模型的图像分类算法。

AlexNet具有深度和广度,包括8个卷积层和3个全连接层。

它通过使用ReLU激活函数和Dropout技术来减少过拟合,并引入了GPU加速,大大提高了训练的效率。

3. VGGNetVGGNet是2014年ImageNet图像分类比赛的亚军算法,其最大的特点是网络结构更加深层、更加复杂。

VGGNet的网络结构非常规整,由16层或19层卷积层和全连接层组成。

VGGNet通过多次堆叠3x3的小卷积核来代替5x5或7x7的大卷积核,从而大大减少了参数量,同时增加了网络的深度。

4. GoogLeNetGoogLeNet是2014年ImageNet图像分类比赛的冠军算法,它具有非常深的网络结构,但相比于VGGNet,参数量更少。

CNN典型网络结构与常用框架

CNN典型网络结构与常用框架CNN,即卷积神经网络(Convolutional Neural Network),是一种常用的深度学习网络结构,特别适用于图像和视频处理任务。

本文将介绍CNN的典型网络结构和常用框架,并进行详细讨论。

一、典型网络结构:1. LeNet-5:LeNet是最早出现的CNN结构,由Yann Lecun等人提出。

它主要用于手写数字识别任务,包含两个卷积层和三个全连接层。

LeNet-5提出了卷积,池化和全连接等重要概念,并定义了后续CNN的基本框架。

2. AlexNet:AlexNet是由Alex Krizhevsky等人提出的一个重要CNN结构。

它在2024年的ImageNet图像分类大赛上大放异彩,引起了广泛关注。

AlexNet包含8层神经网络,其中有5个卷积层和3个全连接层。

AlexNet增加了模型的深度和宽度,采用了更大的卷积核和更多的参数,使得模型能够更好地提取图像的特征。

3. VGG:VGG是由Karen Simonyan和Andrew Zisserman提出的一种深层CNN结构。

它使用了非常小的卷积核(3x3)和更深的网络结构,共有16-19层卷积层。

VGG网络结构非常简洁清晰,具有良好的可扩展性,并且在图像分类和物体检测等任务上取得了很好的效果。

4. GoogLeNet:GoogLeNet是由Google公司的研究员提出的CNN结构。

它在2024年的ImageNet图像分类比赛上获得了冠军,并引起了广泛关注。

GoogLeNet采用了一个称为Inception Module的模块化结构,可以有效地减少参数数量,提高模型的效率和准确性。

5. ResNet:ResNet是由Kaiming He等人提出的一个深度残差网络结构。

它采用了残差学习的思想,允许网络层直接学习输入残差的映射,解决了深度CNN难以训练的问题。

ResNet在多个图像处理任务上取得了最好的效果,并引发了更深层次的CNN模型的研究热潮。

caffe网络模型各层详解(中文版)

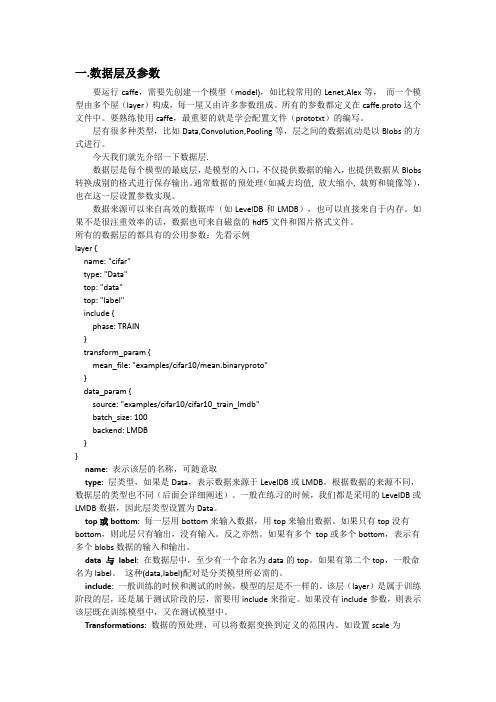

一.数据层及参数要运行caffe,需要先创建一个模型(model),如比较常用的Lenet,Alex等,而一个模型由多个屋(layer)构成,每一屋又由许多参数组成。

所有的参数都定义在caffe.proto这个文件中。

要熟练使用caffe,最重要的就是学会配置文件(prototxt)的编写。

层有很多种类型,比如Data,Convolution,Pooling等,层之间的数据流动是以Blobs的方式进行。

今天我们就先介绍一下数据层.数据层是每个模型的最底层,是模型的入口,不仅提供数据的输入,也提供数据从Blobs 转换成别的格式进行保存输出。

通常数据的预处理(如减去均值, 放大缩小, 裁剪和镜像等),也在这一层设置参数实现。

数据来源可以来自高效的数据库(如LevelDB和LMDB),也可以直接来自于内存。

如果不是很注重效率的话,数据也可来自磁盘的hdf5文件和图片格式文件。

所有的数据层的都具有的公用参数:先看示例layer {name: "cifar"type: "Data"top: "data"top: "label"include {phase: TRAIN}transform_param {mean_file: "examples/cifar10/mean.binaryproto"}data_param {source: "examples/cifar10/cifar10_train_lmdb"batch_size: 100backend: LMDB}}name: 表示该层的名称,可随意取type: 层类型,如果是Data,表示数据来源于LevelDB或LMDB。

根据数据的来源不同,数据层的类型也不同(后面会详细阐述)。

一般在练习的时候,我们都是采用的LevelDB或LMDB数据,因此层类型设置为Data。

基于深度学习的图像识别模型评估与性能分析

基于深度学习的图像识别模型评估与性能分析引言:图像识别是计算机视觉领域的一个重要研究方向。

近年来,深度学习技术的发展带来了图像识别领域的突破性进展。

基于深度学习的图像识别模型在各个应用领域展现出强大的性能和广泛的应用潜力。

然而,如何对这些模型进行评估与性能分析仍然是一个挑战。

本文将重点讨论基于深度学习的图像识别模型评估与性能分析的方法和技术。

一、图像识别模型评估的主要指标图像识别模型的评估与性能分析需要考虑多个指标。

常用的指标包括准确率、召回率、精度、F1值等。

准确率是指模型对样本的正确分类数量与总样本数量的比值,召回率是指模型对正样本的正确分类数量与实际正样本数量的比值,精度是指模型对正样本的正确分类数量与模型分类为正样本的数量的比值,F1值是准确率和召回率的调和平均值。

二、数据集的选择与处理数据集的选择是图像识别模型评估的一个重要环节。

一个好的数据集应具备多样性、广泛性和代表性。

在实际应用中,我们可以从公开数据集中选择适合自己需求的数据集,例如ImageNet、CIFAR等。

此外,数据集的处理也是重要的一步。

对于大规模的数据集,可以采用数据增强的方法,如水平翻转、平移、旋转等来扩充数据量,提高模型的泛化能力。

三、模型结构与训练策略基于深度学习的图像识别模型通常采用卷积神经网络(CNN)结构。

常用的结构包括LeNet、AlexNet、VGG、GoogLeNet、ResNet等。

模型结构的选择应根据任务的复杂程度和数据集的规模来确定。

训练策略也是影响模型性能的重要因素。

常用的训练策略包括批量梯度下降、随机梯度下降、学习率衰减、正则化等。

四、评估与交叉验证为了评估图像识别模型的性能,通常需要将数据集划分为训练集、验证集和测试集。

训练集用于模型的训练,验证集用于模型的调参和性能评估,测试集用于最终的性能评估。

为了减小因数据集划分引入的随机性,通常会进行多次交叉验证。

交叉验证可以准确评估模型的性能,并降低模型对特定数据集的过拟合风险。

caffe 模型格式

caffe 模型格式

Caffe是一个流行的深度学习框架,它使用自己独特的模型格式来表示神经网络模型。

Caffe模型格式通常包括两个主要文件,.prototxt文件和.caffemodel文件。

.prototxt文件是Caffe模型的网络结构描述文件,它以文本形式定义了神经网络的层次结构、层类型、参数设置等信息。

这个文件描述了神经网络的拓扑结构,包括输入层、卷积层、池化层、全连接层等等。

通过.prototxt文件,我们可以清晰地了解神经网络的结构和参数设置。

.caffemodel文件则包含了经过训练的神经网络模型的权重参数,以二进制形式存储。

这个文件保存了神经网络中每个层次的权重和偏置等参数,是模型训练得到的实际参数数值。

通

过.caffemodel文件,我们可以加载已经训练好的模型,并在新的数据上进行推断或者微调。

总的来说,Caffe模型格式通过.prototxt文件描述网络结构,通过.caffemodel文件保存模型参数,这种分离的设计使得用户可以灵活地加载、修改和使用神经网络模型。

同时,Caffe还提供了

丰富的工具和接口,方便用户进行模型的训练、测试和部署。

这种模型格式的设计使得Caffe成为了许多研究人员和工程师的首选深度学习框架之一。

深度学习技术在图像分类中的创新和挑战

深度学习技术在图像分类中的创新和挑战随着科技的不断发展,深度学习技术在图像分类中发挥了巨大的作用。

深度学习是一种机器学习的方法,它模仿人脑的神经网络进行学习与训练。

它通过多层的神经元网络来学习输入数据的表示,并进行分类和预测。

在图像分类中,深度学习技术的应用已经取得了许多创新和突破,但也面临着一些挑战。

首先,深度学习技术在图像分类中的创新主要表现在模型的设计和算法的改进上。

以卷积神经网络(CNN)为例,CNN是一种特别适合处理图像数据的深度学习模型,它采用了卷积层、池化层和全连接层等多个层次的结构,可以有效地利用图像中的空间结构信息,从而提高图像分类的准确率。

近年来,研究者们通过改进CNN的结构、网络连接方式和损失函数等方面,进一步提升了图像分类的性能。

例如,引入了残差结构的ResNet模型、在损失函数中使用辅助分类器的GoogLeNet模型等,都取得了显著的效果。

这些创新有效地提高了图像分类的准确率和鲁棒性。

其次,深度学习技术在图像分类中面临的挑战主要包括训练样本不足、过拟合和计算复杂度等方面。

深度学习模型通常需要大量的标注样本来进行训练,但在实际应用中获取大规模标注样本是一项困难和昂贵的工作。

此外,深度学习模型容易受到过拟合问题的影响,即在训练集上表现良好,但在测试集上表现较差。

为了缓解过拟合问题,研究者们提出了一系列的正则化方法,如dropout、权重衰减等。

然而,有效地解决过拟合问题仍然是一个挑战。

另外,深度学习模型的计算复杂度较高,特别是在训练阶段,需要大量的计算资源和时间。

因此,如何在保持准确率的同时提高计算效率也是一个亟待解决的问题。

此外,深度学习技术在图像分类中还需要解决的问题包括对小目标的识别、数据集的不平衡性和模型的可解释性等。

在真实场景中,图像中的目标可能存在很小的尺度,如细胞、病毒等,这对深度学习模型的识别能力提出了更高的要求。

针对这个问题,研究者们提出了一些针对小目标的目标检测方法,如Faster R-CNN、YOLO等,这些方法在一定程度上解决了小目标识别的问题,但依然存在改进的空间。

caffe标准算子

Caffe提供了一系列的标准算子,这些算子是用于处理输入数据、提取特征、计算损失等任务的基本工具。

以下是一些常见的Caffe标准算子:

数据预处理算子:例如,对输入数据进行缩放、裁剪、翻转等操作。

卷积算子:用于在输入特征图上进行卷积操作,提取特征。

池化算子:例如max_pooling和average_pooling,用于减小特征图的尺寸。

激活函数算子:例如ReLU(Rectified Linear Unit)、sigmoid等,用于非线性化操作。

全连接层算子:用于在特征图上进行全连接操作,实现分类等任务。

损失函数算子:用于计算模型的损失值,用于反向传播时更新模型参数。

softmax算子:用于将模型的输出转换为概率分布。

批归一化算子:用于在训练过程中稳定模型的输出,加速收敛。

这些标准算子都是Caffe框架中预定义的,可以直接在模型中使用。

同时,Caffe也支持用户自定义算子,以满足特定的需求。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Going deeper with convolutionsChristian Szegedy Google Inc.Wei Liu University of North Carolina,Chapel Hill Yangqing Jia Google Inc.Pierre Sermanet Google Inc.Scott Reed University of Michigan Dragomir Anguelov Google Inc.Dumitru Erhan Google Inc.Vincent Vanhoucke Google Inc.Andrew RabinovichGoogle Inc.AbstractWe propose a deep convolutional neural network architecture codenamed Incep-tion,which was responsible for setting the new state of the art for classification and detection in the ImageNet Large-Scale Visual Recognition Challenge 2014(ILSVRC14).The main hallmark of this architecture is the improved utilization of the computing resources inside the network.This was achieved by a carefully crafted design that allows for increasing the depth and width of the network while keeping the computational budget constant.To optimize quality,the architectural decisions were based on the Hebbian principle and the intuition of multi-scale processing.One particular incarnation used in our submission for ILSVRC14is called GoogLeNet,a 22layers deep network,the quality of which is assessed in the context of classification and detection.1IntroductionIn the last three years,mainly due to the advances of deep learning,more concretely convolutional networks [10],the quality of image recognition and object detection has been progressing at a dra-matic pace.One encouraging news is that most of this progress is not just the result of more powerful hardware,larger datasets and bigger models,but mainly a consequence of new ideas,algorithms and improved network architectures.No new data sources were used,for example,by the top entries in the ILSVRC 2014competition besides the classification dataset of the same competition for detec-tion purposes.Our GoogLeNet submission to ILSVRC 2014actually uses 12×fewer parameters than the winning architecture of Krizhevsky et al [9]from two years ago,while being significantly more accurate.The biggest gains in object-detection have not come from the utilization of deep networks alone or bigger models,but from the synergy of deep architectures and classical computer vision,like the R-CNN algorithm by Girshick et al [6].Another notable factor is that with the ongoing traction of mobile and embedded computing,the efficiency of our algorithms –especially their power and memory use –gains importance.It is noteworthy that the considerations leading to the design of the deep architecture presented in this paper included this factor rather than having a sheer fixation on accuracy numbers.For most of the experiments,the models were designed to keep a computational budget of 1.5billion multiply-adds at inference time,so that the they do not end up to be a purely academic curiosity,but could be put to real world use,even on large datasets,at a reasonable cost.a r X i v :1409.4842v 1 [c s .C V ] 17 S e p 2014In this paper,we will focus on an efficient deep neural network architecture for computer vision, codenamed Inception,which derives its name from the Network in network paper by Lin et al[12] in conjunction with the famous“we need to go deeper”internet meme[1].In our case,the word “deep”is used in two different meanings:first of all,in the sense that we introduce a new level of organization in the form of the“Inception module”and also in the more direct sense of increased network depth.In general,one can view the Inception model as a logical culmination of[12] while taking inspiration and guidance from the theoretical work by Arora et al[2].The benefits of the architecture are experimentally verified on the ILSVRC2014classification and detection challenges,on which it significantly outperforms the current state of the art.2Related WorkStarting with LeNet-5[10],convolutional neural networks(CNN)have typically had a standard structure–stacked convolutional layers(optionally followed by contrast normalization and max-pooling)are followed by one or more fully-connected layers.Variants of this basic design are prevalent in the image classification literature and have yielded the best results to-date on MNIST, CIFAR and most notably on the ImageNet classification challenge[9,21].For larger datasets such as Imagenet,the recent trend has been to increase the number of layers[12]and layer size[21,14], while using dropout[7]to address the problem of overfitting.Despite concerns that max-pooling layers result in loss of accurate spatial information,the same convolutional network architecture as[9]has also been successfully employed for localization[9, 14],object detection[6,14,18,5]and human pose estimation[19].Inspired by a neuroscience model of the primate visual cortex,Serre et al.[15]use a series offixed Gaborfilters of different sizes in order to handle multiple scales,similarly to the Inception model.However,contrary to thefixed 2-layer deep model of[15],allfilters in the Inception model are learned.Furthermore,Inception layers are repeated many times,leading to a22-layer deep model in the case of the GoogLeNet model.Network-in-Network is an approach proposed by Lin et al.[12]in order to increase the representa-tional power of neural networks.When applied to convolutional layers,the method could be viewed as additional1×1convolutional layers followed typically by the rectified linear activation[9].This enables it to be easily integrated in the current CNN pipelines.We use this approach heavily in our architecture.However,in our setting,1×1convolutions have dual purpose:most critically,they are used mainly as dimension reduction modules to remove computational bottlenecks,that would otherwise limit the size of our networks.This allows for not just increasing the depth,but also the width of our networks without significant performance penalty.The current leading approach for object detection is the Regions with Convolutional Neural Net-works(R-CNN)proposed by Girshick et al.[6].R-CNN decomposes the overall detection problem into two subproblems:tofirst utilize low-level cues such as color and superpixel consistency for potential object proposals in a category-agnostic fashion,and to then use CNN classifiers to identify object categories at those locations.Such a two stage approach leverages the accuracy of bound-ing box segmentation with low-level cues,as well as the highly powerful classification power of state-of-the-art CNNs.We adopted a similar pipeline in our detection submissions,but have ex-plored enhancements in both stages,such as multi-box[5]prediction for higher object bounding box recall,and ensemble approaches for better categorization of bounding box proposals.3Motivation and High Level ConsiderationsThe most straightforward way of improving the performance of deep neural networks is by increas-ing their size.This includes both increasing the depth–the number of levels–of the network and its width:the number of units at each level.This is as an easy and safe way of training higher quality models,especially given the availability of a large amount of labeled training data.However this simple solution comes with two major drawbacks.Bigger size typically means a larger number of parameters,which makes the enlarged network more prone to overfitting,especially if the number of labeled examples in the training set is limited. This can become a major bottleneck,since the creation of high quality training sets can be tricky(a)Siberian husky(b)Eskimo dogFigure1:Two distinct classes from the1000classes of the ILSVRC2014classification challenge.and expensive,especially if expert human raters are necessary to distinguish betweenfine-grained visual categories like those in ImageNet(even in the1000-class ILSVRC subset)as demonstrated by Figure1.Another drawback of uniformly increased network size is the dramatically increased use of compu-tational resources.For example,in a deep vision network,if two convolutional layers are chained, any uniform increase in the number of theirfilters results in a quadratic increase of computation.If the added capacity is used inefficiently(for example,if most weights end up to be close to zero), then a lot of computation is wasted.Since in practice the computational budget is alwaysfinite,an efficient distribution of computing resources is preferred to an indiscriminate increase of size,even when the main objective is to increase the quality of results.The fundamental way of solving both issues would be by ultimately moving from fully connected to sparsely connected architectures,even inside the convolutions.Besides mimicking biological systems,this would also have the advantage offirmer theoretical underpinnings due to the ground-breaking work of Arora et al.[2].Their main result states that if the probability distribution of the data-set is representable by a large,very sparse deep neural network,then the optimal network topology can be constructed layer by layer by analyzing the correlation statistics of the activations of the last layer and clustering neurons with highly correlated outputs.Although the strict math-ematical proof requires very strong conditions,the fact that this statement resonates with the well known Hebbian principle–neurons thatfire together,wire together–suggests that the underlying idea is applicable even under less strict conditions,in practice.On the downside,todays computing infrastructures are very inefficient when it comes to numerical calculation on non-uniform sparse data structures.Even if the number of arithmetic operations is reduced by100×,the overhead of lookups and cache misses is so dominant that switching to sparse matrices would not pay off.The gap is widened even further by the use of steadily improving, highly tuned,numerical libraries that allow for extremely fast dense matrix multiplication,exploit-ing the minute details of the underlying CPU or GPU hardware[16,9].Also,non-uniform sparse models require more sophisticated engineering and computing infrastructure.Most current vision oriented machine learning systems utilize sparsity in the spatial domain just by the virtue of em-ploying convolutions.However,convolutions are implemented as collections of dense connections to the patches in the earlier layer.ConvNets have traditionally used random and sparse connection tables in the feature dimensions since[11]in order to break the symmetry and improve learning,the trend changed back to full connections with[9]in order to better optimize parallel computing.The uniformity of the structure and a large number offilters and greater batch size allow for utilizing efficient dense computation.This raises the question whether there is any hope for a next,intermediate step:an architecture that makes use of the extra sparsity,even atfilter level,as suggested by the theory,but exploits ourcurrent hardware by utilizing computations on dense matrices.The vast literature on sparse matrix computations(e.g.[3])suggests that clustering sparse matrices into relatively dense submatrices tends to give state of the art practical performance for sparse matrix multiplication.It does not seem far-fetched to think that similar methods would be utilized for the automated construction of non-uniform deep-learning architectures in the near future.The Inception architecture started out as a case study of thefirst author for assessing the hypothetical output of a sophisticated network topology construction algorithm that tries to approximate a sparse structure implied by[2]for vision networks and covering the hypothesized outcome by dense,read-ily available components.Despite being a highly speculative undertaking,only after two iterations on the exact choice of topology,we could already see modest gains against the reference architec-ture based on[12].After further tuning of learning rate,hyperparameters and improved training methodology,we established that the resulting Inception architecture was especially useful in the context of localization and object detection as the base network for[6]and[5].Interestingly,while most of the original architectural choices have been questioned and tested thoroughly,they turned out to be at least locally optimal.One must be cautious though:although the proposed architecture has become a success for computer vision,it is still questionable whether its quality can be attributed to the guiding principles that have lead to its construction.Making sure would require much more thorough analysis and verification: for example,if automated tools based on the principles described below wouldfind similar,but better topology for the vision networks.The most convincing proof would be if an automated system would create network topologies resulting in similar gains in other domains using the same algorithm but with very differently looking global architecture.At very least,the initial success of the Inception architecture yieldsfirm motivation for exciting future work in this direction.4Architectural DetailsThe main idea of the Inception architecture is based onfinding out how an optimal local sparse structure in a convolutional vision network can be approximated and covered by readily available dense components.Note that assuming translation invariance means that our network will be built from convolutional building blocks.All we need is tofind the optimal local construction and to repeat it spatially.Arora et al.[2]suggests a layer-by layer construction in which one should analyze the correlation statistics of the last layer and cluster them into groups of units with high correlation. These clusters form the units of the next layer and are connected to the units in the previous layer.We assume that each unit from the earlier layer corresponds to some region of the input image and these units are grouped intofilter banks.In the lower layers(the ones close to the input)correlated units would concentrate in local regions.This means,we would end up with a lot of clusters concentrated in a single region and they can be covered by a layer of1×1convolutions in the next layer,as suggested in[12].However,one can also expect that there will be a smaller number of more spatially spread out clusters that can be covered by convolutions over larger patches,and there will be a decreasing number of patches over larger and larger regions.In order to avoid patch-alignment issues,current incarnations of the Inception architecture are restricted tofilter sizes1×1, 3×3and5×5,however this decision was based more on convenience rather than necessity.It also means that the suggested architecture is a combination of all those layers with their outputfilter banks concatenated into a single output vector forming the input of the next stage.Additionally, since pooling operations have been essential for the success in current state of the art convolutional networks,it suggests that adding an alternative parallel pooling path in each such stage should have additional beneficial effect,too(see Figure2(a)).As these“Inception modules”are stacked on top of each other,their output correlation statistics are bound to vary:as features of higher abstraction are captured by higher layers,their spatial concentration is expected to decrease suggesting that the ratio of3×3and5×5convolutions should increase as we move to higher layers.One big problem with the above modules,at least in this na¨ıve form,is that even a modest number of 5×5convolutions can be prohibitively expensive on top of a convolutional layer with a large number offilters.This problem becomes even more pronounced once pooling units are added to the mix: their number of outputfilters equals to the number offilters in the previous stage.The merging of the output of the pooling layer with the outputs of convolutional layers would lead to an inevitable(a)Inception module,na¨ıve version(b)Inception module with dimension reductionsFigure2:Inception moduleincrease in the number of outputs from stage to stage.Even while this architecture might cover the optimal sparse structure,it would do it very inefficiently,leading to a computational blow up within a few stages.This leads to the second idea of the proposed architecture:judiciously applying dimension reduc-tions and projections wherever the computational requirements would increase too much otherwise. This is based on the success of embeddings:even low dimensional embeddings might contain a lot of information about a relatively large image patch.However,embeddings represent information in a dense,compressed form and compressed information is harder to model.We would like to keep our representation sparse at most places(as required by the conditions of[2])and compress the signals only whenever they have to be aggregated en masse.That is,1×1convolutions are used to compute reductions before the expensive3×3and5×5convolutions.Besides being used as reduc-tions,they also include the use of rectified linear activation which makes them dual-purpose.The final result is depicted in Figure2(b).In general,an Inception network is a network consisting of modules of the above type stacked upon each other,with occasional max-pooling layers with stride2to halve the resolution of the grid.For technical reasons(memory efficiency during training),it seemed beneficial to start using Inception modules only at higher layers while keeping the lower layers in traditional convolutional fashion. This is not strictly necessary,simply reflecting some infrastructural inefficiencies in our current implementation.One of the main beneficial aspects of this architecture is that it allows for increasing the number of units at each stage significantly without an uncontrolled blow-up in computational complexity.The ubiquitous use of dimension reduction allows for shielding the large number of inputfilters of the last stage to the next layer,first reducing their dimension before convolving over them with a large patch size.Another practically useful aspect of this design is that it aligns with the intuition that visual information should be processed at various scales and then aggregated so that the next stage can abstract features from different scales simultaneously.The improved use of computational resources allows for increasing both the width of each stage as well as the number of stages without getting into computational difficulties.Another way to utilize the inception architecture is to create slightly inferior,but computationally cheaper versions of it.We have found that all the included the knobs and levers allow for a controlled balancing of computational resources that can result in networks that are2−3×faster than similarly performing networks with non-Inception architecture,however this requires careful manual design at this point. 5GoogLeNetWe chose GoogLeNet as our team-name in the ILSVRC14competition.This name is an homage to Yann LeCuns pioneering LeNet5network[10].We also use GoogLeNet to refer to the particular incarnation of the Inception architecture used in our submission for the competition.We have also used a deeper and wider Inception network,the quality of which was slightly inferior,but adding it to the ensemble seemed to improve the results marginally.We omit the details of that network,since our experiments have shown that the influence of the exact architectural parameters is relativelytype patch size/strideoutputsizedepth#1×1#3×3reduce#3×3#5×5reduce#5×5poolprojparams opsconvolution7×7/2112×112×641 2.7K34M max pool3×3/256×56×640convolution3×3/156×56×192264192112K360M max pool3×3/228×28×1920inception(3a)28×28×25626496128163232159K128M inception(3b)28×28×4802128128192329664380K304M max pool3×3/214×14×4800inception(4a)14×14×512219296208164864364K73M inception(4b)14×14×5122160112224246464437K88M inception(4c)14×14×5122128128256246464463K100M inception(4d)14×14×5282112144288326464580K119M inception(4e)14×14×832225616032032128128840K170M max pool3×3/27×7×8320inception(5a)7×7×8322256160320321281281072K54M inception(5b)7×7×10242384192384481281281388K71M avg pool7×7/11×1×10240dropout(40%)1×1×10240linear1×1×100011000K1M softmax1×1×10000Table1:GoogLeNet incarnation of the Inception architectureminor.Here,the most successful particular instance(named GoogLeNet)is described in Table1for demonstrational purposes.The exact same topology(trained with different sampling methods)was used for6out of the7models in our ensemble.All the convolutions,including those inside the Inception modules,use rectified linear activation. The size of the receptivefield in our network is224×224taking RGB color channels with mean sub-traction.“#3×3reduce”and“#5×5reduce”stands for the number of1×1filters in the reduction layer used before the3×3and5×5convolutions.One can see the number of1×1filters in the pro-jection layer after the built-in max-pooling in the pool proj column.All these reduction/projection layers use rectified linear activation as well.The network was designed with computational efficiency and practicality in mind,so that inference can be run on individual devices including even those with limited computational resources,espe-cially with low-memory footprint.The network is22layers deep when counting only layers with parameters(or27layers if we also count pooling).The overall number of layers(independent build-ing blocks)used for the construction of the network is about100.However this number depends on the machine learning infrastructure system used.The use of average pooling before the classifier is based on[12],although our implementation differs in that we use an extra linear layer.This enables adapting andfine-tuning our networks for other label sets easily,but it is mostly convenience and we do not expect it to have a major effect.It was found that a move from fully connected layers to average pooling improved the top-1accuracy by about0.6%,however the use of dropout remained essential even after removing the fully connected layers.Given the relatively large depth of the network,the ability to propagate gradients back through all the layers in an effective manner was a concern.One interesting insight is that the strong performance of relatively shallower networks on this task suggests that the features produced by the layers in the middle of the network should be very discriminative.By adding auxiliary classifiers connected to these intermediate layers,we would expect to encourage discrimination in the lower stages in the classifier,increase the gradient signal that gets propagated back,and provide additional regulariza-tion.These classifiers take the form of smaller convolutional networks put on top of the output of the Inception(4a)and(4d)modules.During training,their loss gets added to the total loss of the network with a discount weight(the losses of the auxiliary classifiers were weighted by0.3).At inference time,these auxiliary networks are discarded.The exact structure of the extra network on the side,including the auxiliary classifier,is as follows:•An average pooling layer with5×5filter size and stride3,resulting in an4×4×512output for the(4a),and4×4×528for the(4d)stage.Figure3:GoogLeNet network with all the bells and whistles•A1×1convolution with128filters for dimension reduction and rectified linear activation.•A fully connected layer with1024units and rectified linear activation.•A dropout layer with70%ratio of dropped outputs.•A linear layer with softmax loss as the classifier(predicting the same1000classes as the main classifier,but removed at inference time).A schematic view of the resulting network is depicted in Figure3.6Training MethodologyOur networks were trained using the DistBelief[4]distributed machine learning system using mod-est amount of model and data-parallelism.Although we used CPU based implementation only,a rough estimate suggests that the GoogLeNet network could be trained to convergence using few high-end GPUs within a week,the main limitation being the memory usage.Our training used asynchronous stochastic gradient descent with0.9momentum[17],fixed learning rate schedule(de-creasing the learning rate by4%every8epochs).Polyak averaging[13]was used to create thefinal model used at inference time.Our image sampling methods have changed substantially over the months leading to the competition, and already converged models were trained on with other options,sometimes in conjunction with changed hyperparameters,like dropout and learning rate,so it is hard to give a definitive guidance to the most effective single way to train these networks.To complicate matters further,some of the models were mainly trained on smaller relative crops,others on larger ones,inspired by[8]. Still,one prescription that was verified to work very well after the competition includes sampling of various sized patches of the image whose size is distributed evenly between8%and100%of the image area and whose aspect ratio is chosen randomly between3/4and4/3.Also,we found that the photometric distortions by Andrew Howard[8]were useful to combat overfitting to some extent.In addition,we started to use random interpolation methods(bilinear,area,nearest neighbor and cubic, with equal probability)for resizing relatively late and in conjunction with other hyperparameter changes,so we could not tell definitely whether thefinal results were affected positively by their use.7ILSVRC2014Classification Challenge Setup and ResultsThe ILSVRC2014classification challenge involves the task of classifying the image into one of 1000leaf-node categories in the Imagenet hierarchy.There are about1.2million images for training, 50,000for validation and100,000images for testing.Each image is associated with one ground truth category,and performance is measured based on the highest scoring classifier predictions. Two numbers are usually reported:the top-1accuracy rate,which compares the ground truth against thefirst predicted class,and the top-5error rate,which compares the ground truth against thefirst 5predicted classes:an image is deemed correctly classified if the ground truth is among the top-5, regardless of its rank in them.The challenge uses the top-5error rate for ranking purposes.We participated in the challenge with no external data used for training.In addition to the training techniques aforementioned in this paper,we adopted a set of techniques during testing to obtain a higher performance,which we elaborate below.1.We independently trained7versions of the same GoogLeNet model(including one widerversion),and performed ensemble prediction with them.These models were trained with the same initialization(even with the same initial weights,mainly because of an oversight) and learning rate policies,and they only differ in sampling methodologies and the random order in which they see input images.2.During testing,we adopted a more aggressive cropping approach than that of Krizhevsky etal.[9].Specifically,we resize the image to4scales where the shorter dimension(height or width)is256,288,320and352respectively,take the left,center and right square of these resized images(in the case of portrait images,we take the top,center and bottom squares).For each square,we then take the4corners and the center224×224crop as well as theTeam Year Place Error(top-5)Uses external dataSuperVision20121st16.4%noSuperVision20121st15.3%Imagenet22kClarifai20131st11.7%noClarifai20131st11.2%Imagenet22kMSRA20143rd7.35%noVGG20142nd7.32%noGoogLeNet20141st6.67%noTable2:Classification performanceNumber of models Number of Crops Cost Top-5error compared to base11110.07%base110109.15%-0.92%11441447.89%-2.18%7178.09%-1.98%710707.62%-2.45%714410086.67%-3.45%Table3:GoogLeNet classification performance break downsquare resized to224×224,and their mirrored versions.This results in4×3×6×2=144 crops per image.A similar approach was used by Andrew Howard[8]in the previous year’s entry,which we empirically verified to perform slightly worse than the proposed scheme.We note that such aggressive cropping may not be necessary in real applications,as the benefit of more crops becomes marginal after a reasonable number of crops are present(as we will show later on).3.The softmax probabilities are averaged over multiple crops and over all the individual clas-sifiers to obtain thefinal prediction.In our experiments we analyzed alternative approaches on the validation data,such as max pooling over crops and averaging over classifiers,but they lead to inferior performance than the simple averaging.In the remainder of this paper,we analyze the multiple factors that contribute to the overall perfor-mance of thefinal submission.Ourfinal submission in the challenge obtains a top-5error of6.67%on both the validation and testing data,ranking thefirst among other participants.This is a56.5%relative reduction compared to the SuperVision approach in2012,and about40%relative reduction compared to the previous year’s best approach(Clarifai),both of which used external data for training the classifiers.The following table shows the statistics of some of the top-performing approaches.We also analyze and report the performance of multiple testing choices,by varying the number of models and the number of crops used when predicting an image in the following table.When we use one model,we chose the one with the lowest top-1error rate on the validation data.All numbers are reported on the validation dataset in order to not overfit to the testing data statistics.8ILSVRC2014Detection Challenge Setup and ResultsThe ILSVRC detection task is to produce bounding boxes around objects in images among200 possible classes.Detected objects count as correct if they match the class of the groundtruth and their bounding boxes overlap by at least50%(using the Jaccard index).Extraneous detections count as false positives and are penalized.Contrary to the classification task,each image may contain。