Matlab-SVM整理

matlab的svmrfe函数

一、介绍MATLAB是一种流行的技术计算软件,广泛应用于工程、科学和其他领域。

在MATLAB的工具箱中,包含了许多函数和工具,可以帮助用户解决各种问题。

其中,SVMRFE函数是MATLAB中的一个重要功能,用于支持向量机分类问题中的特征选择。

二、SVMRFE函数的作用SVMRFE函数的全称为Support Vector Machines Recursive Feature Elimination,它的作用是利用支持向量机进行特征选择。

在机器学习和模式识别领域,特征选择是一项重要的任务,通过选择最重要的特征,可以提高分类器的性能,并且减少计算和存储的开销。

特征选择问题在实际应用中经常遇到,例如在生物信息学中,选择基因表达数据中最相关的基因;在图像处理中,选择最相关的像素特征。

SVMRFE函数可以自动化地解决这些问题,帮助用户找到最佳的特征子集。

三、使用SVMRFE函数使用SVMRFE函数,用户需要准备好特征矩阵X和目标变量y,其中X是大小为m×n的矩阵,表示m个样本的n个特征;y是大小为m×1的向量,表示m个样本的类别标签。

用户还需要设置支持向量机的参数,如惩罚参数C和核函数类型等。

接下来,用户可以调用SVMRFE函数,设置特征选择的方法、评价指标以及其他参数。

SVMRFE函数将自动进行特征选择,并返回最佳的特征子集,以及相应的评价指标。

用户可以根据返回的结果,进行后续的分类器训练和预测。

四、SVMRFE函数的优点SVMRFE函数具有以下几个优点:1. 自动化:SVMRFE函数可以自动选择最佳的特征子集,减少了用户手工试验的时间和精力。

2. 高性能:SVMRFE函数采用支持向量机作为分类器,具有较高的分类精度和泛化能力。

3. 灵活性:SVMRFE函数支持多种特征选择方法和评价指标,用户可以根据自己的需求进行灵活调整。

五、SVMRFE函数的示例以下是一个简单的示例,演示了如何使用SVMRFE函数进行特征选择:```matlab准备数据load fisheririsX = meas;y = species;设置参数opts.method = 'rfe';opts.nf = 2;调用SVMRFE函数[selected, evals] = svmrfe(X, y, opts);```在这个示例中,我们使用了鸢尾花数据集,设置了特征选择的方法为递归特征消除(RFE),并且要选择2个特征。

matlab fitsvm参数

matlab fitsvm参数fitcsvm是MATLAB中用于构建支持向量机(SVM)分类模型的函数。

SVM是一种常用的分类方法,其基本思想是将数据映射到高维空间,在该空间中找到一个最优的超平面,以区分不同类别的数据。

fitcsvm函数具有丰富的参数选项,可以根据具体的需求来调整模型的性能和精度。

下面将介绍一些常用的参数及其相关参考内容:1. 'KernelFunction'参数:指定SVM模型所使用的核函数类型。

常见的核函数有线性核函数、多项式核函数、高斯核函数等。

可以使用以下代码来设置核函数类型:```matlabSVMModel = fitcsvm(X, Y, 'KernelFunction', 'linear');```有关不同核函数的详细信息和选取准则,可以参考MATLAB官方文档中的KernelFunction参数说明。

2. 'BoxConstraint'参数:用于控制模型的复杂度和鲁棒性。

该参数的取值范围是大于0的实数,较小的值表示更简单的模型,较大的值表示更复杂的模型。

可以使用以下代码来设置BoxConstraint的值:```matlabSVMModel = fitcsvm(X, Y, 'BoxConstraint', 1.0);```3. 'Standardize'参数:指定是否对输入数据进行标准化处理。

标准化是将输入数据减去其均值并除以标准差,以消除不同特征量级对模型的影响。

可以使用以下代码来设置是否进行标准化处理:```matlabSVMModel = fitcsvm(X, Y, 'Standardize', true);```更多关于数据标准化的信息可以参考MATLAB官方文档中的Standardize参数说明。

4. 'KernelScale'参数:用于指定核函数的缩放因子。

matlab svm多分类算法 -回复

matlab svm多分类算法-回复什么是SVM多分类算法?支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,用于分类和回归分析。

它的主要思想是在特征空间中找到一个最优的超平面,将不同类别的样本点分开。

SVM被广泛应用于二分类问题,但在现实世界中,多分类问题更为常见。

SVM多分类算法是基于SVM算法的扩展,用于解决多类别分类问题。

SVM多分类算法的原理是什么?基本的SVM算法是建立在二分类的基础上的,它通过寻找一个最大化间隔的超平面来进行分类。

然而,在多分类问题中,我们需要一种方法来将多个类别进行有效地分类。

常用的方法有一对一(One-vs-One)和一对其余(One-vs-Rest)。

一对一方法将每两个类别之间都构造一个二分类器。

例如,对于k个类别,需要构建k*(k-1)/2个分类器,每个分类器负责将两个类别中的一个划分出来。

当需要对一个未知类别的样本进行分类时,每个分类器都会给出一个类别的判断结果,最后根据这些结果进行投票或决策,选择得票最多的类别作为最终的分类结果。

一对其余方法则是将一个类别与其他所有类别作为一个整体进行分类。

同样以k个类别为例,需要构建k个二分类器,每个分类器负责将一个类别与其他k-1个类别作区分。

对于未知类别的样本进行分类时,分别计算它与每个类别的距离得分,选择距离最大的类别作为最终的分类结果。

SVM多分类算法的具体实现步骤是什么?以下是一种常见的SVM多分类算法实现步骤的概述:1. 读取数据集:首先,我们需要从数据集中读取样本数据和对应的类别标签。

确保数据集的类别标签是数字或字符串形式。

2. 数据预处理:对于SVM算法,特征归一化是一个重要的预处理步骤。

通过对特征进行归一化或标准化,可以避免样本特征之间的比例差异对分类结果的影响。

3. 划分训练集和测试集:将数据集划分为训练集和测试集,用于构建和评估模型的性能。

4. 对每对分类器进行训练:根据选择的一对一或一对其余方法,依次对每个二分类器进行训练。

matlab中svm的类型

matlab中svm的类型

在MATLAB中,支持向量机(SVM)有两种类型,一种是用于二元分类的分类器,另一种是用于多类分类的分类器。

这两种类型的SVM在MATLAB中均有支持。

对于二元分类,MATLAB中的SVM可以使用fitcsvm函数来训练一个二元分类器。

fitcsvm函数允许用户指定不同的核函数(如线性核、多项式核、高斯核等)以及其他参数,以便根据训练数据来拟合SVM模型。

一旦模型训练完成,可以使用predict函数对新的数据进行分类预测。

对于多类分类,MATLAB中的SVM可以使用fitcecoc函数来训练一个多类分类器。

fitcecoc函数使用“Error-Correcting Output Codes”(ECOC)策略来处理多类分类问题,它将原始多类分类问题转化为一系列的二元分类子问题。

同样,用户可以指定不同的核函数和其他参数来训练多类SVM分类器,并使用predict函数进行分类预测。

除了这两种基本类型的SVM之外,MATLAB还提供了一些其他的功能和工具,如交叉验证、特征选择、参数调优等,以帮助用户更

好地使用SVM进行分类任务。

总的来说,MATLAB中的SVM类型丰富多样,用户可以根据具体的分类问题和需求选择合适的类型和工具来进行分类建模和预测。

matlab中SVM工具箱的使用方法

包已经解压到文件夹F:\R2009b\toolbox\svmmatlab中SVM工具箱的使用方法1,下载SVM工具箱:/faculty/chzheng/bishe/indexfiles/indexl.htm 2,安装到matlab文件夹中1)将下载的SVM工具箱的文件夹放在\matlab71\toolbox\下2)打开matlab->File->Set Path中添加SVM工具箱的文件夹现在,就成功的添加成功了.可以测试一下:在matlab中输入which svcoutput 回车,如果可以正确显示路径,就证明添加成功了,例如:C:\Program Files\MATLAB71\toolbox\svm\svcoutput.m3,用SVM做分类的使用方法1)在matlab中输入必要的参数:X,Y,ker,C,p1,p2我做的测试中取的数据为:N = 50;n=2*N;randn('state',6);x1 = randn(2,N)y1 = ones(1,N);x2 = 5+randn(2,N);y2 = -ones(1,N);figure;plot(x1(1,:),x1(2,:),'bx',x2(1,:),x2(2,:),'k.');axis([-3 8 -3 8]);title('C-SVC')hold on;X1 = [x1,x2];Y1 = [y1,y2];X=X1';Y=Y1';其中,X是100*2的矩阵,Y是100*1的矩阵C=Inf;ker='linear';global p1 p2p1=3;p2=1;然后,在matlab中输入:[nsv alpha bias] = svc(X,Y,ker,C),回车之后,会显示:Support Vector Classification_____________________________Constructing ...Optimising ...Execution time: 1.9 secondsStatus : OPTIMAL_SOLUTION|w0|^2 : 0.418414Margin : 3.091912Sum alpha : 0.418414Support Vectors : 3 (3.0%)nsv =3alpha =0.00000.00000.00000.00000.00002)输入预测函数,可以得到与预想的分类结果进行比较.输入:predictedY = svcoutput(X,Y,X,ker,alpha,bias),回车后得到:predictedY =1111111113)画图输入:svcplot(X,Y,ker,alpha,bias),回车补充:X和Y为数据,m*n:m为样本数,n为特征向量数比如:取20组训练数据X,10组有故障,10组无故障的,每个训练数据有13个特征参数,则m=20,n=13Y为20*1的矩阵,其中,10组为1,10组为-1.对于测试数据中,如果取6组测试数据,3组有故障,3组无故障的,则m=6,n=13Y中,m=6,n=1/SV M_soft.htmlSVM - Support Vector MachinesSoftwareTrain support vector machine classifier/access/helpdesk/help/toolbox/bioinfo/ref/svmtrain.html一些问题???????1.今天我在使用SVM通用工具箱对眼电的信号数据进行分类时出现如下错误:Support Vector Classification_____________________________Constructing ...Optimising ...??? Dimension error (arg 3 and later).Error in ==> svc at 60[alpha lambda how] = qp(H, c, A, b, vlb, vub, x0, neqcstr);不知道是什么原因?答:今天上午终于找到出现这一错误的原因:它并不是SVM程序的问题,是我在整理样本时,把参数需要的样本行列颠倒所致。

SVM分类器-matlab程序-可运行

fprintf('-1');

else

fprintf(' 1');

end

fprintf(' 判别函数值%f 分类结果',sum(i) + b);

if abs(sum(i) + b - 1) < 0.5

else

U = max(0,a1old + a2old - C);

V = min(C,a1old + a2old);

end

if a2new > V

a2new = V;

end

if a2new < U

a2new = U;

end

a1new = a1old + S * (a2old - a2new);%计算新的a1

break;

end

if y(n1) * (sum(n1) + b) < 1 && a(n1) ~=C

break;

end

n1 = n1 + 1;

end

%n2按照最大化|E1-E2|的原则选取

a(n1) = a1new;%更新a

a(n2) = a2new;

%更新部分值

sum = zeros(n,1);

for k = 1 : n

for i = 1 : n

sum(k) = sum(k) + a(i) * y(i) * K(i,k);

end

end

0.9885 5.7625 0.1832 0

-0.3318 2.4373 -0.6884 0

Matlab-SVM整理

SVM整理1各种svm程序包1.1 matlab高级版本中自带的svm函数我现在使用的matlab版本为matlab 7.6.0(R2008a)这个版本中已经自带svm算法,分别为生物信息工具箱(bioinformatics toolbox)中svmclassify函数和svmtrain函数,为上下级关系。

SVMStruct=svmtrain(Training,Group)%svmtrain的输入为样本点training和样本的分类情况group,输出为一个分类器svmstruct.核函数,核参数,和计算方法等都是可选的,如SVMStruct = svmtrain(…, ‘Kernel_Function’, Kernel_FunctionValue, …)但是切记切记一定要成对出现。

然后,将分类器和testing sample带入svmclassify中,可以得到分类结果和准确度。

举个例子svmStruct=svmtrain(data(train,:),groups(train),’Kernel_Function’,'rbf’,'Kernel_FunctionValue’,’5′,’showplot’,true);%用了核宽为5的径向基核,且要求作图%这里我觉得原作者的写法有误,应该是svmStruct = svmtrain(data(train,:),groups(train),...'Kernel_Function','rbf','RBF_Sigma',5,'showplot',true);classes = svmclassify(svmStruct,data(test,:),’showplot’,true);%要求输出检测样本点的分类结果,且画图表示。

tip 1: 有归一化scale功能,可以通过调参数实现tip 2: 计算方法可选qp,smo,lstip 3: 有个关于soft margin的盒子条件,我不太明白是干嘛的,谁懂得话,就给我讲讲哈tip 4: 画出来的图很难看to sum up: 挺好的1.2较早使用的工具箱SVM and Kernel Methods Matlab Toolbox2005年法国人写的,最近的更新为20/02/2008下载的地址为http://asi.insa-rouen.fr/enseignants/~arakotom/toolbox/index.html这是我最早开始用的一个工具箱,我很喜欢,到现在还是,对于svm的初学者是个很好的toolbox.有详细的说明和很多的demo和例子,包含现今几乎所有的有关svm的成熟算法和数据预处理方法(pca及小波等)。

matlab fitsvm参数

matlab fitsvm参数在 MATLAB 中,fitcsvm 函数用于训练支持向量机(Support Vector Machine,SVM)分类器。

下面是 fitcsvm 函数的常用参数:1. 数据集参数:- 'X':输入特征矩阵,大小为M×N,其中M是样本数量,N是特征数量。

- 'Y':分类标签向量,大小为M×1,其中M是样本数量。

2. 模型参数:- 'KernelFunction':核函数类型,可以是线性核函数'linear'、多项式核函数'polynomial'、高斯核函数'gaussian'(默认值)、径向基函数'rbf'等。

- 'KernelScale':核函数的尺度参数,用于控制特征空间中各个特征的重要程度。

对于高斯核函数'gaussian'和径向基函数'rbf',该参数决定了支持向量机的“宽度”。

3. 优化参数:- 'BoxConstraint':惩罚参数C,用于控制分类器的错误容忍度。

较小的C值会产生较大的间隔,容忍一些错误分类,从而使模型更简单;较大的C值会产生较小的间隔,减少误分类,但可能过拟合。

- 'KernelOffset':与超平面的距离偏移量,可以用于改变判决边界的位置。

- 'Solver':优化求解器的类型,可以是序列最小优化(SMO)算法'smo'(默认值)、拉格朗日乘子法(Lagrange multiplier)'lagrange'、内点法(interior-point)'interior-point'等。

4. 其他参数:- 'Standardize':是否对输入数据进行标准化处理,默认为true。

matlabsvm代码运动想象二分类

matlabsvm代码运动想象二分类Matlabsvm代码运动想象二分类•背景介绍:Matlabsvm代码是一种用于运动想象二分类任务的工具,它可以对脑电信号进行分析,从中识别出人们脑海中所想象的运动。

这对于研究脑机接口和开发相关应用具有重要意义。

•什么是运动想象二分类:运动想象二分类是一种基于脑电信号的分类任务,通过分析被试在不实际进行运动的情况下脑电信号的特征,来判断被试想象的是哪种运动(如左手运动或右手运动)。

•Matlabsvm代码的功能:Matlabsvm代码提供了一个快速高效的工具,可以帮助研究者进行运动想象二分类任务。

它利用支持向量机(SVM)算法,通过训练一个分类器来实现对脑电信号的分类。

•准备数据:在使用Matlabsvm代码进行分类之前,需要准备好脑电信号的数据集。

这个数据集通常包括被试在进行运动想象任务时记录的脑电信号数据,以及与之对应的类别标签(即想象的是哪种运动)。

•特征提取:在进行运动想象二分类之前,我们需要从脑电信号中提取一些特征,用来描述信号中的信息。

常用的特征包括时域特征、频域特征和时频特征等。

Matlabsvm代码提供了一些常用的特征提取函数,可以根据需要选择合适的特征进行提取。

•训练分类器:在准备好数据和特征之后,我们可以使用Matlabsvm代码来训练一个分类器。

这个分类器将学习从特征到类别标签的映射关系,以便后续对新的脑电信号进行分类预测。

•模型评估:为了评估分类器的性能,我们通常需要将数据集分为训练集和测试集。

通过在测试集上进行预测,并与真实标签进行比较,我们可以计算分类器的准确率、精确率、召回率等指标,以评估其在运动想象二分类任务中的表现。

•模型优化:根据模型评估的结果,我们可以对模型进行优化,以提高分类器的性能。

常见的优化方法包括调整模型参数、使用交叉验证等。

Matlabsvm代码提供了一些优化方法和工具,可以帮助我们改进分类器的性能。

•应用领域:运动想象二分类在脑机接口技术、康复治疗和虚拟现实等领域具有广泛应用。

傻瓜攻略(十九)——MATLAB实现SVM多分类

傻瓜攻略(十九)——MATLAB实现SVM多分类SVM (Support Vector Machine) 是一种常用的机器学习算法,广泛应用于分类问题。

原始的 SVM 算法只适用于二分类问题,但是有时我们需要解决多分类问题。

本文将介绍如何使用 MATLAB 实现 SVM 多分类。

首先,我们需要明确一些基本概念。

在 SVM 中,我们需要对每个类别建立一个分类器,然后将未知样本进行分类。

这涉及到两个主要步骤:一对一(One-vs-One)分类和一对其他(One-vs-Rest)分类。

在一对一分类中,我们需要对每两个类别都建立一个分类器。

例如,如果有三个类别 A、B 和 C,那么我们需要建立三个分类器:A vs B, A vs C 和 B vs C。

然后,我们将未知样本进行分类,看它属于哪个类别。

在一对其他分类中,我们将一个类别看作是“正例”,而其他所有类别看作是“负例”。

例如,如果有三个类别 A、B 和 C,那么我们需要建立三个分类器:A vs rest, B vs rest 和 C vs rest。

然后,我们将未知样本进行分类,看它属于哪个类别。

接下来,我们将使用一个示例数据集来演示如何使用MATLAB实现SVM多分类。

我们将使用鸢尾花数据集,该数据集包含了三个类别的鸢尾花样本。

首先,我们需要加载数据集。

在 MATLAB 中,我们可以使用`load`函数加载内置的鸢尾花数据集。

代码如下所示:```load fisheriris```数据集加载完成后,我们可以查看数据集的结构。

在 MATLAB 中,我们可以使用`whos`函数查看当前工作空间中的变量。

代码如下所示:```whos``````X = meas;Y = species;```然后,我们可以使用`fitcecoc`函数构建一个多分类 SVM 模型。

`fitcecoc`函数可以自动选择最佳的核函数,并训练多个二分类器来实现多分类。

代码如下所示:```SVMModel = fitcecoc(X, Y);```训练完成后,我们可以使用`predict`函数对未知样本进行分类。

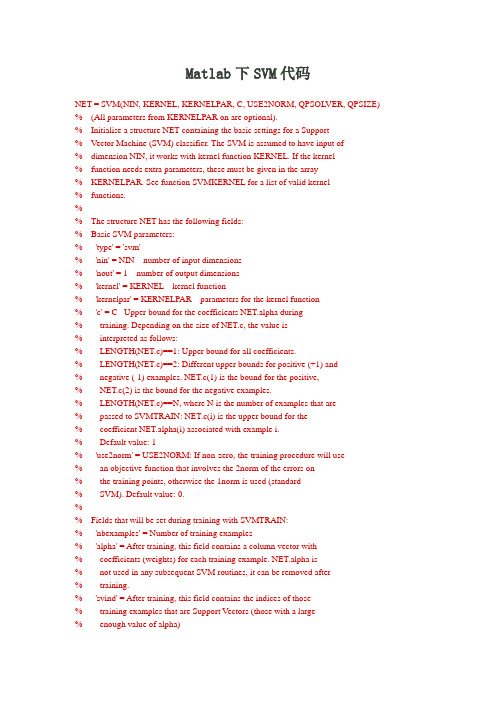

Matlab下SVM代码

Matlab下SVM代码NET = SVM(NIN, KERNEL, KERNELPAR, C, USE2NORM, QPSOLVER, QPSIZE) % (All parameters from KERNELPAR on are optional).% Initialise a structure NET containing the basic settings for a Support% Vector Machine (SVM) classifier. The SVM is assumed to have input of% dimension NIN, it works with kernel function KERNEL. If the kernel% function needs extra parameters, these must be given in the array% KERNELPAR. See function SVMKERNEL for a list of valid kernel% functions.%% The structure NET has the following fields:% Basic SVM parameters:% 'type' = 'svm'% 'nin' = NIN number of input dimensions% 'nout' = 1 number of output dimensions% 'kernel' = KERNEL kernel function% 'kernelpar' = KERNELPAR parameters for the kernel function% 'c' = C Upper bound for the coefficients NET.alpha during% training. Depending on the size of NET.c, the value is% interpreted as follows:% LENGTH(NET.c)==1: Upper bound for all coefficients.% LENGTH(NET.c)==2: Different upper bounds for positive (+1) and% negative (-1) examples. NET.c(1) is the bound for the positive,% NET.c(2) is the bound for the negative examples.% LENGTH(NET.c)==N, where N is the number of examples that are% passed to SVMTRAIN: NET.c(i) is the upper bound for the% coefficient NET.alpha(i) associated with example i.% Default value: 1% 'use2norm' = USE2NORM: If non-zero, the training procedure will use% an objective function that involves the 2norm of the errors on% the training points, otherwise the 1norm is used (standard% SVM). Default value: 0.%% Fields that will be set during training with SVMTRAIN:% 'nbexamples' = Number of training examples% 'alpha' = After training, this field contains a column vector with% coefficients (weights) for each training example. NET.alpha is% not used in any subsequent SVM routines, it can be removed after% training.% 'svind' = After training, this field contains the indices of those% training examples that are Support Vectors (those with a large% enough value of alpha)% 'sv' = Contains all the training examples that are Support Vectors.% 'svcoeff' = After training, this field is the product of NET.alpha% times the label of the corresponding training example, for all% examples that are Support Vectors. It is given in the same order% as the examples are given in NET.sv.% 'bias' = The linear term of the SVM decision function.% 'normalw' = Normal vector of the hyperplane that separates the% examples. This is only computed if a linear kernel% NET.kernel='linear' is used.%% Parameters specifically for SVMTRAIN (rarely need to be changed):% 'qpsolver' = QPSOLVER. QPSOLVER must be one of 'quadprog', 'loqo', % 'qp' or empty for auto-detect. Name of the function that solves% the quadratic programming problems in SVMTRAIN.% Default value: empty (auto-detect).% 'qpsize' = QPSIZE. The maximum number of points given to the QP % solver. Default value: 50.% 'alphatol' = Tolerance for all comparisons that involve the% coefficients NET.alpha. Default value: 1E-2.% 'kkttol' = Tolerance for checking the KKT conditions (termination% criterion) Default value: 5E-2. Lower this when high precision is% required.。

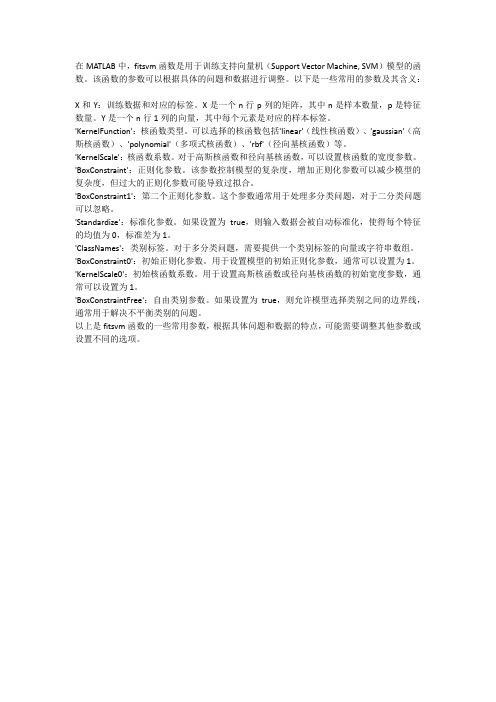

matlab fitsvm参数

在MATLAB中,fitsvm函数是用于训练支持向量机(Support Vector Machine, SVM)模型的函数。

该函数的参数可以根据具体的问题和数据进行调整。

以下是一些常用的参数及其含义:X和Y:训练数据和对应的标签。

X是一个n行p列的矩阵,其中n是样本数量,p是特征数量。

Y是一个n行1列的向量,其中每个元素是对应的样本标签。

'KernelFunction':核函数类型。

可以选择的核函数包括'linear'(线性核函数)、'gaussian'(高斯核函数)、'polynomial'(多项式核函数)、'rbf'(径向基核函数)等。

'KernelScale':核函数系数。

对于高斯核函数和径向基核函数,可以设置核函数的宽度参数。

'BoxConstraint':正则化参数。

该参数控制模型的复杂度,增加正则化参数可以减少模型的复杂度,但过大的正则化参数可能导致过拟合。

'BoxConstraint1':第二个正则化参数。

这个参数通常用于处理多分类问题,对于二分类问题可以忽略。

'Standardize':标准化参数。

如果设置为true,则输入数据会被自动标准化,使得每个特征的均值为0,标准差为1。

'ClassNames':类别标签。

对于多分类问题,需要提供一个类别标签的向量或字符串数组。

'BoxConstraint0':初始正则化参数。

用于设置模型的初始正则化参数,通常可以设置为1。

'KernelScale0':初始核函数系数。

用于设置高斯核函数或径向基核函数的初始宽度参数,通常可以设置为1。

'BoxConstraintFree':自由类别参数。

如果设置为true,则允许模型选择类别之间的边界线,通常用于解决不平衡类别的问题。

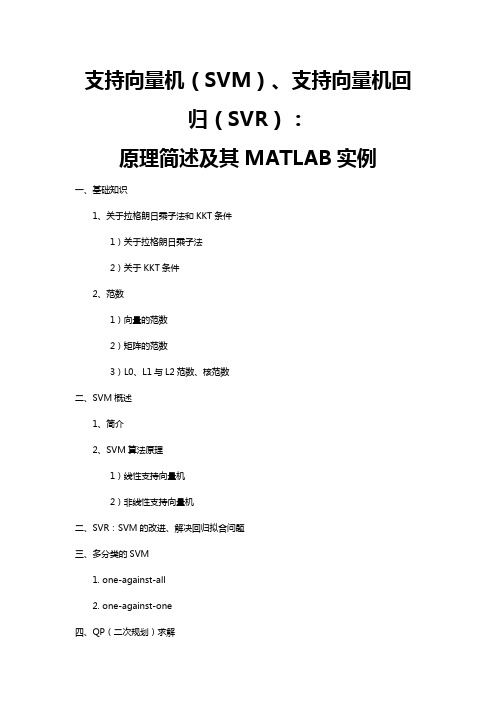

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法2)关于KKT条件2、范数1)向量的范数2)矩阵的范数3)L0、L1与L2范数、核范数二、SVM概述1、简介2、SVM算法原理1)线性支持向量机2)非线性支持向量机二、SVR:SVM的改进、解决回归拟合问题三、多分类的SVM1. one-against-all2. one-against-one四、QP(二次规划)求解五、SVM的MATLAB实现:Libsvm1、Libsvm工具箱使用说明2、重要函数:3、示例支持向量机(SVM):原理及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法首先来了解拉格朗日乘子法,为什么需要拉格朗日乘子法呢?记住,有需要拉格朗日乘子法的地方,必然是一个组合优化问题。

那么带约束的优化问题很好说,就比如说下面这个:这是一个带等式约束的优化问题,有目标值,有约束条件。

那么你可以想想,假设没有约束条件这个问题是怎么求解的呢?是不是直接 f 对各个 x 求导等于 0,解 x 就可以了,可以看到没有约束的话,求导为0,那么各个x均为0吧,这样f=0了,最小。

但是x都为0不满足约束条件呀,那么问题就来了。

有了约束不能直接求导,那么如果把约束去掉不就可以了吗?怎么去掉呢?这才需要拉格朗日方法。

既然是等式约束,那么我们把这个约束乘一个系数加到目标函数中去,这样就相当于既考虑了原目标函数,也考虑了约束条件。

现在这个优化目标函数就没有约束条件了吧,既然如此,求法就简单了,分别对x求导等于0,如下:把它在带到约束条件中去,可以看到,2个变量两个等式,可以求解,最终可以得到,这样再带回去求x就可以了。

那么一个带等式约束的优化问题就通过拉格朗日乘子法完美的解决了。

更高一层的,带有不等式的约束问题怎么办?那么就需要用更一般化的拉格朗日乘子法,即KKT条件,来解决这种问题了。

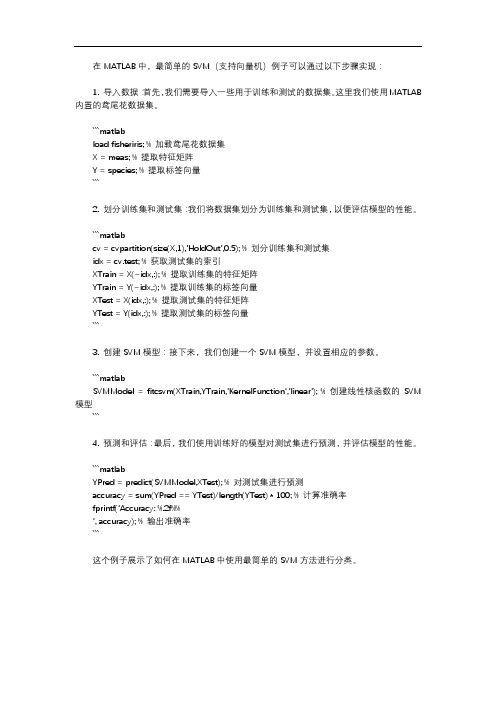

matlab中最简单的svm例子

在MATLAB中,最简单的SVM(支持向量机)例子可以通过以下步骤实现:1. 导入数据:首先,我们需要导入一些用于训练和测试的数据集。

这里我们使用MATLAB 内置的鸢尾花数据集。

```matlabload fisheriris; % 加载鸢尾花数据集X = meas; % 提取特征矩阵Y = species; % 提取标签向量```2. 划分训练集和测试集:我们将数据集划分为训练集和测试集,以便评估模型的性能。

```matlabcv = cvpartition(size(X,1),'HoldOut',0.5); % 划分训练集和测试集idx = cv.test; % 获取测试集的索引XTrain = X(~idx,:); % 提取训练集的特征矩阵YTrain = Y(~idx,:); % 提取训练集的标签向量XTest = X(idx,:); % 提取测试集的特征矩阵YTest = Y(idx,:); % 提取测试集的标签向量```3. 创建SVM模型:接下来,我们创建一个SVM模型,并设置相应的参数。

```matlabSVMModel = fitcsvm(XTrain,YTrain,'KernelFunction','linear'); % 创建线性核函数的SVM 模型```4. 预测和评估:最后,我们使用训练好的模型对测试集进行预测,并评估模型的性能。

```matlabYPred = predict(SVMModel,XTest); % 对测试集进行预测accuracy = sum(YPred == YTest)/length(YTest) * 100; % 计算准确率fprintf('Accuracy: %.2f%%', accuracy); % 输出准确率```这个例子展示了如何在MATLAB中使用最简单的SVM方法进行分类。

svm matlab 代码 -回复

svm matlab 代码-回复如何用MATLAB编写SVM算法代码支持向量机(Support Vector Machine, SVM)是一种被广泛应用于模式分类和回归分析的机器学习算法。

本文将以MATLAB为工具,一步一步地介绍如何编写SVM算法的代码。

一、数据准备编写SVM代码的第一步是准备好训练数据和测试数据。

一般来说,我们需要将数据转换成向量的形式,并标注不同样本的类别。

在MATLAB中,可以使用矩阵表示样本的特征向量,使用向量表示样本的类别标签。

二、数据预处理在训练SVM模型之前,我们需要对数据进行预处理。

预处理包括数据归一化、数据划分等步骤。

1. 数据归一化数据归一化是将样本数据按照一定的比例缩放,使得数据在同一数量级上。

常见的归一化方法有min-max归一化和z-score标准化。

在MATLAB中,可以使用`mapminmax`函数进行min-max归一化,使用`zscore`函数进行z-score标准化。

2. 数据划分为了评估模型的性能,我们需要将数据分为训练集和测试集。

一般情况下,可以将数据按照70的比例划分为训练集,30的比例划分为测试集。

在MATLAB中,可以使用`cvpartition`函数进行数据划分。

三、训练SVM模型在准备好数据之后,我们可以开始训练SVM模型。

MATLAB提供了`fitcsvm`函数用于训练SVM分类器。

1. 设置SVM参数在训练SVM模型之前,我们需要设置SVM的参数。

常见的参数包括核函数类型、核函数参数、惩罚参数等。

在MATLAB中,可以使用`templateSVM`对象来设置SVM的参数。

2. 训练模型使用`fitcsvm`函数进行训练模型。

该函数需要输入训练数据、训练标签和SVM参数。

四、测试模型在训练完SVM模型之后,我们需要对模型进行测试,评估模型的性能。

1. 预测结果使用训练好的SVM模型对测试数据进行预测,得到预测结果。

MATLAB 提供了`predict`函数用于进行预测。

matlab对三维数据的svm分类

matlab对三维数据的svm分类1.引言1.1 概述概述部分的内容可以包括对SVM分类算法和三维数据的概述。

在本文中,我们将探讨如何使用MATLAB来对三维数据进行支持向量机(SVM)分类。

SVM是一种常用的机器学习算法,可以用于二分类和多分类问题。

它通过寻找一个最优的超平面来将不同类别的数据分开,从而实现分类的目的。

三维数据是指具有三个特征向量的数据集。

这种类型的数据在许多领域中都很常见,例如医学图像处理、计算机视觉和工程分析等。

对于三维数据的分类,我们需要首先对数据进行表示和处理,以便用于SVM算法的输入。

本文的目的是介绍如何使用MATLAB对三维数据进行SVM分类。

我们将从SVM分类算法的基本原理开始,然后讨论如何表示和处理三维数据。

通过实验和结果分析,我们将评估SVM在三维数据分类中的性能,并总结结论。

通过本文的阅读,读者将能够了解SVM算法的基本原理、三维数据的表示和处理方法以及MATLAB在这方面的应用。

这将有助于读者在实际问题中应用SVM算法进行三维数据的分类分析。

1.2文章结构文章结构部分的内容可以按照以下方式编写:本文主要分为引言、正文和结论三个部分。

具体结构如下:2.正文正文部分主要包括两个主题:SVM分类算法和三维数据的表示和处理。

2.1 SVM分类算法在这个部分中,将介绍SVM分类算法的基本原理和步骤。

首先,会对支持向量机(SVM)进行简要的概述,包括其分类原理和优点。

然后,会详细介绍SVM分类算法的步骤,包括数据预处理、选择适当的核函数以及参数的调优等。

同时,还会讨论如何解决线性不可分数据和多类别分类的问题,并列举一些常用的SVM分类器的变形和扩展。

2.2 三维数据的表示和处理在这一部分中,将探讨如何在Matlab中表示和处理三维数据。

首先,会介绍三维数据的基本概念和特点,以及在实际应用中的重要性。

然后,会详细介绍在Matlab中如何使用矩阵和数组表示三维数据,并介绍一些常用的数据结构和操作。

matlab svm多分类算法 -回复

matlab svm多分类算法-回复SVM (Support Vector Machine) 是一种常用的机器学习算法,在多分类问题中也可以被应用。

本文将以中括号内的内容为主题,一步一步回答关于Matlab 中SVM 多分类算法的问题。

一、什么是SVM 多分类算法?SVM 多分类算法是基于SVM 原理的一种分类器,它可以将输入的数据样本分为多个不同的类别。

SVM 多分类算法通过构建多个二分类问题的模型,来实现多分类任务。

简单来说,就是将多个二分类器结合起来,从而实现多分类的功能。

二、如何在Matlab 中使用SVM 多分类算法?在Matlab 中,可以使用内置的函数fitcecoc() 来实现SVM 多分类算法。

fitcecoc() 函数是一种通过Error-Correcting Output Codes (ECOC) 方法来训练多类SVM 的工具。

下面是一步一步的操作指南。

1. 准备数据:首先,我们需要准备用于训练和测试的数据。

这些数据应该包括输入特征和对应的类别标签。

可以使用Matlab 中的数据文件、数据集或自己创建的数据来进行训练和测试。

2. 设置参数:在使用SVM 多分类算法之前,需要设置一些参数。

例如,你可以选择SVM 的核函数类型、调整正则化参数等。

你可以在fitcecoc() 函数中根据实际情况进行相应的参数设置。

3. 划分数据集:为了评估模型的性能,我们需要将数据集划分为训练集和测试集。

可以使用crossvalind() 函数将数据集划分为K 个子集,其中K 为你选择的子集个数。

4. 训练模型:接下来,使用fitcecoc() 函数对训练集进行训练,得到一个多分类器。

5. 测试模型:然后,使用训练好的模型对测试集进行预测,并与真实的标签进行比较,以评估模型的性能。

可以使用predict() 函数来进行预测,并使用confusionmat() 函数生成混淆矩阵,以评估模型的分类准确度。

SVM算法原理及其Matlab应用

SVM算法原理及其Matlab应用支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,它在分类和回归问题中都有广泛的应用。

本文将介绍SVM算法的原理,并探讨其在Matlab中的应用。

一、SVM算法原理SVM算法的核心思想是通过在特征空间中找到一个最优的超平面,将不同类别的样本分开。

其基本原理可以归结为以下几个关键步骤:1. 数据预处理:首先,需要对数据进行预处理,包括数据清洗、特征选择和特征缩放等。

这一步骤的目的是将原始数据转化为适合SVM算法处理的形式。

2. 特征映射:在某些情况下,数据在原始特征空间中无法线性可分。

为了解决这个问题,可以将数据映射到高维特征空间中,使得数据在新的特征空间中线性可分。

3. 构建超平面:在特征空间中,SVM算法通过构建一个超平面来将不同类别的样本分开。

这个超平面被定义为使得两个类别的间隔最大化的平面。

4. 支持向量:在构建超平面的过程中,SVM算法会选择一些样本点作为支持向量。

这些支持向量是距离超平面最近的样本点,它们对于分类结果的决策起到关键作用。

5. 分类决策:当新的样本点浮现时,SVM算法会根据其在特征空间中的位置,通过计算与超平面的距离来进行分类决策。

距离超平面较近的样本点很可能属于一个类别,而距离较远的样本点则很可能属于另一个类别。

二、SVM在Matlab中的应用Matlab作为一种强大的科学计算软件,提供了丰富的工具箱和函数来支持SVM算法的应用。

下面以一个简单的二分类问题为例,介绍SVM在Matlab中的应用过程。

首先,我们需要准备训练数据和测试数据。

在Matlab中,可以使用内置的数据集,或者自己准备数据。

然后,将数据进行预处理,包括特征选择和特征缩放等。

接下来,使用svmtrain函数来训练SVM模型。

该函数需要输入训练数据和相应的标签,以及一些参数,如核函数类型和惩罚参数等。

训练完成后,可以得到一个训练好的SVM模型。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

SVM整理1各种svm程序包1.1 matlab高级版本中自带的svm函数我现在使用的matlab版本为matlab 7.6.0(R2008a)这个版本中已经自带svm算法,分别为生物信息工具箱(bioinformatics toolbox)中svmclassify函数和svmtrain函数,为上下级关系。

SVMStruct=svmtrain(Training,Group)%svmtrain的输入为样本点training和样本的分类情况group,输出为一个分类器svmstruct.核函数,核参数,和计算方法等都是可选的,如SVMStruct = svmtrain(…, ‘Kernel_Function’, Kernel_FunctionValue, …)但是切记切记一定要成对出现。

然后,将分类器和testing sample带入svmclassify中,可以得到分类结果和准确度。

举个例子svmStruct=svmtrain(data(train,:),groups(train),’Kernel_Function’,'rbf’,'Kernel_FunctionValue’,’5′,’showplot’,true);%用了核宽为5的径向基核,且要求作图%这里我觉得原作者的写法有误,应该是svmStruct = svmtrain(data(train,:),groups(train),...'Kernel_Function','rbf','RBF_Sigma',5,'showplot',true);classes = svmclassify(svmStruct,data(test,:),’showplot’,true);%要求输出检测样本点的分类结果,且画图表示。

tip 1: 有归一化scale功能,可以通过调参数实现tip 2: 计算方法可选qp,smo,lstip 3: 有个关于soft margin的盒子条件,我不太明白是干嘛的,谁懂得话,就给我讲讲哈tip 4: 画出来的图很难看to sum up: 挺好的1.2较早使用的工具箱SVM and Kernel Methods Matlab Toolbox2005年法国人写的,最近的更新为20/02/2008下载的地址为http://asi.insa-rouen.fr/enseignants/~arakotom/toolbox/index.html这是我最早开始用的一个工具箱,我很喜欢,到现在还是,对于svm的初学者是个很好的toolbox.有详细的说明和很多的demo和例子,包含现今几乎所有的有关svm的成熟算法和数据预处理方法(pca及小波等)。

最最重要的是有回归!!!且函数简单,容易改动延伸。

最近我在弄模糊支持向量机,弄不出来,折腾的快死人了,那天突然发现其实在这个包的一个程序中改动下就可以达到模糊的效果了,开心啊。

且有多分类且画出来的图好看。

强烈推荐说下包中最重要的几个函数svmreg svmclass svmval其中,svmreg和svmclass的功能分别为训练出回归函数和分类器Svmval将回归函数或分类器带入,对新样本点进行估计1.3最富盛名的libsvm本文来自: 高校自动化网() 详细出处参考(转载请保留本链接):/html/matlab/15830.html业界很有名的一个包,主要是有各种各样的借口,现在最新的到python主页及下载地址:.tw/~cjlin/libsvm/但是,说实话呢,我真是用的不怎么上手首先,实在是不怎么好篡改其次,参数调起来挺麻烦。

但是有很详细的guide book 和例子且主页上的例子很生动,随便点几下,就可以看到分类器产生的过程和效果。

业界用的非常多,应该svm在应用领域影响力最大的一个包了据说(according to 诺,井博士)linux下非常非常好使。

1.4 osu-svm matlab toolbox下载地址:/projects/svm/觉得和libsvm没什么太大的差别有多分类且可以生成个阶梯图,我觉得这种图要比普通的分类平面图好些,好像可以看到更多的信息。

、1.5 spider machine learning matlab toolbox主页:/projects/svm/那个是相当cool~啊包括了迄今为止较为常用的machine learning algorithms还有无监督的一些算法,如谱聚类我研究了一小下,不太好篡改,但是很好用,我做多分类是就用了这个包,效果不好,但是挺好调整本文来自: 高校自动化网() 详细出处参考(转载请保留本链接):/html/matlab/15830_2.html1.6 svc(注意版本)包已经解压到文件夹F:\R2009b\toolbox\svmmatlab中SVM工具箱的使用方法1,下载SVM工具箱:/faculty/chzheng/bishe/indexfiles/indexl.htm2,安装到matlab文件夹中1)将下载的SVM工具箱的文件夹放在\matlab71\toolbox\下2)打开matlab->File->Set Path中添加SVM工具箱的文件夹现在,就成功的添加成功了.可以测试一下:在matlab中输入which svcoutput 回车,如果可以正确显示路径,就证明添加成功了,例如:C:\Program Files\MATLAB71\toolbox\svm\svcoutput.m3,用SVM做分类的使用方法1)在matlab中输入必要的参数:X,Y,ker,C,p1,p2我做的测试中取的数据为:N = 50;n=2*N;randn('state',6);x1 = randn(2,N)y1 = ones(1,N);x2 = 5+randn(2,N);y2 = -ones(1,N);figure;plot(x1(1,:),x1(2,:),'bx',x2(1,:),x2(2,:),'k.');axis([-3 8 -3 8]);title('C-SVC')hold on;X1 = [x1,x2];Y1 = [y1,y2];X=X1';Y=Y1';其中,X是100*2的矩阵,Y是100*1的矩阵C=Inf;ker='linear';global p1 p2p1=3;p2=1;然后,在matlab中输入:[nsv alpha bias] = svc(X,Y,ker,C),回车之后,会显示:Support Vector Classification_____________________________Constructing ...Optimising ...Execution time: 1.9 secondsStatus : OPTIMAL_SOLUTION|w0|^2 : 0.418414Margin : 3.091912Sum alpha : 0.418414Support Vectors : 3 (3.0%)nsv =3alpha =0.00000.00000.00000.00000.00002)输入预测函数,可以得到与预想的分类结果进行比较.输入:predictedY = svcoutput(X,Y,X,ker,alpha,bias),回车后得到:predictedY =1111111113)画图输入:svcplot(X,Y,ker,alpha,bias),回车补充:X和Y为数据,m*n:m为样本数,n为特征向量数比如:取20组训练数据X,10组有故障,10组无故障的,每个训练数据有13个特征参数,则m=20,n=13Y为20*1的矩阵,其中,10组为1,10组为-1.对于测试数据中,如果取6组测试数据,3组有故障,3组无故障的,则m=6,n=13Y中,m=6,n=1/SVM_soft.html2 原理详解2.1 SVM.ppt2.2 陆振波的SVM的MATLAB代码的解释%构造训练样本n = 50;randn('state',6);x1 = randn(2,n); %2行N列矩阵y1 = ones(1,n); %1*N个1x2 = 5+randn(2,n); %2*N矩阵y2 = -ones(1,n); %1*N个-1figure;plot(x1(1,:),x1(2,:),'bx',x2(1,:),x2(2,:),'k.');%x1(1,:)为x1的第一行,x1(2,:)为x1的第二行axis([-3 8 -3 8]);title('C-SVC')hold on;X = [x1,x2]; %训练样本d*n矩阵,n为样本个数,d为特征向量个数Y = [y1,y2]; %训练目标1*n矩阵,n为样本个数,值为+1或-1%训练支持向量机function svm = svmTrain(svmType,X,Y,ker,p1,p2)options = optimset; % Options是用来控制算法的选项参数的向量rgeScale = 'off';options.Display = 'off';switch svmTypecase 'svc_c',C = p1;n = length(Y);H = (Y'*Y).*kernel(ker,X,X);f = -ones(n,1); %f 为1*n 个-1,f 相当于Quadprog 函数中的c A = []; b = [];Aeq = Y; %相当于Quadprog 函数中的A1,b1 beq = 0;lb = zeros(n,1); %相当于Quadprog 函数中的LB ,UB ub = C*ones(n,1);a0 = zeros(n,1); % a0是解的初始近似值[a,fval,eXitflag,output,lambda] = quadprog(H,f,A,b,Aeq,beq,lb,ub,a0,options); %a 是输出变量,它是问题的解% Fval 是目标函数在解a 处的值 % Exitflag>0,则程序收敛于解x Exitflag=0,则函数的计算达到了最大次数 Exitflag<0,则问题无可行解,或程序运行失败% Output 输出程序运行的某些信息 %Lambda 为在解a 处的值Lagrange 乘子%支持向量机的数学表达式:()()Cy st X X K y y W i i li i j i j i j lj i i li i ≤≤=+-=∑∑∑===αααααα00:,21min 11,1(i=1 to L)Quadprog 函数:cx Hx x T+21minSt:()()()有界约束等式约束不等式约束UB x LB b x A b Ax ≤≤=≤11 因此,H = (Y'*Y).*kernel(ker,X,X)支持向量机的数学表达式中的最优解为T l),...,(***1ααα=,∑==li ii i x y W 1**α,)2/()*(*1*1*∑∑==-=i y i li i i x W B αα%寻找支持向量 a = svm.a;epsilon = 1e-8;i_sv = find(abs(a)>epsilon); %0<a<a(max)则认为x 为支持向量 plot(X(1,i_sv),X(2,i_sv),'ro');%构造测试数本[x1,x2] = meshgrid(-2:0.05:7,-2:0.05:7); %x1和x2都是181*181的矩阵 [rows,cols] = size(x1); %M=size(x1,1):返回x 数组的行数181 %N=size(x1,2):返回x 数组的列数181nt = rows*cols; Xt = [reshape(x1,1,nt);reshape(x2,1,nt)];%reshape(x1,1,nt)是将x1转成1*(181*181)的矩阵;所以Xt 是一个2*(181*181)的矩阵%测试输出tmp = (a.*Y)*kernel(ker,X,X(:,i_sv)); %∑==li i i i x X K y a tmp 1*),(b = 1./Y(i_sv)-tmp;b = mean(b); %∑=-=li j i i i x x K yi y b 1*),(αtmp = (a.*Y)*kernel(ker,X,Xt); %∑==li i i i x X K y a tmp 1*),( Xt 是要进行判别Yd = sign(tmp+b); %}),(sgn{)(1*∑=+=li i i i b X x K a y x f%分界面Yd = reshape(Yd,rows,cols)contour(x1,x2,Yd,[0 0],'m'); % Contour 函数:曲面的等高线图2.3 svm自己实现在当前数据挖掘和机器学习领域,最为热门的话题莫过于SVM和Boosting方法了。