多处理机系统介绍(翻译)

多核CPU与多处理机分解

分的受保护的内存空间。

13121507张文杰

流水线

译码级有一些略微的修改。 不同于以往处理器仅仅译码指令指针指向的指令, 现今的处理器(2008-2013 年)每个时钟周期最多 可以译码 4 条指令。 寄存器重命名(register aliasing) 在处理器内部,这些原始的寄存器(如 AX,BX,CX,DX 等)被翻译(或者重命名)成为内部 的寄存器,而这些寄存器对程序员是不可见的。寄存 器和内存地址需要被映射到一个临时的地方用于指令 执行。当前每个始终周期可以翻译 4 条微指令。 重排序缓存(Reorder Buffer, ROB) ROB 可以存储最多 128 条微指令。在支持超线程 的处理器上,ROB 同样可以重排来自两个虚拟处理器 的指令。两个虚拟处理器在 ROB 中将微指令汇集到 一个共享的乱序执行部件中。

13122711胡红青

两者的比较

这就像为什么我们要去公司上班而不是在家里上 班一样。去公司上班(多核CPU)的话,资源共 享(共享缓存),沟通方便(CPU内数据传输速 度远大于总线速度)。 但是如果信息技术(类比总线)上有突破性进展, 否则我们还是每天要挤公车去公司上班。

13122711胡红青

形象的任务目标:你需要搬很多砖,你现在有一百支手。 实际的任务目标: 你有一个很大的计算任务,你有很多cpu。

13121507张文杰

02 简谈进程、线程、多机、内核、流水线

16组

13121507张文杰

专业定义

操作系统中的进程是指特定的代码序列在指 定的数据集合上的一次执行活动,是指并行 程序的一次执行过程,在Windows系统中就 是一个EXE文件。 计算机上运行的可执行文件对特定的输入数 据的一个实例。 进程=PCB(进程控制块)+程序段+数据

专业英语 缩写翻译

ABI 应用二进制接口(Application Binary Interface)ACSI 国家信息化咨询委员会(advisory committee for state informatization)ADSL 非对称数字用户线路(Asymmetric Digital Subscriber Line)AI 人工智能(artificial intelligence)AMPS 高级移动电话系统(Advanced Mobile Phone System)API 应用程序接口(Application Programming Interface)ASIC 特定用途集成电路(Application Specific Integrated Circuit)ASTM 美国试验材料学会(American Society for Testing Material)AT&T 美国电话电报公司(American Telephone and Telegraph Company)ATM 异步传输模式(Asynchronous Transfer Mode)ATOS Origin 源讯公司Auto-ID 自动识别(Auto-ID)AWS 美国航空气象处(Air Weather Service);BAP 基本汇编程序(Basic Assembler Program)BGA 集成电路采用有机载板的一种封装法BOINC 伯克利开放式网络计算 (Berkeley Open Infrastructure For Network Computing ) BSP 板级支持包(Board Support Package)Business Processing 业务处理流程CaaS 通信即服务(communication as a Service)CAN 控制器局域网络(Controller Area Network)CAS 中国科学院(Chinese Academy of SciencesCCTV 中国中央电视台(China Central Television)CDMA2000 电信移动通信系统CIP 预编目录(cataloging in publication)CITYNET 城市间合作网络CMU 卡内基梅隆大学(Carnegie Mellon University)CN 通信网络(Communicating Net)CPU 中央处理机(Central Processing Unit)CRA 应答验证 (challenge-response authentication)DARPA 美国国防部高级研究计划局(Defense Advanced Research Projects Agency)DARPA 研究计划署(Defense Advanced Research Projects Agency)DASH7Data mining 数据挖掘技术(即指从资料中发掘资讯或知识)DDoS 分布式拒绝服务(Distributed Denial of Service)DG INFSO 媒体总司DG INFSO/D4 欧盟委员会DGINFSO‐D4DMM 分布式内存多处理器(distributed memory multiprocessor)DNS 域名服务器(Domain Name Server)DoD 美国国防部(Department of Defense of the United States)DRAM 动态随机存取存储器(Dynamic Random Access Memory)DSL 数字用户线路(Digital Subscriber Line)DSP 数字信号处理器(Digital Signal Processor)DSS 决策支持系统(Decision Support Systems)DynDNS 动态DNSEAN 欧洲商品编码(Europ Article Number)EAS 电子防窃系统(Electronic Article Surveillance)ECMA 欧洲电脑制造商协会(European Computer Manufactures Association)EPC 电子产品代码(Electronic Product Code)EPCglobal 国际物品编码协会EAN和美国统一代码委员会( UCC )的一个合资公司ERP 企业资源计划(Enterprise Resource Planning)ETSI 欧洲电信标准协会(European Telecommunication Standards Institute)EU-funded CASAGRAS1 coordination 欧盟资助CASAGRAS1协调FAT 文件分配表(File Allocation Table)FP7 欧盟第七框架计划(Framework Program 7)FreeOTFE 免费实时加密FSTC 金融服务技术联盟(Financial Services Technology Consortium)FTP 文件传输协议(File Transfer Protocol)GM 通用汽车公司(General Motors)GMSA 全球移动通信系统协会(global system for mobile communications association) GPRS 通用分组无线业务(General Packet Radio Service)GPS 全球定位系统(Global Position System)GSM 全球移动通信系统(Global System for Mobile Communications)GUI-based 图形用户界面HP 惠普公司HTML5 HTML5是HTML下一个的主要修订版本,现在仍处于发展阶段HTTP 超文本传输协议(Hyper Text Transport Protocol)HTTPS 安全超文本传输协议(Hypertext Transfer Protocol Secure)I²C 两线式串行总线(Inter-Integrated Circuit)IaaS 架构即服务(Infrastructure As A Service)IATA 国际航空运输协会(International Air Transport Association)ICC 集成电路卡(integrated circuit card)ICT 集成电路计算机遥测技术(Integrated Computer Telemetry)iDA 资讯通信发展管理局(infocomm Development Authority)IEC 国际电工技术委员会(International Electrotechnical Commission)IEEE 电气与电子工程师协会(Institute of Electrical and Electronic Engineers)IETF Internet工程任务组(Internet Engineering Task Force)IMT-2000 国际移动电话系统-2000(International Mobile Telecom System-2000)IOT 物联网(Internet Of Things)IPSec 网际协议安全(Internet Protocol Security)IPSO 因特网协议安全选件(Internet protocol security option )IPv4 IPv4,是互联网协议(Internet Protocol,IP)的第四版IR 指令寄存器(instruction register)ISA 工业标准总线(Industry Standard Architecture)ISM 美国供应管理协会(the Institute for Supply Management , ISM)ISO 国际标准化组织(International Standardization Organization)ISTAG IST咨询集团(IST advisory group)IT 信息技术(Information Technology)ITSO_LtdITU 国际电信联盟(International Telecommunication Union)KAEC 阿卜杜拉国王经济城(King Abdullah Economic City)KVM 基于内核的虚拟机(K Virtual Machine)LAN 局域网(local area network)LCD 液晶显示屏(liquid crystal display)LR-WPAN 低速率无线个人区域网络(Low Rate-Wireless Personal Area Network)LSI 大规模集成电路(Large Scale Integrated circuit)MAC 多路存取计算机(Multi-Access Computer)MAN 城域网(Metropolitan Area Network)MASDAR 马斯达尔MEMS 微电子机械系统(Micro-electromechanical Systems)METI 日本经济贸易产业省(Ministry of Economy, Trade and Industry)MIC 部门内部事务和通讯(the ministry of internal affairs and communications) MIT 麻省理工学院(Massachu-setts Institute of Technology);MPP 大量信息并行处理机,大规模并行处理机(Massively Parallel Processor)MRI 核磁共振成像(Magnatic Resonance Imaging);MSI 中规模集成电路(medium-scale integration)MVNO AdicaNaaS 网络即服务(Network As A Service)NASA 美国国家航空和宇宙航行局(National Aeronautics and Space Administration)NetBSD 一个免费的,具有高度移植性的UNIX-like操作系统NFC 近场通讯(Near Field Communication)NFCIPNIC 网络接口卡(Network Interface Card)NMT 北欧移动电话(Nordic Mobile Telephone)NSF (美国)国家科学基金会(National Science Foundation)NTT DoCoMo 移动通信网公司NYU 纽约大学(New York University)OLED 有机发光二极管(Organic Light Emitting Diode)ONS 国家统计局(Office For National Statistics)P2P 点对点技术(peer-to-peer);PaaS 平台即服务(Platform As A Service)PARC 帕洛阿尔托研究中心(Palo Alto Research Center)PC 个人电脑(Personal Computer);PCI 外部控制器接口(Peripheral Component Interconnect)PHY 物理层协议(Physical Layer)PKI 公钥基础设施(Public Key Infrastructure)POTS 普通老式电话服务(Plain Old Telephone Service)QNX 嵌入式实时操作系统(Quick Unix )R&D 研发(Research & Development)RACO 德国雷科resPONDER 响应器RFID 无线射频识别(radio frequency identification devices)RISC 精简指令集计算机(Reduced Instruction-Set Computer)ROM 只读存储器(read only memory)RS-232 串行数据通信的接口标准RTOS 实时操作系统(Real Time Operating System)SaaS 软件即服务(Software as a Service)SAP SAP是目前全世界排名第一的ERP软件SAVVIS 维斯公司SCADA 监测控制和数据采集(supervisory control and data acquisition)SIM 用户身份识别卡(subscriber identity module)SIMD 单指令多数据(Single Instruction Multiple Data)SIMIT 中国科学院上海微系统与信息技术研究所SMP 对称多处理机(SymmetricalMulti-Processing)SOC 片上系统(System on a Chip)SPOM 自动程序单芯片微处理(Self Programmable One Chip Microprocessor)SPT 季票 (season parking ticket)SRI 斯坦福研究院(Stanford Research Institute)SSE 单指令多数据流式扩展 ( streaming SIMD extensions)SSI 小规模集成(电路)(Small Scale Integration);SSO 单点登录(single sign-on)T2TITTACS 全接入通信系统(Total Access Communication System)TCB 可信计算基(Trusted Computing Base)TCP/IP 传输控制/网络通讯协定(Transmission Control Protocol / Internet Protocol)TD-SCDMA 即时分同步的码分多址技术(Time Division-Synchronization Code Division Multiple Access)TEDS 传感器电子数据表(Transducer Electronic Data Sheet)TLS/SSL SSL(Secure Sockets Layer,安全套接层)TPANSmitterTRON 实时操作系统核心程序(The Realtime Operating System Nucleus)U.S.Department of Defence 美国国防部UCC 统一编码委员会(uniform code council inc)UCLA 加州大学洛杉矶分校(University of California at Los Angeles)UHF 超高频(Ultra High Frequency)UML 统一建模语言(Unified Modeling Language)UNL 无处不在的网络实验室(ubiquitous networking laboratory)USAID 美国国际开发署(United States Agency for International Development)USB 通用串行总线(Universal Serial Bus)USDA 美国农业部(United States Department of Agriculture)VLSI 超大规模积体电路(Very Large Scale Integrated Circuites)VNP-VNOWAN 广域网(Wide Area Network)WCDMA 宽带码分多址移动通信系统(Wideband Code Division Multiple Access)Wi-Fi 无线上网技术WROM 一次写/读很多内存(write once/read many memory)WSN 无线传感网络(wireless sensor network)。

单片机介绍中英文

附件1:外文资料翻译译文单片机介绍单片机也被称为微控制器(Microcontroller Unit),常用英文字母的缩写MCU表示单片机,它最早是被用在工业控制领域。

单片机由芯片内仅有CPU的专用处理器发展而来。

最早的设计理念是通过将大量外围设备和CPU集成在一个芯片中,使计算机系统更小,更容易集成进复杂的而对体积要求严格的控制设备当中。

INTEL的Z80是最早按照这种思想设计出的处理器,从此以后,单片机和专用处理器的发展便分道扬镳。

早期的单片机都是8位或4位的。

其中最成功的是INTEL的8031,因为简单可靠而性能不错获得了很大的好评。

此后在8031上发展出了MCS51系列单片机系统。

基于这一系统的单片机系统直到现在还在广泛使用。

随着工业控制领域要求的提高,开始出现了16位单片机,但因为性价比不理想并未得到很广泛的应用。

90年代后随着消费电子产品大发展,单片机技术得到了巨大提高。

随着INTEL i960系列特别是后来的ARM系列的广泛应用,32位单片机迅速取代16位单片机的高端地位,并且进入主流市场。

而传统的8位单片机的性能也得到了飞速提高,处理能力比起80年代提高了数百倍。

目前,高端的32位单片机主频已经超过300MHz,性能直追90年代中期的专用处理器,而普通的型号出厂价格跌落至1美元,最高端[1]的型号也只有10美元。

当代单片机系统已经不再只在裸机环境下开发和使用,大量专用的嵌入式操作系统被广泛应用在全系列的单片机上。

而在作为掌上电脑和手机核心处理的高端单片机甚至可以直接使用专用的Windows和Linux操作系统。

单片机比专用处理器更适合应用于嵌入式系统,因此它得到了最多的应用。

事实上单片机是世界上数量最多的计算机。

现代人类生活中所用的几乎每件电子和机械产品中都会集成有单片机。

手机、电话、计算器、家用电器、电子玩具、掌上电脑以及鼠标等电脑配件中都配有1-2部单片机。

而个人电脑中也会有为数不少的单片机在工作。

CPU的英文全称Central Processing Unit

CPU专题CPU的英文全称Central Processing Unit,中文名称即中央处理单元,也称为微处理器.中央处理器(Central Processing Unit,简写为CPU)的结构,CPU是决定电脑性能的核心部件。

CPU即中央处理单元,是英文Central Processing Unit 的缩写,是整个系统的核心,也是整个系统最高的执行单位。

它负责整个系统指令的执行,数学与逻辑的运算,数据的存储与传送,以及对内对外输入与输出的控制。

在向大家介绍CPU详细的情形之前,务必要让大家弄清楚到底CPU是什么?它到底有那些重要的性能指标呢?CPU的英文全称是Central Processing Unit,我们翻译成中文也就是中央处理器。

CPU(微型机系统)从雏形出现到发壮大的今天(下文会有交代),由于制造技术的越来越现今,在其中所集成的电子元件也越来越多,上万个,甚至是上百万个微型的晶体管构成了CPU的内部结构。

那么这上百万个晶体管是如何工作的呢?看上去似乎很深奥,其实只要归纳起来稍加分析就会一目了然的,CPU的内部结构可分为控制单元,逻辑单元和存储单元三大部分。

CPU的工作原理就象一个工厂对产品的加工过程:进入工厂的原料(指令),经过物资分配部门(控制单元)的调度分配,被送往生产线(逻辑运算单元),生产出成品(处理后的数据)后,再存储在仓库(存储器)中,最后等着拿到市场上去卖(交由应用程序使用)。

CPU作为是整个微机系统的核心,它往往是各种档次微机的代名词,如往日的286、386、486,到今日的奔腾、奔腾二、K6等等,CPU的性能大致上也就反映出了它所配置的那部微机的性能,因此它的性能指标十分重要。

在这里我们向大家简单介绍一些CPU主要的性能指标:第一、主频,倍频,外频。

经常听别人说:“这个CPU的频率是多少多少。

”其实这个泛指的频率是指CPU的主频,主频也就是CPU的时钟频率,英文全称:CPU Clock Speed,简单地说也就是CPU运算时的工作频率。

Nucleus 操作系统内部参考手册介绍

第一章 介绍

这章描述了该手册的目的,提供了 Nucleus PLUS 内核的概述及它的结构。 章节 1.1 手册的目的 1.2 关于 Nucleus PLUS 1.3 Nucleus PLUS 的结构

2.2 组件组成

软件组成部分包含文件:数据类型的定义和常量文件,外部接口文件,一个或更多的 c 和汇编文件。具体文件如下列表: 文件名 功能说明 备注 XX_DEFS.H 定义常量和数据结构 XX_EXTR.H 定义外部接口,是按照原形函数定义的 XXD.C 定义静态和全局数据结构 XXI..C 定义组件的初始化函数 XXF.C 该文件的常量函数,提供对象的静态信息 XXC.C 包含组件的核心函数 XXCE.C 包含对核心函数错误检测的外壳函数 XXS.C 定义补充的函数 XXSE.C 定义查错函数 注:xx 代表组件名的两个字母。每个组件不必每种文件类型都有。 格式 所有的软件代码文件都有相同的基本格式。文件的第一部分包含了标题的通用信息,作为 序言调用的开端。第二部分包含了专用于内部数据声明和内部函数的说明。剩下的部分包含 了文件的实际函数。 序言 序言的目的用于描述文件的目录。 与 ATI 的自己的文件相关联,并提供了文件修订版的相 关信息。 一个序言格式例子,如下所示:

第二章 工具约定

2.1 组件 2.2 组件组成 格式 序言 序言之后 文件其他部分 2.3 命名约定 组件命名 #define 命名 结构体命名 Typedef 命名 结构体成员命名 全局变量命名 局部变量命名 函数命名 2.4 缩进 2.5 注释

第三章 软件概述

3.1 基本用法 操作模式 应用初始化 包含文件 3.2 数据类型 3.3 服务调用映像

使用AI技术进行机器翻译的步骤与技巧

使用AI技术进行机器翻译的步骤与技巧随着人工智能(AI)的快速发展,机器翻译已经成为一项受到广泛关注的技术。

通过利用强大的计算能力和大数据分析,AI可以在较短时间内完成大量文本的翻译工作。

本文将介绍使用AI技术进行机器翻译的步骤与技巧。

一、收集并准备训练样本为了让AI系统学习并理解不同语言之间的关系,第一步是收集并准备足够数量和多样性的训练样本。

这些样本应该包括各种主题和领域的文章、网页内容以及其他相关文本资料。

这样做可以确保AI系统具备泛化能力,并能够应对各种实际翻译任务。

二、构建机器翻译模型在拥有足够训练数据后,下一步是构建一个机器翻译模型。

通常情况下,基于神经网络的深度学习模型被广泛应用于机器翻译领域。

这种模型可以通过多层次处理来提取输入文本中隐藏信息,进而生成目标语言的输出结果。

三、训练机器翻译模型训练机器翻译模型需要大量的计算资源和时间。

在这一过程中,AI系统会根据输入的训练样本逐步调整自己的参数,以最大程度地提高翻译准确度。

在迭代的过程中,可以使用一些优化方法来加快训练速度,例如批量梯度下降算法或Adam优化器等。

四、处理长句和复杂结构在进行机器翻译时,经常会遇到一些长句子或复杂结构。

为了提高准确性,可以采取以下策略:首先,在输入之前对句子进行分段处理,并在段落之间建立联系;其次,针对复杂结构设计特定的处理规则,例如将从句分解为简单短语进行独立翻译。

五、引入语境信息为了更好地理解输入文本并生成更准确的翻译结果,加入语境信息是非常重要的。

通过引入上下文信息或先前翻译的片段,AI系统可以更好地理解当前待翻译句子所处的语义环境,并做出相应调整。

这种技巧能够提高机器翻译的连贯性和准确度。

六、后处理和编辑尽管AI系统在机器翻译方面取得了巨大进展,但人工编辑仍然是确保最终翻译结果质量的关键环节。

在完成机器翻译后,人工编辑可以对文本进行校对,修复可能存在的语法错误或意义不符情况,并调整句子结构以提高自然度。

计算机系统的基础知识

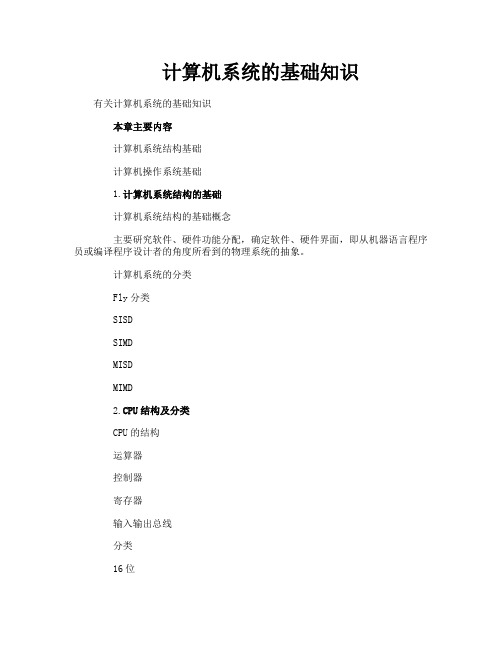

计算机系统的基础知识有关计算机系统的基础知识本章主要内容计算机系统结构基础计算机操作系统基础1.计算机系统结构的基础计算机系统结构的基础概念主要研究软件、硬件功能分配,确定软件、硬件界面,即从机器语言程序员或编译程序设计者的角度所看到的物理系统的抽象。

计算机系统的分类Fly分类SISDSIMDMISDMIMD2.CPU结构及分类CPU的结构运算器控制器寄存器输入输出总线分类16位32位64位3.指令系统及其分类指令系统的基础概念指令系统是计算机所有指令的集合。

程序员用各种语言编写的程序都有翻译成以指令形式表示的机器语言后才能运行,所以指令系统反映了计算机的基本功能,是硬件设计人员和程序员都能看到的机器的主要属性。

分类复杂指令系统(CISC):随着硬件成本的不断下降,软件成本的不断提高,使得人们热衷于在指令系统中增加更多的指令和复杂的指令,来提高操作系统的效率,并尽量缩短指令系统与高级语言的语义差别,以便高级语言的编译和降低软件成本,同时为了保证程序兼容,新的计算机的指令系统只能增加而不能减少,所以就使得指令系统越来越来复杂精简指令系统(RISC):通过简化指令使计算机的结构更加简单合理,从而提高运算速度!RISC的特点及其优缺点4.存储系统的基础知识基本概念存储器主要用于存放计算机的程序和数据,存储器系统指的是存储器硬件设备以及管理该存储器的'软、硬件设备。

对存储器的基本要求是增大容量、提高速度、降低价格。

单一的存储器硬件(主存储器)难以满足要求。

所以就提出了多层次的存储体系结构(即:寄存器---Cache--主存—外存)在计算机中存放当前正在执行的程序以及被程序所使用的数据(包括运算结果)原存储器称为主存储器。

也就是我们所说的内存5.主存储器的种类按读写功能来分:是否需要定期刷新:静态:不停电情况下能长时间保留不变,速度快,但容量小,成本高动态:不停电的情况下也要定期刷新,容量大,成本低,常用在计算机系统中,常见的有:SDRAM、DDR等可读写(RAM)可擦写只读:EPRM(可擦写,用紫外线擦写)EERM(可用电擦写)FLASH(电读写,但只能以块为单位,速度快,成本低,现在最常用)可编程:ERM(通过编程一次性写入)只读:RM(制造时一次性写入)6.存储器容量的扩展位扩展:位扩展是对存储器的位数进行扩充字扩展:是对存储器的容量进行扩展位、字扩展:对位数和容量都进行扩展7.多体交叉存储为了协调存储器与CPU速度的,其工作原理是:将存储器分成几个独立的个体,这样第一次就能进行多个字的数据读写!影响多体交叉效率的因素:多体存储的模值M数据的分布情况较移指令8.Cache的基础知识基本概念在多级存储体系中,Cache处于CPU与存储器之间,其目的是使程序员能使作一个速度与CACHE相当而容量与主存相当的存储器。

通信-通信英语对照翻译

*understand the difference between telecommunications and data communications. 明白远距离通讯和数据通讯的之间的差异性telecommunications:包括了电话技术电报技术还有电视是指有距离的通讯data communications:在计算机信息系统中,数据(data)是以2进位的方式(0或1)来表示而数据通讯则是将资料以(0或1)的型式经由穿传输媒介在两个装置之间交换*be familiar with standards organizations and their duties.熟悉标准的组织和他们的责任1.ISO(国际标准组织) :发展世界性的技术协议,然后发行国际标准2.ITU-T(国际电信联盟标准化部门):制定电子通讯的标准3.ANSI(美国国家标准协会):非营利的私人组织目标在美国提供一致的标准4.IEEE(电机及电子工程师学会):世上最大的职业电机工会监视着发展与融合国际标准来计算和沟通(?)5.EIA(电子工业协会)*Understand the need for a network and distinguish between different network types. 了解网络所需和区别网络的类型.Performance reliability security我们要了解网络的是整体效率、可靠度和安全性.网络的类型::*Understand the difference between a protocol and a standard.了解protocol和standard的不同.Protocol: 在终端机或电上的软硬件界面,集允许经由通讯网路传送信号并形成通讯语言Standard: 在工程和技术上用于规定项目、材料、方式、设计或工程实践所用的标准格式.*list the component of a data communications system.列出构成数据通讯系统的要素1.message: 可被沟通的讯息,如文字,数字,图片,声音,视讯或者上述的综合体2.sender: 传送讯息的设备,如:计算机,工作站,电话,等等.3.receiver: 接收讯息的设备,如:计算机,电视,工作站,电话,等等4.medium: 传送媒介,是指讯息重传送端到接收端之间的实体路径,如:双绞线,雷射,无线电波,同轴电缆,,光纤5.protocol:协定:一种管理数据通讯的公用规则,少了它传送端和接收端可能会无法了解彼此的讯息为何~*understand the duties of the layers in the OSI model.明白OSI模型各层的任务1.实体层(Physical Layer):1.传输信息的介质规格2.将数据以实体呈现并传输的规格3.接头的规格2.链接层(Data-Link Layer):包含3项:1.同步2.侦错3.制定媒体存取的控制的方法3.网络层(Network Layer):包含2项:1.寻址2.选择传输路径4.传输层(Transport Layer)工作包含3项:1.编定序号2.控制数据流量3.侦错与错误处理.5.会议层(Session Layer)负责通讯的双方在正式开始传输前的沟通,目的在于建立莉传输时所遵循的的规则,使传输更顺畅更有效率.6.表现层(Presentation Layer):包含3项:1.内码转换2.压缩与解压缩3.加密与解密7.应用层(Application Layer)直接提供档案传输,电子邮件,网页浏览等服务给使用者.在实作上,大多化身为成套的应用程序*Understand the duties of the layers in the Internet model了解因特网模式各层的职责第四层:应用层,定义应用程序如何提供服务.第三层:传输层,负责传输过程的流量控制、错误处理、资料重送等工作.第二层:网络层,决定数据如何传送到目的地.第一层:连结层,负责对硬件的沟通.*Be able to compare the layers in the OSI and Internet model.能够比较OSI模式和因特网模式.Internet model的应用层相当于OSI model的第5、6、7三层Internet model的连结层相当于OSI model的第1、2二层Internet model的分工比较粗略,不像OSI model那么精密与周延.Internet model比较简单和有效率, OSI model适合用在学习上,容易分清各层的职责.KEY TREMSAmerican National standards Institute(ANSI): 美国国家标准协会application layer :应用层--osi模型的7层之一直接提供档案传输,电子邮件,网页浏览等服务给使用者.在实作上,大多化身为成套的应用程序ATM Forum:异步传输模式论坛(?)Bit: 位--以二进记数方法表示的一个数字。

计算机系统结构08SIMD计算机(并行处理机)121106

B6700 内存

B6700 CPU

48

48 BIOM 128

CDC

...

DFS

I/O 总线

256 1024

256

IOS

1024

16

实 时 装 置

1.阵列控制器 阵列控制器CU实际是一台小型计算机。 对阵列处理机单元实行控制和完成标量操作。 标量操作与各PE的数组操作可以重叠执行。 控制器的功能有以下五个方面: (1)对指令进行译码,并执行标量指令; (2)向各PE发出执行数组操作指令的控制信号; (3)产生地址,并向所有处理单元广播公共地址; (4)产生数据,并向所有处理单元广播公共数据; (5)接收和处理PE、I/O操作以及B6700产生的陷 阱中断信号。

25

3.文件存储器 (1)计算任务文件从系统管理机家载到文件 存储器,由控制处理机执行。 (2)文件存储器是在BSP直接控制下的唯一 外围设备。 (3)程序执行过程中所产生的暂存文件和输 出文件,在将它们送给系统管理机输出 给用户之前是存在文件存储器中的。 (4)文件存储器的数据传输率较高,大大地 缓解了I/O受限制问题。

14

8.3.1 lllialv并行处理机

(1)1963年,美国西屋电器公司提出“Slotnick,The SOLOMON Compuer,Simultaneous Operation linked Ordinal Modular Network”. (2)1966年美国国防远景研究规划局ARPR与伊利诺 依大学签定合同。原计划:256PE,运算速度为 1GFLOPS。 (3)Burroughs公司和伊利诺依大学于1972年共同设 计和生产,1975年实际投入运行。用了4倍的经 费,只达到1/20的速度。只实现了8*8=64个PE, 只达到50MFLOPS。 (3)llliaclv的影响非常大。它是并行处理机的典型代 表,也是分布存储器并行处理机的典型代表。 15

(完整版)数字信号处理英文文献及翻译

数字信号处理一、导论数字信号处理(DSP)是由一系列的数字或符号来表示这些信号的处理的过程的。

数字信号处理与模拟信号处理属于信号处理领域。

DSP包括子域的音频和语音信号处理,雷达和声纳信号处理,传感器阵列处理,谱估计,统计信号处理,数字图像处理,通信信号处理,生物医学信号处理,地震数据处理等。

由于DSP的目标通常是对连续的真实世界的模拟信号进行测量或滤波,第一步通常是通过使用一个模拟到数字的转换器将信号从模拟信号转化到数字信号。

通常,所需的输出信号却是一个模拟输出信号,因此这就需要一个数字到模拟的转换器。

即使这个过程比模拟处理更复杂的和而且具有离散值,由于数字信号处理的错误检测和校正不易受噪声影响,它的稳定性使得它优于许多模拟信号处理的应用(虽然不是全部)。

DSP算法一直是运行在标准的计算机,被称为数字信号处理器(DSP)的专用处理器或在专用硬件如特殊应用集成电路(ASIC)。

目前有用于数字信号处理的附加技术包括更强大的通用微处理器,现场可编程门阵列(FPGA),数字信号控制器(大多为工业应用,如电机控制)和流处理器和其他相关技术。

在数字信号处理过程中,工程师通常研究数字信号的以下领域:时间域(一维信号),空间域(多维信号),频率域,域和小波域的自相关。

他们选择在哪个领域过程中的一个信号,做一个明智的猜测(或通过尝试不同的可能性)作为该域的最佳代表的信号的本质特征。

从测量装置对样品序列产生一个时间或空间域表示,而离散傅立叶变换产生的频谱的频率域信息。

自相关的定义是互相关的信号本身在不同时间间隔的时间或空间的相关情况。

二、信号采样随着计算机的应用越来越多地使用,数字信号处理的需要也增加了。

为了在计算机上使用一个模拟信号的计算机,它上面必须使用模拟到数字的转换器(ADC)使其数字化。

采样通常分两阶段进行,离散化和量化。

在离散化阶段,信号的空间被划分成等价类和量化是通过一组有限的具有代表性的信号值来代替信号近似值。

计算机系统知识

硬件

硬件系统主要由中央处理器、存储器、输入输出控制系统和各种外部设备组成。中央处理器是对信息进行高速运算处理的主要部件,其处理速度最高可达每秒几亿次操作。存储器用于存储程序、数据和文件,常由快速的主存储器(容量可达数百兆字节)和慢速海量辅助存储器(容量可达 1011字节以上)组成。各种输入输出外部设备是人机间的信息转换器,由输入-输出控制系统管理外部设备与主存储器(中央处理器)之间的信息交换。

中文名称:计算机系统 英文名称:computer system 定义:由一台或多台计算机和相关软件组成并完成某种功能的系统。 应用学科:机械工程(一级学科);工业自动化仪表与系统(二级学科);自动控制器及系统-自动控制系统(三级学科

计算机系统由计算机硬件和软件两部分组成。硬件包括中央处理机、存储器和外部设备等;软件是计算机的运行程序和相应的文档。计算机系统 具有接收和存储信息、按程序快速计算和判断并输出处理结果等功能

工作流程

用户使用计算机系统算题的一般流程如图2。①通过系统操作员建立帐号,取得使用权。帐号既用于识别并保护用户的文件(程序和数据),也用于系统自动统计用户使用资源的情况(记帐,付款)。②根据要解决的问题,研究算法,选用合适的语言,编写源程序,同时提供需处理的数据和有关控制信息。③把②的结果在脱机的专用设备上放入软磁盘,建立用户文件(也可在联机终端上进行,直接在辅助存储器中建立文件,此时第四步省去)。④借助软盘机把软盘上用户文件输入计算机,经加工处理,作为一个作业,登记并存入辅助存储器。⑤是要求编译。操作系统把该作业调入主存储器,并调用所选语言的编译程序,进行编译和连接(含所调用的子程序),产生机器可执行的目标程序,存入辅助存储器。⑥要求运算处理。操作系统把目标程序调入主存储器,由中央处理器运算处理,结果再存入辅助存储器。⑦运算结果由操作系统按用户要求的格式送外部设备输出。 计算机内部工作(④~⑦)是在操作系统控制下的一个复杂过程。通常,一台计算机中有多个用户作业同时输入,它们由操作系统统一调度,交错运行。但这种调度对用户是透明的,一般用户无需了解其内部细节。 用户可用一台终端,交互式的控制③~⑦的进行(分时方式);也可委托操作员完成③~⑦,其中④~⑦是计算机自动进行的(批处理方式)。批处理方式的自动化程度高,但用户不直观,无中间干预。分时方式用户直观控制,可随时干预纠错,但自动化程度低。现代计算机系统大多提供两种方式,由用户选用。

专业术语缩写翻译

FAMAS Financial And Management Accounting System 金融管理会计系统FAMOS Fast Multi –Tasking Operating System 快速多任务操作系统FAMOS Floating –gate Avalanche injection MOS 浮动栅雪崩注入型金属氧化物半导体FAMS Forecasting and Modeling System 预测与建模系统FAMT Fully Automatic Machine Translation 全自动机器翻译FANET Federal Acquisition NETwork 联邦信息采集网FAP Facial Animation Parameters 面部表情参数〖MPEG〗FAP Failure Analysis Program 故障分析程序FAP File Allocation Problem 文件分配问题FAP Financial Analysis Program 财政分析程序FAP Floating –point Arithmetic Package 浮点运算软件包FAP Format And Protocol 格式与协议FAP FORTRAN Assembly Program Fortran语言的汇编程序FAPRS Federal Assistance Program Retrieval System 联邦辅助程序检索系统FAPS Financial Analysis and Planning System 金融分析与计划系统FaPS File and Print Service 文件和打印服务FAPUSMCEB Frequency Allocation Panel United States Military Communication Electronics Board 美国军事通信电子委员会频率分配小组FAQ Frequently Asked Questions 经常被问及的问题,常见问题解答〖因特网〗.faq 常问问题的文本文件格式〖后缀〗FAQS Fast Queuing System 快速排队系统FAR Facility Request 设备请求FAR Failure Analysis Report 故障分析报告FAR Fault Address Register 故障地址寄存器FAR File Address Register 文件地址寄存器FAR Function Analysis Report 功能分析报告.far 音乐文件格式〖后缀〗FARA Federal Acquisition Reform Act 联邦信息采集改革法案FARNET Federal Academic Research Network 联邦学术研究网FARNET Federation of American Research Networks 美国科研网络联盟FAS Federation of American Scientists 美国科学家联合会FAS Fiber Access System 光纤接入系统FAS Floating –point Arithmetic System 浮点运算系统FAS Frame Alignment Signal 帧对齐信号FASA Federal Acquisition Streamlining Act 联邦信息采集合理化法案FAST Facility for Automatic Sorting and Testing 自动分类测试设备FAST Fast Access Storage Technology 快速访问存储技术FAST Fingerprint Access and Searching Technique 指纹存取与搜索技术FAST Formula And Statement Translator 公式和语句翻译程序FAST Future Automatic Search Traveler 未来自动搜索旅行者技术〖数字护照〗FASTI Fast Access to System Technical Information 快速存取系统技术信息FASTNet Full Automated Switched Telecommunication Network 全自动切换式远程通信网FAT Fast Automatic Transfer 快速自动传送FAT File Allocation Table 文件分配表FAT Formula Assembler Translator 公式汇编程序翻译器FAT32 32 –bit File Allocation Table 32位文件分配表FATAL Fully Automatic Test Algebraic Language 全自动测试代数语言FATDL Frequency And Time Division Data Link 频率和时间分开的数据链路FAW Frame Alignment Word 帧对齐字FAX (Facsimile) 传真(设备,系统,传输).fax 传真文件格式〖后缀〗FB Feedback 反馈FB File Block 文件块FB Fixed Block 固定块FB Flow Block 流程图FB Frame buffer 帧缓冲(器)FBA Facial and Body Animation 面部和身体动作译码器〖MPEG〗FBA Fanned Beam Antenna 扇形束天线FBA Fixed Block Architecture 固定块体系结构FBA Frame Bandwidth Allocation 帧带宽分配FBC File Buffer Count 文件缓冲区计数FBC File Buffered Channel 全缓冲通道FBD Flow Block Diagram 流程块图表FBD Function Block Diagram 功能块图表FBF FeedBack Filter 反馈滤波器FBFM FeedBack Frequency Modulation 反馈调频FBI Federal Bureau of Investigation 联邦调查局FBI Federation of British Industries 英国工业联合会FBI File Bus In 文件输入总线FBM Foreground and Background Monitor 前后台监控程序FBN FeedBack Network 反馈网络FBO File Bus Out 文件总线输出FBOE Frequency Band Of Emission 发射的频带FBRAM Frame Buffer RAM 帧缓冲器随机存取存储器FBT Facility Block Table 设备组表格FBTF Fiber Bundle Transfer Function 光纤束传送功能FC DOS的外部命令:比较两个文件的内容FC Failure Count 故障计数FC Failure Control 故障控制FC False Code 伪码FC Family Computer 任天堂家用机〖模拟器〗FC Feed Count 送纸计数FC Fiber Channel 光纤通道FC Fiber Connector 光纤连接器FC fingers crossed 十指交合〖网语〗FC Firefox Communications “火狐”通信设备公司(美国,出品网关设备)FC Flow Control 流程控制FC Folio Corp. “开卷”公司(美国,出品网络数据库出版工具)FC Font Change 字体改变FC Font Color 字体颜色FC Format Counter 格式计数器FC Frame Control 帧控制FC Frequency Changer 变频器FC Frequency Channel 频道FC Frequency Converter 变频器FC Fresh Copy 最新副本FC Full Client 全功能客户端〖服务器〗FC Functional Code 功能码.fc Harvard Graphics 2.0的拼写检查字典文件格式〖后缀〗FCA Fault Correction Array 故障纠正数组(惠普公司的)FCA File Cylinder Address 文件查找柱形区地址,文件同位标磁道组地址FCA Fixed Channel Allocation 固定通道分配FCA Frequency Conversion Accessory 频率变换辅助设备FCA Functional Configuration Audit 功能配置审查FC-AL Fiber Channel –Arbitrated Loop 光纤通道仲裁环FCB File Control Block 文件控制块FCB Forms Control Block 表单控制块FCB Forms Control Buffer 窗体控制缓冲器(区)FCB Function Control Block 功能控制块FCC Federal Communication Commission 联邦通信委员会(美国)FCC File Carbon Copy 文件复写副本FCC Flight Control Computer 飞行控制计算机FCC Forward Control Channel 前方控制通道FCCH Frequency Correction Channel 频率修正通道FCCN Federal Communication Commission Network 联邦通信委员会网络FCD Facsimile Coded Data 传真编码数据FCD Frequency Compression Demodulator 频率压缩解调器FCDR Failure Cause Data Report 故障原因数据报告FC-EL Fiber Channel Enhanced Loop 光纤通道增强环FCF Facilities Control Form 设备控制形式FCF Facsimile Control Field 传真控制字段FCF File CCW Flags 文件通道命令字标志FCF Frequency Compressive Feedback 频率压缩反馈FCFC First –Character Forms Control 首字符形体控制FCFS First Come First Served 先来先服务FCH File Count High 文件计数高位FCHM Fully Continuous Hidden Markov 完全不间断隐蔽型马尔可夫模型(用于嵌入软件的声音部件)FCI Frame Copied Indicator 帧拷贝指示器FCIF Full Common Intermediate Format 全通用中介格式FCIN Fast Carry Iterative Network 快速进位迭代网络FCL Feedback Control Loop 反馈控制环FCL Feeder Control Logic 馈线控制逻辑FCL File Count Low 文件计数低位FCL Format Control Language 格式控制语言FCLOSE File CLOSE 关闭文件FCM Fast Component Mounter 快速组件安装机FCM Fault Control Module 故障控制模块FCM File Compare Mask 文件比较掩码FCM Firmware Control Memory 固件控制存储器.fcm jlpak10的向前压缩二进制文件批处理文件格式〖后缀〗FCO Fault Control Office 故障控制室FCO Functional Check –Out 功能检查FCodes (Forth bytecodes)向前字节码FCP Federal Cataloging Program 联邦编目程序(美国)FCP File Control Panel 文件控制面板FCP File Control Procedure 文件控制过程FCP File Control Processor 文件控制处理器FCP File Control Program 文件控制程序FCP Firewall Control Protocol 防火墙控制协议FCP Four –Color Printing 四色打印FCP Frequency Comparison Pilot 频率对比向导FCP Fujitsu Computer Products Inc. 富士通计算机产品有限公司(日本,1935年从富士公司分出,出品硬盘、打印机、扫描仪、便携机等)FCP Function Control Package 操作程序包FCPGA Flip –Chip PGA 反转芯片针栅阵列,倒装塑针矩阵〖封装〗ECPU Flexible Central Processing Unit 软性中央处理单元FCS Facsimile Communications System 传真通信系统FCS Facsimile Control System 传真控制系统FCS Fast Circuit Switching 快速线路切换FCS Fiber Channel Standard 光纤通道标准FCS File Control Services 文件控制服务FCS File Control System 文件控制系统FCS First Customer Ship 第一艘顾客船(Sun公司的)FCS Frame Check Sequence 帧检查顺序FCS Frame Check Sum 帧检查概要FCS Frye Computer Systems Inc. 弗赖尔计算机系统公司(美国,出品网络管理设备)FCS Functional Check –Out Set 功能检验设置FCST Federal Council for Science and Technology 联邦科学技术委员会(美国)FCU File Control Unit 文件控制单元FCU Function Conversion Unit 功能转换单元FCW Format Control Word 格式控制字FD Feedback Decoding 反馈译码FD Fiber Duct 光纤管道FD File Definition 文件定义FD File Description 文件描述FD File Directory 文件目录FD Flexible Disk 软盘FD Floppy Disk 软盘FD Floppy Drive 软驱FD Frames Dropped 帧丢失数FD Frequency Diversity 频率差异FD Frequency Divider 分频器FD Frequency Doubler 倍频器FD Full Duplex 全双工FD Function Description 功能描述FD Function Device 功能设备.fd MS Fortran的说明文件格式〖后缀〗.fd DataFlex用于编译程序的域偏移量文件格式〖后缀〗FDA File Data Address 文件数据地址FDACS Floating Decimal Abstract Coding System 浮点十进制抽象编码系统FDB Field Descriptor Block 域描述符数据块FDB File Data Block 文件数据块FDB File Data Buffer 文件数据缓冲器(区)FDB Full Debug Build 完全调试生成〖测试〗FDB Functional Data Base 功能数据库FDBMS Federated Data Base Management System 联合数据库管理系统FDBS Federated distributed Data Base System 联合分布式数据库系统FDC Facsimile Data Converter 传真数据转换器FDC Field Data computer 野外数据计算机FDC Flexible Disk Controller 软盘控制器FDC Flight Director Computer 飞行定向器计算机FDC Floppy Disc Controller 软盘控制器FDC Fluid Digital Computer 射流数字计算机FDC Fractal Design Corp. 分形设计公司(美国,出品绘图软件)FDCS Functionally Distributed Computing System 功能分布式计算系统FDCT Factory Data Collection Terminal 工厂数据收集终端FDCT Forward Discrete Cosine Transform 前方离散余弦变换FDD Flexible Disc Drive 软式磁碟机,软盘驱动器FDD Floppy Disk Drive 软盘驱动器FDD Frequency Division Duplex 频率分开的双工操作,频分双工FDDI Fiber Distributed Data Interface 光纤分布式数据接口(局域网标准,100Mbps)FDDL Field Data Description Language 域数据描述语言FDDL File Data Description Language 文件数据描述语言FDDL Frequency Division Data Link 频率分开的数据链路,频分数据链路FDDQ Fair Dual Distributed Queuing 公平双分布式排队FDF Fiber Distribution Frame 光纤配线架FDFS File Descriptor File System 文件描述符文件系统(Sun公司的)FDHP Full Duplex Handshaking Protocol 全双工信号交换协议FDI Failure Detection and Identification 故障检测与识别FDI Feeder / Distribution Interface 馈线/ 配电接口FDIC Facsimile Data Interchange Continuance 传真数据交换接续设备FDISK Fixed DISK 固定磁盘FDL Facilities Data Link 设备数据链路FDL Feature Definition Language 特性定义语言FDL Figure Description Language 图形描述语言FDL File Definition Language 文件定义语言FDL Formatter Define Language 格式标识符定义语言FDL Forms Description Language 窗体描述语言FDM Frequency –Division Modulation 频率分开的调制,频分调制FDM Frequency –Division Multiplexing 频率分开多路复用,频分多工法FDMA Frequency Division Multiple Address 频率分开多路多址,频分多址FDME Frequency Division Multiplex Equipment 频率分开多路复用设备,频分多路复用设备FDMVC Frequency Division Multiplex V oice Communication 频率分开多路复用语音通信,频分多路语音通信FDP Fast Digital Processor 快速数字处理器FDP Facial Definition Parameters 面部定义参数〖MPEG〗FDP Fiber Distribution Point 光纤分布点FDP Field Developed Program 现场开发程序(IBM公司的)FDP File Definition Processor 文件定义处理器FDP Flight Data Processing 飞行数据处理FDP Form Description Program 表格描述程序FDP Fortran Debug Package Fortran调试程序包(施乐公司的)FDPC Federal Data Processing Center 联邦数据处理中心(美国)FDS Fast –Access Disc Subsystem 快速存取磁盘子系统FDS Fiber Distribution System 光纤分布系统FDS FielD Separator 字段分隔符FDS File Description Subsystem 文件描述子系统FDS File Description System 文件描述系统FDS Fixed Disk Storage 固定磁盘存储FDS Flexible Disk Storage 不定磁盘存储FDSL File Structure Definition Language 文件结构定义语言FDSP Full Duplex Service Phone 全双工免提电话FDT File Description Table 文件描述表FDT Formal Description Techniques 形式描述技术FDT Format Description Techniques 格式描述技术FDT Full Duplex Teletype 全双工电传打字机FDT Function Decision Table 功能决策表FDT Function Description Table 功能描述表FDTC Forward Data Traffic Channel 前方数据通信交往信道FDU Flexible Disc Drive Unit 软盘驱动器FDV Fault Defect Verification 故障缺陷验证FDVDI Fiber Distributed Video / V oice Data Interface 光纤分布式视频/ 语音数据接口.fdw F3设计与映射的格式文件格式〖后缀〗FDX Full DupleX 全双工FE Fast Ethernet 快速以太网FE Focus Error 聚焦误差〖光驱〗FE Format Effectors 格式控制字符FE Framing Error 成帧错误,图像定位错误FE Front End 前端(软件,装置等)FE Functional Entity 功能实体FEA Federal Energy Administration 联邦能源署(美国)FEA Field Effect Amplifier 场效应放大器FEAL Fast Encryption ALgorithm 快速加密算法.feb WordPerfect for Win用于Figure Editor的按钮棒形图文件格式〖后缀〗FEBE Far –End Bit Error 远端位错误FEBE Far –End –Block –Error 远端块错误FEC Feedforward Error Correction 前馈纠错FEC Floating Error Code 浮动错误码FEC Forward Error Coding 前方错误编码FEC Forward Error Control 前方错误控制FEC Forward Error Correction 正向纠错,向前纠错FEC Forward Error –Correcting Coding 正向纠错编码FEC Front –End Computer 前端计算机FECN Forward Explicit Congestion Notification 前方明显拥塞通知FECP Front End Communication Processor 前端通信处理机FECT Forward Error –Correction Technique 向前纠错技术FED Field Emission Display 场射显示器FED Forward Error Detection 前方错误检测FEDAC Forward Error Detection And Correction 正向检错和纠错FedCIRC Federal Computer Incident Response Capability 联邦计算机事件反应能力FEDI Financial Electronic Data Interchange 金融电子数据交换FEDINET FEDeral Information NETwork 联邦信息网FEDLINK FEDeral Library and Information NetworK 联邦图书情报网FED-STD FEDeral STanDard 联邦标准FEDWIRE FEDeral reserve WIRE 联邦备用线路FEE Failure Effects Evaluation 故障影响评估FEE Far –End Error 远端错误FEEL Fox Editor Enhancement Library 编辑器增强库(Visual FoxPro的)FEF File Error Flags register 文件错误标志(寄存器)FEFO First –End First –Out 先完先出,先结束先退出FEHM Fault / Error Handling Model 故障/ 错误处理模型FEI Fargo Electronics Inc. 法戈电子公司(美国,出品打印机)FEIS Financial Executive Information System 金融主管信息系统FEL Feedback Error Learning 反馈错误学习FEP Financial Evaluation Program 财务评估程序FEP Front End Processor 前端处理器FEP Flow Enforcement Parameter 流量执行参量FEP Flow Enhancing Protocol 流量增强协议FEP Front –End Processor 前端处理器FERF Far End Receive Failure 远端接收故障FERS Facility Error Recognition System 设备错误识别系统FES Field Effect Transistor 场效应晶体管FES Frequency Encoding Signal 频率编码信号FES Front –End Scanner 前端扫描器FESH Fast Ethernet Switching Hub 快速以太网交换式集线器(英特尔公司1996年推出)FET Field Effect Transistor 场效应晶体管FETS Field Effect Transistor Storage 场效应晶体管存储体FEXT Far –End Cross Talk 远端串音〖电话〗FF File Find 查找文件FF Final Fantasy 《最终幻想》,《太空战士》〖游戏名〗FF Fixed Frequency 固定频率FF Flip –Flop 触发器FF Form Feed 换页,送纸FF Full Figure 全图,全像.ff Agfa Compugraphics的字体轮廓描述文件格式〖后缀〗FFC Fixed –Form Coding 固定格式编码FFD Functional Flow Diagram 功能流程图FFF FeedForward Filter 前馈滤波器.fff defFax的传真文件格式〖后缀〗FFG Flip –Flop Group 触发器组FFG ForeFront Group “前沿”集团公司(美国,出品浏览器附件)FFGS Faust: the Seven Game of Soul 《浮士德:七个灵魂的游戏》〖游戏名〗FFH Fast Frequency Hopping 快速跳频FFM Fixed Format Message 固定格式报文FFN Full Function Node 全功能节点FFO Failure –Free Operation 无故障运行FFO Fixed Frequency Oscillator 固定频率振荡器FFR Freeze Frame Request 冻结帧请求FFS Formatted File System 格式化文件系统FFSK Fast Frequency –Shift Keying 快速移频键控FFSR FeedForward Signal Regeneration 前馈信号再生FFST First Failure Support Technology 首次故障支持技术FFT Fast Fourier Transform 快速傅里叶变换.fft DisplayWrite的Dca/FFT定型文本文本文件格式〖后缀〗FFTDCA Final Form Text Document Content Architecture 最终形式的文本文件内容体系结构FFTI Fast Fourier Transform Inverse 快速傅里叶反变换FFTS Fiber Feeder Transport System 光纤馈线传送系统FG Forward Gate 正向门(电路)FG Function Generator 功能发生器FGBM ForeGround and Background Monitor 前台与后台监视器FGC Fixed Gain Control 固定增益控制FGC Focusing Grating Coupler 聚焦光栅耦合器FGCS Fifth Generation Computing System 第五代计算系统FGIPC Federation of GovernmeGG Gate 栅极,门(电路),选通G Giga 千兆,吉G Graph 图形G Grid 网格,格栅G Grounding 接地.g APPLAUSE的数据图表文件格式〖后缀〗.g8 PicLab的半成品图形平面3文件格式〖后缀〗G.E.C. General Electric Company 通用电气公司(美国)G.TLD Generic Top –Level Domain 普通顶层域GA a Gigantic Adventure 《开心冒险家》〖游戏名〗ga Gabon 加蓬(域名)GA Gene Amdahl 吉恩·阿姆达尔(1922-1996 大型机之父)GA General Arrangement 常规排列GA Generic Algorithm 普通算法GA Global Address 共用地址,全局地址GaAs FETs Gallium Arsenide Field Effect Transistors 砷化镓场效应晶体管GA&CS Ground Acquisition and Command Station 地面接收和指令站〖航空〗GAC General Access Copy 通用存取副本GACT Graphic Analysis and Correlation Terminal 图像分析与校正终端GAHA Global Information Industry Association 全球信息产业协会联盟GAI Graphics Adapter Interface 图形适配器接口gais 盖世〖中文搜索引擎〗GAL Generalized Assembly Language 通用汇编语言GAL Generic Array Logic 通用阵列逻辑(电路)Galaxy “银河”系列显卡(生产商:AGI)GAM Graphics Access Method 图形存取法.gam GammaFax的传真文件格式〖后缀〗GAMA Graphics Assisted Management Application 图形辅助管理应用软件Game Blaster “游戏冲击波”系列显卡(生产商:Creative)GAN Generalized Activity Network 广义活动网络GAN Generating and Analyzing Network 生成与分析网络GANDALF General Alpha Numeric Direct Access Library Facility 通用甲级数字直接存取库设施GAP Gateway Access Protocol 网关存取协议GAP General Accounting Package 通用会计程序包GAP General Assembly Program 通用汇编程序GAP Graphics Application Program 图形应用程序GAPSS Graphical Analysis Procedures for System Simulation 用于系统仿真的图形分析规程GAPI Gateway Application Programming Interface 网关应用软件编程接口GAPT Graphical Automatically Programmed Tools 自动程控绘图工具GARP Group Address Registration Protocol 组地址注册协议GART Graphics Address Remapping Table 图形地址再映射表〖芯片组〗GAS Gateway Access Service 网关接入服务GAS Global Address Space 全局地址空间GAT General Application Template 通用程序模板GAT Generalized Algebraic Translator 通用代数翻译程序,广义代数翻译程序GAT Georgetown Automatic Translation 乔治敦自动翻译程序(美国乔治敦大学研制)GAT Global Atom Table 全局原子表〖编程〗GAT Graphic Arts Terminal 图形刻印艺术终端〖照排〗GAT Group Audio Terminal 群音频终端GA TD Graphic Analysis of Three –Dimensional Data 三维数据的图形分析GA TE General Purpose Automatic Test Equipment 通用自动测试设备Gateway 2000 网关两千〖厂标〗见:GIGA TT General Agreement on Tariffs and Trade 关税及贸易总协定,关贸总协GB Gain Bandwidth 增益带宽GB Game Boy 任天堂游戏小子〖模拟器〗GB GigaBit 千兆位,千兆比特GB GigaByte 吉字节,十亿(千兆)字节(1GB=1,073,741,824 bytes =1,024MB)GB Gordon Bell 戈登·贝尔(1934-小型机之父)GB Graphic Background 图形背景gb Great Britain 大不列颠联合王国(域名)GB Group Box 组框〖编程〗GB (guo jia biao zhun) 国标(中国)GBEMS Golden Bridge Electronic Mail System 金桥电子邮件系统GBH Graphics Based Hypermedia 基于图形的超媒体GBL GarBLe 错乱,失真.gbl V AXTPU editor的通用定义文件格式〖后缀〗GBM Generalization –Based Memory 基于通用化的存储器GBMP General Bench Mark Program 通用基准程序GBOF General Bill –of –Forms 通用帐表GBNET Gold Bridge interNET 金桥网(即中国国家公用经济信息网)GBP Gain Bandwidth Product 增益带宽乘积Gbps Gigabits / Second 每秒千兆位GBR Global Base Register 共用基准寄存器GBS General Business System 通用商业系统GBT Group on Basic Telecommunications 基础电信分组GBTS General Banking Terminal System 通用银行终端系统GC Genicom Corp. 基因通信公司(美国,出品打印机,德州仪器公司属下)GC Global Control 全球网控制GC Graph Control 统计图控件〖编程〗GC Graphics Context 图形环境(Sun公司的)GC Group Command 组命令.gc1 V AXTPU editor的源码文件格式〖后缀〗.gc3 Golden Common Lisp 3.1的源码文件格式〖后缀〗GC Guidance Computer 导航计算机GCA Gain Control Amplifier 增益控制放大器GCA Ground –Controller Approach 地面控制进场着陆系统GCAP Generalized Circuit Analysis Program 通用电路分析程序GCC General Conference Control 通用会议控制技术GCC Graphic Character Composition 图形字符合成GCC Guidance Checkout Computer 制导校验计算机GCCA Graphic Communications Computer Association 图形通信计算机协会GCCS Global Command Control System 共用指挥控制系统GCD Global Common Directory 综合公用目录.gcd 图形文件格式〖后缀〗GCE Graphics Control Extension 图形控制扩展GCE Ground Checkout Equipment 地面检验设备GCE Ground Common Equipment 地面公用设备GCE Ground Communication Equipment 地面通信设备GCE Ground Communication Facility 地面通信设施GCE Ground Control Equipment 地面控制设备GCH Giga Characters 吉字符,千兆字符GCHQ Government Communications HeadQuarters 政府通信总部(英国)GCI Garbage Collection Interval 垃圾收集间隔GCI General Command Interface 通用命令接口GCI General Communications Interface 通用通信接口GCI Ground – Controlled Interception 地面控制拦截GCM General Circulation Model 常规循环模型GCM Generic Call Monitor 一般呼叫监视器GCN Generalized Connection Network 通用连接网络GCOE Ground Controlled Operational Equipment 地面控制的操作设备〖飞行〗GCP Grand challenge Problems 重大挑战性问题GCPS GigaCycles Per Second 每秒千兆赫GCP Ground Control Point 地面控制点GCR Ghost Cancellation Reference Signal 虚像取消参照信号GCR Ground Controlled Radar 地面控制雷达GCR Group Coded Recording 成组编码记录GCRA Generic Cell Rate Algorithm 普通单元速率算法GCS Gate Controlled Switch 栅控开关GCS General Computer System, Inc. 通用计算机系统公司GCS Global Control System 共用控制系统GCS Graphics Compatibility System 图形兼容性系统GCS Ground Communication System 地面通信系统GCS Group Control Subsystem 群控子系统GCSS (Global Command and Control System and the Global Combat Support System) 全球指挥控制系统与全球战斗支援系统GCSS Global Communication Satellite System 全球通信卫星系统GCSS-AF Global Combat Support System – Air Force 空军全球战斗支援系统GCT Graphics Communications Terminal 图形通信终端GCT Greenwich Civil Time 格林威治民用时GCT Guidance Computer Test 指导计算机测试GCTS Ground Communication Tracking System 地面通信跟踪系统GCTTech 汶鸿主板〖品牌〗GD Gate Driver 门驱动器GD Global Data 全局数据GD good day 白天好〖网语〗GD GrounD 接地,地线GD Group Delay 组延时gd Grenada 格林纳达(域名)GDA Global Data Administrator 共用数据管理程序GDA Global Data Area 共用数据区域GDAS General Data Analysis and Simulation 一般数据分析和模拟GDAS Ground Data Acquisition System 地面数据采集系统GDB Global Data Base 共用数据库GDBMS Generalized Data Base Management System 综合数据库管理系统GDBMS Global Data Base Management System 共用数据库管理系统GDBS Global Data Base System 共用数据库系统,全球数据库系统GDC General – purpose Digital Computer 通用数字计算机GDC Graphics Display Controller 图形显示控制器GDCI General Data Communications Interface 一般数据通信接口GDD Group Delay Dispersion 组延时色散GDDL Graphical Data Definition Language 图形数据定义语言GDF General Data File 一般数据文件GDF Graphics Data File 图形数据文件GDF Group Distribution Frame 用户组配线架.GDF GEOS的字典文件格式〖后缀〗GDHP Globalized Dual Heuristic Programming 全局化双启发式编程GDHS Ground Data Handling System 地面数据处理系统GDI General Database Interface 通用数据库接口GDI Graphic Device Interface 图形设备接口GDI Graphical Direct Interface 图形直接接口GDI Graphical Driver Interface 图形驱动程序接口GDIP GDI Printer 基于主机的打印机GDL Global Data Link 全球数据链接,环球数据线路GDL Graphic Display Library 图形显示库GDM Generalized Directive Model 广义指令模型GDM Global Data Manager 共用数据管理器,全局数据管理程序GDM Graphical Desktop Management 图形桌面管理GDMI Generic Definition of Management Information 管理信息的一般定义GDMO Guidelines for the Definition of Managed Objects 管理对象定义准则GDMS Generalized Data (base) Management System 广义数据(库)管理系统GDN Global Directory Navigator 共用目录引导器GDN Government Data Network 政府数据网(英国)GDNS Global Domain Name Server 共用域名服务器GDO Grid – Dip – Oscillator 栅陷振荡器GDOS Generalized Disk Operating System 通用磁盘操作系统GDOS Graphic Disk Operating System 图形磁盘操作系统GDP Generalized Data Base Processor 通用数据库处理器GDP Goal Directed Programming 目标引导的程序设计GDPS Generalized Disk Programming System 通用磁盘编程系统GDPS Global Data Processing System 共用数据处理系统GDRAM Synchronous Graphic Dynamic Random Access Memory 同步图形动态随机存取存储器GDS Generalized Data base (Sub)System 通用数据库(子)系统GDS Generalized Data Structure 通用数据结构GDS Global Data Schema 共用数据模式GDS Global Data – processing System 共用数据处理系统GDS Global Digital high Speed road 全球数字高速公路GDS Global Directory Service 共用目录服务GDS Global Directory System 共用数据系统GDS Graphic Data System 图形数据系统GDS Graphic Design System 图形设计系统GDS Graphic Display System 图形显示系统GDS / HA Graphical Design Specification for Hospital Administration 医院管理图形设计规范,GDS / HA语言GDSDF Generalized Data Structure Definition Facility 广义数据结构定义设备GDSS Global Decision Support System 共用决策支持系统GDSS Group Decision Support System 群体决策支持系统GDT Gate Delay Time 门延迟时间GDT Global Descriptor Table 共用描述符表GDU Graphic Display Unit 图形显示器GE General – graphic Editor 通用图形编辑程序GE General Electric Co. 通用电气公司(美国)ge Georgia 格鲁吉亚(域名)GE Gigabits Ethernet 十亿比特以太网,千兆位以太网GE Graphic Escape 图形换码,图形转义符GE Greater than or Equal to 大于或等于(Fortran 用语)GE Ground Equipment 地面设备GEA Gigabit Ethernet Alliance 千兆位以太网联盟GEA Graph Extended Algol 图形扩展Algol语言GEAM Generic Engineering Analysis Model 普通工程分析模型GEC General Electric Corporation 通用电气公司GECOM GEneral COMpiler 通用编译程序GECOS GEneral Comprehensive Operating System 通用综合操作系统.ged Arts & Letters的编辑器本地文件格式〖后缀〗GEDAN GEneral Data ANalyzer 通用数据分析程序GEEC Gigabit Ethernet Educational Council 千兆位以太网教育委员会GEIS GE Information Service 通用电气公司信息服务GEIS General Electronic Information Service 一般电子信息服务GEL General Emulation Language 同意仿真语言GEM Global Enterprise Manager 企业网全局管理器.gem GEM和V entura Publisher的矢量图形文件格式〖后缀〗GEMMS Global Enterprise Manufacturing Management System 企业制造全局管理系统GEMS General Epitaxial Monolithic Silicon 普通单晶硅片GEMS Global Enterprise Management of Storage 全局性企业存储管理GEN Gigabit Ethernet Networking 千兆位以太网联网GEN Global Education Network 全球教育网(中国分部:启迪咨询培训有限公司)GEN Global Enterprise Network 全球企业网GEN Global European Network 欧洲共用网,全欧网.gen dBase Application Generator的编译模板文件格式〖后缀〗.gen Ventura Publisher生成的文本文件格式〖后缀〗Genesis “创世纪”系列显卡(生产商:耕宇)GENIE General Electric Network for Information Exchange 通用电器公司的信息交换网GENTEC General Telephone & Electronic Co. 通用电话与电子公司(美国)GENUSC Global Enterprise Network User Super Conference 全球企业网用户高峰会议GEO GEOstationary 与地球同步的GeoCities “地球村”(网站名,1999.1被雅虎并购)GEOS Geodetic Earth Orbiting Satellite 大地测量地球轨道卫星GEOS Geosynchronous Earth Orbit Satellite 地球轨道同步卫星GEOS Graphical Environment Operating System 图形环境操作系统GEP Grolier Electronic Publishing 格罗利尔电子出版公司(法国,专出综合知识类光盘)GEROS GEneral Routine Optimization System 通用例程最佳化系统GERT Graphical Evaluation and Review Technique 图形鉴定与检测技术GERTS GEneral Remote Terminal Supervisor 通用远程终端管理程序GERTS GEneral Remote Terminal System 通用远程终端系统GERTS GEneral Remote Transmission Supervisor 通用远程传输管理程序GES Gateway Exchange Switches 网关交换机开关GES General(ized) Edit System 通用编辑系统GES Global Event Services 全局事件服务GES Ground Earth Station 地面地球站GES Ground Electronic System 地面电子系统GESAL General Electric Symbolic Assembly Language 通用电器符号汇编语言GESAL GEneral Symbolic Assembly Language 通用符号汇编语言GESC (Government Electronic Data Processing Standards Committee) 政府电子数据处理标准委员会(加拿大)GESPL Generalized Edit System Programming Language 通用编辑系统编程语言GEYP Global Electronic Yellow Page 全球电子黄页〖电话号码簿〗gf French Guiana 法属圭亚那(域名)GF Glossy Film 光面胶片〖打印机介质〗GF Gradient Fill 渐变色填充〖打印机〗GFA General Frame Allocation 通用帧分配.gfb 由GIFBLAST生成的压缩GIF图像文件格式〖后缀〗GFC General Flow Chart 总流程图GFC General Flow Control 总流量控制GFF Graphics File Formats 图形文件格式GFI General Format Identifier 通用格式标识符GFLOPS Giga FLoating –point Operations Per Second 每秒千兆浮点运算次数GFP Global Functional Plane 共用作用面GFS Grandfather – Father – Son 祖辈-父辈-子辈调度法GFSK Gauss Frequency Shift Key 高斯频移键GFT Generalized Fault Table 广义故障表.gft NeoPaint的字体文件格式〖后缀〗GG Global Group 全局组〖网络〗GG Go ahead Got it “勇往直前,夺取目标”(“勇往直前”软件公司1998年出品的网页浏览加速器)〖软件名〗GG good game 上等游戏〖网语〗GGC Ground Guidance Computer 地面制导计算机GGID Global Graphic Character Identifier 共用图形字符标识符GGP Gateway – to – Gateway Protocol 网关至网关协议gh Ghana 加纳(域名)GHz Gig Hertz 千兆赫GI Gateway 2000 Inc. 网关2000公司(美国,出品笔记本电脑等)GI General Information 通用信息gi Gibraltar 直布罗陀(域名)GI Group Identification 群组识别GI Group Identifier 群组识别符GI Group Interface 组接口.gib Graph-in-the-Box的图表文件格式〖后缀〗GIBN Global Interoperability for Broadband Network 宽带网全球互用性GIC General Input / Output Channel 通用输入/ 输出通道GIC General Instrument Corporation 通用仪器公司(美国)GID Gateway ID 网关标识符GID General IDentifier 通用标识符GID Group ID (Identifier) 组标识符GID Group IDentification number 组识别号码GIDEP Government Industry Data Exchange Program 政府工业数据交换程序GIF Graphics Interchange Format 图形交换格式(美国计算机服务公司1987年开发).gif 可以存储动画的图像格式,美国计算机服务公司的图像文件图形交换格式〖后缀〗GIG Giga Information Group 千兆信息组GigaByte 技嘉科技股份有限公司(台湾,出品主板)GIGO Garbage In, Garbage Out 垃圾进来,垃圾出去(输入的是错误数据,输出的也是错误数据),无用输入,无用输出GII Geospatial Information Infrastructure 地球空间信息基础设施GII Global Information Infrastructure 全球信息基础设施(1994年美国提出)GIIC Global Information Infrastructure Committee 全球信息基础设施委员会GII-IS Global Information Infrastructure and the Information Society 全球信息基础设施和信息社会GIIPT Geospatial Information Integrated Product Team 地球空间信息综合产品组GIL General purpose Interactive programming Language 通用交互式编程语言GILC Graphical Input Language Computer 图形输入语言计算机GILC Graphical Input Logic Computer 图形输入逻辑计算机GILS。

计算机专业英语课文(第四版)全文翻译

1.2 总线互连总线是连接两个或多个设备的通信通路。

总线的关键特征是,它是一条共享传输介质。

多个设备连接到总线上,任一个设备发出的信号可以为其他所有连接到总线上的设备所接收。

如果两个设备同时传送,它们的信号将会重叠,引起混淆。

因此,一次只能有一个设备成功地(利用总线)发送数据。

典型的情况是,总线由多条通信通路或线路组成,每条线(路)能够传送代表二进制1和0的信号。

一段时间里,一条线能传送一串二进制数字。

总线的几条线放在一起能同时并行传送二进制数字。

例如, 一个8位的数据能在8条总线线上传送。

计算机系统包含有多种不同的总线,它们在计算机系统层次结构的各个层次提供部件之间的通路。

连接主要计算机部件(处理机, 存储器, I/O)的总线称为系统总线。

系统总线通常由50~100条分立的(导)线组成。

每条线被赋予一个特定的含义或功能。

虽然有许多不同的总线设计,但任何总线上的线都可以分成三个功能组:数据线、地址线和控制线。

此外可能还有为连接的模块提供电源的电源线。

数据线提供系统模块间传送数据的路径,这些线组合在一起称为数据总线。

典型的数据总线包含8、16或32根线,线的数量称为数据总线的宽度。

因为每条线每次传送1位,所以线的数目决定了每次能同时传送多少位。

数据总线的宽度是决定系统总体性能的关键因素。

地址线用于指定数据总线上数据的来源和去向。

例如,如果处理机希望从存储器中读一个字的数据,它将所需要字的地址放在地址线上。

显然,地址总线的宽度决定了系统最大可能的存储器容量。

控制线用来控制对数据线和地址线的访问和使用。

由于数据线和地址线被所有部件共享,因此必须用一种方法来控制它们的使用。

控制信号在系统模块之间传送命令和定时信息。

定时信息指定了数据和地址信息的有效性,命令信号指定了要执行的操作。

大多数计算机系统使用多总线,这些总线通常设计成层次结构。

图1.3显示了一个典型的高性能体系结构。

一条局部总线把处理机连接到高速缓存控制器,而高速缓存控制器又连接到支持主存储器的系统总线上。

SCADA系统介绍

上位机:一般由电脑和服务器组成,主要起到远程 监控、报警处理、数据存储以及与其他系统结合的作用。

SCADA系统结构

下位机

下位机类型: 1.远程测控终端RTU RTU安装在远程现场,用来监测远程现场的 传感器和其他电子设备,负责对现场信号、工业 设备进行监测和控制。

2.可编程逻辑控制器PLC PLC是专门为在工业环境下应用而设计的数 字运算操作电子系统。它通过可编程存储器的内 部运算和数字量模拟量的输入输出来控制各种设 备和生产过程。

现场人 机界面 现场I/O

污水处理厂SCADA系统实例

从实例图可以看出,SCADA系统具有分散控制、集 中管理的“集散控制系统”的特征。

二、SCADA系统结构

SCADA系统分为下位机、通信网络、上位机三个 部分。 下位机:一般由RTU和PLC组成,主要起到现场数 据采集和直接控制现场设备的功能; 通信网络:一般使用以太网,实现上、下位机之间 的数据交流;

上位机

上位机组成: SCADA的上位机系统包括SCADA服务器、工程师 站、操作员站、WEB服务器等,这些设备通常采用以太 网进行联网。 上位机系统的组成不是固定的,在实际使用中,可 以根据 SCADA系统的规模和要求进行配置。如果系统 可靠性要求较高,上位机系统还可以进行冗余,即配置 两台SCADA服务器,当其中一个服务器出现故障时,系 统自动切换到另外一个进行工作。

3.处理问题不同 C/S结构的客户端是本地程序,和本地硬件、程序的交互性很 强,可以控制本机的其他程序和读写本地磁盘文件。B/S结构建立 在广域网上、文件进行交互。

四、组态软件

组态软件是上位机软件中的一种,是用于数据采集 与过程控制的专用软件,多使用于SCADA系统和DCS系

多语种机器翻译系统的设计与实现

多语种机器翻译系统的设计与实现随着全球化的推进,不同语言间的交流变得越来越重要。

为了解决语言交流的障碍,多语种机器翻译系统应运而生。

本文将介绍多语种机器翻译系统的设计与实现,以及相关技术和应用。

一、多语种机器翻译系统的设计多语种机器翻译系统的设计需要考虑以下几个方面:1. 数据收集与处理:多语种机器翻译系统需要大量的文本数据进行训练和学习。

设计者首先需要收集不同语言的平行语料,即同一内容的翻译对照文本。

然后,通过数据预处理和清洗,消除语法、标点等差异,以提高翻译的准确性和流畅度。

2. 语言模型构建:语言模型是机器翻译系统的核心组成部分,用于理解源语言和生成目标语言的句子结构和语法规则。

设计者需要构建各个语言的语言模型,并建立语言间的联系和对应关系。

3. 翻译模型设计:翻译模型是多语种机器翻译系统的核心技术,它基于语言模型和前期训练的平行语料,通过机器学习和深度学习算法来进行翻译推理。

设计者需要选择合适的翻译算法和模型结构,以提高翻译的准确性和效率。

4. 接口开发与集成:多语种机器翻译系统需要提供用户友好的接口,以便用户输入源语言文本或选择源语言和目标语言。

同时,系统还需要与其他应用程序和平台进行集成,以实现无缝的语言交流体验。

二、多语种机器翻译系统的实现多语种机器翻译系统的实现主要依赖于自然语言处理(NLP)和机器学习技术。

以下是实现多语种机器翻译系统的几个关键步骤:1. 数据预处理与特征提取:对收集的平行语料进行数据预处理和特征提取。

预处理包括句子分割、分词、词性标注等,以便机器能够理解和处理文本。

特征提取可以利用词袋模型、n-gram模型等方法将文本转化为数值特征。

2. 语言模型构建:根据预处理的文本数据,使用统计方法或神经网络方法构建源语言和目标语言的语言模型。

语言模型可以用于计算句子的概率,以及生成流畅的翻译结果。

3. 翻译模型训练:使用机器学习和深度学习技术,将平行语料和语言模型输入到翻译模型中进行训练。

mlp-mixer体系结构-概述说明以及解释

mlp-mixer体系结构-概述说明以及解释1.引言1.1 概述概述随着深度学习的快速发展和应用的广泛推广,研究人员一直在不断探索新的神经网络体系结构以增强模型的表达能力和性能。

MLP-Mixer体系结构是近期被提出的一种创新型网络结构,它通过全连接层和混合方法来实现对图像数据进行处理和特征提取。

MLP-Mixer体系结构的关键思想是将不同空间位置的特征进行混合,以使得网络具有更好的感知能力和表达能力。

与传统的卷积神经网络(CNN)不同,MLP-Mixer不依赖于卷积操作,而是通过使用多层感知机(MLP)以及一种称为通道(channel)混合的方法来实现特征的学习和提取。

在MLP-Mixer中,网络的输入被看作是一个多通道的张量,每个通道表示一个特定的特征。

通过使用嵌套的MLP操作,网络可以对每个通道进行特征变换和关联,从而达到对不同特征的处理和整合。

通过使用通道混合操作,MLP-Mixer可以将不同通道之间的信息相互关联和整合,使得网络能够捕捉到全局特征和局部特征之间的相互依赖关系。

MLP-Mixer体系结构在一些计算机视觉任务中表现出了良好的性能和可解释性。

例如,在图像分类任务中,MLP-Mixer可以有效地捕捉到图像中不同物体之间的语义关系,从而提高模型的分类准确性。

此外,MLP-Mixer还具有较低的计算复杂性和参数量,使得训练和推理过程更加高效。

本文将对MLP-Mixer体系结构进行详细介绍,并分析其在不同应用领域中的优势和潜在应用。

通过对MLP-Mixer的研究和分析,我们可以更好地理解其原理和特点,并为未来的研究和应用提供有价值的参考。

1.2文章结构1.2 文章结构本篇文章旨在介绍MLP-Mixer体系结构及其优点和应用领域。

为了更好地展现这一主题,本文将分为三个主要部分进行讨论。

第一部分是引言部分,包括概述、文章结构和目的。

在概述中,将简单介绍MLP-Mixer体系结构的背景和相关概念。

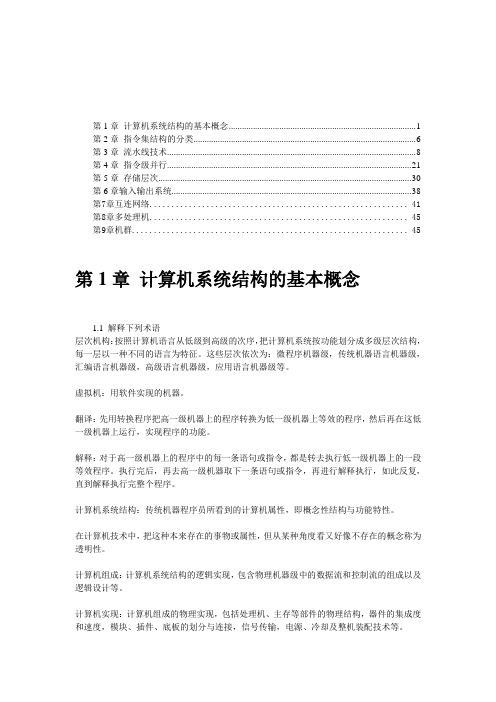

(完整版)完整版计算机体系结构课后习题原版答案-张晨曦著

第1章计算机系统结构的基本概念 (1)第2章指令集结构的分类 (6)第3章流水线技术 (8)第4章指令级并行 (21)第5章存储层次 (30)第6章输入输出系统 (38)第7章互连网络 (41)第8章多处理机 (45)第9章机群 (45)第1章计算机系统结构的基本概念1.1 解释下列术语层次机构:按照计算机语言从低级到高级的次序,把计算机系统按功能划分成多级层次结构,每一层以一种不同的语言为特征。

这些层次依次为:微程序机器级,传统机器语言机器级,汇编语言机器级,高级语言机器级,应用语言机器级等。

虚拟机:用软件实现的机器。

翻译:先用转换程序把高一级机器上的程序转换为低一级机器上等效的程序,然后再在这低一级机器上运行,实现程序的功能。

解释:对于高一级机器上的程序中的每一条语句或指令,都是转去执行低一级机器上的一段等效程序。

执行完后,再去高一级机器取下一条语句或指令,再进行解释执行,如此反复,直到解释执行完整个程序。

计算机系统结构:传统机器程序员所看到的计算机属性,即概念性结构与功能特性。

在计算机技术中,把这种本来存在的事物或属性,但从某种角度看又好像不存在的概念称为透明性。

计算机组成:计算机系统结构的逻辑实现,包含物理机器级中的数据流和控制流的组成以及逻辑设计等。

计算机实现:计算机组成的物理实现,包括处理机、主存等部件的物理结构,器件的集成度和速度,模块、插件、底板的划分与连接,信号传输,电源、冷却及整机装配技术等。

系统加速比:对系统中某部分进行改进时,改进后系统性能提高的倍数。

Amdahl定律:当对一个系统中的某个部件进行改进后,所能获得的整个系统性能的提高,受限于该部件的执行时间占总执行时间的百分比。

程序的局部性原理:程序执行时所访问的存储器地址不是随机分布的,而是相对地簇聚。

包括时间局部性和空间局部性。

CPI:每条指令执行的平均时钟周期数。

测试程序套件:由各种不同的真实应用程序构成的一组测试程序,用来测试计算机在各个方面的处理性能。

foxboro说明

1.1 Triconex的概述

Tri con ex旗 下 有 T ricon和 Trident两 套 控 制 系 统 ,其 中 Trident更 适 用 于 系 统 比 较 小 的 中 /小 型 现 场 环 境 ,而 Tr i con则 多 用 在 需 要 控 制 的 设 备 比 较 多 的大系统中。它们都是一种现代化的可编程逻辑与过程控制器,可以提供 高水平的系统容错能力的控制器。下面说明容错的概念,并列出TRICON系 统的主要特性。

Triconex 提高了系统的安全性,提供自动检测和确认现场传感器的完整 性,完全的跳闸和控制功能,与管理数据高速公路直接连接,以达到安全回 路功能的连续监控。 b)锅炉火焰安全

在大多数的精炼厂中,过程蒸汽锅炉起一个循环回路部件的功能。为了 保护锅炉,正常启动和停机的安全内锁系统以及锅炉火焰安全系统由 Triconex 系统整合为一体。传统应用中,这些功能由独立的,非整合的部件提供。但

----能耐受严酷的工业环境。 ----能够现场安装,可以在控制器在线使用状态下进行模件一级的修 理工作。I/O模件的更换不会打乱现场布线。 ----能支持多达118个I/O模件(模拟的和数字的)和选装的通讯模件, 该模件可以与Modbus主机和从属机连接,或者和Foxboro与Honeywell分布 控 制 系 统 ( DCS)、其 它 在 Peer— to— Peer网 络 内 的 各 个 TRICON、以 及 在 802 .3 网络上的外部主机相连接。 ----备有组合的支持,可以支持位于远离主机架2公里(1.2英里)以内 的远距I/O模件。 ----可以执行控制程序,该程序按继电器梯级逻辑写成并由一独立的 称作TRISTATION的工作站进行演变和调试。 ----在输入和输出模件内备有智能功能,以使主处理器的工作负荷得 以 减 轻 。 每 个 I/O模 件 都 有 三 个 微 处 理 器 。 输 入 模 件 的 微 处 理 器 对 输 入 进 行过滤和解调,并诊断模件上的硬件故障。输出模件微处理器为输出数据 的表决提供信息、检查来自输出终端的环回数据以使输出能最后有效、并 能诊断现场线路的问题。 ----提供总体的在线诊断,并具有自适应修理能力。 ----可以在TRICON正常运行中进行常规维护而不干扰被控的过程。 ----可支持“热插备件”I/O模件在关键时候的使用,在不可能立即 进行维修的情况下应急。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

多处理机系统介绍随着用户计算需求的增长,多处理系统能够提供一个自然地、不断提高的升级途径。

只要核心的用户程序能够提供线程级并行,给系统添加处理器,或者将较小的系统替换为较大的、包含更多处理器的系统,都能给用户提供一个直接增加计算能力的途径。

其次,多处理机系统使系统供应商能够将单个微处理器的设计代价分摊到多种设计方案中,这些设计方案能够提供不同层次的性能和扩展能力。

最后,使用一致共享存储器的多处理机系统能够提供与分时共享的但处理机兼容的编程模式,便于用户使用以前已经存在的应用程序,也便于开发新的应用程序。

在这些系统中,硬件和操作系统软件综合起来提供给用户和程序员的功能界面,实际上是基于以下4点多处理机理想假设:完全共享存储器即系统中所有处理机对所有物理存储器的访问都是平等的。

单位延迟即所有的访存请求都能在一个周期内满足。

无竞争即一个处理机的访存不会受到另一个处理机访存的影响。

写的瞬间船舶即某个处理机写存储器导致的更新立刻对所有的处理机可见。

系统及处理机的设计者必须努力使系统尽量接近这些理想假设,从而满足用户对于性能和正确性的要求。

显然,在实现这些目标时,诸如造价以及可扩展性等因素起着重要作用,但是一个优秀的系统必须很好的满足这些假设。

完全共享存储器,单位延迟以及无竞争诸如图9.4所示,大多数提供一致存储器访问(UMA,Uniform Memory Access)的传统共享存储器多处理机系统使用一种“dancehall”的组织结构,一组存储器模块或者存储体通过交叉开关互联网络与另一组处理机连接起来,并且每个处理机通过交叉开关访问存储器的延迟是相通的。

这种方法的弊端在于交叉开关的价格,该价格会随着处理机和存储器的总数按平方增长,同时每次访存都必须穿过交叉开关,另一种方法是非一致存储访问(NUMA,Nonuniform Memory Access),许多系统供应商现在都按照这种方法构造系统,在这种方法中,处理机仍然通过一个交叉开关互联网络连接在一起,但是每个处理机有一个本地的存储器,它的访问延迟要低得多,在NUMA结构中,只有对远程存储器的访问才存在穿越交叉开关的延迟开销。

在UMA和NUMA系统中,与单处理机系统一样,都是通过cache来近似满足单位延迟的理想假设,cache能够同时满足对本地和远程存储器(NUMA)的访问,类似的,可以使用cache 对访存流量进行过滤减轻存储体之间的竞争。

因此,对于在单处理机系统中不可缺少的cache,在多处理机系统中同样非常有用,然而,cache的存在个处理存储器写操作带来了一定的困难,因为存储器写操作必须对其他处理机可见,或者传播给其他处理器机。

写操作的瞬时传播在一个分时共享的单处理机系统中,如果一个线程改写了存储器某个单元的值,该线程以及任何其他线程都会立刻查看新的值,因为这个值会存放在处理机的cache中。

遗憾的是,对于多处理机系统,不再具备这个立即可见的特性,因为对同一地址的访问可能有其他处理机发出,由于这些处理机有了自己的cache,可能包含同一cache行的私有副本,它们可能看不到其他处理机的更新。

例如,在图9.5(a)中,处理机P1向存储器地址A写入值1。

由于并没有一致性的支持,在P2的cache中,存储器地址A的副本并没有被更新,P2读取A将会得到以前的值0。

这就是经典的cache一致性问题。

要解决这一问题,系统必须提供cache 一致性协议,保证系统中所有的处理机能够察看到其他处理机的更新,这样每个处理机拥有一致的存储器视图。

实现cache一致性有两种基本的方法:更新协议和作废协议,我们将在后面的章节中简要的讨论这两个协议。

图9.5(b)和图9.5(c)分别对这两种协议进行了说明一致的共享存储器对于共享存储器的多处理机系统,一致的存储器视图很难实现。

但如果不能实现一致的视图,共享存储器程序的行为将不可预测,因为不同的处理机从存储器读到的值各不相同。

我们已经论述过,一致性问题是由于写操作不能立刻自动地传播给其他处理机的cache造成的。

有两类一致性协议可以保证写操作的结果对于其他处理机是可见的。

更新协议早期提出的多处理机系统采用一个相当直接的办法来维护cache一致性,在这些系统中,处理机的cache采用写直达策略,所有的写操作不仅写入执行写操作的处理机cache,同时也写入存储器。

这种协议如图9.5(b)所示,由于所有的处理机都连接在一条共享的总线上,这条总线还将所有的处理机与存储器相连,所以所有其他处理机可以在共享总线上监听新的值,并更新它们的数据副本(如果有这样的副本)。

这样就能够得到写直达的结果。

实际上,这种更新协议是基于广播写直达策略的,即每个处理机的每次写操作都是写直达,不仅写入存储器,还写入任何拥有这个数据副本的处理机cache。

显然,这种协议扩展性较差,仅限于数量较少的处理机,否则大量处理机的写直达流量会很快将存储器总线的可用带宽占用完。

可以对该协议进行简单的优化,对数据采取写回策略,即写操作只是将数据写入处理机的本地cache,当这一行被替换出cache时,才将结果写回存储器。

然而,在这样的协议中,任何对共享cache行(存在于任何其他处理机cache中的行)的写操作仍然需要在总线上广播,以使包含共享副本的处理机能更新它们的副本。

而且,一个远程读操作所读的行如果恰好是修改过的,那么在满足读请求之前,要将这一行先写回存储器。

遗憾的是,更新协议对于带宽的苛刻要求使得这种协议几乎消失,因此没有一个现代多处理机系统采用更新协议来维护cache一致性。

作废协议现代共享存储器多处理机系统都采用作废协议来维护cache一致性,作废协议的基本前提很简单:任何时候只允许一个处理机执行写操作(这样的协议经常称为single-writer协议)在该协议中,试图对cache中某一行写数据的处理机必须使该行成为系统中唯一有效的副本,而其他处理机cache中的副本都要作废掉(所以称为作废协议)。

该协议如图9.5(c)所示。

简单地说,处理机执行写之前,首先要检查系统中是否还存在其他副本。

如果有,处理机发出消息将其他副本作废。

然后,处理机向其私有(专用)副本中写入数据。

后续的、对同一行的写操作可以流水化,因为不需要检查是否存在其他副本。

和单处理机的协会cache一样,修改过的行知道被替换出去的时候才协会存储器。

然而,一致性协议必须记住存在这样一个修改过的副本,以防止其他处理机到存储器读取以前的值。

而且,还必须能够从处理机cache 中读出修改过的数据,以满足其他处理机对这个唯一副本的远程访问。

作废协议要求cache目录至少要为每行维护两个状态:修改(M)状态和作废(I)状态。

如果某一行处于作废状态,那么这一行的数据无效,必须从存储器中读取数据。

如果处于修改状态,处理机知道系统中没有别的副本(即本地的副本是专有副本),因此处理机能够对这一行进行读写。

注意,如果被替换出去的行处于修改状态,必须写回存储器,因为处理机可能对它进行了写操作。

简单的办法是在cache行的状态中加入一个dirty位,使得处理机能够区分哪些是处理机的专有行(通常称为E状态),哪些是专有并且修改过的行(M状态)。

Macintosh桌面系统使用的IBM/Motorola PowerPC G3处理器实现了这种作废协议。

注意,如果只有这三种状态(MEI),cache行不能同时出现在多个处理机中。

因此,需要解决这一问题,允许可读的副本能够出现在多个处理机的cache中。

多数作废协议还包括一个共享状态(S),这个状态表明,系统中可能存在多个可读的副本。

如果一个处理机要向处于S状态的cache行写数据,必须首先将这一行提升到M状态并作废其他远程的副本。

图9.6显示了一个简单的MESI一致性协议的状态表个转换图。

每一行代表4种状态(M,E,S或者I)中的一种,针对每种类型的总线事件,每一列总结了一致性控制器必须执行的动作。

引起cache行发生状态转换的事件包括本地访存(读或写)、远程访存(总线读、总线写或者总线状态生机)以及本地的cache行转换。

Cache目录或者标识阵列维护每一个cache 行的MESI状态。

注意,此时允许每个cache行在不同时刻可以具有不同的状态,并使包括私有数据的cache行保持为E状态或者M状态,而包含共享数据的行处于S状态并且可以同时存在于多个cache中。

MESI一致性协议支持single-writer并保证了一致性,同时还支持只读数据的共享,以及在发生本地写实,从专有状态(E)提升到修改状态(M)(不需要总显得状态升级消息)。

实现cache一致性维护cache一致性需要有一套记录cache行状态(即MESI)的机制,从而能够正确处理对这些行的访问。

保存一致性状态最方便的场所是在cache的标识存储器中,因为必须在cache 中对状态信息进行维护。

然而,cache行的本地一致性状态要对系统中其他处理机可见,以满足它们对这些行的访问。

因此,实现cache一致性时必须提供一种分布访问方式。

主要有两种实现方法:监听实现和目录实现。

监听实现实现一致性的最简单的方法是利用监听机制:在监听实现中,所有由一致性协议引起的片外地址事件(即作废协议中的cache失效和作废)将共享总线,这对系统中所有其他处理机都是可见的。

在规模较小的系统中,地址总线是电路共享的,当这些命令放到总线上时,每个处理机都能察看到所有其他处理机的命令。

更先进的点到点互联机制也能实现监听,它通过层次化的监听互联机制,将所有命令反映给所有的处理机。

为简单起见,我们将只讨论地址总线的机制。

在监听实现中,一致性协议规定了一个处理机是否响应总线命令以及如何响应总线命令。

例如,一个远程处理机对当前被修改过的cache行发出读请求,这将导致cache控制器将这一行从本地cache中直接传送给发出请求的处理机,也许还需要写回存储器,以这种方式请求将能够得到最新的副本。

同样,一个远程处理机对当前处于共享状态的行发出作废请求,将导致控制器更新目录表项并将这一行标记为作废。

这将防止本地处理机以后从cache中读取是小的数据。

监听实现的主要缺点在于可扩展性较差。

假设系统中每个处理机以一定的速率产生地址总线事务,可以看到,必须监听的输入地址总线事务直接和系统的处理机数目成正比。

也就是说,如果每个处理机每秒产生s0个总线事务(包括cache失效导致的读请求和对共享行写操作导致的作废请求),系统中有n个处理机,那么每个处理机每秒必须监听ns0个事务,每次监听都要查找本地的cache目录并判断处理机是否需要作出反应(参见图9.6),对于较大的n,查找总带宽是不可接受的,同样,对于将系统中的处理机连接在一起的互联网络,其带宽可能很快就被事务流量占用完。