hadoop3.0.0源码编译

hadoop源码编译问题(Hadoopsourcecodecompilerproblem)

hadoop源码编译问题(Hadoop source code compiler problem)[错误]执行失败的目标组织Apache Maven。

插件:Maven窦插件:1.6:运行(编译原)项目Hadoop常见:发生了一个蚂蚁buildexception:exec返回:1 -> [ 1 ]帮助org.apache.maven.lifecycle.lifecycleexecutionexception:未能执行目标组织Apache Maven。

插件:Maven窦插件:1.6:运行(编译原)项目Hadoop常见:发生了一个蚂蚁buildexception:exec返回:1在牛津。

Apache Maven。

生命周期内。

mojoexecutor。

执行(mojoexecutor。

java:217)在牛津。

Apache Maven。

生命周期内。

mojoexecutor。

执行(mojoexecutor。

java:153)在牛津。

Apache Maven。

生命周期内。

mojoexecutor。

执行(mojoexecutor。

java:145)在牛津。

Apache Maven。

生命周期内。

lifecyclemodulebuilder。

buildproject(lifecyclemodulebuilder。

java:84)在牛津。

Apache Maven。

生命周期内。

lifecyclemodulebuilder。

buildproject(lifecyclemodulebuilder。

java:59)在牛津。

Apache Maven。

生命周期内。

lifecyclestarter。

singlethreadedbuild(lifecyclestarter。

java:183)在牛津。

Apache Maven。

生命周期内。

lifecyclestarter。

执行(lifecyclestarter。

java:161)在牛津。

Windows10x64下编译Hadoop源码

Windows10x64下编译Hadoop源码Windows 10 x64 下编译 Hadoop 源码环境准备Hadoop并没有提供官⽅的 Windows 10 下的安装包,所以需要⾃⼰⼿动来编译,官⽅⽂档中 BUILDING.txt ⽂件中说明了编译源码需要的软件环境:# 1. 具体如下:Hadoop源码Windows 系统JDK 1.8+Maven 3.0 or laterFindbugs 1.3.9 (可省略)ProtocolBuffer 2.5.0CMake 2.6 or newerWindows SDK or Visual Studio 2010 ProfessionalCygwin: 为了使⽤ sh, mkdir, rm, cp, tar, gzip 等命令zlib电脑需要联⽹# 2. Hadoop源码下载可以地址 @选择具体版本即可# 3. JDKJAVA_HOME=JDK⽬录CLASSPATH=.;%JAVA_HOME%\lib;%JAVA_HOME%\lib\jre\lib;PATH=%JAVA_HOME%\bin;%JAVA_HOME%\jre\bin;注意:Hadoop2.7.0 及之后最好使⽤JDK1.7及1.8以上版本进⾏编译,我使⽤的版本如下C:\Users\ZhaoBo>java -versionjava version "1.8.0_181"Java(TM) SE Runtime Environment (build 1.8.0_181-b13)Java HotSpot(TM) 64-Bit Server VM (build 25.181-b13, mixed mode)# 4. Maven下载地址:@M2_HOME=maven⽬录PATH=%M2_HOME%\bin;我使⽤的版本是3.6.0:C:\Users\ZhaoBo>mvn -versionApache Maven 3.6.0 (97c98ec64a1fdfee7767ce5ffb20918da4f719f3; 2018-10-25T02:41:47+08:00)Maven home: D:\apache-maven-3.6.0\bin\..Java version: 1.8.0_181, vendor: Oracle Corporation, runtime: C:\jdk\jdk1.8.0_181\jreDefault locale: zh_CN, platform encoding: GBKOS name: "windows 10", version: "10.0", arch: "amd64", family: "windows"# 5. ProtocolBuffer下载地址:@ protoc-2.5.0-win32.zip 版本, 解压到安装⽬录,并添加到PAHT,如下:PATH=C:\java\protoc-2.5.0-win32;测试:C:\Users\ZhaoBo>protoc --versionlibprotoc 2.5.0# 6. CMake要求 CMake 2.6+ 的版本,下载地址:@ 下载并解压到安装⽬录,并添加bin⽬录到PATH,由于cygwin中也带了个cmake,所以在Path中,cmake 的bin⽬录得加在cygwin的bin ⽬录之前:CMAKE_HOME=cmake⽬录PATH=%CMAKE_HOME%\bin;测试:C:\Users\ZhaoBo>cmake --versioncmake version 3.14.3CMake suite maintained and supported by Kitware (/cmake).# 7. Visual StudioVS的版本选择有两种,第⼀使⽤推荐的VS2010企业版,使⽤这个版本⽐较简单⽅便,或者使⽤最新的VS2015版,需要升级⼀些⽂件。

hadoop3 源码编译

hadoop3 源码编译

编译hadoop 3源码需要以下几个步骤:

1. 确认编译环境

Hadoop 3要求使用JDK 8或更高版本进行编译。

同时需要安装Maven 3.3或更高版本作为构建工具.

2. 下载源代码

从Apache官方网站下载最新的Hadoop v3源代码包并解压缩。

3. 修改配置文件

进入hadoop-3.x-src/hadoop-project-dist/hadoop-common目录,编辑pom.xml文件,将hadoop.version属性设置为当前版本号。

4. 编译代码

在hadoop-3.x-src目录下使用以下命令编译源代码:

```

mvn clean install -DskipTests

```

这将编译hadoop的所有模块,并将构建的JAR文件安装到本地Maven存储库中。

5. 配置环境变量

将以下环境变量添加到你的~/.bashrc文件中:

```

export HADOOP_HOME=/path/to/hadoop-3.x-src/hadoop-

dist/target/hadoop-3.x.x

export PATH=PATH:HADOOP_HOME/bin:HADOOP_HOME/sbin

```

替换/path/to/为你的Hadoop源代码目录。

6. 测试安装

重启终端后,使用以下命令验证Hadoop安装是否成功:

```

hadoop version

```

如果一切顺利,你应该能够看到安装的版本号。

以上是Hadoop 3源代码的编译流程。

Windows10安装Hadoop3.0.0

Windows10安装Hadoop3.0.0前⾔准备:7Zip下载:压缩⼯具,⽀持*.tar.gz格式的压缩⽂件解压Hadoop下载:,笔者选择3.0.0版本下载,官⽹下载的⽹速如同断⽹。

winutils下载:,Hadoop不直接⽀持Windows,使⽤⼯具集进⾏⽀持。

JDK1.8及其以上版本,⾃⾏安装,并配置JAVA_HOME环境变量。

1. ⽂件准备hadoop3.0.0:a. 将原始hadoop-3.0.0下bin⽬录备份;b. 使⽤winutils中的bin⽬录整个替换hadoop中的bin⽬录:c. 在hadoop-3.0.0下按⽬录创建如下⽂件夹:JDK1.8:2. 配置准备2.1 配置环境变量:2.2 编辑hadoop配置⽂件a. hadoop配置⽂件⽬录:b. 配置hadoop-env.cmd, 这⾥将JAVA_HOME换成绝对⽬录(不确定不换可不可以)c. core-site.xml 添加如下配置1<configuration>2<property>3<name></name>4<value>hdfs://localhost:9000</value>5</property>6</configuration>d. hdfs-site.xml添加如下配置1<configuration>2<property>3<name>dfs.replication</name>4<value>1</value>5</property>6<property>7<name>dfs.permissions</name>8<value>false</value>9</property>10<property>11<name>.dir</name>12<value>/D:/hadoop-3.0.0/data/namenode</value>13</property>14<property>15<name>fs.checkpoint.dir</name>16<value>/D:/hadoop-3.0.0/data/snn</value>17</property>18<property>19<name>fs.checkpoint.edits.dir</name>20<value>/D:/hadoop-3.0.0/data/snn</value>21</property>22<property>23<name>dfs.datanode.data.dir</name>24<value>/D:/hadoop-3.0.0/data/datanode</value>25</property>2627</configuration>e. mapred-site.xml添加如下配置1<configuration>2<property>3<name></name>4<value>yarn</value>5</property>67</configuration>f. yarn-site.xml添加如下配置1<configuration>2<!-- Site specific YARN configuration properties -->3<property>4<name>yarn.nodemanager.aux-services</name>5<value>mapreduce_shuffle</value>6</property>7<property>8<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name> 9<value>org.apache.hadoop.mapred.ShuffleHandler</value>10</property>11</configuration>3. 初始化与运⾏使⽤管理员权限运⾏命令⾏3.1 namenode格式化使⽤如下命令进⾏格式化:hdfs namenode -format根据提⽰输⼊y,格式化成功结果如下:3.2 运⾏hadoop进⼊Hadoop的sbin⽬录,执⾏命令:start-all启动四个服务窗⼝:四个服务如下图所⽰:启动成功。

Win10下hadoop3.0.0单机部署

Win10下hadoop3.0.0单机部署前⾔因近期要做 hadoop 有关的项⽬,需配置 hadoop 环境,简单起见就准备进⾏单机部署,⽅便开发调试。

顺便记录下采坑步骤,⽅便碰到同样问题的朋友们。

安装步骤⼀、下载 hadoop-XXX.tar.gz下载地址:将⽂件解压⾄⽆空格⽬录下,好像时间有那么点点久。

注:解压需管理员权限!!!添加环境变量添加HADOOP_HOME配置在 path 中添加 bin ⽬录 C:\hadoop-3.0.0\binJAVA_HOME⼆、hadoop配置1、修改C:/hadoop-3.0.0/etc/hadoop/core-site.xml配置:<configuration><property><name></name>2、修改C:/hadoop-3.0.0/etc/hadoop/mapred-site.xml配置:3、在C:/hadoop-3.0.0⽬录下创建data⽬录,作为数据存储路径:在D:/hadoop-3.0.0/data ⽬录下创建datanode ⽬录;在D:/hadoop-3.0.0/data ⽬录下创建namenode⽬录;4、修改C:/hadoop-3.0.0/etc/hadoop/hdfs-site.xml配置:5、修改C:/hadoop-3.0.0/etc/hadoop/yarn-site.xml配置:<value>hdfs://localhost:9000</value></property><property><name>hadoop.tmp.dir</name><value>/C:/hadoop-3.0.0/data/tmp</value></property></configuration><configuration><property><name></name><value>yarn</value></property></configuration><configuration><!-- 这个参数设置为1,因为是单机版hadoop --><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.permissions</name><value>false </value></property><property><name>.dir</name><value>/C:/hadoop-3.0.0/data/namenode</value></property><property><name>fs.checkpoint.dir</name><value>/C:/hadoop-3.0.0/data/snn</value></property><property><name>fs.checkpoint.edits.dir</name><value>/C:/hadoop-3.0.0/data/snn</value></property><property><name>dfs.datanode.data.dir</name><value>/C:/hadoop-3.0.0/data/datanode</value></property></configuration><configuration><!-- Site specific YARN configuration properties --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.auxservices.mapreduce.shuffle.class </name> <value>org.apache.hadoop.mapred.ShuffleHandler</value>6、修改C:/hadoop-3.0.0/etc/hadoop/hadoop-env.cmd配置,添加7、bin⽬录替换⾄下载解压,然后找到对应的版本后完整替换bin⽬录即可⾄此,我们的配置就完成了三、启动服务1、打开cmd2、通过start-all.cmd启动服务:然后可以看到同时打开了4个cmd窗⼝Hadoop NamenodeHadoop datanodeYARN Resourc ManagerYARN Node Manager通过即可查看集群所有节点状态:</property></configuration>set JAVA_HOME=%JAVA_HOME%set HADOOP_PREFIX=%HADOOP_HOME%set HADOOP_CONF_DIR=%HADOOP_PREFIX%\etc\hadoop set YARN_CONF_DIR=%HADOOP_CONF_DIR%set PATH=%PATH%;%HADOOP_PREFIX%\bincd C:\hadoop-3.0.0\binhdfs namenode -formatC:\hadoop-3.0.0\sbin\start-all.cmd访问即可查看⽂件管理页⾯:总结⼀次还算⽐较顺利的采坑,后⾯准备开始肝项⽬了 orz。

hadoop源码编译

hadoop源码编译Hadoop是目前最流行的分布式计算框架之一,广泛应用于大数据领域。

为了更好地理解Hadoop的内部运行机制,我们有时需要对其源码进行深入研究和编译。

下面就来一步步讲解如何编译Hadoop源码。

一、环境准备在开始编译Hadoop源码之前,需要安装一些必备的软件和环境。

首先要确保已经安装了Java JDK和Maven,其中Java JDK的版本应该至少是1.7或1.8,而Maven则需要3.0以上的版本。

其次需要安装SSH,这是Hadoop用于节点之间通信和管理的必备组件。

最后需要下载Hadoop源码压缩包,解压到本地文件夹。

二、修改配置文件在进行编译过程之前,还需要修改一些Hadoop的配置文件。

具体来说,需要先修改pom.xml文件中的Hadoop版本号,确保与本地安装的版本一致。

然后需要修改hadoop-common-project/hadoop-common/src/main/conf/hadoop-metrics2.properties文件中的hostname值,确保与你当前的主机名一致。

三、编译源码当所有环境准备工作完成后,就可以开始编译Hadoop源码了。

首先需要在hadoop源码文件夹下运行以下命令,生成configure脚本:$ ./bootstrap.sh接着需要执行configure命令,生成Makefile:$ ./configure这个命令会检查编译环境,并根据环境配置参数。

最后,你需要执行make命令来编译Hadoop源码:$ mvn package -Pdist,native -DskipTests -Dtar以上命令会编译生成Hadoop发布版本,并将所有生成的二进制文件打成一个.tar包。

编译过程需要一定的时间,具体取决于你的电脑性能和网络速度。

四、启动HadoopHadoop源码编译完成之后,就可以启动它了。

首先需要将生成的.tar包解压到一个文件夹中:$ tar xf hadoop-x.x.x.tar.gz然后使用以下命令添加环境变量:$ export HADOOP_HOME=/path/to/hadoop-x.x.x$ export PATH=$PATH:$HADOOP_HOME/bin至此,Hadoop就已经编译成功并且可以在本地运行了。

hadoop3 源码编译

hadoop3 源码编译

Hadoop3是一款开源的分布式存储和计算框架,它提供了强大的数据处理能力。

如果你想了解Hadoop3的源码编译过程,可以参考以下步骤:

1. 下载Hadoop3源码:你可以从Hadoop官网或GitHub上获取Hadoop3的源代码。

2. 安装必要的软件:在编译Hadoop3之前,你需要安装一些必要的软件,包括Java、Maven和CMake等。

3. 编译Hadoop3:进入Hadoop3源码目录,执行以下命令:

mvn package -Pdist,native -DskipTests -Dtar

上述命令会创建一个包含Hadoop3二进制文件和配置文件的tar 包。

4. 安装Hadoop3:解压上一步生成的tar包,并将解压后的文件复制到你想要安装Hadoop3的目录。

5. 配置Hadoop3:在安装完成后,你需要对Hadoop3进行配置。

配置文件位于Hadoop3的安装目录下。

6. 启动Hadoop3:执行以下命令启动Hadoop3:

sbin/hadoop-daemon.sh start namenode

sbin/hadoop-daemon.sh start datanode

以上是Hadoop3源码编译的基本步骤,如果你想深入了解Hadoop3的源码,可以阅读Hadoop3的官方文档或参考Hadoop3的源码。

配置eclipse编译_开发Hadoop(MapReduce)源代码

3. 安装 Subclipse(Eclipse 的 SVN 插件)

用于从 Hadoop 获得源代码。我们使用 eclipse 自带的软件安装功能,通过 Subclipse 提供的地址自动下载安装该插件。

•首先访问,在Download and Install页面找到与Eclipse版本合适的Subclipse版本,最新为1.6,将其Eclipse update site URL

•如果选择 release 版本,需进入 tags 目录浏览,找到所需的版本,如 0.21.0 版 MapReduce 源代码地址为:/repos/asf/hadoop/common/tags/release-0.21.0/mapreduce

确定好 SVBiblioteka 地址后,本地 eclipse 需要的操作如下:

将其下的三个全选,然后像subclipse一样安装上。安装好之后,进入Window-Preferences-Team-svn,将svn本地接口选择上安装的那个(下拉就可以看到)。

4. 下载 Hadoop(MapReduce)源代码

首先,Hadoop 源代码共包括 common、hdfs(分布式文件系统)、mapred(MapReduce) 三部分,它们之间存在依赖关系:common 是后两者的公共组件,mapred

查看Window-Preferences-Team-svn,会发现svn本地接口显示为不可用。

可以通过以下方法解决(安装svn所需kit):

打开 eclipse 的菜单 Help > Install New Software,填入上边安装subclipse时所用的安装地址(即 /update_1.6.x),选择第三个subclipse svnkit option,

hadoop编译

hadoop编译

Hadoop编译指的是将Hadoop源代码编译成可执行文件的过程。

Hadoop是一个开源的分布式计算框架,它提供了分布式存储和计算能力,适用于海量数据的处理和分析,是现代大数据处理的重要工具之一。

Hadoop的编译过程相对复杂,需要安装一些必要的软件和工具,并正确配置环境变量。

以下是Hadoop编译的一般步骤:

1. 下载Hadoop源代码:可以从官方网站或GitHub上下载Hadoop 的源代码。

2. 安装必要的软件:Hadoop编译需要安装Maven、Java等软件,确保符合要求的版本。

3. 配置环境变量:设置JAVA_HOME、MAVEN_HOME等环境变量,以便在编译时能够正确调用这些软件。

4. 修改配置文件:根据需要修改Hadoop的配置文件,如hadoop-env.sh、core-site.xml等。

5. 运行编译命令:在命令行中进入Hadoop源代码目录,运行mvn package命令即可开始编译。

编译成功后可以在target目录下找到编译生成的jar包和可执行文件。

总的来说,Hadoop编译需要一定的技术水平和耐心,但是掌握了这个过程,可以更好地理解Hadoop的内部机制和实现。

- 1 -。

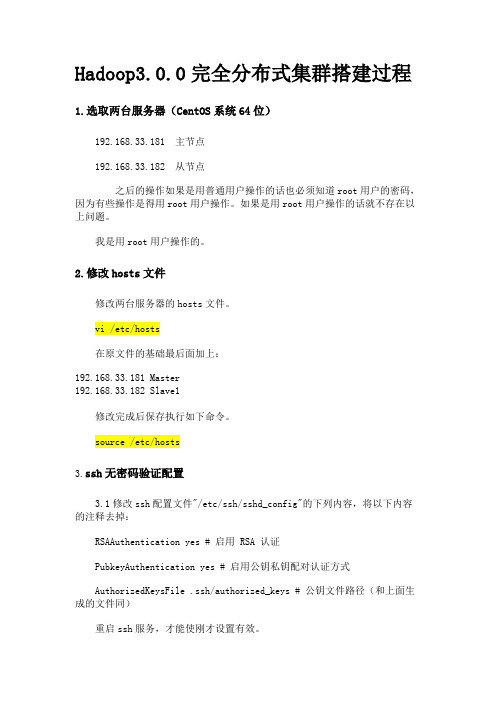

Hadoop3.0.0完全分布式集群搭建过程

Hadoop3.0.0完全分布式集群搭建过程1.选取两台服务器(CentOS系统64位)192.168.33.181 主节点192.168.33.182 从节点之后的操作如果是用普通用户操作的话也必须知道root用户的密码,因为有些操作是得用root用户操作。

如果是用root用户操作的话就不存在以上问题。

我是用root用户操作的。

2.修改hosts文件修改两台服务器的hosts文件。

vi /etc/hosts在原文件的基础最后面加上:192.168.33.181 Master192.168.33.182 Slave1修改完成后保存执行如下命令。

source /etc/hosts3.ssh无密码验证配置3.1修改ssh配置文件"/etc/ssh/sshd_config"的下列内容,将以下内容的注释去掉:RSAAuthentication yes # 启用 RSA 认证PubkeyAuthentication yes # 启用公钥私钥配对认证方式AuthorizedKeysFile .ssh/authorized_keys # 公钥文件路径(和上面生成的文件同)重启ssh服务,才能使刚才设置有效。

service sshd restart验证无密码登录本机是否成功。

ssh localhost3.1在Master上生成密钥:ssh-keygen -t rsa -P ''将Master上密钥拷贝至Slave1ssh-copy-id Slave1ssh命令测试是否连接成功ssh Slave1exit #退出重复上述操作,在Slave1上生成密钥:ssh-keygen -t rsa -P ''将Slave1上密钥拷贝至Masterssh-copy-id Slave13.6ssh命令测试是否连接成功ssh Masterexit #退出4.安装基础环境(JAVA和SCALA环境)4.1 Java1.8环境搭建1)下载jdk-8u144-linux-x64.tar.gz解压tar -zxvf jdk-8u144-linux-x64.tar.gz2)添加Java环境变量,在/etc/profile中添加:export JAVA_HOME=/usr/local/jdk1.8.0_144PATH=$JAVA_HOME/bin:$PATHCLASSPATH=.:$JAVA_HOME/lib/rt.jarexport JAVA_HOME PATH CLASSPATH3)保存后刷新配置source /etc/profile5.Hadoop3.0.0完全分布式搭建以下是在Master节点操作:1)下载二进制包hadoop-3.0.0-alpha4.tar.gz2)解压并移动到相应目录,我习惯将软件放到/opt目录下,命令如下:tar -zxvf hadoop-3.0.0-alpha4.tar.gzmv hadoop-3.0.0 /opt3)修改相应的配置文件。

Hadoop源代码eclipse编译教程

源代码eclipse编译教程一见/hadoopor@1.下载Hadoop源代码Hadoop各成员源代码下载地址:/repos/asf/hadoop,请使用SVN 下载,在SVN浏览器中将trunk目录下的源代码check-out出来即可:请注意只check-out出SVN上的trunk目录下的内容,如:/repos/asf/hadoop/common/trunk,而不是/repos/asf/hadoop/common,原因是/repos/asf/hadoop/common目录下包括了很多非源代码文件,并且很庞大,会导致需要很长的check-out时间。

建议组织成如下图所示的目录结构,以保持本地的目录结构和SVN上的目录结构一致:2.准备编译环境2.1.Hadoop代码版本本教程所采用的Hadoop是北京时间2009-8-26日上午下载的源代码,和hadoop-0.19.x 版本的差异可能较大。

2.2.联网编译Hadoop会依赖很多第三方库,但编译工具Ant会自动从网上下载缺少的库,所以必须保证机器能够访问Internet。

2.3.java编译Hadoop要求使用1.6或更新的JDK,可以从:/javase/downloads/index.jsp上下载JDK。

安装好之后,请设置好JAVA_HOME环境变量,如下图所示:2.4.Ant和Cygwin需要使用Ant工具来编译Hadoop,而Ant需要使用到Cygwin提供的一些工具,如sed 等,可以从:/ivy/download.cgi下载Ant,从/下载Cygwin(Cygwin的安装,请参考《在Windows上安装Hadoop教程》一文)。

安装好之后,需要将Ant和Cygwin的bin目录加入到环境变量PATH中,如下图所示:在安装Cygwin时,建议将SVN安装上,因为在Ant编译过程中会通过SVN下载些文件,但这个不是必须的,下载不成功时,并未见出错,编译仍然可以成功。

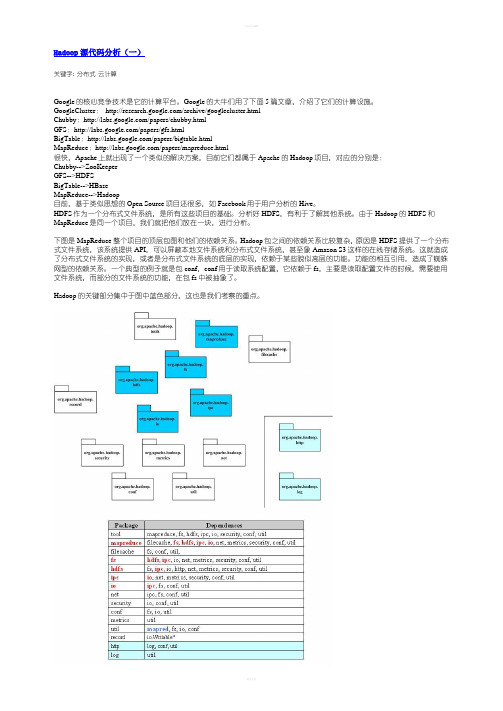

Hadoop源代码分析完整版

关键字: 分布式云计算Google的核心竞争技术是它的计算平台。

Google的大牛们用了下面5篇文章,介绍了它们的计算设施。

GoogleCluster:/archive/googlecluster.htmlChubby:/papers/chubby.htmlGFS:/papers/gfs.htmlBigTable:/papers/bigtable.htmlMapReduce:/papers/mapreduce.html很快,Apache上就出现了一个类似的解决方案,目前它们都属于Apache的Hadoop项目,对应的分别是:Chubby-->ZooKeeperGFS-->HDFSBigTable-->HBaseMapReduce-->Hadoop目前,基于类似思想的Open Source项目还很多,如Facebook用于用户分析的Hive。

HDFS作为一个分布式文件系统,是所有这些项目的基础。

分析好HDFS,有利于了解其他系统。

由于Hadoop的HDFS和MapReduce是同一个项目,我们就把他们放在一块,进行分析。

下图是MapReduce整个项目的顶层包图和他们的依赖关系。

Hadoop包之间的依赖关系比较复杂,原因是HDFS提供了一个分布式文件系统,该系统提供API,可以屏蔽本地文件系统和分布式文件系统,甚至象Amazon S3这样的在线存储系统。

这就造成了分布式文件系统的实现,或者是分布式文件系统的底层的实现,依赖于某些貌似高层的功能。

功能的相互引用,造成了蜘蛛网型的依赖关系。

一个典型的例子就是包conf,conf用于读取系统配置,它依赖于fs,主要是读取配置文件的时候,需要使用文件系统,而部分的文件系统的功能,在包fs中被抽象了。

Hadoop的关键部分集中于图中蓝色部分,这也是我们考察的重点。

下面给出了Hadoop的包的功能分析。

Hadoop源代码分析(三)由于Hadoop的MapReduce和HDFS都有通信的需求,需要对通信的对象进行序列化。

Hadoop编译指导(Maven)

Hadoop编译(Maven)1、环境准备根据Hadoop源码中的BUILDING.txt文件中的不同平台编译要求,安装编译所需要工具。

Linux系统一般包括:#版本根据Hadoop版本要求安装JDK tar包解压安装Maven tar包解压安装apache ant tar包解压安装yum install glibc-headersyum install gcc-c++yum install makeyum install cmakeProtobuf tar包解压安装(第5步注释掉后可以不安装)2、编译所有模块#编译mvn clean compile -Pdist,native -DskipTests或#打包mvn clean package -Pdist,native -DskipTests -Dtar3、部分模块编译假设我们只需要编译打包hadoop-commom和hadoop-hdfs这两个module,可以使用如下命令:mvn -e clean package -Pdist,native -DskipTests -Dmaven.javadoc.skip=true -Dtar -pl hadoop-common-project/,hadoop-hdfs-project/如果我们想同时编译这两个module所依赖的模块,可以在最后加上-am参数。

mvn -e clean package -Pdist,native -DskipTests -Dmaven.javadoc.skip=true -Dtar -pl hadoop-common-project/,hadoop-hdfs-project/ -am4、**编译模块限定参数-am, --also-make 同时构建所列模块的依赖模块。

必须和-pl同时使用。

如 mvn -pl test -am ,将同时构建test的依赖模块-amd, --also-make-dependents 同时构建依赖于所列模块的模块。

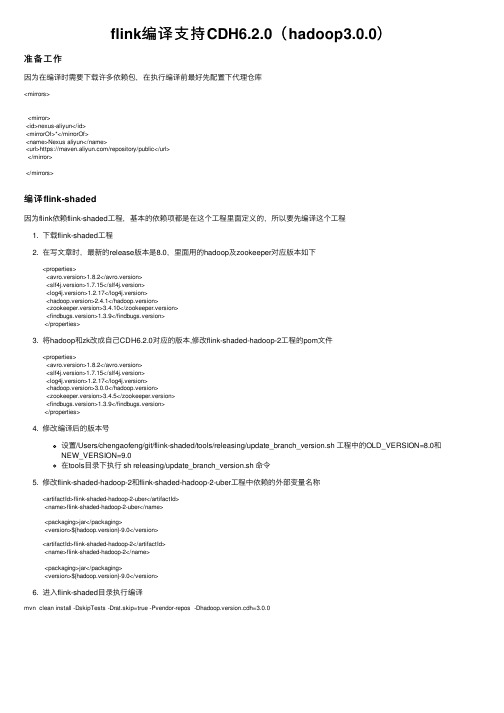

flink编译支持CDH6.2.0(hadoop3.0.0)

flink编译⽀持CDH6.2.0(hadoop3.0.0)准备⼯作因为在编译时需要下载许多依赖包,在执⾏编译前最好先配置下代理仓库<mirrors><mirror><id>nexus-aliyun</id><mirrorOf>*</mirrorOf><name>Nexus aliyun</name><url>https:///repository/public</url></mirror></mirrors>编译flink-shaded因为flink依赖flink-shaded⼯程,基本的依赖项都是在这个⼯程⾥⾯定义的,所以要先编译这个⼯程1. 下载flink-shaded⼯程2. 在写⽂章时,最新的release版本是8.0,⾥⾯⽤的hadoop及zookeeper对应版本如下<properties><avro.version>1.8.2</avro.version><slf4j.version>1.7.15</slf4j.version><log4j.version>1.2.17</log4j.version><hadoop.version>2.4.1</hadoop.version><zookeeper.version>3.4.10</zookeeper.version><findbugs.version>1.3.9</findbugs.version></properties>3. 将hadoop和zk改成⾃⼰CDH6.2.0对应的版本,修改flink-shaded-hadoop-2⼯程的pom⽂件<properties><avro.version>1.8.2</avro.version><slf4j.version>1.7.15</slf4j.version><log4j.version>1.2.17</log4j.version><hadoop.version>3.0.0</hadoop.version><zookeeper.version>3.4.5</zookeeper.version><findbugs.version>1.3.9</findbugs.version></properties>4. 修改编译后的版本号设置/Users/chengaofeng/git/flink-shaded/tools/releasing/update_branch_version.sh ⼯程中的OLD_VERSION=8.0和NEW_VERSION=9.0在tools⽬录下执⾏ sh releasing/update_branch_version.sh 命令5. 修改flink-shaded-hadoop-2和flink-shaded-hadoop-2-uber⼯程中依赖的外部变量名称<artifactId>flink-shaded-hadoop-2-uber</artifactId><name>flink-shaded-hadoop-2-uber</name><packaging>jar</packaging><version>${hadoop.version}-9.0</version><artifactId>flink-shaded-hadoop-2</artifactId><name>flink-shaded-hadoop-2</name><packaging>jar</packaging><version>${hadoop.version}-9.0</version>6. 进⼊flink-shaded⽬录执⾏编译mvn clean install -DskipTests -Drat.skip=true -Pvendor-repos -Dhadoop.version.cdh=3.0.0效果图编译flink1. 下载源码2. 写⽂章时最新的release版本是1.9,所以下载1.9版本的代码3. 修改对应的hadoop和flink.shaded.version值为我们需要的值<hadoop.version>3.0.0</hadoop.version>...<flink.shaded.version.old>7.0</flink.shaded.version.old><flink.shaded.version>9.0</flink.shaded.version>...<hivemetastore.hadoop.version>3.0.0</hivemetastore.hadoop.version>因为只想更新hadoop的版本,所以依赖的其他flink-shaded版本不做变更,以下jackson举例说明,还是⽤旧的版本(⽤最新的编译没有编译过)<dependency><groupId>org.apache.flink</groupId><artifactId>flink-shaded-jackson</artifactId><version>${jackson.version}-${flink.shaded.version.old}</version></dependency><dependency><groupId>org.apache.flink</groupId><artifactId>flink-shaded-jackson-module-jsonSchema</artifactId><version>${jackson.version}-${flink.shaded.version.old}</version></dependency>4. 修改flink-connectors/flink-hbase中依赖的hbase版本号<properties><hbase.version>2.1.2</hbase.version></properties>之后需要修改这个⼯程中的AbstractTableInputFormat.java,TableInputFormat.java以及junit中的编译错误5. 修改版本号修改tools/change-version.sh中新旧版本号OLD="1.9-SNAPSHOT"NEW="1.9-H3"6. 执⾏脚本change-version.sh7. 注释掉不需要编译的⼯程,因为这个编译太耗时间,可以把测试相关的包去掉8. 执⾏编译mvn clean install -DskipTests -Pvendor-repos -Drat.skip=true -Pinclude-hadoop 9. 编译结果10. 在⼯程中使⽤新编译出的版本<properties><flink.version>1.9-H3</flink.version></properties>对应修改后的代码地址版本:release-1.9。

HadoopHDFS源码分析读取命名空间镜像和编辑日志数据

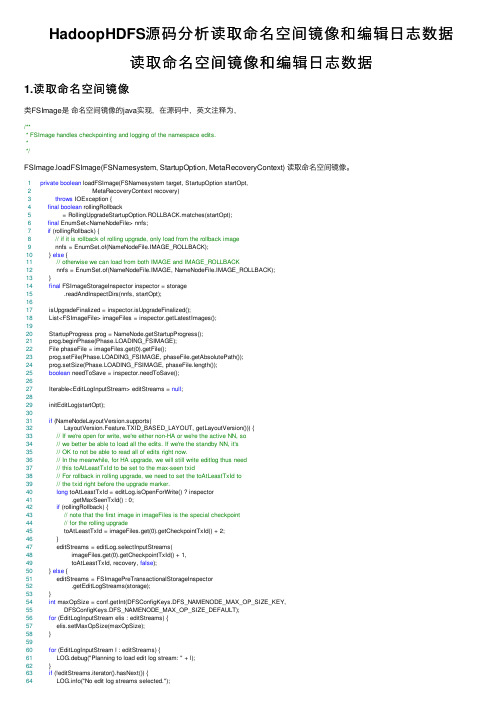

HadoopHDFS源码分析读取命名空间镜像和编辑⽇志数据读取命名空间镜像和编辑⽇志数据1.读取命名空间镜像类FSImage是命名空间镜像的java实现,在源码中,英⽂注释为,/*** FSImage handles checkpointing and logging of the namespace edits.**/FSImage.loadFSImage(FSNamesystem, StartupOption, MetaRecoveryContext) 读取命名空间镜像。

1private boolean loadFSImage(FSNamesystem target, StartupOption startOpt,2 MetaRecoveryContext recovery)3throws IOException {4final boolean rollingRollback5 = RollingUpgradeStartupOption.ROLLBACK.matches(startOpt);6final EnumSet<NameNodeFile> nnfs;7if (rollingRollback) {8// if it is rollback of rolling upgrade, only load from the rollback image9 nnfs = EnumSet.of(NameNodeFile.IMAGE_ROLLBACK);10 } else {11// otherwise we can load from both IMAGE and IMAGE_ROLLBACK12 nnfs = EnumSet.of(NameNodeFile.IMAGE, NameNodeFile.IMAGE_ROLLBACK);13 }14final FSImageStorageInspector inspector = storage15 .readAndInspectDirs(nnfs, startOpt);1617 isUpgradeFinalized = inspector.isUpgradeFinalized();18 List<FSImageFile> imageFiles = inspector.getLatestImages();1920 StartupProgress prog = NameNode.getStartupProgress();21 prog.beginPhase(Phase.LOADING_FSIMAGE);22 File phaseFile = imageFiles.get(0).getFile();23 prog.setFile(Phase.LOADING_FSIMAGE, phaseFile.getAbsolutePath());24 prog.setSize(Phase.LOADING_FSIMAGE, phaseFile.length());25boolean needToSave = inspector.needToSave();2627 Iterable<EditLogInputStream> editStreams = null;2829 initEditLog(startOpt);3031if (NameNodeLayoutVersion.supports(32 LayoutVersion.Feature.TXID_BASED_LAYOUT, getLayoutVersion())) {33// If we're open for write, we're either non-HA or we're the active NN, so34// we better be able to load all the edits. If we're the standby NN, it's35// OK to not be able to read all of edits right now.36// In the meanwhile, for HA upgrade, we will still write editlog thus need37// this toAtLeastTxId to be set to the max-seen txid38// For rollback in rolling upgrade, we need to set the toAtLeastTxId to39// the txid right before the upgrade marker.40long toAtLeastTxId = editLog.isOpenForWrite() ? inspector41 .getMaxSeenTxId() : 0;42if (rollingRollback) {43// note that the first image in imageFiles is the special checkpoint44// for the rolling upgrade45 toAtLeastTxId = imageFiles.get(0).getCheckpointTxId() + 2;46 }47 editStreams = editLog.selectInputStreams(48 imageFiles.get(0).getCheckpointTxId() + 1,49 toAtLeastTxId, recovery, false);50 } else {51 editStreams = FSImagePreTransactionalStorageInspector52 .getEditLogStreams(storage);53 }54int maxOpSize = conf.getInt(DFSConfigKeys.DFS_NAMENODE_MAX_OP_SIZE_KEY,55 DFSConfigKeys.DFS_NAMENODE_MAX_OP_SIZE_DEFAULT);56for (EditLogInputStream elis : editStreams) {57 elis.setMaxOpSize(maxOpSize);58 }5960for (EditLogInputStream l : editStreams) {61 LOG.debug("Planning to load edit log stream: " + l);62 }63if (!editStreams.iterator().hasNext()) {64 ("No edit log streams selected.");65 }6667 FSImageFile imageFile = null;68for (int i = 0; i < imageFiles.size(); i++) {69try {70 imageFile = imageFiles.get(i);71 loadFSImageFile(target, recovery, imageFile, startOpt);72break;73 } catch (IOException ioe) {74 LOG.error("Failed to load image from " + imageFile, ioe);75 target.clear();76 imageFile = null;77 }78 }79// Failed to load any images, error out80if (imageFile == null) {81 FSEditLog.closeAllStreams(editStreams);82throw new IOException("Failed to load an FSImage file!");83 }84 prog.endPhase(Phase.LOADING_FSIMAGE);8586if (!rollingRollback) {87long txnsAdvanced = loadEdits(editStreams, target, startOpt, recovery);88 needToSave |= needsResaveBasedOnStaleCheckpoint(imageFile.getFile(),89 txnsAdvanced);90if (RollingUpgradeStartupOption.DOWNGRADE.matches(startOpt)) {91// rename rollback image if it is downgrade92 renameCheckpoint(NameNodeFile.IMAGE_ROLLBACK, NameNodeFile.IMAGE);93 }94 } else {95// Trigger the rollback for rolling upgrade. Here lastAppliedTxId equals96// to the last txid in rollback fsimage.97 rollingRollback(lastAppliedTxId + 1, imageFiles.get(0).getCheckpointTxId());98 needToSave = false;99 }100 editLog.setNextTxId(lastAppliedTxId + 1);101return needToSave;102 }上⾯的代码中,for循环语句包含的代码⽤于读⼊⽂件的信息。

hadoop3.x源码编译

hadoop3.x源码编译1.最重要的参考资料2.编译环境Linux系统:Centos7.2Jdk版本:jdk1.8cmake版本:3.19Hadoop版本:3.1.2Maven版本:3.6.3Protobuf版本:2.5编译⼯具准备a.安装依赖yum -y install kernel-devel gcc* glibc-headers gcc-c++ zip-devel openssl-devel git ncurses-devel lzo-devel autoconf libtool automake b. java 和maven 环境java 和maven 环境⽤到的太普遍了,这个就不重复了c.安装protobuf可以先查看yum上的版本2.5.0正是所需要的,⽽不是官⽅⾥说的3.x,为什么呢?直接yum install -y protobufx下⾯是⼀段踩坑经历(可以跳过)正常解压后只要$ ./configure$ make$ make check$ make install但你会发现根本没有configure,我们需要执⾏autogen.sh去⽣成configure脚本执⾏autogen.sh,会发现⽆法下载gtest-1.5.0.tar.bz2我们需要⾃⾏下载gtest-1.5.0.tar.bz2,再执⾏autogen.sh⾥剩下的部分⽣成configured.安装CMake 3.19$ curl -L https:///files/v3.19/cmake-3.19.0.tar.gz > cmake-3.19.0.tar.gz$ tar -zxvf cmake-3.19.0.tar.gz && cd cmake-3.19.0$ ./bootstrap$ make -j$(nproc)$ sudo make install3.下载hadoop源码进⾏编译注意为了更好的性能,要使⽤ Native Hadoop Library解压后 ,cd hadoop-3.2.2-src执⾏mvn package -Pdist -DskipTests,native-Dtar -Dmaven.javadoc.skip=true编译中可能因为⽹络问题,有些包⽆法下载并先删除本地仓库中相应包⽬录下的缓存⽂件,再⽤maven安装到本地,再编译源码。

Hadoop(一)Hadoop的简介与源码编译

Hadoop(⼀)Hadoop的简介与源码编译⼀ Hadoop简介1.1Hadoop产⽣的背景1. HADOOP最早起源于Nutch。

Nutch的设计⽬标是构建⼀个⼤型的全⽹搜索引擎,包括⽹页抓取、索引、查询等功能,但随着抓取⽹页数量的增加,遇到了严重的可扩展性问,如何解决数⼗亿⽹页的存储和索引问题。

2. 2003年开始⾕歌陆续发表的三篇论⽂为该问题提供了可⾏的解决⽅案。

分布式⽂件系统(GFS),可⽤于处理海量⽹页的存储分布式计算框架MAPREDUCE,可⽤于处理海量⽹页的索引计算问题。

BigTable 数据库:OLTP 联机事务处理 Online Transaction Processing 增删改,OLAP 联机分析处理 Online Analysis Processing 查询,真正的作⽤:提供了⼀种可以在超⼤数据集中进⾏实时CRUD操作的功能3.Nutch的开发⼈员完成了相应的开源实现HDFS和MAPREDUCE,并从Nutch中剥离成为独⽴项⽬HADOOP,到2008年1⽉,HADOOP成为Apache顶级项⽬,迎来了它的快速发展期。

1.2 Hadoop的优势1)⾼可靠性:因为Hadoop假设计算元素和存储会出现故障,因为它维护多个⼯作数据副本,在出现故障时可以对失败的节点重新分布处理2)⾼扩展性:在集群间分配任务数据,可⽅便的扩展数以千计的节点。

3)⾼效性:在MapReduce的思想下,Hadoop是并⾏⼯作的,以加快任务处理速度。

4)⾼容错性:⾃动保存多份副本数据,并且能够⾃动将失败的任务重新分配。

1.3 Hadoop组成1)Hadoop HDFS:⼀个⾼可靠、⾼吞吐量的分布式⽂件系统。

2)Hadoop MapReduce:⼀个分布式的离线并⾏计算框架。

3)Hadoop YARN:作业调度与集群资源管理的框架。

4)Hadoop Common:⽀持其他模块的⼯具模块。

1.4.1 YARN架构概述1)ResourceManager(rm):处理客户端请求、启动/监控ApplicationMaster、监控NodeManager、资源分配与调度;2)NodeManager(nm):单个节点上的资源管理、处理来⾃ResourceManager的命令、处理来⾃ApplicationMaster的命令;3)ApplicationMaster:数据切分、为应⽤程序申请资源,并分配给内部任务、任务监控与容错。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.

2.编译步骤

(1)jdk安装和部署

1.安装jdk

cd /home/lly/下载/hadoop/

rpm –ivhjdk-8u101-linux-x64.rpm

2.添加环境变量

$sudo vim /etc/profile

3.加入如下内容

export JAVA_HOME=/usr/java/jdk1.8.0_101

export JRE_HOME=$JAVA_HOME/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JER_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$JER_HOME/bin:$PATH

按”esc”

:w

:q

4.立刻应用改变

$sudo source /etc/profile

5.测试

java –version

java version "1.8.0_101"

Java(TM) SE Runtime Environment (build 1.8.0_101-b13)

Java HotSpot(TM) 64-Bit Server VM (build 25.101-b13, mixed mode)

(2)maven安装和部署

1.解压

cd /home/lly/下载/hadoop/

tarzxvfapache-maven-3.3.9-bin.tar.gz -C /usr/soft

2.添加环境变量

$sudo vim /etc/profile

3.加入如下内容

export MAVEN_HOME=/usr/soft/apache-maven-3.3.3

export PATH=.:$PATH:$JAVA_HOME/bin:$MAVEN_HOME/bin

按”esc”

:w

:q

4.立刻应用改变

$sudo source /etc/profile

5.测试

mvn -version

Apache Maven 3.3.9 (bb52d8502b132ec0a5a3f4c09453c07478323dc5;

2015-11-11T00:41:47+08:00)

Maven home: /usr/soft/apache-maven-3.3.9

Java version: 1.8.0_101, vendor: Oracle Corporation

Java home: /usr/java/jdk1.8.0_101/jre

(3)依赖安装

1.输入命令

$sudoyum install g++ autoconfautomakelibtoolcmakezlib1g-dev pkg-configlibssl-de (4)安装cmake

1.解压

cd /home/lly/下载/hadoop/

tarzxvfcmake-3.6.2.tar.gz -C /usr/soft

2.安装

cd/usr/soft/cmake-3.6.2

./bootstrap

make

make install

3.测试

cmake–version

(5)安装protobuf

1.解压

cd /home/lly/下载/hadoop/

tarzxvfprotobuf-2.5.0.tar.gz -C /usr/soft

2.安装

cd/usr/soft/protobuf-2.5.0

./configure --prefix=/usr/soft/protobuf-2.5.0

make

make install

3.安装成功后可将编译程序链接到系统bin目录下,以免每次使用都加绝对路径

cd /usr/soft/protobuf-2.5.0/bin

ln -s /usr/soft/protobuf-2.5.0/bin/protoc /usr/bin/protoc

4.测试(出现libprotoc 2.

5.0证明成功)

protoc --version

(6)编译hadoop3.0

1.解压

cd /home/lly/下载/hadoop/

tarzxvfhadoop-3.0.0-alpha1-src.tar.gz -C /usr/soft

2.进入hadoop-2.7.1-src目录,执行编译

cd /usr/soft/ hadoop-3.0.0-alpha1-src/

mvn clean package -Pdist,native -DskipTests–Dtar

3.缺少zlib

yum -y install zlib-devel

4.缺少openssl

yum -y install openssl

cmake -DCMAKE_PREFIX_PATH=/usr/local/opt/openssl。