Hadoop期中考试 测试

(完整版)hadoop常见笔试题答案

Hadoop测试题一.填空题,1分(41空),2分(42空)共125分1.(每空1分) datanode 负责HDFS数据存储。

2.(每空1分)HDFS中的block默认保存 3 份。

3.(每空1分)ResourceManager 程序通常与NameNode 在一个节点启动。

4.(每空1分)hadoop运行的模式有:单机模式、伪分布模式、完全分布式。

5.(每空1分)Hadoop集群搭建中常用的4个配置文件为:core-site.xml 、hdfs-site.xml、mapred-site.xml 、yarn-site.xml 。

6.(每空2分)HDFS将要存储的大文件进行分割,分割后存放在既定的存储块中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。

7.(每空2分)一个HDFS集群包括两大部分,即namenode 与datanode 。

一般来说,一个集群中会有一个namenode 和多个datanode 共同工作。

8.(每空2分) namenode 是集群的主服务器,主要是用于对HDFS中所有的文件及内容数据进行维护,并不断读取记录集群中datanode 主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。

9.(每空2分) datanode 在HDFS集群中担任任务具体执行角色,是集群的工作节点。

文件被分成若干个相同大小的数据块,分别存储在若干个datanode 上,datanode 会定期向集群内namenode 发送自己的运行状态与存储内容,并根据namnode 发送的指令进行工作。

10.(每空2分) namenode 负责接受客户端发送过来的信息,然后将文件存储位置信息发送给client ,由client 直接与datanode 进行联系,从而进行部分文件的运算与操作。

11.(每空1分) block 是HDFS的基本存储单元,默认大小是128M 。

(完整版)hadoop常见笔试题答案

(完整版)hadoop常见笔试题答案Hadoop测试题一.填空题,1分(41空),2分(42空)共125分1.(每空1分) datanode 负责HDFS数据存储。

2.(每空1分)HDFS中的block默认保存 3 份。

3.(每空1分)ResourceManager 程序通常与NameNode 在一个节点启动。

4.(每空1分)hadoop运行的模式有:单机模式、伪分布模式、完全分布式。

5.(每空1分)Hadoop集群搭建中常用的4个配置文件为:core-site.xml 、hdfs-site.xml、mapred-site.xml 、yarn-site.xml 。

6.(每空2分)HDFS将要存储的大文件进行分割,分割后存放在既定的存储块中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。

7.(每空2分)一个HDFS集群包括两大部分,即namenode 与datanode 。

一般来说,一个集群中会有一个namenode 和多个datanode 共同工作。

8.(每空2分) namenode 是集群的主服务器,主要是用于对HDFS 中所有的文件及内容数据进行维护,并不断读取记录集群中datanode 主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。

9.(每空2分) datanode 在HDFS集群中担任任务具体执行角色,是集群的工作节点。

文件被分成若干个相同大小的数据块,分别存储在若干个datanode 上,datanode 会定期向集群内namenode 发送自己的运行状态与存储内容,并根据namnode 发送的指令进行工作。

10.(每空2分) namenode 负责接受客户端发送过来的信息,然后将文件存储位置信息发送给client ,由client 直接与datanode 进行联系,从而进行部分文件的运算与操作。

11.(每空1分) block 是HDFS的基本存储单元,默认大小是128M 。

Hadoop基础(习题卷8)

Hadoop基础(习题卷8)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]在Java中,<? version="1.0" encoding=”UTF-8”>这行声明该文档采用了什么编码标准A)GB2312B)ANSIC)ISO-8859-1D)UTF-8答案:D解析:2.[单选题]关于hadoop集群描述正确的是( )A)hadoop集群组件之间通过RPC通信协议B)hadoop集群NameNode节点越多越好C)hadoop集群使用Namenode存储元数据D)以上都正确答案:A解析:3.[单选题]HDFS 默认 Block SizeA)32MBB)64MBC)128MBD)240MB答案:B解析:4.[单选题]下面属于Hadoop特点的是()A)低价值密度B)低吞吐量C)高容错D)高成本答案:C解析:5.[单选题]编写MapReduce必须继承()类A)ConfiguredB)DonfiguredC)AonfiguredD)Writable答案:A解析:6.[单选题]在Java中,File类提供的方法中,哪个方法可以获取一个目录下所有子文件对象D)listFiles()答案:D解析:7.[单选题]HDFS结构不包括________。

A)Master体系结构B)主从服务器C)元数据服务器D)存储服务器答案:A解析:8.[单选题]下列哪一项不属于数据库事务具有ACID四性?A)间断性B)原子性C)一致性D)持久性答案:A解析:9.[单选题]客户端从Zookeeper获取Region的存储位置信息后,直接在_______上读写数据。

A)ZookeeperB)HMasterC)Region ServerD)HLog答案:C解析:10.[单选题]对NodeManager服务描述不正确的是( )A)NodeManager负责单节点资源管理和使用B)NodeManager管理当前节点的ContainerC)向ResourceManager汇报本节点上的资源使用情况D)NodeManager服务器不需要与ResourceManager通信答案:D解析:11.[单选题]下面对分区描述的过程正确的是( )A)merge是将多个溢写文件合并到一个文件B)merge过程不可能有Combiner处理C)缓冲区的作用不大D)以上都不正确答案:A解析:12.[单选题]云计算发展对产业的影响对一般企业和机构来说主要是( )。

Hadoop试题试题库完整

Hadoop试题试题库完整1. 以下哪⼀项不属于Hadoop可以运⾏的模式___C___。

A. 单机(本地)模式B. 伪分布式模式C. 互联模式D. 分布式模式2. Hadoop的作者是下⾯哪⼀位__B____。

A. Martin FowlerB. Doug cuttingC. Kent BeckD. Grace Hopper3. 下列哪个程序通常与 NameNode 在同⼀个节点启动__D___。

A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker4. HDFS 默认 Block Size的⼤⼩是___B___。

A.32MBB.64MBC.128MBD.256M5. 下列哪项通常是集群的最主要瓶颈____C__。

A. CPUB. ⽹络C. 磁盘IOD. 内存6. 下列关于MapReduce说法不正确的是_____C_。

A. MapReduce是⼀种计算框架B. MapReduce来源于google的学术论⽂C. MapReduce程序只能⽤java语⾔编写D. MapReduce隐藏了并⾏计算的细节,⽅便使⽤8. HDFS是基于流数据模式访问和处理超⼤⽂件的需求⽽开发的,具有⾼容错、⾼可靠性、⾼可扩展性、⾼吞吐率等特征,适合的读写任务是 __D____。

A.⼀次写⼊,少次读C.多次写⼊,多次读D.⼀次写⼊,多次读9. HBase依靠__A____存储底层数据。

A. HDFSB. HadoopC. MemoryD. MapReduce10. HBase依赖___D___提供强⼤的计算能⼒。

A. ZookeeperB. ChubbyC. RPCD. MapReduce11. HBase依赖___A___提供消息通信机制A. ZookeeperB. ChubbyC. RPCD. Socket12. 下⾯与HDFS类似的框架是___C____?A. NTFSB. FAT32C. GFSD. EXT313. 关于 SecondaryNameNode 下⾯哪项是正确的___C___。

Hadoop基础(习题卷3)

Hadoop基础(习题卷3)第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]大数据的简单算法与小数据的复杂算法相比()A)更有效B)相当C)不具备可比性D)无效答案:A解析:2.[单选题]下列选项中,不是CouchDB的复制中的特点是:A)使用优先列表B)复制过程是逐步进行C)允许分区复制D)支持智能文档模式答案:A解析:3.[单选题]从HDFS下载文件,正确的shell命令是()。

A)-getB)-appendToFileC)-putD)-copyFromLocal答案:A解析:4.[单选题]关于HDFS集群中的DataNode的描述不正确的是?A)存储客户端上传的数据的数据块B)一个DataNode上存储的所有数据块可以有相同的C)DataNode之间可以互相通信D)响应客户端的所有读写数据请求,为客户端的存储和读取数据提供支撑答案:B解析:5.[单选题]在Java中,一个线程如果调用了sleep()方法,能唤醒它的方法是A)notify()B)resume()C)run()D)以上都不是,时间到了会自动继续执行答案:D解析:6.[单选题]软件是大数据的_________。

A)核心解析:7.[单选题]_______模式,只适合于Hive简单试用及单元测试。

A)单用户模式B)多用户模式C)多用户远程模式D)单用户远程模式答案:A解析:8.[单选题]下列关于Hive描述错误的是()。

A)hive学习成本低,支持标准的SQL语法B)hive运行效率低,延迟高C)HQL的表达能力有限D)Hive支持迭代计算答案:D解析:9.[单选题]下面哪个选项不是我们需要Hadoop的主要原因()A)我们需要处理PB级别的数据B)为每个应用建立一个可靠的系统是很昂贵的C)几乎每天都有结点坏掉D)把一个任务分割成多个子任务的方式是不好的答案:D解析:10.[单选题]为了让集群中的机器能够正常通信,所有集群的IP必须设置成静态IP,防止机器重启之后而找不到机器的情况,那么IP地址配置需要修改那个文件()A)ifcfg-loB)network-functionsC)ifcfg-ens33D)network-functions-ipv6答案:C解析:11.[单选题]Spark生态系统组件Spark Streaming的应用场景是?A)基于历史数据的数据挖掘B)图结构数据的处理C)基于历史数据的交互式查询D)基于实时数据流的数据处理答案:D解析:12.[单选题]关于HDFS集群中的DataNode的描述不正确的是?A)DataNode之间都是独立的,相互之间不会有通信B)存储客户端上传的数据的数据块C)响应客户端的所有读写数据请求,为客户端的存储和读取数据提供支撑13.[单选题]Hadoop2.x版本中的数据块大小默认是多少? ()A)64MB)128MC)256MD)512M答案:B解析:14.[单选题]HDFS分布式文件系统的特点为____________。

Hadoop基础(习题卷1)

Hadoop基础(习题卷1)说明:答案和解析在试卷最后第1部分:单项选择题,共145题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]以下哪一项不属于Hadoop可以运行的模式()A)单机模式B)伪分布式模式C)互联模式D)分布式模式2.[单选题]下列哪一个不属于Hadoop的大数据层的功能?A)数据挖掘B)离线分析C)实时计算D)BI分析3.[单选题]用于检查节点自身的健康状态的进程是( )A)ResourceManagerB)NodeManagerC)NameNodeD)DataNode4.[单选题]下面与Zookeeper类似的框架是?A)ProtobufB)JavaC)KafkaD)Chubby5.[单选题]哪个不是HDFS的特点?A)高容错B)高吞吐量C)低延迟读取D)大文件存储6.[单选题]在mapreduce任务中,下列哪一项会由hadoop系统自动排序()A)keys of mapper's outputB)values of mapper's outputC)keys of reducer's outputD)values of reducer's output7.[单选题]HDFS的是基于流数据模式访问和处理超大文件的需求而开发的,默认的最基本的存储单位是64M,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是?A)一次写入,多次读写B)一次写入,少次读写C)多次写入,少次读写D)多次写入,多次读写8.[单选题]下列哪项通常是集群的最主要的性能瓶颈? ()A)CPUB)网络C)磁盘D)内存9.[单选题]以下选项中,哪种类型间的转换是被Hive查询语言所支持的()A)Double-NumberB)BigInt-DoubleC)Int-BigIntD)String--Double10.[单选题]下面哪个选项中的Daemon总是运行在同一台主机上()A)Name Node & Job TrackerB)Secondary Name Node & Job TrackerC)Name Node & Secondary Name NodeD)Data Node & Task Tracker11.[单选题]2003年,Google公司发表了主要讲解海量数据的可靠存储方法的论文是?A)“TheGoogleFileSystem”B)“MapReduce:SimplifiedDataProcessingonLargeClusters”C)“Bigtable:ADistributedStorageSystemforStructuredData”D)“TheHadoopFileSystem”12.[单选题]下列_______通常与NameNode在一个节点启动。

《Hadoop与Spark大数据架构 》综合测试题含答案

《Hadoop与Spark大数据架构》综合测试题含答案1. Spark计算模型中作为数据处理单元的是? [单选题] *A. SplitB. RDD(正确答案)C. TupleD. Partition2. 和MapReduce相比较,Spark编程模型更加适合处理以下哪种计算模式 [单选题] *A. 迭代计算(正确答案)B. 批处理C. 流计算D. 高性能计算3. Spark在以下哪一种模式下无法运行? [单选题] *A. 本地模式B. Apache MesosC. Hadoop 1.0(正确答案)D. Hadoop 2.04. 以下哪种数据库适合处理半结构化数据? [单选题] *A. OracleB. MySQLC. SQLServerD. HBase(正确答案)5. 以下哪种场景不适合流计算引擎进行处理? [单选题] *A. Web应用用户点击行为实时统计B. 电子商务应用的实时推荐C. 大量文件的词频分析(正确答案)D. 数据从采集系统经过转换存入HDFS6. MapReduce程序中的Map任务主要用来执行以下哪种操作? [单选题] *A. 数据提取(正确答案)B. 全局归并C. 数据传输D. 事务处理7. 以下哪个组件是HDFS用来进行目录结构和修改日志管理的组件? [单选题] *A. ResourceManagerB. NodeManagerC. DataNodeD. NameNode(正确答案)8. 分布式文件系统HDFS为了提供数据的可靠性。

采用副本方式通过资源冗余保证数据可靠性,在常用的工程实践中,数据在分布式存储系统中保存时一共保存几份? [单选题] *A、2B、3(正确答案)C、4D、59. 以下哪个组件是Spark中用来提供机器学习算法库的组件? [单选题] *A. HiveB. SparkSQLC. MLlib(正确答案)D. Mahout10. 以下哪个组件是YARN用来进行资源管理和调度任务执行的组件? [单选题] *A. ResourceManager(正确答案)B. NodeManagerC. JobTrackerD. TaskTracker11. 使用Hive进行SQL分析时,以下哪个组件是Hive用来保存数据库、表模式等信息的? [单选题] *A. DriverB. ParserC. OptimizerD. Metastore(正确答案)12. MapReduce程序通常包括map、本地的归并(local groupby),shufle和reduce 四步操作。

Hadoop基础(习题卷5)

Hadoop基础(习题卷5)说明:答案和解析在试卷最后第1部分:单项选择题,共54题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]使用下面那个命令可以将HDFS目录中所有文件合并到一起A)putmergeB)getmergeC)remergeD)mergeALL2.[单选题]下列关于Map/Reduce并行计算模型叙述正确的一项为________。

A)Map/Reduce把待处理的数据集分割成许多大的数据块B)大数据块经Map()函数并行处理后输出新的中间结果C)reduce()函数把多任务处理后的中间结果进行汇总D)reduce阶段的作用接受来自输出列表的迭代器3.[单选题]Hadoop伪分布式是()A)一个操作系统B)一台机器C)一个软件D)一种概念4.[单选题]在MapReduce任务中,下列哪一项会由hadoop自动排序?A)keys of mapper's outputB)values of mapper's outputC)keys of reducer's outputD)values of reducer's output5.[单选题]使配置的环境变量生效的命令是( )A)vi ~/.bashrcB)source ~/bashrcC)cat ~/.bashrcD)source ~/.bashrc6.[单选题]在命令模式中,以下那个命令不会进入输入模式?A)qB)oC)iD)a7.[单选题]DataNode默认存放目录为()A)/opt/hadoop-record/softC)/home/hadoop-record/softD)/opt/hadoop-record/data8.[单选题]HDFS 2.x默认Block Size ( )A)16MBB)32MBC)64MBD)128MB9.[单选题]在本次项目实施中,需求调研前的准备不包括( )。

Hadoop和Hbase测试题

Hadoop、HBase测试题一、选择题(共15题,每题4分,共60分)1. 以下哪一项不属于Hadoop可以运行的模式______。

A. 单机(本地)模式B. 伪分布式模式C. 互联模式D. 分布式模式2. Hadoop的作者是下面哪一位______。

A. Martin FowlerB. Doug cuttingC. Kent BeckD. Grace Hopper3. 下列哪个程序通常与NameNode 在同一个节点启动_____。

A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker4. HDFS 默认Block Size的大小是______。

A.32MBB.64MBC.128MBD.256M5. 下列哪项通常是集群的最主要瓶颈______。

A. CPUB. 网络C. 磁盘IOD. 内存6. 下列关于MapReduce说法不正确的是______。

A. MapReduce是一种计算框架B. MapReduce来源于google的学术论文C. MapReduce程序只能用java语言编写D. MapReduce隐藏了并行计算的细节,方便使用7. HDFS文件系统中一个gzip文件大小75MB,客户端设置Block的大小为默认,请问此文件占用几个Block______。

A. 1B. 2C. 3D. 48. HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是______。

A.一次写入,少次读B.多次写入,少次读C.多次写入,多次读D.一次写入,多次读9. HBase依靠______存储底层数据。

A. HDFSB. HadoopC. MemoryD. MapReduce10. HBase依赖______提供强大的计算能力。

A. ZookeeperB. ChubbyC. RPCD. MapReduce11. HBase依赖______提供消息通信机制A. ZookeeperB. ChubbyC. RPCD. Socket12. 下面与HDFS类似的框架是_______?A. NTFSB. FAT32C. GFSD. EXT313. 关于SecondaryNameNode 下面哪项是正确的______。

Hadoop题库_共2页

1.以下哪一项不属于 Hadoop 可以运行的模式—C —。

A. 单机(本地)模式B. 伪分布式模式C 互联模式D. 分布式模式2. Hadoop 的作者是下面哪一位__B _______ 。

A. Martin FowlerB. Doug cuttingC. Kent BeckD. Grace Hopper3.下列哪个程序通常与 NameNode 在同一个节点启动_D___。

A. TaskTrackerB. DataNodeC. SecondaryNameNodeD. Jobtracker 4. HDFS 默认 Block Size 的大小是 ___B___。

A. 32MBB. 64MBC. 128MBD.256MB. 网络C 磁盘IOD.内存 6.下列关于 MapReduce 说法不正确的是 ________ A. Ma pReduce 是一种计算框架B. Ma pReduce 来源于google 的学术论文C. Map Reduce 程序只能用 java 语言编写D. Ma pReduce 隐藏了并行计算的细节,方便使用8. HDF 淀基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是 _____ __D 。

A. —次写入, B. 多次写入, C. 多次写入, 5.下列哪项通常是集群的最主要瓶颈A. CPUC__。

C_。

少次读 少次读 多次读 多次读D.—次写入,9. HBase依靠A存储底层数据。

A. HDFSB.HadoopC.MemoryD.MapReduce10. HBase依赖—D___提供强大的计算能力。

A.ZookeeperB.ChubbyC.RPCD. MapReduce11. HBase依赖A提供消息通信机制A.ZookeeperB.ChubbyC.RPCD. Socket12.下面与HDFS类似的框架是—C _________ ?A.NTFSB.FAT32C.GFSD.EXT3 13.关于SecondaryNameNode下面哪项是正确的C_。

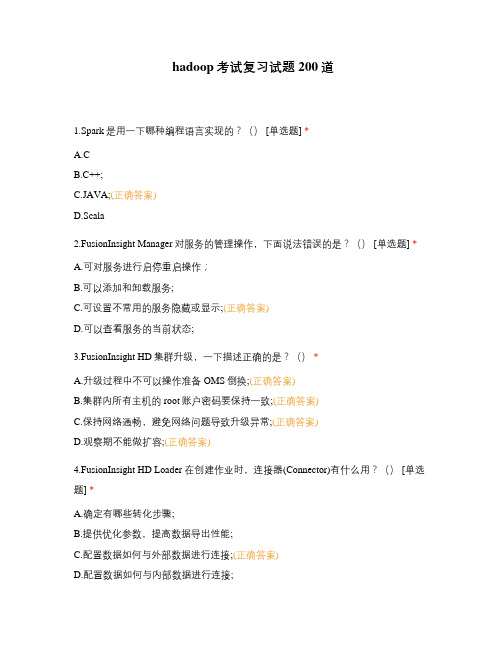

hadoop考试复习试题200道

hadoop考试复习试题200道1.Spark是用一下哪种编程语言实现的?() [单选题] *A.CB.C++;C.JAVA;(正确答案)D.Scala2.FusionInsight Manager对服务的管理操作,下面说法错误的是?() [单选题] *A.可对服务进行启停重启操作;B.可以添加和卸载服务;C.可设置不常用的服务隐藏或显示;(正确答案)D.可以查看服务的当前状态;3.FusionInsight HD集群升级,一下描述正确的是?() *A.升级过程中不可以操作准备OMS倒换;(正确答案)B.集群内所有主机的root账户密码要保持一致;(正确答案)C.保持网络通畅,避免网络问题导致升级异常;(正确答案)D.观察期不能做扩容;(正确答案)4.FusionInsight HD Loader 在创建作业时,连接器(Connector)有什么用?() [单选题] *A.确定有哪些转化步骤;B.提供优化参数,提高数据导出性能;C.配置数据如何与外部数据进行连接;(正确答案)D.配置数据如何与内部数据进行连接;5.下列哪个HDFS命令可用于检测数据块的完整性?() [单选题] *A.hdfs fsck /;(正确答案)B.hdfs fsck / -delete;C.hdfs dfsadmin -report;D.hdfs balancer -threshold 1;6.YARN中设置队列QueueA最大使用资源里,需要配置哪个参数?() [单选题] *A.yarn scheduler capacty root QueueA user-limit-factor;B.yarn scheduler capacty root QueueA minimum-user-limit-percent;C.yarn scheduler capacty root QueueA state;D.yarn scheduler capacty root QueueA maximum-capacity;(正确答案)7.Flume的数据流可以根据headers的信息发送到不同的channel中。

Hadoop期中考试-测试

(20)既然有了Hive,还需要用MapReduce编写程序处理数据吗?(B)

A.不需要

B.需要

2.多选题(每个4分,共20分)

(1)关于HDFS,说法正确的是(ABC)

A.不存在NameNode单点故障问题

B.一个集群可存在多个NameNode对外提供服务

C.HDFS HA和Federation是它的两大特色

Hadoop

1.单选题(每个1.5分,共20分)

(1)Mapreduce擅长哪个领域的计算(A)。

A.离线批处理

B. DAG计算

C.流式计算

D.实时计算

(2)关于MapReduce原理,下面说法错误的是(D)。

A.分为Map和Reduce两个阶段

B. Map阶段由一系列Map任务组成

C. Reduce阶段由一系列Reduce任务组成

D.用户自己指定

HDFS,Block默认大小为128MB。

一个Block文件只能来自于一个文件。

查看一个文件有多少个Block的命令:hdfsfsck /input –files –blocks -locations

(19)Hive和Presto支持标准SQL吗?(BD)

A.都支持

B.都不支持

C. Hive支持,Presto不支持

A. row key

B. column family名称

C.表名

D.列名

E.版本号

F. cell值

数据存储冗余,非常耗费空间

(18)默认情况下,一个MapReduce作业(处理的数据HDFS上的一个目录)的map task个数是由(B)决定的。

A.目录中文件个数

Hadoop测试题

Hadoop测试题(100分)1、下面哪个程序负责HDFS 数据存储?(单选题)【单选题】NodeB.JobtrackerC.DatanodeD.secondaryNameNodeE.tasktracker正确答案: C2、HDfS 中的block 默认保存几份?(单选题)【单选题】A.3 份B.2 份C.1 份D.不确定正确答案: A3、下列哪个程序通常与NameNode 在一个节点启动?(单选题)【单选题】A.SecondaryNameNodeB.DataNodeC.TaskTrackerD.Jobtracker正确答案: D4、Hadoop 作者是哪位?(单选题)【单选题】A.Martin FowlerB.Kent BeckC.Doug cutting正确答案: C5、HDFS 默认Block Size是多少?(单选题)【单选题】A.32MBB.64MBC.128MB正确答案: B6、下列哪项通常是集群的最主要瓶颈?(单选题)【单选题】A.CPUB.网络C.磁盘IOD.内存正确答案: C7、关于SecondaryNameNode 哪项是正确的?(单选题)【单选题】A.它是NameNode 的热备B.它对内存没有要求C.它的目的是帮助NameNode 合并编辑日志,减少NameNode 启动时间D.SecondaryNameNode 应与NameNode 部署到一个节点正确答案: C8、Client 端上传文件的时候下列哪项正确?(单选题)【单选题】A.数据经过NameNode 传递给DataNodeB.Client 端将文件切分为Block,依次上传C.Client 只上传数据到一台DataNode,然后由NameNode 负责Block 复制工作正确答案: B9、配置机架感知的下面哪项正确?(多选题)【多选题】(10分)A.如果一个机架出问题,不会影响数据读写B.写入数据的时候会写到不同机架的DataNode 中C.MapReduce 会根据机架获取离自己比较近的网络数据正确答案: ABC10、下列哪个是Hadoop 运行的模式?(多选题)【多选题】(10分)A.单机版B.伪分布式C.分布式正确答案: ABC。

Hadoop期中考试-测试

B. MapReduce

C. HBase

D. YARN

(7)不属于HBase中的术语的是(D)。

A. Column

B. Column Family

C. Row Key

D. Meta

(8)下面关于Hive,说法错误的是(A)。

A. Hive支持所有标准SQL语法

B. Hive底层采用的计算引擎是MapReduce(目前支持Spark、Tez等)

★(5)关于Block和Split两个概念,下面说法错误的是(C)。

A. Block是HDFS中最小的数据存储单位

B. Split是MapReduce中最小的计算单元

C. Block是Split是一一对应关系(默认是一一对应的)

D. Block和Split之间对应关系是任意的,可由用户控制

(6)以下不属于Hadoop内核的组成部分的是(C)。

答:

createtable if not exists test(

id int,

namename string

)

gzip

storedas parquet;

4.编程题(40分)

(1)有一批文件,格式如下:

每行有4列,每一列均是一个整数,列之间采用“.”作为分隔符,将数据按照第二列和第三列分组,每组中第四列所有数之和。注:如果第二列相同,则按照第三列分组,比如上述结果为:

12.13

14.25

11.41

结果中,key为“第二列和第三列”值,value是对应的第四列累加和,key和value之间使用\t分割。

要求:

使用任意语言实现以上功能,写出Mapper和Reducer,并给出相应的作业提交命令(或脚本)。

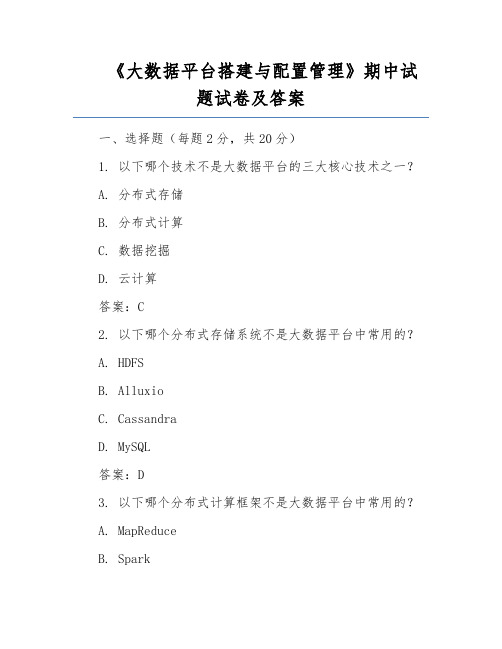

《大数据平台搭建与配置管理》期中试题试卷及答案

《大数据平台搭建与配置管理》期中试题试卷及答案一、选择题(每题2分,共20分)1. 以下哪个技术不是大数据平台的三大核心技术之一?A. 分布式存储B. 分布式计算C. 数据挖掘D. 云计算答案:C2. 以下哪个分布式存储系统不是大数据平台中常用的?A. HDFSB. AlluxioC. CassandraD. MySQL答案:D3. 以下哪个分布式计算框架不是大数据平台中常用的?A. MapReduceB. SparkC. FlinkD. Hadoop答案:D4. 以下哪个大数据平台组件主要用于数据采集?A. KafkaB. HDFSC. SparkD. Elasticsearch答案:A5. 以下哪个配置管理工具在大数据平台中应用较广泛?A. PuppetB. AnsibleC. SaltStackD. All of the above答案:D二、填空题(每题2分,共20分)6. 大数据平台的搭建主要包括:数据采集、______、数据存储、数据处理和分析、数据可视化等环节。

答案:数据清洗7. 在大数据平台中,HDFS负责______,MapReduce负责______。

答案:分布式存储,分布式计算8. Spark相比于MapReduce,具有______、______、______等优势。

答案:运行速度快、内存计算、易于编程9. 大数据平台中的配置管理主要包括:硬件配置、软件配置、______、______等。

答案:网络配置,安全配置10. 在大数据平台中,Kafka主要应用于______、______、______等场景。

答案:消息队列,数据采集,数据流处理三、简答题(每题5分,共30分)11. 简述大数据平台搭建的主要步骤。

答案:(1)需求分析:明确项目需求、目标、业务场景等;(2)技术选型:根据需求选择合适的分布式存储、计算框架、数据采集、处理和分析工具等;(3)硬件部署:搭建服务器、存储设备、网络设备等;(4)软件安装与配置:安装分布式存储、计算框架、数据采集、处理和分析工具等软件,并进行相应配置;(5)数据集成:将采集到的数据存储到分布式存储系统中;(6)数据处理与分析:使用分布式计算框架对数据进行处理和分析;(7)数据可视化:将处理和分析后的数据可视化展示;(8)运维管理:对大数据平台进行监控、维护、优化等。

hadoop常见笔试题答案

hadoop常见笔试题答案hdfs namenode -ormat start-dfs.shstart-yarn.sh stop-dfs.shHadoop 测试题.填空题,1分(41空),2分(42空)共125分1. (每空1分)_datanode ______ 负责HDFS 数据存储。

2. (每空1分)HDFS 中的block 默认保存 _3 _______ 份。

3. (每空1分) ResourceManager 程序通常与NameNode 在一个节点启动。

4. (每空1分)hadoop 运行的模式有:_单机模式 ___ 、伪分布模式、—完全分布式 ________ 。

5.(每空1分)Hadoop 集群搭建中常用的4个配置文件为:_core-site.xml _____________ 、 hdfs-site.xml、_mapred-site.xml __ 、 yarn-site.xml_ 。

6.(每空2分)HDFS 将要存储的大文件进行—分割_,_分割—后存放在既定的存储块中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。

7. (每空2分)一个HDFS 集群包括两大部分,即_namenode_与_datanode_。

一般来说,一个集群中会有一个_namenode_和多个datanode_共同工作。

8.(每空2分)_namenode_是集群的主服务器,主要是用于对HDFS 中所有的文件及内容数据进行维护,并不断读取记录集群中 data node_主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。

9.(每空2分)_datanode_在HDFS 集群中担任任务具体执行角色,是集群的工作节点。

文件被分成若干个相同大小的数据块,分别存储在若干个 datanode_上, _datanode_会定期向集群内_namenode_发送自己的运行状态与存储内容,并根据_namnode 一发送的指令进行工作。

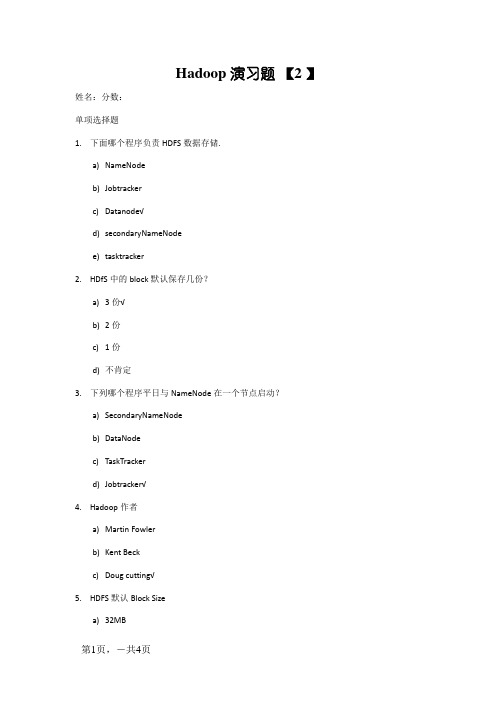

hadoop练习题--带答案

Hadoop 演习题【2 】姓名:分数:单项选择题1.下面哪个程序负责HDFS数据存储.a)NameNodeb)Jobtrackerc)Datanode√d)secondaryNameNodee)tasktracker2.HDfS中的block默认保存几份?a)3份√b)2份c)1份d)不肯定3.下列哪个程序平日与NameNode在一个节点启动?a)SecondaryNameNodeb)DataNodec)TaskTrackerd)Jobtracker√4.Hadoop作者a)Martin Fowlerb)Kent Beckc)Doug cutting√5.HDFS默认Block Sizea)32MBc)128MB6.下列哪项平日是集群的最重要的机能瓶颈a)CPUb)收集c)磁盘√d)内存7.关于SecondaryNameNode哪项是准确的?a)它是NameNode的热备b)它对内存没有请求c)它的目标是关心NameNode归并编辑日记,削减NameNode启动时光√d)SecondaryNameNode应与NameNode部署到一个节点8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block?a) 1b)2√c) 3d) 49.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB.当运行mapreduce义务读取该文件时input split大小为?a)64MBb)75MB√c)一个map读取64MB,别的一个map读取11MB10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB.当运行mapreduce义务读取该文件时input split大小为?a)64MBc)一个map读取64MB,别的一个map读取11MB√多选题:11.下列哪项可以作为集群的治理对象a)Puppet√b)Pdsh√c)Cloudera Manager√d)Rsync + ssh + scp√12.设置装备摆设机架感知的下面哪项准确a)假如一个机架出问题,不会影响数据读写√b)写入数据的时刻会写到不同机架的DataNode中√c)MapReduce会依据机架获取离本身比较近的收集数据√13.Client端上传文件的时刻下列哪项准确a)数据经由NameNode传递给DataNodeb)Client端将文件以Block为单位,管道方法依次传到DataNode√c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作d)当某个DataNode掉败,客户端会持续传给其它DataNode√14.下列哪个是Hadoop运行的模式a)单机版√b)伪散布式√c)散布式√15.Cloudera供给哪几种安装CDH的办法a)Cloudera manager√b)Tar ball√c)Yum√断定题:(全体错)16.Ganglia不仅可以进行监控,也可以进行告警.()17.Nagios不可以监控Hadoop集群,因为它不供给Hadoop支撑.()18.假如NameNode不测终止,SecondaryNameNode会接替它使集群持续工作.()19.Cloudera CDH是须要付费应用的.()20.Hadoop是Java开辟的,所以MapReduce只支撑Java说话编写.()21.Hadoop支撑数据的随机写.()Node负责治理metadata,client端每次读写请求,它都邑从磁盘中读取或则会写入metadata信息并反馈client端.()Node本地磁盘保存了Block的地位信息.()24.Slave节点要存储数据,所以它的磁盘越大越好.()25.Hadoop默认调剂器策略为FIFO,并支撑多个Pool提交Job.()26.集群内每个节点都应当配RAID,如许避免单磁盘破坏,影响全部节点运行.()27.因为HDFS有多个副本,所以NameNode是不消失单点问题的.()28.每个map槽就是一个线程.()29.Mapreduce的input split就是一个block.()30.Hadoop情况变量中的HADOOP_HEAPSIZE用于设置所有Hadoop守护线程的内存.它默认是200MB.()31.DataNode初次参加cluster的时刻,假如log中报告不兼容文件版本,那须要NameNode履行“hadoop namenode -format”操作格局化磁盘.()32.Hadoop1.0和2.0都具备完美的HDFS HA策略.()33.GZIP紧缩算法比LZO更快.()34.PIG是剧本说话,它与mapreduce无关.()。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop期中考试1.单选题(每个分,共20分)(1)Mapreduce擅长哪个领域的计算( A )。

A. 离线批处理B. DAG计算C. 流式计算D. 实时计算(2)关于MapReduce原理,下面说法错误的是( D )。

A. 分为Map和Reduce两个阶段B. Map阶段由一系列Map任务组成C. Reduce阶段由一系列Reduce任务组成D. Map阶段与Reduce阶段没有任何依赖关系(3)HDFS默认副本数是( C )。

A. 1B. 2C. 3D. 4(4)不属于HDFS架构组成部分是( D )。

A. NameNodeB. Secondary NameNodeC. DataNodeD. TaskTracker(Hadoop MapReduce 的组件)★(5)关于Block和Split两个概念,下面说法错误的是( C )。

A. Block是HDFS中最小的数据存储单位B. Split是MapReduce中最小的计算单元C. Block是Split是一一对应关系(默认是一一对应的)D. Block和Split之间对应关系是任意的,可由用户控制(6)以下不属于Hadoop内核的组成部分的是( C )。

A. HDFSB. MapReduceC. HBaseD. YARN(7)不属于HBase中的术语的是( D )。

A. ColumnB. Column FamilyC. Row KeyD. Meta(8)下面关于Hive,说法错误的是( A )。

A. Hive支持所有标准SQL语法B. Hive底层采用的计算引擎是MapReduce(目前支持Spark、Tez等)C. Hive提供的HQL语法,与传统SQL很类似D. Hive Server可采用MySQL存储元数据信息(9)通常而言,一个标准的生产环境(考虑成本、效益等)中,Zookeeper实例个数不可能是( B )。

A. 3B. 4C. 5D. 7(10)Flume的主要作用是( C )。

A. 数据处理和分析B. 数据存储C. 数据收集D. 网络爬虫(11)HBase支持多语言(比如C++、Python等)访问,为实现该功能,它采用的开源软件是( C )。

A. protobufB. 自定义网络协议C. thriftD. avro(12)关于HDFS和HBase,说法错误的是( D )。

A.HDFS不能随机读写,HBase可以B.HDFS适合存储大文件,HBase可以存储小文件C.HBase底层采用了HDFSD.HDFS和HBase无直接关系(13)YARN和MapReduce的关系是( A )。

A. MapReduce是一个计算框架,可运行在YARN之上B.YARN是一个计算框架,可运行在MapReduce之上C.MapReduce和YARN无直接关系D.以上回答均不正确★★★(14)关于MapReduce中的数据本地性,下面方法正确的是(A B )。

A.Map Task和Reduce Task都会考虑数据本地性B.只有Map Task会考虑数据本地性(Reduce阶段是从Map阶段拉取Shuffle数据的)C.只有Reduce Task会考虑数据本地性D.Map Task和Reduce Task都不考虑数据本地性(15)与Hive相比,Presto主要优势是( C )。

A.利用MapReduce进行分布式计算,更加高效B.完全分布式计算,可以充分利用集群资源C.MPP架构,全内存计算D.有很强的容错性(16)下面哪种存储格式是Hive中常用的列式存储格式( D )。

A. Text FileB. Sequence FileC. ParquetD. ORC★(17) 下面哪个信息不会存储在HBase的一个cell(E C )。

A. row keyB. column family名称C. 表名D. 列名E. 版本号F. cell值数据存储冗余,非常耗费空间(18)默认情况下,一个MapReduce作业(处理的数据HDFS上的一个目录)的map task个数是由( B )决定的。

A. 目录中文件个数B. 目录对应的block数目C. 默认个数是1D. 用户自己指定HDFS,Block默认大小为128MB。

一个Block文件只能来自于一个文件。

查看一个文件有多少个Block的命令:hdfs fsck /input –files –blocks -locations(19)Hive和Presto支持标准SQL吗(B D)A. 都支持B. 都不支持C. Hive支持,Presto不支持D. Hive不支持,Presto支持(20)既然有了Hive,还需要用MapReduce编写程序处理数据吗( B )A. 不需要B. 需要2.多选题(每个4分,共20分)(1)关于HDFS,说法正确的是(ABC )A.不存在NameNode单点故障问题B.一个集群可存在多个NameNode对外提供服务C.HDFS HA和Federation是它的两大特色D.不能存储小文件(2)关于Kafka,说法正确的是(BCD )A.是一个分布式key/value存储系统B.由producer、broker和consumer等角色构成C.通过zookeeper进行服务协调D.消息可以存成多个副本以达到容错的目标(3)关于MapReduce,说法正确的是(ACD )A.MapReduce具有容错性,一台节点挂掉不会导致整个应用程序运行失败B.所有MapReduce程序公用一个ApplicationMasterC.MapReduce程序可以运行在YARN之上(也可以运行在本地)D.MapReduce是Hive默认的计算引擎(4)用户可使用哪几种语言开发MapReduce应用程序(ABCD )A.C++B.JavaC.PHPD.Go(5)下面哪几个属于YARN自带的资源调度器(BCD )A.Deadline SchedulerB.FIFO(先进先出)C.Capacity Scheduler(容错调度系统)D.Fair Scheduler(公平调度系统)3.简答题(每个5分,共10分)(1)描述MapReduce作业从提交到YARN上,到运行结束的整个过程,请用步骤1,步骤2,…,描述。

答:步骤1,客户端提交请求到Yarn的ResourceManager步骤2,RM确定一个AppMaster步骤3,AppMaster向RM申请NodeManager步骤4,AppMaster将Task发送给NodeManager仅限执行步骤5,AppMaster负责收集NodeManager的运行结果步骤6,AppMaster将结果返回给客户端(2)★试描述如何对Hadoop Streaming程序进行调试并举出一个例子。

答:单机运行,本地测试::cat,管道输入Mapper,sort(3)试写出以下操作的shell命令:1)在HDFS上创建目录/home/test答:hdfs dfs -mkdir /homehdfs dfs -mkdir /home/test或hdfs dfs -mkdir -p /home/test2)将正在运行的ID为的应用程序杀死答:3)查看HDFS上文件/home/test/的大小答:hdfs dfs -ls /home/test/4)在Hive中创建一个parquet表,采用gzip压缩格式,该表名为test,包含两列:int类型名为id的列和string类型名为namename的列。

如何在Presto中创建这个表,有何不同答:create table if not exists test(id int,namename string)gzipstored as parquet;4.编程题(40分)(1)有一批文件,格式如下:每行有4列,每一列均是一个整数,列之间采用“.”作为分隔符,将数据按照第二列和第三列分组,每组中第四列所有数之和。

注:如果第二列相同,则按照第三列分组,比如上述结果为:351结果中,key为“第二列和第三列”值,value是对应的第四列累加和,key和value之间使用\t分割。

要求:使用任意语言实现以上功能,写出Mapper和Reducer,并给出相应的作业提交命令(或脚本)。

答:(根据WordCount实例进行改造)Mapper:String [] values = ().split(“\\.”);Text outputKey = new Text(values[1]+’.’+values[2]);IntWritable outputValue = new IntWritable(values[3]));(outputKey, outputValue);Reducer:无需调整(2)编写MapReduce程序实现以下功能:1)在Kafka上创建topic,名为“aura”,包含5个partition2)编写producer,将1~100000依次写入该topic,每个数字作为一条消息写入3)用Java语言实现一个consumer,读取aura中的数据,并写入到HDFS的/data/aura目录下4)如何使用MapReduce实现3)中的功能。