GPFS文件系统安装配置和测试

GPFS安装、配置、管理

合用标准文档GPFS的安装、配置、管理合用标准文档目录1 GPFS安装、配置、管理和保护 (1)1.1GPFS安装 (1)1.2GPFS配置 (1)1.2.1集群节点配置 (1)1.2.2G PFS NSD磁盘配置 (1)1.2.3优化 GPFS集群配置 (3)1.2.4创立 GPFS文件系统 (4)1.2.5配置改正 (4)1.3GPFS管理和保护 (8)1GPFS安装、配置、管理和保护本局部围绕 XX公司 HPIS系统实质情况,描述 GPFS的安装、配置过程,以及 GPFS 管理和保护方法。

1.1 GPFS安装GPFS 3.3 及补丁使用 AIX 系统标准 installp方式安装,安装命令比方:#installp -agYXd . all查察安装结果 ;#lslpp -l |grep gpfsgpfs.base 3.3.0.16COMMITTED GPFS File Managergpfs.base 3.3.0.16COMMITTED GPFS File Managergpfs.docs.data 3.3.0.1 COMMITTED GPFS Server Manpages and1.2 GPFS配置1.2.1 集群节点配置准备 node 列表文件,节点属性: manager或 client,quorum或nonquorum #more /home/GPFS/nodeshpis1:manager-quorumhpis2:manager-quorum创立 RAC两节点的 GPFS集群#mcrcluster -N /home/GPFS/nodes -p hpis1 -s hpis2 -r /usr/bin/rsh -R /usr/bin/rcp -C cls_hpis-p,-s 分别表示主,辅集群管理效劳器-r /usr/bin/rsh -R /usr/bin/rcp表示rsh,rcp方式进行集群管理时使用rsh,rcp 管理方式;也可以经过配置ssh,使用 ssh,scp 方式查察集群配置#mmlscluster1.2.2 GPFS NSD磁盘配置因为 RAC只有两个 Server 节点,为保证 GPFS文件系统的高可用性,需要将两台 Server 均设为 quorum 节点,同时从两个储藏和一台Server 的当地盘中分别取一个盘作为tiebreaker quorum Disk。

IBM GPFS并行文件系统安装与配置

IBM GPFS文件系统安装与配置目录1概述 (4)1.1IBM GPFS功能介绍 (4)1.2GPFS体系架构介绍 (2)1.3GPFS的优势 (5)2GPFS安装配置步骤 (6)2.1GPFS安装准备 (6)2.2GPFS的安装软件 (6)2.3配置GPFS集群 (6)1概述1.1IBM GPFS功能介绍GPFS (General Parallel File System) 是IBM 公司第一个共享文件系统,起源于IBM SP 系统上使用的虚拟共享磁盘技术( VSD )。

作为这项技术的核心,GPFS 是一个并行的磁盘文件系统,它保证在资源组内的所有节点可以并行访问整个文件系统。

而且针对此文件系统的服务操作,可以同时安全地在使用此文件系统的多个节点上实现。

GPFS 允许客户共享文件,而这些文件可能分布在不同节点的不同硬盘上。

它提供了许多标准的UNIX 文件系统接口,允许应用不需修改或者重新编辑就可以在其上运行。

GPFS 也支持UNIX 文件系统的工具,即:用户可以像使用普通文件系统一样使用基于GPFS 的文件系统,唯一不同的在于管理GPFS 文件系统的命令。

GPFS 提供的文件系统操作服务可以支持并行应用和串行应用,它允许任何节点(这些节点属于同一个节点组)上的并行应用同时访问同一个文件或者不同的文件。

1.2GPFS体系架构介绍GPFS 文件系统基本上由三层架构组成:磁盘,网络共享磁盘(NSD),GPFS 文件设备,如下图所示。

•磁盘GPFS 文件系统最底层的是物理磁盘设备。

原则上可以采用系统上任何块设备,包括磁盘,磁盘分区,逻辑卷。

从物理连接上来看,GPFS 支持使用所有方式连接的磁盘。

包括本地IDE 磁盘,本地SCSI 磁盘,光纤SAN 磁盘,iSCSI 磁盘,等等。

•网络共享磁盘(NSD: network share disk)NSD 是由磁盘映射出来的虚拟设备,NSD 与磁盘是一一对应的关系。

GPFS_for_linux安装与实施文档

GPFS for linux实施配置文档(Red Hat linux平台)目录1、GPFS for linux实施规划 (3)1.1 规划概要 (3)1.2 网络设计规划 (4)1.3 存储设计规划 (4)2、Linux的安装及配置 (6)2.1 制作Linux Yum源 (6)2.2使用Linux Yum源安装必备rpm包 (7)2.3Linux系统中添加网络设备 (7)3、GPFS软件的安装和准备工作 (14)3.1 必须安装的Linux RPM包 (14)2.2 软件上传至目的Linux分区 (15)2.3 在每个节点上安装GPFS软件包 (15)2.3.1 GPFS基础包安装 (15)2.3.2 GPFS升级包安装 (16)2.4 GPFS软件编译 (16)2.5 GPFS环境变量设置 (17)4、GPFS环境配置文件准备 (18)4.1、创建节点描述文件 (18)4.2、创建磁盘描述文件 (18)4.3、创建主机信任---SSH (18)4.4、确认连接磁盘 (20)5、GPFS集群配置 (21)5.1、建立集群 (21)5.1.1、创建集群 (21)5.1.2、显示配置信息 (21)5.2、创建NSD (21)5.2.1、使用mmcrnsd创建NSD (21)5.2.2、显示NSD (22)5.3、启动GPFS文件系统 (22)5.4、查看GPFS文件系统状态 (22)5.5、建立文件系统 (22)5.6、检查文件系统 (22)5.7、GPFS集群调优 (22)6、GPFS文件系统测试 (24)6.1文件系统测试 (24)6.2 高可用测试 (25)1、G PFS for linux实施规划随着客户对数据越来越高的要求,现有架构的数据传输的速度可能会在将来成为系统分析性能的瓶颈,为了解决该问题,结合IBM GPFS并行文件系统在海量文件处理方面的算法优势及x86 Linux服务器的处理性能,搭建一套测试GPFS文件系统作为数据平台,来提升数据仓库平台的数据传输性能是一个不错的选择。

GPFS文件系统的安装配置与维护

计 算 机 技 术 与 发 展

COMPUTER I CHNOLOGY AND DEVELOPMENT

Vo1.28 No.5 Mav 20l8

GPFS文 件 系统 的安 装 配 置 与 维 护

张 新 诺 ,王 彬

(国 家气象信 息 中心 ,北京 100081)

令及命 令 中各项 参数 的作 用 和使 用 方 式 ,能够 使 维 护人 员 更 好 地 了解 和维 护 GPFS文件 系 统 。同 时 ,也 对 文 件 系 统 在 Linux平台 中出现 问题 时如何 有 效使用 GPFS命令 解决 故 障 ,如何 有 效保 护 数 据安 全 和 数据 完 整性 ,及 如何 恢 复 文件 系 统

件 ,当操 作 系统或 存储 介质 发生 故 障时 ,也 会造 成 GPFS文件 系 统无 法正 常使用 。在 处理 GPFS文 件 系统故 障时 ,需要 使用

相 关命 令 并配合 不 同的参 数对 文件 系统 的相关 内容进行 配 置和创 建 。文 中的 主要 目的是 为 了说 明 GPFS文件 系 统相 关命

wit h t he releva nt commandsand different parameters.Themain purposeinthis paperisto exOainthefunction and usageof the parame-

ters intheGPFS,to makethemaintena n ce staffunder stand an d Use theGPFS better.Atthe sametime,wealso discuss how to Use GPFS comman dto solvet he problem ,how t o efect ively pr o tect dat a securit y a n d dat a integrity,and how t O r eSt Or e the norma l op e r at ion off ile

IBM GPFS配置测试

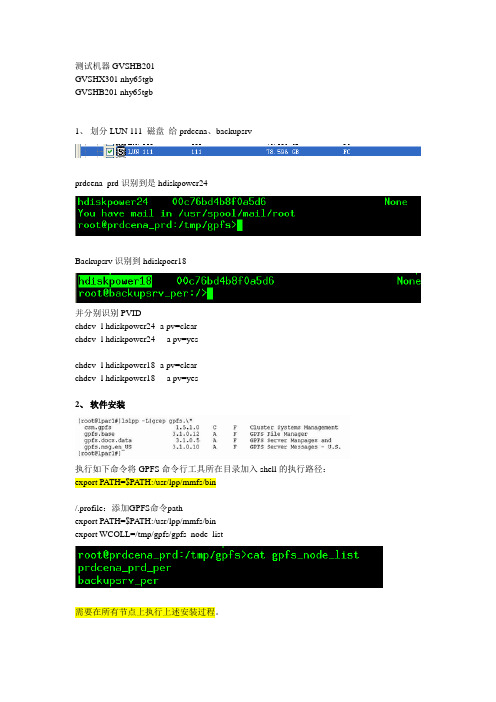

测试机器GVSHB201GVSHX301 nhy65tgbGVSHB201 nhy65tgb1、划分LUN 111 磁盘给prdcena、backupsrvprdcena_prd识别到是hdiskpower24Backupsrv识别到hdiskpoer18并分别识别PVIDchdev -l hdiskpower24 -a pv=clearchdev -l hdiskpower24 -a pv=yeschdev -l hdiskpower18 -a pv=clearchdev -l hdiskpower18 -a pv=yes2、软件安装执行如下命令将GPFS命令行工具所在目录加入shell的执行路径:export PA TH=$PATH:/usr/lpp/mmfs/bin/.profile:添加GPFS命令pathexport PATH=$PATH:/usr/lpp/mmfs/binexport WCOLL=/tmp/gpfs/gpfs_node_list需要在所有节点上执行上述安装过程。

3、准备远程命令执行和远程拷贝环境GPFS支持rsh ssh两种远程执行shell和rcp、scp两种远程拷贝工具。

GPFS默认使用rsh和rcp,下文以rsh+rcp作介绍。

3.1首先保证hosts文件里面包含所有集群节点的纪录。

3.2在.rhost文件里面增加所有集群节点的纪录。

#cat /.rhostsprdcena_prd_per +backupsrv_per +至此,rsh和rcp已能正常工作,可以用rsh hostname command 来验证配置是否正确。

4、准备集群的节点配置文件[root@GVSHB201#]vi /tmp/gpfs/nodefile#NodeName:NodeDesignations:AdminNodeNameprdcena_prd_per:manager-quorumbackupsrv_per:manager-quorum该节点配置文件每一行对应一个集群节点,每个集群节点有用减号分隔两个配置项。

GPFS安装测试记录

******G P F S安装测试记录思创数码科技股份有限公司二零零九年十月********GPFS安装测试小结1.硬件结构配置:本文主要描述基于双DS4800存储、双P570小机的GPFS的集群。

下文所涉及的全部参数设置和配置步骤源于IBM 红皮书《Deploying Oracle 10g RAC on AIX V5 with GPFS》节点使用双IBM P570小机,硬件配置8CPU、32G内存。

存储使用双IBM DS4800存储,存储A(DS4800A)分配数据磁盘、仲裁磁盘个两块、存储B(DS4800B)分配两块数据磁盘一块仲裁磁盘。

网络每节点分别连接到公网和私网,私网用于RAC内部通讯和GPFS数据传输,公网用于实际对外应用接口。

下图是安装测试的基本环境图示。

2.操作系统配置:系统包安装要求bos.adt.basebos.adt.libbos.adt.libmbos.perf.libperfstatbos.perf.perfstatbos.perf.proctoolsrsct.basic.rtepat.clients.rtexlC.aix50.rte 7.0.0.4 or 8.xxxxlC.rte 7.0.0.1 or 8.xxxbos.adt.profabos.cifs_fs(注:由于没有GPFS for aix6.0的官方说明,上面提出的系统包是针对AIX V5.3 系统的,但经过验证GPFS for aix6.0也同样适用)主机信任关系ORACLE RAC和GPFS集群都要求配置SSH或RSH,本文将采用RSH信任方式。

编辑或修改以下文件:_ /etc/hosts_ /etc/hosts.equiv_ Oracle或root 用户的~/.rhosts 文件文件内容大致如下:---------/etc/hosts--------# Public network10.158.116.140 ncst0110.158.116.141 ncst02# GPFS interconnect network192.168.100.1 ncst01-gpfs192.168.100.2 ncst02-gpfs/etc/hosts.equiv和~/.rhosts文件内容ncst01ncst02ncst01-gpfsncst02-gpfs3. GPFS安装配置:IBM的GPFS文件系统提供并行和串行应用。

GPFS安装手册

目录GPFS 基本安装过程 (1)GPFS performance and Infiniband: (5)adding extra subnets(可选): (7)与LUSTRE文件系统共存环境搭建: (8)Gpfs 基本卸载过程 (9)GPFS 基本安装过程同步所有服务器时间,系统时间1.准备并安装rpm包,升级包2.准备依赖包,cp -rf /root/GPFS/6 /var/cache/yum/x86_64/3.yum -y install rsh ; yum -y install libc.so.6 ; yum -y install ksh ; yum -y install libstdc++.so.5;yum -y install compat-libstdc++-33-3.2.3-69.el6.x86_644.cd /root/GPFS;rpm -ivh *.rpm ; rpm -Uvh update/*.rpm5.Linux客户端ssh无密码登录ssh-keygen -t rsa会创建/root/.ssh/id-ras.pub id-ras公钥:/root/.ssh/id-ras.pub私钥:/root/.ssh/id-ras把公钥复制到authorized_keys ,并复制/root/.ssh到所有机器上的/root/目录.If your GPFS cluster is configured to use SSH/SCP, it is suggested that you increase the value of MaxStartups in sshd_config to at least 1024.6.设置环境变量vi /root/.bash_profilePATH=$PATH:/usr/lpp/mmfs/bin启用环境变量source /root/.bash_profile7.编译安装cd /usr/lpp/mmfs/srcmake Autoconfigmake Worldmake InstallImagescd /usr/lpp/mmfs/src; make LINUX_DISTRIBUTION=REDHAT_AS_LINUX Autoconfig; make World;make InstallImagesWhen using GPFS 3.2.1 and earlier there is not an rpm option to the GPFS GPL build process. In this case to distribute the kernel module binaries you can copy the files manually. You can see alist of these files when the make InstallImages process completes. These files are mmfslinux, mmfs26, lxtrace, dumpconv, tracedevcd, and they need to be copied to the /usr/lpp/mmfs/bin directory on the other nodes.命令如下:mkdir /tmp/gpfs_cmds/cp -f /usr/lpp/mmfs/src/bin/mmfslinux /tmp/gpfs_cmds/mmfslinuxcp -f /usr/lpp/mmfs/src/bin/mmfs26 /tmp/gpfs_cmds/mmfs26cp -f /usr/lpp/mmfs/src/bin/tracedev /tmp/gpfs_cmds/tracedevcp -f /usr/lpp/mmfs/src/bin/lxtrace.sial /tmp/gpfs_cmds/lxtrace.sialcp -f /usr/lpp/mmfs/src/bin/mmdumpfilocks.sial /tmp/gpfs_cmds/mmdumpfilocks.sialcp -f /usr/lpp/mmfs/src/bin/lxtrace /tmp/gpfs_cmds/lxtracecp -f /usr/lpp/mmfs/src/bin/dumpconv /tmp/gpfs_cmds/dumpconvcd /tmptar -cf gpfs_cmds.tar ./gpfs_cmdson other nodes copy cmds to /usr/lpp/mmfs/bin8.创建clustermmcrcluster -N hosta:quorum,hostb:quorum -p hosta -s hostb -r /usr/bin/ssh -R/usr/bin/scp9.mmchlicense server --accept -N hosta,hostb10.(可选)修改GPFS文件,支持device-mapper设备cp /usr/lpp/mmfs/samples/nsddevices.sample /var/mmfs/etc/nsddevices修改文件使之能够输出这种格式"mapper/mpath1 dmm" ,mpath1为多路径磁盘for i in `multipath -ll | grep CERESDAT | awk '{print $1}'`doecho mapper/$i dmmdone11.NSD配置文件(dataAndMetadata、dataOnly、metadataOnly、descOnly)DiskUsageIf a value is not specified, the disk usage remains unchanged:dataAndMetadataIndicates that the disk contains both data and metadata. This is the default.dataOnlyIndicates that the disk contains data and does not contain metadata.metadataOnlyIndicates that the disk contains metadata and does not contain data.descOnlyIndicates that the disk contains no data and no file metadata. Such a disk is used solely to keep a copy of the file system descriptor, and can be used as a third failure group in certain disaster recovery configurations. For more information, see General Parallel FileSystem: Advanced Administration and search on Synchronous mirroring utilizing GPFS replication.格式:DiskName:ServerList::DiskUsage:FailureGroup:DesiredNameServerList中可指定主备nsd server,分散磁盘顺序以实现负载均衡[root@node01 ~]# cat diskdef/dev/mapper/meta01:io01:io02:metadataOnly:failgroup01:/dev/mapper/meta02:io03:io04:metadataOnly:failgroup02:12.[root@hosta ~]# vi diskdef/dev/sdc:hosta:hostb::01:/dev/sdd:hostb:hosta::02:/dev/sde:hosta:hostb::01:/dev/sdf:hostb:hosta::02:/dev/sdg:hosta:hostb::01:/dev/sdh:hostb:hosta::02:/dev/sdi:hosta:hostb::01:/dev/sdj:hostb:hosta::02:13.创建NSDmmcrnsd -F diskdef -v no(可选)创建仲裁盘:mmchconfig tiebreakerDisks="gpfs1nsd;gpfs2nsd;gpfs3nsd"14.启动GPFS,并查看启动状态mmstartup -a;mmgetstate -a15.创建文件系统mmcrfs vol_data -F diskdef -B 64K -T /vol_data -v no16.挂载文件系统mmmount vol_data -a17.(可选)变相替换磁盘过程(首先数据得有冗余,加粗字体为命令)mmchdisk vol_data stop -d gpfs12nsdmmlsdisk vol_datadisk driver sector failure holds holds storage name type size group metadata data status availability pool ------------ -------- ------ ------- -------- ----- ------------- ------------ ------------gpfs6nsd nsd 512 1 Yes Yes ready up system gpfs7nsd nsd 512 2 Yes Yes ready up system gpfs8nsd nsd 512 1 Yes Yes ready up system gpfs9nsd nsd 512 2 Yes Yes ready up system gpfs10nsd nsd 512 1 Yes Yes ready up system gpfs11nsd nsd 512 2 Yes Yes ready up system gpfs12nsd nsd 512 1 Yes Yes ready down system gpfs13nsd nsd 512 2 Yes Yes ready up system vi add_diskdef/dev/sdj:hosta:hostb::01:mmcrnsd -F add_diskdefmmlsnsdFile system Disk name NSD servers---------------------------------------------------------------------------vol_data gpfs6nsd hosta,hostbvol_data gpfs7nsd hostb,hostavol_data gpfs8nsd hosta,hostbvol_data gpfs9nsd hostb,hostavol_data gpfs10nsd hosta,hostbvol_data gpfs11nsd hostb,hostavol_data gpfs12nsd hosta,hostbvol_data gpfs13nsd hostb,hosta(free disk) gpfs14nsd hosta,hostbmmadddisk vol_data -F add_diskdef -rThe following disks of vol_data will be formatted on node hosta:gpfs14nsd: size 586061784 KBExtending Allocation MapChecking Allocation Map for storage pool 'system'12 % complete on Fri Jan 4 07:11:45 2013100 % complete on Fri Jan 4 07:12:23 2013Completed adding disks to file system vol_data.mmadddisk: Propagating the cluster configuration data to allaffected nodes. This is an asynchronous process.Restriping vol_data ...Scanning file system metadata, phase 1 ...1 % complete on Fri Jan 4 07:12:37 2013100 % complete on Fri Jan 4 07:12:50 2013Scan completed successfully.Scanning file system metadata, phase 2 ...4 % complete on Fri Jan 4 07:12:53 2013100 % complete on Fri Jan 4 07:13:54 2013Scan completed successfully.Scanning file system metadata, phase 3 ...Scan completed successfully.Scanning file system metadata, phase 4 ...Scan completed successfully.Scanning user file metadata ...23.60 % complete on Fri Jan 4 07:14:16 2013 ( 487171 inodes 1702 MB)100.00 % complete on Fri Jan 4 07:14:46 2013Scan completed successfully.Done18.增加GPFS客户端节点在安装好GPFS rpm情况下(安装方式同上面所提),运行命令:mmaddnode -N client01GPFS performance and Infiniband:linux磁盘预读访问优化:for i in `ls /dev/mapper/ | grep -v control | grep -v Vol`;do blockdev --setra 1024 /dev/mapper/$i;donefor i in `ls /dev/mapper/ | grep -v control | grep -v Vol`;do blockdev --getra /dev/mapper/$i;donemmchconfig prefetchThreads=96mmchconfig worker1Threads=144maxMBpS=3200pagepool=4096MverbsPorts <IB device>verbsRdma [enable|disable][root@node009 ~]# ibstatusInfiniband device 'mlx4_0' port 1 status:default gid: fe80:0000:0000:0000:0030:4800:4413:0001base lid: 0x4bsm lid: 0x35state: 4: ACTIVEphys state: 5: LinkUprate: 20 Gb/sec (4X DDR)Infiniband device 'mlx4_0' port 2 status:default gid: fe80:0000:0000:0000:0030:4800:4413:0002base lid: 0x0sm lid: 0x0state: 1: DOWNphys state: 2: Pollingrate: 10 Gb/sec (4X)mmchconfig verbsPorts="mthca0/1 mthca0/2"mmchconfig versRdma=enableOnce these two parameters are set, if a node has these ports available they are used once the GPFS daemon has started. GPFS decides to use the IB RDMA connection instead of TCP/IP before looking at the subnets parameter. If an IB RDMA connection is available on a node it is used. If there are no IB ports available on a node then the subnets processing rules take effect.For enhanced performance when multiple verbPorts are defined on a node GPFS multiplexes the traffic over all of the available ports.[root@node009 ~]# mmchconfig verbsPorts=mlx4_0mmchconfig: Command successfully completedmmchconfig: 6027-1371 Propagating the cluster configuration data to all affected nodes. This is an asynchronous process.[root@node009 ~]# mmchconfig verbsRdma=enablemmchconfig: Command successfully completedmmchconfig: 6027-1371 Propagating the cluster configuration data to all affected nodes. This is an asynchronous process.[root@node009 ~]# mmfsadm test verbs configVERBS RDMA Configuration:Status : startedStart time : Thu May 5 11:47:45 2011mmfs verbsRDMA : enablemmfs verbsPorts : mlx4_0mmfs verbsRdmasPerNode : 0mmfs verbsRdmasPerConnection : 8mmfs verbsRdmaMinBytes : 8192mmfs verbsRdmaMaxSendBytes : 16777216mmfs verbsRdmaTimeout : 14mmfs verbsLibName : libibverbs.soibv_fork_support : trueMax connections : 65536Max RDMA size : 16777216Max RDMAs per node max : 32Max RDMAs per node curr : 32Number of Devices opened : 1Device : mlx4_0vendor_id : 713Device vendor_part_id : 25418Device mem register chunk : 8589934592 (0x200000000)Device max_sge : 28Device max_qp_wr : 16351Device max_qp_rd_atom : 16Max RDMAs per conn max : 32Max RDMAs per conn curr : 8Open Connect Ports : 1Connect port : mlx4_0/1lid : 75state : IBV_PORT_ACTIVEpath_mtu : IBV_MTU_2048[root@node009 ~]# mmfsadm test verbs connNSD Client Connections:cl nidx destination status curr RW peak RW file RDs file WRs file RD KB file WR KB idx cookie-- ----- --------------- --------------- --------- --------- ---------- ---------- ----------- ----------- ---- ------NSD Server Connections:cl nidx destination status curr rdma wait rdma rdma RDs rdma WRs rdma RDs KB rdma WRs KB idx cookie-- ----- --------------- --------------- --------- --------- ---------- ---------- ----------- ----------- ---- ------adding extra subnets(可选):mmchconfig subnets="192.168.221.0 10.141.0.0"与LUSTRE文件系统共存环境搭建:LUSTRE server端安装包会改变当前操作系统的内核,如果不改变gpfs的编译配置文件,gpfs会无法启动,配置文件名称为site.mcr,在LUSTRE 1.8和LUSTRE 2.2版本上已经验证可以正常工作。

GPFS安装手册-Windows版

PARATERA CONFIDENTIALGPFS安装手册-Windows版V1.0.0PARATERA2013/1/15目录1 配置Windows系统 (3)1.1 分配静态地址 (3)1.2 加入AD域 (3)1.3 关闭UAC (3)1.4 关闭Windows防火墙 (4)2安装基于UNIX应用程序子系统(SUA) (4)3安装GPFS (5)3.1 安装GPFS软件包 (5)3.2 安装GPFS更新包 (5)4 创建GPFS管理员账号 (6)4.1 创建一个域用户root (6)4.2 增加用户root到Domain Admins组 (6)4.3 设置root用户的家目录 (7)4.4 赋予root用户作为服务的登陆权限(所有节点执行) (7)5 配置GPFS管理服务 (9)6安装和配置OpenSSH (9)6.1 下载和安装bundle(include openssh) (9)6.2 配置节点之间的SSH无密码认 (10)7 配置GPFS (10)7.1 配置GPFS机群 (10)7.2 配置NSD (10)7.3 配置GPFS文件系统 (11)8增加x86 Linux节点到Windows机群 (11)1 配置Windows系统⏹GPFS 3.4/3.3支持的系统:Windows Server 2008 x64/Windows Server 2008 R2/Windows HPC Server 2008⏹GPFS 3.2.1支持的系统:Windows Server 2003 R21.1 分配静态地址1.安装GPFS的所有节点都需要分配静态IP地址2.Windows HPC Server的静态IP地址配置a)在所有HPCS节点,打开hosts文件%systemroot%\system32\drivers\etc\hosts:修改ManageFile = true 为ManageFile = falseb)在HPCS头结点,打开PowerShell执行以下命令, 重新开启动态DNS更新:Set-HpcNetwork –EnterpriseDnsRegistrationType WithConnectionDnsSuffix1.2 加入AD域所有在同一个GPFS机群的节点都应该在同一个AD域中。

gpfs安装配置说明

GPFS系统配置(1)

▪ 支持1 to 8,192 个节点(V3.2 & V3.3) V3.1可达4096个节点 可多达 3794 个Linux节点和1530个AIX节点 有些用户实际环境已安装了超过500个节点GPFS

▪ 能mount多个文件系统 V3.2以上支持256个 V3.1.0.5开始支持64个 V3.1开始支持32个

Configuration data Servers角色

– 注: 对GPFS集群做变更配置必需这些节点

mmcrcluster命令

▪ Usage:

▪ mmcrcluster -N {NodeDesc[,NodeDesc...] | NodeFile

▪

-p PrimaryServer

▪

[-s SecondaryServer]

– Installp命令安装如下安装包(前面已经介绍了dsh,我们可以dsh对 多个节点进行同步安装,在节点数非常多时,可以节省很多工作量) ▪ gpfs.base ▪ gpfs.docs.data ▪ gpfs.msg.en_US ▪ gpfs.gui

安装GPFS介质—LINUX节点(Power 服务器)

安装前准备— 存储配置

▪ 将存储LUN/disk 配置映射到GPFS集群节点

– 依据系统需求的不同,disk连接拓扑可能会有差异 ▪ SAN存储模式是将所有节点直接映射到所有节点 ▪ NSD模式只需由作为NSD Server的节点链接disk ▪ 混合模式可以是部分节点直接连接存储,部分做为NSD Client,它们通过NSD Server,通过IP网络进行IO访问 (Network Block IO)

▪

tracedev

▪

dumpconv

GPFS安装与设置

实验1 GPFS安装与设置提示:在开始之前,请登录您所在组的AIX节点,每个节点打开至少一个窗口,以便后续操作。

目标在本实验中将练习如下内容验证AIX 系统环境安装GPFS介质创建GPFS集群定义NSD(Network Shared Disks)创建GPFS文件系统第一节:环境验证A.AIX与GPFS版本验证验证每个节点AIX版本参考GPFS FAQ: /infocenter/clresctr/vxrx/index.jsp # oslevel_______________________________________________________该AIX是否支持GPFS?该AIX版本下对GPFS 是否有特定版本与patch要求?________________________________________________________AIX xlC版本?8.0以上# lslpp -l |grep xlC|grep rte___xlC.aix61.rte 10.1.0.2 COMMITTED XL C/C++ Runtime for AIX 6.1xlC.rte 10.1.0.2 COMMITTED XL C/C++ RuntimexlC.sup.aix50.rte 9.0.0.1 COMMITTED XL C/C++ Runtime for AIX_____________________________________________________IBM JDK Version? Jdk 5# cd /usr; ls java5# /usr/java5/bin/java -version__1.5_____________________________________________________B.网络配置验证各节点的hostname?node1,node2,node3PAlpar10 PAlpar11 PAlpar12________________________________________________________ 各节点是否能相互ping 通?# ping node1# ping node2# ping node3C.验证/etc/hosts文件,应包含组内给节点IP和hostname,如192.168.1.11node1192.168.1.12node2192.168.1.13node3D.ssh安装、配置与通讯验证#cd /home/soft/ssh; installp -agYXpd . all先预览是否能正常安装,输出如下表示通过:SUCCESSES---------Filesets listed in this section passed pre-installation verificationand will be installed.Selected Filesets-----------------openssh.base.client 5.0.0.5302 # Open Secure Shell Commandsopenssh.base.server 5.0.0.5302 # Open Secure Shell Serveropenssh.license 5.0.0.5302 # Open Secure Shell Licenseopenssh.man.en_US 5.0.0.5302 # Open Secure Shell Documentat... openssl.base 0.9.8.840 # Open Secure Socket Layeropenssl.license 0.9.8.840 # Open Secure Socket Licenseopenssl.man.en_US 0.9.8.840 # Open Secure Socket Layer # installp -agYXd . all安装后,如下表示正常:openssl.man.en_US 0.9.8.840 USR APPLY SUCCESS openssl.license 0.9.8.840 USR APPLY SUCCESS openssl.base 0.9.8.840 USR APPLY SUCCESS openssl.base 0.9.8.840 ROOT APPLY SUCCESS openssh.license 5.0.0.5302 USR APPLY SUCCESS openssh.base.client 5.0.0.5302 USR APPLY SUCCESS openssh.base.server 5.0.0.5302 USR APPLY SUCCESS openssh.base.client 5.0.0.5302 ROOT APPLY SUCCESS openssh.base.server 5.0.0.5302 ROOT APPLY SUCCESS openssh.man.en_US 5.0.0.5302 USR APPLY SUCCESS # ssh-keygen -t rsa在每个AIX节点生成ssh-key如下:Generating public/private rsa key pair.Enter file in which to save the key (//.ssh/id_rsa): 回车Created directory '//.ssh'.Enter passphrase (empty for no passphrase): 回车Enter same passphrase again: 回车Your identification has been saved in //.ssh/id_rsa.Your public key has been saved in //.ssh/id_rsa.pub.The key fingerprint is:db:0b:23:aa:81:a9:b2:41:33:97:8b:6b:b7:24:fc:2c root@node1在节点 node1 copy如下文件# cp /.ssh/id_rsa.pub /.ssh/authorized_keys从节点node2 copy /.ssh/id_rsa.pub 到节点1/tmp/id_rsa.pub2,需要输入节点2的root密码从节点node3 copy /.ssh/id_rsa.pub 到节点1/tmp/id_rsa.pub3,需要输入节点3的root密码# scp node2:/.ssh/id_rsa.pub /tmp/id_rsa.pub2root@node2's password:id_rsa.pub 100% 393 0.4KB/s 00:00 # scp node3:/.ssh/id_rsa.pub /tmp/id_rsa.pub3在node1将/tmp/id_rsa.pub2; /tmp/id_rsa.pub3追加到/.ssh/authorized_keys中#cat /tmp/id_rsa.pub2 >> /.ssh/authorized_keys#cat /tmp/id_rsa.pub3 >> /.ssh/authorized_keys将node1上/.ssh/authorized_keys copy到node2,node3#scp /.ssh/authorized_keys node2:/.ssh/authorized_keys#scp /.ssh/authorized_keys node3:/.ssh/authorized_keys在node1,node2,node3节点touch 一个/.hushlogin文件,以屏蔽登录回显信息# touch /.hushlogin验证node1,node2,node3节点的ssh通讯,如能显示日期验证通过on node1# ssh node2 date; ssh node3 dateon node2# ssh node1 date; ssh node3 dateon node3# ssh node1 date; ssh node2 dateE.rsh, dsh 配置创建并编辑/.rhosts文件,node1 rootnode2 rootnode3 root验证rsh通讯,如能显示日期验证通过on node1# rsh node2 date; rsh node3 dateon node2# rsh node1 date; rsh node3 dateon node3# rsh node1 date; rsh node2 date验证dsh通讯,如能显示日期验证通过on node1# dsh -n node2 date; dsh -n node3 dateon node2# dsh -n node1 date; dsh -n node3 dateon node3# dsh -n node1 date; dsh -n node2 dateF.检查各AIX系统共享disks#lsdev –Cc disk#lspv第二节:安装GPFS软件A. 在node1,node2,node3上分别预览与安装GPFS软件及其PTF(Program Temporary Fix)# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/3.2.1.0; inutoc .; installp -agYXpd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/3.2.1.0; installp -agYXd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/ptf; inutoc .; installp -agYXpd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/ptf; installp -agYXd . all"B. 在node1,node2,node3上分别验证GPFS软件# dsh -n node1,node2,node3 "lslpp -L gpfs.*"Fileset Level State Type Description (Uninstaller)----------------------------------------------------------------------------gpfs.base 3.2.1.13 A F GPFS File Managergpfs.docs.data 3.2.1.1 A F GPFS Server Manpages andDocumentationgpfs.gui 3.2.1.0 C F GPFS GUIgpfs.msg.en_US 3.2.1.11 A F GPFS Server Messages - U.S.EnglishState codes:A -- Applied.B -- Broken.C -- Committed.E -- EFIX Locked.O -- Obsolete. (partially migrated to newer version)? -- Inconsistent State...Run lppchk -v.Type codes:F -- Installp FilesetP -- ProductC -- ComponentT -- FeatureR -- RPM PackageC. 在node1,node2,node3上,将gpfs执行命令路径加入PATH环境变量# echo export PATH=$PATH:/usr/lpp/mmfs/bin >>/etc/profile# . /etc/profileD. 在node1,node2,node3上,确认gpfs PATH环境变量是否已正确# env|grep PATH# mmlsclustermmlscluster: 6027-1382 This node does not belong to a GPFS cluster.mmlscluster: 6027-1639 Command failed. Examine previous error messages to determine cause.第三节:创建一个双节点的GPFS集群在本练习中,我们首先建一个单节点的GPFS CLUSTER。

一文读懂GPFS:从基础知识到集群搭建、参数设置优化及故障诊断

一文读懂GPFS:从基础知识到集群搭建、参数设置优化及故障诊断本文整体梳理了GPFS 发展史、GPFS常见架构、GPFS角色和概念、集群搭建、参数设置及优化、故障诊断。

较为清晰明了,以便为大家日常运维提供便利。

一、GPFS 发展史IBM GPFS是一个可扩展,高性能,基于共享磁盘的并行文件系统,自从4.1后更名为IBM Spectrum Scale ,并入IBM Spectrum 产品线。

本文后续有关Spectrum Scale的名字还是以大家较习惯的GPFS 为主。

Spectrum Scale的发展与演进IBM GPFS 软件在当今软件定义存储的大背景下,与时俱进,在原有的基础之上拓展了许多功能,诸如云计算、大数据、云存储和对象存储等,并且还在持续不断的增添新功能。

使得在多种应用场景下均可看见GPFS支持的身影。

二、GPFS常见架构在日常的多种使用GPFS的应用场景中,主要的架构方式有以下几种:GPFS架构分类:•Network-Based Client架构•Direct Attached Storage架构•Mixed NSD access架构•File Placement Optimizer (FPO)架构三、GPFS 角色和概念本文将结合GPFS产品的关键字,对GPFS整体的逻辑概念进行梳理,希望大家有一个清晰的认识。

ClusterGPFS群集是指多个节点的集合,他们共享同一个或者多个并行文件系统;群集里的节点可以并发访问这些文件系统里的数据GPFS Admin LAN用于GPFS 管理的网络Primary/Secondary NSD Server主和次 NSD ServerNSD(network share disk)NSD是一个虚拟的磁盘子系统,提供对GPFS内共享磁盘全局命名的功能Failure GroupFailure Group 是一个磁盘的集合,一个单点故障会引起集合内部的所有磁盘同时失效QuorumQuorum 是保障GPFS资源可用和完整性的机制。

GPFS for linux安装与实施文档

GPFS for linux实施目录1、GPFS规划 (3)2、GPFS实施 (3)2.1、软件需求 (3)2.2软件安装 (3)2.2.1在每个节点上安装GPFS软件包 (4)2.2.2、gpfs软件编译 (4)2.2.3、在每个节点上编译.bashrc文件,建立GPFS命令环境变量 (4)2.2.4、创建节点描述文件 (5)2.2.5、创建磁盘描述文件 (5)2.2.6、创建主机信任文件 (5)2.2.7、确认连接磁盘 (5)3、GPFS安装 (6)3.1、建立集群 (6)3.1.1、创建集群文件系统node1 (6)3.1.2、显示集群文件系统 (6)3.2、创建NSD (7)3.2.、使用mmcrnsd创建NSD (7)3.2.2、显示NSD (7)3.3、启动GPFS文件系统 (7)3.4、查看GPFS文件系统状态 (7)3.5、建立文件系统 (7)3.6、检查文件系统 (8)1、GPFS规划在虚拟机上安装2台RedHat 5 linux,系统分配8G硬盘,令每台节点分配2个2G的硬盘具2、GPFS实施2.1、软件需求辅助软件:Vmvare 7.0redhat 5libstdc++compat-libstdc++-296compat-libstdc++-33libXpimakegcc-c++kernelkernel-headerskernel-develkernel-smpkernel-smp-develxorg-x11-xauthGPFS软件需求gpfs.basegpfs.msg.en_USgpfs.docsgpfs.gp2.2软件安装使用rpm –ivh将以上需求安装包在每个节点上装齐2.2.1在每个节点上安装GPFS软件包2.2.1.1Tar -zxcvf解压gpfs-3.1.0-6.x86_64.update.tar.gz生成gpfs.basegpfs.msg.en_USgpfs.docsgpfs.gp2.2.1.2使用rpm安装软件包rpm -ivh gpfs.msg.en_US-3.1.0-6.noarch.rpmrpm -ivh gpfs.docs-3.1.0-6.noarch.rpmrpm -ivh gpfs.gpl-3.1.0-6.noarch.rpmrpm -ivh ---noscripts gpfs.base-3.1.0-6.x86_64.update.rpm2.2.1.3使用rpm -qa|grep gpfs检查GPFS软件安装情况gpfs.base-3.1.0-6gpfs.msg.en_US-3.1.0-6gpfs.docs-3.1.0-6gpfs.gpl-3.1.0-62.2.2、gpfs软件编译2.2.2.1、在每个节点中准备portability layer build#echo 'Red Hat Enterprise Linux Server release 5.3 (Tikanga)' >/etc/redhat-releasecd /usr/lpp/mmfs/srcexport SHARKCLONEROOT=/usr/lpp/mmfs/srcrm config/site.mcrmake Autoconfig2.2.2.2、在每个节点上检查配置文件值与系统环境是否正确grep ^LINUX_DISTRIBUTION config/site.mcrgrep 'define LINUX_DISTRIBUTION_LEVEL' config/site.mcrgrep 'define LINUX_KERNEL_VERSION' config/site.mcr注意:"2061899" 意思是l "2.6.18-128.1.10.el5"2.2.2.3、在每个节点上编译make cleanmake Worldmake InstallImages2.2.3、在每个节点上编译.bashrc文件,建立GPFS命令环境变量On each node, edit the PATH,vi ~/.bashrc添加PATH=$PATH:/usr/lpp/mmfs/bin立即生效source ~/.bashrc2.2.4、创建节点描述文件Vi /tmp/gpfs_node10.3.164.24 node1:quorum-manager10.3.164.25 node2:quorum-manager2.2.5、创建磁盘描述文件/dev/hdb:node1:::1:GPFSNSD12.2.6、创建主机信任文件2.2.6.1、以下命令分别在node1和node2上都执行一遍#mkdir ~/.ssh#chmod 700 ~/.ssh#ssh-keygen -t rsa#ssh-keygen -t dsa2.2.6.2 、在node1上执行以下命令#cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys#cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#ssh node2 cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys #ssh node2 cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys #scp ~/.ssh/authorized_keys node2:~/.ssh/authorized_keys 2.2.6.3、测试两个节点的连接等效性#ssh node1 date#ssh node2 date2.2.7、确认连接磁盘#fdisk –lDisk /dev/sda: 16.1 GB, 16106127360 bytes255 heads, 63 sectors/track, 1958 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 13 104391 83 Linux/dev/sda2 14 1958 15623212+ 8e Linux LVMDisk /dev/hdb: 2 GB, 2736369664 bytes64 heads, 32 sectors/track, 10239 cylindersUnits = cylinders of 2048 * 512 = 248576 bytes3、GPFS安装3.1、建立集群3.1.1、创建集群文件系统node1mmcrcluster -n /tmp/gpfs_node -p node1 -s node2 -r /usr/bin/ssh -R /usr/bin/scp命令显示:mmcrcluster: Processing node 1mmcrcluster: Processing node2mmcrcluster: Command successfully completedmmcrcluster: Propagating the cluster configuration data to all affected nodes. This is an asynchronous process.3.1.2、显示集群文件系统mmlsclusterGPFS cluster information========================GPFS cluster name: node1GPFS cluster id: 13882348004399855353GPFS UID domain: node1Remote shell command: /usr/bin/sshRemote file copy command: /usr/bin/scpGPFS cluster configuration servers:-----------------------------------Primary server: node1Secondary server:Node Daemon node name IP address Admin node name Designation1 node1 10.3.164.24 node1 quorum-manager2 node2 10.3.164.25 node2 quorum-manager3.2、创建NSD3.2.、使用mmcrnsd创建NSDmmcrnsd -F /tmp/gpfs_disk -v yes命令显示:mmcrnsd: Processing disk hdbmmcrnsd: Propagating the cluster configuration data to allaffected nodes. This is an asynchronous process.3.2.2、显示NSDmmlsnsd –mDisk name NSD volume ID Device Node name Remarks -------------------------------------------------------------------------------gpfs1nsd C0A801F54A9B3732 /dev/hdb node1 primary node gpfs1nsd C0A801F54A9B3732 /dev/hdb node23.3、启动GPFS文件系统mmstartup –aMon Aug 31 10:37:48 CST 2009: mmstartup: Starting GPFS ...3.4、查看GPFS文件系统状态mmgetstate -aNode number Node name GPFS state------------------------------------------1 node1 active2 node2 active3.5、建立文件系统#mkdir /gpfs 建立挂载点#./bin/mmcrfs /gpfs gpfsdev -F /tmp/gpfs_disk -A yes -B 1024K -v yes命令显示:The following disks of gpfsdev will be formatted on node node1:gpfs1nsd: size 2241856 KBFormatting file system ...Disks up to size 2 GB can be added to storage pool 'system'.Creating Inode FileCreating Allocation MapsClearing Inode Allocation MapClearing Block Allocation MapCompleted creation of file system /dev/gpfsdev.mmcrfs: Propagating the cluster configuration data to allaffected nodes. This is an asynchronous process.3.6、检查文件系统#cat /etc/fstab………………………/dev/gpfsdev /gpfs gpfs rw,mtime,atime,dev=gpfsdev,autostart 0 0 Df-g/dev/hdb /gpfs。

GPFS通用并行文件系统之CentOS上部署GPFS集群

GPFS通用并行文件系统之CentOS上部署GPFS集群GPFS文件系统能够横跨在所有主机上,分布在所有磁盘上,条带化读写,高性能。

信令管理机制,并发性好。

可配置failgroup组,可用性高。

下面是GPFS 集群的部署过程......1.环境准备:yum install -y compat-libstdc++-33 rpm-build kernel-headers kernel-devel imake gcc-c++ libstdc++ RedHat-lsb2.GPFS安装:多台服务器都要安装rpm -ivh gpfs.base-3.4.0-0.x86_64.rpmrpm -ivh gpfs.docs-3.4.0-0.noarch.rpmrpm -ivh gpfs.gpl-3.4.0-0.noarch.rpmrpm -ivh gpfs.msg.en_us-3.4.0-0.noarch.rpm[root@Web02_a base]# rpm -qa|grep gpfsgpfs.msg.en_US-3.4.0-0gpfs.gpl-3.4.0-0gpfs.base-3.4.0-0gpfs.docs-3.4.0-03.GPFS升级多台服务器都要安装rpm -Uvhgpfs.base-3.4.0-21.x86_64.update.rpmrpm -Uvh gpfs.docs-3.4.0-21.noarch.rpmrpm -Uvh gpfs.gpl-3.4.0-21.noarch.rpmrpm -Uvh gpfs.msg.en_US-3.4.0-21.noarch.rpm[root@Web02_a update]# rpm -qa|grep gpfsgpfs.gpl-3.4.0-21gpfs.msg.en_US-3.4.0-21gpfs.base-3.4.0-21gpfs.docs-3.4.0-214.编译GPFS源码多台服务器都要安装[root@Web02_a update]# cd/usr/lpp/mmfs/src/[root@Web02_a src]# makeLINUX_DISTRIBUTION=REDHAT_AS_LINUX Autoconfig [root@Web02_a src]# make World[root@Web02_a src]# make InstallImages[root@Web02_a src]# make rpm #生成rpm包,生成路径会有提示[root@Web02_a src]# rpm -ivh/usr/src/redhat/RPMS/x86_64/gpfs.gplbin-2.6.18-308.el5-3.4.0-21.x86_6 4.rpm[root@Web02_a src]# rpm -qa|grep gpfsgpfs.gpl-3.4.0-21gpfs.msg.en_US-3.4.0-21gpfs.gplbin-2.6.18-308.el5-3.4.0-21gpfs.base-3.4.0-21gpfs.docs-3.4.0-215.配置主机的时间同步如果服务器之间时间不同步,部署GPFS集群时会失败[root@Web02_a src]# crontab -l#time sync by yangrong at 2014-1-24*/10 * * * * /usr/sbin/ntpdate >/dev/null 2>&1[root@Nagios update]# crontab -l#time sync by yangrong at 2014-1-24*/10 * * * * /usr/sbin/ntpdate >/dev/null 2>&16.配置ssh免密钥登陆注:也可以配置rsh免密钥,且gpfs默认是使用rsh密钥登陆远端主机[root@Web02_a src]# cd /root/.ssh/[root@Web02_a .ssh]# ssh-keygen -t rsa[root@Web02_a .ssh]# cp id_rsa.pubauthorized_keys[root@Web02_a .ssh]# ssh Web02_a #登陆自己测试[root@Web02_a .ssh]# cat /etc/hosts10.0.0.243 Nagios10.0.0.236 Web02_a[root@Web02_a .ssh]# scp -r /root/.sshroot@Nagios:/root #把密钥拷贝到其它主机[root@Web02_a .ssh]# ssh NagiosLast login: Fri Jan 24 13:59:19 2014 from192.168.2.53[root@Nagios ~]# exit[root@Nagios src]# ssh Web02_aWarning: Permanently added the RSA host keyfor IP address '10.0.0.236' to the list of known hosts.Last login: Fri Jan 24 15:03:44 2014 fromlocalhost.localdomain[root@Web02_a ~]# exit7.配置GPFS环境变量[root@Web02_a .ssh]# echo'exportPATH=$PATH:/usr/lpp/mmfs/bin' >>/etc/profile[root@Web02_a .ssh]# source /etc/profile[root@Web02_a .ssh]# mmfsmmfsadm mmfsd mmfsfuncs.Linuxmmfsck mmfsenv mmfsmnthelpmmfsctl mmfsfuncs mmfsmount#接下来的操作只需要在一台服务器上操作即可。

PGFS简单搭建

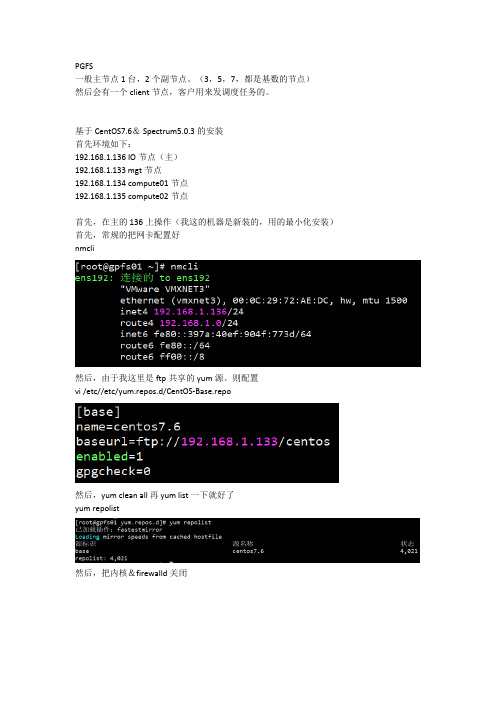

PGFS一般主节点1台,2个副节点。

(3,5,7,都是基数的节点)然后会有一个client节点,客户用来发调度任务的。

基于CentOS7.6& Spectrum5.0.3的安装首先环境如下:192.168.1.136 IO节点(主)192.168.1.133 mgt节点192.168.1.134 compute01节点192.168.1.135 compute02节点首先,在主的136上操作(我这的机器是新装的,用的最小化安装)首先,常规的把网卡配置好nmcli然后,由于我这里是ftp共享的yum源。

则配置vi /etc//etc/yum.repos.d/CentOS-Base.repo然后,yum clean all 再 yum list一下就好了yum repolist然后,把内核&firewalld关闭下面,创建一个gpfs专用的目录,把5.0.3的tar包塞进去mkdir -p /oglab/gpfscd /oglab/gpfs下面做几个域名的映射vi /etc/hosts192.168.1.133 mgt192.168.1.134 c01192.168.1.135 c02192.168.1.136 gpfs01然后,几个节点间建立互信[root@gpfs01 gpfs]# ssh-keygen -t rsa -N '' -f ~/.ssh/id_rsa[root@gpfs01 gpfs]# cat ~/.ssh/id_rsa.pub >>~/.ssh/authorized_keys [root@gpfs01 gpfs]# echo 'StrictHostKeyChecking no' > ~/.ssh/config [root@gpfs01 gpfs]# chmod 644 ~/.ssh/authorized_keys ~/.ssh/config [root@gpfs01 gpfs]# scp -rp ~/.ssh mgt:~/然后,ssh mgt可以直接登录就可以了(其余几个节点也都测试一下)下面,cd /oglab/gpfstar xvf Spectrum_Scale_DAE_503_x86_64_LNX.tar.gzls./Spectrum_Scale_Data_Access-5.0.3.0-x86_64-Linux-install这中间需要同意IBM的协议,按1 enter然后,安装一些必要的依赖包yum -y install kernel-devel cpp gcc gcc-c++ kernel-headers然后,创建一个需要的放安装包的目录/1/mkdir /1/然后,把一些安装需要的包复制到/1下cd /usr/lpp/mmfs/5.0.3.0/gpfs_rpms/然后,下面一步很重要cd /usr/lpp/mmfs/5.0.3.0/zimon_rpms/rhel7/cp .//gpfs.gss.pmcollector-5.0.3-0.el7.x86_64.rpm /1/cd /1/yum install -y gpfs.base*.rpm gpfs.gpl*rpm gpfs.gskit*rpm gpfs.ext*rpm gpfs.adv*rpm gpfs.docs*rpm然后,就可以编译了 /usr/lpp/mmfs/bin/mmbuildgpl安装pgfs完成。

GPFS3.4安装与配置

GPFS3.4 安装与配置V1.0雪王子2011/10/20作者声明:本文是作者根据所做的GPFS实验所著,只是作为作者的一个实验笔记,供以后查看。

实验环境难免与实际的生产环境有所区别,此外,作者的经验与能力有限,在文章中不可避免会有些错误,还请使用者谅解并更正。

本文仅供参考,作者不承担任何责任,特此声明。

目录一、环境信息 (3)二、安装软件 (3)三、GPFS配置 (4)1.配置各节点访问权限 (4)2.创建节点文件 (4)3.创建GPFS集群 (5)4.修改许可 (5)5.创建NSD(网络共享磁盘)文件 (6)6.创建NSD (6)7.创建Tiebreaker文件 (6)8.创建Tiebreaker磁盘 (7)9.启动GPFS (7)10.创建GPFS文件系统 (7)11.修改pagepool大小 (8)12.挂载GPFS文件系统 (9)四、GPFS管理与维护 (9)1.增加节点 (9)2.添加硬盘到已有的GPFS设备...............................................................................10 五、删除GPFS................................................................................................................10 附录.........................................................................................................................................10 附录一:网络共享磁盘(NSD)........................................................................................10 附录二:GPFS可靠性分析和设计思路........................................................................11 参考资料 (12)2 / 13一、环境信息主机名操作系统IP地址用途DCAPP01AIX6.1192.168.18.91gpfs主服务器,quorum节点DCAPP02AIX6.1192.168.18.92gpfs从服务器,quorum节点DCAPP03AIX6.1192.168.18.93gpfs客户端DCAPP04AIX6.1192.168.18.94gpfs客户端二、安装软件需要在全部节点上安装GPFS软件。

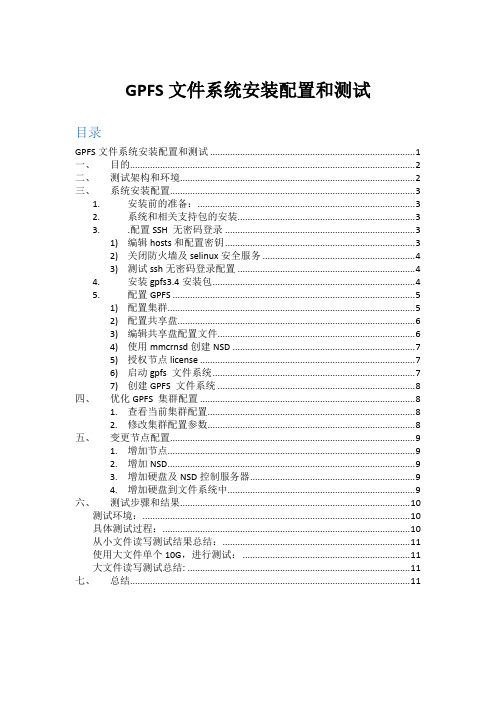

GPFS文件系统安装配置和测试

GPFS文件系统安装配置和测试目录GPFS文件系统安装配置和测试 (1)一、目的 (2)二、测试架构和环境 (2)三、系统安装配置 (3)1.安装前的准备: (3)2.系统和相关支持包的安装 (3)3..配置SSH 无密码登录 (3)1)编辑hosts和配置密钥 (3)2)关闭防火墙及selinux安全服务 (4)3)测试ssh无密码登录配置 (4)4.安装gpfs3.4安装包 (4)5.配置GPFS (5)1)配置集群 (5)2)配置共享盘 (6)3)编辑共享盘配置文件 (6)4)使用mmcrnsd创建NSD (7)5)授权节点license (7)6)启动gpfs 文件系统 (7)7)创建GPFS 文件系统 (8)四、优化GPFS 集群配置 (8)1.查看当前集群配置 (8)2.修改集群配置参数 (8)五、变更节点配置 (9)1.增加节点 (9)2.增加NSD (9)3.增加硬盘及NSD控制服务器 (9)4.增加硬盘到文件系统中 (9)六、测试步骤和结果 (10)测试环境: (10)具体测试过程: (10)从小文件读写测试结果总结: (11)使用大文件单个10G,进行测试: (11)大文件读写测试总结: (11)七、总结 (11)一、目的测试和验证gpfs并行文件系统功能和性能,为将来部署准备二、测试架构和环境架构图三、系统安装配置1.安装前的准备:在IBM 3512 划分3个lun,空间容量分别为:380G,88 G,30 G,映射到两台服务器确保服务器和存储连接正常确保网络连接正常2.系统和相关支持包的安装安装redhat enterprise server Linux 6.3 或6.5安装其它系统需要支持包:yum install libstdc++ compat-libstdc++-296 compat-libstdc++-33 libXp imake gcc-c++ kernel kernel-headers kernel-devel kernel-smp kernel-smp-devel xorg-x11-xauth3..配置SSH 无密码登录1)编辑hosts和配置密钥编辑hostS文件如下所示10.8.8.133 gpfs110.8.8.134 gpfs210.8.8.136 gpfs710.8.8.137 gpfs6登录到各个系统gpfs2,gpfs6,gpfs7上分别执行以下命令#ssh-keygen -t dsa在gpfs2上执行以下命令#cat ~/.ssh/id_dsa.pub > ~/.ssh/authorized_keys#ssh gpfs6 cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#ssh gpfs7 cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#scp ~/.ssh/authorized_keys gpfs6:~/.ssh/authorized_keys#scp ~/.ssh/authorized_keys gpfs7:~/.ssh/authorized_keys完成以后测试gpfs2,gpfs6,gpfs7连通性ssh gpfsx date注意因为版本不一致gpfs2(6.5)版本需要执行restorecon –R –v /root/.ssh2)关闭防火墙及selinux安全服务service iptables stopvi /etc/sysconfig/selinux# This file controls the state of SELinux on the system.# SELINUX= can take one of these three values:# enforcing - SELinux security policy is enforced.# permissive - SELinux prints warnings instead of enforcing.# disabled - No SELinux policy is loaded.SELINUX=disabled# SELINUXTYPE= can take one of these two values:# targeted - Targeted processes are protected,# mls - Multi Level Security protection.SELINUXTYPE=targeted3)测试ssh无密码登录配置登录gpfs1执行命令ssh gpfs6 datessh gpfs7 datessh gpfs3 date4.安装gpfs3.4安装包执行./gpfs_install-3.4.0-0_x86_64 –text-only进行安装Cd /usr/lpp/mmfsRpm –ivh *.rpmtar -zxcvf解压gpfs-3.4.0-6.x86_64.tar.gz生成升级包gpfs.basegpfs.msg.en_USgpfs.docsgpfs.gp安装所有的rpm软件包,并升级补丁Rpm –U *.rom检查GPFS软件包安装情况rpm -qa|grep gpfs增加.bash_profile PATH$PATH=$PATH:$HOME/bin:/usr/lpp/mmfs/bin编译软件cd /usr/lpp/mmfs/srcmake Autoconfigmake Worldmake InstallImages5.配置GPFS1)配置集群在gpfs7上创建集群建立文件/tmp/gpfs.nodes内容为:gpfs7:quorum-managergpfs6:quorum-manager执行命令:/usr/lpp/mmfs/bin/mmcrcluster -n /tmp/gpfs.nodes -p gpfs7 -s gpfs6 -r /usr/bin/ssh -R /usr/bin/scp显示集群信息mmlsclusterGPFS cluster information========================GPFS cluster name: dlokcluster.gpfs7GPFS cluster id: 722837121801769718GPFS UID domain: dlokcluster.gpfs7Remote shell command: /usr/bin/sshRemote file copy command: /usr/bin/scpGPFS cluster configuration servers:-----------------------------------Primary server: gpfs7Secondary server: gpfs6Node Daemon node name IP address Admin node name Designation-----------------------------------------------------------------------------------------------1 gpfs7 10.8.8.136 gpfs7 quorum-manager2 gpfs6 10.8.8.137 gpfs6 quorum-manager2)配置共享盘首先检查硬盘连接正常root@gpfs7 gpfs]# fdisk -lDisk /dev/sda: 146.2 GB, 146163105792 bytes255 heads, 63 sectors/track, 17769 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0006222cDevice Boot Start End Blocks Id System /dev/sda1 * 1 64 512000 83 LinuxPartition 1 does not end on cylinder boundary./dev/sda2 64 17770 142224384 8e Linux LVM Disk /dev/sdb: 146.2 GB, 146163105792 bytes255 heads, 63 sectors/track, 17769 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0003851bDevice Boot Start End Blocks Id System Disk /dev/sdc: 146.2 GB, 146163105792 bytes255 heads, 63 sectors/track, 17769 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0004d5b33)编辑共享盘配置文件[root@gpfs7 gpfs]# vi disk_file/dev/sdh:gpfs7:gpfs6:dataAndMetadata::g1/dev/sdi:gpfs7:gpfs6:dataAndMetadata::g2/dev/sdq:gpfs7:gpfs6:dataAndMetadata::g34)使用mmcrnsd创建NSDmmcrnsd -F /tmp/gpfs_disk -v yes显示NSDMmlsnsd –m[root@gpfs6 home]# mmlsnsd -mDisk name NSD volume ID Device Node name Remarks---------------------------------------------------------------------------------------g1 0A0808885379C4F2 /dev/sdc gpfs6 server nodeg1 0A0808885379C4F2 /dev/sdh gpfs7 server nodeg2 0A0808885379C4F3 /dev/sdd gpfs6 server nodeg2 0A0808885379C4F3 /dev/sdi gpfs7 server nodeg3 0A0808885379C4F4 /dev/sdl gpfs6 server nodeg3 0A0808885379C4F4 /dev/sdq gpfs7 server node5)授权节点licensemmchlicense server --accept –N hpc1,hpc2,hpc36)启动gpfs 文件系统Mmstartup –a查看文件系统状态Mmgeststate –a[root@gpfs6 home]# mmgetstate -aNode number Node name GPFS state------------------------------------------1 gpfs7 active2 gpfs6 active3 gpfs2 active7)创建GPFS 文件系统# mmcrfs gpfsdir1 -F /home/GPFS/nsd -T /gpfsdir1 -A yes -K always -B 2m -E no -m 2 -M 2 -n 32 -Q no -r 2 -R 2 -S yes -v no注:➢其mount点为/oradata, blocksize为2m;注意此参数已经创建,不可修改,blocksize一般要参照存储端LUN设置,以获得最优性能;➢-m 2 -M 2表示写两份metadata数据,-r 2 -R 2表示写两份data数据;➢我们已经将数据盘的failgroup分别设为2、3,GPFS会自动将数据均衡写入不同failgroup中;四、优化GPFS 集群配置1.查看当前集群配置# mmlsconfig[root@gpfs6 home]# mmlsconfigConfiguration data for cluster dlokcluster.gpfs7:-------------------------------------------------myNodeConfigNumber 2clusterName dlokcluster.gpfs7clusterId 722837121801769718autoload nominReleaseLevel 3.4.0.7dmapiFileHandleSize 32pagepool 2048MadminMode centralFile systems in cluster dlokcluster.gpfs7:------------------------------------------/dev/g22.修改集群配置参数Mmchconfig pagepool=2048m五、变更节点配置1.增加节点Mmaddnode -N gpfs12.增加NSD首先编辑磁盘配置文件Vi /root/gpfs/disk_file2/dev/sdb:gpfs1::dataAndMetadata::nsd43.m增加硬盘及NSD控制服务器mmcrnsd -F /root/gpfs/disk_file2 -v no4.增加硬盘到文件系统中mmadddisk g2 -F /root/gpfs/disk_file2显示文件系统mmlsfs g2flag value description------------------- ------------------------ ------------------------------------f 32768 Minimum fragment size in bytes-i 512 Inode size in bytes-I 32768 Indirect block size in bytes-m 1 Default number of metadata replicas-M 2 Maximum number of metadata replicas-r 1 Default number of data replicas-R 2 Maximum number of data replicas -j cluster Block allocation type-D nfs4 File locking semantics in effect-k all ACL semantics in effect-n 32 Estimated number of nodes that will mount file system-B 1048576 Block size-Q none Quotas enforcednone Default quotas enabled --filesetdf No Fileset df enabled?-V 12.10 (3.4.0.7) File system version--create-time Wed May 21 15:21:30 2014 File system creation time-u Yes Support for large LUNs?-z No Is DMAPI enabled?-L 4194304 Logfile size-E Yes Exact mtime mount option-S No Suppress atime mount option-K whenpossible Strict replica allocation option--fastea Yes Fast external attributes enabled?--inode-limit 520192 Maximum number of inodes-P system Disk storage pools in file system -d g1;g2;g3;nsd4 Disks in file system-A yes Automatic mount option-o none Additional mount options-T /gpfsdir1 Default mount point--mount-priority 0 Mount priority六、测试步骤和结果测试环境:Gpfs3 ibm 3850 虚拟机,linux 6.5,本地SAS盘15k转,千兆络Gpfs6 Dell 2950 linux 6.3, 本地SAS盘15k转, 4G HBA 光纤卡Gpfs6 Dell r420 linux 6.3, 本地SAS盘15k转,4G HBA 光纤卡具体测试过程:使用相同资料(普通目录文件4G):1.从gpfs2 本地盘拷贝资料到gpfs 盘,65M/s2从gpfs7 本地盘拷贝资料到gpfs 盘,161M/s3从gpfs6本地盘拷贝资料到gpfs 盘,142M/s4.从gpfs6 gpfs盘拷贝资料到gpfs 盘不同目录122M/s5. 从gpfs6,gpfs7,拷贝同时拷贝本地盘资料到GPFS 盘,gpfs672M/s,pgfs7 98M/s6登录gpfs7,拷贝本地SAS盘资料到本地SAS盘, 60M/s从小文件读写测试结果总结:本次测试环境GPFS客户端从本地到gpfs盘拷贝资料,受限千兆网络影响只能达到65M。

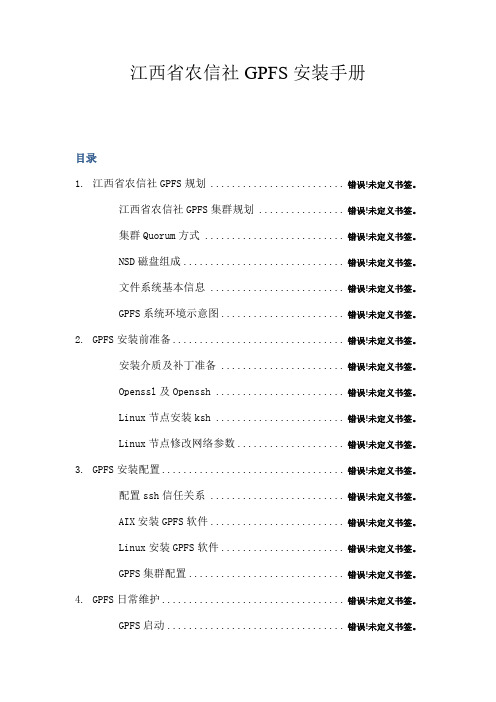

GPFS配置手册

江西省农信社GPFS安装手册目录1. 江西省农信社GPFS规划 ......................... 错误!未定义书签。

江西省农信社GPFS集群规划 ................ 错误!未定义书签。

集群Quorum方式 .......................... 错误!未定义书签。

NSD磁盘组成.............................. 错误!未定义书签。

文件系统基本信息 ......................... 错误!未定义书签。

GPFS系统环境示意图....................... 错误!未定义书签。

2. GPFS安装前准备................................ 错误!未定义书签。

安装介质及补丁准备 ....................... 错误!未定义书签。

Openssl及Openssh ........................ 错误!未定义书签。

Linux节点安装ksh ........................ 错误!未定义书签。

Linux节点修改网络参数.................... 错误!未定义书签。

3. GPFS安装配置.................................. 错误!未定义书签。

配置ssh信任关系 ......................... 错误!未定义书签。

AIX安装GPFS软件......................... 错误!未定义书签。

Linux安装GPFS软件....................... 错误!未定义书签。

GPFS集群配置............................. 错误!未定义书签。

4. GPFS日常维护.................................. 错误!未定义书签。

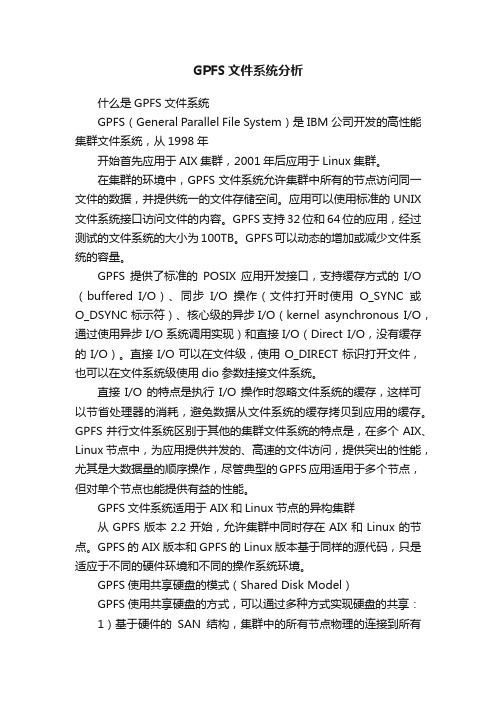

GPFS文件系统分析

GPFS文件系统分析什么是GPFS文件系统GPFS(General Parallel File System)是IBM公司开发的高性能集群文件系统,从1998年开始首先应用于AIX集群,2001年后应用于Linux集群。

在集群的环境中,GPFS文件系统允许集群中所有的节点访问同一文件的数据,并提供统一的文件存储空间。

应用可以使用标准的UNIX 文件系统接口访问文件的内容。

GPFS支持32位和64位的应用,经过测试的文件系统的大小为100TB。

GPFS可以动态的增加或减少文件系统的容量。

GPFS提供了标准的POSIX应用开发接口,支持缓存方式的I/O (buffered I/O)、同步I/O操作(文件打开时使用O_SYNC或O_DSYNC标示符)、核心级的异步I/O(kernel asynchronous I/O,通过使用异步I/O系统调用实现)和直接I/O(Direct I/O,没有缓存的I/O)。

直接I/O可以在文件级,使用O_DIRECT标识打开文件,也可以在文件系统级使用dio参数挂接文件系统。

直接I/O的特点是执行I/O操作时忽略文件系统的缓存,这样可以节省处理器的消耗,避免数据从文件系统的缓存拷贝到应用的缓存。

GPFS并行文件系统区别于其他的集群文件系统的特点是,在多个AIX、Linux节点中,为应用提供并发的、高速的文件访问,提供突出的性能,尤其是大数据量的顺序操作,尽管典型的GPFS应用适用于多个节点,但对单个节点也能提供有益的性能。

GPFS文件系统适用于AIX和Linux节点的异构集群从GPFS版本2.2开始,允许集群中同时存在AIX和Linux的节点。

GPFS 的AIX版本和GPFS的Linux版本基于同样的源代码,只是适应于不同的硬件环境和不同的操作系统环境。

GPFS使用共享硬盘的模式(Shared Disk Model)GPFS使用共享硬盘的方式,可以通过多种方式实现硬盘的共享:1)基于硬件的SAN结构,集群中的所有节点物理的连接到所有的存储2)使用单独的软件驱动VSD(Virtual Shared Disk),对集群节点体统虚拟的共享硬盘,通过VSD调度I/O操作3)使用NSD (Network Shared Disk),是有GPFS本身提供的,通过NSD调度I/O操作在VSD或NSD 的环境中使用GPFS,为增强GPFS的性能,建议存储和节点之间通过高速的通道互连,增加数据的带宽。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

GPFS文件系统安装配置和测试目录GPFS文件系统安装配置和测试 (1)一、目的 (2)二、测试架构和环境 (2)三、系统安装配置 (3)1.安装前的准备: (3)2.系统和相关支持包的安装 (3)3..配置SSH 无密码登录 (3)1)编辑hosts和配置密钥 (3)2)关闭防火墙及selinux安全服务 (4)3)测试ssh无密码登录配置 (4)4.安装gpfs3.4安装包 (4)5.配置GPFS (5)1)配置集群 (5)2)配置共享盘 (6)3)编辑共享盘配置文件 (6)4)使用mmcrnsd创建NSD (7)5)授权节点license (7)6)启动gpfs 文件系统 (7)7)创建GPFS 文件系统 (8)四、优化GPFS 集群配置 (8)1.查看当前集群配置 (8)2.修改集群配置参数 (8)五、变更节点配置 (9)1.增加节点 (9)2.增加NSD (9)3.增加硬盘及NSD控制服务器 (9)4.增加硬盘到文件系统中 (9)六、测试步骤和结果 (10)测试环境: (10)具体测试过程: (10)从小文件读写测试结果总结: (11)使用大文件单个10G,进行测试: (11)大文件读写测试总结: (11)七、总结 (11)一、目的测试和验证gpfs并行文件系统功能和性能,为将来部署准备二、测试架构和环境架构图三、系统安装配置1.安装前的准备:在IBM 3512 划分3个lun,空间容量分别为:380G,88 G,30 G,映射到两台服务器确保服务器和存储连接正常确保网络连接正常2.系统和相关支持包的安装安装redhat enterprise server Linux 6.3 或6.5安装其它系统需要支持包:yum install libstdc++ compat-libstdc++-296 compat-libstdc++-33 libXp imake gcc-c++ kernel kernel-headers kernel-devel kernel-smp kernel-smp-devel xorg-x11-xauth3..配置SSH 无密码登录1)编辑hosts和配置密钥编辑hostS文件如下所示10.8.8.133 gpfs110.8.8.134 gpfs210.8.8.136 gpfs710.8.8.137 gpfs6登录到各个系统gpfs2,gpfs6,gpfs7上分别执行以下命令#ssh-keygen -t dsa在gpfs2上执行以下命令#cat ~/.ssh/id_dsa.pub > ~/.ssh/authorized_keys#ssh gpfs6 cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#ssh gpfs7 cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#scp ~/.ssh/authorized_keys gpfs6:~/.ssh/authorized_keys#scp ~/.ssh/authorized_keys gpfs7:~/.ssh/authorized_keys完成以后测试gpfs2,gpfs6,gpfs7连通性ssh gpfsx date注意因为版本不一致gpfs2(6.5)版本需要执行restorecon –R –v /root/.ssh2)关闭防火墙及selinux安全服务service iptables stopvi /etc/sysconfig/selinux# This file controls the state of SELinux on the system.# SELINUX= can take one of these three values:# enforcing - SELinux security policy is enforced.# permissive - SELinux prints warnings instead of enforcing.# disabled - No SELinux policy is loaded.SELINUX=disabled# SELINUXTYPE= can take one of these two values:# targeted - Targeted processes are protected,# mls - Multi Level Security protection.SELINUXTYPE=targeted3)测试ssh无密码登录配置登录gpfs1执行命令ssh gpfs6 datessh gpfs7 datessh gpfs3 date4.安装gpfs3.4安装包执行./gpfs_install-3.4.0-0_x86_64 –text-only进行安装Cd /usr/lpp/mmfsRpm –ivh *.rpmtar -zxcvf解压gpfs-3.4.0-6.x86_64.tar.gz生成升级包gpfs.basegpfs.msg.en_USgpfs.docsgpfs.gp安装所有的rpm软件包,并升级补丁Rpm –U *.rom检查GPFS软件包安装情况rpm -qa|grep gpfs增加.bash_profile PATH$PATH=$PATH:$HOME/bin:/usr/lpp/mmfs/bin编译软件cd /usr/lpp/mmfs/srcmake Autoconfigmake Worldmake InstallImages5.配置GPFS1)配置集群在gpfs7上创建集群建立文件/tmp/gpfs.nodes内容为:gpfs7:quorum-managergpfs6:quorum-manager执行命令:/usr/lpp/mmfs/bin/mmcrcluster -n /tmp/gpfs.nodes -p gpfs7 -s gpfs6 -r /usr/bin/ssh -R /usr/bin/scp显示集群信息mmlsclusterGPFS cluster information========================GPFS cluster name: dlokcluster.gpfs7GPFS cluster id: 722837121801769718GPFS UID domain: dlokcluster.gpfs7Remote shell command: /usr/bin/sshRemote file copy command: /usr/bin/scpGPFS cluster configuration servers:-----------------------------------Primary server: gpfs7Secondary server: gpfs6Node Daemon node name IP address Admin node name Designation-----------------------------------------------------------------------------------------------1 gpfs7 10.8.8.136 gpfs7 quorum-manager2 gpfs6 10.8.8.137 gpfs6 quorum-manager2)配置共享盘首先检查硬盘连接正常root@gpfs7 gpfs]# fdisk -lDisk /dev/sda: 146.2 GB, 146163105792 bytes255 heads, 63 sectors/track, 17769 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0006222cDevice Boot Start End Blocks Id System /dev/sda1 * 1 64 512000 83 LinuxPartition 1 does not end on cylinder boundary./dev/sda2 64 17770 142224384 8e Linux LVM Disk /dev/sdb: 146.2 GB, 146163105792 bytes255 heads, 63 sectors/track, 17769 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0003851bDevice Boot Start End Blocks Id System Disk /dev/sdc: 146.2 GB, 146163105792 bytes255 heads, 63 sectors/track, 17769 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesSector size (logical/physical): 512 bytes / 512 bytesI/O size (minimum/optimal): 512 bytes / 512 bytesDisk identifier: 0x0004d5b33)编辑共享盘配置文件[root@gpfs7 gpfs]# vi disk_file/dev/sdh:gpfs7:gpfs6:dataAndMetadata::g1/dev/sdi:gpfs7:gpfs6:dataAndMetadata::g2/dev/sdq:gpfs7:gpfs6:dataAndMetadata::g34)使用mmcrnsd创建NSDmmcrnsd -F /tmp/gpfs_disk -v yes显示NSDMmlsnsd –m[root@gpfs6 home]# mmlsnsd -mDisk name NSD volume ID Device Node name Remarks---------------------------------------------------------------------------------------g1 0A0808885379C4F2 /dev/sdc gpfs6 server nodeg1 0A0808885379C4F2 /dev/sdh gpfs7 server nodeg2 0A0808885379C4F3 /dev/sdd gpfs6 server nodeg2 0A0808885379C4F3 /dev/sdi gpfs7 server nodeg3 0A0808885379C4F4 /dev/sdl gpfs6 server nodeg3 0A0808885379C4F4 /dev/sdq gpfs7 server node5)授权节点licensemmchlicense server --accept –N hpc1,hpc2,hpc36)启动gpfs 文件系统Mmstartup –a查看文件系统状态Mmgeststate –a[root@gpfs6 home]# mmgetstate -aNode number Node name GPFS state------------------------------------------1 gpfs7 active2 gpfs6 active3 gpfs2 active7)创建GPFS 文件系统# mmcrfs gpfsdir1 -F /home/GPFS/nsd -T /gpfsdir1 -A yes -K always -B 2m -E no -m 2 -M 2 -n 32 -Q no -r 2 -R 2 -S yes -v no注:➢其mount点为/oradata, blocksize为2m;注意此参数已经创建,不可修改,blocksize一般要参照存储端LUN设置,以获得最优性能;➢-m 2 -M 2表示写两份metadata数据,-r 2 -R 2表示写两份data数据;➢我们已经将数据盘的failgroup分别设为2、3,GPFS会自动将数据均衡写入不同failgroup中;四、优化GPFS 集群配置1.查看当前集群配置# mmlsconfig[root@gpfs6 home]# mmlsconfigConfiguration data for cluster dlokcluster.gpfs7:-------------------------------------------------myNodeConfigNumber 2clusterName dlokcluster.gpfs7clusterId 722837121801769718autoload nominReleaseLevel 3.4.0.7dmapiFileHandleSize 32pagepool 2048MadminMode centralFile systems in cluster dlokcluster.gpfs7:------------------------------------------/dev/g22.修改集群配置参数Mmchconfig pagepool=2048m五、变更节点配置1.增加节点Mmaddnode -N gpfs12.增加NSD首先编辑磁盘配置文件Vi /root/gpfs/disk_file2/dev/sdb:gpfs1::dataAndMetadata::nsd43.m增加硬盘及NSD控制服务器mmcrnsd -F /root/gpfs/disk_file2 -v no4.增加硬盘到文件系统中mmadddisk g2 -F /root/gpfs/disk_file2显示文件系统mmlsfs g2flag value description------------------- ------------------------ ------------------------------------f 32768 Minimum fragment size in bytes-i 512 Inode size in bytes-I 32768 Indirect block size in bytes-m 1 Default number of metadata replicas-M 2 Maximum number of metadata replicas-r 1 Default number of data replicas-R 2 Maximum number of data replicas -j cluster Block allocation type-D nfs4 File locking semantics in effect-k all ACL semantics in effect-n 32 Estimated number of nodes that will mount file system-B 1048576 Block size-Q none Quotas enforcednone Default quotas enabled --filesetdf No Fileset df enabled?-V 12.10 (3.4.0.7) File system version--create-time Wed May 21 15:21:30 2014 File system creation time-u Yes Support for large LUNs?-z No Is DMAPI enabled?-L 4194304 Logfile size-E Yes Exact mtime mount option-S No Suppress atime mount option-K whenpossible Strict replica allocation option--fastea Yes Fast external attributes enabled?--inode-limit 520192 Maximum number of inodes-P system Disk storage pools in file system -d g1;g2;g3;nsd4 Disks in file system-A yes Automatic mount option-o none Additional mount options-T /gpfsdir1 Default mount point--mount-priority 0 Mount priority六、测试步骤和结果测试环境:Gpfs3 ibm 3850 虚拟机,linux 6.5,本地SAS盘15k转,千兆络Gpfs6 Dell 2950 linux 6.3, 本地SAS盘15k转, 4G HBA 光纤卡Gpfs6 Dell r420 linux 6.3, 本地SAS盘15k转,4G HBA 光纤卡具体测试过程:使用相同资料(普通目录文件4G):1.从gpfs2 本地盘拷贝资料到gpfs 盘,65M/s2从gpfs7 本地盘拷贝资料到gpfs 盘,161M/s3从gpfs6本地盘拷贝资料到gpfs 盘,142M/s4.从gpfs6 gpfs盘拷贝资料到gpfs 盘不同目录122M/s5. 从gpfs6,gpfs7,拷贝同时拷贝本地盘资料到GPFS 盘,gpfs672M/s,pgfs7 98M/s6登录gpfs7,拷贝本地SAS盘资料到本地SAS盘, 60M/s从小文件读写测试结果总结:本次测试环境GPFS客户端从本地到gpfs盘拷贝资料,受限千兆网络影响只能达到65M。