ansj分词原理

简单阐述网站关键词的分词的原理(古怪科技)

简单阐述网站关键词的分词的原理

1、字符串匹配的分词方法

这是种常用的分词法,百度就是用此种分词。

字符串匹配的分词方法,又分为3种分词方法。

(1)正向最大匹配法

就是把一个词从左至右来分词。

举个例子:”不知道你在说什么”

这句话采用正向最大匹配法是如何分的呢?“不知道,你,在,说什么”。

(2).反向最大匹配法

"不知道你在说什么"反向最大匹配法来分上面这段是如何分的。

“不,知道,你在,说,什么”,这个就分的比较多了,反向最大匹配法就是从右至左。

(3)就是最短路径分词法。

就是说一段话里面要求切出的词数是最少的。

“不知道你在说什么”最短路径分词法就是指,把上面那句话分成的词要是最少的。

“不知道,你在,说什么”,这就是最短路径分词法,分出来就只有3个词了。

(4)双向最大匹配法。

而有一种特殊的情况,就是关健词前后组合内容被认为粘性相差不大,而搜索结果辊也同时包含这两组词的话,百度会进行正反向同时进行分词匹配。

2、词义分词法

就是一种机器语音判断的分词方法。

很简单,进行句法、语义分析,利用句法信息和语义信息来处理歧义现象来分词,这种分词方法,现在还不成熟,处在测试阶段。

3、统计分词法

根据词组的统计,就会发现两个相邻的字出现的频率最多,那么这个词就很重要。

就可以作为用户提供字符串中的分隔符,这样来分词。

比如,“我的,你的,许多的,这里,这一,那里”等等,这些词出现的比较多,就从这些词里面分开来。

TextRank算法提取关键词的Java实现

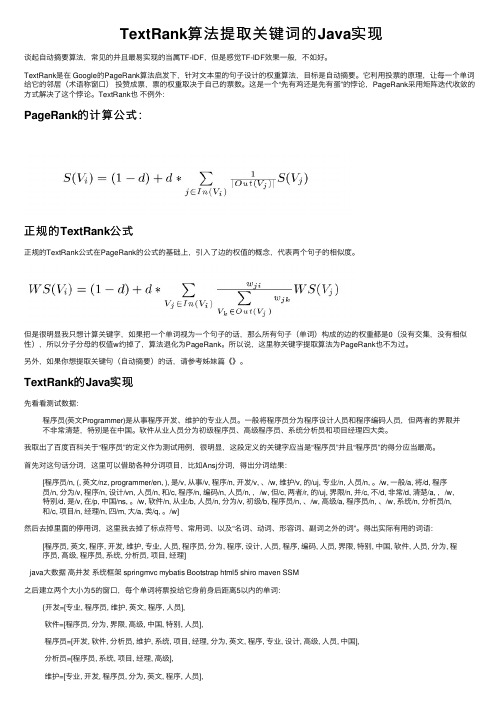

TextRank算法提取关键词的Java实现谈起⾃动摘要算法,常见的并且最易实现的当属TF-IDF,但是感觉TF-IDF效果⼀般,不如好。

TextRank是在 Google的PageRank算法启发下,针对⽂本⾥的句⼦设计的权重算法,⽬标是⾃动摘要。

它利⽤投票的原理,让每⼀个单词给它的邻居(术语称窗⼝)投赞成票,票的权重取决于⾃⼰的票数。

这是⼀个“先有鸡还是先有蛋”的悖论,PageRank采⽤矩阵迭代收敛的⽅式解决了这个悖论。

TextRank也不例外:PageRank的计算公式:正规的TextRank公式正规的TextRank公式在PageRank的公式的基础上,引⼊了边的权值的概念,代表两个句⼦的相似度。

但是很明显我只想计算关键字,如果把⼀个单词视为⼀个句⼦的话,那么所有句⼦(单词)构成的边的权重都是0(没有交集,没有相似性),所以分⼦分母的权值w约掉了,算法退化为PageRank。

所以说,这⾥称关键字提取算法为PageRank也不为过。

另外,如果你想提取关键句(⾃动摘要)的话,请参考姊妹篇《》。

TextRank的Java实现先看看测试数据:程序员(英⽂Programmer)是从事程序开发、维护的专业⼈员。

⼀般将程序员分为程序设计⼈员和程序编码⼈员,但两者的界限并不⾮常清楚,特别是在中国。

软件从业⼈员分为初级程序员、⾼级程序员、系统分析员和项⽬经理四⼤类。

我取出了百度百科关于“程序员”的定义作为测试⽤例,很明显,这段定义的关键字应当是“程序员”并且“程序员”的得分应当最⾼。

⾸先对这句话分词,这⾥可以借助各种分词项⽬,⽐如Ansj分词,得出分词结果:[程序员/n, (, 英⽂/nz, programmer/en, ), 是/v, 从事/v, 程序/n, 开发/v, 、/w, 维护/v, 的/uj, 专业/n, ⼈员/n, 。

/w, ⼀般/a, 将/d, 程序员/n, 分为/v, 程序/n, 设计/vn, ⼈员/n, 和/c, 程序/n, 编码/n, ⼈员/n, ,/w, 但/c, 两者/r, 的/uj, 界限/n, 并/c, 不/d, ⾮常/d, 清楚/a, ,/w,特别/d, 是/v, 在/p, 中国/ns, 。

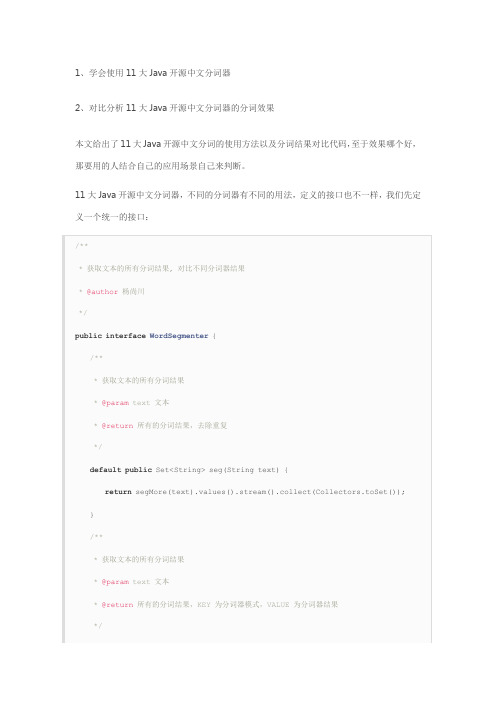

11个Java开源中文分词器使用方法和分词效果对比

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

从上面的定义我们知道,在Java中,同样的方法名称和参数,但是返回值不同,这种情况不可以使用重载。

这两个方法的区别在于返回值,每一个分词器都可能有多种分词模式,每种模式的分词结果都可能不相同,第一个方法忽略分词器模式,返回所有模式的所有不重复分词结果,第二个方法返回每一种分词器模式及其对应的分词结果。

在这里,需要注意的是我们使用了Java8中的新特性默认方法,并使用stream把一个map 的value转换为不重复的集合。

下面我们利用这11大分词器来实现这个接口:

1、word分词器

2、Ansj分词器

3、Stanford分词器

4、FudanNLP分词器

5、Jieba分词器

6、Jcseg分词器

7、MMSeg4j分词器

8、IKAnalyzer分词器

9、Paoding分词器

10、smartcn分词器

11、HanLP分词器

现在我们已经实现了本文的第一个目的:学会使用11大Java开源中文分词器。

最后我们来实现本文的第二个目的:对比分析11大Java开源中文分词器的分词效果,程序如下:。

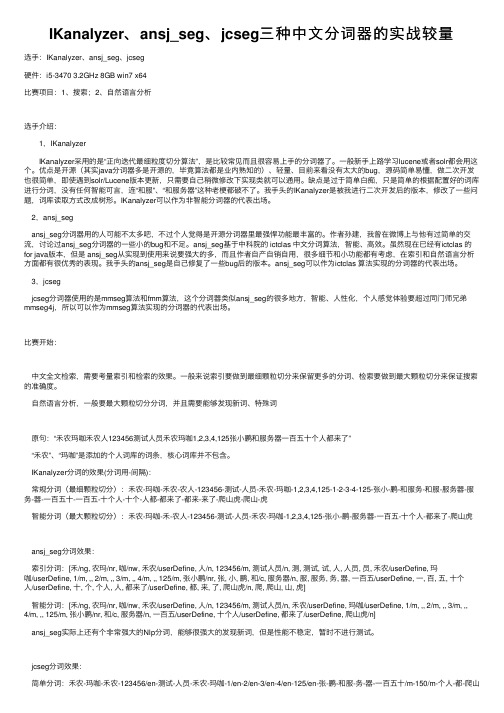

IKanalyzer、ansj_seg、jcseg三种中文分词器的实战较量

IKanalyzer、ansj_seg、jcseg三种中⽂分词器的实战较量选⼿:IKanalyzer、ansj_seg、jcseg硬件:i5-3470 3.2GHz 8GB win7 x64⽐赛项⽬:1、搜索;2、⾃然语⾔分析选⼿介绍: 1,IKanalyzer IKanalyzer采⽤的是“正向迭代最细粒度切分算法”,是⽐较常见⽽且很容易上⼿的分词器了。

⼀般新⼿上路学习lucene或者solr都会⽤这个。

优点是开源(其实java分词器多是开源的,毕竟算法都是业内熟知的)、轻量、⽬前来看没有太⼤的bug,源码简单易懂,做⼆次开发也很简单,即使遇到solr/Lucene版本更新,只需要⾃⼰稍微修改下实现类就可以通⽤。

缺点是过于简单⽩痴,只是简单的根据配置好的词库进⾏分词,没有任何智能可⾔,连“和服”、“和服务器”这种⽼梗都破不了。

我⼿头的IKanalyzer是被我进⾏⼆次开发后的版本,修改了⼀些问题,词库读取⽅式改成树形。

IKanalyzer可以作为⾮智能分词器的代表出场。

2,ansj_segansj_seg分词器⽤的⼈可能不太多吧,不过个⼈觉得是开源分词器⾥最强悍功能最丰富的。

作者孙建,我曾在微博上与他有过简单的交流,讨论过ansj_seg分词器的⼀些⼩的bug和不⾜。

ansj_seg基于中科院的 ictclas 中⽂分词算法,智能、⾼效。

虽然现在已经有ictclas 的for java版本,但是 ansj_seg从实现到使⽤来说要强⼤的多,⽽且作者⾃产⾃销⾃⽤,很多细节和⼩功能都有考虑,在索引和⾃然语⾔分析⽅⾯都有很优秀的表现。

我⼿头的ansj_seg是⾃⼰修复了⼀些bug后的版本。

ansj_seg可以作为ictclas 算法实现的分词器的代表出场。

3,jcsegjcseg分词器使⽤的是mmseg算法和fmm算法,这个分词器类似ansj_seg的很多地⽅,智能、⼈性化,个⼈感觉体验要超过同门师兄弟mmseg4j,所以可以作为mmseg算法实现的分词器的代表出场。

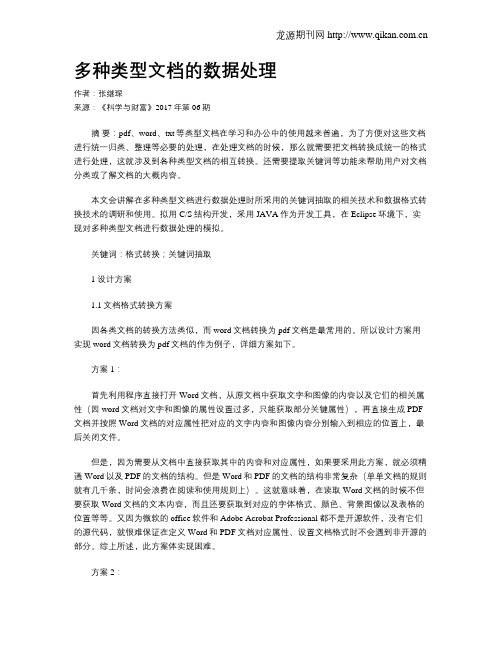

多种类型文档的数据处理

多种类型文档的数据处理作者:张继琛来源:《科学与财富》2017年第06期摘要:pdf、word、txt等类型文档在学习和办公中的使用越来普遍,为了方便对这些文档进行统一归类、整理等必要的处理,在处理文档的时候,那么就需要把文档转换成统一的格式进行处理,这就涉及到各种类型文档的相互转换。

还需要提取关键词等功能来帮助用户对文档分类或了解文档的大概内容。

本文会讲解在多种类型文档进行数据处理时所采用的关键词抽取的相关技术和数据格式转换技术的调研和使用。

拟用C/S结构开发,采用JAVA作为开发工具,在Eclipse环境下,实现对多种类型文档进行数据处理的模拟。

关键词:格式转换;关键词抽取1 设计方案1.1文档格式转换方案因各类文档的转换方法类似,而word文档转换为pdf文档是最常用的。

所以设计方案用实现word文档转换为pdf文档的作为例子,详细方案如下。

方案1:首先利用程序直接打开Word文档,从原文档中获取文字和图像的内容以及它们的相关属性(因word文档对文字和图像的属性设置过多,只能获取部分关键属性),再直接生成PDF 文档并按照Word文档的对应属性把对应的文字内容和图像内容分别输入到相应的位置上,最后关闭文件。

但是,因为需要从文档中直接获取其中的内容和对应属性,如果要采用此方案,就必须精通Word以及PDF的文档的结构。

但是Word和PDF的文档的结构非常复杂(单单文档的规则就有几千条,时间会浪费在阅读和使用规则上)。

这就意味着,在读取Word文档的时候不但要获取Word文档的文本内容,而且还要获取到对应的字体格式、颜色、背景图像以及表格的位置等等。

又因为微软的office软件和Adobe Acrobat Professional都不是开源软件,没有它们的源代码,就很难保证在定义Word和PDF文档对应属性、设置文档格式时不会遇到非开源的部分。

综上所述,此方案体实现困难。

方案2:对于方案1中存在的问题,微软公司和第三方公司提供了操作Word、Excel和PDF的类库、接口和组件,这就有了解决方案。

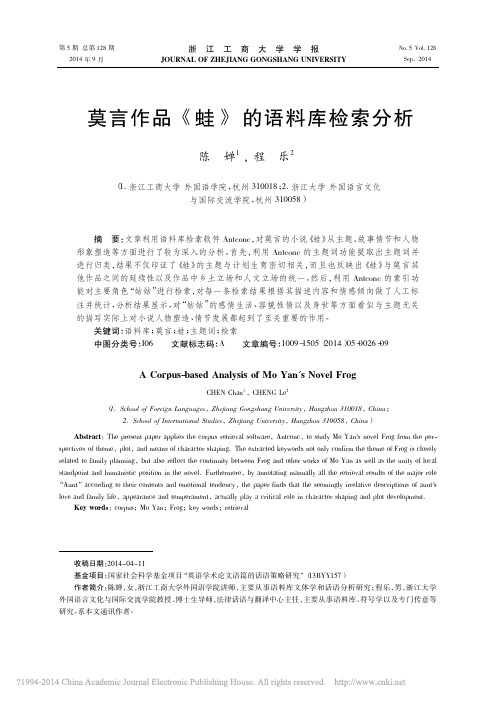

莫言作品_蛙_的语料库检索分析_陈婵

第5期总第128期2014年9月浙江工商大学学报JOURNAL OF ZHEJIANG GONGSHANG UNIVERSITYNo.5Vol.128Sep.2014收稿日期:2014-04-11基金项目:国家社会科学基金项目“英语学术论文语篇的话语策略研究”(13BYY157)作者简介:陈婵,女,浙江工商大学外国语学院讲师,主要从事语料库文体学和话语分析研究;程乐,男,浙江大学外国语言文化与国际交流学院教授、博士生导师,法律话语与翻译中心主任,主要从事语料库、符号学以及专门传意等研究,系本文通讯作者。

莫言作品《蛙》的语料库检索分析陈婵1,程乐2(1.浙江工商大学外国语学院,杭州310018;2.浙江大学外国语言文化与国际交流学院,杭州310058)摘要:文章利用语料库检索软件Antconc ,对莫言的小说《蛙》从主题、故事情节和人物形象塑造等方面进行了较为深入的分析。

首先,利用Antconc 的主题词功能提取出主题词并进行归类,结果不仅印证了《蛙》的主题与计划生育密切相关,而且也反映出《蛙》与莫言其他作品之间的延续性以及作品中乡土立场和人文立场的统一。

然后,利用Antconc 的索引功能对主要角色“姑姑”进行检索,对每一条检索结果根据其描述内容和情感倾向做了人工标注并统计,分析结果显示,对“姑姑”的感情生活、容貌性情以及身世等方面看似与主题无关的描写实际上对小说人物塑造、情节发展都起到了至关重要的作用。

关键词:语料库;莫言;蛙;主题词;检索中图分类号:I06文献标志码:A 文章编号:1009-1505(2014)05-0026-09A Corpus-based Analysis of Mo Yan's Novel FrogCHEN Chan 1,CHENG Le 2(1.School of Foreign Languages ,Zhejiang Gongshang University ,Hangzhou 310018,China ;2.School of International Studies ,Zhejiang University ,Hangzhou 310058,China )Abstract :The present paper applies the corpus retrieval software ,Antconc ,to study Mo Yan's novel Frog from the per-spectives of theme ,plot ,and means of character shaping.The extracted keywords not only confirm the theme of Frog is closely related to family planning ,but also reflect the continuity between Frog and other works of Mo Yan as well as the unity of local standpoint and humanistic position in the novel.Furthermore ,by annotating manually all the retrieval results of the major role “Aunt ”according to their contents and emotional tendency ,the paper finds that the seemingly irrelative descriptions of aunt's love and family life ,appearance and temperament ,actually play a critical role in character shaping and plot development.Key words :corpus ;Mo Yan ;Frog ;key words ;retrieval一、引言2012年,莫言获得了瑞典诺贝尔委员会颁发的诺贝尔文学奖,成为第一位获得该奖项的中国籍作家。

elasticsearch7.8.0参数详解,配置优化

elasticsearch7.8.0参数详解,配置优化优化es的安装和配置是⾮常轻量级的,为满⾜多种不同的应⽤场景,底层提供多种数据结构⽀持,并做了⼤量的默认配置优化,部分配置针对具体的⽤户使⽤场景可能是冗余的,甚⾄可能造成性能的下降,需要根据实际业务场景做适当取舍,我们结合⾃⾝使⽤场景做了如下优化(⽂章中有疏漏或不正确的地⽅也欢迎点评指正)。

⼀、环境配置sudo swapoff -a# 禁⽤swapping,开启服务器虚拟内存交换功能会对es产⽣致命的打击vm.max_map_count# 在/etc/sysctl.conf⽂件中找到该参数,修改为655300后执⾏sysctl -p,不然启动时会报值太⼩⼆、内存优化 常⽤的配置在两个⽂件⾥,分别是 elasticsearch.yml 和 jvm.options(配置内存) jvm.options主要是进⾏内存相关配置,elasticsearch默认给的1g,官⽅建议分配给es的内存不要超出系统内存的50%,预留⼀半给Lucene,因为Lucene会缓存segment数据提升检索性能;内存配置不要超过32g,如果你的服务器内存没有远远超过64g,那么不建议将es的jvm内存设置为32g,因为超过32g后每个jvm对象指针的长度会翻倍,导致内存与cpu的开销增⼤。

-Xms10g-Xmx10g三、基础配置 修改配置⽂件elasticsearch.yml: elasticsearch集群名称,es服务会通过⼴播⽅式⾃动连接在同⼀⽹段下的es服务,通过多播⽅式进⾏通信,同⼀⽹段下可以有多个集群,通过集群名称这个属性来区分不同的集群。

: "test"当前配置所在机器的节点名,你不设置就默认随机指定⼀个name列表中名字,该name列表在es的jar包中config⽂件夹⾥name.txt⽂件中,其中有很多作者添加的有趣名字。

node.master: true指定该节点是否有资格被选举成为node(注意这⾥只是设置成有资格,不代表该node⼀定就是master),默认是true,es是默认集群中的第⼀台机器为master,如果这台机挂了就会重新选举master。

MySQL中文全文检索的实现方法

MySQL中文全文检索的实现方法导言在当今信息爆炸的时代,快速准确地搜索和检索大量的文本数据变得日益重要。

而对于使用MySQL作为数据库的应用程序来说,实现中文全文检索显得尤为关键。

本文将介绍MySQL中文全文检索的实现方法,包括其原理、常用技术和应用示例。

一、MySQL中文全文检索的原理MySQL中文全文检索的原理是基于倒排索引(Inverted Index)和分词技术。

倒排索引是一种将文档中的关键词与其出现的位置对应起来的数据结构,可以提高检索速度和准确度。

而中文分词技术则是将中文文本按照一定规则划分为若干个词语,以便进行索引和检索。

二、1. 安装MySQL中文分词插件MySQL本身并不直接支持中文分词,但可以通过安装第三方插件来实现。

常用的中文分词插件有SmartChineseAnalyzer和Ansj等。

安装插件的具体步骤可以通过查阅相关文档或搜索引擎获得详细指导。

2. 创建全文索引在MySQL中,使用FULLTEXT类型的索引可以实现全文检索。

首先,需要在表中添加FULLTEXT索引,对于中文文本字段,需要使用分词函数对文本进行处理。

例如,假设表中存在一个名为content的文本字段,可以使用以下语句添加全文索引:ALTER TABLE 表名 ADD FULLTEXT(content)3. 进行全文检索一旦添加完全文索引后,就可以使用MATCH AGAINST语句进行全文检索,该语句可以指定要搜索的关键词和字段。

例如,要在content字段中搜索包含关键词“中文”的文本,可以使用以下语句:SELECT * FROM 表名 WHERE MATCH(content) AGAINST ('中文')此外,还可以使用BOOLEAN MODE来进行全文检索,该模式可以通过使用+和-符号指定必须包含或排除的关键词。

例如,要搜索同时包含“中文”和“全文检索”的文本,可以使用以下语句:SELECT * FROM 表名 WHERE MATCH(content) AGAINST ('+中文 +全文检索' IN BOOLEAN MODE)三、MySQL中文全文检索的常用技术1. 高亮显示搜索结果为了让搜索结果更加直观,可以使用HTML的标签和样式对搜索关键词进行高亮显示。

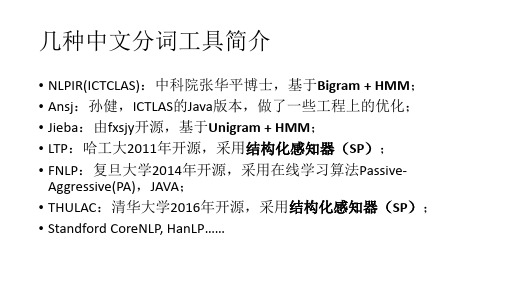

中文分词工具对比

对比:LTP、NLPIR、THULAC和jieba (C++)

• 1、数据集:SIGHAN Bakeoff 2005 MSR, 560KB

对比:LTP、NLPIR、THULAC和jieba (C++)

• 2、数据集:SIGHAN Bakeoff 2005 PKU, 510KB

对比:LTP、NLPIR、THULAC和jieba (C++)

• Thulac4j在官方THULAC-Java基础上做了工程性优化

补充

• 测试数据集为搜狗新闻语料,65MB(少量噪声); • THULAC两种模式:SegOnly模式,只分词没有词性标注;SegPos模 式,分词兼有词性标注; • SegOnly分词速度快,但是准确率较SegPos模式低;而SegPos具有 更高的准确,但内存占用更多、分词速度较慢; • THULAC基于结构化感知器SP,CoreNLP基于CRF,Ansj与HanLP (其两种分词模式)是基于HMM; • 理论上讲,分词效果:CRF ≈≈ SP > HMM; • 从分词速率的测试结果上来看,THULAC是兼顾效果与速率。

几种中文分词工具简介

• NLPIR(ICTCLAS):中科院张华平博士,基于Bigram + HMM; • Ansj:孙健,ICTLAS的Java版本,做了一些工程上的优化; • Jieba:由fxsjy开源,基于Unigram + HMM; • LTP:哈工大2011年开源,采用结构化感知器(SP); • FNLP:复旦大学2014年开源,采用在线学习算法PassiveAggressive(PA),JAVA; • THULAC:清华大学2016年开源,采用结构化感知器(SP); • Standford CoreNLP, HanLP……

ansj_seg用法

ansj_seg用法ansj_seg是一种Java中文分词器,它可以将中文文本划分为一个个词语。

它的用法如下:1. 导入ansj_seg.jar包2. 创建Seg对象javaSeg seg = new DicAnalysis();3. 调用Seg对象的分词方法javaString text = "这是一段测试文本";Result result = seg.parse(text);4. 遍历Result对象,获取每个词语以及其所在位置和分词的类型javaTerm term = null;while ((term = result.next()) != null) {String word = term.getName();int offset = term.getOffe();String nature = term.getNatureStr();do something}5. 可以根据需要选择使用不同的分词方法,比如:- DicAnalysis :基于词典的分词方法- ToAnalysis:基于规则的分词方法- NlpAnalysis:结合了词典和规则的分词方法javaSeg seg = new ToAnalysis(); 使用ToAnalysis分词方法6. 可以自定义词典或停用词,以便更好地识别特定词语或过滤常用词语java自定义词典String userDictPath = "path/to/user_dict.txt";Dictionary dictionary =DictionaryFactory.getDictionary(Dictionary.DEFAULT_MEM_DICT, "userDict", new File(userDictPath).getPath(), true); DictionaryFactory.put(Dictionary.DEFAULT_MEM_DICT, "userDict", dictionary);Seg seg = new DicAnalysis();自定义停用词StopRecognition filter = new StopRecognition();filter.insertStopNatures("w", "r", "zg"); 停用标点符号、代词、转接语素等词性Seg seg = new DicAnalysis().setFilter(filter);。

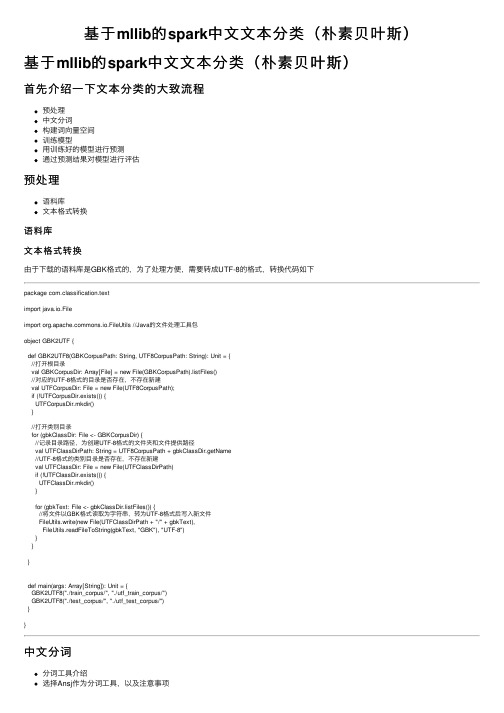

基于mllib的spark中文文本分类(朴素贝叶斯)

基于mllib的spark中⽂⽂本分类(朴素贝叶斯)基于mllib的spark中⽂⽂本分类(朴素贝叶斯)⾸先介绍⼀下⽂本分类的⼤致流程预处理中⽂分词构建词向量空间训练模型⽤训练好的模型进⾏预测通过预测结果对模型进⾏评估预处理语料库⽂本格式转换语料库⽂本格式转换由于下载的语料库是GBK格式的,为了处理⽅便,需要转成UTF-8的格式,转换代码如下package com.classification.textimport java.io.Fileimport mons.io.FileUtils //Java的⽂件处理⼯具包object GBK2UTF {def GBK2UTF8(GBKCorpusPath: String, UTF8CorpusPath: String): Unit = {//打开根⽬录val GBKCorpusDir: Array[File] = new File(GBKCorpusPath).listFiles()//对应的UTF-8格式的⽬录是否存在,不存在新建val UTFCorpusDir: File = new File(UTF8CorpusPath);if (!UTFCorpusDir.exists()) {UTFCorpusDir.mkdir()}//打开类别⽬录for (gbkClassDir: File <- GBKCorpusDir) {//记录⽬录路径,为创建UTF-8格式的⽂件夹和⽂件提供路径val UTFClassDirPath: String = UTF8CorpusPath + gbkClassDir.getName//UTF-8格式的类别⽬录是否存在,不存在新建val UTFClassDir: File = new File(UTFClassDirPath)if (!UTFClassDir.exists()) {UTFClassDir.mkdir()}for (gbkText: File <- gbkClassDir.listFiles()) {//将⽂件以GBK格式读取为字符串,转为UTF-8格式后写⼊新⽂件FileUtils.write(new File(UTFClassDirPath + "/" + gbkText),FileUtils.readFileToString(gbkText, "GBK"), "UTF-8")}}}def main(args: Array[String]): Unit = {GBK2UTF8("./train_corpus/", "./utf_train_corpus/")GBK2UTF8("./test_corpus/", "./utf_test_corpus/")}}中⽂分词分词⼯具介绍选择Ansj作为分词⼯具,以及注意事项Ansj中⽂分词实现分词⼯具介绍中⽂分词的理论部分很多博客都有介绍,这⾥主要介绍代码实现(理论咱现在也不会,就会调⽤API)。

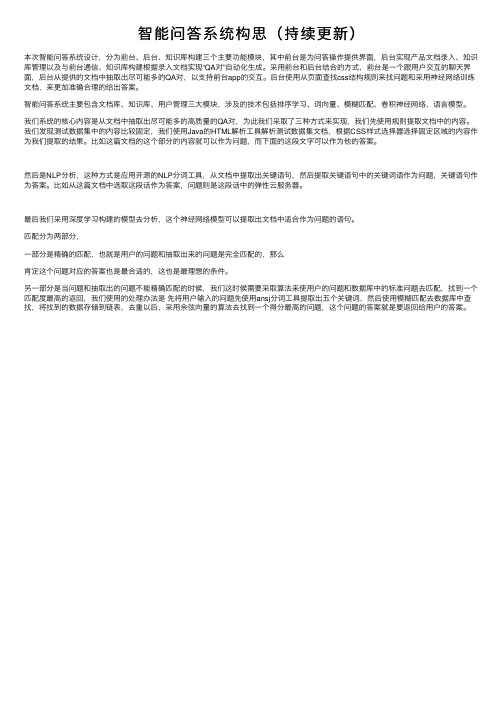

智能问答系统构思(持续更新)

智能问答系统构思(持续更新)本次智能问答系统设计,分为前台、后台、知识库构建三个主要功能模块,其中前台是为问答操作提供界⾯,后台实现产品⽂档录⼊、知识库管理以及与前台通信、知识库构建根据录⼊⽂档实现“QA对”⾃动化⽣成。

采⽤前台和后台结合的⽅式,前台是⼀个跟⽤户交互的聊天界⾯,后台从提供的⽂档中抽取出尽可能多的QA对,以⽀持前台app的交互。

后台使⽤从页⾯查找css结构规则来找问题和采⽤神经⽹络训练⽂档,来更加准确合理的给出答案。

智能问答系统主要包含⽂档库、知识库、⽤户管理三⼤模块,涉及的技术包括排序学习、词向量、模糊匹配、卷积神经⽹络、语⾔模型。

我们系统的核⼼内容是从⽂档中抽取出尽可能多的⾼质量的QA对,为此我们采取了三种⽅式来实现,我们先使⽤规则提取⽂档中的内容。

我们发现测试数据集中的内容⽐较固定,我们使⽤Java的HTML解析⼯具解析测试数据集⽂档,根据CSS样式选择器选择固定区域的内容作为我们提取的结果。

⽐如这篇⽂档的这个部分的内容就可以作为问题,⽽下⾯的这段⽂字可以作为他的答案。

然后是NLP分析,这种⽅式是应⽤开源的NLP分词⼯具,从⽂档中提取出关键语句,然后提取关键语句中的关键词语作为问题,关键语句作为答案。

⽐如从这篇⽂档中选取这段话作为答案,问题则是这段话中的弹性云服务器。

最后我们采⽤深度学习构建的模型去分析,这个神经⽹络模型可以提取出⽂档中适合作为问题的语句。

匹配分为两部分,⼀部分是精确的匹配,也就是⽤户的问题和抽取出来的问题是完全匹配的,那么肯定这个问题对应的答案也是最合适的,这也是最理想的条件。

另⼀部分是当问题和抽取出的问题不能精确匹配的时候,我们这时候需要采取算法来使⽤户的问题和数据库中的标准问题去匹配,找到⼀个匹配度最⾼的返回,我们使⽤的处理办法是先将⽤户输⼊的问题先使⽤ansj分词⼯具提取出五个关键词,然后使⽤模糊匹配去数据库中查找,将找到的数据存储到链表,去重以后,采⽤余弦向量的算法去找到⼀个得分最⾼的问题,这个问题的答案就是要返回给⽤户的答案。

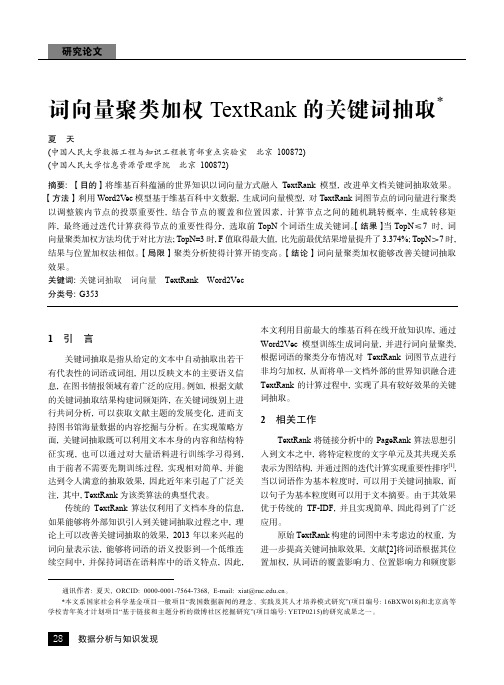

词向量聚类加权TextRank的关键词抽取

TextRank 将链接分析中的 PageRank 算法思想引 入到文本之中, 将特定粒度的文字单元及其共现关系 表示为图结构, 并通过图的迭代计算实现重要性排序[1], 当以词语作为基本粒度时, 可以用于关键词抽取, 而 以句子为基本粒度则可以用于文本摘要。由于其效果 优于传统的 TF-IDF, 并且实现简单, 因此得到了广泛 应用。

传统的textrank算法仅利用了文档本身的信息如果能够将外部知识引入到关键词抽取过程之中理论上可以改善关键词抽取的效果2013年以来兴起的词向量表示法能够将词语的语义投影到一个低维连续空间中并保持词语在语料库中的语义特点因此本文利用目前最大的维基百科在线开放知识库通过word2vec模型训练生成词向量并进行词向量聚类根据词语的聚类分布情况对textrank词图节点进行非均匀加权从而将单一文档外部的世界知识融合进textrank的计算过程中实现了具有较好效果的关键词抽取

1 d 的概率随机跳转到词图中的其他节点, 以保证

TextRank 的迭代计算可以收敛, 通常取值为 0.85;

adj[u] {v | (v u) E} 表示节点 u 的相邻节点集;

p(v u) 表示由节点 v 到达 u 的随机跳转概率。

传统的 TextRank 算法在相邻节点之间采用均匀

28 数据分析与知识发现

总第 2 期 2017 年 第 2 期

响力三个方面调整词图中边的传递权重, 改进关键词 抽取效果。文献[3]则进一步将 TextRank 与 LDA 主题 模型融合到一起, 综合考虑单一文档的结构信息和文 档整体的主题信息, 研究发现在数据集呈现明显的主 题分布时, 对关键词抽取效果有一定改善。文献[4]提 出了 Tag-TextRank 方法, 利用网页的社会化标签提高 网 页 关 键 词 抽 取 的 效 果 。 文 献 [5] 在 词 语 位 置 加 权 TextRank 基础上, 同时考虑词语的逆文档频率, 实现 关键词抽取并用于论文审稿自动推荐之中。近年来, 随着 Word2Vec 词向量模型的兴起, 人们开始尝试将 Word2Vec 应用于关键词抽取之中。文献[6]根据词向 量之间的相似度进行词汇聚类, 针对每个聚类结果簇 选择距离质心最近的词语作为关键词, 实现关键词抽 取。文献[7]利用 Word2Vec 计算词汇之间的相似度矩 阵, 并融入到 TextRank 词图计算过程中, 以改善抽取 效果。

大数据分析训练模式在法学教学中的构建研究

大数据分析训练模式在法学教学中的构建研究摘要:“法律+大数据分析”是未来法学研究的重要发展方向,本文以教改项目为依托,探讨大数据分析训练模式在法学教学中的构建方法和实践,跨系合作建设法律案件预判系统和引导学生撰写法律大数据分析报告是本次教学改革的重点步骤,该训练模式能够帮助学生建立法律大数据分析思维,学会搜集预判系统中需要的关键信息,以及撰写有一定市场指导价值的大数据分析报告。

关键词:法律预判;大数据分析;训练模式;法学教学一、研究背景全国各级人民法院的裁判文书公开上网,诉讼案件的大量文档蕴藏的数据对此后同类型案件的代理和审判具有很高的参考价值,也为法学研究提供了丰富的案例素材,法律业大数据时代已经到来。

法律智能预判系统研究是通过将法院判决书数据信息如:案件耗时、提供材料、胜诉概率、律师费用等进行提取、归类、筛选,运用科学的计算方法对各项数据进行分析,利用数据处理端提取关键信息,机器学习模型进行数据挖掘,得到初步成果,SVM技术生成模型文件,建立起一个互联网用户搜索的数据库,并通过可视化方式进行呈现,得出一个有迹可循的判案参考,达到对诉讼案件结果的预测要求的研究。

什么是法律行业大数据分析报告?目前没有一个标准的或者有说服力的定义。

我们提出一个法律行业大数据的定义雏形,所谓法律行业大数据报告,就是用适当的司法数据收集方法、统计分析方法,对数据进行整理分析,并以法律人的视角筛选、归纳、提炼,最终以可视化方式将历史的或者现实的客观数据呈现给用户,帮助用户预测方向与路径,做出尽可能正确的决策,这里的用户,可以是法律案件当事人,也可以是法律从业者。

二、研究步骤1. 法律智能预判系统建设(1)web前端我们做出了关于法律预判系统前端的web设计。

从Web标准出发,通过HTML 代码实现网站前台的内容和结构,通过CSS代码实现相关内容的样式,通过Java Script代码实现页面的动态效果。

并且考虑到法律工作者和非法律工作者的使用习惯,设计出一个简洁、大方的web界面,还兼顾合理的布局、协调的页面颜色搭配和较好的用户体验。

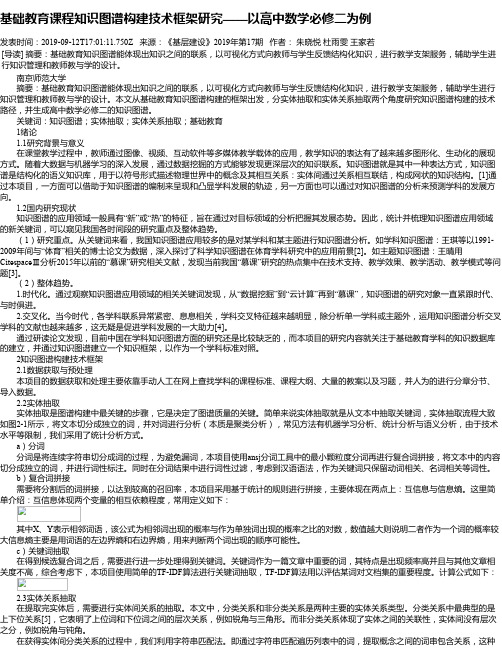

基础教育课程知识图谱构建技术框架研究——以高中数学必修二为例

基础教育课程知识图谱构建技术框架研究——以高中数学必修二为例发表时间:2019-09-12T17:01:11.750Z 来源:《基层建设》2019年第17期作者:朱晓悦杜雨雯王家若[导读] 摘要:基础教育知识图谱能体现出知识之间的联系,以可视化方式向教师与学生反馈结构化知识,进行教学支架服务,辅助学生进行知识管理和教师教与学的设计。

南京师范大学摘要:基础教育知识图谱能体现出知识之间的联系,以可视化方式向教师与学生反馈结构化知识,进行教学支架服务,辅助学生进行知识管理和教师教与学的设计。

本文从基础教育知识图谱构建的框架出发,分实体抽取和实体关系抽取两个角度研究知识图谱构建的技术路径,并生成高中数学必修二的知识图谱。

关键词:知识图谱;实体抽取;实体关系抽取;基础教育1绪论1.1研究背景与意义在课堂教学过程中,教师通过图像、视频、互动软件等多媒体教学载体的应用,教学知识的表达有了越来越多图形化、生动化的展现方式。

随着大数据与机器学习的深入发展,通过数据挖掘的方式能够发现更深层次的知识联系。

知识图谱就是其中一种表达方式,知识图谱是结构化的语义知识库,用于以符号形式描述物理世界中的概念及其相互关系:实体间通过关系相互联结,构成网状的知识结构。

[1]通过本项目,一方面可以借助于知识图谱的编制来呈现和凸显学科发展的轨迹,另一方面也可以通过对知识图谱的分析来预测学科的发展方向。

1.2国内研究现状知识图谱的应用领域一般具有“新”或“热”的特征,旨在通过对目标领域的分析把握其发展态势。

因此,统计并梳理知识图谱应用领域的新关键词,可以窥见我国各时间段的研究重点及整体趋势。

(1)研究重点。

从关键词来看,我国知识图谱应用较多的是对某学科和某主题进行知识图谱分析。

如学科知识图谱:王琪等以1991-2009年间与“体育”相关的博士论文为数据,深入探讨了科学知识图谱在体育学科研究中的应用前景[2]。

如主题知识图谱:王晴用CitespaceⅢ分析2015年以前的“慕课”研究相关文献,发现当前我国“慕课”研究的热点集中在技术支持、教学效果、教学活动、教学模式等问题[3]。

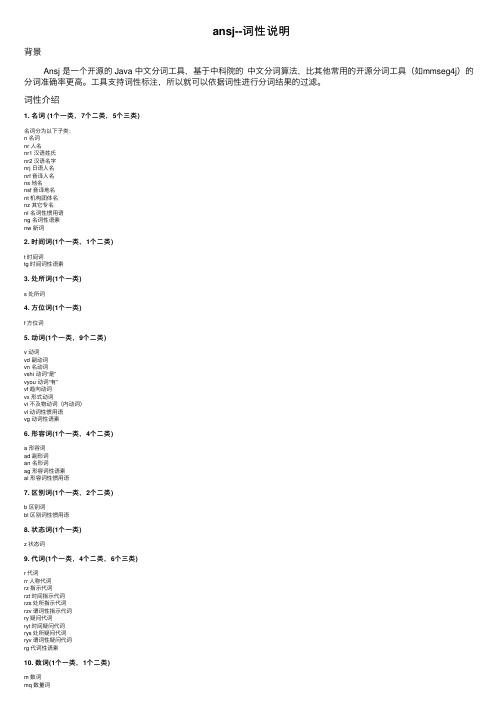

ansj--词性说明

ansj--词性说明背景 Ansj 是⼀个开源的 Java 中⽂分词⼯具,基于中科院的中⽂分词算法,⽐其他常⽤的开源分词⼯具(如mmseg4j)的分词准确率更⾼。

⼯具⽀持词性标注,所以就可以依据词性进⾏分词结果的过滤。

词性介绍1. 名词 (1个⼀类,7个⼆类,5个三类)名词分为以下⼦类:n 名词nr ⼈名nr1 汉语姓⽒nr2 汉语名字nrj ⽇语⼈名nrf ⾳译⼈名ns 地名nsf ⾳译地名nt 机构团体名nz 其它专名nl 名词性惯⽤语ng 名词性语素nw 新词2. 时间词(1个⼀类,1个⼆类)t 时间词tg 时间词性语素3. 处所词(1个⼀类)s 处所词4. ⽅位词(1个⼀类)f ⽅位词5. 动词(1个⼀类,9个⼆类)v 动词vd 副动词vn 名动词vshi 动词“是”vyou 动词“有”vf 趋向动词vx 形式动词vi 不及物动词(内动词)vl 动词性惯⽤语vg 动词性语素6. 形容词(1个⼀类,4个⼆类)a 形容词ad 副形词an 名形词ag 形容词性语素al 形容词性惯⽤语7. 区别词(1个⼀类,2个⼆类)b 区别词bl 区别词性惯⽤语8. 状态词(1个⼀类)z 状态词9. 代词(1个⼀类,4个⼆类,6个三类)r 代词rr ⼈称代词rz 指⽰代词rzt 时间指⽰代词rzs 处所指⽰代词rzv 谓词性指⽰代词ry 疑问代词ryt 时间疑问代词rys 处所疑问代词ryv 谓词性疑问代词rg 代词性语素10. 数词(1个⼀类,1个⼆类)m 数词mq 数量词11. 量词(1个⼀类,2个⼆类)q 量词qv 动量词qt 时量词12. 副词(1个⼀类)d 副词13. 介词(1个⼀类,2个⼆类)p 介词pba 介词“把”pbei 介词“被”14. 连词(1个⼀类,1个⼆类)c 连词cc 并列连词15. 助词(1个⼀类,15个⼆类)u 助词uzhe 着ule 了喽uguo 过ude1 的底ude2 地ude3 得usuo 所udeng 等等等云云uyy ⼀样⼀般似的般udh 的话uls 来讲来说⽽⾔说来uzhi 之ulian 连(“连⼩学⽣都会”)16. 叹词(1个⼀类)e 叹词17. 语⽓词(1个⼀类)y 语⽓词(delete yg)18. 拟声词(1个⼀类)o 拟声词19. 前缀(1个⼀类)h 前缀20. 后缀(1个⼀类)k 后缀21. 字符串(1个⼀类,2个⼆类)x 字符串xx ⾮语素字xu ⽹址URL22. 标点符号(1个⼀类,16个⼆类)w 标点符号wkz 左括号,全⾓:(〔[{《【〖〈半⾓:( [ { < wky 右括号,全⾓:)〕]}》】〗〉半⾓: ) ] { > wyz 左引号,全⾓:“ ‘ 『wyy 右引号,全⾓:” ’ 』wj 句号,全⾓:。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

ansj分词原理

随着互联网的发展,信息爆炸的时代已经到来。

在这样的环境下,对于搜索引擎来说,如何有效地处理海量的文本数据,成为了一项重要的技术挑战。

而分词技术作为搜索引擎处理文本数据的基础,也越来越受到关注。

ansj分词是一种基于Java语言的中文分词工具。

它的特点在于速度快、准确率高,而且支持自定义词典。

在这篇文章中,我们将介绍ansj分词的原理和实现。

一、分词原理

ansj分词的分词原理主要基于两个算法:正向最大匹配算法和逆向最大匹配算法。

这两个算法都是基于词典的匹配算法,具体的流程如下:

1. 正向最大匹配算法

正向最大匹配算法是指从左到右扫描文本,每次取出最长的词语作为分词结果,并将已经分出的词语从文本中删除。

这种算法的优点是速度快,缺点是可能会出现歧义,比如“中国人民银行”这个词语,按照正向最大匹配算法可能会被分成“中国人民”和“银行”两个词语。

2. 逆向最大匹配算法

逆向最大匹配算法是指从右到左扫描文本,每次取出最长的词语作为分词结果,并将已经分出的词语从文本中删除。

这种算法的优点是可以避免歧义,缺点是速度较慢。

ansj分词采用的是双向最大匹配算法,即同时采用正向最大匹配算法和逆向最大匹配算法,然后根据一定的规则来决定最终的分词结果。

二、分词实现

ansj分词的实现主要包括三个方面:词典的构建、分词算法的实现和规则的设计。

1. 词典的构建

词典是分词的基础。

ansj分词采用的是基于内存的双数组Trie 树来实现词典。

Trie树是一种树形结构,用于存储字符串集合。

在Trie树中,每个节点代表一个字符串的前缀,而从根节点到叶子节点的路径表示一个完整的字符串。

由于Trie树的查询效率非常高,因此ansj分词采用了这种数据结构来实现词典。

2. 分词算法的实现

ansj分词采用的是双向最大匹配算法。

具体来说,算法的流程如下:

(1)首先将待分词的文本按照一定的规则进行切割,得到一些基本的词语。

(2)然后将这些词语分别用正向最大匹配算法和逆向最大匹配算法进行分词,并得到两个分词结果。

(3)将两个分词结果进行比较,并根据一定的规则来决定最终的分词结果。

3. 规则的设计

ansj分词的规则设计主要包括以下几个方面:

(1)词典规则:根据词典中的词语来进行分词。

(2)长度规则:优先选择长度较长的词语作为分词结果。

(3)频率规则:优先选择出现频率较高的词语作为分词结果。

(4)位置规则:优先选择在文本中较前面出现的词语作为分词结果。

(5)歧义规则:根据上下文来解决分词歧义。

三、总结

ansj分词是一种基于Java语言的中文分词工具,具有速度快、准确率高和支持自定义词典等优点。

其分词原理主要基于正向最大匹配算法和逆向最大匹配算法,并采用双向最大匹配算法来决定最终的分词结果。

在实现方面,ansj分词主要包括词典的构建、分词算法的实现和规则的设计。