emcvplex存储双活建设方案.

EMC VPLEX

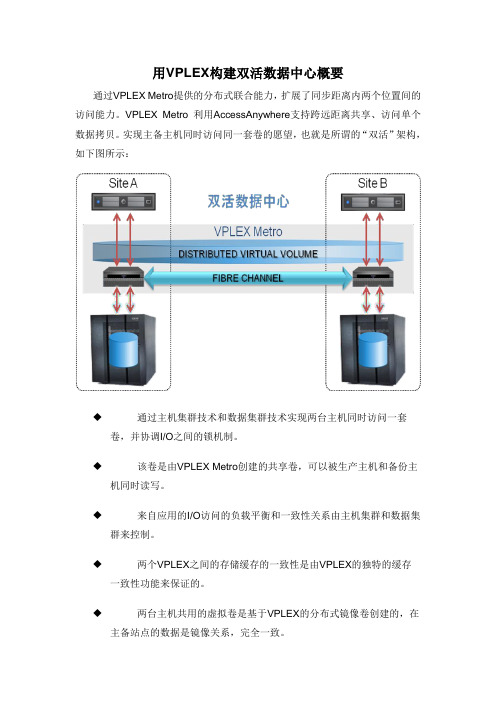

用VPLEX构建双活数据中心概要

通过VPLEX Metro提供的分布式联合能力,扩展了同步距离内两个位置间的访问能力。

VPLEX Metro 利用AccessAnywhere支持跨远距离共享、访问单个数据拷贝。

实现主备主机同时访问同一套卷的愿望,也就是所谓的“双活”架构,如下图所示:

◆通过主机集群技术和数据集群技术实现两台主机同时访问一套

卷,并协调I/O之间的锁机制。

◆该卷是由VPLEX Metro创建的共享卷,可以被生产主机和备份主

机同时读写。

◆来自应用的I/O访问的负载平衡和一致性关系由主机集群和数据集

群来控制。

◆两个VPLEX之间的存储缓存的一致性是由VPLEX的独特的缓存

一致性功能来保证的。

◆两台主机共用的虚拟卷是基于VPLEX的分布式镜像卷创建的,在

主备站点的数据是镜像关系,完全一致。

在生产主机正常进行读写的同时,备份主机可以接受只读I/O请求,而且从备份主机读出来的数据是实时更新的生产数据。

联想VPLEX双活数据中心解决方案

2015 Lenovo Internal. All rights reserved.

9

通过跨不同位置进行镜像,保持可用 性和无中断访问 高可用性 消除因故障切换 所进行的存储操作

实现跨不同位置对数据的 并发读/写访问 跨远距离 即时和同时访问数据 简化工作流

数据中心迁移

工作负载重新平衡

4个前端8 Gb/s FC端口/Director Engine

6

VPLEX:为客户带来绝佳的业务收益

2015 Lenovo Internal. All rights reserved.

7

成功案例:联宝电子私有云、双活数据中心项目

用户痛点:

1. 2. 3. 4. 7*24小时候不间断工厂,不允许业务中断、数据丢失; 核心MES和SAS ERP系统的存储系统,存在单点故障; 随着工厂产能提高,数据库压力增大,原存储性能不够; 原存储管理复杂,几乎无法监控;

Core Core Core Core

Core Core Core Core

Core Core Core Core

Core Core Core Core

Distributed Cache

Inter-Cluster COM Intra-Cluster COM

Distributed Cache

Inter-Cluster COM Intra-Cluster COM

VPLEX Geo

跨数据中心

同步(5-10ms)

异步(50ms)

VPLEX Local

数据中心内

RecoverPoint

异地恢复与第三方站点保护

延伸

2015 Lenovo Internal. All rights reserved.

VTM系统生产存储vplex实施方案

VTM生产系统存储更换实施方案目录实施过程概述本次实施为泰安银行VTM系统原有数据迁移至EMCVPLEX平台,实现在EMCVPLEX平台的数据双活。

项目涉及的设备有原有存储IBMV7000、EMCVPLEX 和IBMF96。

目的是为了数据实现存储IBMV7000与EMCVNX5600存储双活。

1VTM系统设备接入生产环境1.1VTM系统连接示意图1.2SAN交换机端口分配示意图1.3SAN交换机ZONE配置1.3.1通讯要求VTMDF2_S2_P0Sw2:12Vplexvplex-E1DA-FE1 Sw2:52vplex-E1DB-FE1 Sw2:53 vplex-E2DA-FE1 Sw2:54 vplex-E2DB-FE1 Sw2:55VTMv7000V7000_A_1SW1:0Vplexvplex-E1DA-FE0 Sw1:48 VTMv7000存储连接vplex 后端vplex-E1DB-FE0 Sw1:49 V7000_B_1SW2:4vplex-E2DA-FE0 Sw1:50vplex-E2DB-FE0 Sw1:51 V7000_A_3SW1:0Vplexvplex-E1DA-FE1 Sw1:48vplex-E1DB-FE1 Sw1:49 V7000_B_4 SW2:4vplex-E2DA-FE1 Sw1:50 vplex-E2DB-FE1 Sw1:511.3.2 Zone 配置交换机SW1上的ZONE 配置主机zone 名称主机端口 存储端口 VTMappyxv7000_vtmdbfs1_slot18口 0、4口 vtmdbfs1_slot1_vplex_fe 8口 52、53、54、55口VTMDByxv7000_vtmdbfs2_slot112口 0、4口 vtmdbfs2_slot1_vplex_fe 12口52、53、54、55口VTMv7000 V7000_A_1_VPLEX_BE 0、4口48、49、50、51口V7000_B_1_VPLEX_BE交换机SW2上的ZONE 配置主机zone 名称主机端口存储端口VTMapp yxv7000_vtmdbfs1_slot2 8口0、4口vtmdbfs1_slot2_vplex_fe 8口52、53、54、55口VTMDB yxv7000_vtmdbfs2_slot2 12口0、4口vtmdbfs2_slot2_vplex_fe 12口52、53、54、55口VTMv7000 V7000_A_3_VPLEX_BE0、4口48、49、50、51口V7000_B_3_VPLEX_BE2实施前的准备工作注:请联系相关业务管理人员完成下面的工作2.1通知受影响的各业务部门2.2数据备份注:请联系相关业务管理人员做好数据备份工作3查询主机相关信息3.1获取主机的HBA卡信息3.1.1VTMAPP主机信息FC名称WWN号位置描述备注vtmdbfs1_slot1 10:00:00:90:fa:bb:e4:b2 slot1vtmdbfs1_slot2 10:00:00:90:fa:bd:a1:c8 slot23.1.2VTMDB主机上的HBA卡信息FC名称WWN号位置描述备注vtmdbfs2_slot1 10:00:00:90:fa:bd:a1:ca slot1vtmdbfs2_slot2 10:00:00:90:fa:bc:b5:2a slot23.2获取主机VG信息3.2.1VTMAPP(152)主机VG信息VTMAPP主机上所有VGvg_fssize=200Gasm-disk2dg_datasize=2.0Gasm-disk0dg_ocrsize=120Gasm-disk1dg_orasize=200Gasm-disk4dg_backup--没有在oracle中使用size=2.5Tfssize=200Gasm-disk3dg_index3.2.2VTMDB(153)主机上的VG信息VTMDB主机上所有VGvg_fssize=200Gasm-disk2dg_datasize=2.0Gasm-disk0dg_ocrsize=120Gasm-disk1dg_orasize=200Gasm-disk4dg_backup--没有在oracle中使用size=2.5Tfssize=200Gasm-disk3dg_index3.3获取主机的PV信息3.3.1VTMAPP(152)主机上所有的PV信息Pv-name Pv_大小PVUUID Vg_name/dev/dm-8 2.5TB 2Cerob-o20h-cXTN-K86T-aR23-jTzh-CpxxsXvg_fs3.3.2VTMAPP(152)主机上所有的LV信息3.3.3VTMDB(153)主机上的所有PV信息3.3.4VTMDB(153)主机上所有的LV信息4EMC存储分配LUN4.1EMC存储划分LUN4.2V7000存储主机映射排序4.2.1EMCVPLEX添加主机1、在v7000上注册VPLEX的后端端口。

vplex 运维及异构存储双活使用实例技术手册

vplex 运维及异构存储双活使用

实例技术手册

Vplex 运维及异构存储双活使用实例技术手册是一份详细介绍 Vplex

集群组件、硬件架构、存储卷、双活技术和逻辑封装流程等内容的文档。

以下是该手册的核心内容:

1. Vplex 集群组件和硬件架构:Vplex 集群组件都会预安装在DellEMC 机架上,其硬件架构的高可用性体现在以下的方面:

引擎:每个引擎都包含两个独立的控制器。

I/O 模块:每个控制器安装了四个 FC I/O 模块,分为两个前

端模块(连接主机)和两个后端模块(连接存储);另外还有两个

I/O 扩展模块,用于控制器间的数据路径和通信。

备用电源:每个引擎由一个 SPS 提供后备电源,在电源故障时

允许进行写缓存,防止数据丢失。

SAN 交换机:配置了两个 SAN 交换机用于集群内部控制器之间

的连接。

UPS:配备了 UPS 以避免短暂断电带来的业务停顿风险。

2. 存储卷:Vplex 的存储卷是通过 claim 存储阵列中的 LUN 生成的。

每个存储卷都可以被映射到一个或多个虚拟卷,只有虚拟卷才可以被

给前端主机访问。

其中有一种 Distributed 的方式,它是由不同集群的 Device 组成的。

3. 双活技术:Vplex 双活技术可以实现在多个站点间同时读写数据,以提高系统的可用性和性能。

同时,它还可以实现容灾和恢复功能,确保数据的完整性和可靠性。

4. 逻辑封装流程:在 VPLEX 存储纳管之后,还需要按照特定的逻辑封装流程来完成。

其中包括创建 extent、创建 device 和创建virtual volume 等步骤。

双活数据中心容灾建设VPLEX

0

Downtime

Continuous Availability

∞

Recovery

Continuous Data Protection

0

Impact

Data Mobility

Continue to Operate

© Copyright 2013 EMC Corporation. All rights reserved.

© Copyright 2013 EMC Corporation. All rights reserved.

8

VPLEX Architecture

A resilient clustered architecture comprised of

– VPLEX Director and Engine Hardware – Geosynchrony™ Software

Unplanned Physical and Operational Failures

Database

Failure within the data center

© Copyright 2013 EMC Corporation. All rights reserved.

3

Not All Disruptions are “Unplanned”

Operational Recovery to Any Point in Time

© Copyright 2013 EMC Corporation. All rights reserved.

6

A New Business Continuity Strategy

AVAILABLE OPERATIONAL FLEXIBLE

VPLEX双活数据中心解决方案

VPLEX双活数据中心解决方案VPLEX:双活数据中心解决方案在数据中心内部VPLEX Local VPLEX Metro相隔同步距离的FederatedAccessAnywhereVPLEX Geo相隔异步距离的FederatedAccessAnywhere一个、两个或四个引擎VS1VS2Vblock之间的VPLEXVPLEX:为解决今天的IT挑战而生移动性灾难避免数据中心迁移工作负载重新平衡FederatedAccessAnywhere群集A群集B跨远距离移动和重新定位虚拟机、应用程序和数据协作性跨远距离即时和同时访问数据简化工作流FederatedAccessAnywhere实现跨不同位置对数据的并发读/写访问可用性高可用性消除因故障切换所进行的存储操作FederatedAccessAnywhere通过跨不同位置进行镜像,保持可用性和无中断访问群集A群集B群集A群集BVPLEX :横向可扩展、真正的“双活”Director 间通信端口,用于IO 处理和分布式部署4个前端8 Gb/s FC 端口/Director4个后端8 Gb/s FC 端口/Director 分布式缓存保存本地信息利用Fast cache 提升读性能2个四核处理器Host & Array Ports Core Core Core CoreCore Core Core Core Host & Array Ports Core Core Core Core Core Core Core Core Front End Back End Front End Back End EngineDirector ADirector B Distributed CacheDistributed Cache Inter-Cluster COM B A Intra-Cluster COM B A Inter-Cluster COM B A Intra-Cluster COM B A 每个VPLEX 集群包含4个引擎每个VPLEX 引擎包含2个DirectorVPLEX:双活数据中心、两地三中心部署VPLEX Local 数据中心内VPLEX Metro跨数据中心同步(5-10ms)VPLEX Geo跨数据中心异步(50ms)RecoverPoint 异地恢复与第三方站点保护延伸VPLEX:面向私有云设计VPLEX:为客户带来绝佳的业务收益成功案例:联宝电子私有云、双活数据中心项目用户痛点:1.7*24小时候不间断工厂,不允许业务中断、数据丢失;2.核心MES和SAS ERP系统的存储系统,存在单点故障;3.随着工厂产能提高,数据库压力增大,原存储性能不够;联想解决方案:1.联想服务器+EMC VPLEX(Local+Metro)搭建企业私有云;2.核心应用迁移到云平台,实现资源统一管理、调度、使用;3.在两个机房之间构建RPO和RTO=0的核心数据库双活容灾系统;联想存储:您值得信赖的数据管理专家。

EMC vplex Isilon DD存储备份双活系统实施方案

2016年3月目录1.项目实施内容 (5)1.1存储系统架构示意图 (6)1.3本项目设备硬件配置 (6)2.存储系统实施基础配置 (7)2.1双活数据中心存储实现模式 (7)2.2光纤通道交换机端口连接表 (8)2.3VPLEX端口作用描述 (9)2.4VPLEX端口的使用 (9)2.5存储设备线路连接描述 (9)2.6存储设备端口命名规则 (10)3.SAN存储规划 (10)3.1存储设备连接线缆数量及种类 (10)3.2存储设备IP地址配置 (11)3.3VPLEX的端口连接配置 (11)4.VPLEX METRO实施步骤 (12)4.1VPLEX前期准备 (12)4.1.1 system volumes (12)4.2S WITCH ZONING (13)4.3B ACKEND STORAGE PROVISIONQ (13)4.4VPLEX INITIAL SETUP (13)4.4.1 Configip address and hostname of VPLEX (13)4.4.1.1 Connect to management server (13)4.4.1.2 entering the VPLEXCLI (14)4.4.1.3 set the management server ipaddress (14)4.4.1.4 change the hostname of VPLEX (14)4.4.1.5 check software version (14)4.4.2 use EZ-setup to initialize the VPLEX1 (15)4.4.2.1 Start EZ-setup (15)4.4.2.2 Configure the first cluster (15)4.4.2.3 Chose the local authentication (15)4.4.2.4 Configure event notification (15)4.4.2.5 Configure send system report to EMC (16)4.4.2.6 Configure performance statistics collector (16)4.4.2.7 Generate the certificate (16)4.4.2.8 Backend storage discovery (17)4.4.2.9 create meta-data volume (17)4.4.2.10 verify if meta-data volume is successfully created (18)4.4.2.11 create meta-data volume backups (18)4.4.2.12 enable FE port (18)4.4.3 use EZ-setup to initialize the VPLEX2 (18)4.4.3.1 Connect to VPLEX2 (18)4.4.3.2 Sychronize the time on the clusters (18)4.4.3.3 Start EZ-setup on cluster2 (19)4.4.3.4 Configure the Meta-data volume and backup of VPLEX2 (19)4.4.3.5 Complete configuration of cluster1 (19)4.4.3.6 Complete configuration of cluster2 (19)4.4.4 Join the clusters (19)4.4.5 Create logging volumes (20)4.5C HECK THE CLUSTER HEALTH (21)4.6VPLEX BACKEND STORAGE CONNECTIVITY VERIFY (21)4.7C LAIM THE DA TA VOLUME (21)5.ISILON的实施步骤 (23)5.1集群初始化 (23)5.2节点加入 (37)5.3系统健康检查 (38)5.4O NE FS升级 (38)5.5安装补丁包 (38)5.6系统微码升级 (38)5.7硬盘微码升级 (38)5.8管理界面登录 (39)5.9保护级别设置 (39)5.10网络设置 (40)5.10.1 内网设置 (41)5.10.2 外网设置 (41)5.11目录认证服务 (41)5.12SMB共享规划 (41)5.13NFS共享规划 (43)6DATADOMAIN配置步骤 (45)6.1D A TA D OMAIN配置之前实施内容 (45)6.2D A TA D OMAIN VTL配置 (46)7存储设备的使用示范 (55)7.1操作流程 (55)7.2操作示例 (56)7.2.1 光纤交换机操作部分 (56)7.2.2 EMC VNX7600操作部分 (59)7.2.3 VPLEX 操作部分 (62)1.项目实施内容XX公司双活数据中心灾备项目采用EMC VPLEX METRO解决方案,实现院区主机房和灾备机房容灾。

vplex_双活数据中心项目解决方案

连续可用性

易于安装和配置

最佳性能

Federated AccessAnywhere

VPLEX WITNESS

主动

主动

站点 1

站点 2

站点 3

不降低性能地扩展

仍可用于非 RAC 服务器

Extended Clusters for Continuous Application Availability

Array Replication

VPLEX 改变了这一切

… 它令用户在两个数据中心: 同时读写同一份数据 启动同一个应用程序 让客户端随时随地访问

VPLEX 分布式存储双活架构

给远距离的两个数据中心提供一个共享的存储,两边都能同时读写同一份数据 支持所有主流操作系统cluster技术-IBM,HP,SUN,LINUX,MICROSOFT,SYMANTEC 强大的高可用性和灾备解决方案 确保存储100%可用

Array Replication

Traditional Active – Passive Solution

Extended Clusters for Continuous Application Availability

Oracle RAC With VPLEX

Active Failure Domain

Zero impact to user experience

可用性:VPLEX Witness + 跨群集连接

VPLEX Witness 协调无缝故障切换 支持更长距离的延伸服务器群集 为存储更改或事件提供零 RTO 跨群集连接 最适合较短的距离 利用多路径软件 在更高的主机可用性和 CPU 周期之间进行权衡 减少服务器故障切换

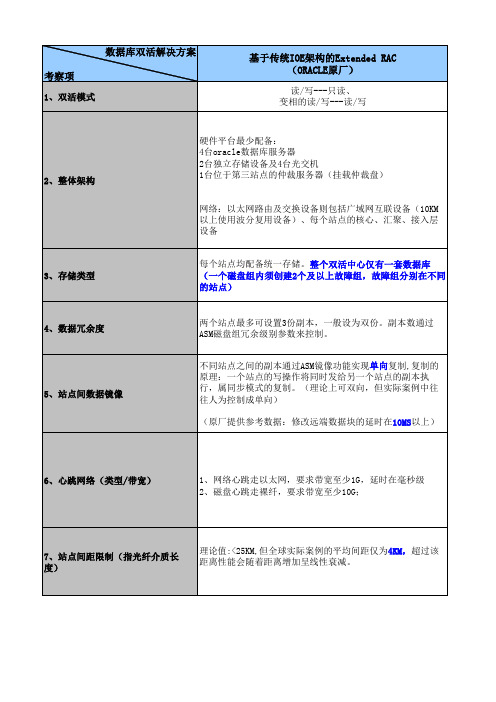

Oracle数据库双活Extended RAC实现技术对比(EMC VPLEX Metro,Oracle IOE,一体机)

网络心跳和磁盘心跳都走IB网络,带宽达40-56Gbps, 可实现端到端延迟<200ns。

★

IB网络比传统以太网的延时 低很多

理论值:<100km公里 ★ 实际案例:<80KM。超过10KM要借助波分复用设备来延 依托IB设备的扩展RAC能支 伸距离。经实测,80KM网络RTT值在0.45-0.5ms

每个站点均配备统一存储。整个双活中心仅有一套数据库(一个 磁盘组内须创建2个及以上故障组,故障组分别在不同的站点)

双份,数据在所有VPLEX存储上做条带化。由vplex实现数据冗 余,一般不再设置ASM磁盘组冗余级别。 不同站点之间的副本利用vplex metro存储复制技术实现双向复 制,任何站点的写操作将同时发给另一个站点的副本执行,属于 同步模式的复制。(双活解决方案不提供异步模式,该模式用于 传统容灾) (参考实际案例数据:经过VPLEX设备,会比第一种方案的延时 还增加1MS) ORACLE RAC: 1、网络心跳走以太网,要求带宽至少1G,延时在毫秒级; 2、磁盘心跳走裸纤,要求带宽至少10G; VPLEX: 3、存储网络至少需8G链路; 在本方案中RAC的磁盘心跳走VPLEX存储网络,带宽至少要满足 10G 理论值:<100km,网络延迟不超过5ms; 实际案例:oracle官方建议不超过10KM,网络延迟不能超过 1ms;超过该距离性能会随着距离增加呈线性衰减。超过10KM要 借助波分复用设备来延伸距离。

相关技术资料

ORACLE原厂白皮书 \\10.194.50.44\平台运维科\8-其它\平台组台帐\双活技术 \oracle

基于VPLEX Metro的Extended RAC (EMC公司)

读/写---读/写 硬件平台最少配备: 2台EMC VPLEX设备 2台独立存储设备 光纤网络交换设备2台(用于连接VPLEX设备、服务器、存储设 备) 4台Oracle数据库服务器 1台VPLEX Witness仲裁服务器 1台位于第三站点的仲裁服务器(挂载仲裁盘) 网络:以太网路由及交换设备则包括广域网互联设备(10KM以上 使用波分复用设备)、每个站点的核心、汇聚、接入层设备

EMC解决方案:VPLEX实现双活数据中心-大连某日资公司

VPLEX实现双活数据中心系统宕机时间趋近于0客户证言:“我们对跟EMC公司的合作非常满意。

EMC公司提供的解决方案,其效果大大超过了我们的预期,让我们发现,云数据中心其实离我们很近。

目前,我们有80%的应用都已经运行在双活数据中心。

很快,我们将把全部应用都迁移到双活数据中心。

”——大连某日资公司首席信息官山浦先生背景和需求某公司是在大连经济技术开发区设立的日本独资制造企业。

该公司的IT系统与日本总部直接连接,每天将产品订单传到总到审核,获得生产许可后,将订单下发到生产车间生产。

因此,IT系统的容灾整个企业的生产运行至关重要。

此前,该公司只有一个数据中心。

如果数据中心发生问题,可能导致订单无法确认,造成生产停顿,给公司带来经济损失。

2011年初,该公司计划在园区内另建容灾机房,希望能够做到,故障恢复目标RPO=0,即0数据丢失,故障恢复时间目标RTO=1小时,即1小时保证恢复故障。

双活数据中心颠覆容灾概念EMC与另外两家厂商一起,参与了这一项目的方案讨论。

在了解客户需求时,EMC 工程师欣喜地发现,该公司的所有业务系统都运行在VMware虚拟化平台,满足了双活数据中心的重要条件。

根据EMC全球的最佳实践,推荐实施双活数据中心的两个应用场景:一个是全虚拟化环境;一个是读多写少的数据库环境(查询类应用)。

该公司正是前一种环境。

实施双活数据中心,是对传统容灾概念的颠覆。

传统的容灾中心有主有备。

从主数据中心切换到备份数据中心,因为切换需要手动操作,一定会有停机时间。

该公司的需求为RTO=1小时,就是为这一时延留出的时间。

在双活数据中心,虚拟机从一个中心切换到另一个中心的时间接近于零。

例如,用VMware高可用软件HA,虚拟机的重启时间为3毫秒,终端用户几乎感受不到时延。

也就是说,可以实现RTO=0。

该公司欣然接受了EMC建立双活数据中心的解决方案。

新机房与原机房距离1公里,通过光纤直连。

总共有40至50台虚拟机,每个中心4台ESX服务器,实现负载均衡。

EMC双活数据中心解决方案 V4.0

EMC数据中心容灾系统建设方案建议书EMC电脑系统(中国)有限公司Version 1.0,2014/10前言信息是用户的命脉, 近十年来信息存储基础设施的建设在用户取得长足的进步。

从内置存储转向外置RAID存储,从多台服务器共享一台外置RAID阵列,再到更多台服务器通过SAN共享更大型存储服务器。

存储服务器容量不断扩大的同时,其功能也不断增强,从提供硬件级RAID保护到独立于服务器的跨磁盘阵列的数据镜像,存储服务器逐渐从服务器外设的角色脱离出来,成为单独的“存储层”,为数据中心的服务器提供统一的数据存储,保护和共享服务。

随着用户业务的不断发展,对IT系统尤其是存储系统的要求越来越高,鉴于用户业务由于信息的重要性,要求各地各用户多中心来预防单一数据中心操作性风险。

多数据中心建设方案可以预防单数据中心的风险,但面对多数据中心建设的巨额投资,如何同时利用多数据中心就成为IT决策者的首要问题。

同时利用多数据中心就必需实现生产数据跨中心的传输和共享,总所周知,服务器性能的瓶颈主要在IO部分,数据在不同中心之间的传输和共享会造成IO延时,进而影响数据中心的总体性能。

同时,各家厂商不断推出新技术,新产品,容量不断扩展,性能不断提高,功能越来越丰富,但由于不同存储厂商的技术实现不尽相同,用户需要采用不同的管理界面来使用不同厂商的存储资源。

这样,也给用户业用户带来不小的问题,首先是无法采用统一的界面来让服务器使用不同厂商的存储服务器,数据在不同厂商存储服务器之间的迁移也会造成业务中断。

作为信息存储行业的领先公司,EMC公司针对用户跨数据中心信息传输和共享的迫切需求,推出存储VPlex解决方案,很好的解决了这些问题。

本文随后将介绍VPlex产品及其主要应用场景,供用户信息存储管理人士参考。

第一章.方案概述1.需求***计划建设两个数据中心,构成同城双生产系统,两中心之间距离不超过100公里;要求数据零丢失,系统切换时间小于5分钟;2.方案简介为了满足客户建设容灾系统的需求,我们设计了本地双活数据中心。

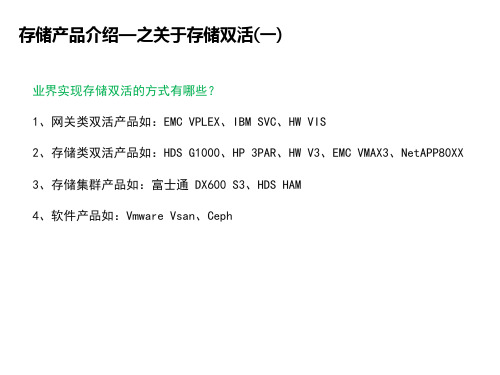

存储双活对比分析(包含实现方式)

存储产品介绍—关于存储双活

Site A

Emc vplex

Active/Active

Site B

Director 1

Direct1or 2

Director 3

Director 4 2

Director 5

3 Director 6

Director 7

D4irector 8

Director 1

Direct1or 2

Site A

Emc vplex

Active/Active

Site B

Director 1

True

Director 1

DirectoAr 2ctive/Active ClustDeirrector 2

Director 3 Load Balance Director 3

Director 4

Director 4

Director 1 Director 2

Director 3 Director 4

Director 5 Director 6

Director 7 Director 8

Ibm svc

Site A

Site B

Node 1

Node 2

Node 3

Node 4

Node 5

Node 6

Node 7

Node 8

Node 3

Node 4

Node 5

Node 6

Node 7

Node 8

存储产品介绍—关于存储双活

Emc vplex NO SPOFSite A NhomakorabeaSite B

Director 1

Director12

Director 3

深入剖析Vplex双活数据中心存储方案

深入剖析Vplex双活数据中心存储方案EMC上一代存储双活方案是通过vPlex网关产品实现,具备异构其他厂商存储的能力,将各厂商存储虚拟化为统一的存储池,为上层服务器提供存储资源。

从2010年vPlex 发布以来其的硬件已经更新了VS1、VS2和VS6三代。

2016年推出的VS6硬件引擎间通过40Gb IB互联(替代FC),在性能上相比VS2硬件提升了2倍、时延下降1/3,并支持更多卷数量。

vPlex6.0 (VS6硬件) 也升级OS至GeoSynchrony6.0针对闪存做了优化。

其双活特性就是通过vPlex Metro的Distributed Device(分布式镜像卷)功能实现,并提供跨站点的双活应用。

vPlex Metro由两套vPlex集群构成,每个站点的vPlex设备都有自己专属的本地存储阵列。

通过创建分布式镜像卷为跨设备的镜像卷,可提供双活访问。

两个站点的vPlex集群各有一个卷,两个卷的ID一样。

在组网上,主机同时连接到两站点的vPlex,两站点的vPlex之间通过FC或10Ge连接,后端阵列只与本地的vPlex连接;vPlex之间和vPlex Witness之间均需要IP网络连接。

vPlex Management Console 是 VPLEX 机柜中的 1U 服务器。

此服务器向vPlex 提供GUI管理界面,在双引擎和四引擎配置中,此服务器由UPS 提供备用电源。

接下来,看看vPlex如何接管外部设备的,外部(包含异构存储)存储把LUN映射给vPlex后,在vPlex上呈现为Storage vol,基于Storage Vol在生产Extents,它可以是Storage Vol的部分或全部(每个Storage Vol最多128个),Extents不能跨Storage Vol,再以Raid的形式组织Extents成Dev(Raid支持0,1和拼接);没有被其他Dev组织的Dev称为Top Level Device,在Top Level Device上创建Virtual volumes提供给主机,并支持在线扩展。

EMC双活数据中心解决方案 V4.0资料

EMC数据中心容灾系统建设方案建议书EMC电脑系统(中国)有限公司Version 1.0,2014/10前言信息是用户的命脉, 近十年来信息存储基础设施的建设在用户取得长足的进步。

从内置存储转向外置RAID存储,从多台服务器共享一台外置RAID阵列,再到更多台服务器通过SAN共享更大型存储服务器。

存储服务器容量不断扩大的同时,其功能也不断增强,从提供硬件级RAID保护到独立于服务器的跨磁盘阵列的数据镜像,存储服务器逐渐从服务器外设的角色脱离出来,成为单独的“存储层”,为数据中心的服务器提供统一的数据存储,保护和共享服务。

随着用户业务的不断发展,对IT系统尤其是存储系统的要求越来越高,鉴于用户业务由于信息的重要性,要求各地各用户多中心来预防单一数据中心操作性风险。

多数据中心建设方案可以预防单数据中心的风险,但面对多数据中心建设的巨额投资,如何同时利用多数据中心就成为IT决策者的首要问题。

同时利用多数据中心就必需实现生产数据跨中心的传输和共享,总所周知,服务器性能的瓶颈主要在IO部分,数据在不同中心之间的传输和共享会造成IO延时,进而影响数据中心的总体性能。

同时,各家厂商不断推出新技术,新产品,容量不断扩展,性能不断提高,功能越来越丰富,但由于不同存储厂商的技术实现不尽相同,用户需要采用不同的管理界面来使用不同厂商的存储资源。

这样,也给用户业用户带来不小的问题,首先是无法采用统一的界面来让服务器使用不同厂商的存储服务器,数据在不同厂商存储服务器之间的迁移也会造成业务中断。

作为信息存储行业的领先公司,EMC公司针对用户跨数据中心信息传输和共享的迫切需求,推出存储VPlex解决方案,很好的解决了这些问题。

本文随后将介绍VPlex产品及其主要应用场景,供用户信息存储管理人士参考。

第一章.方案概述1.需求***计划建设两个数据中心,构成同城双生产系统,两中心之间距离不超过100公里;要求数据零丢失,系统切换时间小于5分钟;2.方案简介为了满足客户建设容灾系统的需求,我们设计了本地双活数据中心。

EMC VPlex存储双活建设方案

XXXX市社保EMC VPlex建议方案V1.0易安信电脑系统(中国)有限公司2012年11月XXX市社保EMC建议方案目录一、总体架构图 (2)二、项目建设规划 (3)1.本地存储双活 (4)2.存储系统利旧 (5)3.数据迁移 (6)4.本地数据备份与恢复 (6)5.备份数据容灾和恢复 (6)三、未来建设规划 (7)1.“双活数据中心” (7)2.“两地三中心” (8)四、产品配置清单 (9)五、相关产品介绍 (11)1.EMC VNX系列存储系统产品介绍 (11)2.EMC VNX系列存储系统规格表 (16)3.EMC存储虚拟化VPLEX产品介绍 (26)4.EMC VPLEX解决方案 (28)5.EMC D ATA D OMAIN虚拟带库介绍 (34)6.N ET W ORKER备份系统介绍 (35)一、总体架构图目前XXX市社保已经在使用EMC的存储系统VNX5100,为了进一步保障社保应用的高可用性,提高生产的安全级别,XXX市社保计划对目前的存储系统进行虚拟化整合,并搭建双活存储系统,保证关键业务所使用的存储系统即使有一台存储系统出现故障,也不会出现业务停顿,达到更高的生产安全保障。

另外,目前发现备份到磁带中的备份集存在很多问题,导致几乎所有备份集都无法读取,这将严重影响整个备份系统的成功率。

所以,非常有必要对整个备份系统进行重新整合,淘汰目前使用的落后技术,采用更加安全、稳定的备份方式。

经讨论和分析,目前XXX市社保的存储整合与数据备份项目可归纳为以下几点需求:1.更加稳定、安全的存储平台;2.更加安全、稳定运行的备份平台和备份存储,并能通过现有网络进行远程备份和恢复;3.可扩展性更强的备份存储,可满足未来几年内数据量的多份全备份,保留所有备份数据若干年以上;经讨论分析,结合系统目前的现状,我们建议XXX市社保存储整合与数据备份项目的架构设计,如下图所示:如上图所示,在生产中心的SAN网络中配置一套存储虚拟化设备——EMC VPlex,将目前的存储系统接入VPlex,所有应用系统只需要访问VPlex上的卷即可,接入VPlex上的存储可以做到镜像关系(即双活)或级联关系。

EMC Vplex双活数据解决方案

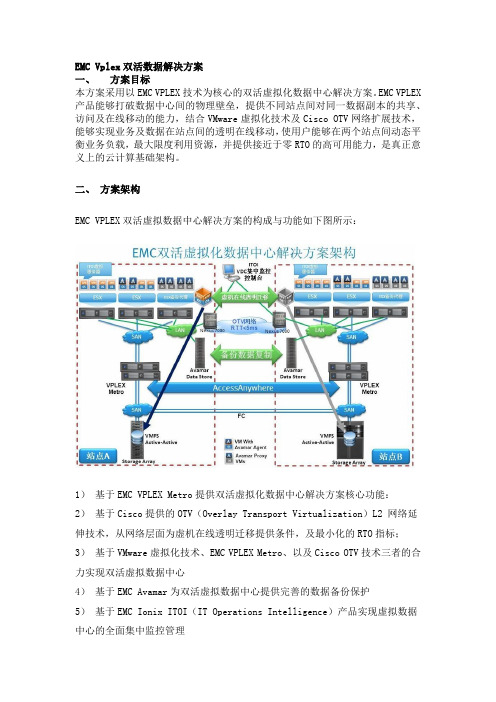

EMC Vplex双活数据解决方案一、方案目标本方案采用以EMC VPLEX技术为核心的双活虚拟化数据中心解决方案。

EMC VPLEX 产品能够打破数据中心间的物理壁垒,提供不同站点间对同一数据副本的共享、访问及在线移动的能力,结合VMware虚拟化技术及Cisco OTV网络扩展技术,能够实现业务及数据在站点间的透明在线移动,使用户能够在两个站点间动态平衡业务负载,最大限度利用资源,并提供接近于零RTO的高可用能力,是真正意义上的云计算基础架构。

二、方案架构EMC VPLEX双活虚拟数据中心解决方案的构成与功能如下图所示:1)基于EMC VPLEX Metro提供双活虚拟化数据中心解决方案核心功能:2)基于Cisco提供的OTV(Overlay Transport Virtualization)L2 网络延伸技术,从网络层面为虚机在线透明迁移提供条件,及最小化的RTO指标;3)基于VMware虚拟化技术、EMC VPLEX Metro、以及Cisco OTV技术三者的合力实现双活虚拟数据中心4)基于EMC Avamar为双活虚拟数据中心提供完善的数据备份保护5)基于EMC Ionix ITOI(IT Operations Intelligence)产品实现虚拟数据中心的全面集中监控管理三、方案功能3.1 EMC VPLEX方案功能EMC VPLEX 引入了一种新的体系结构,它吸收了 EMC 在 20 年设计、实施和完善企业级智能缓存和分布式数据保护解决方案的实践中取得的经验和教训。

以可扩展、高可用的处理器引擎为基础,EMC VPLEX 系列设计为可从小型配置无缝扩展到中型和大型配置。

VPLEX介于在服务器和异构存储之间,使用独特的群集体系结构,该体系结构允许多个数据中心的服务器具有对共享块存储设备的读/写访问权限。

新体系结构的独特特征包括:- 横向扩展群集硬件,允许您从小配置开始并以可预知的服务级别逐步扩展- 高级数据缓存,它利用大规模 SDRAM 缓存提高性能并减少 I/O 延迟和阵列争用- 分布式缓存吻合性,可跨整个群集自动执行 I/O 的共享、平衡和故障切换- 一个统一视图显示跨 VPLEX 群集的一个或多个 LUN(这些群集可以是在同一数据中心内相距几英尺,也可以是跨同步距离),从而实现新的高可用性和工作负载移置模式。

存储及双活测试方案

融通基金存储升级及双活数据中心项目测试方案V1.0深圳市桑威科技有限公司2016年5月文档信息文档维护记录目录1.环境配置 (5)2.测试目的 (5)3.VPLEX测试环境的建立 (5)3.1.SAN SWITCH物理连线 (5)3.2.SAN SWITCH配置 (5)3.3.存储系统配置 (5)4.测试场景 (6)5.测试结论 (7)6.测试步骤及结果 (8)6.1.测试1 : VPLEX控制器高可用测试 (8)6.2.测试2:VPLEX后端链路高可用测试 (9)6.3.测试3:双活镜像测试 (9)6.4.测试4:VPLEX METRO级联链路高可用测试_1 (10)6.5.测试5:双活仲裁测试_1 (10)6.6.测试6:双活仲裁测试_2 (11)6.7.测试7:双活仲裁测试_3 (11)6.8.测试8:双活仲裁测试_4 (12)6.9.测试9:双活仲裁测试_5 (12)6.10.测试10:双活仲裁测试_6 (13)6.11.测试11:双活仲裁测试_7 (13)7.场景测试及结果 (14)7.1.测试场景1:超算VNX5800故障 (14)7.2.测试场景2:汉唐VNX5500故障 (14)7.3.测试场景3:所有存储同时故障 (15)7.4.测试场景4:WITNESS发生故障 (15)7.5.测试场景5:VPLEX_1、VPLEX_2同时故障 (15)7.6.测试场景6:VPLEX_1、VPLEX_2同时故障,后端存储也同时故障 (16)7.7.测试场景7:WITNESS与VPLEX_1 IP通信中断,其他正常 (16)7.8.测试场景8:WITNESS与VPLEX_2 IP通信中断,其他正常 (17)7.9.测试场景9:WITNESS与VPLEX_1、VPLEX2 IP通信中断,其他正常 (17)7.10.测试场景10:VPLEX_1、VPLEX2 IP通信中断,但是VPLEX_1、VPLEX2各自与WITNESS IP通信正常187.11.测试场景11:4台FC交换机之间的裸光纤全部故障,其他正常 (18)7.12.测试场景12:超算FC交换机故障 (19)7.13.测试场景13:汉唐FC交换机故障 (19)7.14.测试场景14:所有交换机同时故障 (20)7.15.测试场景15:VPLEX_1与VNX5800光纤链路故障,其它正常 (20)7.16.测试场景16:VPLEX_2与VNX5500光纤链路故障,其它正常 (21)7.17.测试场景17:裸光纤全故障,外网LUN在超算起来,内网LUN从汉唐起来 (21)8.审计意见 (22)9.讨论反馈后备注 (22)1.环境配置2.测试目的测试不同场景下,测试主机对EMC虚拟化存储的访问状况,从而测试EMC VPLEX metro的高可用性。

VPLEX双活系统介绍

在两数据中心间灵活部署或迁移数据与应用

Local HA (A-A mode)

+

Remote DA (A mode)

中台湾

Win Servers

IONIX Console

……

SAN

Vplex

Storage Federation

生 产 中 心

DWDM

备 援 中 心

SAN

Vplex

Storage Federation

4

挑战 3:协作

在不同的位置同时使用数据

传统解决方案 使用 VPLEX

在两个位置之间上载和 下载产生很大的时间延迟

允许即时数据访问, 实时支持远程用户

© 版权所有 2011 EMC Corporation。保留所有权利。

5

VPLEX 系列概述 它是什么?

• 硬件和软件虚拟化平台 • 作为基于 SAN 的解决方案实施

EMC VPLEX

分布式. 动态. 智能.

© 版权所有 2011 EMC Corporation。保留所有权利。

1

今天的 IT 挑战

满足日益苛刻的业务要求

• 移动性 • 可用性 • 协作

© 版权所有 2011 EMC Corporation。保留所有权利。

2

难题 1:移动性

在不同的位置之间无缝移动应用程序

23

非常感谢

© 版权所有 2011 EMC Corporation。保留所有权利。

24

Backup Slides

© 版权所有 2011 EMC Corporation。保留所有权利。

25

EMC VPLEX:下一代数据虚拟化解决方案

横向扩展的集群体系 从小规模起步,实现到大规模的横向扩展 高级数据缓存 提高I/O性能 分布式缓存一致性 跨VPLEX引擎实现自动的负载平衡和失效转移 联合信息接入

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

文档来源为:从网络收集整理.word版本可编辑.欢迎下载支持.XXXX市社保EMC VPlex建议方案V1.0易安信电脑系统(中国)有限公司2012年11月目录一、总体架构图.............................................................................................. 错误!未定义书签。

二、项目建设规划.......................................................................................... 错误!未定义书签。

1.本地存储双活.............................................................................................. 错误!未定义书签。

2.存储系统利旧.............................................................................................. 错误!未定义书签。

3.数据迁移...................................................................................................... 错误!未定义书签。

4.本地数据备份与恢复 .................................................................................. 错误!未定义书签。

5.备份数据容灾和恢复 .................................................................................. 错误!未定义书签。

三、未来建设规划.......................................................................................... 错误!未定义书签。

1.“双活数据中心”...................................................................................... 错误!未定义书签。

2.“两地三中心” ............................................................................................ 错误!未定义书签。

四、产品配置清单.......................................................................................... 错误!未定义书签。

五、相关产品介绍.......................................................................................... 错误!未定义书签。

1.EMC VNX系列存储系统产品介绍........................................................... 错误!未定义书签。

2.EMC VNX系列存储系统规格表............................................................... 错误!未定义书签。

3.EMC存储虚拟化VPLEX产品介绍......................................................... 错误!未定义书签。

4.EMC VPLEX解决方案.................................................................................. 错误!未定义书签。

5.EMC D ATA D OMAIN虚拟带库介绍 ............................................................. 错误!未定义书签。

6.N ET W ORKER备份系统介绍........................................................................ 错误!未定义书签。

一、总体架构图目前XXX市社保已经在使用EMC的存储系统VNX5100,为了进一步保障社保应用的高可用性,提高生产的安全级别,XXX市社保计划对目前的存储系统进行虚拟化整合,并搭建双活存储系统,保证关键业务所使用的存储系统即使有一台存储系统出现故障,也不会出现业务停顿,达到更高的生产安全保障。

另外,目前发现备份到磁带中的备份集存在很多问题,导致几乎所有备份集都无法读取,这将严重影响整个备份系统的成功率。

所以,非常有必要对整个备份系统进行重新整合,淘汰目前使用的落后技术,采用更加安全、稳定的备份方式。

经讨论和分析,目前XXX市社保的存储整合与数据备份项目可归纳为以下几点需求:1.更加稳定、安全的存储平台;2.更加安全、稳定运行的备份平台和备份存储,并能通过现有网络进行远程备份和恢复;3.可扩展性更强的备份存储,可满足未来几年内数据量的多份全备份,保留所有备份数据若干年以上;经讨论分析,结合系统目前的现状,我们建议XXX市社保存储整合与数据备份项目的架构设计,如下图所示:如上图所示,在生产中心的SAN网络中配置一套存储虚拟化设备——EMC VPlex,将目前的存储系统接入VPlex,所有应用系统只需要访问VPlex上的卷即可,接入VPlex上的存储可以做到镜像关系(即双活)或级联关系。

建议对重要应用的数据存储在镜像的两台存储系统上。

通过全新的备份软件Networker和备份存储Datadomain对生产数据进行本地及远程备份和恢复。

整个方案的组成部分为:A.省中心机房-光纤交换网络:由两台速度为8Gbps的光纤交换机组成光纤交换网络,为所有系统提供基于光纤协议的访问;两台光纤交换机之间互为冗余,为系统的网络提供最大的可靠性保护。

用户可自行建设冗余SAN网络。

B.中心机房-主存储系统:配置一台EMC VNX 7500存储系统,与当前的EMC VNX5100存储通过虚拟化存储进行本地数据保护,对外提供统一的访问接口;重要应用系统的数据都保存在这两台的存储系统上;➢EMC VNX 7500存储系统可同时提供光纤SAN、IP SAN、NAS等多种存储模式,最大可扩展到1000块磁盘,支持光纤盘、闪存盘、SATA盘、SAS盘、NL-SAS盘等多种磁盘混插,大大增强存储系统的可扩展性;➢VNX 7500支持将闪存盘作为可读写的二级缓存来使用,VNX7500最大可支持2.1TB二级缓存。

同时支持自动的存储分层(FAST),提高存储系统的整体性能;➢VNX 7500还支持LUN的条带化或级联式扩展,以将数据分散到更多的磁盘上;C.中心机房-存储虚拟化:以EMC VPlex Local作为存储虚拟化;应用系统只需要访问虚拟化存储,而不需要直接管理后端的具体的存储系统;通过存储虚拟化,可以达到两台存储之间双活,可以支持异构的存储系统,对数据进行跨存储的本地及远程保护,统一管理接口和访问接口;D.中心机房-利旧存储:除了用来做“存储双活”的现有存储系统EMC VNX5100外,如果还有其他的SAN存储系统,EMC建议,通过VPlex虚拟化功能,将这些旧存储系统挂接到VPlex虚拟化存储中,加以利用;这些存储资源将作为存储资源池共享,按需使用;(注:挂接到vPlex后端的其他存储品牌需要在vPlex的兼容列表内。

)E.中心机房-备份存储(虚拟带库):在中心机房,由一台Data Domain DD620作为备份存储,存储所有应用的备份数据;EMC Data Domain是一台磁盘备份存储,可以模拟成磁带,提供非常高效的重复数据消除功能,可以与现有的大部分备份软件配合使用,例如Networker、Symantec等;F.中心机房-备份软件:采用EMC Networker备份软件,为所有系统提供备份功能,包括全备、增量备份、差量备份等;Networker提供了LAN Free备份功能,可将备份数据从存储系统中通过SAN网络直接写入虚拟带库中,减少备份时间和网络压力;G.备份机房-备份存储:为保证备份数据的安全性,建议在远程搭建一套备份机房,保存一份备份数据在远端备份存储中(上图中,逻辑示意①所示),中心机房与远程备份机房之间通过政务网传输数据;为了降低备份存储的管理复杂度、提高远程备份的速度,建议在远端配置一台Data Domain DD620,作为系统的远程备份存储;两台DD 620之间复制经过消重后的备份数据,可以降低数据复制对网络的压力;H.远程备份机房-备份软件:为了防止当省数据中心的备份服务器出现问题后,无法将数据恢复出来,可以在远程备份机房准备一套备份服务器,但这台备份服务器平时处于关机状态,仅在需要时及在远程机房进行恢复演练时启用;二、项目建设规划通过EMC VPlex对存储进行虚拟化,逻辑示意图如下图所示:虚拟存储VPLEXLocal内部网数据库服务器应用系统服务器光纤交换网络光纤交换网络虚拟卷存储系统 A生产卷1生产卷1生产卷2生产卷2生产卷3扩展卷3存储系统 B存储系统 D存储系统 C1.本地存储双活应用系统通过虚拟化存储VPlex访问后端的存储系统,VPlex在提供虚拟化的存储访问的同时,还可以对数据进行本地保护。

如下图所示,VPlex通过镜像虚拟卷提供给应用系统访问,而在后端,VPlex镜像虚拟卷将数据写入两台独立的存储系统中,来达到数据本地保护的目的。

VPlex提供的本地数据高可用性保护,可以保证在存储系统、VPlex系统自身出现故障时,应用还可以正常使用,且不会导致数据丢失。

➢当存储系统A/B其中一台出现故障时,由于通过VPlex的镜像功能,存储系统A/B 之间是RAID 1关系,应用系统可以正常运行,不需要停机;➢当VPlex系统自身出现故障时,由于在Vplex中的设置,VPlex不会修改存储系统LUN 的配置信息,即,用户可以将存储系统A或B的LUN直接挂到应用系统,保证应用系统的继续运行,不会产生数据丢失。