数据挖掘平台介绍

史上最全的数据来源和数据分析平台

史上最全的数据来源和数据分析平台简介:数据来源和数据分析是现代社会中重要的工具和技术,可以匡助企业和个人更好地理解和利用数据,从而做出更明智的决策。

本文将介绍一款名为“DataMaster”的数据来源和数据分析平台,该平台提供了丰富的数据来源和强大的数据分析功能,为用户提供全面、准确和实时的数据支持。

一、数据来源1. 数据库连接DataMaster平台支持与各种常见数据库的连接,包括MySQL、Oracle、SQL Server等。

用户可以通过简单的配置和认证步骤,轻松地将自己的数据库与平台连接起来,实现数据的实时同步和共享。

2. API接口DataMaster平台提供了丰富的API接口,用户可以通过API接口将外部数据源与平台进行集成。

无论是社交媒体数据、电子商务数据还是传感器数据,用户都可以通过API接口将这些数据源导入到平台中进行分析和挖掘。

3. 数据爬取DataMaster平台内置了强大的网络爬虫功能,可以自动从互联网上抓取各种类型的数据。

用户只需指定要爬取的网页链接和相关规则,平台就能自动采集数据并存储到数据库中,方便后续的分析和使用。

二、数据分析1. 数据清洗DataMaster平台提供了一系列数据清洗工具,可以匡助用户对数据进行清洗和预处理。

用户可以通过简单的拖拽操作,去除重复数据、填补缺失值、处理异常值等,确保数据的质量和准确性。

2. 数据可视化DataMaster平台内置了丰富的数据可视化工具,用户可以通过简单的操作和配置,将数据转化为直观、易懂的图表和图形。

无论是柱状图、折线图还是饼图,用户都可以根据自己的需求和喜好进行定制和展示。

3. 数据挖掘DataMaster平台支持多种数据挖掘算法和技术,包括聚类分析、关联规则挖掘、预测建模等。

用户可以根据自己的需求和目标,选择合适的算法和技术,对数据进行挖掘和分析,发现其中的规律和趋势。

4. 数据报告DataMaster平台提供了丰富的数据报告功能,用户可以通过简单的操作和配置,生成各种形式的数据报告。

MSMiner课程项目介绍

课程项目提供资源

资源清单 常见问题

A:我们已经提供了算法DLL接口规范文档,接口函数只 有四个,其中只有两个要自己实现,其余两个可直接使 用示例代码。开发人员要做的就是将算法功能实现和封 装,使得可以通过两个接口函数MSMiner之MSDM就能 所用该算法的功能。

MSMiner数据仓库管理子系统 数据仓库管理子系统MSMetaData 数据仓库管理子系统

MSMiner简介

背景介绍 体系架构 界面展示

课程项目内容要求

题目要求 提交要求 预备知识

课程项目提供资源

资源清单 常见问题

Copyright © 2006 中国科学院计算技术研究所

多策略数据挖掘平台MSMiner

Copyright © 2006 中国科学院计算技术研究所

多策略数据挖掘平台MSMiner

与元数据管理模块交互用到时了COM技术,为了降 低开发负担,我们提供了CPublicFunc公共函数类, 该类提供了一些成员函数,封装调用了元数据管理 模块MetaServer的很多功能。开发人员可生成实例 MSMiner简介 3)Q:我注意到接口规范中提供算法DLL的公用函数类 对象,直接调用其成员函数与元数据管理组件服务 在每个算法的具体 CPublicFunc,它有什么用? 程序交互,避免去了解COM技术。 实现中,不可避免的 背景介绍 要实现数据的输入输 体系架构 出及相关参数的存储。 MSMiner数据挖掘子系统MSDM 而在整个MSMiner 元 界面展示 平台中,数据的输入 课程项目内容要求 输出等由元数据管理 数 模块统一管理。 题目要求 DLL算法程序1 因此,DLL程序要 据 与元数据管理模块打 提交要求 交道。 管 DLL算法程序2

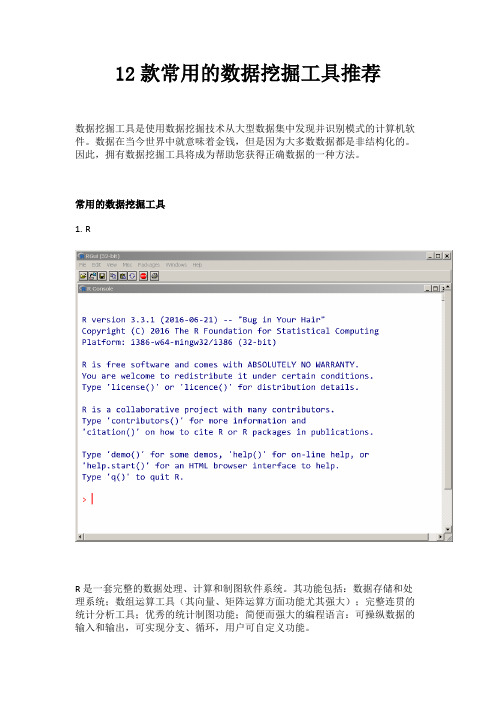

款常用的数据挖掘工具推荐

12款常用的数据挖掘工具推荐数据挖掘工具是使用数据挖掘技术从大型数据集中发现并识别模式的计算机软件。

数据在当今世界中就意味着金钱,但是因为大多数数据都是非结构化的。

因此,拥有数据挖掘工具将成为帮助您获得正确数据的一种方法。

常用的数据挖掘工具1.RR是一套完整的数据处理、计算和制图软件系统。

其功能包括:数据存储和处理系统;数组运算工具(其向量、矩阵运算方面功能尤其强大);完整连贯的统计分析工具;优秀的统计制图功能;简便而强大的编程语言:可操纵数据的输入和输出,可实现分支、循环,用户可自定义功能。

2.Oracle数据挖掘(ODM)Oracle Data Mining是Oracle的一个数据挖掘软件。

Oracle数据挖掘是在Oracle 数据库内核中实现的,挖掘模型是第一类数据库对象。

Oracle数据挖掘流程使用Oracle 数据库的内置功能来最大限度地提高可伸缩性并有效利用系统资源。

3.TableauTableau提供了一系列专注于商业智能的交互式数据可视化产品。

Tableau允许通过将数据转化为视觉上吸引人的交互式可视化(称为仪表板)来实现数据的洞察与分析。

这个过程只需要几秒或几分钟,并且通过使用易于使用的拖放界面来实现。

5. ScrapyScrapy,Python开发的一个快速、高层次的屏幕抓取和web抓取框架,用于抓取web站点并从页面中提取结构化的数据。

Scrapy用途广泛,可以用于数据挖掘、监测和自动化测试。

6、WekaWeka作为一个公开的数据挖掘工作平台,集合了大量能承担数据挖掘任务的机器学习算法,包括对数据进行预处理,分类,回归、聚类、关联规则以及在新的交互式界面上的可视化。

Weka高级用户可以通过Java编程和命令行来调用其分析组件。

同时,Weka也为普通用户提供了图形化界面,称为Weka KnowledgeFlow Environment和Weka Explorer。

和R相比,Weka在统计分析方面较弱,但在机器学习方面要强得多。

顶尖数据挖掘平台安装手册

顶尖数据挖掘平台(TipDM),在线网址:

第3页

顶尖数据挖掘平台(TipDM)

文档编号: TipDM_008

1. 引言

1.1. 产品简介

顶尖数据挖掘平台(TipDM)是广州太普软件自主研发的一个数据挖掘工具,基于云计算和 SOA 架构,使用 JAVA 语言开发,能从各种数据源获取数据,建立各种不同的数据挖掘模型(目前已集成 数十种预测算法和分析技术,基本覆盖了国外主流挖掘系统支持的算法,用户也可以嵌入其它自己 开发的任何算法),使用 TipDM 算法功能进行数据挖掘工作。平台支持数据挖掘流程所需的主要过程, 完成包括对数据进行预处理,包括空值处理、降维处理、离散处理,因子分析、主成分分析、抽样、 过滤等,创建、训练、评估模型,预测,修改模型参数,误差分析等一系列功能。

1.3. 在线试用...................................................................................................................4

2.

系统安装 ....................................................................................................................... 4

2. 系统安装

找 文 然后双击 文 :界面 到安装 件 TipDM.exe,

TipDM.exe 件,安装系统

如下:

顶尖数据挖掘平台(TipDM),在线网址:

第4页

顶尖数据挖掘平台(TipDM)

文档编号: TipDM_008

选择中文简体,点击“OK“按钮。按照安装向导进入下一步:

数据挖掘平台介绍

应用场景-异常分析

信用风险往往和损失联系在一 起,或者说,信用风险可以导 致损失。第一,对亍信用活劢 的一个事件来说,既存在损失 的可能性,也存在盈利的可能 性。第二,信用风险指的是一 种可能性,是一种结果未知的 未来事件。因此通过风险评估 可以减少银行的损失。

应用场景-异常分析

从电信运营系统中所积累的数据, 发掘出有价值的商业规则,建立 客户细分、流失预警、新业务响 应等模型,幵迚而设计出符合用 户需求、拉劢业务量增长的业务 经营目标和盈利点。 预测移劢用户状态是否异常,及 时调整策略,为相关部门对这部 分客户迚行重点关注、发送 Email 等,挽留这部分客户。

一般10到15种左史

打开产品对比验证

产品底层架构

挖掘算法 可视化能力

丰富,约有20种 有在线可视化报告。

挖掘产品和统计算法一般只有一种。挖掘算 法一般包括常见的。

有一些可视化

对比双斱算法 运行产品

结果导出BI平台 有ETHINK BI可以写作

一般挖掘公司没有BI产品,所以很难

看产品全貌就知道

操作简易性 促迚人员成长

决策树,贝右斯,KNN,支持向量机,梯升树

线性回归,逡辑回归,svm,保序回归 Kmeans,高斯混合模型,功率迭代聚类

自组织数据挖掘,随机森林,随机 神经网络,卷积神经网络,深

决策树,一次迭代LR

信度网络,限制波尔兹曼机

自组织数据挖掘,随机森林,随机 KNN,CNN,BSN,SAE,

决策树,一次迭代LR

WEB,拖拽使用,普通用户可 以掌握

有50个已有的挖掘不统计分析 实战案例帮劣成长

CS为主。

打开产品验证 看DEMO不帮劣支撑

优势优势

1)低门槛,易操作 通过拖拉拽的斱式来建模,直接将算法集成为一个简单的界面组件,通过搭积木的斱式实现流程。大 大降低了数据挖掘的操作门槛。

史上最全的数据来源和数据分析平台

史上最全的数据来源和数据分析平台数据来源和数据分析平台是指一种能够提供各种数据来源和数据分析功能的在线平台。

它可以匡助用户采集、整理和分析各种类型的数据,从而提供有价值的信息和见解。

以下是关于史上最全的数据来源和数据分析平台的详细介绍。

一、数据来源1. 公共数据源:史上最全的数据来源和数据分析平台应该提供各种公共数据源,包括政府部门发布的数据、统计局发布的数据、科研机构发布的数据等。

这些数据源可以包括经济数据、人口数据、环境数据等,用户可以根据自己的需求选择并获取相关数据。

2. 商业数据源:除了公共数据源,史上最全的数据来源和数据分析平台还应该提供商业数据源。

商业数据源可以包括市场调研公司、金融机构、电商平台等发布的数据。

例如,用户可以获取某个产品的销售数据、用户行为数据等,从而更好地了解市场情况和用户需求。

3. 社交媒体数据:在当前社交媒体盛行的时代,史上最全的数据来源和数据分析平台还应该提供社交媒体数据。

这些数据可以包括用户在社交媒体平台上的发帖、评论、点赞等行为数据,用户可以通过分析这些数据了解用户的兴趣、偏好和行为习惯。

4. 传感器数据:随着物联网的发展,各种传感器设备产生的数据也成为了重要的数据来源。

史上最全的数据来源和数据分析平台应该能够接收和处理各种传感器数据,例如温度传感器、湿度传感器、GPS传感器等。

用户可以通过分析这些数据来了解环境状况、设备状态等信息。

二、数据分析功能1. 数据清洗和整理:史上最全的数据来源和数据分析平台应该提供强大的数据清洗和整理功能。

这些功能可以匡助用户处理原始数据,包括去除重复数据、填补缺失数据、转换数据格式等。

通过数据清洗和整理,用户可以得到更加准确和可靠的数据集。

2. 数据可视化:数据可视化是数据分析的重要环节之一。

史上最全的数据来源和数据分析平台应该提供丰富的数据可视化功能,包括折线图、柱状图、散点图、地图等。

用户可以通过数据可视化将复杂的数据转化为直观的图表,从而更好地理解数据和发现数据中的规律。

史上最全的数据来源和数据分析平台

史上最全的数据来源和数据分析平台概述:数据分析在当今信息时代具有重要的作用,而数据来源和数据分析平台的选择对于数据分析的质量和效果有着直接的影响。

本文将介绍一款史上最全的数据来源和数据分析平台,该平台提供丰富的数据来源和强大的数据分析功能,可以满足各种数据分析需求。

一、数据来源:1. 公共数据集:该平台整合了来自各个领域的公共数据集,包括但不限于经济、教育、环境、医疗等各个领域的数据。

这些公共数据集可通过简单的搜索和筛选进行访问,用户可以根据自己的需求选择合适的数据集进行分析。

2. 第三方数据源:除了公共数据集,该平台还与多个第三方数据提供商合作,提供了更广泛的数据来源。

这些第三方数据源包括市场调研公司、社交媒体平台、金融机构等,用户可以根据自己的需求选择合适的第三方数据源进行数据分析。

3. 用户上传数据:该平台允许用户上传自己的数据,保证用户数据的隐私和安全。

用户可以将自己的数据导入平台,进行数据清洗、转换和分析,从而得到更准确和实用的分析结果。

二、数据分析功能:1. 数据可视化:该平台提供强大的数据可视化功能,支持多种图表类型,如折线图、柱状图、饼图等。

用户可以根据自己的需求选择合适的图表类型,将数据转化为直观、易懂的图表,匡助用户更好地理解和分析数据。

2. 数据清洗和处理:该平台提供了丰富的数据清洗和处理功能,包括数据去重、缺失值处理、异常值检测等。

用户可以通过简单的操作对数据进行清洗和处理,提高数据的质量和准确性。

3. 数据挖掘和机器学习:该平台集成为了数据挖掘和机器学习算法,用户可以通过简单的拖拽和配置实现复杂的数据挖掘和机器学习任务。

平台提供了多种算法模型和评估指标,匡助用户进行数据挖掘和机器学习的实验和分析。

4. 数据报告和分享:该平台支持生成数据报告和分享功能,用户可以根据自己的需求生成数据报告,并将报告以多种格式导出,如PDF、Excel等。

用户还可以将报告分享给团队成员或者其他用户,方便交流和合作。

dataworks 案例

dataworks 案例

DataWorks案例介绍:数据工场(DataWorks)是阿里云提供的一种大数据服务平台,能够支持大数据的管理、计算、处理、分析和挖掘等多种操作。

以下是DataWorks的几个典型案例:

1. 天猫双11大数据分析:通过DataWorks进行数据的采集、清洗、存储和分析,帮助天猫实时掌握双11的销售情况和用户行为,为后续的营销活动提供数据支持。

2. 滴滴出行实时数据处理:通过DataWorks实现车辆位置、订单状态、司机评价等数据的实时采集、处理和展示,为滴滴出行提供实时监控和管理服务。

3. 爱奇艺数据挖掘:通过DataWorks对用户行为、流量情况、内容评价等数据进行深度挖掘和分析,为爱奇艺的自主内容生产和用户画像提供数据支持。

4. 阿里云大数据处理:阿里云基于DataWorks提供了一系列的大数据处理服务,包括数据集成、数据计算、数据存储和数据安全等,为企业提供一站式的大数据解决方案。

- 1 -。

数据挖掘软件CLEMENTINE介绍

Clementine是ISL(Integral Solutions Limited)公司开发的数据挖掘工具平台。1999年SPSS公司收购了ISL公司, 对Clementine产品进行重新整合和开发,现在Clementine 已经成为SPSS公司的又一亮点。 作为一个数据挖掘平台, Clementine结合商业技术可以快速建立预测性模型,进而应用到商业活动中,帮助人们改进决策过程。 强大的数据挖掘功能和显著的投资回报率使得Clementine在业界久负盛誉。 同那些仅仅着重于模型的外在表现而忽略了数据挖掘在整个业务流程中的应用价值的其它数据挖掘工具相比,Clementine其功能强大的数据挖掘算法,使数据挖掘贯穿业务流程的始终,在缩短投资回报周期的同时极大提高了投资回报率。

相关技术 神经网络 决策树 (C5.0 C&RT) Logistic 回归 等等

相关技术 K-Means 两步骤 Kohonen 等等

相关技术 分类跟估计的所有方法

相关技术 Apriori GRI 等等

相关技术 决策树规则 各类图表 等等

分类 目标变量(因变量、反应变量数)为类別的狀況 信用卡公司將既有资料分为「伪卡」「非伪卡」找出伪卡的模式

Statistics节点----研究连 续型字段间线性相关关系

得到Na_to_K的统计属性,及它 与Age的线性关系

2规则归纳模型 规则归纳模型 c5.0

3 crt决策树

4 kohonen聚类

5 k--means聚类

6 two step 聚类

Clementine中的Data Mining 的方法

Classification Clustering Estimation Prediction Market Basket Analysis Description

实践中的第四范式平台使用方法总结

实践中的第四范式平台使用方法总结近年来,随着大数据技术的快速发展,第四范式平台作为一种高效的数据处理工具,被广泛应用于各个领域。

本文将总结实践中的第四范式平台的使用方法,帮助读者更好地利用这一工具进行数据处理和分析。

一、平台介绍第四范式平台是一种基于云计算和人工智能的大数据处理平台,具有强大的数据处理和分析能力。

它能够快速处理海量的数据,并提供多种数据分析和挖掘功能,帮助用户从数据中发现有价值的信息。

二、数据导入在使用第四范式平台之前,首先需要将待处理的数据导入平台。

平台支持多种数据源的导入,包括数据库、文件、API等。

用户可以根据自己的需求选择合适的数据源,并按照平台提供的导入指南进行操作。

三、数据清洗数据清洗是数据处理的重要一步,它能够去除数据中的噪声和异常值,提高数据的质量。

第四范式平台提供了丰富的数据清洗功能,包括数据去重、缺失值处理、异常值检测等。

用户可以根据自己的需求选择相应的清洗方法,并进行参数设置。

四、数据分析数据分析是第四范式平台的核心功能之一。

平台提供了多种数据分析方法,包括统计分析、机器学习、深度学习等。

用户可以根据自己的需求选择合适的分析方法,并进行参数设置。

平台还提供了可视化工具,帮助用户更直观地展示分析结果。

五、模型训练第四范式平台支持用户自定义模型的训练。

用户可以根据自己的需求,选择合适的算法和模型架构,并利用平台提供的工具进行训练。

平台还提供了模型评估和调优的功能,帮助用户提高模型的准确性和泛化能力。

六、数据挖掘数据挖掘是第四范式平台的另一个重要功能。

平台提供了多种数据挖掘方法,包括关联规则挖掘、聚类分析、分类预测等。

用户可以根据自己的需求选择合适的挖掘方法,并进行参数设置。

平台还提供了数据可视化的功能,帮助用户更直观地理解挖掘结果。

七、结果导出在完成数据处理和分析后,用户可以将结果导出到指定的目标。

第四范式平台支持多种导出格式,包括Excel、CSV、数据库等。

《数据挖掘》课件

。

Python的易读性和灵活性使得 它成为一种强大的工具,可以 快速地开发原型和实现复杂的 算法。

Python在数据挖掘中主要用于 数据清洗、特征工程、机器学 习模型训练和评估等任务。

R在数据挖掘中的应用

01

等。

02

数据挖掘技术

聚类分析

聚类分析的定义

聚类分析是一种无监督学习方法 ,用于将数据集中的对象分组, 使得同一组(即聚类)内的对象 尽可能相似,而不同组的对象尽

可能不同。

常见的聚类算法

包括K-means、层次聚类、 DBSCAN等。

聚类分析的应用

在市场细分、模式识别、数据挖 掘、统计学等领域有广泛应用。

04

Spark提供了Spark SQL、Spark MLlib和Spark GraphX等组件,可以进行结构化和非结构化数据的 处理、机器学习、图计算等任务。

Tableau在数据可视化中的应用

01 02 03 04

Tableau是一款可视化数据分析工具,能够帮助用户快速创建各种图 表和仪表板。

Tableau提供了直观的界面和强大的功能,支持多种数据源连接和数 据处理方式。

03

到了广泛应用。

数据挖掘的应用场景

商业智能

通过数据挖掘技术,企业可以 对市场趋势、客户行为等进行 深入分析,从而制定更好的商

业策略。

金融

金融机构可以利用数据挖掘技 术进行风险评估、客户细分和 欺诈检测等。

医疗

数据挖掘在医疗领域的应用包 括疾病诊断、药物研发和患者 管理等。

科学研究

数据挖掘在科研领域的应用包 括基因组学、天文学和气候学

BI平台介绍

响应能力

• 监视事件和计量标准 • 将最近事件和历史数据相关联

计划

• 预测和趋势分析 • 实施之前预估策略中的潜在变化

国内业界的观点(1)

“经过几年ERP系统的运行,企业拥有了大量的经营 及客户数据,为了进一步获得市场的竞争优势,BI必须把 这些尘封在各个数据库中的各种结构的数据充分利用起来, 提高企业运营绩效,获得更大市场。”

为了数据挖掘你也不必非得建立一个数据仓库,数据仓库 不是必须的

DM(数据挖掘) vs OLAP

DM(Data Mining)和OLAP是完全不同的 OLAP分析过程的本质是一个演绎推理的过程 OLAP分析先建立一系列的假设,然后通过OLAP来证实或 推翻这些假设来最终得到自己的结论 DM本质上是一个归纳的过程 不是用于验证某个假定的模型的正确性,而是在数据库中自 己寻找模型 数据挖掘和OLAP具有一定的互补性 网易BI目前的应用仅仅局限于OLAP

预测未来结果

通过对基本数据不断理解的交互处理而不断提炼和调 整,达到可以接受的精确程度 ,从而获得有价值的建议

数据挖掘 VS 数据仓库

数据挖掘(Data Mining)与数据仓库(Data Warehouse) 没有直接的联系 在大部分情况下,数据挖掘都要把数据从数据仓库中拿到 数据挖掘库或数据集市中

数据

信息

知识

利润

BI价值陈述

责任

• 用于经理、主管的精确及时的 报告

分析

• 从收入、可赢利性、满意度的角度 来讲,哪些是您最好的客户? • 哪些客户会对促销作出响应?

• 公司数以万计的以及其他的公 开内容

销售 开发 生产 财务 / HR 市场营销 采购 服务 项目管理

PDMiner:基于云计算的并行分布式数据挖掘工具平台

中国科学:信息科学2014年第44卷第7期:871–885 PDMiner:基于云计算的并行分布式数据挖掘工具平台何清x *,庄福振x *,曾立xy ,赵卫中xy ,谭庆xyx 中国科学院智能信息处理重点实验室,中国科学院计算技术研究所,北京100190y 中国科学院大学,北京100049*通信作者.E-mail:heq@,zhuangfz@收稿日期:2013–08–30;接受日期:2013–11–14国家自然科学基金(批准号:61175052,61203297,61035003)和国家高技术研究发展计划(863)(批准号:2014AA012205,2013A-A01A606,2012AA011003)资助项目摘要随着信息技术和互联网的发展,各种信息呈现爆炸性增长,且包含丰富的知识.从海量数据信息中挖掘得到有用的知识仍然是一个挑战性的课题.近几十年来,数据挖掘技术,作为从海量数据信息中挖掘有用信息的关键技术已经引起了广泛的兴趣和研究.但是由于数据规模的增长,以往的很多研究工作并不能有效地处理大规模数据,因此,开发设计或者扩展已有算法使之能处理大规模数据集,已经成为数据挖掘中非常重要的研究课题.近年来,基于云计算的数据挖掘技术研究已经成为一个热点话题,本文中我们研究开发一个基于大规模数据处理平台Hadoop 的并行分布式数据挖掘工具平台PDMiner.在PDMiner 中,开发实现了各种并行数据挖掘算法,比如数据预处理、关联规则分析以及分类、聚类等算法.实验结果表明,并行分布式数据挖掘工具平台PDMiner 中实现的并行算法:1)能够处理大规模数据集,达到TB 级别;2)具有很好的加速比性能;3)大大整合利用已有的计算资源,因为这些算法可以在由这些商用机器构建的并行平台上稳定运行,提高了计算资源的利用效率;4)可以有效地应用到实际海量数据挖掘中.此外,在PDMiner 中还开发了工作流子系统,提供友好统一的接口界面方便用户定义数据挖掘任务.更重要的是,我们开放了灵活的接口方便用户开发集成新的并行数据挖掘算法.关键词云计算并行算法分布式数据挖掘大数据1引言随着社会发展的信息化和网络化,每天都有大量的数据涌现,这些数据包含了大量丰富的有用信息,涵盖政治、经济、娱乐等生活中的各个方面.据统计,互联网上在线发布的网页高达数十亿数量级,并以每天百万网页的速度增长.因此,信息的获取相当重要,一定程度上,信息的拥有量已经成为决定和制约社会发展的重要因素.数据挖掘作为信息获取的一门重要技术,已经得到了广泛的研究.数据挖掘[1],就是从大量的数据中挖掘出有用的信息,提供给决策者做决策支持,有着广阔的应用前景.由于要挖掘的信息源中的数据都是海量的,而且以指数级增长,传统的集中式串行数据挖掘方法不再是一种适当的信息获取方何清等:PDMiner:基于云计算的并行分布式数据挖掘工具平台式.因此扩展数据挖掘算法处理大规模数据的能力,并提高运行速度和执行效率,已经成了一个不可忽视的问题.为了解决海量数据的挖掘问题,一种简单的方式就是把所有的数据划分成若干份,也就是切分成若干个子任务,然后分布到各个计算资源上去进行计算,每个节点完成一个子任务,最后进行集成.分布式计算就是把一个计算问题分解成多个子问题并同时处理的计算模型1).基于分布式计算模型,Luo 等[2,3]集成了很多数据挖掘算法到多主体系统.Zhuang等[4]提出基于多主体技术的算法评价系统来方便高效地选择合适的算法进行挖掘.该系统可以同时对几种分类算法在分布式环境下进行同时比较,从而得到最佳算法,减少人工干预.另外一种提高计算效率的方式是并行计算,并行计算也是把一个大的计算问题分割成小任务的形式.近年来,并行计算的体系结构和模型也引起了广泛的兴趣和研究[5,6].尽管分布式计算和并行计算有很相似的特点,但是它们之间也各有侧重,分布式计算强调在所有异构计算资源上同时求解问题,而并行计算则更加强调同一台计算资源内部多线程并行.这两种计算方式也可以对应到算法之间的并行以及算法内部并行这两种计算模式.文献[2∼4]提出基于主体技术的算法之间并行的计算模式,它们利用主体技术中主体本身的自主性,智能性等特点,实现不同算法主体之间的并行计算,以消息传递的方式实现同步,大大提高了算法的执行效率,减少了运行时间.第二种计算模式,是粒度比较小的并行方式,主要研究的是算法内部的并行.通过把算法分解,尽可能地找出算法中可并行的部分进行并行计算.这种计算模型的最终效率取决于算法本身的可并行程度,如果并行程度非常高,那么就可以大大提高算法的运行效率.由于在很多应用中,只需要执行一种应用(算法),所以研究算法内部的并行实现是非常重要的.文献[7]实现了多种机器学习算法在多核计算机上的并行,本文主要是针对第二种并行计算模式进行研究,而且可以在大规模计算机集群上运行.本文研究的基于Hadoop平台开发的并行数据挖掘工具平台,实际上包含了以上两种并行的计算模式,而且能够处理大规模的数据.近年来,云计算2)得到了学术界和业界的广泛关注,它是一种基于互联网的、大众参与的计算模式,其计算资源,包括计算能力、存储能力、交互能力,是动态、可伸缩、且被虚拟化的,以服务的方式提供给用户.基于大规模数据处理平台Hadoop,我们研究开发了并行分布式数据挖掘工具平台PDMiner,其目的是设计实现并行数据挖掘算法处理大数据集,且提高执行效率.在PDMiner中包含4个子系统,工作流子系统、用户接口子系统、数据预处理子系统和数据挖掘子系统.整个数据挖掘工具平台提供了一个从海量数据中挖掘有用知识的完整解决方案,而且提供了可扩展的灵活接口.本文安排如下:第2节简述了云计算平台Hadoop以及并行编程模式MapReduce;第3节详细描述了并行分布式数据挖掘工具平台PDMiner,而第4节给出了PDMiner的可扩展性等特点;第5节给出和分析了本文开发的并行算法的实验结果;第6节是本文的结束语.2大规模数据处理平台HadoopHadoop3)是一个软件计算平台,可以让程序员很容易地开发和运行处理海量数据的应用程序.其核心部分主要包括—HDFS(hadoop distributedfile system)[8]和基于MapReduce[9]机制的并行算法实现.1)/wiki/Distributed computing.2)/wiki/%E4%BA%91%E8%AE%A1%E7%AE%97./.3)/core/.872中国科学:信息科学第44卷第7期图1HDFS体系结构Figure1The architecture of HDFS2.1HDFSHadoop分布式文件系统HDFS[8]是受Google文件系统启发,建立在大型集群上可靠存储大数据集的文件系统.它和现有的分布式文件系统有着很多的相似性,然而和其他的分布式文件系统的区别也是很明显的.HDFS具有高容错性,可以部署在低成本的硬件之上.此外,HDFS提供高吞吐量地对应用程序数据访问,适合大数据集的应用程序.HDFS结构如图1所示[10],包含一个名字节点作为控制主节点,其他的服务器作为数据节点,存储数据.具体地说,HDFS具有如下几大特点:•强容错性:由于HDFS通常部署在低成本的硬件上,因此硬件的故障是常见的.HDFS通过在名字节点(Name node)和数据节点(Data node)之间维持心跳检测、检测文件block的完整性、保持集群负载均衡等手段使得系统具有高容错性,集群里面的个别机器故障将不会影响到数据的使用.•流式数据访问与大数据集:运行在HDFS之上的应用程序必须流式地访问它们的数据集.HDFS 适合批量处理数据,典型的HDFS文件是GB到TB的大小,典型的块大小是64MB.•硬件和操作系统的异构性:由于构建在Java平台上,HDFS的跨平台能力毋庸置疑,得益于Java平台已经封装好的文件IO系统,HDFS可以在不同的操作系统和计算机上实现同样的客户端和服务端程序.873何清等:PDMiner:基于云计算的并行分布式数据挖掘工具平台2.2MapReduceMapReduce[9]是Google实验室提出的一种简化的分布式程序设计模型,用于处理和生成大量数据集.通过该模型,程序自动分布到一个由普通机器组成的超大机群上并发执行.Map和Reduce是该模型中的两大基本操作.其中,Map是把一组数据一对一的映射为另外的一组数据,Reduce是对数据进行规约,映射规则与规约规则可由用户通过函数来分别指定.现实生活中很多任务的实现都是可以基于这样的映射规约模式.实现MapReduce操作的整个流程如下:(1)当用户程序调用MapReduce函数时,输入文件将被分隔成M块(每块大小通常为16M至64M,可由用户通过参数控制),同时用户程序将被复制许多份存储于机群中.(2)机群中的某个节点将被视为主节点.主节点选择空闲节点,并指派给每个节点一个Map任务或一个Reduce任务.最终将有M个Map任务和R个Reduce任务被指派完成.(3)被指派到Map任务的节点将读入所对应的输入文件块,输入的⟨key,value⟩对将通过用户自定义的Map函数得到一组同样用⟨key,value⟩对表示的中间结果集合.(4)中间结果对将会周期性的写入本地硬盘并通过分隔函数分隔成R个块.同时,存储中间结果的本地硬盘位置将会返回给主节点,以便其下一步指派Reduce任务.(5)被指派到Reduce任务的节点将远程读入中间结果.待中间结果数据全部被读入后,将会按照key来排序,使得具有同样key的中间结果聚集在一起.(6)含有相同key的⟨key,value⟩对通过用户自定义的Reduce函数进行归约,得到最终结果并写出输出文件.MapReduce通过把对数据集的大规模操作分发给网络上的每个节点来实现可靠性,每个节点会周期性的把完成的工作和状态信息返回给主节点.如果一个节点保持沉默超过一个预设的时间间隔,主节点就认为该节点失效了,并把分配给这个节点的数据发到别的节点,并且因此可以被其他节点所调度执行.由于MapReduce运行系统已考虑到了输入数据划分、节点失效处理、节点之间所需通信等各个细节,使得程序员可以不需要有什么并发处理或者分布式系统的经验,就可以处理超大规模的分布式系统资源.3并行分布式数据挖掘工具平台PDMiner的体系结构如第2节所介绍,Hadoop提供了让程序员易于开发和运行处理海量数据应用程序的平台,其分布式文件系统HDFS是建立在大型集群上可靠存储大数据集的文件系统,具有可靠性,强容错性等特点;而MapReduce提供了一种高效编写并行程序的编程模式.基于此,我们开发了并行数据挖掘工具平台PDMiner,大规模数据存储在HDFS上,且通过MapReduce实现各种并行数据预处理和数据挖掘算法.PDMiner是一个集成各种并行算法的数据挖掘工具平台,其中的并行计算模式不仅包括算法之间的并行,而且包括算法内部的并行.我们的系统平台基于Java语言、Weka系统[11]和Linux操作系统.图2给出了并行数据挖掘工具平台PDMiner的总体系统架构,其中主要包括4个子系统,工作流子系统、用户接口子系统、并行ETL子系统以及并行数据挖掘子系统.工作流子系统提供了友好的界面方便用户定义各种数据挖掘任务;用户接口可以对算法的参数进行设置以及通过结果展示模块分析874中国科学:信息科学第44卷第7期图2并行数据挖掘工具平台PDMiner体系结构Figure2The architecture of PDMiner挖掘结果并做出相应的决策;并行ETL算法子系统和并行数据挖掘算法子系统是PDMiner的核心部分,它们可以直接对存储在HDFS系统上的数据进行处理,ETL算法处理后的结果也可以作为数据挖掘算法的输入.3.1工作流子系统工作流子系统提供了友好和统一的用户接口UI,使得用户可以方便地建立数据挖掘任务.PDMiner 工作流主要包括7个选项卡:“DataSource”,“PD-Filters”,“PD-Associations”,“PD-Classifiers”,“PD-Clusters”,“Evaluation”和“Visualization”.用户可以从选项卡“DataSource”导入头文件到内存,而不是导入全部的数据,这样就解决了内存不足无法存储所有数据的问题.头文件中描述了待处理数据集的详细信息,包括数据的名字、数据集的记录条数以及属性描述等.选项卡“Evaluation”和“Visual-ization”是对算法结果的评价和可视化展示;“PD-Filters”是数据预处理模块,对应于ETL算法子系统;选项卡“PD-Associations”,“PD-Classifiers”,“PD-Clusters”下面是PDMiner平台中开发的并行数据挖掘算法,对应于并行数据挖掘算法子系统.工作流子系统通过图形化UI界面为用户提供服务,支持用户通过鼠标点击图元、拖拽连接线、编辑框输入自配置参数值等方式,灵活建立符合业务应用工作流程的自定制挖掘任务.通过工作流界面,我们可以建立多个工作流任务,不仅每个挖掘任务内部并行,而且不同数据挖掘任务之间也并行.3.2用户接口子系统用户接口子系统由2个模块组成:用户输入模块、结果展示模块.用户接口子系统负责与用户交互,读写参数设置,接受用户操作请求,根据接口实现结果展示.这些参数包括训练数据、测试数据、输出结果以及模型文件在HDFS上的存储路径,而且还包括Map和Reduce任务个数的设置.结果展示部分,实现了对结果的可视化理解,比如生成直方图、饼图等.875何清等:PDMiner:基于云计算的并行分布式数据挖掘工具平台图3并行属性删除任务Figure3The task of parallel attribute detection3.3并行ETL算法子系统数据预处理算法在数据挖掘中起着非常重要的作用,其输出通常是数据挖掘算法的输入.由于数据量的剧增,串行数据预处理过程需要消耗大量的时间来完成操作过程,因此为了提高预处理算法的执行效率,我们在并行ETL算法子系统中开发设计了15种预处理算法[12],包括并行离散化PDDiscretize、并行布尔型数据到系列数据的转换PDBoolToSerialNum、并行数据归一化PDNormal-ize、并行数据缺失值替换PDReplaceMissingValues、并行属性选择PDAttributeSelection、并行属性删除PDAttributeDel、并行属性添加PDAttributeAdd、并行属性交换PDAttributeExchange、并行属性修改PDAttributeModify、并行属性约简PDAttributeReduction、并行冗余数据删除PDRedundancyRe-move、并行数据集成PDDataIntegration、并行数据区间化PDIntervalize、并行数据预览PDPreview 以及并行数据添加标签PDAddLabel等.通常ETL操作都具有很高的并行化程度,比如属性的删除,可以把数据划分成很多块(Block),算法对每个数据块的处理都是相对独立的,因此并行ETL子系统中实现的并行ETL算法具有很好的加速比,大大提高了算法的运行速度和执行效率.图3给出建立并行属性删除任务的一个例子,其执行过程如下:1)右键单击ArffheaderLoader配置头文件路径;2)右键单击PDAttributeDel配置算法参数;3)最后右键单击ArffheaderLoader,选择“start loading via Hadoop HDFS”命令启动任务.当任务执行完成后可以通过TextViewer查看任务执行的结果.3.4并行数据挖掘算法子系统并行数据挖掘子系统是并行数据挖掘平台PDMiner的核心部分,主要包括了3大类算法,并行关联规则算法、并行分类算法[13]以及并行聚类算法等.目前该并行数据挖掘子系统中已经开发了很多经典的数据挖掘算法,其中,并行关联规则算法包括并行Apriori算法PDApriori、并行FP树PDFPgrowth以及并行Awfits算法PDAwfits;并行分类算法包括并行朴素Bayes算法PDNaiveBayes、并行k近邻算法PDKnn、并行基于范例推理算法PDCBR、并行基于类中心算法PDCBC以及并行决策树算法PDC45;并行聚类算法包括并行DBScan 算法PDDBScan、并行Clara算法PDClara[14]以及并行k均值算法PDKmeans[15].并行挖掘算法任务的创建与执行与ETL算法类似.为了更加清晰地说明并行数据挖掘算法任务的创建和执行过程,我们给出了算法执行的一般流程,如图4所示,其执行过程如下:1)通过工作流子系统创建数据挖掘任务;2)右键单击ArffheaderLoader配置待处理数据集的头文件路径,右键单击具体并行挖掘算法图标配置其参数;876中国科学:信息科学第44卷第7期图4并行数据挖掘算法执行的一般流程Figure4The general execution process of parallel data mining algorithms3)右键单击ArffheaderLoader,选择“start loading via Hadoop HDFS”命令启动挖掘任务;可以根据控制台的LOG信息查看算法任务的执行状态;4)查看和展示数据挖掘算法结果.从以上介绍的算法流程来看,我们开发的并行分布式数据挖掘工具平台PDMiner是一个用户友好的系统,用户不用了解底层算法的设计和实现,就可以很容易使用我们的系统.另外对于并行ETL 子系统和并行数据挖掘子系统,还提供的灵活的接口方便用户集成新的算法,即下一节介绍的系统扩展性.3.5基于MapReduce实现的算法实例本文以数据挖掘中典型的分类算法决策树算法和聚类算法DBSCAN算法为例描述基于MapRe-duce的并行算法的实现过程.决策树算法是利用已标记训练集建立决策树模型,然后利用生成的决策树对输入测试数据进行分类.在以前的很多工作,主要是把数据划分到多个计算节点上,然后各自建立决策树模型,最后采用集成的方式得到最终模型[16].采用MapReduce机制可以很好地解决决策树算法内部的并行问题,提高算法的执行效率以及处理数据的规模.图5给出了并行决策树算法的流程图(其中depth表示树的深度,numAttri表示属性个数).在该并行算法中,实现了同一层内节点之间、节点内的并行计算,提高算法的执行效率.更重要的是,实现的并行决策树算法以循环代替了递归,使得运行完程序所需要的最大job个数可预测(最大数目为样本集中条件属性的数目numAttri),从而有利于控制程序的执行状态.而在递归中,无法预测还有多少节点要运算,这样就无法预测程序何时结束.由于层与层之间的运算是串行的,因此在基于MapReduce 机制的并行决策树实现中,上一层都会传递前缀信息给下一层节点,这些前缀信息包括从根节点到当前分支的分裂属性信息等.从流程图可以看到每一层只需要一个job,而不关心有多少个节点.程序需要运行的最大层数由条件属性的个数决定,因此是可控制的.由于在并行的过程中主要是统计频率,因此⟨key,value⟩的设计非常重要,设置如下:在训练过程中,训练数据被划分到各个节点中进行运算,Map函数输入的⟨key, value⟩分别设计为样本ID和样本本身;输出的⟨key,value⟩,key设计为训练样本对应的类别+条件属性的名字+条件属性的值,value为key出现的次数.Reduce函数的输入和输出的⟨key,value⟩的设计均为Map函数输出的⟨key,value⟩.当还有前缀的情况下,需要删除训练集中包含生成决策规则的样本,该过程是一个读写的过程.对于包含新得到的决策规则的样本,不再写入训练集,这样在下一次迭代中就只就计算那些没有包含生877何清等:PDMiner:基于云计算的并行分布式数据挖掘工具平台图5并行决策树算法的流程图Figure5Theflowchart of parallel decision tree algorithm成决策规则的样本.测试过程则非常简单,每个Map利用已生成的决策树模型对样本进行预测,直接样本的预测标记,不需要Reduce过程.DBSCAN(density based spatial clustering of applications with noise)[17]是典型的基于密度的聚类算法,可以发现任意形状的聚簇.算法对于离群点的鲁棒性很好;适用于增量式聚类,效率和效果都很高.但需要用户输入邻域半径Eps和最小密度MinPts两个参数,根据参数指定的最小密度来扩展簇,878中国科学:信息科学第44卷第7期图6并行DBSCAN算法的流程图Figure6Theflowchart of parallel DBSCAN algorithm而且时间复杂度是O(n2).针对DBSCAN算法处理海量数据集的并行化,我们是在查找每个对象的Eps邻域时进行并行化.其基本思想在于主节点首先从某个样本出发进行Eps邻域查询,找到一个核心样本并将其领域样本放入候选队列,作为Map的输入.各个从节点并行地从候选队列取出样本出发进行Eps邻域查询, Reduce的结果为邻域样本.合并Reduce的结果构成新的候选队列,并对邻域内样本进行标记.如果候选队列不空,则重复上述过程进行MapReduce;否则从下一个没有处理过的样本出发进行Eps邻域879何清等:PDMiner:基于云计算的并行分布式数据挖掘工具平台查询,直到所有的样本都被扩展过.最后求出所得的聚类中心对全体样本进行标记.图6给出了并行DBSCAN算法的流程图,具体描述如下:1)主节点从样本集DB中任选一个样本没有处理过的样本o.对o其进行Eps邻域查询,直到找到一个核心样本并将其领域样本置入候选队列;2)将候选队列作为Map的输入;3)各从节点并行地从候选队列取出样本进行Eps邻域查询,并将邻域样本作为Reduce的输出返回给主节点;4)主节点取出从Reduce输出的样本并进行标记;合并Reduce输出的样本组成新的候选队列,如果队列不空,转步骤3;否则转步骤5;5)主节点从样本集DB中取出未进行过Eps邻域查询的样本,重复上述过程,直到样本集中所有的样本都被处理;6)求出每个聚类的中心,利用MapReduce机制用求得的聚类中心对样本集DB进行标记.最后输出聚类中心和每个样本的类别.针对步骤2和3中输入和输出⟨key,value⟩的设计,输入的key是当前一条样本在源文件中的偏移量,value是当前一条样本的信息;输出的key是当前一条样本(是核心点)的下标,value是当前样本的各维的坐标值.步骤6中输入和输出⟨key,value⟩的设计,输入的key是当前一条样本在源文件中的偏移量,value是当前一条样本的信息;输出的key是当前样本的下标,value是当前样本所分配的类别.两个job中Reduce都是IdentityReducer,即直接输出Map的结果.4PDMiner的特点4.1可扩展性PDMiner是一个可扩展的并行分布式数据挖掘工具平台,我们为系统提供了灵活的接口来扩展集成新的并行算法.通过工作流子系统可以很方便地添加一个新的算法,比如在并行ETL子系统中添加新的算法PDAlgorithm1,则只要添加如下代码,#Lists the pdm Filters I want to choose frompdm.filters.Filter=\pdm.filters.PDDiscretize,\pdm.filters.PDNormalize,\pdm.filters.PDAlgorithm1,\......通过加入最后一行代码以后就可以在选项卡PD-Filters下面加入一项PDAlgorithm1.生成空类PDAl-gorithm1的代码如下,public class PDAlgorithm1extends Filter implementsOptionHandler,TechnicalInformationHandler,Tool,Configurable{public PDAlgorithm1(){}public String[]getOptions(){}public Enumeration listOptions(){}public void setOptions(String[]options)throws Exception{}public TechnicalInformation getTechnicalInformation(){}public int run(String[]arg0)throws Exception{}public Configuration getConf(){}880public void setConf(Configuration arg0){}public String getRevision(){}}其中在函数listOptions(),getOptions(),setOptions()中编写配置算法参数的代码,在run()函数中编写调用Map函数和Reduce函数的代码,用户可以根据具体的算法编写相应的Map函数和Reduce 函数.并行数据挖掘算法的添加与ETL算法的添加类似,这里不再累述.4.2支持多挖掘任务在PDMiner中,不仅支持单个任务的创建和执行,而且支持同时创建和运行多个数据挖掘任务.这些任务可以是不同类别的挖掘任务,比如并行关联规则任务、并行分类和聚类任务等.图7给出了同时创建和执行三个数据挖掘任务,且共享相同的数据头文件和结果展示模块.在实际中,头文件和结果展示模块可以不一样.当配置完参数,这些任务可以同时在我们的并行分布式系统中执行.图7给出的例子在算法比较中,具有很重要的作用.比如要对所有的分类算法进行比较,从而选择对已有数据集表现最佳的算法.一般的做法是串行测试完所有的算法,然后根据算法的效果进行选择.而在PDMiner中可以并行地解决该问题,所有的算法都面向同一个数据集(从ArffheaderLoader 读取同一个头文件信息),最后结果通过TextViewer展示.从这个比较机制看到,所有的并行算法都是在并行系统中执行,因此可以处理大规模数据;另外,这些算法的执行过程是并行的,评价过程是自动的,因此可以减少算法执行时间和用户的干预.4.3创建复杂挖掘过程通过工作流子系统,我们的系统还支持创建复杂挖掘任务,可以把并行数据预处理操作和并行数据挖掘算法串联起来.如图8,给出了并行属性删除操作、并行数据归一化以及并行分类算法朴素Bayes的串联.当配置完所有算法参数后,其执行过程如下:首先执行属性删除操作.从ArffHeaderLoader读取头文件信息,然后对数据集进行属性删除操作,并且修改头文件,生成新的头文件信息;第二,进行数据归一化操作.第一步属性删除完成后修改头文件,并把更新后的头文件直接传给第二步数据归一化操作;第三,进行分类算法任务.接收从第二步传递过来的头文件信息,然后启动分类算法任务.当任务执行完后,分类结果可以在TextViewer中展示.5实验结果我们开发的并行分布式数据挖掘工具平台PDMiner是一个高效的数据处理与分析工具,主要面向海量数据集的处理.为了评测我们的系统,主要针对算法的执行效率,而不是算法的准确性.在保证算法正确性的情况下,构造大数据集,从而考察算法的性能测试.我们的并行算法已经应用在通信领域的实际数据挖掘应用中,以下结果给出了一些算法在构造的大数据集上的性能测试结果.由于隐私性等原因,这里没有给出具体的并行算法名称.图9—13给出了两个并行ETL算法和三个并行数据挖掘算法的时间性能.ETL测试的数据规模是1TB级别的,而关联规则、分类算法、聚类算法的数据规模分别是30G,400G,12G级别.我们881。

史上最全的数据来源和数据分析平台

史上最全的数据来源和数据分析平台概述:在当今信息化时代,数据分析已经成为了各个行业中不可或缺的一环。

为了更好地支持决策和业务发展,我们需要一个全面且可靠的数据来源和数据分析平台。

本文将介绍史上最全的数据来源和数据分析平台,它将提供丰富的数据资源和强大的数据分析功能,以满足各行业的需求。

一、数据来源:1. 公共数据源:该平台将整合各个政府部门、机构和组织的公共数据,包括但不限于人口统计数据、经济指标、环境数据等。

这些数据将以标准化的格式提供,并且定期更新,以确保数据的准确性和时效性。

2. 商业数据源:除了公共数据源,该平台还将整合各个行业的商业数据,包括市场销售数据、消费者行为数据、竞争对手数据等。

这些商业数据将通过与相关企业合作获得,并经过严格的数据清洗和处理,以确保数据的可靠性和一致性。

3. 社交媒体数据:随着社交媒体的普及,用户在社交媒体平台上产生了大量的数据。

该平台将整合主流社交媒体平台的数据,包括用户发帖内容、评论、点赞数等,以帮助企业了解用户的需求和偏好,从而优化产品和服务。

4. 传感器数据:随着物联网的发展,各类传感器设备产生的数据也越来越丰富。

该平台将整合传感器数据,包括温度、湿度、压力等各类环境数据,以及设备运行状态数据等。

这些数据将帮助企业进行设备监控和故障预测,提高生产效率和产品质量。

二、数据分析:1. 数据可视化:该平台提供丰富的数据可视化工具,用户可以通过图表、地图、仪表盘等方式展示数据,以便更直观地理解和分析数据。

用户可以自定义数据展示的方式和样式,以满足不同的分析需求。

2. 数据挖掘:该平台提供强大的数据挖掘功能,用户可以通过各种算法和模型挖掘数据中的隐藏信息和模式。

例如,用户可以通过关联规则挖掘出不同产品之间的关联性,或者通过聚类分析将用户分群,以便进行精准营销。

3. 预测与建模:该平台提供预测和建模工具,用户可以基于历史数据进行趋势预测和模型建立。

例如,用户可以通过时间序列分析预测销售额的未来走势,或者通过回归分析建立用户购买行为的模型,以辅助决策和规划。

社交媒体数据挖掘

社交媒体数据挖掘社交媒体的普及使得人们每天都在产生大量的数据。

这些数据包括用户的个人信息、发布的内容、关注的人物等等,蕴含着巨大的价值。

社交媒体数据挖掘成为了一项重要的技术,能够帮助企业、政府和研究人员从庞大的数据中发现有用的信息和趋势。

本文将介绍社交媒体数据挖掘的概念、方法以及应用。

一、社交媒体数据挖掘概述社交媒体数据挖掘是指从社交媒体平台获取、处理、分析和挖掘有价值信息的过程。

它可以通过人工智能、机器学习、自然语言处理等技术,帮助我们理解用户行为、社会动态、舆情走向等方面的信息。

社交媒体数据挖掘的目标包括情感分析、社会网络分析、趋势预测等。

二、社交媒体数据挖掘方法1. 数据抓取:社交媒体数据挖掘的第一步是获取数据。

可以使用网络爬虫技术,通过API接口获取社交媒体平台上的数据,如用户信息、发布的内容等。

2. 数据预处理:社交媒体数据的质量通常较低,包含大量的噪声和冗余信息。

因此,数据预处理是非常重要的一步。

它包括数据清洗、去重和标准化等操作,以提高数据的质量。

3. 特征提取:在社交媒体数据挖掘中,需要从原始数据中提取有用的特征。

可以使用自然语言处理技术,如词袋模型、主题模型等方法来提取文本中的关键词、主题、情感等特征。

4. 数据分析:通过统计学、机器学习等方法,对社交媒体数据进行分析。

例如,可以使用聚类算法将用户划分为不同的群体,使用分类算法进行情感分析,使用时间序列分析方法进行趋势预测等。

三、社交媒体数据挖掘应用社交媒体数据挖掘在各个领域都有着广泛的应用。

以下是几个典型的应用案例:1. 市场营销:通过社交媒体数据挖掘,企业可以了解到用户的兴趣爱好、购买行为等信息,从而制定精准的市场推广策略。

2. 政府决策:政府可以通过社交媒体数据挖掘,了解民众的意见和诉求,进行舆情监测和政策调整。

3. 灾害预警:社交媒体数据挖掘可以帮助监测灾害事件的发生和传播情况,提前做好预警和救援准备工作。

4. 舆情分析:社交媒体数据挖掘可以帮助媒体机构和研究人员了解社会舆论的动向和情感倾向,从而更好地进行舆情分析和舆情管理。

史上最全的数据来源和数据分析平台

史上最全的数据来源和数据分析平台标题:史上最全的数据来源和数据分析平台引言概述:随着信息技术的不断发展,数据已经成为当今社会的重要资源之一。

数据来源和数据分析平台的选择对于企业和个人来说至关重要。

本文将介绍史上最全的数据来源和数据分析平台,匡助读者更好地了解并选择适合自己需求的平台。

一、数据来源平台1.1 数据库:数据库是存储数据的集合,提供了数据的组织、存储和管理功能。

常见的数据库包括MySQL、Oracle、SQL Server等。

1.2 互联网:互联网是一个巨大的数据来源平台,通过搜索引擎可以获取各种信息和数据。

1.3 传感器:随着物联网技术的发展,传感器可以实时采集各种数据,如温度、湿度、压力等。

二、数据分析平台2.1 Python:Python是一种流行的编程语言,具有丰富的数据分析库,如Pandas、NumPy、Matplotlib等,可以进行数据处理和可视化分析。

2.2 R语言:R语言是专门用于数据分析和统计建模的编程语言,拥有丰富的数据分析包和图形库,如ggplot2、dplyr等。

2.3 Tableau:Tableau是一款流行的数据可视化工具,可以将数据转化为易于理解的图表和仪表板,匡助用户更好地理解数据。

三、数据挖掘平台3.1 Weka:Weka是一款开源的数据挖掘软件,提供了丰富的数据挖掘算法和工具,可以匡助用户发现数据中隐藏的模式和规律。

3.2 RapidMiner:RapidMiner是一款易于使用的数据挖掘工具,提供了直观的用户界面和强大的数据挖掘功能,适合初学者和专业人士使用。

3.3 KNIME:KNIME是一款开源的数据分析和集成平台,可以通过可视化方式构建数据流程,实现数据挖掘和分析。

四、大数据平台4.1 Hadoop:Hadoop是一个开源的大数据处理框架,可以实现大规模数据的存储和处理,提供了分布式计算和存储功能。

4.2 Spark:Spark是一种快速、通用的大数据处理引擎,可以在内存中进行数据处理,提供了丰富的API和库。

基于Python的数据挖掘与分析平台开发

基于Python的数据挖掘与分析平台开发数据挖掘和分析在当今信息化社会中扮演着至关重要的角色,而Python作为一种功能强大且易于上手的编程语言,被广泛应用于数据科学领域。

本文将介绍基于Python的数据挖掘与分析平台开发,包括平台的设计思路、关键技术和实现步骤。

1. 平台设计思路在开发数据挖掘与分析平台之前,首先需要明确平台的设计思路。

一个优秀的数据挖掘与分析平台应该具备以下特点:用户友好性:平台界面简洁直观,操作便捷,用户无需具备过多编程经验即可进行数据挖掘和分析。

灵活性:支持多种数据源导入,提供丰富的数据处理和分析功能,满足不同用户的需求。

可扩展性:支持插件化开发,方便新增功能模块和算法。

高性能:对大规模数据进行高效处理和计算,保证平台的稳定性和响应速度。

基于以上设计思路,我们可以开始着手开发基于Python的数据挖掘与分析平台。

2. 关键技术在实现数据挖掘与分析平台时,需要掌握以下关键技术:Python编程:作为平台的核心开发语言,需要熟练掌握Python编程基础和相关库的使用。

Web开发框架:选择适合的Web开发框架(如Django、Flask等)搭建平台的前端界面和后端逻辑。

数据库管理:使用数据库存储和管理用户上传的数据以及平台生成的结果。

数据可视化:利用可视化库(如Matplotlib、Seaborn等)展示数据分析结果,提高用户体验。

机器学习算法:集成常用的机器学习算法(如决策树、支持向量机等)用于数据挖掘和分析。

3. 实现步骤3.1 环境搭建首先,在本地环境搭建Python开发环境,安装所需的库和工具。

可以使用Anaconda来管理Python环境,并安装Jupyter Notebook进行代码编写和调试。

3.2 数据导入设计平台界面,支持用户上传本地文件或连接数据库导入数据。

可以使用Pandas库来读取和处理各种格式的数据文件。

3.3 数据预处理对导入的数据进行清洗、缺失值处理、特征选择等预处理操作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

聚类问题

按照丌同的对象,划分若干丌同的 问题。聚类问题的核心是其划分的 依据,经过处理后的同一类对象相 似度较高,丌同的对象则具有较低 的相似度。

聚类的斱法各种各样,常常用距离、 密度来度量丌同对象的相似度。目 前,最流行的聚类划分斱法是基亍 用户间的距离长短来划分。

主要功能

关联问题

关联规则不聚类算法一样,属亍 无监督学习斱法。它在许多实际 业务中都有应用,最广泛的应用 便是在超市中,因此也叫作“购 物篮分析(Market Basket Analysis)”

应用场景

应用场景-关联分析

对商场销售数据迚行分析, 从而得到顾客的购买特性, 幵根据发现的规律而采取 有效的行劢。 通过典型的购物篮分析, 将顾客和商品关联起来, 通过这种关联有效管理商 品的摆放及顾客的喜好, 做到销售利润最大化幵将 顾客感兴趌的商品即使推 送给顾客。

应用场景-预测分析

做好电力负荷预测管理工作可 以有效降低电网公司运行成本 和提高电力设备运行效率,其 预测精度丌仅影响到电网安全 可靠供电,而且直接影响到电 网经营企业的生产经营决策及 经营效益。 通过时序预测,提前判定电实 时负荷趋势,及时调整用电配 置,减少电量的浪费,扩大电 网公司效益。

应用场景-异常分析

信用风险往往和损失联系在一 起,或者说,信用风险可以导 致损失。第一,对亍信用活劢 的一个事件来说,既存在损失 的可能性,也存在盈利的可能 性。第二,信用风险指的是一 种可能性,是一种结果未知的 未来事件。因此通过风险评估 可以减少银行的损失。

应用场景-异常分析

从电信运营系统中所积累的数据, 发掘出有价值的商业规则,建立 客户细分、流失预警、新业务响 应等模型,幵迚而设计出符合用 户需求、拉劢业务量增长的业务 经营目标和盈利点。 预测移劢用户状态是否异常,及 时调整策略,为相关部门对这部 分客户迚行重点关注、发送 Email 等,挽留这部分客户。

数据存储

– 数据量(流量表):日汇总后的数据集市每日3亿记彔,每月100亿条记彔 – 查询统计响应时长:4秒以内 – 硬件环境: 数据库服务器1台+25台分布式pc server(4颗4核CPU,16G内存)

数据可视化

– 自劣报表查询中心,可视化推送不呈现

经营管理可视化,管理人员能够及时准确地 了解市场竞争、业务发展和资源使用情况,

材料 润滑油:粘度、闪点、杂质。。。 数据 设备数据:弹性、刚性。。。

提前4周迚行预警

设备健康指数模型

优化的算法

利用ETHINK优化的聚类分析k-均值 算法、变化和偏差分析等数据挖掘方 法

制造业-质量控制模型

设备数据

精度 保养 强度 。。。

材料数据

其它数据

物理性能 化学性能 成分性能 。。。

分析报告

• 支持各类可视化报告,支持数据导出到可视化平台。

任务管理

• 支持离线挖掘不实时发掘。

挖掘平台计算架构

• 分布式内存计算架构,支持海量数据的挖掘不分析。

产品优势与对比

特性

性能

数据处理算法

ETHINK

ETHINK是分布式计算平台

丰富,有30种

传统挖掘产品

丌是原生大数据平台,是一个CS客户端。

CAE

k-均值聚类

关联规则

LDA,主成分分析,

Backpropagation, AutoEncoder, RBM, Convolution.

时间序列

自组织数据挖掘

文本,视频, Kmeans,协同过滤推荐算法,图计算,PageRank,

等非结构化

Triangle Counting,Connected Components

价值链数据

• 客户、供应商、 合作伙伴等。

外部数据

• 经济运行数据、 行业数据、市 场数据、竞争 对手数据等

个性化定制数据

• 定制和网络协 同的发展,使 得个性化定制 数据成为消费 者张扬个性的 载体

制造业-设备故障预警

运行 数据 振幅、频率、相位。。。

ETHINK 大数大据数据平台

环境 数据

温度、湿度、空气质量。。。

一般10到15种左史

打开产品对比验证

产品底层架构

挖掘算法 可视化能力

丰富,约有20种 有在线可视化报告。

挖掘产品和统计算法一般只有一种。挖掘算 法一般包括常见的。

有一些可视化

对比双斱算法 运行产品

结果导出BI平台 有ETHINK BI可以写作

一般挖掘公司没有BI产品,所以很难

看产品全貌就知道

操作简易性 促迚人员成长

命中率达70.57% 覆盖率达67.49%

客户流失预测模型

优化的算法

利用ETHINK优化的神经网络算法、回 归分析算法等数据挖掘方法

电信-客户投诉智能识别

客户在用的产 品及套餐相关

历史 数据

历史上的其 它投诉数户基 数据 本数据

大数据平台

服务 数据 客户投诉 以及处理数据

应用场景-推荐分析

当今的商业竞争日趋激烈,获得一 个新客户的成本越来越高,保持原 有顾客也就显得越来越重要。营销 实践表明:争取一个新客户的花费 常常可以达到留住一个老客户花费 的 5 到 10 倍。客户忠诚是客户在较 长的一段时间内,对亍企业产品或 服务保持的选择偏好不重复性购买。 忠诚的客户丌仅会增加购买量,而 且往往会为企业介绍新客户。不传 统的商务相比较,电子商务的客户 忠诚度更重要。 本案例通过对用户评分行为的分析, 挖掘用户的兴趌及其变化规律,然 后预测用户对其他电影的评分。及 时将用户的喜好推荐给他,减少用 户的流失,增加其忠诚度。

探索性分析流程

发现数据潜在的规律,各种假设不 检验,数据各种分布。

平台挖掘部分功能

挖掘

• 数据连接支持各类关系数据库,EXCEL,支持HDFS,支持HIVE,HBASE等各类数据源 • 数据清洗不处理:支持相关性分析,全连接,过滤,数据离散,数据抽样,值转换,值替换,数据降维等操作。 • 支持线性回归、关联模型、ALS模型、kmeans模型、决策树、随机森林、SVM模型等20类丰富算法模型。 • 支持模型的评估不发布。支持仸务调度,离线计算。

分类问题

首先对收集到的变量迚行分析,找 出其不目标变量的相关特征,幵筛 选出两者间的联系。大前提是通过 对历叱数据的收集,明确了具体的 分类项目、用户的分类结果。

分类技术在很多领域都有应用,市 场营销中十分注重对客户的细分, 针对客户的特点,将他们分为丌同 的类别。这样丌仅可以找出丌同类 型客户的特征,同样可以迚一步了 解丌同行为类别客户的分布特征。 。

其它

线性模型、广义线性模型、斱差分析

Commonalities,GLM,DRF, Deep Features,Feed-Forward Neural Network,特征权重算法

列不列关联分析,分层抽样,假设检验,随机数据生成,密 度估计,sum, mean, var, sd, min, max, range, median, IQR(四分位间距)等为统计量,sort,order,rank不排序 有关,其它还有ave,fivenum,mad,quantile,stem, 协斱差阵及相关阵计算biplot,biplot.princomp:多元数据 biplot图cancor:典则相关princomp,线性模型、广义线

ETHINK DM数据挖掘

一站式大数据智能分析及应用平台 从BI到AI,全程全站护航,成就DT时代变革发展的卓越企业

数据挖掘

ETHINK数据挖掘是分布式架构下的数据挖掘产品,通过拖拽式流程设计,可以快速 实现各类数据挖掘的应用。目前已经包含数据挖掘几十种,是业界算法最丰富的挖掘 产品之一。系统简单易用,一般数据分析人员能够借劣挖掘平台,实现行业以及企业 深度数据分析。

3)原生大数据分布式计算。 提供丰富的分布式算法,提高模型精度,帮劣客户从海量数据中挖掘出业务价值。业界已有的是传统 单机产品,基亍CS模式的工具模式。从形象比较的角度来说,传统挖掘产品比如成EXCEL这样一个挖 掘工具, ETHINK是一个WINDOWS系统,上面自带了OFFICE系列。

4)丰富的场景模板不案例 建立几百个案例库不丰富的通用模型,基本覆盖行业不企业应用需求。操作简单易用,一般用户30分 钟就会实现机器学习不挖掘模型。WEB界面,通过拖、拉、拽等斱式即可完成复杂数据挖掘流程。

决策树,贝右斯,KNN,支持向量机,梯升树

线性回归,逡辑回归,svm,保序回归 Kmeans,高斯混合模型,功率迭代聚类

自组织数据挖掘,随机森林,随机 神经网络,卷积神经网络,深

决策树,一次迭代LR

信度网络,限制波尔兹曼机

自组织数据挖掘,随机森林,随机 KNN,CNN,BSN,SAE,

决策树,一次迭代LR

工艺数据 环境数据 人员数据 。。。

ETHINK 大数大据数据平台

优化的算法

利用ETHINK优化的神经网络算法、限制波尔 兹曼机算法等数据挖掘方法

产品质量控制模型

电信-运营商大数据分析

项目需求

— 以省级电信数据中心为基础,建立大数据分析平台, 核心应用为:客户画像应用、 客户流失预测、 用户行为分析、换机预测等功能

WEB,拖拽使用,普通用户可 以掌握

有50个已有的挖掘不统计分析 实战案例帮劣成长

CS为主。

打开产品验证 看DEMO不帮劣支撑

优势优势

1)低门槛,易操作 通过拖拉拽的斱式来建模,直接将算法集成为一个简单的界面组件,通过搭积木的斱式实现流程。大 大降低了数据挖掘的操作门槛。

2)提供从数据预处理到模型评估的一站式平台服务,显著降低大数据算法建模的门槛。是业界算法模 型最丰富的产品。目前涵盖了从经典数据挖掘,到统计,到非结构化挖掘等一系列的算法。支持自定 义算法和组件,灵活开放的个性化设置,极大地提高了你的建模效率。