linux系统性能优化及瓶颈分析

Linux操作系统内核性能测试与调优

Linux操作系统内核性能测试与调优操作系统是计算机系统中最核心的软件之一,它负责协调和管理计算机硬件资源以及提供统一的用户界面。

Linux操作系统因其开放源代码、稳定性和安全性而备受欢迎。

然而,在大规模和高负载的环境中,Linux操作系统的性能可能会出现瓶颈。

因此,进行内核性能测试与调优是非常重要的。

一、性能测试的重要性在处理大量数据和并发用户请求时,操作系统的性能会成为瓶颈。

通过性能测试,我们可以了解操作系统在不同负载情况下的表现,进而定位和解决性能瓶颈。

性能测试有助于提高系统的响应时间、吞吐量和并发性能,从而确保系统的稳定运行。

二、性能测试的分类1. 压力测试:通过模拟实际用户行为或产生大量虚拟用户,并观察系统在负载增加的情况下的响应时间和吞吐量。

常用的压力测试工具包括Apache JMeter和Gatling等。

2. 负载测试:通过模拟实际业务场景,并且能够测试系统在高负载情况下的响应能力和稳定性。

这种测试方法可以帮助我们发现系统在繁忙时是否仍然能够正常工作,并识别可能存在的性能瓶颈。

3. 并发测试:通过模拟多个并发用户并行执行相同或不同的操作,以验证系统在并发访问下的性能表现。

这种测试方法可以评估系统的并发处理能力和资源利用率。

三、内核性能调优的重要性Linux操作系统的性能与其内核配置息息相关。

对内核的性能调优可以提高系统的响应速度、降低延迟和提高吞吐量。

通过调整内核参数和优化内核模块,可以使操作系统更好地适应特定的工作负载。

四、内核性能调优的方法1. 内核参数调整:根据系统的工作负载特点,适当调整内核参数。

例如,可以通过修改TCP/IP堆栈参数来提高网络性能,或者通过修改文件系统参数来提高磁盘I/O性能。

2. 内核模块优化:优化内核使用的模块,选择性加载和卸载不必要的模块,以减少内核的资源占用和启动时间。

3. 中断处理优化:通过合理分配和调整中断处理的优先级,减少中断处理的开销,提高系统的性能。

linux性能调优学习笔记

Linux 性能调优1.Profiling几种工具profiling 包括几种:cpu profiling,即提到的性能分析。

memory profiling,即分析程序性能。

network profiling,即网络流量的分析。

另外,profiling又分两种:1, sampling。

即采样方式。

2, instruments,即插装代码技术。

(包含: 编译期间,链接期间,运行期间)。

oprofile ---- 属于sampling 方式,即不影响程序行为,也不需要重启程序,它是对cpu进行采样分析。

gprof ---- 属于插装技术,需在编译期间增加-pg 选项,属于GNU 部分,不需安装,随着gcc附带。

valgrind--- 属于插装技术,需要在运行期间增加valgrind选项。

(其中massif工具用于内存分析,callgrind用于性能分析)google-perftools ---- 属于插装技术,需要在链接期间增加-L/usr/lib -lprofiler 选项。

2.gprof 分析linux程序性能瓶颈gcc -pg -o test test.ctest运行的时候会把搜集的信息保存在gmoun.out中fedora 不能使用-lc_p选项的问题一般gprof只能查看用户函数信息。

如果想查看库函数的信息,需要在编译是再加入“-lc_p”编译参数代替“-lc”编译参数,这样程序会链接libc_p.a库,才可以产生库函数的profiling信息。

需要安装glibc-profile,下载地址http://ftp.riken.jp/Linux/fedora/core/updates/2/i386/glibc-profile-2.3.3-27.1.i386.rp。

gprof hello gmon.out -p 得到每个函数占用的执行时间gprof hello gmon.out -q 得到call graph,包含了每个函数的调用关系,调用次数,执行时间等信息。

perf用法

perf用法详解perf是Linux系统下的性能分析工具,可以用于分析程序的性能瓶颈和优化程序。

下面将详细介绍perf的用法和常见用法。

一、perf的基本用法1.安装perf在Ubuntu系统下,可以使用以下命令安装perf:2.使用perf record记录性能事件使用以下命令可以记录程序运行时的性能事件:其中,-g表示记录调用栈信息,-p表示记录指定进程的pid。

执行完毕后,会生成一个名为perf.data的文件,其中包含了程序运行时的性能事件信息。

3.使用perf report分析性能事件使用以下命令可以分析perf.data文件中的性能事件:该命令会显示程序运行时的性能事件报告,包括每个函数的CPU占用情况、调用栈信息等。

二、perf的常见用法1.性能分析使用perf record和perf report可以分析程序的性能瓶颈,找到CPU占用较高的函数或线程,从而进行优化。

2.内存泄漏检测使用perf工具可以检测程序的内存泄漏情况。

例如,可以使用以下命令检测程序是否存在内存泄漏:其中,-o表示输出结果到指定文件,--表示后面的参数为程序和参数。

执行完毕后,生成一个名为output_file的文件,其中包含了程序运行时的性能事件信息。

然后可以使用以下命令分析内存泄漏:其中,--sort=dso表示按照共享库名称进行排序,--dso表示只显示共享库名称。

执行完毕后,会显示程序运行时的内存占用情况报告,包括每个共享库的内存占用情况、调用栈信息等。

如果某个共享库的内存占用较高,则可能是该共享库存在内存泄漏问题。

3.缓存失效分析使用perf工具可以分析程序的缓存失效情况。

例如,可以使用以下命令分析程序运行时的缓存失效情况:其中,--表示后面的参数为程序和参数,--表示其他选项参数。

执行完毕后,生成一个名为output_file的文件,其中包含了程序运行时的性能事件信息。

然后可以使用以下命令分析缓存失效情况:其中,--sort=sym表示按照函数名称进行排序。

Linux系统性能测试脚本使用Shell脚本实现对Linux系统性能的压力测试和评估

Linux系统性能测试脚本使用Shell脚本实现对Linux系统性能的压力测试和评估在开发和运维过程中,评估和测试系统性能是至关重要的。

这有助于发现可能存在的瓶颈和问题,以便及时采取措施进行优化和改进。

Linux系统提供了丰富的工具和命令来评估和测试系统性能,而其中使用Shell脚本来实现性能测试可以更加方便和有效。

一、性能测试的目的和重要性性能测试是为了评估计算机系统或软件在特定条件下的运行性能。

它可用于评估系统的稳定性、可靠性、可扩展性、响应时间等指标。

通过性能测试,我们可以发现系统的瓶颈,优化资源的利用,提高系统的吞吐量和响应速度。

二、Shell脚本的优势Shell脚本是Linux系统中常用的脚本语言,具有以下优势:1. 简单易用:Shell脚本语法相对简单,易于理解和学习,而且可以直接在终端运行,不需要编译和链接过程。

2. 灵活性高:Shell脚本可以通过调用系统命令和工具来实现各种功能,包括性能测试。

并且可以结合其他脚本语言进行更复杂的操作。

3. 命令丰富:在Linux系统中,有大量的命令和工具可供使用,可以通过Shell脚本集成这些命令和工具来完成性能测试任务。

三、Shell脚本实现性能测试的步骤1. 设定测试环境:在开始性能测试之前,需要准备适当的环境,并安装必要的工具和软件。

例如,可以使用yum命令安装sysstat工具和其他性能测试工具。

2. 编写Shell脚本:Shell脚本负责执行性能测试的具体步骤和命令。

可以使用循环结构和计时器来模拟实际的压力测试情况。

3. 运行脚本:通过运行Shell脚本,可以执行性能测试并获取测试结果。

测试结果可以保存到文件中以便后续分析和比较。

4. 分析测试结果:根据测试结果,可以进行性能评估和分析,找出性能瓶颈,并提出相应的优化建议。

四、Shell脚本示例下面是一个简单的Shell脚本示例,用于实现Linux系统的CPU、内存和磁盘性能测试。

```bash#!/bin/bash# 测试CPU性能echo "CPU性能测试开始..."sysbench --test=cpu --cpu-max-prime=20000 runecho "CPU性能测试结束。

系统性能评估与优化:如何评估系统性能,找出系统瓶颈并进行优化

系统性能评估与优化:如何评估系统性能,找出系统瓶颈并进行优化引言当我们使用计算机系统进行各种任务时,系统性能是至关重要的。

无论是进行科学计算、玩游戏还是进行日常办公,我们都希望系统能够以高效、快速、可靠的方式完成任务。

然而,系统的性能受到多种因素的影响,包括硬件配置、软件设计、网络连接等等。

因此,对系统性能进行全面评估和优化是非常必要的。

本文将介绍如何评估系统性能,找出系统瓶颈并进行系统性能优化。

我们将从初步评估开始,逐步深入,探讨各种评估和优化方法。

通过了解系统性能评估与优化的基本原理和方法,我们将能够更好地理解和处理系统性能问题。

初步评估要评估系统的性能,首先需要对系统进行初步评估。

这个评估过程可以简单地观察系统在正常使用情况下的表现,包括响应速度、运行稳定性等方面。

虽然这种评估方法并不精确,但可以帮助我们初步了解系统的性能。

观察响应速度观察系统的响应速度是初步评估系统性能的一种简单有效的方法。

我们可以观察系统在各种不同任务下的响应速度,比较其快慢。

一般来说,如果系统的响应速度较快,那么系统的性能可能较好;反之,如果系统响应速度较慢,可能存在性能问题。

运行稳定性评估除了观察响应速度,我们还可以评估系统的运行稳定性。

运行稳定性是指系统能够持续稳定运行的能力。

我们可以观察系统在长时间运行时是否存在崩溃、卡顿等问题。

如果系统经常出现这些问题,那么可能存在性能问题。

性能评估方法初步评估只能提供一些主观的参考,为了更准确地评估系统性能,我们需要使用一些科学的方法和工具。

下面将介绍几种常用的系统性能评估方法。

负载测试负载测试是评估系统性能的一种常用方法。

在负载测试中,我们会模拟系统在不同负载情况下的工作状态,观察系统对负载的响应能力。

常用的负载测试工具包括Apache JMeter、LoadRunner等。

通过负载测试,我们可以得到系统在不同负载情况下的性能指标,如响应时间、吞吐量等,从而评估系统的性能。

Linux系统性能优化脚本使用Shell脚本实现对Linux系统性能的优化和调整

Linux系统性能优化脚本使用Shell脚本实现对Linux系统性能的优化和调整Linux是一种常用的操作系统,广泛应用于服务器、个人电脑等领域。

随着系统的使用时间的增长,系统性能可能会逐渐下降,为了保持系统的高效运行,我们可以通过使用Shell脚本来进行性能优化和调整。

本文将介绍如何使用Shell脚本进行Linux系统性能的优化。

一、优化磁盘空间磁盘空间在Linux系统中扮演着重要的角色,因为磁盘空间的占用情况直接影响到系统的运行速度和稳定性。

通过使用Shell脚本,我们可以进行磁盘空间的优化。

下面是一个简单的脚本示例,用于删除指定目录下的临时文件:```shell#!/bin/bash# 清理临时文件temp_dir="/tmp"rm -rf ${temp_dir}/*```此脚本将清理/tmp目录下的所有临时文件。

您可以根据自己的需求修改脚本,并将其添加到定时任务中,以定期清理临时文件。

二、优化内存使用内存是系统性能的关键因素之一。

通过优化内存使用,可以提高系统的响应速度和稳定性。

下面是一个示例脚本,用于释放Linux系统中的内存:```shell#!/bin/bash# 释放内存sync; echo 3 > /proc/sys/vm/drop_caches```此脚本通过将3写入/proc/sys/vm/drop_caches文件来释放内存。

您可以根据需要修改脚本并将其添加到定时任务中,以定期释放内存。

三、优化网络性能网络性能是Linux系统中的另一个重要因素。

通过优化网络设置,可以提高系统的网络传输速度和稳定性。

下面是一个示例脚本,用于优化TCP/IP设置:```shell#!/bin/bash# 优化TCP/IP设置sysctl -w net.ipv4.tcp_max_syn_backlog=65536sysctl -w dev_max_backlog=65536sysctl -w net.ipv4.tcp_tw_recycle=1sysctl -w net.ipv4.tcp_tw_reuse=1```此脚本通过修改sysctl参数来优化TCP/IP设置。

解决Linux系统常见的卡顿问题让你的电脑运行如飞

解决Linux系统常见的卡顿问题让你的电脑运行如飞Linux系统作为一款开源操作系统,被越来越多的人所使用。

然而,有时候我们在使用Linux系统时会遇到一些卡顿的问题,这给我们的使用体验带来了一定的困扰。

本文将就解决Linux系统常见的卡顿问题的方法进行探讨,帮助你的电脑运行如飞。

1. 确保系统更新:及时进行系统的更新,可以解决很多不稳定和卡顿的问题。

你可以通过命令行方式更新系统,具体步骤如下:```sudo apt-get updatesudo apt-get upgrade```这样可以检查并更新系统的软件包,保持系统的稳定性和安全性。

2. 优化启动项:Linux系统启动时默认会加载一些启动项,这些启动项可能有些并不是你每次都需要的。

你可以通过禁用一些不必要的启动项来减少系统负担,提高系统的响应速度。

```sudo systemctl list-unit-files |grep enabledsudo systemctl disable <service_name>```在上述命令中,`<service_name>`为你想要禁用的启动项的名称。

仅禁用你确实不需要的启动项,以避免对系统正常运行产生影响。

3. 检查系统资源:卡顿问题有时可能是由于系统资源不足引起的,因此我们需要检查系统的资源使用情况。

通过命令`top`或者`htop`可以实时监测当前系统资源的使用情况。

```sudo apt-get install htophtop```如果系统资源占用率过高,可以通过关闭一些不必要的程序来释放系统资源。

4. 清理临时文件:临时文件是在Linux系统中非常常见的,它们可以占用系统的存储空间,并影响系统的性能。

定期清理临时文件可以帮助我们提高系统的运行效果。

```sudo apt-get autocleansudo apt-get autoremove```上述命令会清理掉一些已经不需要的系统文件和依赖包,释放系统的存储空间。

性能测试--瓶颈分析方法

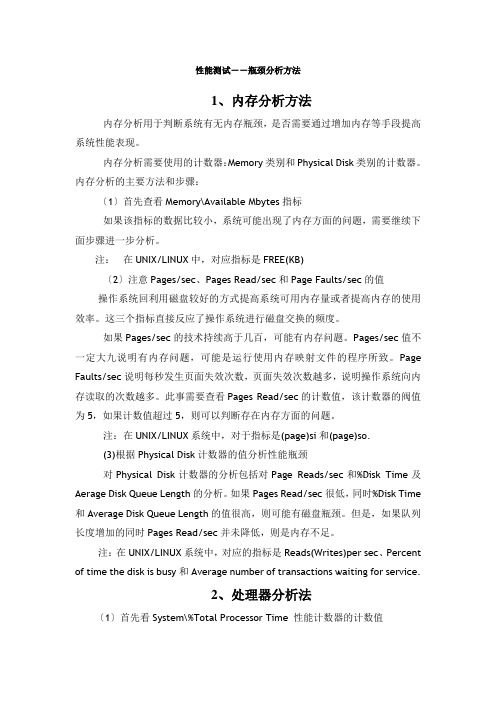

性能测试--瓶颈分析方法1、内存分析方法内存分析用于判断系统有无内存瓶颈,是否需要通过增加内存等手段提高系统性能表现。

内存分析需要使用的计数器:Memory类别和Physical Disk类别的计数器。

内存分析的主要方法和步骤:〔1〕首先查看Memory\Available Mbytes指标如果该指标的数据比较小,系统可能出现了内存方面的问题,需要继续下面步骤进一步分析。

注:在UNIX/LINUX中,对应指标是FREE(KB)〔2〕注意Pages/sec、Pages Read/sec和Page Faults/sec的值操作系统回利用磁盘较好的方式提高系统可用内存量或者提高内存的使用效率。

这三个指标直接反应了操作系统进行磁盘交换的频度。

如果Pages/sec的技术持续高于几百,可能有内存问题。

Pages/sec值不一定大九说明有内存问题,可能是运行使用内存映射文件的程序所致。

Page Faults/sec说明每秒发生页面失效次数,页面失效次数越多,说明操作系统向内存读取的次数越多。

此事需要查看Pages Read/sec的计数值,该计数器的阀值为5,如果计数值超过5,则可以判断存在内存方面的问题。

注:在UNIX/LINUX系统中,对于指标是(page)si和(page)so.(3)根据Physical Disk计数器的值分析性能瓶颈对Physical Disk计数器的分析包括对Page Reads/sec和%Disk Time及Aerage Disk Queue Length的分析。

如果Pages Read/sec很低,同时%Disk Time 和Average Disk Queue Length的值很高,则可能有磁盘瓶颈。

但是,如果队列长度增加的同时Pages Read/sec并未降低,则是内存不足。

注:在UNIX/LINUX系统中,对应的指标是Reads(Writes)per sec、Percent of time the disk is busy和Average number of transactions waiting for service.2、处理器分析法〔1〕首先看System\%Total Processor Time 性能计数器的计数值该计数器的值表达服务器整体处理器利用率,对多处理器的系统而言,该计数器提醒所有CPU的平均利用率。

中标普华Linux系统讲座-系统优化

07

总结与展望

本次讲座内容回顾与总结

系统性能分析工具介绍

我们详细讲解了如何使用top、htop、vmstat等命令来监控系统资源使用情况,包括 CPU、内存、磁盘I/O等。

系统优化实践

通过具体的案例,我们演示了如何对Linux系统进行优化,包括内核参数调整、进程管理 、文件系统优化等。

常见问题及解决方案

最佳实践分享:如何保障系统安全稳定运行

定期安全评估

定期对系统进行安全评估,发现潜在的安全 风险并及时处理。

监控与日志分析

配置系统监控和日志分析工具,实时监测系 统运行状态和安全事件。

数据备份与恢复

定期备份重要数据,并测试备份数据的可恢 复性,确保数据安全。

应急响应计划

制定应急响应计划,明确安全事件处置流程, 提高系统应对突发事件的能力。

降低成本

优化系统资源利用,减少 不必要的资源浪费,可以 降低企业的IT成本。

保障系统稳定性

通过优化系统配置和参数 调整,可以提高系统的稳 定性和可靠性,减少系统 故障和崩溃的风险。

系统优化的重要性

提高工作效率

优化后的系统可以更快地 响应用户请求和完成任务, 提高工作效率。

增强系统安全性

通过优化系统安全设置和 策略,可以提高系统的安 全性,保护数据和隐私安 全。

案例三

某科研机构Linux系统计算资源优化实践,通过合理分配 计算资源、采用并行计算技术等措施,提高了计算效率和 研究成果产出。

05

中标普华Linux系统常用 优化工具介绍与使用技巧

系统监控工具

top

实时显示系统中各个进程的资 源占用状况,类似于Windows

的任务管理器。

htop

Linux软件性能分析与优化

r u n t i me k e r n e l d a t a,p a r s e t h e d a t a a n d o u t p u t t h e p a r s e d r e s u l t s i n a g r a p h i c a l i n t e f r a c e mo d e b y me a n s o f Wi n d o ws v i s u a l i z a t i o n t o o l ,B y a n a l y z i n g t h e o u t p u t o f t h e r e s u l t s ,w e c a n l o c a t e t h e p o s i t i o n s a n d t h e

摘

要: 为 了全 面分析 L i n u x系统 性能 , 预测 系统潜 在 的瓶 颈 问题 , 首ቤተ መጻሕፍቲ ባይዱ先使用 L i n u x内核 动态探

测X - 具S y s t e m T a p来 采集 系统运 行 时的 内核 数据 , 将 数据 解 析 后借 助 Wi n d o w s 平 台 的可视 化 X - 具 将解析 结果 以图形 界面 的方 式输 出。通过 分析输 出结 果 , 可 以定 位 引起 系统 性能 问题 的位 置 和原 因, 以此对 系统做进 一步 的优 化 , 以达到用 户可接 受的 需求。 关键 词 : L i n u x系统 ; S y s t e m T a p工具 ; 可视 化 ; 性 能分析 ; 性能优 化

Abs t r a c t : F o r a c o mp r e h e n s i v e a n a l y s i s o f t h e Li n u x s y s t e m p e fo r r ma n c e a n d p r e d i c t i n g p o t e n t i a l s y s t e m b o t t l e n e c k s,we n e e d t o u s e S y s t e mTa p, t he L i n u x k e r n e l d y n a mi c p r o b i n g t o o l , t o a c q u i r e s y s t e m

Linux系统性能调优脚本

Linux系统性能调优脚本Linux系统是一种常用的操作系统,它具有开放源代码的特点,使得用户可以自由地进行定制和优化。

为了提高系统的性能,我们可以使用脚本进行调优。

本文将介绍一些常用的Linux系统性能调优脚本,帮助您优化系统并提升其性能。

一、检测系统性能瓶颈的脚本1. vmstat 脚本:vmstat 是一个常用的性能分析工具,可以显示系统的虚拟内存、进程、磁盘、CPU 等各方面的性能信息。

通过编写脚本,在一段时间内持续运行 vmstat 命令,并将结果输出到日志文件中,我们可以分析系统的性能瓶颈所在,并采取相应的优化措施。

2. top 脚本:top 是一个交互式的进程查看工具,可以实时显示系统的进程状态、CPU 使用率、内存使用情况等。

编写脚本将 top 的输出结果保存到日志文件中,可以帮助我们了解系统中的资源占用情况,找出性能瓶颈。

二、优化系统资源的脚本1. 清理内存脚本:Linux系统会将一部分内存用于缓存,而过多的缓存会影响系统的性能。

编写脚本可以定期清理不必要的缓存,释放内存资源,提高系统的响应速度。

2. 禁用不必要的服务脚本:在Linux系统中,可能会存在一些不需要的服务,默认情况下这些服务都会启动,占用系统资源。

编写脚本可以检测并禁用这些不必要的服务,从而释放系统资源,提升性能。

三、优化磁盘写入性能的脚本1. IO调度算法脚本:Linux系统中提供了多种IO调度算法,可以根据实际需求选择适合的算法来优化磁盘的读写性能。

编写脚本可以自动设置合适的IO调度算法,提高磁盘的性能。

2. 优化磁盘读写缓存脚本:在Linux系统中,可以通过调整磁盘的读写缓存大小来提高IO性能。

编写脚本可以自动设置合适的缓存大小,加速磁盘的读写操作,从而提升系统的整体性能。

四、优化网络性能的脚本1. 设置最大文件打开数脚本:Linux系统中,每个进程可以打开的文件数是有限制的。

如果系统中同时运行了大量的进程,并且每个进程都打开了大量的文件,则可能导致系统的性能下降。

linux毕业设计

linux毕业设计在选择Linux作为毕业设计的主题之前,我们需要先了解什么是Linux以及它的相关特点和应用。

Linux是一种开放源代码的操作系统,最初由Linus Torvalds 于1991年创建。

它基于Unix操作系统,并且是免费的,因此被广泛使用于各种设备和领域,如服务器、嵌入式系统和移动设备等。

Linux具有以下几个重要的特点:1. 开放源代码:Linux的源代码是公开可用的,任何人都可以查看、修改和分发它。

这种开放性使得Linux能够以一种协作的方式进行开发和改进,并且能够成为用户需求的反映。

2. 多用户和多任务:Linux支持多个用户同时登录并在同一时间运行多个任务。

这使得它成为服务器操作系统的首选,因为它可以同时处理多个请求。

3. 可定制性:Linux可以根据用户的需求进行自定义配置。

用户可以选择安装所需的软件包,并且可以根据需要进行各种设置和优化。

4. 安全性:Linux有一个强大的安全系统,可以保护用户数据和系统资源。

它提供了许多安全功能,如用户权限控制、防火墙和密码加密等。

在选择Linux作为毕业设计的主题时,可以从以下几个方面展开研究和实践:1. Linux操作系统性能优化:通过分析Linux的性能瓶颈和优化方法,提高系统的运行效率和响应能力。

2. Linux服务器搭建与管理:通过搭建一个基于Linux的服务器,并配置各种服务和功能,如Web服务器、邮件服务器、数据库服务器等。

3. Linux网络安全和防护:研究Linux的网络安全机制和相关工具,通过配置防火墙和实施访问控制等措施,提高系统的安全性。

4. Linux嵌入式系统开发:研究如何在嵌入式设备上运行Linux系统,并开发相关的应用程序,如智能家居系统、机器人控制系统等。

5. Linux应用程序开发:通过使用Linux开发工具和框架,开发各种应用程序,如图形界面应用程序、网络应用程序等。

无论你选择哪一个方向,都需要具备一定的Linux操作系统和编程知识。

Linux网络性能优化提高带宽和延迟的技巧

Linux网络性能优化提高带宽和延迟的技巧Linux是一种出色的操作系统,被广泛用于服务器环境中。

在网络通信中,性能优化对于提高带宽和降低延迟至关重要。

以下是一些在Linux系统上优化网络性能的技巧。

1. 使用适当的网络驱动程序网络驱动程序负责处理网络数据包的传输和接收。

选择适合硬件设备和操作系统的最新驱动程序,可以提高网络性能。

在Linux环境中,常见的网络驱动程序有e1000e、ixgbe和mlx4_en等。

2. 调整网络协议栈参数Linux的网络协议栈参数可以通过修改系统内核参数进行优化。

一些重要的参数包括TCP窗口大小、拥塞控制算法以及SYN队列大小等。

通过针对具体的网络需求进行调整,可以提高带宽和降低延迟。

3. 使用高效的网络服务软件选择高效的网络服务软件可以改善网络性能。

例如,Nginx作为一个轻量级的Web服务器,具有高性能和并发能力。

相比之下,Apache是一个功能较为丰富但相对较重的服务器软件。

4. 配置适当的网络缓冲区网络缓冲区的大小对于网络性能至关重要。

通过调整Linux系统中的网络缓冲区大小,可以提高网络吞吐量和降低延迟。

TCP栈和网络设备的缓冲区大小可以通过修改系统参数进行调整。

5. 启用网络流量控制和优先级Linux系统提供了一些机制来控制网络流量,以确保关键应用程序的优先级。

例如,使用Traffic Control来限制特定应用程序的带宽,或者通过Quality of Service(QoS)来为特定应用程序指定优先级。

6. 开启TCP快速打开握手TCP快速打开是一种优化技术,通过减少三次握手的次数来降低延迟。

在Linux系统上,可以通过修改内核参数来启用TCP快速打开握手功能。

这样可以加快连接的建立速度和降低延迟。

7. 使用断开连接的快速回收在网络通信中,及时回收断开的连接对于释放资源非常重要。

通过启用Linux系统的断开连接快速回收功能,可以在断开连接后立即释放相关资源,提高系统的处理能力和网络性能。

使用shell脚本进行系统性能调优和优化

使用shell脚本进行系统性能调优和优化随着数据量的不断增加和业务的迅猛发展,系统性能调优和优化变得越来越重要。

在Linux系统中,Shell脚本是一种强大的工具,可以帮助我们自动化地进行性能优化。

本文将介绍如何使用Shell脚本进行系统性能调优和优化。

一、监控系统性能在进行性能调优和优化之前,我们需要先了解系统的当前性能状况。

Shell脚本可以帮助我们监控系统的各项指标,从而找出性能瓶颈所在。

下面是一些常用的监控指标及对应的Shell脚本命令:1. CPU利用率可以使用命令"top"来查看系统的实时CPU利用率。

如果需要将实时数据保存到文件中,可以使用以下脚本命令:```#!/bin/bashtop -b -n 1 | grep "Cpu(s)" >> cpu.txt```2. 内存利用率使用命令"free"可以查看系统的内存利用率。

以下是一个示例脚本命令,将内存利用率保存到文件中:```#!/bin/bashfree -h | grep "Mem" >> memory.txt```3. 磁盘利用率使用命令"df"可以查看系统的磁盘利用率。

以下是一个示例脚本命令,将磁盘利用率保存到文件中:```#!/bin/bashdf -h | grep "/dev/sda1" >> disk.txt```通过监控这些关键指标,我们可以获得系统当前的性能状况,为后续的优化工作提供依据。

二、分析系统性能瓶颈通过监控系统的性能指标,我们可以找到系统的性能瓶颈所在。

接下来,我们需要使用Shell脚本来分析性能瓶颈的原因,从而有针对性地进行优化。

1. CPU性能瓶颈分析在分析CPU性能瓶颈时,可以使用命令"top"来查看系统中消耗CPU资源最多的进程。

Linux命令高级技巧使用perf进行系统性能分析

Linux命令高级技巧使用perf进行系统性能分析Linux命令高级技巧:使用perf进行系统性能分析Linux操作系统是一款广泛使用的开源操作系统,性能优化是使用Linux系统的开发人员和系统管理员必须掌握的技能。

在Linux系统中,perf是一个重要的工具,可以用于系统性能分析和调优。

本文将介绍perf命令的基本用法和高级技巧,帮助读者更好地利用perf进行系统性能分析。

1. perf概述perf是Linux内核中的一款性能分析工具,可以收集系统的各种事件,并提供详细的性能分析报告。

它利用了Linux内核中的性能事件子系统,可以监测CPU的硬件性能计数器、trace用户态和内核态的函数调用、记录程序的事件等。

使用perf可以帮助开发人员和系统管理员了解系统的性能瓶颈,以及优化程序和系统的方法。

2. 安装perfperf是Linux内核的一部分,通常已经默认安装在大多数Linux发行版中。

可以通过以下命令检查perf是否已经安装:```$ perf --version```如果没有安装,可以使用包管理工具进行安装。

例如,使用apt-get命令安装perf:```$ sudo apt-get install linux-tools-common linux-tools-$(uname -r)```3. 基本用法perf命令的基本用法非常简单,可以通过perf [options] [command]的方式运行。

其中,options是一些参数配置,command是要执行的命令或程序。

以下是perf的一些常用命令行参数:- record:用于记录性能事件,并生成数据文件以供后续分析。

例如,记录CPU的硬件性能计数器事件:```$ perf record -e cycles,instructions -c 10000 command```- report:用于分析和展示从record阶段收集到的数据。

例如,生成性能分析报告:```$ perf report```- top:以类似top命令的方式展示系统当前的性能状况和占用资源最多的进程。

perf的用法

perf是Linux系统下的性能分析工具,用于分析系统性能数据,帮助用户了解系统瓶颈和优化系统性能。

以下是perf的基本用法:

1. perf list:列出系统中可用的perf工具。

2. perf top:显示当前系统性能最差的进程,按CPU利用率排序。

3. perf record:记录系统性能数据,并生成性能分析报告。

可以使用该命令记录应用程序的基准测试数据,例如通过基准测试工具。

4. perf report:展示性能分析报告,包括CPU利用率、缓存命中率、磁盘I/O等指标。

5. perf analyze:分析之前记录的性能数据,以发现潜在的性能瓶颈。

以下是perf的常用命令和用法示例:

* perf record -g:使用调试信息记录应用程序性能数据。

* perf report -g:使用调试信息展示性能分析报告。

* perf top -g:使用调试信息显示当前系统性能最差的进程。

* perf timechart:生成系统性能时间线图表,展示CPU利用率、缓存命中率等指标的变化。

除了上述基本用法外,perf还提供了许多其他选项和功能,例如采样、过滤、计数器等。

可以通过查看perf的文档或使用man perf命令来获取更多详细信息。

需要注意的是,perf工具通常需要一定的系统资源和权限才能使用。

在使用perf进行性能分析时,需要确保系统资源充足,并且具有足够的权限来执行相关操作。

为什么你的Linux系统运行速度慢大优化技巧助你提速

为什么你的Linux系统运行速度慢大优化技巧助你提速为什么你的Linux系统运行速度慢? 大优化技巧助你提速作为一种主流的操作系统,Linux在安全性、稳定性和可定制性方面都具有优势。

然而,有时候我们可能会遇到Linux系统运行速度慢的问题。

本文将探讨可能导致系统运行缓慢的原因,并介绍一些大优化技巧,帮助你提高Linux系统的运行速度。

首先,让我们来看一下可能导致Linux系统运行缓慢的一些常见问题:1. 资源占用:过多的后台进程和服务可能会消耗过多的系统资源,导致系统变慢。

你可以使用系统监视工具(如top和htop)来查看当前运行的进程,并根据需要进行关闭或优化。

2. 硬件配置不足:如果你的计算机硬件资源有限,例如内存(RAM)或处理器(CPU)较低,那么你可能会经常遇到系统运行缓慢的问题。

考虑升级硬件或使用更轻量级的Linux发行版来提高性能。

3. 磁盘空间不足:当你的磁盘空间接近满时,系统可能会变得缓慢或不稳定。

确保你有足够的可用磁盘空间,并定期清理或重新分配磁盘空间。

接下来,让我们介绍一些大优化技巧,以帮助你提高Linux系统的运行速度:1. 禁用不需要的服务和进程:检查并禁用你不需要的服务和进程,以减少资源消耗。

你可以使用系统管理工具(如systemd或SysVinit)来管理服务的启动。

2. 使用轻量级的桌面环境:如果你使用的是图形界面的Linux发行版,并且觉得系统运行缓慢,考虑切换到更轻量级的桌面环境,例如Xfce或LXDE。

这些桌面环境通常消耗较少的系统资源,可以提高系统的响应速度。

3. 调整系统内核参数:优化Linux内核参数可以提高系统性能。

你可以编辑/sys/目录下的相关文件,修改参数值。

然而,在修改参数之前,请确保你了解其含义和可能带来的影响。

4. 使用高效的文件系统:选择适合你的需求的高效文件系统。

一些常见的高效文件系统包括Ext4和XFS。

这些文件系统具有更好的性能和更快的文件访问速度。

操作系统的性能优化与调优

操作系统的性能优化与调优操作系统是计算机系统中最核心的软件之一,它负责管理和控制计算机硬件资源的分配和调度。

一个良好的操作系统能够提高计算机的性能和效率,使得用户能够更加高效地进行各种操作和任务。

本文将介绍操作系统的性能优化与调优的方法和技巧。

一、背景介绍操作系统是计算机硬件与应用软件之间的桥梁,它承担着任务调度、内存管理、文件系统管理等重要功能。

一个性能良好的操作系统能够有效地提升计算机的计算能力和响应速度,使得用户能够更好地进行各种操作和任务。

因此,操作系统的性能优化和调优显得尤为重要。

二、性能优化的方法1. 硬件优化性能优化的第一步是对计算机硬件进行优化。

合理配置计算机的硬件资源,如CPU、内存、硬盘等,可以提高计算机的运算速度和数据读写能力。

同时,选择适合的硬件设备也能够提供更好的性能支持。

2. 软件优化软件优化是操作系统性能优化的重要环节。

通过对操作系统内核和系统服务进行优化,可以提高系统的运行效率和响应速度。

对于开发人员来说,编写高效的代码和程序也是提升操作系统性能的关键。

3. 系统配置优化合理的系统配置能够提升操作系统的性能。

例如,对于Windows系统,我们可以通过调整虚拟内存的大小、优化系统服务、禁用无用的启动项等方式来提高系统的性能。

对于Linux系统,可以通过修改内核参数、优化文件系统以及安装合适的驱动程序来提高系统的性能。

三、调优的技巧1. 内存管理调优内存是操作系统的核心资源之一,合理利用和调优内存可以提高系统的性能。

可以通过增加内存容量、优化内存分配算法、使用高效的内存管理工具等方式来改善系统的内存管理性能。

2. 磁盘IO调优磁盘IO的效率直接影响系统的运行速度和响应能力。

为了提高磁盘IO的性能,可以通过调整磁盘缓存策略、优化磁盘分区方式、使用高速硬盘等方式来提高系统的磁盘IO性能。

3. 任务调度调优任务调度是操作系统的重要功能之一,合理调度任务可以提高系统的并发处理能力和响应速度。

Linux操作系统的缺点全面解析

Linux操作系统的缺点全面解析Linux操作系统作为后起之秀,系统的优缺点也比较明显。

下面由店铺为大家整理了Linux操作系统的缺点全面解析的相关知识,希望对大家有帮助!Linux操作系统的缺点全面解析一Linux 的缺点:1、图形接口作的还不够好:Linux 需要使用『指令列』的终端机模式进行系统的管理!虽然近年来有很多的图形接口开发使用在Linux 上面,但毕竟要熟悉 Linux 还是以指令列来使用是比较好的,因此要接受Linux的玩家必须比较要能熟悉对计算机下指令的行为,而不是用鼠标!2、使用LINUX的最大缺点是没有一个实体对它的发展负责。

LINUX的开发人员分散在世界各地,他们可以随意发表自己的程序,没有正式的质量保证程序。

由于分散性的开发,LINUX缺乏技术支持;3、并不能安装和运行在所有硬件平台上。

LINUX所支持的硬件取决于每个开发者编写代码时所用的硬件。

4、一些应用软件,尤其是FOR WINDOWS、DOS的,不能在LINUX上使用。

目前解决的办法是,与其它操作系统共存于一台机器上。

5、另外,安装软件还不够智能,有时需要重新编译内核,还要修改Makefile等文件,费时费力,还常常安装不上----可能是没有优化、配置好内核Linux操作系统的缺点全面解析二可扩展性随着2.6内核的出现,可扩展性已经不再像原来那样重要,但是Linux一直都没有像Unix那样的扩展性。

一般来说,企业们都要求要有最大的性能,可靠性和可扩展性,Unix一直是最佳的选择。

Unix系统的高可用性也比Linux操作系统更加成熟。

硬件集成/支持的缺乏尽管很多公司认为这一点是一个附加物,但是,财富500强公司通常都更喜欢来自硬件支持的更舒适的性能以及硬件与操作系统之间更加紧密地集成。

我们都知道如果你的硬件供应商与你的操作系统软件供应商不同会发生什么或者受到什么职责。

驱动支持是硬件供应商带来的,但这对于Linux系统来说,一直是一个挑战。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

linux系统性能优化及瓶颈分析一,用vmstat分析系统I/O情况[root@localhost ~]# vmstat -n 3 (每个3秒刷新一次)procs-----------memory--------------------swap--- ---io---- --system---- ------cpu--------r b swpd free buff cache si so bi bo in cs us sy id wa1 0 144 186164 1052522386848 0 0 18 166 83 2 48 21 31 02 0 144 189620 1052522386848 0 0 0 177 10391210 34 10 56 00 0 144 214324 1052522386848 0 0 0 10 1071 670 32 5 63 00 0 144 202212 1052522386848 0 0 0 189 1035 558 20 377 02 0 144 158772 1052522386848 0 0 0 203 10652832 70 14 15 0IO-bi:从块设备读入的数据总量(读磁盘)(KB/S)-bo:写入到块设备的数据总量(写磁盘)(KB/S)随机磁盘读写的时候,这2个值越大(如超出1M),能看到CPU在IO等待的值也会越大二,用iostat分析I/O子系统情况如果你的系统没有iostat,sar,mpstat等命令,安装sysstat-7.0.2-1.el5.i386.rpm包,iostat工具将对系统的磁盘操作活动进行监视。

它的特点是汇报磁盘活动统计情况,同时也会汇报出CPU 使用情况。

同vmstat一样,iostat也有一个弱点,就是它不能对某个进程进行深入分析,仅对系统的整体情况进行分析。

iostat的语法如下:程序代码iostat [ -c | -d ] [ -k ] [ -t ] [ -V ] [ -x [ device ] ] [ interval [ count ] ]-c为汇报CPU的使用情况;-d为汇报磁盘的使用情况;-k表示每秒按kilobytes字节显示数据;-t为打印汇报的时间;-v表示打印出版本信息和用法;-x device指定要统计的设备名称,默认为所有的设备;interval指每次统计间隔的时间;count指按照这个时间间隔统计的次数。

iostat在内核2.4和内核2.6中数据来源不太一样,对于kernel 2.4, iostat 的数据的主要来源是 /proc/partitions;在2.6中,数据来源主要是/proc/diskstats和/sys/block/sd*/stat这两个文件#cat /proc/diskstats | grep sda8 0 sda 17945521 1547188 466667211 174042714 1585387442776252 469241932 2406054445 0 137655809 25809604228 1 sda1 936 1876 6128 2 sda2 19489178 466659986 58655070 4692402248 3 sda3 1270 1441 332648 4 sda4 4 80 08 5 sda5 648 1442 08 6 sda6 648 1442 0第1列 : 磁盘主设备号(major)第2列 : 磁盘次设备号(minor)第3列 : 磁盘的设备名(name)第4列 : 读请求总数(rio)第5列 : 合并的读请求总数(rmerge)第6列 : 读扇区总数(rsect)第7列 : 读数据花费的时间,单位是ms.(从__make_request到end_that_request_last)(ruse)第8列 : 写请求总数(wio)第9列 : 合并的写请求总数(wmerge)第10列 : 写扇区总数(wsect)第11列 : 写数据花费的时间,单位是ms. (从__make_request到end_that_request_last)(wuse)第12列 : 现在正在进行的I/O数(running),等于I/O队列中请求数第13列 : 系统真正花费在I/O上的时间,除去重复等待时间(aveq)第14列 : 系统在I/O上花费的时间(use)。

#iostat -x 1Linux 2.6.18-53.el5PAE (localhost.localdomain) 03/27/2009avg-cpu: %user %nice %system %iowait %steal %idle30.72 0.00 5.00 5.72 0.00 58.56 Device: rrqm/s wrqm/s r/s w/s rsec/s wsec/s avgrq-sz avgqu-sz await svctm %utilsda 0.79 21.81 9.15 8.08 237.99 2 39.29 27.69 1.32 76.31 4.07 7.02sdb 0.69 19.13 3.26 2.99 153.08 176.92 52.85 0.43 68.80 5.96 3 .72sdc 3.47 89.30 10.95 7.30 213.30 7 72.94 54.04 1.32 72.43 4.18 7.63每项数据的含义如下,rrqm/s: 每秒进行 merge 的读操作数目。

即 rmerge/swrqm/s: 每秒进行 merge 的写操作数目。

即 wmerge/sr/s: 每秒完成的读 I/O 设备次数。

即 rio/sw/s: 每秒完成的写 I/O 设备次数。

即 wio/srsec/s: 每秒读扇区数。

即 rsect/swsec/s: 每秒写扇区数。

即 wsect/srkB/s: 每秒读K字节数。

是 rsect/s 的一半,因为每扇区大小为512字节。

wkB/s: 每秒写K字节数。

是 wsect/s 的一半。

avgrq-sz: 平均每次设备I/O操作的数据大小 (扇区)。

即(rsect+wsect)/(rio+wio)avgqu-sz: 平均I/O队列长度。

即 aveq/1000 (因为aveq的单位为毫秒)。

await: 平均每次设备I/O操作的等待时间 (毫秒)。

即(ruse+wuse)/(rio+wio)svctm: 平均每次设备I/O操作的服务时间 (毫秒)。

即 use/(rio+wio) %util: 一秒中有百分之多少的时间用于 I/O 操作,或者说一秒中有多少时间I/O队列是非空的,即use/1000 (因为use的单位为毫秒),如果 %util 接近 100%,说明产生的I/O请求太多,I/O系统已经满负荷,该磁盘可能存在瓶颈。

svctm 一般要小于 await (因为同时等待的请求的等待时间被重复计算了),svctm 的大小一般和磁盘性能有关,CPU/内存的负荷也会对其有影响,请求过多也会间接导致 svctm 的增加。

await 的大小一般取决于服务时间(svctm) 以及 I/O 队列的长度和 I/O 请求的发出模式。

如果 svctm 比较接近 await,说明 I/O 几乎没有等待时间;如果 await 远大于 svctm,说明 I/O 队列太长,应用得到的响应时间变慢,如果响应时间超过了用户可以容许的范围,这时可以考虑更换更快的磁盘,调整内核 elevator 算法,优化应用,或者升级 CPU。

队列长度(avgqu-sz)也可作为衡量系统 I/O 负荷的指标,但由于 avgqu-sz 是按照单位时间的平均值,所以不能反映瞬间的 I/O 洪水。

io/s = r/s +w/sawait=(ruse+wuse)/io(每个请求的等待时间)await*io/s=每秒内的I/O请求总共需要等待的msavgqu-sz=await*(r/s+w/s)/1000(队列长度)以下数据其实与/proc/diskstats中除设备号与设备名外的其它数据是一一对应关系,只是统计的方法略有差别而已。

#cat /sys/block/sda/stat17949157 1547772 466744707 174070520 15855905 42781288 469298468 2406092114 2 137680700 2581025934三,sar -b 监控I/O#sar -b 1 10Linux 2.6.18-53.el5PAE (localhost.localdomain) 03/29/200912:19:40AM tps rtps wtps bread/s bwrtn /s12:19:42AM 21.48 9.40 12.08 187.92 429.5312:19:43AM 14.00 14.00 0.00 840.00 0.00 12:19:44AM 10.29 8.82 1.47 235.29 217.65 12:19:45AM 12.87 10.89 1.98 752.48 142.5712:19:46AM 19.82 12.61 7.21 425.23 381.98 12:19:47AM 19.00 19.00 0.00 512.00 0.00 12:19:49AM 9.29 9.29 0.00 262.86 0.00 12:19:50AM 16.00 5.00 11.00 144.00 536.00 12:19:51AM 17.65 8.82 8.82 211.76 235.29 12:19:52AM 41.41 29.29 12.12 614.14 363.64 Average: 17.75 12.30 5.45 397.19 231.99-tps:每秒钟对磁盘发送transfer的总数,一个transfer就是一个I/O,多个逻辑请求组合成一个对磁盘的I/O请求,一个transfer的大小不确定。

-rtps:每秒钟的物理读的总数-wtps:每秒钟的物理写的总数-bread/s:每秒钟从磁盘读取的数据总数-bwrtn/s:每秒钟写入磁盘的数据的总数四,sar -d 1 10Linux 2.6.18-53.el5PAE (localhost.localdomain) 03/29/200912:38:56 AM DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util12:38:57 AM dev8-0 15.00 232.00 0.00 15.47 0.010.87 0.87 1.3012:38:57 AM dev8-16 6.00 80.00 320.00 66.67 0.058.67 8.67 5.2012:38:57 AM dev8-32 10.00 224.00 0.00 22.40 0.099.20 9.20 9.20tps:每秒钟对磁盘发送transfer的总数,一个transfer就是一个I/O,多个逻辑请求组合成一个对磁盘的I/O请求,一个transfer的大小不确定rd_sec/s每秒钟读取的扇区数,每个扇区512 bytes.wr_sec/s每秒钟写入的扇区数,每个扇区512 bytes.avgrq-sz对磁盘请求的扇区的平均大小。