Kettle源码分析_(详包)

pentaho-kettle编译

Pentaho-Kettle是一款开源的ETL工具,它可以帮助用户实现各种数据集成、数据转换和数据加载的任务。

本文将对Pentaho-Kettle的编译过程进行详细介绍,以便读者能够更好地理解并使用这一工具。

一、Pentaho-Kettle编译概述1. Pentaho-Kettle的源代码是使用Java语言编写的,因此要进行编译,首先需要安装JDK(Java Development Kit)。

2. 在JDK安装完成后,需要下载Pentaho-Kettle的源代码,并解压到本地的开发环境中。

3. Pentaho-Kettle的源代码采用Ant构建系统进行编译,因此还需要安装Ant工具。

4. 接下来,就可以使用Ant工具进行编译Pentaho-Kettle的源代码了。

二、安装JDK1. 在冠方全球信息站(xxx)上下载最新版本的JDK安装包。

2. 安装JDK时,需要按照冠方指南进行操作,确保安装成功。

三、下载Pentaho-Kettle源代码1. 从Pentaho冠方全球信息站(xxx Integration/)上下载最新版本的Pentaho-Kettle源代码压缩包。

2. 将下载的压缩包解压到本地的开发环境目录中。

四、安装Ant工具1. 在冠方全球信息站(xxx)上下载最新版本的Ant安装包。

2. 安装Ant时,需要按照冠方指南进行操作,确保安装成功。

五、编译Pentaho-Kettle源代码1. 打开命令行工具,进入到Pentaho-Kettle源代码的根目录。

2. 执行命令“ant clean all”,等待编译过程完成。

3. 编译成功后,会在Pentaho-Kettle源代码的根目录生成相应的可执行文件和库文件。

六、常见问题及解决方法1. 编译过程中可能会遇到缺少依赖库的情况,这时需要根据错误提示下载并安装相应的依赖库。

2. 在安装JDK和Ant工具时,需要确保环境变量已正确配置,否则无法成功编译Pentaho-Kettle源代码。

Kettle源码分析之Job执行

Kettle源码分析之Job执行1. 源码结构如图所示主要有五个source folder组成src 包含调度逻辑和具体的执行代码。

最重要的两个包为org.pentaho.di.job和org.pentaho.di.trans。

src-ui 主要是一些图形界面的代码,最主要的是org.pentaho.di.ui包。

test未研究, 应该是一些Junit测试的代码,scr-core 主要是定义了系统用到的一些值类型和对应的接口、异常类、XML相关的接口及封装、log设置、组件加载、行数据、元信息等src-db 最主要的是org.pentaho.di.core.database包,包含各数据库对应的元数据类和不同数据库必须继承的基类和必须实现的接口。

2 Job执行相关的类与接口2.1 JobGraph类维护整个Job编辑区的信息和相应的操作主要的成员变量和方法private JobMeta jobMeta; 由Job编辑面板动态维护private Repository rep;private Job job;private JobTracker jobTracker;用于跟踪日志记录private Date startDate, endDate, currentDate, logDate, depDate;private boolean active, stopped;状态位private List<RowMetaAndData> sourceRows; 返回结果的数据内容private Result result;每次执行完一个jobentry返回结果public synchronized void startJob(JobExecutionConfiguration executionConfiguration) throws KettleException2.2 JobMeta维护整个Job的元数据。

kettle参数、变量详细讲解

kettle参数、变量详细讲解kettle 3.2 以前的版本⾥只有 variable 和 argument,kettle 3.2 中,⼜引⼊了 parameter 概念;variable 即environment variables(环境变量或全局变量),即使是不同的转换它们也拥有同样的值;⽽argument(位置参数)和parameter(命名参数),可以映射为局部变量,只针对⼀个特定的转换,⽐如像是限定结果集的⼤⼩和过滤条件。

1、 variable(变量)variables 也可以认为叫做environment variables , 就像它的名字⼀样,主要是⽤来设定环境变量的,⽐如最常见的:⽂件的存放地址,smtp 的配置等等,你也可以把它认为是编程语⾔⾥⾯的全局变量,即使是不同的转换它们也拥有同样的值;变量可以⽤在转换或作业中,可以通过在转换中使⽤ Set Variable 步骤定义或在kettle.properties⽂件中定义,⽂件的路径默认如下:$HOME/.kettle (Unix/Linux/OSX)C:\Documents andSettings\<username>\.kettle\ (Windows)C:\Users\<username>\.kettle\(Windows Vista)1.1、kettle.properties⽂件中定义全局变量打开⽂件,直接在⾥⾯定义,如: TODAY=to_char(sysdate,'yyyy-mm-dd'),这⾥⽀持数据库函数,说的更直⽩点,就是这⾥定义是个啥,那么在transformation⾥边取到的它就是啥。

在需要的地⽅,直接%%V_YES_DATE%%,或者${V_YES_DATE}就可以得到。

需要提醒的是如果编辑中⽂,需要navationtoascii⼯具或在eclipse中编辑。

定义后保存重启spoon才⽣效。

计算机网络软件及应用:kettle调研手记-技巧汇总

kettle调研手记-技巧汇总1、对于源数据后面自动添加“.0”的问题可以通过在输入步骤“格式”栏中设置长度解决,如下图2、输入为excel文件时的设置说明3、根据入库单号把明细中的金额求和后,更新到主表中,但是如果有的入库单号在主表中不存在则就会报错,这是数据问题,解决办法为,在更新步骤中设置一下”忽略查询失败”,则只对目标表中存在数据进行更新,如下图:4、使用资源库(repository)登录时,默认的用户名和密码是admin/admin5、当job是存放在资源库(一般资源库都使用数据库)中时,使用Kitchen.bat执行job时,需使用如下的命令行:Kitchen.bat /rep repository_name /user admin /pass admin /job job 名称> E:\\test.log其中repository_nameo为repository.xml中的repository,在最下面6、当job没有存放在资源库而存放在文件系统时,使用Kitchen.bat执行job时,需使用如下的命令行:Kitchen.bat /norep /file user-transfer-job.kjb7、资源名称最好不要用中文,如果程序在保持时的字符集跟系统不一致,就会造成repositories.xml文件中出现乱码,导致无法启动,解决方法是:到用户目录下找到repositories.xml。

将.kettle 文件夹删除,重写用英文名称创建后,成功启动。

8、在WINDOWS下自动执行的配置:先建一个bat文件,内容为:E:\work\kettle\pdi-ce-4.2.0-RC1\data-integration\Kitchen.bat /rep kettle_test /user admin /pass admin /job job的名称然后在windows中新建一个定时任务即可9、在LINUX下执行脚本命令:10、KETTLE所在目录/data-integration/kitchen.sh /reprepository_name /user admin /pass admin /job job名称> /opt/data_wash/log/test.log其中repository_nameo为repository.xml中的repository,在最下面11、Repository.xml在linux系统下的位置:$HOME/.kettle/repository.xml12、定义全局变量:在.kettle目录下,打开kettle.properties文件,以键值对的方式添加即可,如:变量名称=变量值,然后在kettle设置图中可以利用”Get Variables”步骤获取到13、在windows下,kettle的资源库中的数据库表名为小写,而在linux下则为大写,这一点需要注意,以移植时需要所导出表的插入sql脚本,否则会出现无法登录,找不到表的错误。

Kettle源码分析_(详包)

PDI(Kettle)源码分析说明书版本:Kettle v3.2************************有限公司企业技术中心2010-1-29源码结构src\目录下代码结构org.pentaho.di.cluster模块序号模块名称备注说明1 ClusterSchema 群集模式结合了从服务器列表,让他们完全可以设置。

它(可以)包含高性能的优化选项这一组。

例如关于期权与节点本身来过滤的主节点通信。

2 Messages 集群设置相关国际化消息读取get()set()方法.3 SlaveServer 从服务器的配置调用。

org.pentaho.di.core模块序号模块名称备注说明1 AddUndoPositionInterface接口。

内含addUndoPosition()2 Condition 这个类描述了一般意义的条件3 EngineMetaInterface 接口4 LastUsedFile 上次使用的文件5 NotePadMeta 描述一份转换,作业,架构,或报告。

org.pentaho.di.core.annotationsorg.pentaho.di.core.changedorg.pentaho.di.core.configorg.pentaho.di.core.guiorg.pentaho.di.core.listenersorg.pentaho.di.core.playlistorg.pentaho.di.core.pluginsorg.pentaho.di.core.reflectionorg.pentaho.di.core.undoorg.pentaho.di.joborg.pentaho.di.job.entriesorg.pentaho.di.job.entries.abortorg.pentaho.di.job.entries.addresultfilenamesorg.pentaho.di.job.entries.columnsexistorg.pentaho.di.job.entries.connectedtorepositoryorg.pentaho.di.job.entries.copyfilesorg.pentaho.di.job.entries.copymoveresultfilenamesorg.pentaho.di.job.entries.createfileorg.pentaho.di.job.entries.createfolderorg.pentaho.di.job.entries.delayorg.pentaho.di.job.entries.deletefileorg.pentaho.di.job.entries.deletefilesorg.pentaho.di.job.entries.deletefoldersorg.pentaho.di.job.entries.deleteresultfilenamesorg.pentaho.di.job.entries.dtdvalidatororg.pentaho.di.job.entries.emptyorg.pentaho.di.job.entries.evalorg.pentaho.di.job.entries.evaluatetablecontentorg.pentaho.di.job.entries.exportrepositoryorg.pentaho.di.job.entries.filecompareorg.pentaho.di.job.entries.fileexistsorg.pentaho.di.job.entries.filesexistorg.pentaho.di.job.entries.folderisemptyorg.pentaho.di.job.entries.folderscompareorg.pentaho.di.job.entries.ftporg.pentaho.di.job.entries.ftpdeleteorg.pentaho.di.job.entries.ftpputorg.pentaho.di.job.entries.getpoporg.pentaho.di.job.entries.httporg.pentaho.di.job.entries.joborg.pentaho.di.job.entries.mailorg.pentaho.di.job.entries.mailvalidatororg.pentaho.di.job.entries.movefilesorg.pentaho.di.job.entries.msaccessbulkloadorg.pentaho.di.job.entries.msgboxinfoorg.pentaho.di.job.entries.mssqlbulkloadorg.pentaho.di.job.entries.mysqlbulkfileorg.pentaho.di.job.entries.mysqlbulkloadorg.pentaho.di.job.entries.pingorg.pentaho.di.job.entries.setvariablesorg.pentaho.di.job.entries.sftporg.pentaho.di.job.entries.sftpputorg.pentaho.di.job.entries.shellorg.pentaho.di.job.entries.simpleevalorg.pentaho.di.job.entries.snmptraporg.pentaho.di.job.entries.specialorg.pentaho.di.job.entries.sqlorg.pentaho.di.job.entries.ssh2getorg.pentaho.di.job.entries.ssh2putorg.pentaho.di.job.entries.successorg.pentaho.di.job.entries.tableexistsorg.pentaho.di.job.entries.transorg.pentaho.di.job.entries.truncatetablesorg.pentaho.di.job.entries.unziporg.pentaho.di.job.entries.waitforfileorg.pentaho.di.job.entries.waitforsqlorg.pentaho.di.job.entries.writetologorg.pentaho.di.job.entries.xmlwellformedorg.pentaho.di.job.entries.xsdvalidatororg.pentaho.di.job.entries.xsltorg.pentaho.di.job.entries.zipfileorg.pentaho.di.job.entryorg.pentaho.di.job.entry.validatororg.pentaho.di.kitchenorg.pentaho.di.lineageorg.pentaho.di.panorg.pentaho.di.partitionorg.pentaho.di.pkgorg.pentaho.di.repositoryorg.pentaho.di.resourceorg.pentaho.di.sharedorg.pentaho.di.transorg.pentaho.di.trans.clusterorg.pentaho.di.trans.debugorg.pentaho.di.trans.performanceorg.pentaho.di.trans.steporg.pentaho.di.trans.step.errorhandlingorg.pentaho.di.trans.steps org.pentaho.di.trans.steps.abortorg.pentaho.di.trans.steps.accessinputorg.pentaho.di.trans.steps.accessoutputorg.pentaho.di.trans.steps.addsequenceorg.pentaho.di.trans.steps.addxmlorg.pentaho.di.trans.steps.aggregaterowsorg.pentaho.di.trans.steps.analyticqueryorg.pentaho.di.trans.steps.appendorg.pentaho.di.trans.steps.blockingsteporg.pentaho.di.trans.steps.calculatororg.pentaho.di.trans.steps.checksumorg.pentaho.di.trans.steps.cloneroworg.pentaho.di.trans.steps.closureorg.pentaho.di.trans.steps.columnexistsbinationlookuporg.pentaho.di.trans.steps.constantorg.pentaho.di.trans.steps.creditcardvalidatororg.pentaho.di.trans.steps.csvinputorg.pentaho.di.trans.steps.cubeinputorg.pentaho.di.trans.steps.cubeoutputorg.pentaho.di.trans.steps.databasejoinorg.pentaho.di.trans.steps.databaselookuporg.pentaho.di.trans.steps.dbprocorg.pentaho.di.trans.steps.delayorg.pentaho.di.trans.steps.deleteorg.pentaho.di.trans.steps.denormaliserorg.pentaho.di.trans.steps.detectemptystreamorg.pentaho.di.trans.steps.detectlastroworg.pentaho.di.trans.steps.dimensionlookuporg.pentaho.di.trans.steps.dummytransorg.pentaho.di.trans.steps.dynamicsqlroworg.pentaho.di.trans.steps.excelinputorg.pentaho.di.trans.steps.exceloutputorg.pentaho.di.trans.steps.execprocessorg.pentaho.di.trans.steps.execsqlroworg.pentaho.di.trans.steps.fieldsplitterorg.pentaho.di.trans.steps.fileexistsorg.pentaho.di.trans.steps.filesfromresultorg.pentaho.di.trans.steps.filestoresultorg.pentaho.di.trans.steps.filterrowsorg.pentaho.di.trans.steps.fixedinputorg.pentaho.di.trans.steps.flattenerorg.pentaho.di.trans.steps.formulaorg.pentaho.di.trans.steps.getfilenamesorg.pentaho.di.trans.steps.getfilesrowscountorg.pentaho.di.trans.steps.getpreviousrowfieldorg.pentaho.di.trans.steps.getsubfoldersorg.pentaho.di.trans.steps.getvariableorg.pentaho.di.trans.steps.getxmldataorg.pentaho.di.trans.steps.gpbulkloaderorg.pentaho.di.trans.steps.groupbyorg.pentaho.di.trans.steps.httporg.pentaho.di.trans.steps.httppostorg.pentaho.di.trans.steps.ifnullbrightoutputorg.pentaho.di.trans.steps.injectororg.pentaho.di.trans.steps.insertupdateorg.pentaho.di.trans.steps.janinoorg.pentaho.di.trans.steps.joinrowsorg.pentaho.di.trans.steps.ldapinputorg.pentaho.di.trans.steps.ldifinputorg.pentaho.di.trans.steps.luciddbbulkloaderorg.pentaho.di.trans.steps.mailorg.pentaho.di.trans.steps.mailvalidatororg.pentaho.di.trans.steps.mappingorg.pentaho.di.trans.steps.mappinginputorg.pentaho.di.trans.steps.mappingoutputorg.pentaho.di.trans.steps.mergejoinorg.pentaho.di.trans.steps.mergerowsorg.pentaho.di.trans.steps.mondrianinputorg.pentaho.di.trans.steps.monetdbbulkloaderorg.pentaho.di.trans.steps.mysqlbulkloaderorg.pentaho.di.trans.steps.normaliserorg.pentaho.di.trans.steps.nulliforg.pentaho.di.trans.steps.numberrangeorg.pentaho.di.trans.steps.orabulkloaderorg.pentaho.di.trans.steps.parallelgzipcsvorg.pentaho.di.trans.steps.pgbulkloaderorg.pentaho.di.trans.steps.processfilesorg.pentaho.di.trans.steps.propertyinputorg.pentaho.di.trans.steps.propertyoutputorg.pentaho.di.trans.steps.randomvalueorg.pentaho.di.trans.steps.regexevalorg.pentaho.di.trans.steps.replacestringorg.pentaho.di.trans.steps.reservoirsamplingorg.pentaho.di.trans.steps.rowgeneratororg.pentaho.di.trans.steps.rowsfromresultorg.pentaho.di.trans.steps.rowstoresultorg.pentaho.di.trans.steps.rssinputorg.pentaho.di.trans.steps.rssoutputorg.pentaho.di.trans.steps.samplerowsorg.pentaho.di.trans.steps.scriptvalues_modorg.pentaho.di.trans.steps.selectvaluesorg.pentaho.di.trans.steps.setvaluefieldorg.pentaho.di.trans.steps.setvariableorg.pentaho.di.trans.steps.socketreaderorg.pentaho.di.trans.steps.socketwriterorg.pentaho.di.trans.steps.sortorg.pentaho.di.trans.steps.sortedmergeorg.pentaho.di.trans.steps.splitfieldtorowsorg.pentaho.di.trans.steps.sqlorg.pentaho.di.trans.steps.sqlfileoutputorg.pentaho.di.trans.steps.stepmetaorg.pentaho.di.trans.steps.streamlookuporg.pentaho.di.trans.steps.stringcutorg.pentaho.di.trans.steps.switchcaseorg.pentaho.di.trans.steps.synchronizeaftermergeorg.pentaho.di.trans.steps.systemdataorg.pentaho.di.trans.steps.tableexistsorg.pentaho.di.trans.steps.tableinputorg.pentaho.di.trans.steps.tableoutputorg.pentaho.di.trans.steps.textfileinputorg.pentaho.di.trans.steps.textfileoutputorg.pentaho.di.trans.steps.uniquerowsorg.pentaho.di.trans.steps.uniquerowsbyhashsetorg.pentaho.di.trans.steps.univariatestatsorg.pentaho.di.trans.steps.updateorg.pentaho.di.trans.steps.validator。

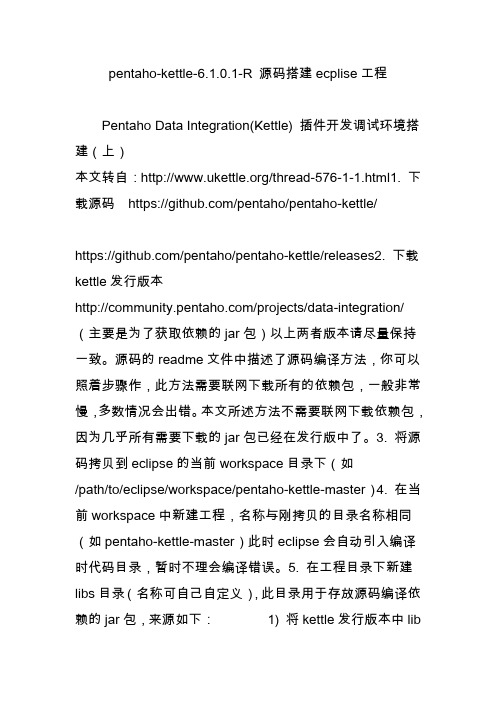

pentaho-kettle-6.1.0.1-R 源码搭建ecplise工程

pentaho-kettle-6.1.0.1-R 源码搭建ecplise工程Pentaho Data Integration(Kettle) 插件开发调试环境搭建(上)本文转自:/thread-576-1-1.html1. 下载源码https:///pentaho/pentaho-kettle/https:///pentaho/pentaho-kettle/releases2. 下载kettle发行版本/projects/data-integration/ (主要是为了获取依赖的jar包)以上两者版本请尽量保持一致。

源码的readme文件中描述了源码编译方法,你可以照着步骤作,此方法需要联网下载所有的依赖包,一般非常慢,多数情况会出错。

本文所述方法不需要联网下载依赖包,因为几乎所有需要下载的jar包已经在发行版中了。

3. 将源码拷贝到eclipse的当前workspace目录下(如/path/to/eclipse/workspace/pentaho-kettle-master)4. 在当前workspace中新建工程,名称与刚拷贝的目录名称相同(如pentaho-kettle-master)此时eclipse会自动引入编译时代码目录,暂时不理会编译错误。

5. 在工程目录下新建libs目录(名称可自己自定义),此目录用于存放源码编译依赖的jar包,来源如下:1) 将kettle发行版本中lib目录下所有jar包复制到新建的libs目录下2) 将kettle发行版本中libswt目录下相应平台的swt.jar复制到新建的libs目录下(请注意jvm版本,如果系统是win64,但jvm是32,则要选择win32下的swt.jar文件)3) 将kettle发行版本中plugins目录下所有插件目录中lib目录下的jar文件复制到新建的libs目录下4) 如要消除import中mockito相关错误,需要下载mockito-all,并复制到新建的libs目录下,参考下载地址/maven2/org/mockito/mockito-all/1.9.5/mockito-all-1.9.5.jar6. 在工程属性中java build path部分,libraries标签页下点击add library,选择JUnit并确定。

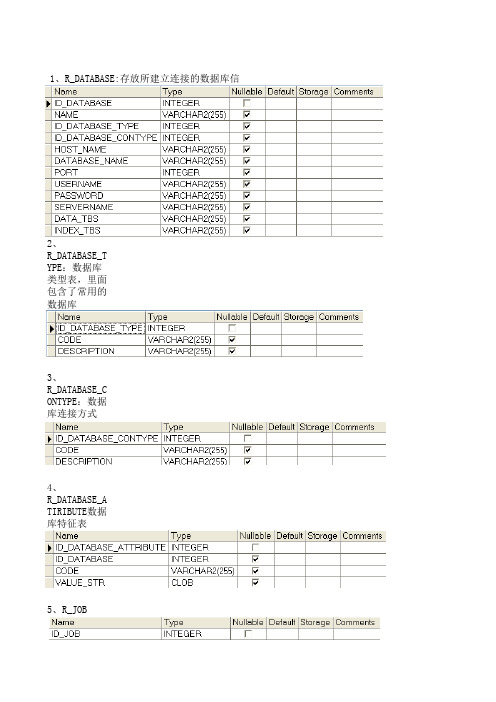

kettle资源库表详解

2、 R_DATABASE_T YPE:数据库 类型表,里面 包含了常用的 数据库

3、 R_DATABASE_C ONTYPE:数据 库连接方式

4、 R_DATABASE_A TIRIBUTE数据 库特征表

5、R_JOB

6、 R_JOB_ATTRIB UTE job的 一些设置属 性,如 LOG_SIZE_LIM IT

32、 R_VERSION

33、 R_CLUSTER(集 群)

34、 R_CLUSTER_SL AVE

35、R_SLAVE

36、 R_PARTITION 数据库分区

37、 R_PARTITIOITION 条件表

39、 R_DEPENDENCY

40、 R_DIRECTORY 资源数据库中 目录的概念

背景RGB的值

前景RGB的值

是否画阴影

12、 R_JOBENTRY_C OPY JOB中各 个操作在 Spoon的设计 器中的参数

13、 R_JOBENTRY_D ATABASE

Job中 某 个操作连 接数据库 的信息

14、 R_JOBENTRY_T YPE 操作 种类

15、R_LOG日

16、 R_LOGLEVEL 日志级别

17、R_STEP 转换中的每一 步操作的表

30、R_USER用 户表( 用户与 权限.一开始 建立的用户有 两种,admin和 guest ,权限 有5种,Read only access , Administrato r , Use transformati ons , Use Jobs , Use schemas .)

31、R_VALUE

41、R_NOTE 注释表

kettle excel 复杂格式 解析

kettle excel 复杂格式解析Kettle Excel 复杂格式解析在数据处理和分析的领域中,Excel 是一个广泛使用的工具。

然而,由于Excel 文件的复杂格式,很多人在使用Kettle(一种开源的ETL工具)进行数据导入时遇到了困难。

本文将详细解析如何使用Kettle 解析Excel 中的复杂格式。

1. 背景介绍Excel 的复杂格式主要包括合并单元格、样式、公式、条件格式等。

这些格式信息对于数据导入和处理都是非常重要的,因此我们需要确保在使用Kettle 进行数据导入时能够正确解析这些格式。

2. 解析合并单元格合并单元格在Excel 中常用于标题、表头等区域,它们在数据处理中可能会造成困惑。

使用Kettle 导入Excel 数据时,可以通过设置"合并行"和"合并列"的选项来处理合并单元格的情况,确保数据的正确导入和整理。

3. 解析样式Excel 的样式包括字体、颜色、边框、背景色等,这些样式信息需要在数据导入中得到保留。

在Kettle 中,可以通过自定义样式表来定义样式的映射关系,将Excel 中的样式信息正确地导入到数据目标中。

4. 解析公式Excel 中的公式在数据导入过程中通常需要得到保留,并计算出结果。

在Kettle 中,可以使用JavaScript 脚本来解析Excel 中的公式,并将计算结果正确导入到数据目标中。

5. 解析条件格式Excel 中的条件格式可以根据设定的条件来自动改变单元格的样式。

在Kettle 中,可以通过使用JavaScript 脚本来解析Excel 中的条件格式,并根据条件设定相应的样式映射关系,确保数据目标中的样式与Excel 中的一致。

6. 总结本文以Kettle 解析Excel 中的复杂格式为主题,详细介绍了合并单元格、样式、公式和条件格式的解析方法。

通过合理设置Kettle 的参数和使用JavaScript 脚本,能够确保在数据导入过程中正确处理Excel中的复杂格式,以确保数据的准确性和完整性。

Kettle体系结构与源码分析(详细全面)

Kettle程序分析1.简介ETL是数据抽取(Extract)、转换(Transform)、装载(Load)的过程。

Kettle是一款国外开源的ETL工具,有两种脚本文件transformation和job,transformation 完成针对数据的基础转换,job则完成整个工作流的控制。

2.相关概念Job:一个作业,由不同逻辑功能的entry组件构成,数据从一个entry组件传递到另一个entry组件,并在entry组件中进行相应的处理。

Transformation:完成针对数据的基础转换,即一个数据转换过程。

Entry:实体,即job型组件。

用来完成特定功能应用,是job的组成单元、执行单元。

Step:步骤,是Transformation的功能单元,用来完成整个转换过程的一个特定步骤。

Hop:工作流或转换过程的流向指示,从一个组件指向另一个组件,在kettle源工程中有三种hop,无条件流向、判断为真时流向、判断为假时流向。

3.体系结构kettle平台是整个系统的基础,包括元数据管理引擎、数据集成引擎、UI和插件管理模块。

(1)元数据管理引擎元数据管理引擎管理ktr、kjb或者元数据库,插件通过该引擎获取基本信息,主要包括TransMeta、JobMeta和StepMeta三个类。

TransMeta类,定义了一个转换(对应一个.ktr文件),提供了保存和加载该文件的方法;JobMeta类,同样对应于一个工作(对应一个.kjb文件),提供保存和加载方法;StepMeta类,保存的是Step的一些公共信息的类,每个类的具体的元数据将保存在显示了StepMetaInterface的类里面。

(2)数据集成引擎数据集成引擎包括Step引擎、Job引擎和数据库访问引擎三大部分,主要负责调用插件,并返回相应信息。

(3)UIUI显示Spoon这个核心组件的界面,通过xul实现菜单栏、工具栏的定制化,显示插件界面接口元素,其中的TransGraph类和JobGraph类是用于显示转换和Job的类。

KETTLE使用说明及带输入参数JAVA调用

ETL工具——kettle使用说明1简介ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),Kettle是一款国外开源的etl工具,纯java编写,数据抽取高效稳定。

2运行环境:OS:Window、Linux、Unix均可Jdk1.4以上3开始使用:Kettle可以在/网站下载。

下载kettle压缩包,因kettle为绿色软件,解压缩到任意本地路径即可。

(本文着重介绍kettle3.2.0稳定版)Spoon是一个图形用户界面,在不同平台上运行Spoon需要不同的脚本:Spoon.bat:在windows平台运行Spoon(或直接点击Kettle.exe)。

Spoon.sh:在Linux、Apple OSX、Solaris平台运行Spoon。

登陆一般选择没有资源库:Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

4转换(Transformation)新建一个转换kettle默认transformation文件保存后后缀名为ktr新建数据库连接(此链接也可在用到的节点处配置)填写数据源配置内容点击Test测试连接成功:核心对象切换到核心对象,菜单列出的是Transformation中可以调用的环节列表,可以通过鼠标拖动的方式对环节进行添加。

并且可通过shift+鼠标拖动,实现环节之间的连接。

常用节点介绍(红色节点后面逐一演示)类别环节名称功能说明输入文本文件输入从本地文本文件输入数据表输入从数据库表中输入数据获取系统信息读取系统信息输入数据输出文本文件输出将处理结果输出到文本文件表输出将处理结果输出到数据库表插入/更新根据处理结果对数据库表机型插入更新,如果数据库中不存在相关记录则插入,否则为更新。

会根据查询条件中字段进行判断更新根据处理结果对数据库进行更新,若需要更新的数据在数据库表中无记录,则会报错停止删除根据处理结果对数据库记录进行删除,若需要删除的数据在数据库表中无记录,则会报错停止查询数据库查询根据设定的查询条件,对目标表进行查询,返回需要的结果字段流查询将目标表读取到内存,通过查询条件对内存中数据集进行查询调用DB存储过程调用数据库存储过程转换字段选择选择需要的字段,过滤掉不要的字段,也可做数据库字段对应过滤记录根据条件对记录进行分类排序记录将数据根据某以条件,进行排序空操作无操作增加常量增加需要的常量字段脚本Modified Java扩展功能,编写JavaScript脚本,对数据进行相应处理Script Value映射映射(子转换)数据映射作业Sat Variables设置环境变量Get Variables获取环境变量表输入双击拖动到工作面板上的表输入结点,选择(或者新建)所需要的数据库连接,点击获取SQL查询语句或自行编辑SQL。

kettle产品详细介绍()

晴天云目录Kettle产品详细介绍..........................................................................................................................Kettle产品详细介绍..........................................................................................................................1.Kettle简介 ......................................................................................................................................2.Kettle 的安装 .................................................................................................................................3.Kettle 的详细介绍..........................................................................................................................3.1Kettle 资源库管理............................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................................3.2菜单栏介绍 ......................................................................................................................................................................................................................................................................3.2.2 编辑 ..........................................................................................................................2.2.3 视图 ..........................................................................................................................2.2.4 资源库 ......................................................................................................................3.2.5 转换 ..........................................................................................................................3.2.6 作业 ..........................................................................................................................3.2.7 向导 ..........................................................................................................................3.2.8 帮助 ..........................................................................................................................3.3工具栏介绍 ..........................................................................................................................3.3.1 transformation的工具栏..........................................................................................3.3.2 Jobs工具栏 ...............................................................................................................3.4主对象树介绍 ......................................................................................................................的主对象树 ........................................................................................................................主对象树 ............................................................................................................................3.5核心对象介绍 ......................................................................................................................核心对象 ............................................................................................................................核心对象 ............................................................................................................................3.6 transformation功能.............................................................................................................3.7 Jobs功能 ..............................................................................................................................4 Kettle 优点......................................................................................................................................5 Kettle 缺点......................................................................................................................................Kettle产品详细介绍1.Kettle简介简单地说,Kettle 就是国外一个开源的ETL工具。

kettle 分层解析

kettle 分层解析摘要:1.Kettle 分层解析简介2.Kettle 分层解析的步骤3.Kettle 分层解析的优点4.Kettle 分层解析的局限性5.Kettle 分层解析的应用示例正文:1.Kettle 分层解析简介Kettle 分层解析是一种数据处理技术,主要用于将大量数据分解为多个较小的子集,以便更容易管理和分析。

这种技术可以帮助用户更有效地从数据中提取信息,从而实现对数据的快速处理和解析。

2.Kettle 分层解析的步骤Kettle 分层解析主要包括以下几个步骤:(1)数据抽取:从原始数据源中抽取所需数据。

(2)数据转换:将抽取的数据进行清洗、转换和集成,使其符合分析要求。

(3)数据存储:将转换后的数据存储到临时数据库或其他存储介质中,以便后续分析。

(4)数据分析:对存储的数据进行分析,以提取所需的信息和知识。

(5)结果呈现:将分析结果以图表、报告等形式呈现给用户。

3.Kettle 分层解析的优点Kettle 分层解析具有以下优点:(1)易于管理和维护:将大量数据分解为多个较小的子集,有助于提高数据处理的效率,降低维护成本。

(2)灵活性:Kettle 分层解析可以根据实际需求对数据进行定制,以满足不同场景的分析需求。

(3)可扩展性:Kettle 分层解析可以很容易地与其他数据处理工具和系统集成,以实现更高效的数据处理。

4.Kettle 分层解析的局限性尽管Kettle 分层解析具有很多优点,但仍存在以下局限性:(1)对硬件资源要求较高:由于需要处理大量数据,Kettle 分层解析对硬件资源有一定要求,可能导致成本上升。

(2)数据安全风险:Kettle 分层解析可能导致数据泄露,因此在使用过程中需要注意数据安全问题。

5.Kettle 分层解析的应用示例Kettle 分层解析在很多领域都有广泛应用,例如:(1)市场调查:通过对大量市场数据进行分层解析,可以提取出有关市场趋势、消费者需求等方面的信息,为企业制定市场策略提供依据。

kettle的基本介绍

kettle的基本介绍Kettle主要内容:⼀.ETL介绍⼆.Kettle介绍三.调⽤Kettle API⼀、ETL介绍1. ETL是什么?1).ETL分别是“Extract”、“ Transform” 、“Load”三个单词的⾸字母缩写也即数据抽取、转换、装载的过程,但我们⽇常往往简称其为数据抽取。

ETL包含了三⽅⾯:Extract(抽取):将数据从各种原始的业务系统中读取出来,这是所有⼯作的前提。

⼀般抽取过程需要连接到不同的数据源,以便为随后的步骤提供数据。

这⼀部分看上去简单⽽琐碎,实际上它是 ETL 解决⽅案的成功实施的⼀个主要障碍。

Transform(转换):按照预先设计好的规则将抽取得数据进⾏转换,使本来异构的数据格式能统⼀起来。

任何对数据的处理过程都是转换。

这些处理过程通常包括(但不限于)下⾯⼀些操作:移动数据根据规则验证数据数据内容和的修改将多个数据源的数据集成根据处理后的数据计算派⽣值和聚集值Load(装载):将转换完的数据按计划增量或全部导⼊到数据仓库中。

也就是说将数据加载到⽬标系统的所有操作。

2).ETL是(Extract)、清洗(Cleaning)、转换(Transform)、装载(Load)的过程。

是构建的重要⼀环,⽤户从抽取出所需的数据,经过,最终按照预先定义好的数据仓库模型,将数据加载到数据仓库中去。

3).ETL是BI/DW( Business Intelligence/Data Warehouse , 商务智能/数据仓库)的核⼼和灵魂,按照统⼀的规则集成并提⾼数据的价值,是负责完成数据从数据源向⽬标数据仓库转化的过程,是实施数据仓库的重要步骤。

DW(Data Warehouse)即数据仓库:这个概念是由被誉为“数据仓库之⽗”的WilliamH.Inmon博⼠提出的:数据仓库是⼀个⾯向主题的、集成的、随时间变化的、信息相对稳定的数据集合,它⽤于对企业管理和决策提供⽀持。

Kettle工具介绍

Kettle⼯具介绍⽬录1.1 kettle⼯具的优势 (2)1.1.1 kettle开源、⾼效 (2)1.1.2 kettle ⾮常强⼤⽽且易于使⽤的设计界⾯ (2)1.1.3 有⾮常强⼤⽽且众多的使⽤群体,应⽤⼴泛 (2)1.1.4 可⽤java进⾏集成开发 (2)1.2 kettle⼯具使⽤介绍 (3)1.2.1 资源库连接 (3)1.2.2 创建转换(transformation)或⼯作(job) (3)1.2.3 数据库连接 (3)1.2.4.1 数据抽取 (4)1.2.4.1 数据转换 (6)1.2.5 其他转换数据功能 (6)1.3 Java应⽤程序中集成Kettle (9)1.3.1 java程序分析 (9)1.3.2代码演⽰ (12)数据抽取之kettle⼯具1.1 kettle⼯具的优势1.1.1 kettle开源、⾼效Kettle是⼀款国外开源的etl⼯具,纯java编写,绿⾊⽆需安装,数据抽取⾼效稳定。

Kettle中有两种脚本⽂件,transformation和job,transformation完成针对数据的基础转换,job则完成整个⼯作流的控制。

1.1.2 kettle ⾮常强⼤⽽且易于使⽤的设计界⾯1.1.3 有⾮常强⼤⽽且众多的使⽤群体,应⽤⼴泛1.1.4 可⽤java进⾏集成开发提供了基于JAVA的脚步编写功能,可以灵活地⾃定义ETL过程,使⾃⾏定制、批量处理等成为可能,这才是⼀个程序员需要做的⼯作,⽽不仅是象使⽤Word⼀样操作kettle⽤户界⾯。

1.2 kettle⼯具使⽤介绍1.2.1 资源库连接kettle 有两种⽅式连接资源库:⼀种是纯数据库式,也就是你所有的转换全部都保存在⼀个数据库中,⼀般你在开始使⽤kettle的时候,它都会要求你建⽴⼀个资源仓库,这个资源仓库的连接⽅式就是你的数据库连接,你需要能够有相应的数据库驱动和对应的连接⽤户名和密码。

另外⼀种连接⽅式是使⽤⽂本⽂件,也就是xml⽂件,在做完任何转换之后,我们都可以把转换或者Job变成xml⽂件输出,这个输出⽂件包含你所有转换的全部信息。

2024版年度搞定Kettle详细教程

降低工作强度。

12

03

数据抽取、转换与加载实战演练

2024/2/3

13

数据源连接配置方法论述

确定数据源类型

根据实际需求选择合适的数据源类型,如关系 型数据库、文件、API等。

2024/2/3

配置数据源连接参数

根据所选数据源类型,配置相应的连接参数,如数据 库地址、端口、用户名、密码等。

测试数据源连接

可视化展示

通过图表等方式直观展示监控指标和报警信息,提高问题发现和处理 效率。

2024/2/3

21

Hale Waihona Puke 日志查看和问题排查方法根据日志信息快速定位问题所在,如 数据源连接失败、数据转换错误等。

对问题排查和解决过程进行总结和归 纳,形成经验库,为后续类似问题提 供参考和借鉴。

日志查看

问题定位

问题解决

经验总结

提供详细的日志查看功能,包括任务 执行日志、系统日志等,以便追踪任 务执行过程和排查问题。

2024/2/3

针对定位到的问题,提供相应的解决 方案和修复措施,确保任务能够恢复 正常执行。

22

05

高级功能拓展与应用场景探讨

2024/2/3

23

自定义函数编写技巧分享

掌握Kettle内置函数

了解并熟悉Kettle提供的内置函数,包括字符串处理、日期转换、 数学计算等,为编写自定义函数打下基础。

2024/2/3

3

Kettle简介及应用场景

1

Kettle是一款开源的ETL工具,全称为Pentaho Data Integration,主要用于数据抽取、转换和 加载。

2

Kettle可以应用于数据迁移、数据整合、数据处 理等多种场景,支持多种数据源和数据格式。

史上最强Kettle培训教程资料

流程调试与优化

对整个处理流程进行调试和优化,确保数据处 理的正确性和高效性。

总结与拓展思考

Kettle是一款功能强大的ETL工具, 可以高效地处理大量数据。

Kettle支持多种数据库和文件格式的 输出,可以满足不同的需求场景。

在实际使用中,需要根据具体需求和 数据特点,设计合理的处理流程和方 案。

Kettle支持多种快捷键操 作,用户可以在工具栏中 查看并设置相关快捷键。

视图切换与展示

设计视图

用于可视化设计ETL转换流程和作业调度流程,支持拖拽组件并进行 连线,方便用户进行流程设计。

预览视图

用于预览当前转换/作业的执行结果,帮助用户及时发现并解决问题 。

日志视图

展示当前转换/作业的执行日志信息,包括执行步骤、耗时、错误信 息等,方便用户进行问题定位和排查。

数据抽取策略及实现

抽取策略

根据业务需求和数据特点 ,制定合适的数据抽取策 略,如全量抽取、增量抽 取等。

抽取实现方式

介绍如何通过Kettle实现 数据抽取,包括使用不同 的抽取组件、设置抽取参 数等。

性能优化技巧

分享在数据抽取过程中进 行性能优化的技巧,如并 行抽取、分批抽取等。

数据转换技巧分享

启动Kettle

将下载的压缩包解压到指定目录 ,如C:kettle或

/home/user/kettle。

解压安装包

将Kettle的可执行文件路径添加 到系统的环境变量中,以便在命 令行或终端中直接运行Kettle。

配置环境变量

双击Kettle的可执行文件或在命 令行中输入kettle命令,即可启 动Kettle软件。

错误代码

ERROR: Database connection failed

2024版kettle使用教程(超详细)

分布式计算原理

阐述Kettle分布式计算的原理, 如何利用集群资源进行并行处理 和任务调度。

01 02 03 04

集群配置与部署

详细讲解Kettle集群的配置步骤, 包括环境准备、节点配置、网络 设置等。

集群监控与管理

介绍Kettle提供的集群监控和管 理工具,方便用户实时了解集群 状态和作业执行情况。

03

实战演练

以一个具体的实时数据处理任务为例, 介绍如何使用Kettle设计实时数据处理 流程。

案例四:Kettle在数据挖掘中应用

数据挖掘概念介绍

01

数据挖掘是指从大量数据中提取出有用的信息和知识的

过程,包括分类、聚类、关联规则挖掘等任务。

Kettle在数据挖掘中的应用

02

Kettle提供了丰富的数据处理和转换功能,可以方便地

Chapter

案例一:ETL过程自动化实现

ETL概念介绍

ETL即Extract, Transform, Load,是数据仓 库技术中重要环节,包括数据抽取、清洗、转 换和加载等步骤。

Kettle实现ETL过程

通过Kettle的图形化界面,可以方便地设计ETL流程, 实现数据的自动化抽取、转换和加载。

作业项配置

对作业项进行详细配置,包括数据源、目标库、 字段映射等。

作业项管理

支持作业项的复制、粘贴、删除等操作,方便快速构建作业。

定时任务设置与执行

定时任务设置

支持基于Cron表达式的定时任务设置,实现 周期性自动执行。

立即执行

支持手动触发作业执行,满足即时数据处理 需求。

执行日志查看

Kettle学习系列之kettle的下载、安装和初步使用(windows平台下)(图文详解)

Kettle学习系列之kettle的下载、安装和初步使⽤(windows平台下)(图⽂详解) 不多说,直接上⼲货!kettle的下载 K ettle可以在⽹站下载/projects/pentaho/files/Data%20Integration/7.1/pdi-ce-7.1.0.0-12.zip/downloadkettle的安装 下载kettle压缩包,因kettle为绿⾊软件,解压缩到任意本地路径即可。

我这⾥,在D:\SoftWare下,新建kettle, 解压 对于,在windows下配置jdk,我这⾥就不多赘述了。

kettle的初步使⽤ 进⼊到Kettle⽬录,如果Kettle部署在windows环境下,双击运⾏spoon.bat或Kettle.exe⽂件,出现如下界⾯: 因为,运⾏spoon 在不同的平台上运⾏spoon所⽀持的脚本: Spoon.bat:在Windows平台上运⾏spoon; Spoon.sh:在Linux、AppleOSX、Solaris平台上运⾏Spoon。

默认打开的是,⼤家Kettle安装⽬录下的,英⽂欢迎界⾯。

file:///D:/SoftWare/kettle/data-integration/docs/English/welcome/index.html初步使⽤: 左上⾓点击”⽂件-新建-转换“保存为demo.ktr⼤家初步启动和使⽤可能出现的问题总结问题⼀:配置JVM及内存配置问题如果java_home设置了,仍提⽰:could not find the main class. Program will exit!可以设置环境变量:PENTAHO_JAVA_HOME,变量值为:jdk的安装⽬录,1.6以上即可。

本机为: D:\Program Files\java\jdk1.7.0_8但是,⼀般都不需要哈。

问题⼆:如果启动还报错 ERROR:could not create the java virtual machine! 不是Java虚拟出了问题,修改⼀下spoon.bat⾥内存配置:if "%PENTAHO_DI_JAVA_OPTIONS%"=="" set PENTAHO_DI_JAVA_OPTIONS="-Xms1024m" "-Xmx2048m" "-XX:MaxPermSize=256m"改为:if "%PENTAHO_DI_JAVA_OPTIONS%"=="" set PENTAHO_DI_JAVA_OPTIONS="-Xms512m" "-Xmx1024m" "-XX:MaxPermSize=256m"问题三:连接数据库找不到驱动问题(MySql为例)提⽰错误[mysql] : org.pentaho.di.core.exception.KettleDatabaseException:Error occured while trying to connect to the databaseDriver class 'org.gjt.mm.mysql.Driver' could not be found, make sure the 'MySQL' driver (jar file) is installed. org.gjt.mm.mysql.Driver解决办法:把mysql-connector-java-5.1.21-bin.jar拷贝到D:\SoftWare\kettle\data-integration\lib下⾯,然后重新启动spoon即可。

Kettle源码分析_(详包)

PDI(Kettle)源码分析说明书版本:Kettle v3.2************************有限公司企业技术中心2010-1-29源码结构src\目录下代码结构org.pentaho.di.cluster模块序号模块名称备注说明1 ClusterSchema 群集模式结合了从服务器列表,让他们完全可以设置。

它(可以)包含高性能的优化选项这一组。

例如关于期权与节点本身来过滤的主节点通信。

2 Messages 集群设置相关国际化消息读取get()set()方法.3 SlaveServer 从服务器的配置调用。

org.pentaho.di.core模块序号模块名称备注说明1 AddUndoPositionInterface接口。

内含addUndoPosition()2 Condition 这个类描述了一般意义的条件3 EngineMetaInterface 接口4 LastUsedFile 上次使用的文件5 NotePadMeta 描述一份转换,作业,架构,或报告。

org.pentaho.di.core.annotationsorg.pentaho.di.core.changedorg.pentaho.di.core.configorg.pentaho.di.core.guiorg.pentaho.di.core.listenersorg.pentaho.di.core.playlistorg.pentaho.di.core.pluginsorg.pentaho.di.core.reflectionorg.pentaho.di.core.undoorg.pentaho.di.joborg.pentaho.di.job.entriesorg.pentaho.di.job.entries.abortorg.pentaho.di.job.entries.addresultfilenamesorg.pentaho.di.job.entries.columnsexistorg.pentaho.di.job.entries.connectedtorepositoryorg.pentaho.di.job.entries.copyfilesorg.pentaho.di.job.entries.copymoveresultfilenamesorg.pentaho.di.job.entries.createfileorg.pentaho.di.job.entries.createfolderorg.pentaho.di.job.entries.delayorg.pentaho.di.job.entries.deletefileorg.pentaho.di.job.entries.deletefilesorg.pentaho.di.job.entries.deletefoldersorg.pentaho.di.job.entries.deleteresultfilenamesorg.pentaho.di.job.entries.dtdvalidatororg.pentaho.di.job.entries.emptyorg.pentaho.di.job.entries.evalorg.pentaho.di.job.entries.evaluatetablecontentorg.pentaho.di.job.entries.exportrepositoryorg.pentaho.di.job.entries.filecompareorg.pentaho.di.job.entries.fileexistsorg.pentaho.di.job.entries.filesexistorg.pentaho.di.job.entries.folderisemptyorg.pentaho.di.job.entries.folderscompareorg.pentaho.di.job.entries.ftporg.pentaho.di.job.entries.ftpdeleteorg.pentaho.di.job.entries.ftpputorg.pentaho.di.job.entries.getpoporg.pentaho.di.job.entries.httporg.pentaho.di.job.entries.joborg.pentaho.di.job.entries.mailorg.pentaho.di.job.entries.mailvalidatororg.pentaho.di.job.entries.movefilesorg.pentaho.di.job.entries.msaccessbulkloadorg.pentaho.di.job.entries.msgboxinfoorg.pentaho.di.job.entries.mssqlbulkloadorg.pentaho.di.job.entries.mysqlbulkfileorg.pentaho.di.job.entries.mysqlbulkloadorg.pentaho.di.job.entries.pingorg.pentaho.di.job.entries.setvariablesorg.pentaho.di.job.entries.sftporg.pentaho.di.job.entries.sftpputorg.pentaho.di.job.entries.shellorg.pentaho.di.job.entries.simpleevalorg.pentaho.di.job.entries.snmptraporg.pentaho.di.job.entries.specialorg.pentaho.di.job.entries.sqlorg.pentaho.di.job.entries.ssh2getorg.pentaho.di.job.entries.ssh2putorg.pentaho.di.job.entries.successorg.pentaho.di.job.entries.tableexistsorg.pentaho.di.job.entries.transorg.pentaho.di.job.entries.truncatetablesorg.pentaho.di.job.entries.unziporg.pentaho.di.job.entries.waitforfileorg.pentaho.di.job.entries.waitforsqlorg.pentaho.di.job.entries.writetologorg.pentaho.di.job.entries.xmlwellformedorg.pentaho.di.job.entries.xsdvalidatororg.pentaho.di.job.entries.xsltorg.pentaho.di.job.entries.zipfileorg.pentaho.di.job.entryorg.pentaho.di.job.entry.validatororg.pentaho.di.kitchenorg.pentaho.di.lineageorg.pentaho.di.panorg.pentaho.di.partitionorg.pentaho.di.pkgorg.pentaho.di.repositoryorg.pentaho.di.resourceorg.pentaho.di.sharedorg.pentaho.di.transorg.pentaho.di.trans.clusterorg.pentaho.di.trans.debugorg.pentaho.di.trans.performanceorg.pentaho.di.trans.steporg.pentaho.di.trans.step.errorhandlingorg.pentaho.di.trans.steps org.pentaho.di.trans.steps.abortorg.pentaho.di.trans.steps.accessinputorg.pentaho.di.trans.steps.accessoutputorg.pentaho.di.trans.steps.addsequenceorg.pentaho.di.trans.steps.addxmlorg.pentaho.di.trans.steps.aggregaterowsorg.pentaho.di.trans.steps.analyticqueryorg.pentaho.di.trans.steps.appendorg.pentaho.di.trans.steps.blockingsteporg.pentaho.di.trans.steps.calculatororg.pentaho.di.trans.steps.checksumorg.pentaho.di.trans.steps.cloneroworg.pentaho.di.trans.steps.closureorg.pentaho.di.trans.steps.columnexistsbinationlookuporg.pentaho.di.trans.steps.constantorg.pentaho.di.trans.steps.creditcardvalidatororg.pentaho.di.trans.steps.csvinputorg.pentaho.di.trans.steps.cubeinputorg.pentaho.di.trans.steps.cubeoutputorg.pentaho.di.trans.steps.databasejoinorg.pentaho.di.trans.steps.databaselookuporg.pentaho.di.trans.steps.dbprocorg.pentaho.di.trans.steps.delayorg.pentaho.di.trans.steps.deleteorg.pentaho.di.trans.steps.denormaliserorg.pentaho.di.trans.steps.detectemptystreamorg.pentaho.di.trans.steps.detectlastroworg.pentaho.di.trans.steps.dimensionlookuporg.pentaho.di.trans.steps.dummytransorg.pentaho.di.trans.steps.dynamicsqlroworg.pentaho.di.trans.steps.excelinputorg.pentaho.di.trans.steps.exceloutputorg.pentaho.di.trans.steps.execprocessorg.pentaho.di.trans.steps.execsqlroworg.pentaho.di.trans.steps.fieldsplitterorg.pentaho.di.trans.steps.fileexistsorg.pentaho.di.trans.steps.filesfromresultorg.pentaho.di.trans.steps.filestoresultorg.pentaho.di.trans.steps.filterrowsorg.pentaho.di.trans.steps.fixedinputorg.pentaho.di.trans.steps.flattenerorg.pentaho.di.trans.steps.formulaorg.pentaho.di.trans.steps.getfilenamesorg.pentaho.di.trans.steps.getfilesrowscountorg.pentaho.di.trans.steps.getpreviousrowfieldorg.pentaho.di.trans.steps.getsubfoldersorg.pentaho.di.trans.steps.getvariableorg.pentaho.di.trans.steps.getxmldataorg.pentaho.di.trans.steps.gpbulkloaderorg.pentaho.di.trans.steps.groupbyorg.pentaho.di.trans.steps.httporg.pentaho.di.trans.steps.httppostorg.pentaho.di.trans.steps.ifnullbrightoutputorg.pentaho.di.trans.steps.injectororg.pentaho.di.trans.steps.insertupdateorg.pentaho.di.trans.steps.janinoorg.pentaho.di.trans.steps.joinrowsorg.pentaho.di.trans.steps.ldapinputorg.pentaho.di.trans.steps.ldifinputorg.pentaho.di.trans.steps.luciddbbulkloaderorg.pentaho.di.trans.steps.mailorg.pentaho.di.trans.steps.mailvalidatororg.pentaho.di.trans.steps.mappingorg.pentaho.di.trans.steps.mappinginputorg.pentaho.di.trans.steps.mappingoutputorg.pentaho.di.trans.steps.mergejoinorg.pentaho.di.trans.steps.mergerowsorg.pentaho.di.trans.steps.mondrianinputorg.pentaho.di.trans.steps.monetdbbulkloaderorg.pentaho.di.trans.steps.mysqlbulkloaderorg.pentaho.di.trans.steps.normaliserorg.pentaho.di.trans.steps.nulliforg.pentaho.di.trans.steps.numberrangeorg.pentaho.di.trans.steps.orabulkloaderorg.pentaho.di.trans.steps.parallelgzipcsvorg.pentaho.di.trans.steps.pgbulkloaderorg.pentaho.di.trans.steps.processfilesorg.pentaho.di.trans.steps.propertyinputorg.pentaho.di.trans.steps.propertyoutputorg.pentaho.di.trans.steps.randomvalueorg.pentaho.di.trans.steps.regexevalorg.pentaho.di.trans.steps.replacestringorg.pentaho.di.trans.steps.reservoirsamplingorg.pentaho.di.trans.steps.rowgeneratororg.pentaho.di.trans.steps.rowsfromresultorg.pentaho.di.trans.steps.rowstoresultorg.pentaho.di.trans.steps.rssinputorg.pentaho.di.trans.steps.rssoutputorg.pentaho.di.trans.steps.samplerowsorg.pentaho.di.trans.steps.scriptvalues_modorg.pentaho.di.trans.steps.selectvaluesorg.pentaho.di.trans.steps.setvaluefieldorg.pentaho.di.trans.steps.setvariableorg.pentaho.di.trans.steps.socketreaderorg.pentaho.di.trans.steps.socketwriterorg.pentaho.di.trans.steps.sortorg.pentaho.di.trans.steps.sortedmergeorg.pentaho.di.trans.steps.splitfieldtorowsorg.pentaho.di.trans.steps.sqlorg.pentaho.di.trans.steps.sqlfileoutputorg.pentaho.di.trans.steps.stepmetaorg.pentaho.di.trans.steps.streamlookuporg.pentaho.di.trans.steps.stringcutorg.pentaho.di.trans.steps.switchcaseorg.pentaho.di.trans.steps.synchronizeaftermergeorg.pentaho.di.trans.steps.systemdataorg.pentaho.di.trans.steps.tableexistsorg.pentaho.di.trans.steps.tableinputorg.pentaho.di.trans.steps.tableoutputorg.pentaho.di.trans.steps.textfileinputorg.pentaho.di.trans.steps.textfileoutputorg.pentaho.di.trans.steps.uniquerowsorg.pentaho.di.trans.steps.uniquerowsbyhashsetorg.pentaho.di.trans.steps.univariatestatsorg.pentaho.di.trans.steps.updateorg.pentaho.di.trans.steps.validator。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

PDI(Kettle)源码分析说明书版本:Kettle v3.2************************有限公司企业技术中心2010-1-29源码结构src\目录下代码结构org.pentaho.di.clusterorg.pentaho.di.coreorg.pentaho.di.core.annotationsorg.pentaho.di.core.changedorg.pentaho.di.core.configorg.pentaho.di.core.guiorg.pentaho.di.core.listenersorg.pentaho.di.core.playlistorg.pentaho.di.core.pluginsorg.pentaho.di.core.reflectionorg.pentaho.di.core.undoorg.pentaho.di.joborg.pentaho.di.job.entriesorg.pentaho.di.job.entries.abortorg.pentaho.di.job.entries.addresultfilenamesorg.pentaho.di.job.entries.columnsexistorg.pentaho.di.job.entries.connectedtorepositoryorg.pentaho.di.job.entries.copyfilesorg.pentaho.di.job.entries.copymoveresultfilenamesorg.pentaho.di.job.entries.createfileorg.pentaho.di.job.entries.createfolderorg.pentaho.di.job.entries.delayorg.pentaho.di.job.entries.deletefileorg.pentaho.di.job.entries.deletefilesorg.pentaho.di.job.entries.deletefoldersorg.pentaho.di.job.entries.deleteresultfilenamesorg.pentaho.di.job.entries.dtdvalidatororg.pentaho.di.job.entries.emptyorg.pentaho.di.job.entries.evalorg.pentaho.di.job.entries.evaluatetablecontentorg.pentaho.di.job.entries.exportrepositoryorg.pentaho.di.job.entries.filecompareorg.pentaho.di.job.entries.fileexistsorg.pentaho.di.job.entries.filesexistorg.pentaho.di.job.entries.folderisemptyorg.pentaho.di.job.entries.folderscompareorg.pentaho.di.job.entries.ftporg.pentaho.di.job.entries.ftpdeleteorg.pentaho.di.job.entries.ftpputorg.pentaho.di.job.entries.getpoporg.pentaho.di.job.entries.httporg.pentaho.di.job.entries.joborg.pentaho.di.job.entries.mailorg.pentaho.di.job.entries.mailvalidatororg.pentaho.di.job.entries.movefilesorg.pentaho.di.job.entries.msaccessbulkloadorg.pentaho.di.job.entries.msgboxinfoorg.pentaho.di.job.entries.mssqlbulkloadorg.pentaho.di.job.entries.mysqlbulkfileorg.pentaho.di.job.entries.mysqlbulkloadorg.pentaho.di.job.entries.pingorg.pentaho.di.job.entries.setvariablesorg.pentaho.di.job.entries.sftporg.pentaho.di.job.entries.sftpputorg.pentaho.di.job.entries.shellorg.pentaho.di.job.entries.simpleevalorg.pentaho.di.job.entries.snmptraporg.pentaho.di.job.entries.specialorg.pentaho.di.job.entries.sqlorg.pentaho.di.job.entries.ssh2getorg.pentaho.di.job.entries.ssh2putorg.pentaho.di.job.entries.successorg.pentaho.di.job.entries.tableexistsorg.pentaho.di.job.entries.transorg.pentaho.di.job.entries.truncatetablesorg.pentaho.di.job.entries.unziporg.pentaho.di.job.entries.waitforfileorg.pentaho.di.job.entries.waitforsqlorg.pentaho.di.job.entries.writetologorg.pentaho.di.job.entries.xmlwellformedorg.pentaho.di.job.entries.xsdvalidatororg.pentaho.di.job.entries.xsltorg.pentaho.di.job.entries.zipfileorg.pentaho.di.job.entryorg.pentaho.di.job.entry.validatororg.pentaho.di.kitchenorg.pentaho.di.lineageorg.pentaho.di.panorg.pentaho.di.partitionorg.pentaho.di.pkgorg.pentaho.di.repositoryorg.pentaho.di.resourceorg.pentaho.di.sharedorg.pentaho.di.transorg.pentaho.di.trans.clusterorg.pentaho.di.trans.debugorg.pentaho.di.trans.performanceorg.pentaho.di.trans.steporg.pentaho.di.trans.step.errorhandlingorg.pentaho.di.trans.stepsorg.pentaho.di.trans.steps.abortorg.pentaho.di.trans.steps.accessinputorg.pentaho.di.trans.steps.accessoutputorg.pentaho.di.trans.steps.addsequenceorg.pentaho.di.trans.steps.addxmlorg.pentaho.di.trans.steps.aggregaterowsorg.pentaho.di.trans.steps.analyticqueryorg.pentaho.di.trans.steps.appendorg.pentaho.di.trans.steps.blockingsteporg.pentaho.di.trans.steps.calculatororg.pentaho.di.trans.steps.checksumorg.pentaho.di.trans.steps.cloneroworg.pentaho.di.trans.steps.closureorg.pentaho.di.trans.steps.columnexistsbinationlookuporg.pentaho.di.trans.steps.constantorg.pentaho.di.trans.steps.creditcardvalidatororg.pentaho.di.trans.steps.csvinputorg.pentaho.di.trans.steps.cubeinputorg.pentaho.di.trans.steps.cubeoutputorg.pentaho.di.trans.steps.databasejoinorg.pentaho.di.trans.steps.databaselookuporg.pentaho.di.trans.steps.dbprocorg.pentaho.di.trans.steps.delayorg.pentaho.di.trans.steps.deleteorg.pentaho.di.trans.steps.denormaliserorg.pentaho.di.trans.steps.detectemptystreamorg.pentaho.di.trans.steps.detectlastroworg.pentaho.di.trans.steps.dimensionlookuporg.pentaho.di.trans.steps.dummytransorg.pentaho.di.trans.steps.dynamicsqlroworg.pentaho.di.trans.steps.excelinputorg.pentaho.di.trans.steps.exceloutputorg.pentaho.di.trans.steps.execprocessorg.pentaho.di.trans.steps.execsqlroworg.pentaho.di.trans.steps.fieldsplitterorg.pentaho.di.trans.steps.fileexistsorg.pentaho.di.trans.steps.filesfromresultorg.pentaho.di.trans.steps.filestoresultorg.pentaho.di.trans.steps.filterrowsorg.pentaho.di.trans.steps.fixedinputorg.pentaho.di.trans.steps.flattenerorg.pentaho.di.trans.steps.formulaorg.pentaho.di.trans.steps.getfilesrowscountorg.pentaho.di.trans.steps.getpreviousrowfieldorg.pentaho.di.trans.steps.getvariableorg.pentaho.di.trans.steps.getxmldataorg.pentaho.di.trans.steps.gpbulkloaderorg.pentaho.di.trans.steps.groupbyorg.pentaho.di.trans.steps.httporg.pentaho.di.trans.steps.httppostorg.pentaho.di.trans.steps.ifnullbrightoutputorg.pentaho.di.trans.steps.injectororg.pentaho.di.trans.steps.insertupdate。