raid实验报告

实验四 磁盘阵列实验

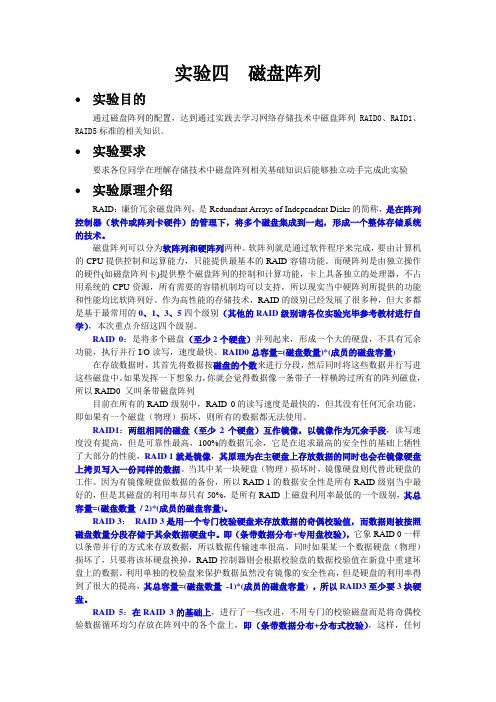

实验四磁盘阵列●实验目的通过磁盘阵列的配置,达到通过实践去学习网络存储技术中磁盘阵列RAID0、RAID1、RAID5标准的相关知识。

●实验要求要求各位同学在理解存储技术中磁盘阵列相关基础知识后能够独立动手完成此实验●实验原理介绍RAID:廉价冗余磁盘阵列,是Redundant Arrays of Independent Disks的简称,是在阵列控制器(软件或阵列卡硬件)的管理下,将多个磁盘集成到一起,形成一个整体存储系统的技术。

磁盘阵列可以分为软阵列和硬阵列两种。

软阵列就是通过软件程序来完成,要由计算机的CPU提供控制和运算能力,只能提供最基本的RAID容错功能。

而硬阵列是由独立操作的硬件(如磁盘阵列卡)提供整个磁盘阵列的控制和计算功能,卡上具备独立的处理器,不占用系统的CPU资源,所有需要的容错机制均可以支持,所以现实当中硬阵列所提供的功能和性能均比软阵列好。

作为高性能的存储技术,RAID的级别已经发展了很多种,但大多都是基于最常用的0、1、3、5四个级别(其他的RAID级别请各位实验完毕参考教材进行自学),本次重点介绍这四个级别。

RAID 0:是将多个磁盘(至少2个硬盘)并列起来,形成一个大的硬盘,不具有冗余功能,执行并行I/O读写,速度最快。

RAID0总容量=(磁盘数量)*(成员的磁盘容量)在存放数据时,其首先将数据按磁盘的个数来进行分段,然后同时将这些数据并行写进这些磁盘中。

如果发挥一下想象力,你就会觉得数据像一条带子一样横跨过所有的阵列磁盘,所以RAID0 又叫条带磁盘阵列目前在所有的RAID级别中,RAID 0的读写速度是最快的,但其没有任何冗余功能,即如果有一个磁盘(物理)损坏,则所有的数据都无法使用。

RAID1:两组相同的磁盘(至少2个硬盘)互作镜像,以镜像作为冗余手段,读写速度没有提高,但是可靠性最高,100%的数据冗余,它是在追求最高的安全性的基础上牺牲了大部分的性能,RAID 1就是镜像,其原理为在主硬盘上存放数据的同时也会在镜像硬盘上拷贝写入一份同样的数据。

raid卡测试报告

研发部测试报告 raid卡功能测试验证文件编号:201912021517产品名称: RAID卡检验类别:研发测试受控状态:受控测试人:测试时间:2019/11/29 -2019/12/03测试地点:研发测试室测试产品:RAID 卡测试数量: 2测试型号及供应商: 9260-8I (SN:SV43882489)、9271-8I(SN:SK73972352)测试项目:质量及性能测试测试依据: 《产品配件入厂检验规范》《产品通用技术要求及交收检验规范》GB/T9813-2000《微型计算机通用规范》一、测试环境二、测试工具restart.sh、restart_write.sh、zftesthdspeed、zftesthdspeedwrite、a.txt、Burnin Test for Linux三、外观检查9260-8I:整体外观无脏污、破损、撞件9271-8I:整体外观无脏污;C2B11电容掉件、C416电容附近变色C2B11掉件:局部变色:整体外观:四、功能测试9271-8I :使用三块硬盘做Raid5;Raid 设置配置为write through 无cache ;安装系统到raid 硬盘组后安装Testhdspeed 、burnin test 进行raid 硬盘组的速度及稳定性测试,测试时间12H读取速度:写入速度:9260-8i:在启动界面及BIOS界面均识别不到raid卡,卡上报警红灯常亮。

五、测试结论9271-8i卡有掉件及过热局部变色现象;I/O速度测试正常,压力12H后稳定无死机、重启现象,此板卡功能性、稳定性均正常,可以正常使用。

9260-8i卡外观无损坏,在超微、Intel、华硕平台均识别不到,为个例不良品。

RHCA课程实验记录——RH436 高级的RAID管理

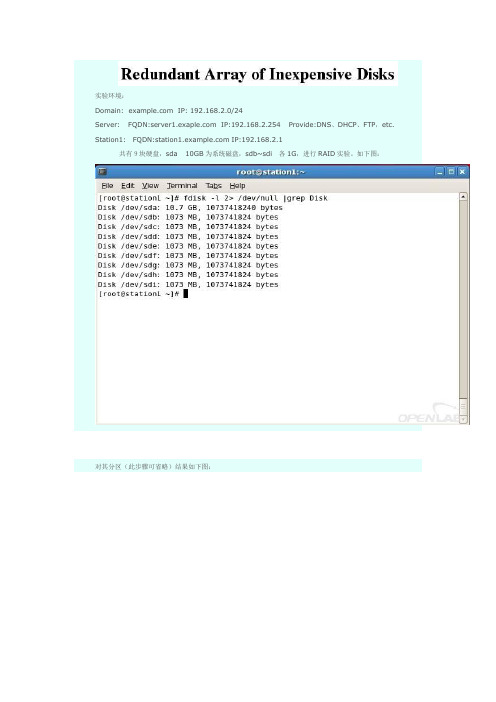

实验环境:Domain: IP: 192.168.2.0/24Server: FQDN: IP:192.168.2.254 Provide:DNS、DHCP、FTP,etc. Station1:FQDN: IP:192.168.2.1共有9块硬盘,sda 10GB为系统磁盘,sdb~sdi各1G,进行RAID实验。

如下图:对其分区(此步骤可省略)结果如下图:Station2:FQDN: IP:192.168.2.2下面的部分实验将会把Station1的RAID硬盘迁移到Station2中组装。

实验一:本地的RAID组装描述:在/etc/mdadm.conf文件损坏或丢失的情况下,并已知原raid的类型及所组成的硬盘名,来进行组装,使其正常运行。

步骤:1st: 首先创建一个RAID5.将sdb1,sdc1,scd1,sdf1组装一个包含一个热备盘的RAID5。

2ed: 使用命令查看RAID的状态。

3rd:生成/etc/mdadm.conf文件。

4th:手动停掉md0,再尝试启动。

成功启动。

5th:再次停掉md0,并将/etc/mdadm.conf改名,尝试启动6th:无法启动,因为已知RAID名为md0,且组成的硬盘为sdb1,sdc1,scd1,sdf1故可进行重新组装。

如下图:查看状态实验成功。

实验二:事件通知。

描述:当RAID出现问题时,发送邮件给指定帐户,这里我们将实验1中的RAID5损坏一块硬盘进行测试。

步骤:1st: 将邮件通知的命令写入/etc/mdadm.conf2ed:强制损坏/dev/sdc1实验成功。

如果RAID没有损坏,也可以测试邮件通知是否成功。

如下图:实验三:在线拉伸RAID。

描述:通常在实际生产环境中,随着数据量的不断增加,原有的RAID设备空间不足,所以要进行扩展,而又要保证服务器的正常运行,所以要在不中断服务器运行的情况下对RAID设备进行在线的拉伸。

同样在实验一的环境下进行,将该RAID5的大小由2GB扩大到3GB。

网络存储实验报告

湖北文理学院《网络存储》实验报告专业班级:计科1211姓名:***学号:***任课教师:李学峰2014年11月16日实验01 Windows 2003的磁盘阵列技术一、实验目的1.掌握在Windows 2003环境下做磁盘阵列的条件和方法。

2.掌握在Windows 2003环境下实现RAID0的方法。

3. 掌握在Windows 2003环境下实现RAID1的方法。

4. 掌握在Windows 2003环境下实现RAID5的方法。

5. 掌握在Windows 2003环境下实现恢复磁盘阵列数据的方法。

二、实验要求1.在Windows 2003环境下实现RAID02.在Windows 2003环境下实现RAID13.在Windows 2003环境下实现RAID54.在Windows 2003环境下实现恢复磁盘阵列数据三、实验原理(一)磁盘阵列RAID技术的概述RAID是一种磁盘容错技术,由两块以上的硬盘构成冗余,当某一块硬盘出现物理损坏时,换一块同型号的硬盘即可自行恢复数据。

RAID有RAID0、RAID1、RAID5等。

RAID 技术是要有硬件来支持的,即常说的RAID卡,如果没RAID卡或RAID芯片,还想做RAID,那就要使用软件RAID技术,微软Windows系统只有服务器版本才支持软件RAID技术,如Windows Server 2003等。

(二)带区卷(RAID0)带区卷是将多个(2-32个)物理磁盘上的容量相同的空余空间组合成一个卷。

需要注意的是,带区卷中的所有成员,其容量必须相同,而且是来自不同的物理磁盘。

带区卷是Windows 2003所有磁盘管理功能中,运行速度最快的卷,但带区卷不具有扩展容量的功能。

它在保存数据时将所有的数据按照64KB分成一块,这些大小为64KB的数据块被分散存放于组成带区卷的各个硬盘中。

(三)镜像卷(RAID1)镜像卷是单一卷的两份相同的拷贝,每一份在一个硬盘上。

数据队列实验报告总结(3篇)

第1篇一、实验背景数据结构是计算机科学中一个重要的基础学科,其中队列作为一种常用的数据结构,在计算机科学和实际应用中具有广泛的应用。

队列是一种先进先出(FIFO)的线性表,它允许在表的一端进行插入操作,在另一端进行删除操作。

本实验旨在通过实现队列的基本操作,加深对队列数据结构概念和特性的理解,并掌握其在实际应用中的运用。

二、实验目的1. 理解队列数据结构的概念和特性。

2. 掌握队列的存储结构,包括顺序存储和链式存储。

3. 熟悉队列的基本操作,如入队、出队、队列长度、队列状态判断等。

4. 通过实际编程,提高数据结构应用能力。

三、实验内容1. 队列的顺序存储结构实现:- 定义队列结构体,包含队列长度、队列最大长度、队列首尾指针等。

- 实现队列的初始化、入队、出队、判断队列是否为空、判断队列是否已满等操作。

2. 队列的链式存储结构实现:- 定义队列节点结构体,包含队列数据、指针等。

- 实现队列的初始化、入队、出队、判断队列是否为空、判断队列是否已满等操作。

3. 队列的实际应用:- 使用队列实现广度优先搜索(BFS)算法。

- 使用队列实现单链表反转。

- 使用队列实现表达式求值。

四、实验步骤1. 创建队列结构体,定义队列的基本属性和操作函数。

2. 实现队列的顺序存储结构,包括队列的初始化、入队、出队、判断队列是否为空、判断队列是否已满等操作。

3. 实现队列的链式存储结构,包括队列的初始化、入队、出队、判断队列是否为空、判断队列是否已满等操作。

4. 通过实际编程,验证队列的基本操作是否正确。

5. 使用队列实现实际应用,验证队列在解决问题中的应用价值。

五、实验结果与分析1. 顺序存储结构实现:- 队列的初始化、入队、出队、判断队列是否为空、判断队列是否已满等操作均能正常进行。

- 队列的顺序存储结构在插入和删除操作时,需要移动队列中的元素,因此时间复杂度为O(n)。

2. 链式存储结构实现:- 队列的初始化、入队、出队、判断队列是否为空、判断队列是否已满等操作均能正常进行。

RAID实验的结果分析和实验未完成事项以及收获和感想

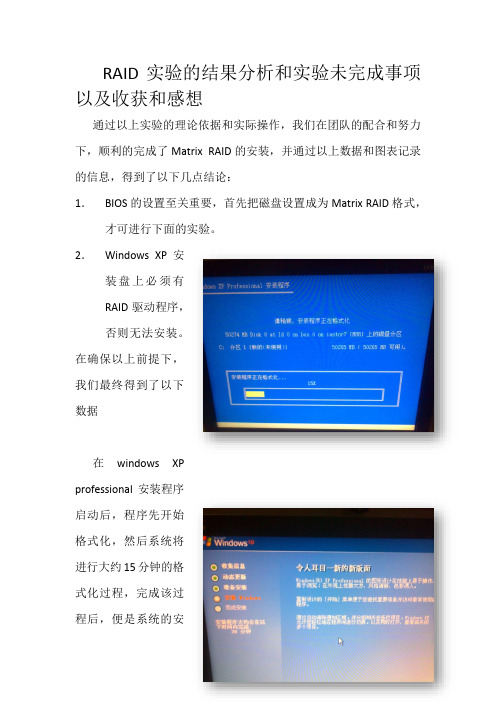

RAID实验的结果分析和实验未完成事项以及收获和感想通过以上实验的理论依据和实际操作,我们在团队的配合和努力下,顺利的完成了Matrix RAID的安装,并通过以上数据和图表记录的信息,得到了以下几点结论:1.BIOS的设置至关重要,首先把磁盘设置成为Matrix RAID格式,才可进行下面的实验。

2.Windows XP安装盘上必须有RAID驱动程序,否则无法安装。

在确保以上前提下,我们最终得到了以下数据在windows XPprofessional安装程序启动后,程序先开始格式化,然后系统将进行大约15分钟的格式化过程,完成该过程后,便是系统的安装读取过程,该过程中我们组做的比较顺利,该过程之后,便是xp系统的正式安装,如图1-2所示,在五步中,系统的安装花时间较长,约10分钟左右,之后,完成者五步便完成了基本的安装,下面需要对xp系统进行优化。

完成一系列的安装之后,重启电脑,便可以顺利的进入xp系统。

之后需要对RAID进行测试,测试结果如图1-3 1-4所示测试一从图中的数据中,我们可以看出,随机访问是11.9ms,CPU的占用率是0%,平均读盘速度是111.1MB/s,突发传输速度是227.2MB/s。

与普通的想比较我们可以看到,平均读盘比普通高56MB/S.超出一倍。

突发速度比普通高99MB/s,超出88%左右。

可以明显的看出,该模式优于普通模式。

测试二从该表我们可以看到,随机访问的时间是15.4ms,平均传输是55.3MB/s突发传输速度是128.6MB/s。

测试三从该图中我们可以看出,平均读取时间17ms cpu使用率o%,平均读取速度65.9MB/s,突发速度为136.5Mb/s。

比普通的大2mb/s。

可见效果佳于普通。

以上几组测试都说明了RAID模式下的优越性。

可以明显的感觉到速度的提升。

完成该实验重要点在于1、BIOS设置2、Intel Matrix Storage Manager Option ROM设置3、盘上是否有RAID驱动程序4、Matrix RAID 性能测试实验需要团队的配合和分工,也需要很好的耐心和信心。

实验5-RAID实验-实验报告

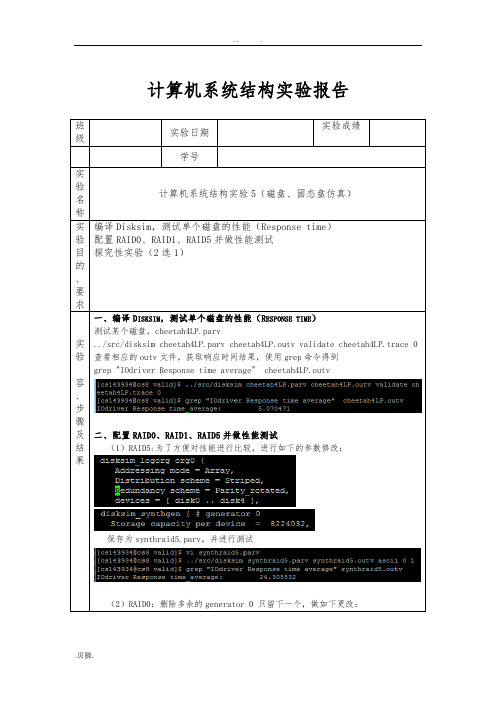

计算机系统结构实验报告班级实验日期实验成绩学号实验名称计算机系统结构实验5(磁盘、固态盘仿真)实验目的、要求编译Disksim,测试单个磁盘的性能(Response time)配置RAID0、RAID1、RAID5并做性能测试探究性实验(2选1)实验容、步骤及结果一、编译D ISKSIM,测试单个磁盘的性能(R ESPONSE TIME)测试某个磁盘,cheetah4LP.parv../src/disksim cheetah4LP.parv cheetah4LP.outv validate cheetah4LP.trace 0 查看相应的outv文件,获取响应时间结果,使用grep命令得到grep "IOdriver Response time average" cheetah4LP.outv二、配置RAID0、RAID1、RAID5并做性能测试(1)RAID5:为了方便对性能进行比较,进行如下的参数修改:保存为synthraid5.parv,并进行测试(2)RAID0:删除多余的generator 0 只留下一个,做如下更改:保存为synthraid0.parv,并进行测试(3)RAID1:删除多余的generator 0 只留下一个,做如下更改:保存为synthraid1.parv,并进行测试结论:通过测试我们可以发现在有效存储容量相同的情况下,RAID0使用的时间最少,速度最快。

三、探究性实验(2选1)设计实验,任意选择其中一种RAID模式,分析验证其参数敏感性参数包括盘数,条带大小。

◎敏感性指:给定负载,其性能是否会随着参数变化而剧烈变化?◎看上去完全没变化?注意负载强度是否足够。

这里我们选择RAID5模式进行测试。

(1)条带大小一定,磁盘数改变此时(Stripe unit = 64,Parity stripe unit = 64)磁盘个数7个8个9个10个11个设备有效容量12336048 14392056 16448064 18504072 20560080 Synthetic结21.657719 20.865686 20.332438 19.923599 19.728367果2014.436976 1355.984474 1019.857911 882.827067 676.563854 Financial结果从一二两幅图中我们可以看到性能受磁盘个个数影响明显,对参数磁盘个数敏感,随着磁盘个数的增加,花费的时间减少。

实验1存储设备的安装和基本调试

6.在服务器上安装iscis initiator软件。

7.配置iscis initiator软件使服务器和存储设备正常工作。

8.通过windows的磁盘管理功能查找外部存储设备并测试。

四、实验体会与小结

五、教师评语。(优/良/中/及格/差)

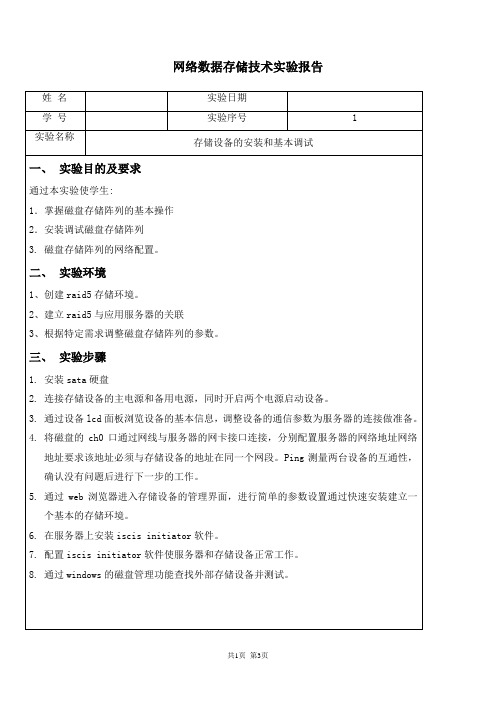

网络数据存储技术实验报告

姓 名

实验日期

学 号

实验序号

1

实验名称

存储设备的安装和基本调试

一、实验目的及要求

通过本实验使学生:

1.掌握磁盘存储阵列的基本操作

2.安装调试磁盘存储阵列

3. 磁盘存储阵列的网络配置。

二、实验环境

1、创建raid5存储环境。

2、建立raid5与应用服务器的关联

3、根据特定需求调整磁盘存储阵列的参数。

三、实验步骤

1.安装sata硬盘

2.连接存储设备的主电源和备用电源,同时开启两个电源启动设备。

3.通过设备lcd面板浏览设备的基本信息,调整设备的通信参数为服务器的连接做准备。

4.将磁盘的ch0口通过网线与服务器的网卡接口连接,分别配置服务器的网络地址网络地址要求该地址必须与存储设备的地址在同一个网段。Ping测量两台设备的互通性,确认没有问题后进行下一步的工作。

indows VM中RAID5的创建实训报告

indows VM中RAID5的创建实训报告一、【实验目的】(1)学会在windows和Linux环境下构建软件RAID环境,并且实现RAID1和RAID5。

(2)比较理解RAID1和RAID5的异同,深刻掌握不同RAID的性能比较。

二、【实验设备】Windows Server2016系统、Linux三、【实验要求】学会在Windows server系统下创建RAID环境,掌握用命令行在Linux系统下创建RAID环境。

四、【实验步骤】(一)在Windows server系统下创建RAID环境,并实现RAID1和RAID5。

首先建立五个5g的磁盘。

打开虚拟机设置。

硬件——设备——硬盘——添加选择SCSI。

创建新虚拟磁盘。

磁盘大小设为5g,选择将虚拟磁盘存储为单个文件。

选择一个合适的地方存储,命名为experience Windows Server 2016-0这样就完成了一个磁盘的建立,接下来再按照上述方法创建四个。

打开磁盘管理,发现这五个磁盘属于脱机状态。

右键——联机再次右键——初始化磁盘。

这时就可以建立卷了。

除了这样直接用之外,还可以输入命令让磁盘脱机和清除磁盘属性。

打开cmd,进入diskpart界面,list disk 表示查看磁盘状态,select disk 2表示选择磁盘2进行操作,online disk表示使磁盘2联机,attr disk clear readonly表示删除磁盘属性。

这样设置完再进入磁盘管理,会自动弹出弹窗,让你进行初始化。

我们直接点击确认即可。

右键选择磁盘0——新建镜像卷。

(要注意此时要有两个已经初始化好的磁盘才可以建立镜像卷,因为RAID 1最少要两个磁盘。

从左边再选择一个磁盘,这样右边就有两个,符合建立RAID1的标准。

随便选一个磁盘驱动器号。

命名为RAID1,并且勾选快速格式化。

成功创建。

接下来创建RAID5,首先要有三个初始化好的磁盘,因为RAID5的建立至少要3个磁盘。

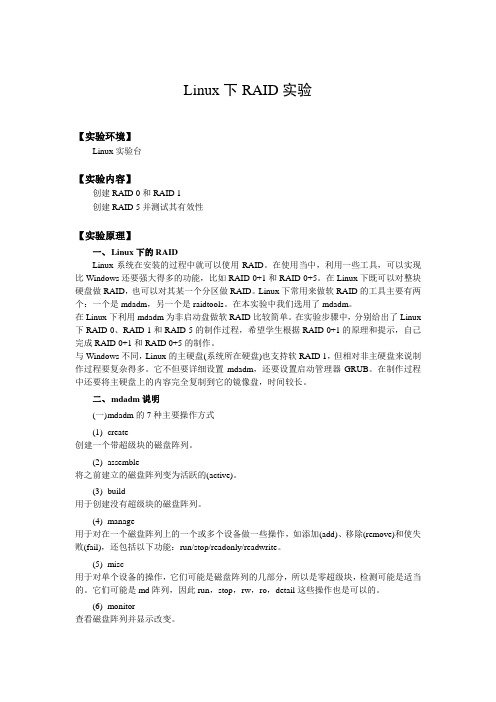

Linux下RAID实验

Linux下RAID实验【实验环境】Linux实验台【实验内容】创建RAID 0和RAID 1创建RAID 5并测试其有效性【实验原理】一、Linux下的RAIDLinux系统在安装的过程中就可以使用RAID。

在使用当中,利用一些工具,可以实现比Windows还要强大得多的功能,比如RAID 0+1和RAID 0+5。

在Linux下既可以对整块硬盘做RAID,也可以对其某一个分区做RAID。

Linux下常用来做软RAID的工具主要有两个:一个是mdadm,另一个是raidtools。

在本实验中我们选用了mdadm。

在Linux下利用mdadm为非启动盘做软RAID比较简单。

在实验步骤中,分别给出了Linux 下RAID 0、RAID 1和RAID 5的制作过程,希望学生根据RAID 0+1的原理和提示,自己完成RAID 0+1和RAID 0+5的制作。

与Windows不同,Linux的主硬盘(系统所在硬盘)也支持软RAID 1,但相对非主硬盘来说制作过程要复杂得多。

它不但要详细设置mdadm,还要设置启动管理器GRUB。

在制作过程中还要将主硬盘上的内容完全复制到它的镜像盘,时间较长。

二、mdadm说明(一)m dadm的7种主要操作方式(1)create创建一个带超级块的磁盘阵列。

(2)assemble将之前建立的磁盘阵列变为活跃的(active)。

(3)build用于创建没有超级块的磁盘阵列。

(4)manage用于对在一个磁盘阵列上的一个或多个设备做一些操作,如添加(add)、移除(remove)和使失败(fail),还包括以下功能:run/stop/readonly/readwrite。

(5)misc用于对单个设备的操作,它们可能是磁盘阵列的几部分,所以是零超级块,检测可能是适当的。

它们可能是md阵列,因此run,stop,rw,ro,detail这些操作也是可以的。

(6)monitor查看磁盘阵列并显示改变。

Lniux文件系统实验报告

实验五文件系统

一、实验目的

1.掌握Linux系统下fdisk命令的用法。

2.掌握Linux系统下文件系统的创建、挂载与卸载。

3.掌握Linux系统下利用RAID技术实现磁盘冗余阵列的方法。

二、实验内容

1.磁盘分区管理

2.动态磁盘管理

三、实验指导

1.服务器现需要新建一块20GB的硬盘,需要对新增的硬盘进行分区管理、分区方案为/user目录所在分区10GB,/backup目录所在分区5GB,/home目录所在分区5GB。

步骤一,添加新硬盘

点击“编辑虚拟机设置”按钮,如下图

选择添加硬盘,如下图

下一步选择“SCSI(S)推荐”,如下图

下一步创建“新虚拟磁盘”,设置磁盘空间大小为“20GB”,如下图所示

单击完成,即完成了新硬盘的添加,如下图所示

通过fdisk -l命令查看新硬盘是否添加成功

步骤二,利用fdisk命令对/dev/sdb/进行分区

步骤三,格式化新建分区,在各分区上建立ext3类型的文件的系统,建立时要求检查磁盘坏块并显示详细信息。

步骤四,将/dev/sdb1挂载到/user目录,/dev/sdb2挂载到

/backup目录,/dev/sdb3挂载到/home目录

2、某公司的Linux服务器新增两块硬盘,硬盘大小为40GB。

为了实现数据保护功能,现需利用2块硬盘创建RAID1卷。

要求创建的RAID设备名为/dev/md110,并利用mkfs命令创建ext3文件系统。

最后将文件系统挂载到系统上。

四、实验总结

通过本次实验,我学习到fdisk 的一些命令和在Linux 系统下利用RAID 技术实现磁盘冗余阵列的方法。

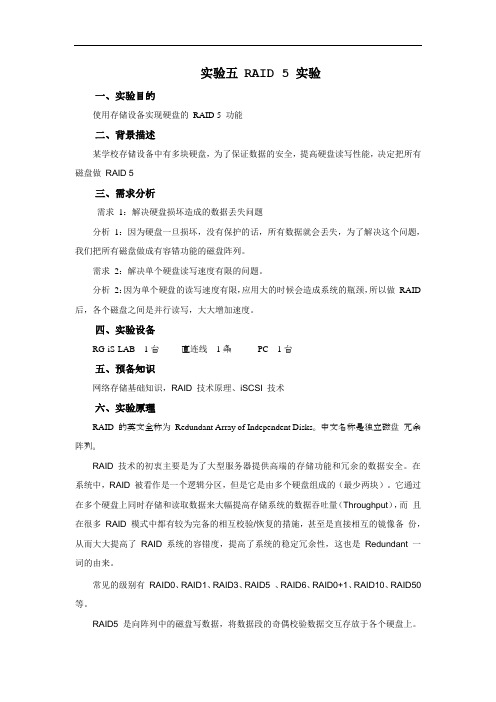

RAID 实验

实验五RAID 5实验一、实验目的使用存储设备实现硬盘的RAID 5 功能二、背景描述某学校存储设备中有多块硬盘,为了保证数据的安全,提高硬盘读写性能,决定把所有磁盘做RAID 5三、需求分析需求1:解决硬盘损坏造成的数据丢失问题分析1:因为硬盘一旦损坏,没有保护的话,所有数据就会丢失,为了解决这个问题,我们把所有磁盘做成有容错功能的磁盘阵列。

需求2:解决单个硬盘读写速度有限的问题。

分析2:因为单个硬盘的读写速度有限,应用大的时候会造成系统的瓶颈,所以做RAID 后,各个磁盘之间是并行读写,大大增加速度。

四、实验设备RG-iS-LAB 1台直连线1条PC 1台五、预备知识网络存储基础知识,RAID技术原理、iSCSI技术六、实验原理RAID 的英文全称为Redundant Array of Independent Disks。

中文名称是独立磁盘冗余阵列。

RAID 技术的初衷主要是为了大型服务器提供高端的存储功能和冗余的数据安全。

在系统中,RAID被看作是一个逻辑分区,但是它是由多个硬盘组成的(最少两块)。

它通过在多个硬盘上同时存储和读取数据来大幅提高存储系统的数据吞吐量(Throughput),而且在很多RAID模式中都有较为完备的相互校验/恢复的措施,甚至是直接相互的镜像备份,从而大大提高了RAID系统的容错度,提高了系统的稳定冗余性,这也是Redundant一词的由来。

常见的级别有RAID0、RAID1、RAID3、RAID5、RAID6、RAID0+1、RAID10、RAID50等。

RAID5 是向阵列中的磁盘写数据,将数据段的奇偶校验数据交互存放于各个硬盘上。

任何一个硬盘损坏,都可以根据其它硬盘上的校验位来重建损坏的数据。

RAID 5一个阵列中至少需要三个物理驱动器,硬盘的利用率为n-1/n。

性价比最高,如图5-1所示RAID 5 磁盘阵列+。

七、实验步骤可以直接使用RG-iS-LAB中的硬盘进行RAID,也可以在RG-iS-LAB上划分几块存储空间给PC,用PC来实现,空间划分方法见《IP SAN实验》。

raid实验报告

课程实验报告课程名称:计算机组成原理专业班级:计算机科学与技术1107班学号:姓名:指导老师:报告日期: 2013-11-2计算机科学与技术学目录【实验环境】 (1)【实验内容】 (1)【实验原理】 (1)【实验步骤】 (3)(1)创建RAID 0 (5)Raid0的速度测试 (9)创建RAID 1 (10)Raid1的使用 (13)Raid1的速度测试 (14)Raid1故障测试: (16)创建RAID 5 (19)Raid5的使用 (21)Raid5的速度测试 (22)RAID5故障测试 (24)Raid阵列速度的说明。

(31)【实验思考】 (32)Raid0+1 (32)查看raid (33)速度测试 (34)Raid0+5 (34)查看Raid0+5信息 (35)Raid0+5速度测试 (36)实验体会 (36)【实验环境】Linux虚拟机【实验内容】创建RAID 0和RAID 1创建RAID 5并测试其有效性【实验原理】一、Linux下的RAIDLinux系统在安装的过程中就可以使用RAID。

在使用当中,利用一些工具,可以实现比Windows还要强大得多的功能,比如RAID 0+1和RAID 0+5。

在Linux 下既可以对整块硬盘做RAID,也可以对其某一个分区做RAID。

Linux下常用来做软RAID的工具主要有两个:一个是mdadm,另一个是raidtools。

在本实验中我选用了mdadm。

在Linux下利用mdadm为非启动盘做软RAID比较简单。

在实验步骤中,分别给出了Linux下RAID 0、RAID 1和RAID 5的制作过程。

RAID0:RAID0并不是真正的RAID结构,没有数据冗余,RAID0连续地分割数据并并行地读/写于多个磁盘上。

因此具有很高的数据传输率,但RAID0在提高性能的同时,并没有提供数据可靠性,如果一个磁盘失效,将影响整个数据。

因此RAID0不可应用于需要数据高可用性的关键应用。

RAID1+LVM实验

RAID1+LVM实验目录一、LVM基本术语 (2)二、创建Raid1+LVM系统 (4)1. 硬盘创建Raid分区 (4)2. 分别创建RAID1级别设备 (5)3. 创建基于LVM的逻辑磁盘分区结构 (7)4. 最终划分好的系统分区结构 (9)三、安装LVM (10)四、创建和管理LVM (11)1、创建LVM类型分区 (11)2、创建物理卷PV (14)3、创建卷组VG (15)4、创建逻辑卷 (17)5、格式化 (19)6、挂载LVM (19)五、扩展卷组大小 (20)六、从卷组中删除物理卷 (24)七、扩展逻辑卷的大小 (24)八、删除LVM (26)一、LVM基本术语LVM是在磁盘分区和文件系统之间添加的一个逻辑层,来为文件系统屏蔽下层磁盘分区布局,提供一个抽象的盘卷,在盘卷上建立文件系统。

管理员利用LVM 可以在磁盘不用重新分区的情况下动态调整文件系统的大小,并且利用LVM管理的文件系统可以跨越磁盘,当服务器添加了新的磁盘后,管理员不必将原有的文件移动到新的磁盘上,而是通过LVM可以直接扩展文件系统跨越磁盘。

首先讨论以下几个LVM术语:物理存储介质(The physical media)这里指系统的存储设备:硬盘,如:/dev/hda、/dev/sda等等,是存储系统最低层的存储单元。

●物理卷(physical volume)物理卷就是指硬盘分区或从逻辑上与磁盘分区具有同样功能的设备(如RAID),是LVM的基本存储逻辑块,但和基本的物理存储介质(如分区、磁盘等)比较,却包含有与LVM相关的管理参数●卷组(Volume Group)LVM卷组类似于非LVM系统中的物理硬盘,其由物理卷组成。

可以在卷组上创建一个或多个“LVM分区”(逻辑卷),LVM卷组由一个或多个物理卷组成。

●逻辑卷(logical volume)LVM的逻辑卷类似于非LVM系统中的硬盘分区,在逻辑卷之上可以建立文件系统(比如/home或者/usr等)。

实现RAID0、1、5 实验报告

实现RAID0、1、5 实验报告班级:10网工三班学生姓名:谢昊天学号:1215134046实验目的:1.掌握软RAID的配置方法。

2.掌握RAID0、1、5的配置过程。

3.掌握RAID1、5数据恢复方法。

实验要求:1.实验中仔细观察、记录、比较实验结果,如果不一致应找出原因。

2.实验中凡是需要命名的地方,均以自己名字的全拼来命名,可以用不同后缀来区分。

如张三的两台服务器可以命名为:zhangsanS1,zhangsanS2。

实验内容:1、在VMware中创建一台Windows Server。

2、将该Server添加3块虚拟磁盘。

3、格式化新添加的3块磁盘。

4、在新磁盘上分别配置RAID0 、1、5,对应驱动器号分别为E、F、G。

5、在以上三个卷中分别建立不同的文件。

6、关闭Server,去掉所添加硬盘中的第一块。

7、开启Server,查看E、F、G还能否访问。

8、关闭Server,重新添加一块新磁盘,并使用其恢复RAID1和RAID5。

实验步骤与实验过程:1、首先在VMware中创建出一台Windows Server,将Server添加3块虚拟磁盘,然后打开虚拟机格式化添加的3块磁盘,在新磁盘上分别配置为RAID0 、1、5,对应驱动器号分别为E、F、G,并在以上三个卷中分别建立出不同的文件。

2、关闭Server,去掉添加硬盘中的第一块,开启Server,查看E、F、G是否还能否访问。

3、关闭Server,重新添加一块新的磁盘,并恢复RAID1和RAID5。

实验结果:1、配置了成功RAID0、1、5,并将名为Inetpub、Program Files、web的三个文件分别加入到E、F、G三个磁盘。

2、去掉所添加硬盘中的第一块后,打开虚拟机后只剩下新建的F盘,并且可以访问F盘的文件Program Files3、去掉所添加硬盘中的第一块后,E、F、G在磁盘管理中都显示失败,修复磁盘RAID1、5后显示状态良好,并且可以访问F、G盘的文件Program Files、web。

磁盘阵列实验报告

磁盘阵列实验报告1. 引言磁盘阵列是一种由多个硬盘组成的存储系统,通过组合多个硬盘的存储容量和性能,提供了更高的数据可靠性和读写速度。

在本次实验中,我们搭建了一个磁盘阵列系统,进行了性能测试,并对其性能进行了评估和分析。

2. 实验目的本次实验的主要目的包括:1. 掌握磁盘阵列的组建和配置方法;2. 测试磁盘阵列的读写性能,并分析其性能表现;3. 评估磁盘阵列在不同工作负载下的性能表现。

3. 实验环境本次实验的实验环境如下:- CPU:Intel Core i7-9700K;- 内存:16GB DDR4;- 硬盘:8块SATA硬盘(容量为2TB,转速为7200RPM);- 操作系统:Ubuntu Linux 20.04.1 LTS。

4. 磁盘阵列配置在实验中,我们选择了一种常见的磁盘阵列配置方式:RAID 0。

RAID 0使用条带化(striping)的方式将数据均匀分布在多个硬盘上,从而提高了读写性能。

然而,由于数据没有冗余备份,RAID 0无法实现数据的冗余和容错。

我们通过软件配置方式实现了RAID 0。

首先,我们使用Linux提供的`mdadm`工具将物理硬盘建立为RAID设备,然后进行格式化和挂载。

5. 性能测试与分析我们对磁盘阵列进行了一系列性能测试,包括顺序读写、随机读写以及不同读写负载下的性能测试。

5.1 顺序读写性能测试在顺序读写性能测试中,我们使用了`dd`命令进行测试。

对于顺序读测试,我们从磁盘阵列中读取了一个大文件,并计算了读取速度。

对于顺序写测试,我们向磁盘阵列中写入一个大文件,并计算了写入速度。

5.2 随机读写性能测试在随机读写性能测试中,我们使用了`fio`工具进行测试。

我们设置了一系列随机读写的负载,包括不同的队列深度和线程数,并分别测试了随机读和随机写的性能。

通过分析测试结果,我们评估了磁盘阵列在不同负载下的性能表现。

5.3 不同读写负载下的性能测试在不同读写负载下的性能测试中,我们使用了`iozone`工具进行测试。

计算机系统结构实验报告-存储系统RAID 性能测试

计算机系统结构实验报告班级:xxxxxxxxxxxxxxxx 姓名:xxxxxx 学号:2xxxxxxxxxxxxxx 报告完成时间:20xxxxxxxx计算机系统结构实验报告班级xxxxxxx 实验日期xxxxxxxxx 实验成绩姓名xxxxxxxxxx 学号xxxxxxxxxxxx实验名称存储系统RAID 性能测试实验目的、要求及器材实验目的与要求:①掌握RAID0-5的基本组织方式和特点②RAID0,1,5配置与简单测试;③探究RAID的小写性能或参数敏感性实验器材:虚拟LINUX环境Ubuntu;d isksim-4.0;计算机一台。

实验内容、步骤及结果1.编译Disksim①通过邮件将disksim-4.0.tar.gz和ssd-add-on.zip传送至Ubuntu。

②Tar -vxzf disksim-4.0.tar.gz③在disksim-4.0中编译 make④Unzip ../ssd-add-on.zip⑤patch -p1 < ssdmodel/ssd-patch⑥在Ssdmodel中make⑦进入valid,chmod a+x runvalidOK now!在disksim-4.0中的valid或者ssdmodel/valid 中执行./runvalid即可得到所有文件的测试结果2.修改parv内logorg,模拟RAID0有效盘数设为5Raid0.parv中参数设置如下# component instantiationinstantiate [ statfoo ] as Statsinstantiate [ ctlr0 .. ctlr4 ] as CTLR0instantiate [ bus0 ] as BUS0instantiate [ disk0 .. disk4 ] as HP_C3323Ainstantiate [ driver0 ] as DRIVER0instantiate [ bus1 .. bus5 ] as BUS1# end of component instantiation# system topology[设为5个盘并行的拓扑结构]设置冗余模式、编址模式、分配策略等:disksim_logorg org0 {Addressing mode = Array,Distribution scheme = Striped,Redundancy scheme = Noredun,devices = [ disk0 .. disk4 ],Stripe unit = 64,……}设置随机概率Probability of sequential access = 0.2,Probability of local access = 0.4,Probability of read access = 0.66,Probability of time-critical request = 0.1,Probability of time-limited request = 0.3,存储器总容量为Storage capacity per device = 2056008*5 = 10280040,接下来便可进行虚拟测试../src/disksim raid0.parv raid0.txt ascii 0 1打开raid0.txt查看测试结果:Overall I/O System Total Requests handled: 10002Overall I/O System Requests per second: 100.928186Overall I/O System Completely idle time: 11953.034363 0.120616Overall I/O System Response time average: 24.486686Overall I/O System Response time std.dev.: 13.542895Overall I/O System Response time maximum: 137.672973Overall I/O System Response time distribution< 5 < 10 < 20 < 40 < 60 < 90 <120 <150 <200 200+ 196 332 3551 4960 690 220 44 9 0 0可见raid0 组织模式的I/O系统平均响应时间为24.486686 ms3.修改parv内logorg,模拟RAID1有效盘数设为4Raid1.parv中参数设置如下# component instantiationinstantiate [ statfoo ] as Statsinstantiate [ ctlr0 .. ctlr7 ] as CTLR0instantiate [ bus0 ] as BUS0instantiate [ disk0 .. disk7 ] as HP_C3323Ainstantiate [ driver0 ] as DRIVER0instantiate [ bus1 .. bus8 ] as BUS1# end of component instantiation# system topology[设为8个盘并行的拓扑结构]冗余模式设为Redundancy scheme = Shadowed,存储容量 Storage capacity per device = 8224032,其余设置同raid0接下来进行虚拟测试../src/disksim raid1.parv raid1.txt ascii 0 1打开raid1.txt查看测试结果:OVERALL I/O SYSTEM STATISTICS-----------------------------Overall I/O System Total Requests handled: 9999Overall I/O System Requests per second: 100.452735Overall I/O System Completely idle time: 12533.813298 0.125918Overall I/O System Response time average: 23.141863Overall I/O System Response time std.dev.: 11.234684Overall I/O System Response time maximum: 136.662648Overall I/O System Response time distribution< 5 < 10 < 20 < 40 < 60 < 90 <120 <150 <200 200+ 185 255 3912 4958 553 114 21 1 0 0可见raid1 组织模式的I/O系统平均响应时间为23.141863 ms4.修改parv内logorg,模拟RAID5有效盘数设为4Raid0.parv中参数设置如下# component instantiationinstantiate [ statfoo ] as Statsinstantiate [ ctlr0 .. ctlr4 ] as CTLR0instantiate [ bus0 ] as BUS0instantiate [ disk0 .. disk4 ] as HP_C3323Ainstantiate [ driver0 ] as DRIVER0instantiate [ bus1 .. bus5 ] as BUS1# end of component instantiation# system topology[设为5个盘并行的拓扑结构]冗余模式设为Redundancy scheme = Parity_rotated,存储容量 Storage capacity per device = 8224032,其余设置同raid0接下来进行虚拟测试../src/disksim raid5.parv raid5.txt ascii 0 1打开raid5.txt查看测试结果:OVERALL I/O SYSTEM STATISTICS-----------------------------Overall I/O System Total Requests handled: 10001Overall I/O System Requests per second: 100.494066Overall I/O System Completely idle time: 6.907489 0.000069Overall I/O System Response time average: 56.222291Overall I/O System Response time std.dev.: 49.033242Overall I/O System Response time maximum: 480.847859Overall I/O System Response time distribution< 5 < 10 < 20 < 40 < 60 < 90 <120 <150 <200 200+ 109 164 1496 3273 1722 1503 752 439 324 219可见raid5 组织模式的I/O系统平均响应时间为56.222291 ms5.探究性试验设计实验,任意选择其中一种RAID模式,分析验证其参数敏感性参数包括盘数,条带大小敏感性指,给定负载,其性能是否会随着参数变化而剧烈变化本实验采用ssdmodel执行,期间同时加载了<tracefile> 和<synthgen>发现得到的结果反而相差不大,所以后来只加载了ssd-postmark-aligned2.trace。

磁盘寻道实验报告(3篇)

第1篇一、实验目的1. 理解磁盘的工作原理和结构,了解磁盘寻道的基本概念。

2. 掌握常用的磁盘寻道算法,如先来先服务(FCFS)、最短寻道时间优先(SSTF)、SCAN和循环SCAN算法。

3. 比较不同磁盘寻道算法的性能,分析其优缺点。

4. 提高对操作系统磁盘管理模块的理解。

二、实验内容1. 磁盘结构及工作原理2. 磁盘寻道算法a. 先来先服务(FCFS)算法b. 最短寻道时间优先(SSTF)算法c. SCAN算法d. 循环SCAN算法3. 实验数据及结果分析三、实验步骤1. 磁盘结构及工作原理(1)观察实验所提供的磁盘,了解其结构及工作原理。

(2)记录磁盘的转速、平均寻道时间、磁盘传输速率等参数。

2. 磁盘寻道算法(1)编写程序模拟FCFS算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

(2)编写程序模拟SSTF算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

(3)编写程序模拟SCAN算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

(4)编写程序模拟循环SCAN算法,输入一组磁盘请求,输出磁头移动轨迹及磁头移动距离。

3. 实验数据及结果分析(1)收集实验数据,包括不同磁盘寻道算法的磁头移动轨迹及磁头移动距离。

(2)比较不同磁盘寻道算法的性能,分析其优缺点。

(3)根据实验结果,得出结论。

四、实验结果与分析1. FCFS算法FCFS算法是一种简单的磁盘寻道算法,按照请求顺序服务磁盘请求。

该算法的优点是实现简单,缺点是效率较低,容易产生“饥饿现象”。

2. SSTF算法SSTF算法优先处理距离磁头最近的磁盘请求,以减少磁头移动距离。

该算法的优点是寻道时间较短,缺点是可能会造成某些请求长时间得不到服务。

3. SCAN算法SCAN算法按照磁道顺序移动磁头,当磁头到达磁盘的另一端时,反向移动。

该算法的优点是寻道时间较短,且公平性较好,缺点是可能会产生“振荡现象”。

4. 循环SCAN算法循环SCAN算法是SCAN算法的一种改进,当磁头到达磁盘的另一端时,不再反向移动,而是继续按照磁道顺序移动。

RAID1,RAID5,SSD读写性能测试结果1(实测)

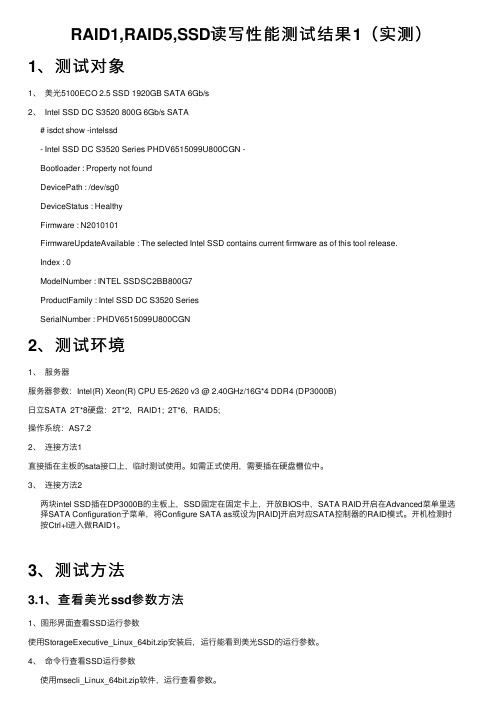

RAID1,RAID5,SSD读写性能测试结果1(实测)1、测试对象1、美光5100ECO 2.5 SSD 1920GB SATA 6Gb/s2、 Intel SSD DC S3520 800G 6Gb/s SATA# isdct show -intelssd- Intel SSD DC S3520 Series PHDV6515099U800CGN -Bootloader : Property not foundDevicePath : /dev/sg0DeviceStatus : HealthyFirmware : N2010101FirmwareUpdateAvailable : The selected Intel SSD contains current firmware as of this tool release.Index : 0ModelNumber : INTEL SSDSC2BB800G7ProductFamily : Intel SSD DC S3520 SeriesSerialNumber : PHDV6515099U800CGN2、测试环境1、服务器服务器参数:Intel(R) Xeon(R) CPU E5-2620 v3 @ 2.40GHz/16G*4 DDR4 (DP3000B)⽇⽴SATA 2T*8硬盘:2T*2,RAID1; 2T*6,RAID5;操作系统:AS7.22、连接⽅法1直接插在主板的sata接⼝上,临时测试使⽤。

如需正式使⽤,需要插在硬盘槽位中。

3、连接⽅法2两块intel SSD插在DP3000B的主板上,SSD固定在固定卡上,开放BIOS中,SATA RAID开启在Advanced菜单⾥选择SATA Configuration⼦菜单,将Configure SATA as或设为[RAID]开启对应SATA控制器的RAID模式。

开机检测时按Ctrl+I进⼊做RAID1。

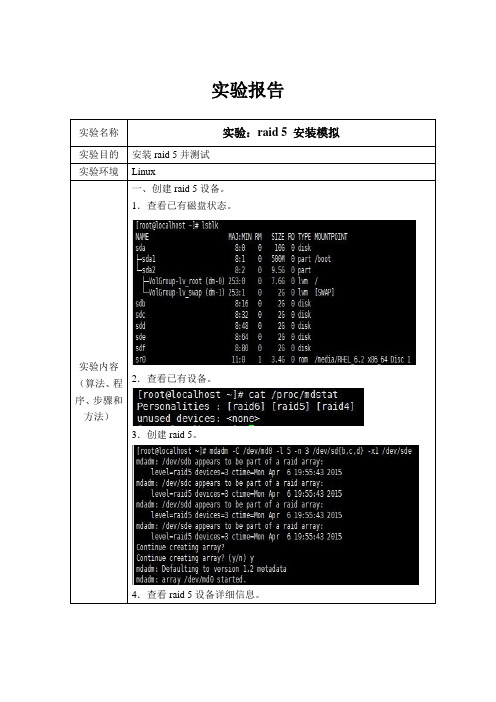

raid 5实验报告

vim /etc/fstab

984f686f-de64ef2b-8fca37e2-89a727c0/mntext4defaults0 0

mount–a(挂载设备)

df -hቤተ መጻሕፍቲ ባይዱ

mdadm -Ds > /etc/mdadm.conf

测试:

mdadm /dev/md0 -f /dev/sdd(破坏磁盘sdd)

7.编辑fstab文件使raid 5设备可以自动挂载。

8.挂载raid 5设备。

9.创建mdamd.conf文件。

二、测试raid 5设备。

1.使磁盘sdd坏掉,磁盘sde自动顶替磁盘sdd。

2.移除磁盘sdd。

3.添加磁盘sdf为备用磁盘。

4.这时再查看设备详细信息,已经没有磁盘sdd,但仍能正常工作。

数据记录和计算

创建:

lsblk

cat /proc/mdstat (查看现有设备)

mdadm -C /dev/md0 -l5 -n3 /dev/sd{b,c,d} -x1 /dev/sde(创建raid 5)

mdadm -D /dev/md0(查看详细信息)

mkfs.ext4 /dev/md0(格式化)

mdadm /dev/md0 -r /dev/sdd(移除磁盘sdd)

mdadm /dev/md0 -a /dev/sdf(添加磁盘sdf)

mdadm -D /dev/md0(查看设备详细信息)

结论

(结果)

Raid 5设备安装测试成功。

小结

Raid 5设备比较稳定,使用与大部分情况,学会安装raid 5是非常有必要的。

实验报告

实验名称

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

课程实验报告课程名称:计算机组成原理专业班级:计算机科学与技术1107班学号:姓名:指导老师:报告日期: 2013-11-2计算机科学与技术学目录【实验环境】 (1)【实验内容】 (1)【实验原理】 (1)【实验步骤】 (3)(1)创建RAID 0 (5)Raid0的速度测试 (9)创建RAID 1 (10)Raid1的使用 (13)Raid1的速度测试 (14)Raid1故障测试: (16)创建RAID 5 (19)Raid5的使用 (21)Raid5的速度测试 (22)RAID5故障测试 (24)Raid阵列速度的说明。

(31)【实验思考】 (32)Raid0+1 (32)查看raid (33)速度测试 (34)Raid0+5 (34)查看Raid0+5信息 (35)Raid0+5速度测试 (36)实验体会 (36)【实验环境】Linux虚拟机【实验内容】创建RAID 0和RAID 1创建RAID 5并测试其有效性【实验原理】一、Linux下的RAIDLinux系统在安装的过程中就可以使用RAID。

在使用当中,利用一些工具,可以实现比Windows还要强大得多的功能,比如RAID 0+1和RAID 0+5。

在Linux 下既可以对整块硬盘做RAID,也可以对其某一个分区做RAID。

Linux下常用来做软RAID的工具主要有两个:一个是mdadm,另一个是raidtools。

在本实验中我选用了mdadm。

在Linux下利用mdadm为非启动盘做软RAID比较简单。

在实验步骤中,分别给出了Linux下RAID 0、RAID 1和RAID 5的制作过程。

RAID0:RAID0并不是真正的RAID结构,没有数据冗余,RAID0连续地分割数据并并行地读/写于多个磁盘上。

因此具有很高的数据传输率,但RAID0在提高性能的同时,并没有提供数据可靠性,如果一个磁盘失效,将影响整个数据。

因此RAID0不可应用于需要数据高可用性的关键应用。

RAID1:RAID1通过数据镜像实现数据冗余,在两对分离的磁盘上产生互为备份的数据。

RAID1可以提高读的性能,当原始数据繁忙时,可直接从镜像中读取数据。

RAID1是磁盘阵列中费用最高的,但提供了最高的数据可用率。

当一个磁盘失效,系统可以自动地交换到镜像磁盘上,而不需要重组失效的数据。

RAID5:RAID5没有单独指定的奇偶盘,而是交叉地存取数据及奇偶校验信息于所有磁盘上。

在RAID5上,读/写指针可同时对阵列设备进行操作,提供了更高的数据流量。

RAID5更适合于小数据块,随机读写的数据。

RAID3与RAID5相比,重要的区别在于RAID3每进行一次数据传输,需涉及到所有的阵列盘。

而对于RAID5来说,大部分数据传输只对一块磁盘操作,可进行并行操作。

在RAID5中有“写损失”,即每一次写操作,将产生四个实际的读/写操作,其中两次读旧的数据及奇偶信息,两次写新的数据及奇偶信息。

二、mdadm说明(一)mdadm的7种主要操作方式(1)create创建一个带超级块的磁盘阵列。

(2)assemble将之前建立的磁盘阵列变为活跃的(active)。

(3)build用于创建没有超级块的磁盘阵列。

(4)manage用于对在一个磁盘阵列上的一个或多个设备做一些操作,如添加(add)、移除(remove)和使失败(fail),还包括以下功能:run/stop/readonly/readwrite。

(5)misc用于对单个设备的操作,它们可能是磁盘阵列的几部分,所以是零超级块,检测可能是适当的。

它们可能是md阵列,因此run,stop,rw,ro,detail这些操作也是可以的。

(6)monitor查看磁盘阵列并显示改变。

(7)grow允许改变一个磁盘阵列的关键属性,比如大小,设备数量等。

(二)create/build常用操作create/build常用操作如下表所示。

参数或选项说明--add或-a 添加或热添加磁盘--fail或-f 将RAID中的磁盘标记为已坏--remove或-r 从RAID中移除磁盘(注意:只有先将磁盘标识为已坏,才能移除) --set-faulty --fail功能相同--run或-R 开始运行一个已创建的阵列--stop或-S 停止运行一个阵列,释放它所有的磁盘资源--readonly或-o 标记阵列为只读--readwrite或-w 标记阵列为可读写--zero-supterblock 从一个设备中去掉MD超级块--raid-disks 创建RAID时需要用到的硬盘或分区数--spare-disks 创建RAID时作用侯补的硬盘或分区数,当组RAID的硬盘或分区出现问题被取下时,被设定为修补的硬盘或分区会自动补缺。

三、mdadm命令示例(1)利用sdb1,sdc1,sdd1创建一个RAID 1名为md0,其中sdb1和sdd1是组成md0的磁盘,sdc1是md0的备份盘,如果sdb1或sdd1出现问题,系统会自动将sdc1顶替该磁盘,使md0重归于完整。

具体命令如图所示。

(2)停止md0的运行,并释放它的所有资源:mdadm --stop /dev/md0。

(3)查看md0详情:mdadm --detail /dev/md0。

(4)将md0中的sdb1标记为已坏:mdadm /dev/md0 --fail /dev/sdb1。

(5)将sdb1移除出md0:mdadm /dev/md0 --remove /dev/sdb1。

(三)mdadm配置文件为了保证在每次重启系统时,RAID都能正常运行,需要创建或修改/etc/mdadm.conf文件,将RAID的信息写入文件的最下方。

写入信息包括RAID用到的硬盘和组成方式,上面示例的配置文件写法如图2.5.5-2所示。

【实验步骤】一、添加磁盘进入Linux虚拟机界面,点击“虚拟机硬盘设置”。

然后以相同的方式添加七块硬盘。

在弹出的对话框中设置添加硬盘的路径并设置磁盘大小442G(学号),如图所示,然后单击“下一步”直到完成。

相同方法,共添加七块虚拟硬盘。

完成后如下图:六块硬盘添加完成后,点击“开启此虚拟机”,进入Linux系统。

注意在实验过程中不要关闭虚拟机。

(1)创建RAID 0(1)Raid的搭建用到mdadm命令,因此我们先获取权限。

终端输入 sudo su 。

然后在控制台中输入命令:fdisk -l,查看当前系统硬盘情况。

观察各盘大小。

发现显示为47.2G ,和我们创建时的44G有点差别。

(2)为了用起来方便,我们采用sdb和sdc来创建RAID0。

首先对sdb和sdc格式化为创建raid的磁盘格式。

终端输入:fdisk /dev/sdb输入n进行选择。

输入t选择格式fd,不要忘记w保存。

对sdc同样操作。

格式。

(3)在控制台中输入命令:mdadm -C -v /dev/md127 -l0 -n2 /dev/sdb1/dev/sdc1如图所示。

Raid建立完成后会自动启动,因此不需要额外的操作。

(4)输入命令mdadm -D /dev/md0查看 RAID0 的信息。

如下图:(5)输入命令:cat /proc/mdstat查看目前磁盘阵列的运行情况,如图所示。

Raid0的使用(1)输入:fdisk -l /dev/md127,查看/dev/md127 设备是否存在,以及它的容量,它应该接近sdb和sdc两块硬盘大小之和,如图所示。

图中显示md127大小为94.5GB(2)创建文件系统。

输入mkfs.ext3 /dev/md127(3):挂载文件系统并使用输入命令:mkdir /softraid0mount /dev/md127 /softraid0df –l /dev/md127(4):RAID 的自动挂载,输入命令:gedit /etc/fstab 编辑文件,在下面加入:/dev/md127 /softraid0 ext3 defaults 0 0这样系统重新启动后会自动将/dev/md127 挂接到 /softraid0 目录下!Raid0的速度测试1.采用hdparm测试。

输入命令:hdparm -tT /dev/md127 经过多次测试,硬盘的读取效率稳定在540MB/sec左右,硬盘快取的读取效率稳定在2550M/sec左右。

2.采用系统自带的软件测试。

注:方法1和方法2测试的数据不一样。

RAID0的随机读取性能:很好RAID0的随机写入性能:很好RAID0的持续读取性能:很好RAID0的持续写入性能:很好RAID0的优点:最快的读写性能,如果每块硬盘拥有独立的控制器性能将会更好。

RAID0的缺点:任何一块硬盘出现故障所有的数据都会丢失,大部分的控制器都是通过软件实现的,所以效能并不好。

创建RAID 11.格式化磁盘sdd,sde。

2.在终端中输入命令:mdadm -C -v /dev/md126 -l1 -n2 /dev/sdd1 /dev/sde1。

如图所示。

3.输入命令mdadm -D /dev/md126查看 RAID1 的信息。

如下图:4.输入命令:cat /proc/mdstat查看目前磁盘阵列的运行情况,如图所示。

以RAID阵列有一个冗余组数据同步的初始化过程(resync)。

Raid1的使用(1)输入:fdisk -l /dev/md126,查看/dev/md126 设备是否存在,以及它的容量,它应该接近一块硬盘大小,如图所示。

图中显示md126大小为47.2GB(2)创建文件系统。

输入mkfs.ext3 /dev/md126(3):挂载文件系统并使用输入命令:mkdir /softraid1 ; mount /dev/md126 /softraid1df –l /dev/md126 将raid1挂载到softraid1文件夹下(4):RAID 的自动挂载。

输入命令gedit /etc/fstab 编辑文件,在下面加入:/dev/md126 /softraid1 ext3 defaults 0 0这样系统重新启动后会自动将/dev/md126 挂接到 /softraid1 目录下!Raid1的速度测试1.命令测试输入命令hdparm –tT /dev/md126 经过多次测试,速度稳定在500MB/sec左右。

2.软件测试RAID1的随机读取性能:好RAID1的随机写入性能:好RAID1的持续读取性能:一般RAID1的持续写入性能:好RAID1的优点:数据高可靠性,易于实现,设计简单。

RAID1的缺点:比RAID0相比速度较慢,特别是写入速度,另外就是我们仅仅能使用一半的硬盘容量。

Raid1故障测试:首先我们在raid1挂载的盘里面写入一个测试文档。