视频会议中混音后溢出问题的研究及解决方法

视频会议中常出现的几种音频问题及解决方案

视频会议中常出现的几种音频问题及解决方案随着视频会议的使用量不断增加,大家对视频会议的要求也越来越高,针对视频会议,大家都会说视频比较重要,其实不然,视频会议中,音频才是最重要的,以为与会者之间的交流主要是通过音频对话或者讨论实现,视频只要有图片,如果能清晰的表现当然最好,但是最有说服力的肯定是音频,具备好的视频和普通的音频比具备好的音频普通的视频要有用的多。

当然,由于现在对于音频产品的重视程度还不是很高,导致在视频会议过程中,音频出现问题的概率很高,这里,艾力特音频作为资深的会议音频产品专家,也将在为实践中碰到的视频会议音频问题进行一个总结,以便于有问题时能够快速地找到问题缘由。

一.音频通话过程中声音轻这个主要表现为对方传过来的声音很轻,要很费力才能听清楚对方在讲什么。

问题一般出在声音的采集方面,本方可以先测试下自身的扬声器或者喇叭,用本地电脑进行播放测试,看播放的音量是否足够大,如果确定本方音频下行是正常,则可以基本判断问题在于上行,一般可以调整设备输入(录音)音量大小,这需要特别署名,是调节录音音量,实际操作中往往很多人,只会调整喇叭的声音,而不会用录音音量的大小调节。

二.音频通话过程中噪声比较大噪声的大小,主要有两个方面的影响,一是会议过程中,可能存在风扇,空调等噪声源,而一般的会议类音频拾音产品都不会有特别的噪声处理,导致噪声都拾取进来,第二,就是音频上行,录音的音量太大,导致了轻微的动作都有较大的声音采集,引起噪声,当然,有时候会议软件中有一些功能,比如降噪,静噪等功能开启时,若和软件冲突,也容易引起噪声。

三.视频会议过程中能够听到自己的声音视频会议过程中,发现能够听到自己的声音又传回来了,例如很多手机当用免提的时候,也很容易出现该种情况,这类主要是音频设备没有选择好。

虽然现在的视频会议软件都拥有消除回声功能,但是没有一个能够真正将回声消除的,所以还需要后前端的音频设备来匹配,比如艾力特音频的全向麦克风,需要其自带回声消除功能,这样才能确保对方的声音从喇叭出来,不会从产品的拾音部位又传出,导致回声。

视频会议出现回音解决方法

四、中大型会议室的音频设备选择

中大型会议室的会议回音或噪音类似。选择音频设备的思路如下。

1、已有的会议室中控系统可以与视频会议结合。

2、调音台就是不可缺少的音频设备核心。需选用现场调音台,能在嘈杂的环境中,获得优美的讲话音效。

3、按需接入多只麦克风。调音台允许接入多只,所以,动圈麦克风的牢固耐用、灵敏度低与单指向性的特点可以继续发挥,还可以灵活地把无线麦克风的灵活优势发挥出来。

1、使用动圈麦克风。好的动圈麦克风具有牢固耐用、灵敏度低与单指向性特点,可用于嘈杂舞台的现场,有效抑制嘈杂环境中噪音,清晰准确再现讲话声音。譬如:ShureSM58人声话筒。

2、使用无线麦克风。具有上述动圈麦克风的优点,同时还具有1台接收机带多个话筒的便利。

3、需使用话放放大音量。由于阻抗不匹配,动圈麦克风或无线麦克风直接接电脑上时音量很小,必须转接。如果会议室规模不大,最简单的就就是使用话放,能放大麦克风音量。

g、用调音台或者话放来加强动圈麦克风的音量。

2、附加的pc会带来杂音。

c、网络带宽不好或者服务器性能不好,会使声音不能实时传递。等等。

其次,不同的使用环境与使用要求,可以选择不同的音视频设备。

二、单人参会的音频设备选择

单人参会,就是指参会人用一个日常办公的笔记本或者电脑,利用网络参与会议,因为只有一个人用,往往需要便携的小设备。

1、耳麦。单人用的最简单的方式就是用耳麦,对耳麦的使用主要就是要注意不要使用那些过于敏感的耳麦,就可以避免回音。

2、PC麦克风。一般的使用方式就是选择有一定方向性的pc麦克风。比如PhilipsSHM1000。

三、中小型会议室的音频设备选择

消除会议室回音的方法.

消除会议室回音的方法

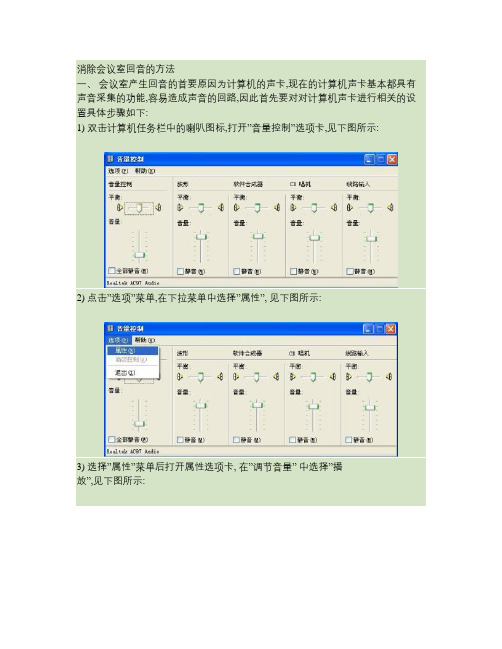

一、会议室产生回音的首要原因为计算机的声卡,现在的计算机声卡基本都具有声音采集的功能,容易造成声音的回路,因此首先要对对计算机声卡进行相关的设置具体步骤如下:

1) 双击计算机任务栏中的喇叭图标,打开”音量控制”选项卡,见下图所示:

2) 点击”选项”菜单,在下拉菜单中选择”属性”, 见下图所示:

3) 选择”属性”菜单后打开属性选项卡, 在”调节音量” 中选择”播

放”,见下图所示:

5) 在“显示下列音量控制”中选择”麦克风”, 见下图所示:

6) 在做完以上操作之后点击”确定”,打开”主音量”选项卡, 确定”麦克风”选项已打勾即为静音状态,见下图所示:

7) 打开”属性”选项卡,在”调节音量”中选择”录音”,在”显示下列音量控制”中选择”所有”的选项, 见下图所示:

8) 完成以上操作之后点击”确定”,打开”音量控制”选项卡,确定”麦克风”选项已打勾被选择, 见下图所示:

二、会议室产生回音的原因还有就是有的终端使用了”全向麦克风”,.现在

有的USB摄像头自身具有了全向麦克风的功能, 如果在使用过程中参数设置不当,那么就很容易造成会议室存在回音的情况.而且目前这种情况最为常见,因此在使用过程中一定要注意!

1) 以Logitech摄像头为例,如果视频会议客户端使用Logitech摄像头,那

么系统的”音频采集设备”项会选择使用摄像头自带的全向麦克风,这样的话就很容易造成回音了,如下图所示:

2) 选择正确的”音频采集设备”如计算机的声卡(配备耳麦),目前常见的声卡为Realtek AC97,如下图所示:

回音问题有时会严重影响会议室的进展,因此在使用过程中一定要注意相关参数的设置!。

视频会议的音频干扰及处理办法

技术:视频会议的音频干扰及处理方法要把视频会议做得更好,就要提高对声音的审美鉴赏力量和艺术修养,并对声音的还原进行构思和创意,才能提高声音的艺术表现力。

声音还原是技术和艺术的有机结合,其质量的好坏要从主观和客观两方面来衡量。

随着组织工作信息化程度的提高,各省市视频会议系统都有不同程度的延长,整个系统的设计、选购、安装、调试,涉及到音频、视频、电源、灯光等因素的影响。

本文就相关技术问题进行研讨,提出不同的解决方法。

一、信号流程分会场的设施包括会议终端及相关外部设施,设施种类及功能大同小异。

由上图可见, 音频信号的传输处理过程分为两局部:①本端的声音通过麦克风拾音,将人声转化为电信号送往调音台进行放大、混合、安排、音质修饰和效果加工处理后,再分为二路:一路信号送往本端的功率放大器进行放大后经扬声器还原为声音;另一路信号由调音台的帮助输出(AUX OUT)送往会议终端处理后传输给远端。

②远端送来的信号通过会议终端处理后,音频信号进入调音台进行加工处理,再送往本端的功率放大器进行放大,经扬声器还原为声音。

以上分析可知,调音台是各路信号加工处理的汇聚点,如何调整好调音台的各个旋钮及功能键,是调试中的关键所在。

二、存在问题纵观全国组织部门视频会议系统例行调试和召开会议,声音还原的质量有了明显的提高,但个别省市还存在问题,主要表现为噪声大、失真大、电平不法律规范、频响不匀称、声音比例失调、混响延时不当等问题。

1、噪声大。

它影响声音的清楚度、严厉度和光明度,严峻时会掩盖了会场的声音。

① 本底噪声。

由于增益过大、采纳自动增益掌握方式、阻抗不匹配等,都会消失本底噪声。

② 麦克风“扑”声。

麦克风是扩音系统的第一个环节,其信号质量的好坏直接影响到整个会议效果,因此要依据其特点和性能、声源重现的特征以及各声源之间的相对关系合理选择和设置。

对于破音较强的发言者,应选用防“扑”声的麦克风。

2、失真大。

它与设施的非线性失真和人为因素有关。

多方电话会议系统中混音溢出问题的一种改进算法

第3 0卷 第 1期 20 0 7年 2月

电 子 器 ቤተ መጻሕፍቲ ባይዱ

C ̄ ee J un lO lcrn D vcs lns o ra f Ee to e ie

V0. O No 1 I3 .

F b 2 0 e .07

An I p o e g rt m o e fo o d o M i i g i m r v d Alo ih f rOv r l w fAu i x n n

在音频模块 中, 传统上是使用控制发 言权 的方 法, 即某一时刻只允许 一个人发言. 每个会议 中首先 选定一个会议主席 , 发言者在发言前必须向会议主席 申 请发言权, 在发 言结束后释放发言权[ ]这样一 3. 来, 大大限制了会议成员之间的交流, 所以, 我们采用

混音技术解决了电话会议中这样的问题. 让更多的成

使用的网络也是 目前发展最快的 It n t即可视 ne e, r 化I P电话会议 系统. 电话会议 系统是 利用计算 而

员可以在同一时刻发言, 并将所有发言者的信息传达

给所有参与会议的成员, 即所谓的混音.

本文将首先简单介绍一下传统的混音算法 以及

现有 的语音算法[ , 6 然后提出一种改进的算法 , ] 并给 出实验结果, 最后进行了总结.

一

问题介绍了一种新 型的混 音算 法 , 该算法依 据音 频数据的变化来相应 的调整 衰减因子 , 的解 决 了混音 中因为溢 出而带 很好

来的噪声 , 而且变化也更加平滑. 实验结果表明 , 该算法在溢 出相当严重 的情况下也能有较高的混音质量.

关键 词 : 电话会议; 混音算法 ; 衰减因子; 溢出

机, 多媒体通信技术和设备 , 通过 I P网络传输信道 在两地或者多个地点之间开会 的一种通信手段. 在

视频会议中常出现的几种音频问题及解决方案

视频会议中常出现的几种音频问题及解决方案随着视频会议的使用量不断增加,大家对视频会议的要求也越来越高,针对视频会议,大家都会说视频比较重要,其实不然,视频会议中,音频才是最重要的,以为与会者之间的交流主要是通过音频对话或者讨论实现,视频只要有图片,如果能清晰的表现当然最好,但是最有说服力的肯定是音频,具备好的视频和普通的音频比具备好的音频普通的视频要有用的多。

当然,由于现在对于音频产品的重视程度还不是很高,导致在视频会议过程中,音频出现问题的概率很高,这里,艾力特音频作为资深的会议音频产品专家,也将在为实践中碰到的视频会议音频问题进行一个总结,以便于有问题时能够快速地找到问题缘由。

一.音频通话过程中声音轻这个主要表现为对方传过来的声音很轻,要很费力才能听清楚对方在讲什么。

问题一般出在声音的采集方面,本方可以先测试下自身的扬声器或者喇叭,用本地电脑进行播放测试,看播放的音量是否足够大,如果确定本方音频下行是正常,则可以基本判断问题在于上行,一般可以调整设备输入(录音)音量大小,这需要特别署名,是调节录音音量,实际操作中往往很多人,只会调整喇叭的声音,而不会用录音音量的大小调节。

二.音频通话过程中噪声比较大噪声的大小,主要有两个方面的影响,一是会议过程中,可能存在风扇,空调等噪声源,而一般的会议类音频拾音产品都不会有特别的噪声处理,导致噪声都拾取进来,第二,就是音频上行,录音的音量太大,导致了轻微的动作都有较大的声音采集,引起噪声,当然,有时候会议软件中有一些功能,比如降噪,静噪等功能开启时,若和软件冲突,也容易引起噪声。

三.视频会议过程中能够听到自己的声音视频会议过程中,发现能够听到自己的声音又传回来了,例如很多手机当用免提的时候,也很容易出现该种情况,这类主要是音频设备没有选择好。

虽然现在的视频会议软件都拥有消除回声功能,但是没有一个能够真正将回声消除的,所以还需要后前端的音频设备来匹配,比如艾力特音频的全向麦克风,需要其自带回声消除功能,这样才能确保对方的声音从喇叭出来,不会从产品的拾音部位又传出,导致回声。

视频会议系统常见问题及解决方法

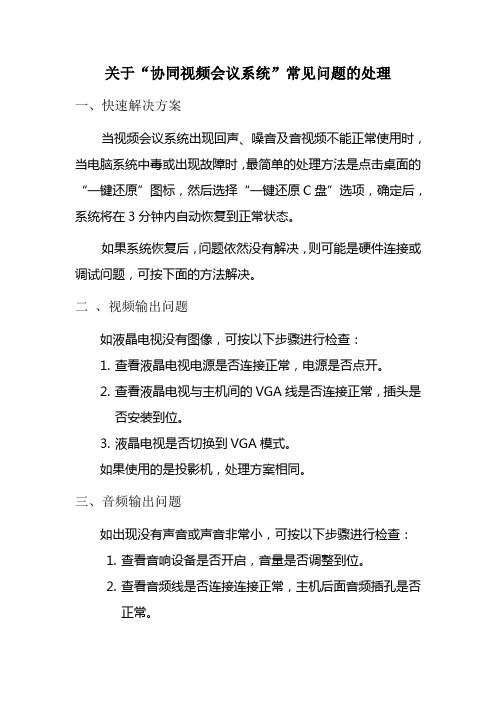

关于“协同视频会议系统”常见问题的处理一、快速解决方案当视频会议系统出现回声、噪音及音视频不能正常使用时,当电脑系统中毒或出现故障时,最简单的处理方法是点击桌面的“一键还原”图标,然后选择“一键还原C盘”选项,确定后,系统将在3分钟内自动恢复到正常状态。

如果系统恢复后,问题依然没有解决,则可能是硬件连接或调试问题,可按下面的方法解决。

二、视频输出问题如液晶电视没有图像,可按以下步骤进行检查:1.查看液晶电视电源是否连接正常,电源是否点开。

2.查看液晶电视与主机间的VGA线是否连接正常,插头是否安装到位。

3.液晶电视是否切换到VGA模式。

如果使用的是投影机,处理方案相同。

三、音频输出问题如出现没有声音或声音非常小,可按以下步骤进行检查:1.查看音响设备是否开启,音量是否调整到位。

2.查看音频线是否连接连接正常,主机后面音频插孔是否正常。

3.查看电脑音量控制。

双击右下角“小喇叭”4.查看“主音量”、“波形”两项,调制最上方为音量最大,最下方为最小,“平衡”处调制中央位置。

5.查看视频会议软件中音量,滑杆一般应该调到最大。

在会议室中,调节左下角位置音量,最右端为音量最大。

6.如通过以上设置均正确时,可播放当地音频文件,或临时更换成耳机,用来排除音响或电脑插口是否有问题。

四、音频输入问题1.查看麦克风是否开启,麦克风电量是否充足。

当声音小而哑时,则可能是电池电量不足,应尽快更换。

2. 查看音频线是否插好,麦克风应插到主机后的音频输入插孔。

3. 查看麦克风转接头是否安装牢固。

4. 可通过使用电脑中的“录音笔”测试麦克风状态。

运行录音笔程序:点击“开始”—“所有程序”—“附件”—“娱乐”—“录音笔”。

12先点击“2”,进行录音,看看“1”处是否有波动,如果波动,则说明麦克风状态正常。

6.查看电脑中的音量设置是否正常“线路输入”处音量要调制最上方。

7.查看视频会议中的麦克音量设置,滑杆一般应设置到最右的位置。

视频会议本地发言有重音

视频会议本地发言有重音

在当今数字化时代,视频会议已经成为人们工作和生活中不可或缺的一部分。

而在视频会议中,本地发言的重音问题也逐渐引起了人们的关注。

在视频会议中,本地发言的重音问题可能会给沟通带来一些困难。

有时候,由

于网络延迟或者音频质量不佳,本地发言的重音可能会导致对方无法听清楚发言内容,甚至造成误解。

这种情况下,不仅会影响工作效率,也可能会影响人际关系。

为了解决视频会议中本地发言的重音问题,我们可以采取一些措施。

首先,我

们可以选择高质量的音频设备,确保发言的清晰度和准确性。

其次,我们可以提前测试网络连接,确保视频会议中没有延迟或者卡顿的情况发生。

另外,我们也可以通过提前练习和调整发音,减少本地发言的重音,从而更好地进行沟通。

除此之外,视频会议平台也可以在技术上进行优化,提供更好的音频处理功能,帮助用户解决本地发言的重音问题。

通过不断改进和创新,我们相信视频会议中的本地发言重音问题将会得到有效解决。

总的来说,视频会议中本地发言的重音问题是一个需要重视的话题。

通过采取

合适的措施和技术优化,我们可以有效解决这一问题,提高视频会议的沟通效率和质量,为工作和生活带来更多便利。

抗混响措施

抗混响措施1. 引言在音频处理中,混响是一种常见的问题,它会给录制和播放的声音带来不必要的干扰和回声。

混响的产生是由于声音在环境中的反射和衍射所引起的,例如在大型会议室、音乐录音棚或室外场合中。

为了改善音频的质量,降低混响的影响,我们需要采取一些抗混响的措施。

本文将介绍一些常见的抗混响措施和方法,帮助使用者减少混响问题,提高音频的清晰度和准确性。

2. 抗混响措施2.1 使用吸声材料吸声材料是一种可以吸收声波的材料,它可以减少声音反射和回声。

在音频处理中,使用吸声材料来覆盖或填充房间的墙壁、天花板和地板等表面,可以有效降低混响的影响。

常见的吸声材料包括声吸板、泡棉、毛毡等,它们可以减少声音的反射,提高录音的质量。

2.2 调整麦克风位置对于录音环境来说,麦克风的位置也是影响混响的因素之一。

正确地放置麦克风可以减少声音反射和回声,降低混响问题。

通常情况下,应将麦克风靠近声源,并避免将其放置在靠近墙壁或有反射表面的位置。

同时,应尽量将麦克风与其他声源保持一定的距离,以防止回声的干扰。

2.3 使用低混响环境选择一个低混响的录音环境也是减少混响的有效措施之一。

尽量选择没有大面积空旷的房间,而是选择有吸声材料覆盖的小房间或隔音环境,这样可以减少声音的反射和回声,降低混响的影响。

2.4 使用数字信号处理技术除了物理的抗混响措施外,数字信号处理技术也可以帮助降低混响的影响。

在音频处理软件中,可以使用混响抑制器、降噪器等工具来处理混响问题。

混响抑制器可以通过模拟人耳的传输特性,抑制混响成分,提高音频的清晰度。

降噪器则可以帮助消除背景噪音,进一步减少混响的影响。

2.5 调整音频设备设置在录音和播放过程中,正确地调整音频设备的设置也是降低混响的关键。

首先要确保麦克风和扬声器等设备的位置和方向正确,避免产生回声和反射。

其次,要调整合适的音量和增益,避免因过大的音量导致混响问题。

此外,选择合适的音频格式和采样率也能改善音频的质量,减少混响的影响。

会议话筒问题解决方案

会议话筒问题解决方案在会议中,话筒是非常重要的设备,它能够确保会议进行顺利,让每一个参预者都能够清晰地听到发言者的讲话。

然而,在实际的会议中,会议话筒往往会浮现各种问题,比如声音不清晰、漏音、噪音等。

本文将为您介绍一些解决会议话筒问题的方案。

一、声音不清晰的问题解决方案1.1 调整话筒的位置:确保话筒与发言者的口鼻保持适当的距离,普通建议距离为10-15厘米。

1.2 检查话筒的接线:确保话筒的接线正确连接,没有松动或者接触不良的情况。

1.3 调节话筒的音量:根据实际情况适当调节话筒的音量,避免声音过大或者过小。

二、漏音的问题解决方案2.1 检查话筒的封闭性:确保话筒的外壳完好,没有破损或者松动的地方,避免漏音。

2.2 调整话筒的方向:确保话筒的接收方向对准发言者,避免因话筒角度不正确而导致漏音。

2.3 使用防风罩:在户外或者通风较大的场所会议中,可以使用防风罩来减少风声对话筒的影响,避免漏音。

三、噪音的问题解决方案3.1 检查话筒的接线:确保话筒的接线没有松动或者接触不良的情况,避免因接线问题导致噪音。

3.2 调整话筒的位置:避免话筒与其他电子设备或者干扰源过近,避免干扰信号导致噪音。

3.3 使用降噪设备:在噪音环境较大的场所,可以使用降噪设备来减少外界噪音对话筒的影响,提高音质清晰度。

四、话筒频繁断音的问题解决方案4.1 检查话筒的电源:确保话筒的电源充足,避免因电源不足导致频繁断音。

4.2 检查话筒的接线:确保话筒的接线正确连接,没有松动或者接触不良的情况,避免因接线问题导致频繁断音。

4.3 检查话筒的工作状态:定期检查话筒的工作状态,及时更换老化或者损坏的部件,避免因话筒故障导致频繁断音。

五、话筒无法启动的问题解决方案5.1 检查话筒的电源:确保话筒的电源正常连接,开关处于打开状态,避免因电源问题无法启动话筒。

5.2 检查话筒的接线:确保话筒的接线正确连接,没有松动或者接触不良的情况,避免因接线问题无法启动话筒。

如何处理视频会议中的技术故障和常见问题?(二)

视频会议已经成为现代工作和生活中不可或缺的一部分。

然而,在参加视频会议时,我们经常会遇到各种技术故障和常见问题,这些问题可能会影响到会议的效果和体验。

因此,如何有效地处理视频会议中的技术故障和常见问题成为了我们需要解决的重要问题。

故障一:音频问题音频问题是视频会议中最常见的故障之一。

有时,我们可能会遇到声音延迟、回声、杂音等问题。

首先,我们需要检查自己的麦克风和扬声器是否正常工作。

可以尝试将麦克风调整到适当的位置,并确保麦克风的声音不被其他外部干扰所影响,例如背景噪音。

其次,我们还可以尝试调整视频会议软件的音频设置,提高声音的采样率和清晰度。

如果仍然存在音频问题,建议尝试使用耳机和麦克风组合,以减少干扰和杂音。

故障二:视频画面问题视频画面问题通常包括图像卡顿、画面模糊等情况。

这些问题可能会降低会议的效果和交流的效率。

首先,我们可以尝试检查网络连接是否稳定。

如果网络连接不稳定,可以尝试关闭其他消耗大量带宽的应用程序或设备,以优化网络质量。

其次,我们还可以尝试调整视频会议软件的图像设置,降低图像质量以提高视频传输的流畅性。

此外,还可以尝试关闭视频会议中的其他功能,例如屏幕共享和虚拟背景等,以减少带宽的消耗。

故障三:网络连接问题网络连接问题可能导致视频会议无法正常进行。

当我们遇到网络连接问题时,可以采取以下措施来解决问题。

首先,确保您的网络连接是可靠的。

可以尝试重新连接网络或重启路由器来解决网络连接问题。

此外,也可以尝试使用有线网络连接代替无线连接,以获得更稳定的网络信号。

其次,如果网络连接问题持续存在,建议与网络服务提供商联系,寻求技术支持和解决方案。

他们可能会为您提供有关网络配置和设置的帮助,以提高网络连接的稳定性。

常见问题一:缺乏交流和沟通视频会议虽然方便,但由于缺乏面对面的交流和沟通,可能导致一些问题。

首先,我们可以尝试更好地利用会议工具中的交互功能,例如聊天窗口和表情反馈等。

通过这些交互功能,我们可以更方便地与其他与会人员进行沟通和交流。

音视频问题处理办法讲解

一、音频设置2

1、会议室-音频设置2

2、本地音量调节3

二、回音的消除设置3

1、本地设置消除回音4

2、桌面应用消除回音4

3、会场回音消除方法6

三、声卡驱动程序更新7

四、视频设置10

一、音频设置

1、会议室-音频设置

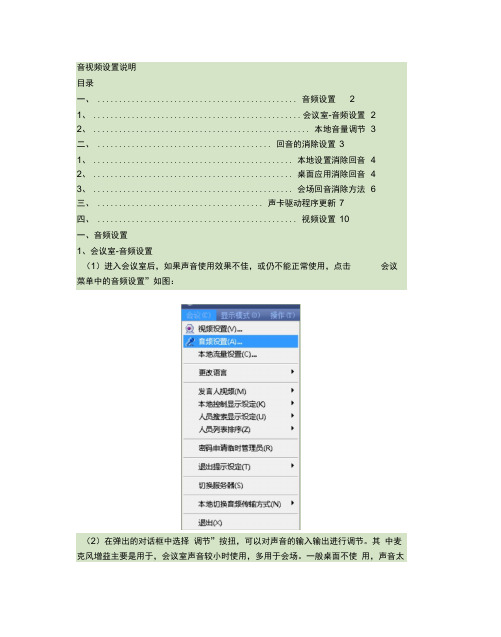

(1)进入会议室后,如果声音使用效果不佳,或仍不能正常使用,点击会议

菜单中的音频设置”如图:

建蜀设置甕啊音頻雨音的耳它方面・洋削厲風,谙娶阈砺件艾

匚iOESMS®

三、声卡驱动程序更新

如果前面设置都正确了,还是没有解决,那就与声卡驱动程序有关了。具体设置 如下:

(1)准备好声卡的最新驱动(可在官方网站下载),然后在桌面右击我的电

脑”——属性”弹出如下对话框:

USB Audio Device

®传魏机频捕捉设备砂传魏音频驼动程序

®媒体控制设备

9观频編码解码器 血音频编码解码器

(3)2、尽量不要直接使用笔记本自带麦克和喇叭,可外接任意形式的耳麦,笔 记本麦为usb,比较灵

敏,容易形成回声;

3、 各参与测试方对运行的网络环境进行自检,qq传东西等占用上传比较厉害的 行为很影响视频会议的效果;

讲话时,自己的声波条却在闪动,则表示自己会场产生回音,需要进行如下调试 工作。

1本地设置消除回音

(1)打开 音频设置”窗口,点击 选项”菜单中的 属性”打开,如下:

(2)在 播放”选项中音频设置窗口将 麦克风”勾上 静音”并将 软件合成器”勾 上 静音”且将其音量设至最小,这样也可以有效的防止回音,如图:

2、桌面应用消除回音

(1)桌面应用时有时候也会产生回音,这时,检查本地的声音输入是否太大, 可以适当的调整小麦克的小平滚动条较小,来减少回音。如图:

基于会议系统混音算法的研究与应用

i=0 , 1 , …, Ⅳ 一1

( 1 )

⑨6 @ @可@@ 响 响@0 ⑥ V

重堡

基于会议系统混音 算法 的研究 与应用 ・ 算 法 研 究 ・

殷 晓虎, 周 娟, 张 静

( 西安 科 技 大 学

通 信 与 信 息工 程 学 院 , 陕 西 西安

7 1 0 0 5 4 )

【 摘

要 】在而解决 多路混音后的溢出噪声 问题 是语音处理 的核 心。

【 A b s t r a c t 】A u d i o p r o c e s s i n g i s v e r y i m p o t r a n t i n t h e m l u t i m e d i a c o n f e r e n c e s y s t e m . H o w t o s o l v e t h e p r o b l e m o f o v e r f l o w a f t e r

现有的混音算法存在 音量突变 的问题 , 通过对 其分 析 , 找 出 了最 主 要的原 因。在此基 础 上, 提 出 了一种 改进 的算 法—— 自对齐减 谱法 , 经仿真结果表 明: 该算 法消 除噪声效果更 明显 , 可用于多媒体视 频会议 系统 中。

【 关键词 】语音处理 ; 混音算法; 溢 出; 自对 齐减谱 法 【 中图分类号 】T N 9 1 2 【 文献标志码】A

a u d i o m i x i n g i s t h e c o r e o f a u d i o p r o c e s s i n g . No w,t h e e x i s t i n g a l g o r i t h ms h a v e a p r o b l e m w h i c h i s v o l u me c h a n g e . A s e l f—a l i g - n i n g s p e c t r a l me t h o d i s p mp os d o i n t h i s p a p e r b y na a ly z i n g t h e e x i s t i n g p r o b l e ms i n t h e a u d i o mi x i n g a l g o i r t h ms . T h e e x p e i r me n t l a r e s u l t s s h o w t h a t t h i s lg a o i r t h m h a s m o r e o b v i o u s d e n o i s i n g e f e c t s ,a nd i t c a n b e u s e d i n he t mu l t i me d i a c o n f e r e n c e s y s t e m.

视频会议出现回音和噪音问题该如何解决

视频会议出现回音和噪音问题该如何解决在召开视频会议当中,你常常会受到自己回声的干扰?常常因为听到刺耳的啸叫而难受?常常会因为会议室中的噪音漏听了一些重要的信息?视频会议如果有回音和噪音的话,会极大的损害参会人愉快的心情,使本来优雅的“高科技”活动变成身心疲惫的累赘,累及会议组织方的企业形象受损。

视频会议系统是个软硬件综合的系统,需要对每个环节做细致的调节,以实现完美的会议效果。

视频会议是个性能优异的多媒体交换系统,回音和噪音的解决,主要是靠对麦克风、音响、调音台等音频设备的选择和配置来解决,这实际是从舞台或者音乐会的技术来吸取经验。

会议室的回音一直是一个比较普遍,比较难以处理的问题,是我们进行会议室装修设计时的需要考虑的重点,优鸿装饰设计经过多年的办公室装修经验总结:根据会议室回音产生的复杂程度的不同,其处理的方式和解决的难易程度会有很大的区别的,我们建议:对会议室的回音的解决可以通过软件和硬件或两种结合的方式进行处理,根据多年的经验,如果将软硬件的方法配合调试,则可以达到最佳的解决会议室的回音问题。

专业的装修公司对会议室装修中的会议室的回音等问题有着独特的解决方案,主要从硬件、软件两个方面来进行会议室的回音处理。

软件解决方案:如果会议室需要长期保持一个随时都能讨论的状态,优鸿装饰建议为这样的会议室选择具有回音消除功能的语音采集设备,为的是保持较好的会议效果,其实,针对这样的会议室,优鸿装饰会建议他们选择扬声器模式,除非他们使用的是耳机设备,不然,只在要发言前再锁定谈话,发言结束后取消锁定谈话,另外,在视频软件中的AEC功能也可在一定程度上消除在会议过程中产生的回声。

建议在会议室的客户端上去安装windows XP 操作系统,因为,此功能在windows XP操作系统下效率相对很高。

硬件解决方案:根据会议室应用的环境的不同,我们会选用不同的硬件设备,一般的会议室优鸿装饰会选用带回音抑制功能的均衡器,这样的均衡器能达到很好的回音抑制效果,同时,我们还可以配备一个单独的反馈抑制设备,反馈抑制器是处理和解决会议室的回音问题中最常见,也是最简单的设备之一,这种反馈抑制器的品种非常的多,他们的报价有几百元的,也有几万元的,但我们会根据会议室回音解决的效果结合反馈抑制器本身性能来建议客户使用哪一种,优鸿装饰对产生回音的复杂程度进行分析后,会有专业调试人员进行调试,如果我们的会议室中已经配备了很专业的调音台、均衡器等设备,则他们的配合使用会使得会议室的回音消除的效果更佳。

视频会议音频出现问题怎么解决?

视频会议音频出现问题怎么解决?

一场好的视频会议,除了视频会议画质是否达到高清,大家更在乎的是视频会议音频是否清晰,是否能够清晰连贯地听清楚对方在说什么的讲话,最大程度地模拟“面对面”交流的效果。

但要确保会议音频有一个清晰效果,通常会遇到以下几个问题:

* 声音很空旷,并且有周围环境的杂音。

这是因为使用的是全向麦或阵列麦拾音设备,拾音范围大。

这种情况我们可以选择一些拾音距离稍微小一点的全向麦克风,或是直接定向麦,缩小拾音距离,拾取到的声音没有环境的杂音,会议讲话就会更清晰。

* 在说话的时候能听到自己的回音。

这种情况可能是因为对方的调音台设置错误,或者全向麦离链接的音响在3米以内造成的。

此时要检查调音台设置,或将全向麦离音响3米以上即可解决问

题。

*传输的声音断断续续。

如果使用的是无线麦,可能是无线麦和接收器之间的信号传输不稳定。

建议更换效果好的无线麦套装。

如果使用的是有线麦,有可能是网络波动造成的。

建议视频会议终端设备都连接有线网络,并配置固定I P地址,通过上网行为管理设备或流控设备,为视频会议终端设备分配固定的带宽。

以保障视频会议系统的正常运行。

视频会议中混音后溢出问题的研究及解决方法

视频会议中混音后溢出问题的研究及解决方法

马旋∗ 王衡 汪国平 董士海

∗ 国家自然基金项目(60173062),

北京市自然基金项目(4012008). 联系作者, Email:mx@.

常使用 32 bit 来表示线性叠加以后的数据, 也就是 C 语言中的 int 类型, 实现简单, 运算也比较快, 更能满足很 多路音频同时进行混音的需要. 式 (2) 对和值作平均, 解决了溢出的问题, 但是混音以后的声音非常小, 效果非常不理想. 论文 [2] 中提出对于式 (2) 的改进算法, 着眼点在于不同路对于混音结果的贡献平衡, 对于溢出没有进行 很好的控制. 进行滤波处理的另外一种常用方法就是“箝位”, 当发生上溢时, 箝位以后的值为所能表示的最大值, 当发 生下溢时, 箝位后的值为所能表示的最小值, 如式 (3) 所示: if sample > M AX, M AX N ormalize(sample) = M IN (3) if sample < M IN , sample 其他情况. 其中, sample 为叠加以后的样本值, 为 32 bit, M AX 是最大输出值, 这里为 32767, M IN 为最小输出值, 为 −32768. 现在很多现有的论文和系统都是采用箝位方法, 因为实现简单, 快速, 效率很高. 但是可以看出, 这种箝位 方法相当于在最大和最小的临界值处切了一刀, 非常生硬, 会造成较大的波形失真. 在 4.1 节中, 我们可以看到 比较的结果.

视频会议中噪音的消除

作者: 王照环 韩钏

作者机构: 天津市水务局信息管理中心计算机科,天津300074

出版物刊名: 科技资讯

页码: 12-12页

年卷期: 2010年 第13期

主题词: 视频会议 噪音 混音 音频处理平台

摘要:视频会议系统是一种在位与两个或多个地点的多个用户之间提供语音和运动彩色画面的双向实时传送的视听会话型会议业务。

大型视频会议系统在军事、政府、商贸、医疗等部门有广泛的应用。

本文首先介绍了视频会议系统的发展情况以及视频会议系统的优势所在,并介绍了视频会议中常见的两个问题:回声和噪声。

本文重点阐述了视频会议系统中的噪音产生原因,并从硬件和软件两方面提出了解决方案。

多方电话会议系统中混音溢出问题的一种改进算法

多方电话会议系统中混音溢出问题的一种改进算法

张微;毛敏

【期刊名称】《电子器件》

【年(卷),期】2007(030)001

【摘要】音频模块在电话会议系统中起着举足轻重的作用,怎样解决混音后带来的溢出问题又是音频模块中的核心.针对这一问题介绍了一种新型的混音算法,该算法依据音频数据的变化来相应的调整衰减因子,很好的解决了混音中因为溢出而带来的噪声,而且变化也更加平滑.实验结果表明,该算法在溢出相当严重的情况下也能有较高的混音质量.

【总页数】3页(P294-296)

【作者】张微;毛敏

【作者单位】华东师范大学电子系,上海,200062;华东师范大学电子系,上

海,200062

【正文语种】中文

【中图分类】TP3

【相关文献】

1.一种改进的蚁群算法解决粮食物流中的VRP问题 [J], 许德刚;肖人彬;赵新;王胜轩

2.一种解决光网络中动态 RWA 问题的改进蚁群算法 [J], 付依俊;陆月明

3.一种改进的多方权重指数算法在基于CIPP的混合式教学评价体系中的应用 [J], 樊玲;胡来;李柏君;覃柳婷

4.一种改进的新型布谷鸟搜索算法在工业流水作业中调度问题的优化应用 [J], 边倩

5.一种改进人工鱼群算法求解冷链中车辆路径问题 [J], 李俊青;黄体浩;宋美娴;韩玉艳

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 引言

在视频会议系统中, 音频模块有着很大的重要性, 也是评测一个视频会议系统质量的重要方面. 相比起视 频模块来说, 音频质量的好坏涉及到会议内容, 有可能会影响到交流的准确性, 而质量稍微差一点的视频则是 可以承受的. 在音频模块中, 传统上是使用控制发言权的方法, 即某一时刻只允许一个人发言, 发言前需要向会议主席 申请发言权, 发言结束以后释放发言权. 这种方法限制了会议成员之间的交流. 因此, 音频的混合也是一个不 可或缺的特性. Hawwa S.[1] 总结了几种音频流混合的方法: 1. 混音器可能对每个流单独操作, 然后再转发给其他的参与者. 2. 混音器从不同的参与者接收流, 选择一个或者多个流转发给所有其他参与者. 3. 混音器从不同的参与者接收流, 把数据解码再混合, 然后再编码, 最后再发给所有的参与者. 第三种方法也就是我们真正意义上的混音, 因为多个音频流经过混合以后, 只剩一路, 大大减少了带宽的 需要, 对于视频会议系统是最优的, 本文所讨论的混音技术也就是这种意义上的混音. 在本文中我们改进了其中一种方法, 并和现有的一些混音技术进行了比较, 提高了混音的质量, 更有利于 会议成员之间的交流合作. 本文所讨论的视频会议系统为纯软件实现的桌面型视频会议系统, 采集的音频数 据格式为 Linear PCM, 16 bit, 单声道, 采样率为 8000 HZ.

视频会议中混音后溢出问题的研究及解决方法

马旋∗ 王衡 汪国平 董士海

北京大学计算机系人机交互与多媒体实验室 北京 100871

摘要: 本文对于桌面型视频会议系统音频模块中存在的混音以后质量不佳的问题, 提出一种改进的音频 混音算法, 使用随着音频数据的变化而变化的衰减因子来对音频数据进行衰减, 很好地解决了由于溢出所带 来的噪音, 并且变化更加平滑, 没有跳跃现象, 实际应用中有比较好的效果. 关键词: 视频会议; 音频; 混音; 多点控制器

4

实验结果

在此基础上, 我们的测试主要分为两部分, 一部分是静态测试, 主要是针对混音本身算法的效果, 不考虑其 他可能影响效果的因素. 另一部分是动态测试, 在实际的视频会议系统中进行整体测试, 主要针对与编解码器 的配合情况以及效率问题.

4.1

静态测试结果

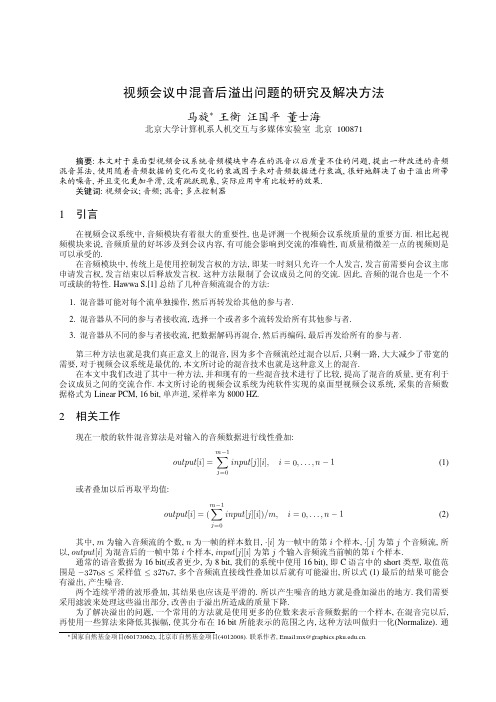

实验数据是录制好的 4 路语音数据, 两路男声, 两路女声, 其中有一路女声声音比较小, 有一路男声相对 比较大, 格式仍然是 linear PCM raw, 16 bit, 单声道, 采样率为 8000 HZ, 时间 30 秒, 帧长 30 毫秒. 针对基于 式 (2), (3) 的算法以及我们使用的这种混音方法, 做了测试, 测试环境为 Windows 2000 系统, 主频 P-IV 1.6G, 内存 256M. 均值方法, 平均耗时 31 毫秒; 箝位方法, 平均耗时 31 毫秒; 归一化定标方法, 平均耗时 47 毫秒. 可以看出 在现在的主流 PC 配置中, 相差并不是很大, 30 秒的数据只有十几毫秒的差距, 还没有进行特别的优化. 所以从 这点来说, 复杂度并不高, 耗时也很少, 完全可以满足实际应用. 最后混音的波形图如下所示, 截取的音频数据为第 13 - 14 秒, 共 8000 个采样点.

-20000

-30000 13000 13200 13400 Time (ms) 13600 13800

-30000 14000 13000 13200 13400 Time (ms) 13600 13800 14000

Figure 3: 原始归一化定标结果

Figure 4: 新归一化定标结果

图 3 和图 4 是原始算法的结果以及我们改进以后的结果. 原始的归一化定标算法, 相对于箝位算法来讲, 在临界值处比较平滑. 但是在听觉测试中可以听到有比较 明显的跳跃, 失真度略微高一些, 整体的声强也有所减弱. 我们对其改进了以后的结果, 对于最后的混音质量 有明显提高, 整体过渡都比较平滑, 没有跳跃现象出现, 声强也比原来的要大一些, 相对来说更接近原始值. 这是因为, 原始算法中对一个样本值使用衰减因子 f 衰减以后, 如果还是溢出, 它采用原来的值来计算 f , 这样就会造成过多地衰减, 这也是造成有跳跃现象比较明显以及声强比较弱的原因. 而我们采用衰减以后的 值来计算新的衰减因子, 减小了绝对的衰减量, 仍然达到了归一化的目标, 相对来说声强要强, 并且变化比较 平滑, 整体质量有所提高.

j = t, i = 0, . . . , n − 1

(4)

我们在实际系统中对文 [4] 提出的“归一化定标”算法进行了改进. 主要思想就是使用一个衰减因子, 对音 频数据进行衰减, 衰减因子会随着数据而变化. 当溢出时, 衰减因子比较小, 使溢出的音频数据衰减以后处于 临界值以内, 当没有溢出时, 衰减因子会慢慢增加, 尽量保持数据的平滑变化. 而不是对于整帧使用同一个衰 减因子来进行, 这是不同于式 (2) 和式 (3) 的地方, 既保证了整体的声强不至于衰减太快, 又保证了较小的失真 度. 算法如下所述: 1. f 初始化为 1. 2. 对于一帧中的样本按顺序处理: (a) output[i] = mixing [i] × f . (b) 如果 output[i] > M AX , 求得最大的 f 满足 output[i] × f < M AX , 然后 f = f , output[i] = M AX . (c) 如果 output[i] < M IN , 求得最大的 f 满足 output[i] × f > M IN , 然后 f = f , output[i] = M IN . 3. 如果 f < 1, 则 f = f + ST EP SIZE . 继续处理下一帧, 转 2. 其中 f 为衰减因子, f 为新的衰减因子; mixing [] 为所有音频流的某一帧线性叠加值, 实际实现的时候如 式 (4) 所示; output[] 为归一化以后的输出帧. M AX 为正的最大值; M IN 为负的最大值. ST EP SIZE 为 f 变 化的步长, 通常取为 (1 − f )/16 或者 (1 − f )/32. 我们对所做的改进只有一个地方, 就是在衰减以后的值溢出的情况下, 求新的衰减因子 f 的方法不同, 新 的 f 需要满足 output[i] × f < M AX 或者 output[i] × f > M IN , 而不是使用 mixing [i]. 也就是说, 使用衰 减以后的值 output[i] 来计算 f , 而不是原始值 mixing [i]. 用数学来表达, S 为溢出的一个样本值, 在 S × f 仍然溢出的情况下, 我们比较一下计算出来的新衰减因 AX , 我们改进的算法得出的新 子的大小. 假设是上溢, forig 是原始算法计算出的新的衰减因子, 则 forig < M S M AX M AX M AX 衰减因子 fnew < S ×f , 因为 S > S × f , 所以 S < S ×f , 那么 fnew 很大程度上要大于 forig . 衰减因子大 了(更接近 1), 相邻的数据变化不会特别大, 所以跳跃的现象不会特别明显.

(2)

其中, m 为输入音频流的个数, n 为一帧的样本数目, ·[i] 为一帧中的第 i 个样本, ·[j ] 为第 j 个音频流, 所 以, output[i] 为混音后的一帧中第 i 个样本, input[j ][i] 为第 j 个输入音频流当前帧的第 i 个样本. 通常的语音数据为 16 bit(或者更少, 为 8 bit, 我们的系统中使用 16 bit), 即 C 语言中的 short 类型, 取值范 围是 −32768 ≤ 采样值 ≤ 32767, 多个音频流直接线性叠加以后就有可能溢出, 所以式 (1) 最后的结果可能会 有溢出, 产生噪音. 两个连续平滑的波形叠加, 其结果也应该是平滑的. 所以产生噪音的地方就是叠加溢出的地方. 我们需要 采用滤波来处理这些溢出部分, 改善由于溢出所造成的质量下降. 为了解决溢出的问题, 一个常用的方法就是使用更多的位数来表示音频数据的一个样本, 在混音完以后, 再使用一些算法来降低其振幅, 使其分布在 16 bit 所能表示的范围之内, 这种方法叫做归一化(Normalize). 通

3

改进的混音方法

混音的时候, 如 [3] 所提到的, 还需要屏蔽某一路的本地音频数据, 这样就不会听到本地的声音, 只能听到 其他 n − 1 路的声音, 也就是说, 对于第 t 路音频, 要发送Βιβλιοθήκη 这个终端的混音后的数据如式 (4):

m−1

mixing [i] = (

j =0

input[j ][i]),

-30000 14000 13000 13200 13400 Time (ms) 13600 13800 14000

Figure 1: 均值混音结果

Figure 2: 箝位混音结果

从图 1 和图 2 中, 我们可以看出, 基于式 (2) 的均值算法结果明显振幅比较小, 大大低于原来各部分的振 幅, 声音变得比较小. 而基于式 (3) 的箝位算法在上下的临界值处一刀切, 比较僵硬, 可以明显感觉到这部分有 嘈杂声.

Original Scale Result 30000 "data-orig-scale.data" 30000 New Scale Result "data-new-scale.data"

20000

20000

10000 Amplitude Amplitude

10000

0

0

-10000

-10000

-20000

Average Method Result 30000 "data-avg.data" 30000 Cut Method Result "data-cut.data"

20000