用python爬虫抓站的一些技巧总结 _ observer专栏杂记

Python网络爬虫的使用技巧

Python网络爬虫的使用技巧Python 网络爬虫的使用技巧在如今信息爆炸的时代,我们获取所需信息的方式也在不断变化。

网络爬虫作为一种强大的工具,能够帮助我们从网络中快速获取所需数据。

Python 作为一种灵活易用且功能丰富的编程语言,被广泛应用于网络爬虫的开发。

在本文中,我们将讨论一些 Python 网络爬虫的使用技巧,帮助您更好地实现您的爬虫需求。

一、选择合适的网络爬虫库Python 提供了多个网络爬虫库,如 Requests、Scrapy 等。

选择合适的库对于开发高效的爬虫至关重要。

如果您只需要简单地发送 HTTP 请求并获取响应,Requests 库是一个不错的选择。

如果您需要开发更为复杂的爬虫,比如爬取多个页面并解析数据,Scrapy 则是一个更好的选择。

Scrapy 提供了强大的框架和许多内置功能,使您能够更便捷地处理页面间的导航、数据解析和持久化等任务。

二、设定适当的请求头和代理当进行网络爬取时,合理设置请求头和代理将有助于规避反爬机制。

有些网站可能会检测请求头中的 User-Agent 字段,因此我们可以设置一个合理的 User-Agent 值,使我们的爬虫看起来更像一个正常的浏览器请求。

另外,一些网站可能会限制同一个 IP 地址的请求频率,我们可以使用代理服务器进行请求,以避免被封禁。

三、处理网页响应在获取到网页响应后,我们需要对其进行合适的处理。

首先,我们需要考虑网页的编码问题。

有些网页可能没有指定编码,可以使用第三方库 chardet 来自动检测编码。

其次,我们需要解析网页,提取我们需要的数据。

对于 HTML 格式的网页,可以使用第三方库 BeautifulSoup 进行解析。

对于 JSON 格式的数据,可以使用内置的 json 模块进行处理。

四、处理动态加载的数据有些网站使用AJAX 或JavaScript 动态加载数据,这给爬虫带来了一定的挑战。

我们可以使用第三方库 Selenium 来模拟浏览器行为,实现动态加载数据的爬取。

Python网络爬虫实践技巧

Python网络爬虫实践技巧第一章:网络爬虫概述网络爬虫是通过模拟浏览器行为从网页中抓取数据的程序。

Python是一种非常适合编写网络爬虫的编程语言,它有丰富的第三方库和库函数来处理网页的解析和数据的提取。

第二章:爬虫基础知识在开始编写爬虫之前,我们首先需要了解一些基本的爬虫知识。

这包括HTTP协议、User-Agent、Cookies、动态网页和静态网页等概念。

了解这些知识能够帮助我们更好地编写和调试爬虫。

第三章:请求和响应在编写爬虫时,首先需要向目标网站发送请求,然后获取到网站的响应进行处理。

Python的requests库是一个非常方便的发送请求和获取响应的工具。

在这一章节中,我们将介绍如何使用requests库来发送HTTP请求。

第四章:网页解析获取到网页的响应后,我们需要从中提取出我们感兴趣的数据。

Python的Beautiful Soup库是一个非常强大的网页解析库,它可以帮助我们方便地提取出网页中的内容,并且支持CSS选择器和正则表达式等多种方式的解析。

第五章:数据存储爬虫爬取到的数据一般都需要进行存储和处理。

在这一章节中,我们将介绍如何使用Python的各种方式进行数据的存储,包括文本文件、CSV文件、Excel文件、MySQL数据库和MongoDB数据库等。

第六章:登录和身份验证有些网站需要登录后才能进行爬取,这给爬虫的编写增加了一些难度。

在这一章节中,我们将介绍如何使用Python的requests库和Cookie来实现网站的模拟登录和身份验证。

第七章:爬虫的反爬机制为了防止爬虫对网站的影响,很多网站会采取一些反爬措施。

在这一章节中,我们将介绍一些常见的反爬机制,包括验证码、限制访问频率和动态加载数据等,并且提供一些应对策略。

第八章:代理和IP池为了规避一些反爬机制,我们可以使用代理服务器来隐藏自己的真实IP地址。

在这一章节中,我们将介绍如何使用Python的requests库来设置代理,并且讲解如何使用IP池来解决IP被封禁的问题。

Python网络爬虫定向爬取与智能化抓取技巧

Python网络爬虫定向爬取与智能化抓取技巧网络爬虫是一种自动获取互联网上信息的程序,而Python作为一门强大的编程语言,提供了丰富的库和工具来实现网络爬虫的功能。

本文将介绍Python网络爬虫的定向爬取和智能化抓取技巧。

一、定向爬取定向爬取是指针对特定的网站或特定的内容进行爬取,而不是对整个互联网进行全面抓取。

Python提供了许多库,如requests、BeautifulSoup等,可以帮助我们实现定向爬取。

1. 确定爬取目标在进行定向爬取之前,我们首先需要确定爬取的目标。

这包括确定要爬取的网站、页面和需要获取的信息。

通过分析网站的结构和页面的内容,我们可以确定需要使用的爬取策略和技术手段。

2. 发送HTTP请求使用Python的requests库,我们可以发送HTTP请求来获取网页的内容。

通过设置相应的请求头和参数,我们可以模拟浏览器的行为,绕过网站的反爬机制。

3. 解析网页内容获取网页内容后,我们需要解析其中的信息。

使用BeautifulSoup库可以方便地处理和解析HTML和XML等类型的网页内容。

通过标签选择器、属性选择器和文本选择器等方法,我们可以定位和提取我们所需的信息。

4. 存储数据爬取到的数据需要进行存储,以供后续分析和使用。

我们可以将数据存储到数据库中,如MySQL、MongoDB等,或者存储到本地文件中,如CSV、Excel等格式。

二、智能化抓取智能化抓取是指根据网站的内容和结构,通过智能化的算法和机制来进行数据抓取。

Python提供了一些强大的库和工具,如Scrapy、Selenium等,可以实现智能化抓取的功能。

1. 使用Scrapy框架Scrapy是一个功能强大的Python爬虫框架,它提供了高度可定制化和可扩展的架构,适用于各种网站和爬取任务。

通过编写Scrapy的Spider和Item Pipeline,我们可以定义爬取的规则和流程,实现自动化抓取。

2. 动态网页的抓取一些网站使用了动态网页技术,其内容是通过JavaScript动态加载的,无法通过普通的HTML解析方式获取到。

Python网络爬虫的医疗健康信息抓取与挖掘技巧

Python网络爬虫的医疗健康信息抓取与挖掘技巧随着互联网的发展,医疗健康信息的获取对于人们的生活越来越重要。

Python网络爬虫作为一种强大的自动化工具,能够帮助我们从互联网上高效地抓取和挖掘医疗健康相关的信息。

本文将探讨使用Python网络爬虫抓取与挖掘医疗健康信息的技巧。

一、选择合适的网站和页面分析结构在开始之前,我们首先需要选择合适的医疗健康网站。

一些可信赖的健康网站如世界卫生组织官网、医学期刊官网等,它们通常提供权威、可靠的医疗健康信息。

此外,对于医院、诊所等机构的官方网站也是我们抓取数据的好选择。

在选择好网站后,我们需要进行页面分析,了解网站的结构和页面元素。

通过审查元素、查看网页源代码等方式,我们可以获得页面的HTML结构和CSS样式信息。

这对于后续编写爬虫代码是非常重要的。

二、使用Python库进行网页抓取Python提供了许多强大的库,如Requests、urllib等,可以帮助我们从网站上获取页面内容。

我们可以使用这些库中的函数发送HTTP请求,获取页面的HTML代码,然后将其保存到本地文件或者在内存中进行处理。

三、解析HTML并提取所需信息从网页中获取到的HTML代码通常是一片混乱的标签和文本。

为了提取出我们需要的信息,我们可以使用Python中的解析库,如BeautifulSoup、Scrapy等。

这些库可以帮助我们解析HTML,提供简洁的API来选择和提取特定元素。

四、处理动态加载的内容有些网站的内容是通过JavaScript动态加载的,这就需要我们模拟浏览器的行为来获取到完整的页面。

Selenium是一个非常强大的Python库,可以模拟浏览器的行为,加载并执行JavaScript代码,从而获取动态加载的内容。

五、处理页面反爬虫机制为了防止大规模的数据抓取,一些网站会采取反爬虫机制。

常见的反爬虫手段包括IP封锁、验证码、请求频率限制等。

为了应对这些阻碍,我们可以使用代理IP池、验证码识别、设置请求头等方式来绕过限制,并保证数据的抓取效率和稳定性。

Python爬虫开发的基本原理与技巧有哪些

Python爬虫开发的基本原理与技巧有哪些在当今的数字化时代,数据成为了一种极其宝贵的资源。

Python 爬虫作为获取数据的有效手段,受到了众多开发者的青睐。

那么,Python 爬虫开发的基本原理是什么?又有哪些实用的技巧呢?首先,我们来了解一下 Python 爬虫的基本原理。

简单来说,Python 爬虫就是通过编写程序,让计算机模拟浏览器的行为,自动访问网页并提取所需的数据。

这一过程主要涉及以下几个关键步骤:1、发送请求:使用 Python 的相关库(如`requests`)向目标网页发送 HTTP 请求,就好像我们在浏览器中输入网址一样。

2、获取响应:服务器接收到请求后,会返回相应的响应,包括网页的 HTML 代码、图片、脚本等内容。

3、解析数据:通过解析获取到的 HTML 代码或其他数据格式(如JSON),提取出我们感兴趣的信息。

4、存储数据:将提取到的数据保存到本地文件(如 CSV、JSON 等格式)或数据库中,以便后续的分析和使用。

为了更好地理解这些步骤,我们以一个简单的例子来说明。

假设我们想要获取某个新闻网站上的头条新闻标题和链接。

首先,我们使用`requests` 库发送请求获取网页的 HTML 代码,然后使用`BeautifulSoup` 或`lxml` 等库来解析 HTML 代码,找到包含新闻标题和链接的标签,提取出相应的文本和链接,最后将这些数据保存到一个文件中。

接下来,我们来探讨一些 Python 爬虫开发的技巧。

1、选择合适的请求头在发送 HTTP 请求时,设置合适的请求头是非常重要的。

请求头中包含了许多关于请求的信息,如用户代理(UserAgent)、接受的语言(AcceptLanguage)等。

一些网站会根据请求头来判断请求是否来自合法的浏览器,如果请求头设置不当,可能会被网站识别为爬虫并拒绝访问。

因此,我们可以模拟常见浏览器的请求头,增加爬虫的隐蔽性。

2、处理反爬虫机制很多网站为了防止爬虫过度抓取数据,会设置各种反爬虫机制,如验证码、IP 封禁、访问频率限制等。

使用Python进行网络爬虫和数据抓取

使用Python进行网络爬虫和数据抓取随着互联网的快速发展,数据已经成为当今社会的一种重要资源。

而网络爬虫和数据抓取技术则成为了获取和分析数据的重要手段。

Python作为一种简单易用且功能强大的编程语言,被广泛应用于网络爬虫和数据抓取领域。

本文将介绍如何使用Python进行网络爬虫和数据抓取,并探讨其在实际应用中的一些技巧和注意事项。

一、什么是网络爬虫和数据抓取网络爬虫是一种自动化程序,通过模拟浏览器行为,从网页中提取所需的数据。

数据抓取则是指从各种数据源中提取数据的过程。

网络爬虫和数据抓取技术可以帮助我们快速获取大量的数据,并进行进一步的分析和应用。

二、Python的网络爬虫库Python提供了许多强大的网络爬虫库,其中最常用的是BeautifulSoup和Scrapy。

BeautifulSoup是一个解析HTML和XML文档的库,它可以帮助我们方便地从网页中提取所需的数据。

而Scrapy则是一个功能强大的网络爬虫框架,它提供了更多的功能和灵活性,适用于大规模的数据抓取任务。

三、使用BeautifulSoup进行数据抓取首先,我们需要安装BeautifulSoup库。

在Python中,可以使用pip命令来安装第三方库。

安装完成后,我们可以通过导入相应的模块来开始使用BeautifulSoup。

接下来,我们需要指定要抓取的网页URL,并使用Python的requests库发送HTTP请求,获取网页的内容。

然后,我们可以使用BeautifulSoup解析网页,并通过选择器来提取所需的数据。

选择器可以是标签名、类名、ID等,根据网页的结构和需求来确定。

最后,我们可以将提取到的数据保存到本地文件或者数据库中,以便后续的分析和应用。

在保存数据时,我们可以使用Python的文件操作函数或者数据库操作函数,根据实际情况选择合适的方式。

四、使用Scrapy进行数据抓取Scrapy是一个强大的网络爬虫框架,它提供了更多的功能和灵活性,适用于大规模的数据抓取任务。

Python网络爬虫中的数据抓取与数据分析

Python网络爬虫中的数据抓取与数据分析Python作为一种高效、简洁且易于学习的编程语言,被广泛应用于各个领域。

其中,网络爬虫是Python应用的一个重要方向之一,通过网络爬虫,我们可以获取互联网上的各种数据资源,并对数据进行分析和处理。

本文将介绍Python网络爬虫中的数据抓取与数据分析的方法和技巧。

一、数据抓取1. 网页数据抓取网页是网络爬虫最常见的数据抓取对象之一。

Python中有多种库可以用于抓取网页数据,比如Requests库和Urllib库。

我们可以使用这些库发送HTTP请求,获取网页的HTML源代码,并对HTML源代码进行解析提取所需数据。

2. API数据抓取很多网站提供了API接口,供用户获取特定的数据。

通过调用API 接口,我们可以直接获取结构化的数据,无需进行HTML解析等复杂的操作。

Python中的Requests库可以用于发送API请求,并对返回结果进行解析提取。

3. 文件数据抓取除了抓取网页数据和API数据,我们还可以通过Python爬虫获取其他类型的数据,比如文本文件、图片文件、视频文件等。

通过使用适当的库和方法,我们可以轻松地下载和保存这些文件数据。

二、数据分析1. 数据清洗在进行数据分析之前,我们通常需要对数据进行清洗和预处理。

数据清洗包括去除重复数据、处理缺失值、修复错误数据等操作。

Python 中的Pandas库提供了丰富的函数和方法,可以帮助我们高效地进行数据清洗。

2. 数据转换有时,我们需要将抓取到的原始数据转换为我们需要的格式。

比如,将时间数据转换为日期格式,将文本数据转换为数值型数据等。

Python 中的Numpy库和Pandas库提供了强大的数据转换功能,可以方便地进行各种数据类型的转换。

3. 数据分析与可视化数据分析的核心是对数据进行统计和计算,并通过可视化的方式展示分析结果。

Python中的Matplotlib库和Seaborn库是两个常用的数据可视化库,它们提供了丰富的图表类型和绘图函数,可以帮助我们直观地展示和分析数据。

使用Python网络爬虫进行数据采集与

使用Python网络爬虫进行数据采集与处理使用Python网络爬虫进行数据采集与处理在当今信息爆炸的时代,数据被称为新的石油,而数据采集与处理是获取和利用这一宝贵资源的重要环节。

Python作为一种简单、灵活而又强大的编程语言,被广泛应用于网络爬虫开发,为我们提供了一种高效的方式来获取和处理各种数据。

本文将介绍如何使用Python网络爬虫进行数据采集与处理的方法和技巧。

一、网络爬虫简介网络爬虫(Web Spider)是一种自动化程序,通过访问互联网上的各种网页,根据规定的规则抓取其中的数据,并将其保存到本地或进行进一步的处理。

网络爬虫可以实现数据的自动采集,节省大量的时间和精力。

Python提供了许多优秀的爬虫框架,如Scrapy、BeautifulSoup等,可以帮助我们快速地构建起自己的网络爬虫。

二、数据采集1. 网络请求利用Python的网络请求库,如requests,可以发送HTTP请求获取网页的源代码。

我们可以通过设置请求头、cookies等参数来模拟不同的用户访问行为,还可以设置代理,实现匿名访问。

通过解析响应,就可以获取到网页中的各种数据。

2. 数据解析获取到网页源代码后,下一步就是对其进行解析,提取出我们所需的数据。

Python提供了一种强大的解析库,称为BeautifulSoup。

我们可以使用BeautifulSoup解析HTML或XML文档,通过标签、类名、属性等方法快速定位需要采集的数据,并进行提取。

三、数据处理1. 数据存储通过网络爬虫采集到的数据,我们可以选择将其保存到本地文件或数据库中。

Python提供了各种文件操作和数据库操作的模块,可以方便地进行数据的存储和管理。

如果要保存为Excel或CSV文件,可以使用pandas库进行处理。

2. 数据清洗和处理采集到的数据往往存在一些不规范或不完整的情况,需要进行数据清洗和处理。

Python提供了各种数据处理和分析的库,如pandas和numpy,可以对数据进行清洗、筛选、排序、去重等操作,使其变得更加规范和有用。

Python中的爬虫和数据抓取技巧

Python中的爬虫和数据抓取技巧Python作为一门广泛应用于数据科学、机器学习、人工智能等领域的编程语言,其强大的数据抓取和爬虫能力也备受关注。

本文介绍Python中的爬虫和数据抓取技巧,包括基础语法、常见库以及实用技巧等方面。

一、基础语法1.1 爬虫的基本流程爬虫的基本流程可以分为以下几个步骤:(1)发送请求:使用Python中内置的urllib或第三方库requests向目标网站发送请求,获取网页源代码。

(2)解析网页:使用Python中内置的re和第三方库BeautifulSoup对网页源代码进行解析,提取所需数据。

(3)保存数据:将提取到的数据保存到本地文件或数据库中。

1.2 爬虫中的正则表达式正则表达式是在Python中进行正则匹配的基础。

re库是Python中用于正则表达式操作的模块,可以在Python中轻松地处理文本数据。

在爬虫中,正则表达式可以用于网页源代码的解析,提取需要的数据。

1.3 解析网页的库解析网页主要使用的是第三方库BeautifulSoup和XPath。

BeautifulSoup是Python中常用的解析HTML和XML的第三方库,可以用于提取网页中的各类数据。

XPath是一种用于XML文档的查询语言,常用于从HTML和XML中提取信息。

二、常见库介绍2.1 urlliburllib是Python自带的HTTP请求库,支持HTTP、HTTPS、FTP等协议,功能齐全,使用简单方便,适合爬取简单的网站。

2.2 requestsrequests库是一个非常流行的Python HTTP请求库,相比urllib,更加简便易用,API设计更为人性化,日志输出更加友好,接口更加简洁,支持会话维持、文件上传、HTTP协议的Cookies等重要功能,适合爬取复杂的网站。

2.3 Beautiful SoupBeautifulSoup是一种解析HTML和XML文档的Python库,可以从网页中提取数据。

Python网络爬虫实践数据抓取与处理

Python网络爬虫实践数据抓取与处理在当今信息时代,数据是重要的资源之一。

随着互联网的快速发展,人们可以通过网络获取各种各样的数据。

而Python作为一种高效的编程语言,具备强大的网络爬虫功能,可以帮助我们快速地获取所需的数据。

本文将介绍Python网络爬虫的实践经验,包括数据抓取与处理。

一、数据抓取网络爬虫主要通过HTTP协议与目标网站进行通信,获取网页内容。

使用Python的requests库可以方便地发送请求,并获取响应。

接下来是通过HTML解析库对获取的网页进行解析,提取所需的信息。

1. 发送HTTP请求在使用Python进行网络爬取之前,我们需要 import requests 库,并使用 requests.get() 函数发送HTTP请求。

该函数接受一个URL作为参数,并返回一个包含响应内容的Response对象。

2. 解析HTML内容使用HTML解析库对获取的网页进行解析,以提取所需的数据。

常用的HTML解析库有BeautifulSoup和lxml等。

通过调用对应的方法和属性,我们可以对HTML文档进行遍历和搜索,提取出我们所需的信息。

二、数据处理在数据抓取完成后,我们可能需要对数据进行一些处理,以便更好地应用于相关领域。

Python提供了丰富的数据处理库和工具,可以帮助我们对数据进行清洗、分析和可视化等处理。

1. 数据清洗数据清洗是指对原始数据进行预处理,以去除重复、无效或错误的数据。

Python中常用的数据清洗工具有pandas库和numpy库,能够对数据进行筛选、填充缺失值、删除重复值等操作,以保证数据的准确性和一致性。

2. 数据分析数据分析是在数据清洗的基础上,对数据进行统计和挖掘,以发现数据中的规律和关联,为决策提供依据。

Python中常用的数据分析库有pandas和numpy,可以进行数据聚合、排序、统计和分组等操作。

3. 数据可视化数据可视化是将数据转化为图形形式,以便更直观地展示数据的趋势和关系。

Python网络爬虫实践技巧

Python网络爬虫实践技巧随着互联网的迅速发展,大量数据被发布在各类网站上,而网络爬虫的出现为我们从复杂的网页中抓取所需信息提供了可能。

Python作为一种广泛使用的编程语言,有优秀的网络爬虫库,使得利用Python进行网络爬虫实践变得更加便捷。

本文将分享一些Python网络爬虫的实践技巧,帮助读者更好地掌握这一有价值的技能。

一、选择合适的网络爬虫库在进行Python网络爬虫实践时,我们需要选择一个合适的网络爬虫库来帮助我们处理网页数据。

Python中最流行的网络爬虫库有BeautifulSoup和Scrapy。

BeautifulSoup是一个解析HTML和XML的库,它可以帮助我们快速定位和提取需要的数据。

而Scrapy是一个功能强大的爬虫框架,它提供了丰富的功能和强大的处理能力,适合处理复杂的网页结构。

二、学习基本的HTML和CSS知识在进行网页爬取时,了解基本的HTML和CSS知识是非常重要的。

因为网页上的数据通常是以HTML语言编写的,我们需要理解网页的结构和元素,才能准确地定位和提取数据。

同时,CSS也在网页中起到了美化和布局的作用,通过学习CSS知识,我们可以更好地理解网页的样式和布局,有助于我们提取所需数据。

三、模拟浏览器行为有些网站在访问时需要验证身份或者进行一些其他的操作,这时我们需要模拟浏览器行为来绕过这些限制。

Python的Selenium库可以模拟浏览器行为,例如自动填写表单、点击按钮等,帮助我们获取到需要的数据。

但是,在使用Selenium时需要注意,过于频繁的访问可能会被网站封禁IP,所以我们需要控制访问频率,避免对网站造成不必要的麻烦。

四、处理动态加载的网页有时候,我们访问的网页中的数据是通过JavaScript动态加载的,而传统的简单爬虫无法获取到这些数据。

这时,我们可以使用Python的Requests-HTML库来处理动态加载的网页。

Requests-HTML库可以渲染JavaScript,并且提供了一些方便的方法来提取页面中的数据,使得我们能够获取到动态加载的内容。

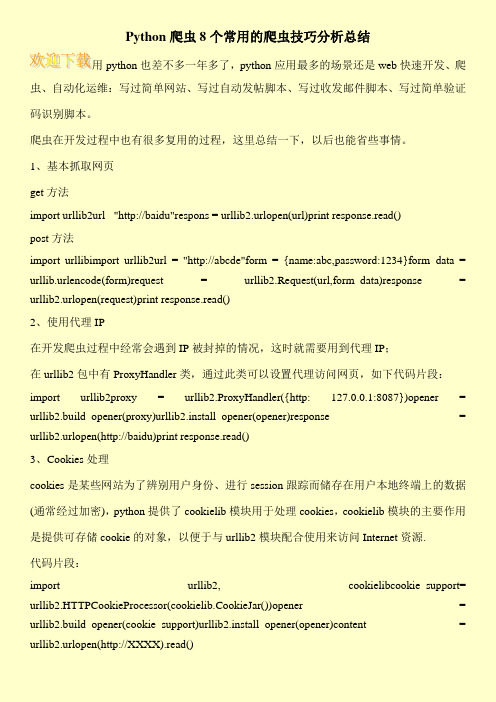

Python爬虫8个常用的爬虫技巧分析总结

Python爬虫8个常用的爬虫技巧分析总结用python也差不多一年多了,python应用最多的场景还是web快速开发、爬虫、自动化运维:写过简单网站、写过自动发帖脚本、写过收发邮件脚本、写过简单验证码识别脚本。

爬虫在开发过程中也有很多复用的过程,这里总结一下,以后也能省些事情。

1、基本抓取网页get方法import urllib2url "http://baidu"respons = urllib2.urlopen(url)print response.read()post方法import urllibimport urllib2url = "http://abcde"form = {name:abc,password:1234}form_data = urllib.urlencode(form)request = urllib2.Request(url,form_data)response = urllib2.urlopen(request)print response.read()2、使用代理IP在开发爬虫过程中经常会遇到IP被封掉的情况,这时就需要用到代理IP;在urllib2包中有ProxyHandler类,通过此类可以设置代理访问网页,如下代码片段:import urllib2proxy = urllib2.ProxyHandler({http: 127.0.0.1:8087})opener = urllib2.build_opener(proxy)urllib2.install_opener(opener)response = urllib2.urlopen(http://baidu)print response.read()3、Cookies处理cookies是某些网站为了辨别用户身份、进行session跟踪而储存在用户本地终端上的数据(通常经过加密),python提供了cookielib模块用于处理cookies,cookielib模块的主要作用是提供可存储cookie的对象,以便于与urllib2模块配合使用来访问Internet资源.代码片段:import urllib2, cookielibcookie_support= urllib2.HTTPCookieProcessor(cookielib.CookieJar())opener = urllib2.build_opener(cookie_support)urllib2.install_opener(opener)content = urllib2.urlopen(http://XXXX).read()。

Python网络爬虫的数据抓取与处理

Python网络爬虫的数据抓取与处理网络爬虫是一种自动化程序,用于从互联网上获取各种信息。

Python是一种强大的编程语言,广泛应用于网络爬虫的开发。

本文将介绍Python网络爬虫的数据抓取与处理的基本原理和方法。

一、数据抓取1. 数据抓取的概念和方法数据抓取是指从网页上提取所需的信息。

Python提供了多个库,如Requests和BeautifulSoup,用于实现网页的请求和解析。

通过发送HTTP请求,我们可以获取网页的HTML源代码。

然后,使用解析库将HTML源代码转化为一个可以操作的对象,如BeautifulSoup对象。

2. 网络请求的发送使用Requests库发送网络请求是一种简单而方便的方法。

我们可以指定请求的URL、请求方法、请求头等参数,并通过添加参数、表单数据或JSON数据进行请求。

3. HTML解析BeautifulSoup库可以将HTML源代码解析为一个Python对象,使得我们可以使用Python的强大功能来解析和提取所需的数据。

可以使用BeautifulSoup提供的方法和选择器来定位和提取HTML元素。

二、数据处理1. 数据清洗与整理爬取的数据通常会包含一些无用的信息、空格、特殊字符等。

我们需要进行数据清洗,去除这些无关的内容。

可以使用正则表达式或字符串处理方法来清洗数据,并将其整理成我们所需的格式。

2. 数据存储在爬虫过程中,我们需要将获取到的数据保存下来。

可以选择将数据存储到数据库中(如MySQL、MongoDB等)或保存为本地文件。

使用Python的数据库连接库和文件操作方法,我们可以将数据存储到所选的存储介质中。

3. 数据分析与可视化抓取的数据经过清洗和整理后,我们可以进行数据分析和可视化。

Python提供了多个数据分析和可视化的库,如Numpy、Pandas和Matplotlib等。

可以使用这些库来进行数据统计、计算、绘图等操作,从而对数据进行深入分析。

三、注意事项和技巧1. 尊重网站规则在进行数据抓取时,我们需要尊重网站的规则。

Python网络爬虫中的数据抓取与处理的实战经验分享

Python网络爬虫中的数据抓取与处理的实战经验分享随着互联网的快速发展,数据已经成为我们生活和工作中不可或缺的一部分。

而在海量的数据中,我们经常会遇到需要从网页上抓取数据并进行处理的情况。

Python作为一门强大的编程语言,拥有丰富的网络爬虫库和数据处理工具,使得我们可以高效地进行数据抓取与处理。

本文将分享一些在Python网络爬虫中的数据抓取与处理过程中的实战经验。

一、数据抓取在进行数据抓取之前,我们首先需要了解要抓取的网页的结构和所需数据在网页中的位置。

通常,我们可以使用Python中的requests库来发送HTTP请求获取网页内容,然后使用解析库(如BeautifulSoup或XPath)来提取所需数据。

1. 发送HTTP请求要发送HTTP请求,我们可以使用requests库中的get或post方法。

其中,get方法用于获取网页内容,post方法用于提交表单数据或进行其他与服务器的交互。

示例代码:```pythonimport requestsdef get_page(url):response = requests.get(url)if response.status_code == 200:return response.textelse:return None```2. 解析网页获取网页内容后,我们需要使用解析库来提取所需数据。

如果网页是HTML格式的,可以使用BeautifulSoup库来解析;如果网页是XML格式的,可以使用lxml库来解析。

示例代码:```pythonfrom bs4 import BeautifulSoupdef parse_page(html):soup = BeautifulSoup(html, 'html.parser')# TODO: 提取所需数据的代码return data```二、数据处理一旦我们成功抓取到了所需的数据,接下来就是对数据进行处理。

Python网络爬虫中的数据抓取策略与优化

Python网络爬虫中的数据抓取策略与优化Python网络爬虫是一种用于自动化获取互联网上数据的工具,它能够通过HTTP协议与网站交互,模拟浏览器行为并获取页面的结构化数据。

在实际应用中,数据抓取策略与优化是提高爬虫效率和稳定性的关键因素。

本文将介绍Python网络爬虫中的常见数据抓取策略,并讨论一些优化技巧。

一、目标网站与数据分析在开始编写网络爬虫之前,首先需要明确目标网站和所需抓取的数据类型。

分析目标网站的页面结构和数据特征,确定合适的数据抓取方案。

可以通过Chrome浏览器的开发者工具或者Python的第三方库BeautifulSoup进行网页分析,查看页面元素和数据节点的选择器,以便后续编写抓取代码。

二、数据抓取策略1. 基本数据抓取针对简单的网页,可以使用Python的第三方库requests发送HTTP 请求获取网页内容,并使用正则表达式或者BeautifulSoup解析和提取所需数据。

例如,使用requests.get(url)获取网页内容,然后通过正则表达式或者BeautifulSoup选择器,提取出所需数据。

2. 动态数据抓取对于使用JavaScript动态加载数据的网页,上述基本策略无法获取到完整的数据。

这时可以使用模拟浏览器行为的工具,如Selenium或者Pyppeteer来实现数据的完整获取。

这些工具可以自动执行JavaScript代码,并获取执行后的页面内容。

使用这些工具,需要安装对应的浏览器驱动,如ChromeDriver或者GeckoDriver等,并编写相应的代码来模拟用户交互操作,实现动态数据抓取。

3. 高级数据抓取在一些复杂的网站中,反爬虫机制可能会被使用,阻碍数据的抓取。

针对这种情况,可以尝试以下策略:- 使用随机User-Agent头信息,模拟不同类型的浏览器请求;- 使用代理IP进行请求,避免IP被封禁;- 对请求进行频率控制,防止过于频繁的访问被网站限制;- 使用验证码自动识别工具,如Tesseract、机器学习模型等。

Python网络爬虫的优化技巧与经验分享

Python网络爬虫的优化技巧与经验分享在当今信息时代,互联网成为了获取各种数据的主要途径之一。

而Python作为一种简单易学且功能强大的编程语言,被广泛应用于网络爬虫的开发中。

本文将分享一些优化Python网络爬虫的技巧与经验,帮助读者更高效地爬取所需的数据。

一、合理使用请求头对于大多数网站而言,为了防止爬虫的恶意请求,会通过检查请求头中的User-Agent等信息来判断请求的合法性。

因此,在编写爬虫时,合理设置请求头是非常重要的一项优化措施。

可以通过设置User-Agent、Referer、Accept-Language等字段来模拟浏览器发送请求,减少被服务器屏蔽的概率。

二、设置合理的请求频率和超时时间在网络爬虫中,请求频率过高容易引起服务器拒绝服务或被封IP的情况。

为了避免这种问题的发生,我们可以设置合理的请求频率,避免对服务器造成过大的负担。

同时,合理设置超时时间也能够提高爬虫的运行效率,避免长时间等待服务器响应而浪费时间。

三、使用代理IP当我们需要大规模爬取数据时,为了避免被服务器封禁IP,可以使用代理IP来进行请求。

代理IP可以隐藏我们的真实IP地址,增加爬虫的请求隐蔽性。

通过使用多个代理IP进行轮换,可以有效提高爬虫的稳定性和成功率。

四、使用多线程或异步请求在Python中,可以使用多线程或异步请求的方式来提高爬虫的效率。

通过使用多线程,可以同时处理多个请求,加快数据的获取速度。

而通过异步请求,可以在等待某个请求的响应时,继续发送其他请求,充分利用网络资源,提高爬虫的效率。

五、使用缓存策略当我们需要爬取的数据具有一定稳定性时,可以采用缓存策略来避免重复请求。

通过缓存已经获取的数据,可以减少对服务器的请求次数,提高爬虫的效率。

常见的缓存策略包括内存缓存和磁盘缓存,可以根据具体情况选择合适的方式。

六、异常处理与日志记录在爬虫过程中,难免会遇到各种问题,如网络连接失败、网页解析错误等。

为了提高爬虫的稳定性,我们应该合理地处理这些异常情况,并记录日志以便后期排查和分析。

使用Python实现网络爬虫的编程技巧

使用Python实现网络爬虫的编程技巧在当今信息爆炸的时代,互联网成为了人们获取信息的重要渠道。

而网络爬虫作为一种自动化工具,可以帮助我们从互联网中快速、高效地获取所需的数据。

Python作为一种简单易用且功能强大的编程语言,被广泛应用于网络爬虫的开发中。

本文将介绍使用Python实现网络爬虫的一些编程技巧。

一、选择合适的爬虫框架在开始编写网络爬虫之前,我们需要选择一个合适的爬虫框架。

Python中有很多成熟的爬虫框架,如Scrapy、Beautiful Soup等。

这些框架提供了丰富的功能和方便的接口,可以大大简化爬虫的开发过程。

根据具体需求和个人喜好,选择一个适合自己的框架进行开发。

二、设置合理的请求头在进行网络爬取时,我们需要发送HTTP请求来获取网页内容。

为了避免被网站认定为恶意爬虫,我们需要设置合理的请求头。

请求头中包含了一些信息,如User-Agent、Referer等,可以模拟浏览器的行为,减少被封禁的风险。

三、处理网页内容获取到网页内容后,我们需要对其进行处理,提取我们所需的数据。

这时可以使用正则表达式、XPath、CSS选择器等方法来进行数据提取。

Python中有很多强大的库可以帮助我们进行数据解析,如re、lxml、Beautiful Soup等。

选择合适的库来处理网页内容,可以大大提高开发效率。

四、处理反爬措施为了防止被爬虫频繁访问,很多网站会采取一些反爬措施,如设置验证码、限制访问频率等。

在编写爬虫时,我们需要针对这些反爬措施进行相应的处理。

可以使用代理IP、随机延时等方法来规避反爬措施,保证爬虫的正常运行。

五、数据存储和去重在进行数据爬取时,我们通常需要将获取到的数据进行存储,以便后续的分析和使用。

可以将数据存储到数据库中,也可以保存为文件或者导出为其他格式。

同时,为了避免重复爬取相同的数据,我们需要对已爬取的数据进行去重处理。

可以使用哈希算法、数据库的唯一索引等方法来实现数据的去重。

python爬虫方法总结

python爬虫方法总结

Python 爬虫是一种通过编程自动获取互联网上信息的技术。

总

结起来,Python 爬虫的方法包括以下几个方面:

1. 使用 requests 库发送 HTTP 请求获取网页内容。

可以使用GET 或 POST 方法获取网页内容,还可以设置请求头、代理等信息。

2. 使用 BeautifulSoup 或 lxml 解析网页内容。

这些库可以

帮助我们从 HTML 或 XML 中提取出需要的信息,比如链接、文本、

图片等。

3. 使用正则表达式进行信息提取。

在一些情况下,可以使用正

则表达式来匹配并提取网页中的特定信息。

4. 处理动态网页。

对于使用 JavaScript 动态加载内容的网页,可以使用 Selenium 或 Pyppeteer 等工具模拟浏览器行为,获取完

整的页面内容。

5. 存储数据。

爬取到的数据可以存储到数据库中,比如 MySQL、MongoDB,也可以存储为文件,比如 CSV、JSON 等格式。

总的来说,Python 爬虫的方法涉及到发送请求、解析内容、处理动态页面和存储数据等方面,需要综合运用多种技术来完成对目标网站的信息获取。

学习Python网络爬虫的高级技巧

学习Python网络爬虫的高级技巧第一章爬虫基础知识爬虫是一种自动化的数据抓取工具,通过模拟人的浏览器行为来获取网页上的数据。

Python是开发爬虫的一种常用语言,具有丰富的库和框架支持。

在学习Python网络爬虫的高级技巧之前,我们首先需要了解几个爬虫的基础知识。

1.1 网络协议网络爬虫需要通过HTTP或HTTPS协议发送请求获取网页数据。

了解这些协议的基本原理和常用请求方式对于编写高效的爬虫程序是非常重要的。

1.2 Python网络请求库Python提供了许多网络请求库,如urllib、urllib2、requests等。

这些库可以帮助我们发送HTTP请求、处理Cookie和代理等,是编写爬虫程序的基础工具。

第二章爬取动态网页许多网页使用AJAX技术动态加载数据,对于这样的网页,我们需要使用一些高级技巧来进行爬取。

2.1 Selenium自动化工具Selenium是一种自动化测试工具,同时也可以用于爬虫。

通过模拟浏览器行为,我们可以执行JavaScript代码并获取动态生成的内容。

2.2 使用PhantomJS无界面浏览器PhantomJS是一个基于WebKit的无界面浏览器,我们可以使用它来执行JavaScript代码并获取完整的动态页面内容。

第三章反爬虫策略和应对方法为了保护网站数据的安全和防止恶意爬取,许多网站会采取一些策略来反爬虫。

了解这些策略并采取相应的应对方法是进行高级爬虫开发的关键。

3.1 User-Agent伪装User-Agent是用来标识爬虫的身份,网站可以通过User-Agent 来判断是否为爬虫访问。

我们可以伪装User-Agent,使其看起来更像一个普通用户的浏览器来规避反爬虫策略。

3.2 IP代理池有些网站会根据IP地址限制访问次数或者禁止某些IP地址的访问。

通过使用IP代理池,我们可以轮流使用不同的IP地址来避免被封禁。

第四章数据解析和存储爬虫只是获取网页数据的第一步,接下来我们需要将数据进行解析和存储,以便后续的分析和使用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

推特上看过来的,感觉好悬

Reply

tyz says:

January 12, 2010 at 3:56 pm

博主不会那么俗的,应该在家写爬龙脚本准备把大家都吓死。。。

Reply

/?p=476

impo rt urllib postdata=urllib.urlencode({ 'username':'XXXXX', 'password':'XXXXX', 'continueURI':'/', 'fk':fk, 'login_submit':'登录' })

5.验证码的处理 碰到验证码咋办?这里分两种情况处理: 1.google那种验证码,凉拌 2.简单的验证码:字符个数有限,只使用了简单的平移或旋转加噪音而没有扭曲的,这种还是有可能可以处理 的,一般思路是旋转的转回来,噪音去掉,然后划分单个字符,划分好了以后再通过特征提取的方法(例如PCA) 降维并生成特征库,然后把验证码和特征库进行比较。这个比较复杂,一篇博文是说不完的,这里就不展开了, 具体做法请弄本相关教科书好好研究一下。 3.事实上有些验证码还是很弱的,这里就不点名了,反正我通过2的方法提取过准确度非常高的验证码,所以2事 实上是可行的。 6.总结 基本上我遇到过的所有情况,用以上方法都顺利解决了,不太清楚还有没有其他漏掉的情况,所以本文到这里就 完成了,以后要是碰上其他情况,再补充相关方法好了:) 本文后续见: /?p=753

5/7

2011/4/4

wpzone says:

January 13, 2010 at 5:15 pm

用python爬虫抓站的一些技巧总结 | ob…

/old的文章都很实用,让我了解了不少东西,强烈建议博主更新频繁一点

This entry was posted in python, 编程 and tagged python, 编程. Bookmark the permalink.

20 Responses to 用 python爬虫抓站的一些技巧总结

qsun says:

December 26, 2009 at 8:43 pm

/?p=476

4/7

2011/4/4

Reply

用python爬虫抓站的一些技巧总结 | ob…

Good says:

December 27, 2009 at 12:11 am

不错,python简单的多线程确实适合爬虫,有正则,基本上就没什么大问题了

Reply

Pingback: Tw eets that mention 用python 爬虫抓站的一些技巧总结 | Observer专栏杂记 --

headers是一个dict数据结构,你可以放入任何想要的header,来做一些伪装。例如,有些自作聪明的网站总喜欢 窥人隐私,别人通过代理访问,他偏偏要读取header中的X-Forwarded-For来看看人家的真实IP,没话说,那就 直接把X-Forwarde-For改了吧,可以改成随便什么好玩的东东来欺负欺负他,呵呵。 3.5 终极绝招 有时候即使做了3.1-3.4,访问还是会被据,那么没办法,老老实实把httpfox中看到的headers全都写上,那一般 也就行了。 再不行,那就只能用终极绝招了,selenium直接控制浏览器来进行访问,只要浏览器可以做到的,那么它也可以 做到。类似的还有pamie,watir,等等等等。 4.多线程并发抓取 单线程太慢的话,就需要多线程了,这里给个简单的线程池模板 这个程序只是简单地打印了1-10,但是可以看出是并发地。

impo rt urllib2 content = urllib2.urlopen('http://XXXX').read()

2.使用代理服务器 这在某些情况下比较有用,比如IP被封了,或者比如IP访问的次数受到限制等等。

impo rt urllib2 proxy_support = urllib2.ProxyHandler({'http':'http://XX.XX.XX.XX:XXXX'}) opener = urllib2.build_opener(proxy_support, urllib2.HTTPHandler) urllib2.install_opener(opener) content = urllib2.urlopen('http://XXXX').read()

/?p=476

3/7

2011/4/4

用python爬虫抓站的一些技巧总结 | ob…

#这个是工作进程,负责不断从队列取数据并处理 def working(): wh ile True: arguments = q.get() do_somthing_using(arguments) sleep(1) q.task_done() #fork NUM个线程等待队列 for i i n range(NUM): t = Thread(target=working) t.setDaemon(True) t.start() #把JOBS排入队列 for i i n range(JOBS): q.put(i) #等待所有JOBS完成 q.join()

2011/4/4 observer 专栏杂记

建站 编程 杂记

用python爬虫抓站的一些技巧总结 | ob…

用 python爬虫抓站的一些技巧总结

Posted on December 26, 2009 by observer

学用python也有3个多月了,用得最多的还是各类爬虫脚本:写过抓代理本机验证的脚本,写过在discuz论坛中自 动登录自动发贴的脚本,写过自动收邮件的脚本,写过简单的验证码识别的脚本,本来想写google music的抓取 脚本的,结果有了强大的gmbox,也就不用写了。 这些脚本有一个共性,都是和web相关的,总要用到获取链接的一些方法,再加上simplecd这个半爬虫半网站的 项目,累积不少爬虫抓站的经验,在此总结一下,那么以后做东西也就不用重复劳动了。 1.最基本的抓站

是的没错,如果想同时用代理和cookie,那就加入proxy_support然后operner改为

opener = urllib2.build_opener(proxy_support, cookie_support, urllib2.HTTPHandler)

3.2 表单的处理

/?p=476 1/7

oldjan says:

December 27, 2009 at 4:20 am

写得真不错 正好在学习这方面 感谢你的分享

Reply

bones7456 says:

December 27, 2009 at 9:29 pm

宝贵的经验,太有用了,谢谢Observer ! PS:我那半成品gmbox 也被提到了,哈哈。。。

Reply

犀牛 says:

December 28, 2009 at 2:45 am

请问 centos的vps能否搭建SimpleCD的运行环境

Reply

loveandy183 says:

December 29, 2009 at 11:49 am

你好,我是菜鸟,弱弱的问一下你的“最基本的抓站”里面代码运行下,会产生什么样的效果,我这边没一点反应,我网址里填 的

3.4 反 ”反盗链 ” 某些站点有所谓的反盗链设置,其实说穿了很简单,就是检查你发送请求的header里面,referer站点是不是他自 己,所以我们只需要像3.3一样,把headers的referer改成该网站即可,以黑幕著称地cnbeta为例:

#... headers = { 'Referer':'/articles' } #...

3.需要登录的情况 登录的情况比较麻烦我把问题拆分一下: 3.1 cookie的处理

impo rt urllib2, cookielib cookie_support= urllib2.HTTPCookieProcessor(cookielib.CookieJar()) opener = urllib2.build_opener(cookie_support, urllib2.HTTPHandler) urllib2.install_opener(opener) content = urllib2.urlopen('http://XXXX').read()

然后生成http请求,再发送请求:

req = urllib2.Request( url = '/signin/*//', data = postdata ) result = urllib2.urlopen(req).read()

2011/4/4

用python爬虫抓站的一些技巧总结 | ob…

登录必要填表,表单怎么填?首先利用工具截取所要填表的内容 比如我一般用firefox+httpfox插件来看看自己到底发送了些什么包 这个我就举个例子好了,以verycd为例,先找到自己发的POST请求,以及POST表单项:

可以看到verycd的话需要填username,password,continueURI,fk,login_submit 这几项,其中fk是随机生成的(其 实不太随机,看上去像是把epoch时间经过简单的编码生成的),需要从网页获取,也就是说得先访问一次网 页,用正则表达式等工具截取返回数据中的fk项。continueURI顾名思义可以随便写,login_submit是固定的, 这从源码可以看出。还有username,password那就很显然了。 好的,有了要填写的数据,我们就要生成postdata