学习 camera framework 总结

讯道摄像机学习情况总结

讯道摄像机系统学习总结学习时间:7.12-7.13使用到的主要设备有:1.讯道摄像机(CAM)2.对焦/变焦伺服手柄3.摄像机寻像器4.摄像机控制单元(CCU)5.远程控制面板(RCP)6.监视器其它:三脚架、BNC线缆、讯道摄像机光缆以及电源线若干本次学习内容:1.前期准备工作:①三脚架的使用:打开并支起三脚架到合适的高度后,认识水平阻尼开关、俯仰阻尼开关,俯仰回弹阻尼开关位置,上手体验不同阻尼下的手感。

利用水平调节阀进行三脚架水平的校准;②摄像机镜头的安装、摄像机托板的安装;③将安装好托板的摄像机安装到三脚架上,安装好后打开三脚架云台锁扣,卸下摄像机;④安装摄像机寻像器。

2.通过不同的线缆将各设备连接起来:①伺服手柄域摄像机机头的连接;②寻像器与摄像机的连接;③摄像机通过光缆与CCU进行连接;④RCP与CCU使用CCA-5线缆进行连接;⑤CCU板卡安装与取下;⑥CCU与监视器使用BNC电缆连接。

3.连接好设备后,依次打开各设备电源,详细观看与操作设备:①机头菜单操作;②使用伺服手柄进行摄像机的变焦/对焦操作,认识手柄上的RET按键FRAMESPEED等按键的功能;③打开摄像机控制菜单,对摄像机进行一些基本的参数调节;④摄像机的后焦校准;⑤寻像器的设置与使用,面板各按钮、旋钮的功能,如自定义按键、PEAKING旋钮等;⑥认识监视器前面板的各按钮,打开并认识设置菜单,调整监视器显示参数(亮度、对比度、饱和度等);⑦认识CCU前面板各按钮,后面板各接口,通过RCP打开CCU的设置菜单,操作并调整部分菜单设置;⑧使用RCP对CAM进行控制,操作光圈、设置黑、白平衡、色温等参数;⑨认识RCP各个按钮的作用,在RCP触屏上点击各个菜单,了解RCP的其它操作;学习情况说明:学习成员有高XX、王XX、宋XX、韩XX,由张XX、李xx指导,每个人均上手对各设备进行了安装与拆卸,认识并实际操作了各种设备。

cam总结

CAM总结1. 引言卷积注意力机制(Convolutional Attention Mechanism,CAM)是一种基于深度学习的图像理解和目标定位技术。

CAM通过学习图像的局部信息和全局上下文,能够在图像中准确地定位感兴趣的目标物体。

本文将对CAM的原理、应用和优缺点进行详细总结。

2. CAM原理CAM的基本原理是通过将全局平均池化(Global Average Pooling,GAP)应用于卷积层的特征图上,得到与输出类别相关的类激活图(Class Activation Map)。

CAM将卷积层的输出特征图与全局平均池化结合,将注意力集中在对目标物体有区分度和重要性的特定位置上。

CAM的实现步骤如下: - 通过卷积神经网络提取图像特征; - 将特征图进行全局平均池化,得到每个特征图通道的权重; - 将权重与特征图相乘,得到类激活图。

CAM的优点在于其简单、易解释且计算效率高,在图像分类、目标定位等任务中表现出良好的性能。

3. CAM的应用3.1 图像分类CAM在图像分类任务中广泛应用。

通过对图像进行分类,CAM能够输出类激活图,高亮显示出图像中对分类结果具有重要贡献的区域。

这有助于理解模型对不同类别的判断依据,并提供可解释性。

3.2 目标定位CAM在目标定位任务中发挥关键作用。

通过计算类激活图,CAM能够准确地定位出目标物体在图像中的位置。

这对于视觉检测、图像分割等任务具有重要意义。

3.3 视觉解释CAM还可以用于图像的视觉解释。

通过显示类激活图,CAM能够帮助用户理解模型在图像上的注意力分布,从而提高对图像分类和目标检测结果的信任度。

4. CAM的优缺点4.1 优点•简单易懂:CAM使用了简单的全局平均池化和特征图相乘的操作,原理直观易懂。

•高效计算:CAM的计算效率较高,适用于大规模图像数据处理。

•可解释性强:CAM能够输出可解释的类激活图,帮助理解模型的决策过程。

4.2 缺点•局限性:CAM在处理复杂场景、遮挡较多的图像上可能效果不佳,对于细节信息的提取能力有限。

相机成像知识点归纳总结

相机成像知识点归纳总结相机成像是指相机通过光学系统和成像传感器将物体上的光信息转换成电信号,然后再转换成可视的图像的过程。

相机成像涉及到光学、传感器、图像处理等多个方面的知识。

在本文中,我将对相机成像的一些重要知识点进行归纳总结,希望能对读者有所帮助。

一、光学系统1.1 光学系统组成光学系统是相机的重要组成部分,其主要由镜头、光圈、快门和滤镜等组成。

1.2 镜头镜头是相机光学系统的核心部件,它的主要作用是将光线聚焦到成像传感器上。

镜头的质量直接影响着图像的清晰度和色彩还原度。

镜头的焦距、光圈、变焦方式、防抖等都是镜头的重要参数。

1.3 光圈光圈是控制镜头入射光线的大小和量的装置。

光圈大小的调节可以控制光线的透过量,从而控制图像的曝光量和景深。

1.4 快门快门是控制光线进入成像传感器的时间和速度的装置。

快门的快慢决定了影像的曝光时间,影响照片的动态效果。

1.5 滤镜滤镜是用来过滤入射光线中特定波长成分的装置,如紫外线、可见光和红外线等。

在特殊的光线条件下,使用适当的滤镜可以对图像进行修饰。

二、成像传感器2.1 成像传感器的种类成像传感器主要有CCD和CMOS两种类型。

CCD(Charge Coupled Device)传感器在感光元件之间传递电荷,其优点是信噪比高、低噪声,但功耗较大。

CMOS(Complementary Metal-Oxide-Semiconductor)传感器直接将感光元件产生的电信号转换成数字信号,其优点是功耗低、易于集成,但信噪比相对较低。

2.2 成像传感器参数成像传感器的参数包括像素数、感光元件大小、感光元件类型等。

像素数决定了图像的分辨率,感光元件大小和类型决定了图像的噪声和动态范围。

2.3 成像传感器的工作原理成像传感器通过感光元件的感光和电荷转换来实现对光信号的采集和转换。

传感器在接受到光线后,感光元件产生的电荷被转换为数字信号,再经过处理成为可见的图像。

三、图像处理3.1 图像处理的主要功能图像处理包括白平衡、曝光补偿、锐化、降噪等多种功能。

camera常用知识及流程分析

2.1 mediaservice启动 在init.rc文件中

service media /system/bin/mediaserver class main user media group system audio camera inet net_bt net_bt_admin net_bw_acct drmrpc mediadrm ioprio rt 4

五、3288和3188及以前的代码差异

5.1 两者差别

两者差别最大的就在camera大部分驱动放在camerahal做的。 3288的驱动文件放在hardware\rk29\camera\SiliconImage\isi\drv,这里面只是简单 camera芯片数组集合,以及一些函数结构体的赋值,部分操作代码放在库里面。 3288比其他芯片多了isp(Image Signal Processing),当然对图像的处理代码也放在 相应的isp库里面。 camera定义的地方也有所不一样hardware\rk29\camera\Config\cam_board.xml 具体的定义的说明可以看相关文档

三、kernel相关代码分析

3.2 v4l2_device

如上所说,camera host是一个v4l2_device设备,即我们的cif相关驱动, cif驱动较sub_dev复杂一点。 在上面说的目录下面有 rk30_camera_oneframe.c rk30_camera_pingpong.c 两个文件,目前默认的为前一种模式,即单帧模式,后一种为乒乓模式。 那host驱动就涉及到裁剪,格式,制式,videobuf的初始化与设置。 当全部设置好,会设置寄存器设置开始接收stream流,当buf接受满后会产生中 断,进入rk_camera_irq函数,会将camera数据存入队列,并将vb->state = VIDEOBUF_DONE;

人工智能实训课程学习总结使用深度学习算法进行像识别的实践经验分享

人工智能实训课程学习总结使用深度学习算法进行像识别的实践经验分享人工智能实训课程学习总结:使用深度学习算法进行图像识别的实践经验分享人工智能(Artificial Intelligence,简称AI)作为近年来备受关注的热门领域,为了更好地掌握和应用AI技术,我参加了一门人工智能实训课程。

这门课程主要以深度学习算法为核心,围绕图像识别展开。

在课程学习的过程中,我不断积累了实践经验,克服了各种困难,取得了一定的成果。

下面将分享我在这门课程中的学习总结和实践经验。

一、课程背景和目标人工智能实训课程是为了培养学员对深度学习算法在图像识别领域的应用能力而设立的。

通过该课程,我们旨在掌握深度学习算法的基本原理和常见模型,学会利用深度学习算法进行图像分类、目标检测等任务,并能够运用已学知识和工具,进行实际的图像识别项目开发。

二、课程学习和实践过程1. 学习基础理论知识在课程开始阶段,我们系统学习了深度学习算法的基础理论知识,包括神经网络的原理、卷积神经网络(Convolutional Neural Network,简称CNN)的结构和工作原理等。

通过理论学习,我们深入理解了深度学习算法的核心思想和运行机制。

2. 实践项目案例为了更好地将理论知识转化为实践能力,我们进行了多个图像识别项目的实践。

这些项目案例涵盖了不同领域和不同难度的图像识别任务,如手写数字识别、猫狗分类、人脸识别等。

通过参与实践项目,我们逐步了解了深度学习算法在具体任务中的应用方法,熟悉了相关工具和框架的使用,提高了项目实施的能力。

3. 解决实践难题在实践过程中,我们也遇到了不少困难和挑战。

例如,对于某些任务,模型训练时间过长,需要优化网络结构和参数设置;又如,针对少样本问题,我们需要应用迁移学习等方法进行补救。

面对这些实践难题,我们通过查阅文献、与同学分享经验等方式,积极寻找解决方案,最终获得了令人满意的结果。

4. 总结归纳和反思课程学习结束后,我们进行了总结归纳和反思。

Camera_framework

CAMERA FRAMEWORKCAMERA.JAVA

Camera.java提供了操作Cameramera的参数的功能。 3.Preview功能:

a.将Preview的显示到屏幕上或者是SurfaceTexture上。

b.获取Camera preview Frame的callstack 4.Capture a.onShutter, JPEG, RAW, " PostView" 5. Lock 和Unlock功能 6. Focus,Zoom及FaceDetection功能

FRAMEWORKSERVICE

Camera service要点: 1.管理 Camera硬件资源 2.运行在MediaServer进程中 3.是一个SharedLibrary libCameraService.so a android.permissions.Camera的检查 b 确保只有一个Client 链接到一个Camera硬件对象 c 确保进程连接到一个Camera硬件对象 d 返回Callback给APP层 e 通过Binder访问

CAMERA FRAMEWORK辅助类

几个辅助小类:

Camera Parameter camera parameter的设置,包含white balance, color effect, exposure, scene mode, antibanding, focus mode, preview size, picture size。

FRAMEWORK文件模 块

Camera Framework的client部分:

代码位置:frameworks/av/camera

Camera.cpp \ CameraMetadata.cpp \ CameraParameters.cpp \ ICamera.cpp \ ICameraClient.cpp \ ICameraService.cpp \ ICameraServiceListener.cpp \ ICameraRecordingProxy.cpp \ ICameraRecordingProxyListener.cpp \ IProCameraUser.cpp \ IProCameraCallbacks.cpp \ camera2/ICameraDeviceUser.cpp \ camera2/ICameraDeviceCallbacks.cpp \ camera2/CaptureRequest.cpp \ ProCamera.cpp \ CameraBase.cpp \

调试camera总结

调试camera经验总结。

一个好的camera效果,需要多方面保证,1.senor,镜头,马达要好,这是源,如果源头不好,后面怎么优化都没有用。

2.ISP要好,ISP是否有硬件滤波器?3A算法是否先进,iphone好也是其3A的算法很厉害。

对于我们来说,首先是争取选择更好的物理,是否是背照式是sensor?如果需要夜景好是否是大pixel的sensor 或者是否是RGBW的sensor?镜头的光圈是否足够大,是5P,还是6P的,是否带有蓝光玻璃等?选定好了一款sensor,怎么开始我们调试工作。

1.找模组厂要到golden模组,如AWB,shading和AF的golden,后续我们的调试都是基于这个模组,只有使用这种模组调试的才能cover尽可能多的模组。

如果有条件的话,可以向厂家要到一些corner模组,用来验证我们后续调试的效果怎么样?2.点亮我们的sensor,检查出图是否正常?如色彩是否正常,powernoise是否很明显?马达是否能正常工作,闪光灯是否能正常工作?3.Sensor是否烧入了OTP,如果烧入了OTP,需要导入OTP,验证OTP工作是否正常?4.以上都准备好了的话,我们就可以进入camera的调试。

对于调试一个camera的模组,我们首先要评估这个模组的能力怎么样?确定我们帧率和gain策略,特别是对于帧率一旦修改,理论上整个效果都需要重新开始调试。

确定好了曝光表之后,我们就可以用golden模组拍raw图了,拍好raw图,按照高通的文档一步步进行调试。

调试完成之后,测一下客观指标,分辨率,AWB,饱和度,色彩误差,灰阶,亮度均匀性,色彩均匀性,noise等,需要保证各个客观指标不能有大问题,每一项由问题,都说明我们的那一方面调试或者是我们raw图片拍出问题,需要分析原因解决问题。

满足客观指标之后,再去测试各个主观测试场景,如室内人物,室内花草,室内文字,夜景照片,室外人物,室外花草,室外建筑物,室外汽车等各个场景,根据各个场景的问题再解决。

cief原理 -回复

cief原理-回复" cief原理"是一个模型评估指标,用于衡量深度学习模型的性能和鲁棒性。

在本文中,我们将逐步回答关于"CIEF原理"的问题。

第一步:什么是CIEF原理?"CIEF原理"是Camera Image Evaluation Framework(相机图像评估框架)的缩写。

它是由日本电子信息通信研究所(NICT)开发的一种模型评估指标。

该原理旨在全面评估深度学习模型对摄像机图像品质和感知的影响,以便更好地了解和改进模型的性能。

第二步:为什么需要CIEF原理?在现代计算机视觉和图像处理中,深度学习模型在图像生成、图像修复、图像增强等任务中发挥着重要作用。

然而,传统的图像质量评估指标往往无法全面评价深度学习模型的性能,因为这些指标往往只关注图像的一些局部属性,无法反映人类感知。

CIEF原理通过结合客观评价和主观评价,从人类感知的角度来评估深度学习模型。

这有助于更全面地理解模型对图像品质和感知的影响,并为改进模型提供指导。

第三步:CIEF原理如何工作?CIEF原理主要包括以下几个步骤:1. 数据准备:首先,需要准备一组图像样本,包括参考图像(原始图像)和测试图像(由模型生成的图像)。

这些图像应该涵盖不同场景和典型问题。

2. 主观实验:进行主观评价实验,邀请一些参与者对参考图像和测试图像进行评级或排序。

可以使用多种评估方法,如有/无参考评估、对比评估等。

参与者可能是专业人士、普通用户或受过培训的观众。

3. 客观评价:使用一些客观评价指标衡量参考图像和测试图像之间的差异。

这些指标可以包括图像质量指标(如PSNR、SSIM、NIQE等)和视觉差异指标(如DSSIM、MSSSIM等)。

4. 模型性能分析:将主观评估和客观评价的结果结合起来,分析深度学习模型的性能。

这可以通过计算CIEF得分(CIEF Score)来完成。

CIEF 得分是一种标量指标,用于衡量模型的整体性能和优劣。

camera驱动交流(高通平台)

Then 进入HAL层 /hardware/qcom/camera/QualcommCamera2.cpp

/hardware/qcom/camera/QcameraHWI.cpp

status_t QCameraHardwareInterface::autoFocus() { …

Kernel 层初始化时,主要是初始化 I2C 接口、配置参数、check sensor ID

Open 过程(7X):

Open 过程(8X): JAVA层是一样的,不一样的在于HAL层的OPEN方法从 /hardware/qcom/camera/ QualcommCamera2.cpp HAL_openCameraHardware(cameraId) 改为了 new QCameraHardwareInterface(cameraId, mode);

我们乊前打开了/dev/video2 的节点,在 msm_open 函数中最后会去 调 用 msm_send_open_server,这 个函数 会 去唤 醒我 们用 户 空间 的 config 线程。

在这个函数中我们需要注意这个timeout的时间限制,它是要求我们 的请求必须在10s内完成,否则config线程就会超时,从而导致相机将 无法使用,只能通过重启来修复。 这个MSM_V4L2_OPEN将会调用到 \vendor\qcom\proprietary\mm-camera\server\core\Qcamsvr. c qcamsvr_process_server_node_event的这个函数会被唤醒 如下:

Then

static int8_t config_proc_CAMERA_SET_PARM_AUTO_FOCUS(void *parm1, void *parm2) { … rc = ctrl->comp_ops[MCTL_COMPID_SENSOR].set_params( ctrl->comp_ops[MCTL_COMPID_SENSOR].handle, SENSOR_SET_AUTO_FOCUS, NULL, NULL); … } 在上面这个函数有对YUV和RAW sensor进行区分,RAW sensor走的是 MCTL_COMPID_STATSPROC,而YUV是通过MCTL_COMPID_SENSOR往

camera相关知识点总结

camera相关知识点总结一、相机的基本原理1. 光学原理相机的基本原理是利用光学透镜将光线聚焦在感光元件上,以记录被摄物体的影像。

光从被摄物体上反射出来,通过透镜进入相机内部,形成倒立的实际大小的实像。

这个实像成为感光元件上清晰的倒影。

感光元件的光感受器件(CCD或CMOS)是记录这个图像的关键部件。

2. 快门原理快门是相机的一个重要组成部分,它控制相机的曝光时间。

当快门按下时,快门会打开一小段时间,让光线进入感光元件,这就是曝光时间。

曝光时间越长,进入感光元件的光线就越多,照片的亮度就越高;曝光时间越短,光线就越少,照片的亮度就越低。

此外,快门速度还会影响运动物体的清晰度,快门速度越快,动态物体就越清晰,反之越模糊。

3. 光圈原理光圈是控制光线进入相机的部件。

光圈大小用F值表示,F值越小,光线进入相机的量就越大,照片的景深就越浅;F值越大,光线进入相机的量就越小,照片的景深就越深。

光圈的调节对照片焦点的对准和景深的控制起着重要作用。

4. ISO原理ISO是感光度的单位,它表示相机感光元件对光线的灵敏度。

ISO值越高,相机对光线的灵敏度就越高,在暗光环境下也能拍摄清晰亮度的照片;ISO值越低,相机对光线的灵敏度就越低,适合在明亮光线下的拍摄。

二、不同类型相机的特点及用途1. 单反相机单反相机是专业摄影师最常用的相机类型之一。

它具有高像素、快速对焦和成像质量高的特点。

单反相机拥有更多的手动调节功能,可以拍摄出更具创意的照片。

此外,单反相机还可更换镜头,满足不同拍摄场景的需求,如广角、长焦和微距等。

2. 微单相机微单相机是一种介于单反相机和数码相机之间的相机类型。

它拥有较小的体积和重量,更适合日常携带。

微单相机的成像质量、对焦速度和手动调节功能也较为出色。

它通常搭配可更换镜头,可以满足不同拍摄场景的需求。

3. 数码相机数码相机是便携式相机,适合普通人日常拍摄用。

它体积小巧,操作简单,成像质量和对焦速度一般较低。

摄像课实习总结5篇

摄像课实习总结5篇篇1光阴似箭,为期数周的摄像课实习已然结束。

这次实习不仅让我对摄像技术有了更为深入的了解,也让我在实践中不断磨砺技能,提升自我。

现将本次实习经历进行如下总结。

一、实习背景与目的本次实习旨在通过实践操作,将理论知识与实际拍摄相结合,提高摄像技能。

课程涵盖了摄像基础、拍摄技巧、后期制作等多个方面,通过实际操作,我得以在实践中不断摸索,积累经验。

二、实习内容与过程1. 摄像基础学习:实习初期,我们学习了摄像的基本原理和技巧,包括摄像机的使用、构图、光线运用等。

在导师的指导下,我逐渐掌握了摄像机的操作技巧,学会了如何运用光线来营造拍摄氛围。

2. 实战拍摄:学习基础知识的同时,我们进行了实战拍摄。

通过拍摄校园、人物、风景等多种题材,我逐渐将理论知识转化为实际操作。

在拍摄过程中,我学会了如何选择拍摄角度、运用拍摄手法,以及调整参数以获取最佳拍摄效果。

3. 后期制作:拍摄完成后,我们学习了视频剪辑、调色、音效等后期制作技能。

通过实践操作,我逐渐掌握了Premiere、AE等视频制作软件,学会了如何运用这些工具来优化视频效果。

4. 团队协作:实习过程中,我们分组进行了团队拍摄项目。

在团队中,我学会了如何与他人沟通协作,共同完成任务。

我们共同商讨拍摄方案,分工合作,最终完成了任务。

三、实习收获与体会1. 技能提升:通过本次实习,我的摄像技能得到了显著提升。

我不仅掌握了摄像基础知识和技巧,还学会了后期制作和团队协作等技能。

2. 实践经验:实习过程中,我亲自参与了实战拍摄和后期制作,积累了丰富的实践经验。

这些经验对我未来的摄像工作具有指导意义。

3. 解决问题的能力:在实习过程中,我遇到了许多问题和挑战。

通过解决问题,我学会了如何独立思考和解决问题,这对我的职业发展具有重要意义。

4. 团队协作意识:团队拍摄项目让我深刻体会到了团队协作的重要性。

我学会了如何与团队成员沟通协作,共同完成任务。

四、存在问题与建议1. 技能掌握程度不足:虽然实习过程中我取得了一定进步,但仍有许多技能和知识需要继续学习。

Android camera libcamera动态库实现流程总结

Android camera libcamera动态库实现流程总结libcamera.so 流程总结framework/base/include/ui下的CameraHardwareInterface.h定义了libCameraService.so需要的所有接口:getPreviewHeap(),startPreview(preview_callbackcb, void*user),stopPreview(),previewEnabled(),autoFocus(autofocus_callback,void*user),takePicture(shutter_callback,raw_callback,jpeg_callback,void*user)cancelPicture(boolcancel_shutter,boolcancel_raw,boolcancel_jpeg)setParameters(),getParameters()release(), dump(),openCameraHardware()其中还定义了5个函数指针,分别指向CameraService.cpp中定义的5个callback函数:void(*preview_callback)(constsp<IMemory>&mem, void*user);void (*shutter_callback)(void* user);void(*raw_callback)(constsp<IMemory>&mem, void* user);void(*jpeg_callback)(constsp<IMemory>&mem, void* user);void(*autofocus_callback)(bool focused, void* user);libCamera.so是对CameraHardwareInterface.h的具体实现。

camera驱动调试

最近学习了一下camera驱动,除了查看平台文档和sensor的规格书,也在网上查看了高手们到经验。

对camera还是比较陌生的,和大部分驱动的调试相差无几,还是在前人的工作基础上进行的。

下面将我的学习和大家交流一下:一.Framework层1.android.hardware.Camera:代码位置/ap-scr/frameworks/base/core/java/android/hardware/Camera.java这部分目标是framework.jar。

这是是Android 提供给app层调用的java接口。

这个类用来连接或断开一个Camera 服务,设置拍摄参数,开始、停止预览,拍照等。

2.android.hardware.Camera这个类是和JNI中定义的类是一个,有些方法通过JNI的方式调用本地代码得到,有些方法自己实现。

Camera的JAVA native调用部分(JNI):/android/frameworks/base/core/jni/android_hardware_Camera.cpp。

Camera.java 承接JAVA 代码到C++ 代码的桥梁。

编译生成libandroid_runtime.so 。

libandroid_runtime.so库是公用的, 其中除了Camera 还有其他方面的功能。

3.Camera框架的client部分:代码位置:\ap-src\frameworks\av\camera下5个文件。

Camera.cppCameraParameters.cppICamera.cppICameraClient.cppICameraService.cpp它们的头文件在\ap-src\frameworks\av\include\camera目录下。

这部分的内容编译生成libcamera_client.so 。

在Camera 模块的各个库中,libcamera_client.so 位于核心的位置,作为Camera 框架的Client 客户端部分,与另外一部分内容服务端 libcameraservice.so 通过进程间通讯(即Binder 机制)的方式进行通讯。

Android framework camera分析

1 AndroiHale Waihona Puke 's camera 模块概述

Camera 模块是 android 系统中用于处理视频输入的模块。Android 将 camera 定义为一个 framework, 这样客户可以使用 camera's framework 支持不同的硬件,只需客户实现 camera 的 framework 。本文主要介绍 camera framework 和如何实现 camera framework。

class CameraHardwareInterface : public virtual RefBase 类 CameraHardwareInterface 虚拟继承于 RefBase 防止二意性。 RefBase 是引用计数基础类。几乎每个 class 都会继承自 RefBase。

CameraHardwareInterface 中定义了若干函数,下面逐个介绍 virtual ~CameraHardwareInterface() { }

pure vitual function, 设置 3 个 callback,(3 个 callback 一般由 CameraService::Client 中实现)。 下面是 3 个 callback 函数的原型: typedef void (*notify_callback)(int32_t msgType,

virtual sp<IMemoryHeap> getRawHeap() const = 0; pure vitual function, 返回由 new MemoryHeapBase(size) 分配的用于保存 camera 拍照时返回的 rowdata。

virtual void setCallbacks(notify_callback notify_cb, data_callback data_cb, data_callback_timestamp data_cb_timestamp, void* user) = 0;

camera学习入门指南

camera学习⼊门指南等待补充。

1.背景介绍近年来,随着消费电⼦领域市场的快速增长,如安防、图像等领域,camera市场得到了快速发展。

智能⼿机这⼏年以拍照作为主打卖点,带动了camera(CCM)出货。

具体可以看电⼦⾏业分析或者券商研报⾏业分析,⽐如下⾯两份。

在招聘⽹站上搜索camera,可以看到,多为⼿机⼚商、智能硬件和汽车安防相关⾏业,包括tuning、效果、系统、性能功耗、测试等,其中camera tuning的岗位是最多的。

绝⼤多数产品⽅案系统都是使⽤Android操作系统⽅案,所以需要对Android有⼀定了解。

以前camera tuning⼯作是由算法⼯程师完成,后⾯随着⽤户对图像质量要求越来越⾼。

ISP处理器出现和流⾏催⽣很多tuning的⼯作。

基础知识:光学基本概念、camera基础知识:涉及硬件模组、软件架构等,linux驱动开发基本知识。

2.camera基础篇camera和光学知识和摄影知识密切相关。

2.1.光学知识成像原理:视场⾓FOV(Field of View):包括HFOV(⽔平), VFOV(垂直),DFOV(对⾓)Focal Length:焦距EFL(Effective Focal Length)有效焦距、Fno(Aperture Value对应的Focal number)光圈数值,如F2.8,为光圈“系数”,简称为F值。

Fno = EFL/D(光圈直径)RGB(red green blue),光学三原⾊。

⾃然界中⾁眼所能看到的任何⾊彩都可以由这三种⾊彩混合叠加⽽成,因此也称为加⾊模式。

YUV(全称英⽂真没找到),是编译true-color颜⾊空间(color space)的种类,Y'UV, YUV, YCbCr,YPbPr等专有名词都可以称为YUV,彼此有重叠。

Y”表⽰明亮度(Luminance或Luma),也就是灰阶值,“U”和“V”表⽰的则是⾊度(Chrominance或Chroma)。

相机算法入门知识点总结

相机算法入门知识点总结相机算法是指在数字图像处理领域对相机图像进行处理和优化的算法。

相机算法广泛应用于数字相机、手机相机和摄像头等设备中,其作用是提高图像质量、增强图像效果、改善拍摄体验等。

相机算法涉及到图像处理、计算机视觉、图像识别等多个领域,是一个综合性的技术。

本文将从基本概念、常见算法和应用实践等方面对相机算法进行系统的介绍和总结。

基本概念1. 数字图像数字图像是使用数字化设备对具体对象、场景、图形等进行记录、传输和展示的一种视觉媒体。

数字图像由像素组成,每个像素代表图像中的一个点,具有颜色和亮度信息。

数字图像通常用二维矩阵表示,其中每个元素为像素的亮度和颜色值。

数字图像处理就是对数字图像进行处理和分析的一种技术,其目的是改善图像质量、提取图像特征、实现图像识别等。

2. 相机基本原理相机是一种光学设备,能够将被摄物体的光线投射到感光介质上并记录下来。

相机包括镜头、曝光系统、感光介质和成像管路等部分。

当光线通过镜头进入相机时,会成像在感光介质上,并形成一幅图像。

感光介质通常是指胶片或传感器,可以记录下被摄物体的光线信息。

成像管路是指光线从镜头到感光介质的传输路径,包括镜头系统、镜筒、快门等部分。

3. 相机参数相机的参数包括焦距、光圈、快门速度、感光度等。

焦距是指镜头到感光介质的距离,影响照片中景深和透视关系。

光圈是指镜头的光圈大小,控制进入镜头的光线量,影响照片的景深和亮度。

快门速度是指感光介质暴露在光线下的时间,决定照片的清晰度和运动停顿。

感光度是指感光介质对光线敏感程度的参数,影响照片的噪点和颗粒度。

4. 相机图像处理相机图像处理是指对相机采集的图像进行处理和优化的过程。

图像处理包括色彩校正、锐化、去噪、对比度调整、亮度调整等操作,可以提高图像质量,增强图像效果。

相机图像处理也可以涉及到特效处理、美颜处理、人脸识别等高级算法,对图像进行进一步的加工和修改。

常见算法1. 色彩校正色彩校正是指对图像进行色彩平衡的处理,使图像的颜色看上去更加真实和自然。

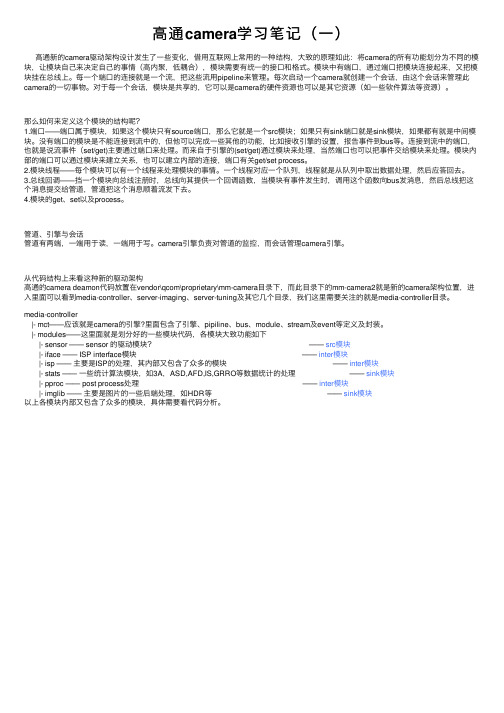

高通camera学习笔记(一)

⾼通camera学习笔记(⼀)⾼通新的camera驱动架构设计发⽣了⼀些变化,借⽤互联⽹上常⽤的⼀种结构,⼤致的原理如此:将camera的所有功能划分为不同的模块,让模块⾃⼰来决定⾃⼰的事情(⾼内聚,低耦合),模块需要有统⼀的接⼝和格式。

模块中有端⼝,通过端⼝把模块连接起来,⼜把模块挂在总线上。

每⼀个端⼝的连接就是⼀个流,把这些流⽤pipeline来管理。

每次启动⼀个camera就创建⼀个会话,由这个会话来管理此camera的⼀切事物。

对于每⼀个会话,模块是共享的,它可以是camera的硬件资源也可以是其它资源(如⼀些软件算法等资源)。

那么如何来定义这个模块的结构呢?1.端⼝——端⼝属于模块,如果这个模块只有source端⼝,那么它就是⼀个src模块;如果只有sink端⼝就是sink模块,如果都有就是中间模块。

没有端⼝的模块是不能连接到流中的,但他可以完成⼀些其他的功能,⽐如接收引擎的设置,报告事件到bus等。

连接到流中的端⼝,也就是说流事件(set/get)主要通过端⼝来处理。

⽽来⾃于引擎的(set/get)通过模块来处理,当然端⼝也可以把事件交给模块来处理。

模块内部的端⼝可以通过模块来建⽴关系,也可以建⽴内部的连接,端⼝有关get/set process。

2.模块线程——每个模块可以有⼀个线程来处理模块的事情。

⼀个线程对应⼀个队列,线程就是从队列中取出数据处理,然后应答回去。

3.总线回调——挡⼀个模块向总线注册时,总线向其提供⼀个回调函数,当模块有事件发⽣时,调⽤这个函数向bus发消息,然后总线把这个消息提交给管道,管道把这个消息顺着流发下去。

4.模块的get、set以及process。

管道、引擎与会话管道有两端,⼀端⽤于读,⼀端⽤于写。

camera引擎负责对管道的监控,⽽会话管理camera引擎。

从代码结构上来看这种新的驱动架构⾼通的camera deamon代码放置在vendor\qcom\proprietary\mm-camera⽬录下,⽽此⽬录下的mm-camera2就是新的camera架构位置,进⼊⾥⾯可以看到media-controller、server-imaging、server-tuning及其它⼏个⽬录,我们这⾥需要关注的就是media-controller⽬录。

2023年Camera软件开发工程师年度总结及来年计划

YOUR LOGO

THANK YOU

汇报人:

汇报时间:20XX/01/01

解决方案实施效果:通过不断尝 试和改进,最终成功解决了技术 难点,提高了软件性能和稳定性

添加标题

添加标题

添加标题

添加标题

采取的解决方案:深入研究相机 标定技术,优化图像处理算法, 提高软件性能和稳定性

未来改进方向:继续深入研究相 关技术,持续优化软件性能,提 高用户体验

团队协作与沟通

高效沟通:及时准确传递信息, 避免误解和冲突

有效协作工具:使用协作工具提 高团队效率

添加标题

添加标题

添加标题

添加标题

协作精神:共同完成项目,互相 支持,共同成长

沟通反馈:及时反馈工作进展, 调整计划和方向

收获与成长

完成了多少个Camera软件的开发项目 在项目中获得了哪些技能和经验 提高了哪些方面的能力,如团队协作、沟通能力等 获得了哪些荣誉和奖励,如优秀员工、最佳团队等

添加标题

添加标题

添加标题

添加标题

提升专业能力:深入理解相机硬 件和软件,提高在相机系统设计 和优化方面的能力。

参与开源项目:参与开源相机软 件项目,与全球开发者共同交流 和成长。

寻求挑战与突破

不断学习新技术和知识,提升自己的技术实力 主动寻求更有挑战性的项目和工作机会,不断突破自己的能力上限 积极参与行业交流和技术分享,扩大自己的人脉和影响力 在职业发展中注重个人品牌的建立,不断提升自己的知名度和信誉

YOUR LOGO

Camera软件开发工程师年度总结及来 ,a click to unlimited possibilities 年计划

汇报人:

汇报时间:20XX/01/01

人工智能影像处理工程师实习总结

人工智能影像处理工程师实习总结经过两个月的实习,我有幸成为一名人工智能影像处理工程师实习生。

在这段时间里,我深入了解了人工智能与影像处理领域的最新技术,并且亲自参与了一些项目,积累了宝贵的经验。

在本文中,我将对我的实习经历进行总结和反思,分享一些重要的收获和体会。

1. 前期准备工作在实习开始之前,我了解到人工智能与影像处理领域的基本概念和相关算法。

通过学习和实践,我熟悉了常用的图像处理软件、编程语言和深度学习框架。

这些准备工作为我的实习打下了坚实的基础,使我能够更好地理解实际项目中的需求和挑战。

2. 参与实际项目在实习期间,我有机会参与了一个基于人工智能的医学影像处理项目。

我与团队其他成员共同合作,研究和开发了一种新的算法,用于识别肺部疾病的早期征兆。

在这个项目中,我负责数据预处理、特征提取和模型训练等工作。

通过与团队密切合作,我学会了如何有效地应用人工智能技术来解决实际问题,并且提出了一些改进的思路和方法。

3. 技术与团队交流在实习期间,我积极参与技术分享和团队交流。

我经常与同事讨论和分享最新的研究成果和技术趋势,从中学到了很多宝贵的经验和见解。

与此同时,我也向团队成员请教问题和寻求帮助。

通过与他们的交流互动,我不仅加深了对技术的理解,还培养了良好的团队合作和沟通能力。

4. 面对挑战与解决问题在实习期间,我遇到了各种各样的挑战和问题。

有时,项目进展缓慢,需要我不断尝试和调整方法。

还有一些技术难题,我必须花费大量的时间和精力来研究和解决。

虽然这些困难使我感到沮丧,但我从中获得了宝贵的经验和成长。

通过与同事和导师的交流,我学会了不断解决问题的方法,并且在实践中逐渐提升了自己的技术能力。

5. 总结与展望通过这次实习,我深刻认识到了人工智能影像处理这一领域的重要性和挑战。

我在实际项目中学到了关于数据处理、算法设计和团队协作的宝贵经验。

同时,我也发现自己在某些方面仍然存在着不足和待提升之处,比如代码的规范性和算法优化的能力。

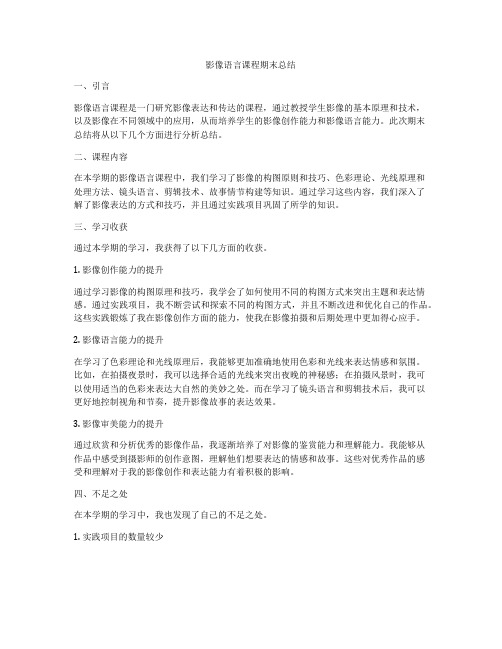

影像语言课程期末总结

影像语言课程期末总结一、引言影像语言课程是一门研究影像表达和传达的课程,通过教授学生影像的基本原理和技术,以及影像在不同领域中的应用,从而培养学生的影像创作能力和影像语言能力。

此次期末总结将从以下几个方面进行分析总结。

二、课程内容在本学期的影像语言课程中,我们学习了影像的构图原则和技巧、色彩理论、光线原理和处理方法、镜头语言、剪辑技术、故事情节构建等知识。

通过学习这些内容,我们深入了解了影像表达的方式和技巧,并且通过实践项目巩固了所学的知识。

三、学习收获通过本学期的学习,我获得了以下几方面的收获。

1. 影像创作能力的提升通过学习影像的构图原理和技巧,我学会了如何使用不同的构图方式来突出主题和表达情感。

通过实践项目,我不断尝试和探索不同的构图方式,并且不断改进和优化自己的作品。

这些实践锻炼了我在影像创作方面的能力,使我在影像拍摄和后期处理中更加得心应手。

2. 影像语言能力的提升在学习了色彩理论和光线原理后,我能够更加准确地使用色彩和光线来表达情感和氛围。

比如,在拍摄夜景时,我可以选择合适的光线来突出夜晚的神秘感;在拍摄风景时,我可以使用适当的色彩来表达大自然的美妙之处。

而在学习了镜头语言和剪辑技术后,我可以更好地控制视角和节奏,提升影像故事的表达效果。

3. 影像审美能力的提升通过欣赏和分析优秀的影像作品,我逐渐培养了对影像的鉴赏能力和理解能力。

我能够从作品中感受到摄影师的创作意图,理解他们想要表达的情感和故事。

这些对优秀作品的感受和理解对于我的影像创作和表达能力有着积极的影响。

四、不足之处在本学期的学习中,我也发现了自己的不足之处。

1. 实践项目的数量较少虽然课程中有一些实践项目,但由于时间和资源的限制,实践项目的数量相对较少。

这使得我在实际操作方面的训练不够充分,对于一些概念的掌握和技能的应用还不够熟练。

希望在将来的学习中能够增加实践项目的数量,以提高自己的实际操作能力。

2. 对于某些概念的理解不够深入在学习过程中,我对于某些概念的理解可能不够深入。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CAMERA_MSG_VIDEO_FRAME = 0x020,

CAMERA_MSG_POSTVIEW_FRAME = 0x040,

CAMERA_MSG_RAW_IMAGE = 0x080,

CAMERA_MSG_COMPRESSED_IMAGE = 0x100,

virtual sp<IMemoryHeap> getRawHeap() const = 0;

pure vitual function, 返回由new MemoryHeapBase(size) 分配的用于保存camera 拍照时返回的rowdata。

virtual void setCallbacks(notify_callback notify_cb,

CAMERA_MSG_ALL_MSGS = 0x1FF

};

virtual void disableMsgType(int32_t msgType) = 0

pure vitual function,与 enableMsgType相反。

virtual bool msgTypeEnabled(int32_t msgType) = 0

pure vitual function, 用于判断一个或者多个msgtype 是否有效,内部使用 &操作。

virtual status_t startPreview() = 0;

class CameraHardwareInterface 定义于

./frameworks/base/include/ui/CameraHardwareInterface.h

class CameraHardwareInterface : public virtual RefBase

类 CameraHardwareInterface 虚拟继承于RefBase 防止二意性。

换句话讲每一个CameraHardwareInterface 实例对应一个硬件。(不知道这样说对不对)

2.CameraService 是 Camera框架的中间层,用于链接 CameraHardwareInterface 和 Client.

定义于文件 frameworks/base/camera/libcameraservice/CameraService.h

enum {

CAMERA_MSG_ERROR = 0x001,

CAMERA_MSG_SHUTTER = 0x002,

CAMERA_MSG_FOCUS = 0x004,

CAMERA_MSG_ZOOM = 0x008,

virtual boid stopRecording() = 0;

virtual status_t autoFocus(...) = 0;

virtual status_t takePicture(....) = 0;

…

};

类中定义了 拍照 录像 等 api,当需要支援新的硬件时就需要继承于类Class CameraHardwareInterface,支援 拍照录像等功能。

1.CameraHardwareInterface 链接 camera server 和 vedio4linux(也可能是其他的驱动),通过实现CameraHardwareInterface 可以屏蔽不同的driver 对之前实现的code的冲击,这样无论使用何种驱动程序,camera hal 几乎不需要进行任何的修改。

andorid 针对opencore 做了封装,简单的应用可以使用 android 封装好的api 进行 录像 播放等功能。

andy_1982 发表于 2010-8-5 11:03

呵呵,支持。

gooderfeng 发表于 2010-8-5 11:32

5 分析核心代码

class CameraHardwareInterface 是camera 框架最核心的部分,当需要支援新硬件的时候需要实现新的class 并且public继承 CameraHardwareInterface。

RefBase 是引用计数基础类。几乎每个class 都会继承自RefBase。

CameraHardwareInterface中定义了若干函数,下面逐个介绍

virtual ~CameraHardwareInterface() { }

virtual destructor 子类在释放资源时可以正确调用子类和父类destructor

其中之前的 3个callback 函数 和 camerahal Байду номын сангаас会以成员变量的形式存在于 class Client.

总结 当需要支援一个camera 的时候,需要实现 2个类:

Class CameraHardwareInterface:用于实现一个新硬件

CameraService:用于实现 CameraService::Client 中的3个callback 函数。

3 camera 对视频处理流程

简单的流程控制。

简单的数据流程:

4 代码初步描述

下图为camera 调用流程,为android 提供的 camera 框架。

以上的框架已经由android 实现,在移植新的硬件的时候,我们无需修改以上对应的code.

需要实现的code 为 CameraHardwareInterface 这一层。

const sp<IMemory>& dataPtr,

void* user);

typedef void (*data_callback_timestamp)(nsecs_t timestamp,

启动 android 模拟器(包括虚拟的 sdcard)

emulator -sdcard /sdcard.img

通过 adb logcat 获取启动log.

分析启动log 是否正常,是否正常启动了sdcard.

使用模拟器进行拍照,并查看log.

以上是基于android 提供的虚拟机来实现的模拟。在没有硬件的环境里面,可以通过这个环境进行配置和测试。

pure vitual function,用于指定msgtype 对应的callback(上面那3个callback)是否可以调用,如当 nableMsgType(CAMERA_MSG_PREVIEW_FRAME) 则可以调用 data_callback。

Android支援的msgtype:

class CameraService : public BnCameraService

{

class Client;

};

类BnCameraService 中提供了一些api,但是这些api(拍照 录像等)并不被其他程序使用,而只在本地使用。而 class Client 是个很重要的类,它在内部真实的处理由 camera hal 返回的数据和notify 信息。

++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++

学习 camera framework 总结的一点东西

[i=s] 本帖最后由 gooderfeng 于 2010-8-5 11:18 编辑 [/i]

看了一下camera framework 做一下记录,可能有不少明显的错误,有啥错误大家告诉我,谢谢

int32_t msgType,

const sp<IMemory>& dataPtr,

void* user);

notify_callback 用于处理一些通知的消息,如按了快门等。

data_callback 用来返回 通过camera 得到的raw data.

data_callback_timestamp 用来返回 通过camera 得到的raw data 并且携带 时间戳。

virtual void enableMsgType(int32_t msgType) = 0;

CameraHardwareInterface 接口定义于文件 frameworks/base/include/ui/CameraHardwareInterface.h中。

Class CameraHardwareInterface : public virtual RefBase

{

virtual status_t startRecording(...) = 0;

pure vitual function, 设置3个callback,(3个callback 一般由 CameraService::Client 中实现)。

下面是3个 callback 函数的原型:

typedef void (*notify_callback)(int32_t msgType,

virtual sp<IMemoryHeap> getPreviewHeap() const = 0;

pure vitual function, 返回由new MemoryHeapBase(size) 分配的用于保存preview mediadata,previewbuf 内部实现为ping-pang buf。