2018年常见Hadoop面试题及答案_光环大数据培训

hadoop常见面试问题

hadoop常见面试问题

以下是一些Hadoop常见的面试问题:

1. Hadoop是什么?它在大数据领域中的作用是什么?

2. Hadoop的核心组件有哪些?它们各自的作用是什么?

3. HDFS是什么?它有哪些特点和优势?

4. MapReduce是什么?它是如何工作的?

5. YARN是什么?它在Hadoop中的作用是什么?

6. 在Hadoop中如何处理数据倾斜?有哪些常见的数据倾斜问题需要避免?

7. Hadoop集群的部署和配置需要注意哪些问题?

8. 如何优化Hadoop集群的性能?有哪些常见的性能调优方法?

9. 在Hadoop中如何进行数据迁移?有哪些常见的迁移策略?

10. 如何进行Hadoop的安全性配置和管理?有哪些常见的安全措施需要采取?

11. Hadoop和Spark的区别和联系是什么?在什么情况下应该选择Hadoop或Spark?

12. 在Hadoop中如何进行数据清洗和预处理?有哪些常用的工具和库可以使用?

13. 如何使用Hadoop进行机器学习和数据挖掘?有哪些常见的算法和应用场景?

14. Hadoop的版本演进和兼容性问题需要注意哪些方面?

15. 你如何在Hadoop上进行大数据实时流处理?有哪些常用的流处理框架可以选择和使用?。

大数据技术Hadoop面试题,看看你能答对多少(2)

大数据技术Hadoop面试题,看看你能答对多少(2)c)Yum d)Rpm8. 以下哪项可以作为集群的管理?答案:ABDa)Puppetb)Pdshc)Cloudera Managerd)Zookeeper9. 配置机架感知的下面哪项正确:答案ABCa)如果一个机架出问题,不会影响数据读写b)写入数据的时候会写到不同机架的 DataNode 中c)MapReduce 会根据机架获取离自己比拟近的网络数据10. Client 端上传文件的时候以下哪项正确?答案Ba)数据经过 NameNode 传递给 DataNodeb)Client 端将文件切分为 Block,依次上传c)Client 只上传数据到一台 DataNode,然后由 NameNode 负责 Block 复制工作该题分析:Client向NameNode发起文件写入的请求。

NameNode根据文件大小和文件块配置情况,返回给Client它所管理局部DataNode的信息。

Client将文件划分为多个Block,根据DataNode的地址信息,按顺序写入到每一个DataNode块中。

11. 以下哪个是 Hadoop 运行的模式:答案ABCa)单机版b)伪分布式c)分布式12. Cloudera 提供哪几种安装 CDH 的方法?答案:ABCDa)Cloudera managerb)Tarballc)Yumd)Rpm13. Ganglia 不仅可以进行监控,也可以进行告警。

( )14. Block Size 是不可以修改的。

( )15. Nagios 不可以监控 Hadoop 集群,因为它不提供 Hadoop 支持。

( )16. 如果 NameNode 意外终止,SecondaryNameNode 会接替它使集群继续工作。

( )17. Cloudera CDH 是需要付费使用的。

( )18. Hadoop 是 Java 开发的,所以 MapReduce 只支持 Java 语言编写。

光环大数据分享关于Hadoop的面试问答题

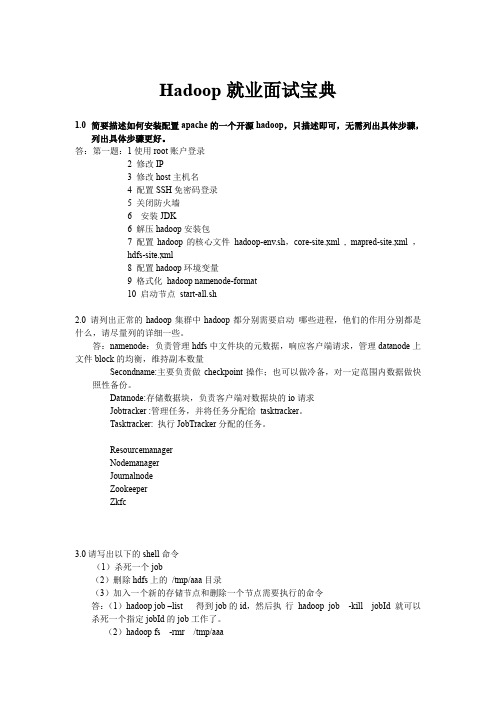

光环大数据分享关于Hadoop的面试问答题1.简单描述如何安装配置一个apache开源版hadoop,只描述即可,无需列出完整步骤,能列出步骤更好。

1)安装JDK并配置环境变量(/etc/profile)2)关闭防火墙3)配置hosts文件,方便hadoop通过主机名访问(/etc/hosts)4)设置ssh免密码登录5)解压缩hadoop安装包,并配置环境变量6)修改配置文件($HADOOP_HOME/conf)hadoop-env.shcore-site.xmlhdfs-site.xmlmapred-site.xml7)格式化hdfs文件系统(hadoopnamenode-format)8)启动hadoop($HADOOP_HOME/bin/start-all.sh)9)使用jps查看进程2.请列出正常工作的hadoop集群中hadoop都分别需要启动那些进程,他们的作用分别是什么,尽可能写的全面些。

1)NameNode:HDFS的守护进程,负责记录文件是如何分割成数据块,以及这些数据块分别被存储到那些数据节点上,它的主要功能是对内存及IO进行集中管理2)SecondaryNameNode:辅助后台程序,与NameNode进行通信,以便定期保存HDFS元数据的快照。

3)DataNode:负责把HDFS数据块读写到本地的文件系统。

4)JobTracker:负责分配task,并监控所有运行的task。

5)TaskTracker:负责执行具体的task,并与JobTracker进行交互。

3.请列出你所知道的hadoop调度器,并简要说明其工作方法。

比较流行的三种调度器有:默认调度器FIFO,计算能力调度器CapacityScheduler,公平调度器FairScheduler1)默认调度器FIFOhadoop中默认的调度器,采用先进先出的原则2)计算能力调度器CapacityScheduler选择占用资源小,优先级高的先执行3)公平调度器FairScheduler同一队列中的作业公平共享队列中所有资源4.Hive有那些方式保存元数据的,各有那些特点。

Hadoop面试题目及答案

Hadoop面试题目及答案Hadoop面试45个题目及答案1.Hadoop集群可以运行的3个模式?单机(本地)模式伪分布式模式全分布式模式2. 单机(本地)模式中的注意点?在单机模式(standalone)中不会存在守护进程,所有东西都运行在一个JVM上。

这里同样没有DFS,使用的是本地文件系统。

单机模式适用于开发过程中运行MapReduce程序,这也是最少使用的一个模式。

3. 伪分布模式中的注意点?伪分布式(Pseudo)适用于开发和测试环境,在这个模式中,所有守护进程都在同一台机器上Hadoop被安装在cd/usr/lib/hadoop-0.20/。

8. Namenode、Job tracker和task tracker 的端口号是?Namenode,70;Job tracker,30;Task tracker,60。

9. Hadoop的核心配置是什么?Hadoop的核心配置通过两个xml文件来完成:1,hadoop-default.xml;2,hadoop-site.xml。

这些文件都使用xml格式,因此每个xml中都有一些属性,包括名称和值,但是当下这些文件都已不复存在。

10. 那当下又该如何配置?Hadoop现在拥有3个配置文件:1,core-site.xml;2,hdfs-site.xml;3,mapred-site.xml。

这些文件都保存在conf/子目录下。

11. RAM的溢出因子是?溢出因子(Spill factor)是临时文件中储存文件的大小,也就是Hadoop-temp目录。

12. fs.mapr.working.dir只是单一的目录?fs.mapr.working.dir只是一个目录。

13. hdfs-site.xml的3个主要属性?.dir决定的是元数据存储的路径以及DFS的存储方式(磁盘或是远端)dfs.data.dir决定的是数据存储的路径fs.checkpoint.dir用于第二Namenode 14. 如何退出输入模式?退出输入的方式有:1,按ESC;2,键入:q(如果你没有输入任何当下)或者键入:wq(如果你已经输入当下),并且按下Enter。

hadoop培训_ Hadoop面试题汇总_光环大数据培训

hadoop培训_Hadoop面试题汇总_光环大数据培训光环大数据作为国内知名的hadoop培训的机构,聘请专业讲师面对面授课,与时俱进及时更新课程体系,为保障学员就业与多家单位进行合作,保障学员就业。

光环大数据所有项目都由阿里云真实项目数据,光环大数据成为阿里云授权认证中心,毕业通过相关考试就可以获得阿里云的证书。

Apache hadoop 是一个开源软件框架,可安装在一个商用机器集群中,使机器可彼此通信并协同工作,以高度分布式的方式共同存储和处理大量数据。

最初,Hadoop 包含以下两个主要组件:Hadoop Distributed File System (HDFS) 和一个分布式计算引擎,该引擎支持以 MapReduce 作业的形式实现和运行程序。

Map Reduce & YARN简介Apache Hadoop 是一个开源软件框架,可安装在一个商用机器集群中,使机器可彼此通信并协同工作,以高度分布式的方式共同存储和处理大量数据。

最初,Hadoop 包含以下两个主要组件:Hadoop Distributed File System (HDFS) 和一个分布式计算引擎,该引擎支持以 MapReduce 作业的形式实现和运行程序。

MapReduce 是 Google 推广的一个简单的编程模型,它对以高度并行和可扩展的方式处理大数据集很有用。

MapReduce 的灵感来源于函数式编程,用户可将他们的计算表达为 map 和 reduce 函数,将数据作为键值对来处理。

Hadoop 提供了一个高级 API 来在各种语言中实现自定义的 map 和 reduce 函数。

Hadoop 还提供了软件基础架构,以一系列 map 和 reduce 任务的形式运行 MapReduce 作业。

Map 任务在输入数据的子集上调用 map 函数。

在完成这些调用后,reduce 任务开始在 map 函数所生成的中间数据上调用 reduce 任务,生成最终的输出。

10道Hadoop面试真题及解题思路_光环大数据storm课程培训

10道Hadoop面试真题及解题思路_光环大数据storm课程培训(一) 海量日志数据,提取出某日访问百度次数最多的那个 IP 。

首先是这一天,并且是访问百度的日志中的 IP 取出来,逐个写入到一个大文件中。

注意到 IP是 32 位的,最多有个 2^32 个 IP 。

同样可以采用映射的方法,比如模 1000 ,把整个大文件映射为 1000 个小文件,再找出每个小文中出现频率最大的 IP (可以采用 hash_map 进行频率统计,然后再找出频率最大的几个)及相应的频率。

然后再在这 1000 个最大的 IP 中,找出那个频率最大的 IP ,即为所求。

大数据算法思想:分而治之 +Hash1.IP 地址最多有 2^32=4G 种取值情况,所以不能完全加载到内存中处理;2. 可以考虑采用“分而治之”的思想,按照 IP 地址的 Hash(IP)%1024 值,把海量 IP 日志分别存储到 1024 个小文件中。

这样,每个小文件最多包含4MB 个 IP 地址;3. 对于每一个小文件,可以构建一个 IP 为 key ,出现次数为 value 的 Hash map ,同时记录当前出现次数最多的那个 IP 地址;4. 可以得到 1024 个小文件中的出现次数最多的 IP ,再依据常规的排序算法得到总体上出现次数最多的 IP ;(二) 搜索引擎会通过日志文件把用户每次检索使用的所有检索串都记录下来,每个查询串的长度为 1-255 字节。

假设目前有一千万个记录(这些查询串的重复度比较高,虽然总数是 1 千万,但如果除去重复后,不超过 3 百万个。

一个查询串的重复度越高,说明查询它的用户越多,也就是越热门。

),请你统计最热门的 10 个查询串,要求使用的内存不能超过 1G 。

典型的 Top K 算法,还是在这篇文章里头有所阐述,详情请参见:十一、从头到尾彻底解析 Hash 表算法。

文中,给出的最终算法是:第一步、先对这批海量数据预处理,在 O ( N )的时间内用 Hash 表完成统计 ;第二步、借助堆这个数据结构,找出 Top K ,时间复杂度为 N ‘ logK 。

光环大数据云计算培训 云计算面试题汇总

光环大数据云计算培训云计算面试题汇总云计算培训,云计算面试题汇总。

光环大数据了解到,云计算连接技术最重要的优势就是是令人难以置信的速度,敏捷性而且能够实现业务转型。

云计算会继续延续自己的辉煌,而绝对不仅仅是一个技术流行语,只是一个外行人对自动化连接的称谓而已。

云计算培训光环大数据通过总结参加云计算培训毕业后的学员的面试经验,给大家分享下云计算面试题:1)使用云计算有哪些优点?使用云计算有下列优点:a)备份数据和存储数据b)强大的服务器功能c)SaaS(软件即服务)d)信息技术沙盒功能e)提高生产力f)具有成本效益,并节省时间2)可否列举哪些平台用于大规模云计算?用于大规模云计算的平台包括:a)ApacheHadoopb)MapReduce3)可否解释用于云计算部署的不同模式?不同的云计算部署模式包括:a)私有云b)公共云c)社区云d)混合云云计算培训4)云计算与移动计算有何区别?移动计算使用与云计算同样的概念。

借助互联网而不是借助单个设备,云计算因数据而变得活跃。

它为用户提供了需要按需获取的数据。

在移动计算中,应用程序在远程服务器上运行,为用户提供了访问所存储数据的权限。

5)用户如何得益于公用计算(utilitycomputing)?公用计算让用户可以只需要为使用的资源付费。

它是由决定从云端部署哪种类型的服务的企业组织管理的一种插件。

大多数企业组织青睐混合策略。

6)由于数据在云端传输,你如何确保数据安全?数据从一个地方传输到另一地方的过程中想确保数据安全,就要确保针对你发送的数据所使用的加密密钥没有泄露。

7)云在安全方面的措施有哪些?a)身份管理:授权应用程序服务。

b)访问控制:将权限授予用户,那样用户可以控制进入到云环境的另一个用户的访问。

c)验证和授权:只允许用授权和验证的用户访问数据和应用程序。

8)可否列出定义云架构的不同层?云计算培训云架构使用的不同层包括:a)CLC即云控制器b)Walrusc)集群控制器d)SC即存储控制器e)NC即节点控制器大数据+云计算时代,云计算培训,就选光环大数据!为什么大家选择光环大数据!大数据培训、人工智能培训、培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请大数据领域具有多年经验的讲师,提高教学的整体质量与教学水准。

大数据职位面试题目汇总_光环大数据培训

大数据职位面试题目汇总_光环大数据培训大数据职位面试题目汇总,最近总是听到各种各样的报怨,面试的时候问的问题以前没有接触过,或者说接触的少,再加上面试心里比较紧张,就把以前即使知道的内容都忘记怎么说,还有一种说法是嘴笨,面试和考试是一样的,对于比较常见的问题你就要熟烂于心,最好是保持一颗平常心,始终保持一颗此处不留爷,自有留爷处的心态。

下面介绍一些大数据职位面试的时候经常会问到的一些技术方面的问题,希望看完这篇文章能让你用出洪荒之力,职业生涯进一步发展。

hdfs原理,以及各个模块的职责对于任何对文件系统元数据产生修改的操作,Namenode 都会使用一种称为EditLog 的事务日志记录下来。

整个文件系统的命名空间,包括数据块到文件的映射、文件的属性等,都存储在一个称为FsImage 的文件中DataNodeDatanode 将HDFS 数据以文件的形式存储在本地的文件系统中,它并不知道有关HDFS 文件的信息。

它把每个HDFS 数据块存储在本地文件系统的一个单独的文件中。

当一个Datanode 启动时,它会扫描本地文件系统,产生一个这些本地文件对应的所有HDFS 数据块的列表,然后作为报告发送到Namenode ,这个报告就是块状态报告。

Secondary NameNodeSecondary NameNode 定期合并fsimage 和edits 日志,将edits 日志文件大小控制在一个限度下。

Secondary NameNode处理流程node 响应Secondary namenode 请求,将edit log 推送给Secondary namenode ,开始重新写一个新的edit log 。

2.Secondary namenode 收到来自namenode 的fsimage 文件和edit log 。

3.Secondary namenode 将fsimage 加载到内存,应用edit log ,并生成一个新的fsimage 文件。

【八斗学院】2018年Hadoop面试题及答案(大数据人才招聘常见试题)

2018年Hadoop面试题及答案(大数据人才招聘常见试题)来源:八斗学院一、简单叙述如何安装开源版本Hadoop,无需完整步骤1.创建hadoop用户.2.setup修改IP.3.安装javaJdk,并且修改etc/profile文件,配置java的环境变量.4.修改host的文件域名5.安装SSH免密码通信。

6.解压hadoop包.7.配置conf文件下的hadoop-env.sh.core-site.sh.mapre-site.sh.hdfs-site.sh8配置hadoop环境变量9.hadoop格式化hadoopnamenode-format10.启动hadoopstart-all二、请写出以下执行的命令1.杀死一个jobhaoopjob-list拿到job-idhadoopjob-killjob-id2.删除hdfs上/tmp/aaa目录hadoopfs-rmr/tmp/aaa3.加入一个新的存储节点和删除一个计算节点需要刷新到集群的状态命令a.新节点时:hadoop-deamon.shstartdatenodeHadoop-deamon.shstarttasktrackerb.删除节点时:hadoopmradmin-refreshnodesHadoopdfsadmin-refreshnodes三、Hadoop调度器有哪几种,说明你知道的1.Fairschedular: 公平调度,所有job具有相同的资源。

2.Fifoschedular:默认,先进先出原则。

3.Capacityschedular:计算能力调度器,选择占用最小、优先高级的先执行。

四、简单叙述mapreduce中combiner,partition的作用biner:实现的功能跟reduce差不多,接受map的值,经过计算后给reduce,他的key,value类型跟reduce完全一样,当reduce业务复杂时可以用,不过他貌似是操作本机的数据2.Partition:将输出的结果分别保存在不同的文件中。

2018年Hadoop 机器学习面试题汇总_光环大数据培训

2018年Hadoop 机器学习面试题汇总_光环大数据培训无论你是想从事大数据相关职位的职场小白,还是准备往高处走的牛牛。

小白有了这些在校招中过关斩将,牛牛们温故知新跨过业务壁垒。

B格高的HR,或者想要个助理的大数据工作者也可以了解下同行是怎么筛选人。

非主流的可以拿来撩HR妹纸,折腾面试的小鲜肉…………………………最近笔试了很多家公司校招的数据分析和数据挖掘岗位,今天(9.18r)晚上做完唯品会的笔试题,才忽然意识过来,不管题目简单也好、难也好,都要去切切实实的去掌握。

毕竟不能永远眼高手低,否则最后吃亏的一定是自己。

hadoop1、Hadoop基础知识面试题大汇总(IT公司面试手册,基础问题汇集可能出现在笔试或者口头问答里哦)2、33道Hadoop面试题,看看你能答对多少?(答案在后面)(纯粹hadoop笔试题,有答案哦—-技术过硬能够横着走)3、面试hadoop可能被问到的问题,附部分参考答案(hadoop三方面—三座大山等你搬开)4、美国大数据工程师面试攻略美国大数据工程师面试攻略(大数据相关技术:hadoop ,Spark ,linkedin)5.专门为面试而学的大数据该文总结了一些面试常见的hadoop知识,包括1. hdfs原理,以及各个模块的职责2. map reduce 的工作原理3. hadoop1 与 hadoop2 的区别等本文是同学们进入阿里云等公司的hadoop内核研发岗位的一个指引,需要具备哪些要求,如果不具备则可以往这方面努力。

7、分享:6个公司大数据岗位的面试经验目前新工作已经找好,但想分享最近面试的失败经历(成功的那些就不讲了),吐槽吐槽,跟广大吃瓜群众分享一下过程中的经历心得,我的语文体育老师教的,还请大家莫怪。

数据挖掘&机器学习1 、Python面试题总结(python基础,问题涵盖面较广)2、阿里招聘负责人揭秘面试”潜规则”(资深HR揭秘面试的生存法则,不仅仅是情商逆商智商大比拼,还要翻翻此宝典–别被人家看low了。

面试hadoop可能被问到的问题,你能回答出几个

1、hadoop运行的原理?hadoop主要由三方面组成:1、HDFS2、MapReduce3、HbaseHadoop框架中最核心的设计就是:MapReduce和HDFS。

MapReduce的思想是由Google的一篇论文所提及而被广为流传的,简单的一句话解释MapReduce就是“任务的分解与结果的汇总”。

HDFS是Hadoop分布式文件系统(Hadoop Distributed File System)的缩写,为分布式计算存储提供了底层支持。

MapReduce从它名字上来看就大致可以看出个缘由,两个动词Map和Reduce,“Map(展开)”就是将一个任务分解成为多个任务,“Reduce”就是将分解后多任务处理的结果汇总起来,得出最后的分析结果。

这不是什么新思想,其实在前面提到的多线程,多任务的设计就可以找到这种思想的影子。

不论是现实社会,还是在程序设计中,一项工作往往可以被拆分成为多个任务,任务之间的关系可以分为两种:一种是不相关的任务,可以并行执行;另一种是任务之间有相互的依赖,先后顺序不能够颠倒,这类任务是无法并行处理的。

回到大学时期,教授上课时让大家去分析关键路径,无非就是找最省时的任务分解执行方式。

在分布式系统中,机器集群就可以看作硬件资源池,将并行的任务拆分,然后交由每一个空闲机器资源去处理,能够极大地提高计算效率,同时这种资源无关性,对于计算集群的扩展无疑提供了最好的设计保证。

(其实我一直认为Hadoop 的卡通图标不应该是一个小象,应该是蚂蚁,分布式计算就好比蚂蚁吃大象,廉价的机器群可以匹敌任何高性能的计算机,纵向扩展的曲线始终敌不过横向扩展的斜线)。

任务分解处理以后,那就需要将处理以后的结果再汇总起来,这就是Reduce要做的工作。

2、mapreduce的原理?Hadoop中的MapReduce是一个使用简易的软件框架,基于它写出来的应用程序能够运行在由上千个商用机器组成的大型集群上,并以一种可靠容错的式并行处理上T级别的数据集。

Hadoop100道面试题及答案解析

Hadoop100道面试题及答案解析3.6误)3.7Hadoop支持数据的随机读写。

(错) (8)NameNode负责管理metadata,client端每次读写请求,它都会从磁盘中3.8读取或则会写入metadata信息并反馈client端。

(错误) (8)NameNode本地磁盘保存了Block的位置信息。

(个人认为正确,欢迎提出其它意见) (9)3.93.10 3.11DataNode通过长连接与NameNode保持通信。

(有分歧) (9)Hadoop自身具有严格的权限管理和安全措施保障集群正常运行。

(错误)93.12 3.13 3.14Slave节点要存储数据,所以它的磁盘越大越好。

(错误) (9)hadoop dfsadmin–report命令用于检测HDFS损坏块。

(错误)(9)Hadoop默认调度器策略为FIFO(正确) (9)100道常见Hadoop面试题及答案解析目录1单选题 (5)1.1 1.2 1.3 1.4 1.5 1.6 1.7下面哪个程序负责HDFS数据存储。

(5)HDfS中的block默认保存几份? (5)下列哪个程序通常与NameNode在一个节点启动? (5)Hadoop作者 (6)HDFS默认Block Size (6)下列哪项通常是集群的最主要瓶颈: (6)关于SecondaryNameNode哪项是正确的? (6)2 3多选题 (7)2.12.22.32.42.5下列哪项可以作为集群的管理? (7)配置机架感知的下面哪项正确: (7)Client端上传文件的时候下列哪项正确? (7)下列哪个是Hadoop运行的模式: (7)Cloudera提供哪几种安装CDH的方法? (7)判断题 (8)3.13.23.3Ganglia不仅可以进行监控,也可以进行告警。

(正确) (8)Block Size是不可以修改的。

(错误) (8)Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。

Hadoop面试中6个常见的问题及答案

Hadoop面试中6个常见的问题及答案你准备好面试了吗?呀,需要Hadoop 的知识!!?不要慌!这里有一些可能会问到的问题以及你应该给出的答案。

Q1.什么是Hadoop?Hadoop 是一个开源软件框架,用于存储大量数据,并发处理/查询在具有多个商用硬件(即低成本硬件)节点的集群上的那些数据。

总之,Hadoop 包括以下内容:HDFS(Hadoop Distributed File System,Hadoop 分布式文件系统):HDFS 允许你以一种分布式和冗余的方式存储大量数据。

例如,1 GB(即1024 MB)文本文件可以拆分为16 * 128MB 文件,并存储在Hadoop 集群中的8 个不同节点上。

每个分裂可以复制3 次,以实现容错,以便如果1 个节点故障的话,也有备份。

HDFS 适用于顺序的“一次写入、多次读取”的类型访问。

MapReduce:一个计算框架。

它以分布式和并行的方式处理大量的数据。

当你对所有年龄> 18 的用户在上述1 GB 文件上执行查询时,将会有“8 个映射”函数并行运行,以在其128 MB 拆分文件中提取年龄> 18 的用户,然后“reduce”函数将运行以将所有单独的输出组合成单个最终结果。

YARN(Yet Another Resource Nagotiator,又一资源定位器):用于作业调度和集群资源管理的框架。

Hadoop 生态系统,拥有15 多种框架和工具,如Sqoop,Flume,Kafka,Pig,Hive,Spark,Impala 等,以便将数据摄入HDFS,在HDFS 中转移数据(即变换,丰富,聚合等),并查询来自HDFS 的数据用于商业智能和分析。

某些工具(如Pig 和Hive)是MapReduce 上的抽象层,而Spark 和Impala 等其他工具则是来自MapReduce 的改进架构/设计,用于显著提高的延迟以支持近实时(即NRT)和实时处理。

hadoop大数据面试题

hadoop大数据面试题一、简介Hadoop是一个开源的分布式计算框架,用于存储和处理大规模数据。

它通过将大数据分布在廉价的硬件上,以横向扩展的方式提供高性能和可靠性。

在大数据领域,Hadoop已经成为了一个核心技术。

在进行Hadoop大数据面试时,以下是一些常见问题及其答案。

二、Hadoop基础知识1. 什么是Hadoop?Hadoop是一个分布式计算和存储框架,可以处理大规模的数据集。

它包括HDFS(Hadoop分布式文件系统)和MapReduce分布式处理模型。

2. 解释HDFS(Hadoop分布式文件系统)的工作原理。

HDFS将文件切分成小块,并将这些块分布在不同节点上进行存储,以实现数据的容错和高可用性。

每个文件块会有多个副本进行备份,以防止数据丢失。

3. 解释MapReduce的工作原理。

MapReduce是一种用于大规模数据处理的编程模型。

它将计算任务划分为Map和Reduce两个阶段。

Map阶段将输入数据切分为小任务并进行处理,Reduce阶段将Map输出结果进行归并和计算。

4. Hadoop与传统数据库的区别是什么?Hadoop适用于处理大规模数据,能够通过横向扩展来提供高性能和可靠性。

传统数据库适用于事务处理和实时查询,但在处理大规模数据时性能较差。

5. Hadoop的优点是什么?Hadoop具有横向扩展能力、高容错性、低成本、高可靠性、灵活性和可扩展性等优点。

三、Hadoop生态系统1. 解释Hadoop生态系统。

Hadoop生态系统是指与Hadoop相关的各种开源项目与工具,用于帮助开发人员更好地使用和管理Hadoop集群。

2. 列举一些常见的Hadoop生态系统组件。

常见的Hadoop生态系统组件包括Hive、Pig、HBase、Sqoop、Flume、Oozie、ZooKeeper等。

3. 解释Hive和Pig的区别。

Hive是一个基于Hadoop的数据仓库和查询系统,使用SQL语言进行数据分析。

大数据集群面试题目(3篇)

第1篇一、基础知识1. 请简述大数据的概念及其在当今社会中的重要性。

2. 什么是Hadoop?请简要介绍其架构和核心组件。

3. 请解释HDFS的工作原理,以及它在数据存储方面的优势。

4. 请说明MapReduce编程模型的基本原理和执行流程。

5. 什么是YARN?它在Hadoop生态系统中的作用是什么?6. 请描述Zookeeper在Hadoop集群中的作用和常用场景。

7. 什么是Hive?它与传统的数据库有什么区别?8. 请简述HBase的架构和特点,以及它在列式存储方面的优势。

9. 什么是Spark?它与Hadoop相比有哪些优点?10. 请解释Flink的概念及其在流处理方面的应用。

二、Hadoop集群搭建与优化1. 请描述Hadoop集群的搭建步骤,包括硬件配置、软件安装、配置文件等。

2. 请说明如何实现Hadoop集群的高可用性,例如HDFS和YARN的HA配置。

3. 请简述Hadoop集群的负载均衡策略,以及如何进行负载均衡优化。

4. 请解释Hadoop集群中的数据倾斜问题,以及如何进行数据倾斜优化。

5. 请说明如何优化Hadoop集群中的MapReduce任务,例如调整map/reduce任务数、优化Shuffle过程等。

6. 请描述Hadoop集群中的内存管理策略,以及如何进行内存优化。

7. 请简述Hadoop集群中的磁盘I/O优化策略,例如磁盘阵列、RAID等。

8. 请说明如何进行Hadoop集群的性能监控和故障排查。

三、数据存储与处理1. 请描述HDFS的数据存储格式,例如SequenceFile、Parquet、ORC等。

2. 请解释HBase的存储结构,以及RowKey和ColumnFamily的设计原则。

3. 请简述Hive的数据存储格式,以及其与HDFS的交互过程。

4. 请说明Spark的数据存储格式,以及其在内存和磁盘之间的数据交换过程。

5. 请描述Flink的数据流处理模型,以及其在数据流中的操作符和窗口机制。

hadoop面试题目(3篇)

第1篇一、Hadoop基础知识1. 请简述Hadoop的核心组件及其作用。

2. 什么是Hadoop生态系统?列举出Hadoop生态系统中的主要组件。

3. 什么是MapReduce?请简述MapReduce的原理和特点。

4. 请简述Hadoop的分布式文件系统HDFS的架构和特点。

5. 什么是Hadoop的YARN?它有什么作用?6. 请简述Hadoop的HBase、Hive、Pig等组件的特点和应用场景。

7. 什么是Hadoop的集群部署?请简述Hadoop集群的部署流程。

8. 什么是Hadoop的分布式缓存?请简述其作用和实现方式。

9. 什么是Hadoop的MapReduce作业?请简述MapReduce作业的执行流程。

10. 请简述Hadoop的HDFS数据复制策略。

11. 什么是Hadoop的NameNode和DataNode?它们各自有什么作用?12. 请简述Hadoop的HDFS数据写入和读取过程。

13. 什么是Hadoop的Zookeeper?它在Hadoop集群中有什么作用?14. 请简述Hadoop的HDFS数据块的校验和机制。

15. 什么是Hadoop的HDFS数据恢复机制?二、Hadoop核心组件面试题1. 请简述Hadoop的MapReduce组件的架构和执行流程。

2. 请简述Hadoop的HDFS数据块的读写过程。

3. 请简述Hadoop的YARN资源调度器的工作原理。

4. 请简述Hadoop的HBase组件的架构和特点。

5. 请简述Hadoop的Hive组件的架构和特点。

6. 请简述Hadoop的Pig组件的架构和特点。

7. 请简述Hadoop的Zookeeper组件的架构和特点。

8. 请简述Hadoop的HDFS数据块的复制策略。

9. 请简述Hadoop的HDFS数据块的校验和机制。

10. 请简述Hadoop的HDFS数据恢复机制。

三、Hadoop高级面试题1. 请简述Hadoop集群的故障转移机制。

Hadoop面试题汇总_光环大数据Hadoop培训

Hadoop面试题汇总_光环大数据Hadoop培训光环大数据培训班认为,近日有高中同学求助,一看题目,正好与LZ 所学技术相关,便答应了下来,因为正是兴趣所在,也没有管能不能实现。

话不多说,先上题:同学告诉我,这是浪潮实习生的面试题。

LZ先对题目作简单的说明,给定了一个corpus.txt 文件作为语料处理的源文件,文件大小30.3M,内容即题目要求中的图片所示,要求对语料文件中出现的词进行词频统计,并把词频相同的词语用## 相连(如研究##落实1008 ),并按词频从大到小排序。

题目要求的是根据所学的Java I/O 处理、集合框架、字符集与国际化、异常处理等基础知识完成此题,但同学表明可以使用大数据的相关知识,让LZ 感到兴趣的是,最近LZ 一直在研究hadoop,词频统计的题目做了不少,便欣然接受同学的求助。

自己挖的坑总要填的,若是进行简单的词频统计,很简单,涉及到将相同词频的词语排在一行并用## 连接,因为LZ 水平有限,在实现的过程中还是遇到了不少的困难。

一、简单实现词频统计刚入手此题目,LZ 的思路就是先实现一个简单的词频统计,然后在实现简单词频统计的基础上,对代码进行修改,实现相同词频的词语放在一行使用## 连接。

思路很简单,简单的词频统计实现的也非常顺利,但接下的思路实现起来便没有那么容易了。

先来看一看简单的词频统计这个功能吧。

1. 首先先来写Mapper 的功能,上代码:1 public class WordHandlerMapper extends Mapper<LongWritable, Text, Text,LongWritable> { 2 3 @Override 4 protected void map(LongWritable key, Text value, Context context) 5 throws IOException, InterruptedException { 6 7 String[] strs = StringUtils.split(value.toString(), "/t"); 8 9 for(String str : strs) {10 int index = str.indexOf("/");11 12 if(index < 0) {13 index = 0;14 }15 16 String word = str.substring(0, index);17 context.write(new Text(word), new LongWritable(1));18 19 }20 21 }22 23 }WordHandlerMapper 类的功能,首先此类实现了Mapper 类,重写了mapper 方法,使用默认的TextOutputFormat 类,将读取到的一行数据以形参value 的形式传入mapper 方法,第7 行对这行数据也就是value 进行处理,以/t 进行分割,得到了一个String 数组,数组的形式为:["足协/j", "杯赛/n", "常/d"] 形式,然后10 行对数组进行遍历,然后获取到/之前的内容,也就是我们需要统计词频的词语,如10 - 16 行所示,然后将得到的词语传入context 的write 方法,map 程序进行缓存和排序后,再传给reduce 程序。

大数据工程师必备常见Hadoop面试题及答案解析(问答题)

大数据工程师必备常见Hadoop面试题及答案解析(问答题)5 问答题(二)5.1 写出以下执行命令1)如何杀死一个job先Hadoop job -list 得到jobid 杀死job:hadoop job -kill jobid2)删除hdfs 上的/tmp/xxx 目录hadoop fs -rm -r /tmp/xxx 3)加入一个新的存储节点和删除一个计算节点,需要刷新集群状态命令加入新节点时:Hadoop-daemon.sh start datanodeHadoop-daemon.sh start tasktracker删除节点时Hadoop maradmin -refreshnodesHadoop dfsadmin -refreshnodes5.2 简述一下hdfs 的数据压缩算法,工作中用的是那种算法,为什么?1、在HDFS 之上将数据压缩好后,再存储到HDFS2、在HDFS 内部支持数据压缩,这里又可以分为几种方法:2.1、压缩工作在DataNode 上完成,这里又分两种方法:2.1.1、数据接收完后,再压缩这个方法对HDFS 的改动最小,但效果最低,只需要在block 文件close 后,调用压缩工具,将block 文件压缩一下,然后再打开block 文件时解压一下即可,几行代码就可以搞定2.1.2、边接收数据边压缩,使用第三方提供的压缩库效率和复杂度折中方法,Hook 住系统的write 和read 操作,在数据写入磁盘之前,先压缩一下,但write 和read 对外的接口行为不变,比如:原始大小为100KB 的数据,压缩后大小为10KB,当写入100KB 后,仍对调用者返回100KB,而不是10KB2.2、压缩工作交给DFSClient 做,DataNode 只接收和存储这个方法效果最高,压缩分散地推给了HDFS 客户端,但DataNode 需要知道什么时候一个block 块接收完成了。

hadoop面试题

18.}

19.return -1;

20.//找到了,返回找到的数值的下标,没找到,返回-1

21.}

22.

23.

24.//start提示:自动阅卷起始唯一标识,请勿删除或增加。

25.public static void main(String[] args)

26.{

27.System.out.println("Start...");

13.0 hive内部表和外部表的区别

Hive向内部表导入数据时,会将数据移动到数据仓库指向的路径;若是外部表,数据的具体存放目录由用户建表时指定

在删除表的时候,内部表的元数据和数据会被一起删除,

而外部表只删除元数据,不删除数据。

这样外部表相对来说更加安全些,数据组织也更加灵活,方便共享源数据。

14. Hbase的rowKey怎么创建比较好?列簇怎么创建比较好?

10.简述hadoop实现jion的几种方法

Map side join----大小表join的场景,可以借助distributed cache

Reduce side join

11.0请用java实现非递归二分查询

1.public class BinarySearchClass

2.{

3.

4.public static int binary_search(int[] array, int value)

}

context.write(v2, new LongWritable(count));

}

}

}

7.0你认为用java,streaming,pipe方式开发map/reduce,各有哪些优点

就用过java和hiveQL。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2018年常见Hadoop面试题及答案_光环大数据培训hadoop的测试题及答案解析,题目种类挺多,一共有98道题,题目难度不大,对于高手来说,90分以上才是你的追求。

1 单选题1.1 下面哪个程序负责 HDFS 数据存储。

a)NameNodeb)Jobtrackerc)Datanoded)secondaryNameNodee)tasktracker答案 C datanode1.2 HDfS 中的 block 默认保存几份?a)3 份b)2 份c)1 份d)不确定答案 A 默认 3份1.3 下列哪个程序通常与 NameNode 在一个节点启动?a)SecondaryNameNodeb)DataNodec)TaskTracker答案 D,此题分析:hadoop 的集群是基于 master/slave 模式,namenode 和 jobtracker 属于master,datanode 和 tasktracker 属于 slave , master 只有一个,而slave 有多个SecondaryNameNode 内存需求和 NameNode 在一个数量级上,所以通常 secondary ,NameNode(运行在单独的物理机器上)和 NameNode 运行在不同的机器上。

JobTracker 和 TaskTracker,JobTracker 对应于 NameNode,TaskTracker 对应于 DataNode,DataNode 和 NameNode 是针对数据存放来而言的,JobTracker 和 TaskTracker 是对于 MapReduce 执行而言的,mapreduce 中几个主要概念,mapreduce 整体上可以分为这么几条执行线索:obclient,JobTracker 与 TaskTracker。

JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,并把路径提交到 Jobtracker,然后由 JobTracker 创建每一个Task(即 MapTask 和ReduceTask)并将它们分发到各个 TaskTracker 服务中去执行。

JobTracker 是一个 master 服务,软件启动之后 JobTracker 接收 Job,负责调度 Job的每一个子任务 task 运行于 TaskTracker 上,并监控它们,如果发现有失败的 task 就重新运行它。

一般情况应该把 JobTracker 部署在单独的机器上。

TaskTracker 是运行在多个节点上的 slaver 服务。

TaskTracker 主动与JobTracker 通信,接收作业,并负责直接执行每一个任务。

TaskTracker 都需要运行在 HDFS 的 DataNode上。

1.4 Hadoop 作者a)Martin Fowlerb)Kent Beckc)Doug cutting答案 C Doug cutting1.5 HDFS 默认 Block Sizea)32MBc)128MB答案:B(因为版本更换较快,这里答案只供参考)1.6 下列哪项通常是集群的最主要瓶颈:a)CPUb)网络c)磁盘 IOd)内存答案:C 磁盘该题解析:首先集群的目的是为了节省成本,用廉价的 pc 机,取代小型机及大型机。

小型机和大型机有什么特点?cpu 处理能力强内存够大。

所以集群的瓶颈不可能是 a 和 d网络是一种稀缺资源,但是并不是瓶颈。

由于大数据面临海量数据,读写数据都需要 io,然后还要冗余数据,hadoop 一般备 3份数据,所以 IO 就会打折扣。

1.7 关于 SecondaryNameNode 哪项是正确的?a)它是 NameNode 的热备b)它对内存没有要求c)它的目的是帮助 NameNode 合并编辑日志,减少 NameNode 启动时间d)SecondaryNameNode 应与 NameNode 部署到一个节点。

2 多选题2.1 下列哪项可以作为集群的管理?a)Puppetb)Pdshc)Cloudera Managerd)Zookeeper答案:ABD2.2 配置机架感知的下面哪项正确:a)如果一个机架出问题,不会影响数据读写b)写入数据的时候会写到不同机架的 DataNode 中c)MapReduce 会根据机架获取离自己比较近的网络数据答案 ABC2.3 Client 端上传文件的时候下列哪项正确?a)数据经过 NameNode 传递给 DataNodeb)Client 端将文件切分为 Block,依次上传c)Client 只上传数据到一台 DataNode,然后由 NameNode 负责 Block 复制工作答案 B,该题分析:lient 向 NameNode 发起文件写入的请求。

NameNode 根据文件大小和文件块配置情况,返回给 Client 它所管理部分DataNode 的信息。

入到每一个DataNode 块中。

2.4 下列哪个是 Hadoop 运行的模式:a)单机版b)伪分布式c)分布式答案 ABC2.5 Cloudera 提供哪几种安装 CDH 的方法?a)Cloudera managerb)Tarballc)Yumd)Rpm答案:ABCD3 判断题3.1 Ganglia 不仅可以进行监控,也可以进行告警。

( 正确)分析:此题的目的是考 Ganglia 的了解。

严格意义上来讲是正确。

ganglia 作为一款最常用的 Linux 环境中的监控软件,它擅长的的是从节点中按照用户的需求以较低的代价采集数据。

但是 ganglia 在预警以及发生事件后通知用户上并不擅长。

最新的ganglia 已经有了部分这方面的功能。

但是更擅长做警告的还有 Nagios。

Nagios,就是一款精于预警、通知的软件。

通过将 Ganglia 和 Nagios 组合起来,把Ganglia 采集的数据作为 Nagios 的数据源,然后利用 Nagios 来发送预警通知,可以完美的实现一整套监控管理的系统。

3.2 Block Size 是不可以修改的。

(错误 )分析:它是可以被修改的 Hadoop 的基础配置文件是 hadoop-default.xml,默认建立一个 Job 的时候会建立 Job 的 Config,Config 首先读入hadoop-default.xml 的配置,然后再读入 hadoop-site.xml 的配置(这个文件hadoop-default.xml 的系统级配置。

3.3 Nagios 不可以监控 Hadoop 集群,因为它不提供 Hadoop 支持。

(错误 )分析:Nagios 是集群监控工具,而且是云计算三大利器之一3.4 如果 NameNode 意外终止,SecondaryNameNode 会接替它使集群继续工作。

(错误 )分析:SecondaryNameNode 是帮助恢复,而不是替代,如何恢复,可以查看3.5 Cloudera CDH 是需要付费使用的。

(错误 )分析:第一套付费产品是 Cloudera Enterpris,Cloudera Enterprise 在美国加州举行的Hadoop 大会 (Hadoop Summit) 上公开,以若干私有管理、监控、运作工具加强Hadoop 的功能。

收费采取合约订购方式,价格随用的 Hadoop 叢集大小变动。

3.6 Hadoop 是 Java 开发的,所以 MapReduce 只支持 Java 语言编写。

(错误 )分析:rhadoop 是用 R 语言开发的,MapReduce 是一个框架,可以理解是一种思想,可以使用其他语言开发。

3.7 Hadoop 支持数据的随机读写。

(错 )分析:lucene是支持随机读写的,而 hdfs 只支持随机读。

但是 HBase 可以来补救。

HBase提供随机读写,来解决 Hadoop 不能处理的问题。

HBase自底层设计开始即聚焦于各种可伸缩性问题:表可以很“高”,有数十亿个数据行;也可以“宽”,有数百万个列;水平分区并在上千个普通商用机节点上自动复制。

表的模式是物理存储的直接反映,使系统有可能提高高效的数据结构的序列化、存储和检索。

3.8 NameNode 负责管理 metadata,client 端每次读写请求,它都会从磁盘中读取或则会写入 metadata 信息并反馈 client 端。

(错误)此题分析:是序列化的结果,只有每次 namenode 启动的时候才会读取。

1)文件写入Client 向 NameNode 发起文件写入的请求。

NameNode 根据文件大小和文件块配置情况,返回给 Client 它所管理部分DataNode 的信息。

Client 将文件划分为多个 Block,根据 DataNode 的地址信息,按顺序写入到每一个DataNode 块中。

2)文件读取Client 向 NameNode 发起文件读取的请求。

3.9 NameNode 本地磁盘保存了 Block 的位置信息。

( 个人认为正确,欢迎提出其它意见)分析:DataNode 是文件存储的基本单元,它将 Block 存储在本地文件系统中,保存了 Block的 Meta-data,同时周期性地将所有存在的 Block 信息发送给 NameNode。

NameNode返回文件存储的 DataNode 的信息。

Client 读取文件信息。

3.10 DataNode 通过长连接与 NameNode 保持通信。

(有分歧 )这个有分歧:具体正在找这方面的有利资料。

下面提供资料可参考。

首先明确一下概念:(1).长连接Client 方与 Server 方先建立通讯连接,连接建立后不断开,然后再进行报文发送和接收。

这种方式下由于通讯连接一直存在,此种方式常用于点对点通讯。

(2).短连接毕后立即断开连接。

此种方式常用于一点对多点通讯,比如多个 Client 连接一个 Server.为什么大家选择光环大数据!大数据培训、人工智能培训、Python培训、大数据培训机构、大数据培训班、数据分析培训、大数据可视化培训,就选光环大数据!光环大数据,聘请专业的大数据领域知名讲师,确保教学的整体质量与教学水准。

讲师团及时掌握时代潮流技术,将前沿技能融入教学中,确保学生所学知识顺应时代所需。

通过深入浅出、通俗易懂的教学方式,指导学生更快的掌握技能知识,成就上万个高薪就业学子。

【报名方式、详情咨询】光环大数据官方网站报名:/手机报名链接:http:// /mobile/。