KETTLE使用说明(中文版)

kettle使用手册

kettle使用手册Kettle使用手册一、Kettle简介1.1 Kettle概述Kettle(也被称为Pentaho Data Integration)是一款开源的ETL(Extract, Transform, Load)工具,它能够从各种数据源中提取数据,并进行各种转换和加工,最后将数据加载到指定的目的地中。

Kettle具有强大的数据处理功能和友好的图形化界面,使得数据集成和转换变得简单而高效。

1.2 功能特点- 数据抽取:从多种数据源中提取数据,包括关系型数据库、文件、Web服务等。

- 数据转换:支持多种数据转换操作,如字段映射、类型转换、数据清洗等。

- 数据加载:将转换后的数据加载到不同的目的地,如数据库表、文件、Web服务等。

- 调度管理:支持定时调度和监控,可自动执行数据集成任务。

二、安装与配置2.1 系统要求在安装Kettle之前,请确保满足以下系统要求: - 操作系统:Windows、Linux、Unix等。

- Java版本:JDK 1.8及以上。

- 内存:建议至少4GB的可用内存。

2.2 安装Kettle最新版本的Kettle安装包,并按照安装向导进行安装。

根据系统要求和个人需求进行相应的配置选项,完成安装过程。

2.3 配置Kettle在安装完成后,需要进行一些配置以确保Kettle正常运行。

具体配置步骤如下:- 打开Kettle安装目录下的kettle.properties文件。

- 根据实际需要修改配置项,如数据库连接、日志路径、内存分配等。

- 保存修改并重启Kettle。

三、Kettle基础操作3.1 数据抽取3.1.1 创建数据源连接打开Kettle,左上角的“新建连接”按钮,在弹出的窗口中选择待抽取的数据源类型(如MySQL、Oracle等),填写相关参数并测试连接。

3.1.2 设计数据抽取作业- 打开Kettle中的“转换”视图。

- 从左侧的工具栏中选择适当的输入组件(如“表输入”或“文件输入”),将其拖拽到设计区域中。

kettle使用手册

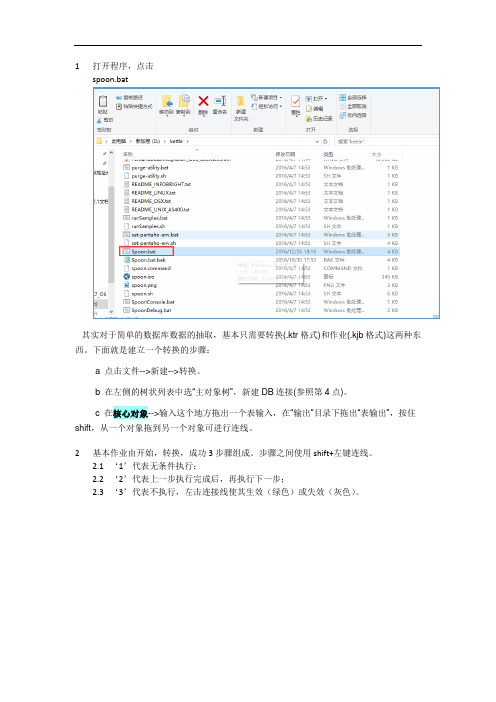

1打开程序,点击spoon.bat其实对于简单的数据库数据的抽取,基本只需要转换(.ktr格式)和作业(.kjb格式)这两种东西。

下面就是建立一个转换的步骤:a 点击文件-->新建-->转换。

b 在左侧的树状列表中选“主对象树”,新建DB连接(参照第4点)。

c 在核心对象-->输入这个地方拖出一个表输入,在“输出”目录下拖出“表输出”,按住shift,从一个对象拖到另一个对象可进行连线。

2基本作业由开始,转换,成功3步骤组成。

步骤之间使用shift+左键连线。

2.1‘1’代表无条件执行;2.2‘2’代表上一步执行完成后,再执行下一步;2.3‘3’代表不执行,左击连接线使其生效(绿色)或失效(灰色)。

3打开具体步骤中的转换流程,点击‘Transformation’跳转至相应具体转换流程,编辑此转换具体路径,双击转换,弹出窗口,‘1’为相对路径,点击‘2’选择具体Visit.ktr 转换,为绝对路径。

4建立数据库连接,输入相应信息测试,成功即可图45转换具体设置,如图4,‘表输出’至‘文本文件输出’流程跳接线为错误处理步骤,当输出格式不能满足表输出的目的表结构类型时,将会将记录输出到‘文本文件输出’中的记录中。

5.1双击‘表输入’,输入相应的SSQL语句,选择配置数据库连接,或新增,预览查询生成的结果(如果数据库配置中使用变量获取,此处预览生成错误)。

5.2双击‘表输出’,选择数据库连接,‘浏览’选择相应目标表,(此处‘使用批量插入’勾选去除,目的是在错误处理步骤中无法使用批量处理,可能是插件兼容问题)6表输出插件定义a) Target Schema:目标模式。

要写数据的表的Schema的名称。

允许表明中包含“。

”对数据源来说是很重要的b) 目标表:要写数据的表名。

c) 提交记录数量:在数据表中用事物插入行。

如果n比0大,每n行提交一次连接。

否则不使用事务,速度会慢一些。

d) 裁剪表:在第一行数据插入之前裁剪表。

kettle的使用方法

kettle的使用方法Kettle是一种用于数据集成和转换的开源工具,也被称为Pentaho Data Integrator(PDI)。

它提供了一套功能强大的工具,可以帮助用户从不同的数据源中提取、转换和加载数据。

本文将介绍Kettle 的使用方法,帮助读者快速上手使用该工具。

一、安装Kettle您需要从Kettle官方网站下载最新版本的安装包。

安装包通常是一个压缩文件,您可以将其解压到您选择的目录中。

然后,通过运行解压后的文件夹中的启动脚本来启动Kettle。

二、连接数据源在使用Kettle之前,您需要先连接到您的数据源。

Kettle支持多种类型的数据源,包括关系型数据库、文件、Web服务等。

您可以使用Kettle提供的连接器来连接到您的数据源,或者根据需要自定义连接器。

连接成功后,您可以在Kettle中查看和操作您的数据。

三、创建转换在Kettle中,数据转换是通过创建转换作业来实现的。

转换作业是由一系列的转换步骤组成的,每个步骤都执行特定的数据操作。

您可以使用Kettle提供的各种转换步骤,如数据提取、数据过滤、数据转换、数据加载等,来构建您的转换作业。

四、配置转换步骤在创建转换作业后,您需要配置每个转换步骤的参数和选项。

例如,在数据提取步骤中,您需要指定要提取的数据源和查询条件。

在数据转换步骤中,您可以定义数据的转换逻辑,如数据清洗、数据合并、数据计算等。

在数据加载步骤中,您需要指定目标数据表和加载方式。

五、运行转换作业完成转换步骤的配置后,您可以运行整个转换作业,将数据从源数据源提取、转换和加载到目标数据源。

在运行转换作业之前,您可以选择性地预览转换结果,以确保数据操作的准确性和一致性。

Kettle还提供了调试功能,可以帮助您快速定位和解决转换作业中的问题。

六、调度转换作业除了手动运行转换作业之外,Kettle还支持将转换作业安排为定期执行的任务。

您可以使用Kettle提供的调度功能,根据您的需求设置转换作业的执行时间和频率。

kettle使用方法

kettle使用方法一、什么是kettle?Kettle是一款功能强大的开源ETL (Extract, Transform, Load) 工具,用于处理各种数据的抽取、转换和加载。

它提供了可视化的界面,使用户能够轻松地创建和管理数据流程。

二、kettle的安装和配置1.下载kettle安装包,并解压到指定目录。

2.进入kettle目录,在终端中运行spoon.sh (Linux/Mac) 或spoon.bat(Windows) 启动kettle。

3.在弹出的窗口中,点击”File”菜单,选择”Preferences”打开配置页面。

4.在配置页面中,设置kettle的选项,如数据连接、插件路径等。

三、kettle中的数据流程1.创建一个新的数据流程:点击工具栏上的”新建”按钮,在弹出的对话框中选择”Transformation”创建一个新的转换,或选择”Job”创建一个作业。

2.在数据流程中,可以拖拽各种组件来构建转换或作业,如数据输入、数据输出、转换、聚合等。

3.连接组件:使用鼠标拖拽连线工具,连接各个组件,定义数据的流向。

4.配置组件:双击组件,如数据输入组件,可以配置数据源的连接信息、查询语句等。

5.定义转换规则:在转换组件中,根据需要配置字段映射、条件过滤、转换函数等。

6.运行数据流程:点击工具栏上的”运行”按钮,运行数据流程并查看结果。

四、kettle的常用组件和功能1.数据输入:用于读取数据源的组件,支持多种数据源,如数据库、文件、Web服务等。

2.数据输出:用于将数据写入目标的组件,支持多种输出格式,如数据库表、文件、Web服务等。

3.转换组件:用于对数据进行转换的组件,如字段映射、类型转换、条件过滤、聚合等。

4.调度和监控:kettle提供了作业调度和监控的功能,可以定时执行作业、生成报表等。

5.插件扩展:kettle支持插件扩展,用户可以根据需要开发自己的插件,用于处理特定的数据源或转换规则。

Kettle的使用说明

KETTLE使用说明简介Kettle是一款国外开源的ETL工具,纯java编写,可以在Window、Linux、Unix上运行,绿色无需安装,数据抽取高效稳定。

Kettle 中文名称叫水壶,该项目的主程序员MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。

Kettle这个ETL工具集,它允许你管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述你想做什么,而不是你想怎么做。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

Kettle可以在/网站下载到。

注:ETL,是英文Extract-Transform-Load 的缩写,用来描述将数据从来源端经过萃取(extract)、转置(transform)、加载(load)至目的端的过程。

ETL 一词较常用在数据仓库,但其对象并不限于数据仓库。

下载和安装首先,需要下载开源免费的pdi-ce软件压缩包,当前最新版本为5.20.0。

下载网址:/projects/pentaho/files/Data%20Integration/然后,解压下载的软件压缩包:pdi-ce-5.2.0.0-209.zip,解压后会在当前目录下上传一个目录,名为data-integration。

由于Kettle是使用Java开发的,所以系统环境需要安装并且配置好JDK。

žKettle可以在/网站下载ž 下载kettle压缩包,因kettle为绿色软件,解压缩到任意本地路径即可。

运行Kettle进入到Kettle目录,如果Kettle部署在windows环境下,双击运行spoon.bat 或Kettle.exe文件。

Linux用户需要运行spoon.sh文件,进入到Shell提示行窗口,进入到解压目录中执行下面的命令:# chmod +x spoon.sh# nohup ./spoon.sh & 后台运行脚本这样就可以打开配置Kettle脚本的UI界面。

Kettle配置使用说明

Kettle配置使用说明Kettle配置使用说明1.文件结构1.1 kettle4.0.1该文件夹存放的是kettle4.0.1的桌面应用程序,/kettle4.0.1/Spoon.bat是运行软件的一个批处理文件,双击运行。

1.2 workspace该文件夹存放的是以各个警种总队全拼命名的分别存放.ktr文件和.job文件的文件夹。

Start.job是一个启动总纲。

1.3 script该文件夹是存放的数据库建库脚本,目前是oracle10g版本1.4 model存放的是powerDesign的cdm概念模型文件用于根据需要生成pdm和script。

2.文件路径配置本系统使用的都是系统所在路径的相对路径,不管处于什么目录下都请将kettle4.0.1和workspace的文件夹放在同一目录之下。

当然你可以随意改变文件夹的名称。

3.运行环境配置先运行一次/kettle4.0.1/Spoon.bat,Linux就不说了,如果你用的是windows系统,那么你可以在/${userhome}/.kettle下找到一个.kettle的文件夹主要说下:Response.xml-记录资源库信息(自己去勾)Kettle.property-这是好东西,可以让你在软件中任何可以使用到环境变量的地方使用到里面的配置信息(键-值对配置),类似全局变量。

当然是有利有弊,配置点什么数据库连接和一些常用的东西之外别把那里当仓库,想下全局变量定义的多了会给系统带来什么风险。

A_fileInput=file:///E:/Test_Server/srcFile/A_fileOutput=file:///E:/Test_Server/errFile/这2个属性是配置读取的Excel文件和输出错误的Excel文件用到的路径配置。

由于文件名命名的差异和存放位置的不同需要使用者自行配置。

有在系统内修改文件路径的风险,当然这是没有办法避免的,只能在项目初期和用户有这方面的约定俗成。

计算机网络Kettle命令行使用说明

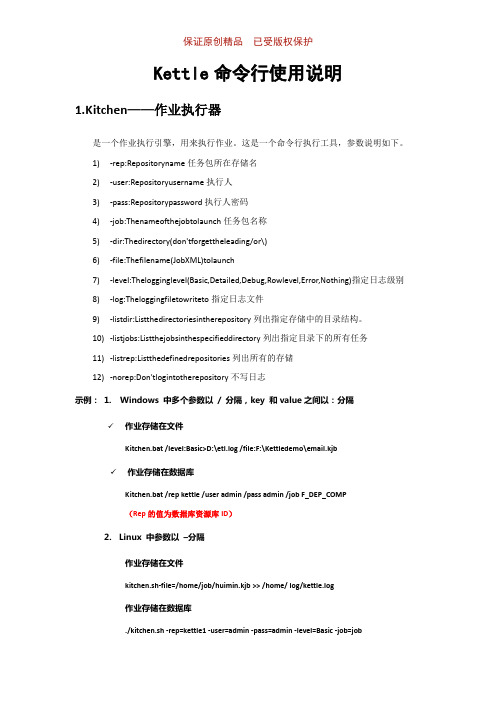

保证原创精品已受版权保护Kettle命令行使用说明1.Kitchen——作业执行器是一个作业执行引擎,用来执行作业。

这是一个命令行执行工具,参数说明如下。

1)-rep:Repositoryname任务包所在存储名2)-user:Repositoryusername执行人3)-pass:Repositorypassword执行人密码4)-job:Thenameofthejobtolaunch任务包名称5)-dir:Thedirectory(don'tforgettheleading/or\)6)-file:Thefilename(JobXML)tolaunch7)-level:Thelogginglevel(Basic,Detailed,Debug,Rowlevel,Error,Nothing)指定日志级别8)-log:Theloggingfiletowriteto指定日志文件9)-listdir:Listthedirectoriesintherepository列出指定存储中的目录结构。

10)-listjobs:Listthejobsinthespecifieddirectory列出指定目录下的所有任务11)-listrep:Listthedefinedrepositories列出所有的存储12)-norep:Don'tlogintotherepository不写日志示例:1. Windows 中多个参数以/ 分隔,key 和value之间以:分隔✓作业存储在文件Kitchen.bat /level:Basic>D:\etl.log /file:F:\Kettledemo\email.kjb✓作业存储在数据库Kitchen.bat /rep kettle /user admin /pass admin /job F_DEP_COMP(Rep的值为数据库资源库ID)2.Linux 中参数以–分隔作业存储在文件kitchen.sh-file=/home/job/huimin.kjb >> /home/ log/kettle.log作业存储在数据库./kitchen.sh -rep=kettle1 -user=admin -pass=admin -level=Basic -job=job。

Kettle用户操作手册1

Kettle用户操作手册1.kettle介绍1.1 什么是kettleKettle是“Kettle E.T.T.L. Envirnonment”只取首字母的缩写,这意味着它被设计用来帮助你实现你的ETTL 需要:抽取、转换、装入和加载数据;它的名字起源正如该项目的主程序员MATT所说:希望把各种数据放到一个壶里然后以一种指定的格式流出。

Spoon是一个图形用户界面,它允许你运行转换或者任务。

1.2 Kettle 的安装要运行此工具你必须安装 Sun 公司的JAVA 运行环境1.4 或者更高版本,相关资源你可以到网络上搜索JDK 进行下载,Kettle 的下载可以到取得最新版本。

1.3 运行SPOON下面是在不同的平台上运行Spoon 所支持的脚本:Spoon.bat: 在windows 平台运行Spoon。

Spoon.sh: 在Linux、Apple OSX、Solaris 平台运行Spoon。

1.4 资源库一个Kettle资源库可以包含那些转换信息,这意味着为了从数据库资源中加载一个转换就必须连接相应的资源库。

在启动SPOON的时候,可以在资源库中定义一个数据库连接,利用启动spoon时弹出的资源库对话框来定义,如图所示:单击加号便可新增;关于资源库的信息存储在文件“reposityries.xml”中,它位于你的缺省home 目录的隐藏目录“.kettle”中。

如果是windows 系统,这个路径就是c:\Documents and Settings\<username>\.kettle。

如果你不想每次在Spoon 启动的时候都显示这个对话框,你可以在“编辑/选项”菜单下面禁用它。

admin 用户的缺省密码也是admin。

如果你创建了资源库,你可以在“资源库/编辑用户”菜单下面修改缺省密码。

1.5 定义1.5.1 转换主要用来完成数据的转换处理。

转换步骤,可以理解为将一个或者多个不同的数据源组装成一条数据流水线。

KETTLE简单使用说明文档

KETTLE简单使用说明文档1. 下载和安装要运行此工具你必须安装SUN 公司的JAVA 运行环境 1.4 或者更高版本,相关资源你可以到网络上搜索JDK 进行下载。

设置JAVA 运行环境变量,JAVA_HOME 和PATHKETTLE 的下载可以到/取得最新版本,下载后解压,就可以直接运行。

2.kettle主要有两部分组成,主对象树,核心对象,3.新建一个kettle文件(数据库之间做处理)1)转换右键点击新建,如图所示2) 设置数据库连接,上图DB连接右键新建(支持多库连接): 如图:3)核心对象里面有很多组件,通过拖拽来供给我们做操作,如图4)添加一个源输入,打开输入文件夹,可以看到各种输入类型,支持文件,数据库等。

如图5)这里通过数据库操作,那我们这里拖拽一个表输入组件6)双击打开,可以看到你可以选择上面连接的数据库,然后通过获取sql语句来选择你要输入的源表进行操作。

并且sql语句支持传递变量参数和占位符参数,以及多表关联sql。

如下图7)输入表已经OK,那输出表呢,那我看下输出组件。

如图8)选中两个组件,右键新建节点连接。

如下图9)双击打开表输出,选择输出的数据库,以及目标表和输入表与目标表的字段映射10)映射选择以及匹配11)点击箭头弹出启动界面,点击启动,该kettle文件即可执行数据的迁移了12)上面是一个简单的数据库转换操作。

在表输入和表输出直接可以加不同组件对数据进行筛选过滤。

通过转换文件夹下的组件。

如图转换可以处理中文乱码,字段数字的计算,值的转换,序列的生成等等脚本可以用java代码,javascript,sql脚本等等查询支持调用存储过程,两个表直接关联查询等等以上只是针对kettle工具的简单实用介绍。

KETTLE使用说明

KETTLE使用说明在本使用说明中,我们将详细介绍如何使用KETTLE完成一些常见的数据处理任务。

第一步:安装和启动KETTLE在Windows中,双击运行Spoon.bat文件来启动KETTLE。

在Linux 和Mac OS中,打开终端,进入KETTLE目录,输入"./spoon.sh"命令来启动KETTLE。

第二步:创建一个新的数据流程启动KETTLE后,您将看到一个图形化界面。

在左上角的工具栏中,有一个新建按钮,点击它来创建一个新的数据流程。

在创建数据流程时,您需要为其指定一个名称。

完成后,点击确定按钮。

第三步:添加数据源在左侧的工具箱中,您可以找到各种组件,如输入步骤、输出步骤、转换步骤等。

为了演示,我们先添加一个输入步骤。

在工具箱中,找到输入步骤,并将其拖放到主界面中。

然后,双击该步骤,在弹出的对话框中配置数据源。

在配置对话框中,您需要指定数据源的类型,如文本文件、Excel文件、数据库等。

根据不同的类型,您可能需要提供相应的连接信息。

完成配置后,点击确定按钮。

在数据流程中,您可以使用转换步骤对数据进行处理。

为了演示,我们使用一个简单的转换步骤来删除重复的数据。

在工具箱中,找到去重复步骤,并将其拖放到已添加的输入步骤的下方。

然后,双击该步骤,在弹出的对话框中配置参数。

在配置对话框中,您需要指定要去重的字段。

您可以选择多个字段以进行复合去重。

完成配置后,点击确定按钮。

第五步:添加输出在数据流程中,您也需要指定一个输出步骤来保存处理后的数据。

在工具箱中,找到输出步骤,并将其拖放到已添加的去重复步骤的下方。

然后,双击该步骤,在弹出的对话框中配置输出格式和目标文件。

在配置对话框中,您需要指定输出的格式,如文本文件、Excel文件、数据库等。

根据不同的格式,您可能需要提供相应的连接信息。

完成配置后,点击确定按钮。

第六步:保存和运行数据流程完成对数据流程的配置后,点击工具栏中的保存按钮来保存数据流程。

Kettle5.某使用步骤带案例解析详细版

Kettle5.某使用步骤带案例解析详细版Kettle使用方法介绍1、Kettle概念Kettle是一款国外开源的ETL工具,纯java编写,可以在Window、Linux、Unix 上运行,绿色无需安装,数据抽取高效稳定。

Kettle 中文名称叫水壶,该项目的主程序员MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。

Kettle这个ETL工具集,它允许你管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述你想做什么,而不是你想怎么做。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

2、下载和部署下载kettle压缩包,因kettle为绿色软件,解压缩到任意本地路径即可3、Kettle环境配置1.安装JDK(略)2.测试JDK安装成功(略)3.运行KettleWindows下找到$KETTLE_HOME/spoon.dat,双击运行欢迎界面如下图所示:4、KETTLE组件介绍与使用4.1 Kettle使用Kettle提供了资源库的方式来整合所有的工作,;1)创建一个新的transformation,点击保存到本地路径,例如保存到D:/etltest下,保存文件名为Trans,kettle默认transformation文件保存后后缀名为ktr;2)创建一个新的job,点击保存到本地路径,例如保存到D:/etltest下,保存文件名为Job,kettle默认job文件保存后后缀名为kjb;4.2 组件树介绍4.2.1Transformation 的主对象树和核心对象分别如下图:Transformation中的节点介绍如下:Main Tree:菜单列出的是一个transformation中基本的属性,可以通过各个节点来查看。

DB连接:显示当前transformation中的数据库连接,每一个transformation的数据库连接都需要单独配置。

kettle工具用法

kettle工具用法关于"kettle工具用法"的1500-2000字文章:Kettle工具是一款功能强大的开源数据集成工具,旨在简化和自动化数据导入、转换和输出的过程。

它拥有直观而强大的用户界面,可让用户通过图形化界面创建和管理数据管道。

本文将逐步回答Kettle工具的用法,涵盖安装、界面介绍、数据导入和转换、数据输出等方面。

一、安装Kettle工具首先,访问Kettle官方网站并下载最新版本的Kettle工具。

下载完成后,运行安装程序,并按照提示进行安装。

安装完成后,打开Kettle工具。

二、界面介绍打开Kettle工具后,你将看到一个主界面,其中包含了工具栏、转换面板和作业面板等。

工具栏上有各种按钮,用于打开、保存和运行数据转换和作业。

转换面板用于创建、编辑和管理数据转换,而作业面板用于创建和管理作业。

你可以通过拖放组件和连接器来建立转换和作业的流程。

三、数据导入数据导入是Kettle工具的一个重要功能,它允许将数据从各种来源导入到目标数据库或文件中。

在Kettle中,你可以通过以下步骤导入数据:1. 创建新的数据转换:在转换面板上右键单击,选择“新建转换”来创建一个新的数据转换。

2. 添加数据输入组件:在工具栏上选择“输入”,然后拖放数据源到转换面板上。

根据需要选择适当的输入类型,如CSV文件、数据库、Excel文件等。

3. 配置数据输入组件:选择添加到转换面板的数据输入组件,右键单击并选择“编辑”。

在配置窗口中,设置数据源的连接信息、查询语句和字段映射等。

4. 添加目标组件:与添加数据输入组件类似,选择“输出”按钮并拖放目标数据库或文件组件到转换面板上。

5. 配置目标组件:选择添加到转换面板的目标组件,右键单击并选择“编辑”。

在配置窗口中,设置目标数据库的连接信息、目标表或文件的格式等。

6. 连接输入和目标组件:在转换面板上,拖动鼠标从数据输入组件的输出连接器到目标组件的输入连接器上,建立数据流。

KETTLE使用说明及带输入参数JAVA调用

ETL工具——kettle使用说明1简介ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),Kettle是一款国外开源的etl工具,纯java编写,数据抽取高效稳定。

2运行环境:OS:Window、Linux、Unix均可Jdk1.4以上3开始使用:Kettle可以在/网站下载。

下载kettle压缩包,因kettle为绿色软件,解压缩到任意本地路径即可。

(本文着重介绍kettle3.2.0稳定版)Spoon是一个图形用户界面,在不同平台上运行Spoon需要不同的脚本:Spoon.bat:在windows平台运行Spoon(或直接点击Kettle.exe)。

Spoon.sh:在Linux、Apple OSX、Solaris平台运行Spoon。

登陆一般选择没有资源库:Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

4转换(Transformation)新建一个转换kettle默认transformation文件保存后后缀名为ktr新建数据库连接(此链接也可在用到的节点处配置)填写数据源配置内容点击Test测试连接成功:核心对象切换到核心对象,菜单列出的是Transformation中可以调用的环节列表,可以通过鼠标拖动的方式对环节进行添加。

并且可通过shift+鼠标拖动,实现环节之间的连接。

常用节点介绍(红色节点后面逐一演示)类别环节名称功能说明输入文本文件输入从本地文本文件输入数据表输入从数据库表中输入数据获取系统信息读取系统信息输入数据输出文本文件输出将处理结果输出到文本文件表输出将处理结果输出到数据库表插入/更新根据处理结果对数据库表机型插入更新,如果数据库中不存在相关记录则插入,否则为更新。

会根据查询条件中字段进行判断更新根据处理结果对数据库进行更新,若需要更新的数据在数据库表中无记录,则会报错停止删除根据处理结果对数据库记录进行删除,若需要删除的数据在数据库表中无记录,则会报错停止查询数据库查询根据设定的查询条件,对目标表进行查询,返回需要的结果字段流查询将目标表读取到内存,通过查询条件对内存中数据集进行查询调用DB存储过程调用数据库存储过程转换字段选择选择需要的字段,过滤掉不要的字段,也可做数据库字段对应过滤记录根据条件对记录进行分类排序记录将数据根据某以条件,进行排序空操作无操作增加常量增加需要的常量字段脚本Modified Java扩展功能,编写JavaScript脚本,对数据进行相应处理Script Value映射映射(子转换)数据映射作业Sat Variables设置环境变量Get Variables获取环境变量表输入双击拖动到工作面板上的表输入结点,选择(或者新建)所需要的数据库连接,点击获取SQL查询语句或自行编辑SQL。

KETTLE使用说明(中文版)

5.4 输出:插入/更新

插入/更新:若流里的数据在目标表中不存在,执行插入,否则执行更新, 数据量不大的情况下,一般采用插入/更新操作。

5.5 输出:更新

这个步骤类似于插入/更新步骤,除了对数据不作插入操作之外。它仅仅 执行更新操作。

5.6 输出:删除

这个步骤类似于更新步骤,除了不更新操作之外,其他的行均被删除。

选择表输入, excel 输出,建立节点 连接。右击连接线,可编辑连线属 性。

5.1常用输入:

表输入 Excel 输入 文本文件输入 XML 文件输入 CUBE 输入(多维数据集) 获取系统信息

5.2输入:表输入

选择表输入,点击鼠标右键,选择编辑步骤。 步骤名称可以更改,一般更改为和输入表相关的名称。 数据库连接 : 选择一个已建好的数据库连接,也可以新建一个。 点击”获取SQL查询语句”,可弹出数据库浏览器,选择自己需要的表或视图。 选择好表或视图后,SQL 区域会显示相应的SQL,如选择在SQL里包含字段名,你 所选择的表的所有字段均会显示. 在SQL区域用户可手动修改SQL语句。

7.3 Flow :Blocking Step(被冻结的步骤)

这是一个非常简单的步骤,它冻结所有的输出,直到从上一个步骤来的最后一行 数据到达,最后 一行数据将发送到下一步。 你可以使用这个步骤触发常用插件、 存储过程和js等等。

8.0 连接 :Merge Join(合并排序)

这个步骤将来自两个不同的步骤输 入的数据执行一个高效的合并。合 并选项包括INNER ,LEFT OUTER , RIGHT OUTER, FULL OUTER. 这个步骤将输入的行按照指定的字 段存储 被合并的两个步骤,必须按照相同 的段进行排序。

KETTLE使用说明(中文版)

7.0 Flow : 空操作(什么也不做)

这个操作说明都不做,它的主要作用是,在你想做测试的时候,充当一个占位符。

7.1 Flow : 过滤记录

这个步骤根据条件和比较符来过滤记录。 发送true数据给步骤: 指定条件返回true的数据将发送到此步骤 发送false数据给步骤: 指定条件返回false 的数据将发送到此步骤。 True 和false 步骤必须指定。

1.2 安装kettle 要运行Kettle ,必须按安装java 环境1.4或以上版本,kettle下载可以到: 取得最新版本。(pdi-ce-4.0.1-stable.zip) 1.3 运行spoon 下面是不同平台上运行spoon 所支持的脚本 : spoon.bat windows 平台运行Spoon. Spoon.sh linux 平台运行Spoon. 1.4 资源库 一个Kettle 资源库可以包含那些转换信息,这意味着为了从数据资源中加载一个转 换,你必须连接相应的资源库。

连接名称 : 选择数据库序列存在的 连接名称 序列名称: 数据库序列的名称 使用计数器来计算序列: 如果想使用kettle生成的 序列,使用此项。

计数器名称(可选):如果一个转换中多个步

骤生成同样的值名称,这个选项允许你指定计数 器的名称,避免按照先后顺序通过多个步骤。 起始值: 序列的起始值 增量 : 序列的增量 最大值 : 序列的最大值,如果超过,将重新开始

1.6.2 任务 1. Job Entry : 一个 一个Job Entry 是一个任务的一部分,它执行某些内容。 是一个任务的一部分,它执行某些内容。 2. Hop: 一个 一个Hop 代表两个步骤之间的一个或者多个数据流。一个 代表两个步骤之间的一个或者多个数据流。一个Hop总是代 总是代 表着两个Job Entry 之间的连接,并且能够被原始的 之间的连接,并且能够被原始的Job Entry设置,无 设置, 表着两个 设置 条件的执行下一个JobEntry,直到执行成功或者失败。 直到执行成功或者失败。 条件的执行下一个 直到执行成功或者失败

kettle常用操作

kettle常用操作

使用水壶是一项简单而常见的操作,以下是使用水壶的常见操作:

1. 填水,首先,打开水壶的盖子,然后将水倒入水壶中。

请注意,不要超过水壶的最大容量标记,以避免溢出。

2. 盖盖,在倒入水后,确保盖子牢固地关闭,以防止水从水壶中溢出,并确保安全。

3. 插电,将水壶的插头插入电源插座。

在插入插头之前,请确保水壶内没有水,以避免电击危险。

4. 按钮操作,大多数水壶都配有开关按钮或热水按钮。

按下按钮,启动水壶加热水。

5. 等待,等待水壶加热水直至水烧开。

一些水壶会发出声音或者自动关闭,以示水已经烧开。

6. 倒水,当水烧开后,小心地将热水从水壶中倒出。

确保小心

操作,以免烫伤。

7. 断电,在使用完水壶后,务必拔掉电源插头,以确保安全。

以上是使用水壶的常见操作步骤,希望对你有所帮助。

如果你有其他问题,欢迎随时提出。

kettle使用方法说明文档课案

Kettle 使用方法说明文档1.安装程序解压到随意盘符,解压后点击根目录下Spoon.bat以下列图所示。

点击 cancel2.创立表到表直接抽取本实例演示的是在 Oracle 数据库 zhwater 下的 zh 用户里面表sys_user变换到当地 Oracle 数据库 orcl 下的 zw 用户下的表 sys_user。

演示过程是成立transform 将数据从 zh.sys_user抽取到 zw. sys_user 里面。

两个表构造同样。

a)成立变换进入系统后以下列图所示,双击变换。

b)创立源和目标数据库连结c)成立变换步骤点开【输入】—— >【表输入】将表输入拉到右边。

双击右边的表输入,以下列图,配置点开【输出】—— >【插入 /更新】将其拉到右边。

按住 shift 先后左键点击表输入和插入/更新的图标。

双击插入 /更新图标,点击【获得字段】和【获得和更新字段】用来查问的重点字保存主键USERID ,其余删掉。

点击确立保存,点击上方考证无错误后,点击履行,以下列图。

数据库中能够看到数据已从zh.sys_user抽取到 zw.sys_userD)保存文件保存文件的文件名不可以是中文,文件路径不可以包括中文3.创立带数据聚合的表到表抽取本实例演示的是在数据库SG186ND 下的 basic_data用户里面的两个表 sc_work_ticket 和 t_sc_work_ticket。

演示过程是成立transform 将数据从 sc_work_ticket 抽取到 t_sc_work_ticket 里面。

即模拟基础表到主题表抽取过程。

a)源数据获得变换和链接创立过程见上节说明。

将表输入 step 拉入图中双击表输入,配置源连结。

b)数据分组将【 Memory Group by】拖入图中,并按住shift 连结表输入和Memory Group by。

点开【 Memory Group by 】,将基础表中波及维度的字段加入分组内。

2024版kettle使用教程(超详细)

分布式计算原理

阐述Kettle分布式计算的原理, 如何利用集群资源进行并行处理 和任务调度。

01 02 03 04

集群配置与部署

详细讲解Kettle集群的配置步骤, 包括环境准备、节点配置、网络 设置等。

集群监控与管理

介绍Kettle提供的集群监控和管 理工具,方便用户实时了解集群 状态和作业执行情况。

03

实战演练

以一个具体的实时数据处理任务为例, 介绍如何使用Kettle设计实时数据处理 流程。

案例四:Kettle在数据挖掘中应用

数据挖掘概念介绍

01

数据挖掘是指从大量数据中提取出有用的信息和知识的

过程,包括分类、聚类、关联规则挖掘等任务。

Kettle在数据挖掘中的应用

02

Kettle提供了丰富的数据处理和转换功能,可以方便地

Chapter

案例一:ETL过程自动化实现

ETL概念介绍

ETL即Extract, Transform, Load,是数据仓 库技术中重要环节,包括数据抽取、清洗、转 换和加载等步骤。

Kettle实现ETL过程

通过Kettle的图形化界面,可以方便地设计ETL流程, 实现数据的自动化抽取、转换和加载。

作业项配置

对作业项进行详细配置,包括数据源、目标库、 字段映射等。

作业项管理

支持作业项的复制、粘贴、删除等操作,方便快速构建作业。

定时任务设置与执行

定时任务设置

支持基于Cron表达式的定时任务设置,实现 周期性自动执行。

立即执行

支持手动触发作业执行,满足即时数据处理 需求。

执行日志查看

kettle 用法

Kettle是一款开源的ETL工具,使用Kettle可以轻松地实现数据集成、转换和加载等任务。

以下是Kettle的基本用法:1. 下载并解压Kettle:可以从官网下载Kettle的最新版本,然后解压到本地。

2. 创建转换任务:在Kettle中,可以使用“转换”标签页来创建转换任务。

首先,需要点击“新建”按钮创建一个新的转换任务。

然后,可以在左侧的“资源”面板中选择需要用到的转换组件,例如输入、输出、过滤器、连接器等。

将组件拖动到中间的画布中,并对其进行配置。

3. 连接输入和输出数据:在转换任务中,需要连接输入和输出数据。

可以通过拖动“输入”和“输出”组件到画布中,并使用箭头连接它们。

在连接时,可以设置数据的映射关系,例如将输入表中的某个字段映射到输出表中的某个字段。

4. 添加过滤器:在转换任务中,可以添加过滤器来筛选数据。

可以通过拖动“过滤器”组件到画布中,并对其进行配置。

可以设置过滤器的条件,例如筛选出年龄大于等于18岁的用户。

5. 配置连接信息:在转换任务中,需要配置连接信息,以便能够连接到数据源和目标数据库。

可以通过拖动“连接”组件到画布中,并对其进行配置。

需要设置连接的数据库类型、数据库的主机名、用户名、密码等信息。

6. 运行转换任务:在配置完转换任务后,可以点击“运行”按钮来执行转换任务。

在运行时,需要选择转换任务的输入和输出路径,并设置其他相关参数。

如果一切正常,转换任务将会执行成功,并将数据加载到目标数据库中。

以上是Kettle的基本用法,通过Kettle可以轻松地实现数据集成、转换和加载等任务。

如果需要更复杂的操作,可以参考Kettle的官方文档或者搜索相关教程进行学习。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1. 5 资源库自动登录

可以设置以下环境变量,来让 Spoon 自动登录资源库。 环境变量:KETTLE_REPOSITORY,KETTLE_USER, KETTLE_PASSWORD

1.6 定义

1.6.1 转换

1. Value : Values 是行的一部分,且包含以下类型的数据: Strings, floating point Numbers 、 unlimited precision BigNumbers、Integers、 Dates 或者 Boolean. 2. Row : 一行包含0个或者个Values 3.Output Stream : 一个Output Stream 是离开一个步骤时的行的堆栈。

及所有加载的任务和转换中搜索,并展示搜 索的结果。

2 新建一个转换或任务

可以通过工具栏上的文件/新建/ 来建立一个转换或任务,也可以 直接在主对象页签栏双击转换, 新建一个转换。选择好需要创建 的文件类型后,将会根据你的选 择,创建一个图形界面。

转换

作业

3 数据库连接

一个连接描述了 kettle连接数据 库的方法,左边 的菜单展示了所 有可用的连接。

3. Note: 一个Note 是一个任务附加的文本注释信息。

1.7选项

你可以改变很多选项来增强图形用户界面的个性化。例如设置窗体的字体 和颜色。此选项在 Tools/选项 中设置。

1.8搜索元数据

通过 编辑/搜索元数据(ctr+f) 来使用这个特 性。

这个选项将在可用的字段、连接器、注释以

7.3 Flow :Blocking Step(被冻结的步骤)

这是一个非常简单的步骤,它冻结所有的输出,直到从上一个步骤来的最后一行 数据到达,最后 一行数据将发送到下一步。 你可以使用这个步骤触发常用插件、 存储过程和js等等。

8.0 连接 :Merge Join(合并排序)

这个步骤将来自两个不同的步骤输 入的数据执行一个高效的合并。合 并选项包括INNER ,LEFT OUTER , RIGHT OUTER, FULL OUTER. 这个步骤将输入的行按照指定的字 段存储 被合并的两个步骤,必须按照相同 的段进行排序。

连接名称 : 选择数据库序列存在的 连接名称

序列名称: 数据库序列的名称 使用计数器来计算序列: 如果想使用kettle生成的 序列,使用此项。

计数器名称(可选):如果一个转换中多个步

骤生成同样的值名称,这个选项允许你指定计数 器的名称,避免按照先后顺序通过多个步骤。 起始值: 序列的起始值 增量 : 序列的增量 最大值 : 序列的最大值,如果超过,将重新开始

3.2 SQL 编辑器(SQL Editor)

1. 描述 Spoon 提供简单SQL 编辑器 ,可以实现 创建表,删除索引或者修改字段。大多数的 DDL,例如: create / alter table ,create index , create sequence 命令都可以通过 SQL编辑器窗口运行。(新建转换,输出是 表输出时,可打开SQL 编辑器)

选择表输入, excel 输出,建立节点 连接。右击连接线,可编辑连线属 性。

5.1常用输入:

表输入 Excel 输入 文本文件输入 XML 文件输入 CUBE 输入(多维数据集) 获取系统信息

5.2输入:表输入

选择表输入,点击鼠标右键,选择编辑步骤。 步骤名称可以更改,一般更改为和输入表相关的名称。 数据库连接 : 选择一个已建好的数据库连接,也可以新建一个。 点击”获取SQL查询语句”,可弹出数据库浏览器,选择自己需要的表或视图。 选择好表或视图后,SQL 区域会显示相应的SQL,如选择在SQL里包含字段名,你 所选择的表的所有字段均会显示. 在SQL区域用户可手动修改SQL语句。

5.7 输出:表输出

这个步骤可以存 取信息到数据库 中

5.8 输出:XML输出

这个步骤允许你从源中写入行到一个或多个xml文件。

6.0 转换:去除重复记录

这个步骤从输入流中移除重复的记录 步骤名称 : 在单一步骤中必须唯一 Redirect duplicate: 如果想知道多少重复行被去掉,就勾选此项。 字段名 : 用来比较的字段的字段名称。

值不同

“new” : 引用流中没有找到关键字 “deleted”: 比较流中没有找到关键字。 比较流中的数据进入下一步骤,除非在”删除”的 情况。

9.0 作业 核心对象

1. 通用 (1). START : start是任务执行的入口,首先必须是任务可以执行。只有无条件的任务条目可以从

5.4 输出:插入/更新

插入/更新:若流里的数据在目标表中不存在,执行插入,否则执行更新, 数据量不大的情况下,一般采用插入/更新操作。

5.5 输出:更新

这个步骤类似于插入/更新步骤,除了对数据不作插入操作之外。它仅仅 执行更新操作。

5.6 输出:删除

这个步骤类似于更新步骤,除了不更新操作之外,其他的行均被删除。

6.2 转换:增加序列

这个步骤在流里增加一个序列,一个序列是 在某个起始值 和增量的基础上,经常改变 的整数值。可以使用数据库的序列,也可以 使用kettle决定的序列 Kettle 序列在同一个转换中是唯一使用的, 每一次转换运行的时候,序列的值又会重新 循环一次,从开始值开始。 使用数据库获取序列:

8.1 连接 :合并记录

这个步骤允许你比较两个行流。如果想在两 个不同的时间比较数据,这是非常有用的。 它常被用于数据仓库源系统没有包含最后更 新日期的情况。 两个行流被合并,一个是引用流(旧数据),一 个是比较流(新数据),每次都是行里的最 后版本通过进入下一步骤,行有以下标记:

“Identical” : 关键字在两个流中都存在,并且值相同 “changed” : 关键字在两个流中都存在,但一个或更多的

2. 局限性 这只是一个简单的SQL 编辑器,它不可能完 全知道超过20种它所支持的数据库的方言。 这意味着创建存储过程,触发器或者其他的 数据库对象可能带来很多问题。在这种情况 下,应考虑使用数据库自带的工具。

4.数据库浏览器

1. 描述 数据库浏览器只显示可用的表,视图或者目 录

5.新建一个转换

1.2 安装kettle 要运行Kettle ,必须按安装java 环境1.4或以上版本,kettle下载可以到: 取得最新版本。(pdi-ce-4.0.1-stable.zip) 1.3 运行spoon 下面是不同平台上运行spoon 所支持的脚本 : spoon.bat windows 平台运行Spoon. Spoon.sh linux 平台运行Spoon. 1.4 资源库 一个Kettle 资源库可以包含那些转换信息,这意味着为了从数据资源中加载一个转 换,你必须连接相应的资源库。

7.2 Flow : Abort(中止)

这个步骤允许你在观察输入的时候中止步骤,它的主要用途是错误处理,在一定数量的行流 过错误的连接时中止转换。 失败阀值: 中止转换的开始行数。如果设置为0,在第一行的时候,步骤将被中止。 失败信息:中止的时候放入日志文件的消息,如果没有输入就使用缺省消息。 总是记录行数: 中止步骤总是记录处理的行数。

6.3 转换 : 拆分字段

这个步骤允许根据分隔符来拆分之盾。 步骤名称:在单一转换中必须唯一 需要拆分的字段: 想要拆分的字段的名称。 分隔符: 决定字段结束的分隔符 字段 : 拆分形成的字段列表。 例如: 某字段包含 : (123,456,789) , 使用逗号(,)分割符,可将字段分成三个段。

5.3 输出:Excel 输出

Excel 输出编辑步骤选项,有三 个选项卡, 文件/内容/字段。 文件选项卡: 文件名选择输出文 件保存的路径。 扩展名: 系统默认为xls. 内容选项卡: 一般不需做修改。 字段选项卡:点击获取字段,输 入流中的字段全部会获取到,不 需要的字段,可选中不需要的行, 右键删除。

6.1 转换:排序记录

这个步骤利用你指定的字段排序行,无论他们是按照升序还是降序。 当行数超过5000行的时候,Kettle 使用临时文件来排序行。 排序目录:临时文件存储的目录,如果缺省则为标准的系统临时文件 夹。 临时文件前缀:选择一个容易记的前缀,以便在临时目录中查找。 压缩临时文件: 当需要完成排序的时候,这个选项将压缩临时文件。

3.1 选项

1. Connection name :定义转换或任务访问的连接的唯一名称,可自行 设置,但不能为空。 2. Connection Type:连接的数据类型 3. Access: 可以是Native(JDBC),odbc, oci,jndi.一般选择JDBC 4. HostName: 指定数据库部署的主机或者服务器的名称,也可以指定IP 地址。 5. DataBase Name :指定连接的数据库的名称,如果是ODBC方式就指定 DSN名称。 6. port Number : 设定数据库监听的TCP/I连接数据库的用户名和密码

4 .Input Stream : 一个Input Stream 是进入一个步骤时的行的堆栈。

5. Hop: 一个Hop 代表两个步骤之间的一个或者多个数据流。一个Hop总是代 表着一个步骤的输出流和一个步骤的输入流。 6. Note: 一个Note 是一个转换附加的文本注释信息。

1.6.2 任务 1. Job Entry : 一个Job Entry 是一个任务的一部分,它执行某些内容。 2. Hop: 一个Hop 代表两个步骤之间的一个或者多个数据流。一个Hop总是代 表着两个Job Entry 之间的连接,并且能够被原始的Job Entry设置,无 条件的执行下一个JobEntry,直到执行成功或者失败。