矩阵分解在推荐系统中的应用1

矩阵分解在推荐系统的应用

矩阵分解在推荐系统的应用随着互联网的发展和电子商务的兴起,推荐系统逐渐成为用户获取信息和商品的重要途径。

推荐系统的核心目标是根据用户的历史行为和个人偏好,预测和推荐用户可能感兴趣的信息和商品。

为了实现准确的推荐,矩阵分解作为一种常用的方法被广泛应用在推荐系统中。

矩阵分解是一种数学方法,它将一个大的矩阵分解为两个较小的矩阵的乘积。

在推荐系统中,矩阵分解可以被用来对用户和商品之间的关系进行建模。

通过将用户-商品评分矩阵分解为用户特征矩阵和商品特征矩阵,推荐系统可以通过计算用户和商品之间的相似度来预测用户对未知商品的喜好程度。

首先,推荐系统需要收集用户的历史行为数据,例如用户购买记录、评分和点击行为等。

这些数据可以表示为一个稀疏的用户-商品评分矩阵,其中行表示用户,列表示商品,每个元素表示用户对商品的评分或行为。

然后,通过矩阵分解,可以将用户-商品评分矩阵分解为用户特征矩阵和商品特征矩阵。

用户特征矩阵是一个N×K的矩阵,其中N是用户的数量,K是特征的数量。

每一行表示一个用户,每一列表示一个特征。

特征可以是用户的年龄、性别、兴趣爱好等。

同样,商品特征矩阵是一个M×K的矩阵,其中M是商品的数量。

每一行表示一个商品。

通过计算用户特征矩阵和商品特征矩阵之间的相似度,推荐系统可以预测用户对未知商品的评分。

矩阵分解的优势在于它可以充分利用用户和商品之间的隐含关系。

通过分解用户-商品评分矩阵,推荐系统可以挖掘用户和商品的潜在特性,从而更好地理解用户的偏好和商品的特点。

此外,矩阵分解还可以减轻数据稀疏性问题,因为通过用户特征矩阵和商品特征矩阵的乘积,可以填充原始评分矩阵中的缺失值。

矩阵分解在推荐系统中的应用不仅限于常见的商品推荐,还可以扩展到其他领域。

例如,在电影推荐系统中,矩阵分解可以用来为用户推荐适合其口味的电影。

在社交网络中,矩阵分解可以用来预测用户之间的社交关系。

此外,矩阵分解还可以应用在音乐推荐、新闻推荐和广告推荐等多个领域。

Python中的矩阵分解应用技巧

Python中的矩阵分解应用技巧矩阵分解是一种对矩阵进行分析和降维的有效算法。

随着大数据和机器学习的发展,矩阵分解在许多领域得到了广泛应用,例如推荐系统、图像处理、自然语言处理和社交网络分析等。

Python是一种流行的编程语言,拥有丰富的科学计算库和矩阵操作工具。

在Python环境中,进行矩阵分解可以使用各种库,例如NumPy、SciPy、Scikit-learn和TensorFlow等。

本文将探讨Python中的矩阵分解应用技巧,包括矩阵分解的概念、常用方法和实例应用。

1.矩阵分解的概念矩阵分解是一种将一个矩阵分解为多个较小矩阵的方法。

它可以用于降低矩阵的维度、简化数据结构和提取特征等。

在机器学习中,矩阵分解是一种实现数据降维的算法,它从高维数据中提取关键特征,使得数据可以更加有效地表示和处理。

矩阵分解的目标是将一个矩阵A分解为两个矩阵U和V的乘积。

其中,U是m×r的矩阵,V是r×n的矩阵,r是矩阵分解的秩。

因此,矩阵A的秩为r,且有A=UV。

在矩阵分解中,常用的方法有SVD(奇异值分解)、PCA(主成分分析)和NMF(非负矩阵分解)等。

下面将介绍这三种常用的矩阵分解方法以及它们的Python实现。

2.基于SVD的矩阵分解SVD是一种基于矩阵特征值和特征向量的分解算法。

它将一个矩阵分解为三个矩阵的乘积,即A=UΣV^T,其中U和V是正交矩阵,Σ是对角矩阵。

SVD的重要性在于它能够识别和提取矩阵的主成分,从而对矩阵进行降维和特征提取。

在Python中,使用NumPy库可以轻松地进行SVD。

例如,考虑以下代码:```import numpy as npA = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])U, S, Vt = np.linalg.svd(A)```该代码将矩阵A进行SVD分解,并返回分解后的矩阵U、S和Vt。

其中,S是矩阵A的奇异值,即矩阵Σ的对角线元素。

推荐系统的常用算法原理和实现

推荐系统的常用算法原理和实现推荐系统是将用户的兴趣和需求与商品或服务进行匹配,帮助用户发现他们可能感兴趣的内容。

在实践中,推荐系统使用各种不同的算法来实现这一目标。

以下是一些常见的推荐系统算法原理和实现的介绍。

1. 协同过滤算法(Collaborative Filtering)协同过滤算法是推荐系统中最常见的算法之一、它基于用户和物品之间的关联性来进行推荐。

协同过滤算法可以分为两类:基于用户的协同过滤和基于物品的协同过滤。

基于用户的协同过滤是通过找到与目标用户兴趣相似的其他用户,然后将他们的喜好推荐给目标用户。

基于物品的协同过滤则是找到与目标物品相似的其他物品,并将这些相似物品推荐给目标用户。

2. 基于内容的推荐算法(Content-based Filtering)基于内容的推荐算法是根据用户对物品的历史行为和物品的特征信息来进行推荐。

该算法通过比较用户的兴趣和物品的特征来决定哪些物品是相似的,并推荐相似的物品给用户。

例如,如果一个用户喜欢电影A,基于内容的推荐算法可以找到其他电影,这些电影的类型,演员或导演与电影A相似,然后将这些相似的电影推荐给用户。

3. 矩阵分解算法(Matrix Factorization)矩阵分解算法是一种通过将用户-物品关联矩阵分解为两个低秩矩阵来进行推荐的算法。

通过低秩矩阵的分解,可以发现用户和物品之间的隐含特征,从而预测用户对未知物品的评分。

矩阵分解算法的一个典型应用是在电影推荐系统中,根据用户的评分数据,将用户和电影关联矩阵分解为用户-隐含特征矩阵和电影-隐含特征矩阵。

4. 多臂赌博机算法(Multi-Armed Bandit)多臂赌博机算法是一种用于在线推荐系统中的算法。

它基于动态调整推荐策略,根据用户的反馈来优化推荐结果。

多臂赌博机算法类似于一个赌博机,每个臂代表一种推荐策略,根据用户的反馈进行调整。

如果其中一种策略获得了较好的反馈,系统将更多地使用该策略进行推荐;如果其中一种策略获得了较差的反馈,系统将减少该策略的使用。

基于矩阵分解的情景感知个性化推荐法研究

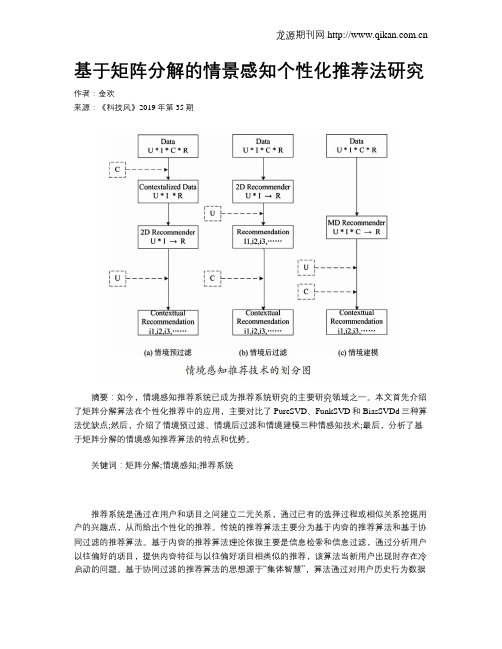

基于矩阵分解的情景感知个性化推荐法研究作者:金欢来源:《科技风》2019年第35期摘要:如今,情境感知推荐系统已成为推荐系统研究的主要研究领域之一。

本文首先介绍了矩阵分解算法在个性化推荐中的应用,主要对比了PureSVD、FunkSVD和BiasSVDd三种算法优缺点;然后,介绍了情境预过滤、情境后过滤和情境建模三种情感知技术;最后,分析了基于矩阵分解的情境感知推荐算法的特点和优势。

关键词:矩阵分解;情境感知;推荐系统推荐系统是通过在用户和项目之间建立二元关系,通过已有的选择过程或相似关系挖掘用户的兴趣点,从而给出个性化的推荐。

传统的推荐算法主要分为基于内容的推荐算法和基于协同过滤的推荐算法。

基于内容的推荐算法理论依据主要是信息检索和信息过滤,通过分析用户以往偏好的项目,提供内容特征与以往偏好项目相类似的推荐,该算法当新用户出现时存在冷启动的问题。

基于协同过滤的推荐算法的思想源于“集体智慧”,算法通过对用户历史行为数据的挖掘发现用户的偏好,基于不同的偏好对用户进行群组划分并推荐品味相似的商品。

协同过滤算法同样也存在冷启动的问题,当没新用户数据时,无法给出较好的推荐。

没有考虑情境的差异,比如不同根据季节的不同,给用户推荐与季节相适应的服饰。

基于以上问题,研究人员提出了基于矩阵分解的情境感知推荐法。

1 矩阵分解算法在个性化推荐中的应用矩阵分解的核心思想是将用户评分矩阵分解为低秩的矩阵,使其乘积尽可能接近原始评分矩阵,使得预测的矩阵与原始矩阵之间的误差平方最小。

奇异值分解(Singular Value Decomposition,以下简称SVD)在机器学习领域得到了广泛的应用,因为它不仅可以用于降维算法中的特征分解,还能用于推荐算法。

如果将m个用户和n个项目对应的评分看做一个矩阵M,本文将用矩阵分解来解决该问题。

1.1 PureSVD算法PureSVD(传统的奇异值分解)在降维中的应用,将用户和项目对应的m×n矩阵M进行SVD分解,通过选择部分较大的奇异值进行降维分解为:Mm×n=Um×k∑k×kVTk×n(1)其中k是矩阵M中的奇异值的个数,一般会小于用户数和项目数。

奇异值矩阵分解算法在推荐系统的应用效果

奇异值矩阵分解算法在推荐系统的应用效果推荐系统已经在我们的日常生活中扮演了越来越重要的角色。

无论是在电子商务平台上购物,还是在视频流媒体平台上观看影片,推荐系统都能够根据我们的兴趣和偏好,向我们推荐最相关的商品或内容。

为了实现更精准和个性化的推荐,奇异值矩阵分解(Singular Value Decomposition,简称SVD)算法被广泛应用于推荐系统中。

本文将探讨奇异值矩阵分解算法在推荐系统中的应用效果。

一、奇异值矩阵分解算法简介奇异值矩阵分解算法属于一种基于矩阵分解的协同过滤算法,通过将用户-物品评分矩阵分解为三个矩阵的乘积,对用户和物品的潜在特征进行建模。

这三个矩阵分别代表用户特征、物品特征和特征空间的权重。

在推荐过程中,通过计算用户和物品在特征空间上的相似度,给用户推荐与其兴趣最匹配的物品。

二、奇异值矩阵分解算法的原理在奇异值矩阵分解算法中,首先需要构建用户-物品评分矩阵。

该矩阵的行表示用户,列表示物品,每个元素表示用户对物品的评分。

然后,通过对评分矩阵进行矩阵分解,得到用户特征矩阵、物品特征矩阵和特征空间权重矩阵。

在计算用户特征矩阵和物品特征矩阵时,可以使用一种常见的优化算法——随机梯度下降。

该算法通过不断迭代更新模型参数,将预测评分与真实评分之间的误差最小化。

通过迭代优化算法,得到最佳的用户特征矩阵和物品特征矩阵。

最后,根据用户特征矩阵、物品特征矩阵和特征空间权重矩阵,可以计算用户和物品之间的相似度。

通过计算相似度,可以为用户推荐与其兴趣相符的物品。

三、奇异值矩阵分解算法的应用效果奇异值矩阵分解算法在推荐系统中的应用效果已经得到了广泛的验证和证明。

与传统的协同过滤算法相比,奇异值矩阵分解算法具有以下优势:1. 精准度高:奇异值矩阵分解算法能够对用户和物品进行更准确的建模,通过捕捉用户和物品的潜在特征,实现更个性化的推荐。

2. 冷启动问题:传统的协同过滤算法在面对新用户或新物品时存在冷启动问题,即无法准确预测新用户对新物品的兴趣。

矩阵奇异值分解的实际应用

矩阵奇异值分解的实际应用

矩阵奇异值分解(SVD)在实际中有很多应用,下面是其中的一些例子:

- 图像压缩:SVD可以将图像的大小最小化到可接受的质量水平,从而在相同磁盘空间中存储更多图像。

它利用了在SVD之后仅获得的一些奇异值很大的原理,通过修剪三个矩阵中的前几个奇异值,可以获得原始图像的压缩近似值,人眼无法区分一些压缩图像。

- 数据降维:在大多数应用中,我们希望将高秩矩阵缩减为低秩矩阵,同时保留重要信息。

SVD可以实现这一目标,通过保留前r个较大的奇异值,来近似表示原始矩阵,从而达到降维的目的。

- 推荐系统:在推荐系统中,SVD可以用于计算用户和项目之间的相似度。

通过将用户和项目的矩阵进行奇异值分解,可以得到一个包含奇异值和左右奇异向量的矩阵。

这些奇异值和奇异向量可以用于计算用户和项目之间的相似度,从而为用户推荐类似的项目。

总之,矩阵奇异值分解在数据压缩、数据降维、推荐系统等方面都有重要的应用,它可以帮助我们从高维数据中提取关键信息,同时保持数据的重要特征。

线性代数在人工智能中的应用

线性代数在人工智能中的应用人工智能(Artificial Intelligence,AI)是近年来发展迅猛的领域,它涵盖了机器学习、深度学习、自然语言处理等多个子领域。

而线性代数作为数学的重要分支,正发挥着不可或缺的作用。

本文将探讨线性代数在人工智能中的应用。

一、矩阵与向量在神经网络中的应用神经网络是人工智能领域中最为重要的技术之一。

在神经网络中,矩阵和向量的应用尤为广泛。

神经网络的训练过程可以看作是通过调整矩阵中的权重和偏置项,使得网络能够更好地拟合输入与输出之间的关系。

矩阵乘法在神经网络中被广泛使用,它将输入与权重相乘并加上偏置项,得到每个神经元的激活值。

而向量则可以表示神经网络中的输入、输出和中间结果,方便进行计算和推理。

二、特征值分解在降维中的应用在处理大规模数据时,降维是一个重要的问题。

特征值分解(Eigenvalue Decomposition)是线性代数中的一种方法,可以将一个矩阵分解为特征值和特征向量的乘积。

在降维中,我们可以通过特征值分解将高维数据映射到低维空间,从而减少数据的维度。

这样一来,不仅可以节省计算资源,还可以提高模型的训练速度和效果。

三、矩阵求逆在最小二乘法中的应用最小二乘法是一种常用的回归分析方法,它可以通过最小化误差的平方和来拟合数据。

在最小二乘法中,需要求解一个线性方程组,而矩阵求逆是解决线性方程组的一种常见方法。

通过求逆,可以得到方程组的解析解,从而得到最佳的拟合曲线。

然而,在实际应用中,矩阵求逆可能会面临数值稳定性的问题,因此需要采用其他方法,如QR分解或奇异值分解。

四、奇异值分解在图像处理中的应用奇异值分解(Singular Value Decomposition,SVD)是线性代数中的一种重要方法,可以将一个矩阵分解为三个矩阵的乘积。

在图像处理中,奇异值分解可以用于图像压缩和图像增强。

通过保留较大的奇异值,可以实现图像的压缩,减少存储空间的占用。

而通过过滤掉较小的奇异值,可以去除图像中的噪声和干扰,提高图像的质量。

矩阵分解的方法和应用

矩阵分解的方法和应用在机器学习和数据分析领域,矩阵分解是一个常用的技术手段。

通过对数据矩阵进行分解,我们可以得到数据的潜在特征和规律,从而更好地理解和利用数据。

本文将介绍矩阵分解的常见方法和应用。

一、基本概念矩阵分解是指将一个矩阵表示为若干个小矩阵(或向量)的乘积的形式。

这些小矩阵一般是具有特定结构或意义的,例如对称矩阵、正定矩阵、特征矩阵等等。

矩阵分解可以应用到各种场景,例如数据降维、矩阵压缩、矩阵重构、协同过滤等等。

二、矩阵分解的方法常见的矩阵分解方法有以下几种:1. 奇异值分解(SVD)奇异值分解是一种基础的矩阵分解方法。

它将一个矩阵分解为三个小矩阵的乘积形式:$A=U\Sigma V^T$,其中$U$和$V$是正交矩阵,$\Sigma$是奇异值矩阵。

通过特征值分解可以得到奇异值矩阵,从而实现矩阵分解。

奇异值分解可以用来进行数据降维和矩阵重构。

例如,我们可以将一个高维度的数据矩阵分解为低维度的奇异向量,从而实现数据降维;或者我们可以使用奇异向量重构原始的矩阵,从而实现数据压缩。

2. QR分解QR分解是一种将矩阵分解为正交矩阵和上三角矩阵的方法。

具体来说,对于一个矩阵$A$,可以分解为$A=QR$,其中$Q$是正交矩阵,$R$是上三角矩阵。

QR分解可以应用到求解线性方程组、估计模型参数等领域。

3. 特征值分解(EVD)特征值分解是指将一个方阵分解为正交矩阵和对角矩阵的乘积形式。

具体来说,对于一个方阵$A$,可以分解为$A=V\LambdaV^{-1}$,其中$V$是正交矩阵,$\Lambda$是对角矩阵,对角线上的元素就是矩阵$A$的特征值。

特征值分解可以用于矩阵压缩和数据降维。

三、矩阵分解的应用1. 推荐系统推荐系统是一种常见的应用场景,它可以根据用户历史行为和兴趣,向用户推荐可能感兴趣的物品。

矩阵分解可以应用到推荐系统中,其基本思路是利用用户对物品的评分矩阵,对其进行分解,得到用户和物品的特征向量,然后通过计算余弦距离等方法,计算出用户和物品之间的相似度,从而推荐给用户可能感兴趣的物品。

机器学习知识:机器学习中的矩阵分解方法

机器学习知识:机器学习中的矩阵分解方法矩阵分解方法是机器学习中的一种重要算法,它可以将高维数据降维,使得数据更易于处理和理解。

本文将介绍矩阵分解的概念、应用场景和常见方法等相关知识,帮助读者了解机器学习中的矩阵分解技术。

一、什么是矩阵分解矩阵分解是将一个大型稠密矩阵分解成为多个小的稀疏矩阵的过程,可以有效降低数据规模,简化计算复杂度。

矩阵分解在很多领域都得到了广泛的应用,尤其是在推荐系统、自然语言处理和图像处理等领域。

二、矩阵分解的应用场景推荐系统是矩阵分解的一个重要应用场景。

推荐系统的目的是为用户提供他们可能感兴趣的产品或者服务,从而提高用户的购买率和满意度。

在推荐系统中,每个用户和每个产品都可以看作是矩阵中的一个元素,因此可以通过矩阵分解来预测用户对产品的喜好程度,从而进行个性化推荐。

自然语言处理也是另一个重要的应用领域。

人类语言具有很高的复杂性,不同的语言之间也存在着很大的差异。

因此,在自然语言处理中往往需要对单词进行编码,以便机器可以更好地处理它们。

这些编码可以在一个矩阵中进行表示,然后通过矩阵分解来提取文本信息。

三、矩阵分解的常见方法1、SVD分解SVD分解是矩阵分解中最常见的方法之一。

它将一个较大的矩阵分解为三个较小的矩阵,并可以有效降维。

其中,第一个矩阵代表数据的样本,第二个矩阵代表数据的属性,第三个矩阵则是特征值矩阵。

2、PCA分解PCA分解是另一个常见的矩阵分解方法。

它通过协方差矩阵的特征值和特征向量来降维。

在这个过程中,PCA会找到最大的方差并将数据投影到具有最大方差的维度上。

这样可以有效地减少数据的维度,从而简化数据的处理。

3、NMF分解NMF分解是另一种常见的矩阵分解方法,它可以对非负数据进行有效的降维和特征提取。

NMF分解中,矩阵中的每一个元素都必须是非负的。

这样可以更好地处理各种类型的非负数据,例如图像中的像素值和声音中的频率等。

四、矩阵分解的优缺点优点:1、降低数据维度,减少特征数量,提高模型效率和预测准确度。

使用奇异值分解进行矩阵分解的实际应用(Ⅰ)

奇异值分解(SVD)是一种重要的矩阵分解方法,它在数据分析、图像处理、推荐系统等领域有着广泛的应用。

在本文中,我们将探讨奇异值分解的原理及其在实际应用中的一些案例。

首先,让我们来了解一下奇异值分解的原理。

奇异值分解是将一个矩阵分解为三个矩阵的乘积的过程。

对于一个矩阵A,它的奇异值分解可以表示为A=UΣV^T,其中U和V是正交矩阵,Σ是一个对角矩阵,对角线上的元素称为奇异值。

通过奇异值分解,我们可以将原始矩阵表示为一些基础特征的线性组合,从而能够更好地理解和处理原始数据。

在数据分析领域,奇异值分解被广泛应用于降维和特征提取。

通过对数据矩阵进行奇异值分解,我们可以得到数据的主要特征向量和奇异值,从而可以选择保留最重要的特征,实现数据的降维处理。

这对于高维数据的可视化和分析非常有用。

此外,奇异值分解还可以用于去噪和数据压缩,通过去除奇异值较小的部分,可以实现对数据的有效压缩和去噪处理。

在图像处理领域,奇异值分解也有着重要的应用。

通过对图像矩阵进行奇异值分解,可以实现图像的压缩和去噪处理。

此外,奇异值分解还可以用于图像的特征提取和图像匹配,对于图像识别和图像处理有着重要的意义。

在推荐系统领域,奇异值分解被广泛应用于协同过滤算法。

通过对用户-物品评分矩阵进行奇异值分解,可以得到用户和物品的隐含特征向量,从而可以实现对用户和物品之间的关联关系进行分析和推荐。

奇异值分解在推荐系统中的应用,大大提高了推荐的准确性和效率。

除了上述领域之外,奇异值分解还在信号处理、文本挖掘、自然语言处理等领域有着重要的应用。

通过对大规模数据进行奇异值分解,可以实现对数据的有效分析和处理,为实际应用提供了强大的工具支持。

综上所述,奇异值分解作为一种重要的矩阵分解方法,具有广泛的实际应用价值。

在数据分析、图像处理、推荐系统等领域,奇异值分解都起着不可替代的作用。

随着大数据和人工智能技术的发展,奇异值分解的应用前景将会更加广阔,为实际问题的解决提供更多可能性。

矩阵分解算法在推荐系统中的应用实践

矩阵分解算法在推荐系统中的应用实践推荐系统是一类重要的信息过滤系统,其目的是通过利用用户历史行为数据,挖掘用户的兴趣模式,并根据这些模式为用户提供个性化的推荐结果。

在推荐系统中,矩阵分解算法是一种常用的方法,通过对用户-物品评分矩阵进行分解,能够有效地捕捉用户和物品之间的潜在关系,从而实现个性化的推荐。

1. 推荐系统概述推荐系统在人们的日常生活中扮演着重要的角色,它们广泛应用于电子商务、社交网络、音乐、电影等领域。

推荐系统的目标是在大量的物品中,根据用户的兴趣,为用户提供个性化的推荐结果,帮助用户发现潜在的兴趣点。

推荐系统通常分为两种类型:协同过滤和内容过滤。

其中,协同过滤是一种通过分析用户之间的关系,为用户进行推荐的方法。

而内容过滤则是基于物品的属性信息为用户进行推荐。

矩阵分解算法主要应用于协同过滤推荐系统中。

2. 矩阵分解算法原理矩阵分解算法的主要思想是将用户-物品评分矩阵分解为两个低秩的矩阵,通过这种方式,可以捕捉到用户和物品之间的潜在关系。

通常使用的矩阵分解算法有奇异值分解(Singular Value Decomposition,简称SVD)和潜在语义索引(Latent Semantic Indexing,简称LSI)。

在矩阵分解算法中,用户-物品评分矩阵被表示为R,矩阵R中的每个元素R[i,j]表示用户i对物品j的评分。

矩阵分解的目标是找到两个低秩矩阵P和Q,使得它们的乘积近似等于原始矩阵R。

具体的目标函数可以表示为:R ≈ P × Q其中,P是一个m×k的矩阵,表示用户和潜在因素之间的关系,Q是一个k×n的矩阵,表示物品和潜在因素之间的关系。

通过最小化目标函数,可以通过优化算法(如梯度下降)来寻找最优的P和Q矩阵。

3. 推荐系统中的应用实践矩阵分解算法在推荐系统中的应用主要包括基于矩阵分解的协同过滤算法和深度矩阵分解算法。

基于矩阵分解的协同过滤算法是推荐系统中最常用的方法之一。

非负矩阵分解算法在推荐系统中的应用

非负矩阵分解算法在推荐系统中的应用随着互联网飞速发展, 推荐系统已经成为了人们信息获取和购买习惯调整的重要方式之一。

而推荐算法也成为了推荐系统中的重要组成部分。

从最早的基于词频统计的分析算法到后来的协同过滤算法,推荐算法一直在不断改进,以期提高推荐系统的精度和效率。

近年来,非负矩阵分解算法(NMF)被引入到推荐系统中,成为了一种新的推荐算法,并且在一些领域中已经取得了很好的效果。

一、什么是非负矩阵分解算法?非负矩阵分解算法在2001年由Lee和Seung提出,也称为NMF算法。

它是一种在推荐系统中非常有用的算法,可以方便地推断出用户对物品的偏好。

简单来说,就是将一个原始的矩阵分解成两个非负的矩阵,一个是用户矩阵,另外一个是物品矩阵,并通过计算它们的积,可以预测用户之前没有评价过的物品。

NMF算法在推荐系统中的一个优势是它可以解决“数据稀疏”问题。

在推荐系统中,一个用户可能只对很少的几个物品进行了评价,这就导致了大部分的元素都是空值。

NMF算法通过矩阵分解,可以填充空间,并预测用户对新的物品的偏好,提高推荐的准确度。

因此,NMF算法被广泛应用在社交网络推荐、电影和音乐推荐、商品推荐等。

二、NMF算法在推荐系统中的优势除了可以解决数据稀疏的问题,NMF算法在推荐系统中有许多其他的优势。

1. 预测准确度高在很多情况下,NMF算法的预测准确度比传统的推荐算法更高。

这是因为它能够抽象出更多的特征,并用这些特征来更好地描述用户的偏好,从而提高预测的准确度。

2. 模型可解释性强NMF算法中的用户矩阵和物品矩阵都只包含非负值,这意味着它们都有一个自然的物理解释。

例如,在一个用户矩阵中,每一行都代表该用户对不同特征的偏好评分,如“音乐”、“体育”、“电影”等。

同样地,在一个物品矩阵中,每一列代表该物品各个特征的分值。

这种解释性强的模型可以让我们更好地观察用户和物品之间的关系,并更好地解释预测结果。

3. 算法参数少NMF算法的参数相对较少,只有两个矩阵需要分解,因此实现过程会更加简单,运算速度更快,这对于大规模的推荐系统来说尤其重要。

矩阵分解与应用

矩阵分解是一种被广泛应用于线性代数及其相关领域的数学方法。

它将一个复杂的矩阵分解为若干个简单的因子,以便进行更加灵活和高效的运算。

这种方法在很多领域都有重要的应用,如图像处理、数据压缩、推荐系统等等。

在图像处理领域,矩阵分解常常用于图像降噪和图像压缩方面。

图像降噪是指去除图像中的噪声,以提高图像的质量。

传统的降噪方法往往不够准确或者计算量过大,而矩阵分解则可以通过分解图像矩阵,获取图像的特征信息,并更加准确地去除噪声。

另外,在图像压缩方面,矩阵分解可以将原始矩阵分解为若干个低秩矩阵,从而达到压缩图像的目的。

在数据分析领域,矩阵分解可以用于提取数据中的隐藏特征,进行数据降维和特征选取。

通过将原始数据矩阵进行分解,可以得到数据的主成分,从而提取到数据集中的重要特征信息。

这可以帮助我们更好地理解数据,发现数据中的规律性,并用于数据的分类、聚类等任务。

此外,通过矩阵分解,我们还可以对数据进行降维,减少数据的维度,从而提高数据处理的效率。

推荐系统是近年来受到广泛关注的一个领域,而矩阵分解在推荐系统中发挥了重要作用。

推荐系统旨在根据用户的历史行为、兴趣等信息,推荐他们可能感兴趣的物品。

矩阵分解可以将用户和物品的关系表示为一个矩阵,通过分解这个矩阵,可以获取到用户和物品之间的潜在关系。

基于这些关系,我们可以将最适合用户的物品推荐给他们。

矩阵分解在推荐系统中的应用不仅提高了推荐的准确性,还使得系统具有更好的扩展性和实时性。

总结起来,矩阵分解是一种非常强大的数学方法,有着广泛的应用前景。

它在图像处理、数据分析和推荐系统等领域都发挥了重要作用。

通过将复杂的矩阵分解为若干个简单的因子,矩阵分解使得相关领域的各种问题得以更加灵活和高效地解决。

我们相信,随着技术的不断进步,矩阵分解在更多领域将发挥更大的作用,带来更多的创新和发展。

矩阵分解的原理与应用

矩阵分解的原理与应用矩阵是线性代数中最基本的数据结构,在机器学习,推荐系统,图像处理等领域都有广泛应用。

矩阵分解就是将一个大的矩阵分解成多个小的矩阵,通常用于降维、特征提取、数据压缩等任务。

我们现在就来详细探讨矩阵分解的原理和应用。

一、基本概念与背景1. 矩阵的基本概念矩阵是由多行和多列构成,每行和每列的数值称为元素。

用数的矩形阵列来表示的数学对象称为矩阵。

2. 矩阵的类型在数据分析中,矩阵有不同的分类,如稠密矩阵、稀疏矩阵、分块矩阵等。

3. 矩阵分解的背景通过矩阵分解,我们可以将一个大的矩阵分解成多个小的矩阵,这些小矩阵可以更方便的处理。

同时,矩阵分解也可以用来进行数据压缩、降维、特征提取等任务。

二、矩阵分解的基本思想矩阵分解的基本思想是将大的矩阵分解成多个小的矩阵,通常是将原始数据矩阵分解成两个或以上的低维矩阵。

其中,最基本的矩阵分解方法包括奇异值分解(Singular Value Decomposition,简称SVD)和QR分解(QR Decomposition)。

1. 奇异值分解(SVD)奇异值分解是将任意矩阵分解为三个矩阵之积的算法。

SVD可以分解任意的矩阵X为X=UΣV*的形式,其中U和V是两个矩阵,Σ是一个对角矩阵,其对角线上的元素称为奇异值。

这里,U、V都是酉矩阵,U、V*在原始矩阵的意义下构成一个对称双正交矩阵(或称为正交矩阵)。

其中,U是原始矩阵XXT的特征向量组成的矩阵,V是原始矩阵XTX的特征向量组成的矩阵。

奇异值则是U和V之间的关联,它是一个对角矩阵,其中的元素由矩阵的奇异值所组成。

SVD的一个重要应用是在推荐系统中的协同过滤算法中。

在协同过滤算法中,我们可以将用户-物品评分矩阵分解为两个矩阵,以此来实现推荐。

2. QR分解(QR Decomposition)QR分解是将矩阵分解为正交矩阵和上三角矩阵之积的算法。

将矩阵A分解为A=QR,其中Q是正交矩阵,R是上三角矩阵。

基于矩阵分解的音乐推荐系统研究

基于矩阵分解的音乐推荐系统研究1. 引言随着互联网技术的发展,音乐已经成为人们日常生活中必不可少的一部分。

越来越多的用户通过音乐APP来收听自己喜欢的音乐,但是随之而来的问题是用户面临着大量的歌曲和音乐推荐信息,往往无法很好地找到自己喜欢的音乐。

为此,许多研究者提出了各种各样的音乐推荐算法,其中基于矩阵分解的算法成为了研究热点。

2. 矩阵分解算法矩阵分解算法是一种优化方法,在计算机领域中被广泛应用。

常见的矩阵分解方法有奇异值分解(SVD)和非负矩阵分解(NMF)等。

在音乐推荐系统中,矩阵分解算法可以将用户-歌曲矩阵分解为用户隐向量矩阵和歌曲隐向量矩阵,并使用这两个矩阵来预测用户对未知歌曲的喜好程度。

3. 音乐推荐系统的构建基于矩阵分解算法的音乐推荐系统可以分为以下几个步骤:3.1 数据预处理在音乐推荐系统中,需要处理用户对歌曲的评分数据。

一些用户可能没有对某些歌曲进行评分,此时需要采用一定的算法来填补这些缺失的数据。

3.2 隐向量矩阵的分解在处理好用户-歌曲评分数据后,可以通过矩阵分解算法将用户-歌曲矩阵分解为用户隐向量矩阵和歌曲隐向量矩阵。

这一步通常使用优化算法来求解,例如随机梯度下降算法等。

3.3 用户-歌曲相似度计算随后,需要计算用户-歌曲的相似度。

此时,可以将用户隐向量矩阵和歌曲隐向量矩阵相乘,得到一个用户-歌曲的矩阵,矩阵中的元素表示用户对歌曲的喜好程度预测。

3.4 推荐歌曲在计算完用户-歌曲矩阵时,可以从中筛选出用户可能感兴趣的歌曲,并进行推荐。

推荐歌曲时可以采用流行度和用户兴趣程度相结合的方法,让推荐的歌曲更符合用户的喜好。

4. 基于矩阵分解算法的音乐推荐系统优势和不足4.1 优势基于矩阵分解算法的音乐推荐系统能够将用户对歌曲的评分映射为向量表示,可以通过向量相乘的方式计算用户-歌曲相似度。

此外,矩阵分解算法可以处理隐式反馈数据,使得系统对于没有评分的歌曲也能进行推荐。

同时,基于矩阵分解算法的音乐推荐系统可以通过优化算法不断学习,提高推荐系统精度。

矩阵分解应用

矩阵分解应用矩阵分解是一种将一个矩阵拆分为多个子矩阵的数学方法,它在多个领域中都有广泛的应用。

本文将介绍矩阵分解在推荐系统、图像处理以及数据压缩领域的应用。

一、推荐系统中的矩阵分解推荐系统是指根据用户的历史行为和偏好,为用户提供个性化的推荐信息。

矩阵分解可以用于推荐系统中的协同过滤算法,通过分解用户-物品评分矩阵,将其拆分为用户特征矩阵和物品特征矩阵。

通过计算用户特征矩阵和物品特征矩阵的乘积,可以预测用户对未评分物品的喜好程度,从而进行个性化推荐。

二、图像处理中的矩阵分解图像处理中的矩阵分解主要应用于图像压缩和图像恢复。

在图像压缩中,矩阵分解可以将原始图像矩阵拆分为低秩近似矩阵和稀疏矩阵。

低秩近似矩阵包含图像的主要信息,而稀疏矩阵包含图像的噪声和细节信息。

通过保留低秩近似矩阵,可以实现对图像的高效压缩。

在图像恢复中,矩阵分解可以通过拆分观测矩阵和字典矩阵,利用稀疏表示的方法对图像进行重建,从而实现对图像的修复和增强。

三、数据压缩中的矩阵分解数据压缩是指对原始数据进行编码和压缩,以减少存储空间和传输带宽的需求。

矩阵分解可以应用于数据压缩中的矩阵压缩算法。

通过将原始数据矩阵拆分为低秩近似矩阵和稀疏矩阵,可以利用低秩近似矩阵的低维表示来压缩数据。

同时,稀疏矩阵的稀疏性质可以进一步压缩数据,减少存储和传输的开销。

矩阵分解在推荐系统、图像处理以及数据压缩领域都有重要的应用。

通过将原始矩阵拆分为多个子矩阵,可以提取出矩阵的主要信息,从而实现个性化推荐、图像压缩和数据压缩等功能。

矩阵分解为这些领域提供了一种有效的数学工具,为相关技术的发展和应用提供了基础。

随着数据量的不断增加和应用场景的多样化,矩阵分解的应用将会越来越广泛,对于提高系统性能和用户体验具有重要意义。

基于矩阵分解的协同过滤算法在电影推荐中的应用

基于矩阵分解的协同过滤算法在电影推荐中的应用电影推荐算法一直是人工智能领域中的研究热点。

其中一种重要算法就是基于矩阵分解的协同过滤算法。

这种算法可以通过用户对电影评分的矩阵进行分解,找到用户的隐含偏好,从而进行电影推荐。

本文将介绍该算法的原理,并探讨其在电影推荐中的应用。

一、基于矩阵分解的协同过滤算法原理在传统的协同过滤算法中,我们通过对用户与物品之间的相似度进行计算,来找到相似用户或物品,进而进行推荐。

而基于矩阵分解的协同过滤算法则是首先对用户-物品评分矩阵进行分解,再基于分解后的矩阵进行推荐。

具体来说,该算法可以通过以下步骤进行:1. 建立评分矩阵。

将用户对电影的评分放在一个矩阵中,这个矩阵中每一行代表一个用户,每一列代表一部电影。

2. 对评分矩阵进行分解。

采用SVD分解算法,将评分矩阵分解为三个矩阵:用户矩阵U、电影矩阵V和奇异值矩阵Σ。

3. 根据分解后的矩阵计算预测评分。

将用户矩阵U、电影矩阵V和奇异值矩阵Σ相乘,得到一个新的矩阵P。

该矩阵中包含了用户对所有电影的预测评分。

4. 进行推荐。

从P中选择用户未看过的电影,对其预测评分进行排序,选取评分最高的电影进行推荐。

二、基于矩阵分解的协同过滤算法在电影推荐中的应用1. 提升推荐效果传统的推荐算法往往只能根据用户的历史交互数据进行推荐,而无法准确地预测用户的隐含偏好。

而基于矩阵分解的协同过滤算法可以通过分解评分矩阵,找到用户的隐含偏好,从而准确地对用户进行推荐。

这种算法可以大大提升推荐效果,满足用户的个性化需求。

2. 应用广泛基于矩阵分解的协同过滤算法不仅可以用于电影推荐,还可以应用于音乐、图书、新闻等多个领域的推荐。

这种算法无需考虑具体的物品属性,只需要根据用户的行为数据进行分析,因此适用性非常广泛。

3. 矩阵分解的实现复杂度较高基于矩阵分解的协同过滤算法实现起来比较复杂,需要进行SVD分解等复杂的计算。

此外,在用户数和物品数较多时,评分矩阵很大,矩阵分解会耗费大量的时间和内存。

矩阵分解的应用

矩阵分解的应用

最近年来,随着大数据时代的到来,用矩阵分解来挖掘数据中隐含的模式和规律,已

经成为一种重要的数据分析手段。

矩阵分解也成为许多应用领域的重要组成部分。

首先,机器学习和推荐系统中都广泛使用矩阵分解技术,其目的是从大量的、稀疏的

用户和物品交互数据中提取特征。

通过矩阵分解,可以很好地捕捉和精确地表示用户和物

品的关联关系,从而为更准确地推荐相应的物品、内容提供基础。

此外,矩阵分解技术也在计算机视觉中得到了广泛应用。

在图像分类中,我们可以利

用矩阵分解技术来提取图像的特征,以帮助我们更准确地识别图像中的对象。

在图像处理中,矩阵分解将帮助我们实现图像的压缩储存,从而大大提高处理效率。

最后,矩阵分解技术还可以应用于文本处理和自然语言处理中。

在文本处理中,我们

可以用矩阵分解技术将大量的文本数据分解为用户特征和文本特征,从而实现文本的聚类、分类和情感分析。

此外,在自然语言处理中,矩阵分解也可以从词与词之间的关系中学习

词的概念,进而实现新词的挖掘,以及词的表义定义。

总之,矩阵分解技术在挖掘数据中隐藏的语义模式和表达方式方面发挥着重要作用,

它已经成为机器学习和推荐系统、计算机视觉和文本处理等多种应用领域的重要组成部分,给我们带来了巨大的方便。

基于神经网络的矩阵分解算法及应用研究

基于神经网络的矩阵分解算法及应用研究矩阵分解是一种常用的数据降维方法,随着神经网络的快速发展,基于神经网络的矩阵分解算法在各个领域得到了广泛的应用。

本文将介绍基于神经网络的矩阵分解算法的原理、优势以及在推荐系统和图像处理等领域的应用研究。

一、神经网络的基本知识神经网络是一种模拟人脑神经系统的计算模型,由多层神经元组成。

其中,每个神经元接收来自上一层神经元的输入,并通过激活函数计算输出。

神经网络通过不断调整参数来逼近目标函数的最小值,从而实现对数据的建模和预测。

二、矩阵分解算法的原理矩阵分解算法主要用于将一个大型的矩阵分解为几个小型的矩阵的乘积。

这种分解能够减少计算的复杂度,提高计算效率。

基于神经网络的矩阵分解算法通常使用自编码器或者深度神经网络来实现。

自编码器是一种无监督学习算法,它由编码器和解码器两部分组成。

编码器将输入数据压缩为低维的表示,而解码器则根据低维表示重构原始数据。

通过调整自编码器的参数,可以实现对矩阵的分解和重构。

深度神经网络是一种多层的神经网络结构,具有极强的表达能力,能够有效地处理复杂的非线性关系。

通过使用深度神经网络,可以将矩阵分解为多个因子,并进行有目标的降维。

三、基于神经网络的矩阵分解算法的优势1. 高效性:神经网络可以并行计算,加速了矩阵分解过程,提高了计算效率。

2. 强大的模型表达能力:神经网络能够处理非线性关系,在复杂的数据集上表现出色。

3. 自适应性:神经网络具有自适应的特性,可以根据数据进行参数的调整,提升算法的准确性。

四、基于神经网络的矩阵分解算法在推荐系统中的应用推荐系统被广泛应用于电子商务、社交媒体等领域,用于给用户提供个性化的推荐。

基于神经网络的矩阵分解算法在推荐系统中的应用研究主要包括以下几个方面:1. 基于用户行为的推荐:通过分析用户的历史行为数据,如点击、购买等,建立用户与物品的矩阵,并利用神经网络对用户行为进行建模,预测用户对未知物品的喜好程度,从而实现个性化的推荐。

低秩矩阵三分解及应用

低秩矩阵三分解及应用低秩矩阵三分解及应用一、引言随着大数据时代的到来,数据的处理和分析变得越来越重要。

在许多应用领域,特别是推荐系统、图像处理和语音识别等领域,矩阵分解被广泛应用。

矩阵分解是将一个矩阵分解为多个矩阵的乘积的过程,它能够提取出矩阵中的潜在特征和隐藏结构。

低秩矩阵三分解是其中的一种重要的矩阵分解方法,在本文中我们将详细介绍低秩矩阵三分解及其应用。

二、低秩矩阵三分解的基本概念和方法低秩矩阵三分解是将一个矩阵分解为三个矩阵的乘积的过程,其中两个矩阵的秩较小。

具体来说,对于一个m×n的矩阵A,低秩矩阵三分解的目标是找到两个低秩矩阵U和V,使得A≈U×V,其中U是一个m×k的矩阵,V是一个k×n的矩阵,k远小于m和n。

一般情况下,低秩矩阵三分解是通过最小化A和U×V之间的距离来实现的,最常用的方法是奇异值分解(singular value decomposition,SVD)。

三、低秩矩阵三分解的应用1. 推荐系统推荐系统是利用用户历史行为和兴趣,为用户生成个性化的推荐内容。

低秩矩阵三分解能够提取出用户的兴趣偏好和物品的特征,从而对用户的兴趣进行建模。

通过将用户-物品评分矩阵进行低秩矩阵三分解,可以得到用户兴趣矩阵和物品特征矩阵,从而实现个性化推荐。

2. 图像处理图像处理中的许多任务,如图像去噪、图像压缩和图像复原等,可以看作是对观测到的图像进行低秩矩阵三分解的过程。

通过将观测到的图像表示为低秩矩阵的和稀疏矩阵的和,可以从图像中提取出潜在的结构信息和噪声。

3. 语音识别语音识别是将人的语音信息转化为可被计算机处理的结果。

低秩矩阵三分解可以应用于语音信号的降噪和特征提取等任务。

通过将语音信号进行低秩矩阵分解,可以减少噪声的干扰,提取出语音信号中的关键特征。

四、低秩矩阵三分解的挑战和改进方法低秩矩阵三分解在实际应用中面临着一些挑战,如计算复杂度高、存储空间需求大等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

利用矩阵分解预测缺失值的推荐算法

推荐系统的目标就是预测出符号“?”对应位置的 分值。推荐系统基于这样一个假设:用户对项目的 打分越高,表明用户越喜欢。因此,预测出用户对 未评分项目的评分后,根据分值大小排序,把分值 高的项目推荐给用户。

利用矩阵分解预测缺失值的推荐算法

矩阵分解目标就是把用户-项目评分矩阵R分解成用 户因子矩阵和项目因子矩阵乘的形式,即R=UV,这 里R是n×m, n =6, m =7,U是n×k,V是k×m。直 观地表示如下:

用数学表达的话,设用户向量是Nu,投影到U空间后的向量 为P,则有:

然后就可以计算这个用户(用P向量)与其他用户(Uk的各 行向量)之间的相似度了。大量的实验表明,计算相似度的 话还是使用欧式距离比较有效。上面的算法瓶颈是如何在 “茫茫人海”中找到最相似的那个User。

基于奇异值分解的推荐算法

使用基于物品的推荐不存在上面的计算瓶颈,因为我们探索 的是物品之间的相似度而不是用户之间的相似度。在大多数 系统中,物品比用户更稳定,不经常变化。所以,基于物品 的相似度非常适合预计算。 相类似的,如果要计算两Item之间的相似度需要使用Vk矩阵。 Vk 每一行代表一个Item,行之间越相近则代表Item之间越相 似。其计算过程与上面所讲的User之间的推荐过程很接近。

假定用S 乘以������ ,则有:

特征值与特征向量的意义

上例表明,即使������是一个任意的向量,用S 去乘以它 的效果都取决于S 的特征值及特征向量。另外,从 S ������ = 60 ������1 +80 ������2 +6 ������3,看出一个非常直观的结论就是, 相对而言,S ������的大小更不受S 的小特征值影响。上 例中,由于λ3=1,所以上式中最右边的加数的影响 较小。实际上,如果完全忽略上式的最右边对应于 λ3=1 的特征向量那么S������的结果就是(60,80,0)T而不是 正确结果(60,80,6)T,但是不论采用哪一种指标(比 如差向量的长度)来计算,这两个向量都相对比较 接近。这也意味着,对于矩阵-向量的乘积来说,较 小的特征值及其特征向量的影响也较小。

基于奇异值分解的推荐算法

【问】评分矩阵A,已知User=x, Item=y, 请问Rating=?

1) 从原始矩阵A中找到被User=x评过分的那些items;

2) 使用降维矩阵,找出被User=x评过分的跟Item=y最相似的那个Item;

3) 从原始矩阵A中获取被User=x评过分的最相似的Item的评分,并把这个 评分当做User=x对Item=y的评分。 与基于用户相似度推荐类似,在第二步计算中,如果Item=y已经在降维 矩阵中,则可计算;如果Item=y是一个新物品,则要先做投影,然后再 计算。

奇异值分解

特征值分解是一个提取矩阵特征很不错的方法,但 是它只是对方阵而言的,在现实的世界中,我们看 到的大部分矩阵都不是方阵,比如说有N个学生, 每个学生有M科成绩,这样形成的一个N * M的矩阵 就不可能是方阵,我们怎样才能描述这样普通的矩 阵呢的重要特征呢?奇异值分解可以用来干这个事 情,奇异值分解(SVD)是一个能适用于任意的矩阵的 一种分解的方法。

利用矩阵分解预测缺失值的推荐算法

高维的用户-项目评分矩阵分解 成为两个低维的用户因子矩阵 和项目因子矩阵,因此矩阵分 解和PCA不同,不是为了降维。 用户i对项目j的评分rij = <ui,vj>。 下面介绍评估低维矩阵乘积拟 合评分矩阵的方法。

首先假设,用户对项目的真实 评分和预测评分之间的差服从 高斯分布,基于这一假设,可 推导出目标函数如右图:

特征值与特征向量的意义

在数学上,特别是线性代数中,对于一个给定的线性变 换,它的特征向量V经过这个线性变换后,得到的新向 量仍然与原来的V保持在同一条直线上,但其长度也 许会改变.一个特征向量的长度在该线性变换下缩放 的比例称为其特征值. 对于特征向量,线性变换仅仅改变它们的长度,而 不改变它们的方向(除了反转以外),而对于其它 向量,长度和方向都可能被矩阵所改变。如果特征 值的模大于1,特征向量的长度将被拉伸,而如果特 征值的模小于1,特征向量的长度就将被压缩。如果 特征值小于0,特征向量将会被翻转。

矩阵分解在推荐系统中的应用(1)

重庆大学 余俊良

摘 要

• 线性代数基础知识

• 奇异值分解 • 梯度下降算法

• 一般矩阵分解 • 非负矩阵分解

• 上下文感知的矩阵分解 • 融合社会化信息的矩阵分解 • 实验分析

特征值与特征向量

对于M×M的方阵C 及非零向量������ ,有C ������ = λ ������ 。

设新的Item评分向量是Ni(mx1),处于U空间(m维),需要投影到Vk 空间(n维)。首先通过内积计算Ni在U空间中的坐标,然后使用Sk反向 伸缩坐标即可得到在V空间的坐标。

用数学表达的话,设用户向量是Ni,投影到V空间后的向量为P,则有:

基于奇异值分解的推荐算法

基于奇异值分解的推荐算法

SVD的缺点:

特征值与特征向量的意义

由上例可知,如果我们想要描述好一个变换,那我 们就描述好这个变换主要的变化方向就好了。看看 之前特征值分解的式子,分解得到的Σ矩阵是一个对 角阵,里面的特征值是由大到小排列的,这些特征 值所对应的特征向量就是描述这个矩阵变化方向 (从主要的变化到次要的变化排列)。

我们通过特征值分解得到的前N个特征向量,那么 就对应了这个矩阵最主要的N个变化方向。我们利 用这前N个变化方向,就可以近似这个矩阵(变 换)。也就是之前说的:提取这个矩阵最重要的特 征。

在第二步中,如果User=x已经在降维矩阵中,则按 上面步骤计算;如果User=x是一个新的用户,在计 算相似度之前,这个新用户必须冲n维空间投影到k 维空间中。

基于奇异值分解的推荐算法

如果知道SVD的空间几何意义,理解投影过程就很简单:原 来的用户的评分向量Nu(1xn)是在V空间中(n维),将其与Vk 矩阵相乘就知道这个用户向量的坐标,然后根据S进行坐标 缩放(同时截取前k个值即可),获得的坐标就是用户的评 分向量Nu在U空间中的坐标了。

基于奇异值分解的推荐算法

基于用户相似度的SVD推荐算法

【问】评分矩阵A,已知User=x, Item=y, 请问Rating=? 1) 从原始矩阵A中找出对Item=y评过分的所有用户;

2) 使用降维矩阵,找出对Item=y评过分的与User=x 最相近的那个User;

3) 从原始矩阵中获取最相似用户对Item=y的评分, 并把这个评分当做User=x对Item=y的评分。

奇异值分解

SVD能提供原始矩阵的最好的低阶线性近似。通过选取最大 的k个奇异值可以降低原始矩阵的维度。k的值会根据数据的 大小和结构而变化,一个典型的做法是保留矩阵中90%的能 量信息,即将奇异值的平方和累加到总值的90为止。在很多 情况下,前10%甚至1%的奇异值的和就占了全部的奇异值 之和的99%以上了。也就是说,我们也可以用前K个奇异值 来近似描述矩阵。

奇异值分解

令r 是M×N 矩阵C 的秩,那么C 存在如下形式的SVD:

U 是一个M×M 的矩阵,其每一列是矩阵CCT的正交 特征向量,而N×N 矩阵V 的每一列都是矩阵CTC 的 正交特征向量。 1.CCT 的特征值 λ1, λ2,…, λr 等于CTC 的特征值;

2.对于1≤ i ≤ r,令σi = λi ,并且 λi ≥ λi+1。M × N的 矩阵Σ 满足Σ ii=σi,其中1≤ i≤ r,而Σ 中其他元素均为 0。

设 V 和 W 是在相同域 K 上的向量空间。函数 f : V → W 被称为 是线性映射,如果对于 V 中任何两个向量 x 和 y 与 K 中任何标 量 a,满足下列两个条件: 可加性: ������ ������ + ������ = ������ ������ + ������(������)

简单来说就是,线性映射可以用矩阵-向量乘法表示。 在线性映射中,可以把N维向量投影到M维向量,N可以 不等于M.

当N==M时,也就是定义中的自同态映射.

特征向量与特征值在自同态的情况下产生.即N维到N 维的映射.

线性映射与矩阵

看下面几个二维空间自同态映射的例子.

逆时针旋转90 度 逆时针旋转θ 度:

SVD often raises difficulties due to the high portion of missing values caused by sparseness in the user-item ratings matrix. Conventional SVD is undefined when knowledge about the matrix is incomplete. Moreover, carelessly addressing only the relatively few known entries is highly prone to overfitting.

齐次性:

������ ������������ = ������������ ������

这等价于要求对于任何向量 x1, ..., xm 和标量 a1,..., am,方程 成立。

线性映射与矩阵

如果 V 和 W 是有限维的,并且在这些空间中有选择好 的基,则从 V 到 W 的所有线性映射可以被表示为矩阵; 如果 A 是实数的m×n矩阵,则规定f(x)=Ax描述一个线 性映射 Rn → Rm。

针对x轴反射

在所有方向上放大2 倍

挤压

向y轴投影

线性映射与矩阵

一个矩阵就是一个线性映射的描述,因为一个矩阵 乘以一个向量后得到的向量,其实就相当于将这个 向量进行了线性变换。

线性映射与矩阵

从前面的例子可以看到,矩阵对应了一个变换,是把 任意一个向量变成另一个方向或长度不同的新向量。 在这个变换的过程中,原向量主要发生旋转、伸缩的 变化。如果矩阵对某一个向量或某些向量只发生伸缩 变换,不对这些向量产生旋转的效果,那么这些向量 就称为这个矩阵的特征向量,伸缩的比例就是特征值。