word2vec词向量模型

中文 wrod2vec 酒店评价模型

文章题目:探索中文word2vec模型在酒店评价中的应用一、引言在当今数字化时代,酒店业的发展已经离不开大数据和人工智能技术的支持。

随着社交媒体和在线点评评台的兴起,越来越多的用户在网上共享对酒店的评价和体验。

对这些评价进行有效地分析和挖掘,可以帮助酒店业主了解用户需求、改善服务质量,并优化营销策略。

二、使用word2vec模型分析酒店评价1. 介绍中文word2vec模型中文word2vec模型是一种词向量表示模型,它可以将中文文本中的词语转换成向量形式,从而方便计算机对文本进行分析和处理。

通过训练大规模中文语料库,word2vec模型可以学习每个词语的语义和语境信息,进而实现对文本信息的深度理解和挖掘。

2. 应用word2vec模型分析酒店评价通过使用word2vec模型分析酒店评价,可以实现以下几个方面的应用:(1)评价情感分析通过构建酒店评价文本的word2vec表示,可以对评价文本中的情感进行分析和分类。

通过识别出评价文本中的关键词语,并根据这些关键词语的向量表示,可以准确判断评价文本的情感倾向,从而帮助酒店业主了解用户对其服务的满意度和不满意度。

(2)评价关键词提取利用word2vec模型可以实现对酒店评价文本中的关键词提取。

通过计算每个词语的相似度,可以找出在评价文本中频繁出现的关键词,并进一步进行关键词的聚类和分类分析,从而帮助酒店业主了解用户对不同方面的服务和设施的评价和需求。

(3)评价主题挖掘通过对酒店评价文本进行word2vec表示,可以实现对评价文本中的主题进行挖掘。

通过计算词语之间的语义相似度,可以发现评价文本中涉及的主题和话题,并据此对评价文本进行主题分类和归纳,从而帮助酒店业主更好地了解用户对酒店的各个方面的评价和建议。

三、总结和展望通过本文对中文word2vec模型在酒店评价中的应用进行探讨,我们可以看到该模型在酒店评价分析中具有很大的潜力。

通过利用word2vec模型,可以实现对酒店评价的情感分析、关键词提取和主题挖掘,从而帮助酒店业主更好地理解用户需求和改进服务质量。

word2vec构建中文词向量

word2vec构建中⽂词向量词向量作为⽂本的基本结构——词的模型,以其优越的性能,受到⾃然语⾔处理领域研究⼈员的青睐。

良好的词向量可以达到语义相近的词在词向量空间⾥聚集在⼀起,这对后续的⽂本分类,⽂本聚类等等操作提供了便利,本⽂将详细介绍如何使⽤word2vec构建中⽂词向量。

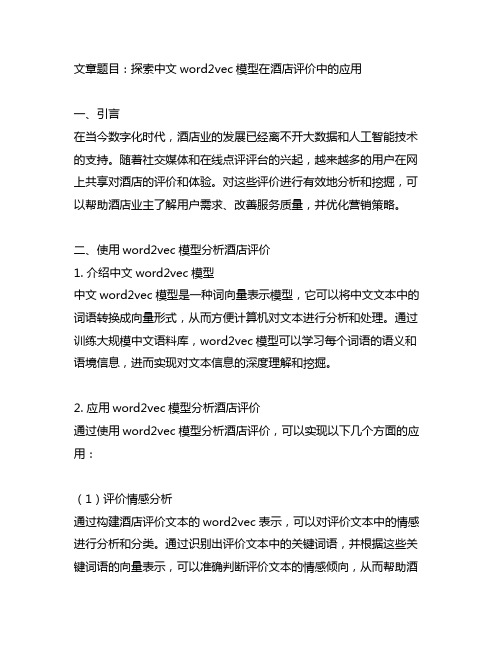

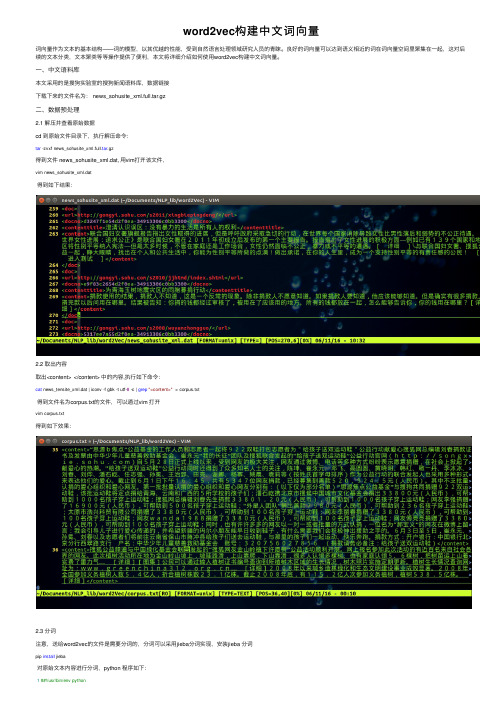

⼀、中⽂语料库本⽂采⽤的是搜狗实验室的搜狗新闻语料库,数据链接下载下来的⽂件名为: news_sohusite_xml.full.tar.gz⼆、数据预处理2.1 解压并查看原始数据cd 到原始⽂件⽬录下,执⾏解压命令:tar -zvxf news_sohusite_xml.full.tar.gz得到⽂件 news_sohusite_xml.dat, ⽤vim打开该⽂件,vim news_sohusite_xml.dat得到如下结果:2.2 取出内容取出<content> </content> 中的内容,执⾏如下命令:cat news_tensite_xml.dat | iconv -f gbk -t utf-8 -c | grep"<content>" > corpus.txt得到⽂件名为corpus.txt的⽂件,可以通过vim 打开vim corpus.txt得到如下效果:2.3 分词注意,送给word2vec的⽂件是需要分词的,分词可以采⽤jieba分词实现,安装jieba 分词pip install jieba对原始⽂本内容进⾏分词,python 程序如下:1##!/usr/bin/env python2## coding=utf-83import jieba45 filePath='corpus.txt'6 fileSegWordDonePath ='corpusSegDone.txt'7# read the file by line8 fileTrainRead = []9#fileTestRead = []10 with open(filePath) as fileTrainRaw:11for line in fileTrainRaw:12 fileTrainRead.append(line)131415# define this function to print a list with Chinese16def PrintListChinese(list):17for i in range(len(list)):18print list[i],19# segment word with jieba20 fileTrainSeg=[]21for i in range(len(fileTrainRead)):22 fileTrainSeg.append([''.join(list(jieba.cut(fileTrainRead[i][9:-11],cut_all=False)))])23if i % 100 == 0 :24print i2526# to test the segment result27#PrintListChinese(fileTrainSeg[10])2829# save the result30 with open(fileSegWordDonePath,'wb') as fW:31for i in range(len(fileTrainSeg)):32 fW.write(fileTrainSeg[i][0].encode('utf-8'))33 fW.write('\n')可以得到⽂件名为 corpusSegDone.txt 的⽂件,需要注意的是,对于读⼊⽂件的每⼀⾏,使⽤结巴分词的时候并不是从0到结尾的全部都进⾏分词,⽽是对[9:-11]分词 (如⾏22中所⽰: fileTrainRead[i][9:-11] ),这样可以去掉每⾏(⼀篇新闻稿)起始的<content> 和结尾的</content>。

基于word2vec模型的文本特征抽取方法详解

基于word2vec模型的文本特征抽取方法详解在自然语言处理领域,文本特征抽取是一个重要的任务。

它的目标是将文本数据转换为机器学习算法可以处理的数值特征。

近年来,基于word2vec模型的文本特征抽取方法在该领域取得了显著的进展。

本文将详细介绍这一方法的原理和应用。

一、word2vec模型简介word2vec是一种用于将词语表示为向量的技术。

它基于分布假设,即上下文相似的词语往往具有相似的含义。

word2vec模型通过学习大量的文本数据,将每个词语表示为一个固定长度的向量,使得具有相似含义的词语在向量空间中距离较近。

二、word2vec模型的训练过程word2vec模型有两种训练方法:Skip-gram和CBOW。

Skip-gram模型通过给定中心词语,预测其周围的上下文词语;CBOW模型则相反,通过给定上下文词语,预测中心词语。

这两种方法都使用神经网络进行训练,通过最大化预测准确率来学习词语的向量表示。

三、基于word2vec模型的文本特征抽取方法基于word2vec模型的文本特征抽取方法主要有两种:词袋模型和平均词向量模型。

1. 词袋模型词袋模型是一种简单而常用的文本特征抽取方法。

它将文本表示为一个词语频率的向量,其中每个维度对应一个词语。

基于word2vec模型的词袋模型将每个词语的向量表示相加,并除以文本长度得到平均向量。

这种方法可以捕捉到文本中词语的语义信息,但忽略了词语的顺序。

2. 平均词向量模型平均词向量模型是一种更加复杂的文本特征抽取方法。

它将文本表示为所有词语向量的平均值。

通过这种方式,平均词向量模型可以保留词语的顺序信息。

与词袋模型相比,平均词向量模型可以更好地捕捉到文本的语义信息。

四、基于word2vec模型的文本特征抽取方法的应用基于word2vec模型的文本特征抽取方法在许多自然语言处理任务中得到了广泛应用。

例如,情感分析任务可以通过将文本表示为词袋模型或平均词向量模型的特征向量,然后使用机器学习算法进行分类。

word2vec和doc2vec词向量表示

word2vec和doc2vec词向量表⽰Word2Vec 词向量的稠密表达形式(⽆标签语料库训练)Word2vec中要到两个重要的模型,CBOW连续词袋模型和Skip-gram模型。

两个模型都包含三层:输⼊层,投影层,输出层。

1.Skip-Gram神经⽹络模型(跳过⼀些词)skip-gram模型的输⼊是⼀个单词wI,它的输出是wI的上下⽂wO,1,...,wO,C,上下⽂的窗⼝⼤⼩为C。

举个例⼦,这⾥有个句⼦“I drive my car to the store”。

我们如果把”car”作为训练输⼊数据,单词组{“I”, “drive”, “my”, “to”, “the”, “store”}就是输出。

所有这些单词,我们会进⾏one-hot编码2.连续词袋模型(Continuos Bag-of-words model)CBOW模型是在已知当前词w(t)的上下⽂w(t-2),w(t-1),w(t+1),w(t+2)的前提下预测当前词w(t)Hierarchical Softmax 实现加速。

3.传统的神经⽹络词向量语⾔模型DNN,⾥⾯⼀般有三层,输⼊层(词向量),隐藏层和输出层(softmax层:要计算词汇表中所有词softmax概率)。

⾥⾯最⼤的问题在于从隐藏层到输出的softmax层的计算量很⼤,因为要计算所有词的softmax概率,再去找概率最⼤的值。

word2vec也使⽤了CBOW与Skip-Gram来训练模型与得到词向量,但是并没有使⽤传统的DNN模型。

最先优化使⽤的数据结构是⽤霍夫曼树来代替隐藏层和输出层的神经元,霍夫曼树的叶⼦节点起到输出层神经元的作⽤,叶⼦节点的个数即为词汇表的⼩⼤。

⽽内部节点则起到隐藏层神经元的作⽤体如何⽤霍夫曼树来进⾏CBOW和Skip-Gram的训练我们在下⼀节讲,这⾥我们先复习下霍夫曼树。

霍夫曼树的建⽴其实并不难,过程如下:(节点权重可看作词频) 输⼊:权值为(w1,w2,...wn)的n个节点 输出:对应的霍夫曼树1)将(w1,w2,...wn)看做是有n棵树的森林,每个树仅有⼀个节点。

使用Word2Vec进行文本特征抽取的实用方法

使用Word2Vec进行文本特征抽取的实用方法自然语言处理(Natural Language Processing, NLP)是人工智能领域中的一个重要研究方向,而文本特征抽取是NLP的核心任务之一。

Word2Vec是一种基于神经网络的词向量模型,它能够将文本中的词语转化为实数向量,进而用于文本分类、聚类、情感分析等任务。

本文将介绍使用Word2Vec进行文本特征抽取的实用方法。

一、Word2Vec模型简介Word2Vec模型是由Google于2013年提出的一种词向量模型,它通过训练神经网络来学习词语的分布式表示。

Word2Vec模型有两种训练方式:Skip-gram和CBOW。

Skip-gram模型是基于上下文预测中心词语,而CBOW模型则是基于中心词语预测上下文。

在训练过程中,Word2Vec模型会根据语料库中的词语共现关系来更新词向量,从而使得相似的词语在向量空间中距离较近。

二、数据预处理在使用Word2Vec进行文本特征抽取之前,我们需要对原始文本数据进行预处理。

首先,需要将文本数据分割成句子,并对句子进行分词。

分词可以使用现有的中文分词工具,如结巴分词。

其次,需要去除停用词,即那些在文本中频繁出现但没有实际意义的词语,如“的”、“了”等。

最后,可以根据实际需求对文本进行其他预处理操作,如词性标注、词干提取等。

三、训练Word2Vec模型在进行文本特征抽取之前,我们需要先训练一个Word2Vec模型。

为此,我们需要准备一个大规模的语料库,其中包含足够多的文本数据。

可以使用维基百科、新闻语料库等公开数据集,也可以使用自己的数据集。

在训练Word2Vec模型时,需要指定一些参数,如词向量的维度、窗口大小、迭代次数等。

这些参数的选择会影响最终的词向量质量,需要根据实际情况进行调整。

四、文本特征抽取在训练好Word2Vec模型之后,我们可以使用它来进行文本特征抽取。

一种常见的方法是将文本中的每个词语转化为对应的词向量,然后将这些词向量进行平均或加权平均得到文本的表示向量。

word2vec训练模型实现文本转换词向量

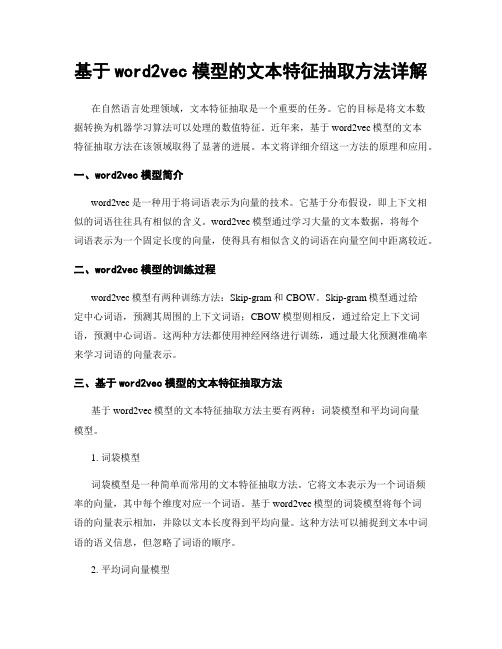

word2vec训练模型实现⽂本转换词向量利⽤ Word2Vec 实现⽂本分词后转换成词向量步骤:1、对语料库进⾏分词,中⽂分词借助jieba分词。

需要对标点符号进⾏处理2、处理后的词语⽂本利⽤word2vec模块进⾏模型训练,并保存 词向量维度可以设置⾼⼀点,3003、保存模型,并测试,查找相似词,相似词topN1import re2import jieba3from gensim.models import Word2Vec, word2vec456def tokenize():7"""8分词9 :return:10"""11 f_input = open('166893.txt', 'r', encoding='utf-8')12 f_output = open('yttlj.txt', 'w', encoding='utf-8')13 line = f_input.readline()14while line:15 newline = jieba.cut(line, cut_all=False)16 newline = ''.join(newline)17 fileters = [',', ':', '。

', '!', '!', '"', '#', '$', '%', '&', '\(', '\)', '\*', '\+', ',', '-', '\.', '/', ':', ';', '<', '=', '>', '\?', '@'18 , '\[', '\\', '\]', '^', '_', '`', '\{', '\|', '\}', '~', '”', '“', '?']19 newline = re.sub("<.*?>", "", newline, flags=re.S)20 newline = re.sub("|".join(fileters), "", newline, flags=re.S)21 f_output.write(newline)22print(newline)23 line = f_input.readline()24 f_input.close()25 f_output.close()262728def train_model():29"""30训练模型31 :return:32"""33 model_file_name = 'model_yt.txt'34 sentences = word2vec.LineSentence('yttlj.txt')35 model = word2vec.Word2Vec(sentences, window=5, min_count=5, workers=4, vector_size=300)36 model.save(model_file_name)373839def test():40"""41测试42 :return:43"""44 model = Word2Vec.load('model_yt.txt')45print(model.wv.similarity('赵敏', '赵敏'))46print(model.wv.similarity('赵敏', '周芷若'))47for k in model.wv.most_similar('赵敏', topn=10):48print(k[0], k[1])495051if__name__ == '__main__':52 test()View Code⼩结:word2vec是实现词嵌⼊的⼀种⽅式。

Word2Vec算法简介

Word2Vec算法简介⼀.简介 word2vec是Google在2003年开源的⼀款将词表征为实数值向量的⾼效算法,采⽤的模型有CBOW【Continuous Bag-Of-Words 连续的词袋模型】和Skip-Gram两种。

word2vec通过训练,可以把⽂本内容的处理简化为k维向量空间中的向量运算,⼆向量空间上的相似度可以⽤来表⽰⽂本语义上的相似度。

⼆.背景知识 1.One-hot Representation NLP相关的任务中最常见的第⼀步是创建⼀个词表库并把每个词顺序编号。

这实际就是词表⽰⽅法中的One-hot Representation,这种⽅法把每个词顺序编号,每个词就是⼀个很长的向量,向量的维度等于词表⼤⼩,⼀般采⽤稀疏编码存储,只有对应位置上的数字为1其它都为0。

这种表⽰⽅法最⼤的问题是⽆法捕捉词与词之间的相似度,⽽且还容易发⽣维数灾难,尤其是在Deep Learning相关的⼀些应⽤中。

2.Distributed Representation Distributed Representation 通过训练将每个词映射成k维实数向量【k⼀般为模型的超参数】,通过词之间的距离【⽐如:cosine相似度、欧式距离等】来判断它们之间的语义相似度。

word2vec就是采⽤这种词向量表⽰⽅式。

三.统计语⾔模型 传统的统计语⾔模型是表⽰语⾔基本单位【⼀般为句⼦】的概率分布函数,这个概率分布也就是该语⾔的⽣成模型。

⼀般语⾔模型可以使⽤各个词语条件的概率表⽰。

1.上下⽂⽆关模型 该模型仅仅考虑当前词本⾝的概率,不考虑词所对应的上下⽂环境,仅仅依赖于训练⽂本中的词频统计。

这是⼀种最简单,易于实现,但没有多⼤实际应⽤价值的统计语⾔模型。

它是n-gram模型中n=1时候的特殊情况,所以也称为Unigram Model【⼀元⽂法统计模型】。

2.n-gram模型 当n=1时,就是上⾯所说的上下⽂⽆关模型,这⾥n-gram⼀般认为是n>=2时的上下⽂相关模型。

词向量生成模型

词向量生成模型

词向量生成模型是一种自然语言处理技术,它的主要目的是将单词转换为向量表示。

这种模型可以通过学习单词之间的语义和上下文关系来生成词向量。

常见的词向量生成模型包括Word2vec、GloVe和FastText等。

其中,Word2vec是一种基于神经网络的词向量生成模型。

它主要包括两种算法,即CBOW和Skip-gram。

CBOW算法是基于上下文预测目标单词,而Skip-gram算法则是基于目标单词预测上下文单词。

GloVe是一种基于全局向量的词向

量生成模型,它通过对单词之间的共现关系进行建模来生成词向量。

FastText则是

一种基于子词的词向量生成模型,它将单词表示为其子词的向量和单词向量的加和。

词向量生成模型已经被广泛应用于自然语言处理领域,包括语言建模、文本分类、信息检索、机器翻译等方面。

通过将单词表示为向量,可以更好地处理自然

语言中的语义和上下文关系,从而提高自然语言处理的效果。

文本分类实战(一)——word2vec预训练词向量

⽂本分类实战(⼀)——word2vec预训练词向量1 ⼤纲概述 ⽂本分类这个系列将会有⼗篇左右,包括基于word2vec预训练的⽂本分类,与及基于最新的预训练模型(ELMo,BERT等)的⽂本分类。

总共有以下系列: 所有代码均在仓库中。

2 数据集 数据集为IMDB 电影影评,总共有三个数据⽂件,在/data/rawData⽬录下,包括unlabeledTrainData.tsv,labeledTrainData.tsv,testData.tsv。

在进⾏⽂本分类时需要有标签的数据(labeledTrainData),但是在训练word2vec词向量模型(⽆监督学习)时可以将⽆标签的数据⼀起⽤上。

3 数据预处理 IMDB 电影影评属于英⽂⽂本,本序列主要是⽂本分类的模型介绍,因此数据预处理⽐较简单,只去除了各种标点符号,HTML标签,⼩写化等。

代码如下:import pandas as pdfrom bs4 import BeautifulSoupwith open("/data4T/share/jiangxinyang848/textClassifier/data/unlabeledTrainData.tsv", "r") as f:unlabeledTrain = [line.strip().split("\t") for line in f.readlines() if len(line.strip().split("\t")) == 2]with open("/data4T/share/jiangxinyang848/textClassifier/data/labeledTrainData.tsv", "r") as f:labeledTrain = [line.strip().split("\t") for line in f.readlines() if len(line.strip().split("\t")) == 3]unlabel = pd.DataFrame(unlabeledTrain[1: ], columns=unlabeledTrain[0])label = pd.DataFrame(labeledTrain[1: ], columns=labeledTrain[0])def cleanReview(subject): # 数据处理函数beau = BeautifulSoup(subject)newSubject = beau.get_text()newSubject = newSubject.replace("\\", "").replace("\'", "").replace('/', '').replace('"', '').replace(',', '').replace('.', '').replace('?', '').replace('(', '').replace(')', '')newSubject = newSubject.strip().split("")newSubject = [word.lower() for word in newSubject]newSubject = "".join(newSubject)return newSubjectunlabel["review"] = unlabel["review"].apply(cleanReview)label["review"] = label["review"].apply(cleanReview)# 将有标签的数据和⽆标签的数据合并newDf = pd.concat([unlabel["review"], label["review"]], axis=0)# 保存成txt⽂件newDf.to_csv("/data4T/share/jiangxinyang848/textClassifier/data/preProcess/wordEmbdiing.txt", index=False) 我们使⽤pandas直接处理数据,建议使⽤apply⽅法,处理速度⽐较快,数据处理完之后将有标签和⽆标签的数据合并,并保存成txt⽂件。

向量对齐模型

向量对齐模型向量对齐模型是一种用于将文本表示为向量的方法,它在自然语言处理和信息检索等领域中具有广泛的应用。

本文将介绍向量对齐模型的基本原理、常用方法以及应用场景。

一、向量对齐模型的基本原理向量对齐模型的基本原理是通过将文本映射到一个高维向量空间中,使得具有相似语义的文本在向量空间中的距离较近,从而实现对文本的语义关系建模。

常用的向量对齐模型包括Word2Vec、GloVe 和BERT等。

二、常用的向量对齐方法1. Word2VecWord2Vec是一种基于神经网络的词向量表示模型,它通过训练一个浅层的神经网络,将词语映射到一个低维向量空间中。

Word2Vec模型可以学习到词语的分布式表示,同时保留了词语之间的语义关系。

2. GloVeGloVe是一种基于全局词汇统计信息的词向量表示模型,它通过对词语的共现矩阵进行分解,得到词语的向量表示。

GloVe模型在学习词向量时考虑了全局词汇的统计信息,使得词向量更加准确。

3. BERTBERT是一种基于Transformer的预训练语言模型,它通过训练一个深层的神经网络,将词语和上下文的关系进行建模。

BERT模型不仅可以学习到词语的向量表示,还可以捕捉到词语之间的语义关系和上下文信息。

1. 文本分类向量对齐模型可以将文本表示为向量,从而方便进行文本分类任务。

通过计算文本向量之间的相似度,可以实现对文本的分类和聚类。

2. 信息检索向量对齐模型可以将查询文本和文档表示为向量,通过计算它们之间的相似度,可以实现信息检索任务。

在搜索引擎中,可以根据查询文本的向量与文档的向量进行匹配,返回与查询相关的文档。

3. 问答系统向量对齐模型可以将问题和候选答案表示为向量,通过计算它们之间的相似度,可以实现问答系统。

在问答系统中,可以根据问题的向量与候选答案的向量进行匹配,选择最相似的答案。

四、总结向量对齐模型是一种将文本表示为向量的方法,它可以将文本的语义关系建模,并在自然语言处理和信息检索等领域中具有广泛的应用。

word2vec原理推导?

Word2Vec是一种基于神经网络的单词嵌入模型,它通过将单词映射到低维向量空间来表示单词的语义关系。

Word2Vec有两种不同的训练算法:连续词袋模型(CBOW)和跳字模型(Skip-gram Model)。

1. **连续词袋模型(CBOW):**假设我们有一个句子"I love natural language processing",并且我们设定窗口大小为2,即考虑上下文窗口内的2个单词。

首先,我们将每个单词转换为“one-hot”编码,例如,"I"编码为[1, 0, 0, 0],"love"编码为[0, 1, 0, 0]等。

然后,我们选择一个中心单词,例如选择"love"作为目标单词。

CBOW模型的目标是根据上下文单词(即窗口内的单词),来预测目标单词。

我们将窗口内的所有单词的嵌入向量相加,并将其输入到一个隐藏层中。

隐藏层的输出通过一个softmax层,被训练为预测目标单词的概率分布。

具体推导如下:- 输入:窗口内的上下文单词的one-hot编码表示为x,目标单词的one-hot编码表示为y。

- 假设我们有一个输入到隐藏层的权重矩阵W_hidden,并且隐藏层到输出softmax层的权重矩阵为W_output。

隐藏层的输出表示为h。

- 首先,将输入x与隐藏层的权重矩阵相乘并求和,得到隐藏层的输入:h_input = W_hidden * x。

- 接下来,我们应用一个非线性激活函数(如sigmoid或ReLU)到隐藏层的输入:h = activation(h_input)。

- 最后,将隐藏层的输出与输出层的权重矩阵相乘,并将结果应用softmax函数得到目标单词的概率分布:y_pred = softmax(W_output * h)。

- 模型的目标是最大化目标单词的预测概率。

可以使用交叉熵损失函数来度量预测分布与实际分布之间的差异。

生成向量的开源方法

生成向量的开源方法生成向量是机器学习和数据科学中常用的一项技术。

它在各种应用中都起到关键作用,如文本分类、图像识别、推荐系统等。

本文将介绍一些常见的开源方法和工具,帮助读者了解如何生成向量,并且给出一些实际的示例。

一、Word2VecWord2Vec是Google于2013年推出的一种用于生成词向量的模型。

它基于神经网络,通过学习词汇的上下文关系来生成向量表示。

Word2Vec模型可以通过训练大规模的文本语料库来得到词向量,并且可以通过简单的数学运算得到词语之间的语义关系。

例如,可以使用词向量的加减法来计算“国王”-“男人”+“女人”的结果,得到的向量最接近的词语可能是“皇后”。

二、GloVeGloVe是一种基于全局向量的词汇表示方法。

它与Word2Vec有类似的原理,但是在计算上有所不同。

GloVe通过统计词语共现的频率来构建词向量,通过一些数学运算来优化词向量的质量。

相比于Word2Vec,GloVe在一些任务上表现更好,尤其是在语义相似度和类比推理方面。

三、BERTBERT是一种新型的预训练语言模型,可以生成高质量的词向量。

它采用了Transformer模型,通过大规模的无监督学习来学习词语的上下文关系。

BERT的一个重要特点是双向性,即它可以同时考虑上下文的信息,从而得到更准确的词向量表示。

这使得BERT在各种自然语言处理任务中取得了很好的效果。

四、ELMoELMo是另一种基于Transformer的预训练语言模型。

它可以为每个词生成多层的向量表示,包含了不同层次的语义信息。

与传统的词向量不同,ELMo的向量是上下文相关的,即同一个词在不同上下文中可能有不同的向量表示。

ELMo模型可以通过训练大规模的语料库来得到,也可以直接使用已经训练好的模型进行迁移学习。

五、使用示例下面以文本分类为例,展示如何使用开源方法生成向量。

假设我们有一个文本分类任务,需要将新闻文本分为“体育”和“科技”两类。

word2vec生成词向量和字向量

word2vec⽣成词向量和字向量⽣成字符向量的过程中需要注意:1)在收集数据⽣成corpus时候,通过Word2Vec⽣成字向量的时候,产⽣了“ ”空格字符向量,但是加载模型是不会成功的。

那么你不是⽣成的binary⽂件,就可以修改此⽂件,更改或删除。

⽰例参考代码如下:import osimport gensimfrom gensim.models import word2vecfrom sklearn.decomposition import PCAimport numpy as npimport logginglogging.basicConfig(format='%(asctime)s:%(levelname)s:%(message)s', level=)class TrainVector:def__init__(self):cur = '/'.join(os.path.abspath(__file__).split('/')[:-1])# 训练语料所在⽬录self.token_filepath = os.path.join(cur, 'train_data/token_train.txt')self.pinyin_filepath = os.path.join(cur, 'train_data/pinyin_train.txt')self.postag_filepath = os.path.join(cur, 'train_data/postag_train.txt')self.dep_filepath = os.path.join(cur, 'train_data/dep_train.txt')self.word_filepath = os.path.join(cur, 'train_data/word_train.txt')# 向量⽂件所在⽬录self.token_embedding = os.path.join(cur, 'model/token_vec_300.bin')self.postag_embedding = os.path.join(cur, 'model/postag_vec_30.bin')self.dep_embedding = os.path.join(cur, 'model/dep_vec_10.bin')self.pinyin_embedding = os.path.join(cur, 'model/pinyin_vec_300.bin')self.word_embedding = os.path.join(cur, 'model/word_vec_300.bin')#向量⼤⼩设置self.token_size = 300self.pinyin_size = 300self.dep_size = 10self.postag_size = 30self.word_size = 300'''基于gensimx训练字符向量,拼⾳向量,词性向量'''def train_vector(self, train_path, embedding_path, embedding_size):sentences = word2vec.Text8Corpus(train_path) # 加载分词语料model = word2vec.Word2Vec(sentences, size=embedding_size, window=5, min_count=5) # 训练skip-gram模型,默认window=5model.wv.save_word2vec_format(embedding_path, binary=False)'''基于特征共现+pca降维的依存向训练'''def train_dep_vector(self, train_path, embedding_path, embedding_size):f_embedding = open(embedding_path, 'w+')deps = ['SBV', 'COO', 'ATT', 'VOB', 'FOB', 'IOB', 'POB', 'RAD', 'ADV', 'DBL', 'CMP', 'WP', 'HED', 'LAD']weight_matrix = []for dep in deps:print(dep)weights = []for line in open(train_path):line = line.strip().split('\t')dep_dict = {i.split('@')[0]:int(i.split('@')[1]) for i in line[1].split(';')}sum_tf = sum(dep_dict.values())dep_dict = {key:round(value/sum_tf,10) for key, value in dep_dict.items()}weight = dep_dict.get(dep, 0.0)weights.append(str(weight))weight_matrix.append(weights)weight_matrix = np.array(weight_matrix)pca = PCA(n_components = embedding_size)low_embedding = pca.fit_transform(weight_matrix)for index, vecs in enumerate(low_embedding):dep = deps[index]vec = ''.join([str(vec) for vec in vecs])f_embedding.write(dep + '' + vec + '\n')f_embedding.close()'''训练主函数'''def train_main(self):#训练依存向量self.train_dep_vector(self.dep_filepath, self.dep_embedding, self.dep_size)#训练汉字字向量self.train_vector(self.token_filepath, self.token_embedding, self.token_size)#训练汉语词性向量self.train_vector(self.postag_filepath, self.postag_embedding, self.postag_size) #训练汉语词向量self.train_vector(self.word_filepath, self.word_embedding, self.word_size) # 训练汉语拼⾳向量self.train_vector(self.pinyin_filepath, self.pinyin_embedding, self.pinyin_size) returnif__name__ == '__main__':handler = TrainVector()handler.train_main()。

Word2vec的工作原理及应用

Word2vec的工作原理及应用1. 介绍Word2vec是一种用于将文本转换为数值向量表示的技术。

它是通过训练神经网络模型来学习单词之间的语义关系,从而将单词转化为向量形式。

本文将介绍Word2vec的工作原理及其在自然语言处理领域的应用。

2. Word2vec的工作原理Word2vec通过两种主要的模型来进行单词向量表示:Skip-gram模型和CBOW模型。

2.1 Skip-gram模型Skip-gram模型的目标是通过给定一个中心单词来预测其周围的上下文单词。

具体步骤如下: 1. 首先,将文本中的每个单词表示为一个独热向量(one-hot vector)。

2. 然后,构建一个包含多个隐藏层的神经网络模型,并将中心单词的独热向量作为输入。

3. 通过训练模型,使得模型能够学习到每个单词和其周围上下文单词之间的关联关系。

4. 最终,从隐藏层中提取出的向量表示就是每个单词的Word2vec向量。

2.2 CBOW模型CBOW模型与Skip-gram模型相反,其目标是通过给定周围的上下文单词来预测中心单词。

具体步骤如下: 1. 与Skip-gram模型一样,将文本中的每个单词表示为一个独热向量。

2. 构建一个包含多个隐藏层的神经网络模型,并将上下文单词的独热向量作为输入。

3. 通过训练模型,使得模型能够学习到上下文单词与中心单词之间的关联关系。

4. 最终,从隐藏层中提取出的向量表示就是每个单词的Word2vec向量。

3. Word2vec的应用Word2vec在自然语言处理领域有着广泛的应用,以下是几个示例:3.1 单词相似度计算利用Word2vec,可以计算两个单词之间的相似度。

通过计算两个单词向量之间的余弦相似度,可以衡量它们在语义上的相似程度。

这对于词义消歧、语义搜索等任务非常有用。

3.2 文本分类Word2vec可以将文本转换为向量表示,从而用于文本分类任务。

通过将文本中的每个单词转换为Word2vec向量,然后将这些向量作为输入,可以训练一个分类模型来进行文本分类。

使用word2vec训练中文词向量

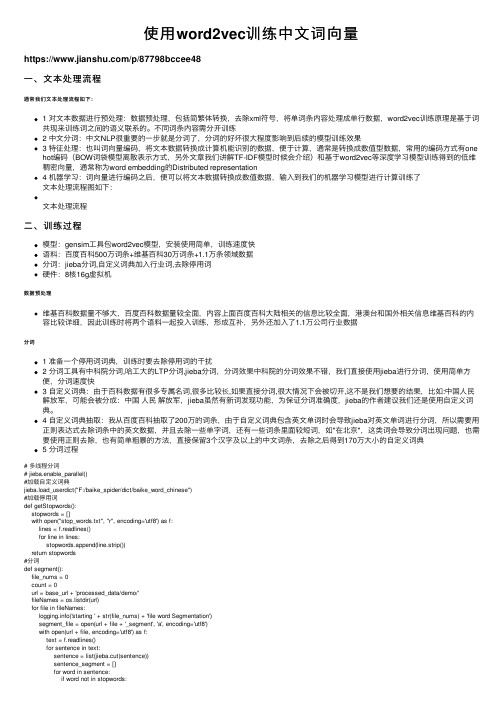

使⽤word2vec训练中⽂词向量https:///p/87798bccee48⼀、⽂本处理流程通常我们⽂本处理流程如下:1 对⽂本数据进⾏预处理:数据预处理,包括简繁体转换,去除xml符号,将单词条内容处理成单⾏数据,word2vec训练原理是基于词共现来训练词之间的语义联系的。

不同词条内容需分开训练2 中⽂分词:中⽂NLP很重要的⼀步就是分词了,分词的好坏很⼤程度影响到后续的模型训练效果3 特征处理:也叫词向量编码,将⽂本数据转换成计算机能识别的数据,便于计算,通常是转换成数值型数据,常⽤的编码⽅式有onehot编码(BOW词袋模型离散表⽰⽅式,另外⽂章我们讲解TF-IDF模型时候会介绍)和基于word2vec等深度学习模型训练得到的低维稠密向量,通常称为word embedding的Distributed representation4 机器学习:词向量进⾏编码之后,便可以将⽂本数据转换成数值数据,输⼊到我们的机器学习模型进⾏计算训练了⽂本处理流程图如下:⽂本处理流程⼆、训练过程模型:gensim⼯具包word2vec模型,安装使⽤简单,训练速度快语料:百度百科500万词条+维基百科30万词条+1.1万条领域数据分词:jieba分词,⾃定义词典加⼊⾏业词,去除停⽤词硬件:8核16g虚拟机数据预处理维基百科数据量不够⼤,百度百科数据量较全⾯,内容上⾯百度百科⼤陆相关的信息⽐较全⾯,港澳台和国外相关信息维基百科的内容⽐较详细,因此训练时将两个语料⼀起投⼊训练,形成互补,另外还加⼊了1.1万公司⾏业数据分词1 准备⼀个停⽤词词典,训练时要去除停⽤词的⼲扰2 分词⼯具有中科院分词,哈⼯⼤的LTP分词,jieba分词,分词效果中科院的分词效果不错,我们直接使⽤jieba进⾏分词,使⽤简单⽅便,分词速度快3 ⾃定义词典:由于百科数据有很多专属名词,很多⽐较长,如果直接分词,很⼤情况下会被切开,这不是我们想要的结果,⽐如:中国⼈民解放军,可能会被分成:中国⼈民解放军,jieba虽然有新词发现功能,为保证分词准确度,jieba的作者建议我们还是使⽤⾃定义词典。

word2Vec实战解读

word2Vec实战解读word2Vec实战解读1. word2vec介绍Word2vec,是⼀群⽤来产⽣词向量的相关模型。

这些模型为浅⽽双层的神经⽹络,⽤来训练以重新建构语⾔学之词⽂本。

⽹络以词表现,并且需猜测相邻位置的输⼊词,在word2vec中词袋模型假设下,词的顺序是不重要的。

训练完成之后,word2vec模型可⽤来映射每个词到⼀个向量,可⽤来表⽰词对词之间的关系,该向量为神经⽹络之隐藏层。

2. CBOW算法:CBOW是已知当前词的上下⽂,来预测当前词。

3. skip-gram算法:已知当前词的情况下,预测其上下⽂。

4. 优缺点skip-gram⽐Cbow准确率⾼,能更好的处理⽣僻字(即出现频率低的字)。

因为在计算时,Cbow会将context word加起来,所以在遇到⽣僻词时预测效果将会⼤⼤降低,⽽skip-gram则会预测⽣僻字的使⽤环境Cbow⽐skip-gram训练快5. 代码执⾏下载,在TensorFlow-Examples\tensorflow_v1\examples\2_BasicModels\word2vec.py路径下,会找到word2vec.py⽂件。

""" Word2Vec.Implement Word2Vec algorithm to compute vector representations of words.This example is using a small chunk of Wikipedia articles to train from.References:- Mikolov, Tomas et al. "Efficient Estimation of Word Representationsin Vector Space.", 2013.Links:- [Word2Vec] https:///pdf/1301.3781.pdfAuthor: Aymeric DamienProject: https:///aymericdamien/TensorFlow-Examples/"""from __future__ import division, print_function, absolute_importimport collectionsimport osimport randomimport urllibimport zipfileimport numpy as npimport tensorflow as tf# Training Parameterslearning_rate = 0.1batch_size = 128num_steps = 3000000display_step = 10000eval_step = 200000# Evaluation Parameters#评价参数eval_words = [b'five', b'of', b'going', b'hardware', b'american', b'britain']# Word2Vec Parametersembedding_size = 200 # Dimension of the embedding vectormax_vocabulary_size = 50000 # Total number of different words in the vocabularymin_occurrence = 10 # Remove all words that does not appears at least n timesskip_window = 3 # How many words to consider left and rightnum_skips = 2 # How many times to reuse an input to generate a labelnum_sampled = 64 # Number of negative examples to sample# Download a small chunk of Wikipedia articles collectionurl = '/dc/text8.zip'data_path = 'text8.zip'if not os.path.exists(data_path):print("Downloading the dataset... (It may take some time)")filename, _ = urllib.request.urlretrieve(url, data_path)print("Done!")# Unzip the dataset file. Text has already been processedwith zipfile.ZipFile(data_path) as f:text_words = f.read(list()[0]).lower().split()# Build the dictionary and replace rare words with UNK token#构建字典,并⽤UNK令牌替换稀有单词count = [('UNK', -1)]# Retrieve the most common words#检索最常⽤的单词count.extend(collections.Counter(text_words).most_common(max_vocabulary_size - 1))# Remove samples with less than 'min_occurrence' occurrences#删除⼩于'min_occurrence'的样本#删除出现次数⼩于'min_occurrence'的样本for i in range(len(count) - 1, -1, -1):if count[i][1] < min_occurrence:count.pop(i)else:# The collection is ordered, so stop when 'min_occurrence' is reachedbreak# Compute the vocabulary sizevocabulary_size = len(count)# Assign an id to each wordword2id = dict()for i, (word, _)in enumerate(count):word2id[word] = idata = list()unk_count = 0for word in text_words:# Retrieve a word id, or assign it index 0 ('UNK') if not in dictionaryindex = word2id.get(word, 0)if index == 0:unk_count += 1data.append(index)count[0] = ('UNK', unk_count)id2word = dict(zip(word2id.values(), word2id.keys()))print("Words count:", len(text_words))print("Unique words:", len(set(text_words)))print("Vocabulary size:", vocabulary_size)print("Most common words:", count[:10])data_index = 0# Generate training batch for the skip-gram modeldef next_batch(batch_size, num_skips, skip_window):global data_indexassert batch_size % num_skips == 0assert num_skips <= 2 * skip_windowbatch = np.ndarray(shape=(batch_size), dtype=np.int32)labels = np.ndarray(shape=(batch_size, 1), dtype=np.int32)# get window size (words left and right + current one)span = 2 * skip_window + 1buffer = collections.deque(maxlen=span)if data_index + span > len(data):data_index = 0buffer.extend(data[data_index:data_index + span])data_index += spanfor i in range(batch_size // num_skips):context_words = [w for w in range(span) if w != skip_window]words_to_use = random.sample(context_words, num_skips)for j, context_word in enumerate(words_to_use):batch[i * num_skips + j] = buffer[skip_window]labels[i * num_skips + j, 0] = buffer[context_word]if data_index == len(data):buffer.extend(data[0:span])data_index = spanelse:buffer.append(data[data_index])data_index += 1# Backtrack a little bit to avoid skipping words in the end of a batchdata_index = (data_index + len(data) - span) % len(data)return batch, labels# Input dataX = tf.placeholder(tf.int32, shape=[None])# Input labelY = tf.placeholder(tf.int32, shape=[None, 1])# Ensure the following ops & var are assigned on CPU# (some ops are not compatible on GPU)with tf.device('/cpu:0'):# Create the embedding variable (each row represent a word embedding vector)embedding = tf.Variable(tf.random_normal([vocabulary_size, embedding_size]))# Lookup the corresponding embedding vectors for each sample in XX_embed = tf.nn.embedding_lookup(embedding, X)# Construct the variables for the NCE lossnce_weights = tf.Variable(tf.random_normal([vocabulary_size, embedding_size]))nce_biases = tf.Variable(tf.zeros([vocabulary_size]))# Compute the average NCE loss for the batchloss_op = tf.reduce_mean(tf.nn.nce_loss(weights=nce_weights,biases=nce_biases,labels=Y,inputs=X_embed,num_sampled=num_sampled,num_classes=vocabulary_size))# Define the optimizeroptimizer = tf.train.GradientDescentOptimizer(learning_rate)train_op = optimizer.minimize(loss_op)# Evaluation# Compute the cosine similarity between input data embedding and every embedding vectors X_embed_norm = X_embed / tf.sqrt(tf.reduce_sum(tf.square(X_embed)))embedding_norm = embedding / tf.sqrt(tf.reduce_sum(tf.square(embedding), 1, keepdims=True)) cosine_sim_op = tf.matmul(X_embed_norm, embedding_norm, transpose_b=True)# Initialize the variables (i.e. assign their default value)init = tf.global_variables_initializer()with tf.Session() as sess:# Run the initializersess.run(init)# Testing datax_test = np.array([word2id[w] for w in eval_words])average_loss = 0for step in range(1, num_steps + 1):# Get a new batch of databatch_x, batch_y = next_batch(batch_size, num_skips, skip_window)# Run training op_, loss = sess.run([train_op, loss_op], feed_dict={X: batch_x, Y: batch_y})average_loss += lossif step % display_step == 0 or step == 1:if step > 1:average_loss /= display_stepprint("Step " + str(step) + ", Average Loss= " + \"{:.4f}".format(average_loss))average_loss = 0# Evaluationif step % eval_step == 0 or step == 1:print("Evaluation...")sim = sess.run(cosine_sim_op, feed_dict={X: x_test})for i in range(len(eval_words)):top_k = 8 # number of nearest neighborsnearest = (-sim[i, :]).argsort()[1:top_k + 1]log_str = '"%s" nearest neighbors:' % eval_words[i]for k in range(top_k):log_str = '%s %s,' % (log_str, id2word[nearest[k]])print(log_str)6. 运⾏结果。

自然语言处理中的词向量表示工具推荐

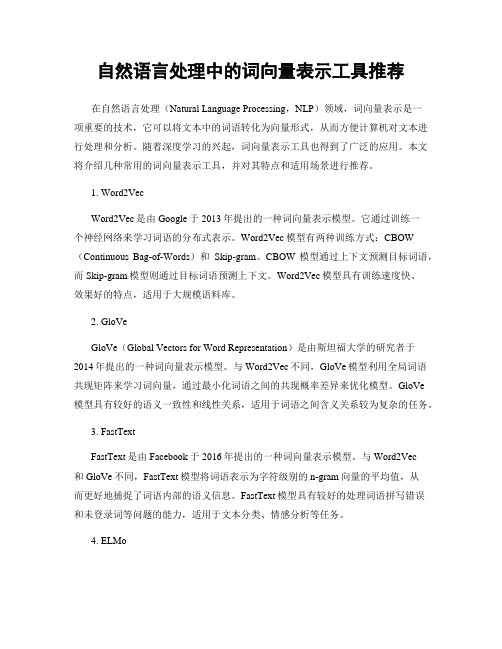

自然语言处理中的词向量表示工具推荐在自然语言处理(Natural Language Processing,NLP)领域,词向量表示是一项重要的技术,它可以将文本中的词语转化为向量形式,从而方便计算机对文本进行处理和分析。

随着深度学习的兴起,词向量表示工具也得到了广泛的应用。

本文将介绍几种常用的词向量表示工具,并对其特点和适用场景进行推荐。

1. Word2VecWord2Vec是由Google于2013年提出的一种词向量表示模型。

它通过训练一个神经网络来学习词语的分布式表示。

Word2Vec模型有两种训练方式:CBOW (Continuous Bag-of-Words)和Skip-gram。

CBOW模型通过上下文预测目标词语,而Skip-gram模型则通过目标词语预测上下文。

Word2Vec模型具有训练速度快、效果好的特点,适用于大规模语料库。

2. GloVeGloVe(Global Vectors for Word Representation)是由斯坦福大学的研究者于2014年提出的一种词向量表示模型。

与Word2Vec不同,GloVe模型利用全局词语共现矩阵来学习词向量,通过最小化词语之间的共现概率差异来优化模型。

GloVe模型具有较好的语义一致性和线性关系,适用于词语之间含义关系较为复杂的任务。

3. FastTextFastText是由Facebook于2016年提出的一种词向量表示模型。

与Word2Vec和GloVe不同,FastText模型将词语表示为字符级别的n-gram向量的平均值,从而更好地捕捉了词语内部的语义信息。

FastText模型具有较好的处理词语拼写错误和未登录词等问题的能力,适用于文本分类、情感分析等任务。

4. ELMoELMo(Embeddings from Language Models)是由斯坦福大学的研究者于2018年提出的一种词向量表示模型。

ELMo模型通过训练一个双向语言模型来学习词向量,同时考虑了词语的上下文信息。

自然语言处理的词向量模型比较

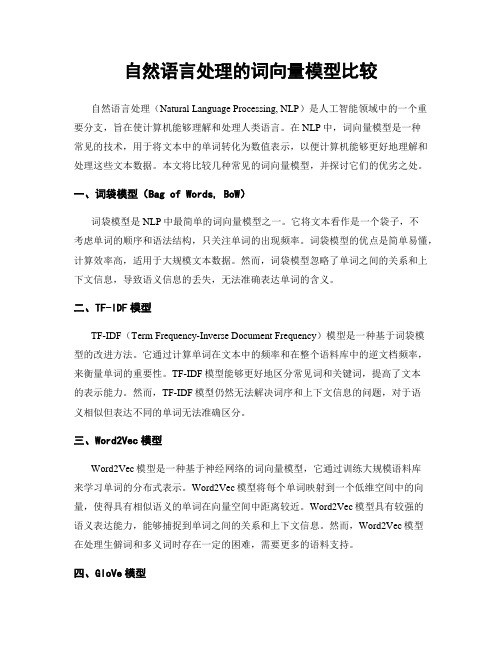

自然语言处理的词向量模型比较自然语言处理(Natural Language Processing, NLP)是人工智能领域中的一个重要分支,旨在使计算机能够理解和处理人类语言。

在NLP中,词向量模型是一种常见的技术,用于将文本中的单词转化为数值表示,以便计算机能够更好地理解和处理这些文本数据。

本文将比较几种常见的词向量模型,并探讨它们的优劣之处。

一、词袋模型(Bag of Words, BoW)词袋模型是NLP中最简单的词向量模型之一。

它将文本看作是一个袋子,不考虑单词的顺序和语法结构,只关注单词的出现频率。

词袋模型的优点是简单易懂,计算效率高,适用于大规模文本数据。

然而,词袋模型忽略了单词之间的关系和上下文信息,导致语义信息的丢失,无法准确表达单词的含义。

二、TF-IDF模型TF-IDF(Term Frequency-Inverse Document Frequency)模型是一种基于词袋模型的改进方法。

它通过计算单词在文本中的频率和在整个语料库中的逆文档频率,来衡量单词的重要性。

TF-IDF模型能够更好地区分常见词和关键词,提高了文本的表示能力。

然而,TF-IDF模型仍然无法解决词序和上下文信息的问题,对于语义相似但表达不同的单词无法准确区分。

三、Word2Vec模型Word2Vec模型是一种基于神经网络的词向量模型,它通过训练大规模语料库来学习单词的分布式表示。

Word2Vec模型将每个单词映射到一个低维空间中的向量,使得具有相似语义的单词在向量空间中距离较近。

Word2Vec模型具有较强的语义表达能力,能够捕捉到单词之间的关系和上下文信息。

然而,Word2Vec模型在处理生僻词和多义词时存在一定的困难,需要更多的语料支持。

四、GloVe模型GloVe(Global Vectors for Word Representation)模型是一种基于全局词频统计的词向量模型。

它通过分析大规模语料库中单词的共现关系,来学习单词的分布式表示。

人工智能资料-机器学习算法:word2vec(词向量与统计语言模型)

Word2Vec 是Google 在2013年年年年中开源的⼀一款将词表征为实数值向量量的⾼高效⼯工具,采⽤用的模型有CBOW (Continuous Bag-Of-Words ,即连续的词袋模型)和Skip-Gram 两种。

word2vec ⼀一般被外界认为是⼀一个Deep Learning (深度学习)的模型,究其原因,可能和word2vec 的作者Tomas Mikolov 的Deep Learning 背景以及word2vec 是⼀一种神经⽹网络模型相关,但我们谨慎认为该模型层次较浅,严格来说还不不能算是深层模型。

当然如果word2vec 上层再套⼀一层与具体应⽤用相关的输出层,⽐比如Softmax ,此时更更像是⼀一个深层模型。

word2vec 通过训练,可以把对⽂文本内容的处理理简化为K 维向量量空间中的向量量运算,⽽而向量量空间上的相似度可以⽤用来表示⽂文本语义上的相似度。

因此,word2vec 输出的词向量量可以被⽤用来做很多NLP 相关的⼯工作,⽐比如聚类、找同义词、词性分析等等。

⽽而word2vec 被⼈人⼴广为传颂的地⽅方是其向量量的加法组合运算(Additive Compositionality ),官⽹网上的例例⼦子是:vector (′Paris ′)−vector (′France ′)+vector (′Italy ′)≈vector (′Rome ′),vector (′king ′)−vector (′man ′)+vector (′women ′)≈vector (′queen ′)。

但我们认为这个多少有点被过度炒作了了,很多其他降维或主题模型在⼀一定程度也能达到类似效果,⽽而且word2vec 也只是少量量的例例⼦子完美符合这种加减法操作,并不不是所有的case 都满⾜足。

word2vec ⼤大受欢迎的另⼀一个原因是其⾼高效性,Mikolov 在论⽂文中指出⼀一个优化的单机版本⼀一天可训练上千亿个词。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目录

1 2

基本概念 模型与方法 实际应用

3

词向量 • 自然语言中的词语在机器学习中的表示符号 • One-Hot Representation

例如: “话筒”表示为:[0, 0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, …] “麦克”表示为:[0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, …] 实现时可以用0,1,2,3等对词语进行计算,这样的“话筒”可以用4表示,麦克 可以用10表示

两个语言模型 CBOW:Continuous Bag-of-Words Skip-Gram:Continuous Skip-Gram Model

两种优化方法 Hierarchical Softmax Negative Sampling

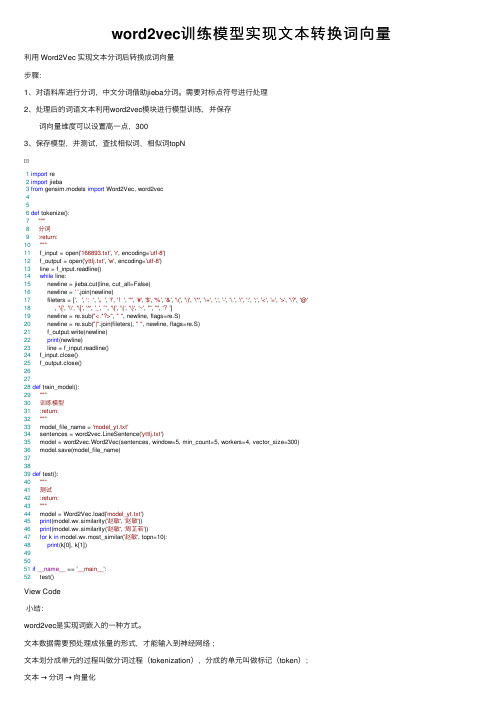

CBOW and Skip-Gram

初始化值是零向量, 叶节点对应的单词的词向量是 随机初始化的。 CBOW 的目 标 是 根 据 上 下 文 来 预 测 当 前 词 语 的 概率Skip-Gram恰好相反, 它是根据当前词语来预测上下文的概率。这 两 种 方 法 都 利 用 人 工 神 经 网 络 作 为它们的分类 算法。起 初, 每 个 单 词 都 是 一 个 随 机 N 维 向 量,经过训练之后, 利用 CBOW 或者 SkipGram方法获得每个单词的最优向量。

机器翻译 • 机器翻译

• 语言词语的关系集合被表征为向量集合 • 向量空间内,不同语言享有许多共性 • 实现一个向量空间到另一个向量空间的映射和转换

• 图为英语和西班语的五个词在向量空间中的位置(已 经过降维) • 对英语和西班语之间的翻译准确率高达90%

推荐应用 Item2Vec

论文:Item2vec: Neural Item Embedding for Collaborative Filtering 应用到推荐场景的i2i相似度计算中,但实际效果看还有有提升的。主要做法是 把item视为word,用户的行为序列视为一个集合,item间的共现为正样本, 并按照item的频率分布进行负样本采样

Skip-Gram模型结构

小明 喜欢 吃 甜甜 的 苹果

d吃 c b a

目录

1 2

基本概念 模型与方法

3

实际应用

词相似度 训练数据集:经过分词后的新闻数据,大小184MB查看

"中国","钓鱼岛","旅游","苹果"几个词语的相似词语如下所示

向量加减法 向量加减法

"中国+北京-日本","中国+北京-法国"

目录

1 2

基本概念 模型与方法 实际应用

3ቤተ መጻሕፍቲ ባይዱ

Word2Vec

Google的Mikolov在2013年推出了一款计算词向量的工具

word2vec作为神经概率语言模型的输入,其本身其实是神经概率模型的副产品,是为了通过神经网 络学习某个语言模型而产生的中间结果。具体来说,“某个语言模型”指的是“CBOW”和“SkipGram”。具体学习过程会用到两个降低复杂度的近似方法——Hierarchical Softmax或Negative Sampling。

CBOW模型结构

输入层是上下文的词语的词 向量,是CBOW模型的一 个参数。训练开始的时候, 词向量是个随机值,随着训 练的进行不断被更新。当模 型训练完成之后可以获得较 为准确的词向量。

时间复杂度: O(|V|) O(log2(|V|))

Softmax

CBOW模型结构——霍夫曼树

在训练阶段,当给定一个上下文,要 预测词(Wn)的时候,实际上知道要的 是哪个词(Wn),而Wn是肯定存在于 二叉树的叶子节点的,因此它必然有 一个二进制编号,如“010011”,那 么接下来我们就从二叉树的根节点一 个个地去遍历,而这里的目标就是预 测这个词的二进制编号的每一位.即对 于给定的上下文,我们的目标是使得 预测词的二进制编码概率最大。形象 地说,我们希望在根节点,词向量和 与根节点相连经过logistic计算得到的 概率尽量接近0(即预测目标是 bit=1);在第二层,希望其bit是1, 即概率尽量接近1……这么一直下去, 我们把一路上计算得到的概率相乘, 即得到目标词Wn在当前网络下的概率 (P(Wn)),那么对于当前这个sample 的残差就是1-P(Wn)。于是就可以 SGD优化各种权值了。

谢谢观看

词向量模型—Word2Vec

前言

计算机

人类

VS

老外来访被请吃饭。落座后,一中国人说: “我先去方便一下。”老外不解,被告知 “方便”是“上厕所”之意。席间主宾大 悦。道别时,另一中国人对老外发出邀请: “我想在你方便的时候也请你吃饭。”老 外愣了,那人接着说: “如果你最近不 方便的话,咱找个你我都方便的时候一起 吃。

语言模型 • 判断一句话是不是正常人说出来的

给定一个字符串”w1, w2, w3, w4, … , wt”,计算它是自然语言的概率、 P(w1,w2,…,wt)=P(w1)×P(w2|w1)×P(w3|w1,w2)×…×P(wt|w1,w2,…,wt−1) P(大家,喜欢,吃,苹果)=p(大家)p(喜欢|大家)p(吃|大家,喜欢)p(苹果|大 家,喜欢,吃) p(大家)表示“大家”这个词在语料库里面出现的概率; p(喜欢|大家)表示“喜欢”这个词出现在“大家”后面的概率; p(吃|大家,喜欢)表示“吃”这个词出现在“大家喜欢”后面的概率; p(苹果|大家,喜欢,吃)表示“苹果”这个词出现在“大家喜欢吃”后面的概 率。 把这些概率连乘起来,得到的就是这句话平时出现的概率。 如果这个概率特别低,说明这句话不常出现,那么就不算是一句自然语言, 因为在语料库里面很少出现。如果出现的概率高,就说明是一句自然语言。 常用的语言模型都是在近似地求 P(wt|w1,w2,…,wt−1)。 比如 n-gram 模型就是用 P(wt|wt−n+1,…,wt−1) 近似表示前者。 N-pos 先对词进行了词性分类

问题: 1. 维度很大,当词汇较多时,可能会达到百万维,造成维度灾难 2. 词汇鸿沟:任意两个词之间都是孤立的,不能体现词与词之间的关系。

词向量 • Distributional Representation

将词表示为 [0.793, -0.177, -0.107, 0.109, 0.542, …]的矩阵,通常该类矩阵设置为50维或 100维 通过计算向量之间的距离,来体现词与词之间的相似性,解决词汇鸿沟的问题 实现时可以用0,1,2,3等对词语进行计算,这样的“话筒”可以用4表示,麦克可以用10表示 如何训练: 1. 没有直接的模型可以训练得到 2. 可以在训练语言模型的同时,得到词向量。