网络分析与综合-6.5 归一化和去归一化

归一化的计算公式

归一化的计算公式归一化是一种在数学和各种科学领域中常用的方法,它能让不同范围和量级的数据变得具有可比性。

归一化的计算公式虽然看起来可能有点复杂,但其实理解起来也并不难。

先来说说归一化到底是啥。

比如说,我们要比较两个班级学生的考试成绩。

一个班级的成绩普遍在 80 到 90 分之间,另一个班级的成绩则在60 到70 分之间。

单纯看分数,好像第一个班级的学生成绩更好,但如果考虑到两个班级的试卷难度不同呢?这时候,归一化就派上用场了,它能消除这种由于测量尺度不同带来的差异。

归一化的计算公式有很多种,常见的有线性归一化和非线性归一化。

线性归一化的公式一般是:\[X_{norm} = \frac{X - X_{min}}{X_{max} - X_{min}}\]这里的 \(X\) 是原始数据,\(X_{min}\) 是数据中的最小值,\(X_{max}\) 是数据中的最大值。

举个例子,一个班级学生的数学成绩分别是 60 分、70 分、80 分、90 分和 100 分。

那么 \(X_{min} = 60\),\(X_{max} = 100\) 。

假如我们要对 80 分进行归一化,那就是 \(\frac{80 - 60}{100 - 60} = 0.5\) 。

非线性归一化就更复杂一些啦,比如对数归一化、反正切归一化等等。

但别担心,咱们先把线性的搞清楚,其他的也能慢慢理解。

我之前在给学生讲这个知识点的时候,就发生了一件有趣的事儿。

有个学生特别较真儿,他就觉得归一化没啥用,说:“老师,这多麻烦呀,直接看分数不就行了?”我就笑着跟他说:“那好呀,咱们来做个实验。

”我拿出了两份数据,一份是不同班级学生的身高数据,另一份是不同班级学生的体重数据。

然后让他直接比较哪个班级的同学“更厉害”。

这孩子一下子就懵了,这身高和体重咋比呀?然后我就趁机给他讲,这就像不同班级的考试成绩,如果没有归一化,就很难公平地比较。

经过这一番折腾,这孩子终于明白了归一化的重要性。

同等学力申硕《电气工程学科综合水平全国统一考试》章节题库(电网络理论与电磁场数值分析)

7.8 试比较级联法、仿真电感法、FDNR 法之间的相同点与不同点。 答:见表 7-1。

7.4 试说明何谓网络综合,它在电路设计中的作用。 答:所谓网络综合,即按预定条件,根据数学方法和一定的步骤来确定一个电路的结构

1 / 11

圣才电子书 十万种考研考证电子书、题库视频学习平台

及其构成元件。网络综合可用来设计各类滤波器和模拟电路,如含有运算放大器的有源 RC 网络、有源 RC 滤波器等。

表 7-1 级联法、仿真电感法、FDNR 法之间子书、题库视频学习平台

7.9 何谓方程的复杂性阶数? 答:方程的复杂性阶数等于独立的初始条件数,这些初始条件通过变量来表示。由线性 非时变 R、L(M)、C 元件组成的电路的复杂性阶数等于任何时间 t0(特别是 t0=0)时的 独立电感电流和电容电压的数目。所以,当电路中不存在纯由电感或电感和独立电流源构成 的割集或纯由电容或电容和独立电压源构成的回路,则复杂性阶数等于储能元件的总数。

图 7-1

Z11

答:设该二端口网络的阻抗参数矩阵为

Z21

Z12

Z22

,由各阻抗参数定义式,可以求

得

Z11

R1

/

/

j

1 C

4 / 11

圣才电子书

十万种考研考证电子书、题库视频学习平台

Z12 0

Z21

gm R2

R1

/

什么是归一化和标准化

什么是归⼀化和标准化 归⼀化(Rescaling,max-min normalization,有的翻译为离差标准化)是指将数据缩放到[0,1]范围内,公式如下:X' = [X - min(X)] / [max(X) - min(X)] 标准化(Standardization, Z-score normalization,后者翻译为标准分)是指在不改变数据分布情况下,将数据处理为均值为0,标准差为1的数据集合。

公式如下:X' = [X - mean(X)] / δ 标准化的公式很眼熟,则不就是正态分布N(µ,δ) ~ N(0, 1)的公式吗?X' = (X - µ) / δ 注意标准化的公式并不局限于正态分布,任何分布都可以通过标准化将数据分布变为均值为0,⽅差为1的数据序列。

注: 1. 中⼼化,是部分标准化:X' = X - mean(X),⽐如PCA就需要对数据⾸先进⾏中⼼化处理之后,得到的数据才能⽐较好的描述主成分。

2. normalization被翻译为正规化。

有的博客和⽂章写作正则化(regularization)笑笑就好了。

区别和⽤途 归⼀化和标准化虽然都是在保持数据分布不变的情况下(为什么能够保持数据的分布不变?因为两者本质上都只是对数据进⾏线性变化),对数据进⾏处理,但是从公式上⾯还是能够明显看出来,归⼀化的处理只是和最⼤值最⼩值相关,标准化却是和数据的分布相关(均值,⽅差),所以标准化的统计意义更强,是是对于数据缩放处理的⾸选。

只是有些特殊场景下,⽐如需要数据缩放到[0,1]之间(标准化并不保证数据范围),以及在⼀些稀疏数据场景,想要保留0值,会采⽤到归⼀化,其他的⼤部分时候,标准化是⾸选。

为什么需要标准化? 让数据因为量纲不⼀致导致的数据差别较⼤情况有所收敛。

为什么量纲不⼀致会导致问题?如果⼀个特征的A的值分布式在[0, 1],另外⼀个特征B的分布是在[100, 10000],那么在进⾏梯度下降调试参数的时候,明显对于B特征的参数的修改造成的改动要强于A特征,但是在显⽰意义可能并不是如此。

归一化法名词解释

归一化法名词解释归一化法,又称为标准化法,是一种数据处理的常用方法。

它通过对数据进行线性变换,使得数据符合一定的标准或特定的分布,以便于进行比较、分析或者其他处理。

在各个领域的数据处理中都有广泛的应用,特别是在机器学习和数据挖掘领域。

归一化法的目的是消除不同数据之间的量纲和数值范围差异,使得数据具有可比性。

在实际应用中,不同的数据可能具有不同的量纲,例如某些数据的单位是厘米,而另一些数据的单位是千克。

如果不进行归一化处理,就会导致数据的差异被放大,从而影响到后续的分析结果。

对于归一化法的应用,常见的方法包括线性归一化和零均值归一化。

线性归一化是将原始数据线性映射到[0,1]的区间内。

具体的计算公式为:$$x'=\frac{x-min(x)}{max(x)-min(x)}$$其中,$x$表示原始数据,$x'$表示归一化后的数据。

通过线性归一化,将原始数据的最大值映射为1,最小值映射为0,其他值则按照线性关系进行映射。

零均值归一化,又称为标准化,是将原始数据按照均值为0,标准差为1的规则进行变换。

具体的计算公式为:$$x'=\frac{x-\mu}{\sigma}$$其中,$x$表示原始数据,$x'$表示归一化后的数据,$\mu$表示原始数据的均值,$\sigma$表示原始数据的标准差。

通过零均值归一化,将原始数据的均值调整为0,标准差调整为1,使得数据更加符合正态分布。

归一化法在实际应用中具有广泛的作用。

首先,归一化可以提高数据的可比性。

例如在数据挖掘中,不同指标的数值范围可能有很大的差异,如果不进行归一化处理,就会导致某些指标在模型中占据主导地位,而其他指标被忽略。

通过归一化处理,可以保证每个指标对模型的贡献相对均衡,从而提高模型的效果。

其次,归一化可以提高模型的鲁棒性。

在一些机器学习算法中,例如支持向量机(SVM)和K近邻(KNN)等,模型的训练过程依赖于数据之间的距离或相似度。

归一化数据处理

归一化数据处理归一化数据处理是在数据分析和机器学习中常用的一项技术,它可以将不同数据的取值范围转换为统一的标准范围,从而方便进行比较和分析。

本文将介绍归一化的概念、常用的归一化方法以及归一化的应用场景。

一、归一化的概念归一化(Normalization)是将数据按比例缩放,使之落入一个特定的区间,常见的是将数据缩放到[0, 1]或[-1, 1]的范围内。

归一化可以消除数据之间的量纲差异,避免因为数据的绝对值大小不同而导致的计算偏差。

在数据分析和机器学习中,很多算法都要求输入的特征数据具有相同的尺度。

二、常用的归一化方法1. 最小-最大归一化(Min-Max Normalization):将数据线性地缩放到[0, 1]的范围内,公式如下:X' = (X - X_min) / (X_max - X_min)其中,X为原始数据,X'为归一化后的数据,X_min为原始数据的最小值,X_max为原始数据的最大值。

2. Z-score归一化(Standardization):将数据转换为均值为0,标准差为1的标准正态分布,公式如下:X' = (X - mean) / std其中,X为原始数据,X'为归一化后的数据,mean为原始数据的均值,std为原始数据的标准差。

3. 小数定标归一化(Decimal Scaling):将数据除以一个固定的基数,使数据的绝对值都小于1,公式如下:X' = X / 10^k其中,X为原始数据,X'为归一化后的数据,k为一个合适的整数。

三、归一化的应用场景1. 数据挖掘和机器学习:在训练模型之前,通常需要对输入的特征数据进行归一化处理,以提高模型的准确性和稳定性。

2. 图像处理:在图像处理中,归一化可以用来调整图像的对比度和亮度,使图像更加清晰和易于分析。

3. 信号处理:在信号处理中,归一化可以用来消除信号的幅度差异,使得不同信号之间的比较更加准确。

《网络分析与综合》试题(答案)

《网络分析与综合》试题答案一、填空题(本大题共25分,未注明的每空1分)⏹ 从不对称二端口网络两端的得到的影像阻抗(不相等),而传输常数(相等)。

⏹在300Ω负载上测得的电压为31V ,其绝对电压电平为(32)dB ,其绝对功率电平为(35)dB 。

(此题每空2分)⏹ 已知一有向图的节点数为11个,支路数为15个,那么其树支数为(10)个,基本回路有(5)个,基本割集数有(10)个。

⏹ 二端口网络的各类网络参数都有(4)个,但在无受控源时只有(3)个是独立的,且当网络又是对称时,则只有(2)个是独立的。

⏹ 梯型滤波器的开、短路阻抗在通带内的类型(不)同,在阻带内(相)同。

⏹不论二端口网络是否匹配,只要网络的衰减不小于(3)奈培或(26)分贝,网络的输入阻抗就等于网络的(影像)阻抗。

⏹ LC 二端口网络的一个传输零点在200Hz 处,而y 22只有在150Hz 的零点,这时必须采用(零点位移)技术,(部分)(部分、全部)实现(∞)(0、∞)处的(极点)(零点、极点),这样就可以将y 22(150Hz )处的零点移到(200Hz )处。

⏹ “链接”指的是前一个网络的(输出)端口与后一个网络的(输入)端口相联,不管它们是否匹配,其总的(传输、A 、T )参数为组成它的各个子网络的相应参数的乘积。

二、简答题(包括名词解释)(17分)● (2分)基本割集矩阵基本割集矩阵与支路关系的矩阵:支路与基本割集无关联,元素取0;有关联且方向相同取1;有关联但方向相反取-1。

● (5分)由()111εγ+=th Z Z C i (其中21C L Z Zth =ε),我们可以得到一些什么启示由该式可以看出:⑴当2C L Z Z =时,11C i Z Z =(匹配);⑵ 当()N 3≥=γαRe 时,11C i Z Z ≈,可见,当相关网络对匹配要求较高时,而实际又难以做到时,可以用增加网络衰耗的方法来加以解决。

● (4分)用均匀传输线的一次参数RLCG 表示的二次参数Z C 、γ是怎样的波阻抗:Cj G Lj R Z C ωω++=,传播常数:()()C j G L j R ωωγ++=● (3分)分布参数网络当信号的波长小于或等于处理它的网络的尺寸时,该网络就称为分布参数网络● (3分)K 式滤波器串臂阻抗与并臂阻抗互为倒量的滤波器二、计算题(本大题共58分)⒈ 321110001000001110011001 7641532⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡---=b b b b b b b A (3分)764176415321000110010011000101010001101 ⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡----=b b b b b b b B f (3分) 5327641532111110011000100011001c c c b b b b b b b Q f ⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡----= (2分) ⒉ ()()()K s s s s K s s s s s H ++++=++++=233212342(2分)()()s KK s K s s s s K s s s n s m 792179237179131233324-+⎪⎭⎫ ⎝⎛-++=+++=,或 010079203702331321234KK s K s s K s -(4分) ⎪⎩⎪⎨⎧-0792 K K ,9140 K (2分) ⒊ 图部分,包含分析3分Ω=∞ 161Z ,Ω= 401Z ,Ω=⨯==∞ 84160111Z Z Z C (2分) Ω=∞ 122Z ,Ω== 341202//Z ,Ω=⨯==∞ 63120222Z Z Z C (2dB 774 54930214111202110111..≈≈====--∞-∞-N th th Z Z th Z Z th γ(2分) dB N 433 845371..≈≈=γγ(1分)⒋ 最靠近原点的是一个极点,说明这是一个RC 单端口网络(4分)(图4分)⒌ ① 极点:0s =, 1.41j ±±,∞,零点:j ±, 1.73s j =±±(及曲线图4分)② ()42343111212416s s Z s s s s ss s ++==++++(4分) ③(2分)⒍ ()ss s s s s s s s s H U 31111201411201311112063524352+++++++=,s s s s y 3111120635212++=-,s s s s s y 3111120141120352422++++=(4分) ()s H 传输零点:0=s 处,2阶;∞→s 处,3阶;12y -零点:0=s 处,2阶;∞→s 处,3阶,故22y 没有私有极点,第一个元件在串臂上;由于是电压源激励,故最后一个元件应与电压源串联(4分)。

王勤电网络理论第六章

1

1 Z ( s) = [ F0 ( s ) + sT0 ( s ) + V0 ( s )] 2 s I1

1

F0 ( jω ) = 2 ∑ (

j=2 b

b

Ij 2 Ij 2

) R j = 2P

2

T0 ( jω ) = 2 ∑ (

j=2 b

) L j = 4W L

2

V0 ( jω ) = 2 ∑ (

∴参数的阻抗归一化与去归一化表达式为:

RN = R kZ , LN = L kZ , C N = kZ C .

R = kZ RN , L = kZ LN , C = C N kZ .

2、频率的归一化与去归一化 设归一化常数为kω= s/sN ,为使阻抗值不变,应有

s s sL = ⋅ k L ≡ sN LN , sC = ⋅ k C ≡ sN C N ω ω k k ω ω

因Z(s)极点的留数为正实数,有kp1= k*p1 , 故

2k p1 s 2k p 2 s k0 k ks k s + 2 + L ≡ k∞ s + 0 + 2 1 2 + 2 2 2 + L Z ( s ) = k∞ s + + 2 s s +ω21 s +ω2 2 s s +ωp1 s +ωp 2 p p

∴ 参数的频率归一化与去归一化表达式为:

RN = R , LN = kω L , C N = kωC

R = RN , L = LN kω , C = C N kω

3、同时有阻抗与频率的归一化与去归一化 R kω RN = , LN = L , C N = k Z kωC kZ kZ

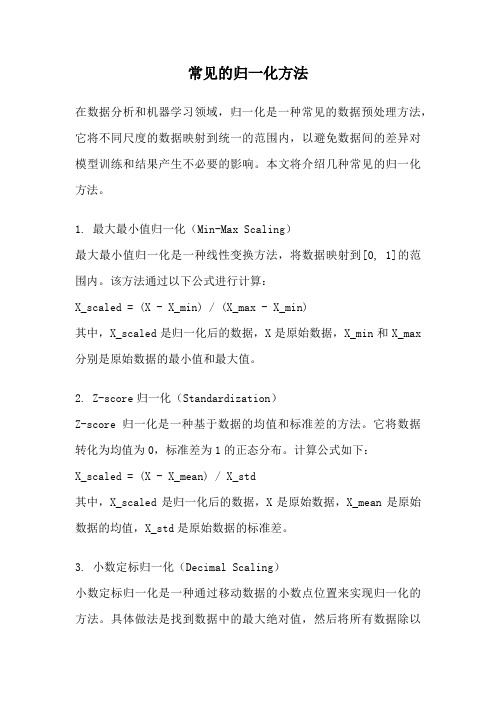

常见的归一化方法

常见的归一化方法在数据分析和机器学习领域,归一化是一种常见的数据预处理方法,它将不同尺度的数据映射到统一的范围内,以避免数据间的差异对模型训练和结果产生不必要的影响。

本文将介绍几种常见的归一化方法。

1. 最大最小值归一化(Min-Max Scaling)最大最小值归一化是一种线性变换方法,将数据映射到[0, 1]的范围内。

该方法通过以下公式进行计算:X_scaled = (X - X_min) / (X_max - X_min)其中,X_scaled是归一化后的数据,X是原始数据,X_min和X_max 分别是原始数据的最小值和最大值。

2. Z-score归一化(Standardization)Z-score归一化是一种基于数据的均值和标准差的方法。

它将数据转化为均值为0,标准差为1的正态分布。

计算公式如下:X_scaled = (X - X_mean) / X_std其中,X_scaled是归一化后的数据,X是原始数据,X_mean是原始数据的均值,X_std是原始数据的标准差。

3. 小数定标归一化(Decimal Scaling)小数定标归一化是一种通过移动数据的小数点位置来实现归一化的方法。

具体做法是找到数据中的最大绝对值,然后将所有数据除以该最大绝对值的幂次,使得所有数据的绝对值都小于1。

例如,如果最大绝对值是10^k,那么归一化后的数据为:X_scaled = X / 10^k4. 归一化到单位长度(Unit Length)归一化到单位长度是一种将数据向量转化为单位长度的方法,常用于文本分类等任务中。

具体做法是将向量除以其自身的模长。

计算公式如下:X_scaled = X / ||X||其中,X_scaled是归一化后的向量,X是原始向量,||X||是X的模长。

5. 对数函数归一化(Logarithmic Scaling)对数函数归一化是一种将数据通过对数函数进行变换的方法。

通过对数函数的压缩作用,可以将原始数据的范围缩小。

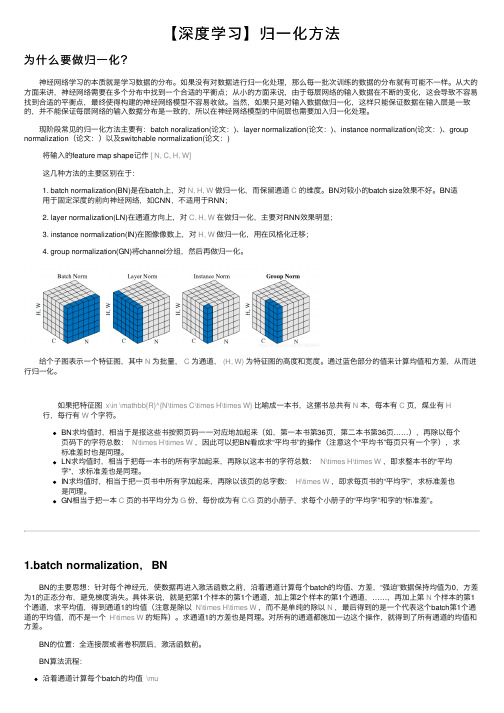

【深度学习】归一化方法

【深度学习】归⼀化⽅法为什么要做归⼀化?神经⽹络学习的本质就是学习数据的分布。

如果没有对数据进⾏归⼀化处理,那么每⼀批次训练的数据的分布就有可能不⼀样。

从⼤的⽅⾯来讲,神经⽹络需要在多个分布中找到⼀个合适的平衡点;从⼩的⽅⾯来说,由于每层⽹络的输⼊数据在不断的变化,这会导致不容易找到合适的平衡点,最终使得构建的神经⽹络模型不容易收敛。

当然,如果只是对输⼊数据做归⼀化,这样只能保证数据在输⼊层是⼀致的,并不能保证每层⽹络的输⼊数据分布是⼀致的,所以在神经⽹络模型的中间层也需要加⼊归⼀化处理。

现阶段常见的归⼀化⽅法主要有:batch noralization(论⽂:)、layer normalization(论⽂:)、instance normalization(论⽂:)、group normalization(论⽂:)以及switchable normalization(论⽂:)将输⼊的feature map shape记作[ N, C, H, W]这⼏种⽅法的主要区别在于:1. batch normalization(BN)是在batch上,对N, H, W 做归⼀化,⽽保留通道C 的维度。

BN对较⼩的batch size效果不好。

BN适⽤于固定深度的前向神经⽹络,如CNN,不适⽤于RNN;2. layer normalization(LN)在通道⽅向上,对C, H, W 在做归⼀化,主要对RNN效果明显;3. instance normalization(IN)在图像像数上,对H, W 做归⼀化,⽤在风格化迁移;4. group normalization(GN)将channel分组,然后再做归⼀化。

给个⼦图表⽰⼀个特征图,其中N 为批量,C 为通道,(H, W) 为特征图的⾼度和宽度。

通过蓝⾊部分的值来计算均值和⽅差,从⽽进⾏归⼀化。

如果把特征图 x\in \mathbb{R}^{N\times C\times H\times W} ⽐喻成⼀本书,这摞书总共有N 本,每本有C 页,煤业有H ⾏,每⾏有W 个字符。

归一化原理

归一化原理归一化原理是指将数据按比例缩放,使之落入一个特定的范围。

在数据处理和机器学习中,归一化是一种常见的数据预处理方法,它可以消除不同特征之间的量纲影响,使得数据更容易被处理和分析。

在实际应用中,我们经常会遇到不同特征之间的数值范围差异很大的情况。

如果不对数据进行归一化处理,那么在进行数据分析和建模时,数值范围较大的特征会对结果产生更大的影响,从而导致模型训练不稳定甚至无法收敛。

因此,归一化原理的应用可以有效提高数据处理和模型训练的稳定性和准确性。

归一化原理的核心思想是将数据映射到一个特定的区间内,常见的归一化方法包括最小-最大归一化和Z-score归一化。

最小-最大归一化是指将原始数据线性映射到[0, 1]的区间内。

具体的归一化公式为:\[ x_{norm} = \frac{x x_{min}}{x_{max} x_{min}} \]其中,\( x_{norm} \)为归一化后的数据,\( x \)为原始数据,\( x_{min} \)和\( x_{max} \)分别为原始数据的最小值和最大值。

Z-score归一化是指将原始数据映射到均值为0,标准差为1的正态分布内。

具体的归一化公式为:\[ x_{norm} = \frac{x \mu}{\sigma} \]其中,\( x_{norm} \)为归一化后的数据,\( x \)为原始数据,\( \mu \)为原始数据的均值,\( \sigma \)为原始数据的标准差。

除了最小-最大归一化和Z-score归一化之外,还有其他一些归一化方法,如小数定标标准化、对数变换等。

在实际应用中,我们需要根据数据的特点和需求来选择合适的归一化方法。

归一化原理的应用不仅局限于数据处理和机器学习领域,它在其他领域也有着广泛的应用。

例如,在图像处理中,归一化可以提高图像的对比度和清晰度;在信号处理中,归一化可以提高信号的稳定性和可靠性。

总之,归一化原理是一种重要的数据预处理方法,它可以有效消除不同特征之间的量纲影响,提高数据处理和模型训练的稳定性和准确性。

五种归一化原理-概述说明以及解释

五种归一化原理-概述说明以及解释1.引言1.1 概述概述:归一化是一种数据预处理技术,广泛应用在数据挖掘、机器学习等领域。

它是将不同取值范围的数据统一到同一尺度上的一种方法。

在现实世界中,数据往往存在着不同的度量单位、不同的数值范围,这样的数据对于分析和比较常常造成困扰。

因此,归一化通过将数据进行线性等比例缩放,将其映射到一个特定的范围,从而消除了数据之间的量纲和取值范围的差异。

归一化的目的是使得不同指标之间具有可比性与可度量性,便于分析和处理数据,更好地挖掘数据中所携带的信息。

归一化不仅可以改善数据的表现形式,还能提高模型的准确性和稳定性。

本文将介绍五种常用的归一化原理,分别是线性归一化、零-均值归一化、小数定标标准化、Sigmoid函数归一化和正则化方法。

这些原理在处理不同类型的数据时具有各自的优势和适用范围。

通过深入了解这些归一化原理,我们可以更好地选择和应用归一化方法,以提升数据处理和分析的效果。

接下来的章节将详细介绍这五种归一化原理的具体原理和实现方法,并探讨其各自的优缺点。

同时,我们也会总结归一化的应用前景和未来发展方向,展望归一化技术在数据处理和分析中的重要性和潜力。

文章结构部分的内容可以按照以下方式编写:1.2 文章结构本文将围绕五种归一化原理进行阐述和分析。

文章分为引言、正文和结论三个部分。

在引言部分,我们将对归一化的概念进行概述,说明归一化在数据处理和分析中的重要性。

然后,我们将介绍文章的结构和目的,以便读者对整个文章有一个清晰的了解。

正文部分将详细介绍五种归一化原理。

首先,我们将探讨归一化原理1,解释其背后的概念和原理,并探讨其在实际应用中的优点和局限性。

接下来,我们将继续介绍归一化原理2、3、4和5,逐一进行分析和讨论。

每种归一化原理都将详细说明其适用的场景和应用示例,以帮助读者更好地理解和应用这些原理。

在结论部分,我们将总结归一化原理的主要观点和应用场景。

我们还将探讨归一化在未来的发展前景,以及其在各个领域的潜在应用价值。

归一化全面总结

归⼀化全⾯总结1、信号处理⼯具箱中经常使⽤的是nyquist频率,它被定义为采样频率的⼀半,在滤波器的阶数选择和设计中的截⽌频率均使⽤nyquist频率进⾏归⼀化处理。

例如对于⼀个采样频率为1000hz的系统,400hz的归⼀化频率就为400/500=0.8。

归⼀化频率范围在[0,1]之间。

如果将归⼀化频率转换为⾓频率,则将归⼀化频率乘以2*pi;如果将归⼀化频率转换为hz,则将归⼀化频率乘以采样频率的⼀半。

2、我在⽹上下载⼀个BP⽹络的教案,⾥⾯举了个例⼦,但是上⾯的数据归⼀化我没有看明⽩。

原始数据如下:⽉份 1 2 3 4 5 6销量2056 2395 2600 2298 1634 1600⽉份7 8 9 10 11 12销量1873 1478 1900 1500 2046 1556然后他就得出了:%以每三个⽉的销售量经归⼀化处理后作为输⼊P=[0.5152 0.8173 1.0000 ;0.8173 1.0000 0.7308;1.0000 0.7308 0.1390;0.7308 0.1390 0.1087;0.1390 0.1087 0.3520;0.1087 0.3520 0.0000;]';请问他是怎么归⼀化出这些数据的?谢谢了,归⼀化前P应为P1=[2056 2395 2600;2395 2600 2298;2600 2298 1634;2298 1634 1600;1634 1600 1873;1600 1873 1478]‘;取P1 中最⼤元素和最⼩元素分别为Pmax=2600,Pmin=1478,则归⼀化后P的对应元素值为P=(P1-Pmin)/(Pmax-Pmin)。

3、⽤zscore,标准化的⽬的是:使得平均值为0,标准差为1,这样可以使不同量纲的数据放在⼀个矩阵.>> A=magic(4)A =16 2 3 135 11 10 89 7 6 125 1>> [Z,MU,SIGMA] = zscore(A)Z =1.3770 -1.2509 -1.0585 0.8262-0.6426 0.4811 0.2887 -0.09180.0918 -0.2887 -0.4811 0.6426-0.8262 1.0585 1.2509 -1.3770MU =8.5000 8.5000 8.5000 8.5000SIGMA =5.4467 5.1962 5.1962 5.4467>> mean(Z)ans =1.0e-016 *-0.2776 0 0 0.5551>> std(Z)ans =1.0000 1.0000 1.0000 1.00004、关于神经⽹络(matlab)归⼀化的整理关于神经⽹络归⼀化⽅法的整理由于采集的各数据单位不⼀致,因⽽须对数据进⾏[-1,1]归⼀化处理,归⼀化⽅法主要有如下⼏种,供⼤家参考:(by james)1、线性函数转换,表达式如下:y=(x-MinValue)/(MaxValue-MinValue)说明:x、y分别为转换前、后的值,MaxValue、MinValue分别为样本的最⼤值和最⼩值。

归一化方法

归一化方法数据的归一化的目的是将不同量纲和不同数量级大小的数据转变成可以相互进行数学运算的具有相同量纲和相同数量级的具有可比性的数据。

数据归一化的方法主要有线性函数法、对数函数法、反余切函数法等线性函数法对于样本数据x (n ),n =1,2,……,N ,归一化后的样本数据可以采用三种表示方法,分别是最大最小值法、均值法和中间值法。

最大最小值法用于将样本数据归一化到[0,1]范围内;均值法用于将数据归一化到任意范围内,但最大值与最小值的符号不可同时改变;中间值法用于将样本数据归一化到[-1,1]范围内,三种方法的公式分别如式(2-1)、式(2-2)、式(2-3)所示。

()(()min(()))())min(())),1,2,,y k x k x n x n x n k N =--= (0-1) 1()1(),1,2,,,()N i x k y k A k N x x i N x ====∑(0-2) ()(),1,2,,1(max(()))2min(())midx n x k x y k k N x n -==- (0-3) max(())min((),1,2,,2)mid x n n n N x x +== (0-4)其中min(x (n ))表示样本数据x (n )的最小值,max(x (n ))表示样本数据x (n )的最大值,x 表示样本数据x (n )的均值,mid x 为样本数据x (n )的中间值,A 为调节因子,是一个常数,用于根据工程实际需要来调节样本数据的范围。

对数函数法对于样本数据x (n ),n =1,2,……,N,归一化后的样本数据y (n )用公式表示为:10()log (()),1,2,,y k x k k N == (0-5) 对数函数法主要用于数据的数量级非常大的场合。

反余切函数法对于样本数据x (n ),n =1,2,……,N ,归一化后的样本数据y (n )用公式表示为: 2()arctan(()),1,2,,y k x k k N π== (0-6)反余切函数法主要用于将角频率等变量转换到[-1,1]范围。

软考 归一化法计算公式

软考归一化法计算公式软考归一化法计算公式1. 归一化定义归一化是指将具有不同量纲的变量转化为无量纲的统一尺度的过程,常用于将不同变量进行比较和分析。

在软考中,归一化常用于对某些统计指标或得分进行标准化处理,以便进行比较和评估。

2. 计算公式在软考中,常用的归一化方法有以下几种:最小-最大归一化(Min-Max normalization)最小-最大归一化通过对原始数据进行线性变换,将数据映射到指定的范围(通常是[0,1]),公式如下:X_new = (X - X_min) / (X_max - X_min)其中,X是原始数据,X_new是归一化后的数据,X_min和X_max 分别是原始数据的最小值和最大值。

举例说明:假设某科目的成绩范围是0到100分,学生A得到的成绩是80分,那么他的归一化分数可以通过最小-最大归一化计算公式计算如下:X_new = (80 - 0) / (100 - 0) =因此,学生A的归一化分数为。

Z-Score归一化Z-Score归一化是通过对数据进行线性变换,将数据转化为均值为0,标准差为1的分布,公式如下:X_new = (X - X_mean) / X_std其中,X是原始数据,X_new是归一化后的数据,X_mean是原始数据的均值,X_std是原始数据的标准差。

举例说明:假设一批样本的身高数据,计算Z-Score值可以如下计算:身高数据: 170、180、165、175、160均值: (170 + 180 + 165 + 175 + 160) / 5 = 170标准差: sqrt^2 + ^2 + ^2 + ^2 + ^2) / 5) ≈样本i的Z-Score值 = (身高数据i - 均值) / 标准差样本1的Z-Score值 = (170 - 170) / = 0样本2的Z-Score值 = (180 - 170) / ≈样本3的Z-Score值 = (165 - 170) / ≈ -...通过Z-Score归一化,我们可以将不同样本间的身高数据进行标准化处理,方便进行比较和分析。

软考 归一化法计算公式

软考归一化法计算公式摘要:一、软考简介1.软考的定义2.软考的重要性3.软考的分类二、归一化法计算公式1.归一化法的定义2.归一化法的作用3.归一化法的计算公式4.归一化法的应用举例三、软考中归一化法的应用1.软考中归一化法的使用场景2.归一化法在软考中的具体应用四、总结1.归一化法在软考中的重要性2.归一化法的优点和局限性3.对未来软考中归一化法的展望正文:软考,全称为软件考试,是对从事软件开发、软件测试、系统集成等工作人员的一种能力测评。

它分为程序员、软件设计师、系统分析师等多个级别,每个级别都有相应的考试内容和难度。

在软考中,归一化法是一种常用的计算方法。

归一化法,简单来说,就是将一个有量纲的数值转化为无量纲的数值。

在软考中,归一化法主要用于处理数据,使得数据在0-1 之间,方便进行比较和计算。

归一化法的计算公式为:归一化值= (原值- 最小值)/ (最大值- 最小值)例如,假设某个数据集的最小值为10,最大值为50,某个数据点的值为30。

那么,这个数据点的归一化值就是(30 - 10)/ (50 - 10)= 2 / 4 = 0.5。

在软考中,归一化法常用于处理算法性能评价的数据。

例如,在评价算法A 和算法B 的性能时,我们可以通过归一化法将两个算法的运行时间转化为无量纲的数值,然后进行比较。

总的来说,归一化法在软考中起到了很重要的作用。

它能够将复杂的数据转化为简单的数值,方便进行比较和计算。

但是,归一化法也有局限性,它只能处理数值型数据,对于非数值型数据,归一化法就无法处理了。

归一化问题详解

归一化问题详解归一化问题归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量。

归一化是为了加快训练网络的收敛性,可以不进行归一化处理归一化的具体作用是归纳统一样本的统计分布性。

归一化在0-1之间是统计的概率分布,归一化在-1--+1之间是统计的坐标分布。

归一化有同一、统一和合一的意思。

无论是为了建模还是为了计算,首先基本度量单位要同一,神经网络是以样本在事件中的统计分别几率来进行训练(概率计算)和预测的,归一化是同一在0-1之间的统计概率分布;SVM是以降维后线性划分距离来分类和仿真的,因此时空降维归一化是统一在-1--+1之间的统计坐标分布。

当所有样本的输入信号都为正值时,与第一隐含层神经元相连的权值只能同时增加或减小,从而导致学习速度很慢。

为了避免出现这种情况,加快网络学习速度,可以对输入信号进行归一化,使得所有样本的输入信号其均值接近于0或与其均方差相比很小。

归一化是因为sigmoid函数的取值是0到1之间的,网络最后一个节点的输出也是如此,所以经常要对样本的输出归一化处理。

所以这样做分类的问题时用[0.9 0.1 0.1]就要比用要好。

但是归一化处理并不总是合适的,根据输出值的分布情况,标准化等其它统计变换方法有时可能更好。

主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

归一化方法(NormalizationMethod)1。

把数变为(0,1)之间的小数主要是为了数据处理方便提出来的,把数据映射到0~1范围之内处理,更加便捷快速,应该归到数字信号处理范畴之内。

2 。

把有量纲表达式变为无量纲表达式归一化是一种简化计算的方式,即将有量纲的表达式,经过变换,化为无量纲的表达式,成为纯量。

比如,复数阻抗可以归一化书写:Z = R + jωL = R(1 + jωL/R) ,复数部分变成了纯数量了,没有量纲。

网络分析与综合6-5 归一化和去归一化

RN zF

RN zF

LN zF

LN zF

CN

CN

zF

F

F z F

归一化

只考虑阻抗归一化

R 电阻: RN zF

L 电感:LN zF

电容:CN zFC 同时考虑频率和阻抗归一化

R 电阻: RN zF

电感: LN

F

zF 电容:CN zFFC

L

去归一化

去归一化值 频率去归一化 R L C

RN

LN

F

CN

F

阻抗去归一化

频率、阻抗同时 去归一化

§6-5 归一化和去归一化

北京邮电大学

电子工程学院 俎云霄

归一化

频率归一化

归一化频率 N F

F

——频率归一化因子,无量纲的量 ——实际频率

归一化复频率 sN

s

F

归一化

阻抗归一化

归一化阻抗 Z N

Z zF

zF

ห้องสมุดไป่ตู้

——阻抗归一化因子,无量纲的量 ——实际阻抗

Z

只考虑频率归一化 电阻:RN R 电感:LN F L 电容:CN FC

网络流行度预测中的特征归一化技术总结(六)

网络流行度预测中的特征归一化技术总结随着互联网的发展和普及,社交媒体和在线平台成为人们交流、获取信息和娱乐的主要方式。

在这个数字时代,预测网络内容的流行度变得至关重要,因为它有助于营销人员、广告商和决策者制定战略并优化他们的业务。

其中一个关键的技术是特征归一化,它能够对不同特性进行统一处理,提升预测的准确性和有效性。

本文将总结网络流行度预测中的特征归一化技术。

一、特征归一化的意义和作用特征归一化是指将特征数据按照一定的规则和方式进行调整和标准化,以消除不同特征之间的量纲和尺度差异。

这是因为网络内容中的特征往往具有高度异质性和多样性,例如转发数、点赞数、评论数、观看时间等等。

不同特性之间的差异可能导致预测结果的偏倚和不准确,因此特征归一化是必不可少的。

特征归一化的作用有多个方面。

首先,它能够提高预测模型的可解释性和可靠性。

通过将特征数据进行标准化处理,可以降低数据之间的相关性,减少特征之间的冗余信息,使得模型更易于理解和解释。

其次,特征归一化能够提升模型的预测准确性和泛化能力。

通过消除特征之间的量纲差异,模型能够更加准确地学习到特征之间的关系和趋势,从而提高预测的准确性。

最后,特征归一化能够提高模型的稳定性和可靠性。

在样本数据发生波动或特征分布发生变化时,特征归一化能够降低预测模型对这些变化的敏感度,使模型更加稳定和可靠。

二、特征归一化的常用方法特征归一化有多种方法,常用的包括最大最小值归一化、Z-score 标准化和小数定标标准化。

1. 最大最小值归一化最大最小值归一化是一种线性变换方法,将特征数据缩放到一个给定的最小值和最大值之间,通常是0和1。

它的公式如下:\[X'=\frac{X-X_{min}}{X_{max}-X_{min}}\]其中,\(X\)是原始特征数据,\(X_{min}\)和\(X_{max}\)分别是原始数据的最小值和最大值。

2. Z-score标准化Z-score标准化也称为标准差标准化,是一种将特征数据转化为标准正态分布的方法。

[转载]数据的规范化,归一化,标准化,正则化

![[转载]数据的规范化,归一化,标准化,正则化](https://img.taocdn.com/s3/m/7fac01fc162ded630b1c59eef8c75fbfc77d94d2.png)

[转载]数据的规范化,归一化,标准化,正则化数据的规范化,归一化,标准化,正则化,这几个破词整得我头晕,首先这些词就没规范好,对数据做实验更晕,网上狂搜一阵后,发现数据归一化,标准化,正则化,还是有差别数据规范化一种是针对数据库的解释规范化理论把关系应满足的规范要求分为几级,满足最低要求的一级叫做第一范式(1NF),在第一范式的基础上提出了第二范式(2NF),在第二范式的基础上又提出了第三范式(3NF),以后又提出了BCNF范式,4NF,5NF。

范式的等级越高,应满足的约束集条件也越严格。

另一种是就是对数据而言,一直想把数据的规范化的概念与归一化,标准化,正则化区分清楚。

纠结一阵后个人认为,数据的规范化包含了归一化,标准化,正则化,是一个统称(也有人把标准化做为统称,)。

针对不同的问题作用也不同。

数据规范化是数据挖掘中数据变换的一种方式,数据变换将数据转换或统一成适合于挖掘的形式。

而数据规范化是指将被挖掘对象的属性数据按比例缩放,使其落入一个小的特定区间(如[-1, 1]或[0,1])。

对属性值进行规范化常用于涉及神经网络或距离度量的分类算法和聚类算法中。

比如使用神经网络向后传播算法进行分类挖掘时,对训练元组中度量每个属性的输入值进行规范化有助于加快学习阶段的速度。

对于基于距离度量相异度的方法,数据规范化可以让所有的属性具有相同的权重。

数据规范化的常用方法有三种:按小数定标规范化、最小-最大值规范化和z-score规范化。

(1) 最小-最大规范化对原始数据进行线性变换。

zi=xi-xmin/xmax-xmin其中:zi为指标的标准分数,xi为某镇某指标的指标值,xmax为全部镇中某指标的最大值,xmin为全部镇中某指标的最小(2) z-score规范化也称零-均值规范化。

属性A的值是基于A的平均值与标准差规范化。

公式为:(x-mean(x))/std(x)(3) 小数定标规范化通过移动属性值的小数点位置进行规范化,通俗的说就是将属性值除以10的j次幂。

归一化与反归一化

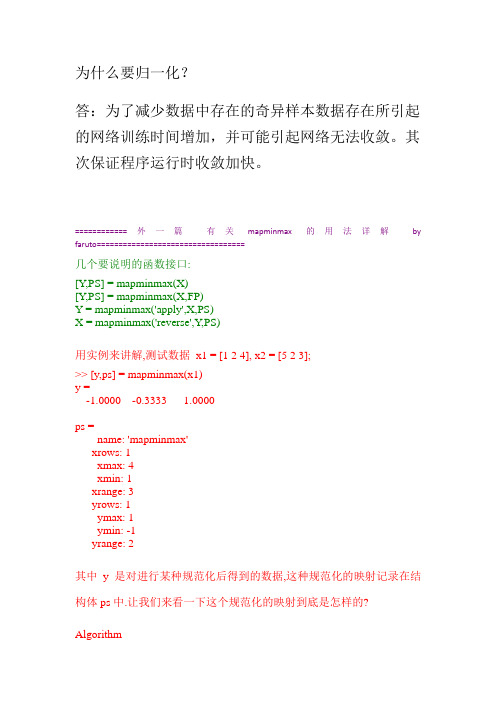

为什么要归一化?答:为了减少数据中存在的奇异样本数据存在所引起的网络训练时间增加,并可能引起网络无法收敛。

其次保证程序运行时收敛加快。

============外一篇有关mapminmax的用法详解by faruto==================================几个要说明的函数接口:[Y,PS] = mapminmax(X)[Y,PS] = mapminmax(X,FP)Y = mapminmax('apply',X,PS)X = mapminmax('reverse',Y,PS)用实例来讲解,测试数据x1 = [1 2 4], x2 = [5 2 3];>> [y,ps] = mapminmax(x1)y =-1.0000 -0.3333 1.0000ps =name: 'mapminmax'xrows: 1xmax: 4xmin: 1xrange: 3yrows: 1ymax: 1ymin: -1yrange: 2其中y是对进行某种规范化后得到的数据,这种规范化的映射记录在结构体ps中.让我们来看一下这个规范化的映射到底是怎样的? AlgorithmIt is assumed that X has only finite real values, and that the elements of each row are not all equal.∙y = (ymax-ymin)*(x-xmin)/(xmax-xmin) + ymin;∙[关于此算法的一个问题.算法的假设是每一行的元素都不想相同,那如果都相同怎么办?实现的办法是,如果有一行的元素都相同比如xt = [1 1 1],此时xmax = xmin = 1,把此时的变换变为y =ymin,matlab内部就是这么解决的.否则该除以0了,没有意义!]也就是说对x1 = [1 2 4]采用这个映射f: 2*(x-xmin)/(xmax-xmin)+(-1),就可以得到y = [ -1.0000 -0.3333 1.0000]我们来看一下是不是: 对于x1而言xmin = 1,xmax = 4;则y(1) = 2*(1 - 1)/(4-1)+(-1) = -1;y(2) = 2*(2 - 1)/(4-1)+(-1) = -1/3 = -0.3333;y(3) = 2*(4-1)/(4-1)+(-1) = 1;看来的确就是这个映射来实现的.对于上面algorithm中的映射函数其中ymin,和ymax是参数,可以自己设定,默认为-1,1;比如:>>[y,ps] = mapminmax(x1)>> ps.ymin = 0;>> [y,ps] = mapminmax(x1,ps)y =0 0.3333 1.0000ps =name: 'mapminmax'xrows: 1xmax: 4xmin: 1xrange: 3yrows: 1ymax: 1ymin: 0yrange: 1则此时的映射函数为: f: 1*(x-xmin)/(xmax-xmin)+(0),是否是这样的这回你可自己验证.O(∩_∩)O如果我对x1 = [1 2 4]采用了某种规范化的方式, 现在我要对x2 = [5 2 3]采用同样的规范化方式[同样的映射],如下可办到:>> [y1,ps] = mapminmax(x1);>> y2 = mapminmax('apply',x2,ps)y2 =1.6667 -0.3333 0.3333即对x1采用的规范化映射为: f: 2*(x-1)/(4-1)+(-1),(记录在ps中),对x2也要采取这个映射.x2 = [5,2,3],用这个映射我们来算一下.y2(1) = 2(5-1)/(4-1)+(-1) = 5/3 = 1+2/3 = 1.66667y2(2) = 2(2-1)/(4-1)+(-1) = -1/3 = -0.3333y2(3) = 2(3-1)/(4-1)+(-1) = 1/3 = 0.3333X = mapminmax('reverse',Y,PS)的作用就是进行反归一化,讲归一化的数据反归一化再得到原来的数据:>> [y1,ps] = mapminmax(x1);>> xtt = mapminmax('reverse',y1,ps)xtt =1 2 4此时又得到了原来的x1(xtt = x1);=================================Matlab 数字归一化问题(by yingzhilian)/viewthread.php?tid=26409&extra=page%3D1&sid=Xs3tJM-------------------------------------------------------归一化化定义:我是这样认为的,归一化化就是要把你需要处理的数据经过处理后(通过某种算法)限制在你需要的一定范围内。