模式识别5-线性分类器-第二讲

模式识别线性判别函数.ppt

5.3 感知准则函数(Perceptron)

可以用梯度下降法求使Jp(a)最小的a*。

J (a)

J p (a)

p

a

( y) yYe

Ye 是被a所错分的样本集。

5.3 感知准则函数(Perceptron)

函数Jp(a)在某点ak的梯度▽Jp(ak)是一 个向量,其方向是Jp(a)增长最快的方向, 而负梯度是减小最快的方向。 ∴ 沿梯度方向→极大值

yi

5.3 感知准则函数(Perceptron)

二.感知准则函数及其梯度下降算法

设有一组样本y1, …, yN(规范的 增广样本向量)。目的是求一a*,使 得a*Tyi>0, i=1, 2, …, N。

5.3 感知准则函数(Perceptron)

构造一个准则函数,

J

(a)

p

(aT

y)

yYe

希望根据给出的已知类别的训练样 本,确定参数w和w0.

5.1 引言

对分类器的性能 提出要求

利用各种

准则函数 目标函数

表示

使所确定的w和w0尽可能 满足这些要求。

对应于准则函数的最优化 (方法),求准则函数的

极值问题。

5.1 引言

线性判别函数分类的错误率可能比 贝叶斯错误率大,但它简单,容易实 现,它是P.R.中最基本的方法之一,人 们对它进行了大量的研究工作。

模式识别--第二讲 线性分类器

第 1 页第二讲 线性分类器一、 判别函数1、 决策论方法在模式识别中,如果根据模式特征信息,按照决策论的思路,以一定的数量规则来采取不同的分类决策,将待识别的模式划分到不同的类别中去,就称为模式识别的决策论方法。

在决策论方法中,特征空间被划分成不同的区域,每个区域对应一个模式类,称为决策区域(Decision Region )。

当我们判定待识别的模式位于某个决策区域时,就判决它可以划归到对应的类别中。

图1 决策区域需要注意的是:决策区域包含模式类中样本的分布区域,但不等于模式类的真实分布范围。

2、 判别函数如果特征空间中的决策区域边界(Decision Boundary )可以用一组方程0)( x i G来表示,则将一个模式对应的特征向量x 代入边界方程中的)(x i G ,确定其正负符号,就可以确定该模式位于决策区域边界的哪一边,从而可以判别其应当属于的类别,)(x i G 称为判别函数(Discriminant Function )。

判别函数的形式可以是线性的(Linear )或非线性(Non-linear)的。

第 2 页例如图2就显示了一个非线性判别函数,当G (x )>0时,可判别模式x ∈ω1;当G (x )<0时,可判别x ∈ω2。

图2 非线性判别函数非线性判别函数的处理比较复杂,如果决策区域边界可以用线性方程来表达,则决策区域可以用超平面(Hyperplane )来划分,无论在分类器的学习还是分类决策时都比较方便。

例如图3中的特征空间可以用两个线性判别函数来进行分类决策:当G 21(x )>0且G 13(x )>0时,x ∈ω2; 当G 13(x )<0且G 21(x )<0时,x ∈ω3; 当G 21(x )<0 且 G 13(x )>0时,x ∈ω1;当G 21(x )>0且G 13(x )<0时,x 所属类别无法判别。

模式识别第二章ppt课件

• 试探方法

凭直观感觉或经验,针对实际问题定义一种 相似性测度的阈值,然后按最近邻规则指定 某些模式样本属于某一个聚类类别。

– 例如对欧氏距离,它反映了样本间的近邻性,但 将一个样本分到不同类别中的哪一个时,还必须 规定一个距离测度的阈值作为聚类的判别准则。

精选ppt课件2021

• 特征选择的维数

在特征选择中往往会选择一些多余的特征,它增加了 维数,从而增加了聚类分析的复杂度,但对模式分类 却没有提供多少有用的信息。在这种情况下,需要去 掉相关程度过高的特征(进行降维处理)。

• 降维方法

– 结论:若rij->1,则表明第i维特征与第j维特征所反 映的特征规律接近,因此可以略去其中的一个特

– 距离阈值T对聚类结果的影响

精选ppt课件2021

17

2.3 基于试探的聚类搜索算法

2.3.2 最大最小距离算法

• 基本思想:以试探类间欧氏距离为最大 作为预选出聚类中心的条件。

• 病人的病程

– 名义尺度:指定性的指标,即特征度量时没有数量

关系,也没有明显的次序关系,如黑色和白色的关

系,男性和女性的关系等,都可将它们分别用“0”

和“1”来表示。

• 超过2个状态时,可精选用pp多t课个件2数021值表示。

8

2.2 模式相似性的测度和

聚类准则

2.2.1 相似Βιβλιοθήκη 测度• 目的:为了能将模式集划分成不同的类别,必须定义 一种相似性的测度,来度量同一类样本间的类似性和 不属于同一类样本间的差异性。

12

2.2 模式相似性的测度和

聚类准则

2.2.2 聚类准则

• 聚类准则函数法

– 依据:由于聚类是将样本进行分类以使类别间可 分离性为最大,因此聚类准则应是反映类别间相 似性或分离性的函数;

模式识别第二章(线性判别函数法)

2类判别区域 d21(x)>0 d23(x)>0 3类判别区域 d31(x)>0 d32(x)>0

0 1 2 3 4 5 6 7 8 9

x1

d23(x)为正

d32(x)为正

d12(x)为正

d21(x)为正

32

i j 两分法例题图示

33

3、第三种情况(续)

d1 ( x) d2 ( x)

12

2.2.1 线性判别函数的基本概念

• 如果采用增广模式,可以表达如下

g ( x) w x

T

x ( x1 , x 2 , , x d ,1)

w ( w1 , w 2 , , w d , w d 1 ) T

T

增广加权向量

2016/12/3

模式识别导论

13

2.1 判别函数(discriminant function) 1.判别函数的定义 直接用来对模式进行分类的准则函数。

模式识别导论

11

2.2.1 线性判别函数的基本概念

• 在一个d维的特征空间中,线性判别函数的

一般表达式如下

g ( x ) w1 x1 w 2 x 2 w d x d w d 1

g ( x ) w x w d 1

T

w为 加 权 向 量

2016/12/3

模式识别导论

1

d1 ( x ) d3 ( x )

2

3

d2 ( x) d3 ( x)

34

多类问题图例(第三种情况)

35

上述三种方法小结:

当c

但是

3 时,i j

法比

i i

法需要更多

模式识别之二次和线性分类器课件

线性分类器利用训练数据集学习得到 一个线性函数,该函数可用于对新数 据进行分类。分类决策边界是一个超 平面,将不同类别的数据分隔开来。

线性分类器数学模型

线性函数

优化目标

正则化

线性分类器使用的线性函数通 常表示为权重向量和特征向量 的内积加上偏置项,即y = w^Tx + b,其中y是预测类别 ,w是权重向量,x是特征向量 ,b是偏置项。

模式识别之二课次件和线性分类器

contents

目录

• 引言 • 二次分类器原理 • 线性分类器原理 • 二次与线性分类器比较 • 二次和线性分类器应用案例 • 总结与展望

01

引言

模式识别概述

模式

01

在感知或观察事物时,人们所发现的事物之间规律性的关系或

特征。

模式识别

02

利用计算机对输入的信号进行分类或描述,以实现自动识别目

01

深度学习在模式识别 中的应用

深度学习技术为模式识别提供了新的 解决方案,能够自动提取数据的深层 特征,提高识别精度。

02

多模态数据融合

利用多模态数据融合技术,将不同来 源、不同类型的数据进行融合,提高 模式识别的性能和鲁棒性。

03

迁移学习在模式识别 中的应用

迁移学习技术可以将在一个任务上学 到的知识迁移到另一个任务上,从而 加速模型训练,提高识别效率。

自然语言处理领域应用案例

1 2

文本分类

通过训练二次和线性分类器,对文本进行分类, 如新闻、广告、评论等,提高信息处理的效率。

情感分析

利用分类器对文本中的情感进行识别和分析,为 企业了解用户需求、改进产品提供参考。

3

机器翻译

结合分类器对源语言进行识别和转换,实现不同 语言之间的自动翻译,促进跨语言交流。

模式识别(国家级精品课程讲义)

1.1 概述-模式识别的基本方法

一、统计模式识别

理论基础:概率论,数理统计 主要方法:线性、非线性分类、Bayes决策、聚类分析 主要优点:

1)比较成熟 2)能考虑干扰噪声等影响 3)识别模式基元能力强 主要缺点: 1)对结构复杂的模式抽取特征困难 2)不能反映模式的结构特征,难以描述模式的性质 3)难以从整体角度考虑识别问题

模式类(Class):具有某些共同特性的模式 的集合。

模式识别的例子

计算机自动诊断疾病:

1. 获取情况(信息采集) 测量体温、血压、心率、 血液化验、X光透射、B超、心电图、CT等尽可 能多的信息,并将这些信息数字化后输入电脑。 当然在实际应用中要考虑采集的成本,这就是 说特征要进行选择的。

2. 运行在电脑中的专家系统或专用程序可以分析 这些数据并进行分类,得出正常或不正常的判 断,不正常情况还要指出是什么问题。

5元

反 射 光 波 形

10元

20元 50元 100元

1 2 3 4 5 6 7 8

1.1 概述-系统实例

数据采集、特征提取:

长度、宽度、磁性、磁性的位置,光反射亮度、光 透射亮度等等

特征选择:

长度、磁性及位置、反射亮度

分类识别:

确定纸币的面额及真伪

1.1 概述-系统实例

训练集:是一个已知样本集,在监督学习方法 中,用它来开发出模式分类器。

模式识别

★ 相关学科

●统计学 ●概率论 ●线性代数(矩阵计算)

●形式语言 ●人工智能 ●图像处理 ●计算机视觉

等等

讲授课程内容及安排

第一章 第二章 第三章 第四章 第五章 第六章 第七章

引论 聚类分析 判别域代数界面方程法 统计判决 学习、训练与错误率估计 最近邻方法 特征提取和选择 上机实习

模式识别复习提纲2

(2)使用最近邻规则将所有样本分配到各聚类中心所代表的类

ωj(l)中,各类所包含的样本数为Nj(l);

(3)计算各类的重心(均值向量),并令该重心为新的聚类中

心,即:

Zj(l+1)=N-j(1l)∑xi j=1,2,…,c xi∈ωj(l)

(4)如zj(l+1)≠zj(l),表示尚未得到最佳聚类结果,则返回步骤 (2),继续迭代;

(1)绝对可分:

➢ 每个模式类都可用单一判别函数与其他模式类区分开。 ➢ 如是M类分类,则有M个判别函数

x2

d3(X)=0

1

d1(X)=0

2 d2(X)=0

3

x1

判别函数的性质:

di(X)=Wi*TX*

>0, X∈ωi

<0, =0,

X不∈定ωj,j≠i

i,j=1,2,……,M

在模式空间S中,若给定N个样本,如能按 照样本间的相似程度,将S划分为k个决策 区域Si(i=1,2,…..,k),使得各样本 均能归入其中一个类,且不会同时属于两 个类。即 S1∪S2∪S3∪……∪Sk=S

Si∩Sj=0,i≠j

数据聚类的依据是样本间的“相似度”

2、数据聚类的特点:

无监督学习 数据驱动 聚类结果多样化:特征选取、相似度的度 量标准,坐标比例;

dij(X)= -dji(X)

分类决策规则:

x2

d23(X)=0 1 3

d12(X)=0

2 d13(X)=0

IR

x1

分类决策规则:

X∈ω1: d12(X)>0, d13(X)>0,

X∈ω2: d21(X)>0, d23(X)>0,

模式识别:线性分类器

模式识别:线性分类器一、实验目的和要求目的:了解线性分类器,对分类器的参数做一定的了解,理解参数设置对算法的影响。

要求:1. 产生两类样本2. 采用线性分类器生成出两类样本的分类面3. 对比线性分类器的性能,对比参数设置的结果二、实验环境、内容和方法环境:windows 7,matlab R2010a内容:通过实验,对生成的实验数据样本进行分类。

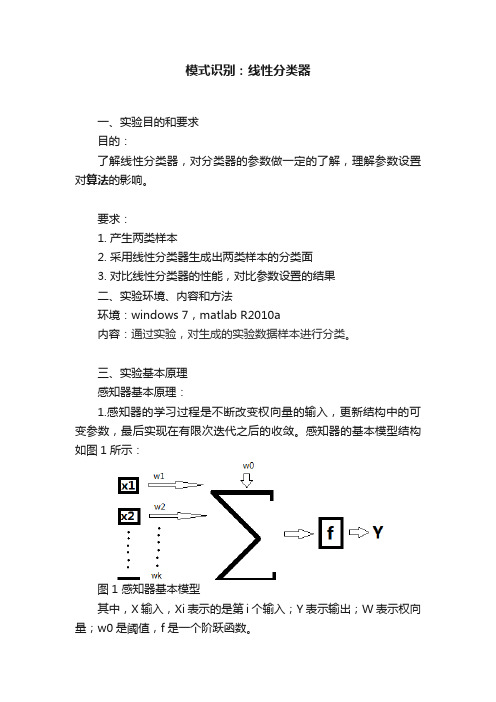

三、实验基本原理感知器基本原理:1.感知器的学习过程是不断改变权向量的输入,更新结构中的可变参数,最后实现在有限次迭代之后的收敛。

感知器的基本模型结构如图1所示:图1 感知器基本模型其中,X输入,Xi表示的是第i个输入;Y表示输出;W表示权向量;w0是阈值,f是一个阶跃函数。

感知器实现样本的线性分类主要过程是:特征向量的元素x1,x2,……,xk是网络的输入元素,每一个元素与相应的权wi相乘。

,乘积相加后再与阈值w0相加,结果通过f函数执行激活功能,f为系统的激活函数。

因为f是一个阶跃函数,故当自变量小于0时,f= -1;当自变量大于0时,f= 1。

这样,根据输出信号Y,把相应的特征向量分到为两类。

然而,权向量w并不是一个已知的参数,故感知器算法很重要的一个步骤即是寻找一个合理的决策超平面。

故设这个超平面为w,满足:(1)引入一个代价函数,定义为:(2)其中,Y是权向量w定义的超平面错误分类的训练向量的子集。

变量定义为:当时,= -1;当时,= +1。

显然,J(w)≥0。

当代价函数J(w)达到最小值0时,所有的训练向量分类都全部正确。

为了计算代价函数的最小迭代值,可以采用梯度下降法设计迭代算法,即:(3)其中,w(n)是第n次迭代的权向量,有多种取值方法,在本设计中采用固定非负值。

由J(w)的定义,可以进一步简化(3)得到:(4)通过(4)来不断更新w,这种算法就称为感知器算法(perceptron algorithm)。

可以证明,这种算法在经过有限次迭代之后是收敛的,也就是说,根据(4)规则修正权向量w,可以让所有的特征向量都正确分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

感知器模型 感知准则函数及梯度下降法

Least Squares Methods Support Vector Machines

The Perceptron Algorithm (cont.)

新内容

迭代过程为: ① 首先任意指定初始权向量w(0); ② 如果第k步不能满足 X T ( Xw(k ) b) 0,则按下式求第(k+1)步 的权向量w(k+1):

w(k 1) w(k ) rk (bk w(k ) xk ) xk

T

Widrow-Hoff算法

H-K(Ho-Kashyap)迭代算法

单样本修正法

rk rk0

Widrow-Hoff

批量样本修正——迭代算法

w1 , 任意初始值 T w ( k 1 ) w ( k ) X ( Xw(k ) b) k

新内容

迭代过程为: ① 首先任意指定初始权向量w(0); ② 如果第k步不能满足 X T ( Xw(k ) b) 0,则按下式求第(k+1)步 的权向量w(k+1):

e.g.,: t

c t

9

新内容

最小平方误差准则

问题: 一次准则函数及其算法(如感知器算法):

适用于线性可分的情况

如果是线性不可分的,分类过程将不收敛

在实际问题中,往往无法事先知道源自式集能否线性可分。能否找到一种算法,使之能够

测试出模式样本集是否线性可分

并且对线性不可分的情况也能给出“次最优”的解

命名由来:这一准则函数是20世纪50年代由Rosenblatt

提出来的,试图用于脑模型感知器中,故一般称为感知 器准则函数。

5

新内容

The Perceptron Algorithm (cont.)

Gradient descent algorithm

The Cost Function

J (w*) min(J (w)) min( (w x))

如果方程组有唯一解,极小值点即是该解,说明训练模式集

是线性可分的;

如果方程组无解,极小值点是最小二乘解。在这里,最小二

乘的含义是对于给定的b,使J极小。在相当多的情况下等价 于误分模式数目最少。

MSE准则函数的伪逆解

2 2 N

新内容

MSE准则函数 J (W ) || e || || XW b || W X i bi min i 1

若b的某些分量取得不当,所求得的W可能不稳定

另b各分量选取不当也会影响收敛速度

新内容

批量样本及单样本修正法:余量b——常矢量

H-K(Ho-Kashyap)算法

H-K(Ho-Kashyap)迭代算法

新内容

H-K(Ho-Kashyap)迭代算法

MSE准则函数

新内容

H-K(Ho-Kashyap)算法

When Y=0 (empty set) a solution is achieved and

J ( w) 0

x 1 if x Y and x 1 x 1 if x Y and x 2

J ( w) 0

4

新内容

The Perceptron Algorithm (cont.)

T xY

梯度下降法,就是利用负梯度方向来决定每次迭代的新的

搜索方向,每次迭代能使待优化的目标函数逐步减小。梯 度下降法是2范数下的最速下降法。

最速下降法的一种简单形式是:x(k+1)=x(k)-a*g(k),其中a

称为学习速率,可以是较小的常数;g(k)是x(k)的梯度。

直观的说,就是在一个有中心的等值线中,从初始值开始,

MSE准则函数的迭代解

w*=X+b, X+=(XTX)-1XT,计算量大

实际中常用梯度下降法:

J(W) 2 W T X i bi X i 2 X T ( XW b) i 1

N

新内容

w0 , 任意初始值 批量样本修正法 T w ( k 1 ) w ( k ) X ( Xw(k ) b) k w0 , 任意初始值 T w ( k 1 ) w ( k ) r ( b w ( k ) xk ) xk k k

w(k 1) w(k ) k X ( Xw(k ) b)

T

可以证明:如果 k 1 / k ,其中 1 是任意正常数,则这个 算法产生的权向量序列wk,k=1,2,…,收敛于满足方程式 J(W) 0

单样本修正——迭代算法

w0 , 任意初始值 T w ( k 1 ) w ( k ) r ( b w ( k ) xk ) xk k k

1 X # ( X T X ) 1 X T 1 1 1 1 2 3 / 2 1 / 2 1 / 2 1 / 2

xY

J ( w) J ( w) ( x) w xY

(1)

The iteration formula is: w(t 1) w(t ) t J (w)

w(t 1) w(t ) t x

xY

Where Y is the subset of the vectors wrongly classified by w.

WTXi>0

引入余量(目标向量) b=[b1, b2, …, bN]T, bi为任意给定正 常数, WTXi = bi >0 N个线性方程的的矩阵表示:

WTXi=b

一般N>n,矛盾方 程组,没有精确解

最小平方误差准则

定义误差向量e=XW-b≠0

新内容

: 定义平方误差准则函数J(w):

2 2 N i 1

J (W ) || e || || XW b || W X bi i T

2

最小二乘近似解(MSE解):

w* arg min ( J s (W ))

w

MSE方法的思想:对每个样本,设定一个“理想”的判别函 数输出值,以最小平方误差为准则求最优权向量

新内容

平方误差准则函数

每次沿着垂直等值线方向移动一个小的距离,最终收敛在 中心。

6

新内容

The Perceptron Algorithm (cont.)

Gradient descent algorithm

The Cost Function

w(t 1) w(t ) t * g (t )

T

J (w) (w x)

解决思路:对线性不可分样本集,求一解矢量使得错

分的模式数目最少

最小平方误差准则

新内容

规范化增广样本向量Xi,增广权向量w,正确分类要求:

wTXi>0, i=1,…,N 线性分类器设计求一组N个线性不等式的解w* 样本集增广矩阵X及一组N个线性不等式的的矩阵表示:

X 1 X 11 X 12 .... X 1n X 2 X 21 ... ... ... X ..... ... ... ... ... X N X N 1 X N 2 ... X Nn

Dr. Jing Bai baijing_nun@

Review

线性分类器的目标 基本步骤 预备知识 线性可分性 样本的规范化 解向量和解区 对解区的限制 感知器模型 感知器算法 两类问题(实例) 多类问题(实例)

复 习

2

Outlines

Introduction

2 2 N i 1

J (W ) || e || || XW b || W T X bi i

2

分析准则函数,W的优化就是使J(W)最小,称为MSE准则。 若WTXi=bi, (i=0,1,2,…,N) ,那么此时的J=min(J)=0; 若某些Xi有WTXi ≠ bi ,则J>0 。当b给定后,可以采用最 优化技术搜索极小值点以求解等式方程组WTXi=bi。

w(k) w(k+1) O w

8

梯度法的示意图

新内容

The perceptron algorithm converges in a finite

number of iteration steps to a solution if

lim k , lim k

2 t k 0 t k 0 t t

【 例 】 已 知 两 类 训 练 样 本 : w1:(0,0)T,(0,1)T; w2:(1,0)T,(1,1)T,使用最小均方误差算法求解解向 0 0 1 1 量w*。 X 0 1 0 1 解 训练样本的增广矩阵: 1 1 1 1 e1的各分量均为0,则w(1)就是所求的解向量

T

2

对准则函数求导并令其为零,有

J(W) 2 W T X i bi X i 2 X T ( XW b) 0 i 1

N

解上方程得准则函数极小化的必要条件: XTXW=XTb

若( X T X ) 1 存在,w* ( X T X ) 1 X T b X b, X ( X T X ) 1 X T T 1 * T T T T 若 ( X X ) 不存在, w ( X X ) X b , ( X X ) 为 X X的广义逆矩阵

Our goal:

新内容

w x( )0 x

T

i j