聚类算法matlab程序

kmeans聚类算法检测故障的matlab程序

kmeans聚类算法检测故障的matlab程序K-means聚类算法是一种常见的无监督学习算法,可用于对数据集进行分类或聚类。

将其应用于故障检测是一种有效的技术,它可以通过识别数据中的异常模式来检测故障。

本文将介绍如何使用Matlab 实现K-means聚类算法以检测故障。

一、程序概述以下是一个简单的Matlab程序,该程序使用K-means聚类算法来检测故障。

该程序首先读取一组传感器数据,然后应用K-means算法对这些数据进行聚类,最后识别出异常模式以检测故障。

二、数据预处理在运行K-means聚类算法之前,需要对数据进行预处理。

这包括去除噪声、填充缺失值、归一化数据等。

在本程序中,我们将使用Matlab内置的函数来执行这些步骤。

三、K-means聚类算法K-means算法的输入是一组数据点及其相应的类别标签。

算法将数据点分配给最近的类别中心(即质心),并更新质心。

这个过程重复进行,直到算法收敛或达到预设的迭代次数。

在Matlab中,可以使用`kmeans`函数来执行K-means聚类算法。

为了选择最佳的聚类数量(即K值),可以使用一些启发式方法,如肘部法则或轮廓系数。

在本程序中,我们使用轮廓系数来确定最佳的K 值。

四、故障检测一旦K-means聚类算法完成并得到聚类结果,就可以使用这些结果进行故障检测。

异常模式通常包括在正常状态下不会出现的极端值或模式变化。

可以使用一些统计测试(如Z-score测试)来检测这些异常模式。

在Matlab中,可以使用`findpeaks`函数来找到数据中的峰值和谷值,并使用这些信息来检测异常模式。

对于每个聚类,我们可以计算每个数据点的Z-score,并使用这些值来标记异常数据点。

一旦标记完异常数据点,就可以对这些数据进行可视化,以便更直观地检测故障。

五、结果展示和优化程序运行结束后,可以通过可视化工具(如Matlab内置的`scatter`函数)将结果展示出来。

Matlab中的聚类分析与分类算法实现

Matlab中的聚类分析与分类算法实现导语:在数据科学和机器学习领域,聚类分析和分类算法是两个重要的主题。

数据的聚类能够将数据集中相似的观测值归为一类,而分类算法则是用于预测未知样本的类别标签。

在Matlab这一强大的数学计算工具中,我们可以利用其丰富的函数库和灵活的编程环境来实现聚类分析和分类算法。

一、聚类分析算法的实现1. K-means聚类算法K-means是最常用的聚类算法之一,它将数据集划分为k个簇,使得同一个簇内的数据点之间的距离最小化,并且不同簇之间的距离最大化。

在Matlab中,我们可以使用kmeans函数来实现K-means聚类算法。

该函数需要输入样本数据矩阵和簇数k,然后返回每个样本点所属的簇标签。

2. 层次聚类算法层次聚类是一种基于距离度量的聚类算法,它将样本逐步合并成越来越大的簇,直到所有样本都被分为一个簇。

在Matlab中,我们可以使用linkage函数来计算样本之间的距离,然后使用cluster函数进行层次聚类。

该函数可以根据指定的距离度量方法(如欧氏距离或曼哈顿距离)和链接方法(如单链接、完全链接或平均链接)对样本进行聚类。

3. DBSCAN聚类算法DBSCAN是一种基于密度的聚类算法,它可以发现任意形状的簇,并且对噪声数据有较高的鲁棒性。

在Matlab中,我们可以使用DBSCAN函数来实现DBSCAN聚类算法。

该函数需要输入样本数据矩阵、密度阈值和邻近距离等参数,然后返回每个样本点所属的簇标签。

二、分类算法的实现1. 决策树分类算法决策树是一种基于判断树结构的分类算法,它通过一系列的决策节点将样本逐步分类到不同的叶节点中。

在Matlab中,我们可以使用fitctree函数来建立决策树分类模型。

该函数需要输入训练数据矩阵和对应的类别标签,然后返回一个可以用于预测的决策树模型。

2. 支持向量机分类算法支持向量机是一种基于间隔最大化的分类算法,它通过在特征空间中找到一个最优超平面来进行分类。

层次聚类 matlab

层次聚类matlabMatlab中的层次聚类算法层次聚类是一种无监督学习算法,它将数据集中的样本按照相似度进行分组。

Matlab提供了丰富的函数和工具箱来实现层次聚类算法。

本文将一步一步回答如何使用Matlab进行层次聚类,并介绍一些相关的概念和技术。

第一步:准备数据首先,我们需要准备要聚类的数据。

一般来说,数据可以是一个矩阵,其中每一行表示一个样本,每一列表示一个特征。

例如,我们可以有一个100x3的矩阵,其中有100个样本和3个特征。

第二步:计算相似度矩阵层次聚类需要通过计算样本之间的相似度来确定它们的聚类关系。

常见的相似度计算方法包括欧几里得距离、曼哈顿距离和相关系数等。

在Matlab中,可以利用pdist函数来计算样本之间的距离。

例如,使用欧几里得距离可以使用以下代码计算相似度矩阵:matlabdistMatrix = pdist(data, 'euclidean');这将返回一个距离矩阵,其中包含了样本之间的欧几里得距离。

第三步:构建聚类树在得到相似度矩阵之后,接下来需要使用linkage函数构建聚类树。

聚类树是一棵二叉树,每个节点表示一个聚类组合。

在Matlab中,聚类树可以通过以下方式构建:matlabtree = linkage(distMatrix);这将返回一个聚类树,其中包含了每个节点的连接关系和连接距离。

第四步:确定聚类结果最后,我们可以使用cluster函数来确定聚类结果。

Matlab中的cluster 函数可以根据给定的聚类树和聚类数量来划分样本。

例如,可以使用以下代码将数据分成3个聚类:matlabclusters = cluster(tree, 'maxclust', 3);这将返回一个向量,其中元素的值表示每个样本所属的聚类。

除了上述介绍的基本步骤之外,Matlab提供了更多高级功能和选项来定制层次聚类算法。

例如,我们可以选择不同的相似度度量方法、聚类算法、距离阈值等。

matlab kmeans聚类算法代码

一、引言在机器学习和数据分析中,聚类是一种常用的数据分析技术,它可以帮助我们发现数据中的潜在模式和结构。

而k均值(k-means)聚类算法作为一种经典的聚类方法,被广泛应用于各种领域的数据分析和模式识别中。

本文将介绍matlab中k均值聚类算法的实现和代码编写。

二、k均值(k-means)聚类算法简介k均值聚类算法是一种基于距离的聚类算法,它通过迭代的方式将数据集划分为k个簇,每个簇内的数据点与该簇的中心点的距离之和最小。

其基本思想是通过不断调整簇的中心点,使得簇内的数据点与中心点的距离最小化,从而实现数据的聚类分布。

三、matlab实现k均值聚类算法步骤在matlab中,实现k均值聚类算法的步骤如下:1. 初始化k个簇的中心点,可以随机选择数据集中的k个点作为初始中心点。

2. 根据每个数据点与各个簇中心点的距离,将数据点分配给距离最近的簇。

3. 根据每个簇的数据点重新计算该簇的中心点。

4. 重复步骤2和步骤3,直到簇的中心点不再发生变化或者达到预定的迭代次数。

在matlab中,可以通过以下代码实现k均值聚类算法:```matlab设置参数k = 3; 设置簇的个数max_iter = 100; 最大迭代次数初始化k个簇的中心点centroids = datasample(data, k, 'Replace', false);for iter = 1:max_iterStep 1: 计算每个数据点与簇中心点的距离distances = pdist2(data, centroids);Step 2: 分配数据点给距离最近的簇[~, cluster_idx] = min(distances, [], 2);Step 3: 重新计算每个簇的中心点for i = 1:kcentroids(i, :) = mean(data(cluster_idx == i, :)); endend得到最终的聚类结果cluster_result = cluster_idx;```四、代码解释上述代码实现了k均值聚类算法的基本步骤,其中包括了参数设置、簇中心点的初始化、迭代过程中的数据点分配和中心点更新。

dbscan聚类算法matlab代码

dbscan聚类算法matlab代码这是一个dbscan聚类算法的matlab代码,运行环境为matlabR2010a:% dbscan聚类算法% 输入:% X 简单点周围扩展点的数据集% eps 点之间的最小距离% minpts 简单点的最小个数% 输出:% C 类别索引% 功能:% 使用的dbscan聚类算法function C = dbscan(X, eps, minpts)% 初始化C = zeros(size(X,1),1);% 计算圆形区域内的数据点k = 0;for i = 1:size(X,1)if ~any(C == i)D = dist(X(i,:),X);% 搜索圆形区域内的数据点Id = find(D <= eps);if length(Id) < minptsC(i) = 0;elsek = k+1;G = regiongrow(X,Id,i);C(G) = k;endendendend% 计算点之间的欧式距离function D = dist(a,b)D = sqrt(sum((a-b).^2));end% regiongrow函数function G = regiongrow(X,Id,i) G = Id;% 搜索邻域并将新点加入while trueL = length(G);for j = 1:L% 搜索G中点的邻域D = dist(X(G(j),:),X);% 找出G中点的邻域内未被选中的点 Id2 = find(D <= eps);% 把未被选中的点加入到G中for k = 1:length(Id2)if ~any(G == Id2(k))G = [G Id2(k)];endendend% 如果G的长度没有变化,则退出循环 if L == length(G)breakendendend。

dbscan聚类算法matlab代码

dbscan聚类算法matlab代码DBSCAN聚类算法是一种基于密度的聚类算法,它能够自动识别数据中的簇,并将噪声数据排除在外。

在本文中,我们将介绍如何使用Matlab实现DBSCAN聚类算法。

我们需要准备数据。

在本例中,我们将使用一个包含1000个数据点的二维数据集。

我们可以使用Matlab的rand函数生成这些数据点。

代码如下:```matlabdata = rand(1000,2);```接下来,我们需要定义DBSCAN算法的参数。

DBSCAN算法有两个重要的参数:半径(eps)和最小点数(minPts)。

半径是指在该半径内的数据点被认为是邻居点。

最小点数是指在该半径内至少需要有多少个邻居点才能形成一个簇。

在本例中,我们将设置eps为0.1,minPts为5。

代码如下:```matlabeps = 0.1;minPts = 5;```接下来,我们可以使用Matlab的DBSCAN函数来执行聚类。

DBSCAN函数需要三个参数:数据集、半径和最小点数。

该函数将返回一个向量,其中每个元素表示该数据点所属的簇的编号。

如果该数据点被认为是噪声,则其簇编号为0。

代码如下:```matlabclusterIdx = DBSCAN(data,eps,minPts);```我们可以使用Matlab的scatter函数将数据点可视化。

我们可以使用不同的颜色来表示不同的簇。

代码如下:```matlabscatter(data(:,1),data(:,2),10,clusterIdx,'filled');```完整的Matlab代码如下:```matlabdata = rand(1000,2);eps = 0.1;minPts = 5;clusterIdx = DBSCAN(data,eps,minPts);scatter(data(:,1),data(:,2),10,clusterIdx,'filled');```通过运行上述代码,我们可以得到一个包含不同颜色的数据点的图像,每种颜色表示一个簇。

gmm聚类算法matlab代码

概述:1. 介绍GMM聚类算法的背景和应用领域a. GMM聚类算法是一种基于高斯混合模型的非监督学习方法,用于将数据集分成多个高斯分布的类别。

它在图像处理、生物信息学、金融等领域有着广泛的应用。

b. 与K均值聚类算法相比,GMM聚类算法具有更高的灵活性和鲁棒性,能够处理非球形的类别边界和重叠的类别。

GMM聚类算法的原理:2. GMM聚类算法的数学模型a. 在GMM聚类算法中,假设数据集是由若干个高斯分布组成的混合模型,每个高斯分布对应一个类别。

对于一个给定的数据点,它属于每个类别的概率可以用高斯分布来表示。

b. 通过最大化数据集的似然函数,可以使用EM(Expectation Maximization)算法来估计高斯分布的参数,从而得到每个类别的均值和协方差矩阵。

实现GMM聚类算法的Matlab代码:3. 数据的准备和预处理a. 在实现GMM聚类算法之前,首先需要准备数据集并进行预处理。

可以从外部文件中读取数据,或者通过随机生成数据来进行测试。

b. 针对不同的数据集,可能需要进行归一化、去除异常值等预处理操作。

4. GMM聚类算法的实现步骤:a. 初始化高斯分布的参数i. 随机初始化每个高斯分布的均值和协方差矩阵。

b. 使用EM算法进行迭代优化i. E步骤:计算每个数据点属于每个类别的概率。

ii. M步骤:根据E步骤的结果更新高斯分布的参数。

c. 重复进行E步骤和M步骤,直到收敛或达到最大迭代次数。

5. Matlab代码示例:a. 读取数据集i. 使用Matlab内置的函数`load`或`csvread`进行数据读取。

b. 初始化高斯分布的参数i. 使用`rand`函数进行随机初始化。

c. 实现EM算法的迭代优化i. 编写E步骤和M步骤的代码,并使用循环进行迭代。

d. 可视化聚类结果i. 使用`plot`函数将聚类结果可视化展示。

应用GMM聚类算法进行数据分析:6. 使用GMM聚类算法对实际数据进行分析a. 选择合适的数据集,并应用编写好的GMM聚类算法进行实验。

kmeans算法的matlab代码

K-means算法是一种常用的聚类算法,在数据挖掘和机器学习领域有着广泛的应用。

它的主要思想是将数据分成K个簇,使得同一簇内的数据相似度较高,不同簇之间的数据相似度较低。

在本文中,我们将介绍K-means算法的原理,并给出其在Matlab中的实现代码。

下面是K-means算法在Matlab中的代码实现:1. 初始化簇中心```function [centroids] = initCentroids(X, K)随机初始化K个簇中心[m, n] = size(X);centroids = X(randperm(m, K), :);end```2. 分配样本到最近的簇```function [idx] = findClosestCentroids(X, centroids)根据当前簇中心,将每个样本分配到最近的簇中K = size(centroids, 1);idx = zeros(size(X,1), 1);m = size(X,1);for i=1:mmin_dist = inf;for j=1:Kdist = sum((X(i,:) - centroids(j,:)).^2);if dist < min_distmin_dist = dist;idx(i) = j;endendendend```3. 更新簇中心```function [centroids] =puteCentroids(X, idx, K) 对每个簇重新计算簇中心[m, n] = size(X);centroids = zeros(K, n);for i=1:Kcentroids(i, :) = mean(X(idx == i, :));endend```4. K-means算法主函数```function [centroids, idx] = runkMeans(X, initial_centroids,max_iters)K-means算法的主函数[m, n] = size(X);K = size(initial_centroids, 1);centroids = initial_centroids;previous_centroids = centroids;idx = zeros(m, 1);for i=1:max_iters计算每个样本到簇中心的最短距离idx = findClosestCentroids(X, centroids);更新簇中心centroids =puteCentroids(X, idx, K);endend```通过以上代码,我们可以在Matlab中实现K-means算法,并对数据进行聚类分析。

kmeans聚类算法检测故障的matlab程序 -回复

kmeans聚类算法检测故障的matlab程序-回复现如今,随着科技的发展和应用线上的普及,各行各业都离不开计算机和电子设备的支持。

然而,这些设备往往在使用过程中会出现各种各样的故障,而这些故障的发现和解决对于设备的正常运行至关重要。

为了能够尽早发现和解决这些故障,工程师们开发了各种各样的故障检测算法和工具。

本文将介绍一种常用的故障检测算法——K-means聚类算法,并以Matlab为例,详细说明如何使用K-means聚类算法来检测故障。

首先,让我们来了解一下K-means聚类算法的基本原理。

K-means算法是一种常用的无监督学习算法,用于将一组数据点分成K个簇。

算法的基本思想是将数据点划分到具有相似特征的簇中,以使得同一簇内的数据点距离尽可能小,而不同簇之间的数据点距离尽可能大。

具体来说,K-means算法的步骤如下:1. 随机选择K个初始聚类中心。

2. 对于每个数据点,计算其与每个聚类中心的距离,将其划分到与之距离最近的聚类中心所代表的簇中。

3. 更新聚类中心,将每个簇内的数据点的均值作为新的聚类中心。

4. 重复步骤2和步骤3,直到达到终止条件(如达到最大迭代次数或各个聚类中心的更新幅度小于某个阈值)。

K-means算法的一个重要应用领域就是故障检测。

在故障检测中,我们可以将每个数据点视为一个设备的状态信息,而不同的簇即代表不同的故障类型。

通过观察和分析每个簇内的数据点,我们可以推断出设备可能存在的故障类型,并采取相应的修复措施。

接下来,我们将以Matlab为例,演示如何使用K-means聚类算法进行故障检测。

首先,我们准备一个包含设备状态信息的数据集。

假设我们有N个设备,每个设备具有M个状态特征。

我们将这些特征组合成一个N×M的矩阵,其中每一行代表一个设备的状态信息。

在Matlab中,我们可以使用`kmeans`函数来实现K-means聚类算法。

该函数的使用方法如下:matlab[idx, C] = kmeans(X, K);其中,`X`是输入的数据集,`K`是指定的簇数量。

matlab实现Kmeans聚类算法

kmeans函数:输入为类别数量k和数据矩阵A;输出为聚类结果A,和迭代次数,并将聚类结果数据以excel形式保存在工作路径下function km(k,A)%函数名里不要出现“-”warning off[n,p]=size(A);%输入数据有n个样本,p个属性cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性%A(:,p+1)=100;A(:,p+1)=0;for i=1:k%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心m=i*floor(n/k)-floor(rand(1,1)*(n/k))cid(i,:)=A(m,:);cid;endAsum=0;Csum2=NaN;flags=1;times=1;while flagsflags=0;times=times+1;%计算每个向量到聚类中心的欧氏距离for i=1:nfor j=1:kdist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离end%A(i,p+1)=min(dist(i,:));%与中心的最小距离[x,y]=find(dist(i,:)==min(dist(i,:)));[c,d]=size(find(y==A(i,p+1)));if c==0 %说明聚类中心变了flags=flags+1;A(i,p+1)=y(1,1);elsecontinue;endendiflagsfor j=1:kAsum=0;[r,c]=find(A(:,p+1)==j);cid(j,:)=mean(A(r,:),1);for m=1:length(r)Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); endCsum(1,j)=Asum;endsum(Csum(1,:))%if sum(Csum(1,:))>Csum2% break;%endCsum2=sum(Csum(1,:));Csum;cid; %得到新的聚类中心endtimesdisplay('A矩阵,最后一列是所属类别');Afor j=1:k[a,b]=size(find(A(:,p+1)==j));numK(j)=a;endnumKtimesxlswrite('',A); %把矩阵A写到excel文件中,保存在工作路径下display('数据已保存为excel格式');。

matlab optics聚类算法

matlab optics聚类算法OPTICS(Ordering Points To Identify the Clustering Structure)是一种基于密度的聚类算法。

它可以自动发现任意形状和大小的簇,并且不需要预先指定簇的数量。

以下是使用MATLAB实现OPTICS算法的步骤:1.初始化核心距离参数ϵ和最小样本数参数MinPts。

2.对于每个数据点,计算其与其邻域内其他点之间的距离,并将这些距离按从小到大排序。

3.对于每个数据点,计算其核心距离:即第MinPts个邻域内最远的点与该点之间的距离。

4.选择一个未被访问过的数据点,并以该点为起始点构建一条路径。

路径上包含所有可达到且未被访问过的数据点,并以这些数据点中核心距离最小的那个为下一个扩展节点。

5.重复步骤4,直到所有数据点都被访问过。

6.输出聚类结果:按照路径顺序将数据点分为不同的簇。

下面是使用MATLAB实现OPTICS算法的示例代码:matlab复制代码function[RD,CD,order]=optics(x,epsilon,MinPts) n=size(x,1);RD=zeros(n,1);CD=zeros(n,1);for i=1:nD=sum((x(i,:)-x).^2,2);[sortedD, sortedIndex]=sort(D, 'ascend');CD(i)=sortedD(MinPts+1);RD(i)=sortedD(1);endCC=ones(n,n);CC(:,1)=0;RD=RD+CC;CD=CD+CC;while trueoldRD=RD;for i=1:nif RD(i)==0 && CD(i)<=epsilon*RD(oldRD==0) RD(i)=CD(i);CD(i)=inf;endendorder=[];for i=1:nif RD(i)>0 && CD(i)<=epsilon*RD(oldRD==0) order=[order num2str(i)];RD(i)=inf;CD(i)=inf;endendif isempty(order)break;endfor j=1:nif RD(j)>0 && any(RD==CD(:,j))==0 && any(RD==CD(j,:))==0RD(j)=CD(j,j);CD(j,j)=inf;endendendend。

dbscan聚类算法三维matlab代码

dbscan聚类算法三维matlab代码

DBSCAN是一种非参数的密度聚类算法,它能够自适应地发现任意形状的聚簇,并且具有很好的鲁棒性和稳定性。

下面是DBSCAN在MATLAB中的三维实现代码。

1. 准备数据

为了演示DBSCAN算法,首先需要生成一组3D数据。

以下是代码:

X = rand(1000, 3); % 生成1000个随机的3维数据点

figure;

scatter3(X(:, 1), X(:, 2), X(:, 3), '.');

2. DBSCAN算法实现

接下来,我们将使用MATLAB内置的DBSCAN函数来实现聚类。

以上代码中,第一行设置了DBSCAN算法的超参数“eps”和“MinPts”,分别代表着聚类半径和最小点数。

接下来,我们调用MATLAB内置的DBSCAN函数进行聚类操作,并生成聚类标签“IDX”,其中初值为-1表示噪音点。

最后,我们可以使用MATLAB中的scatter3函数将聚类结果可视化,其中不同的点颜色表示不同的聚簇。

3. 完整代码

4. 总结

本文介绍了如何在MATLAB中实现DBSCAN聚类算法。

由于DBSCAN算法具有很好的鲁棒性和稳定性,因此它在聚类分析中应用广泛。

在实际应用中,需要根据具体问题来确定聚类半径和最小点数等超参数的取值。

som聚类算法 matlab

som聚类算法是一种自组织映射算法,也称为Kohonen网络,它是一种无监督学习算法,能够实现对数据的聚类和分类。

在数据挖掘和模式识别领域得到广泛应用。

MATLAB作为一种专业的科学计算软件,为用户提供了丰富的工具箱和函数,可以方便地实现SOM聚类算法的应用和分析。

在进行SOM聚类算法之前,需要先准备好数据集。

数据集可以是CSV文件、Excel文件或者MATLAB的数据结构。

下面,我们将详细介绍如何使用MATLAB实现SOM聚类算法的步骤。

1. 导入数据集我们需要导入数据集。

在MATLAB中,可以使用readtable函数读取CSV文件或使用xlsread函数读取Excel文件。

如果数据集是MATLAB数据结构,那么直接加载即可。

将数据加载到MATLAB中后,可以利用MATLAB提供的数据可视化工具,查看数据的分布和特征。

2. 数据预处理在进行SOM聚类算法之前,需要对数据进行预处理,包括数据的归一化、标准化等操作。

MATLAB提供了丰富的函数和工具箱,可以方便地进行数据预处理操作。

3. 构建SOM网络在MATLAB中,可以使用自带的SOM工具箱或者自己编写代码来构建SOM网络。

SOM网络的构建需要设置一些参数,包括网络的大小、学习率、邻域函数等。

通过调整这些参数,可以得到不同的聚类效果。

4. 训练SOM网络构建好SOM网络后,就可以开始训练网络。

在MATLAB中,可以使用tr本人n函数来进行网络的训练。

在训练过程中,SOM网络会不断调整权重,使得节点能够根据输入数据自组织地形成聚类结果。

5. 可视化聚类结果训练好SOM网络后,可以使用MATLAB提供的数据可视化工具,将聚类结果可视化出来。

可以绘制聚类中心、聚类边界等信息,直观地展示数据的聚类效果。

通过以上步骤,我们可以在MATLAB中实现SOM聚类算法,并得到数据的聚类结果。

当然,SOM聚类算法的应用不仅限于数据聚类,在图像处理、模式识别等领域也有广泛的应用。

Matlab中的聚类分析与聚类算法详解

Matlab中的聚类分析与聚类算法详解绪论数据分析是现代科学和工程领域中非常重要的一项技术。

随着互联网和物联网技术的发展,数据的规模和复杂度不断增加,数据分析越来越成为解决实际问题的关键。

聚类分析是一种常用的数据分析技术,它通过将数据样本划分成具有相似性的组或簇,从而揭示数据的内在结构和模式。

在Matlab中,聚类分析功能强大且易于使用,提供了多种聚类算法,如K-means、层次聚类等。

本文将详细介绍Matlab 中的聚类分析方法及其算法。

一、K-means算法K-means算法是聚类分析中最经典且最常用的算法之一。

它将数据样本划分成K个簇,并迭代地优化簇的中心,使得簇内的样本与簇中心的距离最小化。

在Matlab中,使用kmeans函数可以轻松实现K-means算法。

K-means算法的步骤如下:1. 随机选择K个样本作为初始的K个簇中心。

2. 计算每个样本与簇中心的距离,将样本分配到离其最近的簇。

3. 更新每个簇的中心,即计算簇内所有样本的平均值。

4. 重复步骤2和步骤3,直到簇中心不再变化或达到迭代次数。

K-means算法的优点是简单、高效,并且可以处理大规模数据。

但是,它对初始簇中心的选择敏感,容易陷入局部最优解。

二、层次聚类算法层次聚类算法是另一种常见的聚类分析方法。

它通过计算样本之间的相似性,逐步合并或划分样本,构建聚类层次结构。

在Matlab中,使用clusterdata函数可以实现层次聚类算法。

层次聚类算法的步骤如下:1. 将每个样本作为一个初始簇。

2. 计算任意两个簇之间的相似性,常用的相似性度量包括欧氏距离、相关系数等。

3. 合并相似性最高的两个簇,得到新的簇。

4. 重复步骤2和步骤3,直到所有样本被合并为一个簇或达到设定的簇数。

层次聚类算法的优点是可以得到聚类层次结构,方便分析和可视化。

然而,它对数据规模较大时计算复杂度较高。

三、谱聚类算法谱聚类算法是一种基于图论的聚类方法,在处理复杂数据时具有较好的性能。

在Matlab中实现数据聚类和聚类分析的方法

在Matlab中实现数据聚类和聚类分析的方法在Matlab中实现数据聚类和聚类分析数据聚类和聚类分析是在数据挖掘和机器学习领域中非常重要的技术。

它们能够帮助我们将相似的数据点分组,从而揭示出数据之间的内在关系和模式。

在Matlab中,有多种方法可以实现数据聚类和聚类分析,本文将介绍其中的一些常用方法。

首先,我们需要导入数据。

在Matlab中,可以使用`readtable`函数来读取.csv 或.txt文件中的数据。

如果数据是存储在Excel文件中,可以使用`xlsread`函数来读取数据。

另外,也可以手动将数据存储在一个变量中。

在进行聚类之前,我们需要对数据进行预处理。

在预处理阶段,常见的操作包括数据去噪、数据标准化、缺失值处理等。

Matlab提供了一系列函数来实现这些操作,例如`Smooth`函数用于平滑数据,`zscore`函数用于数据标准化。

完成数据预处理后,我们可以开始进行聚类算法的选择和运行。

在Matlab中,有多种聚类算法可供选择,如K-means聚类算法、层次聚类算法、高斯混合模型等。

这些算法各有特点,可根据实际问题选择。

在选择了合适的聚类算法后,我们可以使用相应的函数进行聚类。

以K-means聚类算法为例,可以使用`kmeans`函数来进行聚类操作。

聚类完成后,我们需要进行聚类结果的评估和分析。

在Matlab中,可以使用一些评估指标来度量聚类效果,如聚类轮廓系数、Davies–Bouldin指数等。

这些指标能够帮助我们评估聚类结果的紧密度和分离度。

此外,我们还可以使用可视化工具来展示聚类结果,如散点图、热力图等。

Matlab提供了许多绘图函数用于可视化,如`scatter`函数可以绘制散点图,`heatmap`函数可以绘制热力图。

除了单一的聚类算法外,我们还可以将多个聚类算法进行组合,形成集成聚类模型。

集成聚类模型能够充分发挥各种聚类算法的优势,提高聚类效果。

在Matlab中,可以使用`fitensemble`函数来构建集成聚类模型。

kmeans聚类算法matlab

kmeans聚类算法matlabK-Means聚类算法是一种常用的聚类分析算法,它可以优化数据空间中数据点的结构,将数据分组,形成划分聚类。

K-Means聚类算法于1966年由斯坦福大学的比纳尔格雷开发出来,它的工作原理是:先将给定的数据集初始分组,然后通过不断调整聚类中心的位置,将数据点尽可能的放入其所属的簇,从而得到最优的聚类结果,有效的解决了高维数据空间中线性不可分问题。

K-Means聚类算法是一种直观、简单、可扩展性强的聚类算法,普遍存在于数据挖掘、计算机视觉等领域。

MATLAB是目前最为广泛应用的科学计算语言,它可以将高深的科学计算做成容易理解的程序代码,直接用于各种科学计算任务包括数值计算、科学可视化、直观交互、数据处理以及模拟建模。

其中,K-Means聚类算法也被完美的支持,该算法的MATLAB实现非常简单,因此广受广大科研人员、数据挖掘以及计算机视觉领域的欢迎。

K-Means聚类算法在MATLAB中的实例程序下面是一个K-Means聚类算法在MATLAB中的实例程序:clear all;close all;clc;% The following example shows the use of k-means clustering to% segregate the data into two clusters.% Step 1: Generate the data pointsx=randn(50,2);% Step 2: Label the data pointsy=[ones(25,1);2*ones(25,1)];% Step 3: Apply k-means clustering[idx,centroids]=kmeans(x,2);% Step 4: Plot the original data pointsfigurescatter(x(:,1),x(:,2),50,y,filledtitle(Original Data% Step 5: Plot the cluster data pointsfigurescatter(x(:,1),x(:,2),50,idx,filledtitle(Clustered Data% Step 6: Evaluate the clustering performance[accuracy] = evalClusters(y,idx);程序实现了K-Means聚类算法,包括数据生成、聚类计算、聚类效果可视化和聚类分析等部分,可以很好的说明K-Means聚类算法在MATLAB中的应用。

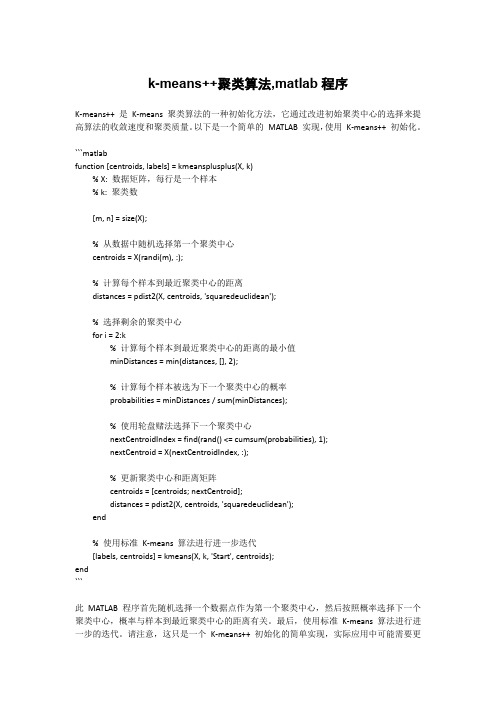

k-means++聚类算法,matlab程序

k-means++聚类算法,matlab程序K-means++ 是K-means 聚类算法的一种初始化方法,它通过改进初始聚类中心的选择来提高算法的收敛速度和聚类质量。

以下是一个简单的MATLAB 实现,使用K-means++ 初始化。

```matlabfunction [centroids, labels] = kmeansplusplus(X, k)% X: 数据矩阵,每行是一个样本% k: 聚类数[m, n] = size(X);% 从数据中随机选择第一个聚类中心centroids = X(randi(m), :);% 计算每个样本到最近聚类中心的距离distances = pdist2(X, centroids, 'squaredeuclidean');% 选择剩余的聚类中心for i = 2:k% 计算每个样本到最近聚类中心的距离的最小值minDistances = min(distances, [], 2);% 计算每个样本被选为下一个聚类中心的概率probabilities = minDistances / sum(minDistances);% 使用轮盘赌法选择下一个聚类中心nextCentroidIndex = find(rand() <= cumsum(probabilities), 1);nextCentroid = X(nextCentroidIndex, :);% 更新聚类中心和距离矩阵centroids = [centroids; nextCentroid];distances = pdist2(X, centroids, 'squaredeuclidean');end% 使用标准K-means 算法进行进一步迭代[labels, centroids] = kmeans(X, k, 'Start', centroids);end```此MATLAB 程序首先随机选择一个数据点作为第一个聚类中心,然后按照概率选择下一个聚类中心,概率与样本到最近聚类中心的距离有关。

聚类分析代码-matlab程序-可运行

clust = find(cidx3 == i);

plot(X(clust,1),X(clust,2),ptsymb{i},'MarkerSize',3,'MarkerFace',MarkFace{i},'MarkerEdgeColor','black');

plot(cmeans3(i,1),cmeans3(i,2),ptsymb{i},'MarkerSize',10,'MarkerFace',MarkFace{i});

[~,order] = sort(P(:,1));

plot(1:size(X,1),P(order,1),'r-',1:size(X,1),P(order,2),'b-',1:size(X,1),P(order,3),'y-');

legend({'Cluster 1 Score' 'Cluster 2 Score' 'Cluster 3 Score'},'location','NW');

cluster3 = (cidx3 == 2);

% 通过观察,K均值方法的第二类是gm的第三类

cluster2 = (cidx3 == 3);

% 计算分类概率

P = posterior(gm,X);

P8 = figure;clf

plot3(X(cluster1,1),X(cluster1,2),P(cluster1,1),'r.')

end

hold off

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

clear allclose alldisp('The only input needed is a distance matrix file')disp('The format of this file should be: ')disp('Column 1: id of element i')disp('Column 2: id of element j')disp('Column 3: dist(i,j)')mdist=input('example_distances');%name of the distance matrix file (with single quotes)?\ndisp('Reading input distance matrix')xx=load(mdist);ND=max(xx(:,2));NL=max(xx(:,1));if (NL>ND)ND=NL;endN=size(xx,1);for i=1:NDfor j=1:NDdist(i,j)=0;endendfor i=1:Nii=xx(i,1);jj=xx(i,2);dist(ii,jj)=xx(i,3);dist(jj,ii)=xx(i,3);endpercent=2.0;fprintf('average percentage of neighbours (hard coded): %5.6f\n', percent);position=round(N*percent/100);sda=sort(xx(:,3));dc=sda(position);fprintf('Computing Rho with gaussian kernel of radius: %12.6f\n', dc); for i=1:NDrho(i)=0.;end%% Gaussian kernel%for i=1:ND-1for j=i+1:NDrho(i)=rho(i)+exp(-(dist(i,j)/dc)*(dist(i,j)/dc));rho(j)=rho(j)+exp(-(dist(i,j)/dc)*(dist(i,j)/dc));endend%% "Cut off" kernel%%for i=1:ND-1% for j=i+1:ND% if (dist(i,j)<dc)% rho(i)=rho(i)+1.;% rho(j)=rho(j)+1.;% end% end%endmaxd=max(max(dist));[rho_sorted,ordrho]=sort(rho,'descend');delta(ordrho(1))=-1.;nneigh(ordrho(1))=0;for ii=2:NDdelta(ordrho(ii))=maxd;for jj=1:ii-1if(dist(ordrho(ii),ordrho(jj))<delta(ordrho(ii)))delta(ordrho(ii))=dist(ordrho(ii),ordrho(jj));nneigh(ordrho(ii))=ordrho(jj);endendenddelta(ordrho(1))=max(delta(:));disp('Generated file:DECISION GRAPH')disp('column 1:Density')disp('column 2:Delta')fid = fopen('DECISION_GRAPH', 'w');for i=1:NDfprintf(fid, '%6.2f %6.2f\n', rho(i),delta(i));enddisp('Select a rectangle enclosing cluster centers')scrsz = get(0,'ScreenSize');figure('Position',[6 72 scrsz(3)/4. scrsz(4)/1.3]);for i=1:NDind(i)=i;gamma(i)=rho(i)*delta(i);endsubplot(2,1,1)tt=plot(rho(:),delta(:),'o','MarkerSize',5,'MarkerFaceColor','k', 'MarkerEdgeColor','k');title ('Decision Graph','FontSize',15.0)xlabel ('\rho')ylabel ('\delta')subplot(2,1,1)rect = getrect(1);rhomin=rect(1);deltamin=rect(4);NCLUST=0;for i=1:NDcl(i)=-1;endfor i=1:NDif ( (rho(i)>rhomin) && (delta(i)>deltamin)) NCLUST=NCLUST+1;cl(i)=NCLUST;icl(NCLUST)=i;endendfprintf('NUMBER OF CLUSTERS: %i \n', NCLUST); disp('Performing assignation')%assignationfor i=1:NDif (cl(ordrho(i))==-1)cl(ordrho(i))=cl(nneigh(ordrho(i)));endend%halofor i=1:NDhalo(i)=cl(i);endif (NCLUST>1)for i=1:NCLUSTbord_rho(i)=0.;endfor i=1:ND-1for j=i+1:NDif ((cl(i)~=cl(j))&& (dist(i,j)<=dc))rho_aver=(rho(i)+rho(j))/2.;if (rho_aver>bord_rho(cl(i)))bord_rho(cl(i))=rho_aver;endif (rho_aver>bord_rho(cl(j)))bord_rho(cl(j))=rho_aver;endendendendfor i=1:NDif (rho(i)<bord_rho(cl(i)))halo(i)=0;endendendfor i=1:NCLUSTnc=0;nh=0;for j=1:NDif (cl(j)==i)nc=nc+1;endif (halo(j)==i)nh=nh+1;endendfprintf('CLUSTER: %i CENTER: %i ELEMENTS: %i CORE: %i HALO: %i \n', i,icl(i),nc,nh,nc-nh);endcmap=colormap;for i=1:NCLUSTic=int8((i*64.)/(NCLUST*1.));subplot(2,1,1)hold onplot(rho(icl(i)),delta(icl(i)),'o','MarkerSize',8,'MarkerFaceColo r',cmap(ic,:),'MarkerEdgeColor',cmap(ic,:));endsubplot(2,1,2)disp('Performing 2D nonclassical multidimensional scaling')Y1 = mdscale(dist, 2, 'criterion','metricstress');plot(Y1(:,1),Y1(:,2),'o','MarkerSize',2,'MarkerFaceColor','k','Ma rkerEdgeColor','k');title ('2D Nonclassical multidimensional scaling','FontSize',15.0) xlabel ('X')ylabel ('Y')for i=1:NDA(i,1)=0.;A(i,2)=0.;endfor i=1:NCLUSTnn=0;ic=int8((i*64.)/(NCLUST*1.));for j=1:NDif (halo(j)==i)nn=nn+1;A(nn,1)=Y1(j,1);A(nn,2)=Y1(j,2);endendhold onplot(A(1:nn,1),A(1:nn,2),'o','MarkerSize',2,'MarkerFaceColor',cma p(ic,:),'MarkerEdgeColor',cmap(ic,:));end%for i=1:ND% if (halo(i)>0)% ic=int8((halo(i)*64.)/(NCLUST*1.));% hold on%plot(Y1(i,1),Y1(i,2),'o','MarkerSize',2,'MarkerFaceColor',cmap(ic ,:),'MarkerEdgeColor',cmap(ic,:));% end%endfaa = fopen('CLUSTER_ASSIGNATION', 'w');disp('Generated file:CLUSTER_ASSIGNATION')disp('column 1:element id')disp('column 2:cluster assignation without halo control')disp('column 3:cluster assignation with halo control')for i=1:NDfprintf(faa, '%i %i %i\n',i,cl(i),halo(i));end。