mfs云计算分布式存储详细步骤

云计算——分布式存储 ppt课件

5.1.3 分布式存储的发展历史

4.21世纪的代表:Cassandra、HBase、MongoDB、DynamoDB (3) MongoDB:文档型数据库同键值(Key-Value)型的数据 库类似,是键值型数据库的升级版,允许嵌套键值,Value值是 结构化数据,数据库可以理解Value的内容,提供复杂的查询, 类似于RDBMS的查询条件。 (4) DynamoDB:Amazon公司的一个分布式存储引擎,是一 个经典的分布式Key-Value存储系统,具备去中心化、高可用性、 高扩展性的特点。

• 大型数据中心在数据存储和数据访问方面有着与先前的应用非常不同 的需求特征,主要包括:数据量庞大、访问的并发度高、文件数量巨 大、数据访问语义和访问接口不同于传统的文件系统、数据共享与数 据安全的保障越来越重要等。

28

云计算——分布 式存储

阶段

产生的技术 背景

负载特征

单机文件系统

分时操作系统 多用户共享 磁盘

• 为解决UNIX文件系统I/O性能低的问题,先后出现了1984年的快速文 件系统(Fast ,FFS)和1992年的日志结构文件系统(Log-Structured File,LFS)。

• 20世纪90年代至今,出现了很多单机文件系统。包括SGI公司于1994 年发布的XFS,以及Sun公司于2004年发布的ZFS。

24

云计算——分布式存储

• NFS(Network ,网络文件系统)由Sun公司在1984年开发,被认为是 第一个广泛应用的现代网络文件系统。NFS的设计目标是提供跨平台 的文件共享系统。由于NFS的实现和设计思想都相对简单,该协议很 快被纳入到RFC标准,并开始大量应用。然而,NFS单一服务器的结 构也决定了它的扩展性有限。

云计算——分布式存储

云计算——分布式存储在当今数字化的时代,数据如同潮水般汹涌增长,如何高效地存储和管理这些海量数据成为了企业和个人面临的重要挑战。

云计算中的分布式存储技术应运而生,为解决这一难题提供了强大的支持。

那么,什么是分布式存储呢?简单来说,分布式存储就是将数据分散存储在多个不同的物理设备上,这些设备通过网络连接在一起,协同工作,共同为用户提供数据存储和访问服务。

想象一下,您有一个巨大的仓库,里面堆满了各种各样的货物。

如果您把所有的货物都堆放在一个角落里,那么在寻找特定的货物时就会非常困难,而且这个角落也很容易变得拥挤不堪。

但是,如果您把货物均匀地分布在整个仓库的不同位置,并给每个位置都做好标记和记录,那么在寻找货物时就会变得高效和便捷。

分布式存储的原理就类似于这个仓库管理的方式。

与传统的集中式存储相比,分布式存储具有许多显著的优势。

首先,它具有更高的可靠性和容错能力。

在分布式存储系统中,如果某个存储节点出现故障,系统可以自动将数据恢复或重新分配到其他正常的节点上,确保数据的可用性和完整性。

这就好比在一个团队中,如果有一个成员生病了,其他人可以迅速补上他的位置,保证工作的顺利进行。

其次,分布式存储能够实现更灵活的扩展。

随着数据量的不断增长,企业可以轻松地添加新的存储节点,以满足不断增加的存储需求。

这种扩展性就像是给房子添加新的房间一样简单,而不需要对整个房屋结构进行大规模的改造。

再者,分布式存储能够提高数据的访问性能。

由于数据分布在多个节点上,用户可以从离自己最近的节点获取数据,从而减少数据传输的延迟和提高访问速度。

这就好比您在附近的超市就能买到所需的物品,而不必长途跋涉去远方的大商场。

分布式存储的实现涉及到多种关键技术。

其中,数据分片是一项重要的技术。

它将大量的数据分割成较小的片段,并将这些片段分布存储在不同的节点上。

通过合理的数据分片策略,可以确保数据的均衡分布和高效访问。

数据复制也是不可或缺的技术之一。

云计算——分布式存储(二)(2024)

引言概述:云计算是一种基于网络的计算模式,它通过共享的资源池,向用户提供按需的计算能力,存储空间和应用程序。

分布式存储作为云计算中重要的组成部分之一,使用了分布式系统的技术,将数据存储在多个物理设备上,并采用冗余和复制机制来提高数据的可靠性和可用性。

本文将深入探讨云计算中的分布式存储技术。

正文内容:一、分布式存储概述:1.分布式存储的定义和基本原理2.分布式存储的特点和优势3.分布式存储的应用领域和发展趋势二、分布式存储体系架构:1.分布式存储系统的组成和模块2.分布式存储的数据访问和传输机制3.分布式存储的数据分布和负载均衡策略4.分布式存储的数据一致性和冗余备份机制5.分布式存储的安全性和权限控制机制三、分布式存储技术:1.分布式文件系统HDFS(HadoopDistributedFileSystem) Ceph文件系统GlusterFSLustre2.分布式块存储CephRBD(RadosBlockDevice) OpenStackCinderAlibabaCloudDiskAWSEBS(ElasticBlockStore)3.分布式对象存储AmazonS3(SimpleStorageService) AliyunOSS(ObjectStorageService) GoogleCloudStorage MicrosoftAzureBlobStorage4.分布式数据库存储CassandraMongoDBRedisTiDB(分布式关系数据库)5.分布式存储的备份和恢复技术数据备份策略和技术故障恢复和数据一致性的保证增量备份与全量备份四、分布式存储的性能优化和扩展:1.分布式存储的性能评估和测试方法2.分布式存储的缓存和加速技术3.分布式存储的数据压缩和存储优化4.分布式存储的负载均衡和并行处理机制5.分布式存储的扩展性和容量增加方法五、分布式存储的挑战和未来发展:1.分布式存储的安全和隐私保护问题2.数据一致性和可靠性的挑战与解决方案3.分布式存储的监控和管理4.边缘计算与分布式存储的结合应用5.分布式存储与、区块链等新兴技术的发展趋势总结:云计算中的分布式存储技术在提供高可用性,可扩展性和性能优化方面发挥着重要作用。

云计算——分布式存储

THANKS

感谢观看

云计算——分布式存储

汇报人: 2023-12-14

目录

• 分布式存储概述 • 分布式存储技术原理 • 分布式存储系统架构 • 分布式存储应用场景 • 分布式存储性能优化策略 • 分布式存储安全问题及解决方案

01

分布式存储概述

定义与特点

定义

分布式存储是一种数据存储技术,它通过将数据分散到多个独立的节点上,以 实现数据的分布式存储和访问。

云计算平台建设

01

02

03

云存储服务

分布式存储作为云计算平 台的核心组件,提供高效 、可扩展的存储服务。

云服务集成

与其他云服务(如计算、 网络、安全等)紧密集成 ,形成完整的云计算解决 方案。

自动化运维与管理

通过自动化工具实现分布 式存储系统的运维和管理 ,提高效率。

物联网数据存储与处理

实时数据采集

现状

目前,分布式存储技术已经成为了云计算领域的重要组成部 分,各大云服务提供商都提供了基于分布式存储的云存储服 务。同时,随着技术的不断发展,分布式存储的性能和稳定 性也在不断提高。

优势与挑战

优势

分布式存储具有高性能、高可用性、安全性、容错性和可维护性等优势,它可以 提供更加高效、灵活和可靠的数据存储服务,同时还可以提供更加灵活的扩展能 力,以满足不断增长的数据存储需求。

支持物联网设备实时采集 数据,并存储在分布式存 储系统中。

数据处理与分析

对物联网数据进行处理和 分析,提取有价值的信息 。

智能决策与控制

基于物联网数据分析结果 ,实现智能决策和控制, 提高生产效率。

05

分布式存储性能优化策略

数据压缩与解压缩技术

mfs分布式文件系统

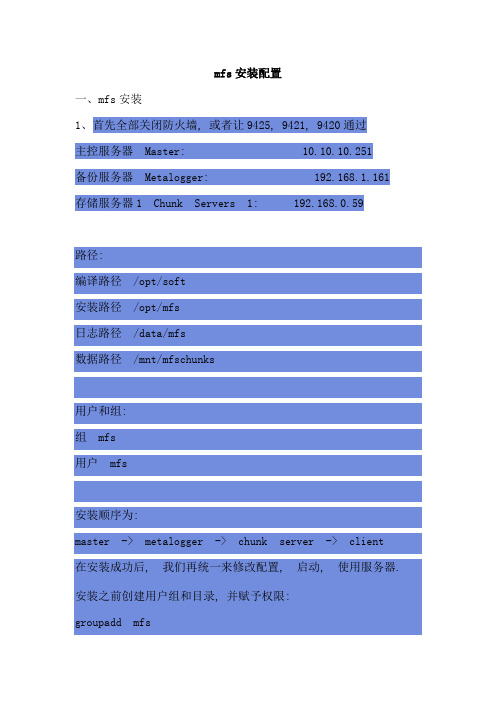

mfs安装配置一、mfs安装1、首先全部关闭防火墙, 或者让9425, 9421, 9420通过主控服务器Master: 10.10.10.251备份服务器Metalogger: 192.168.1.161 存储服务器1 Chunk Servers 1: 192.168.0.59路径:编译路径/opt/soft安装路径/opt/mfs日志路径/data/mfs数据路径/mnt/mfschunks用户和组:组mfs用户mfs安装顺序为:master -> metalogger -> chunk server -> client在安装成功后, 我们再统一来修改配置, 启动, 使用服务器. 安装之前创建用户组和目录, 并赋予权限:groupadd mfsuseradd mfs -g mfs -s /sbin/nologinmkdir -p /opt/soft /data /mnt/mfschunkschown -R mfs:mfs /mnt/mfschunks2、首先安装mastercd /opt/mfs-1.6.27A、编译./configure --prefix=/opt/mfs --sysconfdir=/opt/mfs/etc --locals tatedir=/data --with-default-user=mfs --with-default-group=mfs --disable-mfschunkserver --disable-mfsmountB、安装Make && make installC、配置文件cd /opt/mfs/etc/mfscp mfsmaster.cfg.dist mfsmaster.cfgcp mfsmetalogger.cfg.dist mfsmetalogger.cfgcp mfsexports.cfg.dist mfsexports.cfgcd /data/mfscp metadata.mfs.empty metadata.mfs3、然后是metalogger, metalogger和mester类似:cd mfs-1.6.27./configure --prefix=/opt/mfs --sysconfdir=/opt/mfs/etc --locals tatedir=/data --with-default-user=mfs --with-default-group=mf s --disable-mfschunkserver --disable-mfsmountmake && make installcd /opt/mfs/etc/mfscp mfsmetalogger.cfg.dist mfsmetalogger.cfg4、然后是chunk server:./configure --prefix=/opt/mfs --sysconfdir=/opt/mfs/etc --local statedir=/data --with-default-user=mfs --with-default-group=mf s --disable-mfsmaster --disable-mfsmounte)make && make installF)cd /opt/mfs/etc/mfsg)cp mfschunkserver.cfg.dist mfschunkserver.cfgh)cp mfshdd.cfg.dist mfshdd.cfg5、最后是client, 就是要使用mfs的机器cd /opt/mfs-1.6.27./configure --localstatedir=/data --with-default-user=mfs --wi th-default-group=mfs --disable-mfsmaster --disable-mfschunkse rver --enable-mfsmountMake && make install6、centos用户可以使用yum, 命令如下:yum install fuse.i386 fuse-devel.i386 fuse-libs.i386 z lib-devel.i386二、mfs配置1、mastervi /opt/mfs/etc/mfsexports.cfg第二行的"*"为指定允许挂载的ip, 我们以让192.168.1.1-255允许挂载为例:192.168.1.0/24 / rw,alldirs,maproot=0第一部分:客户端的ip地址第二部分:被挂接的目录第三部分:客户端拥有的权限第二部分说明/ 标识MooseFS根第三部分详细说明ro 只读模式共享rw 读写的方式共享alldirs 允许挂载任何指定的子目录maproot映射为root,还是指定的用户(0表示ROOT)password 指定客户端密码启动master/opt/mfs/sbin/mfsmaster start停止master/opt/mfs/sbin/mfsmaster stop检查是否配置成功ps -ef |grep mfsNetstat -nlp查看日志more -s /var/log/messages/opt/mfs/sbin/mfscgiserv #这个提供web的方式来查看master的状态, 访问地址为http://ip(master):9425在每台服务器的hosts加入如下vi /etc/hosts10.10.10.251 mfsmaster2、chunk serverVi /opt/mfs/etc/mfshdd.cfg加入如下, 指定客服端产生的数据存储位置:/mnt/mfsdd启动/opt/mfs/sbin/mfschunkserver start停止/opt/mfs/sbin/mfschunkserver stop3、Clinet挂载假如我们要挂载到/mnt/mfs目录mkdir -p /mnt/mfs/usr/local/bin/mfsmount /mnt/mfs/ -H mfsmasterdf -h就可以查看到mfsmaster已经被挂载了, 还有mfs的使用情况4、关闭顺序关闭如下, 客户端首先卸载文件系统:umount /mnt/mfs/opt/mfs/sbin/mfschunkserver stop/opt/mfs/sbin/mfsmetalogger stop/opt/mfs/sbin/mfsmaster stop(注:可以挂在根/目录下的子目录,配置文件加上192.168.40.0/24 /test rw,alldirs,maproot=0,password=tes t,注意test目录是在根目录已经创建好的子目录,并且挂载时使用mfsmount /mnt/client -H mfsmaster -o mfssubfolder=/test -p,否则会出现mfsmaster register error: Permission denied的错误。

MFS 分布式存储配置

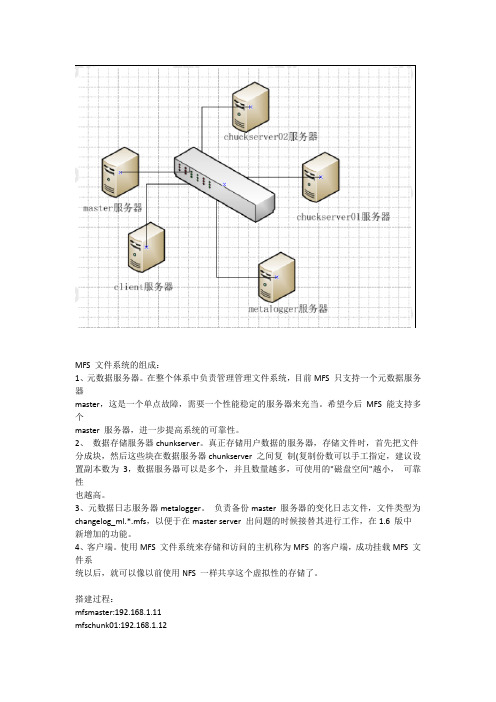

MFS 文件系统的组成:1、元数据服务器。

在整个体系中负责管理管理文件系统,目前MFS 只支持一个元数据服务器master,这是一个单点故障,需要一个性能稳定的服务器来充当。

希望今后MFS 能支持多个master 服务器,进一步提高系统的可靠性。

2、数据存储服务器chunkserver。

真正存储用户数据的服务器,存储文件时,首先把文件分成块,然后这些块在数据服务器chunkserver之间复制(复制份数可以手工指定,建议设置副本数为3,数据服务器可以是多个,并且数量越多,可使用的"磁盘空间"越小,可靠性也越高。

3、元数据日志服务器metalogger。

负责备份master 服务器的变化日志文件,文件类型为changelog_ml.*.mfs,以便于在master server 出问题的时候接替其进行工作,在1.6 版中新增加的功能。

4、客户端。

使用MFS 文件系统来存储和访问的主机称为MFS 的客户端,成功挂载MFS 文件系统以后,就可以像以前使用NFS 一样共享这个虚拟性的存储了。

搭建过程:mfsmaster:192.168.1.11mfschunk01:192.168.1.12mfschunk02:192.168.1.13mfsmetalogger:192.168.1.14client:192.168.1.15注意:都要关闭防火墙和Selinux首先搭建master[root@master opt]# lsmfs-1.6.26-1.el6.rf.x86_64.rpmmfs-cgi-1.6.26-1.el6.rf.x86_64.rpm[root@master opt]# rpm -ivh mfs-1.6.26-1.el6.rf.x86_64.rpm[root@master opt]# rpm -ivh mfs-cgi-1.6.26-1.el6.rf.x86_64.rpm[root@master opt]# ls -l /etc/mfstotal 24-rw-r--r--. 1 root root 509 Mar 21 2013 mfschunkserver.cfg.dist-rw-r--r--. 1 root root 0 Mar 10 10:14 mfsexports.cfg-rw-r--r--. 1 root root 4060 Mar 21 2013mfsexports.cfg.dist-rw-r--r--. 1 root root 57 Mar 21 2013mfshdd.cfg.dist-rw-r--r--. 1 root root 0 Mar 10 10:13 mfsmaster.cfg-rw-r--r--. 1 root root 879 Mar 21 2013 mfsmaster.cfg.dist-rw-r--r--. 1 root root 409 Mar 21 2013 mfsmetalogger.cfg.dist-rw-r--r--. 1 root root 1123 Mar 21 2013mfstopology.cfg.dist[root@master opt]# cd /etc/mfs/[root@mastermfs]# cpmfsmaster.cfg.distmfsmaster.cfg[root@mastermfs]# cpmfsexports.cfg.distmfsexports.cfg上面两个无需更改[root@mastermfs]# cp /var/mfs/metadata.mfs.empty /var/mfs/metadata.mfs[root@mastermfs]# /etc/init.d/mfsmaster startStarting mfsmaster:[root@mastermfs]# netstat -lanput|grepmfstcp 0 0 0.0.0.0:9419 0.0.0.0:* LISTEN 1275/mfsmastertcp 0 0 0.0.0.0:9420 0.0.0.0:* LISTEN 1275/mfsmastertcp 0 0 0.0.0.0:9421 0.0.0.0:* LISTEN 1275/mfsmaster[root@mastermfs]# chkconfigmfsmaster onmetalogger配置[root@metalogger ~]# lsanaconda-ks.cfg install.log mfs-1.6.26-1.el6.rf.x86_64.rpmDiscuz_X2_SC_UTF8.zip install.log.syslog[root@metalogger ~]# rpm -ivh mfs-1.6.26-1.el6.rf.x86_64.rpm[root@metalogger ~]# cd /etc/mfs/[root@metaloggermfs]# lsmfschunkserver.cfg.distmfshdd.cfg.distmfsmetalogger.cfg.distmfsexports.cfg.distmfsmaster.cfg.distmfstopology.cfg.dist[root@metaloggermfs]# cpmfsmetalogger.cfg.dist ./mfsmetalogger.cfg[root@metaloggermfs]# vimmfsmetalogger.cfg15 # MASTER_HOST = mfsmaster16 MASTER_HOST = 192.168.1.1117 # MASTER_PORT = 9419[root@metaloggermfs]# /etc/init.d/mfsmetalogger startStarting mfsmetalogger:[root@metaloggermfs]# netstat -lanput|grepmfstcp 0 0 192.168.1.14:50544 192.168.1.11:9419 ESTABLISHED 1553/mfsmetalogger[root@metaloggermfs]# chkconfigmfsmetaloggeronclient01配置[root@chunkserver01 ~]# rpm -ivh mfs-1.6.26-1.el6.rf.x86_64.rpm[root@chunkserver01 ~]# cd /etc/mfs/[root@chunkserver01 mfs]# lsmfschunkserver.cfg.distmfshdd.cfg.distmfsmetalogger.cfg.distmfsexports.cfg.distmfsmaster.cfg.distmfstopology.cfg.dist[root@chunkserver01 mfs]# ls /dev/sd*/dev/sda /dev/sda2 /dev/sda4 /dev/sdb/dev/sda1 /dev/sda3 /dev/sda5 /dev/sdb1[root@chunkserver01 mfs]# vimmfschunkserver.cfg12 # MASTER_HOST = mfsmaster13 MASTER_HOST = 192.168.1.11 master的ip[root@chunkserver01 mfs]# tail -n 1 mfshdd.cfg/data创建并且要挂在的目录[root@chunkserver01 mfs]# dfFilesystem 1K-blocks Used Available Use% Mounted on/dev/sda2 10079084 2893460 6673624 31% /tmpfs 189864 22576 167288 12% /dev/shm/dev/sda1 198337 33891 154206 19% /boot/dev/sda5 9351388 6679728 2196628 76% /opt/dev/sr0 3632776 3632776 0 100% /iso/dev/sdb1 2063504 1216656 742028 63% /data[root@chunkserver01 mfs]# cat>> /etc/fstab<<EOF> /dev/sdb1 /data ext4 defaults 1 2> EOF[root@chunkserver01 mfs]# tail -n 1 /etc/fstab/dev/sdb1 /data ext4 defaults 1 2[root@chunkserver01 mfs]# /etc/init.d/mfschunkserver startStarting mfschunkserver:[root@chunkserver01 mfs]# chkconfigmfschunkserver on[root@chunkserver01 mfs]# netstat -lanput|grepmfstcp 0 0 0.0.0.0:9422 0.0.0.0:* LISTEN 2480/mfschunkservertcp 0 0 192.168.1.12:54588 192.168.1.11:9420 ESTABLISHED 2480/mfschunkserver[root@chunkserver01 mfs]# ls /data00 0F 1E 2D 3C 4B 5A 69 78 87 96 A5 B4 C3 D2 E1 F0 FF01 10 1F 2E 3D 4C 5B 6A 79 88 97 A6 B5 C4 D3 E2 F1 lost+found02 11 20 2F 3E 4D 5C 6B 7A 89 98 A7 B6 C5 D4 E3 F203 12 21 30 3F 4E 5D 6C 7B 8A 99 A8 B7 C6 D5 E4 F304 13 22 31 40 4F 5E 6D 7C 8B 9A A9 B8 C7 D6 E5 F405 14 23 32 41 50 5F 6E 7D 8C 9B AA B9 C8 D7 E6 F506 15 24 33 42 51 60 6F 7E 8D 9C AB BA C9 D8 E7 F607 16 25 34 43 52 61 70 7F 8E 9D AC BB CA D9 E8 F708 17 26 35 44 53 62 71 80 8F 9E AD BC CB DA E9 F809 18 27 36 45 54 63 72 81 90 9F AE BD CC DB EA F90A 19 28 37 46 55 64 73 82 91 A0 AF BE CD DC EB FA0B 1A 29 38 47 56 65 74 83 92 A1 B0 BF CE DD EC FB0C 1B 2A 39 48 57 66 75 84 93 A2 B1 C0 CF DE ED FC0D 1C 2B 3A 49 58 67 76 85 94 A3 B2 C1 D0 DF EE FD0E 1D 2C 3B 4A 59 68 77 86 95 A4 B3 C2 D1 E0 EF FEchunk02也是一样的配置client的配置[root@client mfs-1.6.27]# ls ~/anaconda-ks.cfginstall.log.syslog mfs-1.6.27install.logiso mfs-1.6.27-1.tar.gz[root@client mfs-1.6.27]# tar -xvf mfs-1.6.27-1.tar.gz[root@client mfs-1.6.27]# lsaclocal.m4 configure.ac ltmain.shmfsdata READMEconfig.guess COPYING m4 mfsmaster rpmconfig.hdebianMakefilemfsmetadump stamp-h1config.h.indepcomp Makefile.am mfsmetalogger UPGRADEconfig.log doc Makefile.in mfsmetarestoreconfig.status INSTALLmfscgimfsmountconfig.sub install-shmfschunkserver missingconfigurelibtoolmfscommon NEWS[root@client mfs-1.6.27]# ./configure --prefix=/usr/local/mfs --enable-mfsmount[root@client mfs-1.6.27]# make&& make install[root@client mfs-1.6.27]# vim /root/.bash_profilePATH=/usr/local/mfs/bin:$PATH:$HOME/bin[root@client mfs-1.6.27]# source /root/.bash_profile[root@client mfs-1.6.27]# df -hFilesystemSize Used Avail Use% Mounted on/dev/sda2 9.7G 1.9G 7.4G 20% /tmpfs 184M 0 184M 0% /dev/shm/dev/sda1 194M 42M 142M 23% /boot/dev/sda5 9.0G 185M 8.3G 3% /opt/dev/sr0 3.5G 3.5G 0 100% /iso192.168.1.11:9421 3.2G 0 3.2G 0% /mnt[root@client mfs-1.6.27]# dd if=/dev/zero of=/mnt/aa01 bs=1M count=2048 2048+0 records in2048+0 records out2147483648 bytes (2.1 GB) copied, 76.4833 s, 28.1 MB/s查看chunk01:chunk02[root@chunkserver01 mfs]# df -hFilesystemSize Used Avail Use% Mounted on/dev/sda2 9.7G 2.8G 6.4G 31% /tmpfs 186M 23M 164M 12% /dev/shm/dev/sda1 194M 34M 151M 19% /boot/dev/sda5 9.0G 6.4G 2.1G 76% /opt/dev/sr0 3.5G 3.5G 0 100% /iso/dev/sdb1 2.0G 1.1G 853M 56% /data[root@chunkserver02host ~]# df -hFilesystemSize Used Avail Use% Mounted on/dev/sda3 a1 194M 26M 159M 14% /boot /dev/sr0 3.5G 3.5G 0 100% /iso/dev/sdb1 2.0G 1.1G 853M 56% /data数据各自存储一半测试:当机一台chunk01,看是否能够存储[root@chunkserver01 mfs]# /etc/init.d/mfschunkserver stopStopping mfschunkserver:[root@chunkserver01 mfs]# netstat -lanput|grepmfs[root@client mfs-1.6.27]# dd if=/dev/zero of=/mnt/aa01 bs=1M count=500 [root@client mfs-1.6.27]# dd if=/dev/zero of=/mnt/aa01 bs=1M count=500 500+0 records in500+0 records out524288000 bytes (524 MB) copied, 21.7707 s, 24.1 MB/s[root@chunkserver02host ~]# df -hFilesystemSize Used Avail Use% Mounted on/dev/sda3 14G 5.4G 7.6G 42% /tmpfs 186M 26M 161M 14% /dev/shm/dev/sda1 194M 26M 159M 14% /boot/dev/sr0 3.5G 3.5G 0 100% /iso/dev/sdb1 2.0G 793M 1.1G 42% /data[root@client mfs-1.6.27]# dd if=/dev/zero of=/mnt/aa01 bs=1M count=500500+0 records in500+0 records out524288000 bytes (524 MB) copied, 21.7707 s, 24.1 MB/s[root@chunkserver02host ~]# df -hFilesystemSize Used Avail Use% Mounted on/dev/sda3 14G 5.4G 7.6G 42% /tmpfs 186M 26M 161M 14% /dev/shm/dev/sda1 194M 26M 159M 14% /boot/dev/sr0 3.5G 3.5G 0 100% /iso/dev/sdb1 2.0G 537M 1.4G 29% /data再次启动chunk01[root@chunkserver01 mfs]# /etc/init.d/mfschunkserver startStarting mfschunkserver:[root@chunkserver01 mfs]# netstat -lanput|grepmfstcp 0 0 0.0.0.0:9422 0.0.0.0:* LISTEN 4028/mfschunkservertcp 0 0 192.168.1.12:54616 192.168.1.11:9420 ESTABLISHED 4028/mfschunkserver[root@chunkserver01 mfs]# df -hFilesystemSize Used Avail Use% Mounted on/dev/sda2 9.7G 2.8G 6.4G 31% /tmpfs 186M 23M 164M 12% /dev/shm/dev/sda1 194M 34M 151M 19% /boot/dev/sda5 9.0G 6.4G 2.1G 76% /opt/dev/sr0 3.5G 3.5G 0 100% /iso/dev/sdb1 2.0G 1.1G 853M 56% /data发现数据依然没有变化。

快速搭建分布式存储系统的步骤与要点(七)

快速搭建分布式存储系统的步骤与要点在当今信息技术快速发展的背景下,分布式存储系统成为了企业在处理大量数据时不可或缺的一种技术手段。

分布式存储系统具有高可靠性、高性能和高扩展性等优势,在提高数据处理效率和可靠性方面发挥着重要作用。

本文将从步骤和要点两个方面,探讨如何快速搭建分布式存储系统。

步骤一:需求分析与规划在搭建分布式存储系统之前,首先需要进行需求分析与规划。

这是非常重要的一步,可以帮助企业清晰地了解自己的业务需求和数据处理方式,从而为搭建分布式存储系统提供指导。

首先,企业需要明确自己的业务需求,例如需要处理的数据量、数据的读写频率、数据的一致性要求等。

通过对这些需求进行分析,可以确定所需的存储系统的规模和性能要求。

其次,企业需要规划分布式存储系统的架构。

架构设计应该考虑到数据的分布和部署方式,包括节点的选择、数据分片的策略以及数据的备份和恢复机制等。

同时,还需要考虑系统的可扩展性,以便在需要时能够方便地增加存储节点。

步骤二:选择合适的分布式存储技术在搭建分布式存储系统之前,企业还需要选择合适的分布式存储技术。

市场上存在多种分布式存储技术,如Hadoop分布式文件系统(HDFS)、Ceph存储系统、GlusterFS等。

在选择时,企业需要综合考虑自身需求、技术特点和可行性等因素。

HDFS是一种分布式文件系统,适用于大数据存储和处理。

HDFS具有高容错性、高性能和高可靠性等特点,但在小文件的处理上性能较差。

Ceph是一种分布式存储系统,适用于海量数据的存储和访问。

Ceph通过数据的分布和备份,提供了高可靠性和高扩展性。

但Ceph的部署和配置相对复杂,要求较高的技术能力。

GlusterFS是一种分布式文件系统,适用于大规模分布式存储。

GlusterFS提供了高性能和高可靠性,同时具有简单的配置和管理方式。

根据企业的需求和技术实力,选择适合自己的分布式存储技术,并进行相应的技术调研和测试,确保选择的技术能够满足自身的需求。

如何实现分布式数据存储和处理

如何实现分布式数据存储和处理随着互联网、云计算和大数据技术的发展,数据量越来越大,数据的处理和存储也越来越复杂。

传统的集中式数据存储和处理方式已经无法满足越来越复杂的场景,如何实现分布式数据存储和处理成为了一个重要的问题。

分布式数据存储和处理是指将数据存储和处理分散到多个节点上,每个节点处理自己所负责的一部分数据,并和其它节点协同工作,从而达到高效、可扩展、可靠的数据存储和处理的目的。

下面介绍一些关键技术和方法,以及实现分布式数据存储和处理的步骤。

一、分布式数据存储技术1. 分布式文件系统分布式文件系统是一种将文件存储在多台节点上的文件系统。

它将存储设备连接到计算机网络上,并使用分布式算法来管理文件和文件系统元数据。

分布式文件系统可以提供高性能、可扩展、可靠的文件存储服务,如Hadoop分布式文件系统(HDFS)等。

2. 对象存储对象存储是一种将数据存储为对象的存储方式。

每个对象包含数据、元数据和一个唯一的标识符(如URL)。

对象存储可以提供高扩展性和容错性,支持海量数据的处理和存储,如AWS S3等。

3. 分布式块存储分布式块存储是一种将数据分割成固定大小的块,并分散存储在多台节点上的存储方式。

每个块具有唯一的标识符,可以根据需要动态地分配和释放。

分布式块存储可以提供高性能、高可用性和高扩展性,如Ceph、GlusterFS等。

二、分布式数据处理技术1. MapReduceMapReduce是一种基于分布式数据处理的编程模型和软件框架。

它将数据分割为多个独立的块,并将其分配到多个节点上进行并行处理。

MapReduce将数据处理过程分解为两个部分:Map和Reduce。

Map将原始数据转换为键值对,Reduce将键值对聚合为最终结果。

MapReduce可以提供高性能、高可用性和高扩展性,如Hadoop MapReduce等。

2. SparkSpark是一种基于内存的分布式数据处理框架,其优点是速度快、易于使用、通用性强。

云计算——分布式存储

云计算——分布式存储在当今数字化的时代,数据的重要性不言而喻。

随着数据量的爆炸式增长,传统的存储方式已经难以满足需求,云计算中的分布式存储应运而生。

它就像是一个超级大仓库,能够高效、可靠地存储和管理海量的数据,为我们的生活和工作带来了巨大的变革。

那么,什么是分布式存储呢?简单来说,分布式存储是将数据分散存储在多个独立的设备上,而不是集中存储在一个单一的存储设备中。

这些设备可以是服务器、硬盘、甚至是云端的虚拟机。

通过网络将它们连接在一起,形成一个统一的存储系统。

想象一下,你有一个非常大的图书馆,里面有成千上万本书。

如果所有的书都堆放在一个房间里,那么要找到你想要的那本书将会非常困难。

但是,如果把这些书按照一定的规则分类,分别放在不同的书架上,每个书架都有明确的标识和索引,那么你就能更快地找到你需要的书。

分布式存储就类似于这样的图书馆管理方式,只不过它管理的是数据,而不是书籍。

分布式存储的优势是显而易见的。

首先,它具有极高的扩展性。

当你的数据量不断增加时,你只需要添加更多的存储设备就可以轻松应对,而不需要对整个系统进行大规模的改造。

这就好比你可以随时给图书馆增加新的书架,而不会影响到读者查找书籍的流程。

其次,分布式存储提高了数据的可靠性和可用性。

由于数据被分散存储在多个设备上,如果其中一个设备出现故障,其他设备上仍然有完整的数据副本,不会导致数据丢失。

这就像是在图书馆里,即使某个书架损坏了,其他书架上还有同样的书籍,读者依然可以借阅。

再者,分布式存储能够提高数据的访问性能。

通过将数据分布在多个设备上,并采用智能的算法进行数据分配和访问调度,可以实现并行的数据访问,大大提高了数据读取和写入的速度。

这就好像在图书馆里设置了多个借阅窗口,读者可以同时办理借阅手续,减少了等待的时间。

然而,分布式存储也并非完美无缺。

它的实现和管理相对复杂,需要处理数据的分布、副本管理、一致性维护等一系列问题。

而且,由于数据分布在多个设备上,数据的安全性和隐私保护也面临着更大的挑战。

云计算之分布式存储

云计算之分布式存储在当今数字化的时代,数据如同潮水般汹涌增长,如何高效地存储和管理这些海量数据成为了摆在我们面前的重要课题。

云计算技术的出现为解决这一问题提供了强大的支持,其中分布式存储作为云计算的关键组成部分,发挥着至关重要的作用。

让我们先来了解一下什么是分布式存储。

简单来说,分布式存储就是将数据分散存储在多个不同的物理设备上,而不是像传统存储那样集中存储在一个单一的设备中。

这些物理设备可以是服务器、存储阵列,甚至是普通的个人电脑。

通过将数据分布存储,不仅提高了数据的可靠性和可用性,还能够实现更高的存储容量和性能。

想象一下,如果我们把所有的数据都放在一个篮子里,一旦这个篮子出了问题,所有的数据都可能丢失。

但在分布式存储中,数据被分成许多小块,分别存储在不同的地方。

即使某个设备出现故障,其他设备上仍然保存着数据的副本,从而确保数据的安全性。

分布式存储的优势是显而易见的。

首先,它具有出色的可扩展性。

随着业务的发展和数据量的增加,我们可以轻松地添加更多的存储设备,而无需对整个系统进行大规模的改造。

这就像是搭积木一样,想要更大的空间,就多添加几块积木就行了。

其次,分布式存储能够提供更高的性能。

由于数据分布在多个设备上,可以同时从多个设备读取和写入数据,大大提高了数据的访问速度。

就好比我们同时从多个水龙头接水,总比只从一个水龙头接水要快得多。

再者,分布式存储具备良好的容错能力。

当某个存储节点出现故障时,系统能够自动检测并进行数据恢复,确保业务的连续性。

这就像是汽车的备胎,当一个轮胎出问题时,备胎能够及时顶上,让汽车继续行驶。

然而,要实现分布式存储并非易事,它面临着一系列的技术挑战。

数据一致性就是其中一个重要的问题。

由于数据分布在多个节点上,如何确保各个节点上的数据是一致的,这是一个需要解决的难题。

如果不同节点上的数据不一致,就可能导致数据的错误和混乱。

数据分布策略也是关键。

如何将数据合理地分布在各个存储节点上,既要考虑数据的访问频率,又要考虑存储节点的负载情况,这需要精心的设计和优化。

mfs 分布式文件系统 网络存储系统.

分布式文件系统MFS(moosefs实现存储共享(第二版到目前为止,有数十种以上的分布式文件系统解决方案可供选择,如lustre,hadoop,Pnfs等等。

我尝试了PVFS,hadoop,moosefs这三种应用,参看了lustre、KFS等诸多技术实施方法,最后我选择了moosefs(以下简称MFS)这种分布式文件系统来作为我的共享存储服务器。

为什么要选它呢?我来说说我的一些看法:8 Q+ H2 O% P0 |! i' c" b; p1、实施起来简单。

MFS的安装、部署、配置相对于其他几种工具来说,要简单和容易得多。

看看lustre 700多页的pdf文档,让人头昏吧。

5 ^ z8 e. p/ s, q2 W3 H {# G2、不停服务扩容。

MFS框架做好后,随时增加服务器扩充容量;扩充和减少容量皆不会影响现有的服务。

注:hadoop也实现了这个功能。

' c8 Q" ]$ ^( E3、恢复服务容易。

除了MFS本身具备高可用特性外,手动恢复服务也是非常快捷的,原因参照第1条。

2 I0 f/ i5 O; }6 z7 z, _4、我在实验过程中得到作者的帮助,这让我很是感激。

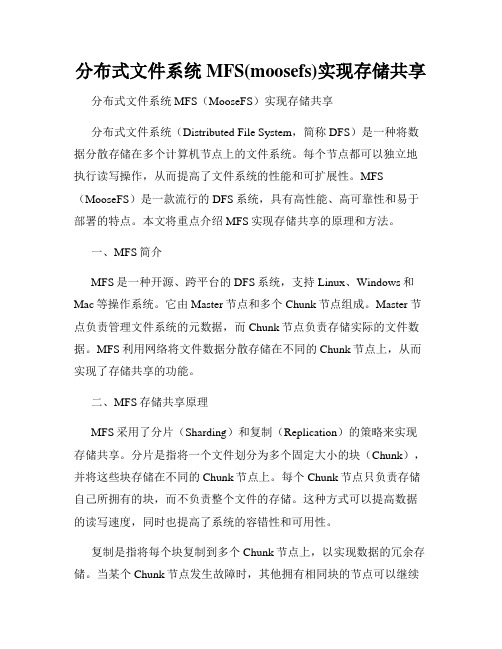

- r+ #5#6低加排气管道由于用户数量的不断攀升,我对访问量大的应用实现了可扩展、高可靠的集群部署(即lvs+keepalived的方式),但仍然有用户反馈访问慢的问题。

通过排查个服务器的情况,发现问题的根源在于共享存储服务器NFS。

在我这个网络环境里,N个服务器通过nfs方式共享一个服务器的存储空间,使得NFS服务器不堪重负。

察看系统日志,全是nfs服务超时之类的报错。

一般情况下,当nfs客户端数目较小的时候,NFS性能不会出现问题;一旦NFS服务器数目过多,并且是那种读写都比较频繁的操作,所得到的结果就不是我们所期待的。

下面是某个集群使用nfs共享的示意图:560这种架构除了性能问题而外,还存在单点故障,一旦这个NFS服务器发生故障,所有靠共享提供数据的应用就不再可用,尽管用rsync方式同步数据到另外一个服务器上做nfs服务的备份,但这对提高整个系统的性能毫无帮助。

云计算——分布式存储

云计算——分布式存储在当今数字化的时代,数据的重要性日益凸显,如何高效、安全地存储和管理海量数据成为了企业和个人面临的重要挑战。

云计算中的分布式存储技术应运而生,为解决这一难题提供了强大的支持。

那么,什么是分布式存储呢?简单来说,分布式存储就是将数据分散存储在多个不同的物理节点上,而非传统的集中式存储在一个单一的存储设备中。

想象一下,您有一个巨大的图书馆,里面有成千上万本书。

如果把所有的书都堆放在一个房间里,找一本书就会变得非常困难,而且如果这个房间出了问题,所有的书都可能受到影响。

但如果把书分散放在多个房间,每个房间都有特定的分类和索引,不仅找书变得更容易,即使某个房间出了问题,也不会影响到其他房间的书。

分布式存储就类似于这样的概念。

分布式存储具有诸多优势。

首先是可靠性和容错性。

由于数据被分散存储在多个节点上,如果某个节点出现故障,系统可以自动从其他正常的节点中恢复数据,从而确保数据的可用性和完整性。

这就好比是在一个团队中,如果有一个人请假,其他人能够顶上,工作依然能够顺利进行。

其次是扩展性。

随着数据量的不断增长,传统的存储系统可能需要进行大规模的硬件升级,这不仅成本高昂,而且操作复杂。

而分布式存储可以通过简单地增加新的节点来扩展存储容量和性能,就像给一个不断壮大的团队增加新成员一样轻松。

再者是性能提升。

在分布式存储中,数据可以并行地从多个节点读取和写入,大大提高了数据访问的速度。

这就好像是多条道路同时通车,交通流量自然就更大,通行速度也更快。

然而,分布式存储也并非完美无缺。

它的复杂性就是一个挑战。

管理和协调多个分布的节点需要复杂的软件和算法,以确保数据的一致性和准确性。

这就像是指挥一个庞大而分散的乐队,需要高超的技巧和精准的协调。

另外,数据分布和副本管理也是需要精心设计的。

要确保数据在各个节点上的分布均匀,避免某些节点负载过重,同时要合理管理数据副本,以在提高可靠性的同时不造成过多的存储浪费。

分布式文件系统MFS(moosefs)实现存储共享

分布式文件系统MFS(moosefs)实现存储共享分布式文件系统MFS(MooseFS)实现存储共享分布式文件系统(Distributed File System,简称DFS)是一种将数据分散存储在多个计算机节点上的文件系统。

每个节点都可以独立地执行读写操作,从而提高了文件系统的性能和可扩展性。

MFS (MooseFS)是一款流行的DFS系统,具有高性能、高可靠性和易于部署的特点。

本文将重点介绍MFS实现存储共享的原理和方法。

一、MFS简介MFS是一种开源、跨平台的DFS系统,支持Linux、Windows和Mac等操作系统。

它由Master节点和多个Chunk节点组成。

Master节点负责管理文件系统的元数据,而Chunk节点负责存储实际的文件数据。

MFS利用网络将文件数据分散存储在不同的Chunk节点上,从而实现了存储共享的功能。

二、MFS存储共享原理MFS采用了分片(Sharding)和复制(Replication)的策略来实现存储共享。

分片是指将一个文件划分为多个固定大小的块(Chunk),并将这些块存储在不同的Chunk节点上。

每个Chunk节点只负责存储自己所拥有的块,而不负责整个文件的存储。

这种方式可以提高数据的读写速度,同时也提高了系统的容错性和可用性。

复制是指将每个块复制到多个Chunk节点上,以实现数据的冗余存储。

当某个Chunk节点发生故障时,其他拥有相同块的节点可以继续提供服务,从而保证数据的可靠性和可用性。

MFS可以根据用户的需求设置块的复制数,以权衡系统的性能和容错性。

三、MFS存储共享方法在使用MFS实现存储共享时,需要按照以下步骤进行配置和操作:1. 安装和配置MooseFS首先,需要在每个节点上安装MooseFS软件,并进行必要的配置。

在Master节点上,需要指定Chunk节点的IP地址和端口号,以及元数据的存储路径。

在Chunk节点上,需要指定Master节点的IP地址和端口号。

Centos下MooseFS(MFS)分布式存储共享环境部署记录

Centos下MooseFS(MFS)分布式存储共享环境部署记录分布式⽂件系统(Distributed File System)是指⽂件系统管理的物理存储资源不⼀定直接连接在本地节点上,⽽是通过计算机⽹络与节点相连,分布式⽂件系统的实际基于客户机/服务器模式。

⽬前常见的分布式⽂件系统有很多种,⽐如Hadoop、Moosefs、HDFS、FastDFS、PNFS(Parallel NFS)、Lustre、TFS、GFS等等⼀系列。

在众多的分布式⽂件系统解决⽅案中,MFS是搭建⽐较简单、使⽤起来也不需要过多的修改web程序,⾮常⽅便。

⼀、MooseFS是什么MooseFS(即Moose File System,简称MFS)是⼀个具有容错性的⽹络分布式⽂件系统,它将数据分散存放在多个物理服务器或单独磁盘或分区上,确保⼀份数据有多个备份副本,对于访问MFS的客户端或者⽤户来说,整个分布式⽹络⽂件系统集群看起来就像⼀个资源⼀样,也就是说呈现给⽤户的是⼀个统⼀的资源。

MooseFS就相当于UNIX的⽂件系统(类似ext3、ext4、nfs),它是⼀个分层的⽬录树结构。

MFS存储⽀持POSIX标准的⽂件属性(权限,最后访问和修改时间),⽀持特殊的⽂件,如块设备,字符设备,管道、套接字、链接⽂件(符合链接、硬链接);MFS⽀持FUSE(⽤户空间⽂件系统Filesystem in Userspace,简称FUSE),客户端挂载后可以作为⼀个普通的Unix⽂件系统使⽤MooseFS。

MFS可⽀持⽂件⾃动备份的功能,提⾼可⽤性和⾼扩展性。

MogileFS不⽀持对⼀个⽂件内部的随机或顺序读写,因此只适合做⼀部分应⽤,如图⽚服务,静态HTML服务、⽂件服务器等,这些应⽤在⽂件写⼊后基本上不需要对⽂件进⾏修改,但是可以⽣成⼀个新的⽂件覆盖原有⽂件。

⼆、MooseFS的特性1)⾼可靠性,每⼀份数据可以设置多个备份(多分数据),并可以存储在不同的主机上2)⾼可扩展性,可以很轻松的通过增加主机的磁盘容量或增加主机数量来动态扩展整个⽂件系统的存储量3)⾼可容错性,可以通过对mfs进⾏系统设置,实现当数据⽂件被删除后的⼀段时间内,依旧存放于主机的回收站中,以备误删除恢复数据4)⾼数据⼀致性,即使⽂件被写⼊、访问时,依然可以轻松完成对⽂件的⼀致性快照5)通⽤⽂件系统,不需要修改上层应⽤就可以使⽤(那些需要专门api的dfs很⿇烦!)。

云计算下分布式存储系统的设计与实现

云计算下分布式存储系统的设计与实现随着数字化时代的到来,数据的存储需求越来越大,单一的存储系统已经无法满足日益增长的数据量。

于是分布式存储系统在云计算时代应运而生。

分布式存储系统是一种将数据存储在多个独立节点上的系统。

在该系统中,不同节点上的数据可以互相备份,提高了数据的可靠性与可用性。

本文将围绕云计算下分布式存储系统的设计与实现展开讨论。

一、分布式存储系统的基本原理受云计算技术的影响,传统的数据存储系统面临着数据存储过程中数据丢失、数据冗余、数据访问等诸多问题。

分布式存储系统通过将数据切分成多份存储在不同的节点之中,通过对数据的冗余进行控制,保证数据的高可靠性,进而建立了高性能、可伸缩、高度可用的存储系统。

分布式存储系统的基本构成是存储节点和元数据服务器:存储节点通常分布在不同的位置或集群中,通过网络连接以形成一个整体存储系统;元数据服务器是整个分布式存储系统的元数据管理中心,主要负责对数据进行控制与管理。

二、分布式存储系统的设计设计一个分布式存储系统需要考虑以下因素:1.存储节点的数量和容量通常,设计一种分布式存储系统时,需要考虑多个节点间的数据分布和数据冗余,维护一个较大规模的存储节点集群是非常必要的。

节点的数量和容量取决于系统的负载和数据规模,可以根据实际需求进行调整。

2.数据切分和冗余数据的切分和冗余对于分布式存储系统来说至关重要。

合理的数据切分以及合适的数据冗余策略,可以提高系统的可靠性和可用性。

数据冗余策略可以采用多副本存储或纠错编码等多种技术。

3.元数据的管理和维护对于分布式存储系统来说,元数据是非常重要的。

元数据主要用来存储数据的相关信息,如数据所在节点、数据切分信息、数据冗余策略等。

元数据的管理和维护需要较高的技术水平和经验。

三、分布式存储系统的实现在实现分布式存储系统时,主要有以下几种技术:1.分布式文件系统分布式文件系统是一种分布式存储系统,可以通过网络连接多个节点,实现文件的浏览、读写、复制等功能。

快速搭建分布式存储系统的步骤与要点(十)

在当今互联网时代,数据的存储和管理变得越来越重要。

为了满足海量数据的需求,分布式存储系统应运而生,并广泛应用于各行各业。

本文将探讨快速搭建分布式存储系统的步骤与要点,希望能为读者提供一点有益的建议。

一、了解基本概念在开始搭建分布式存储系统之前,我们首先需要了解一些基本概念。

分布式存储是将数据分散存储在多台计算机或服务器上,通过网络进行协同工作,以提高系统的容量和可靠性。

常见的分布式存储系统包括分布式文件系统、对象存储系统和分布式数据库等。

二、选择合适的技术和工具在搭建分布式存储系统之前,我们需要选择适合自己需求的技术和工具。

常见的技术包括Hadoop、GlusterFS、Ceph等。

Hadoop是一个开源的分布式计算平台,可以支持大规模数据处理;GlusterFS是一个分布式文件系统,可以实现无中心节点的数据存储;Ceph是一个分布式存储系统,可以提供高性能和高可扩展性的数据存储。

三、规划系统架构在开始实际搭建分布式存储系统之前,我们需要进行系统架构的规划。

首先,确定系统的规模和容量需求,以确定需要多少节点和存储空间。

其次,设计系统的网络拓扑结构,确定节点之间的连接方式和通信协议。

最后,考虑系统的故障处理和容错机制,以保证数据的安全性和可靠性。

四、安装和配置软件在规划系统架构后,我们需要进行软件的安装和配置。

根据选择的技术和工具,按照其官方文档或教程逐步进行安装和配置。

在安装和配置过程中,需要注意一些常见问题,比如操作系统的兼容性、网络环境的配置、节点之间的通信设置等。

五、测试和优化性能在完成软件安装和配置后,我们需要进行系统的测试和性能优化。

通过一些工具和方法,检测系统的各项指标,比如存储容量、读写性能、数据可靠性等。

根据测试结果,进行性能调优和系统参数的优化,以提高系统的稳定性和吞吐量。

六、监控和维护系统在分布式存储系统的运行过程中,我们需要进行系统的监控和维护。

通过监控工具和仪表盘,实时监测系统的运行状况和数据变化。

基于云计算的分布式数据存储与处理

基于云计算的分布式数据存储与处理云计算是现代信息技术中最为划时代的一次革命,对于现代企业的IT架构以及信息管理、处理和存储等方面都产生了深远的影响。

在这个信息化浪潮的背景下,分布式数据存储和处理技术也随之而来,为企业的信息系统构建提供了更为先进和高效的解决方案。

本文将重点探讨如何基于云计算实现分布式数据存储和处理,具体内容将分为以下三个部分展开。

一、分布式数据存储技术分布式数据存储是指将数据分散存储在不同的物理设备中,并由一组相互独立的主机共同协作来实现数据的存储、管理和访问。

这种方式在面对大规模数据量不断增大的情况下,可以大大提高数据存储的可靠性和运行效率。

实现分布式数据存储需要进行以下三个步骤。

1.数据切割将要存储的数据按照一定规则进行切割,然后将切割后的数据分散存储在不同的物理设备上,以保证数据传输和存储的效率。

2.数据分发数据分发是指将切割后的数据分发到不同的物理设备存储之中,要保证各个节点获取数据的时候可以高效地获取到。

3.数据备份由于分布式存储的环境下,故障的概率要比集中式存储环境下更高,因此需要对数据进行备份,以保证数据的可靠性和安全性。

二、分布式数据处理技术分布式数据处理技术是指将数据切分到多个节点上进行处理和分析,通过使用并行计算的方式来提高数据处理的效率和准确性。

与传统的单一节点数据处理方式不同,分布式数据处理技术不仅能够更好地发挥多个节点的计算能力,还可以通过负载均衡等机制来保证数据处理的稳定性和鲁棒性。

分布式数据处理技术的实现需要以下步骤。

1.数据切割同分布式存储一样,分布式数据处理需要先将数据进行切割,将不同的数据分散到不同的节点进行计算处理。

2.数据传输由于要使用到多个节点进行计算处理,因此需要进行数据的传输,传输的方式可以通过网络传输或者使用共享存储器。

3.数据计算处理在各个节点上进行数据计算和处理,根据实际情况,可以使用分布式计算框架如Spark、Hadoop等工具来进行数据处理。

快速搭建分布式存储系统的步骤与要点(五)

现代技术的发展与日俱增,大数据的处理和存储成为一个不可忽视的挑战。

分布式存储系统由于其高可靠性和高效性,被广泛应用于各个领域。

在本文中,我将详细介绍搭建分布式存储系统的步骤和要点,帮助读者了解并实施这一重要的技术。

1. 确定需求和目标在搭建分布式存储系统之前,我们需要明确自己的需求和目标。

关键问题包括:需要存储什么类型的数据?数据量有多大?对数据的读写速度有什么要求?对可靠性和安全性有何要求?明确需求和目标可以帮助我们选择适合的分布式存储系统和相应的配置。

2. 选择合适的分布式存储系统目前市场上有多种不同类型的分布式存储系统可供选择,如Hadoop、GlusterFS、Ceph等。

每个系统都有其独特的特点和适用领域。

在选择系统时,我们应该考虑到自己的需求和目标,并结合系统的稳定性、性能、可扩展性和易于使用性等因素做出决策。

3. 设计和规划系统架构在搭建分布式存储系统之前,我们需要对系统进行设计和规划。

关键问题包括:如何分布数据?如何保证数据的可靠性和一致性?如何管理系统的元数据?如何处理故障和扩展?设计和规划系统架构是搭建成功的关键。

4. 部署和配置分布式存储系统根据系统设计和规划,我们需要进行实际的部署和配置工作。

这包括在不同的节点上安装和配置系统软件,设置节点之间的通信和协调机制,以及配置系统的各项参数。

在此过程中,我们需要注意不同组件之间的依赖关系和性能调优,以确保系统能够正常运行并满足要求。

5. 数据迁移和备份在搭建完成后,我们还需要考虑如何迁移现有数据到分布式存储系统中,并建立有效的备份机制。

数据迁移可以采用批量导入或增量同步等方式,根据实际情况选择最合适的迁移方法。

备份机制可以采用冗余备份或异地备份等方式,以保证数据的安全性和可靠性。

6. 系统监控和维护一旦分布式存储系统搭建完成,我们需要建立相应的监控和维护机制。

这包括监测系统的运行状态和性能指标,及时发现和解决问题;定期进行系统维护,如数据清理、节点维护等;更新系统版本和补丁,以及备份和恢复数据等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

分布式文件系统MFS(moosefs)实现存储共享(第二版)作者:田逸(sery@ )由于用户数量的不断攀升,我对访问量大的应用实现了可扩展、高可靠的集群部署(即lvs+keepalived 的方式),但仍然有用户反馈访问慢的问题。

通过排查个服务器的情况,发现问题的根源在于共享存储服务器NFS 。

在我这个网络环境里,N 个服务器通过nfs 方式共享一个服务器的存储空间,使得NFS 服务器不堪重负。

察看系统日志,全是nfs 服务超时之类的报错。

一般情况下,当nfs 客户端数目较小的时候,NFS 性能不会出现问题;一旦NFS 服务器数目过多,并且是那种读写都比较频繁的操作,所得到的结果就不是我们所期待的。

下面是某个集群使用nfs 共享的示意图:FS FS1、实施起来简单。

MFS的安装、部署、配置相对于其他几种工具来说,要简单和容易得多。

看看lustre 700多页的pdf文档,让人头昏吧。

2、不停服务扩容。

MFS框架做好后,随时增加服务器扩充容量;扩充和减少容量皆不会影响现有的服务。

注:hadoop也实现了这个功能。

3、恢复服务容易。

除了MFS本身具备高可用特性外,手动恢复服务也是非常快捷的,原因参照第1条。

4、我在实验过程中得到作者的帮助,这让我很是感激。

特性(根据官方网站翻译)MFS特性★ 高可靠性(数据能被分成几个副本存储在不同的计算机里)★ 通过增加计算机或增加新的硬盘动态扩充可用磁盘空间★ 可以设置删除文件的空间回收时间[root@mysql-bk serydir]# mfsgettrashtime bind-9.4.0.tar.gzbind-9.4.0.tar.gz: 600文件被删除10分钟后(600秒),才真正删除文件,回收磁盘空间。

★ 为文件创建快照MFS文件系统的组成1、元数据服务器。

在整个体系中负责管理管理文件系统,目前MFS只支持一个元数据服务器master,这是一个单点故障,需要一个性能稳定的服务器来充当。

希望今后MFS 能支持多个master服务器,进一步提高系统的可靠性。

2、元数据日志服务器。

备份master服务器的变化日志文件,文件类型为changelog_ml.*.mfs。

当元数据服务器数据丢失或者损毁,可从日志服务器取得文件进行恢复。

3、数据存储服务器chunkserver。

真正存储用户数据的服务器。

存储文件时,首先把文件分成块,然后这些块在数据服务器chunkserver之间复制(复制份数可以手工指定,建议设置副本数为3)。

数据服务器可以是多个,并且数量越多,可使用的“磁盘空间”越大,可靠性也越高。

4、客户端。

使用MFS文件系统来存储和访问的主机称为MFS的客户端,成功挂接MFS文件系统以后,就可以像以前使用NFS一样共享这个虚拟性的存储了。

元数据服务器安装和配置元数据服务器可以是linux,也可以是unix,你可以根据自己的使用习惯选择操作系统,在我的环境里,我是用freebsd做为MFS元数据的运行平台。

GNU源码,在各种类unix平台的安装都基本一致。

(一) 安装元数据服务1、下载GNU源码wget /project/moosefs/moosefs/1.6.11/mfs-1.6.11.tar.gz2、解包tar zxvf mfs-1.6.11.tar.gz3、切换目录cd mfs-1.6.114、创建用户useradd mfs –s /sbin/nologin5、配置./configure --prefix=/usr/local/mfs --with-default-user=mfs --with-default-group=mfs6、编译安装make ; make install(二) 配置元数据服务元数据服务器的配置文件被放置于安装目录/usr/local/mfs/etc。

与mfs-1.5.12版本不同的是:mfs-1.6.x版安装完成只有模版文件,其后缀形如mfsmaster.cfg.dist。

为了使mfs master正常工作,需要两个配置文件mfsmaster.cfg及mfsexports.cfg,前者为主配置文件,后者为权限控制文件(mfs客户端挂接时使用)。

(1)主配置文件mfsmaster.cfg,可直接从模版文件拷贝而来,打开这个配置文件/usr/local/mfs/etc/mfsmaster.cfg,看看都有哪些内容:# WORKING_USER = mfs# WORKING_GROUP = mfs# SYSLOG_IDENT = mfsmaster# LOCK_MEMORY = 0# NICE_LEVEL = -19# EXPORTS_FILENAME = /usr/local/mfs/etc/mfsexports.cfg# DATA_PATH = /usr/local/mfs/var/mfs# BACK_LOGS = 50# REPLICATIONS_DELAY_INIT = 300# REPLICATIONS_DELAY_DISCONNECT = 3600# MATOML_LISTEN_HOST = *# MATOML_LISTEN_PORT = 9419# MATOCS_LISTEN_HOST = *# MATOCS_LISTEN_PORT = 9420# MATOCU_LISTEN_HOST = *# MATOCU_LISTEN_PORT = 9421# CHUNKS_LOOP_TIME = 300# CHUNKS_DEL_LIMIT = 100# CHUNKS_WRITE_REP_LIMIT = 1# CHUNKS_READ_REP_LIMIT = 5# REJECT_OLD_CLIENTS = 0# deprecated, to be removed in MooseFS 1.7# LOCK_FILE = /var/run/mfs/mfsmaster.lock尽管每行都被注释掉了,但它们却是配置文件的默认值,要改变这些值,需要取消注释,然后明确指定其取值。

接下来说明一下其中一些项目的含义。

◆ EXPORTS_FILENAME = /usr/local/mfs/etc/mfsexports.cfg 权限控制文件的存放位置。

◆ DATA_PATH = /usr/local/mfs/var/mfs 数据存放路径,只元数据的存放路径。

那么这些数据都包括哪些呢?进目录看看,大致分3种类型的文件:这些文件也同样要存储在其他数据存储服务器的相关目录。

◆ MATOCS_LISTEN_PORT = 9420 MATOCS--master to chunkserver,即元数据服务器使用9420这个监听端口来接受数据存储服务器chunkserver端的连接。

◆ MATOML_LISTEN_PORT = 9419 MATOML---master to metalogger,用于备份元数据服务器的变化日志。

注:Mfs-1.5.12以前的版本没有这个项目。

◆ MATOCU_LISTEN_PORT = 9421 元数据服务器在9421端口监听,用以接受客户端对MFS进行远程挂接(客户端以mfsmount挂接MFS)◆ 其他部分看字面意思都不难理解。

还有几个与时间有关的数值,其单位是秒。

这个配置文件,不必做修改就能工作了。

(2)配置文件/usr/local/mfs/etc/mfsexports.cfg,也可直接从模版文件复制而来。

这个文件的内容,十分类似NFS服务器的exports文件.实际配置时,可参照这个文件的默认行来修改以满足自己的应用需求.我的mfsexports.cfg文件的内容为:192.168.93.0/24 / rw(3)复制文件cp /usr/local/mfs/var/mfs/metadata.mfs.empty /usr/local/mfs/var/mfs/metadata.mfs这是一个8字节的文件,为mfs-1.6.x新增项目。

(三) 元数据服务器master启动元数据服务器可以单独启动,即使没有任何数据存储服务器(chunkserver)也是能正常工作的,因此当我们安装配置完MFS后,即可启动它。

执行命令/usr/local/mfs/sbin/mfsmaster start ,如果没有意外,元数据库服务器就应该作为一个守护进程运行起来。

现在我们可以通过3个方面来检查一下MFS master的运行状况:1、检查进程3、 检查系统日志MFS 的日志会直接写入系统日志。

当我们增加数据存储服务器(chunkserver )或数据存储服务器(chunkserver )处故障时,都能在系统日志找到这些记录。

注意,这个日志跟元数据变化日志不是一回事情。

(四)、关闭元数据服务器关闭元数据服务器,务必使用 /usr/local/mfs/sbin/mfsmaster –s 这种方式,如果直接使用kill 杀死进程,将导致下次启动时出现找不到相关文件,而不能正常启动服务器。

这个一定要谨慎。

当然,如果发生了这个事情,还是可以通过 mfsmetastore 来恢复的。

元数据元数据日志日志日志服务器安装和配置服务器安装和配置元数据日志服务为mfs 1.6以后版本新增的服务,即可以把元数据日志保留在元数据服务器,也可以单独存储。

为保证其可靠性,最好单独放置。

需要注意的是,源数据日志守护进程跟元数据服务器(master )在同一个服务器上,备份元数据日志的服务器作为它的客户端,从元数据服务器取得日志文件进行备份。

(一)安装元数据日志服务器metalogger1、下载GNU 源码wget /project/moosefs/moosefs/1.6.11/mfs-1.6.11.tar.gz2、解包 tar zxvf mfs-1.6.11.tar.gz3、切换目录 cd mfs-1.6.114、创建用户 useradd mfs –s /sbin/nologin5、配置 ./configure --prefix=/usr/local/mfs --with-default-user=mfs --with-default-group=mfs6、编译安装 make ; make install(二)元数据日志服务(metalogger )配置该服务仅需要一个配置文件,这里我们只需要从模板文件复制一个,然后稍微加以修改即可,下面是我的某个metalogger 的配置文件:[root@hynfs-2 etc]# more mfsmetalogger.cfg# WORKING_USER = mfs# WORKING_GROUP = mfs# SYSLOG_IDENT = mfsmetalogger# LOCK_MEMORY = 0# NICE_LEVEL = -19# DATA_PATH = /usr/local/mfs/var/mfs# BACK_LOGS = 50# META_DOWNLOAD_FREQ = 24# MASTER_RECONNECTION_DELAY = 5MASTER_HOST = 192.168.93.18MASTER_PORT = 9419# MASTER_TIMEOUT = 60# deprecated, to be removed in MooseFS 1.7# LOCK_FILE = /var/run/mfs/mfsmetalogger.lock这个配置文件,唯一需要修改的地方就是MASTER_HOST,它的值必须是元数据服务器的主机名或者ip地址。