第5章-信息理论与编码课后答案

信息论与编码理论习题答案

信息论与编码理论习题答案LG GROUP system office room 【LGA16H-LGYY-LGUA8Q8-LGA162】第二章 信息量和熵八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率。

解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。

问各得到多少信息量。

解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log = bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log = bit 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a) )(a p =!521信息量=)(1loga p =!52log = bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C = bit 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6= bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6= bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ]而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H = bit或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H = bit),|(Y X Z H =)|(Y Z H =)(X H = bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =+= bit设一个系统传送10个数字,0,1,…,9。

信息论与编码答案傅祖芸

信息论与编码答案傅祖芸【篇一:信息论与编码课程设计报告】t>设计题目:统计信源熵与香农编码专业班级学号学生姓名指导教师教师评分2014年3月24日目录一、设计任务与要求................................................. 2 二、设计思路....................................................... 2 三、设计流程图..................................................... 3 四、程序运行及结果................................................. 5 五、心得体会....................................................... 6 参考文献 .......................................................... 6 附录:源程序.. (7)一、设计任务与要求1、统计信源熵要求:统计任意文本文件中各字符(不区分大小写)数量,计算字符概率,并计算信源熵。

2、香农编码要求:任意输入消息概率,利用香农编码方法进行编码,并计算信源熵和编码效率。

二、设计思路1、统计信源熵:统计信源熵就是对一篇英文文章(英文字母数为n),通过对其中的a,b,c,d/a,b,c,d.....(不区分大小写)统计每个字母的个数n,有这个公式p=n/n可得每个字母的概率,最后又信源熵计算公式h(x)=??p(xi)logp(xi)i?1n,可计算出信源熵h,所以整体步骤就是先统计出英文段落的总字符数,在统计每个字符的个数,即每遇到同一个字符就++1,直到算出每个字符的个数,进而算出每个字符的概率,再由信源熵计算公式计算出信源熵。

2、香农编码:香农编码主要通过一系列步骤支出平均码长与信源之间的关系,同时使平均码长达到极限值,即选择的每个码字的长度ki满足下式:i(xi)?ki?i(xi)?1,?i具体步骤如下:a、将信源消息符号按其出现的概率大小依次排列为:p1?p2?......?pn b、确定满足下列不等式的整数码长ki为:?lb(pi)?ki??lb(pi)?1 c、为了编成唯一可译码,计算第i个消息的累加概率:pi??p(ak)k?1i?1d、将累加概率pi变换成二进制数。

信息理论与编码 答案_姚善化_清华大学出版社汇编

H X Y H X H Y X H Y 0.971 0.715 0.722

0.964 (比特/符号) (5)接收到消息 Y 后所获得的平均互信息量为:

I X ,Y H X H X Y 0.971 0.964 0.007 (比特/符号)

7. 某信源的消息符号集的概率分布和二进制代码如题表 2-5 所示。

所以

H

Y2

1 2

log

2

1 2

log

2

1

比特/符号

H Y2

X

1 4

log1

1 4

log 1

1 2

log1

0

比特/符号

I X ;Y2 H Y2 H Y2 X 1 比特/符号

因此第二个实验好些。

( 2 ) I X ;Y1Y2 H Y2Y2 H Y2Y2 X , 因 此 要 求 出 P Y1Y2 , P Y1Y2 X 和

习题 5 表

p y2 x

0 1 2

0 1 1 0

1 0 0 1

(1) 求 I X ;Y1 和 I X ;Y2 ,并判断作哪一个实验好些。

(2) 求 I X ;Y1,Y2 ,并计算作 Y1 和 Y2 两个实验比作 Y1 或 Y2 中的一个实验各可多得多少关于 X

的信息。

(3) 求 I X ;Y1 Y2 和 I X ;Y2 Y1 ,并解释它们的含义。

(3) 计算由 100 个符号构成的符号序列的熵。

答:

2

(1)信源熵为

H

X

1 4

log

4

3 4

log

4 3

0.8113

比特/符号

(2)该特定序列用 A 表示则

I

A

信息论与编码理论课后答案

信息论与编码理论课后答案【篇一:《信息论与编码》课后习题答案】式、含义和效用三个方面的因素。

2、 1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的是建立信息论的基础。

7、8、是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能事件的自信息量是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2?xn?1)h?n???18、离散平稳有记忆信源的极限熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维连续随即变量x在[a,b] 。

1log22?ep21、平均功率为p的高斯分布的连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一离散无记忆信源的信源熵h(x)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为。

2728、同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 ?mn?ki?11?mp(x)?em29、若一维随即变量x的取值区间是[0,∞],其概率密度函数为,其中:x?0,m是x的数学2期望,则x的信源熵c。

信息论与编码第三版答案

信息论与编码第三版答案《信息论与编码》是一本非常经典的书籍,已经成为了信息科学领域中的经典教材。

本书的第三版已经出版,相比于前两版,第三版的变化不小,主要是增加了一些新内容,同时也对一些旧内容做了修改和完善。

作为一本教材,上面的题目和习题都是非常重要的,它们可以帮助读者更好地理解书中的相关概念和知识点,同时也可以帮助读者更好地掌握理论和技术。

因此,本文将介绍《信息论与编码》第三版中部分习题的答案,方便读者快速查阅和学习。

第一章:信息量和熵1.1 习题1.1Q:两个随机变量的独立性和无关性有什么区别?A:独立性和无关性是两个不同的概念。

两个随机变量是独立的,当且仅当它们的联合概率分布等于乘积形式的边缘概率分布。

两个随机变量是无关的,当且仅当它们的协方差等于0。

1.2 习题1.7Q:什么样的随机变量的熵等于0?A:当随机变量的概率分布是确定的(即只有一个概率为1,其余全为0),其熵等于0。

第二章:数据压缩2.5 习题2.9Q:为什么霍夫曼编码比熵编码更加高效?A:霍夫曼编码能够更好地利用信源的统计特征,将出现频率高的符号用较短的二进制编码表示,出现频率低的符号用较长的二进制编码表示。

这样一来,在编码过程中出现频率高的符号会占用较少的比特数,从而能够更加高效地表示信息。

而熵编码则是针对每个符号分别进行编码,没有考虑符号之间的相关性,因此相比于霍夫曼编码更加低效。

第四章:信道编码4.2 习题4.5Q:在线性块码中,什么是生成矩阵?A:在线性块码中,生成矩阵是一个包含所有二元线性组合系数的矩阵。

它可以用来生成码字,即任意输入信息序列可以通过生成矩阵与编码器进行矩阵乘法得到相应的编码输出序列。

4.3 习题4.12Q:简述CRC校验的原理。

A:CRC校验是一种基于循环冗余校验的方法,用于检测在数字通信中的数据传输错误。

其基本思想是将发送数据看作多项式系数,通过对这个多项式进行除法运算,得到余数,将余数添加到数据尾部,发送给接收方。

信息与编码理论课后习题答案

2.1 莫尔斯电报系统中,若采用点长为0.2s ,1划长为0.4s ,且点和划出现的概率分别为2/3和1/3,试求它的信息速率(bits/s)。

解: 平均每个符号长为:1544.0312.032=⨯+⨯秒 每个符号的熵为9183.03log 3123log 32=⨯+⨯比特/符号所以,信息速率为444.34159183.0=⨯比特/秒2.2 一个8元编码系统,其码长为3,每个码字的第一个符号都相同(用于同步),若每秒产生1000个码字,试求其信息速率(bits /s)。

解: 同步信号均相同不含信息,其余认为等概,每个码字的信息量为 3*2=6 比特;所以,信息速率为600010006=⨯比特/秒2.3 掷一对无偏的骰子,若告诉你得到的总的点数为:(a ) 7;(b ) 12。

试问各得到了多少信息量?解: (a)一对骰子总点数为7的概率是366 所以,得到的信息量为 585.2)366(log 2= 比特(b) 一对骰子总点数为12的概率是361 所以,得到的信息量为 17.5361log 2= 比特2.4经过充分洗牌后的一付扑克(含52张牌),试问:(a) 任何一种特定排列所给出的信息量是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解: (a)任一特定排列的概率为!521, 所以,给出的信息量为 58.225!521log 2=- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为 13131313525213!44A C ⨯=所以,得到的信息量为 21.134log 1313522=C 比特.2.5 设有一个非均匀骰子,若其任一面出现的概率与该面上的点数成正比,试求各点出现时所给出的信息量,并求掷一次平均得到的信息量。

解:易证每次出现i 点的概率为21i,所以比特比特比特比特比特比特比特398.221log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21log )(2612=-==============-==∑=i i X H x I x I x I x I x I x I i ii x I i2.6 园丁植树一行,若有3棵白杨、4棵白桦和5棵梧桐。

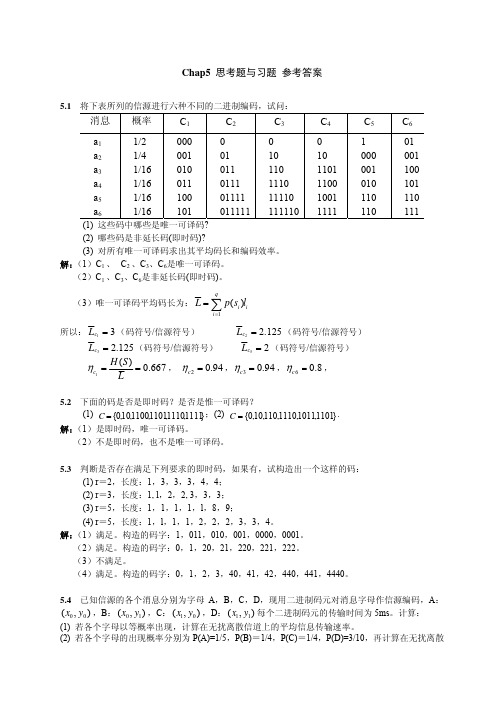

信息论与编码第五章习题参考答案

5.1某离散无记忆信源的概率空间为采用香农码和费诺码对该信源进行二进制变长编码,写出编码输出码字,并且求出平均码长和编码效率。

解:计算相应的自信息量1)()(11=-=a lbp a I 比特 2)()(22=-=a lbp a I 比特 3)()(313=-=a lbp a I 比特 4)()(44=-=a lbp a I 比特 5)()(55=-=a lbp a I 比特 6)()(66=-=a lbp a I 比特 7)()(77=-=a lbp a I 比特 7)()(77=-=a lbp a I 比特根据香农码编码方法确定码长1)()(+<≤i i i a I l a I平均码长984375.164/6317128/17128/1664/1532/1416/138/124/112/1L 1=+=⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯=由于每个符号的码长等于自信息量,所以编码效率为1。

费罗马编码过程5.2某离散无记忆信源的概率空间为使用费罗码对该信源的扩展信源进行二进制变长编码,(1) 扩展信源长度,写出编码码字,计算平均码长和编码效率。

(2) 扩展信源长度,写出编码码字,计算平均码长和编码效率。

(3) 扩展信源长度,写出编码码字,计算平均码长和编码效率,并且与(1)的结果进行比较。

解:信息熵811.025.025.075.075.0)(=--=lb lb X H 比特/符号 (1)平均码长11=L 比特/符号编码效率为%1.81X)(H 11==L η(2)平均码长为84375.0)3161316321631169(212=⨯+⨯+⨯+⨯=L 比特/符号 编码效率%9684375.0811.0X)(H 22===L η(3)当N=4时,序列码长309.3725617256362563352569442569242562732562732256814=⨯+⨯+⨯⨯+⨯⨯+⨯⨯+⨯+⨯⨯+⨯=L平均码长827.04309.34==L %1.98827.0811.0X)(H 43===L η可见,随着信源扩展长度的增加,平均码长逐渐逼近熵,编码效率也逐渐提高。

信息理论与编码课后答案(吕锋王虹着)

第一章教材习题1.1.试述信息与知识、消息和信号之间的区别与联系,并举例说明。

1.2.详述钟义信先生的信息定义体系。

1.3.试查阅文献,说明信息具有哪些特征和性质?1.4.说明通信系统模型由哪几部分组成,并详细讨论每一部分的功能。

1.5.试述信息论的研究内容?第二章教材习题信源模型2.1试简述信源分类以及各种信源特点。

信息的描述2.2在非理想观察模型中,存在哪些不确定性,它们与信息有何关系?不确定性与信息2.3一副充分洗乱的牌(含52张),试问:(1)任一特定排列所给出的不确定性是多少?(2)随机抽取13张牌,13张牌的点数互不相同时的不确定性是多少?2.4同时扔出两个正常的骰子,也就是各面呈现的概率都是1/6,求:(1)“3和5同时出现”这事件的自信息量。

(2)“两个1同时出现”这事件的自信息量。

(3)两个点数的各种组合(无序对)的统计平均自信息量。

(4)两个点数之和(即2,3,…,12构成的子集)的熵。

(5)两个点数中至少有一个是1的自信息量。

2.5设在一只布袋中装有100只对人手的感觉完全相同的木球,每只上涂有1种颜色。

100只球的颜色有下列三种情况:(1)红色球和白色球各50只;(2)红色球99只,白色球1只;(3)红,黄,蓝,白色各25只。

求从布袋中随意取出一只球时,猜测其颜色所需要的信息量。

2.8大量统计表明,男性红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男同志是否为红绿色盲,他回答“是”或“否”。

(1)这二个回答中各含多少信息量?(2)平均每个回答中含有多少信息量?(3)如果你问一位女同志,则答案中含有的平均信息量是多少?联合熵和条件熵2.9任意三个离散随机变量X 、Y 和Z ,求证:()()()()H XYZ H XY H XZ H X −≤−。

平均互信息及其性质2.11设随机变量12{,}{0,1}X x x ==和12{,}{0,1}Y y y ==的联合概率空间为11122122(,)(,)(,)(,)133818XY XY x y x y x y x y P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦定义一个新随机变量Z X Y =×(普通乘积)。

《信息论与编码理论》(王育民李晖梁传甲)课后习题问题详解高等教育出版社

信息论与编码理论习题解第二章-信息量和熵2.1解: 平均每个符号长为:1544.0312.032=⨯+⨯秒 每个符号的熵为9183.03log 3123log 32=⨯+⨯比特/符号所以信息速率为444.34159183.0=⨯比特/秒2.2 解: 同步信号均相同不含信息,其余认为等概,每个码字的信息量为 3*2=6 比特; 所以信息速率为600010006=⨯比特/秒2.3 解:(a)一对骰子总点数为7的概率是366 所以得到的信息量为 585.2)366(log 2= 比特 (b) 一对骰子总点数为12的概率是361 所以得到的信息量为 17.5361log 2= 比特 2.4 解: (a)任一特定排列的概率为!521,所以给出的信息量为 58.225!521log 2=- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为13521313521344!13C A =⨯所以得到的信息量为 21.134log 1313522=C 比特.2.5 解:易证每次出现i 点的概率为21i,所以比特比特比特比特比特比特比特398.221log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21log )(2612=-==============-==∑=i i X H x I x I x I x I x I x I i ii x I i2.6 解: 可能有的排列总数为27720!5!4!3!12= 没有两棵梧桐树相邻的排列数可如下图求得, Y X Y X Y X Y X Y X Y X Y X Y图中X 表示白杨或白桦,它有⎪⎪⎭⎫⎝⎛37种排法,Y 表示梧桐树可以栽种的位置,它有⎪⎪⎭⎫⎝⎛58种排法,所以共有⎪⎪⎭⎫ ⎝⎛58*⎪⎪⎭⎫⎝⎛37=1960种排法保证没有两棵梧桐树相邻,因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为1960log 27720log 22-=3.822 比特 2.7 解: X=0表示未录取,X=1表示录取; Y=0表示本市,Y=1表示外地;Z=0表示学过英语,Z=1表示未学过英语,由此得比特比特比特)01(log )01()0()00(log )00()0()(8113.04log 4134log 43)()(02698.04110435log 104354310469log 10469)1()01(log )01()0()00(log )00()0;(104352513/41)522121()0(/)1())11()1,10()10()1,00(()01(104692513/43)104109101()0(/)0())01()0,10()00()0,00(()00()(4512.04185log 854383log 83)1()01(log )01()0()00(log )00()0;(8551/4121)0(/)1()10()01(8351/43101)0(/)0()00()00()(,251225131)1(,2513100405451)10()1()00()0()0(,54511)1(,51101432141)10()1()00()0()0(,41)1(,43)0(222222222222+=====+=======+==+======+========⨯⨯+========+=========⨯⨯+========+=========+======+========⨯=========⨯=========-===⨯+====+======-===⨯+⨯====+=========x y p x y p x p x y p x y p x p X Y H X H c x p z x p z x p x p z x p z x p z X I z p x p x y p x y z p x y p x y z p z x p z p x p x y p x y z p x y p x y z p z x p b x p y x p y x p x p y x p y x p y X I y p x p x y p y x p y p x p x y p y x p a z p y z p y p y z p y p z p y p x y p x p x y p x p y p x p x p2.8 解:令{}{}R F T Y B A X ,,,,==,则比特得令同理03645.0)()(5.0,02.03.0)2.05.0(log 2.0)()2.05.0(log )2.05.0()2.03.0(log )2.03.0(5.0log 5.03.0log 3.0)5log )1(2.02log )1(5.0log )1(3.05log 2.0log 3.02log 5.0(2.0log 2.0)2.05.0(log )2.05.0()2.03.0(log )2.03.0()()();()(2.0)(,2.05.0)(2.03.0)1(3.05.0)()()()()(5.0max 2'2222223102231022222==∴==+-=---++-+=-+-+-+++-----++-=-===-=+=-⨯+=+==p p I p I p pp p I p p p p p p p p p p p p p p X Y H Y H Y X I p I R P p F P pp p B P B T P A P A T P T P2.9 & 2.12解:令X=X 1,Y=X 1+X 2,Z=X 1+X 2+X 3, H(X 1)=H(X 2)=H(X 3)= 6log 2 比特 H(X)= H(X 1) = 6log 2 =2.585比特 H(Y)= H(X 2+X 3)=6log 61)536log 365436log 364336log 363236log 36236log 361(2222222+++++ = 3.2744比特 H(Z)= H(X 1+X 2+X 3)=)27216log 2162725216log 2162521216log 2162115216log 2161510216log 216106216log 21663216log 2163216log 2161(222222222++++++= 3.5993比特 所以H(Z/Y)= H(X 3)= 2.585 比特 H(Z/X) = H(X 2+X 3)= 3.2744比特 H(X/Y)=H(X)-H(Y)+H(Y/X) = 2.585-3.2744+2.585 =1.8955比特H(Z/XY)=H(Z/Y)= 2.585比特 H(XZ/Y)=H(X/Y)+H(Z/XY) =1.8955+2.585 =4.4805比特 I(Y;Z)=H(Z)-H(Z/Y) =H(Z)- H(X 3)= 3.5993-2.585 =1.0143比特 I(X;Z)=H(Z)-H(Z/X)=3.5993- 3.2744 =0.3249比特 I(XY ;Z)=H(Z)-H(Z/XY) =H(Z)-H(Z/Y)=1.0143比特 I(Y;Z/X)=H(Z/X)-H(Z/XY) = H(X 2+X 3)-H(X 3) =3.2744-2.585 =0.6894比特 I(X;Z/Y)=H(Z/Y)-H(Z/XY) =H(Z/Y)-H(Z/Y) =02.10 解:设系统输出10个数字X 等概,接收数字为Y,显然101)(101)()()(919===∑∑==i j p i j p i Q j w i iH(Y)=log10比特奇奇奇奇偶18log 81101452log 211015)(log)()()(log )()(0)(log ),()(log ),()(22,2222=⨯⨯⨯⨯+⨯⨯⨯=--=--=∑∑∑∑∑∑∑≠====x y p x y p x p x x p x x p x p x y p y x p x y p y x p X Y H x y x i y x y x所以I(X;Y)= 3219.2110log 2=-比特2.11 解:(a )接收前一个数字为0的概率 2180)0()()0(==∑=i i i u p u q wbits p pw u p u I )1(log 11log )0()0(log )0;(2212121-+=-==(b )同理 418)00()()00(==∑=ii iu p u q wbits p p w u p u I )1(log 22)1(log )00()00(log )00;(24122121-+=-== (c )同理 818)000()()000(==∑=ii iu p u q wbits p p w u p u I )1(log 33)1(log )000()000(log )000;(28132121-+=-== (d )同理 ))1(6)1(()0000()()0000(4226818p p p p u p u q w ii i+-+-==∑=bitsp p p p p p p p p p w u p u I 42264242268142121)1(6)1()1(8log ))1(6)1(()1(log )0000()0000(log )0000;(+-+--=+-+--==2.12 解:见2.9 2.13 解: (b))/()/()/(1log)()/(1log)()/()/(1log)()/(1log)()/(XY Z H X Y H xy z p xyz p x y p xyz p xy z p x y p xyz p x yz p xyz p X YZ H x y z xyzxyzxyz+=+===∑∑∑∑∑∑∑∑∑∑∑∑(c))/()/(1log)/()()/(1log)/()()/(X Z H x z p xy z p xy p xy z p xy z p xy p XY Z H xyzxyz=≤=∑∑∑∑∑∑(由第二基本不等式) 或)1)/()/((log )/()()/()/(log)/()()/(1log)/()()/(1log)/()()/()/(=-⨯≤=-=-∑∑∑∑∑∑∑∑∑∑∑∑xy z p x z p e xy z p xy p xy z p x z p xy z p xy p x z p xy z p xy p xy z p xy z p xy p X Z H XY Z H xyzxyzxyzxyz(由第一基本不等式)所以)/()/(X Z H XY Z H ≤(a))/()/()/()/()/(X YZ H XY Z H X Y H X Z H X Y H =+≥+等号成立的条件为)/()/(x z p xy z p =,对所有Z z Y y X x ∈∈∈,,,即在给定X 条件下Y 与Z 相互独立。

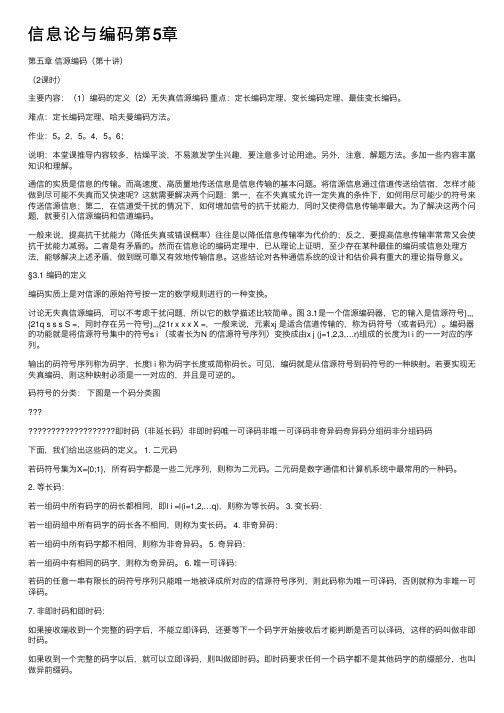

信息论与编码第5章

信息论与编码第5章第五章信源编码(第⼗讲)(2课时)主要内容:(1)编码的定义(2)⽆失真信源编码重点:定长编码定理、变长编码定理、最佳变长编码。

难点:定长编码定理、哈夫曼编码⽅法。

作业:5。

2,5。

4,5。

6;说明:本堂课推导内容较多,枯燥平淡,不易激发学⽣兴趣,要注意多讨论⽤途。

另外,注意,解题⽅法。

多加⼀些内容丰富知识和理解。

通信的实质是信息的传输。

⽽⾼速度、⾼质量地传送信息是信息传输的基本问题。

将信源信息通过信道传送给信宿,怎样才能做到尽可能不失真⽽⼜快速呢?这就需要解决两个问题:第⼀,在不失真或允许⼀定失真的条件下,如何⽤尽可能少的符号来传送信源信息;第⼆,在信道受⼲扰的情况下,如何增加信号的抗⼲扰能⼒,同时⼜使得信息传输率最⼤。

为了解决这两个问题,就要引⼊信源编码和信道编码。

⼀般来说,提⾼抗⼲扰能⼒(降低失真或错误概率)往往是以降低信息传输率为代价的;反之,要提⾼信息传输率常常⼜会使抗⼲扰能⼒减弱。

⼆者是有⽭盾的。

然⽽在信息论的编码定理中,已从理论上证明,⾄少存在某种最佳的编码或信息处理⽅法,能够解决上述⽭盾,做到既可靠⼜有效地传输信息。

这些结论对各种通信系统的设计和估价具有重⼤的理论指导意义。

§3.1 编码的定义编码实质上是对信源的原始符号按⼀定的数学规则进⾏的⼀种变换。

讨论⽆失真信源编码,可以不考虑⼲扰问题,所以它的数学描述⽐较简单。

图 3.1是⼀个信源编码器,它的输⼊是信源符号},,, {21q s s s S =,同时存在另⼀符号},,,{21r x x x X =,⼀般来说,元素xj 是适合信道传输的,称为码符号(或者码元)。

编码器的功能就是将信源符号集中的符号s i (或者长为N 的信源符号序列)变换成由x j (j=1,2,3,…r)组成的长度为l i 的⼀⼀对应的序列。

输出的码符号序列称为码字,长度l i 称为码字长度或简称码长。

可见,编码就是从信源符号到码符号的⼀种映射。

信息理论与编码

1、单选题下列不属于消息的是( )。

2分文字信号图像语言标准答案: B2、单选题设有一个无记忆信源发出符号A和B,已知[如图1],发出二重符号序列消息的信源,无记忆信源熵[如图2]为( )。

2分图1图20.81bit/二重符号1.62bit/二重符号0.93 bit/二重符号1.86 bit/二重符号标准答案: B3、单选题同时扔两个正常的骰子,即各面呈现的概率都是1/6,若点数之和为12,则得到的自信息为( )。

2分-log36bitlog36bit-log(11/36)bitlog(11/36)bit标准答案: B4、单选题二进制通信系统使用符号0和1,由于存在失真,传输时会产生误码,用符号表示下列事件,x0: 发出一个0 、x1: 发出一个1、y0 :收到一个0、y1:收到一个1 ,则已知收到的符号,被告知发出的符号能得到的信息量是( )。

2分H(X/Y)H(Y/X)H(X,Y)H(XY)标准答案: A5、单选题一个随即变量x的概率密度函数P(x)= x /2,[如图1],则信源的相对熵为( )。

2分图10.5bit0.72bit1bit1.44bit标准答案: C6、单选题下面哪一项不属于熵的性质:( )。

2分非负性完备性对称性确定性标准答案: B7、单选题根据树图法构成规则,( )。

2分在树根上安排码字在树枝上安排码字在中间节点上安排码字在终端节点上安排码字标准答案: D8、单选题下列组合中不属于即时码的是( )。

2分{0,01,011}{0,10,110}{00,10,11}{1,01,00}标准答案: A9、单选题已知某(6,3)线性分组码的生成矩阵[如图1],则不用计算就可判断出下列码中不是该码集里的码是( )。

2分图1000000110001011101111111标准答案: D10、单选题下列保密编码中属于现代密码体制的是( )2分凯撒密码Vigenere密码韦维纳姆密码DES加密算法标准答案: D11、单选题1948年,美国数学家( )发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

信息理论与编码答案 人民邮电出版社

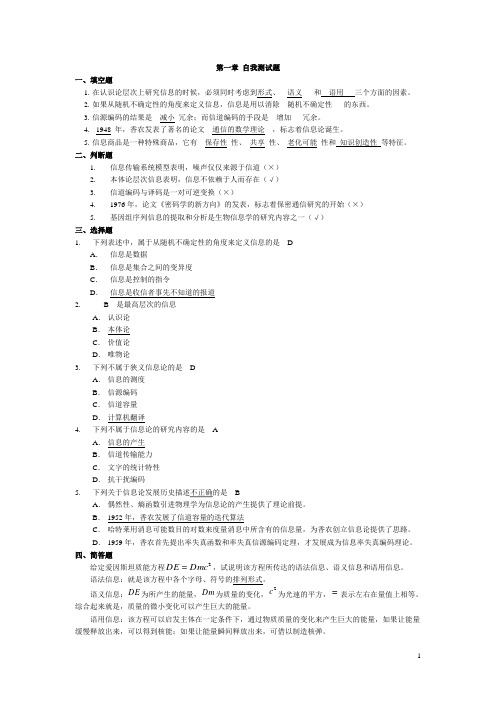

第一章 自我测试题一、填空题1. 在认识论层次上研究信息的时候,必须同时考虑到形式、__语义___和__语用___三个方面的因素。

2. 如果从随机不确定性的角度来定义信息,信息是用以消除__随机不确定性___的东西。

3. 信源编码的结果是__减小_冗余;而信道编码的手段是__增加___冗余。

4. _1948_年,香农发表了著名的论文__通信的数学理论__,标志着信息论诞生。

5. 信息商品是一种特殊商品,它有__保存性_性、_共享_性、_老化可能_性和 知识创造性 等特征。

二、判断题1. 信息传输系统模型表明,噪声仅仅来源于信道(×)2. 本体论层次信息表明,信息不依赖于人而存在(√)3. 信道编码与译码是一对可逆变换(×)4. 1976年,论文《密码学的新方向》的发表,标志着保密通信研究的开始(×)5. 基因组序列信息的提取和分析是生物信息学的研究内容之一(√)三、选择题1.下列表述中,属于从随机不确定性的角度来定义信息的是__D___ A . 信息是数据B . 信息是集合之间的变异度C . 信息是控制的指令D . 信息是收信者事先不知道的报道 2.___B__是最高层次的信息 A . 认识论 B . 本体论 C . 价值论 D . 唯物论 3.下列不属于狭义信息论的是__D___ A . 信息的测度 B . 信源编码 C . 信道容量 D . 计算机翻译 4.下列不属于信息论的研究内容的是__A___ A . 信息的产生 B . 信道传输能力 C . 文字的统计特性 D . 抗干扰编码 5.下列关于信息论发展历史描述不正确的是__B___A . 偶然性、熵函数引进物理学为信息论的产生提供了理论前提。

B . 1952年,香农发展了信道容量的迭代算法C . 哈特莱用消息可能数目的对数来度量消息中所含有的信息量,为香农创立信息论提供了思路。

D . 1959年,香农首先提出率失真函数和率失真信源编码定理,才发展成为信息率失真编码理论。

信息论与编码技术第五章课后习题答案

码,并求出其编码效率。

解:

信源符号 概率 编码

码字 码长

X1

3/8 0

0

1

X2

1/6 1

0

10 2

X3

1/8

1

11 2

X4

1/8 2

0

20 2

X5

1/8

1

21 2

X6

1/12

2

22 2

H(X)=-((3/8)*log(3/8)+(1/6)*log(1/6)+(1/8)*log(1/8)+(1/8)*log(1/8)+(1/8)*log(1/8)+(1/12)*log(1/12))

=2.3852 (三进制单位/信源符号)

H3(X)= H(X)/ 1.5850=2.3852/1.5850= 1.5049(三进制单位/信源符号)

L =(3/8)*1+ (1/6)*2+ (1/8)*2+ (1/8)*2+ (1/8)*2+ (1/12)*2=1.625(码符号/信源符号)

η= H3(X)/ L =1.5049/1.625= 92.61 %

5.8 已知符号集合 {x1, x2 , x3,"} 为无限离散消息集合,它们出现的概率分别为 p(x1) = 1/ 2 , p(x2 ) = 1/ 4 , p(x3 ) = 1/ 8 , p(xi ) = 1/ 2i ,……。

(1) 用香农编码方法写出各个符号消息的码字。 (2) 计算码字的平均信息传输速率。

L =4*(1/4)*1=1(码符号/信源符号)

Rt= H(X)/(t* L )=1/(1*10*10-2)=10(比特/秒)

信息论与编码答案傅祖芸

信息论与编码答案傅祖芸【篇一:信息论与编码课程设计报告】t>设计题目:统计信源熵与香农编码专业班级学号学生姓名指导教师教师评分2014年3月24日目录一、设计任务与要求................................................. 2 二、设计思路....................................................... 2 三、设计流程图..................................................... 3 四、程序运行及结果................................................. 5 五、心得体会....................................................... 6 参考文献 .......................................................... 6 附录:源程序.. (7)一、设计任务与要求1、统计信源熵要求:统计任意文本文件中各字符(不区分大小写)数量,计算字符概率,并计算信源熵。

2、香农编码要求:任意输入消息概率,利用香农编码方法进行编码,并计算信源熵和编码效率。

二、设计思路1、统计信源熵:统计信源熵就是对一篇英文文章(英文字母数为n),通过对其中的a,b,c,d/a,b,c,d.....(不区分大小写)统计每个字母的个数n,有这个公式p=n/n可得每个字母的概率,最后又信源熵计算公式h(x)=??p(xi)logp(xi)i?1n,可计算出信源熵h,所以整体步骤就是先统计出英文段落的总字符数,在统计每个字符的个数,即每遇到同一个字符就++1,直到算出每个字符的个数,进而算出每个字符的概率,再由信源熵计算公式计算出信源熵。

2、香农编码:香农编码主要通过一系列步骤支出平均码长与信源之间的关系,同时使平均码长达到极限值,即选择的每个码字的长度ki满足下式:i(xi)?ki?i(xi)?1,?i具体步骤如下:a、将信源消息符号按其出现的概率大小依次排列为:p1?p2?......?pn b、确定满足下列不等式的整数码长ki为:?lb(pi)?ki??lb(pi)?1 c、为了编成唯一可译码,计算第i个消息的累加概率:pi??p(ak)k?1i?1d、将累加概率pi变换成二进制数。

《信息理论与编码》-答案-考试重点(1--3章)

《信息理论与编码》习题参考答案1. 信息是什么?信息与消息有什么区别和联系?答:信息是对事物存在和运动过程中的不确定性的描述。

信息就是各种消息符号所包含的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2. 语法信息、语义信息和语用信息的定义是什么?三者的关系是什么? 答:语法信息是最基本最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。

语义信息是对客观现象的具体描述,不对现象本身做出优劣判断。

语用信息是信息的最高层次。

它以语法、语义信息为基础,不仅要考虑状态和状态之间关系以及它们的含义,还要进一步考察这种关系及含义对于信息使用者的效用和价值。

三者之间是内涵与外延的关系。

第2章1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量?答:依据题意,这一随机事件的概率空间为120.80.2X x x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦其中:1x 表示摸出的球为红球事件,2x 表示摸出的球是白球事件。

a)如果摸出的是红球,则获得的信息量是()()11log log0.8I x p x =-=-(比特)b)如果摸出的是白球,则获得的信息量是()()22log log0.2I x p x =-=-(比特)c) 如果每次摸出一个球后又放回袋中,再进行下一次摸取。

则如此摸取n 次,红球出现的次数为()1np x 次,白球出现的次数为()2np x 次。

随机摸取n 次后总共所获得信息量为()()()()1122np x I x np x I x +d)则平均随机摸取一次所获得的信息量为()()()()()()()()()112211221log log 0.72 H X np x I x np x I x n p x p x p x p x =+⎡⎤⎣⎦=-+⎡⎤⎣⎦=比特/次2. 居住某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

信息论与编码第二版答案 (3)

信息论与编码第二版答案第一章:信息论基础1.问题:信息论的基本概念是什么?答案:信息论是一种数学理论,研究的是信息的表示、传输和处理。

它的基本概念包括:信息、信息的熵和信息的编码。

2.问题:什么是信息熵?答案:信息熵是信息的度量单位,表示信息的不确定度。

它的计算公式为H(X) = -ΣP(x) * log2(P(x)),其中P(x)表示事件x发生的概率。

3.问题:信息熵有什么特性?答案:信息熵具有以下特性:•信息熵的值越大,表示信息的不确定度越高;•信息熵的值越小,表示信息的不确定度越低;•信息熵的最小值为0,表示信息是确定的。

4.问题:信息熵与概率分布有什么关系?答案:信息熵与概率分布之间存在着直接的关系。

当概率分布均匀时,信息熵达到最大值;而当概率分布不均匀时,信息熵会减小。

第二章:数据压缩1.问题:数据压缩的目的是什么?答案:数据压缩的目的是通过消除冗余和重复信息,使数据占用更少的存储空间或传输更快。

2.问题:数据压缩的两种基本方法是什么?答案:数据压缩可以通过无损压缩和有损压缩两种方法来实现。

无损压缩是指压缩后的数据可以完全还原为原始数据;而有损压缩则是指压缩后的数据不完全还原为原始数据。

3.问题:信息压缩的度量单位是什么?答案:信息压缩的度量单位是比特(bit),表示信息的数量。

4.问题:哪些方法可以用于数据压缩?答案:数据压缩可以通过以下方法来实现:•无结构压缩方法:如霍夫曼编码、算术编码等;•有结构压缩方法:如词典编码、RLE编码等;•字典方法:如LZW、LZ77等。

第三章:信道容量1.问题:什么是信道容量?答案:信道容量是指在给定信噪比的条件下,信道传输的最大数据速率。

2.问题:信道容量的计算公式是什么?答案:信道容量的计算公式为C = W * log2(1 + S/N),其中C表示信道容量,W表示信道带宽,S表示信号的平均功率,N表示噪声的平均功率。

3.问题:信道容量与信噪比有什么关系?答案:信道容量与信噪比成正比,信噪比越高,信道容量越大;反之,信噪比越低,信道容量越小。

信息论与编码理论课后答案

信息论与编码理论课后答案【篇一:《信息论与编码》课后习题答案】式、含义和效用三个方面的因素。

2、 1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的是建立信息论的基础。

7、8、是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能事件的自信息量是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2?xn?1)h?n???18、离散平稳有记忆信源的极限熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维连续随即变量x在[a,b] 。

1log22?ep21、平均功率为p的高斯分布的连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一离散无记忆信源的信源熵h(x)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为。

2728、同时掷两个正常的骰子,各面呈现的概率都为1/6,则“3和5同时出现”这件事的自信息量是 ?mn?ki?11?mp(x)?em29、若一维随即变量x的取值区间是[0,∞],其概率密度函数为,其中:x?0,m是x的数学2期望,则x的信源熵c。

信息论与编码理论-习题答案-姜楠-王健-编著-清华大学

可得 ,3种状态等概率分布。

一阶马尔可夫信源熵为

信源剩余度为

(2)二阶马尔可夫信源有9种状态(状态转移图略),同样列方程组求得状态的平稳分布为

二阶马尔可夫信源熵为

信源剩余度为

由于在上述两种情况下,3个符号均为等概率分布,所以信源剩余度都等于0。

总的概率

所需要的信息量

2.6设 表示“大学生”这一事件, 表示“身高1.60m以上”这一事件,则

故

2.7四进制波形所含的信息量为 ,八进制波形所含信息量为 ,故四进制波形所含信息量为二进制的2倍,八进制波形所含信息量为二进制的3倍。

2.8

故以3为底的信息单位是比特的1.585倍。

2.9(1)J、Z(2)E(3)X

(2)三元对称强噪声信道模型如图所示。

4.7由图可知信道1、2的信道矩阵分别为

它们串联后构成一个马尔科夫链,根据马氏链的性质,串联后总的信道矩阵为

4.8传递矩阵为

输入信源符号的概率分布可以写成行向量形式,即

由信道传递矩阵和输入信源符号概率向量,求得输出符号概率分布为

输入符号和输出符号的联合概率分布为

由冗余度计算公式得

3.18(1)由一步转移概率矩阵与二步转移概率矩阵的公式 得

(2)设平稳状态 ,马尔可夫信源性质知 ,即

求解得稳态后的概率分布

3.19设状态空间S= ,符号空间

且

一步转移概率矩阵

状态转移图

设平稳状态 ,由马尔可夫信源性质有

即

可得

马尔可夫链只与前一个符号有关,则有

3.20消息元的联合概率是

平均信息传输速率

信息理论与编码课后答案第5章

第5章 有噪信道编码5.1 基本要求通过本章学习,了解信道编码的目的,了解译码规则对错误概率的影响,掌握两种典型的译码规则:最佳译码规则和极大似然译码规则。

掌握信息率与平均差错率的关系,掌握最小汉明距离译码规则,掌握有噪信道编码定理(香农第二定理)的基本思想,了解典型序列的概念,了解定理的证明方法,掌握线性分组码的生成和校验。

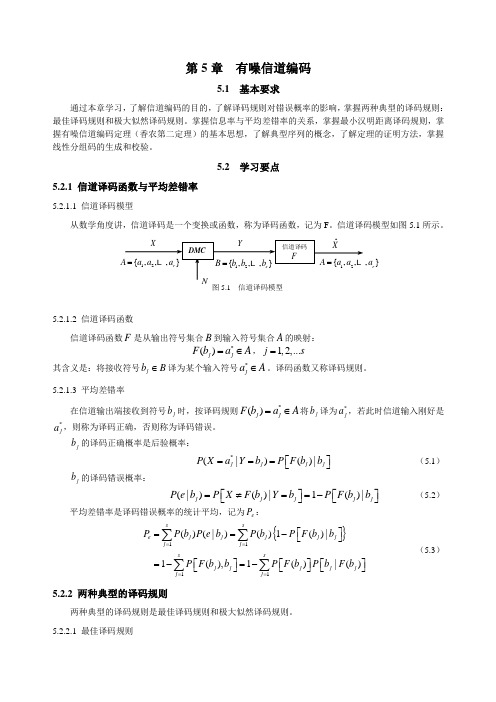

5.2 学习要点5.2.1 信道译码函数与平均差错率5.2.1.1 信道译码模型从数学角度讲,信道译码是一个变换或函数,称为译码函数,记为F 。

信道译码模型如图5.1所示。

5.2.1.2 信道译码函数信道译码函数F 是从输出符号集合B 到输入符号集合A 的映射:*()j j F b a A =∈,1,2,...j s =其含义是:将接收符号j b B ∈译为某个输入符号*j a A ∈。

译码函数又称译码规则。

5.2.1.3 平均差错率在信道输出端接收到符号j b 时,按译码规则*()j j F b a A =∈将j b 译为*j a ,若此时信道输入刚好是*j a ,则称为译码正确,否则称为译码错误。

j b 的译码正确概率是后验概率:*(|)()|j j j j P X a Y b P F b b ⎡⎤===⎣⎦ (5.1)j b 的译码错误概率:(|)()|1()|j j j j j P e b P X F b Y b P F b b ⎡⎤⎡⎤=≠==-⎣⎦⎣⎦ (5.2)平均差错率是译码错误概率的统计平均,记为e P :{}1111()(|)()1()|1(),1()|()s se j j j j j j j ssj j j j j j j P P b P e b P b P F b b P F b b P F b P b F b ====⎡⎤==-⎣⎦⎡⎤⎡⎤⎡⎤=-=-⎣⎦⎣⎦⎣⎦∑∑∑∑ (5.3)5.2.2 两种典型的译码规则两种典型的译码规则是最佳译码规则和极大似然译码规则。

信息理论与编码》,答案,考试重点(1--3章)

《信息理论与编码》习题参考答案1. 信息是什么信息与消息有什么区别和联系答:信息是对事物存在和运动过程中的不确定性的描述。

信息就是各种消息符号所包含的具有特定意义的抽象内容,而消息是信息这一抽象内容通过语言、文字、图像和数据等的具体表现形式。

2. 语法信息、语义信息和语用信息的定义是什么三者的关系是什么答:语法信息是最基本最抽象的类型,它只是表现事物的现象而不考虑信息的内涵。

语义信息是对客观现象的具体描述,不对现象本身做出优劣判断。

语用信息是信息的最高层次。

它以语法、语义信息为基础,不仅要考虑状态和状态之间关系以及它们的含义,还要进一步考察这种关系及含义对于信息使用者的效用和价值。

三者之间是内涵与外延的关系。

第2章1. 一个布袋内放100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量答:依据题意,这一随机事件的概率空间为120.80.2X x x P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦其中:1x 表示摸出的球为红球事件,2x 表示摸出的球是白球事件。

a)如果摸出的是红球,则获得的信息量是()()11log log0.8I x p x =-=-(比特)b)如果摸出的是白球,则获得的信息量是()()22log log0.2I x p x =-=-(比特)c) 如果每次摸出一个球后又放回袋中,再进行下一次摸取。

则如此摸取n 次,红球出现的次数为()1np x 次,白球出现的次数为()2np x 次。

随机摸取n 次后总共所获得信息量为()()()()1122np x I x np x I x +d)则平均随机摸取一次所获得的信息量为()()()()()()()()()112211221log log 0.72 H X np x I x np x I x n p x p x p x p x =+⎡⎤⎣⎦=-+⎡⎤⎣⎦=比特/次2. 居住某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第5章有噪信道编码5.1 基本要求通过本章学习,了解信道编码的目的,了解译码规则对错误概率的影响,掌握两种典型的译码规则:最佳译码规则和极大似然译码规则。

掌握信息率与平均差错率的关系,掌握最小汉明距离译码规则,掌握有噪信道编码定理(香农第二定理)的基本思想,了解典型序列的概念,了解定理的证明方法,掌握线性分组码的生成和校验。

5.2 学习要点5.2.1 信道译码函数与平均差错率5.2.1.1 信道译码模型从数学角度讲,信道译码是一个变换或函数,称为译码函数,记为F 。

信道译码模型如图5.1所示。

5.2.1.2 信道译码函数信道译码函数F 是从输出符号集合B 到输入符号集合A 的映射:*()j j F b a A =∈,1,2,...j s =其含义是:将接收符号j b B ∈译为某个输入符号*j a A ∈。

译码函数又称译码规则。

5.2.1.3 平均差错率在信道输出端接收到符号j b 时,按译码规则*()j j F b a A =∈将j b 译为*j a ,若此时信道输入刚好是*j a ,则称为译码正确,否则称为译码错误。

j b 的译码正确概率是后验概率:*(|)()|j j j j P X a Y b P F b b ⎡⎤===⎣⎦ (5.1)j b 的译码错误概率:(|)()|1()|j j j j j P e b P X F b Y b P F b b ⎡⎤⎡⎤=≠==-⎣⎦⎣⎦ (5.2)平均差错率是译码错误概率的统计平均,记为e P :{}1111()(|)()1()|1(),1()|()s se j j j j j j j ssj j j j j j j P P b P e b P b P F b b P F b b P F b P b F b ====⎡⎤==-⎣⎦⎡⎤⎡⎤⎡⎤=-=-⎣⎦⎣⎦⎣⎦∑∑∑∑ (5.3)5.2.2 两种典型的译码规则两种典型的译码规则是最佳译码规则和极大似然译码规则。

图5.1 信道译码模型}r a5.2.2.1 最佳译码规则使e P 达到最小的译码规则称为最佳译码规则。

这种规则是按后验概率最大原则定出的,所以又称最大后验概率译码规则。

**(),:(|)(|),j j j j j i j i F b a A b BF P a b P a b a A⎧=∈∈⎪⎨∈⎪⎩≥ (5.4) 上式中最大后验概率条件可等价成最大联合概率条件。

将*(|)(|)j j i j P a b P a b ≥两边乘以()j P b ,变换为*(,(,)j j i j P a b P a b )≥。

因此,最佳译码规则又可表示成:**(),:(,)(,),j j j j j i j i F b a A b BF P a b P a b a A⎧=∈∈⎪⎨∈⎪⎩≥ (5.5) 因为使用最大联合概率条件,所以又称为最大联合概率译码规则。

5.2.2.2 极大似然译码规则按最大转移概率条件来确定的译码规则,称为极大似然译码规则:**(),:(|)(|),j j j j j j i i F b a A b B F P b a P b a a A⎧=∈∈⎪⎨∈⎪⎩≥ (5.6) 虽然极大似然译码规则的平均差错率不是最小,不是最佳的,但最易找出。

可以证明,当信道输入等概时,极大似然译码规则与最大联合概率译码规则等价,此时极大似然译码规则也是最佳的。

5.2.3 信道编码对平均差错率和信息率的影响信道编码(或称纠错编码)是靠增加冗余码元来克服或减轻噪声影响的。

冗余是相对于信息的表示而言,但是对提高传送可靠性来说,冗余码元却提供了极宝贵的可靠性信息。

以下以两种简单信道编码方法来说明信道编码对平均差错率和信息率的影响。

5.2.3.1 “简单重复”编码日常中人们可以通过重复某句话使别人听得更清楚。

数字通信中,将符号重复传几次,也会提高传送可靠性。

例如,“重复2次”编码,如图5.2所示。

编码规则为图5.2 “重复2次”编码112345672800000010100111001011101111ffu u αααααααα=−−→========−−→=12345678000001010011100101110111ββββββββ========12000111αα==0000:1111f →⎧⎨→⎩ 扩展信道的转移矩阵为331234567832222223132222223|8[]Y X p p p p p pp p p pp pp p P ppp pp p ppp p pp pp ββββββββαα⎡⎤=⎢⎥⎢⎥⎣⎦按极大似然译码规则得译码函数:1121314851687888()()()()()()()()F F F F F F F F βαβαβαβαβαβαβαβα========即4162183758011000101001000111010110100111FFββββααββββ==⎫⎫⎪⎪==⎪⎪−−→=−−→=⎬⎬==⎪⎪⎪⎪==⎭⎭信道编码之后的信息率为()H U R N=b i t /码元 (5.7) 若信源等概率分布,则log MR N=b i t /码元 (5.8) 其中M 代表信源消息(符号)个数。

无编码 log 2111N R === b i t /码元 210e P -= “重复2次”编码 log 21333N R === b i t /码元 4310e P -=⨯155N R == bit /码元 510e P -=177N R == bit /码元 7410e P -=⨯随着“重复”次数的增加,e P 下降,但R 也跟着下降。

即信息传输的有效性和可靠性是矛盾的。

5.2.3.2 对符号串编码对信源的符号串进行编码,即增多消息个数M ,同时增大码长N ,有可能使平均差错率e P 降低到要求的范围以内,而又能使信息率R 降低得不多。

例如,取4M =(2次扩展信源)、5N =。

4个消息记为123400,01,10,11s s s s ==== 编码函数为1212345:1,2,3,4i i i i i i i i i f s m m a a a a a i α=→==112231241112i i i i i i i i i i i i a m a m a m m a m a m m ⎧=⎪=⎪⎪=⊕⎨⎪=⎪⎪=⊕⎩ 译码采用极大似然规则。

编译码示意图见图5.3所示。

编码后的信息率R 和平均差错率e P 分别为log 4255R == bit /码元 5432411(4208)7.86104e P p p p p p -=-++≈⨯与“重复2次”编码相比,R 略有增加,e P 处在同一数量级。

因此,增大码长N 和适当增多消息个数M ,对兼顾e P (可靠性)和R (有效性)的要求是有效的。

5.2.4 最小汉明距离译码规则5.2.4.1汉明距离两个等长符号序列x 和y 之间的汉明距离,记为(,)D x y ,是x 与y 之间对应位置上不同符号的个数,用来定量描述符号序列之间的“相似”程度。

5.2.4.2汉明距离与信道编码性能的关系码是码字的集合,码字则是由码元组成的符号序列。

假如12{,,,}q C c c c = 是等长码,则C 中任意两个不同码字之间的汉明距离或码间距离为(,),,,i j i j i j D c c c c c c C ≠∈码C 的最小码间距离定义为min min (,),i j i j i j d D c c c c c c C ⎡⎤=≠∈⎣⎦最小码间距离min d 是衡量码的性能的重要参数,码的min d 小,说明其中有些码字受干扰后容易变为另一码字,译码时就会出错。

因此,信道编码在选择码字时,应尽量使码的最小码间距离min d 大一些为好。

图5.3 4M = 、5n = 的编译码示意图0000000010110110101111111010ff f f −−→−−→−−→−−→0000000001000100010001000100001000100011011010110001111010010010111101111000111010111101101010110011111110011100110101001101011011110001111010010010100101111001000000110110111110105次扩展信道对于二元对称信道,设信源有M 个消息12{,,,}M s s s ,输入和输出符号集分别为{0,1}A =和{0,1}B =,其N 次扩展信道的入口符号集N A 和出口符号集N B 中都含有2N 个N 长二元符号串,即122122{,,,}{,,,}N N N NA B αααβββ==从NA 中选择M 个符号串当作码字组成码C :12{,,,}M C c c c =按极大似然译码规则进行译码时,可以推导出等价于以下规则,称为最小(汉明)距离译码规则:**(),:(,)min (,),Nj j j Nj j i j i F c C B F D c D c c C A ββββ⎧=∈∈⎪⎨⎡⎤=∈⊂⎪⎣⎦⎩ (5.9) 其含意是:将接收序列j β译为与之最相似的输入序列(码字)*j c 。

5.2.5有噪信道编码定理(香农第二定理)5.2.5.1有噪信道编码定理若信道是离散、无记忆、平稳的,且信道容量为C ,只要待传送的信息率R C <,就一定能找到一种信道编码方法,使得码长N 足够大时,平均差错率e P 任意接近于零。

有噪信道编码定理实际上是一个存在性定理,它指出:在R C <时,肯定存在一种好的信道编码方法,用这种好码来传送消息可使e P 逼近零。

但香农并没有给出具体编码方法。

对有噪信道编码定理的证明要用到联合典型序列。

所谓典型序列,是指那些平均自信息量逼近熵的序列。

联合ε典型序列,是指那些平均联合自信息量逼近联合熵的序列。

离散无记忆信源X 发出N 长序列12N i i i i x x x x = ,若()()i I x H X Nε-< (5.10) 则称i x 为X 的ε典型序列,否则称为X 的非ε典型序列。

若i x 和j y 分别是X 和Y 的N 长ε典型序列,且(,)()i j I x y H XY Nε-< (5.11)则称序列对(,)i j x y 为X 与Y 的联合ε典型序列,否则称为非联合ε典型序列。

5.2.5.2有噪信道编码逆定理若信道是离散、无记忆、平稳的,且信道容量为C ,如果信息率R C >,则肯定找不到一种信道编码方法,使得码长N 足够大时,平均差错率e P 任意接近于零。

对有噪信道编码逆定理的证明,要用到Fano 不等式。